需要订阅 JoVE 才能查看此. 登录或开始免费试用。

Method Article

相机位置的机器人化测试,以确定心脏直视手术立体3D可视化的理想配置

摘要

3D立体视频的人类深度感知取决于摄像机的分离度,收敛点,距离和物体的熟悉程度。本文提出了一种机器人化方法,用于在现场心脏直视手术期间快速可靠地收集测试数据,以确定理想的相机配置。

摘要

来自外科手术的立体3D视频对于医学教育非常有价值,并改善了临床沟通。但进入手术室和手术区域受到限制。这是一个无菌的环境,物理空间挤满了外科医生和技术设备。在这种情况下,很难对外科手术进行无遮挡的捕获和逼真的再现。本文提出了一种在不同摄像机基线距离和收敛距离下快速可靠地采集立体3D视频数据的方法。为了在手术过程中以最小的干扰收集测试数据,具有高精度和可重复性,相机被连接到双臂机器人的每只手上。机器人安装在手术室的天花板上。它被编程为执行同步相机移动的定时序列,以10 mm的增量步进,在基线距离在50-240 mm之间的一系列测试位置,以及1100 mm和1400 mm的两个收敛距离。暂停手术以允许40个连续的5秒视频样本。共记录了10种手术场景。

引言

在外科手术中,3D 可视化可用于教育、诊断、术前计划和术后评估1,2。逼真的深度知觉可以提高对正常和异常解剖结构的理解3,4,5,6。外科手术的简单2D视频录制是一个良好的开端。然而,缺乏深度知觉可能使非手术同事难以完全理解不同解剖结构之间的前后关系,因此也会带来误解解剖结构的风险7,8,9,10。

3D 观看体验受五个因素的影响:(1) 摄像机配置可以是并行的,也可以是脚趾式的,如图 1 所示,(2) 基线距离(摄像机之间的距离)。(3)与感兴趣对象的距离和其他场景特征,如背景。(4)观看设备的特点,如屏幕尺寸和观看位置1,11,12,13。(5)观众的个人偏好14,15。

设计 3D 相机设置首先要捕获在各种相机基线距离和配置下录制的测试视频,以用于主观或自动评估16,17,18,19,20。摄像机与手术区域的距离必须恒定,以捕获清晰的图像。固定对焦是首选,因为自动对焦将调整为对可能进入视野的手,仪器或头部。然而,当感兴趣的场景是手术场时,这并不容易实现。手术室是限制进入区域,因为这些设施必须保持清洁和无菌。技术设备、外科医生和擦洗护士通常聚集在患者周围,以确保良好的视觉概览和高效的工作流程。为了比较和评估摄像机位置对 3D 观看体验的影响,应记录同一场景的一个完整的摄像机位置测试范围,因为对象特征(如形状、大小和颜色)会影响 3D 观看体验21。

出于同样的原因,应在不同的外科手术中重复相机位置的完整测试范围。必须高精度地重复整个位置序列。在手术环境中,由于空间和时间限制,需要手动调整基线距离22 或具有固定基线距离的不同相机对23 的现有方法不可行。为了应对这一挑战,设计了这种机器人化的解决方案。

数据是通过安装在手术室天花板上的双臂协作工业机器人收集的。摄像头连接到机器人的手腕上,并沿着弧形轨迹移动,基线距离增加,如图 2所示。

为了证明这种方法,记录了来自4名患有4种不同先天性心脏缺陷的不同患者的10个测试系列。当手术暂停是可行的时,选择了场景:手术修复前后的心脏跳动。当心脏被捕时,也制作了系列。手术暂停3分钟20秒,以收集40个具有不同摄像机收敛距离和基线距离的5-ssequences来捕捉场景。这些视频后来进行了后处理,以3D形式显示给临床团队,他们根据0-5的比例对3D视频的逼真程度进行了评分。

脚趾式立体相机的收敛点是两个图像的中心点相交的地方。原则上,收敛点可以放置在物体的前面、内部或后面,见图1A-C。当收敛点位于对象前面时,将捕获对象,并将其显示在左相机图像的中线左侧和右相机图像的中线右侧(图1A)。当收敛点位于对象后面时,则相反的情况适用(图1B)。当收敛点位于物体上时,物体也将出现在相机图像的中线(图1C),这大概应该会产生最舒适的观看效果,因为不需要眯眼来合并图像。为了实现舒适的立体3D视频,收敛点必须位于感兴趣的物体上或稍后一点,否则观众需要自愿向外眯眼(外斜视)。

数据是使用双臂协作工业机器人来定位相机收集的(图2A-B)。机器人在没有设备的情况下重达38公斤。机器人本质上是安全的;当它检测到意外撞击时,它会停止移动。机器人被编程为将带有C接口镜头的5百万像素相机定位在弧形轨迹上,停止在预定的基线距离处(图2C)。使用适配器板将相机连接到机器人手上,如图3所示。每个摄像机以每秒 25 帧的速度录制。镜头设置为光圈值1/8,焦点固定在感兴趣的物体上(心脏的近似几何中心)。每个图像帧都有一个时间戳,用于同步两个视频流。

校准了机器人手腕和摄像头之间的偏移量。这可以通过对齐相机图像的十字准线来实现,如图 4所示。在此设置中,从机器人手腕上的安装点到相机图像传感器中心的总平移偏移量在X方向上为55.3 mm,在Z方向上为21.2 mm, 如图5所示。旋转偏移在1100 mm的收敛距离和50 mm的基线距离处进行校准,并使用机器人控制面板上的操纵杆手动调整。本研究中的机器人在笛卡尔空间中的指定精度为0.02 mm,旋转分辨率为0.01度24。在半径为 1100 m 时,角度差为 0.01 度时,中心点偏移 0.2 mm。在50-240毫米分离的机器人运动中,每个摄像头的十字准线距离理想的收敛中心在2毫米以内。

通过视场中心周围摄像机的对称分离,基线距离逐步增加,增量为10 mm,范围为50-240 mm(图2)。相机在每个位置保持静止5秒,并以50 mm / s的速度在位置之间移动。可以使用图形用户界面在 X 和 Z 方向上调整收敛点(图 6)。机器人在其工作范围内相应地跟随。

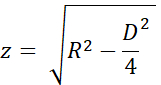

使用均匀三角形和 图7A 和 B中的变量名称估计收敛点的精度。高度 "z" 是从收敛距离 "R" 计算得出的,毕达哥拉斯定理为:

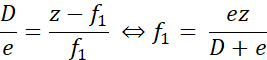

当实际收敛点比所需点更近时,如图7A所示,误差距离"f1"计算如下:

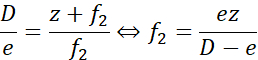

类似地,当收敛点远至所需点时,误差距离"f2"计算如下:

在这里,"e" 是十字准线之间的最大间隔,在校准期间的最大基线距离处最多为2毫米(D = 240毫米)。当 R = 1100 mm (z = 1093 mm) 时,误差小于 ± 9.2 mm。当 R = 1400 mm (z = 1395 mm) 时,误差± 11.7 mm。也就是说,收敛点放置的误差在所需值的1%以内。因此,1100 mm 和 1400 mm 这两个测试距离被很好地分开了。

Access restricted. Please log in or start a trial to view this content.

研究方案

这些实验得到了瑞典隆德当地伦理委员会的批准。参与是自愿的,患者的法定监护人提供了知情的书面同意书。

1. 机器人设置和配置

注:本实验使用双臂协作式工业机器人和带触摸显示屏的标准控制面板。机器人由RobotWare 6.10.01控制器软件和机器人集成开发环境(IDE)RobotStudio 2019.525控制。作者开发的软件,包括机器人应用程序,记录应用程序和后处理脚本,可在GitHub存储库26上找到。

注意:在设置和测试机器人程序期间,请使用防护眼镜并降低速度。

- 按照制造商的规格,使用尺寸为100 kg的螺栓将机器人安装到天花板或桌子上,如产品规格24第25页所述。确保手臂可以自由移动,并且视野的视线不被遮挡。

注意:将机器人安装在高位时,请使用升降机或安全绳。 - 通过转动位于机器人底部的启动开关来启动机器人。按照第47-5625页操作手册中描述的程序校准机器人。

- 在 Windows 计算机上启动机器人 IDE。

- 连接到物理机器人系统(操作手册页 14027)。

- 将机器人程序的代码和用户界面的应用程序库加载到机器人:

- 天花板安装机器人的机器人代码位于" 机器人/倒置代码" 文件夹中,而桌面安装机器人的机器人 代码位于"机器人/表挂载代码"文件夹中。对于每个文件 left/Data.mod、left/MainModule.mod、right/Data.mod 和 right/MainModule.mod:

- 创建与文件同名的新程序模块(请参见操作手册第 31827 页)(数据或主模块),并将文件内容复制到新模块。

- 在机器人 IDE 中按 应用 以将文件保存到机器人。

- 使用文件传输(操作手册页 34627)将位于 FPApp 文件夹中的机器人应用程序文件 TpSViewStereo2.dll、TpsViewStereo2.gtpu.dll和 TpsViewStereo2.pdb传输到机器人。完成此步骤后,机器人 IDE 将不再使用。

- 按机器人触摸显示屏(FlexPendant)背面的 重置 按钮以重新加载图形界面。机器人应用程序Stereo2现在将在触摸显示菜单下可见。

- 通过运行位于 Github 存储库根文件夹中的脚本install_all_linux.sh,在 Ubuntu 20.04 计算机上安装录制应用程序 (Liveview) 和后处理应用程序。

- 将每个摄像头安装到机器人上。安装所需的元件如图 3A所示。

- 将镜头安装到相机上。

- 使用三个 M2 螺钉将摄像机安装到摄像机适配器板上。

- 将圆形安装板安装到摄像机适配器板上,摄像机另一侧有四个 M6 螺钉。

- 对另一台相机重复步骤1.9.1-1.9.3。生成的组件将进行镜像,如图 3B 和 图3C所示。

- 用四个M2.5螺钉将适配器板安装到机器人手腕上,如图 3D所示。

- 对于安装在天花板上的机器人:如图 3C 中的左侧摄像头连接到左侧机器人手臂,如图 2A所示。

- 对于台式机器人:将 图3C 中的左侧摄像头连接到右侧机器人手臂。

- 如图 3E所示,将USB电缆连接到相机和Ubuntu计算机。

2. 验证相机校准

- 在机器人触摸显示屏上,按 "菜单 "按钮并选择 "Stereo2 "以启动机器人应用程序。这将打开主屏幕,如图 6A 所示。

- 在主屏幕上,在机器人应用程序中按 Go启动 1100 mm,然后等待机器人移动到起始位置。

- 从相机上取下保护镜头盖,然后将USB电缆连接到Ubuntu计算机。

- 将打印的校准网格(CalibrationGrid.png放置在存储库中)距相机传感器1100 mm处。为了便于正确识别相应的正方形,请在网格中心的某个地方放置一个小螺母或标记。

- 在 Ubuntu 计算机上启动录制应用程序(运行位于 Github 存储库内 liveview 文件夹中的脚本 start.sh)。这将启动接口,如图 4 所示。

- 调整光圈,并使用光圈和对焦环对焦镜头。

- 在录制应用程序中,选中 "十字准线 "以可视化十字准线。

- 在记录应用中,确保十字准线与两个相机图像中校准网格对齐在同一位置,如图 4所示。最有可能的是,需要进行如下调整:

- 如果十字架没有重叠,请按机器人触摸显示屏上机器人应用程序中的 齿轮 图标(左下角 图6A)以打开设置屏幕,如图 6B所示。

- 按 1。转到"启动 Pos",如图 6B 所示。

- 用操纵杆点动机器人以调整相机位置(操作手册第3123页)。

- 更新每个机械臂的工具位置。按 3。更新左侧工具和4。更新右工具以分别保存左臂和右臂的校准。

- 按 后退箭头 图标(右上方, 图6B)返回主屏幕。

- 在机器人应用程序中按 运行实验 (图6A),并验证十字准线是否对齐。否则,请重复步骤 2.3-2.3.5。

- 添加并测试此时对距离和/或时间的任何更改。这需要更改机器人程序代码和高级机器人编程技能。在左侧任务(手臂)的 "数据 "模块中更改以下变量:整数数组变量 "距离"中的所需分离距离,整数数组 "ConvergencePos "中的收敛距离,并通过编辑变量 Nwaittime (以秒为单位的值)来编辑每一步的时间。

注意:切勿在现场手术期间运行未经测试的机器人程序。 - 校准完成后,按 "抬起 "将机器人手臂提升到待机位置。

- (可选)关闭机器人。

注意:该过程可以在上述任何步骤之间暂停。

3. 手术开始时的准备

- 给机器人除尘。

- 如果机器人已关闭,请通过打开位于机器人底部的 启动开关来启动 机器人。

- 在步骤2.1和2.2中描述的触摸显示和记录应用程序上启动机器人应用程序。

- 在录制应用程序中,创建并选择要保存视频的文件夹(按 "更改文件夹")。

- 在机器人应用中:按下齿轮图标,将摄像头相对于患者放置。通过分别按+/-表示 手距机器人的距离 和 高度来改变X和Z方向,以便图像捕获手术区域。通过手动移动机器人或患者在Y方向上执行定位。

注意:准备工作可以在准备步骤3.1-3.4之间暂停。

4. 实验

注意:应事先告知所有人员有关实验的信息。

- 暂停手术。

- 通知手术室人员实验已启动。

- 在 录制 应用程序中按录制。

- 在机器人应用程序中 按运行实验 。

- 等待程序正在运行;完成后,机器人在触摸显示屏上显示机器人应用程序中的"完成"。

- 按 "退出"在录制应用程序中停止录制。

- 通知手术室人员实验已完成。

- 恢复手术。

注意:在步骤 4.1-4.6 期间,无法暂停实验。

5. 重复

- 重复步骤4.1-4.6以捕获另一个序列,并重复步骤3.1-3.4和步骤4.1-4.6以捕获来自不同手术的序列。捕获大约十个完整的序列。

6. 后处理

注意:可以使用大多数视频编辑软件或后处理文件夹中提供的脚本执行以下步骤。

- 在这种情况下,请以RAW格式保存视频时对视频进行去拜耳化:

- 运行脚本 postprocessing/debayer/run.sh以打开 图 8A 中所示的 debayer 应用程序。

- 按 浏览输入目录 ,然后选择包含 RAW 视频的文件夹。

- 按 "浏览输出目录 ",然后为生成的去拜耳化和颜色调整的视频文件选择一个文件夹。

- 按 德拜尔! 并等待该过程完成 - 两个进度条都已满,如图 8B 所示。

- 将左右同步视频合并为 3D 立体格式28:

- 运行脚本后处理/merge_tb/运行.sh以启动合并应用程序;它将打开 图8C所示的图形用户界面。

- 按 浏览输入目录 ,然后选择包含去拜耳视频文件的文件夹。

- 按 "浏览输出目录 ",然后为生成的合并 3D 立体文件选择一个文件夹。

- 按 合并! ,然后等待 图 8D 中的完成屏幕显示。

- 使用现成的视频编辑软件(如 Premiere Pro)为视频中的每个摄像机距离添加文本标签。

注意:在视频中,每次机器人移动时都会出现明显的抖动,并且摄像机距离增加。在这个实验中,标签A-T用于相机距离。

7. 评估

- 使用活动 3D 投影仪以自上而下的 3D 格式显示视频。

- 观看体验取决于视角和到屏幕的距离;使用目标受众和设置评估视频。

Access restricted. Please log in or start a trial to view this content.

结果

Video1 中显示了一个可接受的评估视频,其中正确的图像放置在自上而下的立体 3D 的顶部。成功的序列应该是清晰的、集中的,并且没有不同步的图像帧。不同步的视频流将导致模糊,如文件视频 2 所示。收敛点应水平居中,独立于相机分离,如图9A,B所示。当机器人在各个位置之间转换时,视频中会出现一个小的抖动,这是在50 mm / s?...

Access restricted. Please log in or start a trial to view this content.

讨论

在现场手术期间,用于3D视频数据收集的实验的总时间受到限制,以便对患者安全。如果物体未聚焦或过度曝光,则无法使用数据。关键步骤是在相机工具校准和设置期间(步骤2)。手术开始时,相机光圈和对焦无法改变;在设置和手术过程中应使用相同的照明条件和距离。必须仔细执行步骤2.1-2.4中的相机校准,以确保心脏在捕获的视频中居中。要对校准进行故障排除,可以通过在坐标系中慢跑?...

Access restricted. Please log in or start a trial to view this content.

披露声明

作者没有什么可透露的。

致谢

该研究由Vinnova(2017-03728,2018-05302和2018-03651),心肺基金会(20180390),家庭坎普拉德基金会(20190194)以及Anna-Lisa和Sven Eric Lundgren基金会(2017年和2018年)资助。

Access restricted. Please log in or start a trial to view this content.

材料

| Name | Company | Catalog Number | Comments |

| 2 C-mount lenses (35 mm F2.1, 5 M pixel) | Tamron | M112FM35 | Rated for 5 Mpixel |

| 3D glasses (DLP-link active shutter) | Celexon | G1000 | Any compatible 3D glasses can be used |

| 3D Projector | Viewsonic | X10-4K | Displays 3D in 1080, can be exchanged for other 3D projectors |

| 6 M2 x 8 screws | To attach the cXimea cameras to the camera adaptor plates | ||

| 8 M2.5 x 8 screws | To attach the circular mounting plates to the robot wrist | ||

| 8 M5 x 40 screws | To mount the robot | ||

| 8 M6 x 10 screws with flat heads | For attaching the circular mounting plate and the camera adaptor plates | ||

| Calibration checker board plate (25 by 25 mm) | Any standard checkerboard can be used, including printed, as long as the grid is clearly visible in the cameras | ||

| Camera adaptor plates, x2 | Designed by the authors in robot_camera_adaptor_plates.dwg, milled in aluminium. | ||

| Circular mounting plates, x2 | Distributed with the permission of the designer Julius Klein and printed with ABS plastic on an FDM 3D printer. License Tecnalia Research & Innovation 2017. Attached as Mountingplate_ROBOT_SIDE_ NewDesign_4.stl | ||

| Fix focus usb cameras, x2 (5 Mpixel) | Ximea | MC050CG-SY-UB | With Sony IMX250LQR sensor |

| Flexpendant | ABB | 3HAC028357-001 | robot touch display |

| Liveview | recording application | ||

| RobotStudio | robot integrated development environment (IDE) | ||

| USB3 active cables (10.0 m), x2 | Thumbscrew lock connector, water proofed. | ||

| YuMi dual-arm robot | ABB | IRB14000 |

参考文献

- Held, R. T., Hui, T. T. A guide to stereoscopic 3D displays in medicine. Academic Radiology. 18 (8), 1035-1048 (2011).

- van Beurden, M. H. P. H., IJsselsteijn, W. A., Juola, J. F. Effectiveness of stereoscopic displays in medicine: A review. 3D Research. 3 (1), 1-13 (2012).

- Luursema, J. M., Verwey, W. B., Kommers, P. A. M., Geelkerken, R. H., Vos, H. J. Optimizing conditions for computer-assisted anatomical learning. Interacting with Computers. 18 (5), 1123-1138 (2006).

- Takano, M., et al. Usefulness and capability of three-dimensional, full high-definition movies for surgical education. Maxillofacial Plastic and Reconstructive Surgery. 39 (1), 10(2017).

- Triepels, C. P. R., et al. Does three-dimensional anatomy improve student understanding. Clinical Anatomy. 33 (1), 25-33 (2020).

- Beermann, J., et al. Three-dimensional visualisation improves understanding of surgical liver anatomy. Medical Education. 44 (9), 936-940 (2010).

- Battulga, B., Konishi, T., Tamura, Y., Moriguchi, H. The Effectiveness of an interactive 3-dimensional computer graphics model for medical education. Interactive Journal of Medical Research. 1 (2), (2012).

- Yammine, K., Violato, C. A meta-analysis of the educational effectiveness of three-dimensional visualization technologies in teaching anatomy. Anatomical Sciences Education. 8 (6), 525-538 (2015).

- Fitzgerald, J. E. F., White, M. J., Tang, S. W., Maxwell-Armstrong, C. A., James, D. K. Are we teaching sufficient anatomy at medical school? The opinions of newly qualified doctors. Clinical Anatomy. 21 (7), 718-724 (2008).

- Bergman, E. M., Van Der Vleuten, C. P. M., Scherpbier, A. J. J. A. Why don't they know enough about anatomy? A narrative review. Medical Teacher. 33 (5), 403-409 (2011).

- Terzić, K., Hansard, M. Methods for reducing visual discomfort in stereoscopic 3D: A review. Signal Processing: Image Communication. 47, 402-416 (2016).

- Fan, Z., Weng, Y., Chen, G., Liao, H. 3D interactive surgical visualization system using mobile spatial information acquisition and autostereoscopic display. Journal of Biomedical Informatics. 71, 154-164 (2017).

- Fan, Z., Zhang, S., Weng, Y., Chen, G., Liao, H. 3D quantitative evaluation system for autostereoscopic display. Journal of Display Technology. 12 (10), 1185-1196 (2016).

- McIntire, J. P., et al. Binocular fusion ranges and stereoacuity predict positional and rotational spatial task performance on a stereoscopic 3D display. Journal of Display Technology. 11 (11), 959-966 (2015).

- Kalia, M., Navab, N., Fels, S. S., Salcudean, T. A method to introduce & evaluate motion parallax with stereo for medical AR/MR. IEEE Conference on Virtual Reality and 3D User Interfaces. , 1755-1759 (2019).

- Kytö, M., Hakala, J., Oittinen, P., Häkkinen, J. Effect of camera separation on the viewing experience of stereoscopic photographs. Journal of Electronic Imaging. 21 (1), 1-9 (2012).

- Moorthy, A. K., Su, C. C., Mittal, A., Bovik, A. C. Subjective evaluation of stereoscopic image quality. Signal Processing: Image Communication. 28 (8), 870-883 (2013).

- Yilmaz, G. N. A depth perception evaluation metric for immersive 3D video services. 3DTV Conference: The True Vision - Capture, Transmission and Display of 3D Video. , 1-4 (2017).

- Lebreton, P., Raake, A., Barkowsky, M., Le Callet, P. Evaluating depth perception of 3D stereoscopic videos. IEEE Journal on Selected Topics in Signal Processing. 6, 710-720 (2012).

- López, J. P., Rodrigo, J. A., Jiménez, D., Menéndez, J. M. Stereoscopic 3D video quality assessment based on depth maps and video motion. EURASIP Journal on Image and Video Processing. 2013 (1), 62(2013).

- Banks, M. S., Read, J. C., Allison, R. S., Watt, S. J. Stereoscopy and the human visual system. SMPTE Motion Imaging Journal. 121 (4), 24-43 (2012).

- Kytö, M., Nuutinen, M., Oittinen, P. Method for measuring stereo camera depth accuracy based on stereoscopic vision. Three-Dimensional Imaging, Interaction, and Measurement. 7864, 168-176 (2011).

- Kang, Y. S., Ho, Y. S. Geometrical compensation algorithm of multiview image for arc multi-camera arrays. Advances in Multimedia Information Processing. 2008, 543-552 (2008).

- Product Specification IRB 14000. DocumentID: 3HAC052982-001 Revision J. ABB Robotics. , Available from: https://library.abb.com/en/results (2018).

- Operating Manual IRB 14000. Document ID: 3HAC052986-001 Revision F. ABB Robotics. , Available from: https://library.abb.com/en/results (2019).

- Github repository. , Available from: https://github.com/majstenmark/stereo2 (2021).

- Operating manual RobotStudio. Document ID: 3HAC032104-001 Revision Y. ABB Robotics. , Available from: https://library.abb.com/en/results (2019).

- Won, C. S. Adaptive interpolation for 3D stereoscopic video in frame-compatible top-bottom packing. IEEE International Conference on Consumer Electronics. 2011, 179-180 (2011).

- Kim, S. K., Lee, C., Kim, K. T. Multi-view image acquisition and display. Three-Dimensional Imaging, Visualization, and Display. Javidi, B., Okano, F., Son, J. Y. , Springer. New York. 227-249 (2009).

- Liu, F., Niu, Y., Jin, H. Keystone correction for stereoscopic cinematography. IEEE Computer Society Conference on Computer Vision and Pattern Recognition Workshops. 2012, 1-7 (2012).

- Kang, W., Lee, S. Horizontal parallax distortion correction method in toed-in camera with wide-angle lens. 3DTV Conference: The True Vision - Capture, Transmission and Display of 3D Video. 2009, 1-4 (2009).

Access restricted. Please log in or start a trial to view this content.

转载和许可

请求许可使用此 JoVE 文章的文本或图形

请求许可探索更多文章

This article has been published

Video Coming Soon

版权所属 © 2025 MyJoVE 公司版权所有,本公司不涉及任何医疗业务和医疗服务。