Method Article

估计人类多指抓取过程中手与物体之间的接触区域

摘要

当我们抓住一个物体时,手指和手的多个区域通常会与物体的表面接触。重建这样的接触区域具有挑战性。在这里,我们提出了一种通过将基于标记的运动捕捉与现有的基于深度学习的手网格重建相结合来近似估计接触区域的方法。

摘要

为了成功抓住物体,我们必须为我们的手在物体表面上选择合适的接触区域。然而,确定这些区域具有挑战性。本文介绍了一种根据基于标记的跟踪数据估计接触区域的工作流程。参与者抓住真实的物体,而我们跟踪物体和手的3D位置,包括手指的关节。我们首先从位于手背上的一系列跟踪标记中确定联合欧拉角。然后,我们使用最先进的手部网格重建算法来生成参与者在当前姿势和 3D 位置下的手的网格模型。

使用3D打印或3D扫描的对象 - 因此,可以作为真实对象和网格数据 - 允许手和对象网格共同配准。反过来,这允许通过计算手网格和共配准的3D对象网格之间的交点来估计近似接触区域。该方法可用于估计人类在各种条件下抓取物体的位置和方式。因此,研究视觉和触觉感知,运动控制,虚拟和增强现实中的人机交互以及机器人技术的研究人员可能会对该方法感兴趣。

引言

抓取和操纵物体的能力是使人类能够根据自己的需求重塑环境的关键能力。然而,有效地控制多关节手是一项具有挑战性的任务,需要复杂的控制系统。该运动控制系统由多种形式的感官输入引导,其中视觉至关重要。通过视觉,个人可以识别环境中的物体并估计它们的位置和物理特性,然后可以轻松到达、抓取和操纵这些物体。了解将视网膜输入与控制手的运动命令联系起来的复杂系统是感觉运动神经科学的一个关键挑战。为了建模、预测和理解这个系统是如何工作的,我们必须首先能够详细研究它。这需要对视觉输入和手动电机输出进行高保真测量。

过去的运动跟踪技术给人类抓取的研究带来了许多限制。例如,需要将电缆连接到参与者的手1,2的系统倾向于限制手指运动的范围,从而可能改变抓取动作或测量本身。尽管存在这些局限性,但以前的研究已经能够确定影响视觉引导抓取的几个因素。其中一些因素包括物体形状3、4、5、6、表面粗糙度7、8、9 或物体相对于手的方向 4、8、10。然而,为了克服以前的技术限制,大多数先前的研究都采用了简单的刺激和高度受限的任务,因此主要关注单个因素3,4,6,7,10,两位数精密夹具3,4,6,9,11,12, 13、14、15、16、17、18、单个物体19、或非常简单的2D形状20、21。先前的发现如何超越这种减少和人工的实验室条件尚不清楚。此外,手与物体接触的测量通常简化为对数字接触点22的估计。这种简化可能适用于描述只有指尖与物体接触的一小部分抓握。然而,在大多数现实世界的抓握中,手指和手掌的大面积区域与物体接触。此外,最近的一项研究23已经证明,使用触觉手套,可以通过物体表面如何撞击手来识别物体。这突出了研究手与被抓物体之间的延伸接触区域的重要性,而不仅仅是物体与指尖之间的接触点22。

动作捕捉和3D手部建模的最新进展使我们能够超越以前的限制,并研究抓握的全部复杂性。基于被动标记的运动跟踪现在可用于毫米大小的标记,这些标记可以连接到参与者的手背以跟踪关节运动24。此外,用于无源标记系统的自动标记识别算法现在足够强大,几乎消除了对标记数据进行大量手动后处理的需要25,26,27。在视频28 中,无标记解决方案在跟踪动物身体部位方面的性能也达到了令人印象深刻的水平。因此,这些运动跟踪方法最终允许对复杂的多位数手部运动进行可靠且无创的测量24。这种测量可以告诉我们关节运动学,并使我们能够估计手和物体之间的接触点。此外,近年来,计算机视觉社区一直在解决构建人手模型的问题,该模型可以复制物体抓取过程中的软组织变形,甚至在手部之间的自接触过程中29,30,31,32。这种3D网格重建可以从不同类型的数据中得出,例如视频片段33、34、骨骼关节(源自基于标记的35或无标记跟踪36)和深度图像37。该领域的第一个关键进展是由Romero等人提供的,38,他们从31名不同姿势的受试者的1,000多次手部扫描中得出了一个参数化手部模型(MANOs)。该模型包含手部姿势和形状的参数,有助于从不同数据源回归到完整的手部重建。最新的 DeepHandMesh29 解决方案基于这种方法,通过深度学习构建参数化模型并添加穿透避免,从而更准确地复制手部部件之间的物理相互作用。通过将这种手部网格重建与3D跟踪对象网格相结合,现在可以估计不仅物体32表面上的接触区域,而且估计手表面上的接触区域。

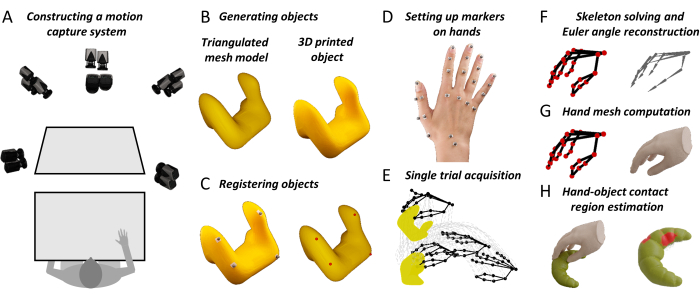

在这里,我们提出了一种工作流程,将物体和手关节的高保真3D跟踪与新颖的手部网格重建算法结合在一起。该方法生成手-物体接触表面的详细地图。这些测量将帮助感觉运动神经科学家扩展我们对人类视觉引导抓取的理论理解。此外,该方法可能对相邻领域的研究人员有用。例如,人为因素研究人员可以使用这种方法在虚拟现实和增强现实中构建更好的人机界面系统18。人类抓取行为的高保真测量还可以帮助机器人专家根据交互式感知原理设计受人类启发的机器人抓取系统39,40,41,42,43。因此,我们希望这种方法将有助于推进神经科学和工程领域的抓取研究,从对高度受限任务的稀疏描述到对复杂物体和现实世界任务的自然抓取行为的更全面描述。图 1 概述了总体方法。

图 1:所提出的方法中的关键步骤 。 (A)动作捕捉摄像机从多个角度对工作台进行成像。(B)刺激对象是从三角网格模型3D打印出来的。(C)四个球形反射标记粘在真实物体的表面上。半自动过程标识网格对象表面上的四个相应点。这种对应关系使我们能够将网格模型旋转平移到真实对象的 3D 跟踪位置。(D)使用双面胶带将反光标记贴在参与者手背上的不同地标上。(E)运动捕捉系统在单次试验中获取被跟踪物体和手部标记的3D空间轨迹。(F)使用3D计算机图形软件构建参与者特定的手骨架。然后通过反向运动学估计实验中每个试验的每一帧的骨骼关节姿势。(G)关节姿势被输入到DeepHandMesh29的修改版本,该版本在当前3D姿势和位置中输出估计的3D手部网格。(H)最后,我们使用网格交集来计算手-物体接触区域。 请点击此处查看此图的大图。

研究方案

在开始实验之前,参与者必须根据机构指南和赫尔辛基宣言提供知情同意。此处描述的所有协议均已获得吉森Justus Liebig大学(LEK-FB06)当地伦理委员会的批准。

1. 安装所有必要的软件

- 在数据和代码存储库中下载项目存储库。

- 安装 材料表中 列出的软件(请注意软件版本,并按照链接获取购买选项和说明)。

- 在数据和代码存储库中,打开命令窗口,然后运行以下命令:

conda env create -f environment.yml - 按照 https://github.com/facebookresearch/DeepHandMesh 中提供的说明下载并安装预训练的 DeepHandMesh29 实例化。

- 将 DeepHandMesh 放在数据和代码存储库的文件夹 "deephandmesh" 中。将文件"main/model.py"替换为数据和代码存储库中包含的 model.py 文件。

2. 准备动作捕捉系统

- 通过布置在工作区周围框架上的运动跟踪相机,将工作台放置在从多个角度成像的跟踪体积内(图1A)。通过将双面胶带连接到每个标记的底部来准备反光标记。

- 以管理员身份执行 Qualisys Track Manager (QTM)。

注意:以管理员身份执行 QTM 对于 Python SDK 控制 QTM 接口是必要的。我们建议始终以管理员身份运行 QTM。

3. 校准相机

- 将L形校准对象置于跟踪体积内。

- 在 QTM 中,单击"捕获"菜单中的"校准",或按"捕获"工具栏中的魔杖图标。 等待校准窗口打开。选择校准的持续时间,然后按OK。

- 在校准期间,在跟踪体积上挥动 校准棒 。按 "导出 "按钮,并指定要将校准导出为文本文件的文件路径。按 OK接受校准。

4. 创建刺激对象

- 以多边形网格的形式构建虚拟 3D 对象模型。使用 3D 打印机构造对象模型的物理副本。

注意:步骤 1.1 中的数据存储库提供了 STL 和波前 OBJ 文件格式的示例对象。STL格式的物体是多种多样的,可以进行3D打印。

5. 准备刺激对象

- 将四个非平面反射标记连接到真实物体的表面上。将对象放在跟踪体积内。

- 在项目存储库中,执行 Python 脚本"Acquire_Object.py"。按照脚本提供的说明对对象标记的 3D 位置执行 1 秒捕获。

- 选取刚体的所有标记。右键单击并选择 定义刚体 (6DOF) |当前帧。输入刚体的名称,然后按 确定。

- 在"文件"菜单中,选择"导出 |到TSV。在新窗口中,选中数据类型设置中的 3D、6D 和骨架框。选中常规设置中的所有框。按确定,然后保存。

6. 共同配准刺激对象的真实和网格模型版本

- 打开 Blender,然后导航到 "脚本" 工作区。打开文件"Object_CoRegistration.py",然后按 运行。导航到 "布局" 工作区,然后按 n 切换边栏。在边栏中,导航到 "自定义 "选项卡。

- 选择要共同注册的 .obj 文件,然后按 "加载对象 "按钮。

- 选择在步骤 3.3 中输出的轨迹文件,并指定附着在刚性对象的标记的名称,以分号分隔。在 Marker 标头中,指定轨迹文件中包含数据列名称的行(计数从 0 开始)。

- 选择带有 6D 后缀的相应刚体文件,并指定在步骤 4.1 中定义的刚体的名称。在 6D 标头中,指定刚体文件中包含数据列名的行。

- 按 加载标记。平移并旋转 标记 对象和/或对象 对象 以对齐它们。指定网格输出文件,然后按 运行协同配准。这将输出一个 .obj 文件,其中包含共同注册的激励网格。

7. 在手上设置记号笔

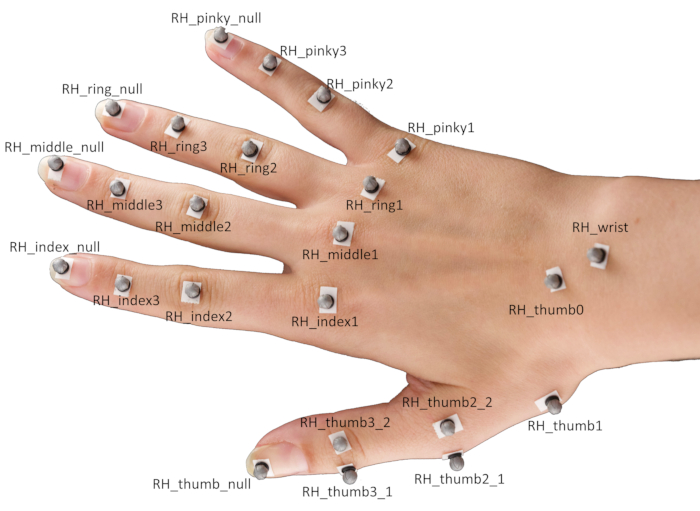

- 使用双面胶带将 24 个球形反射标记贴在参与者手的不同地标上。

注意:标记的具体定位如图 2所示。- 将标记物放在相应指尖的中央,以及食指、中指、无名指和小指的远端指间关节、近端指间关节和掌指关节。

- 对于拇指,在指尖和基底腕掌关节各放置一个标记,在掌指关节和指间关节上各放置一对标记。

注意:这些标记对需要在垂直于拇指主轴的相反方向上位移,并且是估计拇指方向所必需的。 - 最后,将标记物放在手腕中央和舟状拖钓关节上。

图 2:参与者手上的标记放置。 缩写:RH = 右手。 请点击此处查看此图的大图。

8. 获得单一试用版

- 要求参与者将手平放在工作台上,手掌朝下并闭上眼睛。将刺激对象放在参与者面前的工作台上。

- 在 QTM 运行时,在项目存储库中执行 Python 脚本"Single_Trial_Acquisition.py"。按照脚本提供的说明捕获参与者抓住刺激对象的单个试验。

注意:脚本将生成听觉提示。这将向参与者发出信号,让他们睁开眼睛并执行抓握。在我们的演示中,任务是到达并抓住目标物体,将其垂直提升约 10 厘米,将其放下,然后将手放回起始位置。

9. 标记标记

- 在 QTM 中,将单个标记轨迹从" 未识别 轨迹"拖放到 "标记轨迹 ",并根据 图 2 中的命名约定对其进行标记。

- 选择附着在手上的所有标记,然后右键单击并选择 从选择中生成AIM模型。在新窗口中,选择基于 现有AIM模型的标记连接创建新模型 ,然后按 下一步 按钮。

- 选择 RH_FH 模型定义,然后按 "打开"。按 下一步,输入 AIM 型号的名称,然后按 确定。最后,按 "完成 "为参与者的手创建一个AIM模型,该模型将用于自动识别同一参与者的连续试验中的标记。

10. 为参与者创建个性化的骨架定义

- 在 QTM 中,导航到 "播放 "菜单,然后选择" 使用实时输出播放"。

- 打开玛雅。导航到 QTM 连接功能区,然后按连接到 QTM 图标。在新窗口中,选中标记,然后按连接。现在,按 QTM 连接功能架中的播放图标。

- 按住 Shift 键并选择所有手部标记,然后按 清洗定位器 图标。选择 洗手的 记号笔,然后按 按Ctrl + G。这将创建一个 组节点。将组命名 为标记。

- 选择所有手形标记。在" 修改 "菜单中,单击" 搜索和替换名称"。搜索 RH_ 前缀,并删除标记的前缀。

- 按 QTM 连接功能架中的导入求解器图标。加载骨架定义"RH_FH.xml"。

- 在" 窗口 "菜单中,导航到 "常规编辑器 |命名空间编辑器。在新窗口中,单击 :(root),然后按 新建 以创建新的命名空间 RH。单击 RH 命名空间,按 "新建",然后将新命名空间命名为 ModelPose。

- 选择所有标记,单击 RH 命名空间,然后按"添加选定项"将标记添加到 RH 命名空间。

- 选择骨架骨骼,单击" 模型姿势 "命名空间,然后按 "添加选定项 "将骨架骨骼添加到 ModelPose 命名空间。

- 旋转、平移和缩放骨架以适合标记数据。接下来,对于每个骨架关节,分别选择 Shift + 选择骨架关节及其关联标记,然后按 添加附件 图标。最后,按 "导出求解" 图标将新的框架定义导出到可在 QTM 中加载的 XML 文件(请参阅下一步)。

注意:此步骤并非绝对必要,但对于提高骨架拟合到标记数据的精度非常有用。有关详细信息,请阅读 QSolverQuickstartGuide on https://github.com/qualisys/QTM-Connect-For-Maya。

11.重建关节骨骼关节姿势

- 在 QTM 中,按 齿轮 图标打开项目设置。在边栏中,导航到 "骨架求解器",然后按 Load 选择骨架定义文件。将 比例因子 调整为 100%,然后按 应用。

- 导航到 TSV 导出,然后选中数据类型设置中的 3D、6D 和骨架框。选中常规设置中的所有框。按应用,然后关闭项目设置。

- 按 重新处理图标,选中 求解骨架 和 导出到 TSV 文件框,然后按 确定。

12. 生成手部网格重建

- 在项目存储库中打开命令窗口,然后通过执行以下命令激活 conda 环境:

康达激活联系人区域 - 然后,执行以下命令,并按照脚本提供的说明为试验的每一帧生成一个重建当前手部姿势的手网格。

Python Hand_Mesh_Reconstruction.py --GPU 0 --test_epoch 4

注意:这些网格重建是使用开源和预训练的手网格生成工具DeepHandMesh29的修改版本自动生成的。

13. 生成手-物体接触区域估计

- 在项目存储库中打开命令窗口,执行以下命令,然后按照脚本提供的说明,通过计算手和对象网格之间的交点来生成手和对象接触区域估计值。

搅拌机 --背景 --蟒蛇 "Contact_Region_Estimation.py"

结果

所提出的方法的第一个要求是精确跟踪3D物体和手的位置的系统。具体设置如图 1A 所示,使用动作捕捉公司Qualisys生产的硬件和软件。我们将工作台放置在跟踪体积(100 cm x 100 cm x 100 cm)内,该体积由八个跟踪摄像机和六个摄像机从多个角度成像,这些摄像机排列在工作空间周围的立方体框架上。跟踪摄像机以 180 帧/秒的速度和亚毫米级 3D 空间分辨率跟踪跟踪体积内反射标记的 3D 位置。我们采用 4 毫米反光标记,使用亲肤双面胶带将其固定在物体和手上。3D标记位置由动作捕捉软件处理。讨论部分还回顾了可以与所提出的方法一起使用的替代运动捕捉系统。

为了获得被抓取和操纵的真实物体的准确3D重建,我们提出了两种选择。第一个是这里采用的,是从多边形网格形式的虚拟 3D 对象模型开始。这种3D模型可以使用适当的软件(例如,Blender 3D44)构建,然后进行3D打印(图1B)。第二种选择是采用现有的真实3D对象,并使用3D扫描技术构建对象的网格模型复制品。无论采用哪种策略,最终目标都是获得真实的3D对象和相应的虚拟3D对象网格模型。值得注意的是,这里描述的方法仅适用于刚性(即不可变形)物体。

一旦物体的 3D 表面可用作网格模型,就必须跟踪其位置并共同配准(图 1C)。为此,将四个非平面反射标记连接到真实物体的表面上,并将物体放置在跟踪体积内。然后简要捕获对象标记的 3D 位置。此捕获用于建立对象网格模型的四个标记和四个顶点之间的对应关系。这是使用用Blender的Python API编写的简单的临时软件路由完成的。在Blender的视口中,程序将虚拟对象与标记位置一起呈现,这些位置表示为单个网格对象,每个网格由一个球体组成。然后,用户可以旋转和平移对象和/或标记以对齐它们,以便它们与放置在真实对象上的真实标记对齐。程序将注册用于计算最终应用于原始对象网格的单个旋转平移的旋转和平移,从而提供与 QTM 中的刚体定义共同配准的对象网格。

建立对应关系后,每当真实物体在跟踪体积内移动时,都可以通过计算跟踪标记和四个相应网格顶点之间的旋转平移将虚拟对象放置在新位置。为了记录抓握的动态,使用双面胶带将总共24个球形反射标记贴在手的不同地标上(图1D 和 图2)。

在试验开始时(图1E),参与者将手平放在工作台上,手掌朝下并闭上眼睛。实验者将目标物体放在参与者面前的工作台上。接下来,听觉提示向参与者发出信号,让他们睁开眼睛并执行抓握。在我们的演示中,任务是到达并抓住目标物体,将其垂直提升约 10 厘米,将其放下,然后将手放回起始位置。用 Python 3.7 编写的脚本控制实验。在每次试验中,脚本选择并将当前条件设置传达给实验者(例如,对象标识和定位)。该脚本还控制审判时间,包括听觉提示以及动作捕捉记录的开始和停止。

肢体的特征不仅在于它们在3D空间中的位置,还在于它们的姿势。因此,为了获得执行真实抓握的人手的完整 3D 重建,我们不仅需要每个关节在 3D 空间中的位置,还需要每个关节相对于其父关节的相对姿势(平移和旋转)(图 1F)。骨骼关节的位置和方向可以使用反向运动学从标记位置推断出来。为此,我们在这里使用 QTM 软件提供的骨架求解器。为了使求解器正常工作,我们必须首先提供一个骨架定义,将每个关节的位置和方向链接到多个标记位置。因此,将构建骨架定义,并使用适用于 Maya 的 QTM Connect 插件将骨架绑定链接到标记数据。我们为每个参与者创建个性化的骨架定义,以最大限度地提高骨架拟合标记数据的准确性。对于每个参与者,我们手动将手骨架调整到单个动作捕捉数据帧。获得参与者特定的骨骼定义后,我们运行骨骼求解器来估计实验中每个试验的每一帧的骨骼关节姿势。

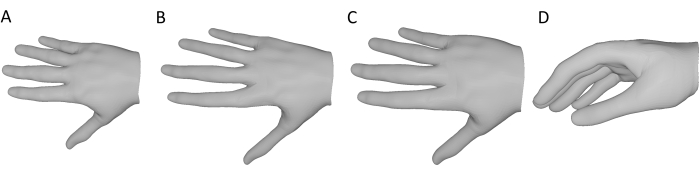

对于实验中每个试验的每一帧,我们生成一个手部网格,该网格使用开源和预训练的手网格生成工具DeepHandMesh28 重建当前的手部姿势(图1G)。DeepHandMesh是一个深度编码器-解码器网络,可从图像生成个性化的手部网格。首先,编码器估计图像中手的姿势(即欧拉关节角)。然后,将估计的手部姿势和个性化 ID 向量输入到解码器,解码器估计一组三个加法校正到绑定模板网格中。最后,根据估计的手部姿势对模板网格进行变形,并使用线性混合蒙皮进行校正。第一种矫正是与ID相关的骨架矫正,通过该矫正器调整骨架以包含特定于人的关节位置。另外两个校正是网格校正,通过它调整网格顶点以更好地表示参与者的手面。其中一个网格校正是依赖于 ID 的网格校正,它考虑了单个参与者手的表面结构。最终的网格校正是与姿势相关的顶点校正,它解释了由于当前手部姿势而导致的手面变形。

DeepHandMesh 使用弱监督进行训练,包括 2D 关节关键点和场景深度图。在这里,我们仅使用预训练的 DeepHandMesh 解码器来生成手网格重建,并通过以下方式进行修改(图 3)。首先,由于网络没有针对特定参与者进行训练,因此采用预训练模型提供的通用ID相关网格校正(图3A)。此外,如上所述,使用 QTM 骨架求解器导出依赖于 ID 的骨架校正(图 3B)。假设手与骨架长度成比例缩放,并且网格厚度通过骨架的相对缩放得出的因子均匀缩放,使得网格更好地接近参与者的手的大小(图3C)。此修改后的网格与当前手部姿势(源自标记数据)以及手腕的 3D 位置和方向一起输入到解码器。因此,解码器计算当前姿势相关的校正,应用所有校正和旋转平移,并在与 3D 跟踪对象网格相同的坐标帧中输出当前手部姿势的 3D 手部网格重建(图 3D)。

图 3:对预训练的 DeepHandMesh 解码器的修改 。 (A) 固定的、通用的、依赖于 ID 的网格校正。(B)在步骤10中通过反向运动学得出的ID依赖性骨架矫正。(C)手网的尺寸与骨骼关节的缩放系数相同。(D)当前手部姿势的最终3D手网格重建。 请点击此处查看此图的大图。

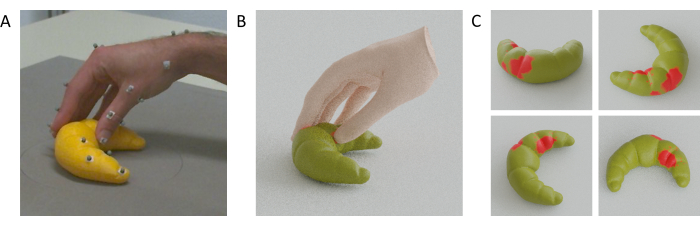

在为参与者的手和被抓住的物体重建 3D 网格模型后,可以通过计算手和物体网格之间的交集来估计手与物体接触区域(图 1H)。这背后的假设是,真正的手通过与表面接触而变形,这意味着骨架可以比手是刚性的更接近表面,这允许手网格体的一部分穿过物体网格。因此,接触区域可以近似为两个网格之间的重叠区域。

具体来说,为了计算这些重叠区域,我们将包含在手部网格的 3D 体积中的对象网格顶点定义为与手接触。这些顶点使用标准光线跟踪方法45进行识别。对于对象网格的每个顶点,将光线从该顶点投射到手形网格外部的任意 3D 点。然后,我们评估投射射线和构成手表面的三角形之间发生的交点数。如果交点数为奇数,则对象顶点包含在手形网格内。如果交点数为偶数,则对象顶点位于手形网格之外。因此,物体表面上的接触区域可以近似为一组三角形面,其顶点都包含在手形网格中。我们可以将相同的原理应用于对象网格的 3D 体积中包含的手部网格顶点,以估计手表面上的接触区域。值得注意的是,也可以使用更高级的布尔网格操作方法31。

视频 1 显示了手、跟踪点和共同注册网格的视频,它们在一次抓取 3D 打印的猫雕像时并排移动。相反,图4A显示了从抓握到3D打印羊角面包的手与物体接触时的单个帧,以及手-物体网格重建(图4B)和羊角面包表面上的估计接触区域(图4C)。

图 4:估计的手与物体接触区域。 (A) 在抓取过程中从其中一个跟踪摄像机查看的被跟踪的手和物体。(B) 从与跟踪摄像机相同的视点重建手网格和跟踪对象网格。(C)从多个视点看到的物体表面的接触区域。 请点击此处查看此图的大图。

视频1:手和物体的网格重建。 从同一摄像机视角查看的单个抓取期间手部的 Gif 动画、跟踪标记以及手部和对象网格重建。 请点击此处下载此视频。

讨论

我们提出了一种方法,可以在多位数抓取期间估计手与物体相互作用的接触区域。由于目前很难完全跟踪手的整个表面,我们建议使用手网格的重建,其姿势由手上的稀疏关键点决定。为了跟踪这些稀疏的关键点,我们的解决方案采用了基于被动标记跟踪的研究级运动捕捉系统。当然,其他运动捕捉系统也可以与所提出的方法一起使用,前提是它们产生足够准确的3D位置数据。我们建议不要使用主动标记运动捕捉系统(例如流行但已停产的Optotrak Certus),因为这些系统需要在参与者的手上连接电缆和/或电子设备,这可能会限制运动或至少产生不太典型的抓握,因为参与者更加有意识地意识到他们的手的姿势。使用惯性测量单元的运动跟踪手套可能是可能的,即使已知这些系统会遭受漂移,也可能限制手部运动,并且不允许手的表面与物体表面完全直接接触。商业无标记手部跟踪解决方案(例如,Leap Motion46,47,48)也可能是可能的,尽管仅使用这些系统可能无法跟踪物体位置。研究级运动捕捉系统最有前途的替代选择是开源的无标记跟踪解决方案(例如,Mathis等人28)。如果与多个共同注册的相机49一起使用,这种系统可以潜在地在3D中跟踪手关节位置和物体位置,而无需标记,手套或电缆。但是,这些解决方案以及这种基于标记的系统可能会因遮挡而遭受数据丢失问题的影响。

局限和未来方向

由于通过这种方法获得的手工重建不会完全准确,因此应使用该方法的实验类型存在一些限制。手部网格重建与地面实况的偏差将表现为估计的手/物体接触区域的偏差。因此,应用此方法得出绝对测量值需要评估接触区域估计值的保真度。然而,即使是近似估计在参与者内的实验设计中仍然有用,因为该方法的潜在偏差可能会以类似的方式影响参与者内的不同实验条件。因此,统计分析和推断应仅针对诸如条件之间接触面积差异之类的措施进行,其中效应的方向将与各自的基本事实相关。在未来的研究中,我们计划进一步验证我们的方法,例如通过将接触区域估计值与热致变色涂料覆盖的物体上的热指纹进行比较。

从数据收集到最终接触区域估计的大多数处理步骤都是全自动的,因此为手-物体接触区域估计的标准化程序做出了重要贡献。但是,仍然必须手动执行个性化骨骼与跟踪标记的 3D 位置的初始拟合,以获得每个参与者的骨骼定义。随着实验参与者数量的增加,手动拟合的数量也会增加,这是目前过程中最耗时的步骤,需要熟悉 Autodesk Maya 软件中的手动绑定。将来,我们的目标是通过添加自动骨架校准程序来自动化此步骤,以避免人为对程序的影响。

此处描述的工作流程依赖于 Qualisys 硬件和软件(例如,QTM 骨架求解器)。这目前限制了我们的方法对具有类似设置的实验室的可访问性。然而,原则上,该方法可以应用于任何运动捕捉数据源。为了扩大可访问性,在正在进行的工作中,我们正在探索替代方案,这些替代方案应该推广我们的工作流程,并使其减少对特定硬件和软件许可证的依赖。

该方法的另一个重要限制是,以目前的形式,它只能应用于刚性(不可变形)物体。将来,可以使用记录被抓物体变形时表面形状的方法克服这一限制。此外,由于其近似性质,该方法目前不太适合非常小或非常薄的物体。

总之,通过将最先进的运动跟踪与高保真手表面建模相结合,我们提供了一种在抓取和操作过程中估计手-物体接触区域的方法。在未来的研究中,我们计划部署这种方法来研究和模拟人类的视觉引导抓取行为16。我们进一步计划将这些工具与眼动追踪46,50,51,52和虚拟/增强现实系统53,54,55集成,以研究真实和虚拟自然环境中的视觉引导手和眼球运动运动控制18,46,56,57.由于这些原因,所提出的方法可能会引起研究触觉感知58,运动控制和虚拟和增强现实中人机交互的研究人员的兴趣。最后,对人类抓取能力的准确测量可以为基于交互式感知原理的鲁棒机器人系统的设计提供信息39,40,41,42,43,并可能在上肢假肢中具有转化应用。

披露声明

作者声明不存在相互竞争的利益。

致谢

这项研究由德国研究协会(DFG,德国研究基金会:项目编号222641018-SFB/TRR 135 TP C1和IRTG-1901"大脑在行动")和黑森州高等教育,科学,研究和艺术部卓越计划资助的研究集群"适应性思维"资助。作者感谢Qualisys支持团队,包括Mathias Bankay和Jeffrey Thingvold,为开发我们的方法提供帮助。作者还感谢Michaela Jeschke冒充手模。所有用于重现该方法的数据和分析脚本以及手稿中提供的结果均可在Zenodo(doi:10.5281 / zenodo.7458911)上找到。

材料

| Name | Company | Catalog Number | Comments |

| Anaconda Python distribution | (Anaconda 5.3.1 or later); https://repo.anaconda.com/archive/ | scripts and functions were generated in Python version 3.7 | |

| Autodesk Maya | Autodesk, Inc. | Maya2022; https://www.autodesk.com/products/maya/overview | 3D computer graphics application. |

| Blender | Blender Foundation | Blender 2.92; https://download.blender.org/release/ | 3D computer graphics application. |

| Computer Workstation | N/A | N/A | OS: Windows 10 or higher. |

| DeepHandMesh | Meta Platforms, Inc. (Meta Open Source) | https://github.com/facebookresearch/DeepHandMesh | Pre-trained hand mesh generation tool. |

| Miqus M5 | Qualisys Ab | https://www.qualisys.com/cameras/miqus/ | Passive marker motion tracking camera (8 units). |

| Miqus video camera | Qualisys Ab | https://www.qualisys.com/cameras/miqus-video/ | Color video camera, synchronized with Miquis M5 tracking cameras (6 units). |

| Project repository | N/A | Data and Code Repository | Data and code to replicate the current project. The repository is currently under construction, but we provide a private link where reviewers can download the current and most up-to-date version of the repository. The final repository will be made publicly available upon acceptance. |

| Python 3 | Python Software Foundation | Python Version 3.7 | Python3 and associated built-in libraries. |

| QTM Connect for Maya | Qualisys Ab | https://github.com/qualisys/QTM-Connect-For-Maya | Stream skeleton, rigid bodies and marker data from QTM to Maya |

| QTM Qualisys Track Manager | Qualisys Ab | Qualisys Track Manager 2021.2; https://www.qualisys.com/software/qualisys-track-manager/ | Motion capture software |

| Qualisys SDK for Python | Qualisys Ab | https://github.com/qualisys/qualisys_python_sdk | Implements communication between QTM and Python |

参考文献

- Derzsi, Z., Volcic, R. MOTOM toolbox: MOtion Tracking via Optotrak and Matlab. Journal of Neuroscience Methods. 308, 129-134 (2018).

- Eloka, O., Franz, V. H. Effects of object shape on the visual guidance of action. Vision Research. 51 (8), 925-931 (2011).

- Lederman, S. J., Wing, A. M. Perceptual judgement, grasp point selection and object symmetry. Experimental Brain Research. 152 (2), 156-165 (2003).

- Schettino, L. F., Adamovich, S. V., Poizner, H. Effects of object shape and visual feedback on hand configuration during grasping. Experimental Brain Research. 151 (2), 158-166 (2003).

- Chen, Z., Saunders, J. A. Online processing of shape information for control of grasping. Experimental Brain Research. 233 (11), 3109-3124 (2015).

- Burstedt, M. K., Flanagan, J. R., Johansson, R. S. Control of grasp stability in humans under different frictional conditions during multidigit manipulation. Journal of Neurophysiology. 82 (5), 2393-2405 (1999).

- Paulun, V. C., Gegenfurtner, K. R., Goodale, M. A., Fleming, R. W. Effects of material properties and object orientation on precision grip kinematics. Experimental Brain Research. 234 (8), 2253-2265 (2016).

- Klein, L. K., Maiello, G., Fleming, R. W., Voudouris, D. Friction is preferred over grasp configuration in precision grip grasping. Journal of Neurophysiology. 125 (4), 1330-1338 (2021).

- Mamassian, P. Prehension of objects oriented in three-dimensional space. Experimental Brain Research. 114 (2), 235-245 (1997).

- Paulun, V. C., Kleinholdermann, U., Gegenfurtner, K. R., Smeets, J. B. J., Brenner, E. Center or side: biases in selecting grasp points on small bars. Experimental Brain Research. 232 (7), 2061-2072 (2014).

- Goodale, M. A., et al. Separate neural pathways for the visual analysis of object shape in perception and prehension. Current Biology. 4 (7), 604-610 (1994).

- Kleinholdermann, U., Franz, V. H., Gegenfurtner, K. R. Human grasp point selection. Journal of Vision. 13 (8), 23 (2013).

- Maiello, G., Paulun, V. C., Klein, L. K., Fleming, R. W. Object visibility, not energy expenditure, accounts for spatial biases in human grasp selection. i-Perception. 10 (1), 204166951982760-20 (2019).

- Maiello, G., Schepko, M., Klein, L. K., Paulun, V. C., Fleming, R. W. Humans can visually judge grasp quality and refine their judgments through visual and haptic feedback. Frontiers in Neuroscience. 14, 591898 (2021).

- Klein, L. K., Maiello, G., Paulun, V. C., Fleming, R. W. Predicting precision grip grasp locations on three-dimensional objects. PLoS Computational Biology. 16 (8), 1008081 (2020).

- Maiello, G., Paulun, V. C., Klein, L. K., Fleming, R. W. The sequential-weight illusion. i-Perception. 9 (4), 204166951879027 (2018).

- Chessa, M., Maiello, G., Klein, L. K., Paulun, V. C., Solari, F. Grasping objects in immersive Virtual Reality. 2019 IEEE Conference on Virtual Reality and 3D User Interfaces (VR). , 1749-1754 (2019).

- Crajé, C., Lukos, J. R., Ansuini, C., Gordon, A. M., Santello, M. The effects of task and content on digit placement on a bottle). Experimental Brain Research. 212 (1), 119-124 (2011).

- Lukos, J., Ansuini, C., Santello, M. Choice of contact points during multidigit grasping: Effect of predictability of object center of mass location. Journal of Neuroscience. 27 (14), 3894-3903 (2007).

- Gilster, R., Hesse, C., Deubel, H. Contact points during multidigit grasping of geometric objects. Experimental Brain Research. 217 (1), 137-151 (2012).

- Schot, W. D., Brenner, E., Smeets, J. B. J. Robust movement segmentation by combining multiple sources of information. Journal of Neuroscience Methods. 187 (2), 147-155 (2010).

- Sundaram, S., et al. Learning the signatures of the human grasp using a scalable tactile glove. Nature. 569 (7758), 698-702 (2019).

- Yan, Y., Goodman, J. M., Moore, D. D., Solla, S. A., Bensmaia, S. J. Unexpected complexity of everyday manual behaviors. Nature Communications. 11 (1), 3564 (2020).

- Han, S., et al. Online optical marker-based hand tracking with deep labels. ACM Transactions on Graphics. 37 (4), 1-10 (2018).

- Clouthier, A. L., et al. Development and validation of a deep learning algorithm and open-source platform for the automatic labelling of motion capture markers. IEEE Access. 9, 36444-36454 (2021).

- . Qualisys AB Qualisys Track Manager User Manual (Version 2022.1) Available from: https://www.qualisys.com/ (2022)

- Mathis, A., et al. DeepLabCut: Markerless pose estimation of user-defined body parts with deep learning. Nature Neuroscience. 21 (9), 1281-1289 (2018).

- Moon, G., Shiratori, T., Lee, K. M. DeepHandMesh: A weakly-supervised deep encoder-decoder framework for high-fidelity hand mesh modeling. ECCV 2020. , (2020).

- Smith, B., et al. Constraining dense hand surface tracking with elasticity. ACM Transactions on Graphics. 39 (6), 219 (2020).

- Taheri, O., Ghorbani, N., Black, M. J., Tzionas, D. GRAB: A dataset of whole-body human grasping of objects. Computer Vision - ECCV 2020: 16th European Conference. , 581-600 (2020).

- Brahmbhatt, S., Tang, C., Twigg, C. D., Kemp, C. C., Hays, J. ContactPose: A dataset of grasps with object contact and hand pose. Computer Vision - ECCV 2020. , 361-378 (2020).

- Wang, J., et al. RGB2Hands: Real-time tracking of 3D hand interactions from monocular RGB video. ACM Transactions on Graphics. 39 (6), 218 (2020).

- Zhang, X., Li, Q., Mo, H., Zhang, W., Zheng, W. End-to-end hand mesh recovery from a monocular RGB image. 2019 IEEE/CVF International Conference on Computer Vision (ICCV). , 2354-2364 (2019).

- Endo, Y., Tada, M., Mochimaru, M. Reconstructing individual hand models from motion capture data). Journal of Computational Design and Engineering. 1 (1), 1-12 (2014).

- Mueller, F., et al. GANerated hands for real-time 3D hand tracking from monocular RGB. 2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition. , 49-59 (2018).

- Mueller, F., et al. Real-time pose and shape reconstruction of two interacting hands with a single depth camera. ACM Transactions on Graphics. 38 (4), 49 (2019).

- Romero, J., Tzionas, D., Black, M. J. Embodied hands: Modeling and capturing hands and bodies together. ACM Transactions on Graphics. 36 (6), 245 (2017).

- Kappler, D., Bohg, J., Schaal, S. Leveraging big data for grasp planning. 2015 IEEE International Conference on Robotics and Automation (ICRA). , 4304-4311 (2015).

- Kokic, M., Kragic, D., Bohg, J. Learning task-oriented grasping from human activity datasets). IEEE Robotics and Automation Letters. 5 (2), 3352-3359 (2020).

- Shao, L., et al. UniGrasp: Learning a unified model to grasp with multifingered robotic hands. IEEE Robotics and Automation Letters. 5 (2), 2286-2293 (2020).

- Shao, L., Migimatsu, T., Zhang, Q., Yang, K., Bohg, J. Concept2Robot: Learning manipulation concepts from instructions and human demonstrations. Robotics: Science and Systems XVI. , (2020).

- Bohg, J. Interactive perception: Leveraging action in perception and perception in action. IEEE Transactions on Robotics. 33 (6), 1273-1291 (2017).

- . Blender Foundation Available from: https://www.blender.org (2022)

- Roth, S. D. Ray casting for modeling solids. Computer Graphics and Image Processing. 18 (2), 109-144 (1982).

- Maiello, G., Kwon, M., Bex, P. J. Three-dimensional binocular eye-hand coordination in normal vision and with simulated visual impairment. Experimental Brain Research. 236 (3), 691-709 (2018).

- Weichert, F., Bachmann, D., Rudak, B., Fisseler, D. Analysis of the accuracy and robustness of the leap motion controller. Sensors. 13 (5), 6380-6393 (2013).

- Guna, J., Jakus, G., Pogačnik, M., Tomažič, S., Sodnik, J. An analysis of the precision and reliability of the leap motion sensor and its suitability for static and dynamic tracking. Sensors. 14 (2), 3702-3720 (2014).

- Sheshadri, S., Dann, B., Hueser, T., Scherberger, H. 3D reconstruction toolbox for behavior tracked with multiple cameras. Journal of Open Source Software. 5 (45), 1849 (2020).

- Maiello, G., Harrison, W. J., Bex, P. J. Monocular and binocular contributions to oculomotor plasticity. Scientific Reports. 6, 31861 (2016).

- Caoli, A., et al. A dichoptic feedback-based oculomotor training method to manipulate interocular alignment. Scientific Reports. 10, 15634 (2020).

- Gibaldi, A., Vanegas, M., Bex, P. J., Maiello, G. Evaluation of the Tobii EyeX eye tracking controller and Matlab toolkit for research. Behavior Research Methods. 49 (3), 923-946 (2017).

- Chessa, M., Maiello, G., Borsari, A., Bex, P. J. The Perceptual quality of the Oculus Rift for immersive virtual reality. Human-Computer Interaction. 34 (1), 51-82 (2016).

- Maiello, G., Chessa, M., Bex, P. J., Solari, F. Near-optimal combination of disparity across a log-polar scaled visual field. PLoS Computational Biology. 16 (4), 1007699 (2020).

- Maiello, G., Chessa, M., Solari, F., Bex, P. J. The (in)effectiveness of simulated blur for depth perception in naturalistic images. PLoS One. 10 (10), 0140230 (2015).

- Maiello, G., Chessa, M., Solari, F., Bex, P. J. Simulated disparity and peripheral blur interact during binocular fusion. Journal of Vision. 14 (8), 13 (2014).

- Maiello, G., Kerber, K. L., Thorn, F., Bex, P. J., Vera-Diaz, F. A. Vergence driven accommodation with simulated disparity in myopia and emmetropia. Experimental Eye Research. 166, 96-105 (2018).

- Moscatelli, A., et al. The change in fingertip contact area as a novel proprioceptive cue. Current Biology. 26 (9), 1159-1163 (2016).

转载和许可

请求许可使用此 JoVE 文章的文本或图形

请求许可探索更多文章

This article has been published

Video Coming Soon

版权所属 © 2025 MyJoVE 公司版权所有,本公司不涉及任何医疗业务和医疗服务。