Method Article

Estimación de las regiones de contacto entre las manos y los objetos durante el agarre humano de varios dígitos

En este artículo

Resumen

Cuando agarramos un objeto, múltiples regiones de los dedos y la mano suelen hacer contacto con la superficie del objeto. La reconstrucción de tales regiones de contacto es un desafío. Aquí, presentamos un método para estimar aproximadamente las regiones de contacto combinando la captura de movimiento basada en marcadores con la reconstrucción de malla manual basada en aprendizaje profundo existente.

Resumen

Para agarrar un objeto con éxito, debemos seleccionar las regiones de contacto apropiadas para nuestras manos en la superficie del objeto. Sin embargo, identificar tales regiones es un desafío. Este documento describe un flujo de trabajo para estimar las regiones de contacto a partir de datos de seguimiento basados en marcadores. Los participantes agarran objetos reales, mientras que nosotros rastreamos la posición 3D tanto de los objetos como de la mano, incluidas las articulaciones de los dedos. Primero determinamos los ángulos de Euler de la articulación a partir de una selección de marcadores de orugas colocados en el dorso de la mano. Luego, utilizamos algoritmos de reconstrucción de malla manual de última generación para generar un modelo de malla de la mano del participante en la pose actual y la posición 3D.

El uso de objetos que fueron impresos en 3D o escaneados en 3D, y que, por lo tanto, están disponibles como objetos reales y datos de malla, permite que las mallas de mano y objeto se registren conjuntamente. A su vez, esto permite la estimación de regiones de contacto aproximadas mediante el cálculo de las intersecciones entre la malla manual y la malla de objetos 3D co-registrada. El método se puede utilizar para estimar dónde y cómo los humanos agarran objetos bajo una variedad de condiciones. Por lo tanto, el método podría ser de interés para los investigadores que estudian la percepción visual y háptica, el control motor, la interacción humano-computadora en realidad virtual y aumentada, y la robótica.

Introducción

La capacidad de agarrar y manipular objetos es una habilidad clave que permite a los humanos remodelar el entorno según sus deseos y necesidades. Sin embargo, controlar las manos multiarticuladas de manera efectiva es una tarea desafiante que requiere un sistema de control sofisticado. Este sistema de control motor es guiado por varias formas de entrada sensorial, entre las cuales la visión es primordial. A través de la visión, los individuos pueden identificar los objetos en el entorno y estimar su posición y propiedades físicas y luego pueden alcanzar, agarrar y manipular esos objetos con facilidad. Comprender el complejo sistema que vincula la entrada en las retinas con los comandos motores que controlan las manos es un desafío clave de la neurociencia sensoriomotora. Para modelar, predecir y comprender cómo funciona este sistema, primero debemos poder estudiarlo en detalle. Esto requiere mediciones de alta fidelidad tanto de las entradas visuales como de las salidas del motor manual.

La tecnología de seguimiento de movimiento anterior ha impuesto una serie de limitaciones en el estudio del agarre humano. Por ejemplo, los sistemas que requieren cables conectados a las manos de los participantes1,2 tienden a restringir el rango de movimientos de los dedos, alterando potencialmente los movimientos de agarre o las mediciones mismas. A pesar de tales limitaciones, investigaciones anteriores han podido identificar varios factores que influyen en el agarre guiado visualmente. Algunos de estos factores incluyen la forma del objeto 3,4,5,6, la rugosidad de la superficie 7,8,9 o la orientación de un objeto con respecto a la mano4,8,10. Sin embargo, para superar las limitaciones tecnológicas anteriores, la mayoría de esta investigación previa ha empleado estímulos simples y tareas altamente restringidas, centrándose predominantemente en factores individuales 3,4,6,7,10, agarres de precisión de dos dígitos3,4,6,9,11,12, 13,14,15,16,17,18, objetos individuales19, o formas 2D muy simples 20,21. Se desconoce cómo se generalizan los hallazgos anteriores más allá de tales condiciones de laboratorio reducidas y artificiales. Además, la medición del contacto mano-objeto a menudo se reduce a la estimación de los puntos de contacto de los dígitos22. Esta simplificación puede ser apropiada para describir un pequeño subconjunto de agarres en los que solo las yemas de los dedos están en contacto con un objeto. Sin embargo, en la mayoría de las capturas del mundo real, extensas regiones de los dedos y la palma entran en contacto con un objeto. Además, un estudio reciente23 ha demostrado, utilizando un guante háptico, que los objetos pueden ser reconocidos por la forma en que su superficie incide en la mano. Esto resalta la importancia de estudiar las regiones de contacto extendido entre las manos y los objetos agarrados, no solo los puntos de contacto entre los objetos y las yemas de los dedos22.

Los avances recientes en la captura de movimiento y el modelado manual 3D nos han permitido superar las limitaciones anteriores y estudiar el agarre en toda su complejidad. El seguimiento pasivo del movimiento basado en marcadores ahora está disponible con marcadores de tamaño milimétrico que se pueden unir al dorso de las manos del participante para rastrear los movimientos articulares24. Además, los algoritmos automáticos de identificación de marcadores para sistemas de marcadores pasivos son ahora lo suficientemente robustos como para casi eliminar la necesidad del extenso postprocesamiento manual de los datos de marcadores25,26,27. Las soluciones Markerless también están alcanzando niveles impresionantes de rendimiento en el seguimiento de partes del cuerpo de animales en videos28. Estos métodos de seguimiento del movimiento, por lo tanto, finalmente permiten mediciones confiables y no invasivas de movimientos complejos de múltiples dígitosde la mano 24. Tales mediciones pueden informarnos sobre la cinemática articular y permitirnos estimar los puntos de contacto entre la mano y un objeto. Además, en los últimos años, la comunidad de visión artificial ha estado abordando el problema de construir modelos de las manos humanas que puedan replicar las deformaciones de los tejidos blandos durante el agarre de objetos e incluso durante el contacto personal entre las partes de la mano 29,30,31,32. Tales reconstrucciones de malla 3D pueden derivarse de diferentes tipos de datos, como secuencias de video 33,34, articulaciones esqueléticas (derivadas de35 basado en marcadores o seguimiento sin marcador36) e imágenes de profundidad37. El primer avance clave en este dominio fue proporcionado por Romero et al.38, quienes derivaron un modelo paramétrico de mano (MANO) a partir de más de 1.000 escaneos manuales de 31 sujetos en diversas poses. El modelo contiene parámetros tanto para la pose como para la forma de la mano, lo que facilita la regresión de diferentes fuentes de datos a una reconstrucción completa de la mano. La solución más reciente DeepHandMesh29 se basa en este enfoque mediante la construcción de un modelo parametrizado a través del aprendizaje profundo y mediante la adición de evitación de penetración, que replica con mayor precisión las interacciones físicas entre las partes de la mano. Al combinar tales reconstrucciones de malla manual con mallas de objetos rastreados en 3D, ahora es posible estimar las regiones de contacto no solo en la superficie de los objetos32 sino también en la superficie de la mano.

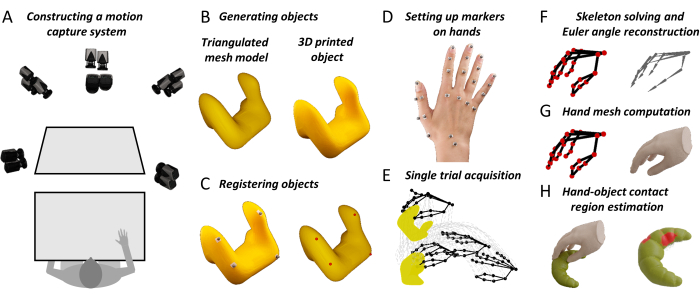

Aquí, proponemos un flujo de trabajo que reúne el seguimiento 3D de alta fidelidad de objetos y articulaciones de mano con nuevos algoritmos de reconstrucción de malla manual. El método produce mapas detallados de superficies de contacto mano-objeto. Estas mediciones ayudarán a los neurocientíficos sensoriomotores a ampliar nuestra comprensión teórica del agarre guiado visualmente humano. Además, el método podría ser útil para los investigadores en campos adyacentes. Por ejemplo, los investigadores del factor humano pueden usar este método para construir mejores sistemas de interfaz hombre-máquina en realidad virtual y aumentada18. Las mediciones de alta fidelidad de los comportamientos de agarre humano también pueden ayudar a los roboticistas a diseñar sistemas de agarre robóticos inspirados en el ser humano basados en los principios de la percepción interactiva 39,40,41,42,43. Por lo tanto, esperamos que este método ayude a avanzar en la investigación de comprensión en los campos de la neurociencia y la ingeniería, desde descripciones dispersas de tareas altamente restringidas hasta caracterizaciones más completas de comportamientos de agarre naturalistas con objetos complejos y tareas del mundo real. El enfoque general se describe en la Figura 1.

Figura 1: Pasos clave en el método propuesto . (A) Las cámaras de captura de movimiento toman imágenes de un banco de trabajo desde múltiples ángulos. (B) Un objeto de estímulo se imprime en 3D a partir de un modelo de malla triangulada. (C) Cuatro marcadores reflectantes esféricos están pegados a la superficie del objeto real. Un procedimiento semiautomatizado identifica cuatro puntos correspondientes en la superficie del objeto de malla. Esta correspondencia nos permite rotar-traducir el modelo de malla a la posición 3D rastreada del objeto real. (D) Los marcadores reflectantes se fijan a diferentes puntos de referencia en el dorso de la mano de un participante con cinta adhesiva de doble cara. (E) El sistema de captura de movimiento adquiere las trayectorias en el espacio 3D del objeto rastreado y los marcadores de mano durante una sola prueba. (F) Un esqueleto de mano específico del participante se construye utilizando software de gráficos por computadora 3D. Las posturas de la articulación esquelética se estiman para cada fotograma de cada ensayo en un experimento a través de la cinemática inversa. (G) Las poses conjuntas se introducen en una versión modificada de DeepHandMesh29, que genera una malla de mano 3D estimada en la pose y posición 3D actuales. (H) Finalmente, usamos la intersección de malla para calcular las regiones de contacto mano-objeto. Haga clic aquí para ver una versión más grande de esta figura.

Protocolo

Antes de comenzar un experimento, los participantes deben dar su consentimiento informado de acuerdo con las directrices institucionales y la Declaración de Helsinki. Todos los protocolos descritos aquí han sido aprobados por el comité de ética local de la Universidad Justus Liebig de Giessen (LEK-FB06).

1. Instalación de todo el software necesario

- Descargue el repositorio del proyecto en Data and Code Repository.

- Instale el software que aparece en la Tabla de materiales (tenga en cuenta las versiones de software y siga los enlaces para obtener opciones de compra e instrucciones).

- En el repositorio de datos y código, abra una ventana de comandos y ejecute el siguiente comando:

conda env create -f environment.yml - Descargue e instale la instancia de DeepHandMesh29 previamente entrenada siguiendo las instrucciones proporcionadas en https://github.com/facebookresearch/DeepHandMesh.

- Coloque DeepHandMesh en la carpeta "deephandmesh" del repositorio de datos y código. Reemplace el archivo "main/model.py" por el archivo model.py contenido en el repositorio de datos y códigos.

2. Preparación del sistema de captura de movimiento

- Coloque un entorno de trabajo dentro de un volumen de seguimiento fotografiado desde múltiples ángulos por cámaras de seguimiento de movimiento dispuestas en un marco que rodea el espacio de trabajo (Figura 1A). Prepare marcadores reflectantes colocando cinta adhesiva de doble cara en la base de cada marcador.

- Ejecute Qualisys Track Manager (QTM) como administrador.

NOTA: La ejecución de QTM como administrador es necesaria para que el SDK de Python tome el control de la interfaz QTM. Recomendamos ejecutar QTM siempre como administrador.

3. Calibración de las cámaras

- Coloque el objeto de calibración en forma de L dentro del volumen de seguimiento.

- Dentro del QTM, haga clic en Calibrar en el menú Capturar, o pulse el icono de varita en la barra de herramientas Capturar. Espere a que se abra una ventana de calibración. Seleccione la duración de la calibración y pulse OK.

- Mueva la varita de calibración a través del volumen de seguimiento durante la duración de la calibración. Pulse el botón Exportar y especifique una ruta de archivo en la que exportar la calibración como un archivo de texto. Acepte la calibración pulsando OK.

4. Creación de un objeto de estímulo

- Construir un modelo de objetos 3D virtual en forma de malla poligonal. Utilice una impresora 3D para construir una réplica física del modelo de objetos.

NOTA: El repositorio de datos del paso 1.1 proporciona objetos de ejemplo en formatos de archivo STL y Wavefront OBJ. Los objetos en formato STL son múltiples y están listos para la impresión 3D.

5. Preparación del objeto de estímulo

- Coloque cuatro marcadores reflectantes no planos en la superficie del objeto real. Coloque el objeto dentro del volumen de seguimiento.

- En el repositorio del proyecto, ejecute el script de Python "Acquire_Object.py". Siga las instrucciones proporcionadas por el script para realizar una captura de 1 s de la posición 3D de los marcadores de objeto.

- Seleccione todos los marcadores del cuerpo rígido. Haga clic derecho y seleccione Definir cuerpo rígido (6DOF) | Marco actual. Introduzca el nombre del cuerpo rígido y pulse OK.

- En el menú Archivo , seleccione Exportar | A TSV. En la nueva ventana, marque las casillas 3D, 6D y Esqueleto en la configuración del tipo de datos . Marque todas las casillas en la configuración general . Presione OK y luego Guardar.

6. Co-registro de versiones reales y modelo de malla del objeto de estímulo

- Abra Blender y navegue hasta el área de trabajo Scripting . Abra el archivo "Object_CoRegistration.py" y presione Ejecutar. Desplázate hasta el espacio de trabajo Diseño y pulsa n para alternar la barra lateral. Dentro de la barra lateral, navega hasta la pestaña Personalizado .

- Seleccione el archivo .obj que desea registrar conjuntamente y pulse el botón Cargar objeto .

- Seleccione el archivo de trayectoria que se exportó en el paso 3.3 y especifique los nombres de los marcadores adjuntos al objeto rígido separados por punto y coma. En el encabezado Marcador, especifique la línea del archivo de trayectoria que contiene los nombres de columna de los datos (el recuento comienza en 0).

- Seleccione el archivo de cuerpo rígido correspondiente con el sufijo 6D y especifique el nombre del cuerpo rígido definido en el paso 4.1. En el encabezado 6D, especifique la línea en el archivo de cuerpo rígido que contiene los nombres de columna de los datos.

- Presione Cargar marcadores. Traduzca y gire el objeto Markers y/o el objeto Object para alinearlos. Especifique un archivo de salida de malla y presione Ejecutar registro conjunto. Esto generará un archivo .obj que contiene la malla de estímulo co-registrada.

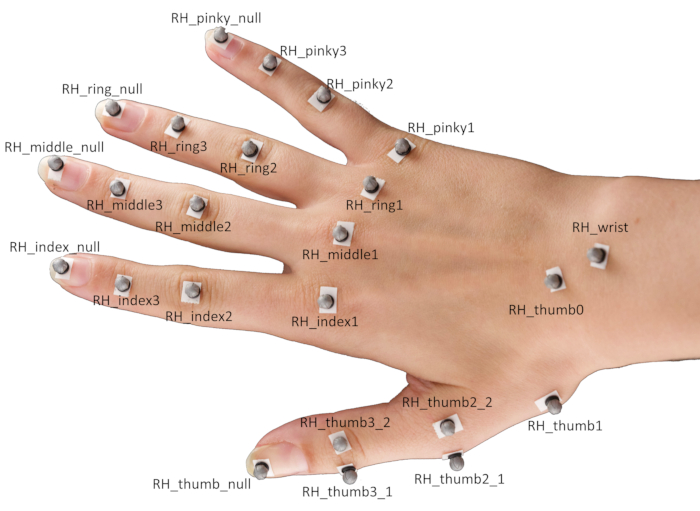

7. Colocación de marcadores en las manos

- Coloque 24 marcadores reflectantes esféricos en diferentes puntos de referencia de la mano de un participante con cinta adhesiva de doble cara.

NOTA: El posicionamiento específico de los marcadores se muestra en la Figura 2.- Coloque los marcadores centralmente en la parte superior de las yemas de los dedos respectivos, así como las articulaciones interfalángicas distales, las articulaciones interfalángicas proximales y las articulaciones metacarpofalángicas del dedo índice, el dedo medio, el anular y el dedo meñique.

- Para el pulgar, coloque un marcador en la yema del dedo y la articulación carpometacarpiana basal, así como un par de marcadores en cada una de las articulaciones metacarpofalángicas e interfalángicas.

NOTA: Estos pares de marcadores deben desplazarse en direcciones opuestas perpendiculares al eje principal del pulgar y son necesarios para estimar la orientación del pulgar. - Finalmente, coloque marcadores en el centro de la muñeca y en la articulación escatorapeziotrapezoidal.

Figura 2: Colocación del marcador en la mano de un participante. Abreviatura: RH = mano derecha. Haga clic aquí para ver una versión más grande de esta figura.

8. Adquisición de un único ensayo

- Pida al participante que coloque su mano plana sobre el banco de trabajo con la palma hacia abajo y que cierre los ojos. Coloque el objeto de estímulo en el banco de trabajo frente al participante.

- Mientras se ejecuta el QTM, ejecute el script de Python "Single_Trial_Acquisition.py" en el repositorio del proyecto. Siga las instrucciones proporcionadas por el guión para capturar una sola prueba del participante agarrando el objeto de estímulo.

NOTA: El guión producirá una señal auditiva. Esto le indicará al participante que abra los ojos y ejecute el agarre. En nuestras demostraciones, la tarea es alcanzar y agarrar el objeto objetivo, levantarlo verticalmente aproximadamente 10 cm, colocarlo y devolver la mano a su posición inicial.

9. Etiquetado de los marcadores

- Dentro del QTM, arrastre y suelte las trayectorias de marcadores individuales de Trayectorias no identificadas a Trayectorias etiquetadas , y etiquételas de acuerdo con la convención de nomenclatura de la Figura 2.

- Seleccione todos los marcadores adjuntos a la mano, haga clic con el botón derecho y seleccione Generar modelo AIM a partir de la selección. En la nueva ventana, seleccione Crear nuevo modelo basado en conexiones de marcador del modelo AIM existente y pulse el botón Siguiente .

- Seleccione la definición del modelo RH_FH y pulse Abrir. Pulse Siguiente, introduzca un nombre para el modelo AIM y pulse OK. Finalmente, presione Finalizar para crear un modelo AIM para la mano del participante, que se utilizará para identificar automáticamente marcadores en ensayos sucesivos del mismo participante.

10. Crear una definición de esqueleto personalizada para el participante

- En QTM, vaya al menú Reproducir y seleccione Reproducir con salida en tiempo real.

- Maya abierto. Desplácese hasta el estante de QTM Connect y pulse el icono Conectar a QTM. En la nueva ventana, marque Marcadores y pulse Conectar. Ahora, pulse el icono Play en el estante de QTM Connect.

- Pulse Mayús y seleccione todos los marcadores de mano y pulse el icono Localizadores de lavado . Seleccione los marcadores de manos lavadas y presione Ctrl + G. Esto creará un nodo de grupo. Asigne al grupo el nombre Marcadores.

- Seleccione todos los marcadores de mano. En el menú Modificar , haga clic en Buscar y reemplazar nombres. Busque el prefijo RH_ y elimine el prefijo de los marcadores.

- Pulse el icono Import Solver en el estante de QTM Connect . Cargue la definición de esqueleto "RH_FH.xml".

- En el menú Windows , vaya a Editores generales | Editor de espacio de nombres. Dentro de la nueva ventana, haga clic en :(raíz) y presione Nuevo para crear un nuevo espacio de nombres, RH. Haga clic en el espacio de nombres RH , presione Nuevo y asígnele al nuevo espacio de nombres el nombre ModelPose.

- Seleccione todos los marcadores, haga clic en el espacio de nombres RH y presione Agregar seleccionados para agregar los marcadores al espacio de nombres RH.

- Seleccione los huesos del esqueleto, haga clic en el espacio de nombres ModelPose y presione Agregar seleccionados para agregar los huesos del esqueleto al espacio de nombres ModelPose.

- Gire, traduzca y escale el esqueleto para que se ajuste a los datos del marcador. A continuación, para cada articulación del esqueleto individualmente, Mayús + Seleccione la articulación del esqueleto y sus marcadores asociados, y presione el icono Agregar archivos adjuntos . Finalmente, presione el icono Exportar Solver para exportar la nueva definición de esqueleto a un archivo XML que se puede cargar en el QTM (consulte el siguiente paso).

NOTA: Este paso no es estrictamente necesario, pero es útil para aumentar la precisión del ajuste del esqueleto a los datos del marcador. Lea la Guía de inicio rápido de QSolverQuickstart en https://github.com/qualisys/QTM-Connect-For-Maya para obtener más información.

11. Reconstruir las posturas de la articulación esquelética articular

- Dentro del QTM, abra la configuración del proyecto pulsando el icono de la rueda dentada . En la barra lateral, navega hasta Skeleton Solver y presiona Cargar para seleccionar un archivo de definición de esqueleto. Ajuste el factor de escala al 100% y pulse Aplicar.

- Vaya a TSV Export y marque las casillas 3D, 6D y Skeleton en la configuración del tipo de datos . Marque todas las casillas en la configuración general . Presione Aplicar y cierre la configuración del proyecto.

- Presione el icono Reprocesar, marque las casillas Resolver esqueletos y Exportar a archivo TSV, y presione OK.

12. Generación de reconstrucciones de malla manual

- Abra una ventana de comandos en el repositorio del proyecto y active el entorno conda ejecutando el comando:

conda activar regiones de contacto - A continuación, ejecute el siguiente comando y siga las instrucciones proporcionadas por el script para generar, para cada fotograma de la prueba, una malla de mano que reconstruya la pose de mano actual.

python Hand_Mesh_Reconstruction.py --gpu 0 --test_epoch 4

NOTA: Estas reconstrucciones de malla se generan automáticamente utilizando una versión modificada de la herramienta de generación de malla manual de código abierto y preentrenada, DeepHandMesh29.

13. Generación de estimaciones de región de contacto mano-objeto

- Abra una ventana de comandos en el repositorio del proyecto, ejecute el siguiente comando y siga las instrucciones proporcionadas por el script para generar estimaciones de la región de contacto de manos y objetos calculando la intersección entre las mallas de mano y objeto.

blender --background --python "Contact_Region_Estimation.py"

Resultados

El primer requisito para el método propuesto es un sistema para rastrear con precisión la posición de los objetos y las manos 3D. La configuración específica se muestra en la Figura 1A y utiliza hardware y software producidos por la empresa de captura de movimiento Qualisys. Colocamos un banco de trabajo dentro de un volumen de seguimiento (100 cm x 100 cm x 100 cm), que se visualiza desde múltiples ángulos mediante ocho cámaras de seguimiento y seis cámaras de video dispuestas en un marco cúbico que rodea el espacio de trabajo. Las cámaras de seguimiento rastrean la posición 3D de los marcadores reflectantes dentro del volumen de seguimiento a 180 cuadros / s y con resolución espacial 3D submilimétrica. Empleamos marcadores reflectantes de 4 mm, que se unen a los objetos y las manos utilizando cinta adhesiva de doble cara amigable con la piel. Las posiciones de los marcadores 3D son procesadas por el software de captura de movimiento. La sección de discusión también revisa los sistemas alternativos de captura de movimiento que podrían emplearse con el método propuesto.

Para obtener reconstrucciones 3D precisas de objetos reales que se agarran y manipulan, proponemos dos opciones. La primera, que es la que se adopta aquí, es partir de un modelo de objetos 3D virtual en forma de malla poligonal. Dichos modelos 3D pueden construirse utilizando el software apropiado (por ejemplo, Blender 3D44) y luego imprimirse en 3D (Figura 1B). La segunda opción es tomar un objeto 3D real existente y utilizar la tecnología de escaneo 3D para construir una réplica de modelo de malla del objeto. Cualquiera que sea la estrategia, el objetivo final es obtener tanto un objeto 3D real como el modelo de malla de objetos 3D virtual correspondiente. Cabe destacar que el enfoque descrito aquí funciona solo con objetos rígidos (es decir, no deformables).

Una vez que la superficie 3D de un objeto está disponible como modelo de malla, su posición debe ser rastreada y co-registrada (Figura 1C). Para ello, se adjuntan cuatro marcadores reflectantes no planos a la superficie del objeto real, y el objeto se coloca dentro del volumen de seguimiento. Las posiciones 3D de los marcadores de objetos se capturan brevemente. Esta captura se utiliza para establecer la correspondencia entre los cuatro marcadores y los cuatro vértices del modelo de malla de objetos. Esto se hace utilizando una ruta de software ad hoc simple escrita en la API Python de Blender. Dentro de la ventana gráfica de Blender, el programa presenta el objeto virtual junto con las posiciones del marcador que se representan como un solo objeto de malla compuesto por una esfera para cada marcador. El usuario puede rotar y traducir el objeto y / o los marcadores para alinearlos de tal manera que se alineen con los marcadores reales colocados en el objeto real. El programa registrará las rotaciones y la traslación que se aplican para calcular una sola roto-traslación que finalmente se aplica a la malla del objeto original, proporcionando una malla de objetos que se co-registra con la definición de cuerpo rígido en QTM.

Una vez establecida la correspondencia, cada vez que el objeto real se mueve dentro del volumen de seguimiento, el objeto virtual se puede colocar en la nueva posición calculando la roto-traducción entre los marcadores rastreados y los cuatro vértices de malla correspondientes. Para registrar la dinámica de la empuñadura, un total de 24 marcadores reflectantes esféricos se adjuntan en diferentes puntos de referencia de la mano utilizando cinta de doble cara (Figura 1D y Figura 2).

Al comienzo de una prueba (Figura 1E), un participante coloca su mano plana en el banco de trabajo con la palma hacia abajo y cierra los ojos. El experimentador coloca un objeto objetivo en el banco de trabajo frente al participante. A continuación, una señal auditiva le indica al participante que abra los ojos y ejecute el agarre. En nuestras demostraciones, la tarea es alcanzar y agarrar el objeto objetivo, levantarlo verticalmente aproximadamente 10 cm, colocarlo y devolver la mano a su posición inicial. Un script escrito en Python 3.7 controla el experimento. En cada prueba, el script selecciona y comunica la configuración de condición actual al experimentador (por ejemplo, identidad y posicionamiento del objeto). El guión también controla el tiempo de prueba, incluidas las señales auditivas y el inicio y la parada de las grabaciones de captura de movimiento.

Las extremidades no solo se caracterizan por su posición en el espacio 3D, sino también por su postura. Por lo tanto, para obtener una reconstrucción 3D completa de una mano humana ejecutando un agarre real, requerimos no solo las posiciones de cada articulación en el espacio 3D, sino también la pose relativa (traslación y rotación) de cada articulación con respecto a su articulación madre (Figura 1F). Las posiciones y orientaciones de la articulación esquelética se pueden inferir a partir de las posiciones de los marcadores utilizando cinemática inversa. Para ello, aquí empleamos el solucionador de esqueletos proporcionado por el software QTM. Para que el solucionador funcione, primero debemos proporcionar una definición de esqueleto que vincule la posición y orientación de cada articulación a múltiples posiciones de marcador. Por lo tanto, se construye una definición de esqueleto, y la plataforma de esqueleto se vincula a los datos del marcador utilizando el complemento QTM Connect para Maya. Creamos definiciones de esqueleto personalizadas para cada participante para maximizar la precisión de los ajustes del esqueleto a los datos del marcador. Para cada participante, ajustamos manualmente un esqueleto de mano a un solo cuadro de datos de captura de movimiento. Una vez obtenida una definición de esqueleto específica del participante, ejecutamos el solucionador de esqueletos para estimar las posturas de la articulación esquelética para cada fotograma de cada ensayo en el experimento.

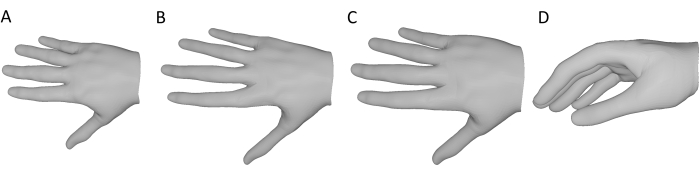

Para cada fotograma de cada ensayo en un experimento, generamos una malla de mano que reconstruye la pose de mano actual utilizando la herramienta de generación de malla manual de código abierto y preentrenada, DeepHandMesh28 (Figura 1G). DeepHandMesh es una red profunda de codificador-decodificador que genera mallas manuales personalizadas a partir de imágenes. Primero, el codificador estima la pose de una mano dentro de una imagen (es decir, los ángulos de Euler conjuntos). Luego, la pose de mano estimada y un vector de identificación personalizado se ingresan en el decodificador, que estima un conjunto de tres correctivos aditivos para una malla de plantilla manipulada. Finalmente, la malla de la plantilla se deforma de acuerdo con la postura de la mano estimada y los correctivos utilizando el pelado de mezcla lineal. El primer correctivo es un correctivo de esqueleto dependiente de ID a través del cual se ajusta la plataforma esquelética para incorporar las posiciones articulares específicas de la persona. Los otros dos correctivos son correctivos de malla a través de los cuales se ajustan los vértices de malla para representar mejor la superficie de la mano del participante. Uno de los correctivos de malla es un correctivo de malla dependiente de ID que explica la estructura de la superficie de la mano de un participante individual. En cambio, el corrector de malla final es un correctivo de vértice dependiente de la pose que explica las deformaciones de la superficie de la mano debido a la postura actual de la mano.

DeepHandMesh se entrena utilizando una supervisión débil con puntos clave conjuntos 2D y mapas de profundidad de escena. Aquí, usamos solo el decodificador DeepHandMesh previamente entrenado para generar reconstrucciones de malla manual, modificadas de las siguientes maneras (Figura 3). En primer lugar, como la red no está capacitada en participantes específicos, se emplea el correctivo de malla genérico dependiente de la identificación proporcionado con el modelo preentrenado (Figura 3A). Además, el correctivo de esqueleto dependiente de ID se deriva utilizando el solucionador de esqueletos QTM como se describió anteriormente (Figura 3B). Se asume la escala proporcional de la mano con la longitud del esqueleto, y el grosor de la malla se escala uniformemente por un factor derivado de la escala relativa del esqueleto tal que la malla se aproxima mejor al tamaño de la mano del participante (Figura 3C). Esta malla modificada se introduce en el decodificador, junto con la postura actual de la mano (derivada de los datos del marcador) y la posición y orientación 3D de la muñeca. El decodificador, por lo tanto, calcula el correctivo dependiente de la pose actual, aplica todos los correctivos y las rototraducciones, y genera una reconstrucción de malla manual 3D de la pose de mano actual en el mismo marco de coordenadas que la malla de objetos rastreados 3D (Figura 3D).

Figura 3: Modificaciones en el decodificador DeepHandMesh previamente entrenado . (A) Correctivo de malla fijo y genérico dependiente de la identificación. (B) correctivo del esqueleto dependiente de ID derivado a través de cinemática inversa en el paso 10. (C) El tamaño de la malla de mano se escala por el mismo factor que las articulaciones esqueléticas. (D) Reconstrucción final de malla de mano 3D de la pose de mano actual. Haga clic aquí para ver una versión más grande de esta figura.

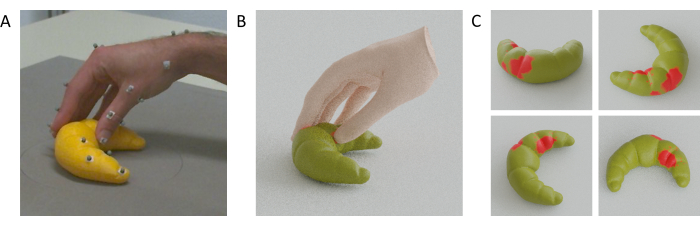

Después de haber reconstruido modelos de malla 3D tanto para la mano de un participante como para un objeto agarrado, las regiones de contacto mano-objeto se pueden estimar calculando la intersección entre la mano y las mallas del objeto (Figura 1H). La suposición detrás de esto es que la mano real se deforma por contacto con la superficie, lo que significa que el esqueleto puede acercarse a la superficie de lo que sería posible si la mano fuera rígida, lo que permite que partes de la malla de la mano pasen a través de la malla del objeto. Como resultado, las áreas de contacto se pueden aproximar como las regiones de superposición entre las dos mallas.

Específicamente, para calcular estas regiones de superposición, definimos los vértices de malla de objetos que están contenidos dentro del volumen 3D de la malla manual como en contacto con la mano. Estos vértices se identifican utilizando un enfoque estándar de trazadode rayos 45. Para cada vértice de la malla del objeto, se proyecta un rayo desde ese vértice a un punto 3D arbitrario fuera de la malla de mano. Luego evaluamos el número de intersecciones que ocurren entre el rayo fundido y los triángulos que componen la superficie de la mano. Si el número de intersecciones es impar, el vértice del objeto está contenido dentro de la malla de mano. Si el número de intersecciones es par, entonces el vértice del objeto está fuera de la malla de mano. Las regiones de contacto en la superficie del objeto pueden, por lo tanto, aproximarse como el conjunto de caras triangulares cuyos vértices están todos contenidos dentro de la malla de la mano. Podemos aplicar el mismo razonamiento a los vértices de la malla de mano contenidos en el volumen 3D de la malla de objetos para estimar las regiones de contacto en la superficie de la mano. En particular, también podrían utilizarse enfoques más avanzados para las operaciones de malla booleana31.

El video 1 muestra un video de una mano, puntos rastreados y malla co-registrada, todos moviéndose uno al lado del otro durante un solo agarre a una figura de gato impresa en 3D. En cambio, la Figura 4A muestra un solo marco en el momento del contacto mano-objeto desde un agarre a un croissant impreso en 3D, junto con las reconstrucciones de malla mano-objeto (Figura 4B) y las regiones de contacto estimadas en la superficie del croissant (Figura 4C).

Figura 4: Regiones estimadas de contacto mano-objeto. (A) Mano y objeto rastreados vistos desde una de las cámaras de seguimiento durante un agarre. (B) Malla de mano reconstruida y malla de objetos rastreados renderizados desde el mismo punto de vista que la cámara de rastreo. (C) Regiones de contacto en la superficie del objeto visto desde múltiples puntos de vista. Haga clic aquí para ver una versión más grande de esta figura.

Video 1: Reconstrucciones de malla de la mano y el objeto. Animación Gif de la mano, marcadores rastreados y las reconstrucciones de malla de manos y objetos durante un solo agarre visto desde el mismo punto de vista de la cámara. Haga clic aquí para descargar este video.

Discusión

Proponemos un método que permite la estimación de regiones de contacto para interacciones mano-objeto durante agarres de varios dígitos. Como el seguimiento completo de toda la superficie de una mano es actualmente intratable, proponemos usar una reconstrucción de una malla de mano cuya postura está determinada por puntos clave dispersos en la mano. Para rastrear estos puntos clave dispersos, nuestra solución emplea un sistema de captura de movimiento de grado de investigación basado en el seguimiento pasivo de marcadores. Por supuesto, otros sistemas de captura de movimiento también podrían emplearse con el método propuesto, siempre que produzcan datos de posición 3D suficientemente precisos. Desaconsejamos los sistemas de captura de movimiento de marcadores activos (como el popular pero descontinuado Optotrak Certus), ya que requieren conectar cables y / o dispositivos electrónicos a las manos de los participantes, lo que puede restringir los movimientos o al menos producir agarres menos típicos a medida que los participantes son más conscientes de la pose de sus manos. Los guantes de seguimiento de movimiento que utilizan unidades de medición inercial pueden ser una posibilidad, aunque se sabe que estos sistemas sufren de deriva, también pueden restringir los movimientos de la mano y no permiten que la superficie de la mano entre en contacto total y directo con las superficies del objeto. Las soluciones comerciales de seguimiento manual sin marcadores (por ejemplo, el Leap Motion46,47,48) también pueden ser una posibilidad, aunque puede que no sea posible rastrear las posiciones de los objetos solo con estos sistemas. La opción alternativa más prometedora a un sistema de captura de movimiento de grado de investigación está dada por soluciones de seguimiento sin marcadores de código abierto (por ejemplo, Mathis et al.28). Si se utilizan con múltiples cámaras co-registradas49, tales sistemas podrían rastrear las posiciones de las articulaciones de la mano y las posiciones de los objetos en 3D sin la necesidad de marcadores, guantes o cables. Sin embargo, estas soluciones, así como este sistema basado en marcadores, pueden sufrir problemas de pérdida de datos debido a oclusiones.

Limitaciones y direcciones futuras

Como las reconstrucciones a mano obtenidas a través de este método no serán completamente precisas, existen algunas limitaciones en los tipos de experimentos para los que se debe usar el método. Las desviaciones en las reconstrucciones de malla manual de la verdad del suelo se manifestarán en desviaciones en las regiones estimadas de contacto mano/objeto. Por lo tanto, la aplicación de este método para derivar medidas absolutas requeriría evaluar la fidelidad de las estimaciones de la región de contacto. Sin embargo, incluso las estimaciones aproximadas pueden ser útiles en diseños experimentales dentro del participante porque es probable que los posibles sesgos del método afecten diferentes condiciones experimentales dentro de un participante de manera similar. Por lo tanto, los análisis estadísticos y las inferencias deben realizarse solo en medidas tales como las diferencias en el área de contacto entre las condiciones, donde la dirección de un efecto se correlacionará con la verdad del terreno respectiva. En futuras investigaciones, planeamos validar aún más nuestro enfoque, por ejemplo, comparando las estimaciones de la región de contacto con las huellas térmicas en objetos cubiertos de pintura termocrómica.

La mayoría de los pasos de procesamiento desde la recopilación de datos hasta la estimación final de la región de contacto están completamente automatizados y, por lo tanto, ofrecen contribuciones importantes hacia un procedimiento estandarizado para la estimación de la región de contacto mano-objeto. Sin embargo, un ajuste inicial de los esqueletos individualizados a las posiciones 3D de los marcadores rastreados aún debe realizarse manualmente para obtener una definición de esqueleto para cada participante. A medida que aumenta el número de participantes para un experimento, también lo hace el número de ajustes manuales, y este es actualmente el paso que más tiempo consume en el procedimiento y requiere cierta familiaridad con el aparejo manual en el software Autodesk Maya. En el futuro, nuestro objetivo es automatizar este paso para evitar la influencia humana en el procedimiento mediante la adición de un procedimiento automático de calibración del esqueleto.

El flujo de trabajo descrito aquí se basa en el hardware y software de Qualisys (por ejemplo, el solucionador de esqueleto QTM). Esto actualmente limita la accesibilidad de nuestro método a laboratorios que tienen una configuración similar. En principio, sin embargo, el método se puede aplicar a cualquier fuente de datos de captura de movimiento. Para ampliar la accesibilidad, en el trabajo en curso, estamos explorando alternativas que deberían generalizar nuestro flujo de trabajo y hacerlo menos dependiente de licencias específicas de hardware y software.

Otra limitación importante del método es que, en su forma actual, solo se puede aplicar a objetos rígidos (no deformables). En el futuro, esta limitación podría superarse utilizando métodos para registrar la forma de la superficie del objeto agarrado a medida que se deforma. Además, debido a su naturaleza aproximada, el método no es actualmente adecuado para objetos muy pequeños o delgados.

En conclusión, al integrar el seguimiento de movimiento de última generación con el modelado de superficie de la mano de alta fidelidad, proporcionamos un método para estimar las regiones de contacto mano-objeto durante el agarre y la manipulación. En futuras investigaciones, planeamos implementar este método para investigar y modelar el comportamiento de agarre guiado visualmente en humanos16. Además, planeamos integrar estas herramientas con el seguimiento ocular 46,50,51,52 y sistemas de realidad virtual / aumentada 53,54,55 para investigar el control motor de movimiento visual guiado de manos y ojos en entornos naturalistas reales y virtuales 18,46,56,57 . Por estas razones, el método propuesto podría ser de interés para los investigadores que estudian la percepción háptica58, el control motor y la interacción humano-computadora en realidad virtual y aumentada. Finalmente, las mediciones precisas de las habilidades de agarre humanas podrían informar el diseño de sistemas robóticos robustos basados en los principios de la percepción interactiva 39,40,41,42,43 y pueden tener aplicaciones traslacionales para prótesis de extremidades superiores.

Divulgaciones

Los autores declaran que no existen intereses contrapuestos.

Agradecimientos

Esta investigación fue financiada por Deutsche Forschungsgemeinschaft (DFG, Fundación Alemana de Investigación: proyecto No. 222641018-SFB / TRR 135 TP C1 e IRTG-1901 "El cerebro en acción") y por el Grupo de Investigación "La mente adaptativa" financiado por el Programa de Excelencia del Ministerio de Educación Superior, Ciencia, Investigación y Arte de Hesse. Los autores agradecen al equipo de soporte de Qualisy, incluidos Mathias Bankay y Jeffrey Thingvold, por su ayuda en el desarrollo de nuestros métodos. Los autores también agradecen a Michaela Jeschke por hacerse pasar por la modelo de mano. Todos los datos y guiones de análisis para reproducir el método y los resultados presentados en el manuscrito están disponibles en Zenodo (doi: 10.5281/zenodo.7458911).

Materiales

| Name | Company | Catalog Number | Comments |

| Anaconda Python distribution | (Anaconda 5.3.1 or later); https://repo.anaconda.com/archive/ | scripts and functions were generated in Python version 3.7 | |

| Autodesk Maya | Autodesk, Inc. | Maya2022; https://www.autodesk.com/products/maya/overview | 3D computer graphics application. |

| Blender | Blender Foundation | Blender 2.92; https://download.blender.org/release/ | 3D computer graphics application. |

| Computer Workstation | N/A | N/A | OS: Windows 10 or higher. |

| DeepHandMesh | Meta Platforms, Inc. (Meta Open Source) | https://github.com/facebookresearch/DeepHandMesh | Pre-trained hand mesh generation tool. |

| Miqus M5 | Qualisys Ab | https://www.qualisys.com/cameras/miqus/ | Passive marker motion tracking camera (8 units). |

| Miqus video camera | Qualisys Ab | https://www.qualisys.com/cameras/miqus-video/ | Color video camera, synchronized with Miquis M5 tracking cameras (6 units). |

| Project repository | N/A | Data and Code Repository | Data and code to replicate the current project. The repository is currently under construction, but we provide a private link where reviewers can download the current and most up-to-date version of the repository. The final repository will be made publicly available upon acceptance. |

| Python 3 | Python Software Foundation | Python Version 3.7 | Python3 and associated built-in libraries. |

| QTM Connect for Maya | Qualisys Ab | https://github.com/qualisys/QTM-Connect-For-Maya | Stream skeleton, rigid bodies and marker data from QTM to Maya |

| QTM Qualisys Track Manager | Qualisys Ab | Qualisys Track Manager 2021.2; https://www.qualisys.com/software/qualisys-track-manager/ | Motion capture software |

| Qualisys SDK for Python | Qualisys Ab | https://github.com/qualisys/qualisys_python_sdk | Implements communication between QTM and Python |

Referencias

- Derzsi, Z., Volcic, R. MOTOM toolbox: MOtion Tracking via Optotrak and Matlab. Journal of Neuroscience Methods. 308, 129-134 (2018).

- Eloka, O., Franz, V. H. Effects of object shape on the visual guidance of action. Vision Research. 51 (8), 925-931 (2011).

- Lederman, S. J., Wing, A. M. Perceptual judgement, grasp point selection and object symmetry. Experimental Brain Research. 152 (2), 156-165 (2003).

- Schettino, L. F., Adamovich, S. V., Poizner, H. Effects of object shape and visual feedback on hand configuration during grasping. Experimental Brain Research. 151 (2), 158-166 (2003).

- Chen, Z., Saunders, J. A. Online processing of shape information for control of grasping. Experimental Brain Research. 233 (11), 3109-3124 (2015).

- Burstedt, M. K., Flanagan, J. R., Johansson, R. S. Control of grasp stability in humans under different frictional conditions during multidigit manipulation. Journal of Neurophysiology. 82 (5), 2393-2405 (1999).

- Paulun, V. C., Gegenfurtner, K. R., Goodale, M. A., Fleming, R. W. Effects of material properties and object orientation on precision grip kinematics. Experimental Brain Research. 234 (8), 2253-2265 (2016).

- Klein, L. K., Maiello, G., Fleming, R. W., Voudouris, D. Friction is preferred over grasp configuration in precision grip grasping. Journal of Neurophysiology. 125 (4), 1330-1338 (2021).

- Mamassian, P. Prehension of objects oriented in three-dimensional space. Experimental Brain Research. 114 (2), 235-245 (1997).

- Paulun, V. C., Kleinholdermann, U., Gegenfurtner, K. R., Smeets, J. B. J., Brenner, E. Center or side: biases in selecting grasp points on small bars. Experimental Brain Research. 232 (7), 2061-2072 (2014).

- Goodale, M. A., et al. Separate neural pathways for the visual analysis of object shape in perception and prehension. Current Biology. 4 (7), 604-610 (1994).

- Kleinholdermann, U., Franz, V. H., Gegenfurtner, K. R. Human grasp point selection. Journal of Vision. 13 (8), 23 (2013).

- Maiello, G., Paulun, V. C., Klein, L. K., Fleming, R. W. Object visibility, not energy expenditure, accounts for spatial biases in human grasp selection. i-Perception. 10 (1), 204166951982760-20 (2019).

- Maiello, G., Schepko, M., Klein, L. K., Paulun, V. C., Fleming, R. W. Humans can visually judge grasp quality and refine their judgments through visual and haptic feedback. Frontiers in Neuroscience. 14, 591898 (2021).

- Klein, L. K., Maiello, G., Paulun, V. C., Fleming, R. W. Predicting precision grip grasp locations on three-dimensional objects. PLoS Computational Biology. 16 (8), 1008081 (2020).

- Maiello, G., Paulun, V. C., Klein, L. K., Fleming, R. W. The sequential-weight illusion. i-Perception. 9 (4), 204166951879027 (2018).

- Chessa, M., Maiello, G., Klein, L. K., Paulun, V. C., Solari, F. Grasping objects in immersive Virtual Reality. 2019 IEEE Conference on Virtual Reality and 3D User Interfaces (VR). , 1749-1754 (2019).

- Crajé, C., Lukos, J. R., Ansuini, C., Gordon, A. M., Santello, M. The effects of task and content on digit placement on a bottle). Experimental Brain Research. 212 (1), 119-124 (2011).

- Lukos, J., Ansuini, C., Santello, M. Choice of contact points during multidigit grasping: Effect of predictability of object center of mass location. Journal of Neuroscience. 27 (14), 3894-3903 (2007).

- Gilster, R., Hesse, C., Deubel, H. Contact points during multidigit grasping of geometric objects. Experimental Brain Research. 217 (1), 137-151 (2012).

- Schot, W. D., Brenner, E., Smeets, J. B. J. Robust movement segmentation by combining multiple sources of information. Journal of Neuroscience Methods. 187 (2), 147-155 (2010).

- Sundaram, S., et al. Learning the signatures of the human grasp using a scalable tactile glove. Nature. 569 (7758), 698-702 (2019).

- Yan, Y., Goodman, J. M., Moore, D. D., Solla, S. A., Bensmaia, S. J. Unexpected complexity of everyday manual behaviors. Nature Communications. 11 (1), 3564 (2020).

- Han, S., et al. Online optical marker-based hand tracking with deep labels. ACM Transactions on Graphics. 37 (4), 1-10 (2018).

- Clouthier, A. L., et al. Development and validation of a deep learning algorithm and open-source platform for the automatic labelling of motion capture markers. IEEE Access. 9, 36444-36454 (2021).

- . Qualisys AB Qualisys Track Manager User Manual (Version 2022.1) Available from: https://www.qualisys.com/ (2022)

- Mathis, A., et al. DeepLabCut: Markerless pose estimation of user-defined body parts with deep learning. Nature Neuroscience. 21 (9), 1281-1289 (2018).

- Moon, G., Shiratori, T., Lee, K. M. DeepHandMesh: A weakly-supervised deep encoder-decoder framework for high-fidelity hand mesh modeling. ECCV 2020. , (2020).

- Smith, B., et al. Constraining dense hand surface tracking with elasticity. ACM Transactions on Graphics. 39 (6), 219 (2020).

- Taheri, O., Ghorbani, N., Black, M. J., Tzionas, D. GRAB: A dataset of whole-body human grasping of objects. Computer Vision - ECCV 2020: 16th European Conference. , 581-600 (2020).

- Brahmbhatt, S., Tang, C., Twigg, C. D., Kemp, C. C., Hays, J. ContactPose: A dataset of grasps with object contact and hand pose. Computer Vision - ECCV 2020. , 361-378 (2020).

- Wang, J., et al. RGB2Hands: Real-time tracking of 3D hand interactions from monocular RGB video. ACM Transactions on Graphics. 39 (6), 218 (2020).

- Zhang, X., Li, Q., Mo, H., Zhang, W., Zheng, W. End-to-end hand mesh recovery from a monocular RGB image. 2019 IEEE/CVF International Conference on Computer Vision (ICCV). , 2354-2364 (2019).

- Endo, Y., Tada, M., Mochimaru, M. Reconstructing individual hand models from motion capture data). Journal of Computational Design and Engineering. 1 (1), 1-12 (2014).

- Mueller, F., et al. GANerated hands for real-time 3D hand tracking from monocular RGB. 2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition. , 49-59 (2018).

- Mueller, F., et al. Real-time pose and shape reconstruction of two interacting hands with a single depth camera. ACM Transactions on Graphics. 38 (4), 49 (2019).

- Romero, J., Tzionas, D., Black, M. J. Embodied hands: Modeling and capturing hands and bodies together. ACM Transactions on Graphics. 36 (6), 245 (2017).

- Kappler, D., Bohg, J., Schaal, S. Leveraging big data for grasp planning. 2015 IEEE International Conference on Robotics and Automation (ICRA). , 4304-4311 (2015).

- Kokic, M., Kragic, D., Bohg, J. Learning task-oriented grasping from human activity datasets). IEEE Robotics and Automation Letters. 5 (2), 3352-3359 (2020).

- Shao, L., et al. UniGrasp: Learning a unified model to grasp with multifingered robotic hands. IEEE Robotics and Automation Letters. 5 (2), 2286-2293 (2020).

- Shao, L., Migimatsu, T., Zhang, Q., Yang, K., Bohg, J. Concept2Robot: Learning manipulation concepts from instructions and human demonstrations. Robotics: Science and Systems XVI. , (2020).

- Bohg, J. Interactive perception: Leveraging action in perception and perception in action. IEEE Transactions on Robotics. 33 (6), 1273-1291 (2017).

- . Blender Foundation Available from: https://www.blender.org (2022)

- Roth, S. D. Ray casting for modeling solids. Computer Graphics and Image Processing. 18 (2), 109-144 (1982).

- Maiello, G., Kwon, M., Bex, P. J. Three-dimensional binocular eye-hand coordination in normal vision and with simulated visual impairment. Experimental Brain Research. 236 (3), 691-709 (2018).

- Weichert, F., Bachmann, D., Rudak, B., Fisseler, D. Analysis of the accuracy and robustness of the leap motion controller. Sensors. 13 (5), 6380-6393 (2013).

- Guna, J., Jakus, G., Pogačnik, M., Tomažič, S., Sodnik, J. An analysis of the precision and reliability of the leap motion sensor and its suitability for static and dynamic tracking. Sensors. 14 (2), 3702-3720 (2014).

- Sheshadri, S., Dann, B., Hueser, T., Scherberger, H. 3D reconstruction toolbox for behavior tracked with multiple cameras. Journal of Open Source Software. 5 (45), 1849 (2020).

- Maiello, G., Harrison, W. J., Bex, P. J. Monocular and binocular contributions to oculomotor plasticity. Scientific Reports. 6, 31861 (2016).

- Caoli, A., et al. A dichoptic feedback-based oculomotor training method to manipulate interocular alignment. Scientific Reports. 10, 15634 (2020).

- Gibaldi, A., Vanegas, M., Bex, P. J., Maiello, G. Evaluation of the Tobii EyeX eye tracking controller and Matlab toolkit for research. Behavior Research Methods. 49 (3), 923-946 (2017).

- Chessa, M., Maiello, G., Borsari, A., Bex, P. J. The Perceptual quality of the Oculus Rift for immersive virtual reality. Human-Computer Interaction. 34 (1), 51-82 (2016).

- Maiello, G., Chessa, M., Bex, P. J., Solari, F. Near-optimal combination of disparity across a log-polar scaled visual field. PLoS Computational Biology. 16 (4), 1007699 (2020).

- Maiello, G., Chessa, M., Solari, F., Bex, P. J. The (in)effectiveness of simulated blur for depth perception in naturalistic images. PLoS One. 10 (10), 0140230 (2015).

- Maiello, G., Chessa, M., Solari, F., Bex, P. J. Simulated disparity and peripheral blur interact during binocular fusion. Journal of Vision. 14 (8), 13 (2014).

- Maiello, G., Kerber, K. L., Thorn, F., Bex, P. J., Vera-Diaz, F. A. Vergence driven accommodation with simulated disparity in myopia and emmetropia. Experimental Eye Research. 166, 96-105 (2018).

- Moscatelli, A., et al. The change in fingertip contact area as a novel proprioceptive cue. Current Biology. 26 (9), 1159-1163 (2016).

Reimpresiones y Permisos

Solicitar permiso para reutilizar el texto o las figuras de este JoVE artículos

Solicitar permisoExplorar más artículos

This article has been published

Video Coming Soon

ACERCA DE JoVE

Copyright © 2025 MyJoVE Corporation. Todos los derechos reservados