Génération d’avatars de combattants à partir d’images de scènes d’entraînement au maniement des armes pour des simulations d’exposition à l’explosion

Dans cet article

Résumé

Un cadre informatique a été développé pour reconstruire automatiquement des scènes virtuelles composées d’avatars 3D de soldats à l’aide d’images et/ou de données vidéo. Les scènes virtuelles aident à estimer l’exposition à la surpression d’explosion pendant l’entraînement au maniement des armes. L’outil facilite une représentation réaliste de la posture humaine dans les simulations d’exposition aux explosions dans divers scénarios.

Résumé

Le personnel militaire impliqué dans l’entraînement au maniement des armes est soumis à des explosions répétées de faible intensité. La méthode dominante d’estimation des charges de souffle implique des jauges de souffle portables. Cependant, à l’aide des données des capteurs portables, les charges d’explosion à la tête ou à d’autres organes ne peuvent pas être estimées avec précision sans connaître la posture corporelle du militaire. Une plate-forme de calcul expérimental complémentaire augmentée d’images et de vidéos pour mener des entraînements plus sûrs aux armes a été développée. Cette étude décrit le protocole de génération automatisée de scènes d’entraînement au maniement des armes à partir de données vidéo pour les simulations d’exposition à l’explosion. La scène de l’explosion extraite des données vidéo au moment du tir de l’arme implique les avatars du corps du militaire, les armes, le sol et d’autres structures. Le protocole informatique est utilisé pour reconstruire les positions et les postures des militaires à l’aide de ces données. Des données d’image ou de vidéo extraites des silhouettes corporelles des militaires sont utilisées pour générer un squelette anatomique et les données anthropométriques clés. Ces données sont utilisées pour générer les avatars 3D de la surface du corps segmentés en parties individuelles du corps et transformés géométriquement pour correspondre aux postures des membres du service extraits. La dernière scène virtuelle d’entraînement aux armes est utilisée pour les simulations informatiques 3D du chargement des ondes de souffle des armes sur les membres du service. Le générateur de scènes d’entraînement au maniement des armes a été utilisé pour construire des avatars anatomiques en 3D de corps de membres individuels du service à partir d’images ou de vidéos dans diverses orientations et postures. Les résultats de la génération d’une scène d’entraînement à partir de données d’image d’un système d’arme d’assaut monté à l’épaule et d’un système d’arme de mortier sont présentés. L’outil de surpression explosive (BOP) utilise la scène virtuelle d’entraînement aux armes pour des simulations 3D du chargement des ondes de choc sur les corps d’avatar des membres du service. Cet article présente des simulations informatiques 3D de la propagation des ondes de choc à partir de tirs d’armes et des charges de souffle correspondantes sur les membres du service en formation.

Introduction

Au cours de l’entraînement militaire, les militaires et les instructeurs sont fréquemment exposés à des explosions de faible intensité avec des armes lourdes et légères. Des études récentes ont montré que l’exposition à l’explosion pourrait entraîner une diminution des performances neurocognitives 1,2 et des altérations des biomarqueurs sanguins 3,4,5,6. L’exposition répétée à des explosions de faible intensité pose des défis pour maintenir des performances optimales et minimiser le risque de blessure 7,8. L’approche conventionnelle utilisant des capteurs de pression portables présente des inconvénients, notamment lorsqu’il s’agit de déterminer avec précision les pressions de souffle sur la tête9. Les effets néfastes connus de l’exposition répétée à des explosions de faible intensité sur la performance humaine (p. ex. pendant l’entraînement et dans les rôles opérationnels) exacerbent ce problème. Les mandats du Congrès (articles 734 et 717) ont stipulé l’exigence de surveillance de l’exposition à l’explosion à l’entraînement et au combat et son inclusion dans le dossier médical du militaire10.

Des capteurs portables peuvent être utilisés pour surveiller la surpression de l’explosion pendant ces opérations d’entraînement au combat. Cependant, ces capteurs sont influencés par des variables telles que la posture du corps, l’orientation et la distance par rapport à la source de l’explosion en raison de la nature complexe des interactions des ondes de choc avec le corps humain9. Les facteurs suivants affectent la répartition de la pression et les mesures du capteur9 :

Distance de la source de l’explosion : L’intensité de la pression varie avec la distance à mesure que l’onde de souffle se disperse et s’atténue. Les capteurs plus proches de l’explosion enregistrent des pressions plus élevées, ce qui a un impact sur la précision et la cohérence des données.

Posture corporelle : Différentes postures exposent diverses surfaces corporelles à l’explosion, modifiant la répartition de la pression. Par exemple, la position debout ou accroupie donne des lectures de pression différentes 9,11.

Orientation : L’angle du corps par rapport à la source de l’explosion affecte la façon dont l’onde de pression interagit avec le corps, ce qui entraîne des divergences dans les lectures9. Les simulations numériques basées sur la physique fournissent des évaluations plus précises en tenant systématiquement compte de ces variables, offrant une analyse contrôlée et complète par rapport aux capteurs portables, qui sont intrinsèquement influencés par ces facteurs.

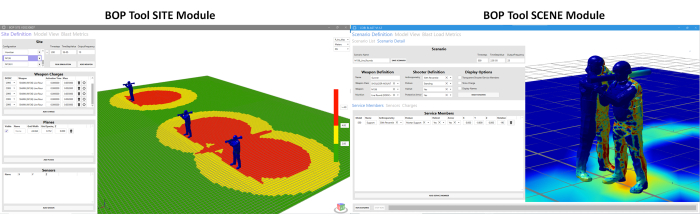

En réponse à ces défis, un effort concerté a été déployé pour mettre au point des outils plus sophistiqués. Dans cette direction, l’outil de surpression explosive (BOP) est développé. Cet outil est développé pour estimer l’exposition à la surpression dans différentes postures et positions des militaires autour des systèmes d’armes. Il y a deux modules différents sous l’outil BOP11. Il s’agit (a) du module SCENE de l’outil BOP et (b) du module SITE de l’outil BOP. Ces modules sont utilisés pour estimer la surpression de l’explosion pendant le tir de l’arme12. Le module BOP SCENE est conçu pour estimer les surpressions dues au souffle subies par les militaires ou les instructeurs participant à un scénario de formation, tandis que le module BOP SITE reconstitue une vue d’ensemble du cours de formation, décrivant les zones de surpression du souffle générées par plusieurs postes de tir. La figure 1 montre un instantané des deux modules. À l’heure actuelle, les modules de l’outil BOP comprennent des caractéristiques de surpression d’explosion d’arme (terme de source d’explosion équivalente) pour quatre systèmes d’armes de niveau 1 définis par le DoD, y compris le fusil de sniper à application spéciale (SASR) M107 de calibre .50, l’arme d’assaut montée sur l’épaule M136, le mortier à tir indirect M120 et les charges de brèche. Le terme noyau d’explosion d’arme fait référence à un terme de source d’explosion équivalent développé pour reproduire le même champ d’explosion entourant un système d’arme que celui de l’arme réelle. Une description plus détaillée du cadre de calcul utilisé pour le développement de l’outil BOP est disponible à titre de référence11. Les simulations de surpression sont exécutées à l’aide du moteur de résolution CoBi-Blast. Il s’agit d’un outil multi-échelle et multiphysique permettant de simuler des surpressions d’explosion. Les capacités de modélisation de l’explosion du moteur sont validées par rapport aux données expérimentales de la littérature12. Cet outil BOP est actuellement en cours d’intégration dans la boîte à outils des gestionnaires de champs de tir (RMTK) pour être utilisé sur différents champs de tir d’entraînement aux armes. RMTK est une suite multi-services d’outils de bureau conçue pour répondre aux besoins des gestionnaires de champs de tir de l’Armée, du Corps des Marines, de l’Armée de l’air et de la Marine en automatisant les opérations de tir, la sécurité et les processus de modernisation.

Figure 1 : Interface utilisateur graphique (GUI) pour le module SCENE de l’outil BOP et le module SITE de l’outil BOP. Le module BOP SCENE est conçu pour estimer les surpressions de souffle sur les modèles de corps de militaire et d’instructeur, tandis que le module BOP SITE est destiné à fournir une estimation des contours de surpression sur un plan qui représente le terrain de formation. L’utilisateur a la possibilité de choisir la hauteur à laquelle l’avion se trouve par rapport au sol. Veuillez cliquer ici pour voir une version agrandie de cette figure.

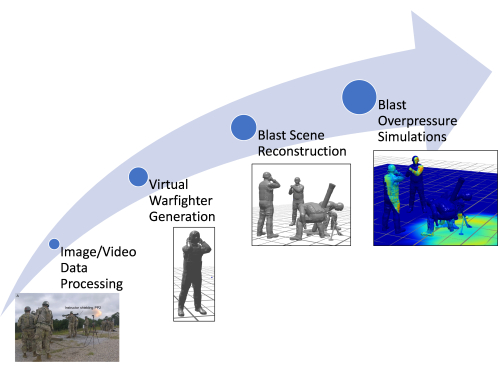

L’une des limites du module SCENE de l’outil BOP existant est son utilisation de données estimées manuellement pour construire des modèles corporels de membres du service virtuel, y compris leur anthropométrie, leur posture et leur position. La génération manuelle des membres du service virtuel dans la posture appropriée demande beaucoup de travail et de temps 11,12. L’ancien outil BOP (approche héritée) utilise une base de données de postures préconfigurées pour construire la scène d’entraînement au maniement des armes sur la base des données d’image (si disponibles). De plus, étant donné que les postures sont approximées manuellement par l’évaluation visuelle, les postures correctes peuvent ne pas être capturées pour un cadre postural complexe. Par conséquent, cette approche introduit des inexactitudes dans l’estimation de l’exposition à la surpression pour chaque membre du service (car un changement de posture peut modifier l’exposition à la surpression dans les régions plus vulnérables). L’article présente les améliorations qui ont été apportées au cadre de calcul existant pour permettre la génération rapide et automatique de modèles de membres du service à l’aide d’outils d’estimation de pose de pointe existants. Cet article traite de l’amélioration de l’outil BOP, en mettant particulièrement l’accent sur le développement d’un pipeline de calcul nouveau et rapide pour reconstruire des scènes d’explosion à l’aide de données vidéo et d’image. L’outil amélioré peut également reconstruire des modèles corporels détaillés des membres du service et des instructeurs au moment du tir de l’arme, en utilisant des données vidéo pour créer des avatars personnalisés par rapport à l’approche héritée. Ces avatars reflètent fidèlement la posture des militaires. Ce travail simplifie le processus de génération de scènes d’explosion et facilite l’inclusion plus rapide des scènes d’explosion pour des systèmes d’armes supplémentaires, réduisant ainsi considérablement le temps et les efforts nécessaires à la création de scènes d’entraînement au maniement des armes. La figure 2 montre un schéma du cadre de calcul amélioré dont il est question dans le présent document.

Figure 2 : Schéma montrant l’organigramme global du processus dans le cadre de calcul. Les différentes étapes comprennent le traitement des données image/vidéo, la génération de combattants virtuels, la reconstitution de scènes d’explosion et les simulations de surpression d’explosion. Veuillez cliquer ici pour voir une version agrandie de cette figure.

L’article présente l’approche automatisée mise en œuvre dans l’outil BOP, qui représente une amélioration significative des outils de calcul disponibles pour estimer l’exposition à la surpression pendant la formation et les opérations. Cet outil se distingue par sa génération rapide d’avatars personnalisés et de scénarios d’entraînement, permettant des simulations immersives de surpression de souffle. Cela marque un changement significatif par rapport à la dépendance traditionnelle à l’égard des modèles de corps humain moyennés par la population, offrant une approche plus précise et individualisée.

Outils de calcul utilisés dans le processus d’automatisation

L’automatisation de la génération de modèles de membres de service virtuel est un processus en plusieurs étapes qui s’appuie sur des outils de calcul avancés pour transformer des images ou des données vidéo brutes en représentations 3D détaillées. L’ensemble du processus est automatisé mais peut être adapté pour permettre la saisie manuelle de mesures connues si nécessaire.

Outils d’estimation de pose 3D : Au cœur du pipeline d’automatisation se trouvent les outils d’estimation de pose 3D. Ces outils analysent les données d’image pour identifier la position et l’orientation de chaque articulation du corps du militaire, créant ainsi un squelette numérique. Le pipeline prend actuellement en charge Mediapipe et MMPose, qui offrent des API Python. Cependant, le système est conçu dans un souci de flexibilité, permettant l’incorporation d’autres outils, tels que des caméras de profondeur, à condition qu’ils puissent produire les données 3D nécessaires sur les articulations et les os.

Générateur de modèles anthropométriques (AMG) : Une fois la pose 3D estimée, l’AMG entre en jeu. Cet outil utilise les données de pose pour créer un modèle de surface de peau 3D qui correspond aux dimensions uniques du corps du militaire. L’outil AMG permet la saisie automatisée ou manuelle de mesures anthropométriques, qui sont ensuite liées aux principaux composants de l’outil pour transformer le maillage 3D du corps en conséquence.

Modélisation squelettique OpenSim : L’étape suivante implique la plate-forme open-source OpenSim13, où un modèle squelettique est ajusté pour s’aligner sur les données de pose 3D. Les outils d’estimation de pose n’imposent pas de longueurs osseuses cohérentes dans le squelette, ce qui peut entraîner une asymétrie irréaliste dans le corps. L’utilisation d’un squelette OpenSim anatomiquement correct produit une structure osseuse plus réaliste. Des marqueurs sont placés sur le squelette OpenSim pour correspondre aux centres articulaires identifiés par l’outil d’estimation de pose. Ce modèle squelettique est ensuite fixé au maillage 3D de la peau à l’aide de techniques d’animation standard.

Cinématique inverse et scripts Python : Pour finaliser la pose du membre du service virtuel, un algorithme de cinématique inverse est utilisé. Cet algorithme ajuste le modèle squelette OpenSim pour qu’il corresponde au mieux à la pose 3D estimée. L’ensemble du pipeline de pose est entièrement automatisé et implémenté dans Python 3. Grâce à l’intégration de ces outils, le processus de génération de modèles de membres de service virtuel a été considérablement accéléré, réduisant le temps nécessaire de plusieurs jours à quelques secondes ou minutes. Cette avancée représente un bond en avant dans la simulation et l’analyse de scénarios d’entraînement au maniement des armes, fournissant des reconstitutions rapides de scénarios spécifiques documentés à l’aide d’images ou de vidéos.

Protocole

Les images et les vidéos utilisées dans cette étude n’ont pas été obtenues directement par les auteurs auprès de sujets humains. Une image provient de ressources gratuites sur Wikimedia Commons, qui est disponible sous une licence du domaine public. L’autre image a été fournie par des collaborateurs de l’Institut de recherche de l’armée Walter Reed (WRAIR). Les données obtenues de WRAIR n’ont pas été identifiées et ont été partagées conformément à leurs directives institutionnelles. Pour les images fournies par WRAIR, le protocole a suivi les directives du comité d’éthique de la recherche humaine de WRAIR, y compris l’obtention de toutes les approbations et consentements nécessaires.

1. Accès au module SCENE de l’outil BOP

- Ouvrez le module SCENE de l’outil BOP à partir de l’interface de l’outil BOP en cliquant sur le bouton du module SCENE de l’outil BOP .

- Cliquez sur Définition du scénario , puis sur l’onglet Détails du scénario .

2. Lecture et traitement des données d’image

- Cliquez sur le bouton IMPORTATION DE L’OUTIL POSETOOL dans le module SCENE de l’outil BOP. Une fenêtre contextuelle s’ouvre, demandant à l’utilisateur de sélectionner l’image ou la vidéo appropriée.

- Accédez au dossier et sélectionnez l’image/vidéo appropriée à l’aide des opérations de la souris.

- Cliquez sur Ouvrir dans la fenêtre contextuelle une fois qu’une image est sélectionnée.

REMARQUE : Cette opération lit l’image ou le fichier vidéo, génère une image si une vidéo est sélectionnée, exécute l’algorithme d’estimation de la pose en arrière-plan, génère les modèles de membres du service virtuel impliqués dans la scène d’entraînement aux armes et les charge dans le module BOP Tool SCENE dans leurs positions respectives.

3. Configuration de l’arme et du tireur

- Choisissez un nom pour le scénario à l’aide de la zone de texte sous Nom du scénario. Il s’agit d’un choix de l’utilisateur. Pour le scénario discuté ici, les développeurs ont choisi le nom de scénario BlastDemo1.

- Choisissez un nom personnalisé dans le champ Nom sous la définition de l’arme. Il s’agit, encore une fois, d’un choix de l’utilisateur. Pour le scénario discuté ici, les développeurs ont choisi le nom d’arme 120Mortar.

- Sélectionnez la classe d’arme appropriée, par exemple MORTIER LOURD, dans la liste des options du menu déroulant.

- Sélectionnez l’arme (M120 dans ce cas) dans la liste des choix de la liste déroulante. Lors de la sélection du système d’arme, le noyau d’explosion correspondant sera automatiquement chargé dans l’interface graphique sous le sous-onglet Charges.

REMARQUE : La liste déroulante regroupera les différents systèmes d’armes possibles spécifiques à la classe d’arme choisie ci-dessus. - Sélectionnez l’obus de munitions (balle d’entraînement à portée complète) pour le système d’arme choisi à l’aide des options déroulantes.

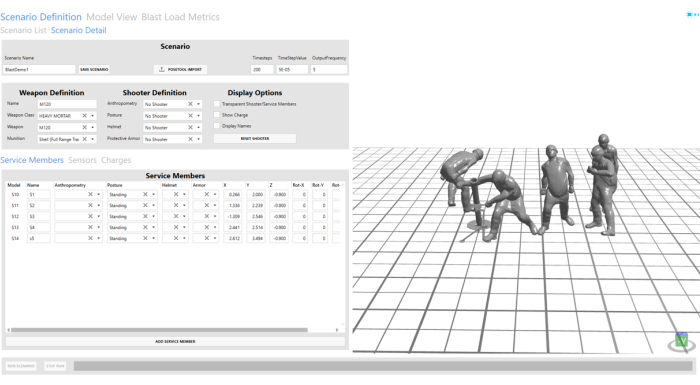

- Sélectionnez Aucun tireur dans les champs Anthropométrie, Posture, Casque et Armure de protection sous la définition du tireur dans les options déroulantes. Reportez-vous à la Figure 3 pour connaître la configuration du dispositif de tir et des membres du service.

REMARQUE : Étant donné que le tireur sera inclus dans la scène importée à l’étape 4, aucun tireur n’a été sélectionné sous la définition du tireur.

Figure 3 : Scène d’explosion importée à partir des données de l’image. La scène de l’explosion est visible dans la fenêtre de visualisation sur le côté droit de l’outil GUI. Veuillez cliquer ici pour voir une version agrandie de cette figure.

4. Configuration des membres du service

- Cliquez sur l’onglet Membres du service . Cet onglet contrôle la position et l’orientation des membres du service importés à partir des données d’image. utilisez les options X, Y, Z et de rotation pour ce faire. Pour l’avatar correspondant à l’assistant mitrailleur, les auteurs ont ajusté la position Y de 2,456 à 2 pour une position d’assistant mitrailleur plus raisonnable.

- Choisissez des noms personnalisés pour tous les modèles de membres de service virtuels importés dans l’interface graphique à l’aide du champ Nom sous l’onglet Membres de service. S1, S2, S3, S4 et S5 sont choisis ici pour tous les modèles de membres de service importés automatiquement.

REMARQUE : Pour le scénario décrit ici, ils ont été nommés S1 et S2. Les autres champs sont automatiquement remplis. Les utilisateurs peuvent les modifier pour affiner la position/postures automatiquement estimées. - Utilisez le bouton Supprimer pour supprimer S2, S4 et S5. Dans le scénario présenté ici, seuls le tireur et l’assistant mitrailleur sont présents au moment du tir.

REMARQUE : Cette opération a été effectuée pour démontrer les options utilisateur personnalisées permettant de supprimer ou d’ajouter des modèles de membres du service selon les besoins à une scène existante.

5. Configuration des capteurs virtuels

- Accédez à l’onglet Capteurs . Ajoutez un nouveau capteur virtuel en cliquant sur Ajouter un capteur.

- Choisissez un nom personnalisé dans le champ Nom. Les développeurs ont choisi la V1 pour la démonstration dans ce document.

- Sélectionnez le type Virtuel en cliquant sur le menu déroulant sous le champ Type de capteur.

- Choisissez l’emplacement du capteur (-0,5, 2, 0,545) en modifiant les zones de texte sous les champs X, Y et Z. Pour le scénario discuté ici, les développeurs ont créé quatre capteurs différents à quatre endroits différents à des fins de démonstration. Les développeurs ont choisi V2, V3 et V4 comme noms de capteur pour les capteurs supplémentaires.

- Répétez les étapes de la version 5.1 à la version 5.4 pour créer des capteurs supplémentaires à (-0.5, 1, 0.545), (-0.5, 0.5, 0.545) et (-0.5, 0, 0.545). Laissez la valeur de rotation sur zéro.

REMARQUE : L’utilisateur peut également choisir des capteurs planaires au cours desquels la rotation peut être utilisée pour ajuster l’orientation du capteur par rapport à la charge de souffle.

6. Enregistrement et exécution du programme

- Enregistrez la scène d’entraînement au maniement des armes en cliquant sur le bouton Enregistrer le scénario dans l’interface graphique en haut.

- Exécutez la simulation de surpression d’explosion pour la scène d’entraînement au tir du M120 en cliquant sur le bouton Exécuter le scénario en bas. La progression de la simulation est affichée à l’aide de la barre de progression en bas.

7. Visualiser les résultats

- Accédez à l’onglet Vue du modèle pour examiner la simulation d’exposition à la surpression de souffle.

- Cliquez sur le bouton Actuel pour charger la simulation terminée dans la fenêtre de visualisation.

- Une fois la simulation chargée, visualisez-la à l’aide du bouton Lecture en bas de l’écran.

- L’utilisateur peut choisir entre les différentes options de la barre de navigation pour lire et mettre en pause la simulation à différentes vitesses. La capture d’écran des commandes de lecture ci-dessous montre plus d’options. L’utilisateur peut contrôler la fenêtre interactive à l’aide de la souris. Cliquez avec le bouton droit de la souris et faites glisser le curseur pour faire pivoter le mode, le bouton gauche pour traduire le modèle et le bouton central pour faire défiler vers l’avant/l’arrière.

- Après avoir examiné la simulation, accédez à l’onglet Blast Load Metrics en cliquant dessus.

- Cliquez sur le bouton Actuel pour charger les graphiques de surpression aux emplacements des capteurs virtuels.

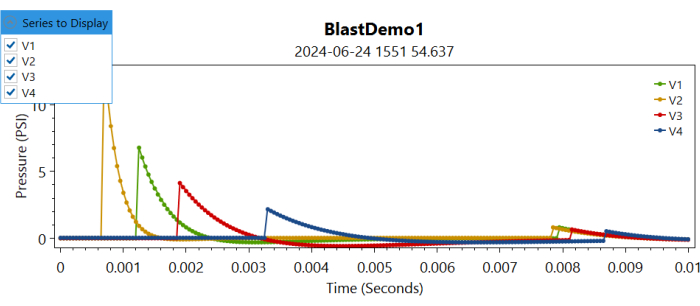

REMARQUE : Cela chargera les informations de surpression aux différents emplacements du capteur dans différents tracés. - Accédez à la liste déroulante Série à afficher et sélectionnez en cochant la case du capteur correspondant pour tracer la surpression enregistrée au niveau de ce capteur virtuel (voir Figure 4).

Figure 4 : Tracé des contrôles des surpressions sur différents capteurs virtuels au fil du temps. L’utilisateur peut choisir la série à afficher en cochant ou décochant les différents capteurs. Veuillez cliquer ici pour voir une version agrandie de cette figure.

Résultats Représentatifs

Reconstitution automatisée des membres du service virtuel et des scènes d’explosion

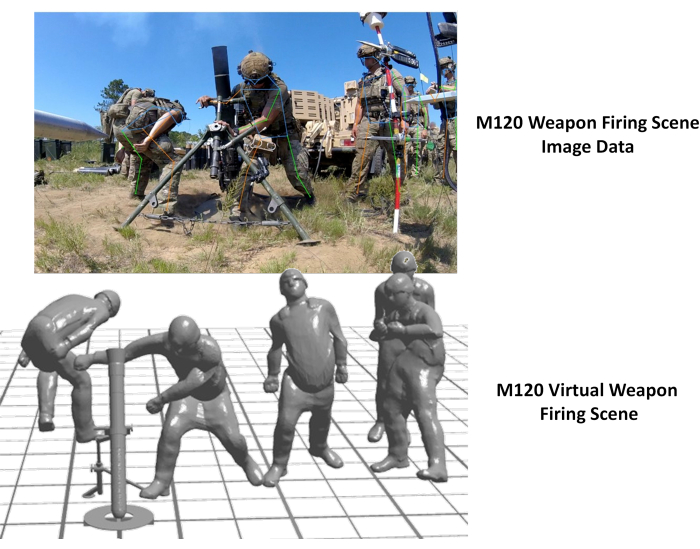

La génération automatisée de modèles de corps de membres de membres du service virtuel et de modèles de scènes d’entraînement aux armes a été réalisée grâce aux capacités d’automatisation de l’outil BOP. La figure 5 montre la scène d’entraînement virtuelle générée à partir des données d’image. Comme on peut l’observer ici, la scène résultante était une bonne représentation des données de l’image. L’image utilisée pour la démonstration de la figure 5 a été obtenue sur Wikimedia Commons.

Figure 5 : Scène virtuelle d’entraînement au maniement des armes à partir des données de l’image. L’image de gauche montre les données d’image correspondant au tir d’une arme AT4, et celle de droite montre la scène virtuelle d’entraînement aux armes générée automatiquement. Ce chiffre a été obtenu sur Wikimedia Commons. Veuillez cliquer ici pour voir une version agrandie de cette figure.

De plus, l’approche a été appliquée pour reconstituer la scène de tir de l’arme M120. L’image a été collectée par WRAIR dans le cadre d’un effort de collecte de données de pression pour l’arme de mortier M120. La figure 6 ci-dessous illustre la scène virtuelle reconstituée de tir d’arme à côté de l’image originale. Une anomalie a été observée dans la position de l’assistant mitrailleur dans la reconstitution virtuelle. Cela peut être corrigé en ajustant la position de l’assistant tireur à l’aide des options utilisateur de l’interface utilisateur de l’interface graphique BOP. De plus, la posture pelvienne de l’instructeur semblait imprécise, probablement en raison de l’obstruction des piquets dans les images. L’intégration de cette approche à d’autres modalités d’imagerie en profondeur serait bénéfique pour remédier à ces divergences.

Figure 6 : Scène virtuelle d’entraînement aux armes à partir des données d’image. L’image de gauche montre les données d’image correspondant au tir d’une arme M120 et celle de droite montre la scène virtuelle d’entraînement aux armes générée automatiquement. Veuillez cliquer ici pour voir une version agrandie de cette figure.

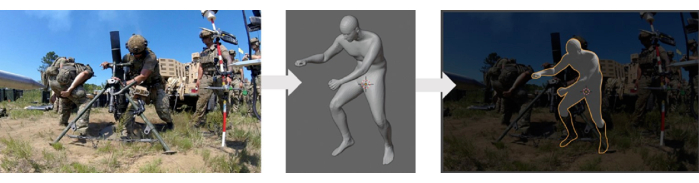

Validation de l’approche de génération automatisée de scènes

Le générateur de modèles de corps humain utilisé dans cette étude a été validé à l’aide de la base de données de balayage du corps humainANSUR II 14, qui comprenait des mesures anthropométriques à partir de données d’imagerie médicale. Une méthode de reconstruction automatisée, qui a utilisé ce générateur de modèles de corps humain, a fait l’objet d’une validation qualitative avec les données disponibles. Ce processus de validation a consisté à comparer les modèles reconstruits avec des données expérimentales (images) en les superposant. La figure 7 présente une comparaison entre les modèles d’avatars 3D et les données expérimentales. Cependant, une validation plus approfondie de cette méthode est nécessaire, ce qui nécessiterait des données expérimentales supplémentaires sur les lieux, y compris des positions précises, des postures et des orientations des différents membres du service impliqués dans une scène d’entraînement.

Figure 7 : Comparaison qualitative du modèle de corps humain virtuel généré avec l’image. Le panneau de gauche affiche l’image d’origine, le panneau du milieu montre le modèle de corps virtuel généré et le panneau de droite montre le modèle virtuel superposé à l’image d’origine. Veuillez cliquer ici pour voir une version agrandie de cette figure.

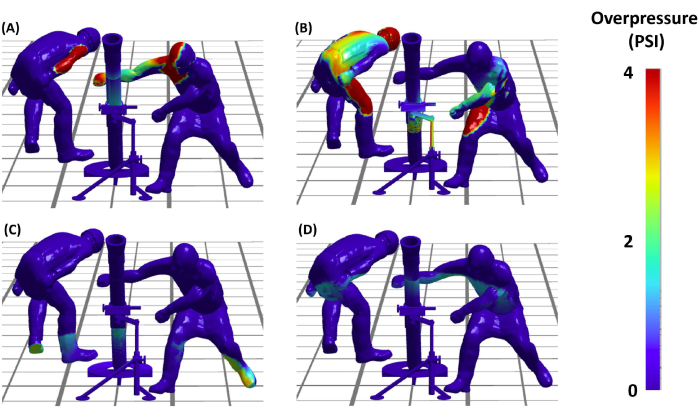

Simulations représentatives de surpression de souffle

Après avoir mis en place la scène d’explosion, les auteurs ont pu passer à la phase critique de l’exécution des simulations de surpression d’explosion (BOP). Cela nous permettra de comprendre la répartition des charges d’explosion sur les différents membres du service impliqués dans une scène de tir d’arme. La figure 8 présente les résultats de ces simulations BOP lors de l’événement de tir de l’arme AT4. Les simulations fournissent une visualisation détaillée des charges de surpression sur le militaire virtuel sur la scène à différents instants au fil du temps. En conclusion, les résultats démontrent non seulement la faisabilité, mais aussi l’efficacité du protocole dans la création de reconstitutions précises et analytiquement utiles de scénarios d’entraînement au maniement des armes, ouvrant ainsi la voie à des études plus avancées sur la sécurité et l’efficacité de l’entraînement militaire.

Figure 8 : Exposition à la surpression de l’explosion sur le tireur. (A, B, C et D) Les quatre panneaux montrent que le modèle a prédit la surpression de l’explosion sur les membres du service virtuel impliqués dans le tir de mortier M120 à différents instants. Les panneaux (C) et (D) montrent la propagation de la surpression due à la réflexion du sol. Veuillez cliquer ici pour voir une version agrandie de cette figure.

Discussion

Le cadre de calcul présenté dans cet article accélère considérablement la génération de scènes d’entraînement aux armes à explosion par rapport aux méthodes manuelles précédemment utilisées utilisant l’évaluation visuelle. Cette approche démontre la capacité du cadre à saisir et à reconstruire rapidement diverses postures militaires.

Avantages de l’approche actuelle

La création de modèles virtuels de corps humains dans des postures et des positions spécifiques est une tâche difficile, avec peu d’outils disponibles à cet effet. La méthode conventionnelle employée dans l’approche héritée, en particulier pour l’outil BOP, a utilisé CoBi-DYN 14,15,16,17. Cette méthode impliquait la création manuelle de modèles de corps humains virtuels avec des vêtements, des casques, des armures de protection et des bottes. Les modèles ont été générés par approximation visuelle approximative, en l’absence d’une approche systématique. Dans l’ancien outil BOP, CoBi-DYN a été utilisé pour créer une base de données de modèles de corps humain accessible lors de l’étape de configuration du scénario. Les utilisateurs sélectionnaient manuellement une configuration posturale approximative et la positionnaient approximativement pour un système d’arme particulier afin d’exécuter le scénario BOP. Bien que la reconstitution de la scène d’explosion à partir de la base de données existante des membres du service (accessible à partir de la liste déroulante de l’outil BOP) ait été relativement rapide, la création initiale de la base de données virtuelle du modèle de membre du service a pris beaucoup de temps, prenant environ 16 à 24 heures par scène en raison de la nature manuelle et approximative du processus. En revanche, la nouvelle approche s’appuie sur des outils d’estimation de pose bien établis pour une création plus automatisée et plus rapide de modèles virtuels de corps humains. Ces outils utilisent automatiquement des données vidéo et d’image pour reconstituer rapidement les scènes d’explosion avec des avatars de membres du service virtuels. Cela réduit considérablement le temps nécessaire à la création de la base de données du corps humain. Cette approche novatrice implique un simple clic sur un bouton pour générer ou reconstruire la scène virtuelle complète à partir de données d’imagerie sans avoir besoin de logiciel supplémentaire. L’ensemble du processus prend maintenant environ 5 à 6 s par scène (après lecture des données d’image, comme le montre la vidéo), ce qui démontre une amélioration substantielle de l’efficacité par rapport à la méthode traditionnelle. Cette méthode n’a pas pour but de remplacer l’approche originale, mais plutôt de la compléter en accélérant la génération de modèles virtuels de membres du service (qui pourront être ajoutés à la base de données des modèles de corps de membres du service à l’avenir). Il simplifie l’ajout de nouvelles configurations plus ou moins complexes et facilite l’intégration de nouveaux systèmes d’armes à l’avenir, améliorant ainsi l’extensibilité de l’outil BOP. Par rapport à l’approche traditionnelle, il est évident que la méthode présentée offre une solution plus rationalisée et automatisée, réduisant l’effort manuel et le temps tout en améliorant la précision et la nature systématique de la création de modèles de corps humains virtuels. Cela met en évidence la force et l’innovation de la méthode décrite sur le terrain.

Validation de la génération automatisée de scènes

Une validation qualitative de l’approche a été réalisée en superposant les scénarios reconstruits sur les données d’image. Cependant, la validation quantitative n’a pas été possible en raison du manque de données disponibles sur le positionnement et la posture de ces images. Les auteurs reconnaissent l’importance d’une validation plus approfondie et prévoient d’aborder cette question dans les travaux futurs. Pour y parvenir, les auteurs envisagent un effort complet de collecte de données afin d’obtenir des informations précises sur le positionnement et la posture. Cela nous permettra d’effectuer une validation quantitative détaillée, ce qui améliorera la robustesse et la précision de l’approche.

Validation des simulations d’exposition au Blast

Les noyaux d’explosion de l’arme ont été développés et validés à l’aide de données de sonde crayon recueillies pendant le tir de l’arme. De plus amples détails sur le noyau de l’explosion de l’arme et les expositions pertinentes seront inclus dans une prochaine publication. Certaines informations à cet égard sont également disponibles dans les publications antérieures 11,12. Cet effort continu contribuera à améliorer la précision et l’efficacité des simulations de surpression de souffle, renforçant ainsi la validité de l’outil.

L’approche présentée ici peut également être utilisée pour générer des avatars virtuels des membres du service, qui peuvent ensuite être incorporés dans la base de données pour être sélectionnés à l’aide de l’outil BOP. Bien que le processus actuel n’enregistre pas automatiquement les modèles dans la base de données, les auteurs prévoient d’inclure cette fonctionnalité dans les futures versions de l’outil BOP. De plus, les auteurs possèdent des outils internes qui permettent de modifier manuellement la posture une fois que la posture automatisée et le modèle 3D ont été générés à partir des données d’image. À l’heure actuelle, cette capacité existe indépendamment et n’est pas intégrée dans l’outil de balance des paiements, car il est nécessaire de développer davantage l’interface utilisateur. Néanmoins, il s’agit d’un travail en cours, et les auteurs ont l’intention de l’intégrer dans les futures versions de l’outil BOP.

Les données de charge d’explosion pourraient également être exportées sous la forme d’un fichier texte ASCII, et d’autres étapes de post-traitement pourraient être appliquées pour étudier plus en détail les modèles de dose d’explosion pour différents systèmes d’arme. Des travaux sont actuellement en cours pour développer des outils de post-traitement avancés pour des mesures de sortie telles que l’impulsion, l’intensité et d’autres qui pourraient aider les utilisateurs à comprendre et à étudier des charges de souffle répétées plus complexes au cours de ces scénarios. De plus, les outils sont développés pour une efficacité de calcul et permettent des vitesses de simulation rapides. Par conséquent, ces outils nous permettent d’effectuer des études d’optimisation inverse pour déterminer la posture et la position optimales lors d’un scénario de tir d’arme. De telles améliorations améliorent l’applicabilité de l’outil pour optimiser les protocoles d’entraînement dans différents champs de tir aux armes. Les estimations de la dose d’explosion pourraient également être utilisées pour développer des modèles informatiques à l’échelle macroscopique à haute résolution plus raffinés pour différentes régions anatomiques vulnérables telles que le cerveau, les poumons et d’autres 18,19,20 et des modèles de lésions à l’échelle microscopique 20,21. Ici, le casque et l’armure incorporés dans les modèles sont uniquement destinés à la représentation visuelle et n’ont pas d’impact sur la dose d’explosion dans ces simulations. Cela est dû au fait que les modèles sont considérés comme des structures rigides, ce qui signifie que leur inclusion ne modifie ni n’influence les résultats des simulations de surpression de souffle.

Cet article s’appuie sur un outil d’estimation de pose open source existant pour estimer la pose humaine dans des scénarios d’entraînement au tir. Veuillez noter que le cadre développé et discuté ici est agnostique en matière d’outils, c’est-à-dire que les auteurs peuvent remplacer un outil existant par un nouvel outil au fur et à mesure que de nouvelles avancées sont réalisées. Dans l’ensemble, les tests ont démontré que si les outils logiciels modernes sont extrêmement puissants, la détection de pose basée sur l’image est une tâche difficile. Cependant, plusieurs recommandations peuvent être utilisées pour améliorer les performances de détection de pose. Ces outils fonctionnent mieux lorsque la personne d’intérêt est bien en vue de la caméra. Bien que cela ne soit pas toujours possible lors des exercices d’entraînement au maniement des armes, le fait d’en tenir compte lors du placement de l’appareil photo peut améliorer les résultats de détection de pose. De plus, les militaires qui effectuent des exercices d’entraînement portent souvent des treillis camouflés qui se fondent dans leur environnement. Il est donc plus difficile pour eux d’être détectés à la fois par l’œil humain et par les algorithmes d’apprentissage automatique (ML). Il existe des méthodes pour améliorer la capacité des algorithmes de ML à détecter les humains portant le camouflage23, mais elles ne sont pas triviales à mettre en œuvre. Dans la mesure du possible, la collecte d’images d’entraînement au maniement des armes dans un endroit avec un arrière-plan très contrasté peut améliorer la détection des poses.

De plus, l’approche conventionnelle pour estimer les quantités 3D à partir d’images consiste à utiliser des techniques de photogrammétrie avec plusieurs angles de caméra. L’enregistrement d’images/vidéos sous plusieurs angles peut également être utilisé pour améliorer l’estimation de la pose. La fusion des estimations de pose de plusieurs caméras est relativement simple24. Une autre technique de photogrammétrie qui pourrait améliorer les résultats consiste à utiliser un damier ou un autre objet de dimensions connues comme point de référence commun pour chaque appareil photo. L’un des défis de l’utilisation de plusieurs caméras est de les synchroniser dans le temps. Des modèles d’apprentissage automatique entraînés sur mesure pourraient être développés pour détecter des caractéristiques telles qu’un casque au lieu d’un visage ou pour détecter des personnes portant des vêtements et des équipements spécifiques à l’armée (par exemple, des bottes, des gilets, des gilets pare-balles). Les outils d’estimation de pose existants peuvent être complétés à l’aide de modèles ML entraînés sur mesure. Bien que cela prenne du temps et soit fastidieux, cela peut améliorer considérablement les performances du modèle d’estimation de pose.

En résumé, ce document décrit efficacement les divers composants du cadre amélioré de surpression de souffle. Ici, les auteurs reconnaissent également le potentiel d’amélioration de son applicabilité et de son efficacité grâce à une intégration plus transparente et à une automatisation complète du pipeline. Des éléments tels que la génération d’un maillage de corps 3D à l’échelle avec l’outil AMG sont en cours d’automatisation pour réduire la saisie manuelle de l’utilisateur. Des travaux sont actuellement en cours pour intégrer ces capacités dans le module SCENE de l’outil BOP. Au fur et à mesure que cette technologie se développe, elle sera rendue accessible à toutes les parties prenantes et à tous les laboratoires du DoD. En outre, les travaux en cours comprennent la caractérisation et la validation des noyaux d’armes pour d’autres systèmes d’armes. Cet effort continu pour affiner et valider les méthodologies garantit que les outils développés par les auteurs restent à l’avant-garde du progrès technologique, contribuant de manière significative à la sécurité et à l’efficacité des exercices d’entraînement militaire. Des publications ultérieures fourniront plus de détails sur ces développements, contribuant ainsi au domaine plus large de la formation et de la sécurité militaires.

Déclarations de divulgation

Les auteurs n’ont rien à divulguer.

Remerciements

La recherche est financée par le bureau de coordination de la recherche sur les blessures causées par les explosions du DoD dans le cadre de l’appel de projet MTEC MTEC-22-02-MPAI-082. Les auteurs reconnaissent également la contribution de Hamid Gharahi pour les noyaux d’explosion d’armes et de Zhijian J Chen pour le développement des capacités de modélisation pour les simulations de surpression d’explosion de tir d’armes. Les points de vue, opinions et/ou conclusions exprimés dans cette présentation sont ceux des auteurs et ne reflètent pas la politique ou la position officielle du ministère de l’Armée ou du ministère de la Défense.

matériels

| Name | Company | Catalog Number | Comments |

| Anthropometric Model Generator (AMG) | CFD Research | N/A | For generting 3D human body models with different anthropometric characteristics. The tool is DoD Open Source. |

| BOP Tool | CFD Research | N/A | For setting up blast scenes and overpressure simulations. The tool is DoD open source. |

| BOP Tool SCENE Module | CFD Research | N/A | For setting up blast scenes and overpressure simulations. The tool is DoD open source. |

| Mediapipe | Version 0.9 | Open-source pose estimation library. | |

| MMPose | OpenMMLab | Version 1.2 | Open-source pose estimation library. |

| OpenSim | Stanford University | Version 4.4 | Open-source musculoskeletal modeling and simulation platform. |

| Python 3 | Anaconda Inc | Version 3.8 | The open source Individual Edition containing Python 3.8 and preinstalled packages to perform video processing and connecting the pose estimation tools. |

Références

- LaValle, C. R., et al. Neurocognitive performance deficits related to immediate and acute blast overpressure exposure. Front Neurol. 10, (2019).

- Kamimori, G. H., et al. Longitudinal investigation of neurotrauma serum biomarkers, behavioral characterization, and brain imaging in soldiers following repeated low-level blast exposure (New Zealand Breacher Study). Military Med. 183 (suppl_1), 28-33 (2018).

- Wang, Z., et al. Acute and chronic molecular signatures and associated symptoms of blast exposure in military breachers. J Neurotrauma. 37 (10), 1221-1232 (2020).

- Gill, J., et al. Moderate blast exposure results in increased IL-6 and TNFα in peripheral blood. Brain Behavior Immunity. 65, 90-94 (2017).

- Carr, W., et al. Ubiquitin carboxy-terminal hydrolase-L1 as a serum neurotrauma biomarker for exposure to occupational low-Level blast. Front Neurol. 6, (2015).

- Boutté, A. M., et al. Brain-related proteins as serum biomarkers of acute, subconcussive blast overpressure exposure: A cohort study of military personnel. PLoS One. 14 (8), e0221036 (2019).

- Skotak, M., et al. Occupational blast wave exposure during multiday 0.50 caliber rifle course. Front Neurol. 10, (2019).

- Kamimori, G. H., Reilly, L. A., LaValle, C. R., Silva, U. B. O. D. Occupational overpressure exposure of breachers and military personnel. Shock Waves. 27 (6), 837-847 (2017).

- Misistia, A., et al. Sensor orientation and other factors which increase the blast overpressure reporting errors. PLoS One. 15 (10), e0240262 (2020).

- National Defense Authorization Act for Fiscal Year 2020. Wikipedia Available from: https://en.wikipedia.org/w/index.php?title=National_Defense_Authorization_Act_for_Fiscal_Year_2020&oldid=1183832580 (2023)

- Przekwas, A., et al. Fast-running tools for personalized monitoring of blast exposure in military training and operations. Military Med. 186 (Supplement_1), 529-536 (2021).

- Spencer, R. W., et al. Fiscal year 2018 National Defense Authorization Act, Section 734, Weapon systems line of inquiry: Overview and blast overpressure tool-A module for human body blast wave exposure for safer weapons training. Military Med. 188 (Supplement_6), 536-544 (2023).

- Delp, S. L., et al. OpenSim: open-source software to create and analyze dynamic simulations of movement. IEEE Trans Biomed Eng. 54 (11), 1940-1950 (2007).

- Zhou, X., Sun, K., Roos, P. E., Li, P., Corner, B. Anthropometry model generation based on ANSUR II database. Int J Digital Human. 1 (4), 321 (2016).

- Zhou, X., Przekwas, A. A fast and robust whole-body control algorithm for running. Int J Human Factors Modell Simulat. 2 (1-2), 127-148 (2011).

- Zhou, X., Whitley, P., Przekwas, A. A musculoskeletal fatigue model for prediction of aviator neck manoeuvring loadings. Int J Human Factors Modell Simulat. 4 (3-4), 191-219 (2014).

- Roos, P. E., Vasavada, A., Zheng, L., Zhou, X. Neck musculoskeletal model generation through anthropometric scaling. PLoS One. 15 (1), e0219954 (2020).

- Garimella, H. T., Kraft, R. H. Modeling the mechanics of axonal fiber tracts using the embedded finite element method. Int J Numer Method Biomed Eng. 33 (5), (2017).

- Garimella, H. T., Kraft, R. H., Przekwas, A. J. Do blast induced skull flexures result in axonal deformation. PLoS One. 13 (3), e0190881 (2018).

- Przekwas, A., et al. Biomechanics of blast TBI with time-resolved consecutive primary, secondary, and tertiary loads. Military Med. 184 (Suppl 1), 195-205 (2019).

- Gharahi, H., Garimella, H. T., Chen, Z. J., Gupta, R. K., Przekwas, A. Mathematical model of mechanobiology of acute and repeated synaptic injury and systemic biomarker kinetics. Front Cell Neurosci. 17, 1007062 (2023).

- Przekwas, A., Somayaji, M. R., Gupta, R. K. Synaptic mechanisms of blast-induced brain injury. Front Neurol. 7, 2 (2016).

- Liu, Y., Wang, C., Zhou, Y. Camouflaged people detection based on a semi-supervised search identification network. Def Technol. 21, 176-183 (2023).

- Real time 3D body pose estimation using MediaPipe. Available from: https://temugeb.github.io/python/computer_vision/2021/09/14/bodypose3d.html (2021)

Réimpressions et Autorisations

Demande d’autorisation pour utiliser le texte ou les figures de cet article JoVE

Demande d’autorisationExplorer plus d’articles

This article has been published

Video Coming Soon