É necessária uma assinatura da JoVE para visualizar este conteúdo. Faça login ou comece sua avaliação gratuita.

Method Article

Acompanhamento a longo prazo de vídeo de animais aquáticos, Cohoused: um estudo de caso da atividade locomotora diária do lagostim (Nephrops norvegicus)

* Estes autores contribuíram igualmente

Neste Artigo

Resumo

Aqui nós apresentamos um protocolo para controlar individualmente os animais durante um longo período de tempo. Ele usa a visão computacional, métodos para identificar um conjunto de marcas construídos manualmente usando um grupo de lagostas como estudo de caso, simultaneamente, fornecendo informações sobre como a casa, manipulam e marcam as lagostas.

Resumo

Apresentamos um protocolo relacionado a uma técnica de controle de vídeo baseada na limiarização de imagem que torna possível controlar individualmente os animais cohoused e subtração de fundo. Nós testamos a rotina de rastreamento com quatro cohoused lagostim (Nephrops norvegicus) sob condições de luz-escuridão durante 5 dias. As lagostas tinham sido marcadas individualmente. A instalação experimental e as técnicas de rastreamento utilizadas baseiam-se inteiramente sobre o software de código aberto. A comparação entre a saída de rastreamento com uma detecção manual indica que as lagostas eram corretamente detectado 69% das vezes. Entre as lagostas detectadas corretamente, suas marcas individuais foram corretamente identificados 89,5% das vezes. Considerando a taxa de quadros usados no protocolo e a taxa de circulação de lagostas, o desempenho de rastreamento o vídeo tem uma boa qualidade, e os resultados representativos suportam a validade do protocolo em produzir dados valiosos para as necessidades de pesquisa (individual ocupação de espaço ou padrões de atividade locomotora). O protocolo apresentado aqui pode ser facilmente personalizado e é, portanto, transferível para outras espécies, onde o acompanhamento individual de espécimes em um grupo pode ser valioso para responder às perguntas de pesquisa.

Introdução

Nos últimos anos, rastreamento automatizado baseado em imagem forneceu conjuntos de dados altamente precisos que podem ser usados para explorar questões básicas em ecologia e comportamento de disciplinas1. Esses conjuntos de dados podem ser usados para a análise quantitativa do comportamento animal2,3. No entanto, cada metodologia de imagem usada para controlar os animais e avaliação de comportamento tem seus pontos fortes e limitações. Nos protocolos de rastreamento com base em imagem que usa a informação espacial de quadros anteriores em um filme para controlar animais4,5,6, erros podem ser introduzidos quando cruzam os caminhos dos dois animais. Esses erros são geralmente irreversíveis e propagam-se através do tempo. Apesar dos avanços computacionais que reduzem ou quase eliminam este problema5,7, estas técnicas ainda precisam de ambientes homogêneos experimentais para rastreamento e identificação animal precisa.

O emprego de marcas que podem ser identificados exclusivamente em animais evita esses erros e permite o acompanhamento a longo prazo dos indivíduos identificados. Marcadores amplamente utilizados (por exemplo, códigos de barra e códigos QR) existem na indústria e comércio e podem ser identificados utilizando técnicas de visão de computador bem conhecidos, tais como aumentada realidade (por exemplo, ARTag8) e calibração da câmera (por exemplo, CALTag9 ). Animais marcados anteriormente têm sido utilizados para estudos comportamentais de alta produtividade em diferentes espécies animais, por exemplo, formigas3 ou abelhas10, mas alguns desses sistemas anteriores não são otimizadas para reconhecer tags isolado3.

O protocolo de rastreamento apresentado neste trabalho é especialmente adequado para rastreamento de animais, imagens de um canal, tais como infravermelho (IR) luz ou luz monocromática (particularmente, nós usamos luz azul). Portanto, o método desenvolvido não usa pistas de cor, sendo também aplicáveis a outras configurações onde há restrições em iluminação. Além disso, usamos etiquetas personalizadas concebidas de modo a para não perturbar as lagostas e, ao mesmo tempo, permitir a gravação com câmeras de baixo custo. Além disso, o método utilizado aqui é baseado na deteção de marca independente de quadro (i.., o algoritmo reconhece a presença de cada marca na imagem independentemente das trajectórias anteriores). Esse recurso é relevante em aplicações onde os animais podem ser ocluídos temporariamente ou trajetórias dos animais podem se cruzam.

O design da marca permite seu uso em diferentes grupos de animais. Uma vez que os parâmetros do método são definidos, pode ser transferida para resolver outros problemas de controle de animais sem a necessidade de formação de um classificador específico (outros crustáceos ou gastrópodes). As principais limitações de exportar o protocolo são do tamanho da marca e a necessidade de ligação com o animal (o que faz não é adequado para pequenos insetos, como moscas, abelhas, etc.) e o pressuposto 2D para a circulação de animais. Essa restrição é significativa, dado que o método proposto assume que o tamanho de etiqueta permanece constante. Um animal mover-se livremente em um ambiente 3D (por exemplo, peixe) iria mostrar tamanhos de marca diferente dependendo de sua distância para a câmera.

O propósito do presente protocolo é fornecer uma metodologia user-friendly para acompanhamento de vários animais marcados por um longo período de tempo (dias ou semanas), em um contexto 2D. A abordagem metodológica baseia-se na utilização de hardware e software de fonte aberta. O software livre e open source permite adaptações, modificações e redistribuição livre; Portanto, o software gerado melhora em cada etapa11,12.

O protocolo apresentado aqui se concentra em um laboratório criado para acompanhar e avaliar a atividade locomotora de quatro animais aquáticos em um tanque por 5 dias. Os arquivos de vídeo gravados a partir de uma imagem de lapso de tempo de 1 s e compilados em um vídeo em 20 frames por segundo (1 dia gravado ocupa cerca de 1 h de vídeo). Todas as gravações de vídeo são automaticamente pós-processada para obter posições animais, aplicação de algoritmos e métodos de visão de computador. O protocolo permite a obtenção de grandes quantidades de dados, evitando sua anotação manual, que foi mostrada para ser demorada e trabalhosa em anteriores trabalhos experimentais13de controle.

Nós usamos o lagostim (Nephrops norvegicus) para o estudo de caso; assim, nós fornecemos condições de laboratório específicas para mantê-los. Lagostas executam ritmos de surgimento de toca bem estudados que estão sob o controle do relógio circadiano14,15, e quando cohoused, formam a hierarquia de dominância16,17. Portanto, o modelo apresentado aqui é um bom exemplo para pesquisadores interessados na modulação do comportamento, com um foco específico sobre ritmos circadianos social.

A metodologia apresentada aqui é facilmente reproduzida e pode ser aplicada a outras espécies, se existe a possibilidade de distinguir entre animais com marcas individuais. Os requisitos mínimos para a reprodução de tal abordagem em laboratório são (i) isotérmicos quartos para a instalação experimental; (ii) um fornecimento contínuo de água; (iii) mecanismos de controle de temperatura de água; (iv) um sistema de controle de luz; (v) uma câmera USB e um computador padrão.

Neste protocolo, usamos Python18 e OpenCV19 (Open Source computador Vision Library). Contamos com rápido e comumente aplicadas as operações (tanto em termos de implementação e execução), tais como plano de fundo subtração20 e imagem limiarização21,22.

Access restricted. Please log in or start a trial to view this content.

Protocolo

As espécies utilizadas neste estudo não é uma espécie em extinção ou protegida. Experimentos de laboratório e de amostragem seguiram a legislação espanhola e o regulamento interno (ICM-CSIC) de institucional em matéria de bem-estar dos animal. Amostragem de animais foi realizada com a permissão da autoridade local (Governo Regional da Catalunha).

1. amostragem e manutenção animal

Nota: O seguinte protocolo baseia-se no pressuposto de que pesquisadores podem saborear s. norvegicus no campo durante a noite para evitar danos ao fotorreceptores23. Exposição de s. norvegicus ao sol deve ser evitada. Após a amostragem, as lagostas são suposto ser alojados em uma facilidade de aclimatação semelhante ao relatado anteriormente17,24, com um fluxo contínuo de água refrigerada do mar (13 ° C). Os animais utilizados neste estudo são do sexo masculinos no estado intermoult, com um comprimento de cefalotórax (CL; média ± DP) de 43.92 ± 2,08 mm (N = 4).

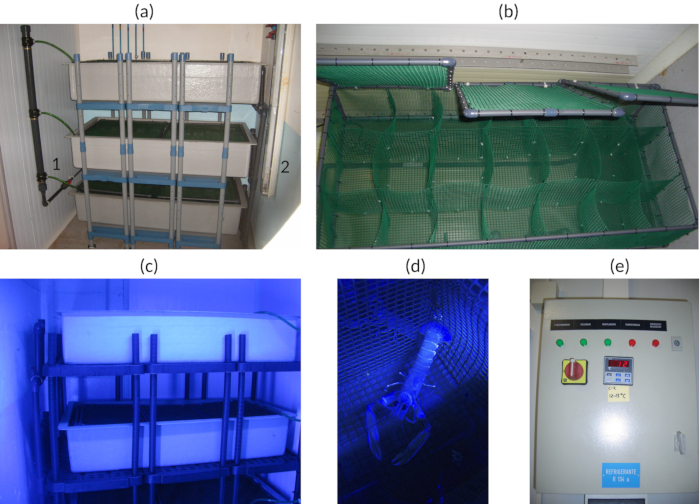

- Manter os indivíduos em compartimentos isolados para evitar quaisquer danos devido a lutas individuais (ver Figura 1a-d).

- Alimentá-los cerca de 3x por semana em momentos aleatórios para não interferir com o ritmo circadiano.

Nota: Neste experimento, mexilhões (cerca de 4 g / lagosta) foram usadas como alimento. Mexilhões foram comprados de fornecedores de alimentos congelados e foram adequados para consumo humano. - Usar a luz azul (425-515 nm) para simular luz horas de acordo com a sensibilidade espectral de25 espécies e as condições ambientais em 400 m profundo26 (veja Figura 1 c,d).

Nota: A instalação usada aqui tem um teto vertical de dois azuis (478 nm) lâmpadas fluorescentes que produziu uma intensidade de luz de 12 lx a 1 m de distância entre as lâmpadas. Consulte a Figura 1a de posição dos candeeiros de tecto e a Tabela de materiais para as características do fabricante e dos técnicas lâmpadas. - Ajustar o fotoperíodo de 12/12 horas de luz/escuridão centro de aclimatação ou simular o fotoperíodo natural da latitude local.

- Regular a temperatura de instalação de 13 ° C e monitorar 2 x diariamente para verificar a temperatura da água da mar admitida é de cerca de 13 ° C (ver Figura 1e).

- Regule a entrada de água do mar, a uma taxa de cerca de 4 L/min para manter boa oxigenação.

Nota: A água do mar circula em um circuito aberto (sem filtros e bombas adicionais são usadas). O abastecimento de água depende dos serviços de planta do aquário principal.

Figura 1 : Vistas de aclimatação facilidade. (um) tanque de prateleiras. (a1) Água do mar de entrada. (a2) Luzes de teto fluorescente. (b) detalhe da luz azul iluminação. (c) detalhe da célula Animal. (d) detalhe de um painel de controle de instalações isoladas. (e) temperatura de configuração para uma das entradas. Clique aqui para ver uma versão maior desta figura.

2. construção da marca

Nota: A tag usada aqui pode ser alterada de acordo com as características do animal-alvo ou outras considerações específicas.

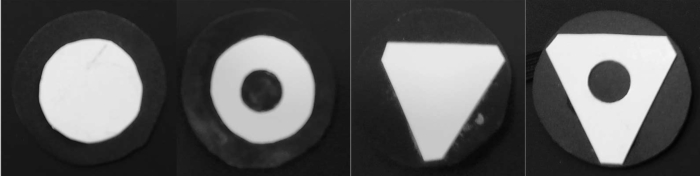

- Corte quatro círculos de 40 mm de diâmetro a partir de uma folha de plástico preto.

- Corte de um branco PVC folha plástica dois triângulos equiláteros com lados de 26 mm.

- Corte de um branco PVC folha plástica dois círculos de 26 mm de diâmetro.

- Marque o centro dos círculos e triângulos brancos e fazer um buraco de 10 mm.

- Cole as quatro formas brancas ao centro dos quatro círculos pretos.

Figura 2 : As quatro rótulos usadas para a marcação individual das lagostas. Círculo, círculo-buraco, triângulo, triângulo-buraco. Clique aqui para ver uma versão maior desta figura.

3. experimental Setup

Nota: A arena experimental é suposto para ser de forma independente da câmara experimental de mas em estreita proximidade com a facilidade de aclimatação.

- Prepare uma câmara experimental onde a temperatura do ar pode ser controlada e mantida à mesma temperatura como a água do mar na área experimental.

-

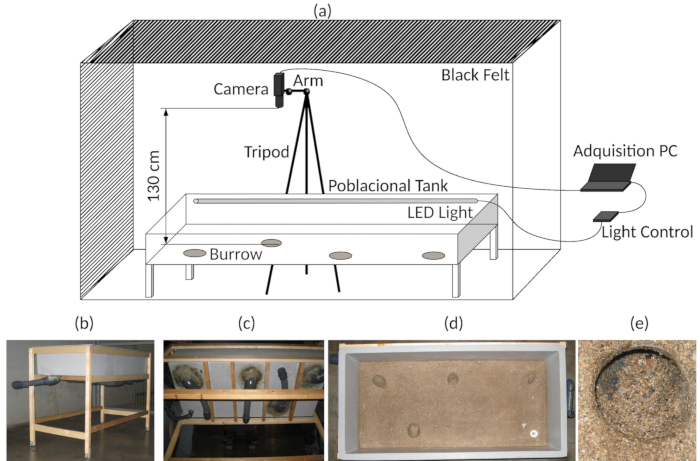

Modifica um tanque de fibra de vidro (1.500 x 700 x 300 mm) para ser usado como uma arena de experimental. Adicione quatro burrows usando tubos de PVC flexíveis no fundo do tanque e vara de areia na superfície onde as lagostas são deveria para mover (Figura 3b-e). Para mais detalhes, consulte17,,27.

- Fornecer a arena experimental com LEDs azuis electrobomba submersível (472 nm, simulando luz horas) e IR LEDs (850 nm, condições escuras) (ver também Figura 3a)17,24.

Nota: Diodo emissor de luz é usado devido ao seu impacto de baixa temperatura e a disponibilidade de controle eletrônico utilizável e hardware livre. Utilizou-se uma instalação isolada com uma temperatura ambiente e água do mar de 13 ± 0,5 ° C. - Mantenha sempre o IR LEDs ligado.

Nota: O IR é necessário para gravar vídeo no escuro e em condições de luz. Não é necessário desligá-lo. - Conecte os LEDs azuis com um aparato para gerenciar o fotoperíodo. Veja as sugestões na Tabela de materiaise para mais detalhes, consulte Sbragaglia et al.. 17 (também mostrado na Figura 3a).

Nota: Iluminação em vídeo ou imagem-automatizada de análises é um fator crítico. Iluminação regular sem sombras por toda a arena evitando reflexões de superfície de água facilita a posterior vídeo ou análise de imagem. No âmbito do presente protocolo, utilizaram-se as condições de luz/escuridão apenas 12/12. Luz e escuridão gradualmente foram alcançadas dentro de 30 min, e um roteiro de luz-controlador é adicionado como arquivo suplementar 1. - Coloque a entrada da água do mar refrigerada em um canto do tanque e a tomada correspondente no canto oposto.

- Regule a entrada de água do mar com um caudal de cerca de 4 L/min.

- Cercam o tanque com uma cortina preta a fim de proporcionar um isolamento completo de outro luz (Figura 3a).

- Fornecer a arena experimental com LEDs azuis electrobomba submersível (472 nm, simulando luz horas) e IR LEDs (850 nm, condições escuras) (ver também Figura 3a)17,24.

- Coloque o tripé para que a câmara web é fixo ao lado da arena experimental e posição da câmera de vídeo acima (130 cm) e no centro da arena experimental (75 x 32,5 cm (ver Figura 3a).

- Verifique se a câmera de vídeo está na posição centrada (ver passo 3.3) para certificar-se não foi movida involuntariamente.

-

Conecte a câmera da web para um computador que é colocado do lado de fora da cortina (Figura 3a).

- Instale o software para gerenciar a gravação de lapso de tempo com a câmera de vídeo.

Nota: Gravações de lapso de tempo dependem de velocidade do movimento da espécie. Consulte também a Tabela de materiais para a câmera, lente olho de peixe, PC e características de software e fabricantes usados aqui. - Ajuste os parâmetros do vídeo gravação de acordo com as características da espécie.

Nota: Considerando a taxa de mobilidade de s. norvegicus, uma gravação de lapso de tempo 1 s foi usada aqui, e o vídeo foi salvo a cada 24 h. - Certifique-se de criar um timestamp (incluindo a data) no vídeo lapso de tempo (como isso pode ajudar para o futuro manual de Pontuação do comportamento).

- Instale o software para gerenciar a gravação de lapso de tempo com a câmera de vídeo.

Figura 3 : Instalação experimental. (a) diagrama da Assembleia do experimental aquisição de tanque e vídeo. (b) vista geral do tanque experimental. (c) fundo vista do tanque experimental, indicando a burrows artificial. (d), Top view, mostrando o fundo do tanque experimental. (e) detalhe de uma das entradas de toca. Clique aqui para ver uma versão maior desta figura.

4. experimental julgamento e preparação de animais

Nota: Todas as etapas com animais devem ser feitas na instalação de aclimatação e sob condições de luz vermelha, de acordo com a sensibilidade espectral de lagosta da Noruega25. Quando se deslocam os animais entre a aclimatação e a instalação experimental, evite qualquer exposição de lagostas à luz, com um saco preto opaco para cobrir a geladeira.

- Preparar uma geladeira anteriormente separada em quatro compartimentos submersos com água a cerca de 7 ° C.

- Prepare as quatro marcas anteriormente construída e rápida colagem, como cianoacrilato.

- Prepare uma bandeja com gelo picado.

- Selecione as quatro lagostas para serem marcadas na instalação de aclimatação e colocar cada um em um compartimento do congelador.

-

Espere 30 min e, em seguida, iniciar o procedimento de marcação.

- Pegue uma lagosta e colocá-lo no gelo esmagado por 5 min para imobilizá-lo e facilitar a operação de marcação.

- Secar a parte superior do cefalotórax a lagosta com papel de adsorção e colocar uma gota de cola rápida sobre ele.

- Coloque a tag horizontalmente no topo do cefalotórax do animal, em contacto com a cola, e esperar o tempo suficiente para a endurecer (por cerca de 20 s).

- Retornar a lagosta para seu compartimento na geladeira e prosseguir com os outros três animais da mesma forma.

- Coloque as lagostas voltar para a cela onde estavam anteriormente e esperar 24h para ter certeza que a marca está devidamente colada.

- Transferi as lagostas da instalação de aclimatação à câmara experimental, usando a mesma geladeira que foi usada para o procedimento de marcação.

- Iniciar a gravação de vídeo e esperar 5 minutos antes de introduzir as lagostas marcadas. Obter uma imagem de fundo em média de 100 quadros iniciais.

Nota: Esperar um mínimo de 1 min é obrigatório para obter o quadros de fundo sem etiquetado lagostas; Eles são necessários para o processamento de vídeo. - Introduza os animais um por um no tanque de experimentação dentro de seu respectivo compartimento, mantendo a água nele.

- Esperar por eles para sair; Se eles não saírem, ajudá-los delicadamente inclinando o compartimento. Consulte a Figura 4 como exemplo dos animais dentro do tanque sob condições experimentais.

Figura 4 : Quadro de vídeo raw. Um exemplo de um quadro de representante de um dos vídeos Time-Lapse coletados durante os experimentos. No canto superior direito, mostramos o carimbo de hora com a data, hora e quadro. Observe as diferenças na iluminação do aquário no canto inferior da imagem. Clique aqui para ver uma versão maior desta figura.

5. a análise Script

-

Realizar a análise após a conclusão do experimento.

- Abra o script de visão de computador para análise de vídeo.

- Lançar o programa em Java para calcular as posições e a distância percorrida pelas lagostas e inserir os dados no banco de dados.

Nota: Este programa é um algoritmo baseado na distância euclidiana28. - Lançamento script SQL para binning dados como intervalo de tempo desejado (ex. 10 min).

6. computador visão Script para análise de vídeo

Nota: O script evita correção de imagem de fisheye, porque ele não introduz um erro relevante na configuração experimental. No entanto, é possível corrigir isso com OpenCV câmera calibração funções29 baseado em vetor e matriz de rotação métodos30,31.

- Selecione a linguagem de programação Python18 .

- Selecione a imagem de19 OpenCV e biblioteca de processamento de vídeo.

- Carrega um vídeo.

Nota: Formatos de vídeo AVI ou . MP4 foram utilizados neste experimento, mas isto não é obrigatório. Depende os FourCC32 codecs instalados no sistema operacional. -

Execute as seguintes etapas para cada quadro Fi no vídeo.

- Subtrair o fundo20B (média dos últimos 100 frames, obtidos da etapa 4.6) do atual quadro Fie atualizar a imagem de fundo B como Fi. Use a função BackgroundSubtractorMOG2 da biblioteca OpenCV19 (veja os scripts no arquivo complementar 2).

- Determine o conjunto de regiões de interesse (ROIs) R a partir de pixels com movimento relevante indicado pelo subtrator de fundo. Use o método aplicável de BackgroundSubtractorMOG2 na biblioteca de19 OpenCV (veja os scripts no arquivo complementar 2). No conjunto, incluem as detecções animais do quadro anterior, em animais além de conta.

- Execute as seguintes etapas para cada ROI Ri

- Aplicar a função dilate e computar os contornos33 do ROI Ri. Use as funções se dilatam e findContours da biblioteca OpenCV19 (veja os scripts no arquivo complementar 2).

- Calcule o casco área34Oi no número de pixels. Use a função convexHull da biblioteca OpenCV19 (veja os scripts no arquivo complementar 2).

- Calcular o raio35ri de ROI Ri. Use a função minEnclosingCircle da biblioteca OpenCV19 (veja os scripts no arquivo complementar 2).

- Calcule a solidez si do ROI Ri. Solidez é a relação entre a área de contorno (obtida na etapa 6.4.3.1) à sua área de superfície convexa (obtida na etapa 6.4.3.2) de Ri.

- Calcule a taxa de proporção ai de ROI Ri. Proporção é a relação entre a largura e a altura do Ri-retângulo delimitador. O retângulo delimitador é calculado usando a função boundingRect da biblioteca OpenCV19 .

- Selecione um conjunto reduzido de ROIs como um candidato para conter os animais, ajustando as propriedades para a área do casco, raio, solidez e proporção.

- Verifique se hi é menos 500,0 ou maior que 100000.0. Em caso afirmativo, descarte o ROI Ri. Caso contrário, manter o Ri como um candidato ROI para a localização de animais.

- Verifique se o ri é inferior a 40,0. Em caso afirmativo, descarte o ROI Ri. Caso contrário, manter o Ri como um candidato ROI para a localização de animais.

- Verifique se o si é menos do que -4.0 descartar o ROI Ri. Caso contrário, manter o Ri como um candidato ROI para a localização de animais.

- Verifique se a ai é menor que 0,15 ou superior a 4.0. É então, descartar o ROI Ri. Caso contrário, manter o Ri como um candidato ROI para a localização de animais.

Nota: O uso de ROIs reduz o custo computacional, focando a busca de marca na região do corpo do animal. Animais detecções de quadros anteriores são incluídas para evitar detecções erradas quando os animais não estão se movendo.

- Analise o animal ROIs para determinar a identidade da marca. Execução de etapas a seguir para cada ROI Ri e para cada interno ROI Pie extrair o ROIs interno P.

- Binarize a imagem em tons de cinza Pi usando o algoritmo de limiarização de36 de Otsu.

- Calcule os contornos33 de Pi, como na etapa 6.4.3.1.

- Calcule o casco área34Oi e a proporção ai, como em etapas 6.4.3.2 e 6.4.3.5.

- Calcule os momentosde forma37,38mi de Pi. Use a função momentos da biblioteca de19 OpenCV (veja os scripts no arquivo complementar 2).

- Selecione um conjunto reduzido de ROIs como um candidato para conter as marcas, utilizando os seguintes critérios.

- Verifique se hi é menos 150,0 ou superior a 500,0. Em caso afirmativo, descarte o ROI de Pi. Caso contrário, mantenha o Pi como candidato ROI para a localização da marca.

- Verifique se a ai é menor do que 0,5 ou maior que 1,5. Em caso afirmativo, descarte o ROI de Pi. Caso contrário, mantenha o Pi como candidato ROI para a localização de animais.

- Verifique se o mi é superior a 0,3. Em caso afirmativo, descarte o ROI de Pi. Caso contrário, mantenha o Pi como candidato ROI para a localização de animais.

- Classifica a tag ROIs. Aproximada de um polígono39 usando o OpenCV19 função38 para cada selecionado ROI Pi19.

- Verificar se há exatamente três vértices no polígono aproximado; atribua a tag para a classe de triângulo . Caso contrário, atribua a classe circle à região de marca.

Nota: Aproximado de polígono armazenado usando uma matriz com os vértices. - Verifique se o pixel central do ROI Pi. Se é um pixel preto , atribua o Pi à classe escondido . Caso contrário, atribua o Pi para a classe de branco .

Nota: O centro de forma é deduzido a partir os momentos calculados na etapa 6.4.5.4. Procure os pixels pretos em uma área de um raio de 4 pixels em torno do centro.

- Verificar se há exatamente três vértices no polígono aproximado; atribua a tag para a classe de triângulo . Caso contrário, atribua a classe circle à região de marca.

- Salvar os dados do quadro: quadro data, tempo de quadro, forma classe, x centro forma e y centro forma coordenada.

- Continue com o próximo quadro ou encerrar o processo. Consulte a Figura 5 abaixo como um exemplo visual dos passos do roteiro de trabalho e assistir o Video 1 como um exemplo de script funcionando.

Figura 5 : Etapas relevantes do script de processamento de vídeo (1) avaliar o movimento de subtração de fundo sobre a média dos últimos 100 frames. (2) resultado do algoritmo da subtração de fundo. (3) aplicar uma operação morfológica dilate às áreas branco-detectado. (4) aplicar correção, estático, principal ROI; polígono amarelo corresponde à área inferior do tanque. (5) calcular contornos para cada região branco-detectado no ROI principal e realizar uma análise estrutural para cada contorno detectado. (6) verificar valores de propriedade estrutural e, em seguida, selecione os candidatos ROI de segundo nível. (7) Binarize quadro usando um algoritmo de limiarização de Otsu; o script só funciona com ROIs de segundo nível. (8) para cada binarized ROI de segundo nível, calcular os contornos das regiões brancas e realizar uma análise estrutural para cada um detectado contorno. (9) verificar a propriedade estrutural valores e, em seguida, seleciona candidatos internos de ROI. (10) para cada contorno no candidato interno de ROI, calcular os descritores/momentos. (11) Verifique se as partidas de forma detectados com o modelo forma e aproximam um polígono para os melhores candidatos de partida. (12) verificar o número de vértices do polígono aproximado e determinar a figura geométrica: círculo ou triângulo. (13), calcular a figura central e verificar se ocorrem pixels pretos; Se sim, é uma figura furada. (14) resultado visual após análise do quadro. Clique aqui para ver uma versão maior desta figura.

Access restricted. Please log in or start a trial to view this content.

Resultados

Nós construímos manualmente um subconjunto dos dados experimentais para validar a análise automatizada de vídeo. Um tamanho de amostra de 1.308 quadros com um nível de confiança de 99% (que é uma medida de segurança que mostra se a amostra reflete com precisão a população, dentro de sua margem de erro) e uma margem de erro de 4% (que é uma porcentagem que descreve como fechar o resposta a amostra deu é o valor real da população) foi aleatoriamente selecionado, e realizou-se...

Access restricted. Please log in or start a trial to view this content.

Discussão

Os resultados de desempenho e representante obtidos com o protocolo de controle de vídeo confirmaram sua validade para a investigação aplicada no domínio do comportamento animal, com um foco específico sobre modulação social e ritmos circadianos dos animais cohoused. A eficácia da detecção de animais (69%) e a precisão da discriminação marca (89,5%) juntamente com as características comportamentais (ou seja, taxa de circulação) das espécies-alvo usadas aqui sugerem que este protocolo é uma solução per...

Access restricted. Please log in or start a trial to view this content.

Divulgações

Os autores não têm nada para divulgar.

Agradecimentos

Os autores agradecem à Dr. Joan B. empresa que financiou a publicação deste trabalho. Também, os autores agradecem aos técnicos da zona de aquário experimental no Instituto de Ciências marinhas em Barcelona (ICM-CSIC) por sua ajuda durante o trabalho experimental.

Este trabalho foi financiado pelo projeto RITFIM (CTM2010-16274; investigador principal: J. Aguzzi) fundada pelo Ministério espanhol de ciência e inovação (MICINN) e a concessão de TIN2015-66951-C2-2-R do Ministério espanhol de economia e competitividade.

Access restricted. Please log in or start a trial to view this content.

Materiais

| Name | Company | Catalog Number | Comments |

| Tripod 475 | Manfrotto | A0673528 | Discontinued |

| Articulated Arm 143 | Manfrotto | D0057824 | Discontinued |

| Camera USB 2.0 uEye LE | iDS | UI-1545LE-M | https://en.ids-imaging.com/store/products/cameras/usb-2-0-cameras/ueye-le.html |

| Fish Eye Len C-mount f = 6 mm/F1.4 | Infaimon | Standard Optical | https://www.infaimon.com/es/estandar-6mm |

| Glass Fiber Tank 1500 x 700 x 300 mm3 | |||

| Black Felt Fabric | |||

| Wood Structure Tank | 5 Wood Strips 50x50x250 mm | ||

| Wood Structure Felt Fabric | 10 Wood Strips 25x25x250 mm | ||

| Stainless Steel Screws | As many as necessary for fix wood strips structures | ||

| PC | 2-cores CPU, 4GB RAM, 1 GB Graphics, 500 GB HD | ||

| External Storage HDD | 2 TB capacity desirable | ||

| iSPY Sotfware for Windows PC | iSPY | https://www.ispyconnect.com/download.aspx | |

| Zoneminder Software Linux PC | Zoneminder | https://zoneminder.com/ | |

| OpenCV 2.4.13.6 Library | OpenCV | https://opencv.org/ | |

| Python 2.4 | Python | https://www.python.org/ | |

| Camping Icebox | |||

| Plastic Tray | |||

| Cyanocrylate Gel | To glue tag’s | ||

| 1 black PVC plastic sheet (1 mm thickness) | Tag's construction | ||

| 1 white PVC plastic sheet (1 mm thickness) | Tag's construction | ||

| 4 Tag’s Ø 40 mm | Maked with black & white PVC plastic sheet | ||

| 3 m Blue Strid Led Ligts (480 nm) | Waterproof as desirable | ||

| 3 m IR Strid Led Ligts (850 nm) | Waterproof as desirable | ||

| 6 m Methacrylate Pipes Ø 15 mm | Enclosed Strid Led | ||

| 4 PVC Elbow 45o Ø 63 mm | Burrow construction | ||

| 3 m Flexible PVC Pipe Ø 63 mm | Burrow construction | ||

| 4 PVC Screwcap Ø 63 mm | Burrow construction | ||

| 4 O-ring Ø 63 mm | Burrow construction | ||

| 4 Female PVC socket glue / thread Ø 63 mm | Burrow construction | ||

| 10 m DC 12V Electric Cable | Light Control Mechanism | ||

| Ligt Power Supply DC 12 V 300 W | Light Control Mechanism | ||

| MOSFET, RFD14N05L, N-Canal, 14 A, 50 V, 3-Pin, IPAK (TO-251) | RS Components | 325-7580 | Light Control Mechanism |

| Diode, 1N4004-E3/54, 1A, 400V, DO-204AL, 2-Pines | RS Components | 628-9029 | Light Control Mechanism |

| Fuse Holder | RS Components | 336-7851 | Light Control Mechanism |

| 2 Way Power Terminal 3.81 mm | RS Components | 220-4658 | Light Control Mechanism |

| Capacitor 220 µF 200 V | RS Components | 440-6761 | Light Control Mechanism |

| Resistance 2K2 7 W | RS Components | 485-3038 | Light Control Mechanism |

| Fuse 6.3 x 32 mm2 3A | RS Components | 413-210 | Light Control Mechanism |

| Arduino Uno Atmel Atmega 328 MCU board | RS Components | 715-4081 | Light Control Mechanism |

| Prototipe Board CEM3,3 orific.,RE310S2 | RS Components | 728-8737 | Light Control Mechanism |

| DC/DC converter,12 Vin,+/-5 Vout 100 mA 1 W | RS Components | 689-5179 | Light Control Mechanism |

| 2 SERA T8 blue moonlight fluorescent bulb 36 watts | SERA | Discontinued/Light isolated facility |

Referências

- Dell, A. I., et al. Automated image-based tracking and its application in ecology. Trends in Ecology & Evolution. 29 (7), 417-428 (2014).

- Berman, G. J., Choi, D. M., Bialek, W., Shaevitz, J. W. Mapping the stereotyped behaviour of freely moving fruit flies. Journal of The Royal Society Interface. 11 (99), (2014).

- Mersch, D. P., Crespi, A., Keller, L. Tracking Individuals Shows Spatial Fidelity Is a Key Regulator of Ant Social Organization. Science. 340 (6136), 1090(2013).

- Tyson, L. Hedrick Software techniques for two- and three-dimensional kinematic measurements of biological and biomimetic systems. Bioinspiration & Biomimetics. 3 (3), 034001(2008).

- Branson, K., Robie, A. A., Bender, J., Perona, P., Dickinson, M. H. High-throughput ethomics in large groups of Drosophila. Nature Methods. 6 (6), 451-457 (2009).

- de Chaumont, F., et al. Computerized video analysis of social interactions in mice. Nature Methods. 9, 410(2012).

- Pérez-Escudero, A., Vicente-Page, J., Hinz, R. C., Arganda, S., de Polavieja, G. G. idTracker: tracking individuals in a group by automatic identification of unmarked animals. Nature Methods. 11 (7), 743-748 (2014).

- Fiala, M. ARTag, a fiducial marker system using digital techniques. 2005 IEEE Computer Society Conference on Computer Vision and Pattern Recognition (CVPR’05). 2, 590-596 (2005).

- Koch, R., Kolb, A., Rezk-Salama, C. CALTag: High Precision Fiducial Markers for Camera Calibration. Koch, R., Kolb, A., Rezk-salama, C. , (2010).

- Crall, J. D., Gravish, N., Mountcastle, A. M., Combes, S. A. BEEtag: A Low-Cost, Image-Based Tracking System for the Study of Animal Behavior and Locomotion. PLOS ONE. 10 (9), e0136487(2015).

- Charpentier, R. Free and Open Source Software: Overview and Preliminary Guidelines for the Government of Canada. Open Source Business Resource. , (2008).

- Crowston, K., Wei, K., Howison, J. Free/Libre Open Source Software Development: What We Know and What We Do Not Know. ACM Computing Surveys. 37, (2012).

- Edmonds, N. J., Riley, W. D., Maxwell, D. L. Predation by Pacifastacus leniusculus on the intra-gravel embryos and emerging fry of Salmo salar. Fisheries Management and Ecology. 18 (6), 521-524 (2011).

- Sbragaglia, V., et al. Identification, Characterization, and Diel Pattern of Expression of Canonical Clock Genes in Nephrops norvegicus (Crustacea: Decapoda) Eyestalk. PLOS ONE. 10 (11), e0141893(2015).

- Sbragaglia, V., et al. Dusk but not dawn burrow emergence rhythms of Nephrops norvegicus (Crustacea: Decapoda). Scientia Marina. 77 (4), 641-647 (2013).

- Katoh, E., Sbragaglia, V., Aguzzi, J., Breithaupt, T. Sensory Biology and Behaviour of Nephrops norvegicus. Advances in Marine Biology. 64, 65-106 (2013).

- Sbragaglia, V., Leiva, D., Arias, A., Antonio García, J., Aguzzi, J., Breithaupt, T. Fighting over burrows: the emergence of dominance hierarchies in the Norway lobster (Nephrops norvegicus). The Journal of Experimental Biology. 220 (24), 4624-4633 (2017).

- Welcome to Python.org. , https://www.python.org/ (2018).

- Bradski, G. OpenCV Library. Dr. Dobb’s Journal of Software Tools. , (2000).

- Piccardi, M. Background subtraction techniques: a review. 2004 IEEE International Conference on Systems, Man and Cybernetics (IEEE Cat. No.04CH37583). 4, 3099-3104 (2004).

- Sankur, B. Survey over image thresholding techniques and quantitative performance evaluation. Journal of Electronic Imaging. 13 (1), 146(2004).

- Lai, Y. K., Rosin, P. L. Efficient Circular Thresholding. IEEE Transactions on Image Processing. 23 (3), 992-1001 (2014).

- Gaten, E. Light‐induced damage to the dioptric apparatus of Nephrops norvegicus (L.) and the quantitative assessment of the damage. Marine Behaviour and Physiology. 13 (2), 169-183 (1988).

- Sbragaglia, V., et al. An automated multi-flume actograph for the study of behavioral rhythms of burrowing organisms. Journal of Experimental Marine Biology and Ecology. 446, 177-186 (2013).

- Johnson, M. L., Gaten, E., Shelton, P. M. J. Spectral sensitivities of five marine decapod crustaceans and a review of spectral sensitivity variation in relation to habitat. Journal of the Marine Biological Association of the United Kingdom. 82 (5), 835-842 (2002).

- Markager, S., Vincent, W. F. Spectral light attenuation and the absorption of UV and blue light in natural waters. Limnology and Oceanography. 45 (3), 642-650 (2000).

- Aguzzi, J., et al. A New Laboratory Radio Frequency Identification (RFID) System for Behavioural Tracking of Marine Organisms. Sensors. 11 (10), 9532-9548 (2011).

- Audin, M. Geometry [Electronic Resource. , Springer Berlin Heidelberg:, Imprint: Springer. Berlin, Heidelberg. (2003).

- OpenCV Team Structural Analysis and Shape Descriptors - OpenCV 2.4.13.7 documentation. , https://docs.opencv.org/2.4/modules/imgproc/doc/structural_analysis_and_shape_descriptors.html?highlight=findcontours#void%20HuMoments(const%20Moments&%20m,%20OutputArray%20hu) (2018).

- Slabaugh, G. G. Computing Euler angles from a rotation matrix. 7, (1999).

- Zhang, Z. A flexible new technique for camera calibration. IEEE Transactions on Pattern Analysis and Machine Intelligence. 22 (11), 1330-1334 (2000).

- www.FOURCC.org - Video Codecs and Pixel Formats. , https://www.fourcc.org/ (2018).

- Suzuki, S., be, K. Topological structural analysis of digitized binary images by border following. Computer Vision, Graphics, and Image Processing. 30 (1), 32-46 (1985).

- Sklansky, J. Finding the convex hull of a simple polygon. Pattern Recognition Letters. 1 (2), 79-83 (1982).

- Fitzgibbon, A., Fisher, R. A Buyer’s Guide to Conic Fitting. , 51.1-51.10 (1995).

- Otsu, N. A Threshold Selection Method from Gray-Level Histograms. IEEE Transactions on Systems, Man, and Cybernetics. 9 (1), 62-66 (1979).

- Hu, M. K. Visual pattern recognition by moment invariants. IRE Transactions on Information Theory. 8 (2), 179-187 (1962).

- Structural Analysis and Shape Descriptors - OpenCV 2.4.13.6 documentation. , https://docs.opencv.org/2.4/modules/imgproc/doc/structural_analysis_and_shape_descriptors.html?highlight=cvmatchshapes#humoments (2018).

- Douglas, D. H., Peucker, T. K. Algorithms for the Reduction of the Number of Points Required to Represent a Digitized Line or its Caricature. Cartographica: The International Journal for Geographic Information and Geovisualization. 10 (2), 112-122 (1973).

- Vanajakshi, B., Krishna, K. S. R. Classification of boundary and region shapes using Hu-moment invariants. Indian Journal of Computer Science and Engineering. 3, 386-393 (2012).

- Kahle, D., Wickham, H. ggmap : Spatial Visualization with ggplot2. The R Journal. , 144-162 (2013).

- Venables, W. N., Ripley, B. D. Modern Applied Statistics with S. , Springer. New York. (2010).

- Abbas, Q., Ibrahim, M. E. A., Jaffar, M. A. A comprehensive review of recent advances on deep vision systems. Artificial Intelligence Review. , (2018).

- Menesatti, P., Aguzzi, J., Costa, C., García, J. A., Sardà, F. A new morphometric implemented video-image analysis protocol for the study of social modulation in activity rhythms of marine organisms. Journal of Neuroscience Methods. 184 (1), 161-168 (2009).

- Chapman, C. J., Shelton, P. M. J., Shanks, A. M., Gaten, E. Survival and growth of the Norway lobster Nephrops norvegicus in relation to light-induced eye damage. Marine Biology. 136 (2), 233-241 (2000).

- Video tracking software | EthoVision XT. , https://www.noldus.com/animal-behavior-research/products/ethovision-xt (2018).

- Correll, N., Sempo, G., Meneses, Y. L. D., Halloy, J., Deneubourg, J., Martinoli, A. SwisTrack: A Tracking Tool for Multi-Unit Robotic and Biological Systems. 2006 IEEE/RSJ International Conference on Intelligent Robots and Systems. , 2185-2191 (2006).

- MATLAB - MathWorks. , https://www.mathworks.com/products/matlab.html (2018).

- Leggat, P. A., Smith, D. R., Kedjarune, U. Surgical Applications of Cyanoacrylate Adhesives: A Review of Toxicity. ANZ Journal of Surgery. 77 (4), 209-213 (2007).

- Dizon, R. M., Edwards, A. J., Gomez, E. D. Comparison of three types of adhesives in attaching coral transplants to clam shell substrates. Aquatic Conservation: Marine and Freshwater Ecosystems. 18 (7), 1140-1148 (2008).

- Cary, R. Methyl cyanoacrylate and ethyl cyanoacrylate. , World Health Organization. Geneva. (2001).

- Krizhevsky, A., Sutskever, I., Hinton, G. E. Imagenet classification with deep convolutional neural networks. Advances in neural information processing systems. , http://papers.nips.cc/paper/4824-imagenet-classification-w 1097-1105 (2012).

Access restricted. Please log in or start a trial to view this content.

Reimpressões e Permissões

Solicitar permissão para reutilizar o texto ou figuras deste artigo JoVE

Solicitar PermissãoThis article has been published

Video Coming Soon

Copyright © 2025 MyJoVE Corporation. Todos os direitos reservados