È necessario avere un abbonamento a JoVE per visualizzare questo. Accedi o inizia la tua prova gratuita.

Method Article

A lungo termine dei Video rilevamento di Cohoused animali acquatici: un caso di studio dell'attività locomotrice quotidiana di scampi (Nephrops norvegicus)

* Questi autori hanno contribuito in egual misura

In questo articolo

Riepilogo

Qui presentiamo un protocollo per monitorare individualmente gli animali per un lungo periodo di tempo. Usa visione artificiale metodi per identificare un set di tag manualmente costruito utilizzando un gruppo di aragoste come caso di studio, fornendo al contempo informazioni su come a casa, manipolare e contrassegno le aragoste.

Abstract

Vi presentiamo un protocollo relazionato a una tecnica di video-monitoraggio basata sulla sottrazione di sfondo e soglia di immagine che rende possibile seguire individualmente gli animali cohoused. Abbiamo testato la routine di rilevamento con quattro cohoused scampi (Nephrops norvegicus) in condizioni di luce-buio per 5 giorni. Le aragoste erano stata contrassegnate individualmente. La messa a punto sperimentale e le tecniche di rilevamento utilizzate sono interamente basate su software open source. Indica il confronto tra l'uscita di rilevamento con un rilevamento manuale che le aragoste erano correttamente rilevato il 69% delle volte. Tra le aragoste correttamente rilevate, loro singoli tag sono stati correttamente identificati 89,5% delle volte. Considerando la frequenza di fotogrammi utilizzate nel protocollo e il tasso di movimento di aragoste, le prestazioni di rilevamento video hanno una buona qualità, e i risultati rappresentativi sostengono la validità del protocollo nella produzione di preziosi dati per esigenze di ricerca (individuo occupazione di spazio o modelli di attività locomotoria). Il protocollo qui presentato possa essere facilmente personalizzato ed è, quindi, trasferibile ad altre specie dove il tracciamento individuale degli esemplari in un gruppo possa essere utile per rispondere alle domande di ricerca.

Introduzione

Negli ultimi anni, rilevamento automatizzato basato su immagine ha fornito altamente accurato set di dati che possono essere utilizzati per esplorare le domande di base in ecologia e comportamento discipline1. Questi set di dati può essere utilizzato per l'analisi quantitativa di comportamento animale2,3. Tuttavia, ogni metodologia di immagine utilizzato per tracciare gli animali e la valutazione di comportamento ha i pregi e limiti. Nei protocolli di rilevamento basato su immagine che utilizzano informazioni spaziali da fotogrammi precedenti in un film per animali4,5,6, errori possono essere introdotte quando attraversano i percorsi di due animali. Questi errori sono in genere irreversibili e propagano attraverso il tempo. Malgrado gli avanzamenti computazionali che ridurre o eliminare quasi questo problema5,7, queste tecniche ancora bisogno di ambienti omogenei sperimentali per il monitoraggio e la precisa identificazione dell'animale.

L'impiego di marchi che possono essere identificati in modo univoco in animali evita questi errori e consente il monitoraggio a lungo termine degli individui identificati. Ampiamente usati indicatori (ad es., codici a barre e codici QR) esistono in commercio e industria e può essere identificati utilizzando tecniche di visione del computer ben noti, come aumentata realtà (ad es., ARTag8) e Calibrazione fotocamera (ad es., CALTag9 ). Taggato come animali precedentemente sono stati usati per studi comportamentali di alto-rendimento in diverse specie animali, per esempio, le formiche3 o API10, ma alcuni di questi sistemi precedenti non sono ottimizzati per riconoscere i tag isolato3.

Il protocollo di rilevamento presentato in questa carta è particolarmente adatto per il monitoraggio di animali nell'immaginario di un canale, come ad esempio la porta a infrarossi (IR) luce o luce monocromatica (in particolare, usiamo la luce blu). Di conseguenza, il metodo sviluppato non utilizzano segnali di colore, anche essere applicabile ad altre impostazioni dove ci sono vincoli nell'illuminazione. Inoltre, utilizziamo i tag personalizzato progettato per non disturbare le aragoste e, allo stesso tempo, consentire di registrare con fotocamere di basso costo. Inoltre, il metodo qui utilizzato si basa sul rilevamento di etichetta indipendente dal telaio (vale a dire., l'algoritmo riconosce la presenza di ciascun tag dell'immagine indipendentemente le traiettorie precedente). Questa funzione è rilevante nelle applicazioni dove gli animali possono essere temporaneamente occluso, o le traiettorie degli animali possono intersecare.

L'etichetta design consente l'utilizzo in diversi gruppi di animali. Una volta impostati i parametri del metodo, potrebbe essere trasferito per affrontare altri problemi relativi al rilevamento degli animali senza l'esigenza di formazione un classificatore specifico (altri crostacei o gasteropodi). Le principali limitazioni di esportazione del protocollo sono le dimensioni del tag e la necessità di attaccamento all'animale (che lo rende non adatto per piccoli insetti, come mosche, API, ecc.) ed il presupposto 2D per la movimentazione degli animali. Questo vincolo è significativo, dato che il metodo proposto presuppone che i tag dimensione rimangano costanti. Un animale di muoversi liberamente in un ambiente 3D (ad es. pesce) mostrerebbe dimensioni tag diverso a seconda della sua distanza alla fotocamera.

Lo scopo del presente protocollo è quello di fornire una metodologia facile da usare per tenere traccia di più animali contrassegnati per un lungo periodo di tempo (giorni o settimane) in un contesto 2D. L'approccio metodologico si basa sull'uso di hardware e software open source. Software libero e open source permette adattamenti, modifiche e ridistribuzione gratuita; di conseguenza, il software generato migliora a ogni passaggio11,12.

Il protocollo qui presentato si concentra su un laboratorio allestito per monitorare e valutare l'attività locomotrice di quattro animali acquatici in un serbatoio per 5 giorni. I file video sono registrati da una 1 immagine di time-lapse s e compilati in un video a 20 fotogrammi al secondo (1 giorno registrati occupa circa 1 ora di video). Tutte le registrazioni video sono automaticamente postprocessed per ottenere le posizioni degli animali, l'applicazione di algoritmi e metodi di visione al computer. Il protocollo permette di ottenere grandi quantità di dati, evitando loro annotazione manuale, che è stato indicato per essere tempo-intenso e laborioso in precedenti documenti sperimentale13di rilevamento.

Usiamo lo scampo (Nephrops norvegicus) per il caso di studio; quindi, mettiamo a disposizione condizioni di laboratorio specifici della specie di mantenerli. Aragoste eseguire ritmi di emersione tana ben studiata che sono sotto il controllo dell'orologio circadiano14,15, e quando cohoused, formano la dominanza gerarchia16,17. Quindi, il modello presentato qui è un buon esempio per i ricercatori interessati nella modulazione sociale di comportamento con un focus specifico sui ritmi circadiani.

La metodologia presentata qui è riprodotto con facilità e può essere applicata ad altre specie se c'è la possibilità di distinguere tra animali con singoli tag. I requisiti minimi per la riproduzione di un tale approccio in laboratorio (i) sono camere isotermiche per la messa a punto sperimentale; (ii) un approvvigionamento continuo di acqua; (iii) meccanismi di controllo di temperatura l'acqua; (iv) un sistema di controllo della luce; (v) una fotocamera USB e un computer standard.

In questo protocollo, usiamo Python18 e OpenCV19 (Open Source Computer Vision Library). Ci basiamo su operazioni veloci e comunemente applicate (sia in termini di attuazione e di esecuzione), come sfondo sottrazione20 e immagine Sogliatura21,22.

Protocollo

Le specie utilizzate in questo studio non sono una specie in via di estinzione o protetta. Esperimenti di laboratorio e di campionamento seguita la normativa spagnola e interno istituzionale (ICM-CSIC) in materia di benessere degli animali. Campionamento degli animali è stata condotta con il permesso dell'autorità locale (governo regionale della Catalogna).

1. campionamento e manutenzione animale

Nota: Il seguente protocollo si basa sul presupposto che i ricercatori possono campione N. norvegicus nel campo durante la notte per evitare di danneggiare i fotorecettori23. Esposizione di N. norvegicus alla luce del sole deve essere evitata. Dopo il campionamento, le aragoste sono supposti per essere ospitato in una struttura di acclimatazione simile a quello riportato precedentemente17,24, con un flusso continuo di acqua di mare refrigerata (13 ° C). Gli animali utilizzati in questo studio sono di sesso maschili allo stato intermoult con una lunghezza del cefalotorace (CL; media ± SD) di 43.92 ± 2,08 mm (N = 4).

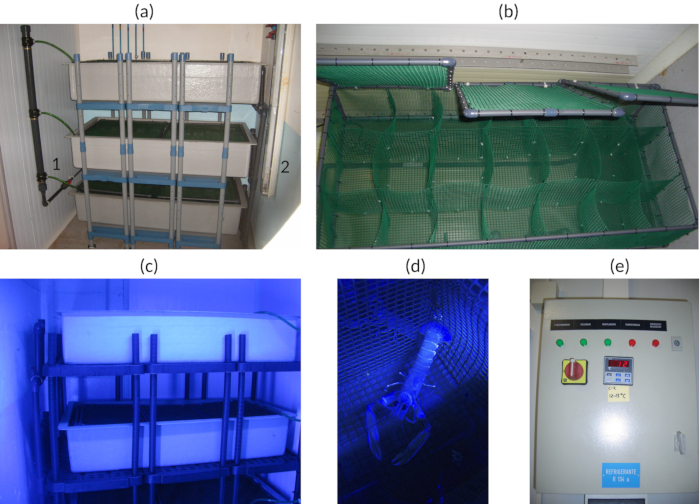

- Mantenere gli individui nei compartimenti isolati per evitare eventuali danni a causa di lotte individuali (Vedi fig. 1a-d).

- Dar loro da mangiare circa 3 volte a settimana a volte casuali per non interferire con i ritmi circadiani.

Nota: In questo esperimento, cozze (circa 4 g per aragosta) sono stati usati come cibo. Mitili sono stati acquistati da fornitori di prodotti alimentari surgelati ed erano adatte per il consumo umano. - Utilizzare luce blu (425-515 nm) per simulare le ore di luce secondo la sensibilità spettrale di25 specie e delle condizioni ambientali alle 400 m profonda26 (Vedi Figura 1 c,sviluppo).

Nota: La struttura utilizzata qui ha un soffitto verticale di due blu (478 nm) lampade fluorescenti che ha prodotto un'intensità di luce di 12 lx 1 m di distanza dalle lampade. Vedere Figura 1a per la posizione delle lampade del soffitto e la Tabella materiali per le caratteristiche tecniche delle lampade e del fabbricante. - Regolare il fotoperiodo dell'impianto acclimatazione a 12/12 ore di luce/buio o simulare il fotoperiodo naturale della latitudine locale.

- Regolare la temperatura impianto a 13 ° C e monitorare 2 volte al giorno per controllare la temperatura dell'acqua del mare inflowing è intorno ai 13 ° C (Vedi Figura 1e).

- Regolare l'afflusso di acqua di mare a una velocità di circa 4 L/min per mantenere buona ossigenazione.

Nota: L'acqua di mare circola in un circuito aperto (filtri e pompe supplementari non sono utilizzate). Il rifornimento idrico dipende dai servizi pianta acquario principale.

Figura 1 : Viste di acclimatazione facility. (una) mensole del serbatoio. (a1) Ingresso dell'acqua di mare. (a2) Plafoniere fluorescenti. illuminazione (b) dettaglio di luce blu. (c) dettaglio della cellula animale. (d) dettaglio di un pannello di controllo di impianto isolato. (e), temperatura ambiente per una delle entrate. Clicca qui per visualizzare una versione più grande di questa figura.

2. costruzione di tag

Nota: Il tag utilizzato qui può essere cambiato secondo le caratteristiche dell'animale di destinazione o altre considerazioni specifiche.

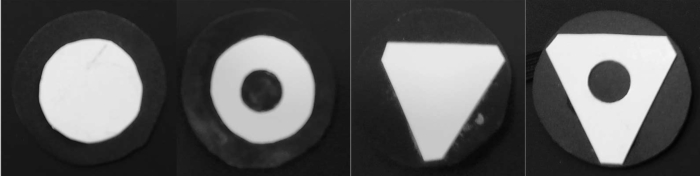

- Tagliare quattro cerchi di 40 mm di diametro da un foglio di plastica nero.

- Tagliare da un bianco PVC foglio di plastica due triangoli equilateri con lati di 26 mm.

- Tagliare da un bianco due cerchi di PVC foglio di plastica di 26 mm di diametro.

- Contrassegnare il centro dei cerchi e triangoli bianchi e praticare un foro di 10 mm in esso.

- Incollare le quattro forme di bianche al centro dei quattro cerchi neri.

Figura 2 : I quattro Tag utilizzati per il tagging individuali delle aragoste. Cerchio, foro del cerchio, triangolo, triangolo-foro. Clicca qui per visualizzare una versione più grande di questa figura.

3. organizzazione sperimentale

Nota: L'arena sperimentale dovrebbe per essere in una camera sperimentale indipendente da ma in prossimità al centro di acclimatazione.

- Impostare una camera sperimentale dove la temperatura dell'aria può essere controllata e mantenuta alla stessa temperatura come l'acqua di mare in ambito sperimentale.

-

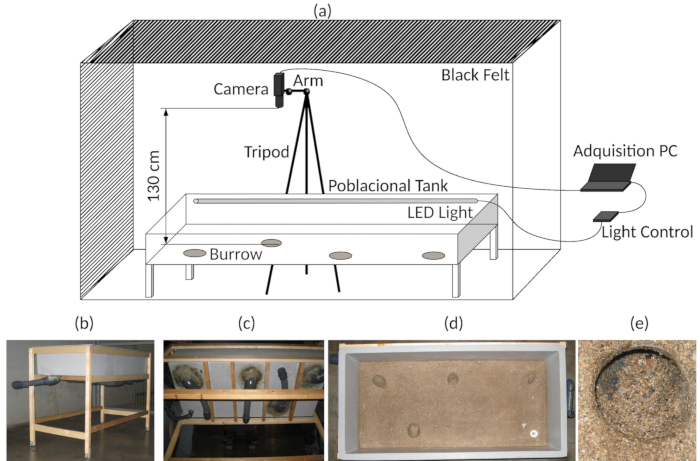

Modificare un serbatoio in fibra di vetro (1.500 x 700 x 300 mm) per essere utilizzato come un'arena sperimentale. Aggiungere quattro tane utilizzando tubi flessibili in PVC nella parte inferiore della sabbia serbatoio e bastone sulla superficie dove le aragoste sono dovuto per spostare (Figura 3b-e). Per ulteriori dettagli, vedere17,27.

- Fornire l'arena sperimentale con LED blu sommergibili (472 nm, simulando le ore di luce) e LED IR (850 nm, condizioni di oscurità) (Vedi anche Figura 3a)17,24.

Nota: Luce LED è usata a causa del suo impatto basso calore e la disponibilità di controllo elettronico utilizzabile e hardware libero. È stato utilizzato un impianto isolato con una temperatura ambientale e dell'acqua di mare di 13 ± 0,5 ° C. - Tenere sempre i LED IR accesi.

Nota: L'IR è necessario per registrare video in condizioni di oscurità e in condizioni di luce. Non è necessario spegnerlo. - Collegare i LED blu con un apparecchio per gestire il fotoperiodo. Vedere i suggerimenti nella Tabella materialie per maggiori dettagli, consultare Sbragaglia et al.. 17 (anche mostrato in Figura 3a).

Nota: Illuminazione nelle analisi di video o immagine automatizzato è un fattore critico. Regolare illuminazione senza ombre tutta l'arena evitando riflessi superficiali dell'acqua facilita il video posteriori o l'analisi dell'immagine. Nel contesto del presente protocollo, sono state utilizzate solo 12/12 condizioni di luce/buio. Luce e le tenebre sono stati raggiunti gradualmente entro 30 min, e uno script di luce-controller viene aggiunto come complementare File 1. - Posto l'ingresso di acqua di mare refrigerata in un angolo del serbatoio e l'uscita corrispondente all'angolo opposto.

- Regolare l'ingresso di acqua di mare ad una portata di circa 4 L/min.

- Circondano il serbatoio con una tenda nera al fine di fornire un completo isolamento da altri luce (Figura 3a).

- Fornire l'arena sperimentale con LED blu sommergibili (472 nm, simulando le ore di luce) e LED IR (850 nm, condizioni di oscurità) (Vedi anche Figura 3a)17,24.

- Collocare il treppiede alla quale la fotocamera web è fissata al lato dell'arena sperimentale e posizione la videocamera sopra (130 cm) e al centro dell'arena sperimentale (75 cm x 32,5 cm (Vedi Figura 3a).

- Verificare se la videocamera è centrato (Vedi punto 3.3) per assicurarsi che essa non sia stata spostata involontariamente.

-

Collegare la videocamera web a un computer che viene inserito all'esterno della tenda (Figura 3a).

- Installare il software per gestire la registrazione time-lapse con la videocamera.

Nota: Time-lapse registrazioni dipendono dalla velocità del movimento della specie. Vedere anche la Tabella materiali per la fotocamera, obiettivo fisheye, PC e caratteristiche software e produttori usati qui. - Regolare i parametri del video registrazione secondo le caratteristiche della specie.

Nota: Considerando il tasso di mobilità di N. norvegicus, una 1 registrazione time-lapse di s è stata usata qui, e il video è stato salvato ogni 24 ore. - Assicurarsi di creare un timestamp (compresa la data) nel video time-lapse (come questo può aiutare per il futuro Punteggio manuale del comportamento).

- Installare il software per gestire la registrazione time-lapse con la videocamera.

Figura 3 : Messa a punto sperimentale. (a) diagramma dell'Assemblea del sperimentale acquisizione serbatoio e video. (b) vista generale del carro armato sperimentale. (c), inferiore vista del carro armato sperimentale, che indica le tane artificiali. (d) Top vista, mostrando la parte inferiore del carro armato sperimentale. (e) particolare di uno degli ingressi tana. Clicca qui per visualizzare una versione più grande di questa figura.

4. prova sperimentale e preparazione degli animali

Nota: Tutti i passi con gli animali deve essere fatta all'interno della struttura di acclimatazione e in condizioni di luce rossa secondo la sensibilità spettrale dell' aragosta Norvegia25. Quando si spostano gli animali tra l'acclimatazione e l'impianto sperimentale, evitare l'esposizione delle aragoste alla luce, usando un sacchetto nero opaco per coprire la ghiacciaia.

- Preparare una ghiacciaia precedentemente separata in quattro compartimenti sommersi con acqua a circa 7 ° C.

- Preparare i quattro tag precedentemente costruita e veloce colla, come cianoacrilato.

- Preparare un vassoio con ghiaccio tritato.

- Selezionare le quattro aragoste di essere taggati nella struttura acclimatazione e mettere ciascuna di esse in uno scomparto della ghiacciaia.

-

Attendere 30 min e, quindi, avviare la procedura di tagging.

- Prendere un'aragosta e metterlo su ghiaccio tritato per 5 min immobilizzare e e facilitare l'operazione di tagging.

- Asciugare la parte superiore del cefalotorace di aragosta con carta assorbente e mettere una goccia di colla veloce su di esso.

- Inserire il tag orizzontalmente in cima cefalotorace dell'animale, a contatto con la colla, e attendere il tempo sufficiente per esso per indurire (per circa 20 s).

- Riportare l'aragosta di scomparto frigorifero e procedere con gli altri tre animali nello stesso modo.

- Mettere le aragoste indietro nella cella dove erano precedentemente e attendere 24 ore per essere sicuri che il tag è correttamente incollato su.

- Trasferire le aragoste provenienti dall'impianto di acclimatazione alla camera di sperimentale usando la ghiacciaia stessa che è stata utilizzata per la procedura di tagging.

- Avviare la registrazione video e attendere 5 minuti prima di introdurre le aragoste taggate. Ottenere un'immagine di sfondo di una media dall'iniziali 100 fotogrammi.

Nota: In attesa di un minimo di 1 min è obbligatoria per ottenere frame sfondo senza taggate aragoste; sono necessari per l'elaborazione video. - Introdurre gli animali uno per uno nel serbatoio sperimentazione all'interno del loro rispettivo vano, mantenendo l'acqua in esso.

- Attendere per loro di uscire; Se non vengono, aiutarli delicatamente inclinando il vano. Vedere la Figura 4 come esempio degli animali all'interno del serbatoio in condizioni sperimentali.

Figura 4 : Raw frame video. Un esempio di un telaio rappresentativo da uno dei video time-lapse raccolti durante gli esperimenti. Nell'angolo superiore destro, mostriamo il timestamp con la data, il tempo e il telaio. Notare le differenze nell'illuminazione serbatoio nell'angolo inferiore dell'immagine. Clicca qui per visualizzare una versione più grande di questa figura.

5. video analisi Script

-

Eseguire l'analisi dopo il completamento dell'esperimento.

- Lanciare lo script di computer vision per l'analisi dei video.

- Lanciare il programma Java per calcolare le posizioni e la distanza coperta dalle aragoste e inserire i dati nel database.

Nota: Questo programma è un algoritmo basato su distanza euclidea28. - Avviare SQL script di binning dati come intervallo di tempo desiderato (es. 10 min).

6. computer Vision Script per l'analisi dei Video

Nota: Lo script evita la correzione delle immagini fisheye perché non introduce un errore rilevante nel setup sperimentale. Tuttavia, è possibile correggere questo con OpenCV fotocamera calibrazione funzioni29 basato su vettori e matrici rotazione metodi30,31.

- Selezionare la lingua del programma Python18 .

- Selezionare l'immagine di19 di OpenCV e libreria di elaborazione video.

- Caricare un video.

Nota: Formati video AVI o . MP4 sono stati utilizzati in questo esperimento, ma questo non è obbligatorio. Dipende il FourCC32 codec installati nel sistema operativo. -

Procedere come segue per ciascun frame Fi nel video.

- Sottrarre il fondo20B (media delle ultime 100 cornici, ottenuto dal passaggio 4.6) dall'attuale telaio Fie aggiornare l'immagine di sfondo B come Fi. Utilizzare la funzione BackgroundSubtractorMOG2 dalla libreria OpenCV19 (Vedi gli script nei supplementari File 2).

- Determinare l'insieme delle regioni di interesse (ROI) R da pixel con rilevante movimento indicato dal subtractor di sfondo. Utilizzare il metodo applicato da BackgroundSubtractorMOG2 nella libreria OpenCV19 (Vedi gli script nei supplementari File 2). Nell'insieme, sono i rilevamenti degli animali dal fotogramma precedente, prendere in animali nonmoving conto.

- Eseguire i passaggi seguenti per ogni ROI Ri

- Applicare la funzione di dilata e calcolare i contorni33 del ROI Ri. Utilizzare le funzioni si dilatano e findContours dalla libreria OpenCV19 (Vedi gli script nei supplementari File 2).

- Calcolare la scafo zona34Ciao del numero di pixel. Utilizzare la funzione InviluppoConvesso dalla libreria OpenCV19 (Vedi gli script nei supplementari File 2).

- Calcolare il raggio35ri del ROI Ri. Utilizzare la funzione minEnclosingCircle dalla libreria OpenCV19 (Vedi gli script nei supplementari File 2).

- Calcolare la solidità si del ROI Ri. Solidità è il rapporto tra la zona del contorno (ottenuta al passaggio 6.4.3.1) alla relativa zona convessa (ottenuta al passaggio 6.4.3.2) del Ri.

- Calcolare rapporto di aspetto Ia del ROI Ri. Aspect ratio è il rapporto tra la larghezza e l'altezza del Ri-rettangolo di delimitazione. Il rettangolo di delimitazione viene calcolato utilizzando la funzione boundingRect dalla libreria OpenCV19 .

- Selezionare un insieme ridotto di ROIs come un candidato per contenere gli animali, regolando le proprietà per zona di scafo, raggio, solidità e proporzioni.

- Verificare se Ciao è minore di 500.0 o maggiore di 100000.0. Se è così, scartare il ROI Ri. In caso contrario, mantenere il Ri come candidato ROI per la posizione degli animali.

- Verifica se la ri è inferiore a 40.0. Se è così, scartare il ROI Ri. In caso contrario, mantenere il Ri come candidato ROI per la posizione degli animali.

- Controllare se si è meno di -4,0 scartare il ROI Ri. In caso contrario, mantenere il Ri come candidato ROI per la posizione degli animali.

- Verifica se l' Ia è inferiore a 0,15 o superiore a 4.0. È così, scartare il ROI Ri. In caso contrario, mantenere il Ri come candidato ROI per la posizione degli animali.

Nota: L'uso di ROIs riduce il costo computazionale, concentrando la ricerca tag sulla regione del corpo dell'animale. Rilevamenti di animale dai fotogrammi precedenti sono inclusi per evitare rilevamenti sbagliati quando gli animali non sono in movimento.

- Analizzare l'animale ROIs per determinare l'identità di tag. Eseguire de seguendo i passaggi per ogni ROI Ri e per ogni interno ROI Pied estrarre l'interno ROIs P.

- Binarize l'immagine in scala di grigi Pi utilizzando l'algoritmo di soglia 36 Otsu.

- Calcolare i contorni33 di Pi, As in passaggio 6.4.3.1.

- Calcolare la scafo zona34Ciao e il rapporto di aspetto Ia, come nei passaggi 6.4.3.2 e 6.4.3.5.

- Calcolare la forma momenti37,38mi di Pi. Utilizzare la funzione momenti dalla libreria OpenCV19 (Vedi gli script nei supplementari File 2).

- Selezionare un insieme ridotto di ROIs come un candidato per contenere i tag, usando i seguenti criteri.

- Verifica se Ciao è minore o maggiore di 500.0 150.0 . Se è così, scartare il ROI Pi. In caso contrario, mantenere il Pi come candidato ROI per la posizione di tag.

- Verifica se l' Ia è minore di 0,5 o maggiore di 1,5. Se è così, scartare il ROI Pi. In caso contrario, mantenere il Pi come candidato ROI per la posizione degli animali.

- Verificare se mi sia maggiore di 0,3. Se è così, scartare il ROI Pi. In caso contrario, mantenere il Pi come candidato ROI per la posizione degli animali.

- Classificare il tag ROIs. Approssimativa di un poligono39 utilizzando la funzione di19 OpenCV38 per ogni selezionato ROI Pi19.

- Controllare se ci sono esattamente tre vertici del poligono approssimata; assegnare il tag alla classe triangolo . In caso contrario, assegnare la classe circle nella regione di tag.

Nota: Approssimata poligono viene archiviato utilizzando una matrice con i vertici. - Verifica del pixel centrale della ROI Pi. Se è un pixel nero , assegnare alla classe forata il Pi . In caso contrario, assegnare il Pi alla classe bianco .

Nota: Il centro forma è dedotto dai momenti calcolati al passaggio 6.4.5.4. Cerca i pixel neri in un'area di un raggio di 4 pixel attorno al centro.

- Controllare se ci sono esattamente tre vertici del poligono approssimata; assegnare il tag alla classe triangolo . In caso contrario, assegnare la classe circle nella regione di tag.

- Salvare i dati di telaio: telaio data, ora di telaio, forma classe, x centro forma coordinate e y centro forma.

- Continuare con il fotogramma successivo o terminare il processo. Vedere Figura 5 qui di seguito come un esempio visivo delle istruzioni di script di lavoro e guardare Video 1 come esempio del funzionamento di script.

Figura 5 : Relativi passaggi di elaborazione video script. (1) valutare il movimento di sottrazione sfondo sopra la media di ultimi 100 fotogrammi. (2) risultato dell'algoritmo di sottrazione di sfondo. (3) applica un'operazione morfologiche dilata alle aree bianco-rilevato. (4) Difficoltà applica, statico, principale ROI; il poligono giallo corrisponde alla zona del serbatoio inferiore. (5) calcolare i contorni per ogni regione bianco-rilevato nel ROI principale ed eseguire un'analisi strutturale per ogni contorno rilevato. (6) verifica i valori delle proprietà strutturali e, quindi, selezionare i candidati ROI di secondo livello. (7), una cornice usando un algoritmo di thresholding Otsu; lo script funziona solo con ROIs di secondo livello. (8) per ciascuna binarizzato ROI di secondo livello, calcolare i contorni delle regioni bianche ed eseguire un'analisi strutturale per ogni rilevato contorno. (9) controllo la proprietà strutturale valori e, quindi seleziona candidati interni di ROI. (10) per ogni contorno nei paesi candidati, ROI interno, calcolare i descrittori/momenti. (11) verificare se le corrispondenze rilevate forma con il modello di forma e approssimano di un poligono per i migliori candidati di partita. (12) controllare il numero di vertici del poligono approssimativo e determinare la figura geometrica: cerchio o un triangolo. Centro (13), calcola la figura e controllare se si verificano pixel neri; Se sì, è una figura forata. (14) risultato visivo dopo analisi fotogramma. Clicca qui per visualizzare una versione più grande di questa figura.

Risultati

Abbiamo costruito manualmente un sottoinsieme dei dati sperimentali per convalidare l'analisi automatizzata dei video. Una dimensione di campione di 1.308 fotogrammi con un livello di confidenza del 99% (che è una misura di sicurezza che mostra se il campione riflette accuratamente la popolazione, all'interno del suo margine di errore) e un margine di errore del 4% (che è una percentuale che descrive come chiudere il risposta ha dato l'esempio è il valore reale della popolazione) è st...

Discussione

Prestazioni e rappresentante risultati ottenuti con il protocollo di video-monitoraggio ha confermato la validità per la ricerca applicata nel campo del comportamento animale, con un focus specifico su modulazione sociale e ritmi circadiani di animali cohoused. L'efficienza di rilevamento animale (69%) e la precisione di discriminazione tag (89,5%) accoppiato con le caratteristiche comportamentali (cioè, tasso di movimento) delle specie bersaglio utilizzato qui suggeriscono che questo protocollo è una soluzione perfet...

Divulgazioni

Gli autori non hanno nulla a rivelare.

Riconoscimenti

Gli autori sono grati alla Dr. Joan B. società che ha finanziato la pubblicazione di questo lavoro. Inoltre, gli autori sono grati per i tecnici della zona acquario sperimentale presso l'Istituto di Scienze Marine di Barcellona (ICM-CSIC) per il loro aiuto durante il lavoro sperimentale.

Questo lavoro è stato supportato dal progetto RITFIM (CTM2010-16274; sperimentatore principale: J. Aguzzi) fondato dal Ministero spagnolo della scienza e innovazione (Formacion) e la concessione di TIN2015-66951-C2-2-R dal Ministero spagnolo dell'economia e della competitività.

Materiali

| Name | Company | Catalog Number | Comments |

| Tripod 475 | Manfrotto | A0673528 | Discontinued |

| Articulated Arm 143 | Manfrotto | D0057824 | Discontinued |

| Camera USB 2.0 uEye LE | iDS | UI-1545LE-M | https://en.ids-imaging.com/store/products/cameras/usb-2-0-cameras/ueye-le.html |

| Fish Eye Len C-mount f = 6 mm/F1.4 | Infaimon | Standard Optical | https://www.infaimon.com/es/estandar-6mm |

| Glass Fiber Tank 1500 x 700 x 300 mm3 | |||

| Black Felt Fabric | |||

| Wood Structure Tank | 5 Wood Strips 50x50x250 mm | ||

| Wood Structure Felt Fabric | 10 Wood Strips 25x25x250 mm | ||

| Stainless Steel Screws | As many as necessary for fix wood strips structures | ||

| PC | 2-cores CPU, 4GB RAM, 1 GB Graphics, 500 GB HD | ||

| External Storage HDD | 2 TB capacity desirable | ||

| iSPY Sotfware for Windows PC | iSPY | https://www.ispyconnect.com/download.aspx | |

| Zoneminder Software Linux PC | Zoneminder | https://zoneminder.com/ | |

| OpenCV 2.4.13.6 Library | OpenCV | https://opencv.org/ | |

| Python 2.4 | Python | https://www.python.org/ | |

| Camping Icebox | |||

| Plastic Tray | |||

| Cyanocrylate Gel | To glue tag’s | ||

| 1 black PVC plastic sheet (1 mm thickness) | Tag's construction | ||

| 1 white PVC plastic sheet (1 mm thickness) | Tag's construction | ||

| 4 Tag’s Ø 40 mm | Maked with black & white PVC plastic sheet | ||

| 3 m Blue Strid Led Ligts (480 nm) | Waterproof as desirable | ||

| 3 m IR Strid Led Ligts (850 nm) | Waterproof as desirable | ||

| 6 m Methacrylate Pipes Ø 15 mm | Enclosed Strid Led | ||

| 4 PVC Elbow 45o Ø 63 mm | Burrow construction | ||

| 3 m Flexible PVC Pipe Ø 63 mm | Burrow construction | ||

| 4 PVC Screwcap Ø 63 mm | Burrow construction | ||

| 4 O-ring Ø 63 mm | Burrow construction | ||

| 4 Female PVC socket glue / thread Ø 63 mm | Burrow construction | ||

| 10 m DC 12V Electric Cable | Light Control Mechanism | ||

| Ligt Power Supply DC 12 V 300 W | Light Control Mechanism | ||

| MOSFET, RFD14N05L, N-Canal, 14 A, 50 V, 3-Pin, IPAK (TO-251) | RS Components | 325-7580 | Light Control Mechanism |

| Diode, 1N4004-E3/54, 1A, 400V, DO-204AL, 2-Pines | RS Components | 628-9029 | Light Control Mechanism |

| Fuse Holder | RS Components | 336-7851 | Light Control Mechanism |

| 2 Way Power Terminal 3.81 mm | RS Components | 220-4658 | Light Control Mechanism |

| Capacitor 220 µF 200 V | RS Components | 440-6761 | Light Control Mechanism |

| Resistance 2K2 7 W | RS Components | 485-3038 | Light Control Mechanism |

| Fuse 6.3 x 32 mm2 3A | RS Components | 413-210 | Light Control Mechanism |

| Arduino Uno Atmel Atmega 328 MCU board | RS Components | 715-4081 | Light Control Mechanism |

| Prototipe Board CEM3,3 orific.,RE310S2 | RS Components | 728-8737 | Light Control Mechanism |

| DC/DC converter,12 Vin,+/-5 Vout 100 mA 1 W | RS Components | 689-5179 | Light Control Mechanism |

| 2 SERA T8 blue moonlight fluorescent bulb 36 watts | SERA | Discontinued/Light isolated facility |

Riferimenti

- Dell, A. I., et al. Automated image-based tracking and its application in ecology. Trends in Ecology & Evolution. 29 (7), 417-428 (2014).

- Berman, G. J., Choi, D. M., Bialek, W., Shaevitz, J. W. Mapping the stereotyped behaviour of freely moving fruit flies. Journal of The Royal Society Interface. 11 (99), (2014).

- Mersch, D. P., Crespi, A., Keller, L. Tracking Individuals Shows Spatial Fidelity Is a Key Regulator of Ant Social Organization. Science. 340 (6136), 1090 (2013).

- Tyson, L. Hedrick Software techniques for two- and three-dimensional kinematic measurements of biological and biomimetic systems. Bioinspiration & Biomimetics. 3 (3), 034001 (2008).

- Branson, K., Robie, A. A., Bender, J., Perona, P., Dickinson, M. H. High-throughput ethomics in large groups of Drosophila. Nature Methods. 6 (6), 451-457 (2009).

- de Chaumont, F., et al. Computerized video analysis of social interactions in mice. Nature Methods. 9, 410 (2012).

- Pérez-Escudero, A., Vicente-Page, J., Hinz, R. C., Arganda, S., de Polavieja, G. G. idTracker: tracking individuals in a group by automatic identification of unmarked animals. Nature Methods. 11 (7), 743-748 (2014).

- Fiala, M. ARTag, a fiducial marker system using digital techniques. 2005 IEEE Computer Society Conference on Computer Vision and Pattern Recognition (CVPR’05). 2, 590-596 (2005).

- Koch, R., Kolb, A., Rezk-Salama, C., Koch, R., Kolb, A., Rezk-salama, C. . CALTag: High Precision Fiducial Markers for Camera Calibration. , (2010).

- Crall, J. D., Gravish, N., Mountcastle, A. M., Combes, S. A. BEEtag: A Low-Cost, Image-Based Tracking System for the Study of Animal Behavior and Locomotion. PLOS ONE. 10 (9), e0136487 (2015).

- Charpentier, R. Free and Open Source Software: Overview and Preliminary Guidelines for the Government of Canada. Open Source Business Resource. , (2008).

- Crowston, K., Wei, K., Howison, J. Free/Libre Open Source Software Development: What We Know and What We Do Not Know. ACM Computing Surveys. 37, (2012).

- Edmonds, N. J., Riley, W. D., Maxwell, D. L. Predation by Pacifastacus leniusculus on the intra-gravel embryos and emerging fry of Salmo salar. Fisheries Management and Ecology. 18 (6), 521-524 (2011).

- Sbragaglia, V., et al. Identification, Characterization, and Diel Pattern of Expression of Canonical Clock Genes in Nephrops norvegicus (Crustacea: Decapoda) Eyestalk. PLOS ONE. 10 (11), e0141893 (2015).

- Sbragaglia, V., et al. Dusk but not dawn burrow emergence rhythms of Nephrops norvegicus (Crustacea: Decapoda). Scientia Marina. 77 (4), 641-647 (2013).

- Katoh, E., Sbragaglia, V., Aguzzi, J., Breithaupt, T. Sensory Biology and Behaviour of Nephrops norvegicus. Advances in Marine Biology. 64, 65-106 (2013).

- Sbragaglia, V., Leiva, D., Arias, A., Antonio García, J., Aguzzi, J., Breithaupt, T. Fighting over burrows: the emergence of dominance hierarchies in the Norway lobster (Nephrops norvegicus). The Journal of Experimental Biology. 220 (24), 4624-4633 (2017).

- . Welcome to Python.org Available from: https://www.python.org/ (2018)

- Bradski, G. . OpenCV Library. Dr. Dobb’s Journal of Software Tools. , (2000).

- Piccardi, M. Background subtraction techniques: a review. 2004 IEEE International Conference on Systems, Man and Cybernetics (IEEE Cat. No.04CH37583). 4, 3099-3104 (2004).

- Sankur, B. Survey over image thresholding techniques and quantitative performance evaluation. Journal of Electronic Imaging. 13 (1), 146 (2004).

- Lai, Y. K., Rosin, P. L. Efficient Circular Thresholding. IEEE Transactions on Image Processing. 23 (3), 992-1001 (2014).

- Gaten, E. Light‐induced damage to the dioptric apparatus of Nephrops norvegicus (L.) and the quantitative assessment of the damage. Marine Behaviour and Physiology. 13 (2), 169-183 (1988).

- Sbragaglia, V., et al. An automated multi-flume actograph for the study of behavioral rhythms of burrowing organisms. Journal of Experimental Marine Biology and Ecology. 446, 177-186 (2013).

- Johnson, M. L., Gaten, E., Shelton, P. M. J. Spectral sensitivities of five marine decapod crustaceans and a review of spectral sensitivity variation in relation to habitat. Journal of the Marine Biological Association of the United Kingdom. 82 (5), 835-842 (2002).

- Markager, S., Vincent, W. F. Spectral light attenuation and the absorption of UV and blue light in natural waters. Limnology and Oceanography. 45 (3), 642-650 (2000).

- Aguzzi, J., et al. A New Laboratory Radio Frequency Identification (RFID) System for Behavioural Tracking of Marine Organisms. Sensors. 11 (10), 9532-9548 (2011).

- Audin, M. . Geometry [Electronic Resource. , (2003).

- . . OpenCV Team Structural Analysis and Shape Descriptors - OpenCV 2.4.13.7 documentation. , (2018).

- Slabaugh, G. G. . Computing Euler angles from a rotation matrix. 7, (1999).

- Zhang, Z. A flexible new technique for camera calibration. IEEE Transactions on Pattern Analysis and Machine Intelligence. 22 (11), 1330-1334 (2000).

- . www.FOURCC.org - Video Codecs and Pixel Formats Available from: https://www.fourcc.org/ (2018)

- Suzuki, S., be, K. Topological structural analysis of digitized binary images by border following. Computer Vision, Graphics, and Image Processing. 30 (1), 32-46 (1985).

- Sklansky, J. Finding the convex hull of a simple polygon. Pattern Recognition Letters. 1 (2), 79-83 (1982).

- Fitzgibbon, A., Fisher, R. . A Buyer’s Guide to Conic Fitting. , 51.1-51.10 (1995).

- Otsu, N. A Threshold Selection Method from Gray-Level Histograms. IEEE Transactions on Systems, Man, and Cybernetics. 9 (1), 62-66 (1979).

- Hu, M. K. Visual pattern recognition by moment invariants. IRE Transactions on Information Theory. 8 (2), 179-187 (1962).

- . Structural Analysis and Shape Descriptors - OpenCV 2.4.13.6 documentation Available from: https://docs.opencv.org/2.4/modules/imgproc/doc/structural_analysis_and_shape_descriptors.html?highlight=cvmatchshapes#humoments (2018)

- Douglas, D. H., Peucker, T. K. Algorithms for the Reduction of the Number of Points Required to Represent a Digitized Line or its Caricature. Cartographica: The International Journal for Geographic Information and Geovisualization. 10 (2), 112-122 (1973).

- Vanajakshi, B., Krishna, K. S. R. Classification of boundary and region shapes using Hu-moment invariants. Indian Journal of Computer Science and Engineering. 3, 386-393 (2012).

- Kahle, D., Wickham, H. ggmap : Spatial Visualization with ggplot2. The R Journal. , 144-162 (2013).

- Venables, W. N., Ripley, B. D. . Modern Applied Statistics with S. , (2010).

- Abbas, Q., Ibrahim, M. E. A., Jaffar, M. A. A comprehensive review of recent advances on deep vision systems. Artificial Intelligence Review. , (2018).

- Menesatti, P., Aguzzi, J., Costa, C., García, J. A., Sardà, F. A new morphometric implemented video-image analysis protocol for the study of social modulation in activity rhythms of marine organisms. Journal of Neuroscience Methods. 184 (1), 161-168 (2009).

- Chapman, C. J., Shelton, P. M. J., Shanks, A. M., Gaten, E. Survival and growth of the Norway lobster Nephrops norvegicus in relation to light-induced eye damage. Marine Biology. 136 (2), 233-241 (2000).

- . Video tracking software | EthoVision XT Available from: https://www.noldus.com/animal-behavior-research/products/ethovision-xt (2018)

- Correll, N., Sempo, G., Meneses, Y. L. D., Halloy, J., Deneubourg, J., Martinoli, A. SwisTrack: A Tracking Tool for Multi-Unit Robotic and Biological Systems. 2006 IEEE/RSJ International Conference on Intelligent Robots and Systems. , 2185-2191 (2006).

- . . MATLAB - MathWorks. , (2018).

- Leggat, P. A., Smith, D. R., Kedjarune, U. Surgical Applications of Cyanoacrylate Adhesives: A Review of Toxicity. ANZ Journal of Surgery. 77 (4), 209-213 (2007).

- Dizon, R. M., Edwards, A. J., Gomez, E. D. Comparison of three types of adhesives in attaching coral transplants to clam shell substrates. Aquatic Conservation: Marine and Freshwater Ecosystems. 18 (7), 1140-1148 (2008).

- Cary, R. . Methyl cyanoacrylate and ethyl cyanoacrylate. , (2001).

- Krizhevsky, A., Sutskever, I., Hinton, G. E. Imagenet classification with deep convolutional neural networks. Advances in neural information processing systems. , 1097-1105 (2012).

Ristampe e Autorizzazioni

Richiedi autorizzazione per utilizzare il testo o le figure di questo articolo JoVE

Richiedi AutorizzazioneThis article has been published

Video Coming Soon