Method Article

全脳イメージングにおける母体行動応答のプロファイリング

要約

ここでは、MRI環境内の行動モニタリングの課題を克服し、外部の手がかりに対する指示されていない行動反応の検出を可能にするビデオ分析パイプラインを紹介します。この分析により、誘発された内部状態の変化と脳全体の活動について、より包括的な理解が促進されます。

要約

近年の全脳イメージングツールの進歩により、神経科学者は、協調的な脳活動がどのように外部の手がかりを処理し、内部状態の変化に影響を与え、行動反応を誘発するかを調査することが可能になりました。例えば、機能的磁気共鳴画像法(fMRI)は、BOLD(Blood Oxygenation-Level-Dependent)応答を用いてマウスを覚醒させ、行動させるマウスの全脳活動を測定できる非侵襲的な技術です。しかし、外部刺激によって誘発されるBOLD反応を完全に理解するためには、実験者がスキャン中の行動反応も評価することが重要です。MRI環境はこの目標に課題を提起し、一般的に採用されている行動モニタリングの方法と互換性をなくします。これらの課題には、(1)視野が限られていること、(2)強磁性部品のない機器の利用可能性が限られていることが含まれます。本稿では、これらの環境制約内で取得した映像から貴重な情報を抽出することで、これらの制約を克服し、全脳神経データ取得時の行動評価を可能にする行動映像解析パイプラインを紹介します。オプティカルフロー推定や次元削減などの手法を用いることで、fMRIスキャン中に提示される刺激に対する行動応答にロバストな違いを検出することができます。例えば、代表的な結果は、マウスの子犬の発声が純粋な声ではなく、母体の雌マウスと処女マウスで有意に異なる行動反応を引き起こすことを示唆しています。今後、この行動解析パイプラインは、当初はfMRI実験の課題を克服するために調整されていましたが、さまざまな神経記録法に拡張できるようになり、制約のある環境での多様な行動モニタリングが可能になります。行動反応と神経反応の調整された評価により、刺激の知覚が複雑な行動出力の調整にどのようにつながるかについて、より包括的な理解が得られます。

概要

神経記録中の行動反応のモニタリングは、刺激によって引き起こされる脳全体の協調活動を理解するために不可欠です。動物が特定の目標指向の方法で刺激に反応すると予測されない場合、指示されていない行動を観察することで、外部の手がかりが動物の内部状態にどのように情報を提供するかについての洞察を得ることができます1,2。広視野カルシウムイメージングや機能的磁気共鳴画像法(fMRI)などのニューロイメージングツールの近年の進歩により、神経科学者は脳の単一領域を超えて研究を拡大することができるようになりました。しかし、このような高次元の神経データをより包括的に理解するためには、これらの複雑なパターンの行動出力を評価する能力もそれに応じて向上させる必要があります。

神経科学研究では、嗅覚を検出するための温度センサーや圧力センサー3,4、舐めを検出するための光線5、所定の身体部位を追跡するためのマーカーレス姿勢推定6など、タスク指示行動を特徴付ける最先端の方法が広く用いられています。しかし、指示されていない行動パターンのデータ駆動型評価は、この分野では依然として課題となっています7。データ駆動型行動分析の手法は急速に進歩していますが、既存の手法では通常、かなりの計算能力、特殊な機器、または動物を特に鮮明に把握する必要があります2,6,8,9。ここで紹介するのは、あらゆるビデオ撮影データに簡単に対応でき、受動的刺激中に取得したビデオから貴重な行動測定値を抽出できる行動ビデオ分析パイプラインです。

この行動解析パイプラインは、広範囲の外部刺激や複数の記録環境、さらにはかなりの制約がある環境にさらされた頭部固定動物における神経データおよびビデオデータの協調的な取得と互換性を持つように設計されています。たとえば、MRI環境は、視野の制限や強磁性コンポーネントのない機器の可用性の制限など、行動モニタリングに特定の課題をもたらします。これらの制約により、一般的に使用される方法は互換性がなくなり、頭の動き(つまり、ボリューム取得間で脳がどのように動くか)などの測定は、スキャン中の身体反応を評価するための最もアクセスしやすいが限定的な方法の1つになります10。これらの制限を克服することにより、このプロトコルはMR対応のビデオ撮影データの分析を容易にし、異なる母性経験を持つ雌マウスが聴覚刺激に対して異なる行動反応を示すことを示しました。母親と処女には、fMRIスキャン中に、苦痛した子犬の発声(「子犬の鳴き声」)や純粋なトーンなどの聴覚刺激が提示されました。これらの刺激は受動的に提示されたため、指示された行動出力はありませんでした。母親は処女と比較して子犬の鳴き声に対して高い反応を示すと予測されましたが、頭に固定された環境で雌マウスが乳児の合図にどのように反応するかについての文献はほとんどありません。したがって、 先験的に追跡するための特定の行動出力はなく、この実験は提案されたデータ駆動型行動分析の完璧なテストになりました。オプティカルフロー推定や次元削減などの方法を用いて、行動反応の集団差が、大きさと空間的発現の両方で検出されました。

今後は、行動反応と神経反応の協調的な評価を活用することで、外部刺激がどのように内部状態を変化させ、複雑な行動出力に情報を提供するかについて、より包括的な理解を達成することができます。この理解は、課せられた課題や指示された行動がない場合に提示される刺激にまで及ぶべきです。ここで紹介する解析パイプラインは、さまざまなニューラルレコーディング技術に拡張でき、制約のある環境でも汎用性の高い行動モニタリングを提供します。

プロトコル

すべての動物実験は、コロンビア大学動物管理委員会(IACUC)によって承認されたプロトコルに従って実施され、すべての方法は関連するガイドライン、規制、および推奨事項に従って実施されました。使用した機器やソフトウェアの詳細は、 資料表に記載されています。

1. ソフトウェア

- MATLAB を Mathworks の Web サイトからダウンロードします。

注: この解析パイプラインを構成するコードは、MATLAB を介してのみ実行可能であり、MATLAB 2023a と互換性を持つように特別に書かれています。 - このパイプラインには、MATLAB 内の Computer Vision Toolbox と Image Processing Toolbox が必要です。ツールボックスを MATLAB アドオンに追加するには 、[Manage Add-Ons]、[Get Add-Ons] の順にクリックし、ツールボックスを検索して追加します。

注: script1_videocoreg.m (Supplementary Coding File 1)、script2_optflow_roiselect.m (Supplementary Coding File 2)、script3_optflow_analysis.m (Supplementary Coding File 3)、script4_optflow_pca.m (Supplementary Coding File 4)、および script5_optflow_pca_analysis.m (Supplementary Coding File 5) の 5 つの MATLAB スクリプトが補助ファイルとして提供されています。また、2 つのサンプル ビデオ (ビデオ 1 と ビデオ 2) と、それに対応するイベント タイミング ファイル (補足ファイル 1 と 補足ファイル 2) も提供されています。最初に、サンプル データを使用してパイプラインを実行することをお勧めします。

注意: コード内のコメントに感嘆符が含まれている場合は、実行前にアクションが必要な領域であるため、注意してください。たとえば、「下のコード ブロックを編集してください」などのコメントがあり、ファイル構造、実験の詳細、または分析のニーズに合わせて編集を行う必要がある場所を強調します。これらの選択肢は、提供されている 2 つのサンプル ビデオに合うように既定で設定されていますが、一方が独自のデータを使用してパイプラインの実行を開始すると、調整が必要になります。 - 各スクリプトの各セクションを実行するには、エディタメニューの [Run and Advance] をクリックします。

2. ビデオの同時登録

注: この分析パイプラインで最初に提供されるスクリプトは script1_videocoreg.m (Supplementary Coding File 1) で、これは共登録 によって すべてのビデオを空間的に位置合わせします。このスクリプトの入力は未加工のビデオで、主な出力は変換されたビデオです。

- スクリプトの セクション 1、2、3、4、5、および 6 を、データ構造に適合するように指示された場所で編集します。

- セクション 1 を実行します。

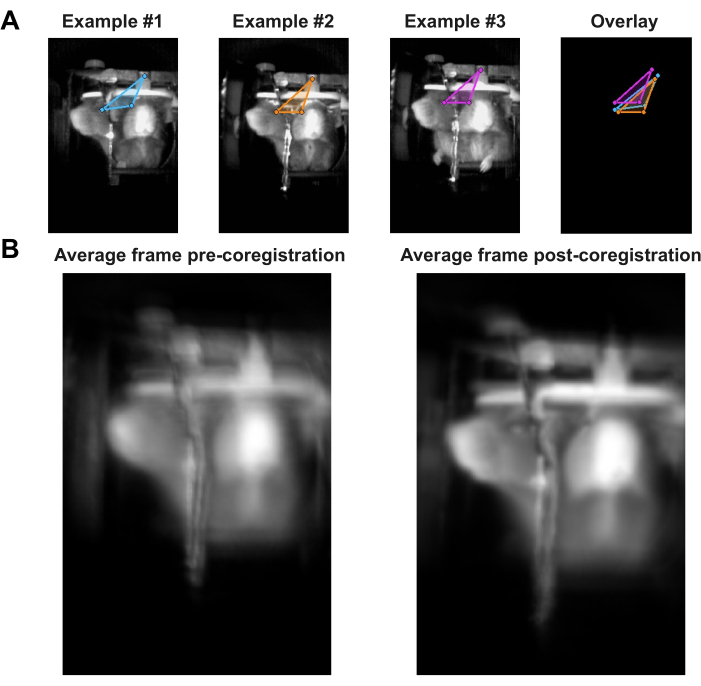

- 図 1A のように、各ビデオでラベルを付けるポイントを 3 つ選択します。これらの 3 つのポイントは、すべてのフレームを相互に共登録するために使用されます。スクリプトのセクション 2 を実行して各ビデオの最初のフレームをプルアップし、マウスを使用して最初の 2 つのポイントを 1 回クリックし、次に 3 番目のポイントをダブルクリックします。最後の動画のポイントを選択したら、Enterキーを押します。

- セクション 3 とセクション 4 を実行します。

- フラグを 0 に設定し、セクション 5 を実行します。次に、フラグを 1 に揃えて設定し、セクション 5 を再度実行します。

- セクション 6 を実行し、結果の図を図 1B と並べて比較します。左側の位置合わせされていない平均画像で観察された収差は、右側の位置合わせされた平均画像で軽減する必要があります。

3.オプティカルフロー推定:フルFOV

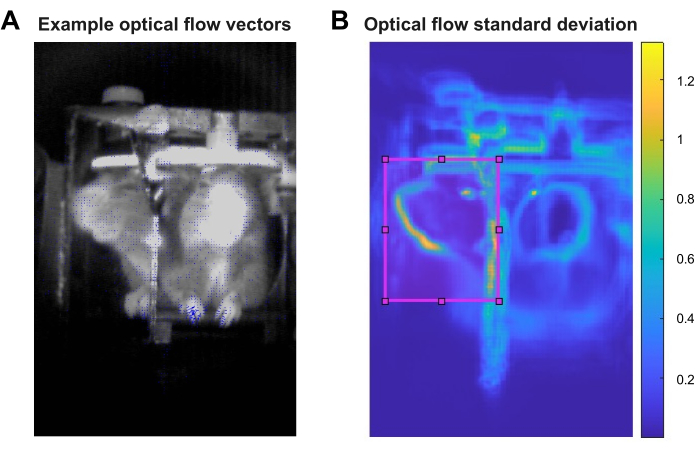

注:スキャンビデオの動きを評価するには、変換されたビデオごとにオプティカルフローを推定する必要があります。これは、提供されているスクリプト script2_optflow_roiselect.m (Supplementary Coding File 2) を使用して、各ビデオの全視野 (FOV) に対して実行できます。このスクリプトの入力は変換されたビデオであり、出力は各ビデオの時間経過に伴う各ピクセルのオプティカル フローの大きさを示す 3D マトリックスです。 図 2A は、オプティカル フロー ベクトルを青色でオーバーレイしたフレームの例を示しており、各ベクトルの長さは、そのピクセルの相対的なオプティカル フローの大きさを表しています。出力をビデオとして保存する方が、3D行列として保存するよりも効率的であることがわかりました。

- スクリプトの セクション 1 を、データ構造に合うように指示された場所で編集します。

- セクション 1 を実行します。

4. ROIの選択

注: 次の分析手順は、分析の焦点を当てる完全な FOV 内の関心領域 (ROI) を選択することにより、計算負荷とデータ ストレージのニーズの観点からはるかに管理しやすくなります。ROIは、関心のある実験や行動に応じて選択することも、よりデータ駆動型のアプローチで選択することもできます。ここで示す代表的な結果については、全視野における各ピクセルのオプティカルフローの大きさの標準偏差を、スクリプトscript2_optflow_roiselect.m、セクション2(補足コーディングファイル2)で計算しました。スクリプトのこの部分の入力はセクション 1 の出力であり、メイン出力は、すべてのビデオのすべてのピクセルにわたるオプティカル フローの大きさの標準偏差を視覚化したものです。提示された代表的な結果では、ミラーFOVはオプティカルフローの比較的高い標準偏差を示し、ROIの実証された選択を導きました。

- スクリプトの セクション 2 を編集して、データ構造に適合するように指示された場合。

- セクション 2 を実行し、結果の画像を使用して、分析されたビデオのどこでオプティカル フローが最も大きく変動するかを確認します。このイメージの例を図 2B に示します。

5. オプティカルフローの定量化:ROI

注:スクリプトscript2_optflow_roiselect.m(Supplementary Coding File 2)のセクション3では、描画ツールを使用してROIを選択し、境界座標を保存できます。スクリプトのこの部分の入力はセクション 1 の出力であり、出力は各ビデオの時間の経過に伴う ROI の平均オプティカル フローの大きさを示す 1D ベクトルです。

- スクリプトの セクション 3 を、データ構造と分析のニーズに合わせて編集します。

注: ROI の選択の進め方には、いくつかのオプションがあります。次の 1 つのオプションを選択します。- オプション1:フルビデオFOVを分析します。

- フラグ selectROI を 0 に設定し、provideROI を 0 に設定します。

- オプション 2: 新しい ROI を分析します。

- フラグ selectROI を 1 に設定し、provideROI を 0 に設定します。次に、newCoordsName を編集します。

- オプション 3: 以前に描画された ROI を分析します。

注: このオプションは、以前にこのコードを実行して ROI を作成したことがある場合にのみ選択してください。- フラグ selectROI を 0 に設定し、provideROI を 1 に設定します。次に、inputCoords を編集して、あらかじめ決められた座標のセットを提供します。

- オプション1:フルビデオFOVを分析します。

- セクション 3 を実行します。

6. オプティカルフローマグニチュードの比較

注: 付属のスクリプト script3_optflow_analysis.m (Supplementary Coding File 3) は、ユーザーのデータに最も特化する必要があります。主な入力は、各ビデオのROIの経時的な平均オプティカルフローの大きさを示す1Dベクトルであり、イベントの開始やグループ/条件情報と適切に組み合わせると、主な出力は分析の関心に合わせて調整できる統計的比較になります。

- スクリプトの セクション 1 から 3 を編集して、データ構造と分析のニーズに合わせます。

- セクション 1 で必要に応じて、解析オプション・フラグ zsc、blrm、blzsc、demeanPerTrial、および applyLPfilter を 0 または 1 に設定します。表示された代表的な結果では、zsc、blrm、および applyLPfilter は 1 に設定され、他のすべてのオプションは 0 に設定されています。

- LPfilter を、目的のローパス フィルターをヘルツ (Hz) で表す数値に設定します。提示された代表的な結果では、行動反応が5Hzよりも速い速度で変動するとは予想されていなかったため、5Hzのローパスフィルターが適用されました。

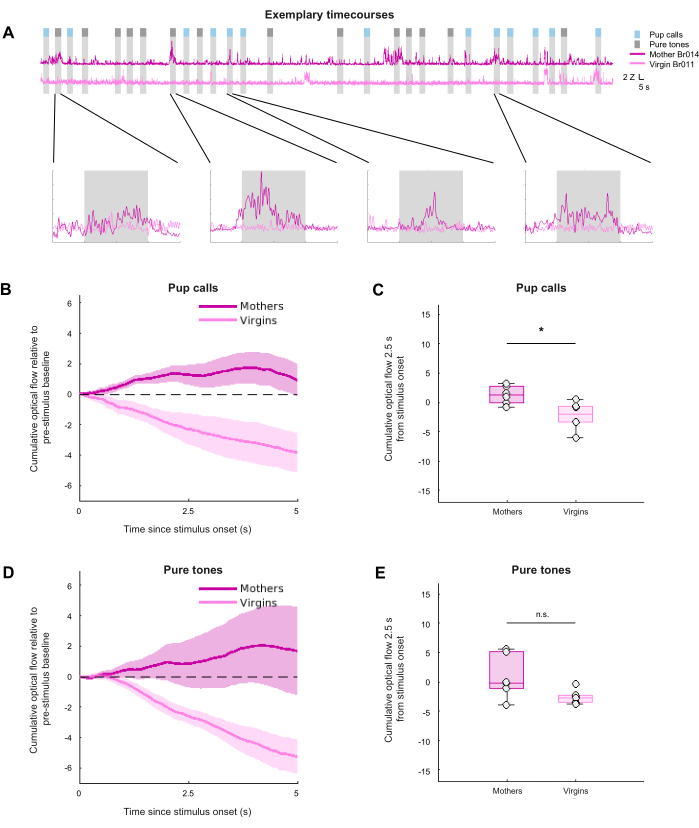

- セクション 1 から 3 を実行します。セクション 3 では、図 3 に示すようなプロットを含む、グループ平均オプティカル フロー時系列、グループ平均累積オプティカル フロー、およびサマリー累積オプティカル フローのプロットを作成する必要があります。セクション 3 は、グループ/条件比較の任意の組み合わせに対して実行できます。

7. オプティカルフローPCA

注:オプティカルフローの大きさの推定に基づいて、script2_optflow_roiselect.m(Supplementary Coding File 2)の出力には、ビデオごとのフレームごとのオプティカルフローの空間分布に関する情報も含まれています。この空間情報の次元を減らすために、付属のスクリプトscript4_optflow_pca.m(Supplementary Coding File 4) 推定されたオプティカルフローに対して主成分分析(PCA)を実行します。主な入力は、以前は各ビヘイビアビデオのビデオとして保存されていた3Dオプティカルフローマトリックスであり、主な出力は、PCと説明された分散情報を含むビデオごとに1つの.matファイルです。

- スクリプトの セクション 1 を編集して、データ構造と分析のニーズに合わせます。

- 解析オプション・フラグ stimnum、dsfactor、および fnfactor をセクション 1 で必要に応じて設定します。提示された代表的な結果では、各刺激タイプが個別に分析され、dsfactorとfnfactorのデフォルト値1が維持されたため、空間または時間のダウンサンプリングは行われませんでした。

- セクション 1 を実行します。

8. オプティカルフローPCAの比較

注: 提供されているスクリプト script5_optflow_pca_analysis.m (Supplementary Coding File 5) は、グループ間で PCA の結果の探索的比較を実行します。主な入力は、刺激特有のPCとscript4_optflow_pca.mから取得した説明された分散情報(Supplementary Coding File 4)で、主な出力は、最初のPCの負荷を示す統計的に閾値化されたヒートマップですが、他のPCもこのスクリプトで分析できます。

- スクリプトの セクション 1 を編集して、データ構造と分析に合わせます。

- セクション 1 とセクション 2 を実行します。

- セクション 3 の入力、特に group 変数と myTitle 変数を編集して、必要なグループ分析と threshT を反映させます。threshT は、結果が有意であると見なされる T 統計量のしきい値を表し、公開されている T 統計量と p 値のテーブルと自由度に基づいて計算できます。

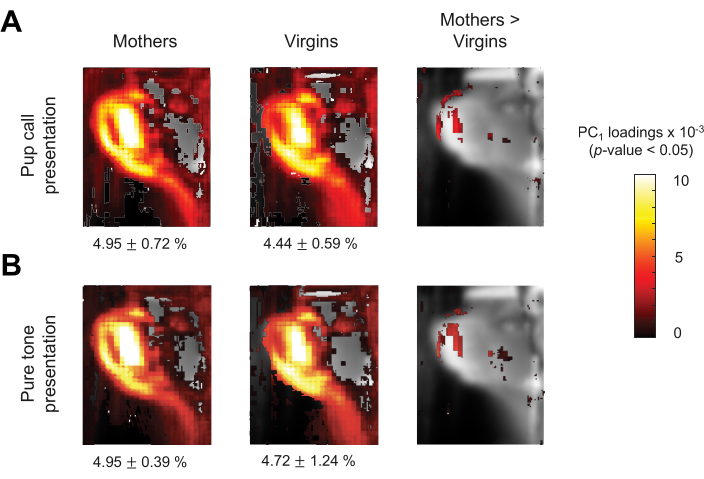

- 関心のあるグループごとに セクション 3 を実行します。このコードでは、 図 4 の左パネルと中央パネルに示されているようなグループ要約統計マップが生成されます。 カクシスの範囲、つまりカラーバーの制限を、視覚化のために必要に応じて調整します。

- Section 4 の入力、特に mag 変数と myTitle 変数を編集して、必要なグループ比較と threshT を反映させます。threshT は、結果が有意であると見なされる T 統計量のしきい値を表し、公開されている T 統計量と p 値のテーブルと自由度に基づいて計算できます。

- 関心のあるグループ比較ごとに セクション 4 を実行します。このコードでは、 図 4 の右側のパネルに示すように、グループ比較統計マップが生成されます。 カクシスの範囲、つまりカラーバーの制限を、視覚化のために必要に応じて調整します。

結果

この解析パイプラインの可能性を実証するために、頭部固定雌マウス(特に母親と処女)の行動ビデオを取得し、機能的磁気共鳴画像法(fMRI)スキャン中にマウスに聴覚刺激を与えました。刺激は、子犬の鳴き声と受動的に提示された純粋なトーンで構成されていたため、指示された行動出力はありませんでした。子犬の鳴き声は、巣から一時的に隔離された生後6日のマウスの子犬が発する超音波発声の録音でした。これらの子犬の鳴き声は、通常、母親が子犬を見つけ、それに向かって移動し、調査し、そしてそれを拾い上げて巣の安全に戻すという母親の子犬の回収行為を誘発します-処女の女性が通常示さない行動11。以前の研究では、子犬の鳴き声は母親の一次聴覚皮質で強力な誘発活動を引き出すが、処女の一次聴覚皮質では誘発されないことが示されていますが、純粋なトーンの反応はグループの違いを示していません12。したがって、子犬の鳴き声に対する行動反応のグループの違いは特定されるが、純粋なトーンではないという仮説が立てられました。しかし、頭に固定された環境での子犬の合図に反応する雌マウスの特定の行動に関する文献はほとんどありません。したがって、特定の行動出力は期待されておらず、この実験は提案されたデータ駆動型行動分析の完璧なテストになりました。

8日間にわたって、すべての動物は徐々に実験者の取り扱い、頭部固定、およびMRI環境に慣れていきました。頭部固定と実験環境に慣れることは、提示された刺激に対する行動反応を評価するために重要です。環境に適切に慣れていないと、動物はストレス反応を示すだけで、ビデオ撮影 で 解析できる刺激による影響を洗い流す可能性があります。

行動装置のセットアップは、データ取得セッションごとに一般的に同じでしたが、fMRIスキャンのために動物を頭部固定するたびに、カメラの視野(FOV)がわずかにずれる可能性があります( 図1AのFOVの例を参照)。これは、カメラマウントの位置がわずかに変更されたことと、各動物のヘッドポストの頭蓋骨アタッチメントの個々のバリエーションによるものと思われます。したがって、スキャンからのビデオは、スキャンと動物全体で含まれる空間情報を比較できるように、線形共レジストレーションを介して互いに位置合わせする必要がありました。共登録は、代表的なデータに合わせて調整されました。例えば、標準的なスキャン日では、動物1匹あたり3〜4回のスキャンが取得され、その結果、1日あたり動物1匹あたり3〜4本のビデオが取得されました。各スキャンの間に、カメラや頭部固定コンポーネントを含むクレードルコンポーネントの動きはありませんでした。したがって、1 匹の動物 1 日につき 1 本のビデオの共レジストレーション変換が決定されると、同じ日にその動物の他の 2 〜 3 本のビデオに適用できるようになった。これにより、このパイプラインの共レジストレーション ステップの時間が節約されますが、必要に応じて、ビデオごとに空間変換を個別に計算することもできます。各ビデオに存在する 3 つのフィーチャは、空間変換のラベリングと計算のポイントとして選択されました。示された代表的なデータでは、ヘッドポストの中心、動物の右目の正面図、および動物の右目の横顔図(45度の角度で配置された鏡に見える)の3つの点でした。ビデオの共レジストレーションの例を 図1A、Bに示し、このステップの効果を実証するために、この実験中に撮影されたすべてのビデオから計算された平均フレームを共レジストレーションの前後に示しています。

このパイプラインは、連続するフレーム13間の物体の見かけの速度を推定することにより、ビデオ内の物体の動きを推定するために使用されるコンピュータビジョン手法であるオプティカルフローに大きく依存しています。オプティカルフローが選ばれたのは、行動反応の代理である動きを定量化できるため、あらかじめ決められた体の部分や関心のある行動は必要ありません。さらに、この方法は、実験時にアクセス可能な唯一のMR対応カメラで取得された代表的なビデオの画質が限られているため、適応性がありました。このパイプラインでは、グローバルで高密度のオプティカルフロー推定のHorn-Schunckアルゴリズムが使用されます。しかし、Lucas-Kanadeアルゴリズムのような他のアルゴリズムは、提供されたMATLABスクリプト14,15,16をわずかに変更するだけで容易に採用することができる。図2Aは、各ピクセルに相対的な光流速ベクトルを重ね合わせたビデオフレームの例を示しています。大きなベクトルは、動物の鼻や足など、動きが予想される領域に表示されることに注意してください。

パイプラインは、FOV 全体にわたるすべてのビデオのオプティカル フローを推定しましたが、残りの解析ステップは、FOV 内の関心領域 (ROI) を選択することで、計算負荷とデータ ストレージのニーズの点ではるかに管理しやすくなりました。ROIは、実験や関心のある所定の行動に応じて、またはよりデータ駆動型のアプローチを通じて選択できます。代表的なデータには 、先験的に追跡するための特定の行動出力が含まれていなかったため、データ駆動型のアプローチが追求されました。オプティカルフローの大きさの標準偏差は、 図2Bに示すように、各ピクセルのすべてのビデオで計算されました。標準偏差が最も高い領域には、目の周りや鼻の周りなど、動物の輪郭が含まれていたため、観察されたオプティカルフローの変動は、ビデオのノイズではなく、動物の動きによって導かれているという確信が持てます。標準偏差が小さい領域には、スキャン中にカメラとクレードルに発生した小さな振動の結果である可能性があるクレードルの輪郭が含まれていました。MRI環境は、勾配の切り替えにより、データ取得中に必然的に振動に乗っ取られ、クレードルの反射コンポーネントで観察されるオプティカルフローの変動に現れる可能性があります。幸いなことに、これらの振動はデータ取得全体を通じて一定であるため、刺激条件に依存せず、行動解析の結果に影響を与えるとは予想されていません。特に、動物の顔のプロファイルビューに対応するミラーのピクセルで、特に高いオプティカルフロー標準偏差が観察され、これが代表データのROIの選択を導きました。これはまた、泡立て器や匂いを嗅ぐなどの行動反応が、孤立した仔仔を求める雌マウスの典型的な行動レパートリーの一部として期待される可能性のある領域でもあった17。

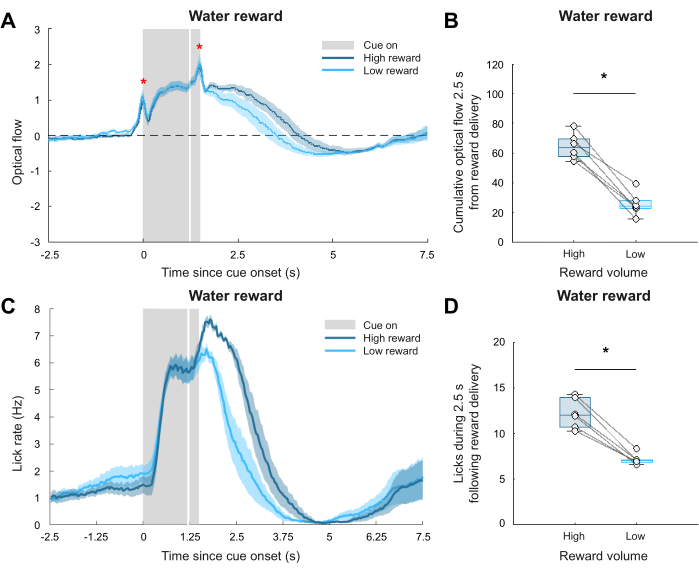

ROIを選択し、すべてのビデオのオプティカルフローの平均フレーム単位の大きさを抽出した後、関心のあるエポック間のオプティカルフローをグループや条件間で比較できます。各ビデオのオプティカルフローベクトルの最初の20秒は、明るさの安定化のためにマスクされていることに注意してください。ただし、これは実験のニーズに合わせて調整できます。各ビデオについて、選択したROIのフレーム単位のオプティカルフローベクトルをZスコアリングし、顔の表情分類に関する以前の研究に従って、カメラの30Hzフレームレートが予想される動作変動よりも速いことを考慮して、5ヘルツ(Hz)でローパスフィルタリングしました2。最後に、Zスコアとフィルタリングされたベクトルを刺激提示エポックにチャンク化して、オプティカルフローに対する刺激提示の影響を評価しました。各エポックについて、平均刺激前ベースライン信号を差し引いて、オプティカルフローを刺激前周期に正規化しました。図3Aは、図3B-Eの要約グループデータを使用して、2つのビデオ(1つの母親と1つの処女)の例示的なオプティカルフロー時系列を示しています。図3Bおよび図3Dは、ベースラインに対する刺激提示中の経時的な累積光流を示し、図3Cおよび図3Eは、刺激開始の2.5秒後の累積光流を要約している。累積オプティカルフローは、自発的な行動反応が時間ロックされた方法で発生すると想定せずに、時間の経過に伴う全体的な動きを捉えるように計算されました。全体として、これらの代表的な結果は、予測されたように、母体マウスと処女マウスでは、純粋な声ではなく、子犬の鳴き声が有意に異なる行動反応を引き起こしたことを示しています(グループ間マンホイットニーU検定:子犬の鳴き声:p = 0.026;純音:p = 0.093)。しかし、この刺激効果は2因子ANOVAでは生き残れませんでしたが、グループ効果は生き残りました(刺激:F(1,10)= 0.19、p = 0.67;グループ:F(1,10)= 8.61、p = 0.015)。全体として、これらの結果は、母親が処女と比較してより高い刺激誘発運動を示し、子犬の鳴き声に対する母親の反応は純粋な声よりも一貫していることを示唆しています。これは、母親の注意力やストレスの高まり、および子犬の鳴き声の行動関連性を反映している可能性があります。これは、純粋なトーンとは異なり、自然主義的な環境の母親の子犬の回収の反応を呼び起こします。まとめると、これらの代表的な結果は、外部刺激提示中のオプティカルフロー推定が、微妙な自発的な行動反応に関する情報を抽出できることを示唆しています。

最後に、代表的なデータでキャプチャされた振る舞いの空間特性を明らかにするために、より探索的な分析が行われました。刺激提示中にROIのどのピクセルが協調的に変動したかを調べるために、空間オプティカルフロー情報の経時的な主成分分析(PCA)を実施しました。この分析により、 図 4 に示すように、最初の PC に最も寄与したピクセルと、各刺激条件のグループ差を示すピクセルが明らかになりました。 図4A、B の右端のパネルは、両方の刺激タイプの提示中に、母親が処女と比較して鼻により多くの動きを示したことを示唆しています。2つのグループと2つの刺激条件にわたって、最初のPCはオプティカルフロー解析の全分散の5.41%±0.59%を説明しました。この部分ではミラーROIが維持されましたが、将来の分析では、刺激に反応して顔を越えた協調的な動きを特徴付けるために、FOVのより広範な部分に拡張される可能性があります。例えば、子犬の動きを比較すると、通常、母親では子犬の呼び出しが子犬の回収を開始するが処女では開始されないこと、および前足が動物の頭よりも自由に動くことができることを考えると、前足の動きを比較すると、より有意なグループの違いが明らかになる可能性がある。

これまでの代表的な結果から、このパイプラインは制約のあるビデオ撮影環境において、外部刺激に対する無指示の行動反応を評価できることが示唆されていましたが、観察されたオプティカルフローの変動が本当に意味のある動物の行動を反映しているのかという疑問が残っていました。この質問に答えるために、同じパイプラインを使用して別の検証データセットを分析しました。別の実験では、水制限を受けた雄マウスを、軽い手がかりを6μL(「高報酬」)または1μL(「低報酬」)の水報酬の送達に関連付けるように訓練しました。注目すべきは、聴覚刺激実験とは異なり、この実験では先験的な行動の読み出し、つまり舐め率が読み取られたことです。リコメーターは、水の噴出口近くのピクセル輝度の分析によって促進された、ビデオベースのリックの検出によって確立されました。したがって、リコメータによって提供される動作読み出しは、オプティカルフロー推定によって提供されるこのパイプラインの動作読み出しを比較するために使用でき、自発的な動作を検出する際の有効性をサポートします。ビデオの共レジストレーション、オプティカルフローの推定、ROIの選択(再びミラーFOVを含む)、およびオプティカルフローの定量化に続いて、オプティカルフローの大きさを比較すると、高報酬と低報酬に対する行動反応の間に有意差が明らかになりました。この分析の結果を図5A,Bに示し、図5Aはグループ平均時系列を示し、図5Bは刺激開始の2.5秒後の累積オプティカルフローを要約します(条件間ペアのWilcoxon符号順位検定:p = 0.031)。オプティカルフロー値は、代表データに記録された自発的な行動と比較して大きく、指示されていない微妙な行動反応を評価するという課題をさらに強調していることに注意してください。図5Cは、2つの報酬条件のそれぞれについてlickometerによって記録された実際の舐め率を示しており、図5Dは、報酬の配信後2.5秒以内に、高報酬条件では低報酬条件と比較してより多くの舐めが記録されることを示しています(条件間ペアのWilcoxon符号順位検定:p = 0.031)。全体として、両方の分析で、高報酬反応と低報酬反応の比較で同様の傾向が明らかになり、提示されたビデオ分析パイプラインが条件間での動物の行動の意味のある違いを捉えることが実証されました。

まとめると、ここに示した代表的な結果は、子犬の鳴き声の提示が母体と処女の雌マウスで有意に異なる反応を引き起こしたのに対し、純粋なトーンはそうではなかったことを示唆しています。検証データセットの解析により、オプティカルフローで観察された違いが、外部刺激に対する行動反応の有意な違いを反映しているという確信が得られます。

(A)3つのフレームでラベル付けされた所定の特徴(ヘッドポストの中央、右目の正面図、右目のプロファイルビュー)を描写したビデオ同時レジストレーションの例、それぞれが異なる動物の異なるビデオから撮影された。オーバーレイでは、3つのポイントが整列しておらず、データ集録セッション間で動作設定がわずかに変化したことを示しています。(B) ビデオの同時登録を実行する前 (左) と実行後 (右) の各ビデオの最後の 10 秒間の平均フレーム。この図の拡大版を表示するには、ここをクリックしてください。

図2:オプティカルフロー推定(A)相対的なオプティカルフローベクトルを青色でオーバーレイしたフレームの例。(B)すべてのビデオのオプティカルフローの平均ピクセル単位標準偏差。鏡越しに動物の顔のプロファイルビューの周囲に選択されたROIは、マゼンタで輪郭が描かれています。カラーバーは標準偏差に対応します。この図の拡大版を表示するには、ここをクリックしてください。

図3:グループおよび条件間でのオプティカルフローの可視化と比較(A)母親の1つのビデオと処女の1つのビデオに対するオプティカルフローの例示的なZスコアおよび5Hzローパスフィルタリングされた時系列。(B)および(D)子犬の鳴き声(B)および純音(D)の刺激期間中に測定された累積オプティカルフロー。網掛けは、平均の標準誤差 (SEM) を表します。(C)および(E)子犬の鳴き声(C)および純音(E)の刺激提示の最初の2.5秒間の累積オプティカルフロー。* p < 0.05、グループ間 Mann-Whitney U 検定 (pup コール: p = 0.026; 純音: p = 0.093)、N = 6 グループあたりを示します。この図の拡大版を表示するには、ここをクリックしてください。

図4:グループ間のPC1の比較 (A,B) グループ間のパップコール(A)および純音(B)中のオプティカルフローの最初の主成分(PC1)の負荷を描いたマップで、多重比較のための補正なしでp<0.05で統計的に閾値化されています。ヒートマップは、各ピクセルのオプティカルフロー変動が他のピクセルと比較してPC1にどの程度寄与したかを示します。小さな黒のテキストは、PC1 で説明された分散の割合を示します (母親の子犬の鳴き声: 4.95% ± 0.72%、処女の子犬の鳴き声: 4.44% ± 0.59%、母親の純音: 4.95% ± 0.39%、処女の純音: 4.72% ± 1.24% (平均±標準偏差))。この図の拡大版を表示するには、ここをクリックしてください。

図 5: 行動分析パイプラインの検証。 (A)平均Zスコア、プレスティミュラスベースラインを差し引いたもの、および高報酬および低報酬配信中の光フローの5Hzローパスフィルタリング時系列。網掛けはSEMを表し、白い縦線は報酬の配信を示し、赤いアスタリスクはライトキューの開始とオフセットによる一時的なオプティカルフローアーティファクトを示します。(B)報酬配信後の最初の2.5秒間の累積オプティカルフローの要約。* p < 0.05 で、条件間の対応のあるウィルコクソン符号順位検定 (p = 0.031) を示します。(C)リコメーターによって得られる、高報酬および低報酬配信中の平均舐め率。網掛けはSEMを表し、白い縦線は報酬の配信を示します。(D)報酬配信後の最初の2.5秒間に記録されたリックの数。* p < 0.05、条件間対応のウィルコクソン符号順位検定 (p = 0.031)、N = 6 を示します。 この図の拡大版を表示するには、ここをクリックしてください。

ビデオ 1: サンプル ビデオ 1。 PCR_Br011_20231015_1842_output.avi。 このビデオをダウンロードするには、ここをクリックしてください。

動画 2: 動画の例 2。 PCR_Br014_20231015_1722_output.avi。 このビデオをダウンロードするには、ここをクリックしてください。

補足ファイル1:ビデオ1のイベントタイミングファイル。 PCR_Br011_20231015_1842_output_videoTimestamps.matです。 このファイルをダウンロードするには、ここをクリックしてください。

補足ファイル2:ビデオ2のイベントタイミングファイル。 PCR_Br014_20231015_1722_output_videoTimestamps.matです。 このファイルをダウンロードするには、ここをクリックしてください。

補足コーディングファイル1:script1_videocoreg.m. このスクリプトは、共登録 によって すべてのビデオを空間的に配置します。 このファイルをダウンロードするには、ここをクリックしてください。

補足コーディングファイル2:script2_optflow_roiselect時 このスクリプトは、変換された各ビデオの完全な FOV のオプティカル フローを推定し、パイプラインの残りの部分の ROI を選択できるようにします。 このファイルをダウンロードするには、ここをクリックしてください。

補足コーディングファイル3:script3_optflow_analysis時 このスクリプトは、選択したROIのさまざまなグループ/条件間でオプティカルフローの大きさを比較します。 このファイルをダウンロードするには、ここをクリックしてください。

補足コーディングファイル4:script4_optflow_pca時 このスクリプトは、選択した ROI の推定オプティカル フローに対して PCA を実行します。 このファイルをダウンロードするには、ここをクリックしてください。

補足コーディングファイル5:script5_optflow_pca_analysis時 このスクリプトは、選択したROIのグループ/条件間でPCAの結果を比較します。 このファイルをダウンロードするには、ここをクリックしてください。

ディスカッション

提示された行動分析パイプラインは、受動的に提示された刺激に応答して指示されていない行動を示す動物のビデオから貴重な情報を抽出することを可能にします。これらの代表的な行動ビデオは、MRI環境での行動反応を捉えるために複数の制約を克服した全脳機能磁気共鳴画像法(fMRI)データと組み合わせて取得されました。オプティカルフロー推定の方法を採用すると、母親と処女が子犬の鳴き声にどのように反応するかの違いが明らかになりましたが、純粋なトーンではなかったため、最初の仮説13,14,15,16が支持されました。この知見は、オプティカルフロー情報の次元削減を利用して、これらの振る舞いの空間分布の探索的解析に拡張されました。

この解析パイプラインは、さまざまな実験パラダイムに広く対応しています。取得する神経データの種類に全く依存せず、過剰な計算能力や特殊な機器を必要としません。主な実験要件は、ビデオ撮影データを刺激提示開始の関連するタイムスタンプとともに記録することです。さらに、デモされた解析の実行に使用されるMATLABスクリプトを提供することで、このパイプラインの実装は、MATLABの経験がほとんどない人でもかなり簡単に行うことができます。プロトコルに記載されている一般的な手順は、ビデオ共レジストレーション、オプティカルフロー推定、関心領域(ROI)選択、ROI固有のオプティカルフロー定量化、オプティカルフローマグニチュード比較、主成分分析(PCA)、およびPCA比較で構成されます。各ステップで、パイプラインは、プロトコルに記載され、コード全体でコメントで強調表示されているように、実験および分析のニーズに合わせて変更できます。

提示されたビデオ分析パイプラインを採用する際には、いくつかの制限に注意する必要があります。まず、行動装置の設計を慎重に検討する必要があります。どのような行動反応が期待できるかが不明な場合、動物についてできるだけ多くの視点を持つことは、将来の分析に役立つ可能性があります。したがって、図1Aの例のビデオフレームに示すように、動物の正面図とプロファイルビューを同時にキャプチャするために、1つまたは複数のミラーを設置することをお勧めします。次に、ビデオ集録用に用意される照明は、視野角(FOV)のすべての関連特徴を見るのに十分な明るさであるが、飽和に達するほど明るくないことをお勧めします。図1Aでは、マウスの鼻の正面図が飽和点に近い位置にあるため、動きを示す明るさの変動を捉えることが困難になっていることがわかります。これは、図 2B に示すように、FOV のこの部分で観察されるオプティカル フローの変動の欠如に寄与している可能性があります。幸いなことに、ノーズのプロファイルビューはこの問題に直面しなかったため、ミラーROIの分析が可能になりました。さらに、視覚刺激が実験に関与している場合は、飽和の可能性を考慮する必要があります。検証データセットの実験では、水の報酬の配信を知らせるために使用される光の手がかりにより、取得したビデオに一時的な飽和が生じ、オプティカルフロー推定に一時的なアーティファクトが生じました。このアーチファクトは図5Aで観察でき、両方の報酬条件のオプティカルフロートレースの2つの鋭いピークは、ライトキューがオンとオフになったときと正確に一致しています。このアーティファクトにより、提示されたパイプラインではこれらの短い時間枠を分析することが困難になり、それが存在していなかった場合、図 5B に示されている結果はさらに重要だった可能性があります。一定のシーン照明は、ほとんどのオプティカルフローアルゴリズム14,16に必要な仮定です。したがって、このビデオ解析パイプラインは、試行中および試行間で環境の照明が大幅に変化する実験には推奨されません。第三に、そして最後に、動物を記録環境に十分に慣れさせることは、このパイプラインを利用する実験の重要な要素です。適切に慣れていないと、動物は重大なストレス反応を示し、ビデオ分析で解析できる微妙な刺激による影響を洗い流す可能性があります。

今後、この行動分析パイプラインを使用して、同時に記録された行動反応と神経反応の協調的な評価を容易にすることができます。このように、指示を受けていない行動を定量的に評価することで、複雑な記録環境における刺激の顕著性を評価するだけでなく、実験グループや条件間で異なる行動反応をテストすることができます。さらに分析を行い、行動反応の個人差や試行ごとの傾向を調査し、対応する神経活動を調べることができます。さらに、PCAを組み込んで刺激誘発運動に関する空間情報を取得することで、刺激提示中に観察される特定のタイプの行動シーケンスがグループや条件によって異なるかどうかをさらに調査することができます。この解析パイプラインは、さまざまなニューラル記録法に簡単に拡張でき、制約のある環境での多様な行動モニタリングを提供します。外部刺激が脳と行動の両方でどのように表現されているかを調査することにより、研究者は刺激の知覚が内部状態とその外部症状にどのように影響するかについてより包括的に理解する準備ができています。

開示事項

著者は何も開示していません。

謝辞

この研究を支援してくださったMarlin研究室とKahn研究室に感謝いたします。また、Kevin Cury博士には、当社のビデオ撮影データに関する洞察に満ちた議論をしていただいたことに感謝いたします。この出版物で報告された研究は、賞番号F31HD114466(BRM)、ハワードヒューズ医学研究所(BJM)、UNCF E.E.の米国国立衛生研究所のユーニス・ケネディ・シュライバー国立小児保健・人間開発研究所の支援を受けました。ジャストフェローシップCU20-1071(BJM)、BBRF NARSAD若手研究者助成金30380(BJM)、およびホワイトホール財団(BJM)。内容は著者の責任であり、必ずしも国立衛生研究所の公式見解を表すものではありません。

資料

| Name | Company | Catalog Number | Comments |

| MATLAB Computer Vision Toolbox | MathWorks | https://www.mathworks.com/products/computer-vision.html | |

| MATLAB Image Processing Toolbox | MathWorks | https://www.mathworks.com/products/image-processing.html | |

| MATLAB software | MathWorks | https://www.mathworks.com/products/matlab.html | |

| MR-compatible camera “12M-i” with integrated LED light | MRC Systems GmbH | 12M-i | https://www.mrc-systems.de/downloads/en/mri-compatible-cameras/manual_mrcam_12m-i.pdf |

参考文献

- Musall, S., Kaufman, M. T., Juavinett, A. L., Gluf, S., Churchland, A. K. Single-trial neural dynamics are dominated by richly varied movements. Nat Neurosci. 22 (10), 1677-1686 (2019).

- Dolensek, N., Gehrlach, D. A., Klein, A. S., Gogolla, N. Facial expressions of emotion states and their neuronal correlates in mice. Science. 368 (6486), 89-94 (2020).

- Kepecs, A., Uchida, N., Mainen, Z. F. The sniff as a unit of olfactory processing. Chemical Senses. 31 (2), 167-179 (2006).

- Shusterman, R., Smear, M. C., Koulakov, A. A., Rinberg, D. Precise olfactory responses tile the sniff cycle. Nat Neurosci. 14 (8), 1039-1044 (2011).

- Han, Z., et al. Awake and behaving mouse fMRI during Go/No-Go task. NeuroImage. 188, 733-742 (2019).

- Mathis, A., Mamidanna, P., Cury, K. M. DeepLabCut: Markerless pose estimation of user-defined body parts with deep learning. Nature Neurosci. 21 (9), 1281-1289 (2018).

- Krakauer, J. W., Ghazanfar, A. A., Gomez-Marin, A., MacIver, M. A., Poeppel, D. Neuroscience needs behavior: Correcting a reductionist bias. Neuron. 93 (3), 480-490 (2017).

- Wiltschko, A. B., Tsukahara, T., Zeine, A. Revealing the structure of pharmacobehavioral space through motion sequencing. Nat Neurosci. 23 (11), 1433-1443 (2020).

- Moëne, O. L., Larsson, M. A new tool for quantifying mouse facial expressions. eNeuro. 10 (2), (2023).

- Paasonen, J., Stenroos, P., Laakso, H. Whole-brain studies of spontaneous behavior in head-fixed rats enabled by zero echo time MB-SWIFT fMRI. NeuroImage. 250, 118924 (2022).

- Ehret, G. Infant rodent ultrasounds: A Gate to the understanding of sound communication. Behav Genet. 35 (1), 19-29 (2005).

- Marlin, B. J., Mitre, M., D'amour, J. A., Chao, M. V., Froemke, R. C. Oxytocin enables maternal behavior by balancing cortical inhibition. Nature. 520 (7548), 499-504 (2015).

- . Optical Flow Available from: https://www.mathworks.com/discovery/optical-flow.html (2024)

- Horn, B. K. P., Schunck, B. G. Determining optical flow. Artif Intell. 17 (1), 185-203 (1981).

- Szeliski, R., Szeliski, R. Dense motion estimation. Computer Vision: Algorithms and Applications. , 335-374 (2011).

- Beauchemin, S. S., Barron, J. L. The computation of optical flow. ACM Comput Surv. 27 (3), 433-466 (1995).

- McRae, B. R., Andreu, V., Marlin, B. J. Integration of olfactory and auditory cues eliciting parental behavior. J Neuroendocrin. 35 (7), e13307 (2023).

転載および許可

このJoVE論文のテキスト又は図を再利用するための許可を申請します

許可を申請This article has been published

Video Coming Soon

Copyright © 2023 MyJoVE Corporation. All rights reserved