Method Article

Profilazione delle risposte comportamentali materne durante l'imaging dell'intero cervello

In questo articolo

Riepilogo

Di seguito viene presentata una pipeline di analisi video che supera le sfide del monitoraggio comportamentale all'interno degli ambienti MRI, consentendo il rilevamento di risposte comportamentali non istruite a segnali esterni. Questa analisi faciliterà una comprensione più completa dei cambiamenti di stato interni evocati e dell'attività cerebrale a livello cerebrale.

Abstract

I recenti progressi negli strumenti di imaging dell'intero cervello hanno permesso ai neuroscienziati di studiare come l'attività cerebrale coordinata elabora i segnali esterni, influenzando i cambiamenti di stato interni e suscitando risposte comportamentali. Ad esempio, la risonanza magnetica funzionale (fMRI) è una tecnica non invasiva che consente di misurare l'attività dell'intero cervello in topi svegli e comportanti utilizzando la risposta dipendente dal livello di ossigenazione del sangue (BOLD). Tuttavia, per comprendere appieno le risposte BOLD evocate da stimoli esterni, è fondamentale che gli sperimentatori valutino anche le risposte comportamentali durante le scansioni. L'ambiente di risonanza magnetica pone sfide a questo obiettivo, rendendo incompatibili i metodi comunemente impiegati di monitoraggio comportamentale. Queste sfide includono (1) un campo visivo limitato e (2) la disponibilità limitata di apparecchiature prive di componenti ferromagnetici. Di seguito viene presentata una pipeline di analisi video comportamentale che supera queste limitazioni estraendo informazioni preziose dai video acquisiti all'interno di questi vincoli ambientali, consentendo la valutazione del comportamento durante l'acquisizione di dati neurali dell'intero cervello. Utilizzando metodi come la stima del flusso ottico e la riduzione della dimensionalità, è possibile rilevare differenze robuste nelle risposte comportamentali agli stimoli presentati durante le scansioni fMRI. Ad esempio, risultati rappresentativi suggeriscono che le vocalizzazioni dei cuccioli di topo, ma non i toni puri, evocano risposte comportamentali significativamente diverse nei topi femmine materne rispetto a quelli vergini. In futuro, questa pipeline di analisi comportamentale, inizialmente adattata per superare le sfide negli esperimenti fMRI, può essere estesa a vari metodi di registrazione neurale, fornendo un monitoraggio comportamentale versatile in ambienti limitati. La valutazione coordinata delle risposte comportamentali e neurali offrirà una comprensione più completa di come la percezione degli stimoli porti al coordinamento di output comportamentali complessi.

Introduzione

Il monitoraggio delle risposte comportamentali durante le registrazioni neurali è essenziale per comprendere l'attività coordinata evocata dallo stimolo in tutto il cervello. Nel caso in cui non si preveda che gli animali rispondano agli stimoli in modo specifico e orientato all'obiettivo, l'osservazione di comportamenti non istruiti può offrire intuizioni su come i segnali esterni informano i loro stati interni 1,2. I recenti progressi negli strumenti di neuroimaging, come l'imaging del calcio ad ampio campo e la risonanza magnetica funzionale (fMRI), hanno permesso ai neuroscienziati di espandere le indagini oltre le singole regioni del cervello. Tuttavia, per ottenere una comprensione più completa di tali dati neurali ad alta dimensione, anche la capacità di valutare gli output comportamentali di questi modelli complessi deve progredire di conseguenza.

I metodi all'avanguardia per caratterizzare i comportamenti istruiti sul compito sono ampiamente utilizzati nella ricerca neuroscientifica, inclusi i sensori di temperatura e pressione per rilevare gli sniff 3,4, i raggi di luce per rilevare le leccate5 e la stima della posa senza marcatori per tracciare parti del corpo predeterminate6. Tuttavia, la valutazione basata sui dati di modelli comportamentali non istruiti rimane una sfida nel campo7. Mentre i metodi per l'analisi comportamentale basata sui dati stanno avanzando rapidamente, i metodi esistenti richiedono in genere una notevole potenza di calcolo, attrezzature specializzate o una visione particolarmente chiara dell'animale 2,6,8,9. Di seguito viene presentata una pipeline di analisi video comportamentale che è facilmente suscettibile di qualsiasi dato videografico e consente l'estrazione di preziose misure comportamentali dai video acquisiti durante la stimolazione passiva.

Questa pipeline di analisi comportamentale è stata progettata per essere compatibile con l'acquisizione coordinata di dati neurali e video in animali con testa fissa esposti a un'ampia gamma di stimoli esterni e a più ambienti di registrazione, anche quelli con vincoli considerevoli. Ad esempio, l'ambiente di risonanza magnetica pone sfide specifiche al monitoraggio comportamentale, tra cui un campo visivo limitato e una disponibilità limitata di apparecchiature prive di componenti ferromagnetici. Questi vincoli rendono incompatibili i metodi comunemente impiegati, lasciando misure come il movimento della testa (cioè il modo in cui il cervello si muove tra le acquisizioni di volume) tra i modi più accessibili ma limitati per valutare le risposte corporee durante le scansioni10. Superando queste limitazioni, questo protocollo ha facilitato l'analisi dei dati videografici compatibili con la risonanza magnetica, dimostrando che i topi femmina con diverse esperienze materne mostrano risposte comportamentali distinte agli stimoli uditivi. Alle madri e alle vergini sono stati presentati stimoli uditivi durante le scansioni fMRI, tra cui vocalizzazioni di cuccioli angosciati ("richiami di cuccioli") e toni puri. Questi stimoli sono stati presentati passivamente, quindi senza alcun output comportamentale istruito. Mentre si prevedeva che le madri mostrassero risposte più elevate ai richiami dei cuccioli rispetto alle vergini, c'è poca letteratura su come i topi femmina rispondono ai segnali dei neonati in un ambiente con la testa fissa. Pertanto, non c'era un output comportamentale specifico da tracciare a priori, rendendo questo esperimento il test perfetto per le analisi comportamentali basate sui dati proposte. Utilizzando metodi come la stima del flusso ottico e la riduzione della dimensionalità, sono state rilevate differenze di gruppo nelle risposte comportamentali, sia in grandezza che in manifestazione spaziale.

Andando avanti, la valutazione coordinata delle risposte comportamentali e neurali può essere sfruttata per ottenere una comprensione più completa di come gli stimoli esterni alterano gli stati interni e informano output comportamentali complessi. Questa comprensione dovrebbe estendersi agli stimoli presentati in assenza di compiti imposti e comportamenti istruiti. La pipeline di analisi qui presentata può essere estesa a varie tecniche di registrazione neurale, fornendo un monitoraggio comportamentale versatile anche in ambienti limitati.

Protocollo

Tutti gli esperimenti sugli animali sono stati eseguiti secondo i protocolli approvati dal Comitato Istituzionale per la Cura e l'Uso degli Animali (IACUC) della Columbia University e tutti i metodi sono stati eseguiti in conformità con le linee guida, i regolamenti e le raccomandazioni pertinenti. I dettagli delle attrezzature e dei software utilizzati sono riportati nella Tabella dei Materiali.

1. Software

- Scarica MATLAB dal sito web di Mathworks.

NOTA: Il codice che comprende questa pipeline di analisi è eseguibile esclusivamente tramite MATLAB ed è stato scritto specificamente per essere compatibile con MATLAB 2023a. - Questa pipeline richiede Computer Vision Toolbox e Image Processing Toolbox all'interno di MATLAB. Aggiungi le caselle degli strumenti ai componenti aggiuntivi di MATLAB facendo clic su Gestisci componenti aggiuntivi, Ottieni componenti aggiuntivi, quindi cercali e aggiungili.

NOTA: Cinque script MATLAB sono forniti come file supplementari, denominati come segue: script1_videocoreg.m (File di codifica supplementare 1), script2_optflow_roiselect.m (File di codifica supplementare 2), script3_optflow_analysis.m (File di codifica supplementare 3), script4_optflow_pca.m (File di codifica supplementare 4) e script5_optflow_pca_analysis.m (File di codifica supplementare 5). Vengono forniti anche due video di esempio (Video 1 e Video 2) e i file di temporizzazione degli eventi corrispondenti (File supplementare 1 e File supplementare 2). Si consiglia di eseguire prima la pipeline con i dati di esempio.

ATTENZIONE: Prestare attenzione a eventuali commenti nel codice che includono un punto esclamativo, poiché si tratta di aree che richiedono un'azione prima dell'esecuzione. Ad esempio, ci sono commenti come "modifica il blocco di codice qui sotto!" per evidenziare dove devono essere apportate modifiche per adattarsi alle strutture dei file, ai dettagli dell'esperimento o alle esigenze di analisi. Queste scelte sono impostate per impostazione predefinita per adattarsi ai due video di esempio forniti, ma dovranno essere modificate una volta che si inizia a eseguire la pipeline con i propri dati. - Per eseguire ogni sezione di ogni script, fare clic su Esegui e avanza nel menu Editor .

2. Coregistrazione video

NOTA: Il primo script fornito in questa pipeline di analisi è script1_videocoreg.m (Supplementary Coding File 1), che allinea spazialmente tutti i video tra loro tramite coregistrazione. Gli input per questo script sono i video grezzi e gli output principali sono i video trasformati.

- Modifica le sezioni 1, 2, 3, 4, 5 e 6 dello script dove indicato per adattarlo alle strutture dati.

- Eseguire la sezione 1.

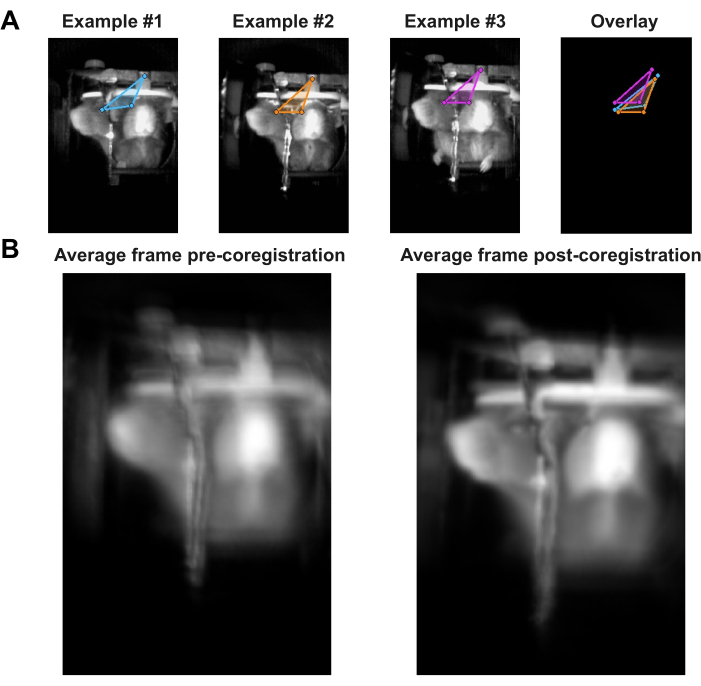

- Scegli tre punti in ogni video da etichettare, come nella Figura 1A. Questi tre punti verranno utilizzati per registrare tutti i fotogrammi l'uno con l'altro. Esegui la Sezione 2 dello script per visualizzare il primo fotogramma di ogni video e usa il mouse per fare clic una volta sui primi due punti, quindi fai doppio clic sul terzo punto. Dopo aver selezionato i punti dell'ultimo video, premere Invio.

- Eseguire la Sezione 3 e la Sezione 4.

- Impostare il flag allineato a 0 ed eseguire la Sezione 5. Quindi, impostare il flag allineato su 1 ed eseguire nuovamente la Sezione 5 .

- Eseguire la Sezione 6 e confrontare la figura affiancata risultante con la Figura 1B. Eventuali aberrazioni osservate nell'immagine media non allineata a sinistra dovrebbero essere ridotte nell'immagine media allineata a destra.

3. Stima del flusso ottico: FOV completo

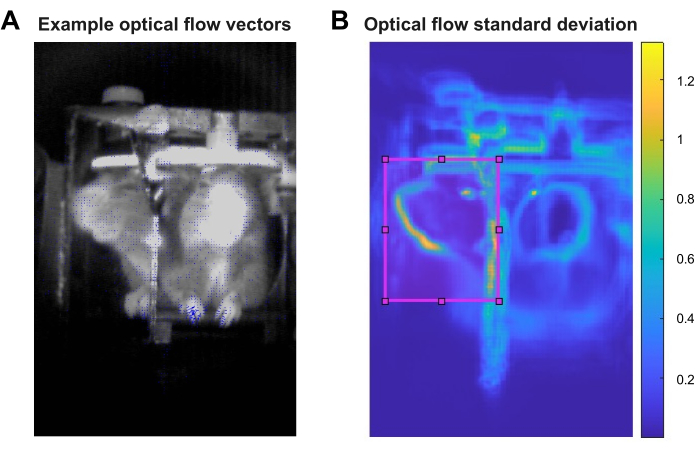

NOTA: Per valutare il movimento attraverso i video di scansione, è necessario stimare il flusso ottico per ogni video trasformato. Questo può essere fatto per l'intero campo visivo (FOV) di ciascun video con lo script fornito script2_optflow_roiselect.m (Supplementary Coding File 2). Gli input per questo script sono i video trasformati e gli output sono matrici 3D che indicano l'ampiezza del flusso ottico di ciascun pixel nel tempo per ogni video. La Figura 2A mostra un fotogramma di esempio con vettori di flusso ottico sovrapposti in blu, dove la lunghezza di ciascun vettore rappresenta l'ampiezza relativa del flusso ottico di quel pixel. Il salvataggio degli output come video è risultato più efficiente rispetto al salvataggio come matrici 3D.

- Modificare la Sezione 1 dello script dove indicato per adattarla alle strutture dati.

- Eseguire la sezione 1.

4. Selezione del ROI

NOTA: Le seguenti fasi di analisi sono rese molto più gestibili in termini di carico computazionale e necessità di archiviazione dei dati selezionando una regione di interesse (ROI) all'interno del FOV completo su cui concentrare l'analisi. Il ROI può essere selezionato in base all'esperimento e ai comportamenti di interesse o attraverso un approccio più data-driven. Per i risultati rappresentativi qui presentati, la deviazione standard dell'ampiezza del flusso ottico di ciascun pixel nel FOV completo è stata calcolata con lo script script2_optflow_roiselect.m, Sezione 2 (File di codifica supplementare 2). Gli input per questa parte dello script sono gli output della Sezione 1 e l'output principale è una visualizzazione della deviazione standard dell'ampiezza del flusso ottico su tutti i pixel di tutti i video. Nei risultati rappresentativi presentati, il FOV dello specchio ha mostrato una deviazione standard relativamente alta del flusso ottico, che ha guidato la scelta dimostrata del ROI.

- Modificare la sezione 2 dello script dove indicato per adattarlo alle strutture dati.

- Esegui la Sezione 2 e utilizza l'immagine risultante per vedere dove il flusso ottico fluttua in modo più drammatico nei video analizzati. Un esempio di questa immagine è mostrato nella Figura 2B.

5. Quantificazione del flusso ottico: ROI

NOTA: La sezione 3 dello script script2_optflow_roiselect.m (Supplementary Coding File 2) consente all'utente di selezionare una ROI con uno strumento di disegno e salvare le coordinate di confine. Gli input per questa parte dello script sono gli output della Sezione 1 e gli output sono vettori 1D che indicano l'entità media del flusso ottico del ROI nel tempo per ogni video.

- Modificare la sezione 3 dello script dove indicato per adattarlo alle strutture di dati e alle esigenze di analisi.

NOTA: Ci sono alcune opzioni su come procedere con la selezione del ROI. Scegli un'opzione:- Opzione 1: analizza l'intero FOV del video.

- Impostare il flag selectROI su 0 e impostare provideROI su 0.

- Opzione 2: analizza un nuovo ROI.

- Impostare il flag selectROI su 1 e impostare provideROI su 0. Quindi modifica newCoordsName.

- Opzione 3: Analizza un ROI disegnato in precedenza.

NOTA: selezionare questa opzione solo se si è precedentemente eseguito questo codice e si è creato un ROI.- Impostare il flag selectROI su 0 e impostare provideROI su 1. Quindi, modifica inputCoords per fornire un set predeterminato di coordinate.

- Opzione 1: analizza l'intero FOV del video.

- Eseguire la sezione 3.

6. Confronto dell'ampiezza del flusso ottico

NOTA: Lo script fornito script3_optflow_analysis.m (Supplementary Coding File 3) richiede la massima specializzazione per adattarsi ai dati dell'utente. Gli input principali sono i vettori 1D che indicano l'entità media del flusso ottico del ROI nel tempo per ciascun video e, se combinati in modo appropriato con l'insorgenza degli eventi e le informazioni su gruppi/condizioni, gli output principali sono confronti statistici che possono essere adattati agli interessi dell'analisi.

- Modifica le sezioni 1-3 dello script per adattarle alle strutture di dati e alle esigenze di analisi.

- Imposta i flag delle opzioni di analisi zsc, blrm, blzsc, demeanPerTrial e applyLPfilter su 0 o 1 come desiderato nella Sezione 1. Nei risultati rappresentativi presentati, zsc, blrm e applyLPfilter sono stati impostati su 1 e tutte le altre opzioni sono state impostate su 0.

- Impostare LPfilter su un numero che rappresenta il filtro passa-basso desiderato in hertz (Hz). Nei risultati rappresentativi presentati, è stato applicato un filtro passa-basso a 5 Hz, poiché non ci si aspettava che le risposte comportamentali fluttuassero a una velocità superiore a 5 Hz.

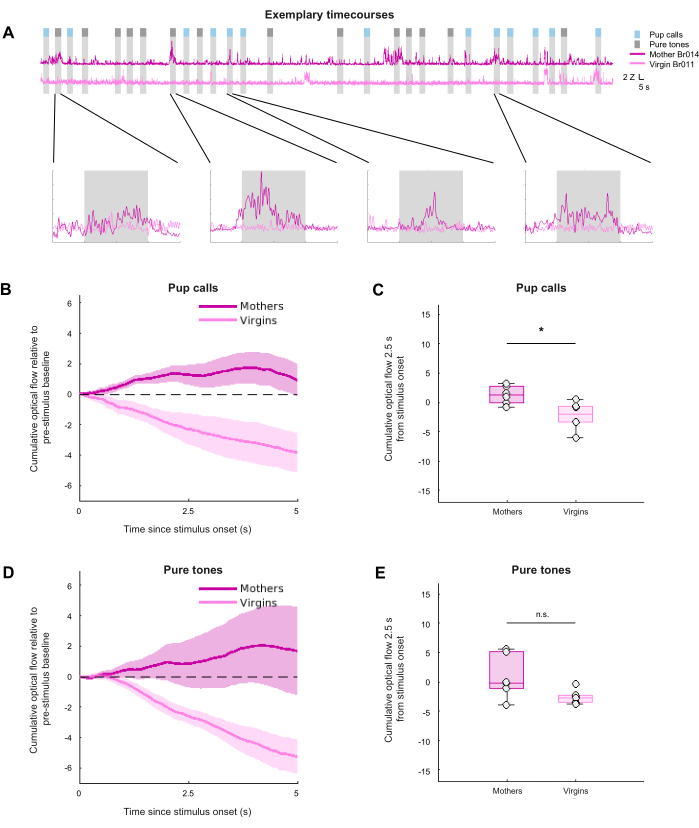

- Eseguire le sezioni 1-3. La sezione 3 dovrebbe produrre grafici per le serie temporali del flusso ottico medio di gruppo, del flusso ottico cumulativo medio di gruppo e del flusso ottico cumulativo riepilogativo, compresi grafici come quelli mostrati nella Figura 3. La sezione 3 può essere eseguita per qualsiasi combinazione di confronti gruppo/condizione.

7. Flusso ottico PCA

NOTA: Basandosi sulla stima dell'ampiezza del flusso ottico, gli output di script2_optflow_roiselect.m (Supplementary Coding File 2) contengono anche informazioni sulla distribuzione spaziale del flusso ottico fotogramma per fotogramma per video. Al fine di ridurre la dimensionalità di queste informazioni spaziali, lo script fornito script4_optflow_pca.m (Supplementary Coding File 4) esegue l'analisi delle componenti principali (PCA) sul flusso ottico stimato. Gli input principali sono le matrici di flusso ottico 3D, precedentemente salvate come video per ogni video comportamentale, e l'output principale è un file .mat per video contenente informazioni sulla varianza spiegate dal PC.

- Modifica la Sezione 1 dello script per adattarla alle strutture di dati e alle esigenze di analisi.

- Impostare le opzioni di analisi flag stimnum, dsfactor e fnfactor come desiderato nella Sezione 1. Nei risultati rappresentativi presentati, ogni tipo di stimolo è stato analizzato separatamente e il valore predefinito di 1 è stato mantenuto per dsfactor e fnfactor, con conseguente assenza di downsampling nello spazio o nel tempo.

- Eseguire la sezione 1.

8. Confronto PCA a flusso ottico

NOTA: Lo script fornito script5_optflow_pca_analysis.m (Supplementary Coding File 5) eseguirà confronti esplorativi dei risultati PCA tra i gruppi. Gli input principali sono il PC specifico dello stimolo e le informazioni sulla varianza spiegate ottenute da script4_optflow_pca.m (Supplementary Coding File 4), mentre gli output principali sono mappe di calore con soglia statistica che descrivono i carichi del primo PC, sebbene anche altri PC possano essere analizzati con questo script.

- Modificare la Sezione 1 dello script per adattarla alle strutture di dati e all'analisi.

- Eseguire la Sezione 1 e la Sezione 2.

- Modificare gli input della Sezione 3 , in particolare le variabili group e myTitle , in modo che riflettano l'analisi di gruppo desiderata, così come threshT. threshT rappresenta la soglia della statistica T al di sopra della quale i risultati saranno considerati significativi, che può essere calcolata sulla base delle tabelle della statistica T per i valori p disponibili al pubblico e dei gradi di libertà.

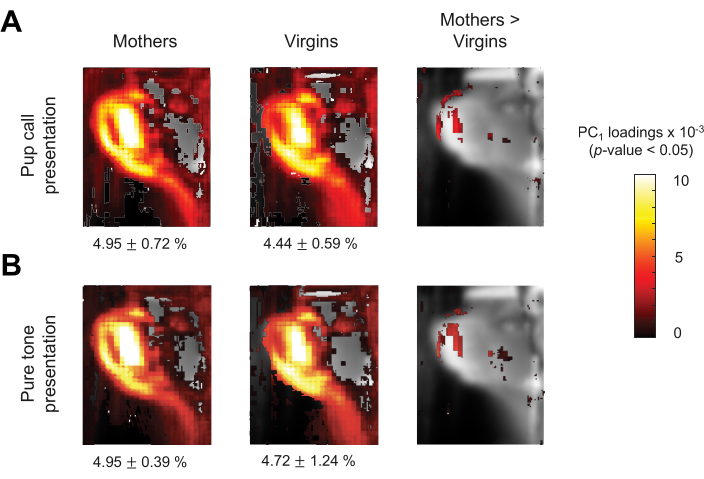

- Esegui la sezione 3 per ogni gruppo di interesse. Il codice deve produrre una mappa statistica di riepilogo del gruppo, come quelle mostrate nei pannelli sinistro e centrale della Figura 4. Regolare l'intervallo di cassi, e quindi i limiti della barra dei colori, come desiderato per la visualizzazione.

- Modifica gli input della Sezione 4 , in particolare le variabili mag e myTitle per riflettere il confronto di gruppo desiderato, così come threshT. threshT rappresenta la soglia della statistica T al di sopra della quale i risultati saranno considerati significativi, che può essere calcolata sulla base delle tabelle della statistica T per i valori p disponibili al pubblico e dei gradi di libertà.

- Esegui la Sezione 4 per ogni confronto di gruppo di interesse. Il codice dovrebbe produrre una mappa statistica di confronto di gruppo, come mostrato nel pannello di destra della Figura 4. Regolare l'intervallo di cassi, e quindi i limiti della barra dei colori, come desiderato per la visualizzazione.

Risultati

Per dimostrare il potenziale di questa pipeline di analisi, sono stati acquisiti video comportamentali di topi femmine con testa fissata, in particolare madri e vergini, mentre ai topi venivano presentati stimoli uditivi durante le scansioni di risonanza magnetica funzionale (fMRI). Gli stimoli consistevano in richiami di cuccioli e toni puri presentati passivamente, quindi senza alcun output comportamentale istruito. I richiami dei cuccioli erano registrazioni di vocalizzazioni ultrasoniche emesse da cuccioli di topo di 6 giorni temporaneamente isolati dal loro nido. Questi richiami dei cuccioli in genere suscitano l'atto materno del recupero dei cuccioli, in cui la madre localizza, si muove verso, indaga, quindi prende in braccio il cucciolo e lo riporta al sicuro nel nido - un comportamento che le femmine vergini in genere non esibiscono11. Lavori precedenti hanno dimostrato che i richiami dei cuccioli suscitano una robusta attività evocata nella corteccia uditiva primaria delle madri ma non delle vergini, mentre le risposte toniche pure non mostrano differenze di gruppo12. Pertanto, è stato ipotizzato che sarebbero state identificate differenze di gruppo nelle risposte comportamentali ai richiami dei cuccioli, ma non toni puri. Tuttavia, c'è poca letteratura sui comportamenti specifici dei topi femmina in risposta ai segnali dei cuccioli in un ambiente con la testa fissa. Pertanto, non ci si aspettava alcun output comportamentale specifico, rendendo questo esperimento il test perfetto per le analisi comportamentali basate sui dati proposte.

Nel corso di otto giorni, tutti gli animali si sono gradualmente abituati alla manipolazione dello sperimentatore, alla fissazione della testa e all'ambiente di risonanza magnetica. L'abitudine alla fissazione della testa e all'ambiente sperimentale è fondamentale per valutare le risposte comportamentali agli stimoli presentati. Se non adeguatamente abituati all'ambiente, gli animali possono solo mostrare risposte allo stress, eliminando eventuali effetti guidati dallo stimolo che potrebbero altrimenti essere analizzati tramite videografia.

Sebbene la configurazione dell'apparato comportamentale fosse generalmente la stessa per ogni sessione di acquisizione dati, è possibile che il campo visivo della telecamera (FOV) si spostasse leggermente ogni volta che un animale veniva fissato alla testa per le scansioni fMRI (vedere i FOV di esempio nella Figura 1A). Ciò era probabilmente dovuto a lievi cambiamenti nel posizionamento del supporto della fotocamera, nonché a variazioni individuali nell'attacco del cranio del palo della testa per ogni animale. Pertanto, i video delle scansioni dovevano essere allineati tra loro tramite la coregistrazione lineare per consentire il confronto delle informazioni spaziali che contenevano tra le scansioni e gli animali. La coregistrazione è stata adattata ai dati rappresentativi. Ad esempio, in un giorno di scansione standard, sono state acquisite 3-4 scansioni per animale, ottenendo 3-4 video per animale al giorno. Tra una scansione e l'altra, non c'è stato alcun movimento dei componenti della culla, compresi i componenti della fotocamera e del fissaggio della testa. Pertanto, una volta determinata la trasformazione di coregistrazione per un video per animale al giorno, potrebbe essere applicata agli altri 2-3 video di quell'animale nello stesso giorno. Se da un lato questo ha permesso di risparmiare tempo nella fase di coregistrazione di questa pipeline, dall'altro le trasformazioni spaziali possono essere calcolate individualmente per ogni video, se necessario. Tre caratteristiche presenti in ogni video sono state scelte come punti per l'etichettatura e il calcolo della trasformazione spaziale. Nei dati rappresentativi mostrati, questi tre punti erano il centro del palo della testa, la vista frontale dell'occhio destro dell'animale e la vista di profilo dell'occhio destro dell'animale (visibile in uno specchio posto con un angolo di 45 gradi). Esempi di coregistrazione video sono illustrati nella Figura 1A, B, che mostra il fotogramma medio calcolato da tutti i video ripresi durante questo esperimento, sia prima che dopo la coregistrazione, per dimostrare l'effetto di questo passaggio.

Questa pipeline si basa molto sul flusso ottico, un metodo di visione artificiale utilizzato per stimare il movimento degli oggetti in un video stimando le loro velocità apparenti tra fotogrammi consecutivi13. Il flusso ottico è stato scelto perché consente la quantificazione del movimento – un proxy delle risposte comportamentali – senza parti del corpo predeterminate o azioni di interesse. Inoltre, questo metodo era suscettibile della limitata qualità dell'immagine dei video rappresentativi, che sono stati acquisiti con l'unica fotocamera compatibile con la risonanza magnetica accessibile al momento dell'esperimento. In questa pipeline viene utilizzato l'algoritmo di Horn-Schunck per la stima del flusso ottico denso globale; tuttavia, altri algoritmi, come l'algoritmo Lucas-Kanade, possono essere facilmente impiegati con lievi modifiche agli script MATLAB forniti 14,15,16. La Figura 2A mostra un esempio di fotogramma video con vettori di velocità del flusso ottico relativi sovrapposti per ogni pixel. Si noti che i vettori più grandi appaiono nelle aree in cui ci si aspetterebbe un movimento, come il muso e le zampe dell'animale.

Mentre la pipeline ha stimato il flusso ottico per tutti i video attraverso l'intero FOV, le restanti fasi di analisi sono state rese molto più gestibili in termini di carico computazionale e esigenze di archiviazione dei dati selezionando una regione di interesse (ROI) all'interno del FOV. Il ROI può essere selezionato in base all'esperimento e ai comportamenti predeterminati di interesse o attraverso un approccio più data-driven. Dato che i dati rappresentativi non includevano alcun output comportamentale specifico da tracciare a priori, è stato perseguito un approccio basato sui dati. La deviazione standard dell'ampiezza del flusso ottico è stata calcolata su tutti i video per ogni pixel, come visualizzato nella Figura 2B. Le aree con la più alta deviazione standard includevano i contorni dell'animale, come intorno all'occhio e al muso, che infondono fiducia nel fatto che le fluttuazioni del flusso ottico osservate fossero guidate dal movimento dell'animale e non dal rumore nei video. Le aree di deviazione standard inferiore includevano i contorni della base, che potevano essere il risultato di piccole vibrazioni nella fotocamera e nella base che si verificavano durante la scansione. L'ambiente della risonanza magnetica è inevitabilmente inondato di vibrazioni durante l'acquisizione dei dati a causa della commutazione dei gradienti, che possono manifestarsi nelle fluttuazioni del flusso ottico osservate nei componenti riflettenti della culla. Fortunatamente, queste vibrazioni sono costanti durante l'acquisizione dei dati, quindi indipendenti dalla condizione dello stimolo e non si prevede che influenzino i risultati dell'analisi comportamentale. Deviazioni standard del flusso ottico particolarmente accentuate sono state osservate nei pixel dello specchio, corrispondenti alla vista di profilo del muso dell'animale, che hanno guidato la selezione del ROI per i dati rappresentativi. Questa era anche una regione in cui ci si poteva aspettare risposte comportamentali, come sbattere e annusare, come parte del tipico repertorio comportamentale delle femmine di topo alla ricerca di un cucciolo isolato che emetteva richiami di cuccioli17.

Dopo aver scelto un ROI ed estratto l'ampiezza media del flusso ottico per fotogrammi per tutti i video, il flusso ottico durante le epoche di interesse può essere confrontato tra gruppi e condizioni. Si noti che i primi 20 secondi del vettore di flusso ottico di ciascun video sono stati mascherati per la stabilizzazione della luminosità; Tuttavia, questo può essere regolato per soddisfare le esigenze sperimentali. Per ogni video, il vettore del flusso ottico per fotogramma per il ROI scelto è stato valutato con Z, quindi, a seguito di un precedente lavoro sulla classificazione delle espressioni facciali, è stato filtrato passa-basso a 5 hertz (Hz) per tenere conto del framerate di 30 Hz della telecamera più veloce di qualsiasi fluttuazione comportamentale prevista2. Infine, i vettori con punteggio Z e filtrati sono stati suddivisi in epoche di presentazione dello stimolo per valutare l'effetto della presentazione dello stimolo sul flusso ottico. Per ogni epoca, il segnale basale medio pre-stimolo è stato sottratto per normalizzare il flusso ottico al periodo pre-stimolo. La Figura 3A mostra una serie temporale del flusso ottico esemplare per due video, una madre e una vergine, con dati di gruppo riepilogativi nella Figura 3B-E. La Figura 3B e la Figura 3D mostrano il flusso ottico cumulativo nel tempo durante la presentazione dello stimolo rispetto al basale, mentre la Figura 3C e la Figura 3E riassumono il flusso ottico cumulativo 2,5 s dopo l'inizio dello stimolo. Il flusso ottico cumulativo è stato calcolato per catturare il movimento complessivo nel tempo senza presumere che le risposte comportamentali spontanee si verifichino in modo bloccato nel tempo. Nel complesso, questi risultati rappresentativi dimostrano che i richiami dei cuccioli, ma non i toni puri, evocano risposte comportamentali significativamente diverse dai topi femmina materni rispetto a quelli vergini, come previsto (test U di Mann-Whitney tra i gruppi: richiami dei cuccioli: p = 0,026; toni puri: p = 0,093). Tuttavia, questo effetto di stimolo non è sopravvissuto a un'ANOVA a 2 vie, mentre l'effetto di gruppo lo ha fatto (stimolo: F(1,10) = 0,19, p = 0,67; gruppo: F(1,10) = 8,61, p = 0,015). Nel complesso, questi risultati suggeriscono che le madri hanno mostrato un movimento evocato dallo stimolo più elevato rispetto alle vergini, con la risposta materna ai richiami dei cuccioli più consistente rispetto ai toni puri. Ciò può riflettere un'accresciuta attenzione o stress nelle madri, nonché la rilevanza comportamentale dei richiami dei cuccioli, che, a differenza dei toni puri, evocano la risposta del recupero dei cuccioli nelle madri in contesti naturalistici. Nel loro insieme, questi risultati rappresentativi suggeriscono che la stima del flusso ottico durante la presentazione di uno stimolo esterno può estrarre informazioni riguardanti risposte comportamentali spontanee e sfumate.

Infine, è stata condotta un'analisi più esplorativa per scoprire le caratteristiche spaziali del comportamento catturato nei dati rappresentativi. Per indagare quali pixel nel ROI fluttuavano in modo coordinato durante la presentazione dello stimolo, è stata condotta l'analisi delle componenti principali (PCA) sulle informazioni del flusso ottico spaziale nel tempo. Questa analisi ha rivelato i pixel che hanno contribuito maggiormente al primo PC, nonché i pixel che mostravano differenze di gruppo per ciascuna condizione di stimolo, come illustrato nella Figura 4. I pannelli più a destra della Figura 4A, B suggeriscono che le madri hanno mostrato più movimento nel naso rispetto alle vergini durante la presentazione di entrambi i tipi di stimolo. Tra i due gruppi e le due condizioni di stimolo, il primo PC ha spiegato il 5,41% ± lo 0,59% della varianza totale nell'analisi del flusso ottico. Mentre il ROI dello specchio è stato mantenuto per questa parte della nostra analisi, le analisi future potrebbero espandersi a una porzione più ampia del FOV per caratterizzare i movimenti coordinati oltre il viso in risposta agli stimoli. Ad esempio, il confronto del movimento delle zampe può rivelare differenze di gruppo più significative, dato che i richiami dei cuccioli in genere avviano il recupero dei cuccioli nelle madri ma non nelle vergini e che le zampe potrebbero muoversi più liberamente della testa dell'animale.

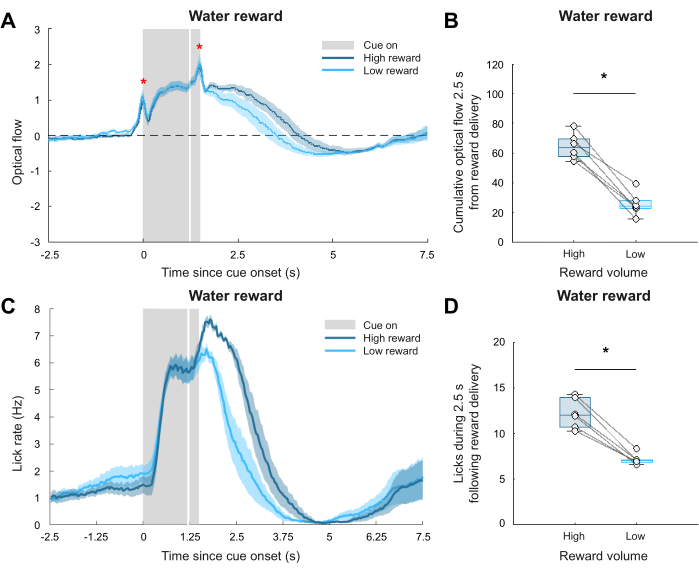

Mentre i risultati rappresentativi finora suggerivano che questa pipeline può valutare le risposte comportamentali non istruite a stimoli esterni in ambienti di videografia vincolati, rimaneva la domanda se le fluttuazioni osservate nel flusso ottico riflettessero veramente il comportamento animale significativo. Per rispondere a questa domanda, è stato analizzato un set di dati di convalida separato utilizzando la stessa pipeline. In un esperimento separato, i topi maschi con restrizione idrica sono stati addestrati ad associare un segnale leggero con l'erogazione di una ricompensa di acqua di 6 μL ("alta ricompensa") o 1 μL ("bassa ricompensa"). In particolare, a differenza dell'esperimento di stimolazione uditiva, questo esperimento aveva una lettura comportamentale a priori : la velocità di leccamento. È stato stabilito un leccometro tramite il rilevamento video delle leccate, facilitato dall'analisi della luminosità dei pixel vicino al beccuccio dell'acqua. La lettura comportamentale fornita dal leccometro potrebbe quindi essere utilizzata per confrontare la lettura comportamentale di questa pipeline fornita dalla stima ottica del flusso, supportando la sua validità nel rilevare comportamenti spontanei. Dopo la coregistrazione video, la stima del flusso ottico, la selezione del ROI (ancora una volta contenente il FOV dello specchio) e la quantificazione del flusso ottico, il confronto dell'ampiezza del flusso ottico ha rivelato una differenza significativa tra le risposte comportamentali ad alte e basse ricompense. I risultati di questa analisi sono mostrati nella Figura 5A, B, dove la Figura 5A mostra la serie temporale media del gruppo e la Figura 5B riassume il flusso ottico cumulativo 2,5 s dopo l'insorgenza dello stimolo (test del rango di Wilcoxon accoppiato tra le condizioni: p = 0,031). Si noti che i valori del flusso ottico erano maggiori rispetto al comportamento spontaneo registrato nei dati rappresentativi, sottolineando ulteriormente la sfida di valutare risposte comportamentali non istruite e sfumate. La Figura 5C mostra l'effettivo tasso di leccamento registrato dal leccometro per ciascuna delle due condizioni di ricompensa, mentre la Figura 5D mostra che durante la condizione di alta ricompensa vengono registrati più lick rispetto alla condizione di bassa ricompensa entro 2,5 s dalla consegna della ricompensa (test del rango di Wilcoxon accoppiato tra le condizioni: p = 0,031). Nel complesso, entrambe le analisi hanno rivelato una tendenza simile nel confronto tra risposte ad alta e bassa ricompensa, convalidando la pipeline di analisi video presentata per catturare differenze significative nel comportamento animale in tutte le condizioni.

Nel loro insieme, i risultati rappresentativi mostrati qui suggeriscono che la presentazione dei richiami dei cuccioli ha evocato risposte significativamente diverse nei topi femmine materne rispetto a quelli vergini, mentre i toni puri non lo hanno fatto. L'analisi di un set di dati di convalida conferisce la certezza che le differenze osservate nel flusso ottico riflettano differenze significative nelle risposte comportamentali agli stimoli esterni.

Figura 1: Coregistrazione video. (A) Esempi di coregistrazione video raffiguranti caratteristiche predeterminate (centro del montante della testa, vista frontale dell'occhio destro, vista di profilo dell'occhio destro) etichettate in tre fotogrammi, ciascuno preso da video diversi di animali diversi. Si noti nell'overlay come i tre punti non fossero allineati, dimostrando come l'impostazione comportamentale sia leggermente cambiata tra le sessioni di acquisizione dati. (B) Il fotogramma medio degli ultimi 10 secondi di ciascun video prima (a sinistra) e dopo (a destra) l'esecuzione della coregistrazione video. Clicca qui per visualizzare una versione più grande di questa figura.

Figura 2: Stima del flusso ottico. (A) Esempio di frame con relativi vettori di flusso ottico sovrapposti in blu. (B) La deviazione standard media del flusso ottico in pixel per tutti i video. Il ROI scelto intorno alla vista di profilo del muso dell'animale attraverso lo specchio è delineato in magenta. La barra dei colori corrisponde alla deviazione standard. Clicca qui per visualizzare una versione più grande di questa figura.

Figura 3: Visualizzazione e confronto del flusso ottico tra gruppi e condizioni. (A) Serie temporali esemplificative del flusso ottico filtrate con punteggio Z e 5 Hz filtrate per un video di una madre e un video di una vergine. (B) e (D) Flusso ottico cumulativo misurato durante il periodo di stimolo dei richiami dei cuccioli (B) e dei toni puri (D). L'ombreggiatura rappresenta l'errore standard della media (SEM). (C) e (E) Flusso ottico cumulativo durante i primi 2,5 secondi di presentazione dello stimolo per i richiami dei cuccioli (C) e i toni puri (E). * Indica p < 0,05, test U di Mann-Whitney tra i gruppi (chiamate pup: p = 0,026; toni puri: p = 0,093), N = 6 per gruppo. Clicca qui per visualizzare una versione più grande di questa figura.

Figura 4: Confronto tra PC1 tra gruppi. (A,B) Mappe che descrivono i carichi della prima componente principale (PC1) del flusso ottico durante i richiami pup (A) e i toni puri (B) tra i gruppi, con soglia statistica a p < 0,05 senza correzione per confronti multipli. La mappa termica indica il grado in cui la fluttuazione del flusso ottico di ciascun pixel ha contribuito al PC1, rispetto agli altri pixel. Il piccolo testo nero indica la percentuale di varianza spiegata dal PC1 (i richiami dei cuccioli delle madri: 4,95% ± 0,72%; i richiami dei cuccioli vergini: 4,44% ± 0,59%; i toni puri delle madri: 4,95% ± 0,39%; i toni puri delle vergini: 4,72% ± 1,24% (deviazione standard media ±)). Clicca qui per visualizzare una versione più grande di questa figura.

Figura 5: Convalida della pipeline di analisi comportamentale. (A) Serie temporale media del flusso ottico con punteggio Z, sottrazione della linea di base pre-stimolo e serie temporali filtrate passa-basso a 5 Hz durante l'erogazione di ricompense alte e basse. L'ombreggiatura rappresenta il SEM, la linea verticale bianca indica la consegna della ricompensa e gli asterischi rossi indicano artefatti temporanei del flusso ottico dovuti all'inizio e all'offset del segnale luminoso. (B) Riepilogo del flusso ottico cumulativo durante i primi 2,5 s dopo la consegna della ricompensa. * Indica p < 0,05, test di rango con segno di Wilcoxon accoppiato tra le condizioni (p = 0,031). (C) Tasso medio di leccamento, ottenuto dal lickometro, durante la consegna di ricompense alte e basse. L'ombreggiatura rappresenta il SEM e la linea verticale bianca indica la consegna della ricompensa. (D) Numero di lick registrati durante i primi 2,5 s dopo la consegna della ricompensa. * Indica p < 0,05, test di rango con segno di Wilcoxon accoppiato tra le condizioni (p = 0,031), N = 6. Clicca qui per visualizzare una versione più grande di questa figura.

Video 1: Esempio di video 1. PCR_Br011_20231015_1842_output.avi. Clicca qui per scaricare questo video.

Video 2: Esempio video 2. PCR_Br014_20231015_1722_output.avi. Clicca qui per scaricare questo video.

File supplementare 1: File di temporizzazione degli eventi per il video 1. PCR_Br011_20231015_1842_output_videoTimestamps.mat. Clicca qui per scaricare questo file.

File supplementare 2: File di temporizzazione degli eventi per il video 2. PCR_Br014_20231015_1722_output_videoTimestamps.mat. Clicca qui per scaricare questo file.

File di codifica supplementare 1: script1_videocoreg.m. Questo script allinea spazialmente tutti i video tra loro tramite la coregistrazione. Clicca qui per scaricare questo file.

File di codifica supplementare 2: script2_optflow_roiselect.m. Questo script stima il flusso ottico per l'intero FOV di ogni video trasformato e consente la selezione di un ROI per il resto della pipeline. Clicca qui per scaricare questo file.

File di codifica supplementare 3: script3_optflow_analysis.m. Questo script confronta l'ampiezza del flusso ottico tra diversi gruppi/condizioni per il ROI scelto. Clicca qui per scaricare questo file.

File di codifica supplementare 4: script4_optflow_pca.m. Questo script esegue la PCA sul flusso ottico stimato del ROI scelto. Clicca qui per scaricare questo file.

File di codifica supplementare 5: script5_optflow_pca_analysis.m. Questo script confronta i risultati PCA tra gruppi/condizioni per il ROI scelto. Clicca qui per scaricare questo file.

Discussione

La pipeline di analisi comportamentale presentata consente l'estrazione di informazioni preziose da video di animali che mostrano comportamenti non istruiti in risposta a stimoli presentati passivamente. Questi video comportamentali rappresentativi sono stati acquisiti in combinazione con i dati di risonanza magnetica funzionale (fMRI) dell'intero cervello, per i quali sono stati superati molteplici vincoli per catturare le risposte comportamentali nell'ambiente MRI. Utilizzando il metodo della stima del flusso ottico, sono state rivelate differenze nel modo in cui le madri rispetto alle vergini rispondono ai richiami dei cuccioli, ma non ai toni puri, supportando l'ipotesi iniziale 13,14,15,16. Sfruttando la riduzione della dimensionalità delle informazioni del flusso ottico, questo risultato è stato esteso a un'analisi esplorativa della distribuzione spaziale di questi comportamenti.

Questa pipeline di analisi è ampiamente suscettibile di vari paradigmi sperimentali. È completamente indipendente dal tipo di dati neurali acquisiti e non richiede un'eccessiva potenza di calcolo o apparecchiature specializzate. Il principale requisito sperimentale è che i dati della videografia siano registrati con i relativi timestamp degli inizi della presentazione dello stimolo. Inoltre, fornendo gli script MATLAB utilizzati per eseguire le analisi dimostrate, l'implementazione di questa pipeline dovrebbe essere abbastanza semplice, anche per coloro che hanno un'esperienza minima in MATLAB. Le fasi generali, come descritto nel protocollo, consistono nella coregistrazione video, nella stima del flusso ottico, nella selezione della regione di interesse (ROI), nella quantificazione del flusso ottico specifico per il ROI, nel confronto dell'ampiezza del flusso ottico, nell'analisi dei componenti principali (PCA) e nel confronto PCA. In ogni fase, la pipeline può essere modificata per adattarsi alle esigenze sperimentali e analitiche, come indicato nel protocollo ed evidenziato con commenti in tutto il codice.

Ci sono diverse limitazioni da tenere a mente quando si utilizza la pipeline di analisi video presentata. In primo luogo, la progettazione dell'apparato comportamentale dovrebbe essere attentamente considerata. Se non è chiaro quali risposte comportamentali ci si può aspettare, potrebbe essere utile per le analisi future avere il maggior numero possibile di punti di vista sull'animale. Pertanto, si consiglia di installare uno o più specchi per catturare contemporaneamente le viste frontali e di profilo dell'animale, come mostrato nei fotogrammi video di esempio nella Figura 1A. In secondo luogo, si raccomanda che l'illuminazione fornita per l'acquisizione video sia sufficientemente luminosa da vedere tutte le caratteristiche rilevanti del campo visivo (FOV), ma non così luminosa da raggiungere la saturazione. Nella Figura 1A, si può osservare che la vista frontale del naso del topo si trova in un punto di quasi saturazione, rendendo difficile catturare eventuali fluttuazioni di luminosità che indicherebbero un movimento. Ciò potrebbe aver contribuito alla mancanza di variazione del flusso ottico osservata in questa parte del FOV, come mostrato nella Figura 2B. Fortunatamente, la vista di profilo del muso non ha riscontrato questo problema, consentendo l'analisi del ROI dello specchio. Inoltre, la possibilità di saturazione dovrebbe essere considerata se nell'esperimento sono coinvolti stimoli visivi. Nell'esperimento del set di dati di convalida, un segnale luminoso utilizzato per segnalare l'erogazione di una ricompensa in acqua ha introdotto una saturazione temporanea nei video acquisiti, ponendo un artefatto temporaneo nella stima del flusso ottico. Questo artefatto può essere osservato nella Figura 5A, dove i due picchi acuti nelle tracce del flusso ottico per entrambe le condizioni di ricompensa si allineano esattamente con il momento in cui il segnale luminoso è stato acceso e spento. Questo artefatto ha reso difficile l'analisi di queste brevi finestre temporali con la pipeline presentata e, se non fosse stato presente, i risultati presentati nella Figura 5B avrebbero potuto essere ancora più significativi. L'illuminazione costante della scena è un presupposto necessario per la maggior parte degli algoritmi di flusso ottico14,16. Pertanto, questa pipeline di analisi video non è consigliata per esperimenti in cui l'illuminazione dell'ambiente cambia drasticamente, sia all'interno che tra le prove. Terzo e ultimo, l'assuefazione sufficiente degli animali all'ambiente di registrazione è una componente chiave di qualsiasi esperimento che trarrà vantaggio da questa pipeline. Se non adeguatamente abituati, gli animali possono mostrare risposte significative allo stress, eliminando eventuali effetti sottili guidati dallo stimolo che potrebbero altrimenti essere analizzati tramite analisi video.

In futuro, questa pipeline di analisi comportamentale può essere impiegata per facilitare la valutazione coordinata delle risposte comportamentali e neurali registrate simultaneamente. Come mostrato, la valutazione quantitativa dei comportamenti non istruiti consente di valutare la salienza degli stimoli in un ambiente di registrazione complesso, nonché di testare le diverse risposte comportamentali tra gruppi e condizioni sperimentali. Ulteriori analisi possono essere condotte per esplorare le differenze individuali o le tendenze prova per prova nelle risposte comportamentali in modo da poter esaminare l'attività neurale corrispondente. Inoltre, l'incorporazione della PCA per ottenere informazioni spaziali sul movimento evocato dallo stimolo può essere utilizzata per indagare ulteriormente se tipi specifici di sequenze comportamentali osservate durante la presentazione dello stimolo differiscono tra gruppi e condizioni. Questa pipeline di analisi può essere facilmente estesa a vari metodi di registrazione neurale, fornendo un monitoraggio comportamentale versatile in ambienti limitati. Studiando come gli stimoli esterni sono rappresentati sia nel cervello che nel comportamento, i ricercatori sono pronti a ottenere una comprensione più completa di come la percezione degli stimoli influenzi gli stati interni e le loro manifestazioni esterne.

Divulgazioni

Gli autori non hanno nulla da rivelare.

Riconoscimenti

Vorremmo ringraziare i laboratori Marlin e Kahn per aver sostenuto questa ricerca. Vorremmo anche ringraziare il Dr. Kevin Cury per la sua approfondita discussione sui nostri dati di videografia. La ricerca riportata in questa pubblicazione è stata supportata dall'Eunice Kennedy Shriver National Institute Of Child Health & Human Development del National Institutes of Health con il numero di premio F31HD114466 (BRM), dall'Howard Hughes Medical Institute (BJM), dall'UNCF E.E. Just Fellowship CU20-1071 (BJM), il BBRF NARSAD Young Investigator Grant 30380 (BJM) e la Whitehall Foundation (BJM). Il contenuto è di esclusiva responsabilità degli autori e non rappresenta necessariamente le opinioni ufficiali del National Institutes of Health.

Materiali

| Name | Company | Catalog Number | Comments |

| MATLAB Computer Vision Toolbox | MathWorks | https://www.mathworks.com/products/computer-vision.html | |

| MATLAB Image Processing Toolbox | MathWorks | https://www.mathworks.com/products/image-processing.html | |

| MATLAB software | MathWorks | https://www.mathworks.com/products/matlab.html | |

| MR-compatible camera “12M-i” with integrated LED light | MRC Systems GmbH | 12M-i | https://www.mrc-systems.de/downloads/en/mri-compatible-cameras/manual_mrcam_12m-i.pdf |

Riferimenti

- Musall, S., Kaufman, M. T., Juavinett, A. L., Gluf, S., Churchland, A. K. Single-trial neural dynamics are dominated by richly varied movements. Nat Neurosci. 22 (10), 1677-1686 (2019).

- Dolensek, N., Gehrlach, D. A., Klein, A. S., Gogolla, N. Facial expressions of emotion states and their neuronal correlates in mice. Science. 368 (6486), 89-94 (2020).

- Kepecs, A., Uchida, N., Mainen, Z. F. The sniff as a unit of olfactory processing. Chemical Senses. 31 (2), 167-179 (2006).

- Shusterman, R., Smear, M. C., Koulakov, A. A., Rinberg, D. Precise olfactory responses tile the sniff cycle. Nat Neurosci. 14 (8), 1039-1044 (2011).

- Han, Z., et al. Awake and behaving mouse fMRI during Go/No-Go task. NeuroImage. 188, 733-742 (2019).

- Mathis, A., Mamidanna, P., Cury, K. M. DeepLabCut: Markerless pose estimation of user-defined body parts with deep learning. Nature Neurosci. 21 (9), 1281-1289 (2018).

- Krakauer, J. W., Ghazanfar, A. A., Gomez-Marin, A., MacIver, M. A., Poeppel, D. Neuroscience needs behavior: Correcting a reductionist bias. Neuron. 93 (3), 480-490 (2017).

- Wiltschko, A. B., Tsukahara, T., Zeine, A. Revealing the structure of pharmacobehavioral space through motion sequencing. Nat Neurosci. 23 (11), 1433-1443 (2020).

- Moëne, O. L., Larsson, M. A new tool for quantifying mouse facial expressions. eNeuro. 10 (2), (2023).

- Paasonen, J., Stenroos, P., Laakso, H. Whole-brain studies of spontaneous behavior in head-fixed rats enabled by zero echo time MB-SWIFT fMRI. NeuroImage. 250, 118924 (2022).

- Ehret, G. Infant rodent ultrasounds: A Gate to the understanding of sound communication. Behav Genet. 35 (1), 19-29 (2005).

- Marlin, B. J., Mitre, M., D'amour, J. A., Chao, M. V., Froemke, R. C. Oxytocin enables maternal behavior by balancing cortical inhibition. Nature. 520 (7548), 499-504 (2015).

- . Optical Flow Available from: https://www.mathworks.com/discovery/optical-flow.html (2024)

- Horn, B. K. P., Schunck, B. G. Determining optical flow. Artif Intell. 17 (1), 185-203 (1981).

- Szeliski, R., Szeliski, R. Dense motion estimation. Computer Vision: Algorithms and Applications. , 335-374 (2011).

- Beauchemin, S. S., Barron, J. L. The computation of optical flow. ACM Comput Surv. 27 (3), 433-466 (1995).

- McRae, B. R., Andreu, V., Marlin, B. J. Integration of olfactory and auditory cues eliciting parental behavior. J Neuroendocrin. 35 (7), e13307 (2023).

Ristampe e Autorizzazioni

Richiedi autorizzazione per utilizzare il testo o le figure di questo articolo JoVE

Richiedi AutorizzazioneEsplora altri articoli

This article has been published

Video Coming Soon