Method Article

高解像度の表面筋電図とコンピュータービジョンによるダイナミックな指のジェスチャーのキャプチャ

要約

この論文では、自然な指のジェスチャー中に手筋電図検査(EMG)と視覚的な指の追跡を同時に記録するための包括的なプロトコルを提示しています。視覚データは、指のジェスチャー認識のための正確なEMGベースの計算モデルを開発するためのグラウンドトゥルースとして機能するように設計されています。

要約

指のジェスチャーは人間のコミュニケーションにおいて重要な要素であり、そのため、指のジェスチャー認識は、最先端の義肢装具と最適化されたリハビリテーションのためのヒューマンコンピューターインターフェースとして広く研究されています。表面筋電図法(sEMG)は、深層学習法と併用することで、この分野で有望な方法と考えられています。しかし、現在の方法では、煩雑な録音設定や手の静止位置の特定に頼ることが多く、実際のアプリケーションでの効果は限られています。ここで報告するプロトコルは、ウェアラブル表面EMGと指追跡システムを組み合わせた高度なアプローチを示しており、動的な手の動き中に包括的なデータを取得します。この方法は、被験者がさまざまな手の位置や動きの中でジェスチャーを行う際に、前腕に配置されたソフトプリント電極アレイ(16個の電極)から筋肉活動を記録します。視覚的な指示により、被験者は特定のジェスチャーを実行するように促され、EMGと指の位置が記録されます。同期したEMG記録とフィンガートラッキングデータの統合により、筋肉活動パターンとそれに対応するジェスチャーを包括的に分析することができます。報告されたアプローチは、EMGと視覚追跡技術を組み合わせることを、補綴、リハビリテーション、およびインタラクティブ技術への応用を備えた直感的で応答性の高いジェスチャー認識システムを開発するための重要なリソースとしての可能性を示しています。このプロトコルは、研究者や実務家を指導し、動的で実世界のシナリオでのジェスチャー認識のさらなる革新と応用を促進することを目的としています。

概要

手のジェスチャーは人間のコミュニケーションに不可欠であり、指のジェスチャーの認識は、人間とコンピューターの相互作用、高度な義肢1,2,3,4、リハビリテーション技術5,6などの分野にわたる研究の重要な領域となっています。その結果、指のジェスチャー認識は、直感的な制御システムや支援デバイスを強化する可能性として大きな注目を集めています。深層学習アルゴリズムと組み合わせた表面筋電図(sEMG)は、手の動きに関連する筋肉の電気的活動を検出する能力があるため、これらのジェスチャーをキャプチャおよび解釈するための非常に有望なアプローチとして浮上しています7、8、9、10、11、12、13、14、15。

しかし、これらの進歩にもかかわらず、現在のアプローチは実際のアプリケーションでは限界に直面しています。既存のシステムのほとんどは、多数の電極5,7,9,16,17と正確な位置決め3,18を備えた複雑で面倒な録音セットアップを必要としますが、これらは制御された環境以外では実装が困難な場合が多いです。さらに、これらのシステムは、静的な手の位置13、18、19、20、21に焦点を当てる傾向があり、日常の活動で発生する動的で流動的なジェスチャーを解釈する能力を制限します。このプロトコルは、より自然な条件で動的なジェスチャ認識をサポートすることで、これらの制限に対処することを目的としています。このような方法論により、補綴物やリハビリテーションなど、リアルタイムの自然なジェスチャー解釈が不可欠な分野で、より実用的でユーザーフレンドリーなアプリケーションが可能になります。

これらの課題に対処するには、より正確で適応性の高いアルゴリズムを開発するには、自然な日常の状況を反映したデータセットが必要です3,4。このようなデータセットでは、モデルの堅牢性を確保するために、さまざまな動的な動き、さまざまな手の位置、大量のデータをキャプチャする必要があります。さらに、トレーニングデータセットとテストデータセットのばらつきは非常に重要であり、モデルがさまざまな手の姿勢、筋肉の活性化パターン、動きを一般化できるようにします。このような多様性をデータに組み込むことで、アルゴリズムは日常の実世界のアプリケーション22でより正確にジェスチャー認識を実行することができるようになる。

これらの課題を克服することは、より実用的で広く適用可能なジェスチャー認識システムの将来の開発に不可欠です。ここで説明する研究とプロトコルは、自然な環境でダイナミックな手の動きをキャプチャできるポータブルでユーザーフレンドリーなセットアップを持つ必要性に起因しています。包括的なデータセットと高度なアルゴリズムは、ヒューマンコンピュータインターフェース、神経補綴、リハビリテーション技術におけるsEMGとディープラーニングの可能性を完全に解き放つために重要です。このプロトコルは、包括的なデータ収集を促進し、多様なハンドポジションに一般化するアルゴリズムモデルの開発をさらに可能にすることで、この分野に貢献することを期待しています。

ジェスチャー認識における大きな課題は、手の位置に対するsEMG信号の感度にあります。多くの研究はジェスチャ予測のための固定された手の位置に焦点を当てていますが、実際のアプリケーションでは、さまざまな手の姿勢で指の動きを認識できるモデルが必要です。最近のアプローチでは、コンピュータビジョンをグラウンドトゥルースの参照として組み込むことでこれに対処し、これらのモデルの精度と柔軟性を向上させています15,19。さらに、sEMG信号を視覚データと統合するハイブリッドモデルは、多様なシナリオで認識精度をさらに向上させる23。

このプロトコルでは、EMGデータとハンドトラッキングデータの両方を実世界のような条件に組み込むことにより、動的ジェスチャー認識を強化するデータ収集への同期アプローチを紹介します。ジェスチャのパフォーマンスを静的な位置に制限する従来の方法とは異なり、このプロトコルには、ハンドダウン、ハンドアップ、ハンドストレート、ハンドムーブの4つの異なる位置で実行されるジェスチャが含まれています。ハンドトラッキングカメラは、3次元のインタラクティブゾーン内で手の動きを追跡し、明確な手の要素を識別し、ダイナミックな動きを高解像度でキャプチャします。筋肉活動を記録するために前腕に配置された16個の電極のソフト電極アレイは、参加者の可動性を妨げることなく安定したワイヤレス記録を提供します。これら 2 つのソースから同期されたデータは、実際の条件で動作可能な高度なジェスチャ認識アルゴリズムを開発するための包括的な基盤を提供します。このアプローチは、現実的なシナリオでの自由な動きと安定した信号記録を容易にすることにより、現在のセットアップの制限に特に対処します。この進歩は、直感的な制御と柔軟性が不可欠な義肢装具、リハビリテーション、インタラクティブ技術のアプリケーション向けのジェスチャー認識技術をサポートします。

プロトコル

健康な参加者 (n = 18、18 歳から 32 歳、男性と女性の両方) がこの研究に募集され、テルアビブ大学倫理審査委員会 (承認番号 0004877-3) によって承認されました。このプロトコルは、人間の参加者が関与する研究に関する委員会のガイドラインに準拠しています。インフォームドコンセントは、機関の要件に従ってすべての参加者から得られました。

1. 実験者ブリーフィング

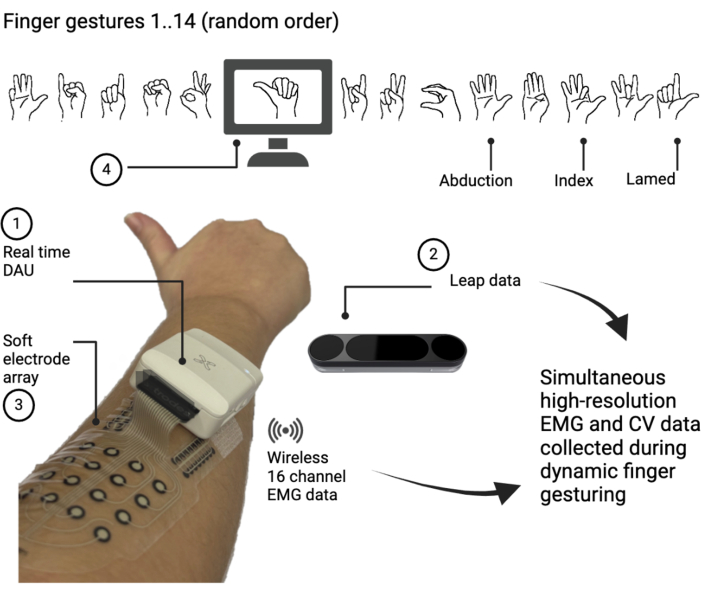

- 参加者に一連の 14 の異なる指のジェスチャー ( 図 1 を参照) を実行し、各ジェスチャーをランダムな順序で 7 回繰り返すように依頼します。各ジェスチャーを5秒間しっかりと維持し、その後3秒間の休憩時間を設けるように依頼します。各セッションの合計時間は13:04分です。

- コンピュータ画面に表示されるジェスチャの大きな画像には、ジェスチャのパフォーマンスを示すカウントダウンタイマーが付随しています。休憩時間中に、参加者に、残りの休憩時間を示すタイマーと一緒に、次のジェスチャーの小さな画像を見てもらいます。2つの異なるビープ音が各ジェスチャーの開始と終了を通知し、参加者が次のジェスチャーの準備をするのに役立ちます。

- 各参加者に、前に提示した22と同様に、4つの異なる位置で手順を実行するように依頼します。

ポジション 1: 立っている参加者。ハンドダウン、ストレート、リラックス。

ポジション2:肘掛け椅子に座っている参加者。手を90°前方に伸ばし、手のひらをリラックスさせます(サポートデバイスを使用できます)。

ポジション3:手を上に折りたたみ(肘を肘掛け椅子に乗せて)、手のひらをリラックスさせます。

ポジション4:参加者は前のポジションのいずれかを選択し、カメラの検出範囲内で手を自由に動かすことができ、PC画面上でリアルタイムで監視されます(詳細については、ステップ1.4を参照してください)。 - 各セッションで、参加者に腕に筋電計デバイスを装着させ、ハンドトラッキングカメラを参加者に向けて配置させます。参加者に、手のひらが常にカメラの方を向いていることを確認するように依頼します。ハンドトラッキングソフトウェアは別の画面に表示されるため、参加者と指揮者の両方がハンドが正しく認識されていることを確認できます。

- 位置ごとに、ハンドトラッキングカメラの位置と角度を調整して、正確なハンド認識を確保します。さらに、スペクトログラムスクリプトを使用して電極からの信号の品質を評価します。

図1:データ収集プロセスの概略図。 被験者には、前腕 (3) に配置されたソフト電極アレイが装備されており、ジェスチャー パフォーマンス中に高解像度の表面筋電図検査 (sEMG) 信号をキャプチャします。被験者は、コンピューターのディスプレイにランダムな順序で提示された14の異なる指のジェスチャーを実行します(4)。EMGデータは、データ収集ユニット(DAU;1)からパーソナルコンピュータ(PC)にワイヤレスでストリーミングされます。同時に、指の関節角度を表すハンドキネマティックデータ(HKD)がハンドトラッキングカメラ(2)を使用してキャプチャされます。 この図の拡大版を表示するには、ここをクリックしてください。

2. データ取得ユニットのセットアップ

- https://github.com/NeuroEngLabTAU/Fingers_Gestures_Recognition.git でGithubリポジトリを開き、インストールセクションの詳細な指示に従います。プライマリ Python ファイル data_collection.py を finger_pose_estimation/data_acquisition フォルダで見つけます。これを使用して実験を実行し、スクリプト spectrogram.py を使用して実験を開始する前にEMG信号の品質を評価し、スクリプトdata_analysis.py信号フィルタリングとセグメンテーションを行います。

- 各セッションの前にEMGデータ収集ユニット(DAU)が完全に充電されていることを確認し、電源を入れます。

- 専用アプリケーションを使用して、DAUをBluetooth経由でPCに接続します。Bluetooth通信速度を500サンプル/秒(S / s)に設定します。

- ハンドトラッキングカメラのソフトウェアをPCにインストールして開きます。ハンドトラッキングカメラとPCをケーブルで接続します。

- 1つの画面で、常にハンドトラッキングカメラソフトウェアを表示します。このようにして、指揮者と参加者は、実験中にカメラが手を正しく認識することを確認できます。

3. 参加者の準備

- 導入と同意

- 研究の関連性と実験手順を参加者に簡単に説明します。人間が関与する研究に関する機関のガイドラインに従って、インフォームドコンセントを取得します。

- 電極の配置

- 参加者に、強い拳を形成して右手を曲げるように指示します。参加者が体を曲げている間に、筋肉に沿ってそっと押して前腕を触診し、筋肉の活性化が最も顕著な場所を特定します。この場所は、収縮中に筋肉が膨らむ領域を感じることで簡単に識別できます。

- オプション:アルコール繊維を含まない布、プレップジェル、または水と石鹸で洗浄して、特定された皮膚領域を準備します。その領域を風乾させます。アルコールによる過度の洗浄は、皮膚を乾燥させる可能性があるため、避けてください。この手順はオプションです。ディスカッションのセクションを参照してください。

- EMG電極アレイから白い保護層をはがし、ステップ3.2.1で決定したように、電極を特定した前腕領域に慎重に取り付けます。( 図1を参照)。粘着テープが手のひらに近づいていることを確認してください。電極アレイを軽くたたいて皮膚に固定します。

- 電極アレイが皮膚に付着したら、透明な支持層をはがします。

- 電極アレイコネクタカードをDAUのコネクタソケットに挿入します。DAUを電極の横にある粘着テープに取り付けます。

- カスタムの Python スペクトログラム スクリプト Spectrogram.py を実行して、リアルタイムの信号品質を確認します。ウィンドウが表示され、すべての電極の生データ(左側)と周波数領域(右側)が表示されます( 補足図1 を参照)。

- すべての電極が検出されて正しく機能していること、および信号が過度のノイズや50Hzのノイズからクリーンであることを確認します。

- 必要に応じて、干渉を引き起こす可能性のある電子機器から離れ、不要なデバイスを電源から抜くことで、50Hzのノイズを低減します。信号が安定するまで待ちます。

- EMG信号のキャプチャを確認する:参加者に肘を肘掛け椅子に置き、指を動かしてからリラックスするように指示します。クリアなEMG信号が表示され、その後に静的なベースラインノイズが表示されていることを確認します。

- シグナルの検証が完了したら、スクリプトを閉じます。

- ジェスチャーと手の位置の見直し

- Finger_pose_estimation > Data_acquisitionをクリックして画像フォルダを開きます。参加者と一緒にジェスチャー画像を確認します。

- 彼らが各動きを理解し、正確に実行できることを確認してください。参加者に4つの手の位置を明確に説明します。

- 各セッションの前に、適切な姿勢とポジショニングを確保しながら、参加者に手の持ち方を指導します。

- 参加者とカメラの位置

- ハンドポジション1では、テーブルから約1m離れたところにまっすぐ立つように参加者に指示します。参加者に、手のひらをハンドトラッキングカメラに向けて、右手をまっすぐリラックスさせたまま押さえるように指示します。ハンドトラッキングカメラを自撮り棒でテーブルに固定し、参加者の手を向けます。

- 手の位置2については、モニターから40〜70cm離れたアームチェアに快適に座るように参加者に指示します。リラックスした手のひらをハンドトラッキングカメラに向けて、右手を90°前方に伸ばすように参加者に指示します。必要に応じて、サポートデバイスを使用して手を安定させます。ハンドトラッキングカメラをテーブルの上に上向きに置きます。

注:参加者は一定の姿勢を保つように求められるため、セッション全体を通して維持できる快適な姿勢を見つけることが重要です。 - ハンドポジション3については、ステップ3.4.2で説明されているように参加者に座るように指示します。肘を肘掛け椅子に乗せながら、手を上に折りたたむように参加者に指示します。手のひらをリラックスさせ、参加者はハンドトラッキングカメラに向き合う必要があります。ハンドトラッキングカメラをテーブルの上に置き、参加者の手を向けます(必要に応じて自撮り棒を使用します)。参加者の位置が、画面を見るためとカメラの視野内にいるための両方に最適であることを確認してください。

- ハンドトラッキングデータを表示する画面を継続的に監視し、実験全体を通してカメラが手と指を検出するようにします。オプション:実験を開始する前に、各手の位置でEMG信号の品質を確認します(ステップ3.2.6.)。

4. データ収集

- 実験の実行

- Pythonを開き、data_collection.pyをロードします。パラメータ num_repetition、gesture_duration、rest_duration が必要に応じて設定されていることを確認します。

- num_repetition: 各ジェスチャ画像が表示される回数を定義します。この実験では、7 に設定すると、各画像が 7 回表示されます。gesture_duration: 参加者がハンドジェスチャを実行する時間(秒単位)を指定します。この実験では、5 秒に設定して、各ジェスチャ イメージが表示される時間を決定します。Rest_duration: 参加者がジェスチャーの間に手のひらをリラックスさせる時間 (秒単位) を指定します。この実験では、3 秒に設定します。

- ハンドトラッキングカメラの位置と角度を参加者の手の位置に合わせます。

- data_collection.pyスクリプトを実行します。参加者の詳細(シリアル番号、年齢、性別、セッション番号、ハンドポジション)を入力するウィンドウが表示されます。この情報を入力して [OK] を押すと、実験が自動的に開始されます。

- Pythonを開き、data_collection.pyをロードします。パラメータ num_repetition、gesture_duration、rest_duration が必要に応じて設定されていることを確認します。

- データ収集

- セッションごとに、自動的に保存されるEMGとハンドトラッキングのデータを記録します。各参加者に対して、ハンドポジションごとに1回、実験を4回繰り返します。

5. 実験終了と実験後のデータの取り扱い

- 実験が完了すると、データは自動的に保存されます。参加者がシリアル番号でラベル付けされたフォルダにデータが保存されていることを確認します。各セッションは S# という名前のサブフォルダー (S1 など) に格納され、各ハンド ポジション P# (P1、P2、P3、P4) に 4 つのサブフォルダーがあります。1 つのセッションのフォルダ サイズは約 160 MB です。

- 参加者が複数のセッションを完了する場合は、すべてのデータが対応するセッションフォルダ(S1、S2など)に保存されていることを確認してください。

- データファイル

各ハンドポジションフォルダ(P#)に次のファイルが含まれていることを確認します。EDFファイルに保存されたEMGデータ。名前は次のとおりです。fpe_pos{ポジション番号}_{サブジェクト番号}_S{セッション番号}_rep0_BT;CSV ファイルに保存されたハンドトラッキング データ、fpe_pos{位置番号}_{被験者番号}_S{セッション番号}_rep0_BT_full;セッションに関するメタデータを含むログファイル log.txt。 - データ処理

注:ユーザーは、信号解析の進め方と使用するツールを選択できます。ここでは、Pythonで信号フィルタリングとデータセグメンテーションを実行するためのスクリプトを提供します。Pythonを使用する場合は、すべての依存関係(Numpy、Pandas、SciPy、MNE、Sklearnなど)がインストールされていることを確認してください。- Pythonを開き、data_analysis.pyをロードしてスクリプトを実行します。

- コンソールにリクエストが表示され、データ処理に必要なパラメータ(EMGファイルへのパス、ハンドキネマティックデータへのパス、処理されたデータが保存されるパス、サンプリングレート(Hz)、ウィンドウ持続時間(ms)、ストライドインターバル(ms))が提供されます。

- その手順に従って、スクリプトはデータ処理を実行します。

- EMG信号フィルタリング:上記のようにスクリプトを実行します。このスクリプトでは、まず 20 Hz のカットオフを持つ 4 次バターワース ハイパス フィルターを適用して非 EMG 信号を除去し、次にノッチ フィルターを適用して 50 Hz と 100 Hz の高調波を除去して sEMG 信号をフィルター処理します。さらに、スクリプトは EMG 信号の正規化を適用します。

- EMG、HKD データ、および指示されたジェスチャ セグメンテーション: 上記のようにスクリプトを実行します。このスクリプトは、指定されたウィンドウの長さとストライド間隔によって定義されるローリング ウィンドウ手法を利用して、セグメンテーションを適用します。この実験では、それぞれ 512 ミリ秒と 2 ミリ秒に設定します。次に、スクリプトは、電極アレイのレイアウトを維持しながら、sEMGチャネル構成を4 x 4の空間グリッド構成に変換します。最後に、スクリプトはメタデータを含むディクショナリを pickle ファイルとして生成します。

- データのクリーニングと検証の手順

- アーティファクト、ノイズ、または一貫性のないジェスチャーラベルを含むセグメントを特定し、データセットから除外します。

- セグメントの完全性とウィンドウ間の時間的連続性を確保して、データの信頼性を維持します。

- ジェスチャ データを HKD と照合して一貫性を確保します。HKD セッション標準から逸脱したジェスチャ パターンを表示しているウィンドウを削除します。

- セッションで予想される運動学的パターンに適合しない外れ値セグメントを検出して破棄します。

- 高度なアルゴリズムを使用して、さらにデータ分析を実行します。これらは現在のプロトコルでは提供されていません。

結果

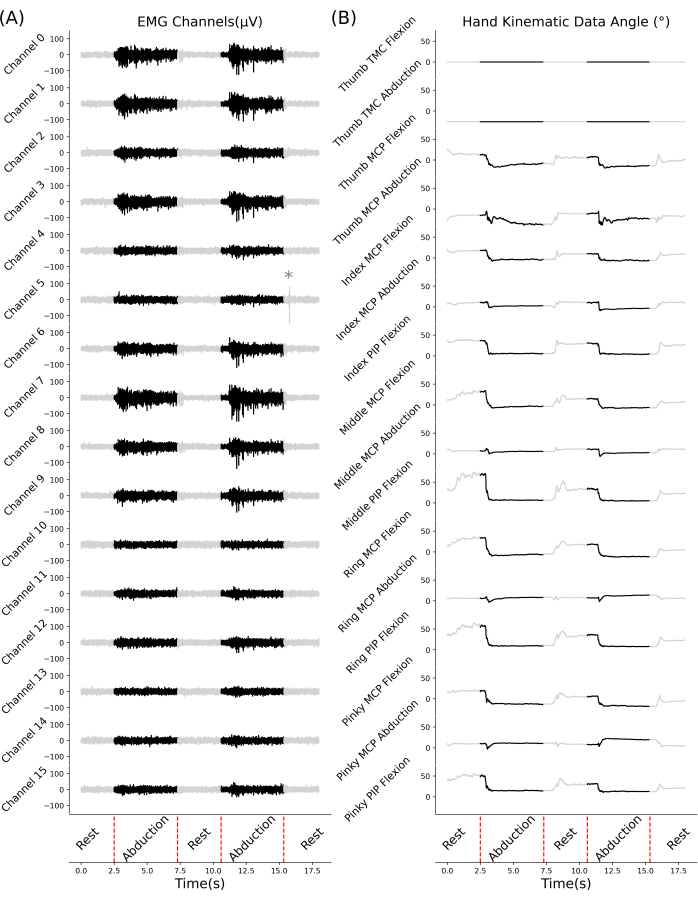

このデータセットは、16チャンネルの筋電図データセットとハンドトラッキングカメラシステムのデータの2つの時間同期コンポーネントで構成されています。16チャンネルの筋電図データは、さまざまな筋肉からの電気信号を経時的に記録することで、筋肉の活動を捉えます。ハンドトラッキングシステムは、手の骨格モデル上の重要なポイントに対応する16チャンネルのデータを提供します。モデルには手首を除いて21ポイントがありますが、モーションコンストレイント24により、この数は16ポイントに減少しました。EMGと視覚データは、同期を確立するために、記録中に同じコンピューター上で2つの別々のプロセスを実行することによって収集されました。タイムスタンプを使用して各プロセスの開始をマークし、データ分析コードで記録の終了時に筋肉活動と手の動きのデータを整列させることができました。タイムスタンプの注釈は、EDFファイルとCSVファイルの両方に自動的に保存され、特定の指のジェスチャーが指示された正確な時間をマークし、データ分析中のアライメントを容易にしました。フィルタリングされたEMG信号(20Hzの4次バターワースハイパスフィルター)は、ベースラインが低い(灰色の影の領域)ことを特徴とし、通常は3〜9μVの範囲に収まります25。このベースラインは、被験者の手が静止していて、筋肉が静止しているときに観察されます。ただし、安静時でも筋緊張が存在する場合は、明確なEMG信号を検出することができます。動きによって引き起こされる機械的なアーチファクトは、通常、10〜20 Hzの範囲で現れるため、それに応じてフィルタリングする必要があります。ベースライン値が大幅に上昇している場合は、50 Hzのライン干渉を示している可能性があるため、実験のセットアップ段階では避ける必要があります。適度な50Hzノイズが持続する場合。ノッチフィルターが適用されます。鋭い動きのアーチファクトは、除去がより困難であり、信号に顕著な高振幅のスパイクとして現れることがよくあります( 図2Aのアスタリスクを参照)。16電極アレイ全体のEMG信号の振幅は、測定された領域にわたる筋肉活動の空間分布を反映して変化します。この分散は、手のジェスチャー中の筋肉収縮の不均一性に関する貴重な洞察を提供します。

ハンドトラッキングカメラは、記録されたEMG信号と密接に相関することが予想される指の角度(ハンドキネマティックデータ、HKD)の直接情報を提供します。ジェスチャー中、特定のジェスチャーに応じて、通常の範囲26の指の角度。ハンドトラッキングカメラとハンドの間の視路が遮られていない場合、 図2に示すように、得られる信号は安定して正確になります。ただし、視覚的な接触が失われた場合、またはシステムに技術的な制限が発生した場合、HKD が不安定になり、誤った値間のジャンプが表示されることがあります。このような外れ値のデータは、データ収集中に最小限に抑え、結果の整合性を維持するために最終分析で破棄する必要があります。

HKDは直感的で、実際に実行されたジェスチャーと直接比較できます。被験者間や異なる手の位置間でのばらつきが少ないことを示しています。対照的に、EMGデータは、手のサイズや筋肉の発達などの解剖学的な違いにより、個人間で大きく異なる傾向がある27。さらに、利き手と非利き手の間でばらつきが見られる場合があります。この主題固有の変動性は、オフライン分析中に対処できます。

図2では、EMGとHKDの両方が指示されたジェスチャトリガに対してオフセットされていることは明らかです。この不一致は、応答時間と自然な動きの実行28によって生じる。回帰タスクでは、このような変動性がデータの豊富さに寄与する可能性がありますが、分類タスクでは、同様のシナリオ28に適用される一般化尤度比アプローチを使用して管理できます。

図2:指の外転中の代表的なsEMGとHKD。 1人の参加者が手の位置1(手を下ろし、まっすぐ、リラックスした状態)で行った動的な指の外転と休息中に記録された表面筋電図(sEMG)信号と手の運動学的データ(HKD)。(A)16チャンネルからのEMG信号を時間の関数としてフィルタリング。アスタリスク(*)は、チャネル5のEMG記録で検出された機械的アーティファクトを示します。(B)HKD、ジョイント角度を時間の関数として示しています。関節角度は、台形中手骨(TMC)、中手指節(MCP)、近位指節間(PIP)など、さまざまな関節で測定されます。実験のフェーズ(休息と外転)は、x軸に沿って示されます。 この図の拡大版を表示するには、ここをクリックしてください。

これらの代表的な結果は、手のジェスチャーをキャプチャする上で、同期されたEMGデータとHKDデータの有用性を実証しました。EMG信号と対応するHKDの位置合わせにより、筋肉の活動を特定指の動きにマッピングすることができます。予測モデルを構築する際、研究者はHKDをグラウンドトゥルースとして使用し、EMGベースのジェスチャー予測を繰り返し検証し、改良することができます。このアプローチは、プロトコールの実際的な適用性を強調し、より自然な環境でのさらなる研究の必要性を示唆しています。

補足図1:信号検証ステップ中に表示されるスペクトログラムウィンドウ。 左側のパネルには生のEMGデータが表示され、右側のパネルには検出された周波数領域が表示されます。(A)50Hzと100Hzの強い干渉を伴う非常にノイズの多いEMG信号の例。(B)参加者を電気機器からさらに遠ざけた後で同じEMG信号が記録され、干渉が最小限に抑えられたきれいなEMG信号が得られる例。 このファイルをダウンロードするには、ここをクリックしてください。

ディスカッション

この研究で提示されたプロトコルは、sEMG信号とHKDの組み合わせを通じて手のジェスチャー認識を強化することを目的とした重要な手順、変更、およびトラブルシューティング戦略を概説しています。主要な制限に対処し、このアプローチを既存の代替案と比較し、さまざまな研究領域での潜在的なアプリケーションを強調しています。このプロトコルの最も重要な側面の1つは、ハンドトラッキングカメラの正しい位置と位置合わせを確保することです。正確なジェスチャキャプチャは、参加者の手に対するカメラの角度と距離に大きく依存します。カメラの位置がわずかにずれるだけでも、トラッキングが不正確になり、ジェスチャデータの忠実度が低下する可能性があります。このアライメントは、一貫性と信頼性のあるデータ収集を確保するために、各参加者とハンドの位置ごとに慎重に調整する必要があります。さらに、ジェスチャが誤って実行されたり、実験の流れとずれたりするジャンクデータを防ぐために、参加者がプロトコルに精通していることが重要です。参加者がジェスチャや実験のセットアップに慣れ親しんでいることを確認することで、データノイズを最小限に抑え、録音の品質を向上させることができます。

このタイプの研究に共通する課題は、sEMG と HKD の両方でのノイズ汚染です。sEMG信号は、筋肉の疲労、運動アーチファクト、電磁干渉などの環境ノイズなどの要因に特に敏感です。バンドパスフィルタリングなどの前処理技術は、ノイズを低減し、信号の明瞭度を向上させるために不可欠です。適切な電極の配置と、休息期にリラックスした筋肉を維持するように参加者に指示することで、運動アーチファクトをさらに軽減できます。これらの予防措置にもかかわらず、解剖学的構造、手の筋力、および筋肉の活性化パターンの個人差により、sEMG信号のある程度の変動は避けられません。このばらつきは、被験者や条件間でこれらの違いを正規化できる柔軟なアルゴリズムによって対処できます。

高品質のsEMG信号を得るための重要な要素は、初期信号の検証です。ゲル電極を使用する従来のプロトコルでは、シグナルの明瞭度を向上させるために、角質除去やアルコールによる洗浄などの皮膚の準備が必要です。しかし、以前の研究では、乾式電極では、皮膚の準備が信号品質に大きな影響を与えない可能性があることを示しました25。このプロトコルでは、スキンクリーニングはオプションであるため、プロセスが簡素化されます。信号品質に影響を与える別の皮膚関連の問題は、腕の毛が過剰で厚いことです。このような場合は、その領域を剃るか、被験者を研究から除外することをお勧めします。

ジェスチャー認識にsEMGを使用する際の重要な課題の1つは、手の位置に対する感度です。同じジェスチャを実行している場合でも、手の向きが異なると、EMG信号パターンが異なる可能性があります。この問題に対処するためには、手の位置のばらつきに対応できる機械学習モデルが不可欠である22。これらのモデルは、堅牢性と一般化可能性を向上させるために、複数の手の姿勢からのデータでトレーニングする必要があります。視覚データとsEMGデータの同期も重要な検討事項です。ジェスチャの実行とデータ記録の間の不一致を避けるためには、ジェスチャの一貫したタイミングが重要です。このプロトコルでは、視覚的なカウントダウンと聴覚的な手がかりを使用して、正確なタイミングを確保し、データ収集中のミスアライメントを修正するために必要に応じて再キャリブレーション手順が採用されるようにします。

その長所にもかかわらず、このプロトコルにはいくつかの制限があります。大きな制約の 1 つは、ハンドトラッキングカメラの視野が限られているため、参加者の手がカメラの検出範囲内に留まる必要があることです。これにより、解析が小さな動きのセットに制限されます。ラボの外での実験では、より複雑なビデオイメージングやスマートグローブの使用が必要になります。また、長時間のセッションでは、参加者の疲労が課題となり、ジェスチャーの精度や筋肉の活性化に影響を与える可能性があり、sEMGデータの品質を低下させる可能性があります。これらの影響を軽減するには、セッションの長さを制限するか、疲労を最小限に抑えるために休憩を挟む必要がある場合があります。さらに、電力線の干渉は、特に参加者がデータキャプチャのためにPCの近くにいる場合に、sEMG信号にノイズを導入する可能性があります。システムのワイヤレスバージョンでは、参加者がコンピューターから離れることができるため、このような干渉を減らすことができます。

EMGベースの指ジェスチャー検出の方法論的大きな制限は、sEMG信号の被験者間変動が大きいことに起因しており、これには各参加者のカスタムモデルの開発が必要です。この主題固有のアプローチは、より正確ですが、プロトコルのスケーラビリティを制限し、新しいユーザーごとに追加のキャリブレーションとトレーニング時間が必要になります。EMGおよびHKDデータストリームは、デュアルプロセス記録により、わずかな時間同期の違いを示します。これらのタイミングの不一致は、維持されたポーズが一時的に安定しているため、静的ジェスチャ分析への影響は最小限に抑えられます。静的ジェスチャの持続的な性質は、より正確な同期を必要とする動的ジェスチャとは異なり、EMGと運動学的特徴の両方が安定するのに十分な時間を提供します。

この方法の主な利点は、ジェスチャをキャプチャする柔軟性です。厳格なセットアップと厳格なジェスチャパラメータを必要とする他のシステムとは異なり、このプロトコルは動的で柔軟な手の位置19に対応する。この柔軟性は、広範囲の動きを解析することを目的とした研究で特に役立ち、実際のアプリケーションへの適応性を高めます。さらに、このプロトコルは、複雑なセットアップをしばしば含む、より高度なモーションキャプチャおよびsEMGシステムと比較して費用対効果が高い29。ハンドトラッキングカメラと半自動のsEMGアルゴリズムを統合することにより、この方法は、データ品質を損なうことなく、ジェスチャー認識研究の実行可能な代替手段を提供します。さらに、このシステムのリアルタイムデータ処理の可能性は、リアルタイムの応答性が不可欠な神経補綴物やリハビリテーションなどのアプリケーションでの即時フィードバックの可能性を開きます。このプロトコルは、いくつかの分野、特に神経補綴物に大きな影響を及ぼします。sEMG信号から手のジェスチャーを正確に予測することは、義肢を制御するために重要であり、この方法によって提供される手の位置の柔軟性は、リアルタイム義肢デバイスの理想的な候補になります。リハビリテーションでは、このプロトコルを使用して、手や指の障害を持つ患者の運動回復を監視および強化することができます。ジェスチャーパフォーマンス中の筋肉の活性化パターンを分析することにより、このシステムを使用して、個々のニーズに合わせてリハビリテーション運動を調整し、運動回復へのパーソナライズされたアプローチを提供できます。ヒューマン・コンピュータ・インタラクション(HCI)では、この方法により、より自然なジェスチャーベースの制御システムが可能になり、ユーザーインターフェースの直感性と有効性が向上します。最後に、このプロトコルは、さまざまな手の位置とジェスチャーが筋肉の活動と疲労にどのように影響するかを評価するための人間工学的研究に適用でき、職場のデザインとユーザーの人間工学の進歩につながる可能性があります。

参加者間で一貫した収縮強度を確保するために、将来の研究では、力を直接測定するための力感知抵抗器を備えた手袋を実装することができます。これにより、被験者間で標準化された取り組みが可能になり、EMGデータの信頼性が向上します。さらに、この力の測定を関節運動学のラベルとして統合すると、筋肉の内部状態をより詳細に表現できるようになり、筋肉の機能と運動パターンの分析が豊かになる可能性があります。このアプローチは、データの一貫性を高めるだけでなく、筋肉の収縮と関節の動きの関係についてより深い洞察を提供します。

結論として、このプロトコルは、神経補綴、リハビリテーション、HCI、および人間工学にわたる幅広いアプリケーションを備えた、手のジェスチャー認識への斬新で柔軟なアプローチを提供します。このシステムには制限がありますが、その柔軟性、費用対効果、およびリアルタイム使用の可能性は、既存の方法に比べて大幅に進歩しています。これらの強みにより、ジェスチャ認識技術のさらなる開発と革新のための有望なツールとなっています。

開示事項

Yael Haneinは、この論文で使用したスクリーン印刷電極技術を商品化したX-trodes Ltdに金銭的利益をもたらすことを宣言しました。他の著者は、開示されたものを除き、原稿で議論されている主題または資料に金銭的利益または金銭的対立を持つ組織または団体と、他の関連する金銭的関与を持っていません。

謝辞

このプロジェクトは、ERC(OuterRetina)とISFからの助成金によって部分的に資金提供されました。資金提供者は、研究デザイン、データ収集と分析、出版の決定、または原稿の準備に関与していませんでした。David Buzaglo氏、Cheni Hermon氏、Liron Ben Ari氏、Adi Ben Ari氏には、プロトコルのオリジナルバージョンの設計に協力していただいたことに感謝します。

資料

| Name | Company | Catalog Number | Comments |

| Adjustable Selfie Stick | Used to position and angle the hand-tracking camera in the desired orientation for optimal data capture during the experiment. | ||

| Alcohol pad | To clean the area for electrode placement. | ||

| Data acquisition unit (DAU) | X-trodes Ltd. | XTR-BT V1.3 | Realtime compatible DAU 2.0.17 or 4.0.1 |

| Finger Gestures Recognition library | https://github.com/NeuroEngLabTAU/Fingers_Gestures_Recognition.git | ||

| Leap Motion Controller 2 | Ultraleap | 129-SP4-00005-03 | Hand-tracking camera |

| Long Type-C to Type-C cable | Connection of the hand-tracking camera to the PC. | ||

| PC Monitors | One for guidelines, one for viewing the hand-tracking camera data | ||

| Personal Computer (PC) | Windows | Windows 10+; Processors: Inteli7 processor. BT receiver. | |

| Python code | A script enabling seamless data streaming and recording up to 500 S/s when DAU is connected to PC via Bluetooth | ||

| Ultraleap Camera Python API | Ultraleap | Python API and instructions from Ultraleap’s GitHub repository (https://github.com/ultraleap/leapc-python-bindings) used to collect data from the Ultraleap unit during the experiment | |

| Ultraleap Hyperion | Ultraleap | Tracking software | |

| XTR EXG16 | X-trodes Ltd. | XTELC0003405RM | 16-channel wearable dry electrode array patch for EMG, ECG monitoring |

| X-trodes PC App | X-trodes Ltd. | 1.1.35.0 | An application for connecting X-trodes DAU to PC via BT |

参考文献

- Fang, B., et al. Simultaneous sEMG recognition of gestures and force levels for interaction with prosthetic hand. IEEE Trans Neural Sys Rehabilitation Eng. 30, 2426-2436 (2022).

- Yadav, D., Veer, K. Recent trends and challenges of surface electromyography in prosthetic applications. Biomed Eng Lett. 13 (3), 353-373 (2023).

- Sapsanis, C., Georgoulas, G., Tzes, A. EMG based classification of basic hand movements based on time-frequency features. , 716-722 (2013).

- Qaisar, S. M., Lopez, A., Dallet, D., Ferrero, F. J. sEMG signal based hand gesture recognition by using selective subbands coefficients and machine learning. , 1-6 (2022).

- Zhang, X., Zhou, P. High-density myoelectric pattern recognition toward improved stroke rehabilitation. IEEE Trans Biomed Eng. 59 (6), 1649-1657 (2012).

- Guo, K., et al. Empowering hand rehabilitation with AI-powered gesture recognition: a study of an sEMG-based system. Bioengineering. 10 (5), 557 (2023).

- Sun, T., Hu, Q., Libby, J., Atashzar, S. F. Deep heterogeneous dilation of LSTM for transient-phase gesture prediction through high-density electromyography: towards application in neurorobotics. IEEE Robot Autom Lett. 7 (2), 2851-2858 (2022).

- Atzori, M., et al. Characterization of a benchmark database for myoelectric movement classification. IEEE Trans Neural Sys Rehabilitat Eng. 23 (1), 73-83 (2015).

- Amma, C., Krings, T., Schultz, T. Advancing muscle-computer interfaces with high-density electromyography. , 929-938 (2015).

- Geng, W., et al. Gesture recognition by instantaneous surface EMG images. Sci Rep. 6 (1), 36571 (2016).

- Wei, W., et al. A multi-stream convolutional neural network for sEMG-based gesture recognition in muscle-computer interface. Pattern Recognit Lett. 119, 131-138 (2019).

- Padhy, S. A tensor-based approach using multilinear SVD for hand gesture recognition from sEMG signals. IEEE Sens J. 21 (5), 6634-6642 (2021).

- Moin, A., et al. A wearable biosensing system with in-sensor adaptive machine learning for hand gesture recognition. Nat Electron. 4 (1), 54-63 (2021).

- Côté-Allard, U., et al. Deep learning for electromyographic hand gesture signal classification using transfer learning. IEEE Trans Neural Sys Rehabilita Eng. 27 (4), 760-771 (2019).

- Liu, Y., Zhang, S., Gowda, M. NeuroPose: 3D hand pose tracking using EMG wearables. , 1471-1482 (2021).

- Dere, M. D., Lee, B. A novel approach to surface EMG-based gesture classification using a vision transformer integrated with convolutive blind source separation. IEEE J Biomed Health Inform. 28 (1), 181-192 (2024).

- Chen, X., Li, Y., Hu, R., Zhang, X., Chen, X. Hand gesture recognition based on surface electromyography using convolutional neural network with transfer learning method. IEEE J Biomed Health Inform. 25 (4), 1292-1304 (2021).

- Lee, K. H., Min, J. Y., Byun, S. Electromyogram-based classification of hand and finger gestures using artificial neural networks. Sensors. 22 (1), 225 (2022).

- Zhou, X., et al. A novel muscle-computer interface for hand gesture recognition using depth vision. J Ambient Intell Humaniz Comput. 11 (11), 5569-5580 (2020).

- Zhang, Z., Yang, K., Qian, J., Zhang, L. Real-time surface EMG pattern recognition for hand gestures based on an artificial neural network. Sensors. 19 (14), 3170 (2019).

- Nieuwoudt, L., Fisher, C. Investigation of real-time control of finger movements utilizing surface EMG signals. IEEE Sens J. 23 (18), 21989-21997 (2023).

- Ben-Ari, L., Ben-Ari, A., Hermon, C., Hanein, Y. Finger gesture recognition with smart skin technology and deep learning. Flexible Printed Electron. 8 (2), 25012 (2023).

- Yang, C., Xie, L. Gesture recognition method based on computer vision and surface electromyography: implementing intention recognition of the healthy side in the hand assessment process. , 663-668 (2024).

- Lin, J., Wu, Y., Huang, T. S. Modeling the constraints of human hand motion. Proc Workshop Human Motion. , 121-126 (2000).

- Arché-Núñez, A., et al. Bio-potential noise of dry printed electrodes: physiology versus the skin-electrode impedance. Physiol Meas. 44 (9), 95006 (2023).

- Gracia-Ibáñez, V., Vergara, M., Sancho-Bru, J. L., Mora, M. C., Piqueras, C. Functional range of motion of the hand joints in activities of the International Classification of Functioning, Disability and Health. J Hand Ther. 30 (3), 337-347 (2017).

- Milosevic, B., Farella, F., Benatti, S. Exploring arm posture and temporal variability in myoelectric hand gesture recognition. , 1032-1037 (2018).

- Gijsberts, A., Atzori, M., Castellini, C., Müller, H., Caputo, B. Movement error rate for evaluation of machine learning methods for sEMG-based hand movement classification. IEEE Trans Neural Sys Rehabilitation Eng. 22 (4), 735-744 (2014).

- Armitano-Lago, C., Willoughby, D., Kiefer, A. W. A SWOT analysis of portable and low-cost markerless motion capture systems to assess lower-limb musculoskeletal kinematics in sport. Front Sports Act Living. 3, 809898 (2022).

転載および許可

このJoVE論文のテキスト又は図を再利用するための許可を申請します

許可を申請さらに記事を探す

This article has been published

Video Coming Soon

Copyright © 2023 MyJoVE Corporation. All rights reserved