JoVE 비디오를 활용하시려면 도서관을 통한 기관 구독이 필요합니다. 전체 비디오를 보시려면 로그인하거나 무료 트라이얼을 시작하세요.

Method Article

오픈-심장 수술의 스테레오 3D 시각화를 위한 이상적인 구성을 결정하기 위해 카메라 위치의 로봇화 테스트

요약

3D 스테레오 비디오의 인간의 깊이 인식은 카메라 분리, 수렴 지점, 물체의 거리 및 친숙도에 따라 달라집니다. 이 백서는 이상적인 카메라 구성을 결정하기 위해 살아있는 오픈 하트 수술 중 신속하고 신뢰할 수 있는 테스트 데이터 수집을 위한 로봇화된 방법을 제시합니다.

초록

외과 적 절차의 스테레오 3D 비디오는 의학 교육에 매우 유용하고 임상 의사 소통을 향상시킬 수 있습니다. 그러나 수술실과 수술장에 대한 접근이 제한됩니다. 그것은 멸균 환경이며, 물리적 공간은 외과 직원과 기술 장비로 붐비고 있습니다. 이 설정에서, 가려지지 않은 캡처 및 수술 절차의 현실적인 재현은 어렵습니다. 이 백서는 다양한 카메라 기준 거리와 수렴 거리에서 입체 3D 비디오의 신속하고 신뢰할 수 있는 데이터 수집방법을 제시합니다. 수술 중 최소한의 간섭으로 테스트 데이터를 수집하기 위해 높은 정밀도와 반복성으로 카메라가 듀얼 암 로봇의 각 손에 부착되었습니다. 로봇은 수술실에 천장에 장착되었습니다. 10mm의 증분 단계에서 50-240mm 사이의 기준거리와 1100mm 및 1400mm의 두 수렴 거리에서 다양한 테스트 위치를 통과하는 동기화된 카메라 움직임시퀀스를 수행하도록 프로그래밍되었습니다. 수술은 40 연속 5s 비디오 샘플을 허용하기 위해 일시 중지되었다. 총 10개의 수술 시나리오가 기록되었습니다.

서문

수술에서 3D 시각화는 교육, 진단, 수술 전 계획 및 수술 후 평가1,2에 사용할 수 있습니다. 현실적인 깊이 지각은 정상 및 비정상적인 해부학의 이해3,4,5,6을 향상시킬 수 있습니다. 외과 적 수술의 간단한 2D 비디오 녹화는 좋은 시작입니다. 그러나, 깊이 지각의 부족은 비 외과 동료가 다른 해부학 구조 사이 antero 후방 관계를 완전히 이해하기 어렵게 만들 수 있고 그러므로 또한 해부학7,8,9,10의 오해의 리스크를 소개합니다.

3D 보기 환경은 (1) 카메라 구성이 도 1, (2) 기준 거리(카메라 간의 분리)에 도시된 대로 평행또는 토인일 수 있습니다. (3) 관심 있는 대상과 배경 등의 기타 장면 특성에 대한 거리. (4) 화면 크기 및 보기 위치와 같은 보기 장치의 특성1,11,12,13. (5) 시청자의 개별 선호도14,15.

3D 카메라 설정 설계는 주관적이거나 자동 평가에 사용되는 다양한 카메라 기준 거리 및 구성에서 녹화된 테스트 비디오를 캡처하는 것으로 시작됩니다16,17,18,19,20. 카메라 거리는 선명한 이미지를 캡처하기 위해 수술장에 일정해야합니다. 자동 초점이 손에 초점을 맞추기 위해 조정되기 때문에 고정 초점이 바람직합니다. 그러나 관심있는 장면이 수술 장일 때 이것은 쉽게 달성 할 수 없습니다. 운영실은 이러한 시설을 깨끗하게 유지하고 멸균해야 하기 때문에 접근 이 공간이 제한되어 있습니다. 기술 장비, 외과 의사 및 스크럽 간호사는 종종 좋은 시각적 개요와 효율적인 워크플로우를 확보하기 위해 환자 주위에 밀접하게 클러스터됩니다. 카메라 위치가 3D 시청 경험에 미치는 영향을 비교하고 평가하기 위해 모양, 크기 및 색상과 같은 개체 특성이 3D 시청 경험에 영향을 줄 수 있으므로 카메라 위치의 전체 테스트 범위가 동일한 장면을 기록해야 합니다.

같은 이유로, 카메라 위치의 완전한 테스트 범위는 다른 수술 절차에 반복되어야한다. 전체 위치 시퀀스는 높은 정확도로 반복되어야 합니다. 수술 환경에서는 기준기 거리의 수동 조정이 필요한 기존 방법22 또는 고정 기준 거리23 이 있는 다른 카메라 쌍을 공간 및 시간 제약 으로 인해 사용할 수 없습니다. 이 문제를 해결하기 위해 이 로봇 화된 솔루션이 설계되었습니다.

이 데이터는 수술실 천장에 장착된 듀얼 암 협업 산업용 로봇으로 수집되었습니다. 카메라는 로봇의 손목에 부착되어 그림 2와 같이 기준거리가 증가하는 아크 모양의 궤적을 따라 움직였다.

접근법을 보여주기 위하여는, 4개의 다른 선천적인 심장 결함을 가진 4명의 다른 환자에서 10개의 시험 시리즈가 기록되었습니다. 수술 이 중단이 가능할 때 장면이 선택되었습니다: 수술 수리 직전과 후에 박동하는 하트가 있습니다. 하트가 체포되었을 때도 시리즈가 만들어졌습니다. 수술은 3 분 및 20 초 동안 일시 중지되어 40 개의 5 ssequences를 수집하여 다양한 카메라 수렴 거리와 기준 거리의 40 개5 ssequences를 수집하여 장면을 캡처했습니다. 이 동영상은 나중에 처리 후 3D로 임상 팀을 위해 표시되었으며, 3D 비디오가 0-5에서 얼마나 현실적인지 평가했습니다.

토에이드 인 스테레오 카메라의 수렴 지점은 두 이미지의 중심점이 만나는 곳입니다. 수렴 지점은 원칙적으로 개체 앞, 내부 또는 뒤에 배치할 수 있으며 그림 1A-C를 참조할 수 있습니다. 수렴점이 오브젝트 앞에 있을 때, 오브젝트가 왼쪽 카메라 이미지에 대한 중간선 왼쪽과 오른쪽 카메라 이미지의 중간선 오른쪽에 표시됩니다(그림 1A). 반대로 수렴점이 오브젝트 뒤에 있을 때 적용됩니다(그림 1B). 수렴점이 오브젝트에 있을 때, 객체는 카메라를 이미지(그림 1C)의 중간선에도 표시하며, 이미지를 병합하는 데 가늘게 뜨지 않으므로 가장 편안하게 볼 수 있을 것입니다. 편안한 스테레오 3D 비디오를 얻으려면 수렴 지점에 위치해야 하며, 관심 있는 대상은 시청자가 자발적으로 외측(exotropia)을 가늘게 뜨게 해야 합니다.

이 데이터는 듀얼 암 협업 산업용 로봇을 사용하여 수집하여 카메라를 배치하였다(그림 2A-B). 로봇의 무게는 장비 없이 38kg입니다. 로봇은 본질적으로 안전합니다. 예기치 않은 영향을 감지하면 이동이 중지됩니다. 이 로봇은 5메가픽셀 카메라를 C-마운트 렌즈로 배치하도록 프로그래밍되었으며, 미리 정해진 기준선 거리(그림 2C)에서 정지하는 아크 모양의 궤적을 따라 배치했습니다. 도 3에 도시된 바와 같이 카메라가 어댑터 플레이트를 사용하여 로봇 손에 부착되었습니다. 각 카메라는 초당 25프레임으로 녹화되었습니다. 렌즈는 관심 있는 대상(심장의 대략적인 기하학적 중심)에 초점을 맞춘 f-stop 1/8에서 설정되었습니다. 모든 이미지 프레임에는 두 비디오 스트림을 동기화하는 데 사용되는 타임스탬프가 있었습니다.

로봇 손목과 카메라 사이의 오프셋이 보정되었습니다. 이는 도 4에 도시된 바와 같이 카메라 이미지의 십자선을 정렬하여 달성할 수 있다. 이 설정에서, 로봇 손목의 장착 지점에서 총 번역 오프셋과 카메라 이미지 센서의 중심은 X 방향에서 55.3mm, Z 방향에서 21.2mm였으며 , 도 5에 표시되었다. 회전 오프셋은 1,100mm의 수렴 거리와 50mm의 기준거리에서 보정되고 로봇 제어판의 조이스틱으로 수동으로 조정되었습니다. 이 연구의 로봇은 카르테시안 공간에서 0.02mm, 회전 해상도24의 정확도가 0.02mm로 지정되었습니다. 반경 1,100m에서 각도 차이는 0.01도로 중심점 0.2mm를 상쇄합니다. 50-240mm 분리에서 전체 로봇 모션 동안, 각 카메라에 대한 십자선은 수렴의 이상적인 중심에서 2mm 이내였다.

기준선 거리는 50-240mm(도 2)에 이르는 10mm 단위로 시야 의 중심 주위 카메라의 대칭 분리에 의해 단계적으로 증가하였다. 카메라는 각 위치에서 5s에 대한 정지 에 보관하고 50mm / s의 속도로 위치 사이를 이동했다. 수렴 점은 그래픽 사용자 인터페이스(그림 6)를 사용하여 X 및 Z 방향으로 조정할 수 있습니다. 로봇은 그에 따라 작동 범위 내에서 따랐다.

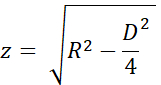

수렴점의 정확도는 도 7A 및 B의 균일한 삼각형과 가변 이름을 사용하여 추정되었다. 높이 'z' 는 피타고라스 정리와 수렴 거리 'R' 에서 계산되었다

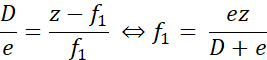

도 7A와 같이 실제 수렴점이 원하는 점보다 가까웠을 때, 오차 거리 'f1'은

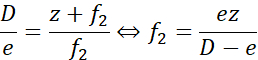

마찬가지로, 수렴점이 원하는 지점에 단종되었을 때, 오차 거리 'f2'는

여기서,'e' 는 교정 시 최대 기준선 분리에서 십자선 사이의 최대 분리(D = 240mm)였다. R = 1100mm(z = 1093mm)의 경우 오차는 ± 9.2mm 미만이었습니다. R = 1400mm(z = 1395mm)의 경우 오차가 11.7mm ±. 즉, 수렴점배치의 오차는 원하는 것의 1% 이내였다. 따라서 1100mm와 1400mm의 두 테스트 거리가 잘 분리되었습니다.

Access restricted. Please log in or start a trial to view this content.

프로토콜

실험은 스웨덴 룬드의 지역 윤리위원회의 승인을 받았습니다. 참여는 자발적이었고, 환자의 법적 보호자는 서면 동의를 통보했다.

1. 로봇 설정 및 구성

참고: 이 실험은 듀얼 암 협업 산업용 로봇과 터치 디스플레이가 있는 표준 제어판을 사용했습니다. 로봇웨어 6.10.01 컨트롤러 소프트웨어 및 로봇 통합 개발 환경(IDE) RobotStudio 2019.525로 제어됩니다. 로봇 응용 프로그램, 기록 응용 프로그램 및 후처리 스크립트를 포함하여 저자가 개발한 소프트웨어는 GitHub 리포지토리26에서 사용할 수 있습니다.

주의: 로봇 프로그램을 설정하고 테스트하는 동안 보호 안경과 속도 저하를 사용합니다.

- 제조업체사양에 따라 25쪽에 설명된 대로 100kg치의 볼트를 사용하여 천장이나 테이블에 로봇을 장착합니다24. 팔이 자유롭게 움직일 수 있고 시야로 가는 시야가 가려지지 않도록 하십시오.

주의: 로봇을 높은 위치에 장착할 때 리프트 또는 안전 로프를 사용합니다. - 로봇의 베이스에 있는 시작 스위치를 돌려 로봇을 시작합니다. 47-5625 페이지의 작동 매뉴얼에 설명된 절차에 따라 로봇을 교정합니다.

- Windows 컴퓨터에서 로봇 IDE를 시작합니다.

- 물리적 로봇 시스템(작동 수동 페이지 14027)에 연결합니다.

- 사용자 인터페이스용 로봇 프로그램 및 응용 프로그램 라이브러리의 코드를 로봇에 로드합니다.

- 천장 장착 로봇의 로봇 코드는 폴더 로봇/반전코드 와 로봇/테이블마운트코드의 테이블 장착 로봇에 있습니다. 왼쪽/Data.mod, 왼쪽/MainModule.mod, 오른쪽/Data.mod 및 오른쪽/MainModule.mod의 각 파일에 대해:

- 파일(데이터 또는 MainModule)과 같은 이름으로 새 프로그램 모듈(운영 수동 페이지 31827 참조)을 만들고 파일 내용을 새 모듈에 복사합니다.

- 로봇 IDE에 적용 을 눌러 파일을 로봇에 저장합니다.

- 파일 전송(수동 페이지 34627)을 사용하여 FPApp 폴더에 있는 로봇 애플리케이션 파일 TpSViewStereo2.dll, TpsViewStereo2.gtpu.dll 및 TpsViewStereo2.pdb 로봇에 전송합니다. 이 단계 후 로봇 IDE는 더 이상 사용되지 않습니다.

- 로봇 터치 디스플레이(FlexPendant) 뒷면의 리셋 버튼을 눌러 그래픽 인터페이스를 다시 로드합니다. 이제 로봇 응용 프로그램 스테레오2가 터치 디스플레이 메뉴 아래에 표시됩니다.

- Github 리포지토리의 루트 폴더에 있는 스크립트 install_all_linux.sh 실행하여 Ubuntu 20.04 컴퓨터에 레코딩 응용 프로그램(Liveview) 및 후처리 응용 프로그램을 설치합니다.

- 각 카메라를 로봇에 장착합니다. 장착에 필요한 구성 요소는 그림 3A에 표시됩니다.

- 렌즈를 카메라에 장착합니다.

- 카메라를 3개의 M2 나사로 카메라 어댑터 플레이트에 장착합니다.

- 카메라 의 반대편에 4 개의 M6 나사가있는 카메라 어댑터 플레이트에 원형 장착 플레이트를 장착합니다.

- 다른 카메라의 경우 1.9.1-1.9.3 단계를 반복합니다. 그림 3B 및 그림 3C와 같이 결과 어셈블리가 미러화됩니다.

- 그림 3D와 같이 4개의 M2.5 나사로 어댑터 플레이트를 로봇 손목에 장착합니다.

- 천장 장착 로봇의 경우: 그림 2A에 도시된 것처럼 왼쪽 카메라를 왼쪽 로봇 암에 부착합니다.

- 테이블 장착 로봇의 경우: 그림 3C 의 왼쪽 카메라를 오른쪽 로봇 암에 부착합니다.

- 그림 3E와 같이 USB 케이블을 카메라에 연결하고 우분투 컴퓨터에 연결합니다.

2. 카메라 교정 확인

- 로봇 터치 디스플레이에서 메뉴 버튼을 누르고 스테레오2 를 선택하여 로봇 응용 프로그램을 시작합니다. 그림 6A에 표시된 대로 메인 화면이 열립니다.

- 메인 화면에서 이동을 눌러 로봇 응용 프로그램에서 1100mm를 시작하고 로봇이 시작 위치로 이동할 때까지 기다립니다.

- 카메라에서 보호 렌즈 캡을 제거하고 USB 케이블을 우분투 컴퓨터에 연결합니다.

- 카메라 센서에서 인쇄된 교정 그리드(교정그리드.png .png 리포지토리에 놓습니다. 해당 사각형의 올바른 식별을 용이하게하려면 작은 나사 너트를 배치하거나 그리드 의 중앙 어딘가에 표시하십시오.

- 우분투 컴퓨터에서 레코딩 응용 프로그램을 시작합니다(Github 리포지토리 내부의 라이브뷰 폴더에 있는 스크립트 start.sh 실행). 이것은 그림 4에 표시된 대로 인터페이스를 시작합니다.

- 조리개를 조정하고 조리개와 초점 링으로 렌즈에 초점을 맞춥니다.

- 녹음 응용 프로그램에서 십자선 을 확인하여 십자선을 시각화합니다.

- 레코딩 응용 프로그램에서 는 그림 4에 나와 같이 십자선이 두 카메라 이미지에서 동일한 위치에서 교정 그리드와 일치하는지 확인합니다. 대부분의 경우 다음과 같이 일부 조정이 필요할 수 있습니다.

- 십자가가 겹치지 않으면 로봇 터치 디스플레이의 로봇 응용 프로그램에서 기어 아이콘(왼쪽 그림 6A 아래)을 눌러 도 6B에 표시된 대로 설정 화면을 엽니다.

- 1을 누릅니다. 그림 6B와 같이 시작 포스로 이동합니다.

- 조이스틱으로 로봇을 조깅하여 카메라 위치를 조정합니다(수동 페이지 3123).

- 각 로봇 암의 공구 위치를 업데이트합니다. 3을 누릅니다. 왼쪽 도구 와 4를 업데이트합니다. 오른쪽 도구를 업데이트 하여 왼쪽과 오른쪽 팔에 대한 교정을 각각 저장합니다.

- 백 화살표 아이콘(오른쪽 상단, 그림 6B)을 눌러 메인 화면으로 돌아갑니다.

- 로봇 응용 프로그램에서 실행 실험 (그림 6A)을 누르고 십자선이 정렬되는지 확인합니다. 그렇지 않으면 2.3-2.3.5 단계를 반복하십시오.

- 이 시점에서 거리 및/또는 시간에 대한 변경 내용을 추가하고 테스트합니다. 이를 위해서는 로봇 프로그램 코드와 고급 로봇 프로그래밍 기술의 변화가 필요합니다. 왼쪽 작업(arm)의 데이터 모듈에서 다음 변수를 변경합니다( 무기): 정수 어레이 변수 거리, 정수 어레이 수렴 거리의 원하는 분리 거리, 수렴 거리 수렴및 변수 Nwaittime (초 값)을 편집하여 각 단계에서 시간을 편집합니다.

주의: 라이브 수술 중에 테스트되지 않은 로봇 프로그램을 실행하지 마십시오. - 교정이 완료되면 올리기 를 눌러 로봇 팔을 대기 위치로 올립니다.

- 선택적으로 로봇을 끕니다.

참고: 위의 단계 간에 절차를 일시 중지할 수 있습니다.

3. 수술 시작 시 준비

- 로봇을 먼지로 비합니다.

- 로봇이 꺼져 있으면 로봇 베이스에 있는 시작 스위치를 켜서 시작합니다.

- 2.1 및 2.2 단계에 설명된 터치 디스플레이 및 기록 응용 프로그램에서 로봇 응용 프로그램을 시작합니다.

- 녹화 응용 프로그램에서 비디오를 저장할 폴더를 만든 다음 선택합니다( 폴더 변경).

- 로봇 응용 프로그램에서 : 기어 아이콘을 누르고 환자와 관련하여 카메라를 배치합니다. 로봇과 높이에서 손 거리를 각각 누르면 X 및 Z 방향을 변경하여 이미지가 수술 장을 캡처합니다. 로봇 이나 환자를 수동으로 이동 하 여 Y 방향으로 위치를 수행 합니다.

참고: 준비 단계 3.1-3.4 사이에 준비를 일시 중지할 수 있습니다.

4. 실험

주의: 모든 직원은 사전에 실험에 대해 통보받아야 합니다.

- 수술을 일시 중지합니다.

- OR 담당자에게 실험이 시작되었다고 알립니다.

- 녹음 응용 프로그램에서 레코드 를 누릅니다.

- 로봇 응용 프로그램에서 실행 실험을 누릅니다.

- 프로그램이 실행되는 동안 기다립니다. 로봇은 완료되면 터치 디스플레이의 로봇 응용 프로그램에 "완료"를 표시합니다.

- 종료를 눌러 녹음 응용 프로그램에서 녹화 를 중지합니다.

- OR 담당자에게 실험이 완료되었음을 알립니다.

- 수술을 재개합니다.

참고: 4.1-4.6단계에서는 실험을 일시 중지할 수 없습니다.

5. 반복

- 다른 시퀀스를 캡처하기 위해 4.1-4.6 단계를 반복하고 다른 수술에서 시퀀스를 캡처하기 위해 3.1-3.4 단계와 단계 4.1-4.6. 약 10개의 전체 시퀀스를 캡처합니다.

6. 후처리

참고: 다음 단계는 대부분의 비디오 편집 소프트웨어 또는 후처리 폴더에 제공된 스크립트를 사용하여 수행할 수 있습니다.

- 이 경우 RAW 형식으로 저장되는 비디오를 디바이더합니다.

- 그림 8A에 표시된 debayer 응용 프로그램을 엽니다.sh 스크립트 후처리/ debayer/run을 실행합니다.

- 입력 디렉토리 탐색을 누르고 RAW 비디오로 폴더를 선택합니다.

- 출력 디렉토리 탐색을 누르고 생성된 디바이엘 및 색상 조정 비디오 파일에 대한 폴더를 선택합니다.

- 데바이엘을 누르세요! 프로세스가 완료될 때까지 기다립니다 - 그림 8B에 표시된 바와 같이 두 진행률 막대가 모두 가득 찼습니다.

- 오른쪽 및 왼쪽 동기화된 비디오를 3D 스테레오 포맷28에 병합합니다28:

- 스크립트 후처리/merge_tb/run.sh 실행하여 병합 응용 프로그램을 시작합니다. 그림 8C에 표시된 그래픽 사용자 인터페이스를 엽니다.

- 입력 디렉토리 탐색을 누르고 분산된 비디오 파일이 있는 폴더를 선택합니다.

- 출력 디렉토리 찾아보기를 누르고 생성된 병합된 3D 스테레오 파일에 대한 폴더를 선택합니다.

- 병합을 누르십시오! 그림 8D의 마무리 화면이 표시될 때까지 기다립니다.

- Premiere Pro와 같은 기성 비디오 편집 소프트웨어를 사용하여 비디오의 각 카메라 거리에 텍스트 라벨을 추가합니다.

참고: 비디오에서는 로봇이 움직일 때마다 눈에 띄는 흔들림이 있으며 카메라 거리가 증가합니다. 이 실험에서는 카메라 거리에 A-T 라벨이 사용되었습니다.

7. 평가

- 활성 3D 프로젝터로 상위 아래 3D 형식으로 비디오를 표시합니다.

- 보기 환경은 시야각과 화면 거리에 따라 달라집니다. 의도한 잠재고객 및 설정을 사용하여 비디오를 평가합니다.

Access restricted. Please log in or start a trial to view this content.

결과

오른쪽 이미지가 상단 하단 입체 3D의 상단에 배치된 허용 가능한 평가 비디오가 Video1에 표시됩니다. 성공적인 시퀀스는 날카롭고, 집중적이며, 비동기 이미지 프레임이 없어야 합니다. 비동기화된 비디오 스트림은 파일 Video 2에 나와 같이 흐림을 일으킵니다. 수렴 점은 그림 9A, B에서 볼 수 있듯이 카메라 분리와 는 별개로 수평으로 중?...

Access restricted. Please log in or start a trial to view this content.

토론

라이브 수술 중, 3D 비디오 데이터 수집에 사용되는 실험의 총 시간은 환자에게 안전한 것으로 제한되었다. 개체가 초점이 맞지 않거나 과도하게 노출된 경우 데이터를 사용할 수 없습니다. 중요한 단계는 카메라 도구 교정 및 설정(2단계)입니다. 수술이 시작되면 카메라 조리개와 포커스를 변경할 수 없습니다. 설치 및 수술 중에 동일한 조명 조건과 거리를 사용해야 합니다. 2.1-2.4 단계의 카메라 ?...

Access restricted. Please log in or start a trial to view this content.

공개

저자는 공개 할 것이 없습니다.

감사의 말

이 연구는 Vinnova (2017-03728, 2018-05302 및 2018-03651), 심장 폐 재단 (20180390), 가족 캄프라드 재단 (20190194), 안나 리사와 스벤 에릭 룬드그렌 재단 (2017 및 2018)의 자금으로 수행되었습니다.

Access restricted. Please log in or start a trial to view this content.

자료

| Name | Company | Catalog Number | Comments |

| 2 C-mount lenses (35 mm F2.1, 5 M pixel) | Tamron | M112FM35 | Rated for 5 Mpixel |

| 3D glasses (DLP-link active shutter) | Celexon | G1000 | Any compatible 3D glasses can be used |

| 3D Projector | Viewsonic | X10-4K | Displays 3D in 1080, can be exchanged for other 3D projectors |

| 6 M2 x 8 screws | To attach the cXimea cameras to the camera adaptor plates | ||

| 8 M2.5 x 8 screws | To attach the circular mounting plates to the robot wrist | ||

| 8 M5 x 40 screws | To mount the robot | ||

| 8 M6 x 10 screws with flat heads | For attaching the circular mounting plate and the camera adaptor plates | ||

| Calibration checker board plate (25 by 25 mm) | Any standard checkerboard can be used, including printed, as long as the grid is clearly visible in the cameras | ||

| Camera adaptor plates, x2 | Designed by the authors in robot_camera_adaptor_plates.dwg, milled in aluminium. | ||

| Circular mounting plates, x2 | Distributed with the permission of the designer Julius Klein and printed with ABS plastic on an FDM 3D printer. License Tecnalia Research & Innovation 2017. Attached as Mountingplate_ROBOT_SIDE_ NewDesign_4.stl | ||

| Fix focus usb cameras, x2 (5 Mpixel) | Ximea | MC050CG-SY-UB | With Sony IMX250LQR sensor |

| Flexpendant | ABB | 3HAC028357-001 | robot touch display |

| Liveview | recording application | ||

| RobotStudio | robot integrated development environment (IDE) | ||

| USB3 active cables (10.0 m), x2 | Thumbscrew lock connector, water proofed. | ||

| YuMi dual-arm robot | ABB | IRB14000 |

참고문헌

- Held, R. T., Hui, T. T. A guide to stereoscopic 3D displays in medicine. Academic Radiology. 18 (8), 1035-1048 (2011).

- van Beurden, M. H. P. H., IJsselsteijn, W. A., Juola, J. F. Effectiveness of stereoscopic displays in medicine: A review. 3D Research. 3 (1), 1-13 (2012).

- Luursema, J. M., Verwey, W. B., Kommers, P. A. M., Geelkerken, R. H., Vos, H. J. Optimizing conditions for computer-assisted anatomical learning. Interacting with Computers. 18 (5), 1123-1138 (2006).

- Takano, M., et al. Usefulness and capability of three-dimensional, full high-definition movies for surgical education. Maxillofacial Plastic and Reconstructive Surgery. 39 (1), 10(2017).

- Triepels, C. P. R., et al. Does three-dimensional anatomy improve student understanding. Clinical Anatomy. 33 (1), 25-33 (2020).

- Beermann, J., et al. Three-dimensional visualisation improves understanding of surgical liver anatomy. Medical Education. 44 (9), 936-940 (2010).

- Battulga, B., Konishi, T., Tamura, Y., Moriguchi, H. The Effectiveness of an interactive 3-dimensional computer graphics model for medical education. Interactive Journal of Medical Research. 1 (2), (2012).

- Yammine, K., Violato, C. A meta-analysis of the educational effectiveness of three-dimensional visualization technologies in teaching anatomy. Anatomical Sciences Education. 8 (6), 525-538 (2015).

- Fitzgerald, J. E. F., White, M. J., Tang, S. W., Maxwell-Armstrong, C. A., James, D. K. Are we teaching sufficient anatomy at medical school? The opinions of newly qualified doctors. Clinical Anatomy. 21 (7), 718-724 (2008).

- Bergman, E. M., Van Der Vleuten, C. P. M., Scherpbier, A. J. J. A. Why don't they know enough about anatomy? A narrative review. Medical Teacher. 33 (5), 403-409 (2011).

- Terzić, K., Hansard, M. Methods for reducing visual discomfort in stereoscopic 3D: A review. Signal Processing: Image Communication. 47, 402-416 (2016).

- Fan, Z., Weng, Y., Chen, G., Liao, H. 3D interactive surgical visualization system using mobile spatial information acquisition and autostereoscopic display. Journal of Biomedical Informatics. 71, 154-164 (2017).

- Fan, Z., Zhang, S., Weng, Y., Chen, G., Liao, H. 3D quantitative evaluation system for autostereoscopic display. Journal of Display Technology. 12 (10), 1185-1196 (2016).

- McIntire, J. P., et al. Binocular fusion ranges and stereoacuity predict positional and rotational spatial task performance on a stereoscopic 3D display. Journal of Display Technology. 11 (11), 959-966 (2015).

- Kalia, M., Navab, N., Fels, S. S., Salcudean, T. A method to introduce & evaluate motion parallax with stereo for medical AR/MR. IEEE Conference on Virtual Reality and 3D User Interfaces. , 1755-1759 (2019).

- Kytö, M., Hakala, J., Oittinen, P., Häkkinen, J. Effect of camera separation on the viewing experience of stereoscopic photographs. Journal of Electronic Imaging. 21 (1), 1-9 (2012).

- Moorthy, A. K., Su, C. C., Mittal, A., Bovik, A. C. Subjective evaluation of stereoscopic image quality. Signal Processing: Image Communication. 28 (8), 870-883 (2013).

- Yilmaz, G. N. A depth perception evaluation metric for immersive 3D video services. 3DTV Conference: The True Vision - Capture, Transmission and Display of 3D Video. , 1-4 (2017).

- Lebreton, P., Raake, A., Barkowsky, M., Le Callet, P. Evaluating depth perception of 3D stereoscopic videos. IEEE Journal on Selected Topics in Signal Processing. 6, 710-720 (2012).

- López, J. P., Rodrigo, J. A., Jiménez, D., Menéndez, J. M. Stereoscopic 3D video quality assessment based on depth maps and video motion. EURASIP Journal on Image and Video Processing. 2013 (1), 62(2013).

- Banks, M. S., Read, J. C., Allison, R. S., Watt, S. J. Stereoscopy and the human visual system. SMPTE Motion Imaging Journal. 121 (4), 24-43 (2012).

- Kytö, M., Nuutinen, M., Oittinen, P. Method for measuring stereo camera depth accuracy based on stereoscopic vision. Three-Dimensional Imaging, Interaction, and Measurement. 7864, 168-176 (2011).

- Kang, Y. S., Ho, Y. S. Geometrical compensation algorithm of multiview image for arc multi-camera arrays. Advances in Multimedia Information Processing. 2008, 543-552 (2008).

- Product Specification IRB 14000. DocumentID: 3HAC052982-001 Revision J. ABB Robotics. , Available from: https://library.abb.com/en/results (2018).

- Operating Manual IRB 14000. Document ID: 3HAC052986-001 Revision F. ABB Robotics. , Available from: https://library.abb.com/en/results (2019).

- Github repository. , Available from: https://github.com/majstenmark/stereo2 (2021).

- Operating manual RobotStudio. Document ID: 3HAC032104-001 Revision Y. ABB Robotics. , Available from: https://library.abb.com/en/results (2019).

- Won, C. S. Adaptive interpolation for 3D stereoscopic video in frame-compatible top-bottom packing. IEEE International Conference on Consumer Electronics. 2011, 179-180 (2011).

- Kim, S. K., Lee, C., Kim, K. T. Multi-view image acquisition and display. Three-Dimensional Imaging, Visualization, and Display. Javidi, B., Okano, F., Son, J. Y. , Springer. New York. 227-249 (2009).

- Liu, F., Niu, Y., Jin, H. Keystone correction for stereoscopic cinematography. IEEE Computer Society Conference on Computer Vision and Pattern Recognition Workshops. 2012, 1-7 (2012).

- Kang, W., Lee, S. Horizontal parallax distortion correction method in toed-in camera with wide-angle lens. 3DTV Conference: The True Vision - Capture, Transmission and Display of 3D Video. 2009, 1-4 (2009).

Access restricted. Please log in or start a trial to view this content.

재인쇄 및 허가

JoVE'article의 텍스트 или 그림을 다시 사용하시려면 허가 살펴보기

허가 살펴보기This article has been published

Video Coming Soon

Copyright © 2025 MyJoVE Corporation. 판권 소유