É necessária uma assinatura da JoVE para visualizar este conteúdo. Faça login ou comece sua avaliação gratuita.

Method Article

Avaliando as múltiplas dimensões do noivado a Caracterizar Aprendizagem: uma perspectiva neurofisiológica

Neste Artigo

Resumo

This paper aims to describe the techniques involved in the collection and synchronization of the multiple dimensions (behavioral, affective and cognitive) of learners’ engagement during a task.

Resumo

In a recent theoretical synthesis on the concept of engagement, Fredricks, Blumenfeld and Paris1 defined engagement by its multiple dimensions: behavioral, emotional and cognitive. They observed that individual types of engagement had not been studied in conjunction, and little information was available about interactions or synergy between the dimensions; consequently, more studies would contribute to creating finely tuned teaching interventions. Benefiting from the recent technological advances in neurosciences, this paper presents a recently developed methodology to gather and synchronize data on multidimensional engagement during learning tasks. The technique involves the collection of (a) electroencephalography, (b) electrodermal, (c) eye-tracking, and (d) facial emotion recognition data on four different computers. This led to synchronization issues for data collected from multiple sources. Post synchronization in specialized integration software gives researchers a better understanding of the dynamics between the multiple dimensions of engagement. For curriculum developers, these data could provide informed guidelines for achieving better instruction/learning efficiency. This technique also opens up possibilities in the field of brain-computer interactions, where adaptive learning or assessment environments could be developed.

Introdução

Engagement desempenha um papel crucial na aprendizagem. Para Clark e Mayer 2, "toda a aprendizagem requer engajamento", independentemente dos meios de comunicação de entrega. Zhang et al. 3 também sugeriram que o aumento do envolvimento do aluno pode melhorar os resultados de aprendizagem, tais como resolução de problemas e habilidades de pensamento crítico. Definindo engajamento continua a ser um desafio. Em sua revisão da literatura, Fredricks, Blumenfeld e Paris 1 definido engajamento por sua natureza multifacetada: "engajamento comportamental baseia-se na idéia de participação; que inclui o envolvimento em atividades acadêmicas e sociais ou extracurriculares. (...) O envolvimento emocional engloba reações positivas e negativas para os professores, colegas, acadêmicos e escola e é presumida para criar laços com um objeto e influência vontade de fazer o trabalho. Finalmente, envolvimento cognitivo baseia-se na idéia de investimento mental; ele incorpora consideração e vontade de exercer o esforço neccessário para compreender idéias complexas e dominar as habilidades difíceis ".

Fredricks, Blumenfeld e Paris 1 também alegou que um foco em comportamento, emoção e cognição, dentro do conceito de engajamento, pode fornecer uma caracterização mais rica de aprendizado. Estes autores apontam que um corpo robusto de pesquisa aborda cada componente de envolvimento separadamente, mas esses componentes não foram estudadas em conjunto. Eles também observaram que há pouca informação disponível sobre as interações entre as dimensões e que mais estudos poderão contribuir para o planejamento de intervenções de ensino afinado. Como um passo nesse sentido, este trabalho descreve uma metodologia de pesquisa que foi desenvolvido para coletar e analisar dados quantitativos e qualitativos, de forma síncrona, no engajamento comportamental, emocional e cognitiva durante tarefas de aprendizagem.

Trazendo as Neurociências em Educação

Behavior e, consequentemente, o engajamento comportamental, tem sido o foco central de estudos em educação: projetos de pesquisa focados principalmente em mudanças no conhecimento e comportamento que ocorrem ao longo de grandes períodos de tempo, entre pré e pós-testes, e ao longo de intervalos de horas, semanas , meses ou anos. Discriminando entre engajamento comportamental, emocional, cognitivo e continua a ser um desafio, porque as duas últimas dimensões não são sistematicamente observável externamente. Cognição e as emoções ou deve ser inferida a partir de observações ou avaliados com medidas de auto-relato. De um ponto de vista externo, continua a ser difícil determinar se os alunos estão a tentar fazer o seu trabalho o mais rapidamente possível ou utilizando estratégias de aprendizagem de nível profundo de dominar um conteúdo específico. Na verdade, Fredricks, Blumenfeld e Paris 1 foram incapazes de encontrar qualquer estudos publicados utilizando medidas diretas, objetivas de envolvimento cognitivo.

Os desenvolvimentos tecnológicos recentes emo domínio das neurociências criaram novas possibilidades de pesquisa em educação. Novos métodos de coleta de dados e algoritmos de análise desenvolvidos no campo da ergonomia neuro parece muito promissor para estudos qualitativos e quantitativos durante as tarefas de aprendizagem. Outras disciplinas, tais como economia, psicologia, marketing e ergonomia, têm vindo a utilizar medições neurofisiológicas para avaliar o envolvimento cognitivo por algum tempo 4-8. Medidas neurofisiológicas, juntamente com algoritmos de análise eficientes, permitem estudar um fenômeno sem perturbá-la. Pela sua natureza, os questionários de auto-relato desengatar alunos de aprendizagem. Medidas neurofisiológicas permitir que projetos de pesquisa a ser realizada em ambientes de aprendizagem mais autênticas. Essas ferramentas incluem equipamento para monitorar a frequência cardíaca, frequência respiratória, pressão arterial, temperatura corporal, diâmetro da pupila, a atividade electrodermal, eletroencefalografia (EEG), etc.

Gathering Sincronizado Dados sobre comportamental, emocional, cognitivo e Engajamento

Como resultados representativos na sequência da utilização deste protocolo, este documento irá apresentar os resultados parciais de um estudo no qual os alunos tinham de resolver, em uma tela de computador, dez problemas em física mecânica. Estes problemas foram desenvolvidos em trabalhos anteriores 9. Dados neurofisiológicos foram coletadas enquanto os alunos foram resolvendo os problemas e relaxante durante uma pausa de 45 s, com os olhos fechados, depois de cada problema.

Como mencionado acima, os dados de noivado comportamentais consistem de interações de software (movimentos e cliques do mouse), o olhar dos olhos, desempenho e respostas a perguntas produzidos por um aluno interagir com o sistema ao realizar a tarefa 1. Um sistema de rastreamento ocular foi utilizado para coletar interações de software e dados do olhar olho. Os dados de desempenho (tempo para resolver um problema, correção de respostas) foram coletados em umsite pesquisa que foi utilizado para apresentar a tarefa. Este site também foi usado para reunir dados de auto-relato recolhidos com um questionário adaptado de Bradley e Lang 10. Envolvimento emocional envolve a caracterização das emoções. De acordo com Lang 11, as emoções são caracterizados em termos de valência (agradável / desagradável) e excitação (calma / despertado). Dados envolvimento emocional foram devidamente recolhidos, usando software de reconhecimento facial automático emoção que quantifica valência emocional e uma atividade codificador / sensor electrodermal para despertar 12,13. Actividade Eletrodermal (EDA) refere-se à resistência eléctrica entre os dois eléctrodos gravada quando uma corrente eléctrica é muito fraco continuamente passados entre eles. Cacioppo, Tassinary Berntson e 14 mostraram que a resistência gravado varia de acordo com a excitação do sujeito. Assim, os dados psicofisiológicas, como valência ou excitação, são considerados como correlatos de envolvimento emocional.

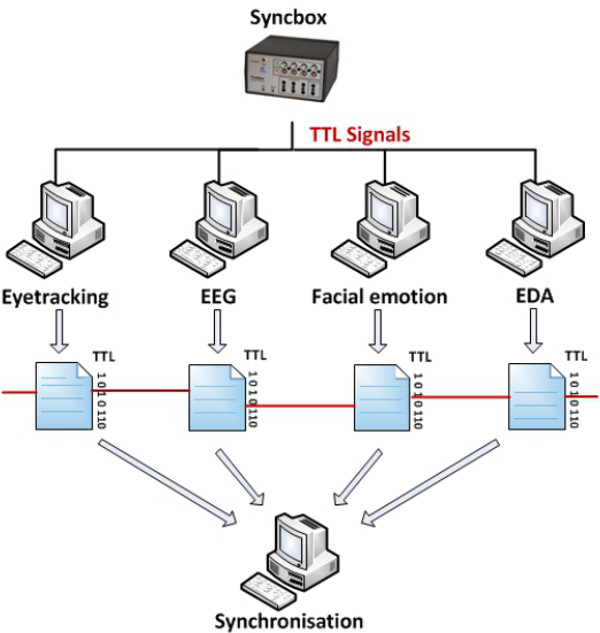

Finalmente, os dados de noivado cognitivas são coletados por meio de eletroencefalografia (EEG). Medidas de EEG, no couro cabeludo, a atividade elétrica dos grupos de neurônios no cérebro sincronizado. Sinais elétricos gravados a partir do couro cabeludo são muitas vezes oscilatório e composta por componentes de frequência. Por convenção, essas freqüências são agrupadas em seqüências, conhecido como bandas. Por exemplo, alfa, beta e teta bandas são o foco deste estudo. De acordo com estudos neurocientíficos 14, essas bandas refletem diferentes habilidades de processamento cognitivo em áreas específicas do cérebro. Assim, a análise da densidade de potência espectral (PSD) de frequências específicas, combinados com numerosos estudos sobre o estado de alerta e 7,15 atenção, permite aos investigadores quantificar envolvimento cognitivo durante uma tarefa. Como Millar et al. 16 observou, a pesquisa mostrou uma relação direta entre a atividade beta e agilidade cognitiva e uma relação indireta entre um alfad atividade theta e agilidade. Assim, o Papa, Bogart e Bartoleme 7 desenvolveram um índice de noivado que calcula o PSD de três bandas: beta / (alfa + teta). Esse índice foi validado em outros estudos sobre o envolvimento 16,17,18. Para caracterizar o envolvimento cognitivo ao longo do tempo, uma transformada de Fourier rápida (FFT) converte o sinal de EEG de cada local activo (F3, F4, O1, O2) num espectro de potência. O índice de acoplamento de EEG no tempo T é calculado pela média de cada razão de acoplamento dentro de uma janela deslizante de 20 seg precedente tempo T. Este procedimento é repetido a cada segundo e uma nova janela de correr é utilizado para actualizar o índice.Uma vez que o objectivo desta metodologia é fornecer uma rica análise das múltiplas dimensões de engajamento, a sincronização de dados é crucial. Como Leger et al. 19 lembrar aos leitores, fabricantes de equipamentos altamente recomendável utilizar apenas um computador por ferramenta de medição para garantir a sua precisão especificada level. Assim, quando vários computadores estão empregados, a sincronização entre computadores de gravação torna-se um passo crítico. As gravações não podem ser iniciadas ao mesmo tempo exato, e cada fluxo de dados tem o seu período de tempo específico (por exemplo, sec 0 de olho rastreamento ≠ sec 0 de EEG ou dados fisiológicos). Isso é extremamente importante: dessincronização entre fluxos de dados significa erros na quantificação de cada dimensão de engajamento. Existem diferentes formas de sincronizar gravações fisiológicas e comportamentais simultâneas. Estes métodos podem ser divididos em duas abordagens principais; direta e indireta 20. O protocolo apresentado na próxima seção é baseada em uma abordagem indireta, onde um dispositivo externo, um syncbox, é usado para enviar sinais de lógica transistor-transistor (TTL) para todos os equipamentos de gravação (como mostrado na Figura 1). À medida que cada peça de equipamento tem uma hora de início diferente, os marcadores TTL são registrados nos arquivos de log com um parente atraso. Os marcadores são então usadas para realinhar os sinais e, assim, assegurar uma sincronização apropriada depois de cada gravação. Um programa de software de análise comportamental que permite a integração de arquivo externo é usado para re-sincronizar o cronograma de cada fluxo de dados e para realizar a análise quantitativa e qualitativa de cada dimensão de engajamento.

Figura 1. Arquitetura do Sistema de Coleta de Dados. O ambiente de laboratório no qual comportamental (eye-tracking), emocional (EDA e emoção facial) e dados cognitivos (EEG) de noivado são recolhidos contém muitos computadores. Isto levanta um desafio para a sincronização de dados que são referenciados em seus respectivos relógios dos computadores. Para ser capaz de analisar todos os dados no mesmo tempo de referência, a configuração do laboratório envolve um syncbox que envia sinais TTL para todos os fluxos de dados.nk "> Clique aqui para ver uma versão maior desta figura.

Para avaliar a precisão da metodologia em termos de sincronização, 45 seg pausas foram introduzidas antes de cada um dos problemas de física mecânica. Durante essas pausas, os sujeitos tiveram para relaxar e fechar os olhos. Como visto em outros estudos 4,9,16,17,18, essas pausas devem induzir variações significativas no sinal coletado: os dois pontos pupila do olho em olho-tracking imediatamente desaparecer (engajamento comportamental) e uma queda imediata no envolvimento cognitivo (EEG sinal) é observada. Estes componentes específicos do sinal são usadas para avaliar a eficácia geral da sincronização. A recente publicação de documentos que total ou parcialmente dependem desse procedimento de sincronização, nas áreas de sistemas de informação 19, interações homem-máquina 21 e educação 9, 22, fornece provas da sua eficácia.

Access restricted. Please log in or start a trial to view this content.

Protocolo

Este protocolo recebeu um certificado de ética do Comité de la recherche institutionnel avec des êtres humains (CIER) de l'Université du Québec à Montréal (UQAM), que foi aprovado pelo HEC-Montreal para o centro de pesquisa Tech3Lab. O protocolo descreve cada um dos passos específicos que são realizados em nosso meio ambiente e equipamentos de laboratório. Embora caminhos de software precisos são fornecidos para esclarecer a metodologia, esta técnica é transferível e pode ser replicado com outros eye-tracking proprietário, automático reconhecimento de emoções faciais, atividade electrodermal e equipamentos eletroencefalografia e software.

1. Configuração do Laboratório de Meio Ambiente

- Ligue o olho-tracker, o amplificador de EEG, os quatro computadores de gravação e alto-falantes.

- Prepare a instalação do aparelho de controlo:

- Prepare a configuração do EEG com material necessário de acordo com recome do fabricanteprocedimentos NDED. Prepare o software EEG para o próximo participante. Inicie o software de rastreamento ocular e criar um novo perfil de participante do software. Inicie o software de gravação de vídeo e as câmeras.

- Inicie o software de sincronização com o sub-rotina específica criada para o projeto com marcadores em 60 seg. Inicie o software de medição fisiológica (para gravar a atividade electrodermal) e abra o layout específico criado para o projeto. Ajuste cadeira do participante ao mais alto nível.

2. Participante Preparação

- Peça ao participante para ler e assinar o formulário de consentimento ético.

- Realizar medições do crânio para EEG:

- Encontre o local Cz na cabeça do participante (de acordo com 10-20 sistemas de referência). Mergulhe o líquido EEG na solução salina (cloreto de potássio) (veja o passo 1.2.1) e iniciar um temporizador (10 min), em conformidade com as normas do fabricante.

- Leia o objetivo do estudo e as etapas do experimento para o participante, "O objetivo deste estudo é observar sua atividade cerebral enquanto você responder a problemas de física. Primeiro vamos instalar os sensores, em seguida, você será solicitado a resolver 10 problemas de física newtoniana no computador. Vamos pedir-lhe para tomar uma 45-sec pausa depois de cada problema com seus olhos fechados. Depois de cada problema, você será solicitado para avaliar a sua avaliação do problema ".

- Diga o assunto que a duração total do experimento será de 90 min.

- Instalar os sensores fisiológicos, de acordo com as recomendações do fabricante: dois sensores gelificados no topo do lado esquerdo.

- Instale a tampa do EEG, de acordo com as recomendações do fabricante e executar uma verificação de impedância com um limiar de 40 kW (de acordo com as especificações do fabricante).

3. Coleta de Dados

- Certifique-se de que todos os softwares de gravação está pronto para ser iniciado em sincronia:

- Fisiologia (dados EDA): Clique no botão "Iniciar".

- A gravação de vídeo: Clique no botão "Abrir".

- Eye-tracking: Clique no botão "em espera".

- EEG: Clique no botão "record".

- O software de sincronização: Clique no botão "círculo verde".

- Olho calibração olhar:

- Realize uma calibração de cinco pontos na tela e observe o participante enquanto ele / ela segue os pontos vermelhos (clique em "Ferramentas / Configurações / Calibração ..."). Repita este procedimento até que uma precisão suficiente é alcançada, de acordo com as normas do fabricante.

- Instruções de tarefas do projeto na tela do participante: perguntar se ele / ela tem alguma dúvida após lê-los, e se ele / ela está pronto para iniciar a experiência.

- Peça ao participante para resolver 10 newtoniana physics problemas.

- Se necessário, execute uma verificação de impedância durante um dos intervalos 45 s (não antes de problema 5).

- Certifique-se de que o participante assume a completa 45 s pausa antes de cada problema (para determinar a linha de base).

4. Fim de Coleta de Dados

- Pare de aquisição de dados em todos os computadores e remover os sensores do participante.

5. Depois de o Participante Has Left

- Limpe a tampa EEG com germicida e arrumar o equipamento, de acordo com as recomendações do fabricante. Salve todos os arquivos de dados coletados e criar um backup no servidor de FTP.

- Preencha a planilha participante: observe qualquer evento particular ou problema durante a coleta de dados. Apagar todos os cookies do navegador da web.

6. Dados Pré-processamento e exportação para o Software de Integração

- EEG

- Importar dados de EEG em EEG software de análise de dados:

- Crie três pastas vazias no computador chamado "dados brutos", "História" e "Exportar" para colar os dados de EEG matérias no arquivo de dados Raw recém-criado.

- No EEG software de análise de dados, clique em "File / New Project ..." e escolha o local de dados brutos, clicando em Procurar e selecionando o arquivo de dados brutos recém-criado. Escolha o local do "Histórico" e as pastas "exportação" da mesma forma.

- Clique em "OK". (A janela deve conter todos os dados de EEG do participante).

- Pré-processo o sinal do cérebro:

- Aplicar um filtro e um entalhe (clique em "Transformações / filtros IIR ..."). Na janela, permitir que o corte de baixa de 1,5 Hz com um declive de 12 dB eo alto ponto de corte em 50 Hz com um declive de 12 dB. Também permitem que um entalhe a 60 Hz de frequência.

- Porque um amplificador DC é usado, DC retirada da tendência de sinal (Clique em "Transformations / DC Eliminar tendência ... "e permitir" baseadas em tempo "em 100 milissegundos antes do marcador e 100 ms antes de conexão DC).

- Faça uma inspeção de dados brutos (Clique em "Transformação / Raw inspeção de dados ..." e selecione a remoção artefato semi-automático). Selecione as seguintes: tensão máxima de 60 mV / ms; Max-min: 200 mV em 200 intervalo ms; amplitude: -400 a +400 mV).

- Executar uma ICA automática com esferificação clássico para remoção piscar de olhos (artefatos miográfica não precisa ser removido porque a sua gama está fora das frequências de interesse). (Clique em "Transformações / ICA ...". No final do ICA, o processo inverso ICA).

- Re-referência ("Transformações / Re-referência ...") o sinal e selecione "média comum".

- Export (clique em "Export / Genéricos Data Export ...") o sinal e marcadores em formato de texto (Selecione a opção ".vhdr"; caixa) para um eventual construção Matlab do índice de noivado. Além disso, selecione o arquivo "cabeçalho Write" e "caixas de arquivo marcador Write".

- Importar o sinal em Matlab.

- Comece Matlab e digite "eeglab" para que o GUI de EEGLab aparece e importar os dados para um participante de cada vez. Na GUI, selecione item de menu "Arquivo / Importar Dados / Usando funções EEGLab e plugins / Do Cérebro Vis Rec .vhdr arquivo".

- Na janela de comando, cole um script 16 que gera um índice de noivado.

NOTA: O script envolvimento cognitivo é calculado pela média de cada / rácio Beta (Alpha Theta +) dentro de um tempo T. janela deslizante 20 seg anterior Este procedimento é repetido a cada segundo e uma nova janela deslizante é usado para atualizar o índice.

- No MS Excel, abra o ficheiro de texto do índice de acoplamento que é gerado no final da escrita por Matlab e aplicar um z-SCORe normalização em dados de EEG para permitir a comparação intersubject. (Para cada valor, calcular esta fórmula no Excel: Z = (valor - média geral) / desvio padrão global.)

- Salve o sinal indicador de engajamento z-score em um arquivo CSV em MS Excel. (Clique em Arquivo / Salvar como ... e selecione CSV no tipo de formato.)

- Repetir o procedimento (a partir do passo 6.1.2.2.) Para cada participante.

- Importar dados de EEG em EEG software de análise de dados:

- Fisiologia:

- Importar dados EDA em software de análise de dados fisiológicos.

- Aplicar estes parâmetros pré-processar o sinal fisiológico:

- Aplicar uma transformação logarítmica a normalizar a distribuição da condutância como por Venables e Christie 23 método.

- Plano do sinal numa janela de 10 seg 24 deslizante.

- Dentro do software fisiológico, calcular uma normalização z-score com os dados de EDA para permitir a comparação intersubject. (Z = (valor - média geral) / desvio padrão global).

- Realce todos os dados com o cursor do canal EDA.

- No menu superior, selecione o canal EDA, e selecione "significa" para obter o valor médio do canal global. Também seleccionar o canal de EDA e "o desvio-padrão" para obter o valor do desvio padrão do canal global.

- Para calcular a equação z-score, clique em "Transformação / forma de onda matemática ..." e selecione o canal EDA na Fonte 1. Selecione "-" (menos) na janela de operação matemática e escolha K na fonte 2. Selecione "Novo destino" no menu de destino e insira o valor médio do canal EDA (veja o passo 6.2.3.2). Selecione "Transform onda inteira", clique em OK e clique em "Transformação / forma de onda matemática ...". Selecione o canal EDA-K na fonte 1, selecione "/" (dividir) na janela de operação matemática, selecione K na fonte 2, selecione "Novo destino" em destino e enter do valor do desvio padrão do canal de EDA (passo 6.2.3.2). Selecione "Transformar onda inteira" e clique em OK.

- Exportar o sinal (excitação) em um arquivo CSV. (Clique em Arquivo / Salvar como ... e selecione CSV no tipo de formato.)

- Automatic facial emoção reconhecimento:

- Importar dados de vídeo do gravador de mídia no software de reconhecimento facial automático emoção. (Clique em "Arquivo / Novo ... / participantes ...". Depois de selecionar um novo participante no menu projeto, clicando sobre ela, clique em "Arquivo / Novo / Análise / Video ...". Clique na lupa ao lado de Análise 1 e escolher o desejado arquivo de vídeo.

- Selecione uma análise offline para "cada terceira frame" e ative "calibração contínua".

- Exportar dados de valência em um arquivo CSV. (Clique em "Opções / Configurações / Logging ...", marque a opção "Escrever valor de valência para o arquivo de log" caixa. Clique em "Arquivo /Export ... ", escolha o local onde os arquivos de log serão exportados, e marque a opção" Salvar registro detalhado caixa ".)

- Abra o arquivo CSV em MS Excel. Copie a coluna de dados de valência em uma única coluna de software SPSS. Clique em "Analyse / Descriptives Estatísticas / Descriptives" e selecione o nome da variável recém-colado. Marque a caixa "Salvar valores padronizados em variáveis". Uma coluna com um z-score irá aparecer. Copie e cole esses escores z ao longo dos velhos dados no arquivo Excel.

- Salve o arquivo do Excel com os escores z do sinal (valência) em formato CSV.

- Importar dados de vídeo do gravador de mídia no software de reconhecimento facial automático emoção. (Clique em "Arquivo / Novo ... / participantes ...". Depois de selecionar um novo participante no menu projeto, clicando sobre ela, clique em "Arquivo / Novo / Análise / Video ...". Clique na lupa ao lado de Análise 1 e escolher o desejado arquivo de vídeo.

7. Data Integration e sincronização

- Em software de análise comportamental:

- Importação eye-tracking vídeos (de noivado comportamental). (Clique em "Arquivo / Importar / Video em uma nova observação ...". O nome do novo observação e escolha o arquivo de vídeo desejado.)

- Código cada vídeo com ser pertinentehaviors e eventos contextuais (marcadores de tempo, respostas certo / errado).

- Importar todos os dados externos com o cabeçalho apropriado: z-score do sinal EEG (envolvimento cognitivo), z-score de sinal EDA (envolvimento emocional), z-score de dados de valência (envolvimento emocional). (Clique em "Arquivo / Importar / dados externos ...". Selecione o tipo de arquivo apropriado e selecione o arquivo CSV correta.)

- Sincronizar o tempo entre os computadores de acordo com estas fórmulas:

- Tempo no olho olhar de vez em EEG = Tempo no olhar olho + segundo marcador no EEG - primeiro marcador no olhar olho.

- Tempo no olhar olho de vez em emoção facial reconhecimento = Tempo no olhar olho + primeiro marcador na emoção facial - primeiro marcador no olhar olho.

- Tempo no olho olhar de vez em atividade electrodermal = Tempo no olhar olho + primeiro marcador na atividade electrodermal - primeiro marcador no olhar olho.

- Digite os dados de correção pressionando "Ctrl + Shift + =221 ;, para abrir o menu de deslocamento. Selecione "deslocamento numérica" para entrar no tempo em segundos entre cada par de fontes de dados [OK?]), De acordo com os cálculos acima referidos.

- Gerar um relatório de acordo com as variáveis de interesse no estudo.

- Selecione variáveis interessantes que serão gerados no relatório (clique em "Analisar / Select Data / Novo Perfil de Dados ..."). A partir da esquerda, deslize as variáveis desejadas entre a caixa "Iniciar" e "Resultados" caixa, no lado direito.

- Gerar o relatório. (Clique em "Analisar / Análise Numérica / New ...", clique em "Estatísticas" e marque a caixa média no menu de dados externa. Concluir, clicando em "Calcular".)

- Exportar os dados para software de análise estatística e realizar a análise de acordo com os objetivos do estudo.

Access restricted. Please log in or start a trial to view this content.

Resultados

Figuras 2 e 3 mostram screenshots dos resultados da integração e sincronização dos dados de noivado comportamentais, emocionais e cognitivas em uma aplicação de software de análise comportamental. Em ambas as figuras, a seção da mão esquerda organiza os sujeitos da pesquisa e do esquema de codificação. Na seção do meio, um vídeo (com pontos vermelhos) mostra olhar olho do sujeito durante a tarefa. Engajamento comportamental do indivíduo pode ser inferida com base no que ele / ela e...

Access restricted. Please log in or start a trial to view this content.

Discussão

Em termos de etapas críticas no âmbito do protocolo, ele deve primeiro ser salientado que a qualidade dos dados é sempre o foco principal para técnicas de coleta de neurofisiológicos. Nesta metodologia, assistentes de investigação devem prestar especial atenção à instrução dos assuntos para minimizar movimentos da cabeça que irão interferir com a monitorização de valência (perdendo ângulo de face correta para a câmera) ou geram artefatos miográfica no EEG. Por outro lado, um equilíbrio deve ser mant...

Access restricted. Please log in or start a trial to view this content.

Divulgações

The authors have nothing to disclose.

Agradecimentos

The authors acknowledge the financial support of the Social Sciences and Humanities Research Council of Canada (SSHERC), Natural Sciences and Engineering Research Council of Canada (NSERC), Fonds de Recherche Nature et Technologies du Québec (FQRNT) and Fonds de Recherche sur la Société et Culture du Québec (FQRSC).

Access restricted. Please log in or start a trial to view this content.

Materiais

| Name | Company | Catalog Number | Comments |

| EGI GSN-32 | EGI | Dense array EEG | |

| Netstation v.5.0 | EGI | EEG data collection software: EEG is collected with 32-electrode dense array electroencephalography (dEEG) geodesic sensor net using Netstation acquisition software and EGI amplifiers (Electrical Geodesics, Inc). The vertex (recording site Cz) is the reference electrode for recording. Impedance is kept below 50 kΩ with a sampling rate of 250 Hz. | |

| Facereader v.4 | Noldus | Facial emotion recognition software | |

| Syncbox | Noldus | Syncbox start the co-registration of EEG and gaze data by sending a Transistor-Transistor Logic (TTL) signal to the EGI amplifier and a keystroke signal to the Tobii Studio v 3.2. | |

| Logitech C600 Webcam | 960-000396 | Webcam used to gather video data sent to mediarecorder and that will be analyzed in Facereader | |

| The Observer XT | Noldus | Integration and synchronization software: The Noldus Observer XT (Noldus Information Technology) is used to synchronize all behavioral, emotional and cognitive engagement data. | |

| On-Screen LED illumination | Noldus | Neon positioned on computer screen in order to correctly light the face of subjects | |

| MediaRecorder | Noldus | Video data collection software | |

| Tobii 60X | Tobii | Collect eye-movement patterns : used to record subjects’ eye movement patterns at 60Hz during the experiment. | |

| Tobii Studio v.3.2 | Tobii | Eye-tracking data collection and analysis software | |

| Analyzer 2 | Brainvision | EEG signal processing software | |

| Acqknowledge v.4.0 | Biopac | ACK100M | Physiological signal acquisition and processing software |

| Control III germicide solution | Maril Products. | 10002REVA-20002-1 | Disinfectant solution used with EEG helmets : recommended by EGI |

| Unipark | QuestBack AG | Online survey environment |

Referências

- Fredricks, J. A., Blumenfeld, P. C., Paris, A. H. School engagement: Potential of the concept, state of the evidence. Rev. Educ. Res. 74 (1), 59-109 (2004).

- Clark, R. C., Mayer, R. E. E-learning and the Science of Instruction. , Pfeiffer. San Francisco. (2011).

- Zhang, D., Zhou, L., Briggs, R. O., Nunamaker, J. F. Instructional video in e-learning: Assessing the impact of interactive video on learning effectiveness. Inform. Manage. 43 (1), 15-27 (2006).

- Freeman, F. G., Mikulka, P. J., Prinzel, L. J., Scerbo, M. W. Evaluation of an adaptive automation system using three EEG indices with a visual tracking task. Biol. Psychol. 50, 61-76 (1999).

- Glimcher, P., Rustichini, A. Neuroeconomics: The consilience of brain and decision. Science. 306 (5695), 447-452 (2004).

- Lieberman, M. D. Social Cognitive neuroscience: A review of core processes. Annu. Rev. Physiol. 58, 259-289 (2007).

- Pope, A. T., Bogart, E. H., Bartolome, D. S. Biocybernetic system evaluates indices of operator engagement in automated task. Biol. Psychol. 40 (1-2), 187-195 (1995).

- Physiological indicators for the evaluation of co-located collaborative play. Mandryk, R., Inkpen, K. CSCW '04 Proceedings of the 2004 ACM conference on Computer supported cooperative work, 2004 Nov 6-10, Chicago, IL, USA, , (2004).

- Allaire-Duquette, G., Charland, P., Riopel, M. At the very root of the development of interest: Using human body contexts to improve women’s emotional engagement in introductory physics. Eur. J. Phy. Ed. 5 (2), 31-48 (2014).

- Bradley, M. M., Lang, P. J. Measuring emotion: The self-assessment manikin and the semantic differential. J. Behav. Ther. Exp. Psy. 25 (1), 49-59 (1994).

- Lang, P. J. The emotion probe: Studies of motivation and attention. Am. Psychol. 50 (5), 372-385 (1995).

- Ekman, P., Felt Friesen, W. false, and miserable smiles. J. Nonverbal Behav. 6 (4), 238-252 (1982).

- Advances in face and gesture analysis. Van Kuilenburg, H., Den Uyl, M. J., Israël, M. L., Ivan, P. Proceedings of Measuring Behavior 2008, 2008 Aug 26-29, Maastricht, The Netherlands, , 371-372 (2008).

- Cacioppo, J., Tassinary, L. G., Berntson, G. G. Handbook of Psychophysiology. , Cambridge University Press. Cambridge, UK. (2007).

- Lubar, J. F., Swartwood, M. O., Swartwood, J. N., O’Donnell, P. H. Evaluation of the effectiveness of EEG neurofeedback training for ADHD in a clinical setting as measured by changes in T.O.V.A. scores, behavioral ratings, and WISC R performance. Biofeedback Self-reg. 20 (1), (1995).

- Mikulka, P. J., Freeman, F. G., Scerbo, M. W. Effects of a biocybernetic system on the vigilance decrement. Hum. factors. 44 (4), 654-664 (2002).

- Freeman, F. G., Mikulka, P. J., Scerbo, M. W., Scott, L. An evaluation of an adaptive automation system using a cognitive vigilance task. Biol. Psychol. 67 (3), 283-297 (2004).

- Chaouachi, M., Chalfoun, P., Jraidi, I., Frasson, C. Affect and mental engagement: Toward adaptability for intelligent systems. Proceedings of the Twenty-Third International Florida Artificial Intelligence Research Society Conference (FLAIRS 2010), Association for the Advancement of Artificial Intelligence. , 355-360 (2010).

- Courtemanche, F., Ortiz de Guinea, A., Titah, R., Fredette, M., Labonté-LeMoyne, É Precision is in the eye of the beholder: Application of eye fixation-related potentials to information systems research. J. Assoc. Inf. Syst. 15 (10), 651-678 (2014).

- Courtemanche, F., Ortiz de Guinea, A., Titah, R., Fredette, M., Labonté-Lemoyne, E. Applying eye fixation-related potentials to information systems research: Demonstration of the method during natural IS use and guidelines for research. J. Assoc. Inf. Syst. 15 (10), (2014).

- Courtemanche, F. Un outil d’évaluation neurocognitive des interactions humain-machine Doctoral thesis. , Université de Montréal. Montreal, QC. (2014).

- Assessing multiple dimensions of learner engagement during science problem solving using psychophysiological and behavioral measures. Charland, P., Léger, P. M., Mercier, J., Skelling-Desmeules, Y. Fourth Scientific International Symposium of the Association for Research in Neuroeducation, Caen, France, , (2014).

- Venables, P. H., Christie, M. J. Electrodermal activity. Techniques in Psychophysiology. Martin, I., Venables, P. , Wiley. Chichester, UK. 3-67 (1980).

- Electrodermal Activity. Boucsein, W. , 2nd ed, Springer. New York. (2012).

- Sarlo, M., Palomba, D., Buodo, G. M., Minghetti, R., Stegagno, L. Blood pressure changes highlight gender differences in emotional reactivity to arousing pictures. Biol. Psychol. 70 (3), 188-196 (2005).

- Martens, R. L., Gulikers, J., Bastiaens, T. The impact of intrinsic motivation on e-learning in authentic computer tasks. J. Comput. Assist. Lear. 20 (5), 368-376 (2004).

Access restricted. Please log in or start a trial to view this content.

Reimpressões e Permissões

Solicitar permissão para reutilizar o texto ou figuras deste artigo JoVE

Solicitar PermissãoThis article has been published

Video Coming Soon

Copyright © 2025 MyJoVE Corporation. Todos os direitos reservados