Un abonnement à JoVE est nécessaire pour voir ce contenu. Connectez-vous ou commencez votre essai gratuit.

Method Article

Conception et évaluation des lunettes actives de la prise alimentaire et de la Classification de l’activité physique

Dans cet article

Résumé

Cette étude présente un protocole de conception et de fabrication d’un dispositif portable de verres de type qui détecte les patrons de l’apport alimentaire et autres activités physiques recommandées, à l’aide de capteurs insérés dans les deux charnières des verres.

Résumé

Cette étude présente une série de protocoles de conception et de fabrication d’un dispositif portable de type lunettes qui détecte les patrons des activités musculaires temporalis pendant la prise de nourriture et d’autres activités physiques. Nous avons fabriqué un cadre 3D-imprimés de lunettes et un module de Conseil (PCB) de cellule intégrée de circuit imprimé de charge inséré dans les deux charnières du cadre. Le module a été utilisé pour acquérir les signaux de force et les transmettre sans fil. Ces procédures prévoient le système avec une plus grande mobilité, qui peut être évaluée en conditions pratiques de porter comme la marche et en agitant. Une représentation de la classification est également évaluée en distinguant les patrons de l’apport alimentaire de ces activités physiques. Une série d’algorithmes ont été utilisées pour prétraiter les signaux, générer des vecteurs de fonctionnalité et reconnaître les patrons de plusieurs vedette (mastication et un clin de œil) et autres activités physiques (reste sédentaire, parler et la marche). Les résultats ont montré que le score de1 moyenne F du classement parmi les activités recommandés était de 91,4 %. Nous croyons que cette approche peut être potentiellement utile pour la surveillance automatique et objective des comportements ingestive avec une précision plus élevée comme un moyen pratique pour traiter les problèmes.

Introduction

Un suivi continu et objective de l’apport alimentaire est essentiel au maintien de l’équilibre énergétique du corps humain, car l’accumulation d’énergie excessive peut causer des overweightness et l’obésité1, qui peut entraîner diverses complications médicales2. Les principaux facteurs dans le déséquilibre de l’énergie sont connus pour être les apport alimentaire excessif et une activité physique insuffisante,3. Diverses études sur le suivi de la dépense énergétique quotidienne ont été introduits avec mesure automatique et objective des patterns d’activité physique par le biais de dispositifs portables4,5,6, même à la consommateur final scène médicale et de niveau7. Recherche sur le suivi de la prise alimentaire, cependant, est toujours dans le cadre de laboratoire, car il est difficile de détecter l’activité de l’apport alimentaire d’une manière directe et objective. Ici, notre objectif est de présenter une conception de l’appareil et de son évaluation pour la surveillance de la consommation d’aliments et les patterns d’activité physique sur le plan pratique dans la vie quotidienne.

Il y a eu diverses approches indirectes pour surveiller la consommation alimentaire par le biais de mastication et déglutition sons8,9,10, mouvement du poignet11,12,13, image analyse14et électromyogramme (EMG)15. Cependant, ces approches ont été difficiles à appliquer aux demandes de la vie quotidienne, à cause de leurs limitations inhérentes : les méthodes en utilisant son risquaient d’être influencé par son environnement ; les méthodes utilisant le mouvement du poignet étaient difficiles à distinguer des autres activités physiques lors de la consommation non alimentaire ; et les méthodes en utilisant les images et les signaux EMG sont limités par la limite du mouvement et de l’environnement. Ces études ont montré la capacité de détection automatique de l’apport de nourriture à l’aide de capteurs, mais avaient encore une limitation de l’application pratique de la vie quotidienne au-delà des paramètres de laboratoire.

Dans cette étude, nous avons utilisé les tendances de l’activité de muscle temporalis comme le suivi automatique et objective de l’apport alimentaire. En général, le muscle temporalis répète la contraction et la relaxation dans le cadre des muscles masticateurs au cours de la nourriture prise16,17; ainsi, l’activité de l’apport alimentaire peut être surveillée en détectant les patrons périodiques de l’activité du muscle temporal. Récemment, il y a eu plusieurs études utilisant le temporalis muscle activité18,19,20,21, qui utilisaient les EMG ou un souche piézoélectrique capteur et les fixer directement sur l’homme peau. Ces approches, toutefois, étaient sensibles à l’emplacement de la peau des électrodes EMG ou capteurs de déformation et sont détachés facilement de la peau due au mouvement physique ou de la transpiration. Par conséquent, nous avons proposé une méthode nouvelle et efficace à l’aide d’une paire de lunettes ce sens les temporalis muscle activité grâce à deux capteurs insérés dans les deux charnières dans notre précédente étude22. Cette méthode a montré un grand potentiel de détection de l’activité de l’apport alimentaire avec une grande précision sans toucher la peau. C’est également non envahissant et non intrusive, puisque nous avons utilisé un dispositif commun de verres-type.

Dans cette étude, nous présentons une série de protocoles détaillés de la mise en œuvre de l’unité de verres-type et comment utiliser les modèles d’activité du muscle temporal pour la surveillance de l’apport alimentaire et l’activité physique. Les protocoles comprennent le processus de conception de matériel et de fabrication qui comprend un châssis 3D-imprimé les lunettes, un module de circuit et d’un module d’acquisition de données et comprennent les algorithmes logiciels de traitement de données et d’analyse. Nous avons par ailleurs étudié la classification parmi plusieurs activités recommandées (par exemple, à mâcher, la marche et un clin de œil) pour démontrer le potentiel comme un système pratique qui peut faire une différence minute entre l’apport alimentaire et toute autre activité physique patrons.

Protocole

Remarque : Toutes les procédures y compris l’utilisation de sujets humains ont été réalisées de manière non invasive de simplement porter une paire de lunettes. Toutes les données ont été acquises en mesurant le signal de force des capteurs insérés dans les verres qui n’étaient pas en contact direct avec la peau. Les données ont été transmises sans fil pour le module d’enregistrement des données, qui, dans ce cas est un smartphone désigné pour l’étude. Tous les protocoles n’étaient pas liés à in vivo/in vitro les études humaines. Aucun échantillon de sang et de médicaments ont été utilisés pour les expériences. Le consentement éclairé a été obtenu de tous les sujets des expériences.

1. fabrication d’un Module de Circuit capteur intégré

-

Acheter des composants électroniques pour la fabrication du module de circuit.

- Achetez deux cellules de pesage de bille, dont chacune opère dans une fourchette comprise entre 0 N et 15 N et délivre une puissance de basse tension différentielle avec portée maximale de mV 120 dans une excitation V 3.3.

NOTE : Ces charge cellules servent à mesurer force signaux à la fois les côtés gauche et droit des lunettes. - Achetez deux amplificateurs d’instrumentation et kΩ deux 15 résistances réglage de gain.

Remarque : L’amplificateur d’instrumentation et de la résistance réglage de gain sont utilisés pour amplifier le signal de la force de la cellule de pesage huit fois, jusqu'à 960 mV. - Acheter une unité de microcontrôleur (MCU) avec une fonctionnalité WiFi (par exemple, connectivité Wi-Fi) et un convertisseur analogique-numérique de 10 bits (ADC).

Remarque : Le MCU est utilisé pour lire les signaux de force et de les transmettre à un module d’acquisition de données sans fil. Comme une broche d’entrée analogique est utilisée pour deux entrées analogiques de force, l’utilisation d’un multiplexeur est introduite dans l’étape suivante 1.1.4. - Acheter un multiplexeur analogique deux voies qui gère les deux signaux d’entrée avec une broche de ADC sur la MCU.

- Acheter une batterie lithium-ion de polymère (LiPo) avec 3,7 V de tension nominale, 300 mAh de capacité nominale et le débit de 1 C.

Remarque : La capacité de la batterie a été choisie pour fournir assez de courant à l’heure plus de 200 mAh et faire fonctionner le système fiable pendant environ 1,5 h d’une expérience. - Acheter un régulateur de tension 3,3 V pour régulation linéaire à la baisse de la tension de batterie 3,7 V à la 3.3 V tension du système.

- Achat cinq 12 kΩ dispositifs montés en surface (SMD) type résistances comme les résistances de pull-up de la MCU. L’empreinte de la résistance est 2,0 x 1,2 mm (taille de 2012).

- Achetez deux cellules de pesage de bille, dont chacune opère dans une fourchette comprise entre 0 N et 15 N et délivre une puissance de basse tension différentielle avec portée maximale de mV 120 dans une excitation V 3.3.

-

Fabriquer des cartes de circuits imprimés (PCB). Cette étape est de dessiner les circuits imprimés et rendre l’oeuvre (c'est-à-dire, la disposition du Conseil d’administration, le fichier .brd) et le schéma (par exemple, le fichier .sch) pour les PCB de fabrication. Une compréhension de base du processus de création de fichiers de l’oeuvre et le schéma est nécessaire pour le développement.

- Dessiner un schéma d’un circuit de gauche contenant la batterie à l’aide d’une application de conception électronique tel qu’illustré dans la Figure 1 a. Sauvegardez le résultat comme les œuvres d’art (.brd) et fichiers de schéma (.sch).

- Dessiner un schéma d’un circuit de droit contenant le MCU à l’aide d’une application de conception électronique tel qu’illustré dans la Figure 1 b. Sauvegardez le résultat comme les œuvres d’art (.brd) et fichiers de schéma (.sch).

- Fabriquer les circuits imprimés en passant une commande auprès d’une société de fabrication de PCB.

- Souder tous les composants électroniques préparées à l’étape 1.1 pour les PCB comme illustré dans la Figure 2 et Figure 3.

ATTENTION : L’amplificateur d’instrumentation est très sensible à la température. Assurez-vous que la température de plomb ne dépasse pas 300 ° C pendant 10 s pendant le brasage, sinon il peut causer des dommages permanents au composant.

2. 3D impression d’une image des lunettes

- Dessiner le modèle 3D de la pièce de tête des verres à l’aide d’un outil de modélisation 3D comme sur la Figure 4 a. Exporter le résultat au format de fichier .stl.

- Dessiner le modèle 3D des temples gauche et à droite des verres à l’aide d’un outil de modélisation, comme illustré dans la Figure 4 b et 4 de la Figure3D. Exporter les résultats vers le format de fichier .stl.

- Imprimer les parties tête de morceau et temple à l’aide d’une imprimante 3D et un filament de fibre de carbone à 240 ° C, une température de buse et 80 ° C, une température de chambre.

Remarque : L’utilisation de n’importe quelle imprimante 3D commercial et tout types de filaments comme acrylonitrile butadiène styrène (ABS) et le polylactide (PLA) peut être autorisée. Les températures de la buse et le lit peuvent être réglées selon le filament et les conditions d’impression. - Chauffez les bouts des temples à l’aide d’une soufflerie d’air chaud d’un cadre de 180 ° C et plier vers l’intérieur environ 15 degrés pour contacter l’épiderme du muscle temporal comme verres classiques.

NOTE : Le degré de flexion du temple lunettes n’a pas besoin d’être rigoureux, étant donné que l’objectif de la courbure doit augmenter d’un facteur de forme en aidant les verres s’adapter sur la tête du sujet lorsqu’il est équipé. Être prudent, cependant, car un pliage excessif empêchera les temples de toucher le muscle temporal, qui ne permet pas de percevoir les tendances significatives. - Répétez les étapes de l’étape 2.1 – 2.4 pour imprimer deux différentes tailles de l’image de lunettes pour s’adapter à plusieurs tailles de siège tel qu’illustré à la Figure 4.

3. montage de toutes les parties des lunettes

- Insérer les PCB sur les deux côtés des temples des verres à l’aide de boulons M2, comme illustré à la Figure 5.

- Assembler la pièce de tête et les temples en insérant les boulons de M2 dans les articulations de la charnière.

- Connecter les BPC de gauche et de droite en utilisant les fils de raccordement 3 pôles, comme illustré à la Figure 5.

- Connectez la batterie sur le circuit gauche et attachez-la avec un ruban adhésif à la tempe gauche. Du côté de montage de la batterie n’est pas critique, puisqu’il peut varier selon la conception de circuits imprimés.

- Couvrir les verres avec les bandes de caoutchouc sur la pointe et le repose-nez pour ajouter plus de frottement avec la peau humaine tel qu’illustré à la Figure 5.

4. élaboration d’un système d’Acquisition de données

Remarque : Le système d’acquisition de données se compose d’une module et un module de réception de données de transmission de données. Le module de transmission de données lit le temps et la force des signaux des deux côtés et puis les envoie pour le module de réception de données, qui recueille les données reçues et les enregistre dans des fichiers .tsv.

-

Télécharger l’application pour le MCU du module PCB suivant les procédures de mesures 4.1.1–4.1.3 de transmission de données.

- Exécutez le projet « GlasSense_Server » attaché aux fichiers supplémentaires à l’aide d’un ordinateur.

Remarque : Ce projet a été généré avec Arduino environnement de développement intégré (IDE). Il permet de lire l’heure et la force des signaux avec 200 échantillons/s et les transmettre au module récepteur de données. - Branchez le module PCB à l’ordinateur via un connecteur de bus série universel (USB).

- Appuyez sur le bouton « Upload » sur l’IDE Arduino pour flasher les codes de programmation de l’étape 4.1.1 dans le microcontrôleur.

- Exécutez le projet « GlasSense_Server » attaché aux fichiers supplémentaires à l’aide d’un ordinateur.

-

Télécharger l’application de réception de données à un smartphone, qui sert à recevoir les données sans fil, suivant les procédures de mesures 4.2.1–4.2.3.

- Exécutez le projet « GlasSense_Client » attaché aux fichiers supplémentaires à l’aide d’un ordinateur.

Remarque : Ce projet a été généré avec c# langage de programmation. Il offre la possibilité de recevoir des données et enregistrer les fichiers .tsv, qui contiennent des informations d’un sujet, telles que nom, sexe, âge et indice de masse corporelle (IMC). - Brancher le smartphone à l’ordinateur via un port USB pour construire l’application de réception de données.

- Appuyez sur le bouton « Fichier > Build & Run » sur le projet c# pour créer l’application de réception de données sur le smartphone.

- Exécutez le projet « GlasSense_Client » attaché aux fichiers supplémentaires à l’aide d’un ordinateur.

5. collecte des données d’une étude de l’utilisateur

Remarque : Cette étude a recueilli six séries d’activité recommandés : reste sédentaire (SR), sédentaires à mâcher (SC), marche (W), mâcher tout en marchant (CW), parlant sédentaire (ST) et sédentaire clin d’oeil (SW).

- Sélectionnez une paire de lunettes qui ont une taille appropriée à l’utilisateur d’être testé. Affiner l’étanchéité avec les boulons à deux charnières (Figure 5).

ATTENTION : Les valeurs de force, ne doivent pas dépasser 15 N, étant donné que les capteurs de force utilisées dans cette étude peuvent perdre la caractéristique linéaire bien au-delà de la portée de l’opération. Les valeurs de force peuvent être affinés en desserrant ou le support de serrage des boulons. -

Compte rendu des activités de tous les sujets en appuyant sur le bouton « Enregistrer » sur l’application construites en étape 4.2.3.

- Enregistrer une activité pendant un bloc de 120 s et générer un fichier d’enregistrement de celui-ci.

- Dans le cas de SR, s’asseoir le sujet sur une chaise et les faire utiliser un téléphone intelligent ou lire un livre. Permettre le déplacement de la tête, mais éviter tout mouvement du corps entier.

- Dans les cas de SC et CW, ont les sujets mangent deux types de texture des aliments (pain grillé et gelée de mastication) afin de tenir compte des propriétés de différents aliments. Servir le pain en tranches de 20 mm x 20 mm, qui est une bonne taille pour manger.

- Dans le cas de W, ont les sujets marcher à une vitesse de 4,5 km/h sur un tapis roulant.

- Dans le cas de ST, les sujets s’asseoir et ont leur lire un livre à haute voix dans un ton normal et la vitesse.

- Dans le cas de SW, informer les sujets de clin d’oeil sur le calendrier d’un son de cloche de 0,5 s à long toutes les 3 s.

- Générer un fichier d’enregistrement au format .tsv des données recueillies à l’étape 5.2.1.

Remarque : Ce fichier contient une séquence de l’époque où les données ont été reçues, un signal de force gauche, un signal de bonne vigueur et une étiquette représentant l’activité actuelle du visage. Visualisations des signaux temporels de toutes les activités dans un bloc d’un utilisateur sont représentées dans la Figure 6. Les six séries d’activité recommandés (SR, SC, W, CW, ST et SW) ont été étiquetés comme 1, 2, 3, 4, 5 et 6, respectivement. Les étiquettes ont été utilisées pour comparer les classes prévues à l’article 8 du protocole. - Faites une pause de 60 s après le bloc d’enregistrement. Enlever les lunettes pendant la pause et re-porter à nouveau lors du redémarrage de l’enregistrement de bloc.

- Répéter l’ensemble bloc sectionneurs des étapes 5.2.1 et 5.2.2 quatre fois pour chaque activité.

- Dans le cas de SW, avoir l’objet clin d’oeil à plusieurs reprises avec le œil gauche au cours d’un seul bloc et alors clin d’oeil à plusieurs reprises avec le œil droit pendant le prochain bloc.

- Enregistrer une activité pendant un bloc de 120 s et générer un fichier d’enregistrement de celui-ci.

- Répétez les étapes 5.1-5.2 et collecter les données provenant de 10 sujets. Dans cette étude, nous avons utilisé cinq mâles et cinq femelles, l’âge moyen était de 27,9 ± 4,3 (écart-type ; s.d.) ans, qui se situait à 19 à 33 ans, et l’IMC moyen était de 21,6 ± 3.2 (s.d.) kg/m2, qui se situait à 17,9 – 27,4 kg/m2.

Remarque : Dans cette étude, les sujets n’ayant pas des conditions médicales à broyer les aliments, clin d’oeil et à pied ont été recrutés, et cette condition a été utilisée pour les critères d’inclusion.

6. signal de prétraitement et Segmentation

Remarque : Les signaux de gauche et de droite sont calculés séparément dans les procédures suivantes.

-

Préparer une série d’images temporelles de 2 s long.

- Segment la 120 s enregistré signaux en un ensemble de 2 cadres de s par les sauts à intervalle de 1 s à l’aide de MATLAB, comme illustré à la Figure 6.

Remarque : Les segmentation images de 2 s long ont été utilisées pour extraire des caractéristiques à l’article 7. La taille de saut s 1 a été déterminée pour diviser des signaux par l’intervalle de clin d’oeil s 3 déjà mentionné à l’étape 5.2.1. - Appliquer un filtre passe-bas (LPF), à l’aide d’un filtre de Butterworth 5ème ordre avec une fréquence de coupure de 10 Hz pour chaque image.

- Enregistrer les résultats de l’étape 6.1.2 comme les cadres temporels pour les prochaines étapes de l’étape 7.1.

- Segment la 120 s enregistré signaux en un ensemble de 2 cadres de s par les sauts à intervalle de 1 s à l’aide de MATLAB, comme illustré à la Figure 6.

-

Préparer une série d’images spectrales.

- Soustrayez la valeur médiane des signaux originaux de chaque image pour enlever la précharge lorsque vous portez les lunettes.

Remarque : La valeur de précharge n’est pas requise pour l’analyse des fréquences suivantes, car il ne comprend pas toute information sur la mastication, à pied, clin d’oeil, etc. il pourrait, cependant, contiennent des informations importantes, qui peuvent varier de sous réserve de l’objet, de chaque réglage des lunettes et même à partir du moment où un sujet porte des lunettes. - S’appliquent à une fenêtre de Hanning à chaque cadre pour réduire une fuite spectrale sur l’analyse des fréquences.

- Produire et enregistrer un spectre unilatéral en appliquant une transformation de Fourier rapide (FFT) à chaque image.

- Soustrayez la valeur médiane des signaux originaux de chaque image pour enlever la précharge lorsque vous portez les lunettes.

- Définit une combinaison d’un temporel et un cadre spectral de la même époque comme un bloc d’image (ou une simple image).

7. génération des vecteurs de la fonction

Remarque : Un vecteur caractéristique est généré par l’image produite à l’article 6 du protocole. Les images gauche et droite sont calculés séparément et combinés en un vecteur caractéristique dans les procédures suivantes. Toutes les procédures ont été mises en œuvre dans MATLAB.

- Extraire des caractéristiques statistiques à un cadre temporel à l’étape 6.1 du protocole. Une liste du nombre total de 54 fonctions est donnée dans le tableau 1.

- Extraire des caractéristiques statistiques d’une image spectrale dans étape 6.2 du protocole. Une liste du nombre total de 30 caractéristiques est donnée dans le tableau 2.

- Générer un vecteur caractéristique 84-dimensionnelle en combinant les caractéristiques temporelles et spectrales ci-dessus.

- Étiqueter les vecteurs de fonction généré depuis les enregistrements à l’étape 5.2 du protocole.

- Répétez les étapes des étapes 7.1 à 7.4 pour tous les blocs de trame et générer une série de vecteurs de fonctionnalité.

8. classification des activités en Classes

Remarque : Cette étape consiste à sélectionner le modèle de classificateur d’un support vector machines (SVM)23 en déterminant les paramètres qui montrent la plus grande précision du problème donné (c.-à-d., les vecteurs de fonctionnalité). Le MVC est une machine supervisée connue apprentissage technique, qui montre les excellentes performances en généralisation et robustesse à l’aide d’une marge maximum entre les classes et une fonction de noyau. Nous avons utilisé une grille-recherche et une méthode de validation croisée pour définir un paramètre de pénalité C et un noyau paramètre γ de l’amande de fonction (RBF) base radiale. Une compréhension minimale de l’apprentissage des techniques et la SVM machine est nécessaire pour effectuer les procédures suivantes. Certains matériaux référentielle23,24,25 sont recommandés pour une meilleure compréhension de l’apprentissage de techniques et l’algorithme SVM machine. Toutes les procédures dans cette section ont été implémentées à l’aide de LibSVM25 progiciel.

- Définir une grille de paires de (C, γ) pour la recherche-grille. Utilisation en croissance exponentielle des séquences de C (2-10, 2-5,..., 230) et γ (2-30, 2-25,..., 210).

NOTE : Ces séquences ont été déterminés de manière heuristique. - Définir une paire de (C, γ) (p. ex., (2-10, 2-30)).

-

Pour le réseau défini à l’étape 8.2, effectuez le schéma de validation croisée 10 fois.

NOTE : Ce mode divise les vecteurs de toute fonctionnalité en 10 parties sous-ensembles, puis tester un sous-ensemble à partir du modèle de classificateur formé par les autres sous-ensembles et répéter sur tous les sous-ensembles, un par un. Par conséquent, chaque vecteur caractéristique peut être testés séquentiellement.- Diviser les vecteurs de toute fonctionnalité en sous-ensembles de 10 épisodes.

- Définir un jeu de test d’un sous-ensemble et une formation de 9 autres sous-ensembles.

- Définir un vecteur d’échelle que les échelles de tous les éléments des vecteurs caractéristique à la gamme de [0, 1] pour l’ensemble de la formation.

Remarque : Le vecteur d’échelle a de même dimension avec le vecteur caractéristique. Il consiste en un ensemble de multiplicateurs capable d’évoluer de la même ligne (ou colonne) de tous les vecteurs de la fonctionnalité à la gamme de [0, 1]. Par exemple, le premier long métrage d’un vecteur caractéristique est linéairement proportionnelle à la gamme de [0, 1] pour les premiers éléments tous les vecteurs de dispositif de formation. Notez que le vecteur d’échelle est défini à partir de l’ensemble de la formation, car le jeu de test doit être considérés comme étant inconnu. Cette étape augmente la précision de la classification en apportant les fonctionnalités la gamme égale et en évitant les erreurs numériques pendant le calcul. - Chaque caractéristique de la formation, mettre sur la plage de l’échelle [0, 1] en utilisant le vecteur d’échelle obtenu à l’étape 8.2.3.

- Chaque caractéristique de l’essai, mettre sur la plage de l’échelle [0, 1] en utilisant le vecteur d’échelle obtenu à l’étape 8.2.3.

- Former l’ensemble de la formation par le biais de la SVM avec la paire de défini à l’étape 8.2 (c, γ) et ensuite construire un modèle de classificateur.

- Tester le jeu de test par le biais de la SVM avec la paire définie (c, γ) dans l’étape 8.2 et le modèle de classificateur provenant de la procédure de formation.

- Calculer une précision de la classification sur le jeu de test. L’exactitude a été calculée à partir du pourcentage de vecteurs de fonctionnalité qui sont correctement classées.

- Répétez les étapes 8.2.2–8.2.8 pour tous les sous-ensembles et calculer la précision moyenne de tous les sous-ensembles.

- Répétez les étapes 8.2 – 8.3.9 pour tous les points de la grille d’une paire de (C, γ).

- Trouver le maximum local de la plus grande précision de la grille. Toutes les procédures de l’article 8 sont illustrées à la Figure 7.

- (Facultatif) Si l’étape de la grille est considéré comme grosse, répétez les étapes 8.1 à 8.5 dans une grille plus fine près du maximum local trouvent à l’étape 8,5 et trouver de nouveaux locaux au maximum la grille fine.

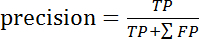

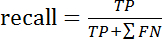

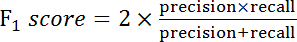

- Calculer la précision, le rappel et la note1 F de chaque catégorie d’activités de l’équation suivante :

Équation 1

Équation 1 Équation 2

Équation 2 Équation 3

Équation 3

où TP, FP et FN représentent vrais positifs, faux positifs et faux négatifs pour chaque activité, respectivement. La matrice de confusion de toutes les activités est donnée dans le tableau 3.

Résultats

Par le biais de la procédure décrite dans le protocole, nous avons préparé deux versions de l’image 3D imprimée en différenciant la longueur de la pièce de tête, LH (133 et 138 mm) et les temples, LT (110 et 125 mm), comme illustré à la Figure 4. Par conséquent, nous pouvons couvrir plusieurs conditions de port, qui peuvent varier de la taille de la tête des sujets, forme, etc. que les sujets a choisi l’un des ca...

Discussion

Dans cette étude, nous avons proposé tout d’abord la conception et la fabrication des verres qui détectent les patrons de consommation d’aliments et d’activités physiques. Comme cette étude principalement axée sur l’analyse des données de distinguer l’apport alimentaire des autres activités physiques (comme la marche et un clin de œil), le système d’acquisition de données et capteur requis la mise en œuvre de l’enregistrement de la mobilité. Ainsi, le système comprenait les capteurs, le MCU av...

Déclarations de divulgation

Les auteurs n’ont rien à divulguer.

Remerciements

Ce travail a été soutenu par Envisible, Inc. Cette étude a été également soutenue par une subvention de la Korean Health Technology R & D Project, ministère de la santé bien-être, République de Corée (HI15C1027). Cette recherche a été financée également par la Fondation nationale de recherche de Corée (FRO-2016R1A1A1A05005348).

matériels

| Name | Company | Catalog Number | Comments |

| FSS1500NSB | Honeywell, USA | Load cell | |

| INA125U | Texas Instruments, USA | Amplifier | |

| ESP-07 | Shenzhen Anxinke Technology, China | MCU with Wi-Fi module | |

| 74LVC1G3157 | Nexperia, The Netherlands | Multiplexer | |

| MP701435P | Maxpower, China | LiPo battery | |

| U1V10F3 | Pololu, USA | Voltage regulator | |

| Ultimaker 2 | Ultimaker, The Netherlands | 3D printer | |

| ColorFabb XT-CF20 | ColorFabb, The Netherlands | Carbon fiber filament | |

| iPhone 6s Plus | Apple, USA | Data acquisition device | |

| Jelly Belly | Jelly Belly Candy Company, USA | Food texture for user study |

Références

- Sharma, A. M., Padwal, R. Obesity is a sign-over-eating is a symptom: an aetiological framework for the assessment and management of obesity. Obes Rev. 11 (5), 362-370 (2010).

- Pi-Sunyer, F. X., et al. Clinical guidelines on the identification, evaluation, and treatment of overweight and obesity in adults. Am J Clin Nutr. 68 (4), 899-917 (1998).

- McCrory, P., Strauss, B., Wahlqvist, M. L. Energy balance, food intake and obesity. Exer Obes. , (1994).

- Albinali, F., Intille, S., Haskell, W., Rosenberger, M. . Proceedings of the 12th ACM international conference on Ubiquitous computing. , 311-320 (2010).

- Bonomi, A., Westerterp, K. Advances in physical activity monitoring and lifestyle interventions in obesity: a review. Int J Obes. 36 (2), 167-177 (2012).

- Jung, S., Lee, J., Hyeon, T., Lee, M., Kim, D. H. Fabric-Based Integrated Energy Devices for Wearable Activity Monitors. Adv Mater. 26 (36), 6329-6334 (2014).

- Fulk, G. D., Sazonov, E. Using sensors to measure activity in people with stroke. Top Stroke Rehabil. 18 (6), 746-757 (2011).

- Makeyev, O., Lopez-Meyer, P., Schuckers, S., Besio, W., Sazonov, E. Automatic food intake detection based on swallowing sounds. Biomed Signal Process Control. 7 (6), 649-656 (2012).

- Päßler, S., Fischer, W. Food intake activity detection using an artificial neural network. Biomed Tech (Berl). , (2012).

- Passler, S., Fischer, W. -. J. Food intake monitoring: Automated chew event detection in chewing sounds. IEEE J Biomed Health Inform. 18 (1), 278-289 (2014).

- Kadomura, A., et al. . CHI'13 Extended Abstracts on Human Factors in Computing Systems. , 1551-1556 (2013).

- Fontana, J. M., Farooq, M., Sazonov, E. Automatic ingestion monitor: A novel wearable device for monitoring of ingestive behavior. IEEE Trans Biomed Eng. 61 (6), 1772-1779 (2014).

- Shen, Y., Salley, J., Muth, E., Hoover, A. Assessing the Accuracy of a Wrist Motion Tracking Method for Counting Bites across Demographic and Food Variables. IEEE J Biomed Health Inform. , (2016).

- Farooq, M., Sazonov, E. . International Conference on Bioinformatics and Biomedical Engineering. , 464-472 (2017).

- Grigoriadis, A., Johansson, R. S., Trulsson, M. Temporal profile and amplitude of human masseter muscle activity is adapted to food properties during individual chewing cycles. J Oral Rehab. 41 (5), 367-373 (2014).

- Strini, P. J. S. A., Strini, P. J. S. A., de Souza Barbosa, T., Gavião, M. B. D. Assessment of thickness and function of masticatory and cervical muscles in adults with and without temporomandibular disorders. Arch Oral Biol. 58 (9), 1100-1108 (2013).

- Standring, S. . Gray's anatomy: the anatomical basis of clinical practice. , (2015).

- Farooq, M., Sazonov, E. A novel wearable device for food intake and physical activity recognition. Sensors. 16 (7), 1067 (2016).

- Zhang, R., Amft, O. . Proceedings of the 2016 ACM International Symposium on Wearable Computers. , 50-52 (2016).

- Farooq, M., Sazonov, E. Segmentation and Characterization of Chewing Bouts by Monitoring Temporalis Muscle Using Smart Glasses with Piezoelectric Sensor. IEEE J Biomed Health Inform. , (2016).

- Huang, Q., Wang, W., Zhang, Q. Your Glasses Know Your Diet: Dietary Monitoring using Electromyography Sensors. IEEE Internet of Things Journal. , (2017).

- Chung, J., et al. A glasses-type wearable device for monitoring the patterns of food intake and facial activity. Scientific Reports. 7, 41690 (2017).

- Cristianini, N., Shawe-Taylor, J. . An introduction to support Vector Machines: and other kernel-based learning methods. , (2000).

- Giannakopoulos, T., Pikrakis, A. . Introduction to Audio Analysis: A MATLAB Approach. , (2014).

- Chang, C. -. C., Lin, C. -. J. LIBSVM: a library for support vector machines. ACM Trans Intell Syst Technol. 2 (3), 27 (2011).

- Po, J., et al. Time-frequency analysis of chewing activity in the natural environment. J Dent Res. 90 (10), 1206-1210 (2011).

- Ji, T. Frequency and velocity of people walking. Struct Eng. 84 (3), 36-40 (2005).

- Knoblauch, R., Pietrucha, M., Nitzburg, M. Field studies of pedestrian walking speed and start-up time. Transp Res Red. 1538, 27-38 (1996).

Réimpressions et Autorisations

Demande d’autorisation pour utiliser le texte ou les figures de cet article JoVE

Demande d’autorisationThis article has been published

Video Coming Soon