需要订阅 JoVE 才能查看此. 登录或开始免费试用。

Method Article

基于计算机视觉的入侵植物生物量估算

摘要

我们报告了一种入侵植物生物量估算方法的详细程序,该方法利用从无人机 (UAV) 遥感获得的数据来评估生物量并捕获入侵物种的空间分布。事实证明,这种方法对进行入侵植物的危害评估和早期预警非常有益。

摘要

我们报告了一种基于无人机遥感和计算机视觉估计入侵植物生物量的方法的详细步骤。为了从研究区域收集样本,我们准备了一个样本方形组件来随机化采样点。使用无人机和相机构建了无人航空相机系统,通过自动导航获取研究区域的连续 RGB 图像。完成拍摄后,收集样本框内的地上生物量,并对所有对应物进行标记和包装。处理样本数据,并将航拍图像分割成 280 x 280 像素的小图像以创建图像数据集。采用深度卷积神经网络绘制研究区 薇甘菊 的分布图,得到其植被指数。将收集的生物体干燥,并将干重记录为真实生物量。使用 K 最近邻回归 (KNNR) 构建入侵植物生物量回归模型,方法是从样本图像中提取植被指数作为自变量,并将其与真实生物量作为因变量整合。结果表明,可以准确预测入侵植物的生物量。通过图像遍历生成入侵植物生物量的准确空间分布图,从而可以精确识别受入侵植物影响的高风险区域。总之,这项研究证明了将无人机遥感与机器学习技术相结合以估计入侵植物生物量的潜力。它为实时监测入侵植物的新技术和新方法的研究做出了重大贡献,并为区域范围内的智能监测和危害评估提供了技术支持。

引言

在该协议中,所提出的基于无人机遥感和计算机视觉的入侵生物量估计方法可以反映入侵生物的分布并预测入侵生物危害的程度。估计入侵生物的分布和生物量对于预防和控制这些生物至关重要。一旦入侵植物入侵,它们就会破坏生态系统并造成巨大的经济损失。快速准确地识别入侵植物并估计关键的入侵植物生物量是入侵植物监测和控制的主要挑战。本文以 薇甘菊 为例,探索一种基于无人机遥感和计算机视觉的入侵植物生物量估算方法,为入侵植物的生态学研究提供了新的途径和方法,促进了入侵植物的生态学研究与管理。

目前, 薇甘菊 的生物量测量主要通过人工采样1.传统的生物量测量方法需要大量的人力和物力资源,效率低下且受地形限制;难以满足 薇甘菊 区域生物量估算的需要。使用该协议的主要优点是它提供了一种量化区域入侵植物生物量和入侵植物空间分布的方法,该方法不考虑该地区的采样限制,并且无需人工调查。

无人机遥感技术在植物生物量估算方面取得了一定的成果,并已广泛应用于农业 2,3,4,5,6,7,林业 8,9,10,11 和草原 12,13,14.无人机遥感技术具有成本低、效率高、精度高、操作灵活等优点15,16,可以高效获取研究区遥感影像数据;然后,提取遥感影像的纹理特征和植被指数,为大面积植物生物量估算提供数据支持。目前的植物生物量估算方法主要分为参数模型和非参数模型17。随着机器学习算法的发展,具有更高准确性的非参数机器学习模型已广泛应用于植物生物量的遥感估计。Chen 等人 18 利用混合 logistic 回归 (MLR)、KNNR 和随机森林回归 (RFR) 来估计云南省森林的地上生物量。他们得出结论,与 MLR 相比,机器学习模型,特别是 KNNR 和 RFR,产生了更好的结果。Yan 等人19 采用 RFR 和极端梯度提升 (XGBR) 回归模型来评估使用各种变量集估计亚热带森林生物量的准确性。Tian 等人20 利用 11 个机器学习模型来估计北部湾不同红树林物种的地上生物量。研究人员发现,XGBR 方法在确定红树林的地上生物量方面更有效。使用人机遥感进行植物生物量估算是一种成熟的做法,然而,使用无人机对入侵植物 Mikania micrantha 进行生物量估算在国内外尚未报道。这种方法与以前所有入侵植物的生物量估算方法根本不同,尤其是 Mikania micrantha。

综上所述,无人机遥感具有分辨率高、效率高、成本低等优点。在遥感影像的特征变量提取中,纹理特征结合植被指数可以获得较好的回归预测性能。在植物生物量估计中,非参数模型可以获得比参数模型更准确的回归模型。因此,为了精确计算入侵植物的零分布及其生物量,我们建议以下概述的入侵植物生物量实验程序,该实验依赖于使用无人机和计算机视觉的遥感。

研究方案

1. 数据集的准备

- 选择研究对象

- 根据实验研究的重点选择测试样品,考虑 Mikania micrantha 或其他入侵植物等选项。

- 收集 UAV 图像

- 根据研究区域的大小,准备 0.5 m*0.5 m 的方形塑料框架,数量为 25-50。

- 采用随机采样方法,使用足够数量的生物量样本确定研究区域中的土壤采样位置。将样品框架水平放置在植被上,完全包围植物,每株植物之间的最小间隔距离为 2 m。

- 使用无人机和相机组成无人机遥感拍摄系统,如图 1 所示。

- 使用 UAV 在指定的研究区域内绘制路线。路线规划设置如图 2 所示。

- 建立 70% 的航向侧重叠率,以 2 s 的均匀时间间隔拍摄照片,保持相机角度垂直于地面 90°,并将相机高度定位在 30 m。这导致研究区域的连续可见图像数据,单个图像分辨率为 8256 x 5504 像素,如图 3 所示。

- 存储航空影像,以便使用 Python 软件进行后续处理以进行生物量估算。

- 收集地上生物量

- 完成无人机数据收集后,在每个样品地中手动收集 Mikania micrantha 的地上生物量。将它们装袋并相应地为每个袋子贴上标签。

- 收集 Mikania micrantha 时,防止样品地块移动。首先,沿着样品图的内边缘切割 Mikania micrantha 。

- 然后,从底部切下 Mikania micrantha 的根茎。清除任何混入的污垢、岩石或其他植物。最后,将样品装袋并贴上标签。

- 将步骤 1.3.1 中收集的入侵植物样本带到实验室。将所有收集的样品风干以蒸发大部分水分。

- 要进一步去除风干样品中的水分,请使用烘箱。将温度设置为 55 °C。 将样品干燥 72 小时,然后在电子天平上称量每个样品,并以克 (g) 为单位记录生物量数据。

- 将电子天平置于不受干扰的环境中,称量、校准并继续称量。将袋子的 Mikania micrantha 放在电子天平上,等待读数稳定,然后记录读数。

- 每小时称量一次 Mikania micrantha ,直到质量不再变化,并将读数减去袋子的重量记录为该样品的测量质量。使用以下公式计算入侵植物的地上生物量:

其中 B 代表 Mikania micrantha 的生物量,以克/平方米 (g/m2) 为单位,M 是测量的 Mikania micrantha 的重量,以克 (g) 为单位,S 对应于样品地的面积,以平方米 (m2) 为单位。

- 完成无人机数据收集后,在每个样品地中手动收集 Mikania micrantha 的地上生物量。将它们装袋并相应地为每个袋子贴上标签。

- 创建数据集

- 从原始无人机图像中提取样本图像对应的 RGB 图像。使用 Python 编程将其划分为 280 × 280 像素的网格(补充图 1)。

- 使用 Python 编程将原始图像数据分割为与示例图像大小相同的较小图像。使用滑动窗口方法进行分割,将水平和垂直步长设置为 280 像素。

- 从步骤 1.4.2 中分割的小图像中,随机选择 880 张入侵植物图像和 1500 张背景图像来创建数据集。然后,以 6:2:2 的比例将此数据集拆分为训练集、验证集和测试集(Supplementray 图 2)。

2. Mikania micrantha 的鉴定

- 准备软件

- 前往 Anaconda 的官方网站 (https://www.anaconda.com/) 下载并安装 Anaconda。然后,前往 PyCharm 的网站 (https://www.jetbrains.com/pycharm/) 并下载 PyCharm IDE。

- 创建 Conda 环境。

- 安装 Anaconda 后打开 Anaconda Prompt 命令行,然后键入 conda create -n pytorch python==3.8 以创建新的 Conda 环境。创建环境后,输入 conda info --envs 以确认 pytorch 环境存在。

- 打开 Anaconda 提示符,然后输入 conda activate pytorch 激活 pytorch 环境。键入 nvidia-smi 检查当前 (Compute Unified Device Architecture) CUDA 版本。然后,通过运行命令安装 PyTorch 版本 1.8.1 conda install pytorch==1.8.1 torchvision==0.9.1 torchaudio==0.8.1 cudatoolkit=11.0 -c pytorch。

- 用于模型识别的运行

注意:使用 PyTorch 构建 Mikania micrantha 本文中使用的识别模型。采用的网络模型是 ResNet10121,该论文的架构与原始论文保持一致。对网络的输出部分进行了修改,以满足洋甘菊识别的要求。- 预处理图像以准备用于模型输入。使用以下代码将图像的大小从 280 x 280 像素调整为 224 x 224 像素,并对其进行标准化,以确保它们满足模型的大小要求:

transform = 转换。Compose([

变换。调整大小((224, 224)),

变换。ToTensor() 的

变换。标准化([0.485, 0.456, 0.406], [0.229, 0.224, 0.225])]) - 使用卷积神经网络执行图像特征提取并降维。

- 首先,通过 self.conv1 初始化初始特征提取的卷积层。通过这个卷积层,原始图像被卷积成一个特征图,该特征图具有self.in_channel通道,用于提取初始特征(补充图 3A)。

注意:高级特征是在对残差传递的卷积操作中提取的。这些层是通过调用 _make_layer 函数生成的,该函数由一系列残差块组成。每个残差块由卷积、批量归一化和激活函数组成,以逐渐提取复杂的特征(补充图 3B)。 - 使用该层的函数修改通道号,以便通过 1x1 卷积进行降维。此操作减少了计算负载,同时保留了重要的特征(补充图 3C)。

注意:总体而言,ResNet101 通过使用各种卷积层执行特征提取,并通过残差块内的 1x1 卷积层实现降维。这种方法使网络能够更深入地学习特征并避免梯度消失的问题,从而能够更有效地学习和表示复杂任务的图像特征。 - 经过卷积和池化操作后,将高质量特征输入到全连接层中。

注意:在 ResNet 架构中,特征提取发生在卷积层中。这些特征随后被发送到全连接 (FC) 层进行分类(补充图 4)。操作 self.avgpool(x) 执行自适应平均池化,以将张量重塑为固定大小。操作 torch.flatten(x, 1) 将张量扩展为一维向量, self.fc(x) 将全连接层应用于展平向量,最终作为分类的最后一步。此过程有效地将提取的特征通过卷积层,通过全连接层将它们转换为适合分类的格式。 - 使用 Softmax 函数根据三个分类要求获取最终输出。

- 首先,通过 self.conv1 初始化初始特征提取的卷积层。通过这个卷积层,原始图像被卷积成一个特征图,该特征图具有self.in_channel通道,用于提取初始特征(补充图 3A)。

- 使用步骤 1.4 中的数据集训练多类识别模型。将迭代次数设置为 200,初始学习率为 0.0001。每 10 次迭代将学习率降低 1/3,批处理大小为 64。每次迭代后自动保存最佳模型参数(补充图 5)。

- 采用经过精心训练的识别模型,并系统地遍历步骤 1.2.2 中的原始图像以进行识别。

- 在 280 像素处精确配置水平和垂直步长,从而生成一个全面的分布图,突出显示研究区域边界内入侵植物群的存在。直观地显示所选结果,如图 4 所示。

注意:初始图像的预处理方式是将其分割成更小的块,使用经过训练的深度学习模型对每个块进行分类,然后将结果组合成输出图像。如果将区块分类为入侵植物,则输出图像上的相应位置将设置为 255。生成的输出图像将保存为灰度图像文件。具体的实现代码如 补充图 6 所示。

- 在 280 像素处精确配置水平和垂直步长,从而生成一个全面的分布图,突出显示研究区域边界内入侵植物群的存在。直观地显示所选结果,如图 4 所示。

- 预处理图像以准备用于模型输入。使用以下代码将图像的大小从 280 x 280 像素调整为 224 x 224 像素,并对其进行标准化,以确保它们满足模型的大小要求:

3. 入侵植物生物量的估算

- 使用 RandomResizedCrop 和 RandomHorizontalFlip 函数(补充图 7)执行简单的数据增强,以扩展在步骤 1.2 中创建的图像集,并提取通常用于估计生物量的六种植被指数,即 RBRI、GBRI、GRRI、RGRI、NGBDI 和 NGRDI。这些指数的计算公式见 表 1 。

- 使用模型的输出创建 K 最近邻回归 (KNNR)22 模型,以确保精确估计入侵植物的生物量。使用提取的植被指数作为估计模型的输入。

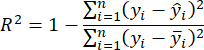

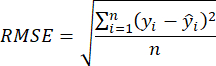

- 使用决定系数 R2 和均方根误差 (RMSE)23 来评估模型的准确性,计算方法如下:

注意:K 最近邻回归 (KNNR) 算法是一种用于解决回归问题的非参数机器学习技术。其基本概念是通过根据输入样本距离确定特征空间中最近的 K 个相邻要素来预测结果。使用 KNNR 的主要好处包括其简单性和易于理解性,并且不需要培训阶段。此外,KNNR 不会对数据的分布做出过多的假设。KNNR 可应用于回归问题,以预测连续客观变量并精确评估入侵植物的生物量。 - 使用步骤 3.2 中选择的地上生物量估计模型,并以 280 像素的水平和垂直步幅扫描步骤 2.3.4 中的入侵植物分布图。

结果

我们展示了一种基于计算机视觉的入侵植物估计方法的代表性结果,该方法在计算机上以编程方式实现。在本实验中,我们以 Mikania micrantha 为研究对象,评估了入侵植物在其自然栖息地的空间分布并估计了其生物量。我们利用无人机相机系统来获取研究地点的图像,其中一部分如图 3 所示。我们利用 ResNet101 卷积神经网络来识别研究区域内的植物。随后,我们绘制了?...

讨论

我们介绍了使用无人机遥感和计算机视觉估算入侵植物生物量的实验的详细步骤。该协议的主要流程和步骤如图 7 所示。适当的样本质量是该计划最关键和最具挑战性的方面之一。这种重要性适用于所有入侵植物以及任何其他植物生物量估计实验24。

为了确定研究区域内入侵植物的分布,我们必须首先使用无人机遥感获取研究区域的可...

披露声明

作者没有什么可披露的。

致谢

作者感谢中国农业科学院和广西大学对这项工作的支持。这项工作得到了中国国家重点研发计划(2022YFC2601500 & 2022YFC2601504)、中国国家自然科学基金(32272633)、深圳市科技计划(KCXFZ20230731093259009)的支持。

材料

| Name | Company | Catalog Number | Comments |

| DSLR camera | Nikon | D850 | Sensor type: CMOS; Maximum number of pixels: 46.89 million; Effective number of pixels: 45.75 million; Maximum resolution 8256 x 5504. |

| GPU - Graphics Processing Unit | NVIDIA | RTX3090 | |

| Hexacopter | DJI | M600PRO | Horizontal flight: 65 km/h (no wind environment); Maximum flight load: 6000 g |

| PyCharm | Python IDE | 2023.1 | |

| Python | Python | 3.8.0 | |

| Pytorch | Pytorch | 1.8.1 |

参考文献

- Lian, J. Y., et al. Influence of obligate parasite Cuscuta campestris on the community of its host Mikania micrantha. Weed Research. 46, 441-443 (2006).

- Yu, X., Bao, Q. Aboveground biomass estimation of potato from UAV multispectral imagery. Remote Sensing. 54 (4), 96-99 (2023).

- Guo, T. C., Wang, Y. H., Feng, W. Research on wheat yield estimation based on multimodal data fusion from unmanned aircraft platforms. Acta Agronomica Sinica. 48 (7), 15 (2022).

- Shao, G. M., et al. Estimation of transpiration coefficient and aboveground biomass in maize using time-series UAV multispectral imagery. The Crop Journal. 10 (5), 1376-1385 (2022).

- Jiang, Q., et al. UAV-based biomass estimation for rice-combining spectral, TIN-based structural and meteorological features. Remote Sensing. 11 (7), 890 (2019).

- Fei, S. P., et al. UAV-based multi-sensor data fusion and machine learning algorithm for yield prediction in wheat. Precision Agriculture. 24, 187-212 (2023).

- Shu, S., et al. Aboveground biomass estimation of rice based on unmanned aerial vehicle imagery. Fujian Journal of Agricultural Sciences. 37 (7), 9 (2022).

- Wu, X., et al. UAV LiDAR-based biomass estimation of individual trees. Fujian Journal of Agricultural Sciences. 22 (34), 15028-15035 (2022).

- Yang, X., Zan, M., Munire, M. Estimation of above ground biomass of Populus euphratica forest using UAV and satellite remote sensing. Transactions of the Chinese Society of Agricultural Engineering. 37 (1), 7 (2021).

- Li, B., Liu, K. Forest biomass estimation based on UAV optical remote sensing. Forest Engineering. 5, 38 (2022).

- Li, Z., Zan, Q., Yang, Q., Zhu, D., Chen, Y., Yu, S. Remote estimation of mangrove aboveground carbon stock at the species level using a low-cost unmanned aerial vehicle system. Remote Sensing. 11 (9), 1018 (2019).

- Luo, S., et al. Fusion of airborne LiDAR data and hyperspectral imagery for aboveground and belowground forest biomass estimation. Ecological Indicators. 73, 378-387 (2017).

- Li, S., et al. Research of grassland aboveground biomass inversion based on UAV and satellite remoting sensing. Remote Sensing Technology and Application. 1, 037 (2022).

- Wengert, M., et al. Multisite and multitemporal grassland yield estimation using UAV-borne hyperspectral data. Remote Sensing. 14 (9), 2068 (2022).

- Li, Y., et al. The effect of season on Spartina alterniflora identification and monitoring. Frontiers in Environmental Science. 10, 1044839 (2022).

- Wang, F., et al. Estimation of above-ground biomass of winter wheat based on consumer-grade multi-spectral UAV. Remote Sensing. 14 (5), 1251 (2022).

- Lu, N., et al. Improved estimation of aboveground biomass in wheat from RGB imagery and point cloud data acquired with a low-cost unmanned aerial vehicle system. Plant Methods. 15 (1), 17 (2019).

- Chen, H., et al. Mapping forest aboveground biomass with MODIS and Fengyun-3C VIRR imageries in Yunnan Province, Southwest China using linear regression, K-nearest neighbor and random. Remote Sensing. 14 (21), 5456 (2022).

- Yan, M., et al. Biomass estimation of subtropical arboreal forest at single tree scale based on feature fusion of airborne LiDAR data and aerial images. Sustainability. 15 (2), 1676 (2023).

- Tian, Y. C., et al. Aboveground mangrove biomass estimation in Beibu Gulf using machine learning and UAV remote sensing. Science of the Total Environment. 781, 146816 (2021).

- Shrivastava, A., et al. Beyond skip connections: Top-down modulation for object detection. arXiv. , (2016).

- Belkasim, S. O., Shridhar, M., Ahmadi, M. Pattern classification using an efficient KNNR. Pattern Recognition. 25 (10), 1269-1274 (1992).

- Joel, S., Jose Luis, A., Shawn, C. K. Farming and earth observation: Sentinel-2 data to estimate within-field wheat grain yield. International Journal of Applied Earth Observation and Geoinformation. 107, 102697 (2022).

- Tian, L., et al. Review of remote sensing-based methods for forest aboveground biomass estimation: Progress, challenges, and prospects. Forests. 14 (6), 1086 (2023).

- Wei, X. Biomass estimation: A remote sensing approach. Geography Compass. 4 (11), 1635-1647 (2010).

- Débora, B., et al. New methodology for intertidal seaweed biomass estimation using multispectral data obtained with unoccupied aerial vehicles. Remote Sensing. 15 (13), 3359 (2023).

- Zhang, J. Y., et al. Unmanned aerial system-based wheat biomass estimation using multispectral, structural and meteorological data. Agriculture. 13 (8), 1621 (2023).

- Shen, H., et al. Influence of the obligate parasite Cuscuta campestris on growth and biomass allocation of its host Mikania micrantha. Journal of Experimental Botany. 56 (415), 1277-1284 (2005).

转载和许可

请求许可使用此 JoVE 文章的文本或图形

请求许可探索更多文章

This article has been published

Video Coming Soon

版权所属 © 2025 MyJoVE 公司版权所有,本公司不涉及任何医疗业务和医疗服务。