Se requiere una suscripción a JoVE para ver este contenido. Inicie sesión o comience su prueba gratuita.

Method Article

Estimación de biomasa basada en visión artificial para plantas invasoras

En este artículo

Resumen

Reportamos procedimientos detallados para un método de estimación de biomasa de plantas invasoras que utiliza datos obtenidos de la teledetección de vehículos aéreos no tripulados (UAV) para evaluar la biomasa y capturar la distribución espacial de las especies invasoras. Este enfoque resulta muy beneficioso para llevar a cabo la evaluación de riesgos y la alerta temprana de plantas invasoras.

Resumen

Informamos sobre los pasos detallados de un método para estimar la biomasa de plantas invasoras basado en la teledetección de UAV y la visión por computadora. Para recolectar muestras del área de estudio, preparamos un conjunto de cuadrados de muestra para aleatorizar los puntos de muestreo. Se construyó un sistema de cámaras aéreas no tripuladas utilizando un dron y una cámara para adquirir imágenes RGB continuas del área de estudio a través de la navegación automatizada. Después de completar el rodaje, se recolectó la biomasa aérea en el marco de la muestra y se etiquetó y empaquetó toda la correspondencia. Se procesaron los datos de muestra y las imágenes aéreas se segmentaron en imágenes pequeñas de 280 x 280 píxeles para crear un conjunto de datos de imágenes. Se utilizó una red neuronal convolucional profunda para mapear la distribución de Mikania micrantha en el área de estudio, y se obtuvo su índice de vegetación. Los organismos colectados se secaron y el peso seco se registró como la biomasa real del suelo. El modelo de regresión de biomasa vegetal invasora se construyó utilizando la regresión K-vecino más cercano (KNNR) extrayendo el índice de vegetación de las imágenes de muestra como variable independiente e integrándolo con la biomasa real del terreno como variable dependiente. Los resultados mostraron que era posible predecir con precisión la biomasa de las plantas invasoras. Se generó un mapa preciso de distribución espacial de la biomasa de plantas invasoras mediante el recorrido de imágenes, lo que permitió la identificación precisa de las áreas de alto riesgo afectadas por plantas invasoras. En resumen, este estudio demuestra el potencial de combinar la teledetección de vehículos aéreos no tripulados con técnicas de aprendizaje automático para estimar la biomasa vegetal invasora. Contribuye significativamente a la investigación de nuevas tecnologías y métodos para el monitoreo en tiempo real de plantas invasoras y proporciona apoyo técnico para el monitoreo inteligente y la evaluación de peligros a escala regional.

Introducción

En este protocolo, el método propuesto de estimación de biomasa invasiva basado en la teledetección de UAV y la visión por computador puede reflejar la distribución de los organismos invasores y predecir el grado de riesgo biológico invasivo. Las estimaciones de la distribución y la biomasa de los organismos invasores son fundamentales para la prevención y el control de estos organismos. Una vez que las plantas invasoras invaden, pueden dañar el ecosistema y causar enormes pérdidas económicas. La identificación rápida y precisa de las plantas invasoras y la estimación de la biomasa de plantas invasoras clave son los principales desafíos en el seguimiento y control de las plantas invasoras. En este protocolo, tomamos Mikania micrantha como ejemplo para explorar un método de estimación de biomasa de plantas invasoras basado en teledetección aérea no tripulada y visión por computadora, que proporciona un nuevo enfoque y método para la investigación ecológica de plantas invasoras y promueve la investigación ecológica y el manejo de plantas invasoras.

En la actualidad, la medición de la biomasa de Mikania micrantha se realiza principalmente mediante muestreo manual1. Los métodos tradicionales de medición de biomasa necesitan mucha mano de obra y recursos materiales, que son ineficientes y limitados por el terreno; es difícil satisfacer las necesidades de estimación de la biomasa regional de Mikania micrantha. La principal ventaja de utilizar este protocolo es que proporciona un método para cuantificar la biomasa regional de plantas invasoras y la distribución espacial de las plantas invasoras de una manera que no tiene en cuenta las limitaciones de muestreo de la zona y elimina la necesidad de encuestas manuales.

La tecnología de teledetección UAV ha logrado ciertos resultados en la estimación de la biomasa vegetal y ha sido ampliamente utilizada en la agricultura 2,3,4,5,6,7, la silvicultura 8,9,10,11 y los pastizales 12,13,14. La tecnología de teledetección de UAV tiene las ventajas de bajo costo, alta eficiencia, alta precisión y operación flexible15,16, que puede obtener de manera eficiente datos de imágenes de teledetección en el área de estudio; Luego, se extrae la característica de textura y el índice de vegetación de la imagen de teledetección para proporcionar datos de apoyo para la estimación de la biomasa vegetal en un área grande. Los métodos actuales de estimación de la biomasa vegetal se clasifican principalmente en modelos paramétricos y no paramétricos17. Con el desarrollo de algoritmos de aprendizaje automático, los modelos de aprendizaje automático no paramétricos con mayor precisión se han utilizado ampliamente en la estimación de la biomasa vegetal mediante teledetección. Chen et al.18 utilizaron regresión logística mixta (MLR), KNNR y regresión forestal aleatoria (RFR) para estimar la biomasa aérea de los bosques de la provincia de Yunnan. Llegaron a la conclusión de que los modelos de aprendizaje automático, específicamente KNNR y RFR, dieron como resultado resultados superiores en comparación con MLR. Yan et al.19 emplearon modelos de regresión RFR y de aumento de gradiente extremo (XGBR) para evaluar la precisión de la estimación de la biomasa de los bosques subtropicales utilizando varios conjuntos de variables. Tian et al.20 utilizaron once modelos de aprendizaje automático para estimar la biomasa aérea de diversas especies de manglares en la bahía de Beibuwan. Los investigadores descubrieron que el método XGBR era más eficaz para determinar la biomasa aérea de los bosques de manglares. La estimación de la biomasa vegetal mediante teledetección hombre-máquina es una práctica bien establecida, sin embargo, el uso de UAV para la estimación de la biomasa de la planta invasora Mikania micrantha aún no se ha informado tanto a nivel nacional como internacional. Este enfoque es fundamentalmente diferente de todos los métodos anteriores de estimación de biomasa para plantas invasoras, especialmente Mikania micrantha.

En resumen, la teledetección de UAV tiene las ventajas de alta resolución, alta eficiencia y bajo costo. En la extracción de variables de características de imágenes de teledetección, las características de textura combinadas con índices de vegetación pueden obtener un mejor rendimiento de predicción de regresión. Los modelos no paramétricos pueden obtener modelos de regresión más precisos que los paramétricos en la estimación de la biomasa vegetal. Por lo tanto, para calcular con precisión la distribución nula de plantas invasoras y su biomasa, sugerimos los siguientes procedimientos descritos para el experimento de biomasa de plantas invasoras que se basa en la teledetección mediante UAV y visión artificial.

Protocolo

1. Preparación de conjuntos de datos

- Selección del objeto de investigación

- Seleccione las muestras de prueba en función del enfoque del estudio experimental, considerando opciones como Mikania micrantha u otras plantas invasoras.

- Recopilación de imágenes de UAV

- Prepare marcos cuadrados de plástico de tamaño 0,5 m * 0,5 m y cantidad de 25-50, dependiendo del tamaño del área estudiada.

- Emplear un enfoque de muestreo aleatorio para determinar las ubicaciones de muestreo de suelo en el área de estudio utilizando un número suficiente de muestras de biomasa. Coloque el marco de muestra horizontalmente sobre la vegetación, abarcando completamente las plantas con una distancia mínima de separación de 2 m entre cada planta.

- Utilice un dron y una cámara para formar un sistema de filmación de detección remota de UAV, como se muestra en la Figura 1.

- Utilice el UAV para trazar la ruta dentro del área de estudio especificada. La configuración de la planificación de rutas se muestra en la Figura 2.

- Establezca una tasa de superposición lateral y de rumbo del 70%, capture fotos a intervalos de tiempo uniformes de 2 s, mantenga el ángulo de la cámara perpendicular al suelo a 90° y coloque la altitud de la cámara a 30 m. Esto dio como resultado datos de imagen visible continua del área de estudio con una resolución de imagen única que mide 8256 x 5504 píxeles, como se muestra en la Figura 3.

- Almacene imágenes aéreas para su posterior procesamiento con el software Python para la estimación de la biomasa.

- Recogida de la biomasa aérea

- Recoja la biomasa aérea de Mikania micrantha manualmente dentro de cada parcela de muestra después de completar la recopilación de datos con drones. Póngalos en una bolsa y etiquete cada bolsa en consecuencia.

- Al recolectar Mikania micrantha, evite que las parcelas de muestra se muevan. Primero, corte la Mikania micrantha a lo largo del borde interior de la parcela de muestra.

- Luego, corta el rizoma de la Mikania micrantha desde la parte inferior. Retire la tierra, las rocas u otras plantas que se hayan mezclado. Por último, embolsar y etiquetar las muestras.

- Lleve al laboratorio las muestras recolectadas de plantas invasoras del paso 1.3.1. Seque al aire todas las muestras recolectadas para evaporar la mayor parte de la humedad.

- Para eliminar aún más la humedad de las muestras secadas al aire, use un horno. Ajuste la temperatura a 55 °C. Seque las muestras durante 72 h, luego pese cada muestra en una balanza electrónica y registre los datos de biomasa en gramos (g).

- Coloque la balanza electrónica en un entorno tranquilo, pese, calibre y continúe pesando. Coloque bolsas de Mikania micrantha en la balanza electrónica, espere a que las lecturas se estabilicen y registre las lecturas.

- Pese la Mikania micrantha cada hora hasta que la masa ya no cambie y registre la lectura menos el peso de la bolsa como la masa medida de esa muestra. Calcule la biomasa aérea de la planta invasora utilizando la siguiente fórmula:

donde B representa la biomasa de Mikania micrantha en gramos por metro cuadrado (g/m2), M es el peso de la Mikania micrantha medida, medido en gramos (g), S corresponde al área de la parcela de muestreo en metros cuadrados (m2).

- Recoja la biomasa aérea de Mikania micrantha manualmente dentro de cada parcela de muestra después de completar la recopilación de datos con drones. Póngalos en una bolsa y etiquete cada bolsa en consecuencia.

- Creación de un conjunto de datos

- Extraiga la imagen RGB correspondiente a la imagen de muestra de la imagen UAV original. Divídalo en una cuadrícula de 280 × 280 píxeles usando programación Python (Figura 1 de Supplementray).

- Segmente los datos de imagen sin procesar en imágenes más pequeñas del mismo tamaño que las imágenes de muestra mediante la programación de Python. Utilice el método de ventana deslizante para la segmentación, estableciendo los pasos horizontal y vertical en 280 píxeles.

- De las imágenes pequeñas segmentadas en el paso 1.4.2, seleccione aleatoriamente 880 imágenes de plantas invasoras y 1500 imágenes de fondo para crear un conjunto de datos. A continuación, divida este conjunto de datos en conjuntos de entrenamiento, validación y prueba en una proporción de 6:2:2 (Figura 2 de Supplementray).

2. Identificación de Mikania micrantha

- Preparación del software

- Vaya al sitio web oficial de Anaconda (https://www.anaconda.com/) y descargue e instale Anaconda. Luego, diríjase al sitio web de PyCharm (https://www.jetbrains.com/pycharm/) y descargue el IDE de PyCharm.

- Creación de un entorno de Conda.

- Abra la línea de comandos del símbolo del sistema de Anaconda después de instalar Anaconda, luego escriba conda create -n pytorch python==3.8 para crear un nuevo entorno de Conda. Una vez creado el entorno, escriba conda info --envs para confirmar que existe el entorno de pytorch .

- Abra el símbolo del sistema de Anaconda y active el entorno pytorch ingresando conda activate pytorch. Compruebe la versión actual de CUDA (Compute Unified Device Architecture) escribiendo nvidia-smi. Luego, instale la versión 1.8.1 de PyTorch ejecutando el comando conda install pytorch==1.8.1 torchvision==0.9.1 torchaudio==0.8.1 cudatoolkit=11.0 -c pytorch.

- Ejecuciones para el reconocimiento de modelos

NOTA: Utilice PyTorch para compilar el archivo Mikania micrantha modelo de reconocimiento utilizado en este trabajo. El modelo de red empleado es ResNet10121, que sigue siendo coherente con el documento original en su arquitectura. Se realizan modificaciones en la sección de salida de la red para cumplir con los requisitos de reconocimiento de manzanilla.- Preprocese las imágenes para prepararlas para la entrada del modelo. Cambie el tamaño de las imágenes de 280 x 280 píxeles a 224 x 224 píxeles y normalícelas para asegurarse de que cumplen los requisitos de tamaño del modelo mediante el siguiente código:

transform = transforma. Componer([

Transforma. Cambiar tamaño((224, 224)),

Transforma. ToTensor(),

Transforma. Normalizar([0,485, 0,456, 0,406], [0,229, 0,224, 0,225])]) - Realice la extracción de características de imagen y reduzca la dimensionalidad mediante una red neuronal convolucional.

- En primer lugar, inicialice la capa convolucional para la extracción inicial de características a través de self.conv1. Con esta capa convolucional, la imagen original se convoluciona en un mapa de características con self.in_channel canales para extraer las características iniciales (Figura complementaria 3A).

NOTA: Las características avanzadas se extraen en una operación de convolución en los pasos residuales. Estas capas se producen invocando la función _make_layer , que comprende una secuencia de bloques residuales. Cada bloque residual consta de funciones de convolución, normalización por lotes y activación para extraer gradualmente características sofisticadas (Figura complementaria 3B). - Utilice la función de la capa para modificar el número de canal para la reducción de dimensionalidad mediante convolución 1x1. Esta operación disminuye la carga computacional al tiempo que conserva las características significativas (Figura complementaria 3C).

NOTA: En general, ResNet101 realiza la extracción de características mediante el uso de varias capas convolucionales, y la reducción de la dimensionalidad se logra a través de capas convolucionales 1x1 dentro del bloque residual. Este enfoque permite que la red aprenda las características más profundamente y evite el problema de la desaparición del gradiente, lo que permite un aprendizaje y una representación más eficientes de las características de la imagen para tareas complejas. - Después de las convoluciones y las operaciones de agrupación, introduzca las entidades de alta calidad en una capa totalmente conectada.

NOTA: En la arquitectura de ResNet, la extracción de características se lleva a cabo en la capa convolucional. Estas entidades se envían posteriormente a la capa totalmente conectada (FC) para su clasificación (Figura 4 suplementaria). La operación self.avgpool(x) realiza un agrupamiento de promedios adaptable para cambiar la forma del tensor a un tamaño fijo. La operación torch.flatten(x, 1) extiende el tensor en un vector unidimensional, y self.fc(x) aplica la capa completamente conectada al vector aplanado, sirviendo en última instancia como el paso final para la clasificación. Este proceso pasa efectivamente las características extraídas a través de la capa convolucional, transformándolas en un formato adecuado para la clasificación a través de la capa completamente conectada. - Utilice la función Softmax para obtener el resultado final en función de los tres requisitos de clasificación.

- En primer lugar, inicialice la capa convolucional para la extracción inicial de características a través de self.conv1. Con esta capa convolucional, la imagen original se convoluciona en un mapa de características con self.in_channel canales para extraer las características iniciales (Figura complementaria 3A).

- Entrene un modelo de reconocimiento multiclase con el conjunto de datos del paso 1.4. Establezca el número de iteraciones en 200 y una tasa de aprendizaje inicial de 0,0001. Reduzca la tasa de aprendizaje en un tercio cada 10 iteraciones con un tamaño de lote de 64. Guarde los parámetros óptimos del modelo automáticamente después de cada iteración (Figura complementaria 5).

- Emplee un modelo de reconocimiento meticulosamente entrenado y recorra sistemáticamente la imagen original del paso 1.2.2 con fines de identificación.

- Configure pasos horizontales y verticales con una precisión de 280 píxeles, lo que da como resultado la generación de un mapa de distribución completo que destaca la presencia de flora invasora dentro de los límites del área de estudio. Presente los resultados seleccionados visualmente como se muestra en la Figura 4.

NOTA: La imagen inicial se preprocesa segmentándola en fragmentos más pequeños, clasificando cada fragmento mediante un modelo de aprendizaje profundo entrenado y combinando los resultados en una imagen de salida. Si un fragmento se clasifica como planta invasora, la ubicación correspondiente en la imagen de salida se establece en 255. La imagen de salida resultante se guarda como un archivo de imagen en escala de grises. El código de implementación específico se muestra en la Figura complementaria 6.

- Configure pasos horizontales y verticales con una precisión de 280 píxeles, lo que da como resultado la generación de un mapa de distribución completo que destaca la presencia de flora invasora dentro de los límites del área de estudio. Presente los resultados seleccionados visualmente como se muestra en la Figura 4.

- Preprocese las imágenes para prepararlas para la entrada del modelo. Cambie el tamaño de las imágenes de 280 x 280 píxeles a 224 x 224 píxeles y normalícelas para asegurarse de que cumplen los requisitos de tamaño del modelo mediante el siguiente código:

3. Estimación de la biomasa vegetal invasora

- Realice un aumento de datos simple con las funciones RandomResizedCrop y RandomHorizontalFlip (Figura complementaria 7) para ampliar el conjunto de imágenes creado en el paso 1.2 y extraer los seis índices de vegetación comúnmente utilizados para estimar la biomasa, que son RBRI, GBRI, GRRI, RGRI, NGBDI y NGRDI. Consulte la Tabla 1 para ver las fórmulas de cálculo de estos índices.

- Cree un modelo de regresión de K-vecino más cercano (KNNR)22 utilizando la salida del modelo para garantizar una estimación precisa de la biomasa de las plantas invasoras. Utilice los índices de vegetación extraídos como entradas para el modelo de estimación.

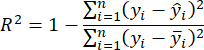

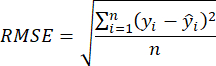

- Utilice el coeficiente de determinación R2 y el error cuadrático medio (RMSE)23 para evaluar la precisión del modelo, que se calcula de la siguiente manera:

NOTA: El algoritmo K-Nearest Neighbor Regression (KNNR) es una técnica de aprendizaje automático no paramétrica que se utiliza para resolver problemas de regresión. Su concepto fundamental es predecir resultados mediante la determinación de los K vecinos más cercanos en el espacio de características en función de las distancias de muestra de entrada. Los beneficios clave de usar KNNR incluyen su simplicidad y facilidad de comprensión, y no requiere ninguna fase de capacitación. Además, KNNR no hace suposiciones excesivas sobre la distribución de los datos. KNNR se puede aplicar en temas de regresión para anticipar variables objetivo continuas y evaluar con precisión la biomasa de plantas invasoras. - Emplee el modelo de estimación de biomasa aérea elegido en el paso 3.2 y escanee el mapa de distribución de plantas invasoras del paso 2.3.4 con zancadas horizontales y verticales de 280 píxeles.

Resultados

Se muestran resultados representativos de un método basado en visión artificial para la estimación de plantas invasoras, el cual se implementa de manera programática en una computadora. En este experimento, evaluamos la distribución espacial y estimamos la biomasa de plantas invasoras en sus hábitats naturales, utilizando Mikania micrantha como sujeto de investigación. Utilizamos un sistema de cámaras de drones para adquirir imágenes del sitio de investigación, una parte de las cuales se exhibe en la <...

Discusión

Presentamos los pasos detallados de un experimento sobre la estimación de la biomasa de plantas invasoras utilizando UAV teledetección y visión por computadora. El proceso y los pasos principales de este acuerdo se muestran en la Figura 7. La calidad adecuada de la muestra es uno de los aspectos más cruciales y desafiantes del programa. Esta importancia es válida para todas las plantas invasoras, así como para cualquier otro experimento de estimación de la biomasa vegetal

Divulgaciones

Los autores no tienen nada que revelar.

Agradecimientos

El autor agradece a la Academia China de Ciencias Agrícolas y a la Universidad de Guangxi por apoyar este trabajo. El trabajo contó con el apoyo del Programa Nacional de Investigación y Desarrollo Clave de China (2022YFC2601500 y 2022YFC2601504), la Fundación Nacional de Ciencias Naturales de China (32272633), el Programa de Ciencia y Tecnología de Shenzhen (KCXFZ20230731093259009)

Materiales

| Name | Company | Catalog Number | Comments |

| DSLR camera | Nikon | D850 | Sensor type: CMOS; Maximum number of pixels: 46.89 million; Effective number of pixels: 45.75 million; Maximum resolution 8256 x 5504. |

| GPU - Graphics Processing Unit | NVIDIA | RTX3090 | |

| Hexacopter | DJI | M600PRO | Horizontal flight: 65 km/h (no wind environment); Maximum flight load: 6000 g |

| PyCharm | Python IDE | 2023.1 | |

| Python | Python | 3.8.0 | |

| Pytorch | Pytorch | 1.8.1 |

Referencias

- Lian, J. Y., et al. Influence of obligate parasite Cuscuta campestris on the community of its host Mikania micrantha. Weed Research. 46, 441-443 (2006).

- Yu, X., Bao, Q. Aboveground biomass estimation of potato from UAV multispectral imagery. Remote Sensing. 54 (4), 96-99 (2023).

- Guo, T. C., Wang, Y. H., Feng, W. Research on wheat yield estimation based on multimodal data fusion from unmanned aircraft platforms. Acta Agronomica Sinica. 48 (7), 15 (2022).

- Shao, G. M., et al. Estimation of transpiration coefficient and aboveground biomass in maize using time-series UAV multispectral imagery. The Crop Journal. 10 (5), 1376-1385 (2022).

- Jiang, Q., et al. UAV-based biomass estimation for rice-combining spectral, TIN-based structural and meteorological features. Remote Sensing. 11 (7), 890 (2019).

- Fei, S. P., et al. UAV-based multi-sensor data fusion and machine learning algorithm for yield prediction in wheat. Precision Agriculture. 24, 187-212 (2023).

- Shu, S., et al. Aboveground biomass estimation of rice based on unmanned aerial vehicle imagery. Fujian Journal of Agricultural Sciences. 37 (7), 9 (2022).

- Wu, X., et al. UAV LiDAR-based biomass estimation of individual trees. Fujian Journal of Agricultural Sciences. 22 (34), 15028-15035 (2022).

- Yang, X., Zan, M., Munire, M. Estimation of above ground biomass of Populus euphratica forest using UAV and satellite remote sensing. Transactions of the Chinese Society of Agricultural Engineering. 37 (1), 7 (2021).

- Li, B., Liu, K. Forest biomass estimation based on UAV optical remote sensing. Forest Engineering. 5, 38 (2022).

- Li, Z., Zan, Q., Yang, Q., Zhu, D., Chen, Y., Yu, S. Remote estimation of mangrove aboveground carbon stock at the species level using a low-cost unmanned aerial vehicle system. Remote Sensing. 11 (9), 1018 (2019).

- Luo, S., et al. Fusion of airborne LiDAR data and hyperspectral imagery for aboveground and belowground forest biomass estimation. Ecological Indicators. 73, 378-387 (2017).

- Li, S., et al. Research of grassland aboveground biomass inversion based on UAV and satellite remoting sensing. Remote Sensing Technology and Application. 1, 037 (2022).

- Wengert, M., et al. Multisite and multitemporal grassland yield estimation using UAV-borne hyperspectral data. Remote Sensing. 14 (9), 2068 (2022).

- Li, Y., et al. The effect of season on Spartina alterniflora identification and monitoring. Frontiers in Environmental Science. 10, 1044839 (2022).

- Wang, F., et al. Estimation of above-ground biomass of winter wheat based on consumer-grade multi-spectral UAV. Remote Sensing. 14 (5), 1251 (2022).

- Lu, N., et al. Improved estimation of aboveground biomass in wheat from RGB imagery and point cloud data acquired with a low-cost unmanned aerial vehicle system. Plant Methods. 15 (1), 17 (2019).

- Chen, H., et al. Mapping forest aboveground biomass with MODIS and Fengyun-3C VIRR imageries in Yunnan Province, Southwest China using linear regression, K-nearest neighbor and random. Remote Sensing. 14 (21), 5456 (2022).

- Yan, M., et al. Biomass estimation of subtropical arboreal forest at single tree scale based on feature fusion of airborne LiDAR data and aerial images. Sustainability. 15 (2), 1676 (2023).

- Tian, Y. C., et al. Aboveground mangrove biomass estimation in Beibu Gulf using machine learning and UAV remote sensing. Science of the Total Environment. 781, 146816 (2021).

- Shrivastava, A., et al. Beyond skip connections: Top-down modulation for object detection. arXiv. , (2016).

- Belkasim, S. O., Shridhar, M., Ahmadi, M. Pattern classification using an efficient KNNR. Pattern Recognition. 25 (10), 1269-1274 (1992).

- Joel, S., Jose Luis, A., Shawn, C. K. Farming and earth observation: Sentinel-2 data to estimate within-field wheat grain yield. International Journal of Applied Earth Observation and Geoinformation. 107, 102697 (2022).

- Tian, L., et al. Review of remote sensing-based methods for forest aboveground biomass estimation: Progress, challenges, and prospects. Forests. 14 (6), 1086 (2023).

- Wei, X. Biomass estimation: A remote sensing approach. Geography Compass. 4 (11), 1635-1647 (2010).

- Débora, B., et al. New methodology for intertidal seaweed biomass estimation using multispectral data obtained with unoccupied aerial vehicles. Remote Sensing. 15 (13), 3359 (2023).

- Zhang, J. Y., et al. Unmanned aerial system-based wheat biomass estimation using multispectral, structural and meteorological data. Agriculture. 13 (8), 1621 (2023).

- Shen, H., et al. Influence of the obligate parasite Cuscuta campestris on growth and biomass allocation of its host Mikania micrantha. Journal of Experimental Botany. 56 (415), 1277-1284 (2005).

Reimpresiones y Permisos

Solicitar permiso para reutilizar el texto o las figuras de este JoVE artículos

Solicitar permisoThis article has been published

Video Coming Soon

ACERCA DE JoVE

Copyright © 2025 MyJoVE Corporation. Todos los derechos reservados