需要订阅 JoVE 才能查看此. 登录或开始免费试用。

Method Article

在实验心理学和认知神经科学研究中呈现真人和真人行为的自然主义设置

摘要

这项研究提出了一种自然主义的实验设置,允许研究人员呈现实时动作刺激,获得响应时间和鼠标跟踪数据,同时参与者在每次刺激显示后做出反应,并使用独特的系统在实验条件之间切换演员,包括特殊的透明有机发光二极管(OLED)屏幕和光操作。

摘要

对他人行为的感知对于生存、互动和沟通至关重要。尽管数十年的认知神经科学研究致力于理解对行为的感知,但我们仍然远离开发一种神经启发的计算机视觉系统来接近人类行为感知。一个主要的挑战是,现实世界中的行动由空间中"此时此地"发生的暂时展开的事件组成,并且是可以接受的。相比之下,迄今为止的视觉感知和认知神经科学研究主要通过2D显示器(例如图像或视频)研究动作感知,这些显示器在空间和时间上缺乏演员的存在,因此这些显示器在提供可操作性方面受到限制。尽管该领域的知识体系越来越多,但必须克服这些挑战,以便更好地了解在现实世界中感知他人行为的基本机制。本研究的目的是引入一种新颖的设置,在近似现实世界设置的场景中与真人演员进行自然主义实验室实验。本研究中使用的设置的核心元素是一个透明的有机发光二极管(OLED)屏幕,参与者可以通过该屏幕观看实际演员的现场表演,同时精确控制他们的演示时间。在这项工作中,该设置在行为实验中进行了测试。我们相信,该装置将帮助研究人员揭示基本且以前无法获得的动作感知认知和神经机制,并将成为未来研究自然环境中社会感知和认知的基础。

引言

生存和社会互动的基本技能是感知和理解他人行为并在周围环境中与他们互动的能力。过去几十年的先前研究对理解个人如何感知和理解他人行为的基本原则做出了重大贡献1,2,3,4,5,6,7,8,9,10,11 .然而,鉴于相互作用的复杂性及其发生的环境,显然需要在自然环境中进一步发展知识体系,以便在日常生活环境中更全面地理解这种复杂的技能。

在我们的日常生活环境等自然环境中,感知和认知表现出具身的、嵌入的、延伸的和活跃的特征12.与倾向于低估身体和环境作用的大脑功能的内部主义描述相反,当代的具身认知方法侧重于大脑,身体和环境的动态耦合。另一方面,大多数社会心理学,认知心理学和神经科学研究倾向于假设在实验室条件下利用良好控制和简化的实验设计(例如,计算机化任务中的图像或视频)产生的结果可以推广到更复杂的场景,例如现实世界的交互1,2,3,4,5,6,7 ,8,9,10,11.这一假设保证了在许多情况下可以获得稳健可靠的数据。然而,一个众所周知的挑战是,在现实世界中进行测试时,从精心控制的实验中得出的模型的有效性是有限的13。因此,已经进行了进一步的调查13,14,15,16,17,18,19,20,21,22,以解决各个研究领域中刺激和实验设计的生态和外部有效性。

在这项研究中,提出了一种新颖的方法,通过使用真实的、身体在场的演员表演的真人动作来研究个人如何感知和评估他人的行为。采用类似于现实生活背景的场景,而实验者可以控制可能的混杂因素。这项研究是Matusz等人框架内的一种"自然主义实验室研究"形式14,可以被认为是"经典实验室研究"之间的中间阶段,前者利用对刺激和环境的最大控制,通常以牺牲自然性为代价,后者旨在以牺牲对刺激和环境的控制为代价,以牺牲对刺激和环境的控制为代价,最大限度地提高自然性14.该研究旨在解决在行动感知研究中对这一水平进行实证调查的需求,以弥合在高度实验控制的传统实验室实验中获得的结果与在完全不受限制的自然环境中进行的研究中获得的结果之间的差距。

受控实验与无约束实验

实验控制是设计实验以测试特定假设的有效策略,因为它允许研究人员将目标变量与可能的混杂因素隔离开来。它还允许通过一定程度的修正重新审视相同的假设,例如在同一设计中使用略微或完全不同的刺激,或在替代实验设置中测试相同的刺激。通过对照实验进行系统研究是认知科学和相关领域研究的传统方法形式。对照实验仍然有助于建立关于各个研究领域认知过程基本原理的知识体系,例如注意力、记忆和感知。然而,最近的研究也承认传统实验室实验在将研究结果推广到现实世界环境方面的局限性,并鼓励研究人员在增强的生态环境中进行研究13,14,15,16,17,18,19,20,21 .这种转变旨在解决传统实验室实验与现实世界环境之间的差异的两个重要问题。首先,实验室外的世界不像实验那样具有确定性,这限制了系统实验操作的代表能力。其次,人脑具有高度的适应性,由于设计和进行实验研究的实际局限性,这一点往往被低估了22。"生态有效性"的概念23,24已被用于解决解决该问题的方法。该术语通常用于指将实验结果推广到实验室环境之外的现实世界的先决条件。生态有效性也被解释为指使用不受约束的刺激验证几乎自然主义的实验设置,以确保研究设计类似于现实生活中的场景25。由于该术语的解释差异很大,因此需要了解替代方法和刺激选择的优点和局限性。

刺激和实验设计中的自然主义水平

以前在实验心理学和认知神经科学方面的工作使用了具有不同自然主义水平的广泛刺激26.大多数研究人员更喜欢使用静态图像或简短的动态视频,因为这些刺激比那些可以模拟真实动作或事件的刺激更容易准备。尽管有优势,但这些刺激不允许研究人员测量社会主体之间的偶然行为。换句话说,他们不可操作,也没有社会负担能力27.近年来,已经开发了这些非交互式刺激的替代方案:虚拟化身的实时动画。这些头像允许调查头像与其用户之间的交互。然而,使用虚拟化身会减少用户的担忧,特别是当它们在现实和偶然行为方面看起来并不特别吸引人时26.因此,现在对在实验研究中使用真实的社会刺激更感兴趣。尽管它们的设计、数据记录和分析可能需要先进的设备和复杂的数据分析,但它们是理解自然主义人类行为和认知的最佳候选者。

本研究提出了一种在实验室环境中使用现实生活中的社会刺激的方法。本研究旨在调查与传统实验室实验相比,人们如何在生态有效性增强的环境中感知和评估他人的行为。我们开发并描述了一种新颖的设置,其中参与者可以接触到真实的演员,这些演员在场并与他们共享相同的环境。在该协议中,测量参与者的响应时间和小鼠轨迹,这需要刺激呈现的精确时间并严格控制这种增强的生态环境中的实验条件。因此,实验范式在文献中存在的框架中脱颖而出,因为刺激的自然性在不牺牲对环境的控制的情况下最大化。下面,该协议介绍了建立此类系统的步骤,然后继续提供样本数据的代表性结果。最后,讨论了范式的重要性、局限性和修改计划。

试验设计

在进入协议部分之前,我们描述了本研究中使用的参数,并将刺激的细节与实验设计一起呈现。

研究中的参数

本研究旨在衡量演员的类型和他们执行的行为类别如何影响参与者的思维感知过程。在该协议中,心灵感知过程在两个主要维度上测量,即代理和经验,正如先前的研究28所提出的那样。这两个维度的高端和低端也包括在内,正如最近由Li等人介绍的那样29。

该研究的结构受到常用内隐关联任务(IAT)31的单类别版本30的启发。在此任务中,参与者将属性概念与目标概念匹配时的响应时间将用作这两个概念的隐式关联的强度的指示。在改编这个隐含任务的过程中,参与者被呈现由真实演员执行的现场动作,并要求他们与目标概念相匹配。目标概念是机构或体验维度的高端和低端,具体取决于实验块。

总而言之,自变量是Actor类型和Action Class。 演员类型有两个级别(即,两个不同的演员,演员1和演员2,在研究中表演)。操作类有两个级别:操作类 1 和操作类 2,每个类包含四个操作。参与者在四个块中分别评估两个参与者(每个块中一个参与者),在每个块中,参与者以平衡的顺序执行所有动作。参与者对两个预定义和强制维度进行评估:代理和经验。实验中的四个方块是(1)代理方块中的Actor1,(2)代理方块中的Actor2,(3)经验方块中的Actor1和经验方块中的Actor2。 块的顺序在参与者之间也是平衡的,因此具有相同代理的块永远不会相互跟随。

除了参与者的答案外,还记录了他们在向两种响应方案之一移动时使用的无线鼠标的响应时间和x-y坐标。因此,因变量是参与者的响应和响应时间(RT),以及来自计算机鼠标跟踪的最大偏差(MD)和曲线下面积(AUC)的测量值。变量响应是分类的;它可以是高或低,并且由于评估是在给定块之一中完成的,因此响应也可以标记为高代理、低代理、高经验或低经验。响应时间是一个连续变量;它的单位是秒,它指的是从操作的呈现开始到鼠标单击其中一个响应选项之间经过的时间。轨迹的MD是一个连续变量,它是指参与者的轨迹与理想化轨迹(直线)之间的最大垂直偏差。轨迹的AUC也是一个连续变量,它是指参与者的轨迹与理想化轨迹32之间的几何区域。

实验的刺激和设计

本研究采用三阶段实验。第三部分的测量值用于分析;前两部分作为最后一部分的准备。下面,我们描述了实验的每个部分以及实验刺激和假设。

在实验第1部分(词汇培训部分)中,参与者完成培训课程,以了解代理和经验的概念以及用高和低这两个词表示的能力水平。为了选择本次培训课程中使用的概念(n = 12),当前工作的一些作者进行了一项规范性研究33。由于本研究计划以参与者的母语进行,因此这些概念在标准化之前也被翻译成土耳其语。从与两个维度的高(n= 3)和低(n= 3)端(每个六个概念)密切相关的概念中选择概念。这部分至关重要,因为参与者对概念的理解有望指导他们的评估过程。

在实验第 2 部分(动作识别部分)中,参与者依次观看 Actor1 和 Actor2 执行的相同八个动作,并向实验者报告动作是什么。此部分用作操作检查;通过在两个参与者都执行时呈现所有动作,可以确保参与者在开始隐式测试之前理解这些动作并熟悉参与者,他们需要在其中进行快速评估。根据一些作者对每个行动者条件进行的两项规范性研究(N = 219)的结果(手稿正在准备中),为行动类1和行动类2选择的行动是那些具有最高H分数和置信水平(每个行动类中的四个不同的动作示例)的行动。所有操作均在 6 秒的相同持续时间内执行。

这是一项正在进行的研究,它还有其他一些组成部分;但是,上述各节的假设如下:(i)参与者的类型将影响因变量;与演员 1 相比,参与者 2 将产生更长的 RT、更高的 MD 和更大的 AUC;(ii) 作用类型将影响相关测量;与行动类 2 相比,行动类 1 将产生更长的 RT、更高的 MD 和更大的 AUC;(iii) 同一参与者和行动类别的高响应和低响应的相关测量值在块维度上会有所不同:代理和经验。

研究方案

本研究中的实验方案得到了比尔肯特大学人类参与者研究伦理委员会的批准。所有参与研究的参与者均年满18岁,他们在开始研究之前阅读并签署了知情同意书。

1. 一般设计步骤

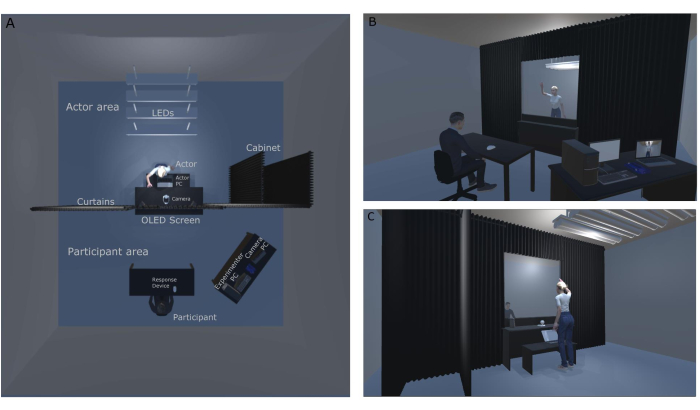

注意:图1A(顶视图)和图1B和图1C(正面和背面视图)显示了实验室布局; 这些数字是根据为这项特定研究设计的原始实验室设置和配置创建的。图 1A 显示了实验室的俯视图布局。在此图中,可以看到天花板和演员柜上的LED灯。遮光窗帘系统将房间一分为二,并通过防止光线泄漏到房间的前部(参与者区域)来帮助控制光线。图1B从实验者的角度展示了实验室的视图。参与者坐在OLED屏幕的正前方,使用透视显示屏,他们可以观看演员表演的现场表演。他们通过使用他们面前的响应设备(无线鼠标)给出响应。实验者可以通过参与者显示器(OLED屏幕)和来自安全摄像头的镜头同时观看演员。图1C展示了研究的后台(Actor区域),其中有安全摄像头和Actor个人电脑(PC),参与者看不到它们。安全摄像机镜头进入摄像机 PC,以在演员和实验者之间建立通信。Actor PC向Actor显示块顺序和下一个操作信息,以便实验不间断地进行。参与者可以快速检查下一个动作,而参与者可以响应上一个试验中的动作。

图1:自然主义实验室设置 。 (A)自然主义实验室设置的自上而下视图。(B)从参与者的角度来看自然主义实验装置的背面和正面。(C)从演员的角度看自然主义实验设置的背面和正面。 请点击此处查看此图的大图。

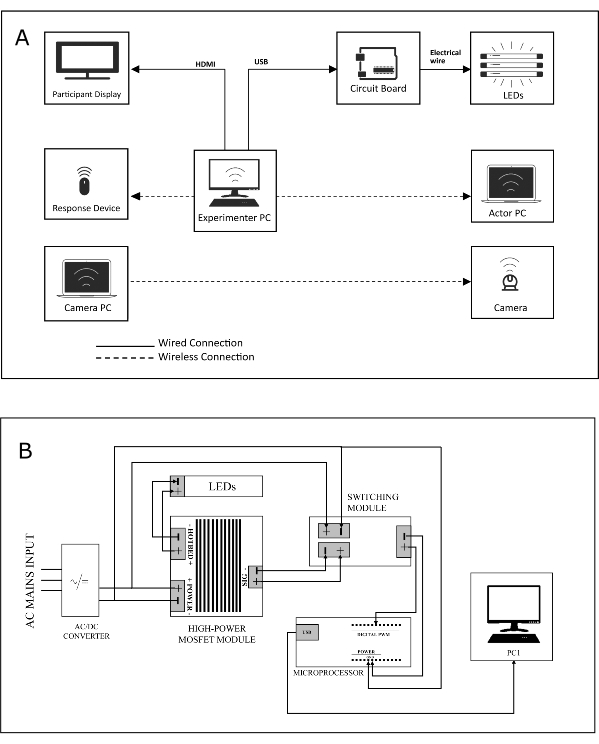

- 设计一个包括三台计算机的设置,包括(1)一台主控台(实验者PC),(2)一台演员笔记本电脑(演员电脑)和(3)一台相机电脑,一台无线响应设备(参与者鼠标),两个显示器,一个照明电路和一个安全摄像头(有关本研究设置的系统图,请参见 图2A )。

注意:实验者将使用实验者PC来运行实验脚本,演员将使用ActorPC来跟踪实验的块和块中动作的顺序,第三个设备,相机PC,将连接到位于演员区域的安全摄像头,并由实验者用于监控后台。 - 将单独的显示器(一个用于显示刺激[参与者显示器],即OLED屏幕)和用于监视实验,响应设备和照明电路(通过 电线或无线连接)的屏幕连接到实验者PC(见 图2A)。

- 通过无线网络连接实验者PC和ActorPC,以将与实验状态相关的信息(例如,"下一个动作ID是'问候语'")传达给参与者。

- 设计和构建一个照明电路(参见 图2B 的电路板),该电路可由微控制器控制以打开和关闭LED。

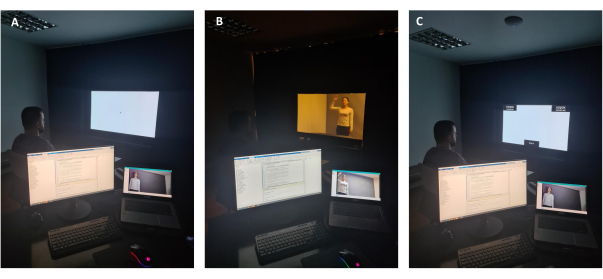

注意: 图3A 从实验者的角度显示了研究中使用的OLED屏幕的不透明使用情况。为了确保不透明,屏幕的背景被调整为白色(RGB:255、255、255),并且房间中的所有灯(参与者区域和演员区域)都关闭。参与者在刺激之前看到注视。 图3B 从实验者的角度显示了研究中数字屏幕的透明使用。要启用透明度,屏幕的背景将调整为黑色 (RGB: 0, 0, 0),并打开天花板上的 LED 灯。参与者观看演员。 图3C 显示了研究中数字屏幕的不透明使用情况。为了确保不透明,屏幕的背景被调整为白色(RGB:255、255、255),并且房间中的所有灯都被关闭。参与者将看到评估屏幕以给出响应。他们需要使用无线鼠标将光标拖动到屏幕的左上角或右上角(两个响应选项之一,高或低)。记录它们的鼠标轨迹和响应时间。 - 将微控制器连接到实验者PC。

- 将运行实验的脚本存储在实验者电脑中。

注意: 图4A 显示了实验期间的后台(演员区域)。房间(参与者区域)的前灯熄灭,演员电脑显示演员将执行的操作的名称。 图 4B 显示了演员内阁,演员可以在其中等待轮到他们并更换服装。从参与者的视野中看不到演员橱柜,并且由于使用了窗帘系统,演员可以使用他们想要的任何入口。在实验过程中,图中显示的荧光灯熄灭。

图 2:系统和接线图。 (A)自然主义实验装置的系统图。(B)实验过程中支撑OLED屏幕的光电路的接线图。请点击此处查看此图的大图。

图3:从实验者的角度看OLED屏幕 。 (A)从实验者的角度不透明地使用OLED数字屏幕。(B)从实验者的角度透明使用OLED数字屏幕。(C)在反应期内从实验者的角度不透明地使用OLED数字屏幕。 请点击此处查看此图的大图。

图 4:实验的后台。 (A) 实验试验期间的后台。(B)演员柜位于OLED屏幕的背面,演员可以在实验过程中等待轮到他们。请点击此处查看此图的大图。

2. 照明电路的设计与实现

- 为电路的设备/组件供电之前要遵循的步骤

- 要更改安装在后台(演员区域)的 LED 的状态,请为实验者电脑提供将 LED 切换为"开"或"关"的功能。

- 要通过USB电缆传达将从实验者PC发送的数字命令,请选择可以接受数字输入并生成数字输出的微控制器设备(请参阅本研究中使用的微控制器的材料 表 )。

- 选择实验者PC的特定USB端口,通过USB电缆 连接到 微控制器的USB输入。在确保已成功建立所有连接之前,请勿打开PC。

- 包括一个开关模块,以增加微控制器产生的输出信号(约3.3 V)的幅度。

- 将微控制器的指定数字输出引脚(对于本实验,指定引脚为D9)和接地引脚连接到开关模块。

- 要运行负载(LED),请包括一个由开关模块产生的信号驱动的高功率金属氧化物半导体场效应晶体管(MOSFET)模块(或MOSFET模块),并将MOSFET模块的信号引脚连接到开关模块上的相应信号接地对。

- 将 MOSFET 模块的热床引脚连接到负载。

- 为了向模块提供稳定的恒定电压(并间接地向 LED 提供),请包括一个 LED 电源,该电源接受交流 (AC) 电源输入并在电路中产生恒定的直流电压。

- 将 LED 电源的输出连接到 MOSFET 模块和开关模块的电源输入。

- 接线电路元件后要遵循的步骤

- 将 USB 电缆连接到实验者 PC 的选定 USB 端口。

- 在微控制器和实验者PC上运行的软件环境之间创建串行通信链路(请参阅 将微控制器连接到实验者PC的小节)。

- 将 LED 电源连接到交流电源输入。

3. 实验编程

注意:创建三个主要的实验脚本(ExperimentScript1.m [补充编码文件 1]、ExperimentScript2.m [补充编码文件 2] 和 ExperimentScript3.m [补充编码文件 3]),以及几个函数(RecordMouse.m [补充编码文件 4]、InsideROI.m [补充编码文件 5]、RandomizeTrials.m [补充编码文件 6]、RandomizeBlocks.m [补充编码文件 7],GenerateResponsePage.m [补充编码文件 8]、GenerateTextures.m [补充编码文件 9]、ActorMachine.m [补充编码文件 10]、MatchIDtoClass.m [补充编码文件 11] 和 RandomizeWordOrder.m [补充编码文件 12]) 来执行实验。

注意:有关详细说明,请参阅相关脚本。

- 试验订单和区块订单的随机化

- 定义并创建两个函数来随机化试验订单 (RandomizeTrials.m) 和块订单 (RandomizeBlocks.m),它们将随机化参数(如参与者 ID)作为输入并返回伪随机序列数组。

- 请参阅脚本 RandomizeBlocks.m(第 2-24 行)和 RandomizeTrials.m(第 3-26 行),了解有关如何生成随机序列的详细信息。

- 跟踪响应(RecordMouse,InsideRoi)

- 创建一个函数,用于跟踪和记录参与者的鼠标轨迹以及实验期间经过的时间(请参阅RecordMouse.m)。

- 创建一个帮助程序函数来检查单击的坐标是否位于可接受的区域内(请参阅脚本 InsideRoi.m)。

- 为指令和反馈生成纹理(GenerateTextures.m,GenerateResponsePage.m)

- 准备与实验相关的说明和与试验相关的反馈作为图像。

- 将这些图像的内容保存到 .mat 文件中(请参阅 ExperimentImages.mat 文件 [补充编码文件 13])。

- 创建屏幕窗口后,将 .mat 文件加载到工作区中(请参阅 GenerateTextures.m 第 25 行)。

- 为每个图像创建单独的纹理及其标识符(请参阅 GenerateTextures.m 第 27-165 行)。

- 定义一个函数来为每个实验脚本绘制相关的响应页面纹理(请参阅 GenerateResponsePage.m)。

- 通过 TCP/IP 将演员 PC 连接到实验者电脑

- 在 Experimenter PC 上运行的脚本(参见 ExperimentScript2.m 第 174 行)中创建 TCP 服务器套接字。

- 在ActorPC上运行的脚本(参见ActorMachine.m第16行)中创建相应的TCP客户端套接字。

- 从运行在实验者 PC 上的脚本(请参阅 ExperimentScript2.m 中的第 207、229 和 278 行或 ExperimentScript3.m 中的第 136、141、153、159 和 297 行)将有关即将到来的块/试验的信息发送给参与者。

- 在ActorPC的屏幕窗口中显示从实验者PC接收到的信息(请参阅ActorMachine.m中的第31-47行)。

- 将微控制器连接到实验者电脑

- 将微控制器连接到特定的 USB 端口(例如端口 9),以控制后台已安装 LED 的状态(打开或关闭)。

- 在微控制器设备和实验者PC之间建立串行通信(参见ExperimentScript2.m脚本中的第185行)。

- 从 Experimenter PC 上运行的脚本向微控制器发送逻辑高信号 (1)(请参阅 ExperimentScript2.m 中的第 290 行或 ExperimentScript3.m 脚本中的第 311 行),以便在通过 USB 电缆 显示 操作时打开 LED。

- 从 Experimenter PC 上运行的脚本向微控制器发送逻辑低信号 (0)(参见 ExperimentScript2.m 中的第 292 行或参见 ExperimentScript3.m 脚本中的第 314 行),以便在参与者预期给出响应时关闭 LED。

4. 样本实验的流程

- 实验前步骤

- 确保实验室中的所有设备(实验者电脑、相机电脑、演员电脑和参与者显示器)均由UPS供电。

- 通过USB电缆将闪电微控制器连接到实验者电脑,这样它就会在实验者电脑打开时自动打开。

- 打开实验者电脑,并检查它是否已连接到 5 GHz Wi-Fi。

- 选择声音设备( 材料表中的扬声器)作为实验者PC的声音输出设备。

- 打开参加者显示屏,并将音量设置设置为 80%。

- 为多台显示器设置实验者电脑的屏幕设置。将实验 PC 的显示扩展到参与者的显示器。实验者PC的显示将为1,参与者的显示将为2。

- 打开演员电脑,检查它是否连接到5 GHz Wi-Fi。

- 通过USB电缆将安全摄像头连接到演员电脑,这样它就会在演员PC打开时自动开机。

- 打开相机电脑,然后在桌面上打开相机应用程序。确保每个演员、他们的动作以及他们对机柜的进出都从摄像机中可见。

- 确保所有计算机、显示器和设备(响应设备 [参与者的无线鼠标]、实验者 PC 和 Actor PC 的扬声器、键盘和鼠标以及闪电微控制器)正常工作。

- 欢迎参与者到另一个房间;在提供有关研究的简要信息后,提供同意书,并让参与者签名。

- 要求参与者从袋子中抽出一个号码,并告诉他们该号码将是他们在整个研究过程中的参与者ID。

- 让参与者使用其匿名参与者 ID 填写在线人口统计表。

注意:至关重要的是,参与者在实验前看不到演员。因此,这项文书工作是在另一个房间而不是主实验室完成的,以便演员可以在参与者之间休息。

- 实验步骤

- 在实验者PC上打开实验软件,打开实验脚本1.m脚本并运行它。

- 填写参与者ID和年龄;然后,脚本将开始实验的第一部分(第一个可见刺激将是参与者显示中心的十字。

- 在ActorPC上打开实验软件,然后打开ActorMachine.m脚本。

- 将相机PC放在实验者PC附近,并确保来自安全摄像机的镜头对参与者不可见。

- 欢迎参与者来到主实验室,让他们在参与者显示屏前坐下。

- 告诉参与者自己安排自己,使十字架在中间并笔直前方。

- 通过参考白板上写的解释和持续时间,简要说明实验的各个部分。

- 关掉实验室里的所有灯。

- 实验部分 1:

- 告诉参与者他们将在实验的第一部分完成词汇/概念训练。警告他们小心遵循说明,以便他们能够通过培训。

- 告诉参与者,当他们准备好时,可以开始实验。

- 当参与者说他们已经准备好进行第一部分时,按下 ESC 按钮。

注意:从现在开始,参与者将通过阅读参与者显示屏上的说明并选择其中一个选项来完成实验。他们将收到有关正确和错误答案的反馈,以便他们在培训中取得良好进展。匹配将持续到参与者在 10 次块重复内达到最低阈值 (80%)。 - 当参与者完成训练部分时,按下ESC按钮,并告诉参与者实验者正在控制鼠标开始实验的第二部分。

- 实验部分 2:

- 打开 ExperimentScript2.m 脚本,等待提示等待 Actor PC。

- 看到提示时按铃,以便其中一个参与者可以在ActorPC上运行脚本以启用与实验者PC的连接。

- 等待 提示实验第 2 部分准备就绪。

- 告诉参与者,现在屏幕将是透明的,而他们通过它观看一些简短的动作。

- 警告他们仔细观察每个动作,并告知他们应该大声说出动作。

- 告诉参与者,当他们准备好时,可以开始实验。

- 当参与者说他们已经准备好进行第一部分时,按下 ESC 按钮。

注意:参与者按照说明进行操作并观看第一个动作。Actor1 在 LED 灯打开时执行操作,并在灯关闭时从 Actor PC 上的提示中检查下一个操作。当每个操作结束时,实验者PC屏幕上将出现一个对话框。 - 在对话框中键入参与者对操作的评价,并在第二个对话框中键入 1 或 0,具体取决于操作的正确或错误标识。

注意:对于第一个演员,这些步骤将重复八次,当演员需要换位时,背景音乐将开始播放。 - 从摄像机PC上的安全摄像头镜头观看后台。

- 按下 ESC 按钮开始识别 Actor2,当 actor 以" 我准备好了" 手势向安全摄像头挥手时。

- 与参与者一起重复步骤 4.4.7 和步骤 4.4.8,直到在 Actor2 执行时也识别出相同的八个动作。

- 当参与者看到 识别完成 警告并通过单击箭头退出零件时,按下 ESC 按钮,并告诉参与者实验者正在控制鼠标开始实验的第三部分。

- 实验部分 3:

- 打开 ExperimentScript3.m 脚本。

- 告诉参与者他们将观看两个演员的行为,然后他们将单击他们认为合适的选项。

注意:参与者将在四个区块中评估参与者的行为。在其中两个块中,Actor1 将执行操作,在另外两个块中,Actor2 将执行相同的操作。在其中两个区块中,参与者将通过归因于高或低机构能力来评估行动,在另外两个区块中,他们将归因于高或低经验能力。 - 当参与者说他们已经准备好进行第三部分时,按下 ESC 按钮。

注意:参与者按照说明进行,他们从第一个块开始。演员在灯光下表演动作,当参与者给出他们的回应时,屏幕变得不透明,灯光被关闭,以便演员可以看到下一个动作。当每个块结束时,Actor将按照ActorPC上的提示改变位置。 - 检查后台是否一切顺利,以及正确的演员在阻止期间是否进行了正确的动作。

- 按下 ESC 按钮开始下一个块,当合适的演员在更换演员后用 "我准备好了" 手势挥手时。

- 与参与者和参与者合作重复步骤4.5.4和步骤4.5.5,直到四个块完成。

- 当参与者看到 实验结束,谢谢 提示时,按 ESC 按钮。

- 感谢参与者,并在汇报和签名后,将参与者送出去。

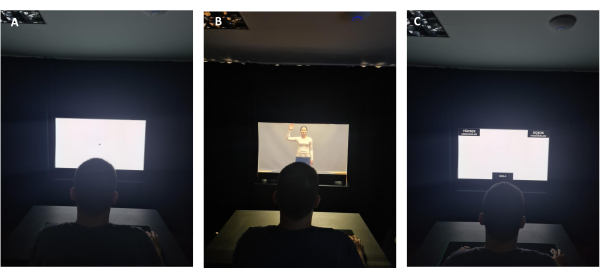

图 5 显示了参与者视图中的示例试验。 图 5A 显示了参与者在不透明的情况下查看屏幕中心的光标。 图5B 显示了参与者通过屏幕观看实时刺激。 图5C 显示了刺激后呈现给参与者的评估屏幕,他们需要将鼠标拖动到屏幕每个顶角的两个选项之一。

图5:从参与者的角度看OLED屏幕 。 (A)在注视屏幕期间从参与者的角度不透明地使用OLED数字屏幕。(B)在演示真人表演期间从参与者的角度透明地使用OLED数字屏幕。 (C)在响应期间从参与者的角度不透明地使用OLED数字屏幕。 请点击此处查看此图的大图。

5. 数据预处理和分析

- 将数据细分为条件

- 将所有参与者数据文件读入软件环境的工作区。

- 定义数据分组的条件(两个操作类 [操作类 1 和操作类 2] x 两个参与者 [参与者 1 和参与者 2] x 两个维度 [代理和体验] x 两个级别 [高和低])。

- 将数据分为四个主要组:代理机构高、代理低、体验高和体验低。

- 将这些主要组划分为四个子组(两个参与者 x 两个操作类)。

- 遍历每个数据文件,对属于先前定义的四个子组之一的试验进行分组。

- 将相关试验信息(响应时间、光标移动和对光标位置进行采样的时间点)存储在每个子组的单独数据结构中。

- 当所有试验都分组时退出循环。

- 轨迹可视化

- 分割数据后,执行以下步骤以可视化鼠标轨迹。

- 要将时间插值应用于响应轨迹,请为每个试验从轨迹数组中选择 101 (x,y) 对,以便每个数据子组都具有具有相同时间步长的试验。

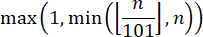

注意:在将对数锚定为 101 时,请确保遵循约定32进行正确的时间归一化。因此,使用以下等式实现时间归一化,其中 n 是轨迹数组中的样本数:

- 计算 101 个时间点中每个时间点的 (x,y) 对的总和,然后将获得的结果除以该子组的试验总数,以获得每个子组的均值(例如,体验低参与者1或体验低参与者2)。

- 对行值应用缩放操作以可视化平均轨迹。

注意: 2D 坐标平面假定两个轴都从位于窗口左下角的零点增加(假设坐标为正整数),而像素格式将窗口的左上角作为参考(例如,零点)。因此,通过从总行数的值中提取每个试验的采样 y 坐标,对采样位置的 y 坐标(对应于像素格式的行值)应用缩放操作。 - 在同一图中绘制相关子组进行比较。

注意: 每条轨迹从位于底部中心的矩形中心开始,标记为 START,并在位于左上角或右上角的矩形内结束。

6. 可能导致系统故障的情况和注意事项

注意:如果系统发生故障,至关重要的是有一个物理标志(按铃)让参与者知道故障并警告他们留在参与者看不见的地方。

- 由于网络连接而失败

- 如果其中一台计算机连接到其他网络,TCP/IP 连接请求将失败,并且系统将显示错误。为防止出现这种情况,请确保实验者电脑和演员电脑位于同一无线网络的同一频段上。

- 若要确保两台 PC 保持在同一网络上,请从两台 PC 中擦除以前连接的无线网络。

- 为所选网络上的设备设置静态 IP 地址,因为网络上的 IP 地址可能会更改,恕不另行通知。

- 与网络的任何短暂断开连接(例如,由于断电、互联网中断等)都可能导致脚本失败。在这些情况下,需要从头开始重新启动系统以重新建立 TCP/IP 连接。

注意:互联网服务提供商可以满足设备的静态IP要求。某些端口可能被给定设备上的操作系统或硬件禁用;因此,必须在实验中使用的端口处于打开状态,并且在实验脚本启动之前不得具有活动连接。

- 由于软件崩溃而导致的故障

- 软件环境可能会因连接失败(例如,串口连接、TCP/IP 连接、显示连接等)而崩溃,这可能会导致数据丢失。若要解决此问题,请将主实验脚本划分为多个脚本。例如,如果在Actor开始执行操作之前需要完成一个块,则在此块期间无需在Experimenter PC上创建服务器。当涉及操作的块即将启动时,可以创建服务器,因此需要在实验者PC和Actor PC之间进行通信。

结果

响应时间 (RT) 比较

目前的研究是一个正在进行的项目,因此,作为代表性结果,提供了来自实验主要部分(实验部分3)的数据。这些数据来自40名参与者,包括23名女性和17名男性,年龄在18-28岁之间(M = 22.75,SD = 3.12 )。

有必要调查因变量分布的正态性程度,以便为分析选择适当的统计方法。因此,执行夏皮罗-威尔克检验以了解三个因变量?...

讨论

本研究的首要目标是有助于我们理解人类高级视觉感知和认知在现实生活中如何工作。这项研究的重点是动作感知,并提出了一种自然但可控的实验范式,使研究人员能够通过在实验室环境中展示真实的演员来测试个人如何感知和评估他人的行为。

与现有方法相比,这一拟议方法的意义有三个方面。(1)通过向参与者展示现场动作,最大限度地发挥刺激的自然性。(2)现实...

披露声明

作者声明,他们与本文所述的研究没有相关或重大的经济利益。

致谢

这项工作得到了土耳其科学技术研究委员会(项目编号:120K913)和比尔肯特大学对 Burcu A. Urgen 的资助。我们感谢我们的飞行员参与者Sena Er Elmas带来了在演员变化之间添加背景噪音的想法,Süleyman Akı设置灯光电路,Tuvana Karaduman在后台使用安全摄像头的想法以及她作为研究中演员之一的贡献。

材料

| Name | Company | Catalog Number | Comments |

| Adjustable Height Table | Custom-made | N/A | Width: 60 cm, Height: 62 cm, Depth: 40 cm |

| Ardunio UNO | Smart Projects | A000066 | Microcontroller used for switching the state of the LEDs from the script running on the operator PC |

| Black Pants | No brand | N/A | Relaxed-fit pants of actors with no apparent brand name or logo. |

| Case | Xigmatek | EN43224 | XIGMATEK HELIOS RAINBOW LED USB 3.0 MidT ATX GAMING CASE |

| CPU | AMD | YD1600BBAFBOX | AMD Ryzen 5 1600 Soket AM4 3.2 GHz - 3.6 GHz 16 MB 65 W 12 nm Processor |

| Curtains | Custom-made | N/A | Width: Part 1: 110 cm width from the wall (left) side, Part 2: 123 cm width above OLED display, Part 3: 170 cm from OLED display to right side, Cabin depth: 100 cm, Inside cabin depth: 100 cm, all heights 230 cm except for Part 2 (75 cm height) |

| Experimenter Adjustable/Swivel Chair | No brand | N/A | Any brand |

| Experimenter Table | Custom | N/A | Width: 160 cm, Height: 75 cm, Depth: 80 cm |

| GPU | MSI | GT 1030 2GHD4 LP OC | MSI GEFORCE GT 1030 2GHD4 LP OC 2GB DDR4 64bit NVIDIA GPU |

| Grey-color blackout curtain | Custom-made | N/A | Width: 330 cm, Height: 230 cm, used for covering the background |

| Hard Disk | Kioxia | LTC10Z240GG8 | Kioxia 240 GB Exceria Sata 3.0 SSD (555 MB Read/540 MB Write) |

| Hard Disk | Toshiba | HDWK105UZSVA | Toshiba 2,5'' 500 GB L200 SATA 3.0 8 MB Cache 5400 Rpm 7 mm Harddisk |

| High-Power MOSFET Module | N/A | N/A | Heating Controller MKS MOSFET Module |

| Laptop | Apple | S/N: C02P916ZG3QT | MacBook Pro 11.1 Intel Core i7 (Used as the actor PC) |

| Laptop | Asus | UX410U | Used for monitoring the security camera in real-time. |

| LED lights | No brand | N/A | |

| LED Strip Power Supply | No brand | N/A | AC to DC voltage converter used for supplying DC voltage to the lighting circuit |

| MATLAB | The MathWorks Inc., Natick, MA, USA | Version: R2022a | Used for programming the experiment. Required Toolboxes: MATLAB Support Package for Arduino Hardware (version 22.1.2) Instrument Control Toolbox (version 4.6) Psychtoolbox (version 3) |

| Monitor | Philips | UHB2051005145 | Model ID: 242V8A/00, PHILIPS 23.8" 242V8A 4ms 75 Hz Freesync DP-HDMI+VGA IPS Gaming Monitor |

| Motherboard | MSI | B450M-A PRO MAX | MSI B450M-A PRO MAX Amd B450 Socket AM4 DDR4 3466(OC) M.2 Motherboard |

| Mouse Pad for participant | Monster | 78185721101502042 / 8699266781857 | Pusat Gaming Mouse Pad XL |

| Night lamp | Aukes | ES620-0.5W 6500K-IP 20 | Used for helping the actors see around when the lights are off in the backstage. |

| Participant Adjustable/Swivel Chair | No brand | N/A | |

| Participant Table | IKEA | Sandsberg 294.203.93 | Width: 110 cm, Height: 75 cm, Depth: 67 cm |

| Power Extension Cable | Viko | 9011760Y | 250 V (6 inlets) Black |

| Power Extension Cable | Viko | 9011730Y | 250 V (3 inlets) Black |

| Power Extension Cable | Viko | 9011330Y | 250 V (3 inlets) White |

| Power Extension Cable | s-link | Model No: SPG3-J-10 | AC - 250 V 3 meter (5 inlets) |

| Power Supply | THERMALTAKE | PS-LTP-0550NHSANE-1 | THERMALTAKE LITEPOWER RGB 550W APFC 12 cm FAN PSU |

| Professional Gaming Mouse | Rampage | 8680096 | Model No: SMX-R50 |

| RAM | GSKILL | F4-3000C16S-8GVRB | GSKILL 8GB (1x8GB) RipjawsV Red DDR4 3000 MHz CL16 1.35 V Single Ram |

| Reception bell | No brand | N/A | Used for helping the communication between the experimenter and the actors. |

| Security Camera | Brion Vega | 2-20204210 | Model:BV6000 |

| Speakers | Logitech | P/N: 880-000-405 PID: WD528XM | Used for playing the background music. |

| Survey Software | Qualtrics | N/A | |

| Switching Module | No brand | N/A | F5305S PMOS Switch Module |

| Table under the OLED display | Custom-made | N/A | Width: 123 cm, Height: 75 cm, Depth: 50 cm |

| Transparent OLED Display | Planar | PN: 998-1483-01 S/N:195210075 | A 55-inch transparent display that showcases dynamic information, enabled the opaque and transparent usage during the experiment. |

| UPS | EAG | K200610100087 | EAG 110 |

| UPS | EAG | 210312030507 | EAG 103 |

| USB 2.0 Cable Type A/B for Arduino UNO (Blue) | Smart Projects | M000006 | Used to connect the microcontroller to the experimenter PC. |

| USB to RS232 Converter | s-link | 8680096082559 | Model: SW-U610 |

| White Long-Sleeved Blouse (2) | H&M (cotton) | N/A | Relaxed-fit blouses with a round neckline and without ant apparent brand name or logo. |

| Wireless Keyboard | Logitech | P/N: 820-003488 S/N: 1719CE0856D8 | Model: K360 |

| Wireless Mouse | Logitech | S/N: 2147LZ96BGQ9 | Model: M190 (Used as the response device) |

参考文献

- Grossman, E. D., Blake, R. Brain areas active during visual perception of biological motion. Neuron. 35 (6), 1167-1175 (2002).

- Saygin, A. P. Superior temporal and premotor brain areas necessary for biological motion perception. Brain. 130 (9), 2452-2461 (2007).

- Peelen, M. V., Downing, P. E. The neural basis of visual body perception. Nature Reviews Neuroscience. 8 (8), 636-648 (2007).

- Caspers, S., Zilles, K., Laird, A. R., Eickhoff, S. B. ALE meta-analysis of action observation and imitation in the human brain. Neuroimage. 50 (3), 1148-1167 (2010).

- Nelissen, K., et al. Action observation circuits in the macaque monkey cortex. Journal of Neuroscience. 31 (10), 3743-3756 (2011).

- Oosterhof, N. N., Tipper, S. P., Downing, P. E. Crossmodal and action-specific: Neuroimaging the human mirror neuron system. Trends in Cognitive Sciences. 17 (7), 311-318 (2013).

- Lingnau, A., Downing, P. E. The lateral occipitotemporal cortex in action. Trends in Cognitive Sciences. 19 (5), 268-277 (2015).

- Giese, M. A., Rizzolatti, G. Neural and computational mechanisms of action processing: Interaction between visual and motor representations. Neuron. 88 (1), 167-180 (2015).

- Tucciarelli, R., Wurm, M., Baccolo, E., Lingnau, A. The representational space of observed actions. eLife. 8, e47686 (2019).

- Tarhan, L., Konkle, T. Sociality and interaction envelope organize visual action representations. Nature Communications. 11 (1), 3002 (2020).

- Urgen, B. A., Saygin, A. P. Predictive processing account of action perception: Evidence from effective connectivity in the action observation network. Cortex. 128, 132-142 (2020).

- Newen, A., De Bruin, L., Gallagher, S. . The Oxford Handbook of 4E Cognition. , (2018).

- Snow, J. C., Culham, J. C. The treachery of images: How realism influences brain and behavior. Trends in Cognitive Sciences. 25 (6), 506-519 (2021).

- Matusz, P. J., Dikker, S., Huth, A. G., Perrodin, C. Are we ready for real-world neuroscience. Journal of Cognitive Neuroscience. 31 (3), 327-338 (2019).

- Zaki, J., Ochsner, K. The need for a cognitive neuroscience of naturalistic social cognition. Annals of the New York Academy of Sciences. 1167 (1), 16-30 (2009).

- Hasson, U., Honey, C. J. Future trends in Neuroimaging: Neural processes as expressed within real-life contexts. NeuroImage. 62 (2), 1272-1278 (2012).

- Risko, E. F., Laidlaw, K. E., Freeth, M., Foulsham, T., Kingstone, A. Social attention with real versus reel stimuli: toward an empirical approach to concerns about ecological validity. Frontiers in Human Neuroscience. 6, 143 (2012).

- Parsons, T. D. Virtual reality for enhanced ecological validity and experimental control in the clinical, affective and social neurosciences. Frontiers in Human Neuroscience. 9, 660 (2015).

- Deuse, L., et al. Neural correlates of naturalistic social cognition: brain-behavior relationships in healthy adults. Social Cognitive and Affective Neuroscience. 11 (11), 1741-1751 (2016).

- Camerer, C., Mobbs, D. Differences in behavior and brain activity during hypothetical and real choices. Trends in Cognitive Sciences. 21 (1), 46-56 (2017).

- Nastase, S. A., Goldstein, A., Hasson, U. Keep it real: Rethinking the primacy of experimental control in cognitive neuroscience. NeuroImage. 222, 117254 (2020).

- Kihlstrom, J. F. Ecological validity and "ecological validity". Perspectives on Psychological Science. 16 (2), 466-471 (2021).

- Brunswik, E. . Perception and the Representative Design of Psychological Experiments. , (1956).

- Aronson, E., Carlsmith, J. M., Gilbert, D. T., Fiske, S. T., Lindzay, G. Experimentation in social psychology. The Handbook of Social Psychology. , 1-79 (1968).

- Ecological validity: Then and now. University of Colorado Available from: https://www.albany.edu/cpr/brunswik/notes/essay1.html (1998)

- Fan, S., Dal Monte, O., Chang, S. W. Levels of naturalism in social neuroscience research. IScience. 24 (7), 102702 (2021).

- Orban, G. A., Lanzilotto, M., Bonini, L. From observed action identity to social affordances. Trends in Cognitive Sciences. 25 (6), 493-505 (2021).

- Gray, H. M., Gray, K., Wegner, D. M. Dimensions of mind perception. Science. 315 (5812), 619 (2007).

- Li, Z., Terfurth, L., Woller, J. P., Wiese, E. Mind the machines: Applying implicit measures of mind perception to social robotics. 2022 17th ACM/IEEE International Conference on Human-Robot Interaction (HRI. , 236-245 (2022).

- Karpinski, A., Steinman, R. B. The single category implicit association test as a measure of implicit social cognition. Journal of Personality and Social Psychology. 91 (1), 16 (2006).

- Greenwald, A. G., McGhee, D. E., Schwartz, J. L. Measuring individual differences in implicit cognition: the implicit association test. Journal of Personality and Social Psychology. 74 (6), 1464 (1998).

- Freeman, J. B., Ambady, N. MouseTracker: Software for studying real-time mental processing using a computer mouse-tracking method. Behavior Research Methods. 42 (1), 226-241 (2010).

- Pekçetin, T. N., Barinal, B., Tunç, J., Acarturk, C., Urgen, B. A. Studying mind perception in social robotics implicitly: The need for validation and norming. Proceedings of the 2023 ACM/IEEE International Conference on Human-Robot Interaction. , 202-210 (2023).

- Yu, Z., Wang, F., Wang, D., Bastin, M. Beyond reaction times: Incorporating mouse-tracking measures into the implicit association test to examine its underlying process. Social Cognition. 30 (3), 289-306 (2012).

- Romero, C. A., Snow, J. C. Methods for presenting real-world objects under controlled laboratory conditions. Journal of Visualized Experiments. (148), e59762 (2019).

- Jastorff, J., Abdollahi, R. O., Fasano, F., Orban, G. A. Seeing biological actions in 3 D: An f MRI study. Human Brain Mapping. 37 (1), 203-219 (2016).

- Ferri, S., Pauwels, K., Rizzolatti, G., Orban, G. A. Stereoscopically observing manipulative actions. Cerebral Cortex. 26 (8), 3591-3610 (2016).

- Stangl, M., Maoz, S. L., Suthana, N. Mobile cognition: Imaging the human brain in the 'real world. Nature Reviews Neuroscience. 24 (6), 347-362 (2023).

- Kriegeskorte, N. Deep neural networks: a new framework for modeling biological vision and brain information processing. Annual Review of Vision Science. 1, 417-446 (2015).

- Marblestone, A. H., Wayne, G., Kording, K. P. Toward an integration of deep learning and neuroscience. Frontiers in Computational Neuroscience. 10, 94 (2016).

转载和许可

请求许可使用此 JoVE 文章的文本或图形

请求许可探索更多文章

This article has been published

Video Coming Soon

版权所属 © 2025 MyJoVE 公司版权所有,本公司不涉及任何医疗业务和医疗服务。