このコンテンツを視聴するには、JoVE 購読が必要です。 サインイン又は無料トライアルを申し込む。

Method Article

実験心理学と認知神経科学研究における実在の人物と実写を提示するための自然主義的な設定

要約

この研究は、研究者がリアルタイムの行動刺激を提示し、参加者が各刺激表示後に応答している間に応答時間とマウス追跡データを取得し、特別な透明有機発光ダイオード(OLED)スクリーンと光操作を含む独自のシステムを使用して実験条件間でアクターを変更できるようにする自然主義的な実験セットアップを提示します。

要約

他人の行動の認識は、生存、相互作用、およびコミュニケーションにとって重要です。行動の知覚を理解することに専念する何十年にもわたる認知神経科学の研究にもかかわらず、人間の行動知覚にアプローチする神経に触発されたコンピュータービジョンシステムの開発にはまだほど遠いです。大きな課題は、現実世界での行動が、「今ここ」で起こり、受け入れられる空間で時間的に展開するイベントで構成されていることです。これに対し、これまでの視覚知覚や認知神経科学の研究は、2次元ディスプレイ(画像や映像など)による行動知覚の研究が中心で、空間や時間にアクターが存在しないため、演技性に限界がある。この分野での知識が増えているにもかかわらず、現実の世界における他者の行動の認識の基本的なメカニズムをよりよく理解するためには、これらの課題を克服する必要があります。この研究の目的は、現実世界の設定に近いシナリオで、生きている俳優と自然主義的な実験室実験を行うための新しいセットアップを導入することです。この研究で使用されたセットアップのコア要素は、参加者がプレゼンテーションのタイミングを正確に制御しながら、物理的に存在する俳優のライブアクションを見ることができる透明な有機発光ダイオード(OLED)スクリーンです。この作業では、このセットアップを行動実験でテストしました。このセットアップは、研究者が行動知覚の基本的で以前はアクセスできなかった認知および神経メカニズムを明らかにするのに役立ち、自然主義的な環境における社会的知覚と認知を調査する将来の研究の基礎となると信じています。

概要

生存と社会的相互作用のための基本的なスキルは、他人の行動を認識して理解し、周囲の環境で彼らと相互作用する能力です。過去数十年の以前の研究は、個人が他人の行動をどのように認識し理解するかの基本原則を理解するのに大きく貢献しました1,2,3,4,5,6,7,8,9,10,11 .それにもかかわらず、相互作用の複雑さとそれらが発生する状況を考えると、日常生活環境におけるこの複雑なスキルをより完全に理解するために、自然主義的な設定で知識体系をさらに発展させる必要があることは明らかです。

私たちの日常生活環境などの自然環境では、知覚と認知は、具体化され、埋め込まれ、拡張され、活動的な特性を示します12。身体と環境の役割を過小評価する傾向がある脳機能の内部主義的な説明とは対照的に、身体化された認知への現代のアプローチは、脳、身体、環境の動的な結合に焦点を当てています。一方、行動知覚に関するほとんどの社会心理学、認知心理学、および神経科学の研究は、実験室の条件(例えば、コンピュータ化されたタスクの画像またはビデオ)で十分に制御され単純化された実験デザインを利用することで、現実世界の相互作用などのより複雑なシナリオに一般化できる結果が得られると仮定する傾向があります1,2,3,4,5,6,7 ,8,9,10,11.この仮定により、多くの状況下で堅牢で信頼性の高いデータを取得できることが保証されます。それにもかかわらず、よく知られている課題は、慎重に制御された実験から導き出されたモデルの有効性が、実際のコンテキストでテストされた場合に制限されることです13。その結果、さまざまな研究分野における刺激と実験計画の生態学的および外部的妥当性に対処するために、さらなる調査13、14、15、16、17、18、19、20、21、22が実施されました。

本研究では、個人が他者の行動をどのように認識し、評価するかを、現実の物理的に存在する俳優によって実行されるライブアクションを使用して調査するための新しい方法を提案します。実際のコンテキストと同様のシナリオが採用され、実験者は考えられる交絡因子を制御できます。この研究は、Matusz et al.14の枠組みの中での「自然主義的な実験室研究」の一形態であり、刺激と環境を最大限に制御し、しばしば自然性を犠牲にする「古典的な実験室研究」と、刺激と環境の制御を犠牲にして自然性を最大化することを目的とした「完全に自然主義的な現実世界の研究」の中間段階として考えることができます14.この研究は、高度な実験制御を伴う従来の実験室実験で得られた発見と、完全に制約のない自然環境で行われた研究で得られた発見との間のギャップを埋めるために、行動知覚研究におけるこのレベルでの経験的調査の必要性に対処することを目的としています。

対照実験と制約なし実験

実験的制御は、研究者がターゲット変数を交絡因子の可能性から分離できるため、特定の仮説をテストするための実験を設計するための効率的な戦略です。また、同じデザインでわずかにまたはまったく異なる刺激を使用したり、代替の実験設定で同じ刺激をテストしたりするなど、特定のレベルの修正で同じ仮説を再検討することもできます。対照実験による体系的な調査は、認知科学および関連分野の研究における伝統的な方法論です。制御された実験は、注意、記憶、知覚などのさまざまな研究領域における認知プロセスの基本原理に関する知識体系を確立するのに役立ちます。しかし、最近の研究では、調査結果を実際の環境に一般化するという点で、従来の実験室実験の限界も認められており、研究者は強化された生態学的環境で研究を行うことが奨励されています13,14,15,16,17,18,19,20,21.このシフトは、従来の実験室実験と実際の設定との間の不一致に関する2つの重要な問題に対処することを目的としています。第一に、実験室の外の世界は実験よりも決定論的ではなく、体系的な実験操作の代表的な力を制限します。第二に、人間の脳は非常に適応性が高く、実験的研究の設計と実施の実際的な制限のために、これはしばしば過小評価されています22。「生態学的妥当性」23,24の概念は、この問題を解決する方法に取り組むために使用されてきました。この用語は通常、実験室の文脈の外で実験結果を現実世界に一般化するための前提条件を指すために使用されます。生態学的妥当性は、研究デザインが実際のシナリオに類似していることを確認するために、制約のない刺激で事実上自然主義的な実験設定を検証することを指すとも解釈されています25。この用語の解釈には大きなばらつきがあるため、代替方法論と刺激選択の利点と限界を理解する必要があります。

刺激と実験計画における自然主義のレベル

実験心理学と認知神経科学の以前の研究では、さまざまなレベルの自然主義を持つ幅広い刺激を使用していました26。ほとんどの研究者は、実際のアクションやイベントをシミュレートできる刺激よりも準備が簡単なため、静止画像または短い動的ビデオを使用することを好みます。利点があるにもかかわらず、これらの刺激は研究者が社会的エージェント間の偶発的な行動を測定することを可能にしない。言い換えれば、彼らは行動可能ではなく、社会的アフォーダンスを持っていません27。近年、これらの非インタラクティブな刺激に代わるものが開発されています:仮想アバターのリアルタイムアニメーション。これらのアバターを使用すると、アバターとそのユーザー間の相互作用を調査できます。ただし、仮想アバターの使用は、特に現実的で偶発的な行動に関して特に魅力的ではないように見える場合、ユーザーの不安が軽減される可能性があります26。したがって、実験的研究において実際の社会的刺激を使用することへの関心が高まっています。それらの設計、データ記録、および分析には高度な機器と複雑なデータ分析が必要になる場合がありますが、自然主義的な人間の行動と認知を理解するための最良の候補です。

本研究では、実験室環境における実生活の社会的刺激を使用するための方法論を提案する。この研究は、従来の実験室実験と比較して生態学的妥当性が強化された環境で、人々が他者の行動をどのように認識および評価するかを調査することを目的としています。私たちは、参加者が物理的に存在し、彼らと同じ環境を共有する実際の俳優にさらされる新しいセットアップを開発し、説明しました。このプロトコルでは、参加者の応答時間とマウスの軌跡が測定されるため、刺激提示の正確なタイミングと、この強化された生態学的環境での実験条件の厳密な制御が必要です。したがって、実験パラダイムは、環境の制御を犠牲にすることなく刺激の自然さが最大化されるため、文献に存在するフレームワークの中で際立っています。以下に、プロトコルはそのようなシステムを確立するためのステップを示し、次にサンプルデータの代表的な結果を続けます。最後に、パラダイムの重要性、制限、および変更の計画について説明します。

実験計画

プロトコルのセクションに進む前に、本研究で使用されたパラメータについて説明し、刺激の詳細を実験計画とともに提示します。

研究におけるパラメータ

この研究は、俳優のタイプと彼らが実行する行動のクラスが参加者の心の知覚プロセスにどのように影響するかを測定することを目的としています。プロトコルでは、心の知覚プロセスは、以前の研究28で提案されているように、エージェンシーと経験の2つの主要な次元で測定されます。これら2つの次元の上限と下限も含まれており、Liらによって最近導入された29。

この研究の構造は、一般的に使用される暗黙的関連タスク(IAT)31 の単一カテゴリバージョン30に触発されました。このタスクでは、参加者が属性コンセプトとターゲットコンセプトを一致させる際の応答時間を、これら 2 つのコンセプトに対する暗黙的な関連付けの強さを示すものとして使用します。この暗黙のタスクの適応では、参加者は実際の俳優によって実行されるライブアクションを提示され、それらをターゲットの概念に一致させる必要があります。ターゲットの概念は、実験のブロックに応じて、エージェンシーまたはエクスペリエンスのディメンションの上限と下限です。

要約すると、独立変数はアクタータイプとアクションクラスです。 アクター タイプには 2 つのレベルがあります (つまり、2 つの異なるアクター、Actor1 と Actor2 がスタディでパフォーマンスを発揮します)。アクション クラスには、アクション クラス 1 とアクション クラス 2 の 2 つのレベルがあり、各クラスには 4 つのアクションが含まれています。参加者は、2 つのアクターを 4 つのブロック (各ブロックに 1 人のアクター) で個別に評価し、各ブロックで、アクターはすべてのアクションをカウンターバランスの順序で実行します。参加者は、エージェンシーと経験という2つの事前定義された強制的な次元に関して評価を実行します。実験の 4 つのブロックは、(1) エージェンシー ブロックのアクター 1、(2) エージェンシー ブロックのアクター 2、(3) エクスペリエンス ブロックのアクター 1、(4) エクスペリエンス ブロックの アクター 2 です。ブロックの順序も参加者間で相殺されるため、同じエージェントを持つブロックが互いに続くことはありません。

参加者の回答に加えて、2つの応答選択肢のいずれかに向かって移動している間に使用するワイヤレスマウスの応答時間とx-y座標が記録されます。したがって、従属変数は、参加者の応答と応答時間(RT)、およびコンピューターのマウス追跡から導出された最大偏差(MD)と曲線下面積(AUC)の測定値です。変数応答はカテゴリです。高または低にすることができ、評価は指定されたブロックのいずれかで行われるため、応答は高エージェンシー、低エージェンシー、高経験、または低経験としてラベル付けすることもできます。応答時間は連続変数です。その単位は秒であり、アクションの表示の開始から応答の選択肢の1つでのマウスクリックの発生までの経過時間を指します。軌道のMDは連続変数であり、参加者の軌道と理想化された軌道(直線)との間の最大の垂直偏差を指します。軌道のAUCも連続変数であり、参加者の軌道と理想化された軌道32との間の幾何学的領域を指す。

実験の刺激と計画

本研究では、3段階の実験が使用されています。3番目の部分からの測定値が分析に使用されます。最初の2つの部分は、最後の部分の準備として機能します。以下では、実験の各部分を実験刺激と仮説とともに説明します。

実験パート1(語彙トレーニングパート)では、参加者は、エージェンシーと経験の概念と、高と低という言葉で表される能力レベルを理解するためのトレーニングセッションを完了します。このトレーニングセッションで使用される概念(n = 12)を選択するために、現在の研究の著者の何人かは規範的研究を実施しました33。本研究は参加者の母国語で実施される予定であったため、概念もトルコ語に翻訳されてから正規化されました。概念は、2つの次元の高値(n = 3)と安値(n = 3)の端に強く関連するものの中から選択されました(それぞれ6つの概念)。参加者の概念の理解が評価プロセスの指針となることが期待されるため、この部分は非常に重要です。

実験パート2(行動識別部分)では、参加者はActor1とActor2が行う同じ8つのアクションを次々に見て、そのアクションが何であるかを実験者に報告します。このセクションは操作チェックとして機能します。両方のアクターが実行しているときにすべてのアクションを提示することで、参加者がアクションを理解し、アクターに精通していることを確認してから、迅速な評価を行う必要がある暗黙のテストを開始できます。アクションクラス1とアクションクラス2に選択されたアクションは、一部の著者が実施した各アクター条件(準備中の原稿)について2つの規範的研究(N = 219)の結果によると、Hスコアと信頼水準が最も高いアクション(各アクションクラスで4つの異なるアクションの例)でした。すべてのアクションは、6秒の等しい時間内に実行されます。

これは進行中の研究であり、他にもいくつかの要素があります。ただし、上記のセクションの仮説は次のとおりです:(i)アクターのタイプが従属変数に影響を与えます。アクター 2 は、アクター 1 と比較して、より長い RT、より高い MD、およびより大きな AUC を生成します。(ii)アクションの種類が従属測定に影響を与える。アクション クラス 1 は、アクション クラス 2 と比較して、より長い RT、より高い MD、およびより大きな AUC を生成します。(iii)同じアクターとアクションクラスに対する高応答と低応答の従属測定値は、ブロックディメンション(エージェンシーとエクスペリエンス)全体で異なります。

プロトコル

この研究の実験プロトコルは、ビルケント大学の人間参加者との研究のための倫理委員会によって承認されました。研究に含まれるすべての参加者は18歳以上であり、研究を開始する前にインフォームドコンセントフォームを読んで署名しました。

1. 一般的な設計手順

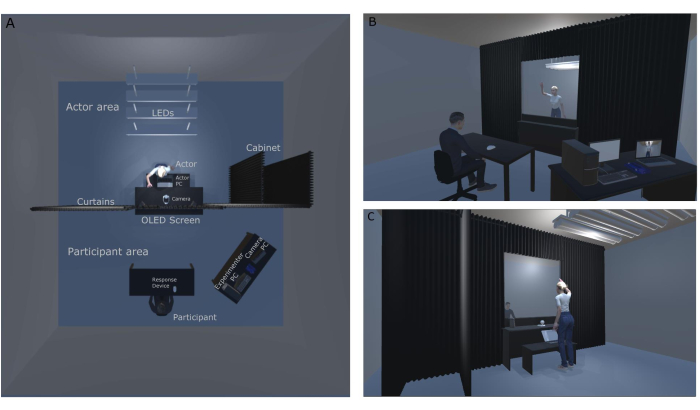

注:図1A(上面図)と図1Bおよび図1C(正面図と背面図)は、実験室のレイアウトを示しています。これらの数値は、この特定の研究のために設計された元のラボのセットアップと構成に関して作成されました。図 1A は、ラボの上面図 レイアウトを示しています。この図では、天井とアクターキャビネットにLEDライトが見えます。遮光カーテンシステムは部屋を半分に分割し、部屋の前部(参加者エリア)への光の漏れを防ぐことで光の操作を支援します。図1Bは、実験者の視点から見た実験室のビューを示しています。参加者はOLEDスクリーンの前に座り、シースルーディスプレイを使用して、俳優が演じるライブアクションを見ることができます。彼らは彼らの前にいる応答デバイス(ワイヤレスマウス)を使って彼らの応答を与えます。実験者は、参加者のディスプレイ(OLED画面)と防犯カメラからの映像を同時に見ることができます。図1Cは、参加者には見えない防犯カメラとアクターパーソナルコンピューター(PC)を使用した研究の舞台裏(アクターエリア)を示しています。防犯カメラの映像はカメラPCに送られ、俳優と実験者の間の通信が確立されます。アクター PC は、ブロックの順序と次のアクション情報をアクターに表示するため、実験は中断することなく流れます。アクターは、参加者が前の試行のアクションに応答している間に、次のアクションをすばやく確認できます。

図1:自然主義的な実験室のセットアップ 。 (A)自然主義的な実験室のセットアップのトップダウンビュー。(B)参加者の視点から見た自然主義的な実験セットアップの裏側と表側。(C)俳優の視点から見た自然主義的な実験設定の裏側と表側。 この図の拡大版を表示するには、ここをクリックしてください。

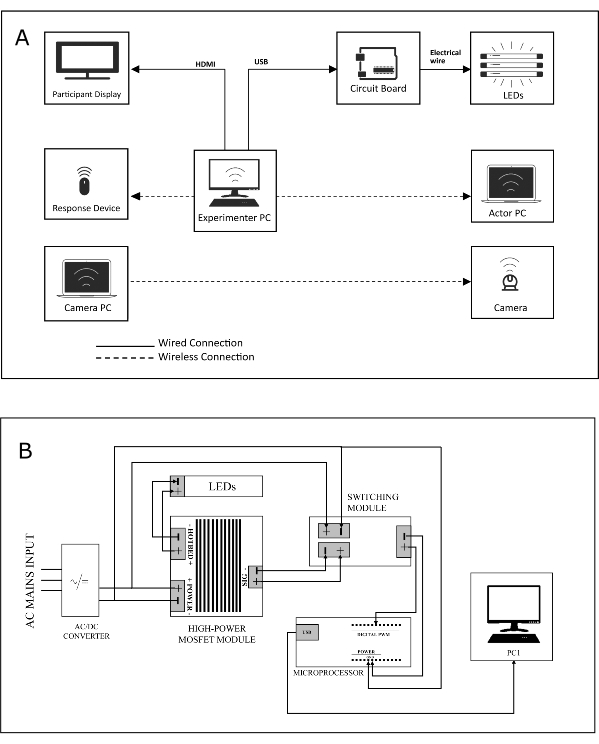

- (1)メインコントロールデスクトップ(実験PC)、(2)アクターラップトップ(アクターPC)、(3)カメラPC、1つのワイヤレス応答デバイス(参加者マウス)、2つのディスプレイ、照明回路、およびセキュリティカメラを含む3台のコンピューターを含むセットアップを設計します(この調査のセットアップのシステム図については、 図2A を参照してください)。

注:実験者PCは実験スクリプトを実行するために実験者によって使用され、アクターPCは実験のブロックとブロック内のアクションの順序を追跡するためにアクターによって使用され、3番目のデバイスであるカメラPCは、アクターエリアにあるセキュリティカメラに接続され、実験者が舞台裏を監視するために使用されます。 - 個別のディスプレイ(刺激の提示用のディスプレイ[参加者ディスプレイ]、つまりOLED画面)と、実験の監視用の画面、応答デバイス、および照明回路(有線または無線接続経由 )を実験者PCに接続します( 図2Aを参照)。

- 実験者 PC とアクター PC をワイヤレス ネットワークで接続し、実験ステータスに関する情報 (「次のアクション ID は 'あいさつ'」など) をアクターに伝えます。

- マイクロコントローラで制御してLEDのオンとオフを切り替えることができる照明回路(回路基板については 図2B を参照)を設計および構築します。

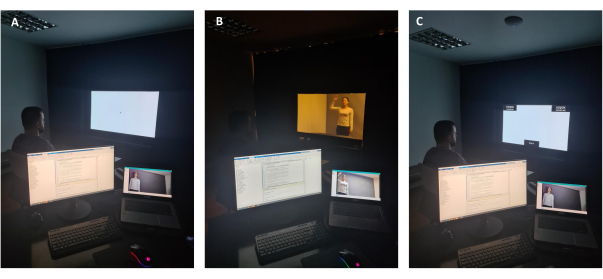

注: 図3A は、実験者の視点からの研究で使用されたOLEDスクリーンの不透明な使用法を示しています。不透明さを確保するために、画面の背景は白(RGB:255、255、255)に調整され、部屋のすべてのライト(参加者エリアとアクターエリアの両方)がオフになります。参加者は刺激の前に固定を見る。 図3B は、実験者の視点から見た研究におけるデジタルスクリーンの透過的な使用方法を示しています。透明度を有効にするには、画面の背景を黒(RGB:0、0、0)に調整し、天井のLEDライトをオンにします。参加者は俳優を見ます。 図3C は、研究におけるデジタルスクリーンの不透明な使用法を示しています。不透明さを確保するために、画面の背景は白(RGB:255、255、255)に調整され、部屋のすべてのライトがオフになります。参加者には、応答を与えるための評価画面が表示されます。ワイヤレスマウスを使用して、カーソルを画面の左上または右上(高または低の2つの応答選択肢のいずれか)にドラッグする必要があります。それらのマウスの軌跡と応答時間が記録されます。 - マイクロコントローラを実験用PCに接続します。

- 実験を実行するスクリプトを実験ツール PC に保存します。

注: 図 4A は、実験中の舞台裏 (アクター エリア) を示しています。ルーム(参加者エリア)のフロントライトが消灯し、アクターPCにアクターが実行するアクションの名前が表示されています。 図 4B は、アクターが順番を待って衣装を着替えることができるアクター キャビネットを示しています。アクターキャビネットは参加者の視界からは見えず、カーテンシステムを使用しているため、アクターは好きな入り口を使用できます。実験中は、図に表示された蛍光灯が消灯しています。

図2:システムと配線図。 (A)自然主義的な実験セットアップのシステム図。(B)実験中のOLEDスクリーンを支える光回路の配線図。この図の拡大版を表示するには、ここをクリックしてください。

図3:実験者の視点から見たOLEDスクリーン 。 (A)実験者の視点からのOLEDデジタルスクリーンの不透明な使用。(B)実験者の視点からのOLEDデジタルスクリーンの透過的な使用。(C)応答期間中の実験者の視点からのOLEDデジタルスクリーンの不透明な使用。 この図の拡大版を表示するには、ここをクリックしてください。

図4:実験の舞台裏 。 (A)実験試験中の舞台裏。(B)俳優キャビネットはOLEDスクリーンの背面にあり、俳優は実験中に自分の順番が見えるのを待つことができます。 この図の拡大版を表示するには、ここをクリックしてください。

2.照明回路の設計と実装

- 回路のデバイス/コンポーネントに電力を供給する前に従う手順

- 舞台裏(アクターエリア)に設置されているLEDの状態を変更するには、実験用PCにLEDをオンまたはオフに切り替える機能を提供します。

- 実験用PCからUSBケーブルで送信されるデジタルコマンドを伝達するには、デジタル入力を取得してデジタル出力を生成できるマイクロコントローラデバイスを選択します(この研究で使用したマイクロコントローラの 材料表 を参照)。

- 実験用PCの特定のUSBポートを選択して、USBケーブル を介して マイクロコントローラのUSB入力に接続します。すべての接続が正常に確立されたことを確認する前に、PCの電源を入れないでください。

- マイクロコントローラによって生成される出力信号(約3.3V)の振幅を増加させるためのスイッチングモジュールを含めます。

- 指定されたデジタル出力ピン(この実験では、指定されたピンはD9です)とマイクロコントローラのグランドピンをスイッチングモジュールに接続します。

- 負荷(LED)を実行するには、スイッチングモジュールによって生成された信号によって駆動される高出力金属酸化膜半導体電界効果トランジスタ(MOSFET)モジュール(またはMOSFETモジュール)を含め、MOSFETモジュールの信号ピンをスイッチングモジュールの対応する信号グランドペアに接続します。

- MOSFETモジュールのホットベッドピンを負荷に接続します。

- 安定化された定電圧をモジュール(および間接的にLED)に供給するには、交流(AC)主電源入力を受け取り、回路内に一定のDC電圧を生成するLED電源を含めます。

- LED電源の出力をMOSFETモジュールとスイッチングモジュールの両方の電源入力に接続します。

- 回路コンポーネントを配線した後に従うべき手順

- USBケーブルを実験用PCの選択したUSBポートに接続します。

- マイクロコントローラと実験PC上で動作するソフトウェア環境との間にシリアル通信リンクを作成します(サブセクション マイクロコントローラを実験用PCに接続するを参照)。

- LED 電源モジュールを AC 主電源入力に接続します。

3.実験のプログラミング

注:3つの主要な実験スクリプト(ExperimentScript1.m [補足コーディングファイル1]、ExperimentScript2.m [補足コーディングファイル2]、および実験スクリプト3.m [補足コーディングファイル3])といくつかの関数(RecordMouse.m [補足コーディングファイル4]、InsideROI.m [補足コーディングファイル5]、RandomizeTrials.m [補足コーディングファイル6]、RandomizeBlocks.m [補足コーディングファイル7]、GenerateResponsePage.m [Supplemental Coding File 8], GenerateTextures.m [Supplemental Coding File 9], ActorMachine.m [Supplemental Coding File 10], MatchIDtoClass.m [Supplemental Coding File 11], RandomizeWordOrder.m [Supplemental Coding File 12]) を使用して実験を実行します。

注: 詳細な説明については、関連するスクリプトを参照してください。

- トライアル注文とブロック注文のランダム化

- ランダム化パラメーター (参加者 ID など) を入力として受け取り、擬似ランダム化シーケンスの配列を返す試行注文 (RandomizeTrials.m) とブロック注文 (RandomizeBlocks.m) をランダム化する 2 つの関数を定義および作成します。

- ランダム化されたシーケンスの生成方法の詳細については、スクリプト RandomizeBlocks.m (2 行目から 24 行目) および RandomizeTrials.m (3 行目から 26 行目) を参照してください。

- 応答の追跡 (RecordMouse、InsideRoi)

- 参加者のマウスの軌跡と実験中の経過時間を追跡して記録する関数を作成します (RecordMouse.m を参照)。

- クリックされた座標が許容領域内にあるかどうかを確認するヘルパー関数を作成します(スクリプトInsideRoi.mを参照)。

- 命令とフィードバックのためのテクスチャの生成 (GenerateTextures.m, GenerateResponsePage.m)

- 実験に関する指示や試行に関するフィードバックを画像として用意します。

- これらの画像の内容を .mat ファイルに保存します (ExperimentImages.mat ファイル [補足コーディング ファイル 13] を参照)。

- 画面上のウィンドウを作成した後、.mat ファイルをワークスペースに読み込みます (GenerateTextures.m 行 25 を参照)。

- イメージごとに個別のテクスチャとその識別子を作成します (GenerateTextures.m の 27 行目から 165 行目を参照)。

- 実験スクリプトごとに関連する応答ページのテクスチャを描画する関数を定義します (「GenerateResponsePage.m」を参照)。

- TCP/IP 経由でアクター PC を実験用 PC に接続する

- 実験用 PC で実行されているスクリプト (ExperimentScript2.m 行 174 を参照) で TCP サーバー ソケットを作成します。

- アクター PC で実行されているスクリプト (ActorMachine.m の 16 行目を参照) で、対応する TCP クライアント ソケットを作成します。

- 実験用 PC で実行されているスクリプト (ExperimentScript2.m の 207、229、および 278 行目を参照)、または ExperimentScript3.m の 136、141、153、159、および 297 行目を参照) から、今後のブロック/トライアルに関する情報をアクターに送信します。

- 実験用 PC から受信した情報をアクター PC のオンスクリーン ウィンドウに表示します (ActorMachine.m の 31 行目から 47 行目を参照)。

- マイクロコントローラを実験用PCに接続する

- マイクロコントローラを特定のUSBポート(ポート9など)に接続して、取り付けられたLEDの状態(オンまたはオフ)を舞台裏で制御します。

- マイクロコントローラデバイスと実験用PC間のシリアル通信を確立します(ExperimentScript2.mスクリプトの185行目を参照)。

- 実験用PC上で実行されているスクリプト(ExperimentScript2.mの290行目または実験スクリプト3.mスクリプトの311行目を参照)からマイクロコントローラにロジックハイ信号(1)を送信して、USBケーブル を介して アクションが表示されたときにLEDをオンにします。

- 実験用PC上で実行されているスクリプト(ExperimentScript2.mの292行目またはExperimentScript3.mスクリプトの314行目を参照)からマイクロコントローラにロジックロー信号(0)を送信して、参加者が応答すると予想されるときにLEDをオフにします。

4. サンプル実験の流れ

- 実験前の手順

- ラボ内のすべてのデバイス(実験用PC、カメラPC、アクターPC、参加者ディスプレイ)にUPSが搭載されていることを確認します。

- USBケーブルを介して雷マイクロコントローラーを実験用PCにリンクすると、実験用PCの電源がオンになると自動的にオンになります。

- 実験ツールPCの電源を入れ、5 GHz Wi-Fiに接続されているかどうかを確認します。

- 実験用PCのサウンド出力デバイスとしてサウンドデバイス( 材料表のスピーカー)を選択します。

- 参加者のディスプレイをオンにし、音量設定を80%に設定します。

- 実験用PCの画面設定をマルチモニター用に設定します。実験用PCの表示を参加者のディスプレイに拡張します。実験用PCの表示は1、参加者の表示は2になります。

- アクター PC の電源を入れ、5 GHz Wi-Fi に接続されているかどうかを確認します。

- USB ケーブルでセキュリティ カメラをアクター PC に接続すると、アクター PC の電源がオンになると自動的に電源がオンになります。

- カメラPCの電源を入れ、デスクトップでカメラアプリケーションを開きます。各俳優、その動き、およびキャビネットへの出入りがカメラから見えることを確認してください。

- すべてのコンピューター、ディスプレイ、デバイス(実験者PCとアクターPCの応答デバイス[参加者のワイヤレスマウス]、スピーカー、キーボード、マウス、およびLightningマイクロコントローラー)が正しく動作することを確認します。

- 参加者を別の部屋に歓迎します。研究に関する簡単な情報を提供した後、同意書を提供し、参加者に署名してもらいます。

- 参加者にバッグから番号を引くように依頼し、その番号が研究全体を通して参加者IDになることを伝えます。

- 参加者に匿名の参加者IDをオンライン人口統計フォームに記入してもらいます。

注:参加者が実験前に俳優を見ないことが重要です。そのため、この事務処理は、俳優が参加者間で休憩できるように、メインの実験室ではなく別の部屋で完了します。

- 実験の手順

- 実験用 PC で実験ソフトウェアを開き、実験スクリプト1.m スクリプトを開いて実行します。

- 参加者IDと年齢を入力します。次に、スクリプトは実験の最初の部分を開始します(最初の目に見える刺激は、参加者ディスプレイの中央にある十字になります)。

- アクター PC で実験ソフトウェアを開き、ActorMachine.m スクリプトを開きます。

- カメラPCを実験用PCの近くに置き、防犯カメラからの映像が参加者に見えないようにします。

- 参加者をメイン実験室に迎え入れ、参加者ディスプレイの前に着席させます。

- 参加者に、十字架が真ん中でまっすぐ前になるように配置するように指示します。

- ホワイトボードに書かれた説明と期間を参照して、実験の部分について簡単に指示を与えます。

- 実験室の照明をすべて消します。

- 実験パート1:

- 実験の最初の部分で語彙/概念トレーニングを完了することを参加者に伝えます。訓練に合格できるように,指示に従うように注意するよう警告します。

- 準備ができたら実験を開始できることを参加者に伝えます。

- 参加者が最初のパートの準備ができたと言ったら、 ESC ボタンを押します。

注:これ以降、参加者は参加者ディスプレイの指示を読み、選択肢の1つを選択することにより、実験を進めます。彼らは彼らの正しい答えと間違った答えに関するフィードバックを受け取り、トレーニングでうまく進むことができます。マッチングは、参加者が10ブロックの繰り返し以内に最小しきい値(80%)に達するまで続行されます。 - 参加者がトレーニングパートを完了したら、ESCボタンを押して、実験者がマウスを制御して実験の2番目の部分を開始することを参加者に伝えます。

- 実験パート2:

- ExperimentScript2.m スクリプトを開き、[ アクター PC を待機しています] というプロンプトが表示されるのを待ちます。

- プロンプトが表示されたらベルを鳴らし、アクターの 1 人がアクター PC でスクリプトを実行して実験ツール PC との接続を有効にできるようにします。

- プロンプト「実験パート 2 の準備ができました」を待ちます。

- 参加者に、画面が透明になり、短いアクションが見えることを伝えます。

- それぞれの行動を注意深く見るように警告し、その行動が大声で言うべきであることを彼らに知らせます。

- 準備ができたら実験を開始できることを参加者に伝えます。

- 参加者が最初のパートの準備ができたと言ったら、 ESC ボタンを押します。

注:参加者は指示を進め、最初のアクションを監視します。Actor1 は、LED ライトがオンになったときにアクションを実行し、ライトがオフになったときにアクター PC のプロンプトから次のアクションを確認します。各アクションが終了すると、実験ツールPC画面にダイアログボックスが表示されます。 - アクションに関する参加者の発言内容をダイアログボックスに入力し、2 番目のダイアログボックスでアクションの正しい識別または間違った識別に応じてそれぞれ「1」または「0」と入力します。

注:これらの手順は最初の俳優に対して8回繰り返され、俳優が場所を変える時間になるとバックグラウンドミュージックの再生が開始されます。 - カメラ付きPCの防犯カメラの映像から舞台裏をご覧ください。

- Esc ボタンを押して Actor2 の識別を開始すると、アクターが I am ready ジェスチャでセキュリティ カメラに向かって手を振った。

- 手順 4.4.7 と手順 4.4.8 を参加者と一緒に繰り返し、Actor2 によって実行されている間に同じ 8 つのアクションも識別されます。

- 参加者が 識別が完了しましたという 警告が表示され、矢印をクリックして部品を終了したら、 ESC ボタンを押して、実験者がマウスを制御して実験の3番目の部分を開始することを参加者に伝えます。

- 実験パート3:

- ExperimentScript3.m スクリプトを開きます。

- 参加者に両方の俳優の行動を監視することを伝え、次に適切だと思うオプションをクリックします。

注:参加者は、4つのブロックで俳優の行動を評価します。2 つのブロックでは、Actor1 がアクションを実行し、他の 2 つのブロックでは、Actor2 が同じアクションを実行します。2つのブロックでは、参加者は高または低のエージェンシー能力を帰属させることによって行動を評価し、他の2つのブロックでは、高または低経験の能力を帰属させます。 - 参加者が第3部の準備ができたと言ったら、 ESC ボタンを押します。

注:参加者は指示を進め、最初のブロックから始めます。俳優は光の中でアクションを実行し、参加者が応答している間、画面は不透明になり、ライトはオフになり、俳優は次にどのアクションが来るかを見ることができます。各ブロックが終了すると、アクターはアクター PC のプロンプトに従って場所を変更します。 - 舞台裏ですべてがうまくいっているかどうか、そしてブロック中に適切なアクターが適切なアクションを実行しているかどうかを確認します。

- ESCボタンを押して次のブロックを開始すると、アクターの交代後に適切なアクターがI am readyジェスチャで手を振った。

- 4つのブロックが完了するまで、参加者とアクターと協力してステップ4.5.4とステップ4.5.5を繰り返します。

- 参加者が 「実験が終了しました」 が表示されたら、プロンプトを送信し、 ESC ボタンを押します。

- 参加者に感謝し、報告と署名を受け取った後、参加者を送り出します。

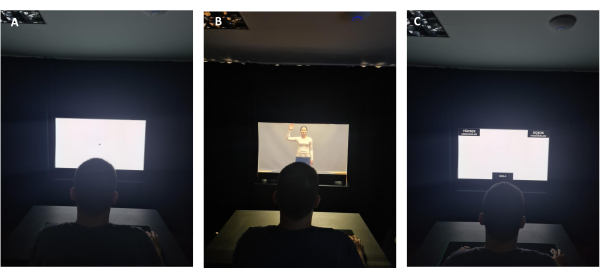

図 5 は、参加者の視点から見たサンプル試行を示しています。 図 5A は、不透明な使用法で画面の中央にあるカーソルを見ている参加者を示しています。 図5B は、画面を通して実写刺激を見ている参加者を示しています。 図5C は、刺激の後に参加者に提示される評価画面を示しており、画面の各上隅にある2つの選択肢のいずれかにマウスをドラッグする必要があります。

図5:参加者の視点から見たOLEDスクリーン 。 (A)固定スクリーン中の参加者の視点からのOLEDデジタルスクリーンの不透明な使用。(B)実写のプレゼンテーション中に参加者の視点からOLEDデジタルスクリーンを透過的に使用します。 (C)応答期間中の参加者の視点からのOLEDデジタルスクリーンの不透明な使用。 この図の拡大版を表示するには、ここをクリックしてください。

5.データの前処理と分析

- データを条件にセグメント化する

- すべての参加者データファイルをソフトウェア環境のワークスペースに読み込みます。

- データをグループ化する条件を定義します (2 つのアクション クラス [アクション クラス 1 とアクション クラス 2] x 2 つのアクター [アクター 1 とアクター 2] x 2 つのディメンション [エージェンシーとエクスペリエンス] x 2 つのレベル [高と低])。

- データを 4 つの主要なグループ (エージェンシー高、エージェンシー低、経験高、経験低) に分割します。

- これらのメイングループを4つのサブグループ(2人のアクターx2つのアクションクラス)に分割します。

- 各データファイルをループして、以前に定義した4つのサブグループのいずれかに属する試験をグループ化します。

- 関連する試行情報 (応答時間、カーソル移動、およびカーソル位置がサンプリングされる時点) を、サブグループごとに別々のデータ構造に保管します。

- すべての試行がグループ化されたら、ループを終了します。

- 軌道の可視化

- データをセグメント化した後、次の手順を実行してマウスの軌跡を視覚化します。

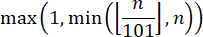

- 応答軌道に時間補間を適用するには、試行ごとに軌道配列から101(x,y)ペアを選択して、データの各サブグループに同じ数の時間ステップの試行が含まれるようにします。

注: ペアの数を 101 に固定するときは、規則32に従って正しい時間の正規化を実行してください。したがって、次の式を使用して時間の正規化を実現します( n は軌道配列のサンプル数です)。

- 101の時点のそれぞれで(x、y)ペアの合計を計算し、得られた結果をそのサブグループの試行の総数で割って、各サブグループの平均を取得します(たとえば、経験の低い俳優1または経験の低い俳優2)。

- 行の値にスケーリング操作を適用して、平均軌道を視覚化します。

注: 2D 座標平面は、両方の軸がウィンドウの左下隅にあるゼロ点から増加することを前提としていますが (座標が正の整数であると仮定します)、ピクセル形式ではウィンドウの左上隅を参照 (ゼロ点など) として使用します。したがって、合計行数の値から各試行のサンプリングされた y 座標を抽出することにより、サンプリングされた位置の y 座標 (ピクセル形式の行値に対応) に対してスケーリング操作を適用します。 - 比較のために、関連するサブグループを同じ図にプロットします。

メモ: 各軌道は、中央下部にある START というラベルの付いた長方形の中心から始まり、左上隅または右上隅にある長方形の内側で終わります。

6. システム障害につながる可能性のある状態と注意事項

注:システム障害が発生した場合は、物理的なサイン(ベルを鳴らす)を作成して、アクターに障害を知らせ、参加者には見えない場所にとどまるように警告することが重要です。

- ネットワーク接続による障害

- コンピュータの 1 つが別のネットワークに接続されている場合、TCP/IP 接続要求は失敗し、システムはエラーを表示します。これを防ぐには、実験用 PC とアクタ PC が同じワイヤレス ネットワークの同じ帯域上にあることを確認してください。

- 両方の PC が同じネットワーク上に残るようにするには、以前に接続したワイヤレス ネットワークを両方の PC から消去します。

- ネットワーク上のIPアドレスは予告なく変更される可能性があるため、選択したネットワーク上のデバイスに静的IPアドレスを設定します。

- ネットワークへの一時的な切断(停電、インターネットの停止など)により、スクリプトが失敗する可能性があります。このような状況では、TCP/IP 接続を再確立するために、システムを最初から再始動する必要があります。

注: デバイスの静的 IP の要件は、インターネット サービス プロバイダーが満たすことができます。特定のポートは、特定のデバイスのオペレーティング システムまたはハードウェアによって無効になっている場合があります。したがって、実験で使用するポートは開く必要があり、実験スクリプトが起動するまでアクティブな接続があってはなりません。

- ソフトウェアクラッシュによる障害

- 接続の失敗(シリアルポート接続、TCP / IP接続、ディスプレイ接続など)によりソフトウェア環境がクラッシュし、データが失われる可能性があります。これを克服するには、メインの実験スクリプトを複数のスクリプトに分割します。たとえば、アクターがアクションの実行を開始する前に完了する必要があるブロックがある場合、このブロック中に実験用PC上にサーバーを作成する必要はありません。サーバーは、アクションを含むブロック、つまり実験者 PC とアクター PC 間の通信を必要とするブロックが起動しようとしているときに作成できます。

結果

応答時間 (RT) の比較

本研究は継続中のプロジェクトであり、代表的な結果として、実験の主要部分(実験パート3)のデータを提示する。これらのデータは、18〜28歳の年齢の女性23人と男性17人を含む40人の参加者からのものです(M = 22.75、 SD = 3.12)。

分析に適した統計的手法を選択するためには、従属変数の分布の正規性の程度を調査する必要が?...

ディスカッション

本研究の包括的な目標は、人間の高レベルの視覚知覚と認知が実生活の状況でどのように機能するかについての理解に貢献することです。この研究は行動知覚に焦点を当て、研究者が実験室の設定で実際の俳優を提示することによって個人が他人の行動をどのように認識し評価するかをテストすることを可能にする自然主義的でありながら制御可能な実験パラダイムを提案しました。

開示事項

著者は、この記事で説明されている研究に関連するまたは重要な金銭的利益がないことを宣言します。

謝辞

この研究は、トルコ科学技術研究評議会(プロジェクト番号:120K913)とビルケント大学からのBurcu A. Urgenへの助成金によって支援されました。パイロット参加者のセナ・エルマスが俳優の変更の間にバックグラウンドノイズを追加するというアイデアをもたらしてくれたこと、スレイマン・アクが光回路をセットアップしてくれたこと、そして舞台裏で防犯カメラを使用するというアイデアと研究の俳優の1人としての彼女の貢献について、Tuvana Karadumanに感謝します。

資料

| Name | Company | Catalog Number | Comments |

| Adjustable Height Table | Custom-made | N/A | Width: 60 cm, Height: 62 cm, Depth: 40 cm |

| Ardunio UNO | Smart Projects | A000066 | Microcontroller used for switching the state of the LEDs from the script running on the operator PC |

| Black Pants | No brand | N/A | Relaxed-fit pants of actors with no apparent brand name or logo. |

| Case | Xigmatek | EN43224 | XIGMATEK HELIOS RAINBOW LED USB 3.0 MidT ATX GAMING CASE |

| CPU | AMD | YD1600BBAFBOX | AMD Ryzen 5 1600 Soket AM4 3.2 GHz - 3.6 GHz 16 MB 65 W 12 nm Processor |

| Curtains | Custom-made | N/A | Width: Part 1: 110 cm width from the wall (left) side, Part 2: 123 cm width above OLED display, Part 3: 170 cm from OLED display to right side, Cabin depth: 100 cm, Inside cabin depth: 100 cm, all heights 230 cm except for Part 2 (75 cm height) |

| Experimenter Adjustable/Swivel Chair | No brand | N/A | Any brand |

| Experimenter Table | Custom | N/A | Width: 160 cm, Height: 75 cm, Depth: 80 cm |

| GPU | MSI | GT 1030 2GHD4 LP OC | MSI GEFORCE GT 1030 2GHD4 LP OC 2GB DDR4 64bit NVIDIA GPU |

| Grey-color blackout curtain | Custom-made | N/A | Width: 330 cm, Height: 230 cm, used for covering the background |

| Hard Disk | Kioxia | LTC10Z240GG8 | Kioxia 240 GB Exceria Sata 3.0 SSD (555 MB Read/540 MB Write) |

| Hard Disk | Toshiba | HDWK105UZSVA | Toshiba 2,5'' 500 GB L200 SATA 3.0 8 MB Cache 5400 Rpm 7 mm Harddisk |

| High-Power MOSFET Module | N/A | N/A | Heating Controller MKS MOSFET Module |

| Laptop | Apple | S/N: C02P916ZG3QT | MacBook Pro 11.1 Intel Core i7 (Used as the actor PC) |

| Laptop | Asus | UX410U | Used for monitoring the security camera in real-time. |

| LED lights | No brand | N/A | |

| LED Strip Power Supply | No brand | N/A | AC to DC voltage converter used for supplying DC voltage to the lighting circuit |

| MATLAB | The MathWorks Inc., Natick, MA, USA | Version: R2022a | Used for programming the experiment. Required Toolboxes: MATLAB Support Package for Arduino Hardware (version 22.1.2) Instrument Control Toolbox (version 4.6) Psychtoolbox (version 3) |

| Monitor | Philips | UHB2051005145 | Model ID: 242V8A/00, PHILIPS 23.8" 242V8A 4ms 75 Hz Freesync DP-HDMI+VGA IPS Gaming Monitor |

| Motherboard | MSI | B450M-A PRO MAX | MSI B450M-A PRO MAX Amd B450 Socket AM4 DDR4 3466(OC) M.2 Motherboard |

| Mouse Pad for participant | Monster | 78185721101502042 / 8699266781857 | Pusat Gaming Mouse Pad XL |

| Night lamp | Aukes | ES620-0.5W 6500K-IP 20 | Used for helping the actors see around when the lights are off in the backstage. |

| Participant Adjustable/Swivel Chair | No brand | N/A | |

| Participant Table | IKEA | Sandsberg 294.203.93 | Width: 110 cm, Height: 75 cm, Depth: 67 cm |

| Power Extension Cable | Viko | 9011760Y | 250 V (6 inlets) Black |

| Power Extension Cable | Viko | 9011730Y | 250 V (3 inlets) Black |

| Power Extension Cable | Viko | 9011330Y | 250 V (3 inlets) White |

| Power Extension Cable | s-link | Model No: SPG3-J-10 | AC - 250 V 3 meter (5 inlets) |

| Power Supply | THERMALTAKE | PS-LTP-0550NHSANE-1 | THERMALTAKE LITEPOWER RGB 550W APFC 12 cm FAN PSU |

| Professional Gaming Mouse | Rampage | 8680096 | Model No: SMX-R50 |

| RAM | GSKILL | F4-3000C16S-8GVRB | GSKILL 8GB (1x8GB) RipjawsV Red DDR4 3000 MHz CL16 1.35 V Single Ram |

| Reception bell | No brand | N/A | Used for helping the communication between the experimenter and the actors. |

| Security Camera | Brion Vega | 2-20204210 | Model:BV6000 |

| Speakers | Logitech | P/N: 880-000-405 PID: WD528XM | Used for playing the background music. |

| Survey Software | Qualtrics | N/A | |

| Switching Module | No brand | N/A | F5305S PMOS Switch Module |

| Table under the OLED display | Custom-made | N/A | Width: 123 cm, Height: 75 cm, Depth: 50 cm |

| Transparent OLED Display | Planar | PN: 998-1483-01 S/N:195210075 | A 55-inch transparent display that showcases dynamic information, enabled the opaque and transparent usage during the experiment. |

| UPS | EAG | K200610100087 | EAG 110 |

| UPS | EAG | 210312030507 | EAG 103 |

| USB 2.0 Cable Type A/B for Arduino UNO (Blue) | Smart Projects | M000006 | Used to connect the microcontroller to the experimenter PC. |

| USB to RS232 Converter | s-link | 8680096082559 | Model: SW-U610 |

| White Long-Sleeved Blouse (2) | H&M (cotton) | N/A | Relaxed-fit blouses with a round neckline and without ant apparent brand name or logo. |

| Wireless Keyboard | Logitech | P/N: 820-003488 S/N: 1719CE0856D8 | Model: K360 |

| Wireless Mouse | Logitech | S/N: 2147LZ96BGQ9 | Model: M190 (Used as the response device) |

参考文献

- Grossman, E. D., Blake, R. Brain areas active during visual perception of biological motion. Neuron. 35 (6), 1167-1175 (2002).

- Saygin, A. P. Superior temporal and premotor brain areas necessary for biological motion perception. Brain. 130 (9), 2452-2461 (2007).

- Peelen, M. V., Downing, P. E. The neural basis of visual body perception. Nature Reviews Neuroscience. 8 (8), 636-648 (2007).

- Caspers, S., Zilles, K., Laird, A. R., Eickhoff, S. B. ALE meta-analysis of action observation and imitation in the human brain. Neuroimage. 50 (3), 1148-1167 (2010).

- Nelissen, K., et al. Action observation circuits in the macaque monkey cortex. Journal of Neuroscience. 31 (10), 3743-3756 (2011).

- Oosterhof, N. N., Tipper, S. P., Downing, P. E. Crossmodal and action-specific: Neuroimaging the human mirror neuron system. Trends in Cognitive Sciences. 17 (7), 311-318 (2013).

- Lingnau, A., Downing, P. E. The lateral occipitotemporal cortex in action. Trends in Cognitive Sciences. 19 (5), 268-277 (2015).

- Giese, M. A., Rizzolatti, G. Neural and computational mechanisms of action processing: Interaction between visual and motor representations. Neuron. 88 (1), 167-180 (2015).

- Tucciarelli, R., Wurm, M., Baccolo, E., Lingnau, A. The representational space of observed actions. eLife. 8, e47686 (2019).

- Tarhan, L., Konkle, T. Sociality and interaction envelope organize visual action representations. Nature Communications. 11 (1), 3002 (2020).

- Urgen, B. A., Saygin, A. P. Predictive processing account of action perception: Evidence from effective connectivity in the action observation network. Cortex. 128, 132-142 (2020).

- Newen, A., De Bruin, L., Gallagher, S. . The Oxford Handbook of 4E Cognition. , (2018).

- Snow, J. C., Culham, J. C. The treachery of images: How realism influences brain and behavior. Trends in Cognitive Sciences. 25 (6), 506-519 (2021).

- Matusz, P. J., Dikker, S., Huth, A. G., Perrodin, C. Are we ready for real-world neuroscience. Journal of Cognitive Neuroscience. 31 (3), 327-338 (2019).

- Zaki, J., Ochsner, K. The need for a cognitive neuroscience of naturalistic social cognition. Annals of the New York Academy of Sciences. 1167 (1), 16-30 (2009).

- Hasson, U., Honey, C. J. Future trends in Neuroimaging: Neural processes as expressed within real-life contexts. NeuroImage. 62 (2), 1272-1278 (2012).

- Risko, E. F., Laidlaw, K. E., Freeth, M., Foulsham, T., Kingstone, A. Social attention with real versus reel stimuli: toward an empirical approach to concerns about ecological validity. Frontiers in Human Neuroscience. 6, 143 (2012).

- Parsons, T. D. Virtual reality for enhanced ecological validity and experimental control in the clinical, affective and social neurosciences. Frontiers in Human Neuroscience. 9, 660 (2015).

- Deuse, L., et al. Neural correlates of naturalistic social cognition: brain-behavior relationships in healthy adults. Social Cognitive and Affective Neuroscience. 11 (11), 1741-1751 (2016).

- Camerer, C., Mobbs, D. Differences in behavior and brain activity during hypothetical and real choices. Trends in Cognitive Sciences. 21 (1), 46-56 (2017).

- Nastase, S. A., Goldstein, A., Hasson, U. Keep it real: Rethinking the primacy of experimental control in cognitive neuroscience. NeuroImage. 222, 117254 (2020).

- Kihlstrom, J. F. Ecological validity and "ecological validity". Perspectives on Psychological Science. 16 (2), 466-471 (2021).

- Brunswik, E. . Perception and the Representative Design of Psychological Experiments. , (1956).

- Aronson, E., Carlsmith, J. M., Gilbert, D. T., Fiske, S. T., Lindzay, G. Experimentation in social psychology. The Handbook of Social Psychology. , 1-79 (1968).

- Ecological validity: Then and now. University of Colorado Available from: https://www.albany.edu/cpr/brunswik/notes/essay1.html (1998)

- Fan, S., Dal Monte, O., Chang, S. W. Levels of naturalism in social neuroscience research. IScience. 24 (7), 102702 (2021).

- Orban, G. A., Lanzilotto, M., Bonini, L. From observed action identity to social affordances. Trends in Cognitive Sciences. 25 (6), 493-505 (2021).

- Gray, H. M., Gray, K., Wegner, D. M. Dimensions of mind perception. Science. 315 (5812), 619 (2007).

- Li, Z., Terfurth, L., Woller, J. P., Wiese, E. Mind the machines: Applying implicit measures of mind perception to social robotics. 2022 17th ACM/IEEE International Conference on Human-Robot Interaction (HRI. , 236-245 (2022).

- Karpinski, A., Steinman, R. B. The single category implicit association test as a measure of implicit social cognition. Journal of Personality and Social Psychology. 91 (1), 16 (2006).

- Greenwald, A. G., McGhee, D. E., Schwartz, J. L. Measuring individual differences in implicit cognition: the implicit association test. Journal of Personality and Social Psychology. 74 (6), 1464 (1998).

- Freeman, J. B., Ambady, N. MouseTracker: Software for studying real-time mental processing using a computer mouse-tracking method. Behavior Research Methods. 42 (1), 226-241 (2010).

- Pekçetin, T. N., Barinal, B., Tunç, J., Acarturk, C., Urgen, B. A. Studying mind perception in social robotics implicitly: The need for validation and norming. Proceedings of the 2023 ACM/IEEE International Conference on Human-Robot Interaction. , 202-210 (2023).

- Yu, Z., Wang, F., Wang, D., Bastin, M. Beyond reaction times: Incorporating mouse-tracking measures into the implicit association test to examine its underlying process. Social Cognition. 30 (3), 289-306 (2012).

- Romero, C. A., Snow, J. C. Methods for presenting real-world objects under controlled laboratory conditions. Journal of Visualized Experiments. (148), e59762 (2019).

- Jastorff, J., Abdollahi, R. O., Fasano, F., Orban, G. A. Seeing biological actions in 3 D: An f MRI study. Human Brain Mapping. 37 (1), 203-219 (2016).

- Ferri, S., Pauwels, K., Rizzolatti, G., Orban, G. A. Stereoscopically observing manipulative actions. Cerebral Cortex. 26 (8), 3591-3610 (2016).

- Stangl, M., Maoz, S. L., Suthana, N. Mobile cognition: Imaging the human brain in the 'real world. Nature Reviews Neuroscience. 24 (6), 347-362 (2023).

- Kriegeskorte, N. Deep neural networks: a new framework for modeling biological vision and brain information processing. Annual Review of Vision Science. 1, 417-446 (2015).

- Marblestone, A. H., Wayne, G., Kording, K. P. Toward an integration of deep learning and neuroscience. Frontiers in Computational Neuroscience. 10, 94 (2016).

転載および許可

このJoVE論文のテキスト又は図を再利用するための許可を申請します

許可を申請さらに記事を探す

This article has been published

Video Coming Soon

Copyright © 2023 MyJoVE Corporation. All rights reserved