È necessario avere un abbonamento a JoVE per visualizzare questo. Accedi o inizia la tua prova gratuita.

Method Article

Una configurazione naturalistica per presentare persone reali e azioni dal vivo in psicologia sperimentale e studi di neuroscienze cognitive

In questo articolo

Riepilogo

Questo studio presenta una configurazione sperimentale naturalistica che consente ai ricercatori di presentare stimoli di azione in tempo reale, ottenere tempi di risposta e dati di tracciamento del mouse mentre i partecipanti rispondono dopo ogni visualizzazione dello stimolo e cambiare gli attori tra le condizioni sperimentali con un sistema unico che include uno speciale schermo a diodi organici trasparenti a emissione di luce (OLED) e manipolazione della luce.

Abstract

La percezione delle azioni altrui è cruciale per la sopravvivenza, l'interazione e la comunicazione. Nonostante decenni di ricerca sulle neuroscienze cognitive dedicate alla comprensione della percezione delle azioni, siamo ancora lontani dallo sviluppo di un sistema di visione artificiale ispirato neuralmente che si avvicini alla percezione dell'azione umana. Una grande sfida è che le azioni nel mondo reale consistono in eventi che si svolgono temporalmente nello spazio che accadono "qui e ora" e sono actable. Al contrario, la percezione visiva e la ricerca sulle neuroscienze cognitive fino ad oggi hanno ampiamente studiato la percezione dell'azione attraverso display 2D (ad esempio, immagini o video) che mancano della presenza di attori nello spazio e nel tempo, quindi questi display sono limitati nell'offrire agibilità. Nonostante il crescente corpo di conoscenze nel campo, queste sfide devono essere superate per una migliore comprensione dei meccanismi fondamentali della percezione delle azioni altrui nel mondo reale. Lo scopo di questo studio è quello di introdurre una nuova configurazione per condurre esperimenti di laboratorio naturalistico con attori dal vivo in scenari che si avvicinano alle impostazioni del mondo reale. L'elemento centrale della configurazione utilizzata in questo studio è uno schermo OLED (Organic Light-Emitting Diode) trasparente attraverso il quale i partecipanti possono guardare le azioni dal vivo di un attore fisicamente presente mentre i tempi della loro presentazione sono controllati con precisione. In questo lavoro, questa configurazione è stata testata in un esperimento comportamentale. Riteniamo che la configurazione aiuterà i ricercatori a rivelare meccanismi cognitivi e neurali fondamentali e precedentemente inaccessibili della percezione dell'azione e sarà una base per studi futuri che indagano la percezione sociale e la cognizione in contesti naturalistici.

Introduzione

Un'abilità fondamentale per la sopravvivenza e l'interazione sociale è la capacità di percepire e dare un senso alle azioni degli altri e interagire con loro nell'ambiente circostante. Ricerche precedenti negli ultimi decenni hanno dato contributi significativi alla comprensione dei principi fondamentali di come gli individui percepiscono e comprendono le azioni degli altri 1,2,3,4,5,6,7,8,9,10,11 . Tuttavia, data la complessità delle interazioni e le circostanze in cui si verificano, vi è un'ovvia necessità di sviluppare ulteriormente il corpo delle conoscenze in contesti naturalistici al fine di raggiungere una comprensione più completa di questa complessa abilità nei contesti della vita quotidiana.

In ambienti naturali come le nostre impostazioni di vita quotidiana, la percezione e la cognizione mostrano caratteristiche incarnate, incorporate, estese ed enattive12. In contrasto con i resoconti internalisti delle funzioni cerebrali che tendono a sottovalutare i ruoli del corpo e dell'ambiente, gli approcci contemporanei alla cognizione incarnata si concentrano sull'accoppiamento dinamico di cervello, corpo e ambiente. D'altra parte, la maggior parte della psicologia sociale, della psicologia cognitiva e della ricerca neuroscientifica sulla percezione dell'azione tendono a presumere che l'utilizzo di progetti di esperimenti ben controllati e semplificati in condizioni di laboratorio (ad esempio, immagini o video in attività computerizzate) produca risultati che possono essere generalizzati a scenari più complessi come le interazioni del mondo reale 1,2,3,4,5,6,7 ,8,9,10,11. Questa ipotesi garantisce che dati robusti e affidabili possano essere ottenuti in molte circostanze. Tuttavia, una sfida ben nota è che la validità dei modelli derivati da esperimenti attentamente controllati è limitata quando testati in un contesto reale13. Di conseguenza, ulteriori indagini 13,14,15,16,17,18,19,20,21,22 sono state condotte per affrontare la validità ecologica ed esterna di stimoli e disegni sperimentali in vari campi di ricerca.

In questo studio, viene suggerito un nuovo metodo per indagare su come gli individui percepiscono e valutano le azioni degli altri utilizzando azioni dal vivo eseguite da un attore reale e fisicamente presente. Vengono impiegati scenari simili ai contesti di vita reale, mentre gli sperimentatori hanno il controllo sui possibili fattori confondenti. Questo studio è una forma di "ricerca naturalistica di laboratorio", nel quadro di Matusz et al.14 che può essere concepita come una fase intermedia tra la "ricerca di laboratorio classica", che fa uso del massimo controllo sugli stimoli e sull'ambiente, spesso a scapito della naturalezza, e la "ricerca del mondo reale completamente naturalistica", che mira a massimizzare la naturalezza a scapito del controllo sulla stimolazione e sull'ambiente14. Lo studio mira ad affrontare la necessità di indagini empiriche a questo livello nella ricerca sulla percezione dell'azione al fine di colmare il divario tra i risultati ottenuti in esperimenti di laboratorio tradizionali con un alto grado di controllo sperimentale e i risultati ottenuti in studi condotti in contesti naturali completamente non vincolati.

Esperimenti controllati e esperimenti non vincolati

Il controllo sperimentale è una strategia efficiente per la progettazione di esperimenti per testare un'ipotesi specifica, in quanto consente ai ricercatori di isolare le variabili target da probabili fattori confondenti. Consente inoltre di rivisitare la stessa ipotesi con determinati livelli di modifiche, come l'uso di stimoli leggermente o totalmente diversi nello stesso progetto o testare gli stessi stimoli in configurazioni sperimentali alternative. L'indagine sistematica attraverso esperimenti controllati è una forma tradizionale di metodologia nella ricerca nelle scienze cognitive e nei domini pertinenti. Gli esperimenti controllati aiutano ancora a stabilire il corpo delle conoscenze sui principi fondamentali dei processi cognitivi in vari domini della ricerca, come l'attenzione, la memoria e la percezione. Tuttavia, recenti ricerche hanno anche riconosciuto i limiti degli esperimenti di laboratorio tradizionali in termini di generalizzazione dei risultati alle impostazioni del mondo reale, e i ricercatori sono stati incoraggiati a condurre studi in impostazioni ecologiche migliorate 13,14,15,16,17,18,19,20,21 . Questo cambiamento mira ad affrontare due importanti questioni riguardanti la discrepanza tra gli esperimenti di laboratorio tradizionali e le impostazioni del mondo reale. In primo luogo, il mondo al di fuori del laboratorio è meno deterministico che negli esperimenti, il che limita il potere rappresentativo delle manipolazioni sperimentali sistematiche. In secondo luogo, il cervello umano è altamente adattivo, e questo è spesso sottovalutato a causa dei limiti pratici della progettazione e della conduzione di studi sperimentali22. Il concetto di "validità ecologica"23,24 è stato utilizzato per affrontare i metodi per risolvere questo problema. Il termine è solitamente usato per riferirsi a un prerequisito per la generalizzazione dei risultati sperimentali al mondo reale al di fuori del contesto di laboratorio. La validità ecologica è stata anche interpretata come riferita alla convalida di configurazioni sperimentali virtualmente naturalistiche con stimoli non vincolati per garantire che il disegno dello studio sia analogo agli scenari della vita reale25. A causa dell'elevato grado di varianza nell'interpretazione di questo termine, è necessaria una comprensione dei vantaggi e dei limiti delle metodologie alternative e della selezione degli stimoli.

Livelli di naturalismo negli stimoli e nella progettazione di esperimenti

Precedenti lavori in psicologia sperimentale e neuroscienze cognitive hanno utilizzato una vasta gamma di stimoli con diversi livelli di naturalismo26. La maggior parte dei ricercatori preferisce utilizzare immagini statiche o brevi video dinamici perché questi stimoli sono più facili da preparare rispetto a quelli che potrebbero simulare un'azione reale o un evento. Nonostante abbiano dei vantaggi, questi stimoli non consentono ai ricercatori di misurare i comportamenti contingenti tra gli agenti sociali. In altre parole, non sono attuabili e non hanno accessibilità sociale27. Negli ultimi anni è stata sviluppata un'alternativa a questi stimoli non interattivi: animazioni in tempo reale di avatar virtuali. Questi avatar consentono l'indagine delle interazioni tra gli avatar e i loro utenti. Tuttavia, l'uso di avatar virtuali è soggetto a una ridotta apprensione degli utenti, soprattutto quando non appaiono particolarmente coinvolgenti in termini di comportamenti realistici e contingenti26. Pertanto, ora c'è più interesse nell'utilizzare stimoli sociali reali negli studi sperimentali. Sebbene la loro progettazione, registrazione dei dati e analisi possa richiedere attrezzature avanzate e analisi di dati complessi, sono i migliori candidati per comprendere il comportamento umano naturalistico e la cognizione.

Il presente studio propone una metodologia per l'utilizzo di stimoli sociali reali in un ambiente di laboratorio. Questo studio mira a indagare come le persone percepiscono e valutano le azioni degli altri in un ambiente con una maggiore validità ecologica rispetto ai tradizionali esperimenti di laboratorio. Abbiamo sviluppato e descritto una nuova configurazione in cui i partecipanti sono esposti ad attori reali che sono fisicamente presenti e condividono lo stesso ambiente con loro. In questo protocollo, vengono misurati i tempi di risposta dei partecipanti e le traiettorie dei topi, il che richiede tempi precisi di presentazione degli stimoli e un rigoroso controllo delle condizioni sperimentali in questo ambiente ecologico migliorato. Pertanto, il paradigma sperimentale spicca tra i quadri presenti in letteratura poiché la naturalezza degli stimoli è massimizzata senza sacrificare il controllo sull'ambiente. Di seguito, il protocollo presenta i passaggi per stabilire un tale sistema e quindi continua con i risultati rappresentativi per i dati di esempio. Infine, viene presentata una discussione sul significato del paradigma, sui limiti e sui piani di modifica.

Progettazione sperimentale

Prima di procedere alla sezione del protocollo, descriviamo i parametri utilizzati nel presente studio e presentiamo i dettagli degli stimoli insieme al disegno sperimentale.

Parametri nello studio

Questo studio mira a misurare come il tipo di attore e la classe di azioni che compiono influenzano i processi di percezione mentale dei partecipanti. Nel protocollo, il processo di percezione della mente è misurato in due dimensioni principali, vale a dire l'agenzia e l'esperienza, come proposto da precedenti ricerche28. Sono incluse anche le estremità alte e basse di queste due dimensioni, come recentemente introdotto da Li et al.29.

La struttura dello studio è stata ispirata dalla versione30 a categoria singola del compito di associazione implicita comunemente usato (IAT)31. In questo compito, i tempi di risposta dei partecipanti mentre corrispondono a un concetto di attributo con il concetto di destinazione vengono utilizzati come indicazione della forza delle loro associazioni implicite per questi due concetti. Nell'adattamento di questo compito implicito, ai partecipanti vengono presentate azioni dal vivo eseguite da attori reali e richiesto di abbinarle ai concetti target. I concetti target sono le estremità alte e basse dell'agenzia o delle dimensioni dell'esperienza, a seconda del blocco dell'esperimento.

Per riassumere, le variabili indipendenti sono Actor Type e Action Class. Il tipo di attore ha due livelli (cioè due attori diversi, Actor1 e Actor2, che si esibiscono nello studio). La classe di azione ha due livelli: Classe di azione1 e Classe di azione2 e ogni classe contiene quattro azioni. I partecipanti valutano i due attori separatamente in quattro blocchi (un attore in ogni blocco), e in ogni blocco, gli attori eseguono tutte le azioni in un ordine controbilanciato. I partecipanti eseguono valutazioni rispetto a due dimensioni predefinite e forzate: Agenzia ed Esperienza. I quattro blocchi dell'esperimento sono (1) Actor1 in Agency Block, (2) Actor2 in Agency Block, (3) Actor1 in Experience Block e (4) Actor2 in Experience Block. L'ordine dei blocchi è anche controbilanciato tra i partecipanti in modo che i blocchi con lo stesso agente non si susseguano mai.

Oltre alle risposte dei partecipanti, vengono registrati i tempi di risposta e le coordinate x-y del mouse wireless che usano mentre si muovono verso una delle due alternative di risposta. Quindi, le variabili dipendenti sono la risposta e il tempo di risposta (RT) dei partecipanti, nonché le misurazioni della deviazione massima (MD) e dell'area sotto la curva (AUC), derivate dal tracciamento del mouse del computer. La risposta variabile è categorica; può essere Alto o Basso e, poiché le valutazioni vengono eseguite in uno dei blocchi dati, le risposte possono anche essere etichettate come Alta Agenzia, Bassa Agenzia, Alta Esperienza o Bassa Esperienza. Il tempo di risposta è una variabile continua; La sua unità è secondi e si riferisce al tempo trascorso tra l'inizio della presentazione di un'azione e il verificarsi di un clic del mouse su una delle alternative di risposta. La MD di una traiettoria è una variabile continua e si riferisce alla più grande deviazione perpendicolare tra la traiettoria dei partecipanti e la traiettoria idealizzata (linea retta). L'AUC di una traiettoria è anche una variabile continua e si riferisce all'area geometrica tra la traiettoria dei partecipanti e la traiettoria idealizzata32.

Stimoli e progettazione dell'esperimento

Nel presente studio viene utilizzato un esperimento in tre fasi. Le misure della terza parte sono utilizzate per le analisi; Le prime due parti servono come preparazione per la parte finale. Di seguito, descriviamo ogni parte dell'esperimento insieme agli stimoli e alle ipotesi sperimentali.

In Esperimento Parte 1 (parte di formazione lessicale), i partecipanti completano una sessione di formazione per comprendere i concetti di Agenzia ed Esperienza e i livelli di capacità rappresentati con le parole Alto e Basso. Per selezionare i concetti (n = 12) da utilizzare in questa sessione di formazione, alcuni degli autori del lavoro attuale hanno condotto uno studio normativo33. Poiché il presente studio è stato pianificato per essere condotto nelle lingue native dei partecipanti, i concetti sono stati tradotti anche in turco prima di essere normalizzati. I concetti sono stati selezionati tra quelli che erano fortemente associati alle estremità Alta (n = 3) e Bassa (n = 3) delle due dimensioni (sei concetti per ciascuna). Questa parte è cruciale poiché ci si aspetta che la comprensione dei concetti da parte dei partecipanti guidi i loro processi di valutazione.

Nell'esperimento Parte 2 (parte di identificazione dell'azione), i partecipanti guardano le stesse otto azioni eseguite da Actor1 e Actor2 una dopo l'altra e riferiscono qual è l'azione allo sperimentatore. Questa sezione funge da controllo di manipolazione; Presentando tutte le azioni quando entrambi gli attori le stanno eseguendo, è possibile assicurarsi che i partecipanti comprendano le azioni e abbiano familiarità con gli attori prima di iniziare il test implicito, dove devono fare valutazioni rapide. Le azioni selezionate per Action Class1 e Action Class2 sono quelle che hanno avuto i punteggi H e i livelli di confidenza più alti (quattro diversi esempi di azione in ogni classe di azione) in base ai risultati dei due studi normativi (N = 219) per ciascuna condizione dell'attore condotti da alcuni degli autori (manoscritto in preparazione). Tutte le azioni vengono eseguite entro una durata di tempo uguale di 6 s.

Questo è uno studio in corso, e ha alcuni altri componenti; Tuttavia, le ipotesi per le sezioni sopra descritte sono le seguenti: (i) il tipo di attore influenzerà le variabili dipendenti; Actor2 produrrà RT più lunghi, MD più elevati e AUC più grandi rispetto ad Actor1; ii) il tipo di azione influirà sulle misurazioni dipendenti; La Classe d'azione1 produrrà RT più lunghi, MD più elevati e AUC più grandi rispetto alla Classe d'azione2; (iii) le misurazioni dipendenti per le risposte High e Low per lo stesso attore e classe d'azione differiranno tra le dimensioni del blocco: Agenzia ed Esperienza.

Protocollo

I protocolli sperimentali in questo studio sono stati approvati dal Comitato etico per la ricerca con partecipanti umani dell'Università di Bilkent. Tutti i partecipanti inclusi nello studio avevano più di 18 anni e hanno letto e firmato il modulo di consenso informato prima di iniziare lo studio.

1. Fasi generali di progettazione

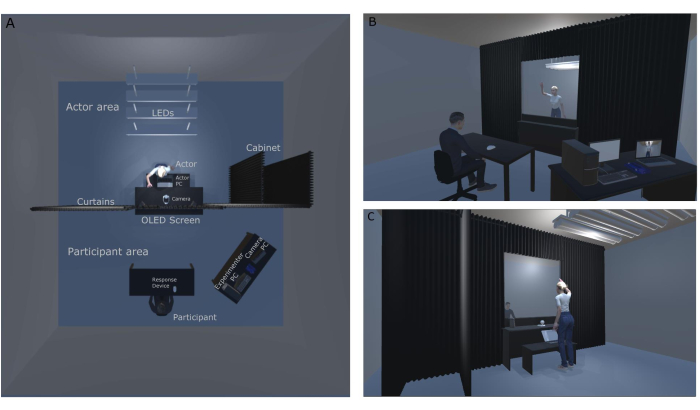

NOTA: la Figura 1A (vista dall'alto) e la Figura 1B e la Figura 1C (vista anteriore e posteriore) illustrano il layout del laboratorio; Queste figure sono state create rispetto all'impostazione e alla configurazione originali del laboratorio progettate per questo particolare studio. Nella Figura 1A viene illustrato il layout top-view del lab. In questa figura, è possibile vedere luci a LED sul soffitto e sul cabinet dell'attore. Il sistema di tende oscuranti divide la stanza a metà e aiuta la manipolazione della luce impedendo alla luce di fuoriuscire nella parte anteriore della stanza (Area partecipanti). La figura 1B presenta la vista del laboratorio dal punto di vista dello sperimentatore. Il partecipante si siede proprio di fronte allo schermo OLED e, utilizzando il display trasparente, può guardare le azioni dal vivo eseguite dagli attori. Danno le loro risposte utilizzando il dispositivo di risposta (un mouse wireless) di fronte a loro. Lo sperimentatore può guardare contemporaneamente l'attore attraverso il display del partecipante (schermo OLED) e il filmato proveniente dalla telecamera di sicurezza. La figura 1C mostra il backstage dello studio (Actor Area) con la telecamera di sicurezza e il personal computer Actor (PC), che non sono visibili al partecipante. Il filmato della telecamera di sicurezza va al PC della fotocamera per stabilire la comunicazione tra gli attori e lo sperimentatore. Il PC Actor visualizza l'ordine dei blocchi e le informazioni sull'azione successiva all'attore in modo che l'esperimento scorra senza alcuna interruzione. Gli attori possono controllare rapidamente l'azione successiva mentre i partecipanti rispondono all'azione nella prova precedente.

Figura 1: Configurazione del laboratorio naturalistico. (A) Vista dall'alto verso il basso dell'allestimento del laboratorio naturalistico. (B) I lati posteriore e anteriore dell'impostazione sperimentale naturalistica dal punto di vista del partecipante. (C) I lati posteriore e anteriore dell'impostazione sperimentale naturalistica dal punto di vista dell'attore. Fare clic qui per visualizzare una versione ingrandita di questa figura.

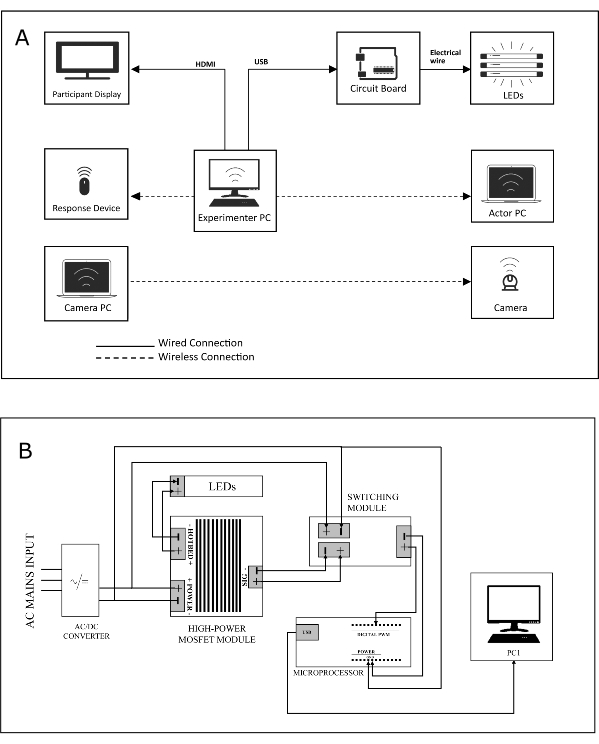

- Progettare una configurazione che includa tre computer, tra cui (1) un desktop di controllo principale (Experimenter PC), (2) un laptop attore (Actor PC) e (3) un PC fotocamera, un dispositivo di risposta wireless (Participant Mouse), due display, un circuito di illuminazione e una telecamera di sicurezza (vedere la Figura 2A per il diagramma sistema della configurazione di questo studio).

NOTA: il PC dello sperimentatore verrà utilizzato dallo sperimentatore per eseguire gli script dell'esperimento, il PC dell'attore verrà utilizzato dall'attore per tenere traccia dei blocchi dell'esperimento e dell'ordine delle azioni nei blocchi e il terzo dispositivo, il PC della fotocamera, sarà collegato alla telecamera di sicurezza situata nell'area dell'attore e utilizzato dallo sperimentatore per monitorare il backstage. - Collegare i display separati (uno per la presentazione degli stimoli [Participant Display], che è lo schermo OLED) e uno schermo per il monitoraggio dell'esperimento, il dispositivo di risposta e il circuito di illuminazione (tramite fili o connessioni wireless) al PC dello sperimentatore (vedere Figura 2A).

- Collegare il PC sperimentatore e il PC attore tramite una rete wireless per trasmettere informazioni relative allo stato dell'esperimento (ad esempio, "l'ID azione successiva è 'saluto''") agli attori.

- Progettare e costruire un circuito di illuminazione che (vedere la Figura 2B per il circuito stampato) può essere controllato da un microcontrollore per accendere e spegnere i LED.

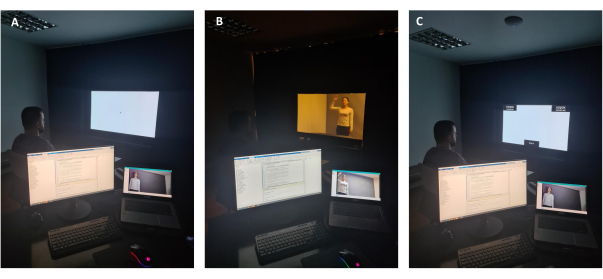

NOTA: La Figura 3A mostra l'uso opaco dello schermo OLED utilizzato nello studio dal punto di vista dello sperimentatore. Per garantire l'opacità, lo sfondo dello schermo viene regolato su bianco (RGB: 255, 255, 255) e tutte le luci nella stanza (sia nell'area partecipanti che nell'area attore) sono spente. Il partecipante vede la fissazione prima degli stimoli. La figura 3B mostra l'uso trasparente dello schermo digitale nello studio dal punto di vista dello sperimentatore. Per consentire la trasparenza, lo sfondo dello schermo viene regolato su nero (RGB: 0, 0, 0) e le luci LED sul soffitto sono accese. Il partecipante guarda l'attore. La figura 3C mostra l'uso opaco dello schermo digitale nello studio. Per garantire l'opacità, lo sfondo dello schermo viene regolato su bianco (RGB: 255, 255, 255) e tutte le luci nella stanza sono spente. Al partecipante viene presentata la schermata di valutazione per dare una risposta. Devono trascinare il cursore in alto a sinistra o in alto a destra dello schermo (una delle due opzioni di risposta, Alta o Bassa) utilizzando un mouse wireless. La loro traiettoria del mouse e il tempo di risposta vengono registrati. - Collegare il microcontrollore al PC sperimentatore.

- Archiviare gli script che eseguono l'esperimento nel PC Experimenter.

NOTA: la Figura 4A mostra il backstage (Area attore) durante l'esperimento. Le luci anteriori della stanza (Area partecipanti) sono spente e il PC Actor mostra il nome dell'azione che verrà eseguita dall'attore. La figura 4B mostra il gabinetto degli attori in cui gli attori possono aspettare il loro turno e cambiare i loro abiti. Il gabinetto degli attori non è visibile dalla vista del partecipante e, poiché viene utilizzato un sistema di tende, gli attori possono utilizzare qualsiasi ingresso desiderino. Durante l'esperimento, le luci fluorescenti visualizzate nella figura sono spente.

Figura 2: Sistema e schema elettrico . (A) Lo schema sistematico dell'impianto sperimentale naturalistico. (B) Lo schema elettrico del circuito luminoso che supporta lo schermo OLED durante l'esperimento. Fare clic qui per visualizzare una versione ingrandita di questa figura.

Figura 3: Schermo OLED dal punto di vista dello sperimentatore. (A) Uso opaco dello schermo digitale OLED dal punto di vista dello sperimentatore. (B) Uso trasparente dello schermo digitale OLED dal punto di vista dello sperimentatore. (C) Uso opaco dello schermo digitale OLED dal punto di vista dello sperimentatore durante un periodo di risposta. Fare clic qui per visualizzare una versione ingrandita di questa figura.

Figura 4: Backstage dell'esperimento. (A) Backstage durante una prova sperimentale. (B) Il cabinet attore è sul retro dello schermo OLED, in cui gli attori possono aspettare che il loro turno sia visibile durante l'esperimento. Fare clic qui per visualizzare una versione ingrandita di questa figura.

2. Progettazione e realizzazione del circuito di illuminazione

- Passi da seguire prima di alimentare i dispositivi/componenti del circuito

- Per modificare gli stati dei LED installati nel backstage (Area attore), fornire al PC sperimentatore la possibilità di commutare i LED su ON o OFF.

- Per trasmettere i comandi digitali che verranno inviati dal PC sperimentatore tramite un cavo USB, selezionare un dispositivo a microcontrollore in grado di prendere ingressi digitali e generare un'uscita digitale (vedere la tabella dei materiali per il microcontrollore utilizzato in questo studio).

- Selezionare una porta USB specifica del PC Experimenter per collegarlo all'ingresso USB del microcontroller tramite un cavo USB. Non accendere il PC prima di aver verificato che tutte le connessioni siano state stabilite correttamente.

- Includere un modulo di commutazione per aumentare l'ampiezza del segnale di uscita (circa 3,3 V) generato dal microcontrollore.

- Collegare il pin di uscita digitale designato (per questo esperimento, il pin designato è D9) e i pin di massa del microcontrollore al modulo di commutazione.

- Per eseguire il carico (i LED), includere un modulo MOSFET (Field-Effect Transistor) ad alta potenza metallo-ossido-semiconduttore (o modulo MOSFET) guidato dal segnale generato dal modulo di commutazione e collegare i pin del segnale del modulo MOSFET alla corrispondente coppia segnale-terra sul modulo di commutazione.

- Collegare i perni del letto caldo del modulo MOSFET al carico.

- Per fornire una tensione costante regolata ai moduli (e indirettamente, ai LED), includere un alimentatore LED che prende l'ingresso di rete a corrente alternata (CA) e genera una tensione CC costante nel circuito.

- Collegare le uscite dell'alimentatore LED agli ingressi di alimentazione sia del modulo MOSFET che del modulo di commutazione.

- Passi da seguire dopo il cablaggio dei componenti del circuito

- Collegare il cavo USB alla porta USB selezionata del PC Experimenter.

- Creare un collegamento di comunicazione seriale tra il microcontroller e l'ambiente software in esecuzione sul PC sperimentatore (vedere la sottosezione Collegamento del microcontroller al PC sperimentatore).

- Collegare l'alimentatore LED all'ingresso di rete CA.

3. Programmazione dell'esperimento

NOTA: creare tre script sperimentali principali (ExperimentScript1.m [file di codifica supplementare 1], ExperimentScript2.m [file di codifica supplementare 2] e ExperimentScript3.m [file di codifica supplementare 3]), nonché diverse funzioni (RecordMouse.m [file di codifica supplementare 4], InsideROI.m [file di codifica supplementare 5], RandomizeTrials.m [file di codifica supplementare 6], RandomizeBlocks.m [file di codifica supplementare 7], GenerateResponsePage.m [file di codifica supplementare 8], GenerateTextures.m [file di codifica supplementare 9], ActorMachine.m [file di codifica supplementare 10], MatchIDtoClass.m [file di codifica supplementare 11] e RandomizeWordOrder.m [file di codifica supplementare 12]) per eseguire l'esperimento.

NOTA: Fare riferimento agli script correlati per spiegazioni dettagliate.

- Randomizzazione degli ordini di prova e blocco

- Definire e creare due funzioni per randomizzare gli ordini di prova (RandomizeTrials.m) e gli ordini di blocco (RandomizeBlocks.m) che accettano i parametri di randomizzazione (ad esempio l'ID partecipante) come input e restituiscono una matrice di sequenze pseudorandomizzate.

- Vedere gli script RandomizeBlocks.m (righe 2-24) e RandomizeTrials.m (righe 3-26) per i dettagli su come vengono generate le sequenze randomizzate.

- Tracciamento della risposta (RecordMouse, InsideRoi)

- Creare una funzione che tenga traccia e registri la traiettoria del mouse dei partecipanti e il tempo trascorso durante l'esperimento (vedere RecordMouse.m).

- Creare una funzione di supporto per verificare se le coordinate cliccate si trovano all'interno delle regioni accettabili o meno (vedere lo script InsideRoi.m).

- Generazione di texture per istruzioni e feedback (GenerateTextures.m, GenerateResponsePage.m)

- Preparare le istruzioni relative all'esperimento e il feedback relativo alle prove come immagini.

- Salvare il contenuto di queste immagini in un file .mat (vedere File ExperimentImages.mat [File di codifica supplementare 13]).

- Caricare il file .mat nell'area di lavoro (vedere GenerateTextures.m riga 25) dopo aver creato una finestra sullo schermo.

- Create una texture separata e il relativo identificatore per ogni immagine (consultate GenerateTextures.m righe 27-165).

- Definire una funzione per disegnare le trame della pagina di risposta correlate per ogni script dell'esperimento (vedere GenerateResponsePage.m).

- Connessione del PC Actor al PC sperimentatore tramite TCP/IP

- Creare un socket server TCP nello script (vedere ExperimentScript2.m riga 174) in esecuzione sul PC Experimenter.

- Creare un socket client TCP corrispondente nello script (vedere ActorMachine.m riga 16) in esecuzione sul PC Actor.

- Inviare informazioni sul blocco/versione di prova imminente agli attori dallo script (vedere le righe 207, 229 e 278 in ExperimentScript2.m o vedere le righe 136, 141, 153, 159 e 297 in ExperimentScript3.m) in esecuzione sul PC Experimenter.

- Visualizzare le informazioni ricevute dal PC Experimenter nella finestra sullo schermo del PC Actor (vedere le righe 31-47 in ActorMachine.m).

- Collegamento del microcontroller al PC Experimenter

- Collegare il microcontrollore a una porta USB specifica (ad esempio, PORTA 9) per controllare lo stato (ON o OFF) dei LED installati nel backstage.

- Stabilire una comunicazione seriale tra il dispositivo microcontroller e il PC Experimenter (vedere la riga 185 nello script ExperimentScript2.m).

- Inviare un segnale logico alto (1) al microcontrollore dallo script in esecuzione sul PC Experimenter (vedere la riga 290 in ExperimentScript2.m o vedere la riga 311 negli script ExperimentScript3.m) per accendere i LED quando le azioni vengono visualizzate tramite il cavo USB.

- Inviare un segnale logico basso (0) al microcontrollore dallo script in esecuzione sul PC Experimenter (vedere la riga 292 in ExperimentScript2.m o vedere la riga 314 negli script ExperimentScript3.m) per spegnere i LED quando ci si aspetta che il partecipante dia una risposta.

4. Il flusso di un esperimento campione

- Fasi preliminari all'esperimento

- Assicurarsi che tutti i dispositivi in laboratorio (Experimenter PC, Camera PC, Actor PC e Participant Display) siano alimentati da un UPS.

- Collegare il microcontroller Lightning al PC Experimenter tramite un cavo USB, in modo che si accenda automaticamente all'accensione del PC Experimenter.)

- Accendi il PC Experimenter e controlla se è connesso a una rete Wi-Fi a 5 GHz.

- Scegliere il dispositivo audio (gli altoparlanti nella tabella dei materiali) come dispositivo di uscita audio del PC Experimenter.

- Accendere il display del partecipante e impostare le impostazioni del volume su 80%.

- Impostare le impostazioni dello schermo del PC Experimenter per più monitor. Estendere la visualizzazione del PC dell'esperimento allo schermo del partecipante. La visualizzazione del PC dello sperimentatore sarà 1 e la visualizzazione del partecipante sarà 2.

- Accendi Actor PC e controlla se è connesso a una rete Wi-Fi a 5 GHz.

- Collegare la telecamera di sicurezza all'Actor PC tramite un cavo USB, in modo che si accenda automaticamente all'accensione dell'Actor PC.

- Accendere il PC fotocamera e aprire l'applicazione fotocamera sul desktop. Assicurati che ogni attore, i suoi movimenti e le sue entrate e uscite dal cabinet siano visibili dalla telecamera.

- Assicurarsi che tutti i computer, i display e i dispositivi (il dispositivo di risposta [mouse wireless del partecipante], gli altoparlanti, la tastiera e il mouse del PC sperimentatore e del PC Actor e il microcontroller Lightning) funzionino correttamente.

- Accogliere il partecipante in un'altra stanza; Dopo aver fornito brevi informazioni sullo studio, fornire il modulo di consenso e farlo firmare al partecipante.

- Chiedi al partecipante di estrarre un numero da una borsa e dì loro che il numero sarà il loro ID partecipante durante lo studio.

- Consenti al partecipante di compilare il modulo demografico online con il proprio ID partecipante anonimo.

NOTA: È fondamentale che i partecipanti non vedano gli attori prima dell'esperimento. Quindi, questi documenti vengono completati in un'altra stanza piuttosto che nella stanza principale dell'esperimento in modo che gli attori possano fare delle pause tra i partecipanti.

- Fasi dell'esperimento

- Aprire il software dell'esperimento sul PC Experimenter, aprire lo script ExperimentScript1.m ed eseguirlo.

- Inserire l'ID del partecipante e l'età; quindi, lo script inizierà la prima parte dell'esperimento (il primo stimolo visibile sarà una croce al centro del Participant Display).

- Aprire il software di esperimento sul PC Actor e aprire lo script ActorMachine.m.

- Posizionare il PC della fotocamera vicino al PC dello sperimentatore e assicurarsi che il filmato proveniente dalla telecamera di sicurezza non sia visibile al partecipante.

- Accogli il partecipante nella sala principale dell'esperimento e lascia che abbia un posto di fronte al display del partecipante.

- Dì al partecipante di sistemarsi in modo che la croce sia nel mezzo e dritto davanti.

- Dare istruzioni sulle parti dell'esperimento brevemente facendo riferimento alle spiegazioni e alle durate scritte sulla lavagna.

- Spegni tutte le luci nella stanza degli esperimenti.

- Esperimento parte 1:

- Dì al partecipante che completerà la formazione lessicale / concettuale nella prima parte dell'esperimento. Avvertili di fare attenzione a seguire le istruzioni in modo che possano superare l'allenamento.

- Dì al partecipante che l'esperimento può essere avviato quando è pronto.

- Premere il pulsante ESC quando il partecipante dice di essere pronto per la prima parte.

NOTA: d'ora in poi, il partecipante procederà nell'esperimento leggendo le istruzioni sul display del partecipante e selezionando una delle scelte. Riceveranno feedback sulle loro risposte giuste e sbagliate in modo che possano progredire bene nella formazione. L'abbinamento continuerà fino a quando i partecipanti non raggiungeranno la soglia minima (80%) entro 10 ripetizioni di blocco. - Quando il partecipante completa la parte di addestramento, premere il pulsante ESC e dire al partecipante che lo sperimentatore sta prendendo il controllo del mouse per avviare la seconda parte dell'esperimento.

- Esperimento parte 2:

- Aprire lo script ExperimentScript2.m e attendere il prompt In attesa del PC Actor.

- Suonare il campanello quando viene visualizzato il prompt in modo che uno degli attori possa eseguire lo script sul PC Actor per abilitare la connessione con il PC Experimenter.

- Attendi il prompt L'esperimento Parte 2 è pronto.

- Dì al partecipante che ora lo schermo sarà trasparente mentre guardano alcune brevi azioni attraverso di esso.

- Avvertili di osservare attentamente ogni azione e informali che dovrebbero dire ad alta voce qual è l'azione.

- Dì al partecipante che l'esperimento può essere avviato quando è pronto.

- Premere il pulsante ESC quando il partecipante dice di essere pronto per la prima parte.

NOTA: Il partecipante procede attraverso le istruzioni e osserva la prima azione. Actor1 esegue le azioni quando le spie LED sono accese e controlla l'azione successiva dal prompt sul PC Actor quando le luci sono spente. Al termine di ogni azione, verrà visualizzata una finestra di dialogo sullo schermo del PC Experimenter. - Digitare ciò che il partecipante dice sull'azione nella finestra di dialogo e digitare 1 o 0 nella seconda finestra di dialogo, a seconda dell'identificazione corretta o errata dell'azione, rispettivamente.

NOTA: Questi passaggi verranno ripetuti otto volte per il primo attore e la musica di sottofondo inizierà a suonare quando è il momento per gli attori di cambiare posto. - Guarda il backstage dal filmato della telecamera di sicurezza sul PC della fotocamera.

- Premere il pulsante ESC per avviare l'identificazione per Actor2 quando l'attore agita le mani verso la telecamera di sicurezza con il gesto I am ready .

- Ripetere i passaggi 4.4.7 e 4.4.8 insieme al partecipante fino a quando non vengono identificate anche le stesse otto azioni mentre vengono eseguite dall'Attore2.

- Quando il partecipante visualizza l'avviso Identificazione è completa ed esce dalla parte facendo clic sulla freccia, premere il pulsante ESC e informare il partecipante che lo sperimentatore sta assumendo il controllo del mouse per avviare la terza parte dell'esperimento.

- Esperimento parte 3:

- Aprire lo script ExperimentScript3.m.

- Dì al partecipante che guarderà le azioni di entrambi gli attori, quindi farà clic sull'opzione che ritiene adatta.

NOTA: I partecipanti valuteranno le azioni degli attori in quattro blocchi. In due dei blocchi, Actor1 eseguirà le azioni e negli altri due, Actor2 eseguirà le stesse azioni. In due dei blocchi, i partecipanti valuteranno le azioni attribuendo capacità di Agenzia Alta o Bassa, e negli altri due, attribuiranno capacità di Esperienza Alta o Bassa. - Premere il pulsante ESC quando il partecipante dice di essere pronto per la terza parte.

NOTA: Il partecipante procede attraverso le istruzioni e inizia con il primo blocco. Gli attori eseguono le azioni alla luce e, mentre i partecipanti danno le loro risposte, lo schermo diventa opaco e le luci vengono spente in modo che gli attori possano vedere quale azione verrà dopo. Al termine di ogni blocco, gli attori cambieranno posto seguendo le istruzioni sul PC Actor. - Controlla se tutto va bene dietro le quinte e se l'attore giusto sta conducendo l'azione giusta durante i blocchi.

- Premi il pulsante ESC per iniziare il blocco successivo quando l'attore giusto agita le mani con il gesto Sono pronto dopo la sostituzione degli attori.

- Ripetere il passaggio 4.5.4 e il passaggio 4.5.5 in collaborazione con il partecipante e l'attore fino al completamento dei quattro blocchi.

- Quando il partecipante vede che l'esperimento è finito, grazie prompt, premere il pulsante ESC .

- Ringrazia il partecipante e, dopo aver fatto il debriefing e preso le firme, invia il partecipante.

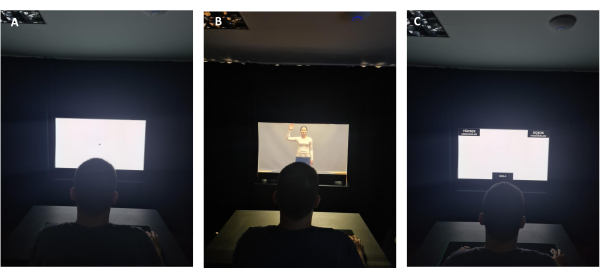

La Figura 5 mostra un esempio di prova dal punto di vista del partecipante. La Figura 5A mostra il partecipante che guarda il cursore al centro dello schermo nel suo utilizzo opaco. La Figura 5B mostra il partecipante che osserva gli stimoli live-action attraverso lo schermo. La Figura 5C mostra la schermata di valutazione presentata al partecipante dopo gli stimoli, in cui è necessario trascinare il mouse su una delle due alternative in ciascun angolo superiore dello schermo.

Figura 5: Schermo OLED dal punto di vista del partecipante. (A) Uso opaco dello schermo digitale OLED dal punto di vista del partecipante durante uno schermo di fissaggio. (B) Uso trasparente dello schermo digitale OLED dal punto di vista del partecipante durante la presentazione di un'azione dal vivo. (C) Uso opaco dello schermo digitale OLED dal punto di vista del partecipante durante il periodo di risposta. Fare clic qui per visualizzare una versione ingrandita di questa figura.

5. Pre-elaborazione e analisi dei dati

- Segmentazione dei dati in condizioni

- Leggere tutti i file di dati dei partecipanti nell'area di lavoro dell'ambiente software.

- Definire le condizioni per raggruppare i dati (due classi di azione [Classe di azione1 e Classe di azione2] x due attori [Actor1 e Actor2] x due dimensioni [Agenzia ed esperienza] x due livelli [Alto e Basso]).

- Segmenta i dati in quattro gruppi principali: Agenzia alta, Agenzia bassa, Esperienza alta ed Esperienza bassa.

- Dividi questi gruppi principali in quattro sottogruppi (due attori x due classi di azione).

- Scorrere ogni file di dati per raggruppare le prove che appartengono a uno dei quattro sottogruppi definiti in precedenza.

- Memorizzare le informazioni di prova rilevanti (tempo di risposta, movimento del cursore e punti temporali in cui viene campionata la posizione del cursore) in strutture di dati separate per ciascun sottogruppo.

- Uscire dal ciclo quando tutte le versioni di prova sono raggruppate.

- Visualizzazione delle traiettorie

- Dopo aver segmentato i dati, eseguire i passaggi seguenti per visualizzare le traiettorie del mouse.

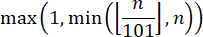

- Per applicare l'interpolazione temporale alle traiettorie di risposta, per ogni prova selezionare 101 (x,y) coppie dalla matrice di traiettorie in modo che ogni sottogruppo di dati abbia prove con un numero uguale di passaggi temporali.

NOTA: mentre si fissa il numero di coppie a 101, assicurarsi di seguire la convenzione32per eseguire la corretta normalizzazione dell'ora. Quindi, ottenere la normalizzazione del tempo usando la seguente equazione, dove n è il numero di campioni in una matrice di traiettorie:

- Calcola la somma delle coppie (x,y) in ciascuno dei 101 punti temporali, quindi dividi il risultato ottenuto per il numero totale di prove di quel sottogruppo per ottenere i mezzi per ciascun sottogruppo (ad esempio, Experience Low Actor1 o Experience Low Actor2).

- Applicare un'operazione di ridimensionamento ai valori delle righe per visualizzare le traiettorie medie.

NOTA: il piano di coordinate 2D presuppone che entrambi gli assi aumentino dal punto zero che si trova nell'angolo inferiore sinistro della finestra (supponendo che le coordinate siano numeri interi positivi), mentre il formato pixel accetta l'angolo superiore sinistro della finestra come riferimento (ad esempio, punto zero). Pertanto, applicare un'operazione di ridimensionamento per le coordinate y (corrispondenti ai valori delle righe in formato pixel) delle posizioni campionate estraendo la coordinata y campionata di ciascuna prova dal valore del numero totale di righe. - Tracciare i sottogruppi correlati nella stessa figura per il confronto.

NOTA: ogni traiettoria inizia al centro del rettangolo situato nella parte inferiore centrale, denominata START, e termina all'interno dei rettangoli situati negli angoli superiore sinistro o superiore destro.

6. Condizioni che possono portare a guasti del sistema e precauzioni

NOTA: In caso di guasto del sistema, è fondamentale avere un segno fisico (suonare un campanello) per informare l'attore del fallimento e avvertirlo di rimanere in un luogo invisibile al partecipante.

- Errori dovuti alla connessione di rete

- Se uno dei computer è connesso a una rete diversa, la richiesta di connessione TCP/IP avrà esito negativo e il sistema visualizzerà un errore. Per evitare ciò, assicurarsi che Experimenter PC e Actor PC si trovino sulla stessa banda della stessa rete wireless.

- Per assicurarsi che entrambi i PC rimangano sulla stessa rete, cancellare le reti wireless connesse in precedenza da entrambi i PC.

- Impostare indirizzi IP statici per i dispositivi sulla rete selezionata poiché gli indirizzi IP su una rete possono cambiare senza preavviso.

- Qualsiasi disconnessione momentanea (ad esempio, a causa di un'interruzione dell'alimentazione, di Internet, ecc.) alla rete può causare l'errore dello script. In queste circostanze, il sistema deve essere riavviato dall'inizio per ristabilire la connessione TCP/IP.

NOTA: il requisito degli IP statici per i dispositivi può essere soddisfatto dal provider di servizi Internet. Alcune porte potrebbero essere disabilitate dal sistema operativo o dall'hardware su un determinato dispositivo; Pertanto, le porte da utilizzare nell'esperimento devono essere aperte e non devono avere una connessione attiva fino all'avvio dello script dell'esperimento.

- Guasti dovuti a crash del software

- L'ambiente software potrebbe bloccarsi a causa di connessioni non riuscite (ad esempio, connessione alla porta seriale, connessione TCP / IP, connessione al display, ecc.) e ciò potrebbe comportare una perdita di dati. Per ovviare a questo problema, dividere lo script principale dell'esperimento in più script. Ad esempio, se c'è un blocco che deve essere completato prima che gli attori inizino a eseguire azioni, non è necessario creare un server sul PC Experimenter durante questo blocco. Il server può essere creato quando il blocco che comporta azioni e, quindi, richiede la comunicazione tra il PC sperimentatore e il PC Actor, sta per iniziare.

Risultati

Confronti dei tempi di risposta (RT)

Lo studio attuale è un progetto in corso, quindi, come risultati rappresentativi, vengono presentati i dati della parte principale dell'esperimento (Esperimento Parte 3). Questi dati provengono da 40 partecipanti, tra cui 23 femmine e 17 maschi, con età compresa tra 18 e 28 anni (M = 22,75, SD = 3,12).

Per scegliere il metodo statistico appropriato per le analisi è stato necessario studiare l'entità della normalità...

Discussione

L'obiettivo generale del presente studio è quello di contribuire alla nostra comprensione di come funzionano la percezione visiva e la cognizione umana di alto livello in situazioni di vita reale. Questo studio si è concentrato sulla percezione dell'azione e ha suggerito un paradigma sperimentale naturalistico ma controllabile che consente ai ricercatori di testare come gli individui percepiscono e valutano le azioni degli altri presentando attori reali in un ambiente di laboratorio.

L'impor...

Divulgazioni

Gli autori dichiarano di non avere interessi finanziari rilevanti o materiali relativi alla ricerca descritta in questo articolo.

Riconoscimenti

Questo lavoro è stato sostenuto da sovvenzioni a Burcu A. Urgen dal Consiglio di ricerca scientifica e tecnologica di Türkiye (numero di progetto: 120K913) e dall'Università di Bilkent. Ringraziamo la nostra partecipante pilota Sena Er Elmas per aver portato l'idea di aggiungere rumore di fondo tra i cambi di attore, Süleyman Akı per aver impostato il circuito delle luci e Tuvana Karaduman per l'idea di utilizzare una telecamera di sicurezza nel backstage e il suo contributo come uno degli attori nello studio.

Materiali

| Name | Company | Catalog Number | Comments |

| Adjustable Height Table | Custom-made | N/A | Width: 60 cm, Height: 62 cm, Depth: 40 cm |

| Ardunio UNO | Smart Projects | A000066 | Microcontroller used for switching the state of the LEDs from the script running on the operator PC |

| Black Pants | No brand | N/A | Relaxed-fit pants of actors with no apparent brand name or logo. |

| Case | Xigmatek | EN43224 | XIGMATEK HELIOS RAINBOW LED USB 3.0 MidT ATX GAMING CASE |

| CPU | AMD | YD1600BBAFBOX | AMD Ryzen 5 1600 Soket AM4 3.2 GHz - 3.6 GHz 16 MB 65 W 12 nm Processor |

| Curtains | Custom-made | N/A | Width: Part 1: 110 cm width from the wall (left) side, Part 2: 123 cm width above OLED display, Part 3: 170 cm from OLED display to right side, Cabin depth: 100 cm, Inside cabin depth: 100 cm, all heights 230 cm except for Part 2 (75 cm height) |

| Experimenter Adjustable/Swivel Chair | No brand | N/A | Any brand |

| Experimenter Table | Custom | N/A | Width: 160 cm, Height: 75 cm, Depth: 80 cm |

| GPU | MSI | GT 1030 2GHD4 LP OC | MSI GEFORCE GT 1030 2GHD4 LP OC 2GB DDR4 64bit NVIDIA GPU |

| Grey-color blackout curtain | Custom-made | N/A | Width: 330 cm, Height: 230 cm, used for covering the background |

| Hard Disk | Kioxia | LTC10Z240GG8 | Kioxia 240 GB Exceria Sata 3.0 SSD (555 MB Read/540 MB Write) |

| Hard Disk | Toshiba | HDWK105UZSVA | Toshiba 2,5'' 500 GB L200 SATA 3.0 8 MB Cache 5400 Rpm 7 mm Harddisk |

| High-Power MOSFET Module | N/A | N/A | Heating Controller MKS MOSFET Module |

| Laptop | Apple | S/N: C02P916ZG3QT | MacBook Pro 11.1 Intel Core i7 (Used as the actor PC) |

| Laptop | Asus | UX410U | Used for monitoring the security camera in real-time. |

| LED lights | No brand | N/A | |

| LED Strip Power Supply | No brand | N/A | AC to DC voltage converter used for supplying DC voltage to the lighting circuit |

| MATLAB | The MathWorks Inc., Natick, MA, USA | Version: R2022a | Used for programming the experiment. Required Toolboxes: MATLAB Support Package for Arduino Hardware (version 22.1.2) Instrument Control Toolbox (version 4.6) Psychtoolbox (version 3) |

| Monitor | Philips | UHB2051005145 | Model ID: 242V8A/00, PHILIPS 23.8" 242V8A 4ms 75 Hz Freesync DP-HDMI+VGA IPS Gaming Monitor |

| Motherboard | MSI | B450M-A PRO MAX | MSI B450M-A PRO MAX Amd B450 Socket AM4 DDR4 3466(OC) M.2 Motherboard |

| Mouse Pad for participant | Monster | 78185721101502042 / 8699266781857 | Pusat Gaming Mouse Pad XL |

| Night lamp | Aukes | ES620-0.5W 6500K-IP 20 | Used for helping the actors see around when the lights are off in the backstage. |

| Participant Adjustable/Swivel Chair | No brand | N/A | |

| Participant Table | IKEA | Sandsberg 294.203.93 | Width: 110 cm, Height: 75 cm, Depth: 67 cm |

| Power Extension Cable | Viko | 9011760Y | 250 V (6 inlets) Black |

| Power Extension Cable | Viko | 9011730Y | 250 V (3 inlets) Black |

| Power Extension Cable | Viko | 9011330Y | 250 V (3 inlets) White |

| Power Extension Cable | s-link | Model No: SPG3-J-10 | AC - 250 V 3 meter (5 inlets) |

| Power Supply | THERMALTAKE | PS-LTP-0550NHSANE-1 | THERMALTAKE LITEPOWER RGB 550W APFC 12 cm FAN PSU |

| Professional Gaming Mouse | Rampage | 8680096 | Model No: SMX-R50 |

| RAM | GSKILL | F4-3000C16S-8GVRB | GSKILL 8GB (1x8GB) RipjawsV Red DDR4 3000 MHz CL16 1.35 V Single Ram |

| Reception bell | No brand | N/A | Used for helping the communication between the experimenter and the actors. |

| Security Camera | Brion Vega | 2-20204210 | Model:BV6000 |

| Speakers | Logitech | P/N: 880-000-405 PID: WD528XM | Used for playing the background music. |

| Survey Software | Qualtrics | N/A | |

| Switching Module | No brand | N/A | F5305S PMOS Switch Module |

| Table under the OLED display | Custom-made | N/A | Width: 123 cm, Height: 75 cm, Depth: 50 cm |

| Transparent OLED Display | Planar | PN: 998-1483-01 S/N:195210075 | A 55-inch transparent display that showcases dynamic information, enabled the opaque and transparent usage during the experiment. |

| UPS | EAG | K200610100087 | EAG 110 |

| UPS | EAG | 210312030507 | EAG 103 |

| USB 2.0 Cable Type A/B for Arduino UNO (Blue) | Smart Projects | M000006 | Used to connect the microcontroller to the experimenter PC. |

| USB to RS232 Converter | s-link | 8680096082559 | Model: SW-U610 |

| White Long-Sleeved Blouse (2) | H&M (cotton) | N/A | Relaxed-fit blouses with a round neckline and without ant apparent brand name or logo. |

| Wireless Keyboard | Logitech | P/N: 820-003488 S/N: 1719CE0856D8 | Model: K360 |

| Wireless Mouse | Logitech | S/N: 2147LZ96BGQ9 | Model: M190 (Used as the response device) |

Riferimenti

- Grossman, E. D., Blake, R. Brain areas active during visual perception of biological motion. Neuron. 35 (6), 1167-1175 (2002).

- Saygin, A. P. Superior temporal and premotor brain areas necessary for biological motion perception. Brain. 130 (9), 2452-2461 (2007).

- Peelen, M. V., Downing, P. E. The neural basis of visual body perception. Nature Reviews Neuroscience. 8 (8), 636-648 (2007).

- Caspers, S., Zilles, K., Laird, A. R., Eickhoff, S. B. ALE meta-analysis of action observation and imitation in the human brain. Neuroimage. 50 (3), 1148-1167 (2010).

- Nelissen, K., et al. Action observation circuits in the macaque monkey cortex. Journal of Neuroscience. 31 (10), 3743-3756 (2011).

- Oosterhof, N. N., Tipper, S. P., Downing, P. E. Crossmodal and action-specific: Neuroimaging the human mirror neuron system. Trends in Cognitive Sciences. 17 (7), 311-318 (2013).

- Lingnau, A., Downing, P. E. The lateral occipitotemporal cortex in action. Trends in Cognitive Sciences. 19 (5), 268-277 (2015).

- Giese, M. A., Rizzolatti, G. Neural and computational mechanisms of action processing: Interaction between visual and motor representations. Neuron. 88 (1), 167-180 (2015).

- Tucciarelli, R., Wurm, M., Baccolo, E., Lingnau, A. The representational space of observed actions. eLife. 8, e47686 (2019).

- Tarhan, L., Konkle, T. Sociality and interaction envelope organize visual action representations. Nature Communications. 11 (1), 3002 (2020).

- Urgen, B. A., Saygin, A. P. Predictive processing account of action perception: Evidence from effective connectivity in the action observation network. Cortex. 128, 132-142 (2020).

- Newen, A., De Bruin, L., Gallagher, S. . The Oxford Handbook of 4E Cognition. , (2018).

- Snow, J. C., Culham, J. C. The treachery of images: How realism influences brain and behavior. Trends in Cognitive Sciences. 25 (6), 506-519 (2021).

- Matusz, P. J., Dikker, S., Huth, A. G., Perrodin, C. Are we ready for real-world neuroscience. Journal of Cognitive Neuroscience. 31 (3), 327-338 (2019).

- Zaki, J., Ochsner, K. The need for a cognitive neuroscience of naturalistic social cognition. Annals of the New York Academy of Sciences. 1167 (1), 16-30 (2009).

- Hasson, U., Honey, C. J. Future trends in Neuroimaging: Neural processes as expressed within real-life contexts. NeuroImage. 62 (2), 1272-1278 (2012).

- Risko, E. F., Laidlaw, K. E., Freeth, M., Foulsham, T., Kingstone, A. Social attention with real versus reel stimuli: toward an empirical approach to concerns about ecological validity. Frontiers in Human Neuroscience. 6, 143 (2012).

- Parsons, T. D. Virtual reality for enhanced ecological validity and experimental control in the clinical, affective and social neurosciences. Frontiers in Human Neuroscience. 9, 660 (2015).

- Deuse, L., et al. Neural correlates of naturalistic social cognition: brain-behavior relationships in healthy adults. Social Cognitive and Affective Neuroscience. 11 (11), 1741-1751 (2016).

- Camerer, C., Mobbs, D. Differences in behavior and brain activity during hypothetical and real choices. Trends in Cognitive Sciences. 21 (1), 46-56 (2017).

- Nastase, S. A., Goldstein, A., Hasson, U. Keep it real: Rethinking the primacy of experimental control in cognitive neuroscience. NeuroImage. 222, 117254 (2020).

- Kihlstrom, J. F. Ecological validity and "ecological validity". Perspectives on Psychological Science. 16 (2), 466-471 (2021).

- Brunswik, E. . Perception and the Representative Design of Psychological Experiments. , (1956).

- Aronson, E., Carlsmith, J. M., Gilbert, D. T., Fiske, S. T., Lindzay, G. Experimentation in social psychology. The Handbook of Social Psychology. , 1-79 (1968).

- Ecological validity: Then and now. University of Colorado Available from: https://www.albany.edu/cpr/brunswik/notes/essay1.html (1998)

- Fan, S., Dal Monte, O., Chang, S. W. Levels of naturalism in social neuroscience research. IScience. 24 (7), 102702 (2021).

- Orban, G. A., Lanzilotto, M., Bonini, L. From observed action identity to social affordances. Trends in Cognitive Sciences. 25 (6), 493-505 (2021).

- Gray, H. M., Gray, K., Wegner, D. M. Dimensions of mind perception. Science. 315 (5812), 619 (2007).

- Li, Z., Terfurth, L., Woller, J. P., Wiese, E. Mind the machines: Applying implicit measures of mind perception to social robotics. 2022 17th ACM/IEEE International Conference on Human-Robot Interaction (HRI. , 236-245 (2022).

- Karpinski, A., Steinman, R. B. The single category implicit association test as a measure of implicit social cognition. Journal of Personality and Social Psychology. 91 (1), 16 (2006).

- Greenwald, A. G., McGhee, D. E., Schwartz, J. L. Measuring individual differences in implicit cognition: the implicit association test. Journal of Personality and Social Psychology. 74 (6), 1464 (1998).

- Freeman, J. B., Ambady, N. MouseTracker: Software for studying real-time mental processing using a computer mouse-tracking method. Behavior Research Methods. 42 (1), 226-241 (2010).

- Pekçetin, T. N., Barinal, B., Tunç, J., Acarturk, C., Urgen, B. A. Studying mind perception in social robotics implicitly: The need for validation and norming. Proceedings of the 2023 ACM/IEEE International Conference on Human-Robot Interaction. , 202-210 (2023).

- Yu, Z., Wang, F., Wang, D., Bastin, M. Beyond reaction times: Incorporating mouse-tracking measures into the implicit association test to examine its underlying process. Social Cognition. 30 (3), 289-306 (2012).

- Romero, C. A., Snow, J. C. Methods for presenting real-world objects under controlled laboratory conditions. Journal of Visualized Experiments. (148), e59762 (2019).

- Jastorff, J., Abdollahi, R. O., Fasano, F., Orban, G. A. Seeing biological actions in 3 D: An f MRI study. Human Brain Mapping. 37 (1), 203-219 (2016).

- Ferri, S., Pauwels, K., Rizzolatti, G., Orban, G. A. Stereoscopically observing manipulative actions. Cerebral Cortex. 26 (8), 3591-3610 (2016).

- Stangl, M., Maoz, S. L., Suthana, N. Mobile cognition: Imaging the human brain in the 'real world. Nature Reviews Neuroscience. 24 (6), 347-362 (2023).

- Kriegeskorte, N. Deep neural networks: a new framework for modeling biological vision and brain information processing. Annual Review of Vision Science. 1, 417-446 (2015).

- Marblestone, A. H., Wayne, G., Kording, K. P. Toward an integration of deep learning and neuroscience. Frontiers in Computational Neuroscience. 10, 94 (2016).

Ristampe e Autorizzazioni

Richiedi autorizzazione per utilizzare il testo o le figure di questo articolo JoVE

Richiedi AutorizzazioneEsplora altri articoli

This article has been published

Video Coming Soon