JoVE 비디오를 활용하시려면 도서관을 통한 기관 구독이 필요합니다. 전체 비디오를 보시려면 로그인하거나 무료 트라이얼을 시작하세요.

Method Article

실험 심리학 및 인지 신경 과학 연구에서 실제 사람과 실제 행동을 제시하기 위한 자연주의적 설정

요약

이 연구는 연구자들이 실시간 행동 자극을 제시하고, 참가자가 각 자극 표시 후에 반응하는 동안 응답 시간 및 마우스 추적 데이터를 얻고, 특수 투명 유기 발광 다이오드(OLED) 화면 및 조명 조작을 포함한 고유한 시스템으로 실험 조건 간에 행위자를 변경할 수 있는 자연주의적 실험 설정을 제시합니다.

초록

다른 사람의 행동에 대한 인식은 생존, 상호 작용 및 의사 소통에 매우 중요합니다. 행동의 인식을 이해하는 데 전념하는 수십 년간의 인지 신경과학 연구에도 불구하고, 우리는 여전히 인간의 행동 인식에 접근하는 신경에서 영감을 받은 컴퓨터 비전 시스템을 개발하는 것과는 거리가 멉니다. 주요 과제는 현실 세계에서의 행동이 "지금 여기"에서 발생하고 적용 가능한 공간에서 일시적으로 전개되는 사건으로 구성된다는 것입니다. 대조적으로, 지금까지의 시각적 인식 및 인지 신경과학 연구는 공간과 시간에 배우의 존재가 없는 2D 디스플레이(예: 이미지 또는 비디오)를 통한 행동 인식을 주로 연구했기 때문에 이러한 디스플레이는 작동 가능성을 제공하는 데 한계가 있습니다. 현장에서 지식의 증가에도 불구하고 현실 세계에서 다른 사람들의 행동을 인식하는 기본 메커니즘을 더 잘 이해하기 위해서는 이러한 도전을 극복해야 합니다. 이 연구의 목적은 실제 설정에 가까운 시나리오에서 실제 배우와 함께 자연주의적 실험실 실험을 수행하기 위한 새로운 설정을 도입하는 것입니다. 이 연구에 사용된 설정의 핵심 요소는 투명 유기 발광 다이오드(OLED) 화면으로, 이를 통해 참가자는 프레젠테이션 타이밍을 정밀하게 제어하면서 물리적으로 존재하는 배우의 라이브 액션을 볼 수 있습니다. 이 작업에서이 설정은 행동 실험에서 테스트되었습니다. 우리는 이 설정이 연구자들이 행동 지각의 근본적이고 이전에는 접근할 수 없었던 인지 및 신경 메커니즘을 밝히는 데 도움이 될 것이며 자연주의적 환경에서 사회적 지각과 인지를 조사하는 향후 연구의 기초가 될 것이라고 믿습니다.

서문

생존과 사회적 상호 작용을위한 기본 기술은 다른 사람들의 행동을 인식하고 이해하고 주변 환경에서 그들과 상호 작용하는 능력입니다. 지난 수십 년 동안의 이전 연구는 개인이 다른 사람의 행동을 어떻게 인식하고 이해하는지에 대한 기본 원칙을 이해하는 데 크게 기여했습니다 1,2,3,4,5,6,7,8,9,10,11 . 그럼에도 불구하고 상호 작용의 복잡성과 상호 작용이 발생하는 상황을 감안할 때 일상 생활 환경에서 이 복잡한 기술에 대한 보다 완전한 이해에 도달하기 위해 자연주의적 환경에서 지식 체계를 더욱 발전시킬 필요가 있습니다.

우리의 일상 생활 환경과 같은 자연 환경에서 지각과 인지는 구체화, 내재, 확장 및 능동적 특성을 나타냅니다12. 신체와 환경의 역할을 과소 평가하는 경향이있는 뇌 기능에 대한 내부 주의적 설명과는 달리, 구체화 된인지에 대한 현대의 접근 방식은 뇌, 신체 및 환경의 역동적 인 결합에 중점을 둡니다. 반면에, 행동 지각에 관한 대부분의 사회 심리학, 인지 심리학 및 신경과학 연구는 실험실 조건(예: 컴퓨터 작업의 이미지 또는 비디오)에서 잘 제어되고 단순화된 실험 설계를 활용하면 실제 상호 작용과 같은 보다 복잡한 시나리오로 일반화될 수 있는 결과를 산출한다고 가정하는 경향이 있습니다 1,2,3,4,5,6,7 ,8,9,10,11. 이 가정은 많은 상황에서 강력하고 신뢰할 수 있는 데이터를 얻을 수 있음을 보장합니다. 그럼에도 불구하고, 잘 알려진 도전은 신중하게 통제된 실험으로부터 도출된 모델들의 타당성이 실제 상황(13)에서 시험될 때 제한된다는 것이다. 결과적으로 다양한 연구 분야에서 자극 및 실험 설계의 생태학적 및 외부적 타당성을 다루기 위해 추가 조사(13,14,15,16,17,18,19,20,21,22)가 수행되었습니다.

이 연구에서는 물리적으로 존재하는 실제 행위자가 수행하는 실제 행동을 사용하여 개인이 다른 사람의 행동을 어떻게 인식하고 평가하는지 조사하기 위한 새로운 방법을 제안합니다. 실제 상황과 유사한 시나리오가 사용되며 실험자는 가능한 교란 요인을 제어 할 수 있습니다. 이 연구는 Matusz et al.14의 틀 내에서 "자연주의적 실험실 연구"의 한 형태로, 종종 자연스러움을 희생시키면서 자극과 환경에 대한 최대한의 통제를 사용하는 "고전적 실험실 연구"와 자극과 환경에 대한 통제를 희생시키면서 자연스러움을 극대화하는 것을 목표로 하는 "완전 자연주의적 실제 연구"사이의 중간 단계로 생각할 수 있습니다 14. 이 연구는 높은 수준의 실험 통제를 통해 전통적인 실험실 실험에서 얻은 결과와 완전히 제한되지 않은 자연 환경에서 수행된 연구에서 얻은 결과 사이의 격차를 해소하기 위해 행동 인식 연구에서 이 수준에서 경험적 조사의 필요성을 해결하는 것을 목표로 합니다.

통제된 실험과 제약되지 않은 실험

실험 제어는 연구자가 교란 요인에서 목표 변수를 분리할 수 있도록 하기 때문에 특정 가설을 테스트하기 위한 실험을 설계하는 효율적인 전략입니다. 또한 동일한 설계에서 약간 또는 완전히 다른 자극을 사용하거나 대체 실험 설정에서 동일한 자극을 테스트하는 것과 같이 특정 수준의 수정으로 동일한 가설을 재검토할 수 있습니다. 통제된 실험을 통한 체계적인 조사는 인지 과학 및 관련 영역 연구에서 전통적인 형태의 방법론입니다. 통제된 실험은 여전히 주의력, 기억력 및 지각과 같은 다양한 연구 영역에서 인지 과정의 기본 원리에 대한 지식 체계를 확립하는 데 도움이 됩니다. 그러나 최근의 연구는 또한 결과를 실제 환경으로 일반화하는 측면에서 전통적인 실험실 실험의 한계를 인정했으며 연구자들은 향상된 생태 환경에서 연구를 수행하도록 권장되었습니다 13,14,15,16,17,18,19,20,21. 이러한 변화는 전통적인 실험실 실험과 실제 환경 간의 불일치와 관련된 두 가지 중요한 문제를 해결하는 것을 목표로 합니다. 첫째, 실험실 밖의 세계는 실험보다 덜 결정론적이어서 체계적인 실험 조작의 대표성을 제한합니다. 둘째, 인간의 뇌는 적응력이 뛰어나며, 이는 실험 연구를 설계하고 수행하는 데 실질적인 한계가 있기 때문에 종종 과소평가된다22. "생태학적 타당성"23,24의 개념은 이 문제를 해결하기 위한 방법을 다루는 데 사용되어 왔다. 이 용어는 일반적으로 실험실 맥락 외부의 실제 세계에 대한 실험 결과를 일반화하기 위한 전제 조건을 나타내는 데 사용됩니다. 생태학적 타당성은 또한 연구 설계가 실제 시나리오와 유사한지 확인하기 위해 제한되지 않은 자극으로 사실상 자연주의적 실험 설정을 검증하는 것을 의미하는 것으로 해석되었습니다25. 이 용어의 해석에 있어 높은 수준의 차이로 인해 대체 방법론과 자극 선택의 장점과 한계에 대한 이해가 필요합니다.

자극과 실험 설계의 자연주의 수준

실험 심리학 및 인지 신경과학의 이전 연구는 다양한 수준의 자연주의와 함께 광범위한 자극을 사용했습니다26. 대부분의 연구자들은 정적 이미지나 짧은 동적 비디오를 사용하는 것을 선호하는데, 그 이유는 이러한 자극이 실제 행동이나 사건을 시뮬레이션할 수 있는 자극보다 준비하기가 더 쉽기 때문입니다. 장점이 있음에도 불구하고 이러한 자극은 연구자가 사회 행위자들 사이에서 우발적 인 행동을 측정하는 것을 허용하지 않습니다. 다시 말해, 그들은 수용 가능하지 않으며 사회적 어포던스가 없습니다27. 최근 몇 년 동안 이러한 비대화형 자극에 대한 대안인 가상 아바타의 실시간 애니메이션이 개발되었습니다. 이러한 아바타를 사용하면 아바타와 사용자 간의 상호 작용을 조사할 수 있습니다. 그러나, 가상 아바타의 사용은 특히 그들이 그들의 현실적이고 우발적인 행동의 관점에서 특별히 매력적으로 보이지 않을 때, 사용자들의 불안을 감소시킬 수 있다(26). 따라서 실험 연구에서 실제 사회적 자극을 사용하는 데 더 많은 관심이 있습니다. 설계, 데이터 기록 및 분석에는 고급 장비와 복잡한 데이터 분석이 필요할 수 있지만 자연주의적 인간 행동과 인지를 이해하는 데 가장 적합한 후보입니다.

본 연구는 실험실 환경에서 실제 사회적 자극을 사용하는 방법론을 제안합니다. 이 연구는 전통적인 실험실 실험에 비해 생태학적 타당성이 향상된 환경에서 사람들이 다른 사람의 행동을 어떻게 인식하고 평가하는지 조사하는 것을 목표로 합니다. 우리는 참가자들이 물리적으로 존재하고 그들과 동일한 환경을 공유하는 실제 배우에게 노출되는 새로운 설정을 개발하고 설명했습니다. 이 프로토콜에서는 참가자의 반응 시간과 마우스 궤적을 측정하므로 자극 표현의 정확한 타이밍과 이 향상된 생태 환경에서 실험 조건에 대한 엄격한 제어가 필요합니다. 따라서 실험 패러다임은 환경에 대한 통제력을 희생하지 않고 자극의 자연 스러움이 극대화되기 때문에 문헌에 존재하는 틀 중에서 두드러진다. 아래에서 프로토콜은 이러한 시스템을 구축하는 단계를 제시한 다음 샘플 데이터에 대한 대표 결과를 계속합니다. 마지막으로 패러다임의 중요성, 한계 및 수정 계획에 대한 논의가 제시됩니다.

실험 설계

프로토콜 섹션으로 진행하기 전에 본 연구에서 사용된 매개변수를 설명하고 실험 설계와 함께 자극의 세부 사항을 제시합니다.

연구의 매개 변수

이 연구는 배우의 유형과 그들이 수행하는 행동의 종류가 참가자의 마음 인식 과정에 어떤 영향을 미치는지 측정하는 것을 목표로 합니다. 프로토콜에서 마음 지각 과정은 이전 연구28에서 제안한 바와 같이 선택의지와 경험이라는 두 가지 주요 차원으로 측정됩니다. 이 두 차원의 고가와 저가도 최근 Li et al.29에 의해 도입된 바와 같이 포함됩니다.

이 연구의 구조는 일반적으로 사용되는 암시적 연관 작업(IAT)31 의 단일 범주 버전 30에서 영감을 받았습니다. 이 작업에서 속성 개념을 대상 개념과 일치시키는 동안 참가자의 응답 시간은 이 두 개념에 대한 암시적 연관의 강도를 나타내는 데 사용됩니다. 이 암묵적인 작업의 적응에서 참가자는 실제 배우가 수행하는 라이브 액션을 제시하고 대상 개념과 일치시켜야 합니다. 대상 개념은 실험의 블록에 따라 에이전시 또는 경험 차원의 상한선과 하한선입니다.

요약하자면, 독립 변수는 액터 타입(Actor Type)과 액션 클래스(Action Class)입니다. 액터 유형에는 두 가지 레벨이 있습니다(즉, 스터디에서 연기하는 두 개의 다른 액터, 액터1 및 액터2). Action Class에는 Action Class1과 Action Class2의 두 가지 수준이 있으며 각 클래스에는 네 개의 작업이 포함되어 있습니다. 참가자들은 두 액터를 4개의 블록(각 블록에 한 액터)으로 따로 평가하고, 각 블록에서 액터는 균형 잡힌 순서로 모든 동작을 수행합니다. 참가자는 사전 정의되고 강제적인 두 가지 차원인 선택의지와 경험에 대한 평가를 수행합니다. 실험의 4개 블록은 (1) 에이전시 블록의 액터1, (2) 에이전시 블록의 액터2, (3) 경험 블록의 액터1, (4) 경험 블록의 액터2입니다. 블록의 순서도 참가자 간에 균형을 이루어 동일한 에이전트를 가진 블록이 서로를 따르지 않도록 합니다.

참가자의 답변 외에도 두 가지 응답 대안 중 하나로 이동하는 동안 사용하는 무선 마우스의 응답 시간과 xy 좌표가 기록됩니다. 따라서 종속 변수는 참가자의 응답 및 응답 시간(RT)뿐만 아니라 컴퓨터 마우스 추적에서 파생된 최대 편차(MD) 및 곡선 아래 면적(AUC)의 측정값입니다. 변수 반응은 범주형입니다. 높음 또는 낮음일 수 있으며 평가가 지정된 블록 중 하나에서 수행되므로 응답은 높은 기관, 낮은 기관, 높은 경험 또는 낮은 경험으로 레이블을 지정할 수도 있습니다. 응답 시간은 계량형 변수입니다. 단위는 초이며 작업 프레젠테이션 시작과 응답 대안 중 하나에서 마우스 클릭 발생 사이의 경과 시간을 나타냅니다. 궤적의 MD는 연속 변수이며 참가자의 궤적과 이상적인 궤적(직선) 사이의 가장 큰 수직 편차를 나타냅니다. 궤적의 AUC는 또한 연속적인 변수이며, 참가자(들)의 궤적과 이상화된 궤적(32) 사이의 기하학적 영역을 의미한다.

실험의 자극과 설계

본 연구에서는 3단계 실험이 사용됩니다. 세 번째 부분의 측정값은 분석에 사용됩니다. 처음 두 부분은 마지막 부분을 준비하는 역할을 합니다. 아래에서는 실험 자극 및 가설과 함께 실험의 각 부분을 설명합니다.

실험 파트 1(어휘 교육 파트)에서 참가자는 에이전시 및 경험의 개념과 높음과 낮음이라는 단어로 표시되는 역량 수준을 이해하기 위한 교육 세션을 완료합니다. 이 교육 세션에서 사용할 개념 (n = 12)을 선택하기 위해 현재 연구의 저자 중 일부는 규범 적 연구33을 수행했습니다. 본 연구는 참가자들의 모국어로 진행될 예정이었기 때문에 개념도 정규화되기 전에 터키어로 번역되었습니다. 개념은 2차원의 높음(n=3) 및 낮음(n=3) 끝과 밀접하게 관련된 개념(각각 6개의 개념) 중에서 선택되었습니다. 이 부분은 개념에 대한 참가자의 이해가 평가 프로세스를 안내할 것으로 예상되기 때문에 매우 중요합니다.

실험 파트 2(행동 식별 파트)에서 참가자는 Actor1과 Actor2가 수행하는 동일한 8가지 동작을 차례로 보고 실험자에게 행동이 무엇인지 보고합니다. 이 섹션은 조작 검사 역할을 합니다. 두 액터가 모두 수행할 때 모든 액션을 제시함으로써 참가자가 빠른 평가가 필요한 암시적 테스트를 시작하기 전에 액션을 이해하고 액터에 익숙해지도록 할 수 있습니다. Action Class1 및 Action Class2에 대해 선택된 행동은 각 행위자 조건에 대한 두 가지 규범 연구(N = 219)의 결과에 따라 H 점수와 신뢰 수준이 가장 높은 행동(각 행동 등급에서 4가지 다른 행동 예시)을 가진 행동입니다. 모든 작업은 6초의 동일한 시간 내에 수행됩니다.

이것은 진행중인 연구이며 몇 가지 다른 구성 요소가 있습니다. 그러나, 상술한 섹션들에 대한 가설들은 다음과 같다: (i) 행위자의 유형은 종속변수들에 영향을 미칠 것이다; Actor2는 Actor1에 비해 더 긴 RT, 더 높은 MD 및 더 큰 AUC를 생성합니다. (ii) 작용 유형이 종속 측정에 영향을 미칩니다. Action Class1은 Action Class2에 비해 더 긴 RT, 더 높은 MD 및 더 큰 AUC를 생성합니다. (iii) 동일한 행위자 및 행동 클래스에 대한 높음 및 낮음 응답에 대한 종속 측정은 블록 차원(선택 의지 및 경험)에 따라 다릅니다.

프로토콜

이 연구의 실험 프로토콜은 Bilkent University의 인간 참가자 연구 윤리 위원회의 승인을 받았습니다. 연구에 포함된 모든 참가자는 18세 이상이었고 연구를 시작하기 전에 정보에 입각한 동의서를 읽고 서명했습니다.

1. 일반 설계 단계

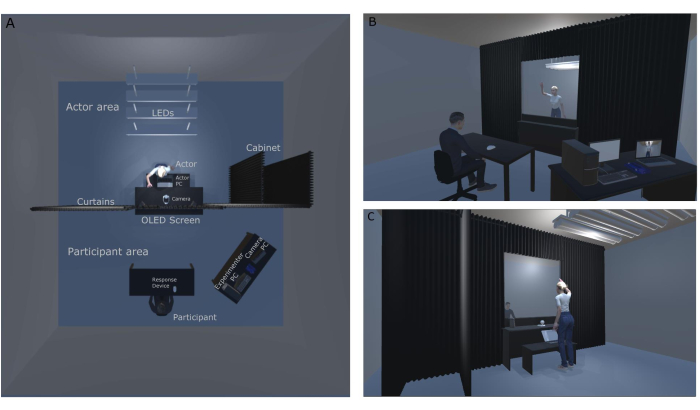

알림: 그림 1A(상단 view) 및 그림 1B 및 그림 1C(전면 및 후면 view)는 실험실 레이아웃을 보여줍니다. 이 수치는 이 특정 연구를 위해 설계된 원래 실험실 설정 및 구성과 관련하여 작성되었습니다. 그림 1A는 랩의 평면도 레이아웃을 보여줍니다. 이 그림에서는 천장과 액터 캐비닛의 LED 조명을 볼 수 있습니다. 암막 커튼 시스템은 방을 반으로 나누고 빛이 방 앞부분(참가자 영역)으로 새는 것을 방지하여 조명 조작을 돕습니다. 그림 1B는 실험자의 관점에서 실험실의 모습을 나타냅니다. 참가자는 OLED 화면 바로 앞에 앉아 투명 디스플레이를 사용하여 배우가 수행하는 라이브 액션을 볼 수 있습니다. 그들은 앞에 있는 응답 장치(무선 마우스)를 사용하여 응답합니다. 실험자는 참가자 디스플레이(OLED 화면)와 보안 카메라에서 나오는 영상을 통해 배우를 동시에 볼 수 있습니다. 그림 1C는 참가자가 볼 수 없는 보안 카메라와 배우 개인용 컴퓨터(PC)가 있는 연구의 백스테이지(행위자 영역)를 보여줍니다. 보안 카메라 영상은 배우와 실험자 간의 통신을 설정하기 위해 카메라 PC로 이동합니다. 행위자 PC는 블록 순서와 다음 행동 정보를 행위자에게 표시하여 실험이 중단 없이 진행되도록 합니다. 행위자는 참가자가 이전 시도의 행동에 응답하는 동안 다음 행동을 빠르게 확인할 수 있습니다.

그림 1: 자연주의적 실험실 설정. (A) 자연주의적 실험실 설정의 하향식 보기. (B) 참가자의 관점에서 본 자연주의적 실험 설정의 뒷면과 앞면. (C) 배우의 관점에서 본 자연주의적 실험 설정의 뒷면과 앞면. 이 그림의 더 큰 버전을 보려면 여기를 클릭하십시오.

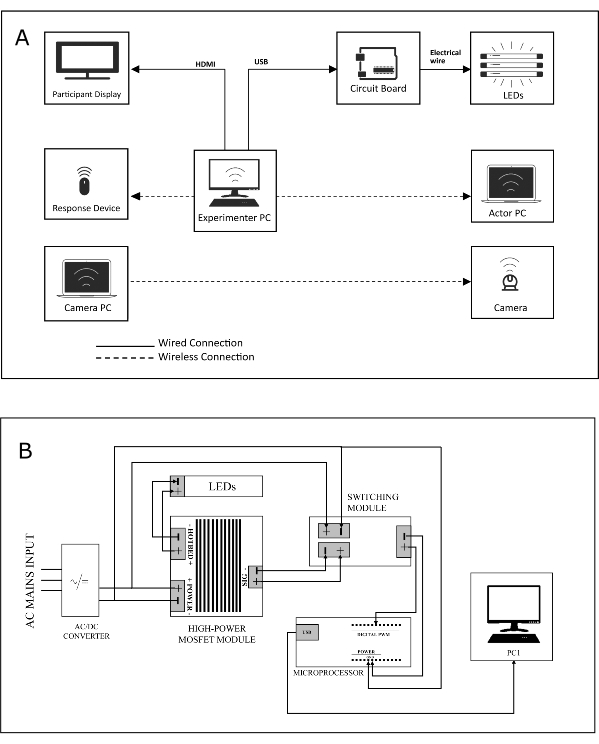

- (1) 주 제어 데스크톱(실험자 PC), (2) 행위자 노트북(행위자 PC), (3) 카메라 PC, 무선 응답 장치 1개(참가자 마우스), 디스플레이 2개, 조명 회로 및 보안 카메라를 포함한 3대의 컴퓨터를 포함하는 설정을 설계합니다(이 연구 설정의 시스템 다이어그램은 그림 2A 참조).

참고 : 실험자 PC는 실험자가 실험 스크립트를 실행하는 데 사용하고, 액터 PC는 행위자가 실험 블록과 블록의 작업 순서를 추적하는 데 사용하며, 세 번째 장치 인 카메라 PC는 행위자 영역에있는 보안 카메라에 연결되어 실험자가 무대 뒤를 모니터링하는 데 사용됩니다. - 별도의 디스플레이(자극 프레젠테이션용 디스플레이[참가자 디스플레이], OLED 화면)와 실험 모니터링용 화면, 응답 장치 및 조명 회로(유선 또는 무선 연결을 통해 )를 실험자 PC에 연결합니다( 그림 2A 참조).

- 실험자 PC와 액터 PC를 무선 네트워크로 연결하여 실험 상태와 관련된 정보(예: "다음 액션 ID는 '인사말''")를 액터에게 전달합니다.

- 마이크로 컨트롤러로 제어하여 LED를 켜고 끌 수 있는 조명 회로(회로 기판의 경우 그림 2B 참조)를 설계하고 구축합니다.

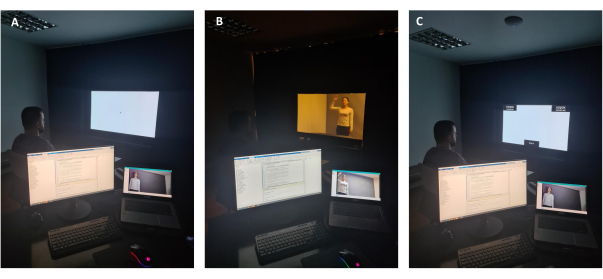

참고: 그림 3A 는 실험자의 관점에서 연구에 사용된 OLED 화면의 불투명한 사용을 보여줍니다. 불투명도를 보장하기 위해 화면의 배경이 흰색(RGB: 255, 255, 255)으로 조정되고 회의실의 모든 조명(참가자 영역 및 액터 영역 모두)이 꺼집니다. 참가자는 자극 전에 고정을 봅니다. 도 3B 는 실험자의 관점에서 본 연구에서 디지털 스크린의 투명한 사용을 보여준다. 투명도를 활성화하기 위해 화면의 배경이 검은색(RGB: 0, 0, 0)으로 조정되고 천장의 LED 조명이 켜집니다. 참가자는 배우를 봅니다. 도 3C 는 연구에서 디지털 스크린의 불투명한 사용을 보여준다. 불투명도를 보장하기 위해 화면의 배경이 흰색(RGB: 255, 255, 255)으로 조정되고 방의 모든 조명이 꺼집니다. 참가자에게 응답을 제공할 수 있는 평가 화면이 표시됩니다. 무선 마우스를 사용하여 커서를 화면의 왼쪽 위 또는 오른쪽 위(높음 또는 낮음의 두 가지 응답 선택 중 하나)로 드래그해야 합니다. 마우스 궤적과 응답 시간이 기록됩니다. - 마이크로 컨트롤러를 실험자 PC에 연결합니다.

- 실험자 PC에 실험을 실행하는 스크립트를 저장합니다.

참고: 그림 4A 는 실험 중 백스테이지(액터 영역)를 보여줍니다. 룸의 전면 조명(참가자 영역)이 꺼지고, 액터 PC에 액터가 수행할 액션의 이름이 표시됩니다. 그림 4B 는 배우가 자신의 차례를 기다렸다가 의상을 변경할 수 있는 액터 캐비닛을 보여줍니다. 배우 캐비닛은 참가자의 시야에서 보이지 않으며 커튼 시스템을 사용하기 때문에 배우가 원하는 입구를 사용할 수 있습니다. 실험 중에는 그림에 표시된 형광등이 꺼집니다.

그림 2: 시스템 및 배선도 . (A) 자연주의적 실험 설정의 시스템 다이어그램. (B) 실험 중 OLED 스크린을 지지하는 광 회로의 배선도. 이 그림의 더 큰 버전을 보려면 여기를 클릭하십시오.

그림 3 : 실험자의 관점에서 본 OLED 화면. (a) 실험자의 관점에서 OLED 디지털 스크린의 불투명한 사용. (B) 실험자의 관점에서 OLED 디지털 스크린의 투명한 사용. (C) 반응 기간 동안 실험자의 관점에서 OLED 디지털 스크린의 불투명한 사용. 이 그림의 더 큰 버전을 보려면 여기를 클릭하십시오.

그림 4: 실험의 백스테이지. (A) 실험 시험 중 백스테이지. (B) 배우 캐비닛은 OLED 화면의 뒤쪽에 있으며, 배우들은 실험 중에 자신의 차례가 보일 때까지 기다릴 수 있습니다. 이 그림의 더 큰 버전을 보려면 여기를 클릭하십시오.

2. 조명 회로의 설계 및 구현

- 회로의 장치/구성 요소에 전원을 공급하기 전에 따라야 할 단계

- 무대 뒤에서 설치된 LED의 상태(행위자 영역)를 변경하려면 실험자 PC에 LED를 ON 또는 OFF로 전환할 수 있는 기능을 제공합니다.

- USB 케이블을 통해 실험자 PC에서 전송 될 디지털 명령을 전달하려면 디지털 입력을 받고 디지털 출력을 생성 할 수있는 마이크로 컨트롤러 장치를 선택하십시오 (이 연구에 사용 된 마이크로 컨트롤러에 대한 재료 표 참조).

- 실험자 PC의 특정 USB 포트를 선택하여 USB 케이블을 통해 마이크로 컨트롤러의 USB 입력에 연결합니다. 모든 연결이 성공적으로 설정되었는지 확인하기 전에 PC를 켜지 마십시오.

- 마이크로 컨트롤러에서 생성되는 출력 신호(약 3.3V)의 진폭을 증가시키는 스위칭 모듈을 포함합니다.

- 지정된 디지털 출력 핀(이 실험에서 지정된 핀은 D9)과 마이크로 컨트롤러의 접지 핀을 스위칭 모듈에 연결합니다.

- 부하(LED)를 실행하려면 스위칭 모듈에서 생성된 신호에 의해 구동되는 고전력 MOSFET(Metal-Oxide-Semiconductor Field-Effect Transistor) 모듈(또는 MOSFET 모듈)을 포함하고 MOSFET 모듈의 신호 핀을 스위칭 모듈의 해당 신호-접지 쌍에 연결합니다.

- MOSFET 모듈의 핫베드 핀을 부하에 연결합니다.

- 조정된 정전압을 모듈에(간접적으로 LED에) 공급하려면 교류(AC) 주전원 입력을 받아 회로에 일정한 DC 전압을 생성하는 LED 전원 공급 장치를 포함합니다.

- LED 전원 공급 장치의 출력을 MOSFET 모듈과 스위칭 모듈의 전원 입력에 연결합니다.

- 회로 구성 요소를 배선한 후 따라야 할 단계

- 실험자 PC의 선택한 USB 포트에 USB 케이블을 연결합니다.

- 마이크로 컨트롤러와 실험자 PC에서 실행되는 소프트웨어 환경 간에 직렬 통신 링크를 만듭니다( 실험자 PC에 마이크로 컨트롤러 연결 하위 섹션 참조).

- LED 전원 공급 장치를 AC 주전원 입력에 연결합니다.

3. 실험 프로그래밍

참고: 세 가지 주요 실험 스크립트(ExperimentScript1.m [보충 코딩 파일 1], ExperimentScript2.m [보충 코딩 파일 2] 및 ExperimentScript3.m [보충 코딩 파일 3])와 여러 함수(RecordMouse.m [보충 코딩 파일 4], InsideROI.m [보충 코딩 파일 5], RandomizeTrials.m [보충 코딩 파일 6], RandomizeBlocks.m [보충 코딩 파일 7], GenerateResponsePage.m [보충 코딩 파일 8], GenerateTextures.m [보충 코딩 파일 9], ActorMachine.m [보충 코딩 파일 10], MatchIDtoClass.m [보충 코딩 파일 11], RandomizeWordOrder.m [보충 코딩 파일 12])을 사용하여 실험을 수행하였다.

참고: 자세한 설명은 관련 스크립트를 참조하십시오.

- 시험 및 블록 주문의 무작위화

- 무작위화 파라미터(예: 참가자 ID)를 입력값으로 받고 의사 랜덤화된 시퀀스로 구성된 배열을 반환하는 시험 주문(RandomizeTrials.m)과 블록 주문(RandomizeBlocks.m)을 랜덤화하는 두 개의 함수를 정의하고 생성합니다.

- 무작위 시퀀스가 생성되는 방법에 대한 자세한 내용은 스크립트 RandomizeBlocks.m(2-24행) 및 RandomizeTrials.m(3-26행)을 참조하십시오.

- 응답 추적(RecordMouse, InsideRoi)

- 실험 중 참가자의 마우스 궤적과 경과 시간을 추적하고 기록하는 함수를 만듭니다(RecordMouse.m 참조).

- 클릭한 좌표가 허용 가능한 영역 내에 있는지 여부를 확인하는 도우미 함수를 만듭니다(스크립트 InsideRoi.m 참조).

- 지침 및 피드백을 위한 텍스처 생성(GenerateTextures.m, GenerateResponsePage.m)

- 실험과 관련된 지침과 시도와 관련된 피드백을 이미지로 준비합니다.

- 이러한 영상의 내용을 .mat 파일에 저장합니다(ExperimentImages.mat 파일 [보충 코딩 파일 13] 참조).

- 화면 창을 만든 후 .mat 파일을 작업 공간으로 불러옵니다(GenerateTextures.m 라인 25 참조).

- 각 이미지에 대해 별도의 텍스처와 식별자를 만듭니다(GenerateTextures.m 27-165행 참조).

- 각 실험 스크립트에 대해 관련 응답 페이지 텍스처를 그리는 함수를 정의합니다(GenerateResponsePage.m 참조).

- TCP/IP를 통해 Actor PC를 Experimenter PC에 연결

- Experimenter PC에서 실행되는 스크립트(ExperimentScript2.m 줄 174행 참조)에 TCP 서버 소켓을 만듭니다.

- 액터 PC에서 실행되는 스크립트(ActorMachine.m 라인 16 참조)에 해당 TCP 클라이언트 소켓을 생성합니다.

- Experimenter PC에서 실행되는 스크립트(ExperimentScript2.m의 207, 229, 278행 참조, ExperimentScript3.m의 136, 141, 153, 159, 297행 참조)에서 액터에게 예정된 블록/트라이얼에 대한 정보를 보냅니다.

- 실험자 PC로부터 수신된 정보를 액터 PC의 화면 창에 표시합니다 (ActorMachine.m 의 31-47행 참조).

- 마이크로 컨트롤러를 실험자 PC에 연결

- 마이크로 컨트롤러를 특정 USB 포트(예: PORT 9)에 연결하여 무대 뒤에서 설치된 LED의 상태(ON 또는 OFF)를 제어합니다.

- 마이크로 컨트롤러 장치와 실험자 PC 간에 직렬 통신을 설정합니다(ExperimentScript2.m 스크립트의 185행 참조).

- 실험자 PC에서 실행되는 스크립트(ExperimentScript2.m의 290행 또는 ExperimentScript3.m 스크립트의 311행 참조)에서 마이크로컨트롤러로 로직 하이 신호(1)를 보내 USB 케이블을 통해 동작이 표시될 때 LED를 켭니다.

- Experimenter PC에서 실행되는 스크립트(ExperimentScript2.m의 292행 또는 ExperimentScript3.m 스크립트의 314행 참조)에서 마이크로컨트롤러로 로직 로우 신호(0)를 보내 참가자가 응답을 제공할 것으로 예상될 때 LED를 끕니다.

4. 샘플 실험의 흐름

- 실험 전 단계

- 랩의 모든 장치(실험자 PC, 카메라 PC, 액터 PC 및 참가자 디스플레이)가 UPS에 의해 전원이 공급되는지 확인합니다.

- USB 케이블을 통해 번개 마이크로 컨트롤러를 실험자 PC에 연결하면 실험자 PC가 켜지면 자동으로 켜집니다.)

- 실험자 PC를 켜고 5GHz Wi-Fi에 연결되어 있는지 확인합니다.

- 사운드 장치( 재료 표의 스피커)를 실험자 PC의 사운드 출력 장치로 선택합니다.

- 참가자 디스플레이를 켜고 볼륨 설정을 80%로 설정합니다.

- 여러 모니터에 대한 실험자 PC의 화면 설정을 지정합니다. 실험 PC의 디스플레이를 참가자 디스플레이로 확장합니다. 실험자 PC의 디스플레이는 1이고 참가자 디스플레이는 2입니다.

- 액터 PC를 켜고 5GHz Wi-Fi에 연결되어 있는지 확인합니다.

- USB 케이블을 통해 보안 카메라를 Actor PC에 연결하면 Actor PC가 켜지면 자동으로 전원이 켜집니다.

- 카메라 PC를 켜고 바탕 화면에서 카메라 응용 프로그램을 엽니다. 각 배우, 그들의 움직임, 캐비닛 출입이 카메라에서 보이는지 확인하십시오.

- 모든 컴퓨터, 디스플레이 및 장치(Experimenter PC 및 Actor PC의 응답 장치[참가자의 무선 마우스], 스피커, 키보드 및 마우스 및 번개 마이크로컨트롤러)가 제대로 작동하는지 확인합니다.

- 참가자를 다른 방에 오신 것을 환영합니다. 연구에 대한 간략한 정보를 제공한 후 동의서를 제공하고 참가자가 서명하도록 합니다.

- 참가자에게 가방에서 숫자를 꺼내도록 요청하고 그 숫자가 연구 내내 참가자 ID가 될 것이라고 말합니다.

- 참가자가 익명의 참가자 ID로 온라인 인구 통계 양식을 작성하도록 합니다.

참고: 참가자가 실험 전에 배우를 않는 것이 중요합니다. 그래서 이 서류 작업은 메인 실험실이 아닌 다른 방에서 완성되어 배우들이 참가자들 사이에 휴식을 취할 수 있도록 합니다.

- 실험 단계

- 실험자 PC에서 실험 소프트웨어를 열고 ExperimentScript1.m 스크립트를 열고 실행합니다.

- 참가자 ID와 나이를 입력합니다. 그런 다음 스크립트는 실험의 첫 번째 부분을 시작합니다(첫 번째 가시적 자극은 참가자 디스플레이 중앙에 있는 십자 표시입니다).

- 액터 PC에서 실험 소프트웨어를 열고 ActorMachine.m 스크립트를 엽니다.

- 카메라 PC를 실험자 PC 근처에 놓고 foo를 확인하십시오.tage 보안 카메라에서 오는 것은 참가자에게 표시되지 않습니다.

- 참가자를 메인 실험실로 초대하고 참가자 디스플레이 앞에 앉게 합니다.

- 참가자에게 십자가가 중앙에 있고 똑바로 앞에 있도록 자신을 정리하라고 말합니다.

- 화이트보드에 적힌 설명과 기간을 참조하여 실험의 각 부분에 대한 지침을 간략하게 설명한다.

- 실험실의 모든 조명을 끕니다.

- 실험 파트 1:

- 참가자에게 실험의 첫 번째 부분에서 어휘/개념 교육을 완료할 것이라고 말합니다. 교육을 통과할 수 있도록 지침을 주의 깊게 따르도록 경고합니다.

- 참가자에게 준비가 되면 실험을 시작할 수 있다고 말합니다.

- 참가자가 첫 번째 파트를 준비했다고 말하면 ESC 버튼을 누릅니다.

참고: 이제부터 참가자는 참가자 디스플레이의 지침을 읽고 선택 항목 중 하나를 선택하여 실험을 진행합니다. 그들은 훈련에서 잘 진행할 수 있도록 정답과 오답에 대한 피드백을 받게 됩니다. 매칭은 참가자가 10블록 반복 내에서 최소 임계값(80%)에 도달할 때까지 계속됩니다. - 참가자가 훈련 부분을 완료하면 ESC 버튼을 누르고 실험자가 실험의 두 번째 부분을 시작하기 위해 마우스를 제어하고 있음을 참가자에게 알립니다.

- 실험 파트 2:

- ExperimentScript2.m 스크립트를 열고 Waiting for the Actor PC 프롬프트를 기다립니다.

- 프롬프트가 표시되면 벨을 눌러 액터 중 한 명이 액터 PC에서 스크립트를 실행하여 실험자 PC와의 연결을 활성화할 수 있도록 합니다.

- 실험 파트 2가 준비되었습니다라는 메시지가 표시될 때까지 기다립니다.

- 참가자에게 이제 화면이 투명해질 것이며 짧은 동작을 통해 볼 수 있다고 말합니다.

- 각 동작을 주의 깊게 관찰하도록 경고하고 행동이 무엇인지 큰 소리로 말해야 한다고 알려줍니다.

- 참가자에게 준비가 되면 실험을 시작할 수 있다고 말합니다.

- 참가자가 첫 번째 파트를 준비했다고 말하면 ESC 버튼을 누릅니다.

참고: 참가자는 지침을 진행하고 첫 번째 작업을 시청합니다. 액터1 은 LED 라이트가 켜졌을 때 액션을 수행하고, 라이트가 꺼졌을 때 액터 PC의 프롬프트에서 다음 액션을 확인합니다. 각 작업이 끝나면 실험자 PC 화면에 대화 상자가 나타납니다. - 대화 상자에 참가자가 동작에 대해 말한 내용을 입력하고, 동작의 올바른 식별 또는 잘못된 식별에 따라 두 번째 대화 상자에 각각 1 또는 0을 입력합니다.

참고: 이 단계는 첫 번째 액터에 대해 8번 반복되며, 액터가 장소를 변경할 때 배경 음악이 재생되기 시작합니다. - 카메라 PC의 보안 카메라 영상에서 무대 뒤를 시청합니다.

- ESC 버튼을 누르면 배우가 I am ready 제스처로 보안 카메라를 향해 손을 흔들 때 Actor2에 대한 식별이 시작됩니다.

- 4.4.7 단계와 4.4.8 단계를 참가자와 함께 반복하여 Actor2가 수행하는 동안 동일한 8개의 동작이 식별될 때까지 합니다.

- 참가자가 식별이 완료 되었다는 경고를 보고 화살표를 클릭하여 부품을 종료하면 ESC 버튼을 누르고 참가자에게 실험자가 실험의 세 번째 부분을 시작하기 위해 마우스를 제어하고 있음을 알립니다.

- 실험 파트 3:

- ExperimentScript3.m 스크립트를 엽니다.

- 참가자에게 두 배우의 행동을 지켜볼 것이라고 말한 다음 적합하다고 생각되는 옵션을 클릭할 것입니다.

참고: 참가자는 4개의 블록에서 배우의 행동을 평가합니다. 두 블록에서 Actor1은 액션을 수행하고, 다른 두 블록에서는 Actor2가 동일한 액션을 수행합니다. 블록 중 두 개에서 참가자는 높거나 낮은 기관 역량을 부여하여 행동을 평가하고 다른 두 블록에서는 높거나 낮은 경험 능력을 부여합니다. - 참가자가 세 번째 파트를 준비했다고 말하면 ESC 버튼을 누릅니다.

참고: 참가자는 지침을 진행하고 첫 번째 블록부터 시작합니다. 배우들은 빛 속에서 액션을 수행하고, 참가자들이 응답하는 동안 화면은 불투명해지고 조명은 꺼지므로 배우들은 다음에 어떤 액션이 나올지 알 수 있습니다. 각 블록이 끝나면, 액터는 액터 PC의 프롬프트에 따라 장소를 변경합니다. - 무대 뒤에서 모든 것이 잘 진행되는지, 블록 중에 올바른 배우가 올바른 행동을 수행하고 있는지 확인하십시오.

- ESC 버튼을 누르면 오른쪽 액터가 액터를 교체한 후 I am ready 제스처로 손을 흔들 때 다음 블록을 시작합니다.

- 4개의 블록이 완료될 때까지 참가자 및 행위자와 협력하여 4.5.4단계와 4.5.5단계를 반복합니다.

- 참가자가 실험이 끝났습니다, 감사합니다 메시지가 표시되면 ESC 버튼을 누릅니다.

- 참가자에게 감사를 표하고 브리핑하고 서명을 받은 후 참가자를 보냅니다.

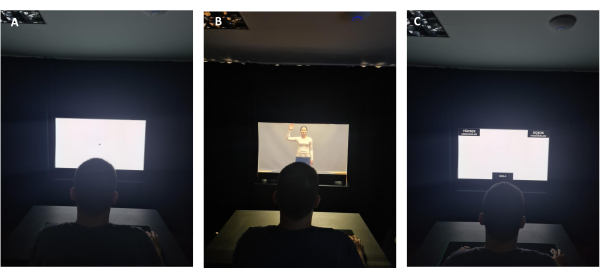

그림 5 는 참가자의 관점에서 샘플 시험을 보여줍니다. 그림 5A 는 참가자가 불투명 한 사용으로 화면 중앙에 커서를 보는 것을 보여줍니다. 도 5B 는 스크린을 통해 라이브 액션 자극을 시청하는 참가자를 보여준다. 도 5C 는 자극 후에 참가자에게 제시된 평가 스크린을 도시하며, 여기서 그들은 스크린의 각각의 상부 코너에 있는 두 개의 대안들 중 하나에 마우스를 드래그할 필요가 있다.

그림 5: 참가자의 관점에서 본 OLED 화면. (A) 고정 화면 중 참가자의 관점에서 OLED 디지털 화면을 불투명하게 사용합니다. (B) 라이브 액션을 발표하는 동안 참가자의 관점에서 OLED 디지털 화면을 투명하게 사용합니다. (C) 응답 기간 동안 참가자의 관점에서 OLED 디지털 화면을 불투명하게 사용합니다. 이 그림의 더 큰 버전을 보려면 여기를 클릭하십시오.

5. 데이터 전처리 및 분석

- 데이터를 조건으로 분할

- 모든 참가자 데이터 파일을 소프트웨어 환경의 작업공간으로 읽어 들입니다.

- 데이터를 그룹화하기 위한 조건을 정의합니다(두 개의 작업 클래스 [Action Class1 및 Action Class2] x 두 개의 행위자 [Actor1 및 Actor2] x 2차원 [Agency and Experience] x 두 가지 수준 [High 및 Low]).

- 데이터를 4개의 주요 그룹(Agency High, Agency Low, Experience High, Experience Low)으로 나눕니다.

- 이러한 주요 그룹을 4개의 하위 그룹(2개의 행위자 x 2개의 액션 클래스)으로 나눕니다.

- 각 데이터 파일을 반복하여 이전에 정의된 4개의 부분군 중 하나에 속하는 시행을 그룹화합니다.

- 관련 시행 정보(응답 시간, 커서 이동 및 커서 위치가 샘플링되는 시점)를 각 하위 그룹에 대한 별도의 데이터 구조로 저장합니다.

- 모든 시도가 그룹화되면 루프를 종료합니다.

- 궤적의 시각화

- 데이터를 분할한 후 다음 단계를 수행하여 마우스 궤적을 시각화합니다.

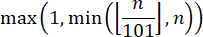

- 반응 궤적에 시간 보간을 적용하려면 각 시행에 대해 궤적 배열에서 101(x,y) 쌍을 선택하여 데이터의 각 부분군이 동일한 시간 스텝 수를 갖는 시행을 갖도록 합니다.

알림: 쌍 수를 101로 고정하는 동안 올바른 시간 정규화를 수행하려면 규칙32를 따라야 합니다. 따라서 다음 방정식을 사용하여 시간 정규화를 달성하며, 여기서 n 은 궤적 배열의 샘플 수입니다.

- 101개의 시점 각각에서 (x,y) 쌍의 합을 계산한 다음 얻은 결과를 해당 하위 그룹의 총 시행 횟수로 나누어 각 하위 그룹(예: 경험 낮은 행위자1 또는 경험 낮은 행위자2)에 대한 평균을 얻습니다.

- 행 값에 스케일링 연산을 적용하여 평균 궤적을 시각화합니다.

참고: 2D 좌표 평면은 두 축이 창의 왼쪽 아래 모서리에 있는 영점(좌표가 양의 정수라고 가정)에서 증가한다고 가정하는 반면, 픽셀 형식은 창의 왼쪽 위 모서리를 참조(예: 영점)로 사용합니다. 따라서 총 행 수의 값에서 각 시행의 샘플링된 y 좌표를 추출하여 샘플링된 위치의 y 좌표(픽셀 형식의 행 값에 해당)에 대한 크기 조정 연산을 적용합니다. - 비교를 위해 동일한 그림에 관련 부분군을 플로팅합니다.

참고: 각 궤적은 시작 레이블이 아래쪽 가운데에 있는 사각형의 중심에서 시작하여 왼쪽 위 또는 오른쪽 위 모서리에 있는 사각형 안쪽에서 끝납니다.

6. 시스템 장애의 원인이 될 수 있는 조건 및 주의사항

참고: 시스템 오류가 발생한 경우 액터에게 오류에 대해 알리고 참가자가 볼 수 없는 장소에 머물도록 경고하는 물리적 표시(벨 울림)를 갖는 것이 중요합니다.

- 네트워크 연결로 인한 오류

- 컴퓨터 중 하나가 다른 네트워크에 연결되어 있으면 TCP/IP 연결 요청이 실패하고 시스템에 오류가 표시됩니다. 이를 방지하려면 실험자 PC와 액터 PC가 동일한 무선 네트워크의 동일한 대역에 있는지 확인하십시오.

- 두 PC가 동일한 네트워크에 유지되도록 하려면 두 PC에서 이전에 연결된 무선 네트워크를 지웁니다.

- 네트워크의 IP 주소는 예고 없이 변경될 수 있으므로 선택한 네트워크의 장치에 대해 고정 IP 주소를 설정합니다.

- 네트워크에 대한 일시적인 연결 끊김(예: 정전, 인터넷 중단 등으로 인해)으로 인해 스크립트가 실패할 수 있습니다. 이러한 상황에서는 TCP/IP 연결을 다시 설정하려면 시스템을 처음부터 다시 시작해야 합니다.

참고: 장치에 대한 고정 IP 요구 사항은 인터넷 서비스 공급자가 충족할 수 있습니다. 특정 포트는 운영 체제 또는 지정된 장치의 하드웨어에 의해 비활성화될 수 있습니다. 따라서 실험에 사용할 포트를 열어야 하며 실험 스크립트가 시작될 때까지 활성 연결이 없어야 합니다.

- 소프트웨어 충돌로 인한 오류

- 연결 실패(예: 직렬 포트 연결, TCP/IP 연결, 디스플레이 연결 등)로 인해 소프트웨어 환경이 충돌할 수 있으며, 이로 인해 데이터가 손실될 수 있습니다. 이를 극복하려면 기본 실험 스크립트를 여러 스크립트로 나눕니다. 예를 들어 액터가 작업 수행을 시작하기 전에 완료해야 하는 블록이 있는 경우 이 블록 중에 실험자 PC에 서버를 만들 필요가 없습니다. 서버는 액션을 수반하고, 따라서 실험자 PC와 액터 PC 간의 통신이 필요한 블록이 시작되려고 할 때 생성될 수 있다.

결과

응답 시간(RT) 비교

현재 연구는 진행중인 프로젝트이므로 대표적인 결과로 실험의 주요 부분 (실험 파트 3)의 데이터를 제시합니다. 이 데이터는 18-28세 범위의 여성 23명과 남성 17명을 포함한 40명의 참가자로부터 얻은 것입니다(미디엄 = 22.75, SD = 3.12).

분석에 적합한 통계적 방법을 선택하기 위해서는 종속 변수 분포의 정규성 정도를 조사하는 것?...

토론

본 연구의 가장 중요한 목표는 인간의 높은 수준의 시각적 인식과 인지가 실제 상황에서 어떻게 작동하는지에 대한 우리의 이해에 기여하는 것입니다. 이 연구는 행동 인식에 초점을 맞추고 연구자가 실험실 환경에서 실제 행위자를 제시함으로써 개인이 다른 사람의 행동을 어떻게 인식하고 평가할 수 있는지 테스트할 수 있도록 하는 자연주의적이면서도 제어 가능한 실험 패러다임을 제안했습?...

공개

저자는 이 기사에 설명된 연구와 관련하여 관련성이 있거나 중요한 재정적 이해관계가 없음을 선언합니다.

감사의 말

이 작업은 Türkiye 과학 기술 연구 위원회(프로젝트 번호: 120K913)와 Bilkent University의 Burcu A. Urgen에 대한 보조금으로 지원되었습니다. 파일럿 참가자인 배우 변경 사이에 배경 소음을 추가하는 아이디어를 제시해 준 Sena Er Elmas, 조명 회로를 설정한 Süleyman Akı, 무대 뒤에서 보안 카메라를 사용하는 아이디어와 연구에 참여한 배우 중 한 명으로 기여한 Tuvana Karaduman에게 감사드립니다.

자료

| Name | Company | Catalog Number | Comments |

| Adjustable Height Table | Custom-made | N/A | Width: 60 cm, Height: 62 cm, Depth: 40 cm |

| Ardunio UNO | Smart Projects | A000066 | Microcontroller used for switching the state of the LEDs from the script running on the operator PC |

| Black Pants | No brand | N/A | Relaxed-fit pants of actors with no apparent brand name or logo. |

| Case | Xigmatek | EN43224 | XIGMATEK HELIOS RAINBOW LED USB 3.0 MidT ATX GAMING CASE |

| CPU | AMD | YD1600BBAFBOX | AMD Ryzen 5 1600 Soket AM4 3.2 GHz - 3.6 GHz 16 MB 65 W 12 nm Processor |

| Curtains | Custom-made | N/A | Width: Part 1: 110 cm width from the wall (left) side, Part 2: 123 cm width above OLED display, Part 3: 170 cm from OLED display to right side, Cabin depth: 100 cm, Inside cabin depth: 100 cm, all heights 230 cm except for Part 2 (75 cm height) |

| Experimenter Adjustable/Swivel Chair | No brand | N/A | Any brand |

| Experimenter Table | Custom | N/A | Width: 160 cm, Height: 75 cm, Depth: 80 cm |

| GPU | MSI | GT 1030 2GHD4 LP OC | MSI GEFORCE GT 1030 2GHD4 LP OC 2GB DDR4 64bit NVIDIA GPU |

| Grey-color blackout curtain | Custom-made | N/A | Width: 330 cm, Height: 230 cm, used for covering the background |

| Hard Disk | Kioxia | LTC10Z240GG8 | Kioxia 240 GB Exceria Sata 3.0 SSD (555 MB Read/540 MB Write) |

| Hard Disk | Toshiba | HDWK105UZSVA | Toshiba 2,5'' 500 GB L200 SATA 3.0 8 MB Cache 5400 Rpm 7 mm Harddisk |

| High-Power MOSFET Module | N/A | N/A | Heating Controller MKS MOSFET Module |

| Laptop | Apple | S/N: C02P916ZG3QT | MacBook Pro 11.1 Intel Core i7 (Used as the actor PC) |

| Laptop | Asus | UX410U | Used for monitoring the security camera in real-time. |

| LED lights | No brand | N/A | |

| LED Strip Power Supply | No brand | N/A | AC to DC voltage converter used for supplying DC voltage to the lighting circuit |

| MATLAB | The MathWorks Inc., Natick, MA, USA | Version: R2022a | Used for programming the experiment. Required Toolboxes: MATLAB Support Package for Arduino Hardware (version 22.1.2) Instrument Control Toolbox (version 4.6) Psychtoolbox (version 3) |

| Monitor | Philips | UHB2051005145 | Model ID: 242V8A/00, PHILIPS 23.8" 242V8A 4ms 75 Hz Freesync DP-HDMI+VGA IPS Gaming Monitor |

| Motherboard | MSI | B450M-A PRO MAX | MSI B450M-A PRO MAX Amd B450 Socket AM4 DDR4 3466(OC) M.2 Motherboard |

| Mouse Pad for participant | Monster | 78185721101502042 / 8699266781857 | Pusat Gaming Mouse Pad XL |

| Night lamp | Aukes | ES620-0.5W 6500K-IP 20 | Used for helping the actors see around when the lights are off in the backstage. |

| Participant Adjustable/Swivel Chair | No brand | N/A | |

| Participant Table | IKEA | Sandsberg 294.203.93 | Width: 110 cm, Height: 75 cm, Depth: 67 cm |

| Power Extension Cable | Viko | 9011760Y | 250 V (6 inlets) Black |

| Power Extension Cable | Viko | 9011730Y | 250 V (3 inlets) Black |

| Power Extension Cable | Viko | 9011330Y | 250 V (3 inlets) White |

| Power Extension Cable | s-link | Model No: SPG3-J-10 | AC - 250 V 3 meter (5 inlets) |

| Power Supply | THERMALTAKE | PS-LTP-0550NHSANE-1 | THERMALTAKE LITEPOWER RGB 550W APFC 12 cm FAN PSU |

| Professional Gaming Mouse | Rampage | 8680096 | Model No: SMX-R50 |

| RAM | GSKILL | F4-3000C16S-8GVRB | GSKILL 8GB (1x8GB) RipjawsV Red DDR4 3000 MHz CL16 1.35 V Single Ram |

| Reception bell | No brand | N/A | Used for helping the communication between the experimenter and the actors. |

| Security Camera | Brion Vega | 2-20204210 | Model:BV6000 |

| Speakers | Logitech | P/N: 880-000-405 PID: WD528XM | Used for playing the background music. |

| Survey Software | Qualtrics | N/A | |

| Switching Module | No brand | N/A | F5305S PMOS Switch Module |

| Table under the OLED display | Custom-made | N/A | Width: 123 cm, Height: 75 cm, Depth: 50 cm |

| Transparent OLED Display | Planar | PN: 998-1483-01 S/N:195210075 | A 55-inch transparent display that showcases dynamic information, enabled the opaque and transparent usage during the experiment. |

| UPS | EAG | K200610100087 | EAG 110 |

| UPS | EAG | 210312030507 | EAG 103 |

| USB 2.0 Cable Type A/B for Arduino UNO (Blue) | Smart Projects | M000006 | Used to connect the microcontroller to the experimenter PC. |

| USB to RS232 Converter | s-link | 8680096082559 | Model: SW-U610 |

| White Long-Sleeved Blouse (2) | H&M (cotton) | N/A | Relaxed-fit blouses with a round neckline and without ant apparent brand name or logo. |

| Wireless Keyboard | Logitech | P/N: 820-003488 S/N: 1719CE0856D8 | Model: K360 |

| Wireless Mouse | Logitech | S/N: 2147LZ96BGQ9 | Model: M190 (Used as the response device) |

참고문헌

- Grossman, E. D., Blake, R. Brain areas active during visual perception of biological motion. Neuron. 35 (6), 1167-1175 (2002).

- Saygin, A. P. Superior temporal and premotor brain areas necessary for biological motion perception. Brain. 130 (9), 2452-2461 (2007).

- Peelen, M. V., Downing, P. E. The neural basis of visual body perception. Nature Reviews Neuroscience. 8 (8), 636-648 (2007).

- Caspers, S., Zilles, K., Laird, A. R., Eickhoff, S. B. ALE meta-analysis of action observation and imitation in the human brain. Neuroimage. 50 (3), 1148-1167 (2010).

- Nelissen, K., et al. Action observation circuits in the macaque monkey cortex. Journal of Neuroscience. 31 (10), 3743-3756 (2011).

- Oosterhof, N. N., Tipper, S. P., Downing, P. E. Crossmodal and action-specific: Neuroimaging the human mirror neuron system. Trends in Cognitive Sciences. 17 (7), 311-318 (2013).

- Lingnau, A., Downing, P. E. The lateral occipitotemporal cortex in action. Trends in Cognitive Sciences. 19 (5), 268-277 (2015).

- Giese, M. A., Rizzolatti, G. Neural and computational mechanisms of action processing: Interaction between visual and motor representations. Neuron. 88 (1), 167-180 (2015).

- Tucciarelli, R., Wurm, M., Baccolo, E., Lingnau, A. The representational space of observed actions. eLife. 8, e47686 (2019).

- Tarhan, L., Konkle, T. Sociality and interaction envelope organize visual action representations. Nature Communications. 11 (1), 3002 (2020).

- Urgen, B. A., Saygin, A. P. Predictive processing account of action perception: Evidence from effective connectivity in the action observation network. Cortex. 128, 132-142 (2020).

- Newen, A., De Bruin, L., Gallagher, S. . The Oxford Handbook of 4E Cognition. , (2018).

- Snow, J. C., Culham, J. C. The treachery of images: How realism influences brain and behavior. Trends in Cognitive Sciences. 25 (6), 506-519 (2021).

- Matusz, P. J., Dikker, S., Huth, A. G., Perrodin, C. Are we ready for real-world neuroscience. Journal of Cognitive Neuroscience. 31 (3), 327-338 (2019).

- Zaki, J., Ochsner, K. The need for a cognitive neuroscience of naturalistic social cognition. Annals of the New York Academy of Sciences. 1167 (1), 16-30 (2009).

- Hasson, U., Honey, C. J. Future trends in Neuroimaging: Neural processes as expressed within real-life contexts. NeuroImage. 62 (2), 1272-1278 (2012).

- Risko, E. F., Laidlaw, K. E., Freeth, M., Foulsham, T., Kingstone, A. Social attention with real versus reel stimuli: toward an empirical approach to concerns about ecological validity. Frontiers in Human Neuroscience. 6, 143 (2012).

- Parsons, T. D. Virtual reality for enhanced ecological validity and experimental control in the clinical, affective and social neurosciences. Frontiers in Human Neuroscience. 9, 660 (2015).

- Deuse, L., et al. Neural correlates of naturalistic social cognition: brain-behavior relationships in healthy adults. Social Cognitive and Affective Neuroscience. 11 (11), 1741-1751 (2016).

- Camerer, C., Mobbs, D. Differences in behavior and brain activity during hypothetical and real choices. Trends in Cognitive Sciences. 21 (1), 46-56 (2017).

- Nastase, S. A., Goldstein, A., Hasson, U. Keep it real: Rethinking the primacy of experimental control in cognitive neuroscience. NeuroImage. 222, 117254 (2020).

- Kihlstrom, J. F. Ecological validity and "ecological validity". Perspectives on Psychological Science. 16 (2), 466-471 (2021).

- Brunswik, E. . Perception and the Representative Design of Psychological Experiments. , (1956).

- Aronson, E., Carlsmith, J. M., Gilbert, D. T., Fiske, S. T., Lindzay, G. Experimentation in social psychology. The Handbook of Social Psychology. , 1-79 (1968).

- Ecological validity: Then and now. University of Colorado Available from: https://www.albany.edu/cpr/brunswik/notes/essay1.html (1998)

- Fan, S., Dal Monte, O., Chang, S. W. Levels of naturalism in social neuroscience research. IScience. 24 (7), 102702 (2021).

- Orban, G. A., Lanzilotto, M., Bonini, L. From observed action identity to social affordances. Trends in Cognitive Sciences. 25 (6), 493-505 (2021).

- Gray, H. M., Gray, K., Wegner, D. M. Dimensions of mind perception. Science. 315 (5812), 619 (2007).

- Li, Z., Terfurth, L., Woller, J. P., Wiese, E. Mind the machines: Applying implicit measures of mind perception to social robotics. 2022 17th ACM/IEEE International Conference on Human-Robot Interaction (HRI. , 236-245 (2022).

- Karpinski, A., Steinman, R. B. The single category implicit association test as a measure of implicit social cognition. Journal of Personality and Social Psychology. 91 (1), 16 (2006).

- Greenwald, A. G., McGhee, D. E., Schwartz, J. L. Measuring individual differences in implicit cognition: the implicit association test. Journal of Personality and Social Psychology. 74 (6), 1464 (1998).

- Freeman, J. B., Ambady, N. MouseTracker: Software for studying real-time mental processing using a computer mouse-tracking method. Behavior Research Methods. 42 (1), 226-241 (2010).

- Pekçetin, T. N., Barinal, B., Tunç, J., Acarturk, C., Urgen, B. A. Studying mind perception in social robotics implicitly: The need for validation and norming. Proceedings of the 2023 ACM/IEEE International Conference on Human-Robot Interaction. , 202-210 (2023).

- Yu, Z., Wang, F., Wang, D., Bastin, M. Beyond reaction times: Incorporating mouse-tracking measures into the implicit association test to examine its underlying process. Social Cognition. 30 (3), 289-306 (2012).

- Romero, C. A., Snow, J. C. Methods for presenting real-world objects under controlled laboratory conditions. Journal of Visualized Experiments. (148), e59762 (2019).

- Jastorff, J., Abdollahi, R. O., Fasano, F., Orban, G. A. Seeing biological actions in 3 D: An f MRI study. Human Brain Mapping. 37 (1), 203-219 (2016).

- Ferri, S., Pauwels, K., Rizzolatti, G., Orban, G. A. Stereoscopically observing manipulative actions. Cerebral Cortex. 26 (8), 3591-3610 (2016).

- Stangl, M., Maoz, S. L., Suthana, N. Mobile cognition: Imaging the human brain in the 'real world. Nature Reviews Neuroscience. 24 (6), 347-362 (2023).

- Kriegeskorte, N. Deep neural networks: a new framework for modeling biological vision and brain information processing. Annual Review of Vision Science. 1, 417-446 (2015).

- Marblestone, A. H., Wayne, G., Kording, K. P. Toward an integration of deep learning and neuroscience. Frontiers in Computational Neuroscience. 10, 94 (2016).

재인쇄 및 허가

JoVE'article의 텍스트 или 그림을 다시 사용하시려면 허가 살펴보기

허가 살펴보기더 많은 기사 탐색

This article has been published

Video Coming Soon

Copyright © 2025 MyJoVE Corporation. 판권 소유