Method Article

Abschätzung von Kontaktbereichen zwischen Händen und Objekten beim mehrstelligen Greifen des Menschen

In diesem Artikel

Zusammenfassung

Wenn wir ein Objekt greifen, kommen in der Regel mehrere Regionen der Finger und der Hand mit der Oberfläche des Objekts in Kontakt. Die Rekonstruktion solcher Kontaktregionen ist eine Herausforderung. In dieser Arbeit stellen wir eine Methode zur approximativen Schätzung der Kontaktregionen vor, indem markerbasiertes Motion Capture mit bestehender Deep-Learning-basierter Handnetzrekonstruktion kombiniert wird.

Zusammenfassung

Um ein Objekt erfolgreich zu greifen, müssen wir geeignete Kontaktbereiche für unsere Hände auf der Oberfläche des Objekts auswählen. Die Identifizierung solcher Regionen ist jedoch eine Herausforderung. In diesem Dokument wird ein Workflow zur Schätzung der Kontaktregionen aus markerbasierten Tracking-Daten beschrieben. Die Teilnehmer greifen reale Objekte, während wir die 3D-Position sowohl der Objekte als auch der Hand, einschließlich der Fingergelenke, verfolgen. Wir bestimmen zunächst die Euler-Gelenkwinkel anhand einer Auswahl von Track-Markern, die auf dem Handrücken positioniert sind. Anschließend verwenden wir modernste Algorithmen zur Rekonstruktion von Handnetzen, um ein Netzmodell der Hand des Teilnehmers in der aktuellen Pose und der 3D-Position zu erstellen.

Durch die Verwendung von Objekten, die entweder 3D-gedruckt oder 3D-gescannt wurden und somit sowohl als reale Objekte als auch als Netzdaten verfügbar sind, können die Hand- und Objektnetze gemeinsam registriert werden. Dies wiederum ermöglicht die Schätzung ungefährer Kontaktbereiche durch Berechnung der Schnittpunkte zwischen dem Handnetz und dem co-registrierten 3D-Objektnetz. Mit der Methode kann abgeschätzt werden, wo und wie Menschen Objekte unter verschiedenen Bedingungen greifen. Daher könnte die Methode für Forscher von Interesse sein, die sich mit visueller und haptischer Wahrnehmung, motorischer Steuerung, Mensch-Computer-Interaktion in virtueller und erweiterter Realität und Robotik befassen.

Einleitung

Die Fähigkeit, Objekte zu greifen und zu manipulieren, ist eine Schlüsselfähigkeit, die es dem Menschen ermöglicht, die Umwelt nach seinen Wünschen und Bedürfnissen umzugestalten. Die effektive Steuerung von mehrgelenkigen Händen ist jedoch eine anspruchsvolle Aufgabe, die ein ausgeklügeltes Steuerungssystem erfordert. Dieses motorische Steuerungssystem wird durch verschiedene Formen des sensorischen Inputs gesteuert, unter denen das Sehen an erster Stelle steht. Durch das Sehen können Individuen die Objekte in der Umgebung identifizieren und ihre Position und physikalischen Eigenschaften einschätzen und diese Objekte dann mit Leichtigkeit erreichen, greifen und manipulieren. Das Verständnis des komplexen Systems, das den Input an der Netzhaut mit den motorischen Befehlen verbindet, die die Hände steuern, ist eine zentrale Herausforderung der sensomotorischen Neurowissenschaften. Um die Funktionsweise dieses Systems zu modellieren, vorherzusagen und zu verstehen, müssen wir es zunächst im Detail untersuchen können. Dies erfordert hochgenaue Messungen sowohl der visuellen Eingänge als auch der Handmotorausgänge.

Die bisherige Motion-Tracking-Technologie hat der Erforschung des menschlichen Greifens eine Reihe von Einschränkungen auferlegt. Zum Beispiel neigen Systeme, die Kabel erfordern, die an den Händen der Teilnehmer befestigt sind1,2, dazu, den Bewegungsumfang der Finger einzuschränken, was möglicherweise die Greifbewegungen oder die Messungen selbst verändert. Trotz dieser Einschränkungen konnten in der bisherigen Forschung mehrere Faktoren identifiziert werden, die das visuell geführte Greifen beeinflussen. Einige dieser Faktoren sind die Objektform 3,4,5,6, die Oberflächenrauheit 7,8,9 oder die Ausrichtung eines Objekts relativ zur Hand 4,8,10. Um jedoch frühere technologische Einschränkungen zu überwinden, wurden in der Mehrzahl dieser früheren Forschungen einfache Stimuli und stark eingeschränkte Aufgaben verwendet, so dass der Schwerpunkt hauptsächlich auf einzelnen Faktoren 3,4,6,7,10 lag, zweistellige Präzisionsgriffe3,4,6,9,11,12, 13,14,15,16,17,18, einzelne Objekte19 oder sehr einfache 2D-Formen 20,21. Wie sich bisherige Befunde über solche reduzierten und künstlichen Laborbedingungen hinaus verallgemeinern lassen, ist nicht bekannt. Darüber hinaus wird die Messung des Hand-Objekt-Kontakts häufig auf die Schätzung von Fingerkontaktpunkten22 reduziert. Diese Vereinfachung kann angemessen sein, um eine kleine Teilmenge von Griffen zu beschreiben, bei denen nur die Fingerspitzen mit einem Objekt in Kontakt sind. Bei den meisten Griffen in der realen Welt kommen jedoch große Bereiche der Finger und der Handfläche mit einem Objekt in Kontakt. Darüber hinaus hat eine kürzlich durchgeführte Studie23 gezeigt, dass Objekte unter Verwendung eines haptischen Handschuhs daran erkannt werden können, wie ihre Oberfläche auf die Hand auftrifft. Dies unterstreicht, wie wichtig es ist, die ausgedehnten Kontaktbereiche zwischen den Händen und den gegriffenen Gegenständen zu untersuchen, nicht nur die Kontaktpunkte zwischen den Gegenständen und den Fingerspitzen22.

Die jüngsten Fortschritte in der Bewegungserfassung und der 3D-Handmodellierung haben es uns ermöglicht, frühere Einschränkungen zu überwinden und das Greifen in seiner ganzen Komplexität zu untersuchen. Passives markerbasiertes Motion Tracking ist jetzt mit millimetergroßen Markern verfügbar, die am Handrücken des Teilnehmers angebracht werden können, um Gelenkbewegungen zu verfolgen24. Darüber hinaus sind automatische Marker-Identifikationsalgorithmen für passive Markersysteme nun robust genug, um die aufwändige manuelle Nachbearbeitung von Markerdaten nahezu überflüssig zu machen25,26,27. Markerlose Lösungen erreichen auch beeindruckende Leistungen bei der Verfolgung von Tierkörperteilen in Videos28. Diese Motion-Tracking-Verfahren erlauben somit endlich zuverlässige und nicht-invasive Messungen komplexer mehrstelliger Handbewegungen24. Solche Messungen können Aufschluss über die Gelenkkinematik geben und die Kontaktpunkte zwischen der Hand und einem Objekt abschätzen. Darüber hinaus hat sich die Computer-Vision-Community in den letzten Jahren mit dem Problem befasst, Modelle der menschlichen Hände zu konstruieren, die die Weichteilverformungen beim Greifen von Objekten und sogar beim Selbstkontakt zwischen Handteilenreplizieren können 29,30,31,32. Solche 3D-Netzrekonstruktionen können aus verschiedenen Arten von Daten abgeleitet werden, wie z.B. Videomaterial 33,34, Skelettgelenke (abgeleitet aus markerbasiertem 35 oder markerlosem Tracking 36) und Tiefenbildern 37. Der erste wichtige Fortschritt auf diesem Gebiet wurde von Romero et al.38 geliefert, die ein parametrisches Handmodell (MANO) aus über 1.000 Handscans von 31 Probanden in verschiedenen Posen ableiteten. Das Modell enthält Parameter sowohl für die Pose als auch für die Form der Hand, was die Regression von verschiedenen Datenquellen zu einer vollständigen Handrekonstruktion erleichtert. Die neuere Lösung DeepHandMesh29 baut auf diesem Ansatz auf, indem sie ein parametrisiertes Modell durch Deep Learning erstellt und eine Penetrationsvermeidung hinzufügt, die physische Interaktionen zwischen Handteilen genauer nachbildet. Durch die Kombination solcher Handnetzrekonstruktionen mit 3D-verfolgten Objektnetzen ist es nun möglich, Kontaktbereiche nicht nur auf der Oberfläche von Objekten32, sondern auch auf der Oberfläche der Hand abzuschätzen.

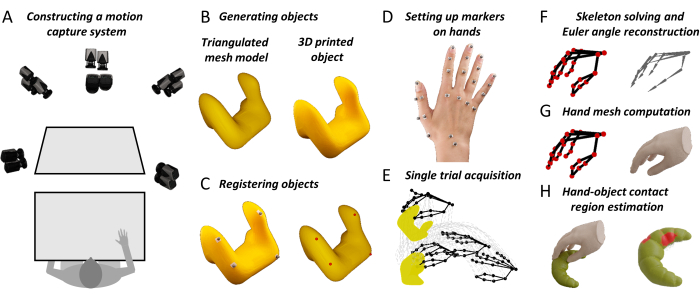

Hier schlagen wir einen Workflow vor, der das High-Fidelity-3D-Tracking von Objekten und Handgelenken mit neuartigen Algorithmen zur Rekonstruktion von Handnetzen kombiniert. Die Methode liefert detaillierte Karten von Hand-Objekt-Kontaktflächen. Diese Messungen werden sensomotorischen Neurowissenschaftlern helfen, unser theoretisches Verständnis des visuell gesteuerten Greifens des Menschen zu erweitern. Darüber hinaus könnte die Methode für Forscher in angrenzenden Bereichen nützlich sein. Beispielsweise können Mensch-Faktor-Forscher diese Methode nutzen, um bessere Mensch-Maschine-Schnittstellensysteme in virtueller und erweiterter Realität zu konstruieren18. High-Fidelity-Messungen des menschlichen Greifverhaltens können Robotikern auch dabei helfen, von Menschen inspirierte Robotergreifsysteme zu entwerfen, die auf den Prinzipien der interaktiven Wahrnehmung basieren 39,40,41,42,43. Wir hoffen daher, dass diese Methode dazu beitragen wird, die Greifforschung in neurowissenschaftlichen und technischen Bereichen voranzubringen, von spärlichen Beschreibungen stark eingeschränkter Aufgaben bis hin zu umfassenderen Charakterisierungen naturalistischer Greifverhaltensweisen mit komplexen Objekten und realen Aufgaben. Der Gesamtansatz ist in Abbildung 1 dargestellt.

Abbildung 1: Die wichtigsten Schritte des vorgeschlagenen Verfahrens . (A) Motion-Capture-Kameras bilden eine Werkbank aus mehreren Blickwinkeln ab. (B) Ein Stimulusobjekt wird aus einem triangulierten Netzmodell 3D-gedruckt. (C) Vier kugelförmige reflektierende Marker werden auf die Oberfläche des realen Objekts geklebt. Ein halbautomatisches Verfahren identifiziert vier korrespondierende Punkte auf der Oberfläche des Netzobjekts. Diese Entsprechung ermöglicht es uns, das Netzmodell in die 3D-verfolgte Position des realen Objekts zu übersetzen. (D) Reflektierende Marker werden mit doppelseitigem Klebeband an verschiedenen Orientierungspunkten auf dem Handrücken eines Teilnehmers befestigt. (E) Das Motion-Capture-System erfasst die Trajektorien des verfolgten Objekts und der Handmarkierungen im 3D-Raum während eines einzigen Versuchs. (F) Ein teilnehmerspezifisches Handskelett wird mit Hilfe von 3D-Computergrafiksoftware konstruiert. Die Skelettgelenkposen werden dann für jedes Bild jedes Versuchs in einem Experiment durch inverse Kinematik geschätzt. (G) Gelenkposen werden in eine modifizierte Version von DeepHandMesh29 eingegeben, die ein geschätztes 3D-Handnetz in der aktuellen 3D-Pose und -Position ausgibt. (H) Schließlich verwenden wir die Netzüberschneidung, um die Hand-Objekt-Kontaktbereiche zu berechnen. Bitte klicken Sie hier, um eine größere Version dieser Abbildung zu sehen.

Protokoll

Vor Beginn eines Experiments müssen die Teilnehmer eine Einverständniserklärung gemäß den institutionellen Richtlinien und der Deklaration von Helsinki abgeben. Alle hier beschriebenen Protokolle wurden von der lokalen Ethikkommission der Justus-Liebig-Universität Gießen (LEK-FB06) genehmigt.

1. Installation der gesamten erforderlichen Software

- Laden Sie das Projekt-Repository unter Data and Code Repository herunter.

- Installieren Sie die Software, die in der Materialtabelle aufgeführt ist (notieren Sie sich die Softwareversionen und folgen Sie den Links für Kaufoptionen und Anweisungen).

- Öffnen Sie im Daten- und Code-Repository ein Befehlsfenster, und führen Sie den folgenden Befehl aus:

conda env create -f environment.yml - Laden Sie die vortrainierte DeepHandMesh29-Instanziierung herunter, und installieren Sie sie, indem Sie den Anweisungen unter https://github.com/facebookresearch/DeepHandMesh folgen.

- Legen Sie DeepHandMesh im Ordner "deephandmesh" des Daten- und Code-Repositorys ab. Ersetzen Sie die Datei "main/model.py" durch die model.py Datei, die im Daten- und Code-Repository enthalten ist.

2. Vorbereiten des Motion-Capture-Systems

- Positionieren Sie einen Arbeitsbereich innerhalb eines Tracking-Volumens, das von Motion-Tracking-Kameras, die auf einem den Arbeitsbereich umgebenden Rahmen angeordnet sind, aus mehreren Blickwinkeln abgebildet wird (Abbildung 1A). Bereiten Sie reflektierende Marker vor, indem Sie doppelseitiges Klebeband an der Basis jedes Markers anbringen.

- Führen Sie Qualisys Track Manager (QTM) als Administrator aus.

HINWEIS: Das Ausführen von QTM als Administrator ist erforderlich, damit das Python SDK die Kontrolle über die QTM-Schnittstelle übernehmen kann. Wir empfehlen, QTM immer als Administrator auszuführen.

3. Kalibrierung der Kameras

- Platzieren Sie das L-förmige Kalibrierobjekt innerhalb des Tracking-Volumens.

- Klicken Sie im QTM im Capture-Menü auf Kalibrieren oder drücken Sie auf das Stab-Symbol in der Capture-Symbolleiste. Warten Sie, bis sich ein Kalibrierungsfenster öffnet. Wählen Sie die Dauer der Kalibrierung aus und drücken Sie OK.

- Schwenken Sie den Kalibrierstab für die Dauer der Kalibrierung über das Tracking-Volumen. Klicken Sie auf die Schaltfläche Exportieren und geben Sie einen Dateipfad an, in den die Kalibrierung als Textdatei exportiert werden soll. Bestätigen Sie die Kalibrierung, indem Sie OK drücken.

4. Erstellen eines Stimulusobjekts

- Konstruieren Sie ein virtuelles 3D-Objektmodell in Form eines Polygonnetzes. Verwenden Sie einen 3D-Drucker, um eine physische Nachbildung des Objektmodells zu erstellen.

HINWEIS: Das Daten-Repository in Schritt 1.1 enthält Beispielobjekte in den Dateiformaten STL und Wavefront OBJ. Objekte im STL-Format sind vielfältig und bereit für den 3D-Druck.

5. Vorbereitung des Stimulusobjekts

- Bringen Sie vier nicht planare reflektierende Marker an der Oberfläche des realen Objekts an. Platzieren Sie das Objekt innerhalb des Tracking-Volumes.

- Führen Sie im Projekt-Repository das Python-Skript "Acquire_Object.py" aus. Befolgen Sie die Anweisungen des Skripts, um die 3D-Position der Objektmarker innerhalb von 1 s zu erfassen.

- Wählen Sie alle Markierungen des steifen Körpers aus. Klicken Sie mit der rechten Maustaste auf und wählen Sie Starrkörper definieren (6DOF) | Aktueller Frame. Geben Sie den Namen des steifen Körpers ein, und drücken Sie OK.

- Wählen Sie im Menü Datei die Option Exportieren | Zum TSV. Aktivieren Sie im neuen Fenster die Kontrollkästchen 3D, 6D und Skeleton in den Datentypeinstellungen . Aktivieren Sie alle Kontrollkästchen in den allgemeinen Einstellungen. Drücken Sie OK und dann Speichern.

6. Co-Registrierung von Real- und Netzmodellversionen des Stimulusobjekts

- Öffnen Sie Blender und navigieren Sie zum Arbeitsbereich Scripting . Öffnen Sie die Datei "Object_CoRegistration.py" und klicken Sie auf Ausführen. Navigieren Sie zum Arbeitsbereich " Layout" und drücken Sie n , um die Seitenleiste umzuschalten. Navigieren Sie in der Seitenleiste zur Registerkarte Benutzerdefiniert .

- Wählen Sie die OBJ-Datei aus, die gemeinsam registriert werden soll, und klicken Sie auf die Schaltfläche Objekt laden .

- Wählen Sie die Trajektoriendatei aus, die in Schritt 3.3 exportiert wurde, und geben Sie die Namen der Marker an, die durch Semikolons getrennt an das steife Objekt angehängt sind. Geben Sie in der Kopfzeile Marker die Zeile in der Trajektoriendatei an, die die Spaltennamen der Daten enthält (die Zählung beginnt bei 0).

- Wählen Sie die entsprechende Steifkörperdatei mit dem Suffix 6D aus und geben Sie den Namen des in Schritt 4.1 definierten Steifkörpers an. Geben Sie in der 6D-Kopfzeile die Zeile in der Steifkörperdatei an, die die Spaltennamen der Daten enthält.

- Drücken Sie auf Marker laden. Verschieben und drehen Sie das Marker-Objekt und/oder das Objekt-Objekt , um sie auszurichten. Geben Sie eine Mesh-Ausgabedatei an, und klicken Sie auf Coregistration ausführen. Dadurch wird eine .obj-Datei ausgegeben, die das co-registrierte Stimulus-Mesh enthält.

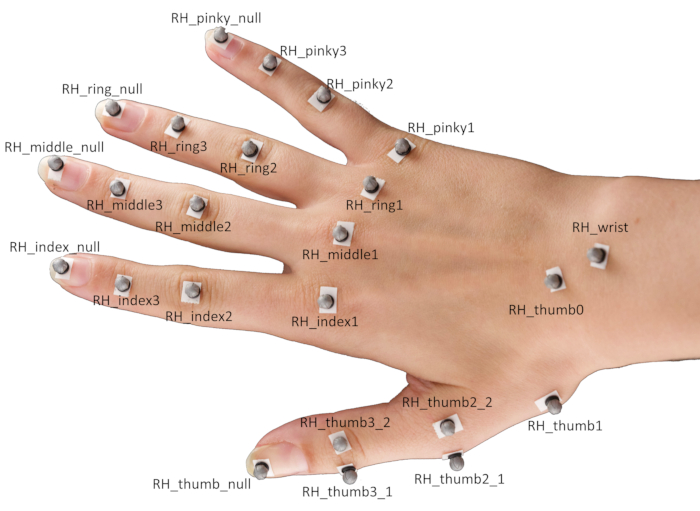

7. Einrichten von Markierungen an den Händen

- Befestigen Sie 24 kugelförmige reflektierende Marker mit doppelseitigem Klebeband an verschiedenen Orientierungspunkten der Hand eines Teilnehmers.

HINWEIS: Die spezifische Positionierung der Marker ist in Abbildung 2 dargestellt.- Positionieren Sie die Marker mittig auf den jeweiligen Fingerkuppen sowie auf den distalen Interphalangealgelenken, proximalen Interphalangealgelenken und Metakarpophalangealgelenken von Zeigefinger, Mittelfinger, Ringfinger und Kleinfinger.

- Positionieren Sie für den Daumen je einen Marker auf der Fingerkuppe und dem basalen Karpometakarpalgelenk sowie je ein Paar Marker auf dem Metakarpophalangealgelenk und dem Interphalangealgelenk.

HINWEIS: Diese Markierungspaare müssen senkrecht zur Hauptachse des Daumens in entgegengesetzte Richtungen verschoben werden und sind notwendig, um die Ausrichtung des Daumens abzuschätzen. - Platzieren Sie zum Schluss Markierungen in der Mitte des Handgelenks und auf dem Scaphotrapeziotrapezgelenk.

Abbildung 2: Platzierung der Marker auf der Hand eines Teilnehmers. Abkürzung: RH = rechte Hand. Bitte klicken Sie hier, um eine größere Version dieser Abbildung zu sehen.

8. Erwerb einer einzelnen Testversion

- Bitten Sie den Teilnehmer, seine Hand mit der Handfläche nach unten flach auf die Werkbank zu legen und die Augen zu schließen. Legen Sie das Stimulusobjekt vor dem Teilnehmer auf die Werkbank.

- Während das QTM läuft, führen Sie das Python-Skript "Single_Trial_Acquisition.py" im Projekt-Repository aus. Befolgen Sie die Anweisungen des Skripts, um einen einzelnen Versuch des Teilnehmers aufzunehmen, der das Stimulusobjekt greift.

HINWEIS: Das Skript erzeugt einen akustischen Hinweis. Dies signalisiert dem Teilnehmer, die Augen zu öffnen und den Griff auszuführen. In unseren Demonstrationen geht es darum, das Zielobjekt zu erreichen und zu greifen, es senkrecht um ca. 10 cm anzuheben, abzusetzen und die Hand wieder in die Ausgangsposition zu bringen.

9. Beschriftung der Marker

10. Erstellen einer personalisierten Skelettdefinition für den Teilnehmer

- Navigieren Sie im QTM zum Menü "Wiedergabe" und wählen Sie "Wiedergabe mit Echtzeitausgabe" aus.

- Öffne Maya. Navigieren Sie zum QTM Connect-Shelf und klicken Sie auf das Symbol Connect to QTM. Aktivieren Sie im neuen Fenster Markierungen und drücken Sie Verbinden. Drücken Sie nun auf das Play-Symbol im QTM Connect-Regal.

- Wählen Sie bei gedrückter Umschalttaste alle Handmarker aus und drücken Sie auf das Symbol "Wash Locators ". Wählen Sie die gewaschenen Handmarker aus und drücken Sie Strg + G. Dadurch wird ein Gruppenknoten erstellt. Nennen Sie die Gruppe Markierungen.

- Wählen Sie alle Handmarker aus. Klicken Sie im Menü " Ändern " auf "Namen suchen und ersetzen". Suchen Sie nach dem Präfix RH_ , und löschen Sie das Präfix für die Markierungen.

- Klicken Sie auf das Symbol "Solver importieren" im QTM Connect-Regal . Laden Sie die Skelettdefinition "RH_FH.xml".

- Navigieren Sie im Windows-Menü zu Allgemeine Editoren | Namespace-Editor. Klicken Sie im neuen Fenster auf :(root) und klicken Sie auf Neu , um einen neuen Namespace (RH) zu erstellen. Klicken Sie auf den RH-Namespace , drücken Sie auf Neu, und nennen Sie den neuen Namespace ModelPose.

- Wählen Sie alle Marker aus, klicken Sie auf den RH-Namespace und klicken Sie auf Auswahl hinzufügen, um die Marker zum RH-Namespace hinzuzufügen.

- Wählen Sie die Skelettknochen aus, klicken Sie auf den ModelPose-Namespace, und klicken Sie auf Auswahl hinzufügen, um die Skelettknochen zum ModelPose-Namespace hinzuzufügen.

- Drehen, verschieben und skalieren Sie das Skelett, um es an die Markerdaten anzupassen. Drücken Sie als Nächstes für jedes Skelettgelenk einzeln Umschalt + Wählen Sie das Skelettgelenk und die zugehörigen Markierungen aus, und klicken Sie auf das Symbol Anhänge hinzufügen . Klicken Sie abschließend auf das Symbol Solver exportieren, um die neue Skelettdefinition in eine XML-Datei zu exportieren, die in das QTM geladen werden kann (siehe nächster Schritt).

ANMERKUNG: Dieser Schritt ist nicht unbedingt erforderlich, aber er ist nützlich, um die Genauigkeit der Skelettanpassung an die Markerdaten zu erhöhen. Weitere Informationen finden Sie im QSolverQuickstartGuide auf https://github.com/qualisys/QTM-Connect-For-Maya.

11. Rekonstruieren Sie die Gelenkhaltungen des Skelettgelenks

- Öffnen Sie innerhalb des QTM die Projekteinstellungen, indem Sie auf das Zahnradsymbol drücken. Navigieren Sie in der Seitenleiste zu Skeleton Solver und drücken Sie Laden , um eine Skeleton-Definitionsdatei auszuwählen. Stellen Sie den Skalierungsfaktor auf 100 % ein, und klicken Sie auf Übernehmen.

- Navigieren Sie zu TSV-Export, und aktivieren Sie die Kontrollkästchen 3D, 6D und Skeleton in den Datentypeinstellungen . Aktivieren Sie alle Kontrollkästchen in den allgemeinen Einstellungen. Klicken Sie auf Übernehmen, und schließen Sie die Projekteinstellungen.

- Klicken Sie auf das Symbol "Erneut verarbeiten", aktivieren Sie die Kontrollkästchen "Skelette lösen" und "In TSV-Datei exportieren", und drücken Sie OK.

12. Erzeugen von Handnetzrekonstruktionen

- Öffnen Sie ein Befehlsfenster im Projekt-Repository, und aktivieren Sie die Conda-Umgebung, indem Sie den folgenden Befehl ausführen:

conda activate contact-regions - Führen Sie dann den folgenden Befehl aus, und befolgen Sie die Anweisungen des Skripts, um für jeden Frame des Versuchs ein Handgitter zu generieren, das die aktuelle Handpose rekonstruiert.

python Hand_Mesh_Reconstruction.py --gpu 0 --test_epoch 4

HINWEIS: Diese Netzrekonstruktionen werden automatisch mit einer modifizierten Version des Open-Source- und vortrainierten Handnetzgenerierungstools DeepHandMesh29 generiert.

13. Generieren von Schätzungen der Hand-Objekt-Kontaktregion

- Öffnen Sie ein Befehlsfenster im Projekt-Repository, führen Sie den folgenden Befehl aus, und befolgen Sie die Anweisungen des Skripts, um Schätzungen für Hand- und Objektkontaktbereiche zu generieren, indem Sie den Schnittpunkt zwischen den Hand- und Objektnetzen berechnen.

blender --background --python "Contact_Region_Estimation.py"

Ergebnisse

Die erste Voraussetzung für die vorgeschlagene Methode ist ein System, mit dem die Position von 3D-Objekten und Händen genau verfolgt werden kann. Der spezifische Aufbau ist in Abbildung 1A dargestellt und verwendet Hardware und Software, die von der Motion-Capture-Firma Qualisys hergestellt werden. Wir positionieren eine Werkbank innerhalb eines Tracking-Volumens (100 cm x 100 cm x 100 cm), das von acht Tracking-Kameras und sechs Videokameras, die auf einem kubischen Rahmen um den Arbeitsbereich angeordnet sind, aus mehreren Blickwinkeln abgebildet wird. Die Tracking-Kameras verfolgen die 3D-Position der reflektierenden Marker innerhalb des Tracking-Volumens mit 180 Bildern/s und mit einer räumlichen Auflösung von Submillimetern in 3D. Wir verwenden 4 mm reflektierende Marker, die mit hautfreundlichem doppelseitigem Klebeband an den Gegenständen und Händen befestigt werden. Die 3D-Markerpositionen werden von der Motion-Capture-Software verarbeitet. Der Diskussionsabschnitt befasst sich auch mit alternativen Motion-Capture-Systemen, die mit der vorgeschlagenen Methode eingesetzt werden könnten.

Um genaue 3D-Rekonstruktionen von realen Objekten zu erhalten, die erfasst und manipuliert werden, schlagen wir zwei Optionen vor. Die erste, die hier angenommen wird, besteht darin, von einem virtuellen 3D-Objektmodell in Form eines Polygonnetzes auszugehen. Solche 3D-Modelle können mit entsprechender Software (z. B. Blender 3D44) konstruiert und anschließend 3D-gedruckt werden (Abbildung 1B). Die zweite Möglichkeit besteht darin, ein vorhandenes, reales 3D-Objekt zu nehmen und die 3D-Scantechnologie zu verwenden, um eine Netzmodellreplik des Objekts zu erstellen. Unabhängig von der Strategie besteht das Endziel darin, sowohl ein reales 3D-Objekt als auch das entsprechende virtuelle 3D-Objektnetzmodell zu erhalten. Bemerkenswert ist, dass der hier beschriebene Ansatz nur mit starren (d. h. nicht verformbaren) Objekten funktioniert.

Sobald die 3D-Oberfläche eines Objekts als Netzmodell verfügbar ist, muss seine Position verfolgt und mitregistriert werden (Abbildung 1C). Dazu werden vier nicht-planare Reflexionsmarker auf der Oberfläche des realen Objekts angebracht und das Objekt innerhalb des Tracking-Volumens platziert. Anschließend werden die 3D-Positionen der Objektmarker kurz erfasst. Diese Erfassung wird verwendet, um die Entsprechung zwischen den vier Markern und vier Scheitelpunkten des Objektnetzmodells herzustellen. Dies geschieht mithilfe einer einfachen Ad-hoc-Softwareroute, die in der Python-API von Blender geschrieben ist. Im Viewport von Blender präsentiert das Programm das virtuelle Objekt zusammen mit den Markerpositionen, die als ein einzelnes Mesh-Objekt dargestellt werden, das aus einer Kugel für jeden Marker besteht. Der Benutzer kann dann das Objekt und/oder die Marker drehen und verschieben, um sie so auszurichten, dass sie mit den echten Markern übereinstimmen, die auf dem realen Objekt platziert sind. Das Programm registriert die Drehungen und Translationen, die angewendet werden, um eine einzelne Roto-Translation zu berechnen, die schließlich auf das ursprüngliche Objektnetz angewendet wird, wodurch ein Objektnetz bereitgestellt wird, das gemeinsam mit der Starrkörperdefinition in QTM registriert wird.

Wenn die Übereinstimmung hergestellt wurde, kann das virtuelle Objekt jedes Mal, wenn das reale Objekt innerhalb des Tracking-Volumens bewegt wird, an der neuen Position platziert werden, indem die Rotationsverschiebung zwischen den verfolgten Markern und den vier entsprechenden Netzknoten berechnet wird. Um stattdessen die Dynamik des Griffs zu erfassen, werden insgesamt 24 sphärische Reflexmarker mit doppelseitigem Klebeband an verschiedenen Orientierungspunkten der Hand angebracht (Abbildung 1D und Abbildung 2).

Zu Beginn eines Versuchs (Abbildung 1E) legt ein Teilnehmer seine Hand flach mit der Handfläche nach unten auf die Werkbank und schließt die Augen. Der Experimentator legt ein Zielobjekt vor dem Teilnehmer auf die Werkbank. Als nächstes signalisiert ein akustischer Hinweis dem Teilnehmer, die Augen zu öffnen und den Griff auszuführen. In unseren Demonstrationen geht es darum, das Zielobjekt zu erreichen und zu greifen, es senkrecht um ca. 10 cm anzuheben, abzusetzen und die Hand wieder in die Ausgangsposition zu bringen. Ein in Python 3.7 geschriebenes Skript steuert das Experiment. Bei jedem Versuch wählt das Skript die aktuellen Zustandseinstellungen aus und teilt sie dem Experimentator mit (z. B. Objektidentität und Positionierung). Das Skript steuert auch das Timing des Versuchs, einschließlich akustischer Hinweise und des Starts und Stopps der Motion-Capture-Aufnahmen.

Gliedmaßen werden nicht nur durch ihre Position im 3D-Raum charakterisiert, sondern auch durch ihre Pose. Um also eine vollständige 3D-Rekonstruktion einer menschlichen Hand zu erhalten, die einen echten Griff ausführt, benötigen wir nicht nur die Positionen jedes Gelenks im 3D-Raum, sondern auch die relative Pose (Translation und Rotation) jedes Gelenks in Bezug auf sein Muttergelenk (Abbildung 1F). Skelettgelenkpositionen und -orientierungen können mit Hilfe der inversen Kinematik aus den Markerpositionen abgeleitet werden. Dazu verwenden wir hier den von der QTM-Software bereitgestellten Skeleton-Solver. Damit der Solver funktioniert, müssen wir zunächst eine Skelettdefinition bereitstellen, die die Position und Ausrichtung jedes Gelenks mit mehreren Markerpositionen verknüpft. Auf diese Weise wird eine Skelettdefinition konstruiert und das Skelett-Rig mit den Markerdaten über das QTM Connect-Plugin für Maya verknüpft. Wir erstellen personalisierte Skelettdefinitionen für jeden Teilnehmer, um die Genauigkeit der Skelettanpassungen an die Markerdaten zu maximieren. Für jeden Teilnehmer passen wir manuell ein Handskelett an ein einzelnes Bild von Motion-Capture-Daten an. Nachdem wir eine teilnehmerspezifische Skelettdefinition erhalten haben, führen wir den Skelett-Solver aus, um die Skelettgelenkposen für jeden Frame jedes Versuchs im Experiment zu schätzen.

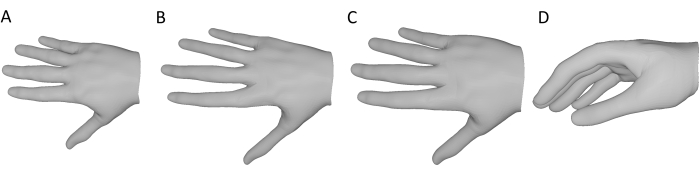

Für jeden Frame jedes Versuchs in einem Experiment generieren wir ein Handnetz, das die aktuelle Handhaltung mit dem Open-Source- und vortrainierten Handnetzgenerierungswerkzeug DeepHandMesh28 rekonstruiert (Abbildung 1G). DeepHandMesh ist ein tiefes Encoder-Decoder-Netzwerk, das personalisierte Handnetze aus Bildern generiert. Zunächst schätzt der Encoder die Pose einer Hand innerhalb eines Bildes (d. h. die Euler-Winkel des Gelenks). Anschließend werden die geschätzte Handpose und ein personalisierter ID-Vektor in den Decoder eingegeben, der einen Satz von drei additiven Korrekturen für ein geriggtes Vorlagengitter schätzt. Schließlich wird das Schablonennetz entsprechend der geschätzten Handpose und Korrekturen mithilfe von linearem Blend-Skinning verformt. Das erste Korrektiv ist ein ID-abhängiges Skelett-Korrektiv, bei dem das Skelett-Rig an die personenbezogenen Gelenkpositionen angepasst wird. Bei den anderen beiden Korrekturen handelt es sich um Netzkorrekturen, bei denen die Netzscheitelpunkte angepasst werden, um die Handoberfläche des Teilnehmers besser darzustellen. Eines der Netzkorrekturmittel ist ein ID-abhängiges Netzkorrekturmittel, das die Oberflächenstruktur der Hand eines einzelnen Teilnehmers berücksichtigt. Das letzte Netzkorrekturmittel ist stattdessen ein posenabhängiges Scheitelpunktkorrekturmittel, das die Verformungen der Handoberfläche aufgrund der aktuellen Handhaltung berücksichtigt.

DeepHandMesh wird mit schwacher Überwachung mit 2D-Gelenkschlüsselpunkten und Szenentiefenkarten trainiert. Hier verwenden wir nur den vortrainierten DeepHandMesh-Decoder, um Handnetzrekonstruktionen zu erzeugen, die auf folgende Weise modifiziert werden (Abbildung 3). Da das Netzwerk nicht auf bestimmte Teilnehmer trainiert wird, wird zunächst das generische ID-abhängige Netzkorrekturmittel verwendet, das mit dem vortrainierten Modell bereitgestellt wird (Abbildung 3A). Des Weiteren wird das ID-abhängige Skelettkorrektiv mit Hilfe des QTM-Skelettlösers abgeleitet, wie oben beschrieben (Abbildung 3B). Es wird eine proportionale Skalierung der Hand mit der Skelettlänge angenommen, und die Maschendicke wird gleichmäßig um einen Faktor skaliert, der sich aus der relativen Skalierung des Skeletts ergibt, so dass sich das Netz der Handgröße des Probanden besser annähert (Abbildung 3C). Dieses modifizierte Netz wird zusammen mit der aktuellen Handpose (abgeleitet aus den Markerdaten) und der 3D-Position und -Ausrichtung des Handgelenks in den Decoder eingegeben. Der Decoder berechnet also das aktuelle posenabhängige Korrektiv, wendet alle Korrekturen und Rotationsverschiebungen an und gibt eine 3D-Handnetzrekonstruktion der aktuellen Handhaltung im selben Koordinatensystem wie das 3D-Track-Objektnetz aus (Abbildung 3D).

Abbildung 3: Modifikationen am vortrainierten DeepHandMesh-Decoder . (A) Korrigiertes, generisches ID-abhängiges Mesh-Korrekturiv. (B) ID-abhängiges Skelettkorrektiv, abgeleitet durch inverse Kinematik in Schritt 10. (C) Die Größe des Handnetzes wird um den gleichen Faktor wie die Skelettgelenke skaliert. (D) Abschließende 3D-Rekonstruktion des Handnetzes der aktuellen Handpose. Bitte klicken Sie hier, um eine größere Version dieser Abbildung zu sehen.

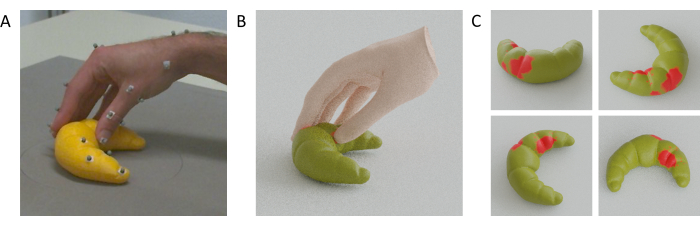

Nach der Rekonstruktion von 3D-Netzmodellen sowohl für die Hand eines Teilnehmers als auch für ein gegriffenes Objekt können die Hand-Objekt-Kontaktbereiche durch Berechnung des Schnittpunkts zwischen den Hand- und Objektnetzen geschätzt werden (Abbildung 1H). Dahinter steckt die Annahme, dass die reale Hand durch den Kontakt mit der Oberfläche verformt wird, was bedeutet, dass das Skelett näher an die Oberfläche kommen kann, als es möglich wäre, wenn die Hand starr wäre, wodurch Teile des Handnetzes durch das Objektnetz hindurchgehen können. Dadurch können die Kontaktflächen als Überlappungsbereiche zwischen den beiden Netzen angenähert werden.

Um diese Überlappungsbereiche zu berechnen, definieren wir Objektnetzscheitelpunkte, die im 3D-Volumen des Handnetzes enthalten sind, als in Kontakt mit der Hand. Diese Scheitelpunkte werden mit einem Standard-Raytracing-Ansatz45 identifiziert. Für jeden Scheitelpunkt des Objektnetzes wird ein Strahl von diesem Scheitelpunkt zu einem beliebigen 3D-Punkt außerhalb des Handnetzes geworfen. Wir beurteilen dann die Anzahl der Schnittpunkte, die zwischen dem gegossenen Strahl und den Dreiecken auftreten, aus denen die Oberfläche der Hand besteht. Wenn die Anzahl der Schnittpunkte ungerade ist, ist der Objektscheitelpunkt im Handnetz enthalten. Wenn die Anzahl der Schnittpunkte gerade ist, befindet sich der Objektscheitelpunkt außerhalb des Handnetzes. Die Kontaktbereiche auf der Oberfläche des Objekts können somit als die Menge der Dreiecksflächen angenähert werden, deren Scheitelpunkte alle innerhalb des Handnetzes enthalten sind. Wir können die gleiche Begründung auf die im 3D-Volumen des Objektnetzes enthaltenen Handnetzscheitelpunkte anwenden, um die Kontaktbereiche auf der Handoberfläche zu schätzen. Bemerkenswert ist, dass auch fortgeschrittenere Ansätze für boolesche Netzoperationen verwendet werden könnten31.

Video 1 zeigt ein Video einer Hand, verfolgter Punkte und eines gemeinsam registrierten Netzes, die sich alle während eines einzigen Griffs zu einer 3D-gedruckten Katzenfigur nebeneinander bewegen. Abbildung 4A zeigt stattdessen ein einzelnes Bild zum Zeitpunkt des Hand-Objekt-Kontakts von einem Griff zu einem 3D-gedruckten Croissant, zusammen mit den Hand-Objekt-Netzrekonstruktionen (Abbildung 4B) und den geschätzten Kontaktbereichen auf der Oberfläche des Croissants (Abbildung 4C).

Abbildung 4: Geschätzte Hand-Objekt-Kontaktregionen. (A) Verfolgte Hand und Objekt, die von einer der Tracking-Kameras während eines Griffs betrachtet werden. (B) Rekonstruiertes Handnetz und Gitter für verfolgte Objekte, die aus demselben Blickwinkel wie die Tracking-Kamera gerendert wurden. (C) Kontaktbereiche auf der Oberfläche des Objekts, die von mehreren Blickwinkeln aus gesehen werden. Bitte klicken Sie hier, um eine größere Version dieser Abbildung zu sehen.

Video 1: Netzrekonstruktionen von Hand und Objekt. GIF-Animation der Hand, verfolgte Markierungen und Rekonstruktionen des Hand- und Objektnetzes während eines einzigen Griffs, betrachtet aus demselben Kamerablickwinkel. Bitte klicken Sie hier, um dieses Video herunterzuladen.

Diskussion

Wir schlagen eine Methode vor, die die Schätzung von Kontaktregionen für Hand-Objekt-Interaktionen bei mehrstelligen Griffen ermöglicht. Da eine vollständige Verfolgung der gesamten Oberfläche einer Hand derzeit nicht möglich ist, schlagen wir vor, eine Rekonstruktion eines Handnetzes zu verwenden, dessen Haltung durch spärliche Schlüsselpunkte auf der Hand bestimmt wird. Um diese spärlichen Schlüsselpunkte zu verfolgen, verwendet unsere Lösung ein forschungstaugliches Motion-Capture-System, das auf passivem Marker-Tracking basiert. Natürlich könnten auch andere Motion-Capture-Systeme mit der vorgeschlagenen Methode eingesetzt werden, vorausgesetzt, sie liefern ausreichend genaue 3D-Positionsdaten. Wir raten von aktiven Marker-Motion-Capture-Systemen (wie z.B. dem beliebten, aber eingestellten Optotrak Certus) ab, da diese das Anbringen von Kabeln und/oder elektronischen Geräten an den Händen der Teilnehmer erfordern, was die Bewegungen einschränken oder zumindest zu weniger typischen Griffen führen kann, da die Teilnehmer bewusster auf die Haltung ihrer Hände aufmerksam gemacht werden. Motion-Tracking-Handschuhe mit Trägheitsmesseinheiten können eine Möglichkeit sein, obwohl bekannt ist, dass diese Systeme unter Drift leiden, auch Handbewegungen einschränken können und es nicht zulassen, dass die Handoberfläche vollständig und direkt mit den Objektoberflächen in Kontakt kommt. Kommerzielle markerlose Hand-Tracking-Lösungen (z. B. die Leap Motion46,47,48) können ebenfalls eine Möglichkeit sein, obwohl es möglicherweise nicht möglich ist, Objektpositionen mit diesen Systemen allein zu verfolgen. Die vielversprechendste Alternative zu einem forschungstauglichen Motion-Capture-System sind quelloffene, markerlose Tracking-Lösungen (z. B. Mathis et al.28). Wenn solche Systeme mit mehreren gemeinsam registrierten Kameras49 verwendet werden, könnten sie potenziell Handgelenkpositionen und Objektpositionen in 3D verfolgen, ohne dass Markierungen, Handschuhe oder Kabel erforderlich sind. Diese Lösungen, wie auch dieses markerbasierte System, können jedoch unter Datenverlustproblemen aufgrund von Okklusionen leiden.

Einschränkungen und zukünftige Richtungen

Da die mit dieser Methode erhaltenen Handrekonstruktionen nicht vollständig genau sind, gibt es einige Einschränkungen bei den Arten von Experimenten, für die die Methode verwendet werden sollte. Abweichungen in der Handnetzrekonstruktion von Ground Truth manifestieren sich in Abweichungen in den geschätzten Hand-Objekt-Kontaktregionen. Die Anwendung dieser Methode zur Ableitung absoluter Maße würde daher eine Bewertung der Genauigkeit der Schätzungen der Kontaktregion erfordern. Aber auch ungefähre Schätzungen können bei Versuchsplänen innerhalb der Teilnehmer nützlich sein, da die potenziellen Verzerrungen der Methode wahrscheinlich unterschiedliche Versuchsbedingungen innerhalb eines Teilnehmers in ähnlicher Weise beeinflussen. Daher sollten statistische Analysen und Schlussfolgerungen nur für Maße wie die Unterschiede in der Kontaktfläche zwischen Bedingungen durchgeführt werden, bei denen die Richtung einer Wirkung mit der jeweiligen Ground Truth korreliert. In zukünftigen Forschungsarbeiten planen wir, unseren Ansatz weiter zu validieren, indem wir beispielsweise die Schätzungen der Kontaktregion mit thermischen Fingerabdrücken auf Objekten vergleichen, die mit thermochromer Farbe bedeckt sind.

Die meisten Verarbeitungsschritte von der Datenerfassung bis zur finalen Kontaktbereichsschätzung sind vollautomatisiert und leisten somit wichtige Beiträge zu einem standardisierten Verfahren zur Hand-Objekt-Kontaktbereichsschätzung. Eine initiale Anpassung der individualisierten Skelette an die 3D-Positionen der getrackten Marker muss jedoch noch manuell durchgeführt werden, um eine Skelettdefinition für jeden Teilnehmer zu erhalten. Wenn die Anzahl der Teilnehmer an einem Experiment zunimmt, steigt auch die Anzahl der manuellen Anpassungen, und dies ist derzeit der zeitaufwändigste Schritt im Verfahren und erfordert eine gewisse Vertrautheit mit dem manuellen Rigging in der Autodesk Maya-Software. In Zukunft wollen wir diesen Schritt automatisieren, um menschliche Einflüsse auf das Verfahren zu vermeiden, indem wir ein automatisches Skelettkalibrierungsverfahren hinzufügen.

Der hier beschriebene Workflow basiert auf der Hardware und Software von Qualisys (z. B. dem QTM-Skelett-Solver). Dies schränkt derzeit die Zugänglichkeit unserer Methode auf Labore ein, die einen ähnlichen Aufbau haben. Prinzipiell lässt sich das Verfahren aber auf jede Quelle von Motion-Capture-Daten anwenden. Um die Zugänglichkeit zu erweitern, suchen wir in der laufenden Arbeit nach Alternativen, die unseren Workflow verallgemeinern und ihn weniger abhängig von bestimmten Hardware- und Softwarelizenzen machen sollten.

Eine weitere wichtige Einschränkung der Methode besteht darin, dass sie in ihrer jetzigen Form nur auf starre (nicht verformbare) Objekte angewendet werden kann. In Zukunft könnte diese Einschränkung durch Methoden zur Erfassung der Oberflächenform des gegriffenen Objekts bei der Verformung überwunden werden. Darüber hinaus ist die Methode aufgrund ihrer ungefähren Natur derzeit nicht gut für sehr kleine oder dünne Objekte geeignet.

Zusammenfassend lässt sich sagen, dass wir durch die Integration von modernstem Motion Tracking mit High-Fidelity-Handoberflächenmodellierung eine Methode zur Schätzung von Hand-Objekt-Kontaktbereichen während des Greifens und der Manipulation bereitstellen. In der zukünftigen Forschung planen wir, diese Methode einzusetzen, um visuell gesteuertes Greifverhalten beim Menschen zu untersuchen und zu modellieren16. Darüber hinaus planen wir, diese Tools mit Eye-Tracking 46,50,51,52 und Virtual-/Augmented-Reality-Systemen 53,54,55 zu integrieren, um die visuell gesteuerte motorische Steuerung von Hand- und Augenbewegungen in realen und virtuellen naturalistischen Umgebungen zu untersuchen 18,46,56,57 . Aus diesen Gründen könnte die vorgeschlagene Methode für Forscher von Interesse sein, die die haptische Wahrnehmung58, die motorische Steuerung und die Mensch-Computer-Interaktion in virtueller und erweiterter Realität untersuchen. Schließlich könnten genaue Messungen der menschlichen Greiffähigkeiten in die Entwicklung robuster Robotersysteme einfließen, die auf den Prinzipien der interaktiven Wahrnehmung basieren 39,40,41,42,43 und könnten translationale Anwendungen für Prothesen der oberen Gliedmaßen haben.

Offenlegungen

Die Autoren erklären, dass keine Interessenkonflikte bestehen.

Danksagungen

Diese Forschung wurde gefördert durch die Deutsche Forschungsgemeinschaft (DFG: Teilprojekt Nr. 222641018-SFB/TRR 135 TP C1 und IGK-1901 "Das Gehirn in Aktion") und durch den Forschungscluster "The Adaptive Mind", gefördert durch das Exzellenzprogramm des Hessischen Ministeriums für Wissenschaft und Kunst. Die Autoren danken dem Qualisys-Support-Team, zu dem auch Mathias Bankay und Jeffrey Thingvold gehören, für die Unterstützung bei der Entwicklung unserer Methoden. Die Autoren danken auch Michaela Jeschke dafür, dass sie als Handmodell posiert hat. Alle Daten und Analyseskripte zur Reproduktion der Methode und der im Manuskript präsentierten Ergebnisse sind auf Zenodo verfügbar (doi: 10.5281/zenodo.7458911).

Materialien

| Name | Company | Catalog Number | Comments |

| Anaconda Python distribution | (Anaconda 5.3.1 or later); https://repo.anaconda.com/archive/ | scripts and functions were generated in Python version 3.7 | |

| Autodesk Maya | Autodesk, Inc. | Maya2022; https://www.autodesk.com/products/maya/overview | 3D computer graphics application. |

| Blender | Blender Foundation | Blender 2.92; https://download.blender.org/release/ | 3D computer graphics application. |

| Computer Workstation | N/A | N/A | OS: Windows 10 or higher. |

| DeepHandMesh | Meta Platforms, Inc. (Meta Open Source) | https://github.com/facebookresearch/DeepHandMesh | Pre-trained hand mesh generation tool. |

| Miqus M5 | Qualisys Ab | https://www.qualisys.com/cameras/miqus/ | Passive marker motion tracking camera (8 units). |

| Miqus video camera | Qualisys Ab | https://www.qualisys.com/cameras/miqus-video/ | Color video camera, synchronized with Miquis M5 tracking cameras (6 units). |

| Project repository | N/A | Data and Code Repository | Data and code to replicate the current project. The repository is currently under construction, but we provide a private link where reviewers can download the current and most up-to-date version of the repository. The final repository will be made publicly available upon acceptance. |

| Python 3 | Python Software Foundation | Python Version 3.7 | Python3 and associated built-in libraries. |

| QTM Connect for Maya | Qualisys Ab | https://github.com/qualisys/QTM-Connect-For-Maya | Stream skeleton, rigid bodies and marker data from QTM to Maya |

| QTM Qualisys Track Manager | Qualisys Ab | Qualisys Track Manager 2021.2; https://www.qualisys.com/software/qualisys-track-manager/ | Motion capture software |

| Qualisys SDK for Python | Qualisys Ab | https://github.com/qualisys/qualisys_python_sdk | Implements communication between QTM and Python |

Referenzen

- Derzsi, Z., Volcic, R. MOTOM toolbox: MOtion Tracking via Optotrak and Matlab. Journal of Neuroscience Methods. 308, 129-134 (2018).

- Eloka, O., Franz, V. H. Effects of object shape on the visual guidance of action. Vision Research. 51 (8), 925-931 (2011).

- Lederman, S. J., Wing, A. M. Perceptual judgement, grasp point selection and object symmetry. Experimental Brain Research. 152 (2), 156-165 (2003).

- Schettino, L. F., Adamovich, S. V., Poizner, H. Effects of object shape and visual feedback on hand configuration during grasping. Experimental Brain Research. 151 (2), 158-166 (2003).

- Chen, Z., Saunders, J. A. Online processing of shape information for control of grasping. Experimental Brain Research. 233 (11), 3109-3124 (2015).

- Burstedt, M. K., Flanagan, J. R., Johansson, R. S. Control of grasp stability in humans under different frictional conditions during multidigit manipulation. Journal of Neurophysiology. 82 (5), 2393-2405 (1999).

- Paulun, V. C., Gegenfurtner, K. R., Goodale, M. A., Fleming, R. W. Effects of material properties and object orientation on precision grip kinematics. Experimental Brain Research. 234 (8), 2253-2265 (2016).

- Klein, L. K., Maiello, G., Fleming, R. W., Voudouris, D. Friction is preferred over grasp configuration in precision grip grasping. Journal of Neurophysiology. 125 (4), 1330-1338 (2021).

- Mamassian, P. Prehension of objects oriented in three-dimensional space. Experimental Brain Research. 114 (2), 235-245 (1997).

- Paulun, V. C., Kleinholdermann, U., Gegenfurtner, K. R., Smeets, J. B. J., Brenner, E. Center or side: biases in selecting grasp points on small bars. Experimental Brain Research. 232 (7), 2061-2072 (2014).

- Goodale, M. A., et al. Separate neural pathways for the visual analysis of object shape in perception and prehension. Current Biology. 4 (7), 604-610 (1994).

- Kleinholdermann, U., Franz, V. H., Gegenfurtner, K. R. Human grasp point selection. Journal of Vision. 13 (8), 23 (2013).

- Maiello, G., Paulun, V. C., Klein, L. K., Fleming, R. W. Object visibility, not energy expenditure, accounts for spatial biases in human grasp selection. i-Perception. 10 (1), 204166951982760-20 (2019).

- Maiello, G., Schepko, M., Klein, L. K., Paulun, V. C., Fleming, R. W. Humans can visually judge grasp quality and refine their judgments through visual and haptic feedback. Frontiers in Neuroscience. 14, 591898 (2021).

- Klein, L. K., Maiello, G., Paulun, V. C., Fleming, R. W. Predicting precision grip grasp locations on three-dimensional objects. PLoS Computational Biology. 16 (8), 1008081 (2020).

- Maiello, G., Paulun, V. C., Klein, L. K., Fleming, R. W. The sequential-weight illusion. i-Perception. 9 (4), 204166951879027 (2018).

- Chessa, M., Maiello, G., Klein, L. K., Paulun, V. C., Solari, F. Grasping objects in immersive Virtual Reality. 2019 IEEE Conference on Virtual Reality and 3D User Interfaces (VR). , 1749-1754 (2019).

- Crajé, C., Lukos, J. R., Ansuini, C., Gordon, A. M., Santello, M. The effects of task and content on digit placement on a bottle). Experimental Brain Research. 212 (1), 119-124 (2011).

- Lukos, J., Ansuini, C., Santello, M. Choice of contact points during multidigit grasping: Effect of predictability of object center of mass location. Journal of Neuroscience. 27 (14), 3894-3903 (2007).

- Gilster, R., Hesse, C., Deubel, H. Contact points during multidigit grasping of geometric objects. Experimental Brain Research. 217 (1), 137-151 (2012).

- Schot, W. D., Brenner, E., Smeets, J. B. J. Robust movement segmentation by combining multiple sources of information. Journal of Neuroscience Methods. 187 (2), 147-155 (2010).

- Sundaram, S., et al. Learning the signatures of the human grasp using a scalable tactile glove. Nature. 569 (7758), 698-702 (2019).

- Yan, Y., Goodman, J. M., Moore, D. D., Solla, S. A., Bensmaia, S. J. Unexpected complexity of everyday manual behaviors. Nature Communications. 11 (1), 3564 (2020).

- Han, S., et al. Online optical marker-based hand tracking with deep labels. ACM Transactions on Graphics. 37 (4), 1-10 (2018).

- Clouthier, A. L., et al. Development and validation of a deep learning algorithm and open-source platform for the automatic labelling of motion capture markers. IEEE Access. 9, 36444-36454 (2021).

- . Qualisys AB Qualisys Track Manager User Manual (Version 2022.1) Available from: https://www.qualisys.com/ (2022)

- Mathis, A., et al. DeepLabCut: Markerless pose estimation of user-defined body parts with deep learning. Nature Neuroscience. 21 (9), 1281-1289 (2018).

- Moon, G., Shiratori, T., Lee, K. M. DeepHandMesh: A weakly-supervised deep encoder-decoder framework for high-fidelity hand mesh modeling. ECCV 2020. , (2020).

- Smith, B., et al. Constraining dense hand surface tracking with elasticity. ACM Transactions on Graphics. 39 (6), 219 (2020).

- Taheri, O., Ghorbani, N., Black, M. J., Tzionas, D. GRAB: A dataset of whole-body human grasping of objects. Computer Vision - ECCV 2020: 16th European Conference. , 581-600 (2020).

- Brahmbhatt, S., Tang, C., Twigg, C. D., Kemp, C. C., Hays, J. ContactPose: A dataset of grasps with object contact and hand pose. Computer Vision - ECCV 2020. , 361-378 (2020).

- Wang, J., et al. RGB2Hands: Real-time tracking of 3D hand interactions from monocular RGB video. ACM Transactions on Graphics. 39 (6), 218 (2020).

- Zhang, X., Li, Q., Mo, H., Zhang, W., Zheng, W. End-to-end hand mesh recovery from a monocular RGB image. 2019 IEEE/CVF International Conference on Computer Vision (ICCV). , 2354-2364 (2019).

- Endo, Y., Tada, M., Mochimaru, M. Reconstructing individual hand models from motion capture data). Journal of Computational Design and Engineering. 1 (1), 1-12 (2014).

- Mueller, F., et al. GANerated hands for real-time 3D hand tracking from monocular RGB. 2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition. , 49-59 (2018).

- Mueller, F., et al. Real-time pose and shape reconstruction of two interacting hands with a single depth camera. ACM Transactions on Graphics. 38 (4), 49 (2019).

- Romero, J., Tzionas, D., Black, M. J. Embodied hands: Modeling and capturing hands and bodies together. ACM Transactions on Graphics. 36 (6), 245 (2017).

- Kappler, D., Bohg, J., Schaal, S. Leveraging big data for grasp planning. 2015 IEEE International Conference on Robotics and Automation (ICRA). , 4304-4311 (2015).

- Kokic, M., Kragic, D., Bohg, J. Learning task-oriented grasping from human activity datasets). IEEE Robotics and Automation Letters. 5 (2), 3352-3359 (2020).

- Shao, L., et al. UniGrasp: Learning a unified model to grasp with multifingered robotic hands. IEEE Robotics and Automation Letters. 5 (2), 2286-2293 (2020).

- Shao, L., Migimatsu, T., Zhang, Q., Yang, K., Bohg, J. Concept2Robot: Learning manipulation concepts from instructions and human demonstrations. Robotics: Science and Systems XVI. , (2020).

- Bohg, J. Interactive perception: Leveraging action in perception and perception in action. IEEE Transactions on Robotics. 33 (6), 1273-1291 (2017).

- . Blender Foundation Available from: https://www.blender.org (2022)

- Roth, S. D. Ray casting for modeling solids. Computer Graphics and Image Processing. 18 (2), 109-144 (1982).

- Maiello, G., Kwon, M., Bex, P. J. Three-dimensional binocular eye-hand coordination in normal vision and with simulated visual impairment. Experimental Brain Research. 236 (3), 691-709 (2018).

- Weichert, F., Bachmann, D., Rudak, B., Fisseler, D. Analysis of the accuracy and robustness of the leap motion controller. Sensors. 13 (5), 6380-6393 (2013).

- Guna, J., Jakus, G., Pogačnik, M., Tomažič, S., Sodnik, J. An analysis of the precision and reliability of the leap motion sensor and its suitability for static and dynamic tracking. Sensors. 14 (2), 3702-3720 (2014).

- Sheshadri, S., Dann, B., Hueser, T., Scherberger, H. 3D reconstruction toolbox for behavior tracked with multiple cameras. Journal of Open Source Software. 5 (45), 1849 (2020).

- Maiello, G., Harrison, W. J., Bex, P. J. Monocular and binocular contributions to oculomotor plasticity. Scientific Reports. 6, 31861 (2016).

- Caoli, A., et al. A dichoptic feedback-based oculomotor training method to manipulate interocular alignment. Scientific Reports. 10, 15634 (2020).

- Gibaldi, A., Vanegas, M., Bex, P. J., Maiello, G. Evaluation of the Tobii EyeX eye tracking controller and Matlab toolkit for research. Behavior Research Methods. 49 (3), 923-946 (2017).

- Chessa, M., Maiello, G., Borsari, A., Bex, P. J. The Perceptual quality of the Oculus Rift for immersive virtual reality. Human-Computer Interaction. 34 (1), 51-82 (2016).

- Maiello, G., Chessa, M., Bex, P. J., Solari, F. Near-optimal combination of disparity across a log-polar scaled visual field. PLoS Computational Biology. 16 (4), 1007699 (2020).

- Maiello, G., Chessa, M., Solari, F., Bex, P. J. The (in)effectiveness of simulated blur for depth perception in naturalistic images. PLoS One. 10 (10), 0140230 (2015).

- Maiello, G., Chessa, M., Solari, F., Bex, P. J. Simulated disparity and peripheral blur interact during binocular fusion. Journal of Vision. 14 (8), 13 (2014).

- Maiello, G., Kerber, K. L., Thorn, F., Bex, P. J., Vera-Diaz, F. A. Vergence driven accommodation with simulated disparity in myopia and emmetropia. Experimental Eye Research. 166, 96-105 (2018).

- Moscatelli, A., et al. The change in fingertip contact area as a novel proprioceptive cue. Current Biology. 26 (9), 1159-1163 (2016).

Nachdrucke und Genehmigungen

Genehmigung beantragen, um den Text oder die Abbildungen dieses JoVE-Artikels zu verwenden

Genehmigung beantragenWeitere Artikel entdecken

This article has been published

Video Coming Soon

Copyright © 2025 MyJoVE Corporation. Alle Rechte vorbehalten