Method Article

Stima delle regioni di contatto tra mani e oggetti durante la presa umana a più cifre

In questo articolo

Riepilogo

Quando afferriamo un oggetto, più regioni delle dita e della mano in genere entrano in contatto con la superficie dell'oggetto. Ricostruire tali regioni di contatto è impegnativo. Qui, presentiamo un metodo per stimare approssimativamente le regioni di contatto combinando l'acquisizione del movimento basata su marker con la ricostruzione della mesh manuale basata sul deep learning esistente.

Abstract

Per afferrare un oggetto con successo, dobbiamo selezionare le regioni di contatto appropriate per le nostre mani sulla superficie dell'oggetto. Tuttavia, identificare tali regioni è difficile. Questo documento descrive un flusso di lavoro per stimare le aree di contatto dai dati di rilevamento basati su marker. I partecipanti afferrano oggetti reali, mentre noi tracciamo la posizione 3D sia degli oggetti che della mano, comprese le articolazioni delle dita. Per prima cosa determiniamo gli angoli di Eulero del giunto da una selezione di marcatori tracciati posizionati sul dorso della mano. Quindi, utilizziamo algoritmi di ricostruzione della mesh a mano all'avanguardia per generare un modello mesh della mano del partecipante nella posa corrente e nella posizione 3D.

L'utilizzo di oggetti stampati in 3D o scansionati in 3D e quindi disponibili sia come oggetti reali che come dati mesh, consente di registrare congiuntamente le mesh di mani e oggetti. A sua volta, ciò consente la stima di regioni di contatto approssimative calcolando le intersezioni tra la mesh manuale e la mesh di oggetti 3D co-registrata. Il metodo può essere utilizzato per stimare dove e come gli esseri umani afferrano gli oggetti in una varietà di condizioni. Pertanto, il metodo potrebbe essere di interesse per i ricercatori che studiano la percezione visiva e tattile, il controllo motorio, l'interazione uomo-computer nella realtà virtuale e aumentata e la robotica.

Introduzione

La capacità di afferrare e manipolare gli oggetti è un'abilità chiave che consente agli esseri umani di rimodellare l'ambiente secondo i loro desideri e bisogni. Tuttavia, controllare efficacemente le mani multi-articolate è un compito impegnativo che richiede un sofisticato sistema di controllo. Questo sistema di controllo motorio è guidato da diverse forme di input sensoriali, tra cui la visione è fondamentale. Attraverso la visione, gli individui possono identificare gli oggetti nell'ambiente e stimare la loro posizione e proprietà fisiche e possono quindi raggiungere, afferrare e manipolare quegli oggetti con facilità. Comprendere il complesso sistema che collega l'input alle retine con i comandi motori che controllano le mani è una sfida chiave delle neuroscienze sensomotorie. Per modellare, prevedere e capire come funziona questo sistema, dobbiamo prima essere in grado di studiarlo in dettaglio. Ciò richiede misurazioni ad alta fedeltà sia degli input visivi che delle uscite del motore manuale.

La passata tecnologia di tracciamento del movimento ha imposto una serie di limitazioni allo studio della presa umana. Ad esempio, i sistemi che richiedono cavi attaccati alle mani dei partecipanti1,2 tendono a limitare la gamma di movimenti delle dita, alterando potenzialmente i movimenti di presa o le misurazioni stesse. Nonostante tali limitazioni, la ricerca precedente è stata in grado di identificare diversi fattori che influenzano la presa guidata visivamente. Alcuni di questi fattori includono la forma dell'oggetto 3,4,5,6, la rugosità superficiale 7,8,9 o l'orientamento di un oggetto rispetto alla mano 4,8,10. Tuttavia, per superare i precedenti limiti tecnologici, la maggior parte di questa ricerca precedente ha impiegato stimoli semplici e compiti altamente vincolati, concentrandosi quindi prevalentemente su fattori individuali 3,4,6,7,10, impugnature di precisione a due cifre3,4,6,9,11,12, 13,14,15,16,17,18, oggetti singoli19, o forme 2D molto semplici 20,21. Come i risultati precedenti si generalizzano al di là di tali condizioni di laboratorio ridotte e artificiali è sconosciuto. Inoltre, la misurazione del contatto mano-oggetto è spesso ridotta alla stima dei punti di contatto delle cifre22. Questa semplificazione può essere appropriata per descrivere un piccolo sottoinsieme di impugnature in cui solo i polpastrelli sono in contatto con un oggetto. Tuttavia, nella maggior parte delle prese del mondo reale, ampie regioni delle dita e del palmo entrano in contatto con un oggetto. Inoltre, un recente studio23 ha dimostrato, usando un guanto tattile, che gli oggetti possono essere riconosciuti da come la loro superficie colpisce la mano. Ciò evidenzia l'importanza di studiare le regioni di contatto estese tra le mani e gli oggetti afferrati, non solo i punti di contatto tra gli oggetti e la punta delle dita22.

I recenti progressi nella motion capture e nella modellazione 3D della mano ci hanno permesso di superare i limiti precedenti e di studiare la comprensione nella sua piena complessità. Il tracciamento del movimento passivo basato su marker è ora disponibile con marcatori di dimensioni millimetriche che possono essere attaccati al dorso delle mani del partecipante per tracciare i movimenti articolari24. Inoltre, gli algoritmi automatici di identificazione dei marcatori per i sistemi di marcatori passivi sono ora sufficientemente robusti da eliminare quasi la necessità di un'ampia post-elaborazione manuale dei dati dei marcatori25,26,27. Le soluzioni senza marker stanno anche raggiungendo livelli impressionanti di prestazioni nel tracciare parti del corpo di animali nei video28. Questi metodi di tracciamento del movimento, quindi, consentono finalmente misurazioni affidabili e non invasive di complessi movimenti della mano a più cifre24. Tali misurazioni possono informarci sulla cinematica articolare e consentirci di stimare i punti di contatto tra la mano e un oggetto. Inoltre, negli ultimi anni, la comunità della visione artificiale ha affrontato il problema della costruzione di modelli delle mani umane in grado di replicare le deformazioni dei tessuti molli durante la presa dell'oggetto e persino durante l'auto-contatto tra le parti della mano 29,30,31,32. Tali ricostruzioni mesh 3D possono essere derivate da diversi tipi di dati, come riprese video 33,34, articolazioni scheletriche (derivate da35 basato su marker o markerless tracking36) e immagini di profondità37. Il primo progresso chiave in questo campo è stato fornito da Romero et al.38, che hanno derivato un modello parametrico della mano (MANO) da oltre 1.000 scansioni della mano da 31 soggetti in varie pose. Il modello contiene parametri sia per la posa che per la forma della mano, facilitando la regressione da diverse fonti di dati a una ricostruzione completa della mano. La soluzione più recente DeepHandMesh29 si basa su questo approccio costruendo un modello parametrizzato attraverso il deep learning e aggiungendo l'evitamento della penetrazione, che replica in modo più accurato le interazioni fisiche tra le parti della mano. Combinando tali ricostruzioni di mesh manuali con mesh di oggetti tracciati 3D, è quindi ora possibile stimare le regioni di contatto non solo sulla superficie degli oggetti32 ma anche sulla superficie della mano.

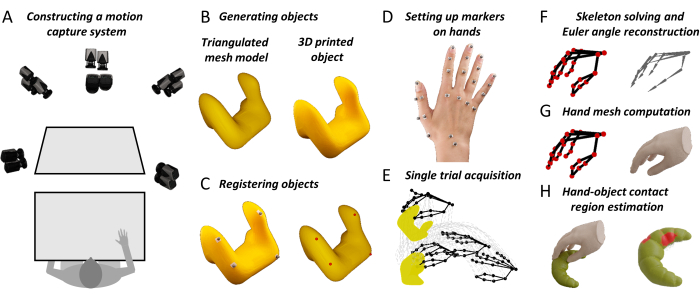

Qui, proponiamo un flusso di lavoro che riunisce il tracciamento 3D ad alta fedeltà di oggetti e giunti delle mani con nuovi algoritmi di ricostruzione della maglia manuale. Il metodo produce mappe dettagliate delle superfici di contatto mano-oggetto. Queste misurazioni aiuteranno i neuroscienziati sensomotori ad estendere la nostra comprensione teorica della presa umana guidata visivamente. Inoltre, il metodo potrebbe essere utile ai ricercatori in campi adiacenti. Ad esempio, i ricercatori del fattore umano possono utilizzare questo metodo per costruire migliori sistemi di interfaccia uomo-macchina nella realtà virtuale e aumentata18. Le misurazioni ad alta fedeltà dei comportamenti di presa umana possono anche aiutare i robotici a progettare sistemi di presa robotica ispirati all'uomo basati sui principi della percezione interattiva 39,40,41,42,43. Noi, quindi, speriamo che questo metodo aiuterà a far progredire la ricerca di presa attraverso i campi delle neuroscienze e dell'ingegneria, da descrizioni sparse di compiti altamente vincolati a caratterizzazioni più complete di comportamenti di presa naturalistica con oggetti complessi e compiti del mondo reale. L'approccio generale è illustrato nella Figura 1.

Figura 1: Fasi principali del metodo proposto . (A) Le telecamere di motion capture riprendono un banco da lavoro da più angolazioni. (B) Un oggetto stimolo viene stampato in 3D da un modello di mesh triangolato. (C) Quattro marcatori riflettenti sferici sono incollati alla superficie dell'oggetto reale. Una procedura semi-automatica identifica quattro punti corrispondenti sulla superficie dell'oggetto mesh. Questa corrispondenza ci consente di roto-tradurre il modello mesh nella posizione tracciata 3D dell'oggetto reale. (D) I marcatori riflettenti sono attaccati a diversi punti di riferimento sul dorso della mano di un partecipante usando nastro biadesivo. (E) Il sistema di motion capture acquisisce le traiettorie nello spazio 3D dell'oggetto tracciato e dei marcatori manuali durante una singola prova. (F) Uno scheletro a mano specifico per il partecipante è costruito utilizzando software di computer grafica 3D. Le pose articolari scheletriche vengono quindi stimate per ogni fotogramma di ogni prova in un esperimento attraverso la cinematica inversa. (G) Le pose congiunte vengono inserite in una versione modificata di DeepHandMesh29, che produce una mesh a mano 3D stimata nella posa e nella posizione 3D correnti. (H) Infine, usiamo l'intersezione mesh per calcolare le regioni di contatto mano-oggetto. Fare clic qui per visualizzare una versione ingrandita di questa figura.

Protocollo

Prima di iniziare un esperimento, i partecipanti devono fornire il consenso informato in conformità con le linee guida istituzionali e la Dichiarazione di Helsinki. Tutti i protocolli qui descritti sono stati approvati dal comitato etico locale dell'Università Justus Liebig di Giessen (LEK-FB06).

1. Installazione di tutti i software necessari

- Scaricare il repository del progetto in Data and Code Repository.

- Installare il software elencato nella tabella dei materiali (prendere nota delle versioni del software e seguire i collegamenti per le opzioni di acquisto e le istruzioni).

- All'interno del repository di dati e codice, aprire una finestra di comando ed eseguire il comando seguente:

conda env create -f environment.yml - Scaricare e installare l'istanza pre-addestrata di DeepHandMesh29 seguendo le istruzioni fornite all'https://github.com/facebookresearch/DeepHandMesh.

- Posiziona DeepHandMesh nella cartella "deephandmesh" del Data and Code Repository. Sostituire il file "main/model.py" con il file model.py contenuto nel repository di dati e codice.

2. Preparazione del sistema di motion capture

- Posizionare un banco di lavoro all'interno di un volume di tracciamento ripreso da più angolazioni dalle telecamere di tracciamento del movimento disposte su un fotogramma che circonda l'area di lavoro (Figura 1A). Prepara i pennarelli riflettenti attaccando del nastro biadesivo alla base di ciascun pennarello.

- Eseguire Qualisys Track Manager (QTM) come amministratore.

NOTA: L'esecuzione di QTM come amministratore è necessaria affinché l'SDK Python assuma il controllo dell'interfaccia QTM. Si consiglia di eseguire sempre QTM come amministratore.

3. Calibrazione delle telecamere

- Posizionare l'oggetto di calibrazione a forma di L all'interno del volume di tracciamento.

- All'interno di QTM, fare clic su Calibrate (Calibrate) nel menu Capture (Capture) oppure premere l'icona della bacchetta nella barra degli strumenti Capture. Attendere l'apertura di una finestra di calibrazione. Selezionare la durata della calibrazione e premere OK.

- Agitare la bacchetta di calibrazione sul volume di tracciamento per tutta la durata della calibrazione. Premere il pulsante Esporta e specificare un percorso di file in cui esportare la calibrazione come file di testo. Accettare la calibrazione premendo OK.

4. Creazione di un oggetto stimolo

- Costruisci un modello a oggetti 3D virtuale sotto forma di una mesh poligonale. Utilizzare una stampante 3D per costruire una replica fisica del modello a oggetti.

Nota : l'archivio dati nel passaggio 1.1 fornisce oggetti di esempio nei formati di file STL e Wavefront OBJ. Gli oggetti in formato STL sono molteplici e pronti per la stampa 3D.

5. Preparare l'oggetto stimolo

- Attacca quattro marcatori riflettenti non planari alla superficie dell'oggetto reale. Posizionare l'oggetto all'interno del volume di tracciamento.

- Nel repository del progetto, eseguire lo script Python "Acquire_Object.py". Seguire le istruzioni fornite dallo script per eseguire un'acquisizione di 1 s della posizione 3D dei marcatori oggetto.

- Selezionare tutti i marcatori del corpo rigido. Fare clic con il pulsante destro del mouse e selezionare Definisci corpo rigido (6DOF) | Fotogramma corrente. Immettete il nome del corpo rigido e premete OK.

- Nel menu File , selezionare Esporta | A TSV. Nella nuova finestra, selezionare le caselle 3D, 6D e Skeleton nelle impostazioni del tipo di dati . Seleziona tutte le caselle nelle impostazioni generali . Premere OK e quindi Salva.

6. Co-registrazione delle versioni del modello reale e mesh dell'oggetto stimolo

- Aprire Blender e passare all'area di lavoro Scripting . Aprire il file "Object_CoRegistration.py" e premere Esegui. Passare all'area di lavoro Layout e premere n per attivare o disattivare la barra laterale. All'interno della barra laterale, vai alla scheda Personalizzata .

- Selezionare il file .obj da registrare insieme e premere il pulsante Carica oggetto .

- Selezionare il file di traiettoria esportato nel passaggio 3.3 e specificare i nomi dei marcatori associati all'oggetto rigido separati da punto e virgola. Nell'intestazione Marker specificare la riga nel file di traiettoria contenente i nomi delle colonne dei dati (il conteggio inizia da 0).

- Selezionare il file del corpo rigido corrispondente con il suffisso 6D e specificare il nome del corpo rigido definito nel passaggio 4.1. Nell'intestazione 6D specificare la riga nel file del corpo rigido contenente i nomi delle colonne dei dati.

- Premere Load Marker. Traslare e ruotare l'oggetto Markers e/o l'oggetto Object per allinearli . Specificare un file di output mesh e premere Run Coregistration. Verrà generato un file .obj contenente la mesh di stimolo co-registrata.

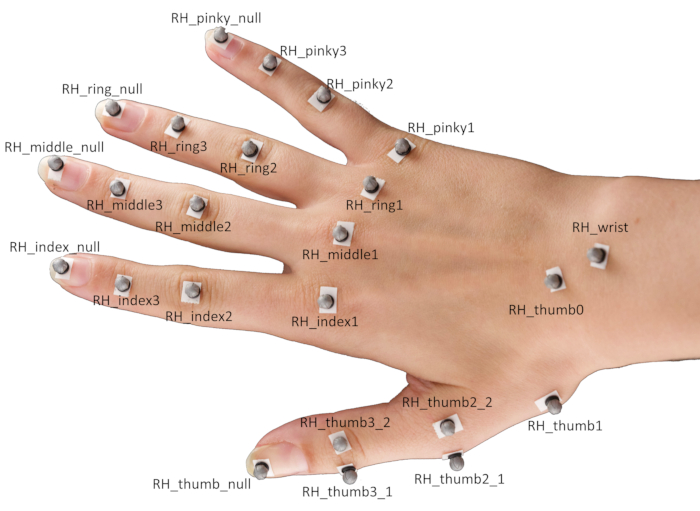

7. Impostazione dei pennarelli sulle mani

- Attacca 24 marcatori riflettenti sferici su diversi punti di riferimento della mano di un partecipante usando del nastro biadesivo.

NOTA: Il posizionamento specifico dei marcatori è illustrato nella Figura 2.- Posizionare i marcatori centralmente sopra la punta delle dita, nonché le articolazioni interfalangee distali, le articolazioni interfalangee prossimali e le articolazioni metacarpo-falangee del dito indice, medio, anulare e mignolo.

- Per il pollice, posizionare un marcatore ciascuno sulla punta del dito e sull'articolazione carpometacarpale basale, nonché una coppia di marcatori ciascuno sulle articolazioni metacarpo-falangee e interfalangee.

NOTA: queste coppie di marcatori devono essere spostate in direzioni opposte perpendicolarmente all'asse principale del pollice e sono necessarie per stimare l'orientamento del pollice. - Infine, posizionare i marcatori al centro del polso e sull'articolazione scaphotrapeziotrapezoidale.

Figura 2: Posizionamento del marcatore sulla mano di un partecipante. Abbreviazione: RH = mano destra. Fare clic qui per visualizzare una versione ingrandita di questa figura.

8. Acquisizione di una singola prova

- Chiedi al partecipante di appoggiare la mano sul banco da lavoro con il palmo rivolto verso il basso e di chiudere gli occhi. Posizionare l'oggetto stimolo sul banco di lavoro di fronte al partecipante.

- Mentre QTM è in esecuzione, eseguire lo script Python "Single_Trial_Acquisition.py" nel repository del progetto. Seguire le istruzioni fornite dallo script per acquisire una singola prova del partecipante che afferra l'oggetto stimolo.

NOTA: lo script produrrà un segnale uditivo. Questo segnalerà al partecipante di aprire gli occhi ed eseguire la presa. Nelle nostre dimostrazioni, il compito è quello di raggiungere e afferrare l'oggetto bersaglio, sollevarlo verticalmente di circa 10 cm, abbassarlo e riportare la mano nella sua posizione di partenza.

9. Etichettatura dei marcatori

- All'interno del QTM, trascinare e rilasciare le singole traiettorie dei marcatori dalle traiettorie non identificate alle traiettorie etichettate ed etichettarle in base alla convenzione di denominazione nella Figura 2.

- Selezionare tutti i marcatori collegati alla mano, quindi fare clic con il pulsante destro del mouse e selezionare Genera modello AIM dalla selezione. Nella nuova finestra, selezionare Crea nuovo modello basato sulle connessioni Marker dal modello AIM esistente e premere il pulsante Avanti .

- Selezionate la definizione del modello RH_FH e premete Apri. Premere Avanti, immettere un nome per il modello AIM e premere OK. Infine, premere Fine per creare un modello AIM per la mano del partecipante, che verrà utilizzato per identificare automaticamente i marcatori nelle prove successive dello stesso partecipante.

10. Creazione di una definizione di scheletro personalizzata per il partecipante

- In QTM, accedere al menu Play e selezionare Play with Real-Time Output.

- Apri Maya. Accedere allo scaffale QTM Connect e premere l'icona Connetti a QTM . Nella nuova finestra, selezionare Marcatori e premere Connetti. Ora, premere l'icona Play nello scaffale QTM Connect .

- Tenete premuto Maiusc e selezionate tutti gli indicatori manuali e premete l'icona Wash Locators . Seleziona gli indicatori delle mani lavate e premi Ctrl + G. Verrà creato un nodo di gruppo. Assegna un nome ai marcatori del gruppo.

- Seleziona tutti gli indicatori a mano. Nel menu Modifica , fare clic su Cerca e sostituisci nomi. Cercare il prefisso RH_ ed eliminare il prefisso per i marcatori.

- Premere l'icona Importa Risolutore nello scaffale QTM Connect . Caricare la definizione di ossatura "RH_FH.xml".

- Nel menu Windows , vai a Editor generali | Editor dello spazio dei nomi. All'interno della nuova finestra, fare clic su :(root) e premere Nuovo per creare un nuovo spazio dei nomi, RH. Fare clic sullo spazio dei nomi RH , premere Nuovo e assegnare al nuovo spazio dei nomi ModelPose.

- Selezionare tutti i marcatori, fare clic sullo spazio dei nomi RH e premere Aggiungi selezionati per aggiungere i marcatori allo spazio dei nomi RH .

- Selezionare le ossa dell'ossatura, fare clic sullo spazio dei nomi ModelPose e premere Aggiungi selezionato per aggiungere le ossa dell'ossatura allo spazio dei nomi ModelPose .

- Ruotare, traslare e ridimensionare l'ossatura per adattarla ai dati del marcatore. Quindi, per ogni giunto di ossatura singolarmente, Maiusc + Selezionare il giunto di ossatura e i relativi indicatori associati, quindi premere l'icona Aggiungi allegati . Infine, premere l'icona Esporta risolutore per esportare la nuova definizione dello scheletro in un file XML che può essere caricato nel QTM (vedere il passaggio successivo).

NOTA: questo passaggio non è strettamente necessario, ma è utile per aumentare la precisione dell'adattamento dello scheletro ai dati del marcatore. Per ulteriori informazioni, leggere la Guida introduttiva QSolver su https://github.com/qualisys/QTM-Connect-For-Maya.

11. Ricostruire le pose articolari scheletriche

- All'interno del QTM, aprire le impostazioni del progetto premendo l'icona della ruota dentata . Nella barra laterale, vai a Risolutore scheletro e premi Carica per selezionare un file di definizione dell'ossatura. Regolare il fattore di scala su 100% e premere Applica.

- Vai a TSV Export e seleziona le caselle 3D, 6D e Skeleton nelle impostazioni del tipo di dati. Seleziona tutte le caselle nelle impostazioni generali. Premere Applica e chiudere le impostazioni del progetto.

- Premere l'icona Rielabora, selezionare le caselle Risolvi scheletri ed Esporta in file TSV, quindi premere OK.

12. Generazione di ricostruzioni di maglie manuali

- Aprire una finestra di comando nel repository del progetto e attivare l'ambiente conda eseguendo il comando:

conda attiva regioni di contatto - Quindi, eseguire il seguente comando e seguire le istruzioni fornite dallo script per generare, per ogni fotogramma della prova, una mesh a mano che ricostruisce la posa della mano corrente.

python Hand_Mesh_Reconstruction.py --gpu 0 --test_epoch 4

NOTA: Queste ricostruzioni mesh vengono generate automaticamente utilizzando una versione modificata dello strumento di generazione di mesh manuali open source e preaddestrato, DeepHandMesh29.

13. Generazione di stime della regione di contatto mano-oggetto

- Aprire una finestra di comando nel repository del progetto, eseguire il comando seguente e seguire le istruzioni fornite dallo script per generare stime dell'area di contatto con la mano e l'oggetto calcolando l'intersezione tra le mesh mano e oggetto.

blender --background --python "Contact_Region_Estimation.py"

Risultati

Il primo requisito per il metodo proposto è un sistema per tracciare con precisione la posizione di oggetti e mani 3D. La configurazione specifica è mostrata nella Figura 1A e utilizza hardware e software prodotti dalla società di motion capture Qualisys. Posizioniamo un banco di lavoro all'interno di un volume di tracciamento (100 cm x 100 cm x 100 cm), che viene ripreso da più angolazioni da otto telecamere di tracciamento e sei videocamere disposte su una cornice cubica che circonda lo spazio di lavoro. Le telecamere di tracciamento tracciano la posizione 3D dei marcatori riflettenti all'interno del volume di tracciamento a 180 fotogrammi/s e con risoluzione spaziale 3D sub-millimetrica. Utilizziamo marcatori riflettenti da 4 mm, che vengono attaccati agli oggetti e alle mani utilizzando nastro biadesivo delicato sulla pelle. Le posizioni dei marcatori 3D vengono elaborate dal software di motion capture. La sezione di discussione esamina anche i sistemi di motion capture alternativi che potrebbero essere impiegati con il metodo proposto.

Per ottenere accurate ricostruzioni 3D di oggetti reali afferrati e manipolati, proponiamo due opzioni. Il primo, che è quello adottato qui, è quello di partire da un modello di oggetti 3D virtuale sotto forma di una mesh poligonale. Tali modelli 3D possono essere costruiti utilizzando software appropriati (ad esempio, Blender 3D44) e quindi stampati in 3D (Figura 1B). La seconda opzione consiste nel prendere un oggetto 3D reale esistente e utilizzare la tecnologia di scansione 3D per costruire una replica del modello mesh dell'oggetto. Qualunque sia la strategia, l'obiettivo finale è quello di ottenere sia un oggetto 3D reale che il corrispondente modello di mesh di oggetti 3D virtuali. Da notare che l'approccio qui descritto funziona solo con oggetti rigidi (cioè indeformabili).

Una volta che la superficie 3D di un oggetto è disponibile come modello di mesh, la sua posizione deve essere tracciata e co-registrata (Figura 1C). Per fare ciò, quattro indicatori riflettenti non planari sono attaccati alla superficie dell'oggetto reale e l'oggetto viene posizionato all'interno del volume di tracciamento. Le posizioni 3D dei marcatori oggetto vengono quindi brevemente acquisite. Questa acquisizione viene utilizzata per stabilire la corrispondenza tra i quattro marcatori e i quattro vertici del modello di mesh di oggetti. Questo viene fatto utilizzando un semplice percorso software ad hoc scritto nell'API Python di Blender. All'interno del Viewport di Blender, il programma presenta l'oggetto virtuale insieme alle posizioni dei marcatori che sono rappresentati come un singolo oggetto mesh composto da una sfera per ciascun marcatore. L'utente può quindi ruotare e traslare l'oggetto e/o i marcatori per allinearli in modo tale che co-allineino con i marcatori reali posizionati sull'oggetto reale. Il programma registrerà le rotazioni e la traslazione applicate per calcolare una singola roto-traslazione che viene infine applicata alla mesh di oggetti originale, fornendo una mesh di oggetti che viene co-registrata con la definizione di corpo rigido in QTM.

Avendo stabilito la corrispondenza, ogni volta che l'oggetto reale viene spostato all'interno del volume di tracciamento, l'oggetto virtuale può essere posizionato nella nuova posizione calcolando la roto-traslazione tra i marcatori tracciati e i quattro vertici di mesh corrispondenti. Per registrare la dinamica della presa, invece, un totale di 24 marcatori riflettenti sferici sono attaccati su diversi punti di riferimento della mano utilizzando nastro biadesivo (Figura 1D e Figura 2).

All'inizio di una prova (Figura 1E), un partecipante appoggia la mano sul banco di lavoro con il palmo rivolto verso il basso e chiude gli occhi. Lo sperimentatore posiziona un oggetto target sul banco di lavoro di fronte al partecipante. Successivamente, un segnale uditivo segnala al partecipante di aprire gli occhi ed eseguire la presa. Nelle nostre dimostrazioni, il compito è quello di raggiungere e afferrare l'oggetto bersaglio, sollevarlo verticalmente di circa 10 cm, abbassarlo e riportare la mano nella sua posizione di partenza. Uno script scritto in Python 3.7 controlla l'esperimento. In ogni prova, lo script seleziona e comunica le impostazioni delle condizioni correnti allo sperimentatore (ad esempio, l'identità e il posizionamento dell'oggetto). Lo script controlla anche i tempi di prova, compresi i segnali uditivi e l'inizio e l'arresto delle registrazioni di motion capture.

Gli arti non sono caratterizzati solo dalla loro posizione nello spazio 3D, ma anche dalla loro posa. Pertanto, per ottenere una ricostruzione 3D completa di una mano umana che esegue una presa reale, abbiamo bisogno non solo delle posizioni di ciascuna articolazione nello spazio 3D, ma anche della posa relativa (traslazione e rotazione) di ciascuna articolazione rispetto alla sua articolazione madre (Figura 1F). Le posizioni e gli orientamenti delle articolazioni scheletriche possono essere dedotti dalle posizioni dei marcatori utilizzando la cinematica inversa. Per fare ciò, qui utilizziamo il risolutore scheletro fornito dal software QTM. Affinché il solutore funzioni, dobbiamo prima fornire una definizione di scheletro che colleghi la posizione e l'orientamento di ciascun giunto a più posizioni del marcatore. Una definizione di scheletro è, quindi, costruita, e lo skeleton rig è collegato ai dati del marker usando il plugin QTM Connect per Maya. Creiamo definizioni di ossatura personalizzate per ogni partecipante per massimizzare la precisione dello scheletro che si adatta ai dati del marcatore. Per ogni partecipante, inseriamo manualmente uno scheletro della mano su un singolo fotogramma di dati di motion capture. Dopo aver ottenuto una definizione di scheletro specifica per il partecipante, eseguiamo quindi il solutore dello scheletro per stimare le pose articolari scheletriche per ogni fotogramma di ogni prova nell'esperimento.

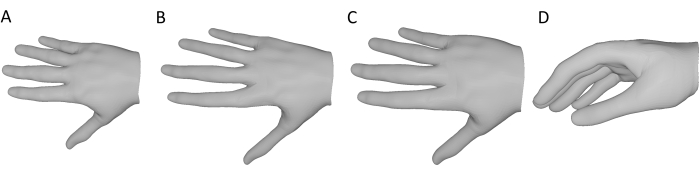

Per ogni fotogramma di ogni prova in un esperimento, generiamo una mesh a mano che ricostruisce la posa della mano corrente utilizzando lo strumento di generazione di mesh manuali open source e preaddestrato, DeepHandMesh28 (Figura 1G). DeepHandMesh è una rete di codificatori-decodificatori profondi che genera mesh manuali personalizzate dalle immagini. In primo luogo, l'encoder stima la posa di una mano all'interno di un'immagine (cioè gli angoli di Eulero congiunti). Quindi, la posa della mano stimata e un vettore ID personalizzato vengono inseriti nel decodificatore, che stima una serie di tre correttivi additivi a una mesh di modelli truccati. Infine, la mesh del modello viene deformata in base alla posa della mano stimata e ai correttivi utilizzando la scrosciatura lineare della miscela. Il primo correttivo è uno scheletro correttivo ID-dipendente attraverso il quale il rig scheletrico viene regolato per incorporare le posizioni articolari specifiche della persona. Gli altri due correttivi sono correttivi di mesh attraverso i quali i vertici della mesh vengono regolati per rappresentare meglio la superficie della mano del partecipante. Uno dei correttivi mesh è un correttivo mesh dipendente dall'ID che tiene conto della struttura superficiale della mano di un singolo partecipante. Il correttivo finale della mesh è invece un correttivo di vertice dipendente dalla posa che tiene conto delle deformazioni della superficie della mano dovute alla posa della mano corrente.

DeepHandMesh viene addestrato utilizzando una supervisione debole con punti chiave di giunzione 2D e mappe di profondità della scena. Qui, utilizziamo solo il decodificatore DeepHandMesh pre-addestrato per generare ricostruzioni di mesh manuali, modificate nei seguenti modi (Figura 3). In primo luogo, poiché la rete non è addestrata su partecipanti specifici, viene utilizzato il correttivo generico della mesh dipendente dall'ID fornito con il modello preaddestrato (Figura 3A). Inoltre, il correttivo dello scheletro dipendente dall'ID viene derivato utilizzando il solutore dello scheletro QTM come descritto sopra (Figura 3B). Si assume una scala proporzionale della mano con la lunghezza dello scheletro e lo spessore della maglia è uniformemente scalato da un fattore derivato dalla scala relativa dello scheletro in modo tale che la maglia si avvicini meglio alla dimensione della mano del partecipante (Figura 3C). Questa mesh modificata viene immessa al decodificatore, insieme alla posa della mano corrente (derivata dai dati del marcatore) e alla posizione e all'orientamento 3D del polso. Il decodificatore, quindi, calcola il correttivo dipendente dalla posa corrente, applica tutti i correttivi e le roto-traslazioni e restituisce una ricostruzione 3D della mesh della mano corrente nella stessa cornice di coordinate della mesh di oggetti tracciati 3D (Figura 3D).

Figura 3: Modifiche al decodificatore DeepHandMesh pre-addestrato . (A) Correttivo mesh generico e generico dipendente dall'ID. (B) Correttivo dello scheletro ID-dipendente derivato attraverso la cinematica inversa nella fase 10. (C) La dimensione della maglia della mano è scalata dello stesso fattore delle articolazioni scheletriche. (D) Ricostruzione finale della maglia della mano 3D della posa della mano corrente. Fare clic qui per visualizzare una versione ingrandita di questa figura.

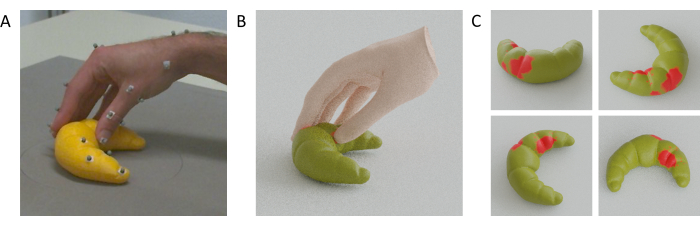

Dopo aver ricostruito i modelli di mesh 3D sia per la mano di un partecipante che per un oggetto afferrato, le regioni di contatto mano-oggetto possono essere stimate calcolando l'intersezione tra le maglie della mano e dell'oggetto (Figura 1H). L'ipotesi alla base di questo è che la mano reale è deformata dal contatto con la superficie, il che significa che lo scheletro può avvicinarsi alla superficie di quanto sarebbe possibile se la mano fosse rigida, il che consente a porzioni della rete della mano di passare attraverso la rete dell'oggetto. Di conseguenza, le aree di contatto possono essere approssimate come le regioni di sovrapposizione tra le due maglie.

In particolare, per calcolare queste regioni di sovrapposizione, definiamo i vertici della mesh oggetto contenuti all'interno del volume 3D della mesh della mano come a contatto con la mano. Questi vertici sono identificati utilizzando un approccio standard di raytracing45. Per ogni vertice della mesh oggetto, viene proiettato un raggio da quel vertice a un punto 3D arbitrario al di fuori della mesh manuale. Valutiamo quindi il numero di intersezioni che si verificano tra il raggio fuso e i triangoli che compongono la superficie della mano. Se il numero di intersezioni è dispari, il vertice dell'oggetto è contenuto all'interno della mesh manuale. Se il numero di intersezioni è pari, il vertice dell'oggetto si trova all'esterno della mesh manuale. Le regioni di contatto sulla superficie dell'oggetto possono, quindi, essere approssimate come l'insieme delle facce triangolari i cui vertici sono tutti contenuti all'interno della maglia della mano. Possiamo applicare lo stesso razionale ai vertici della mesh manuale contenuti nel volume 3D della mesh dell'oggetto per stimare le regioni di contatto sulla superficie della mano. In particolare, potrebbero essere utilizzati anche approcci più avanzati alle operazioni di mesh booleane31.

Il video 1 mostra un video di una mano, punti tracciati e mesh co-registrate che si muovono fianco a fianco durante una singola presa su una figurina di gatto stampata in 3D. La Figura 4A mostra invece un singolo fotogramma al momento del contatto mano-oggetto da una presa a un croissant stampato in 3D, insieme alle ricostruzioni della maglia mano-oggetto (Figura 4B) e alle regioni di contatto stimate sulla superficie del croissant (Figura 4C).

Figura 4: Regioni di contatto mano-oggetto stimate. (A) Mano e oggetto tracciati visti da una delle telecamere di tracciamento durante una presa. (B) Mesh manuale ricostruita e mesh di oggetti tracciati renderizzati dallo stesso punto di vista della telecamera di tracciamento. (C) Regioni di contatto sulla superficie dell'oggetto viste da più punti di vista. Fare clic qui per visualizzare una versione ingrandita di questa figura.

Video 1: Ricostruzioni in rete della mano e dell'oggetto. Animazione Gif della mano, marcatori tracciati e ricostruzioni della maglia di mani e oggetti durante una singola presa vista dallo stesso punto di vista della telecamera. Clicca qui per scaricare questo video.

Discussione

Proponiamo un metodo che consente la stima delle regioni di contatto per le interazioni mano-oggetto durante le prese a più cifre. Poiché il tracciamento completo dell'intera superficie di una mano è attualmente intrattabile, proponiamo di utilizzare una ricostruzione di una maglia della mano la cui posa è determinata da punti chiave sparsi sulla mano. Per tenere traccia di questi punti chiave sparsi, la nostra soluzione utilizza un sistema di motion capture di livello di ricerca basato sul tracciamento passivo dei marcatori. Naturalmente, altri sistemi di motion capture potrebbero anche essere impiegati con il metodo proposto, a condizione che forniscano dati di posizione 3D sufficientemente accurati. Sconsigliamo i sistemi di motion capture dei marker attivi (come il popolare ma fuori produzione Optotrak Certus), poiché richiedono il collegamento di cavi e / o dispositivi elettronici alle mani dei partecipanti, che possono limitare i movimenti o almeno produrre prese meno tipiche poiché i partecipanti sono resi più consapevoli della posa delle loro mani. I guanti di tracciamento del movimento che utilizzano unità di misurazione inerziale possono essere una possibilità, anche se questi sistemi sono noti per soffrire di deriva, possono anche limitare i movimenti della mano e non consentono alla superficie della mano di entrare in contatto completo e diretto con le superfici dell'oggetto. Anche le soluzioni commerciali di tracciamento delle mani senza marker (ad esempio, il Leap Motion46,47,48) possono essere una possibilità, sebbene potrebbe non essere possibile tracciare le posizioni degli oggetti con questi soli sistemi. L'alternativa più promettente a un sistema di motion capture di livello di ricerca è data da soluzioni di tracciamento open-source e senza marker (ad esempio, Mathis et al.28). Se utilizzati con più telecamere co-registrate49, tali sistemi potrebbero potenzialmente tracciare le posizioni delle articolazioni delle mani e delle posizioni degli oggetti in 3D senza la necessità di marcatori, guanti o cavi. Queste soluzioni, così come questo sistema basato su marker, possono soffrire, tuttavia, di problemi di perdita di dati a causa di occlusioni.

Limiti e direzioni future

Poiché le ricostruzioni della mano ottenute attraverso questo metodo non saranno completamente accurate, ci sono alcune limitazioni ai tipi di esperimenti per i quali il metodo dovrebbe essere utilizzato. Le deviazioni nelle ricostruzioni della maglia della mano dalla verità del terreno si manifesteranno in deviazioni nelle regioni di contatto stimate mano / oggetto. Pertanto, l'applicazione di questo metodo per derivare misure assolute richiederebbe la valutazione della fedeltà delle stime della regione di contatto. Tuttavia, anche stime approssimative possono ancora essere utili nei disegni sperimentali all'interno dei partecipanti perché è probabile che i potenziali pregiudizi del metodo influenzino diverse condizioni sperimentali all'interno di un partecipante in modo simile. Pertanto, le analisi statistiche e le inferenze dovrebbero essere eseguite solo su misure come le differenze nell'area di contatto tra le condizioni, in cui la direzione di un effetto sarà correlata alla rispettiva verità di base. Nella ricerca futura, abbiamo in programma di convalidare ulteriormente il nostro approccio, ad esempio confrontando le stime della regione di contatto con le impronte digitali termiche su oggetti coperti di vernice termocromica.

La maggior parte delle fasi di elaborazione dalla raccolta dei dati alla stima della regione di contatto finale sono completamente automatizzate e, quindi, offrono importanti contributi verso una procedura standardizzata per la stima della regione di contatto mano-oggetto. Tuttavia, un adattamento iniziale degli scheletri individualizzati alle posizioni 3D dei marcatori tracciati deve ancora essere eseguito manualmente per ottenere una definizione di scheletro per ciascun partecipante. Con l'aumentare del numero di partecipanti a un esperimento, aumenta anche il numero di adattamenti manuali, e questa è attualmente la fase più dispendiosa in termini di tempo nella procedura e richiede una certa familiarità con il rigging manuale nel software Autodesk Maya. In futuro, miriamo ad automatizzare questo passaggio per evitare l'influenza umana sulla procedura aggiungendo una procedura di calibrazione automatica dello scheletro.

Il flusso di lavoro qui descritto si basa sull'hardware e sul software Qualisys (ad esempio, il solutore di scheletro QTM). Questo attualmente limita l'accessibilità del nostro metodo ai laboratori che hanno una configurazione simile. In linea di principio, tuttavia, il metodo può essere applicato a qualsiasi fonte di dati di motion capture. Per espandere l'accessibilità, nel lavoro in corso, stiamo esplorando alternative che dovrebbero generalizzare il nostro flusso di lavoro e renderlo meno dipendente da specifiche licenze hardware e software.

Un'altra importante limitazione del metodo è che, nella sua forma attuale, può essere applicato solo a oggetti rigidi (indeformabili). In futuro, questa limitazione potrebbe essere superata utilizzando metodi per registrare la forma della superficie dell'oggetto afferrato mentre si deforma. Inoltre, a causa della sua natura approssimativa, il metodo non è attualmente adatto a oggetti molto piccoli o sottili.

In conclusione, integrando il tracciamento del movimento all'avanguardia con la modellazione della superficie della mano ad alta fedeltà, forniamo un metodo per stimare le regioni di contatto mano-oggetto durante la presa e la manipolazione. Nella ricerca futura, abbiamo in programma di implementare questo metodo per indagare e modellare il comportamento di presa visivamente guidato negli esseri umani16. Abbiamo inoltre in programma di integrare questi strumenti con l'eye tracking 46,50,51,52 e i sistemi di realtà virtuale / aumentata 53,54,55 per indagare il controllo motorio del movimento delle mani e degli occhi guidato visivamente in ambienti naturalistici reali e virtuali 18,46,56,57 . Per questi motivi, il metodo proposto potrebbe essere di interesse per i ricercatori che studiano la percezione aptica58, il controllo motorio e l'interazione uomo-computer nella realtà virtuale e aumentata. Infine, misurazioni accurate delle capacità di presa umana potrebbero informare la progettazione di robusti sistemi robotici basati sui principi della percezione interattiva 39,40,41,42,43 e potrebbero avere applicazioni traslazionali per protesi degli arti superiori.

Divulgazioni

Gli autori dichiarano che non esistono interessi concorrenti.

Riconoscimenti

Questa ricerca è stata finanziata dalla Deutsche Forschungsgemeinschaft (DFG, German Research Foundation: progetto n. 222641018-SFB/TRR 135 TP C1 e IRTG-1901 "The Brain in Action") e dal Research Cluster "The Adaptive Mind" finanziato dal Programma di eccellenza del Ministero dell'istruzione superiore, della scienza, della ricerca e dell'arte dell'Assia. Gli autori ringraziano il team di supporto di Qualisys, tra cui Mathias Bankay e Jeffrey Thingvold, per l'assistenza nello sviluppo dei nostri metodi. Gli autori ringraziano anche Michaela Jeschke per aver posato come modella della mano. Tutti i dati e gli script di analisi per riprodurre il metodo e i risultati presentati nel manoscritto sono disponibili su Zenodo (doi: 10.5281/zenodo.7458911).

Materiali

| Name | Company | Catalog Number | Comments |

| Anaconda Python distribution | (Anaconda 5.3.1 or later); https://repo.anaconda.com/archive/ | scripts and functions were generated in Python version 3.7 | |

| Autodesk Maya | Autodesk, Inc. | Maya2022; https://www.autodesk.com/products/maya/overview | 3D computer graphics application. |

| Blender | Blender Foundation | Blender 2.92; https://download.blender.org/release/ | 3D computer graphics application. |

| Computer Workstation | N/A | N/A | OS: Windows 10 or higher. |

| DeepHandMesh | Meta Platforms, Inc. (Meta Open Source) | https://github.com/facebookresearch/DeepHandMesh | Pre-trained hand mesh generation tool. |

| Miqus M5 | Qualisys Ab | https://www.qualisys.com/cameras/miqus/ | Passive marker motion tracking camera (8 units). |

| Miqus video camera | Qualisys Ab | https://www.qualisys.com/cameras/miqus-video/ | Color video camera, synchronized with Miquis M5 tracking cameras (6 units). |

| Project repository | N/A | Data and Code Repository | Data and code to replicate the current project. The repository is currently under construction, but we provide a private link where reviewers can download the current and most up-to-date version of the repository. The final repository will be made publicly available upon acceptance. |

| Python 3 | Python Software Foundation | Python Version 3.7 | Python3 and associated built-in libraries. |

| QTM Connect for Maya | Qualisys Ab | https://github.com/qualisys/QTM-Connect-For-Maya | Stream skeleton, rigid bodies and marker data from QTM to Maya |

| QTM Qualisys Track Manager | Qualisys Ab | Qualisys Track Manager 2021.2; https://www.qualisys.com/software/qualisys-track-manager/ | Motion capture software |

| Qualisys SDK for Python | Qualisys Ab | https://github.com/qualisys/qualisys_python_sdk | Implements communication between QTM and Python |

Riferimenti

- Derzsi, Z., Volcic, R. MOTOM toolbox: MOtion Tracking via Optotrak and Matlab. Journal of Neuroscience Methods. 308, 129-134 (2018).

- Franz, V. H. Optotrak Toolbox. The Optotrak Toolbox: Control your Optotrak from within Matlab. , Available from: http://www.ecogsci.cs.uni-tuebingen.de/OptotrakToolbox/ (2004).

- Eloka, O., Franz, V. H. Effects of object shape on the visual guidance of action. Vision Research. 51 (8), 925-931 (2011).

- Lederman, S. J., Wing, A. M. Perceptual judgement, grasp point selection and object symmetry. Experimental Brain Research. 152 (2), 156-165 (2003).

- Schettino, L. F., Adamovich, S. V., Poizner, H. Effects of object shape and visual feedback on hand configuration during grasping. Experimental Brain Research. 151 (2), 158-166 (2003).

- Chen, Z., Saunders, J. A. Online processing of shape information for control of grasping. Experimental Brain Research. 233 (11), 3109-3124 (2015).

- Burstedt, M. K., Flanagan, J. R., Johansson, R. S. Control of grasp stability in humans under different frictional conditions during multidigit manipulation. Journal of Neurophysiology. 82 (5), 2393-2405 (1999).

- Paulun, V. C., Gegenfurtner, K. R., Goodale, M. A., Fleming, R. W. Effects of material properties and object orientation on precision grip kinematics. Experimental Brain Research. 234 (8), 2253-2265 (2016).

- Klein, L. K., Maiello, G., Fleming, R. W., Voudouris, D. Friction is preferred over grasp configuration in precision grip grasping. Journal of Neurophysiology. 125 (4), 1330-1338 (2021).

- Mamassian, P. Prehension of objects oriented in three-dimensional space. Experimental Brain Research. 114 (2), 235-245 (1997).

- Paulun, V. C., Kleinholdermann, U., Gegenfurtner, K. R., Smeets, J. B. J., Brenner, E. Center or side: biases in selecting grasp points on small bars. Experimental Brain Research. 232 (7), 2061-2072 (2014).

- Goodale, M. A., et al. Separate neural pathways for the visual analysis of object shape in perception and prehension. Current Biology. 4 (7), 604-610 (1994).

- Kleinholdermann, U., Franz, V. H., Gegenfurtner, K. R. Human grasp point selection. Journal of Vision. 13 (8), 23(2013).

- Maiello, G., Paulun, V. C., Klein, L. K., Fleming, R. W. Object visibility, not energy expenditure, accounts for spatial biases in human grasp selection. i-Perception. 10 (1), 204166951982760-20 (2019).

- Maiello, G., Schepko, M., Klein, L. K., Paulun, V. C., Fleming, R. W. Humans can visually judge grasp quality and refine their judgments through visual and haptic feedback. Frontiers in Neuroscience. 14, 591898(2021).

- Klein, L. K., Maiello, G., Paulun, V. C., Fleming, R. W. Predicting precision grip grasp locations on three-dimensional objects. PLoS Computational Biology. 16 (8), 1008081(2020).

- Maiello, G., Paulun, V. C., Klein, L. K., Fleming, R. W. The sequential-weight illusion. i-Perception. 9 (4), 204166951879027(2018).

- Chessa, M., Maiello, G., Klein, L. K., Paulun, V. C., Solari, F. Grasping objects in immersive Virtual Reality. 2019 IEEE Conference on Virtual Reality and 3D User Interfaces (VR). , 1749-1754 (2019).

- Crajé, C., Lukos, J. R., Ansuini, C., Gordon, A. M., Santello, M. The effects of task and content on digit placement on a bottle). Experimental Brain Research. 212 (1), 119-124 (2011).

- Lukos, J., Ansuini, C., Santello, M. Choice of contact points during multidigit grasping: Effect of predictability of object center of mass location. Journal of Neuroscience. 27 (14), 3894-3903 (2007).

- Gilster, R., Hesse, C., Deubel, H. Contact points during multidigit grasping of geometric objects. Experimental Brain Research. 217 (1), 137-151 (2012).

- Schot, W. D., Brenner, E., Smeets, J. B. J. Robust movement segmentation by combining multiple sources of information. Journal of Neuroscience Methods. 187 (2), 147-155 (2010).

- Sundaram, S., et al. Learning the signatures of the human grasp using a scalable tactile glove. Nature. 569 (7758), 698-702 (2019).

- Yan, Y., Goodman, J. M., Moore, D. D., Solla, S. A., Bensmaia, S. J. Unexpected complexity of everyday manual behaviors. Nature Communications. 11 (1), 3564(2020).

- Han, S., et al. Online optical marker-based hand tracking with deep labels. ACM Transactions on Graphics. 37 (4), 1-10 (2018).

- Clouthier, A. L., et al. Development and validation of a deep learning algorithm and open-source platform for the automatic labelling of motion capture markers. IEEE Access. 9, 36444-36454 (2021).

- Qualisys AB Qualisys Track Manager User Manual (Version 2022.1). , Available from: https://www.qualisys.com/ (2022).

- Mathis, A., et al. DeepLabCut: Markerless pose estimation of user-defined body parts with deep learning. Nature Neuroscience. 21 (9), 1281-1289 (2018).

- Moon, G., Shiratori, T., Lee, K. M. DeepHandMesh: A weakly-supervised deep encoder-decoder framework for high-fidelity hand mesh modeling. ECCV 2020. , (2020).

- Smith, B., et al. Constraining dense hand surface tracking with elasticity. ACM Transactions on Graphics. 39 (6), 219(2020).

- Taheri, O., Ghorbani, N., Black, M. J., Tzionas, D. GRAB: A dataset of whole-body human grasping of objects. Computer Vision - ECCV 2020: 16th European Conference. , Glasgow, UK. 581-600 (2020).

- Brahmbhatt, S., Tang, C., Twigg, C. D., Kemp, C. C., Hays, J. ContactPose: A dataset of grasps with object contact and hand pose. Computer Vision - ECCV 2020. , 361-378 (2020).

- Wang, J., et al. RGB2Hands: Real-time tracking of 3D hand interactions from monocular RGB video. ACM Transactions on Graphics. 39 (6), 218(2020).

- Zhang, X., Li, Q., Mo, H., Zhang, W., Zheng, W. End-to-end hand mesh recovery from a monocular RGB image. 2019 IEEE/CVF International Conference on Computer Vision (ICCV). , 2354-2364 (2019).

- Endo, Y., Tada, M., Mochimaru, M. Reconstructing individual hand models from motion capture data). Journal of Computational Design and Engineering. 1 (1), 1-12 (2014).

- Mueller, F., et al. GANerated hands for real-time 3D hand tracking from monocular RGB. 2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition. , 49-59 (2018).

- Mueller, F., et al. Real-time pose and shape reconstruction of two interacting hands with a single depth camera. ACM Transactions on Graphics. 38 (4), 49(2019).

- Romero, J., Tzionas, D., Black, M. J. Embodied hands: Modeling and capturing hands and bodies together. ACM Transactions on Graphics. 36 (6), 245(2017).

- Kappler, D., Bohg, J., Schaal, S. Leveraging big data for grasp planning. 2015 IEEE International Conference on Robotics and Automation (ICRA). , 4304-4311 (2015).

- Kokic, M., Kragic, D., Bohg, J. Learning task-oriented grasping from human activity datasets). IEEE Robotics and Automation Letters. 5 (2), 3352-3359 (2020).

- Shao, L., et al. UniGrasp: Learning a unified model to grasp with multifingered robotic hands. IEEE Robotics and Automation Letters. 5 (2), 2286-2293 (2020).

- Shao, L., Migimatsu, T., Zhang, Q., Yang, K., Bohg, J. Concept2Robot: Learning manipulation concepts from instructions and human demonstrations. Robotics: Science and Systems XVI. , (2020).

- Bohg, J. Interactive perception: Leveraging action in perception and perception in action. IEEE Transactions on Robotics. 33 (6), 1273-1291 (2017).

- Blender Foundation. , Available from: https://www.blender.org (2022).

- Roth, S. D. Ray casting for modeling solids. Computer Graphics and Image Processing. 18 (2), 109-144 (1982).

- Maiello, G., Kwon, M., Bex, P. J. Three-dimensional binocular eye-hand coordination in normal vision and with simulated visual impairment. Experimental Brain Research. 236 (3), 691-709 (2018).

- Weichert, F., Bachmann, D., Rudak, B., Fisseler, D. Analysis of the accuracy and robustness of the leap motion controller. Sensors. 13 (5), 6380-6393 (2013).

- Guna, J., Jakus, G., Pogačnik, M., Tomažič, S., Sodnik, J. An analysis of the precision and reliability of the leap motion sensor and its suitability for static and dynamic tracking. Sensors. 14 (2), 3702-3720 (2014).

- Sheshadri, S., Dann, B., Hueser, T., Scherberger, H. 3D reconstruction toolbox for behavior tracked with multiple cameras. Journal of Open Source Software. 5 (45), 1849(2020).

- Maiello, G., Harrison, W. J., Bex, P. J. Monocular and binocular contributions to oculomotor plasticity. Scientific Reports. 6, 31861(2016).

- Caoli, A., et al. A dichoptic feedback-based oculomotor training method to manipulate interocular alignment. Scientific Reports. 10, 15634(2020).

- Gibaldi, A., Vanegas, M., Bex, P. J., Maiello, G. Evaluation of the Tobii EyeX eye tracking controller and Matlab toolkit for research. Behavior Research Methods. 49 (3), 923-946 (2017).

- Chessa, M., Maiello, G., Borsari, A., Bex, P. J. The Perceptual quality of the Oculus Rift for immersive virtual reality. Human-Computer Interaction. 34 (1), 51-82 (2016).

- Maiello, G., Chessa, M., Bex, P. J., Solari, F. Near-optimal combination of disparity across a log-polar scaled visual field. PLoS Computational Biology. 16 (4), 1007699(2020).

- Maiello, G., Chessa, M., Solari, F., Bex, P. J. The (in)effectiveness of simulated blur for depth perception in naturalistic images. PLoS One. 10 (10), 0140230(2015).

- Maiello, G., Chessa, M., Solari, F., Bex, P. J. Simulated disparity and peripheral blur interact during binocular fusion. Journal of Vision. 14 (8), 13(2014).

- Maiello, G., Kerber, K. L., Thorn, F., Bex, P. J., Vera-Diaz, F. A. Vergence driven accommodation with simulated disparity in myopia and emmetropia. Experimental Eye Research. 166, 96-105 (2018).

- Moscatelli, A., et al. The change in fingertip contact area as a novel proprioceptive cue. Current Biology. 26 (9), 1159-1163 (2016).

Ristampe e Autorizzazioni

Richiedi autorizzazione per utilizzare il testo o le figure di questo articolo JoVE

Richiedi AutorizzazioneEsplora altri articoli

This article has been published

Video Coming Soon