Method Article

인간의 여러 자릿수 파지 중 손과 물체 사이의 접촉 영역 추정

요약

물체를 잡을 때 일반적으로 손가락과 손의 여러 영역이 물체의 표면과 접촉합니다. 이러한 접촉 영역을 재구성하는 것은 어려운 일입니다. 여기서는 마커 기반의 모션 캡쳐와 기존의 딥러닝 기반의 핸드 메시 재구성을 결합하여 접촉 영역을 대략적으로 추정하는 방법을 제시한다.

초록

물체를 성공적으로 잡으려면 물체 표면에서 손이 닿을 적절한 접촉 영역을 선택해야 합니다. 그러나 이러한 지역을 식별하는 것은 어렵습니다. 이 문서에서는 마커 기반 추적 데이터에서 접촉 영역을 추정하는 워크플로에 대해 설명합니다. 참가자는 실제 물체를 잡고 손가락 관절을 포함하여 물체와 손의 3D 위치를 추적합니다. 먼저 손등에 위치한 추적 마커 선택에서 조인트 오일러 각도를 결정합니다. 그런 다음 최첨단 손 메시 재구성 알고리즘을 사용하여 현재 포즈와 3D 위치에서 참가자 손의 메시 모델을 생성합니다.

3D 프린팅 또는 3D 스캔된 객체를 사용하여 실제 객체와 메시 데이터로 모두 사용할 수 있으므로 손 및 물체 메시를 공동 등록할 수 있습니다. 차례로, 이것은 핸드 메시와 공동 등록된 3D 오브젝트 메쉬 사이의 교차점을 계산하여 대략적인 접촉 영역의 추정을 가능하게 한다. 이 방법은 다양한 조건에서 인간이 물체를 잡는 위치와 방법을 추정하는 데 사용될 수 있습니다. 따라서 이 방법은 시각 및 촉각 인식, 운동 제어, 가상 및 증강 현실에서의 인간-컴퓨터 상호 작용, 로봇 공학을 연구하는 연구자들에게 흥미로울 수 있습니다.

서문

물체를 파악하고 조작하는 능력은 인간이 자신의 필요와 필요에 따라 환경을 재구성할 수 있도록 하는 핵심 능력입니다. 그러나 다관절 손을 효과적으로 제어하는 것은 정교한 제어 시스템이 필요한 어려운 작업입니다. 이 모터 제어 시스템은 여러 형태의 감각 입력에 의해 안내되며, 그 중 시력이 가장 중요합니다. 시각을 통해 개인은 환경의 물체를 식별하고 위치와 물리적 특성을 추정한 다음 이러한 물체에 쉽게 도달하고 파악 및 조작할 수 있습니다. 망막의 입력을 손을 제어하는 운동 명령과 연결하는 복잡한 시스템을 이해하는 것은 감각 운동 신경 과학의 핵심 과제입니다. 이 시스템이 어떻게 작동하는지 모델링, 예측 및 이해하려면 먼저 이 시스템을 자세히 연구할 수 있어야 합니다. 이를 위해서는 시각적 입력과 수동 모터 출력 모두에 대한 고충실도 측정이 필요합니다.

과거의 동작 추적 기술은 인간 파악 연구에 많은 제한을 가했습니다. 예를 들어, 참여자의 손(1,2)에 부착된 케이블을 필요로 하는 시스템은 손가락 동작의 범위를 제한하는 경향이 있으며, 잠재적으로 파지 움직임 또는 측정 자체를 변경할 수 있다. 이러한 한계에도 불구하고 이전 연구에서는 시각적 유도 파악에 영향을 미치는 몇 가지 요인을 식별할 수 있었습니다. 이러한 요인 중 일부는 물체 모양3, 4, 5, 6, 표면 거칠기7, 8, 9 또는 손4, 8, 10에 대한 물체의 방향을 포함합니다. 그러나 이전의 기술적 한계를 극복하기 위해 이 선행 연구의 대부분은 단순한 자극과 고도로 제한된 작업을 사용하여 주로 개별 요인 3,4,6,7,10, 두 자리 정밀 그립 3,4,6,9,11,12, 13,14,15,16,17,18, 단일 물체(19), 또는 매우 간단한 2D 모양(20,21). 이전 발견이 그러한 축소되고 인공적인 실험실 조건을 넘어 어떻게 일반화되는지는 알려져 있지 않습니다. 부가적으로, 손-물체 접촉의 측정은 종종 디지트 접촉점(22)의 추정으로 축소된다. 이 단순화는 손가락 끝만 물체와 접촉하는 작은 파악 하위 집합을 설명하는 데 적합할 수 있습니다. 그러나 대부분의 실제 그립에서는 손가락과 손바닥의 광범위한 영역이 물체와 접촉합니다. 또한, 최근 연구(23)는 햅틱 장갑을 사용하여 물체가 표면에 어떻게 영향을 미치는지에 의해 물체를 인식할 수 있음을 입증했습니다. 이것은 물체와 손가락 끝 사이의 접촉점뿐만 아니라 손과 잡은 물체 사이의 확장된 접촉 영역을 연구하는 것의 중요성을 강조한다(22).

모션 캡처 및 3D 손 모델링의 최근 발전으로 우리는 이전의 한계를 뛰어 넘고 완전한 복잡성을 파악하는 것을 연구 할 수있었습니다. 패시브 마커-기반 모션 트래킹은 이제 관절 움직임(24)을 추적하기 위해 참가자의 손등에 부착될 수 있는 밀리미터 크기의 마커와 함께 이용가능하다. 또한, 수동 마커 시스템을 위한 자동 마커 식별 알고리즘은 이제 마커 데이터(25,26,27)의 광범위한 수동 후처리에 대한 필요성을 거의 제거하기에 충분히 견고하다. 마커리스 솔루션은 또한 비디오28에서 동물의 신체 부위를 추적하는 데 인상적인 수준의 성능에 도달하고 있습니다. 따라서, 이러한 움직임-추적 방법들은 최종적으로 복잡한 다수 손 움직임들(24)의 신뢰성 있고 비침습적인 측정을 가능하게 한다. 이러한 측정은 관절 운동학에 대해 알려주고 손과 물체 사이의 접촉점을 추정할 수 있게 해줍니다. 또한, 최근 몇 년 동안, 컴퓨터 비전 커뮤니티는 물체를 잡는 동안, 그리고 심지어 손 부분들 사이의 자기 접촉 동안에도 연조직 변형을 복제할 수 있는 인간 손의 모델들을 구성하는 문제를 다루고 있다(29,30,31,32). 이러한 3D 메쉬 재구성은 비디오 영상(33, 34), 골격 관절(마커 기반(35) 또는 마커리스 트래킹(36)으로부터 유도됨), 및 깊이 이미지(37)와 같은 상이한 유형의 데이터로부터 유도될 수 있다. 이 영역의 첫 번째 주요 발전은 Romero et al.38에 의해 제공되었으며, 그는 다양한 포즈의 31명의 피험자로부터 1,000개 이상의 손 스캔에서 파라메트릭 손 모델(MANO)을 도출했습니다. 이 모델에는 손의 포즈와 모양 모두에 대한 매개 변수가 포함되어 있어 다양한 데이터 소스에서 전체 손 재구성으로의 회귀를 용이하게 합니다. 보다 최근의 DeepHandMesh29 솔루션은 딥 러닝을 통해 매개변수화된 모델을 구성하고 침투 회피를 추가하여 손 부분 간의 물리적 상호 작용을 보다 정확하게 복제함으로써 이러한 접근 방식을 기반으로 합니다. 이러한 손 메시 재구성을 3D 추적된 물체 메시와 결합시킴으로써, 이제 물체(32)의 표면뿐만 아니라 손의 표면 상의 접촉 영역을 추정하는 것이 가능하다.

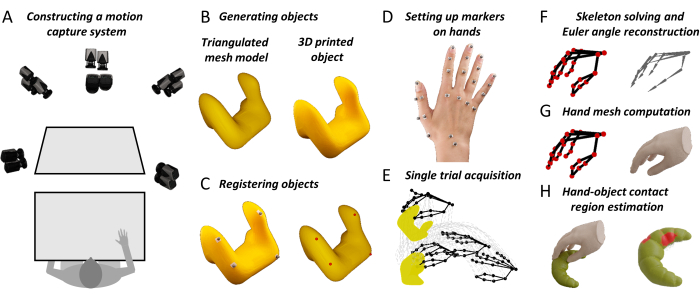

여기에서는 물체와 손 관절의 충실도가 높은 3D 추적을 새로운 손 메시 재구성 알고리즘과 결합하는 워크플로를 제안합니다. 이 방법은 손과 물체의 접촉면에 대한 상세한 지도를 생성합니다. 이러한 측정은 감각 운동 신경 과학자들이 인간의 시각 유도 파악에 대한 이론적 이해를 확장하는 데 도움이 될 것입니다. 또한, 이 방법은 인접 분야의 연구자들에게 유용할 수 있습니다. 예를 들어, 인적 요소 연구자들은 가상 현실 및 증강 현실(18)에서 더 나은 인간-기계 인터페이스 시스템을 구축하기 위해 이 방법을 사용할 수 있다. 인간의 파지 행동에 대한 충실도 측정은 또한 로봇 공학자가 상호 작용 인식 39,40,41,42,43의 원리에 기초하여 인간에서 영감을 받은 로봇 파지 시스템을 설계하는 데 도움이 될 수 있습니다. 따라서 우리는 이 방법이 고도로 제한된 작업에 대한 희박한 설명에서 복잡한 물체 및 실제 작업에 대한 자연주의적 파악 행동의 완전한 특성화에 이르기까지 신경과학 및 공학 분야 전반에 걸친 파악 연구를 발전시키는 데 도움이 되기를 바랍니다. 전반적인 접근 방식은 그림 1에 요약되어 있습니다.

그림 1: 제안된 방법의 주요 단계 . (A) 모션 캡처 카메라는 여러 각도에서 작업대를 이미지화합니다. (B) 자극 객체는 삼각 측량 메쉬 모델에서 3D 인쇄됩니다. (C) 4 개의 구형 반사 마커가 실제 물체의 표면에 접착됩니다. 반자동 절차는 메쉬 객체의 표면에서 4개의 해당 점을 식별합니다. 이러한 대응을 통해 메시 모델을 실제 객체의 3D 추적 위치로 로토 변환할 수 있습니다. (D) 반사 마커는 양면 테이프를 사용하여 참가자의 손등에 있는 다른 랜드마크에 부착됩니다. (E) 모션 캡쳐 시스템은 단일 시험 동안 추적된 물체 및 손 마커의 3D 공간에서 궤적을 획득합니다. (F) 참가자 별 손 골격은 3D 컴퓨터 그래픽 소프트웨어를 사용하여 구성됩니다. 그런 다음 역운동학을 통해 실험에서 각 시도의 각 프레임에 대해 골격 관절 자세를 추정합니다. (G) 관절 포즈는 DeepHandMesh29의 수정된 버전에 입력되며, 현재 3D 포즈 및 위치에서 추정된 3D 손 메시를 출력합니다. (H) 마지막으로 메쉬 교차를 사용하여 손-물체 접촉 영역을 계산합니다. 이 그림의 더 큰 버전을 보려면 여기를 클릭하십시오.

프로토콜

실험을 시작하기 전에 참가자는 기관 지침과 헬싱키 선언에 따라 정보에 입각한 동의를 제공해야 합니다. 여기에 설명된 모든 프로토콜은 Justus Liebig University Giessen(LEK-FB06)의 지역 윤리 위원회의 승인을 받았습니다.

1. 필요한 모든 소프트웨어 설치

- 데이터 및 코드 리포지토리에서 프로젝트 리포지토리를 다운로드합니다.

- 재료 표에 나열된 소프트웨어를 설치합니다(소프트웨어 버전을 기록하고 구매 옵션 및 지침에 대한 링크를 따르십시오).

- 데이터 및 코드 리포지토리 내에서 명령 창을 열고 다음 명령을 실행합니다.

conda env create -f environment.yml - https://github.com/facebookresearch/DeepHandMesh 에 제공된 지침에 따라 사전 훈련된 DeepHandMesh29 인스턴스화를 다운로드하고 설치합니다.

- DeepHandMesh를 Data and Code Repository의 "deephandmesh" 폴더에 배치합니다. "main/model.py" 파일을 데이터 및 코드 리포지토리에 포함된 model.py 파일로 바꿉니다.

2. 모션 캡쳐 시스템 준비

- 작업 공간을 둘러싼 프레임에 배열된 동작 추적 카메라로 여러 각도에서 이미지화된 추적 볼륨 내에 워크벤치를 배치합니다(그림 1A). 각 마커의 바닥에 양면 접착 테이프를 부착하여 반사 마커를 준비합니다.

- 관리자로 Qualisys Track Manager(QTM)를 실행합니다.

참고: Python SDK가 QTM 인터페이스를 제어하려면 관리자로 QTM을 실행해야 합니다. 항상 관리자로 QTM을 실행하는 것이 좋습니다.

3. 카메라 보정

- L자형 보정 개체를 추적 볼륨 내에 놓습니다.

- QTM의 Capture 메뉴에서 Calibrate를 클릭하거나 Capture 도구 모음 에서 지팡이 아이콘을 누릅니다. 보정 창이 열릴 때까지 기다립니다. 보정 기간을 선택하고 OK를 누릅니다.

- 보정 기간 동안 추적 볼륨에 걸쳐 보정 막대 를 흔듭니다. 내보내기( Export ) 버튼을 누르고 보정을 텍스트 파일로 내보낼 파일 경로를 지정합니다. OK를 눌러 보정을 수락합니다.

4. 자극 객체 만들기

- 가상 3D 개체 모델을 다각형 메시 형태로 구성합니다. 3D 프린터를 사용하여 개체 모델의 실제 복제본을 생성합니다.

참고: 1.1단계의 데이터 저장소는 STL 및 Wavefront OBJ 파일 형식의 예제 개체를 제공합니다. STL 형식의 개체는 다양하며 3D 프린팅 준비가 되어 있습니다.

5. 자극 대상 준비

- 4개의 비평면 반사 마커를 실제 물체의 표면에 부착합니다. 추적 볼륨 내에 개체를 배치합니다.

- 프로젝트 리포지토리에서 Python 스크립트 "Acquire_Object.py"를 실행합니다. 스크립트에서 제공하는 지침에 따라 개체 마커의 3D 위치를 1초 동안 캡처합니다.

- 강체의 모든 마커를 선택합니다. 를 마우스 오른쪽 버튼으로 클릭하고 Define Rigid Body (6DOF) | 현재 프레임. 강체의 이름을 입력하고 OK를 누릅니다.

- File(파일) 메뉴에서 Export(내보내기) | TSV로. 새 창에서 데이터 유형 설정에서 3D, 6D 및 스켈레톤 상자를 선택합니다. 일반 설정의 모든 확인란을 선택합니다. OK(확인)를 누른 다음 Save(저장)를 누릅니다.

6. 자극 객체의 실제 및 메쉬 모델 버전 공동 등록

- 블렌더를 열고 스크립팅 작업 공간으로 이동합니다. "Object_CoRegistration.py" 파일을 열고 실행을 누릅니다. 레이아웃 작업 영역으로 이동하고 n 키를 눌러 사이드바를 전환합니다. 사이드바 내에서 Custom(사용자 지정) 탭으로 이동합니다.

- 공동 등록할 .obj 파일을 선택하고 Load Object 버튼을 누릅니다.

- 3.3단계에서 내보낸 궤적 파일을 선택하고 강체 객체에 부착된 마커의 이름을 세미콜론으로 구분하여 지정합니다. 마커 헤더에서 데이터의 열 이름이 포함된 궤적 파일의 줄을 지정합니다(계산은 0부터 시작).

- 6D 접미어가 있는 해당 강체 파일을 선택하고 4.1단계에서 정의한 강체의 이름을 지정합니다. 6D 헤더에서 데이터의 열 이름이 포함된 강체 파일의 행을 지정합니다.

- 로드 마커를 누릅니다. Markers 개체 및/또는 Object 개체를 변환하고 회전하여 정렬합니다. 메시 출력 파일을 지정하고 Run Coregistration을 누릅니다. 이렇게 하면 공동 등록된 자극 메시가 포함된 .obj 파일이 출력됩니다.

7. 손에 마커 설정

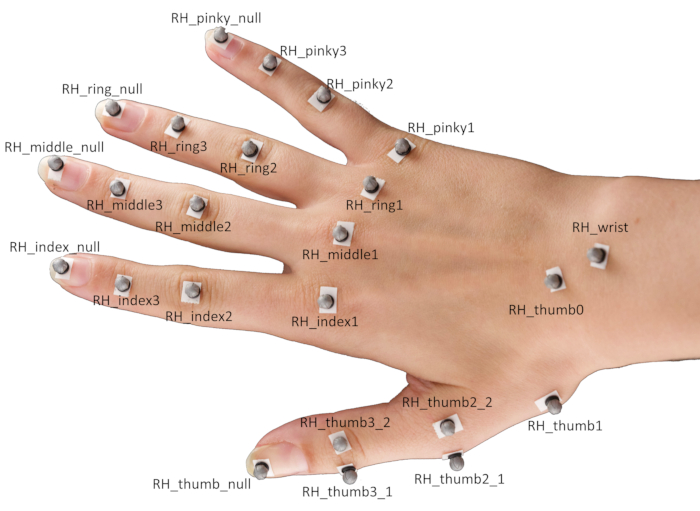

- 양면 테이프를 사용하여 참가자 손의 다른 랜드마크에 24개의 구형 반사 마커를 부착합니다.

알림: 마커의 특정 위치는 그림 2에 나와 있습니다.- 검지, 중지, 약지, 작지의 원위 지절간 관절, 근위 지절간 관절 및 중수골 관절뿐만 아니라 각 손가락 끝 중앙에 마커를 배치합니다.

- 엄지손가락의 경우 손가락 끝과 기저 수근중수골 관절에 각각 하나의 마커를 배치하고 중수골 관절과 지절간 관절에 각각 한 쌍의 마커를 배치합니다.

알림: 이 마커 쌍은 엄지손가락의 주축에 수직인 반대 방향으로 변위되어야 하며 엄지손가락의 방향을 추정하는 데 필요합니다. - 마지막으로 손목 중앙과 주상골사다리꼴 관절에 마커를 놓습니다.

그림 2: 참가자의 손에 마커 배치. 약어: RH = 오른손. 이 그림의 더 큰 버전을 보려면 여기를 클릭하십시오.

8. 단일 시험 획득

- 참가자에게 손바닥이 아래를 향하도록 작업대에 손을 평평하게 놓고 눈을 감으라고 합니다. 참가자 앞의 작업대에 자극 물체를 놓습니다.

- QTM이 실행되는 동안 프로젝트 저장소에서 Python 스크립트 "Single_Trial_Acquisition.py"를 실행합니다. 스크립트에서 제공하는 지침에 따라 자극 대상을 파악하는 참가자의 단일 시도를 캡처합니다.

참고: 스크립트는 청각 신호를 생성합니다. 이것은 참가자에게 눈을 뜨고 잡기를 실행하라는 신호를 보냅니다. 데모에서 작업은 대상 물체에 도달하여 잡고 수직으로 약 10cm 들어 올려 내려 놓고 손을 시작 위치로 되돌리는 것입니다.

9. 마커 라벨링

- QTM 내에서 개별 마커 궤적을 Unidentified 궤적에서 Labeled 궤적으로 끌어다 놓고 그림 2의 명명 규칙에 따라 레이블을 지정합니다.

- 핸드에 부착된 모든 마커를 선택하고 마우스 오른쪽 버튼을 클릭하고 선택 항목에서 AIM 모델 생성을 선택합니다. 새 창에서 기존 AIM 모델의 마커 연결을 기반으로 새 모델 만들기를 선택하고 다음 버튼을 누릅니다.

- RH_FH 모델 정의를 선택하고 열기(Open)를 누릅니다. Next(다음)를 누르고 AIM 모델의 이름을 입력한 다음 OK(확인)를 누릅니다. 마지막으로 Finish(마침)를 눌러 참가자의 손에 대한 AIM 모델을 생성하며, 이 모델은 동일한 참가자의 연속 시도에서 마커를 자동으로 식별하는 데 사용됩니다.

10. 참가자를 위한 개인화된 스켈레톤 정의 만들기

- QTM에서 Play(재생) 메뉴로 이동하고 Play with Real-Time Output(실시간 출력으로 재생)을 선택합니다.

- Maya를 엽니다. QTM Connect 선반으로 이동하고 QTM에 연결 아이콘을 누릅니다. 새 창에서 마커를 선택하고 연결을 누릅니다. 이제 QTM Connect 선반에서 재생 아이콘을 누릅니다.

- Shift 키를 누른 상태에서 모든 손 마커를 선택하고 워시 로케이터 아이콘을 누릅니다. 씻은 손 마커를 선택하고 Ctrl + G를 누릅니다. 그러면 그룹 노드가 생성됩니다. 그룹 이름을 Markers로 지정합니다.

- 모든 손 마커를 선택합니다. Modify( 수정 ) 메뉴에서 Search and Replace Names(이름 검색 및 바꾸기)를 클릭합니다. RH_ 접두어를 검색하고 마커의 접두어를 삭제합니다.

- QTM Connect 선반에서 Import Solver 아이콘을 누릅니다. 스켈레톤 정의 "RH_FH.xml"를 로드합니다.

- Windows 메뉴에서 General Editors | 네임스페이스 편집기. 새 창에서 :(root)를 클릭하고 새로 만들기를 눌러 새 네임스페이스 RH를 만듭니다. RH 네임스페이스를 클릭하고 New를 누른 다음 새 네임스페이스의 이름을 ModelPose로 지정합니다.

- 모든 마커를 선택하고 RH 네임스페이스를 클릭한 다음 Add Selected를 눌러 마커를 RH 네임스페이스에 추가합니다.

- 스켈레톤 본을 선택하고 ModelPose 네임스페이스를 클릭한 다음 Add Selected 를 눌러 스켈레톤 본을 ModelPose 네임스페이스에 추가합니다.

- 마커 데이터에 맞게 뼈대를 회전, 변환 및 배율 조정합니다. 그런 다음 각 스켈레톤 조인트에 대해 개별적으로 Shift + 스켈레톤 조인트 및 관련 마커를 선택하고 첨부 파일 추가 아이콘을 누릅니다. 마지막으로 솔버 내보내기 아이콘을 눌러 새 스켈레톤 정의를 QTM에 로드할 수 있는 XML 파일로 내보냅니다(다음 단계 참조).

참고: 이 단계는 반드시 필요한 것은 아니지만 마커 데이터에 대한 스켈레톤 피팅의 정확도를 높이는 데 유용합니다. 자세한 내용은 https://github.com/qualisys/QTM-Connect-For-Maya 의 QSolverQuickstartGuide 를 참조하십시오.

11. 관절 골격 관절 자세 재구성

- QTM에서 톱니바퀴 아이콘을 눌러 프로젝트 설정을 엽니다. 사이드바에서 Skeleton Solver로 이동하고 Load 키를 눌러 스켈레톤 정의 파일을 선택합니다. Scale Factor를 100%로 조정하고 Apply를 누릅니다.

- TSV 내보내기로 이동하고 데이터 유형 설정에서 3D, 6D 및 스켈레톤 확인란을 선택합니다. 일반 설정의 모든 확인란을 선택합니다. 적용을 누르고 프로젝트 설정을 닫습니다.

- Reprocess 아이콘을 누르고 스켈레톤 풀기 및 TSV 파일로 내보내기 확인란을 선택한 다음 OK를 누릅니다.

12. 핸드 메쉬 재구성 생성

- 프로젝트 리포지토리에서 명령 창을 열고 다음 명령을 실행하여 conda 환경을 활성화합니다.

conda 활성화 연락처 지역 - 그런 다음, 다음 명령을 실행하고 스크립트에서 제공하는 지침에 따라 시도의 각 프레임에 대해 현재 손 포즈를 재구성하는 손 메시를 생성합니다.

파이썬 Hand_Mesh_Reconstruction.py --gpu 0 --test_epoch 4

참고: 이러한 메시 재구성은 사전 훈련된 오픈 소스 핸드 메시 생성 도구인 DeepHandMesh29의 수정된 버전을 사용하여 자동으로 생성됩니다.

13. 손-물체 접촉 영역 추정값 생성

- 프로젝트 리포지토리에서 명령 창을 열고, 다음 명령을 실행하고, 스크립트에서 제공하는 지침에 따라 손 메시와 개체 메시 간의 교집합을 계산하여 손 및 개체 접촉 영역 추정치를 생성합니다.

블렌더 --background --python "Contact_Region_Estimation.py"

결과

제안된 방법에 대한 첫 번째 요구 사항은 3D 물체와 손의 위치를 정확하게 추적하는 시스템입니다. 구체적인 설정은 그림 1A 에 나와 있으며 모션 캡처 회사인 Qualisys에서 생산한 하드웨어와 소프트웨어를 사용합니다. 작업 공간을 둘러싼 입방체 프레임에 배열된 8개의 추적 카메라와 6개의 비디오 카메라로 여러 각도에서 이미지화되는 추적 볼륨(100cm x 100cm x 100cm) 내에 작업대를 배치합니다. 트래킹 카메라는 트래킹 볼륨 내에서 반사 마커의 3D 위치를 180 프레임/초로 3mm 미만의 3D 공간 해상도로 추적합니다. 우리는 피부 친화적 인 양면 접착 테이프를 사용하여 물체와 손에 부착되는 4mm 반사 마커를 사용합니다. 3D 마커 위치는 모션 캡처 소프트웨어에 의해 처리됩니다. 토론 섹션은 또한 제안된 방법과 함께 사용될 수 있는 대체 모션 캡처 시스템을 검토합니다.

파악 및 조작되는 실제 물체의 정확한 3D 재구성을 얻기 위해 두 가지 옵션을 제안합니다. 여기에서 채택한 첫 번째는 다각형 메쉬 형태의 가상 3D 개체 모델에서 시작하는 것입니다. 이러한 3D 모델은 적절한 소프트웨어(예: Blender 3D44)를 사용하여 구성한 다음 3D 프린팅할 수 있습니다(그림 1B). 두 번째 옵션은 기존의 실제 3D 물체를 가져와서 3D 스캐닝 기술을 사용하여 물체의 메시 모델 복제본을 구성하는 것입니다. 전략이 무엇이든 최종 목표는 실제 3D 개체와 해당 가상 3D 개체 메시 모델을 모두 얻는 것입니다. 여기서 설명하는 접근 방식은 단단한(즉, 변형할 수 없는) 개체에서만 작동합니다.

객체의 3D 표면을 메쉬 모델로 사용할 수 있게 되면 해당 위치를 추적하고 공동 등록해야 합니다(그림 1C). 이를 위해 4개의 비평면 반사 마커가 실제 물체의 표면에 부착되고 물체가 추적 볼륨 내에 배치됩니다. 그런 다음 개체 마커의 3D 위치가 간략하게 캡처됩니다. 이 캡처는 개체 메시 모델의 4개 마커와 4개 꼭짓점 간의 대응을 설정하는 데 사용됩니다. 이것은 블렌더의 파이썬 API로 작성된 간단한 임시 소프트웨어 경로를 사용하여 수행됩니다. 블렌더의 뷰포트 내에서 프로그램은 각 마커에 대해 하나의 구로 구성된 단일 메쉬 개체로 표현되는 마커 위치와 함께 가상 개체를 제공합니다. 그 후, 사용자는 오브젝트 및/또는 마커를 회전하고 변환하여 이들이 실제 오브젝트 상에 배치된 실제 마커들과 함께 정렬되도록 정렬할 수 있다. 이 프로그램은 원래 객체 메쉬에 최종적으로 적용되는 단일 로토 변환을 계산하기 위해 적용되는 회전 및 변환을 등록하여 QTM의 강체 정의와 함께 등록된 객체 메쉬를 제공합니다.

대응을 확립하면, 실제 객체가 추적 볼륨 내에서 이동할 때마다, 가상 객체는 추적된 마커와 4개의 대응하는 메시 꼭짓점 사이의 로토 변환을 계산하여 새로운 위치에 배치될 수 있다. 대신 그립의 역학을 기록하기 위해 양면 테이프를 사용하여 총 24개의 구형 반사 마커를 손의 다른 랜드마크에 부착합니다(그림 1D 및 그림 2).

시험 시작 시(그림 1E) 참가자는 손바닥이 아래를 향하도록 작업대에 손을 평평하게 놓고 눈을 감습니다. 실험자는 참가자 앞의 작업대에 대상 개체를 놓습니다. 다음으로, 청각 신호는 참가자에게 눈을 뜨고 파악을 실행하라는 신호를 보냅니다. 데모에서 작업은 대상 물체에 도달하여 잡고 수직으로 약 10cm 들어 올려 내려 놓고 손을 시작 위치로 되돌리는 것입니다. Python 3.7로 작성된 스크립트가 실험을 제어합니다. 각 시도에서 스크립트는 현재 조건 설정(예: 개체 식별 및 위치 지정)을 선택하여 실험자에게 전달합니다. 스크립트는 또한 청각 신호와 모션 캡처 녹화의 시작 및 중지를 포함한 시도 타이밍을 제어합니다.

팔다리는 3D 공간에서의 위치뿐만 아니라 포즈로도 특징지어집니다. 따라서 실제 그립을 실행하는 사람의 손을 완전히 3D로 재구성하려면 3D 공간에서 각 관절의 위치뿐만 아니라 부모 관절에 대한 각 관절의 상대적인 자세(평행 이동 및 회전)도 필요합니다(그림 1F). 골격 관절 위치 및 방향은 역 운동학을 사용하여 마커 위치에서 추론할 수 있습니다. 이를 위해 QTM 소프트웨어에서 제공하는 스켈레톤 솔버를 사용합니다. 솔버가 작동하려면 먼저 각 조인트의 위치와 방향을 여러 마커 위치에 연결하는 골격 정의를 제공해야 합니다. 따라서 스켈레톤 정의가 구성되고 스켈레톤 리그는 Maya용 QTM Connect 플러그인을 사용하여 마커 데이터에 연결됩니다. 마커 데이터에 대한 스켈레톤 피팅의 정확도를 최대화하기 위해 각 참가자에 대해 개인화된 스켈레톤 정의를 만듭니다. 각 참가자에 대해 손 골격을 모션 캡처 데이터의 단일 프레임에 수동으로 맞춥니다. 참가자별 골격 정의를 얻은 후 골격 솔버를 실행하여 실험에서 각 시행의 각 프레임에 대한 골격 관절 포즈를 추정합니다.

실험에서 각 시도의 각 프레임에 대해 오픈 소스 및 사전 훈련된 손 메시 생성 도구인 DeepHandMesh28 을 사용하여 현재 손 포즈를 재구성하는 손 메시를 생성합니다(그림 1G). DeepHandMesh는 이미지에서 개인화된 손 메시를 생성하는 딥 인코더-디코더 네트워크입니다. 먼저 인코더는 이미지 내에서 손의 포즈(즉, 조인트 오일러 각도)를 추정합니다. 그런 다음 추정된 손 포즈와 개인화된 ID 벡터가 디코더에 입력되어 리깅된 템플릿 메시에 대한 3개의 추가 수정 세트를 추정합니다. 마지막으로, 템플릿 메시는 선형 블렌드 스키닝을 사용하여 추정된 손 포즈와 교정에 따라 변형됩니다. 첫 번째 교정은 사람별 관절 위치를 통합하도록 골격 장비를 조정하는 ID 종속 골격 교정입니다. 다른 두 개의 수정은 참가자의 손 표면을 더 잘 나타내기 위해 메쉬 꼭짓점이 조정되는 메쉬 수정입니다. 메쉬 교정 중 하나는 개별 참가자 손의 표면 구조를 설명하는 ID 종속 메쉬 교정입니다. 대신 최종 메시 수정은 현재 손 포즈로 인한 손 표면 변형을 설명하는 포즈 종속 꼭짓점 수정입니다.

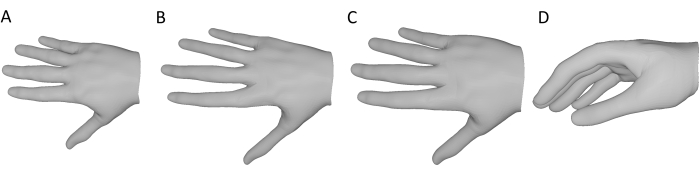

DeepHandMesh는 2D 조인트 키 포인트 및 씬 깊이 맵과 함께 약한 감독을 사용하여 훈련됩니다. 여기서는 사전 훈련된 DeepHandMesh 디코더만 사용하여 다음과 같은 방식으로 수정된 손 메시 재구성을 생성합니다(그림 3). 첫째, 신경망이 특정 참여자에 대해 훈련되지 않았기 때문에 사전 훈련된 모델과 함께 제공되는 일반 ID 종속 메시 교정이 사용됩니다(그림 3A). 또한, ID 종속 골격 교정은 위에서 설명한 대로 QTM 골격 솔버를 사용하여 도출됩니다(그림 3B). 스켈레톤 길이와 손의 비례 스케일링이 가정되고, 메쉬 두께는 스켈레톤의 상대적 스케일링에서 파생된 요인에 의해 균일하게 스케일링되어 메쉬가 참가자의 손 크기에 더 잘 근접하도록 합니다(그림 3C). 이 수정된 메시는 현재 손 포즈(마커 데이터에서 파생됨) 및 손목의 3D 위치 및 방향과 함께 디코더에 입력됩니다. 따라서 디코더는 현재 포즈 종속 수정을 계산하고, 모든 수정 및 로토 변환을 적용하고, 3D 추적된 개체 메시와 동일한 좌표 프레임에서 현재 손 포즈의 3D 손 메시 재구성을 출력합니다(그림 3D).

그림 3: 사전 훈련된 DeepHandMesh 디코더에 대한 수정 사항 . (A) 고정된 일반 ID 종속 메시 수정. (B) 단계 10에서 역운동학을 통해 도출된 ID 의존적 골격 교정. (C) 핸드 메쉬의 크기는 골격 관절과 동일한 계수로 조정됩니다. (D) 현재 손 포즈의 최종 3D 손 메시 재구성. 이 그림의 더 큰 버전을 보려면 여기를 클릭하십시오.

참가자의 손과 잡은 물체 모두에 대해 3D 메시 모델을 재구성한 후, 손과 물체 메시 사이의 교차점을 계산하여 손-물체 접촉 영역을 추정할 수 있습니다(그림 1H). 이 가정은 실제 손이 표면과의 접촉에 의해 변형된다는 것인데, 이는 손이 단단할 때보다 스켈레톤이 표면에 더 가까이 다가올 수 있다는 것을 의미하며, 이로 인해 손 메시의 일부가 오브젝트 메시를 통과할 수 있습니다. 결과적으로 접촉 영역은 두 메시 사이의 중첩 영역으로 근사화될 수 있습니다.

특히, 이러한 겹침 영역을 계산하기 위해 손 메시의 3D 볼륨 내에 포함된 개체 메시 꼭짓점을 손과 접촉하는 것으로 정의합니다. 이러한 꼭짓점들은 표준 레이트레이싱 접근법(45)을 사용하여 식별된다. 개체 메시의 각 꼭짓점에 대해 광선은 해당 꼭짓점에서 손 메시 외부의 임의의 3D 점으로 캐스팅됩니다. 그런 다음 캐스트 광선과 손 표면을 구성하는 삼각형 사이에서 발생하는 교차점의 수를 평가합니다. 교차 수가 홀수이면 개체 꼭짓점이 손 메시 안에 포함됩니다. 교집합 수가 짝수이면 객체 꼭짓점이 손 메시 외부에 있습니다. 따라서 개체 표면의 접촉 영역은 꼭짓점이 모두 손 메시 내에 포함된 삼각형 면 집합으로 근사화할 수 있습니다. 객체 메쉬의 3D 볼륨에 포함된 손 메시 꼭짓점에 동일한 근거를 적용하여 손 표면의 접촉 영역을 추정할 수 있습니다. 특히, 부울 메쉬 연산에 대한 보다 진보된 접근법도 사용될 수 있다31.

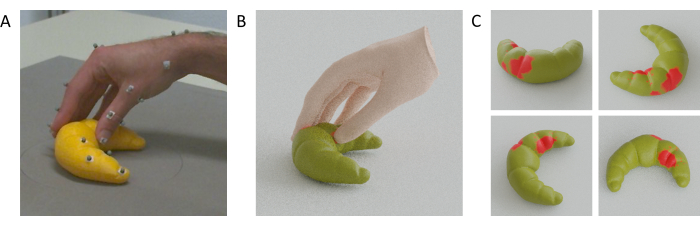

비디오 1은 3D 프린팅된 고양이 피규어를 한 번 잡는 동안 손, 추적된 지점 및 공동 등록된 메시가 모두 나란히 움직이는 비디오를 보여줍니다. 그림 4A는 대신 손-물체가 3D 프린팅된 크루아상으로 접촉할 때의 단일 프레임과 손-물체 메쉬 재구성(그림 4B) 및 크루아상 표면의 추정된 접촉 영역(그림 4C)을 보여줍니다.

그림 4: 추정된 손-물체 접촉 영역. (A) 잡는 동안 추적 카메라 중 하나에서 본 추적된 손과 물체. (B) 트래킹 카메라와 동일한 시점에서 렌더링된 재구성된 핸드 메쉬 및 트래킹 오브젝트 메쉬. (C) 여러 관점에서 본 물체 표면의 접촉 영역. 이 그림의 더 큰 버전을 보려면 여기를 클릭하십시오.

비디오 1: 손과 물체의 메쉬 재구성. 손의 GIF 애니메이션, 추적된 마커, 동일한 카메라 관점에서 볼 때 한 번 잡는 동안 손 및 개체 메시 재구성. 이 비디오를 다운로드하려면 여기를 클릭하십시오.

토론

우리는 여러 자릿수 파악 동안 손-물체 상호 작용에 대한 접촉 영역을 추정할 수 있는 방법을 제안합니다. 손의 전체 표면을 완전히 추적하는 것은 현재 다루기 어렵기 때문에 손의 희박한 키 포인트에 의해 포즈가 결정되는 손 메쉬의 재구성을 사용하는 것이 좋습니다. 이러한 희박한 핵심 포인트를 추적하기 위해 당사 솔루션은 수동 마커 추적을 기반으로 하는 연구 수준의 모션 캡처 시스템을 사용합니다. 물론, 다른 모션 캡쳐 시스템들도 제안된 방법과 함께 사용될 수 있으며, 이들이 충분히 정확한 3D 위치 데이터를 산출할 수 있다. 액티브 마커 모션 캡처 시스템(예: 널리 사용되지만 단종된 Optotrak Certus)은 참가자의 손에 케이블 및/또는 전자 장치를 부착해야 하므로 참가자가 손의 자세를 더 의식적으로 인식하게 됨에 따라 움직임을 제한하거나 최소한 덜 일반적인 그립을 생성할 수 있기 때문에 권장하지 않습니다. 관성 측정 장치를 사용하는 모션 추적 장갑은 이러한 시스템이 드리프트를 겪는 것으로 알려져 있지만 손의 움직임을 제한 할 수 있으며 손 표면이 물체 표면과 완전히 직접 접촉하는 것을 허용하지 않을 수 있습니다. 상업적인 마커리스 핸드-트래킹 솔루션들(예를 들면, 도약 모션(Leap Motion)(46,47,48))이 또한 가능할 수 있지만, 이들 시스템들만으로는 물체 위치들을 추적하는 것이 불가능할 수도 있다. 연구용 모션 캡처 시스템에 대한 가장 유망한 대안은 오픈 소스, 마커리스 추적 솔루션(예: Mathis et al.28)에 의해 제공됩니다. 다수의 공동 등록된 카메라(49)와 함께 사용되는 경우, 이러한 시스템은 마커, 장갑 또는 케이블의 필요 없이 3D에서 손 관절 위치 및 물체 위치를 잠재적으로 추적할 수 있다. 그러나 이러한 솔루션과 이 마커 기반 시스템은 폐색으로 인한 데이터 손실 문제로 어려움을 겪을 수 있습니다.

한계와 향후 방향

이 방법을 통해 얻은 손 재구성은 완전히 정확하지 않기 때문에 방법을 사용해야 하는 실험 유형에는 몇 가지 제한이 있습니다. 실측 자료에서 손 메시 재구성의 편차는 추정된 손/물체 접촉 영역의 편차로 나타납니다. 따라서 절대적 측정값을 도출하기 위해 이 방법을 적용하려면 접촉 영역 추정치의 충실도를 평가해야 합니다. 그러나 대략적인 추정치조차도 방법의 잠재적 편향이 유사한 방식으로 참가자 내의 다른 실험 조건에 영향을 미칠 가능성이 있기 때문에 참가자 내 실험 설계에서 여전히 유용 할 수 있습니다. 따라서 통계 분석 및 추론은 조건의 접촉 면적 차이와 같은 측정에 대해서만 수행되어야 하며, 여기서 효과의 방향은 각각의 실측 자료와 상관관계가 있습니다. 향후 연구에서, 우리는 예를 들어 접촉 영역 추정치를 열 변색 페인트로 덮인 물체의 열 지문과 비교하여 우리의 접근 방식을 추가로 검증 할 계획입니다.

데이터 수집에서 최종 접촉 영역 추정에 이르는 대부분의 처리 단계는 완전히 자동화되어 있으므로 손-물체 접촉 영역 추정을 위한 표준화된 절차에 중요한 기여를 합니다. 그러나 추적된 마커의 3D 위치에 대한 개별화된 스켈레톤의 초기 피팅은 각 참가자에 대한 스켈레톤 정의를 얻기 위해 여전히 수동으로 수행되어야 합니다. 실험 참가자 수가 증가함에 따라 수동 맞춤 수도 증가하며, 이는 현재 절차에서 가장 시간이 많이 소요되는 단계이며 Autodesk Maya 소프트웨어의 수동 리깅에 대해 어느 정도 알고 있어야 합니다. 앞으로는 자동 스켈레톤 보정 절차를 추가하여 절차에 대한 사람의 영향을 피하기 위해 이 단계를 자동화하는 것을 목표로 합니다.

여기에 설명된 워크플로는 Qualisys 하드웨어 및 소프트웨어(예: QTM 스켈레톤 솔버)에 의존합니다. 이것은 현재 유사한 설정을 가진 실험실에 대한 우리 방법의 접근성을 제한합니다. 그러나, 원칙적으로, 이 방법은 모션 캡쳐 데이터의 모든 소스에 적용될 수 있다. 접근성을 확장하기 위해 진행 중인 작업에서 워크플로를 일반화하고 특정 하드웨어 및 소프트웨어 라이선스에 대한 의존도를 낮출 수 있는 대안을 모색하고 있습니다.

이 방법의 또 다른 중요한 한계는 현재 형태로는 단단한(변형할 수 없는) 물체에만 적용할 수 있다는 것입니다. 미래에는 잡은 물체가 변형될 때 표면 모양을 기록하는 방법을 사용하여 이러한 한계를 극복할 수 있습니다. 또한 대략적인 특성으로 인해 이 방법은 현재 매우 작거나 얇은 물체에 적합하지 않습니다.

결론적으로, 최첨단 모션 트래킹과 고충실도 손 표면 모델링을 통합하여 파지 및 조작 시 손-물체 접촉 영역을 추정하는 방법을 제공합니다. 향후 연구에서는 이 방법을 사용하여 인간의 시각적 유도 파악 행동을 조사하고 모델링할 계획입니다 16. 우리는 또한 이러한 도구를 아이 트래킹(46,50,51,52) 및 가상/증강 현실 시스템(53,54,55)과 통합하여 실제 및 가상 자연주의 환경(18,46,56,57)에서 시각적으로 유도된 손 및 안구 운동 모터 제어를 조사할 계획이다. 이러한 이유로, 제안된 방법은 가상 및 증강 현실에서 햅틱 인식(58), 운동 제어 및 인간-컴퓨터 상호작용을 연구하는 연구자들에게 흥미로울 수 있다. 마지막으로, 인간의 파지 능력의 정확한 측정은 상호 작용 지각 39,40,41,42,43의 원리에 기초한 견고한 로봇 시스템의 설계에 정보를 제공 할 수 있으며 상지 보철물에 대한 번역 응용 프로그램을 가질 수 있습니다.

공개

저자는 경쟁 이익이 존재하지 않는다고 선언합니다.

감사의 말

이 연구는 Deutsche Forschungsgemeinschaft (DFG, 독일 연구 재단 : 프로젝트 번호 222641018-SFB / TRR 135 TP C1 및 IRTG-1901 "The Brain in Action")와 Hessian Ministry of Higher Education, Science, Research, and Art의 우수 프로그램 (Excellence Program)이 자금을 지원하는 연구 클러스터 "The Adaptive Mind"가 자금을 지원했습니다. 저자는 분석법 개발에 도움을 준 Mathias Bankay와 Jeffrey Thingvold를 포함한 Qualisys 지원팀에 감사를 표합니다. 저자는 또한 손 모델로 포즈를 취한 Michaela Jeschke에게 감사를 표합니다. 원고에 제시된 방법과 결과를 재현하기 위한 모든 데이터 및 분석 스크립트는 Zenodo(doi: 10.5281/zenodo.7458911)에서 사용할 수 있습니다.

자료

| Name | Company | Catalog Number | Comments |

| Anaconda Python distribution | (Anaconda 5.3.1 or later); https://repo.anaconda.com/archive/ | scripts and functions were generated in Python version 3.7 | |

| Autodesk Maya | Autodesk, Inc. | Maya2022; https://www.autodesk.com/products/maya/overview | 3D computer graphics application. |

| Blender | Blender Foundation | Blender 2.92; https://download.blender.org/release/ | 3D computer graphics application. |

| Computer Workstation | N/A | N/A | OS: Windows 10 or higher. |

| DeepHandMesh | Meta Platforms, Inc. (Meta Open Source) | https://github.com/facebookresearch/DeepHandMesh | Pre-trained hand mesh generation tool. |

| Miqus M5 | Qualisys Ab | https://www.qualisys.com/cameras/miqus/ | Passive marker motion tracking camera (8 units). |

| Miqus video camera | Qualisys Ab | https://www.qualisys.com/cameras/miqus-video/ | Color video camera, synchronized with Miquis M5 tracking cameras (6 units). |

| Project repository | N/A | Data and Code Repository | Data and code to replicate the current project. The repository is currently under construction, but we provide a private link where reviewers can download the current and most up-to-date version of the repository. The final repository will be made publicly available upon acceptance. |

| Python 3 | Python Software Foundation | Python Version 3.7 | Python3 and associated built-in libraries. |

| QTM Connect for Maya | Qualisys Ab | https://github.com/qualisys/QTM-Connect-For-Maya | Stream skeleton, rigid bodies and marker data from QTM to Maya |

| QTM Qualisys Track Manager | Qualisys Ab | Qualisys Track Manager 2021.2; https://www.qualisys.com/software/qualisys-track-manager/ | Motion capture software |

| Qualisys SDK for Python | Qualisys Ab | https://github.com/qualisys/qualisys_python_sdk | Implements communication between QTM and Python |

참고문헌

- Derzsi, Z., Volcic, R. MOTOM toolbox: MOtion Tracking via Optotrak and Matlab. Journal of Neuroscience Methods. 308, 129-134 (2018).

- Franz, V. H. Optotrak Toolbox. The Optotrak Toolbox: Control your Optotrak from within Matlab. , Available from: http://www.ecogsci.cs.uni-tuebingen.de/OptotrakToolbox/ (2004).

- Eloka, O., Franz, V. H. Effects of object shape on the visual guidance of action. Vision Research. 51 (8), 925-931 (2011).

- Lederman, S. J., Wing, A. M. Perceptual judgement, grasp point selection and object symmetry. Experimental Brain Research. 152 (2), 156-165 (2003).

- Schettino, L. F., Adamovich, S. V., Poizner, H. Effects of object shape and visual feedback on hand configuration during grasping. Experimental Brain Research. 151 (2), 158-166 (2003).

- Chen, Z., Saunders, J. A. Online processing of shape information for control of grasping. Experimental Brain Research. 233 (11), 3109-3124 (2015).

- Burstedt, M. K., Flanagan, J. R., Johansson, R. S. Control of grasp stability in humans under different frictional conditions during multidigit manipulation. Journal of Neurophysiology. 82 (5), 2393-2405 (1999).

- Paulun, V. C., Gegenfurtner, K. R., Goodale, M. A., Fleming, R. W. Effects of material properties and object orientation on precision grip kinematics. Experimental Brain Research. 234 (8), 2253-2265 (2016).

- Klein, L. K., Maiello, G., Fleming, R. W., Voudouris, D. Friction is preferred over grasp configuration in precision grip grasping. Journal of Neurophysiology. 125 (4), 1330-1338 (2021).

- Mamassian, P. Prehension of objects oriented in three-dimensional space. Experimental Brain Research. 114 (2), 235-245 (1997).

- Paulun, V. C., Kleinholdermann, U., Gegenfurtner, K. R., Smeets, J. B. J., Brenner, E. Center or side: biases in selecting grasp points on small bars. Experimental Brain Research. 232 (7), 2061-2072 (2014).

- Goodale, M. A., et al. Separate neural pathways for the visual analysis of object shape in perception and prehension. Current Biology. 4 (7), 604-610 (1994).

- Kleinholdermann, U., Franz, V. H., Gegenfurtner, K. R. Human grasp point selection. Journal of Vision. 13 (8), 23(2013).

- Maiello, G., Paulun, V. C., Klein, L. K., Fleming, R. W. Object visibility, not energy expenditure, accounts for spatial biases in human grasp selection. i-Perception. 10 (1), 204166951982760-20 (2019).

- Maiello, G., Schepko, M., Klein, L. K., Paulun, V. C., Fleming, R. W. Humans can visually judge grasp quality and refine their judgments through visual and haptic feedback. Frontiers in Neuroscience. 14, 591898(2021).

- Klein, L. K., Maiello, G., Paulun, V. C., Fleming, R. W. Predicting precision grip grasp locations on three-dimensional objects. PLoS Computational Biology. 16 (8), 1008081(2020).

- Maiello, G., Paulun, V. C., Klein, L. K., Fleming, R. W. The sequential-weight illusion. i-Perception. 9 (4), 204166951879027(2018).

- Chessa, M., Maiello, G., Klein, L. K., Paulun, V. C., Solari, F. Grasping objects in immersive Virtual Reality. 2019 IEEE Conference on Virtual Reality and 3D User Interfaces (VR). , 1749-1754 (2019).

- Crajé, C., Lukos, J. R., Ansuini, C., Gordon, A. M., Santello, M. The effects of task and content on digit placement on a bottle). Experimental Brain Research. 212 (1), 119-124 (2011).

- Lukos, J., Ansuini, C., Santello, M. Choice of contact points during multidigit grasping: Effect of predictability of object center of mass location. Journal of Neuroscience. 27 (14), 3894-3903 (2007).

- Gilster, R., Hesse, C., Deubel, H. Contact points during multidigit grasping of geometric objects. Experimental Brain Research. 217 (1), 137-151 (2012).

- Schot, W. D., Brenner, E., Smeets, J. B. J. Robust movement segmentation by combining multiple sources of information. Journal of Neuroscience Methods. 187 (2), 147-155 (2010).

- Sundaram, S., et al. Learning the signatures of the human grasp using a scalable tactile glove. Nature. 569 (7758), 698-702 (2019).

- Yan, Y., Goodman, J. M., Moore, D. D., Solla, S. A., Bensmaia, S. J. Unexpected complexity of everyday manual behaviors. Nature Communications. 11 (1), 3564(2020).

- Han, S., et al. Online optical marker-based hand tracking with deep labels. ACM Transactions on Graphics. 37 (4), 1-10 (2018).

- Clouthier, A. L., et al. Development and validation of a deep learning algorithm and open-source platform for the automatic labelling of motion capture markers. IEEE Access. 9, 36444-36454 (2021).

- Qualisys AB Qualisys Track Manager User Manual (Version 2022.1). , Available from: https://www.qualisys.com/ (2022).

- Mathis, A., et al. DeepLabCut: Markerless pose estimation of user-defined body parts with deep learning. Nature Neuroscience. 21 (9), 1281-1289 (2018).

- Moon, G., Shiratori, T., Lee, K. M. DeepHandMesh: A weakly-supervised deep encoder-decoder framework for high-fidelity hand mesh modeling. ECCV 2020. , (2020).

- Smith, B., et al. Constraining dense hand surface tracking with elasticity. ACM Transactions on Graphics. 39 (6), 219(2020).

- Taheri, O., Ghorbani, N., Black, M. J., Tzionas, D. GRAB: A dataset of whole-body human grasping of objects. Computer Vision - ECCV 2020: 16th European Conference. , Glasgow, UK. 581-600 (2020).

- Brahmbhatt, S., Tang, C., Twigg, C. D., Kemp, C. C., Hays, J. ContactPose: A dataset of grasps with object contact and hand pose. Computer Vision - ECCV 2020. , 361-378 (2020).

- Wang, J., et al. RGB2Hands: Real-time tracking of 3D hand interactions from monocular RGB video. ACM Transactions on Graphics. 39 (6), 218(2020).

- Zhang, X., Li, Q., Mo, H., Zhang, W., Zheng, W. End-to-end hand mesh recovery from a monocular RGB image. 2019 IEEE/CVF International Conference on Computer Vision (ICCV). , 2354-2364 (2019).

- Endo, Y., Tada, M., Mochimaru, M. Reconstructing individual hand models from motion capture data). Journal of Computational Design and Engineering. 1 (1), 1-12 (2014).

- Mueller, F., et al. GANerated hands for real-time 3D hand tracking from monocular RGB. 2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition. , 49-59 (2018).

- Mueller, F., et al. Real-time pose and shape reconstruction of two interacting hands with a single depth camera. ACM Transactions on Graphics. 38 (4), 49(2019).

- Romero, J., Tzionas, D., Black, M. J. Embodied hands: Modeling and capturing hands and bodies together. ACM Transactions on Graphics. 36 (6), 245(2017).

- Kappler, D., Bohg, J., Schaal, S. Leveraging big data for grasp planning. 2015 IEEE International Conference on Robotics and Automation (ICRA). , 4304-4311 (2015).

- Kokic, M., Kragic, D., Bohg, J. Learning task-oriented grasping from human activity datasets). IEEE Robotics and Automation Letters. 5 (2), 3352-3359 (2020).

- Shao, L., et al. UniGrasp: Learning a unified model to grasp with multifingered robotic hands. IEEE Robotics and Automation Letters. 5 (2), 2286-2293 (2020).

- Shao, L., Migimatsu, T., Zhang, Q., Yang, K., Bohg, J. Concept2Robot: Learning manipulation concepts from instructions and human demonstrations. Robotics: Science and Systems XVI. , (2020).

- Bohg, J. Interactive perception: Leveraging action in perception and perception in action. IEEE Transactions on Robotics. 33 (6), 1273-1291 (2017).

- Blender Foundation. , Available from: https://www.blender.org (2022).

- Roth, S. D. Ray casting for modeling solids. Computer Graphics and Image Processing. 18 (2), 109-144 (1982).

- Maiello, G., Kwon, M., Bex, P. J. Three-dimensional binocular eye-hand coordination in normal vision and with simulated visual impairment. Experimental Brain Research. 236 (3), 691-709 (2018).

- Weichert, F., Bachmann, D., Rudak, B., Fisseler, D. Analysis of the accuracy and robustness of the leap motion controller. Sensors. 13 (5), 6380-6393 (2013).

- Guna, J., Jakus, G., Pogačnik, M., Tomažič, S., Sodnik, J. An analysis of the precision and reliability of the leap motion sensor and its suitability for static and dynamic tracking. Sensors. 14 (2), 3702-3720 (2014).

- Sheshadri, S., Dann, B., Hueser, T., Scherberger, H. 3D reconstruction toolbox for behavior tracked with multiple cameras. Journal of Open Source Software. 5 (45), 1849(2020).

- Maiello, G., Harrison, W. J., Bex, P. J. Monocular and binocular contributions to oculomotor plasticity. Scientific Reports. 6, 31861(2016).

- Caoli, A., et al. A dichoptic feedback-based oculomotor training method to manipulate interocular alignment. Scientific Reports. 10, 15634(2020).

- Gibaldi, A., Vanegas, M., Bex, P. J., Maiello, G. Evaluation of the Tobii EyeX eye tracking controller and Matlab toolkit for research. Behavior Research Methods. 49 (3), 923-946 (2017).

- Chessa, M., Maiello, G., Borsari, A., Bex, P. J. The Perceptual quality of the Oculus Rift for immersive virtual reality. Human-Computer Interaction. 34 (1), 51-82 (2016).

- Maiello, G., Chessa, M., Bex, P. J., Solari, F. Near-optimal combination of disparity across a log-polar scaled visual field. PLoS Computational Biology. 16 (4), 1007699(2020).

- Maiello, G., Chessa, M., Solari, F., Bex, P. J. The (in)effectiveness of simulated blur for depth perception in naturalistic images. PLoS One. 10 (10), 0140230(2015).

- Maiello, G., Chessa, M., Solari, F., Bex, P. J. Simulated disparity and peripheral blur interact during binocular fusion. Journal of Vision. 14 (8), 13(2014).

- Maiello, G., Kerber, K. L., Thorn, F., Bex, P. J., Vera-Diaz, F. A. Vergence driven accommodation with simulated disparity in myopia and emmetropia. Experimental Eye Research. 166, 96-105 (2018).

- Moscatelli, A., et al. The change in fingertip contact area as a novel proprioceptive cue. Current Biology. 26 (9), 1159-1163 (2016).

재인쇄 및 허가

JoVE'article의 텍스트 или 그림을 다시 사용하시려면 허가 살펴보기

허가 살펴보기더 많은 기사 탐색

This article has been published

Video Coming Soon

Copyright © 2025 MyJoVE Corporation. 판권 소유