Zum Anzeigen dieser Inhalte ist ein JoVE-Abonnement erforderlich. Melden Sie sich an oder starten Sie Ihre kostenlose Testversion.

Method Article

Bewertung der Flugleistung und der Augenbewegungsmuster mit dem Virtual Reality Flight Simulator

In diesem Artikel

Zusammenfassung

Es wurde ein neuer Virtual-Reality-Flugsimulator gebaut, der eine effiziente und kostengünstige Bewertung der Flugleistung und der Augenbewegungsmuster ermöglicht. Es bietet auch ein vielversprechendes Forschungsinstrument für die Ergonomie und andere Forschungen.

Zusammenfassung

Die effiziente und wirtschaftliche Leistungsbewertung von Piloten ist für die Luftfahrtindustrie von entscheidender Bedeutung geworden. Mit der Entwicklung von Virtual Reality (VR) und der Kombination von Eye-Tracking-Technologie werden Lösungen, die diesen Anforderungen gerecht werden, Realität. Frühere Studien haben VR-basierte Flugsimulatoren untersucht, wobei der Schwerpunkt hauptsächlich auf der Technologievalidierung und dem Flugtraining lag. In der aktuellen Studie wurde ein neuer VR-Flugsimulator entwickelt, um die Flugleistung von Piloten anhand von Augenbewegungen und Flugindikatoren in einer immersiven 3D-Szene zu bewerten. Während des Experiments wurden 46 Teilnehmer rekrutiert: 23 Berufspiloten und 23 Studenten ohne Flugerfahrung. Die Versuchsergebnisse zeigten signifikante Unterschiede in der Flugleistung zwischen Teilnehmern mit und ohne Flugerfahrung, wobei erstere höher waren als letztere. Im Gegensatz dazu zeigten diejenigen mit Flugerfahrung strukturiertere und effizientere Augenbewegungsmuster. Diese Ergebnisse der Differenzierung der Flugleistung zeigen die Validität des aktuellen VR-Flugsimulators als Methode zur Bewertung der Flugleistung. Die unterschiedlichen Blick-Bewegungsmuster mit Flugerfahrung bilden die Grundlage für die zukünftige Flugauswahl. Dieser VR-basierte Flugsimulator hat jedoch Mängel wie Bewegungsfeedback im Vergleich zu herkömmlichen Flugsimulatoren. Diese Flugsimulator-Plattform ist sehr flexibel, abgesehen von den scheinbar niedrigen Kosten. Es kann die unterschiedlichen Bedürfnisse von Forschenden erfüllen (z. B. Messung des Situationsbewusstseins, der VR-Krankheit und der Arbeitsbelastung durch Hinzufügen relevanter Skalen).

Einleitung

Die Europäische Agentur für Flugsicherheit (2012) kategorisiert Flugsimulatoren als Schulungseinrichtungen, Flug- und Navigationsprogrammtrainer, Flugtrainingsgeräte und komplette Flugsimulatoren1. Bisher steht eine Reihe von Flugsimulatoren für die Ausbildung zur Verfügung, von Low-Level-Tischsystemen bis hin zu hochkomplizierten, bewegungsbasierten Vollflugsimulatoren2. Der traditionelle Simulator umfasst ein Flugdynamikmodell, eine Systemsimulation, ein Hardware-Cockpit, eine externe Visualisierung und eine optionale Bewegungssimulation3.

Diese traditionellen Flugsimulatoren haben einige Vorteile als effektive Flugtrainingsgeräte. Ihre Kosten sind jedoch hoch und umweltschädlich, da der Antrieb jedes Systems erhebliche elektrische Energie erfordert, insbesondere ein vollständiger Flugsimulator, der hohe Temperaturen und Hochdruckflüssigkeit oder Luftdruck benötigt, viel Strom verbraucht und viel Lärm erzeugt4.

Ein einfaches Desktop-Simulatorsystem ist jedoch flexibel und kostengünstig, mit geringerer Immersion und weniger Interaktionen als ein vollständiger Flugsimulator2. Daher ist es unerlässlich, neue Flugsimulatoren zu entwickeln, die die Vorteile von Desktop-Systemen und Full-Flight-Simulatoren kombinieren (mit anderen Worten, die Flexibilität einer Tabletop-Simulation und die Immersions- und Interaktionsebene nahe an einem Full-Flight-Simulator).

Mit der Entwicklung der Computertechnologie, insbesondere der Virtual-Reality-Technologie (VR), wird eine neue Art von Flugsimulator, die auf der aufkommenden VR-Technologie basiert, Realität. Der VR-basierte Flugsimulator ist flexibel, portabel, kostengünstig und hat einen geringeren Platzbedarf als herkömmliche Flugsimulatoren5. Forscher haben in den letzten 20 Jahren Flugsimulatoren auf Basis der VR-Technologie entwickelt 6,7,8,9,10,11; Diese VR-Flugsimulatoren dienen jedoch hauptsächlich der Flugausbildung, und es gibt nur wenige für die Pilotenauswahl. Mit der Kostensenkung und der technologischen Verbesserung verändern sich VR-basierte Simulatoren jedoch und werden für die persönliche Auswahl machbar. In einigen Studien wurden VR-basierte Simulatoren für die persönliche Auswahl in verschiedenen Bereichen eingesetzt: Schijven et al.12 wählten chirurgische Auszubildende mit einem Virtual-Reality-Simulator aus. Huang et al.13 entwickelten ein psychologisches Auswahlinstrument auf Basis von Virtual-Reality-Technologie für die Rekrutierung von Luftwaffenpiloten. Wojciechowski und Wojtowicz14 bewerteten die Fähigkeiten eines Kandidaten als Pilot eines unbemannten Luftfahrzeugs (UAV) auf Basis der VR-Technologie. Angesichts der Tatsache, dass die Pilotenauswahl für die Luftfahrtindustrie von entscheidender Bedeutung ist, ist es dringend erforderlich, einen neuen VR-basierten Flugsimulator zu entwickeln, der sich auf die Pilotenauswahl konzentriert, da die Auswahl von Piloten in großem Maßstab anfällig für die Kosten des Simulators und die Anforderungen an das Portabilitätssimulatorsystem ist.

Augenbewegungen geben Hinweise auf die Leistung eines Piloten. Verschiedene Studien haben ergeben, dass der Eye-Scanning-Modus die Leistung zwischen erfahrenen und unerfahrenen Piloten unterscheidet. Durch den Vergleich des Scanmusters zwischen Experten und Anfängern konnte das effiziente und strukturelle Augenbewegungsverhalten der Experten und die unzureichenden Scanmethoden von Anfängern unterschieden werden. Mehrere Luftfahrtstudien haben ergeben, dass die Augenscan-Strategie von Piloten stark mit dem Kenntnisstandzusammenhängt 15,16,17,18,19,20,21,22,23,24. Laut Bellenkes et al.25 ist die Dauer der Fixierungen bei Experten kürzer und die Häufigkeit ihrer Fixierungen auf Instrumente höher als bei Anfängern. Fast die gleiche Schlussfolgerung zogen Kasarskis et al.26, die entdeckten, dass erfahrene Piloten mehr Fixierungen in Kombination mit kürzeren Dauern als Anfänger haben, was darauf hindeutet, dass erfahrene Piloten einen besseren visuellen Modus haben als Anfänger. In einer weiteren Studie haben Lorenz et al.27 fanden heraus, dass Experten mehr Zeit damit verbringen, aus dem Cockpit zu schauen als Anfänger. Diese Ergebnisse haben einen großen praktischen Wert bei der Auswahl von Neueinsteigern.

Die Bewertung der Flugleistung ist ein weiterer kritischer Faktor für die Auswahl des Piloten. Bei der Bewertung der Flugleistung von Piloten gibt es jedoch folgende Probleme: widersprüchliche Expertenmeinungen, mehr Auswahlnormen und eine einheitliche Auswahltheorie. Im Fahrfeld verglichen Horrey et al.28 den absoluten Wert des Spurverlassens von der Mittellinie für verschiedene experimentelle Bedingungen, um die Fahrleistung zu bewerten. Zurück zum Bereich der Luftfahrt: Der Flight Quick Access Recorder (QAR) zeichnet alle Arten von Manipulationsparametern für Piloten, Flugzeugparameter, Umgebungen und Warninformationen während desFluges 29 auf. Genauer gesagt, wie bei den QAR-Indikatoren, ist der Nickwinkel der Rotationswinkel um die linke und rechte Achse des Flugzeugs30, und die Referenzlinie (oder die mittlere Referenzlinie) befindet sich genau in der Mitte der roten und grünen Linien28; Diese beiden Flugparameter werden verwendet, um die Flugleistung von Teilnehmern mit oder ohne Erfahrung in der aktuellen Studie zu bewerten. Diese QAR-Daten können zur Bewertung der Flugleistung verwendet werden, aber nach unserem besten Wissen wurden sie in der wissenschaftlichen Forschung selten für das persönliche Training und die Auswahl verwendet31,32.

Messungen von Augenbewegungsmustern können verwendet werden, um die Flugleistung zu beurteilen und vorherzusagen und die Ausbildung und Auswahl von Piloten zu leiten. Gerathewohl33 erklärte, dass das Auge das wichtigste Sinnesorgan des Piloten ist und 80% der Fluginformationen verarbeitet. Der Pilot muss visuelle Informationen von Instrumenten im Cockpit erfassen und in ein kohärentes Bild integrieren, um den Flug22 zu bewältigen. Darüber hinaus ist ein optimales Scanverhalten unerlässlich, um eine bessere Flugleistungzu erzielen 15. Allerdings gibt es derzeit keinen erschwinglichen Flugsimulator, der einen Eyetracker integriert, um quantitative Studien über den Zusammenhang zwischen Augenbewegungen und Flugleistung zu ermöglichen.

In der aktuellen Studie wurde ein neuer VR-Flugsimulator entwickelt, um zu beurteilen, ob Teilnehmer mit Flugerfahrung eine bessere Flugleistung aufwiesen als solche ohne Flugerfahrung. Der VR-Flugsimulator integriert Eye-Tracking und ein Flugdynamiksystem, das die Analyse von Augenbewegungsmustern und die Bewertung der Flugleistung ermöglicht. Insbesondere ist es erwähnenswert, dass der VR-Flugsimulator einen VR-Eyetracker34 und keinen glasartigen oder Desktop-Eyetracker verwendet, um die auf dem Interessengebiet (AOI) basierende Augenbewegung ohne zeitaufwändige Frame-Zählung zu analysieren.

Schließlich kann die vorliegende Arbeit zu einer Omnibus-Messung für die Pilotenauswahl in der Zukunft führen, von der Augenscanbahn bis hin zu objektiven Flugleistungsdaten. Mit Hilfe des virtuellen Flugsimulators werden die Kosten für die Flugauswahl erheblich gesenkt und die Norm der Piloten kann auf der Grundlage umfangreicher Datenerfassung gebildet werden. Die Arbeit schließt eine Lücke zwischen konventionellen und Desktop-Simulatoren für die Flugauswahl.

Protokoll

Alle hier beschriebenen Methoden wurden vom Institutional Review Board (IRB) der Tsinghua-Universität genehmigt, und es wurde eine Einverständniserklärung aller Teilnehmer eingeholt. Nach Abschluss des Turniers erhielten alle Teilnehmer 12 $ (oder ein Geschenk im gleichen Wert).

1. Auswahl der Teilnehmer

- Rekrutieren Sie die Teilnehmer gemäß einer früheren Studie zur Leistungsanalyse mit der G*Power-Software35 (siehe Materialtabelle), um sicherzustellen, dass die Teilnehmerzahl der von G*Power angegebenen erwarteten Stichprobengröße entspricht, die 21 beträgt.

HINWEIS: Die von G*Power angegebene erwartete Stichprobengröße bezieht sich auf die geschätzte Anzahl der Teilnehmer, die in einer Studie benötigt werden, um ein gewünschtes Maß an statistischer Aussagekraft zu erreichen, basierend auf der angegebenen Effektgröße, dem Signifikanzniveau und dem verwendeten statistischen Test. Die erwartete Stichprobengröße ist ein wichtiger Aspekt bei der Forschungsplanung. Es hilft den Forschern, die Machbarkeit und Kosteneffizienz ihres Studiendesigns zu bestimmen und stellt sicher, dass die Studie über eine ausreichende statistische Aussagekraft verfügt, um aussagekräftige Effekte zu erkennen. - Stellen Sie sicher, dass keiner der Teilnehmer eine Vorgeschichte von Epilepsie, Herz- oder Gehirnerkrankungen, kürzlich eingenommenen endokrinen oder psychiatrischen Medikamenten oder schweren Hautallergien hat.

- Verwenden Sie die Snellen-Sehtafel (verwenden Sie das metrische System 6/6)36 , um zu bestätigen, dass das Sehvermögen der Teilnehmer normal oder normal korrigiert ist und dass sie keine Sehbehinderungen wie Farbenblindheit oder Farbschwäche haben.

- Stellen Sie sicher, dass keiner der Teilnehmer in den letzten 24 Stunden Alkohol oder Drogen konsumiert hat, die seine Flugfähigkeit beeinträchtigen könnten.

- Stellen Sie sicher, dass die Teilnehmer vor dem Experiment nicht weniger als 6 Stunden geschlafen haben und in guter geistiger Verfassung sind.

2. Flugsimulator-Hardware

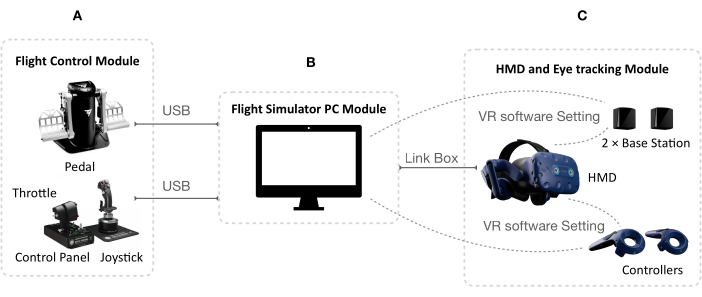

- Vergewissern Sie sich, dass die gesamte Hardware des Flugsimulators vollständig ist. Entsprechend ihrer Funktion ist diese Hardware in drei Module unterteilt (Tabelle 1) (siehe Materialtabelle).

HINWEIS: Forscher müssen einen Metallstab berühren, bevor sie das Gerät berühren, um das Risiko durch elektrostatische Induktion zu vermeiden.- Überprüfen Sie die Komponenten des VR-, HMD- (Head-Mounted-Display) und Eye-Tracking-Moduls anhand von Tabelle 2.

- Stellen Sie sicher, dass alle Komponenten des Flugsimulator-PC-Moduls die folgenden Mindestanforderungen erfüllen: 3,6-GHz-Prozessor, interner 4G-Speicher, 64-Bit-Betriebssystem und Grafikkarte. Das System unterstützt alle Flugregler.

- Überprüfen Sie die Komponenten des Flugsteuerungsmoduls und stellen Sie sicher, dass die Parameterkonfiguration des Geräts mit Tabelle 3 übereinstimmt.

- Installieren Sie die Hardware des Flugsimulators gemäß dem Layout in Abbildung 1. Abbildung 2 zeigt, wie die Hardware angeschlossen ist.

- Verbinden Sie die Drosselklappe und das Bedienfeld physisch und behandeln Sie sie als Einheit.

- Verbinden Sie Gas, Joystick und Pedal über USB mit dem PC-Modul des Flugsimulators.

- Verbinden Sie das HMD über die Link-Box mit dem PC-Modul des Flugsimulators.

- Verbinden Sie die Basisstationen und VR-Controller über die VR-Software am PC mit dem HMD.

| VR-Head-Mounted-Display (HMD) und Eye-Tracking-Modul | 1. Basisstation |

| 2. VR-HMD | |

| Flugsimulator PC-Modul | 3. Flugsimulator PC |

| Flugsteuerungs-Modul | 4. Fluggas |

| 5. Flug-Joystick | |

| 6. Flugpedal |

Tabelle 1: Komponenten der drei Module der Flugsimulator-Hardware.

| Hauptbestandteil | Zubehör |

| VR-HMD | Kopfhörer-Kabel (angeschlossen) |

| Gesichtskissen (beigefügt) | |

| Putzlappen | |

| Kopfhörer-Lochkappe × 2 | |

| Link-Box | Netzteil |

| DisplayPort-Kabel | |

| USB 3.0-Kabel | |

| Montagepad | |

| Steuerungen (2018) × 2 | Netzteile × 2 |

| Schlüsselbänder × 2 | |

| Micro-USB-Kabel × 2 | |

| Basisstation 2.0 × 2 | Netzteile × 2 |

| Montagesatz (2 Halterungen, 4 Schrauben und 4 Wandanker) |

Tabelle 2: Liste der Komponenten des VR-HMD- und Eye-Tracking-Moduls.

| Gerät | Konfiguration der Parameter |

| Flug-Joystick | Neunzehn Aktionstasten |

| Ein 8-Wege-"Standpunkt"-Hut | |

| Mehrere 3D-Magnetsensoren | |

| Ein 5-Schrauben-Federsystem | |

| Eine 16-Bit-Auflösung (Werte 65536 x 65536). | |

| Flug-Bedienfeld | Fünfzehn Aktionstasten |

| Ein TRIM-Rad | |

| Fünf programmierbare LEDs | |

| Fluggas | Siebzehn Aktionstasten |

| Ein Maushut mit Druckknopf | |

| Ein 8-Wege-"Standpunkt"-Hut | |

| Mehrere 3D-Magnetsensoren | |

| Zwei 14-Bit-Auflösungen | |

| Flugpedal | Spannung zwischen 2,5 kg und 5 kg |

| Winkel zwischen 35° und 75° |

Tabelle 3: Die Parameterkonfiguration der Geräte des Flugsteuerungsmoduls.

Abbildung 1: Das Layout der VR-Flugsimulator-Hardware. Bitte klicken Sie hier, um eine größere Version dieser Abbildung anzuzeigen.

Abbildung 2: Der Anschluss der Flugsimulator-Hardware. (A) Flugsteuerungsmodul. Die Drosselklappe und das Bedienfeld sind physisch verbunden und werden als Einheit behandelt. Wenn der Begriff "Gashebel" in dieser Studie verwendet wird, bezieht er sich sowohl auf den Gashebel als auch auf das Bedienfeld. (B) PC-Modul des Flugsimulators. Ein Computer, der die in Schritt 2.2 beschriebenen Anforderungen erfüllt. (C) HMD- und Eye-Tracking-Modul. Die Software Development Kits (SDKs) für Eye-Tracking und die 3D-Engine werden synchronisiert, wenn sie auf demselben Computer installiert werden. Daher interagieren und arbeiten die Eye-Tracking-Funktionen und das Betriebssystem zusammen. Bitte klicken Sie hier, um eine größere Version dieser Abbildung anzuzeigen.

3. Flugsimulator-Software

- Stellen Sie sicher, dass die gesamte Software (siehe Materialtabelle) installiert wurde, bevor das Experiment beginnt. Informationen über die gesamte im Experiment verwendete Software sind in Tabelle 4 aufgeführt.

| Name | Beschreibung | |||

| VR-Software | Ein weit verbreitetes Tool, um VR-Inhalte auf der Hardware zu erleben. | |||

| VR-App-Store | Der App Store für Virtual Reality, in dem Kunden die Inhalte erkunden, erstellen, verbinden und erleben können, die sie lieben und brauchen. | |||

| Eye-Tracking-Software | Eye-Tracking-Software, die vom Forschungsteam über Eye-Tracking- und 3D-Engine-SDKs entwickelt wurde. | |||

| FlySimulator (Englisch) | Das Hauptprogramm der Flugsimulator-Software, das vom Forschungsteam entwickelt wurde. | |||

| Software zur Bildschirmaufzeichnung | Eine kostenlose Open-Source-Software für Videoaufzeichnung und Live-Streaming. | |||

Tabelle 4: Informationen über die gesamte im Experiment verwendete Software.

4. Vorbereitung vor dem Start des Flugsimulators

HINWEIS: Wenn Sie das Eye-Tracking-Programm zum ersten Mal ausführen, führen Sie die zusätzlichen Schritte gemäß Abbildung 3 aus. Das Eye-Tracking-Programm wird nach dem ersten Lauf automatisch aktiviert.

Abbildung 3: Die zusätzlichen Schritte beim ersten Ausführen des Eye-Tracking-Programms. Bitte klicken Sie hier, um eine größere Version dieser Abbildung anzuzeigen.

- Stellen Sie sicher, dass das HMD eingeschaltet und mit dem Computer verbunden ist.

- Platzieren Sie die Basisstation diagonal, um sicherzustellen, dass sich das HMD immer innerhalb des Überwachungsbereichs der Basisstation befinden kann. Halten Sie die Basisstation fest, um eine stabile VR-Umgebung zu erhalten.

- Richten Sie einen Spielbereich nur für Stehplätze ein, gemäß den Anweisungen der VR-Software auf dem Computer.

HINWEIS: Die Eingabeaufforderung lässt einen Bereich mit Raummaßstab zu oder richtet einen Spielbereich nur mit Stehplätzen ein. Der Nur-Stehen-Modus wird im Allgemeinen verwendet, um VR-Szenen zu erleben, die kein Gehen erfordern und ausgewählt werden können, wenn der Benutzer nur wenig Platz hat, um sich zu bewegen. Richten Sie daher in diesem Experiment einen Spielbereich nur für Stehplätze ein. - Stellen Sie die Eye-Tracking-Kalibrierung ein. Das Eye-Tracking-System muss bei jedem Wechsel des Teilnehmers neu kalibriert werden.

- Vergewissern Sie sich, dass die Teilnehmer keine Kontaktlinsen verwenden, was zu einer Fehlfunktion des Eye-Trackings führt.

- Öffnen Sie das Eye-Tracking-Kalibrierungsprogramm mit den VR-Controllern (siehe Materialtabelle).

- Passen Sie die Gerätehöhe, den Augenabstand (IDP) und den Blickpunkt nach den Anweisungen des Systems an.

- Lassen Sie die Augen des Teilnehmers jeden Punkt 2 Sekunden lang im Uhrzeigersinn beleuchten, um die Wirksamkeit der Eye-Tracking-Kalibrierung zu überprüfen.

- Schließen Sie das abgestimmte Flugsteuerungsmodul und das Großbilddisplay (d. h. mindestens einen 27-Zoll-Monitor) an denselben Computer wie das VR-HMD an. Der Bildschirm ermöglicht es dem Experimentator, gleichzeitig zu sehen, was im VR-HMD passiert.

5. Experimenteller Ablauf

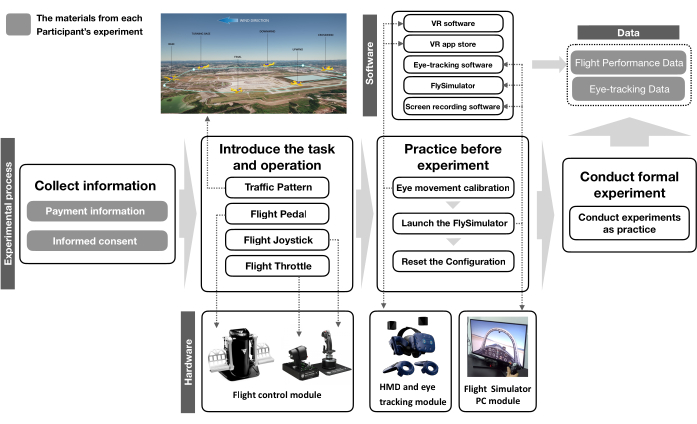

HINWEIS: Das Experiment ist in vier Schritte unterteilt: "Informationen sammeln", "Einführung in die Aufgabe und den Betrieb", "Üben vor dem Experiment" und "Durchführen eines formellen Experiments". Der experimentelle Prozess ist in Abbildung 4 zusammengefasst.

Abbildung 4: Das Flussdiagramm des Experiments. Bitte klicken Sie hier, um eine größere Version dieser Abbildung anzuzeigen.

- Sammeln Sie Informationen von den Teilnehmern (15 Minuten).

- Füllen Sie das Formular mit den Zahlungsdetails mit den Zahlungsinformationen der Teilnehmer aus.

- Informieren Sie die Teilnehmer, das Einwilligungsdokument zu lesen und zu unterschreiben.

- Führen Sie die Teilnehmer in die Aufgabe und den Simulatorbetrieb ein (5 min).

- Erklären Sie den Teilnehmern das Verkehrsmuster und die Karte (Abbildung 5).

- Weisen Sie die Teilnehmer in die Verwendung des VR-Flugsimulators ein.

- Informieren Sie die Teilnehmer, dass sie das Experiment verlassen können, wenn sie sich bei der Simulation eines Fluges unwohl fühlen.

- Bitten Sie die Teilnehmer, den Umgang mit dem VR-Flugsimulator zu üben (15 min).

- Passen Sie das VR-HMD an die Teilnehmer an und kalibrieren Sie die Augenbewegungen. Passen Sie die Gerätehöhe, den Augenabstand (IDP) und den Blickpunkt gemäß den Anweisungen des Systems an.

- Öffnen Sie die Bildschirmaufzeichnungssoftware.

- Starten Sie das FlySimulator-Programm , um die Teilnehmer bei der Flugausbildung zu unterstützen.

- Weisen Sie die Teilnehmer an, das Flugpedal, den Joystick und den Gashebel gemeinsam zu verwenden, um das Flugzeug so nah wie möglich an die Referenzfluglinie zu steuern (Abbildung 5).

- Setzen Sie die Schalttasten für Fluggas und Motor zurück, nachdem Sie das FlySimulator-Programm beendet haben, und beenden Sie die Aufzeichnung des Bildschirms, nachdem der Proband die Übung beendet hat.

- Führen Sie formelle Flugexperimente durch (20 min).

- Setzen Sie das VR-HMD für die Teilnehmer ein und starten Sie OBS Studio , um die Aufzeichnung des Bildschirms zu starten.

- Starten Sie das FlySimulator-Programm, wählen Sie eine passende Perspektive, starten Sie den Motor, lassen Sie die Feststellbremse los und geben Sie Vollgas.

- Beenden Sie das FlySimulator-Programm und setzen Sie dann die Fluggas - und Motorschaltertasten zurück. Beenden Sie die Aufzeichnung des Bildschirms.

Abbildung 5: Das Verkehrsmuster für den VR-Flugsimulator. Der Nickwinkel ist der Drehwinkel um die linke und rechte Achse des Flugzeugs, und die Referenzlinie (oder die mittlere Referenzlinie) befindet sich genau in der Mitte der roten und grünen Linie. Bitte klicken Sie hier, um eine größere Version dieser Abbildung anzuzeigen.

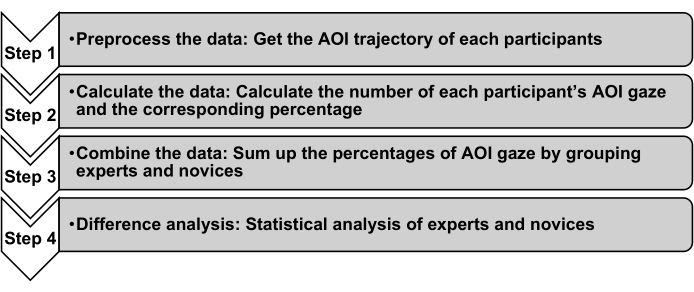

6. Datenanalyse

- Analysieren Sie Augenbewegungsdaten.

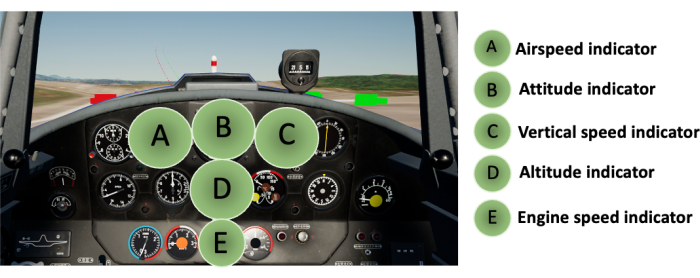

- Unterteilen Sie in dieser Studie fünf AOI-Zonen (Area of Interest); Weitere Informationen zur Berechnung von AOIs finden Sie in Abbildung 6, basierend auf dem tatsächlichen Panel des Flugcockpits, das dem Flugcockpit-Instrument entspricht (Abbildung 7).

- Berechnen Sie den AOI-Differenztest anhand des prozentualen Anteils der Verweilzeit in der AOI-Zone37 unter Berücksichtigung der Ausstattungsmerkmale des in dieser Studie verwendeten VR-Okulomotors.

HINWEIS: Der durchschnittliche Prozentsatz der Verweildauer ist der kumulative Prozentsatz, der mit dem Betrachten innerhalb eines AOI verbracht wurde, geteilt durch die gesamte Fixationszeit und gemittelt über die Teilnehmer hinweg.

- Analysieren Sie Flugleistungsdaten mit eigens entwickelten Programmierskripten unter Verwendung von Python 3.10. Der Kernalgorithmus für Leistungsmetriken wurde von der QAR-Analysemethode adaptiert, die von den QAR-Daten von 35 BAE-146-Flugzeugen inspiriert wurde, die von der National Aeronautics and Space Administration (NASA)38 zur Verfügung gestellt wurden.

HINWEIS: Flugleistungsindikatoren für diese Studie: die Gesamtflugzeit (die Gesamtzeit vom Start bis zur Landung für jeden Teilnehmer in Sekunden), der Nickwinkel 1 s vor der Landung (Nickwinkel des Flugzeugs 1 s vor der Landung, ermittelt aus Rohdaten, in Grad), die mittlere Entfernung zur Referenzlinie (mittlerer Fehler des räumlichen Abstands zwischen dem Flugzeug und der Referenzlinie während des Fluges, in Metern) und Standardabweichung des Abstands zur Referenzlinie (Standardabweichung des räumlichen Abstands zwischen dem Flugzeug und der Referenzlinie während des Fluges, in Metern). - Führen Sie die statistischen Analysen durch.

- Verwenden Sie den Shapiro-Wilk-Test39 , um die Normalität der Daten zu bestätigen.

- Verwenden Sie Statistiksoftware (siehe Materialtabelle) für deskriptive Statistiken, den Mann-Whitney U-Test und den Student's t-Test.

- Darstellen der Geigendiagramme, um die Form der Datenverteilung40 besser anzuzeigen.

HINWEIS: Die Erklärung für die Effektstärke, die mit Cohens d gemessen wird, lautet wie folgt: 0,1 ist sehr klein, 0,2 ist klein, 0,5 ist mittel, 0,8 ist groß, 1,2 ist sehr groß und 2,0 ist riesig41,42. Das Signifikanzniveau wurde auf p < 0,05 festgelegt.

Abbildung 6: AOI-Vorverarbeitung und Berechnung des Strömungsprozesses. In den Abschnitten 1 bis 4 wird beschrieben, wie die vorliegende Studie die Augenbewegungsdaten der Piloten bis zum unabhängigen Stichproben-t-Test verarbeitet hat. Bitte klicken Sie hier, um eine größere Version dieser Abbildung anzuzeigen.

Abbildung 7: Schematische Darstellung der AOI-Aufteilung des Fluginstruments. Die Funktion der Instrumente: (A) Der Fluggeschwindigkeitsanzeiger zeigt die Geschwindigkeit des Flugzeugs relativ zur Luft an. (B) Die Höhenanzeige zeigt die Nick- und Rollhöhe des Luftfahrzeugs an. (C) Die vertikale Geschwindigkeitsanzeige zeigt die Steig- oder Sinkgeschwindigkeit des Luftfahrzeugs an. (D) Die Höhenanzeige zeigt die barometrische Höhe des Luftfahrzeugs an. (E) Die Motordrehzahlanzeige zeigt die Drehzahl des Flugzeugmotors an. Bitte klicken Sie hier, um eine größere Version dieser Abbildung anzuzeigen.

Ergebnisse

Für das aktuelle Experiment wurden 23 Experten mit Flugerfahrung und 23 Neulinge ohne Flugerfahrung ausgewählt. Die Teilnehmer waren zwischen 25 und 58 Jahre alt (Experten: M = 32,52 Jahre, SD = 7,28 Jahre; Anfänger: M = 29,57 Jahre, SD = 5,74 Jahre). Das Geschlecht aller Teilnehmer war männlich. Alle Neulinge wurden von der Tsinghua-Universität rekrutiert (Studenten oder Dozenten), und alle Experten kamen von China Eastern Airlines.

Augenbewegu...

Diskussion

In der aktuellen Studie wurde untersucht, ob Teilnehmer mit Flugerfahrung eine bessere Flugleistung aufwiesen als diejenigen ohne Flugerfahrung in einem VR-basierten Flugsimulator. Vor allem aber wurde untersucht, ob bei diesen Teilnehmern mit besserer Flugleistung ein optimiertes Augenbewegungsmuster gefunden werden konnte. Die Ergebnisse zeigen signifikante Unterschiede zwischen Teilnehmern mit und ohne Flugerfahrung bei drei wichtigen Flug-QAR-Indikatoren: Nickwinkel 1 s vor der Landung, die mittlere Entfernung zur Re...

Offenlegungen

Die Autoren gaben an, keine finanziellen Angaben oder Interessenkonflikte zu machen.

Danksagungen

Die Autoren sind Herrn Li Yan unglaublich dankbar für seine Hilfe bei der Rekrutierung von Pilotteilnehmern und danken Frau Bu Lingyun für ihre Arbeit beim Zeichnen von Bildern. Die Forschung wurde unterstützt von der National Natural Science Foundation of China (Fördernummer T2192931, 72071185), dem National Brain Project (Fördernummer STI2030-Major Projects2022ZD0208500), dem National Key Laboratory Project of Human Factors Engineering (Fördernummer SYFD062003), dem National Key Laboratory Project of Human Factors Engineering (Fördernummer 6142222210201) und dem Jahr 2022 Major Projects of Military Logistic Research Grant und Key Project of Air Force Equipment Comprehensive Forschung (Fördernummer KJ2022A000415).

Materialien

| Name | Company | Catalog Number | Comments |

| 3D engine SDK | Epic Games | Unreal Engine 4 GameAnalytics Unreal SDK | This SDK is a powerful yet flexible free analytics tool designed for games. |

| CPU | Intel | IntelCore i9 | One of the most powerful CPU on the mainstream market. |

| Eye tracking SDK | Tobii | Tobii XR SDK | This SDK provide device agnostic access to eye tracking data to allow development for headsets from many different hardware vendors and is not limited to devices using Tobii Eye Tracking hardware. |

| Eye tracking software | Developed by the research team | A program that tracks the movement of a person's eyes while they are using a virtual reality HMD. | |

| FlySimulator program | Developed by the research team | A software that simulates flying experiences in a virtual environment, using VR HMD and hand-held controllers. | |

| Graphics card | NVIDIA | GeForce RTX 3090 10496 NVIDIA CUDA Cores 1.70 GHz Boost Clock 24 GB Memory Size GDDR6X Memory Type | One of the most powerful graphics card on the mainstream market. |

| Operating system (OS) | Microsoft | Windows XP | An operating system (OS) developed and exclusively distributed by Microsoft Corporation |

| Replica control panel | THRUSTMASTER | 2960720 2971004 2962072 2960748 2960769 | U.S. Air Force A-10C attack aircraft HOTAS |

| Replica joystick | THRUSTMASTER | 2960720 | U.S. Air Force A-10C attack aircraft HOTAS |

| Replica pedal | THRUSTMASTER | TPR pendular rudder | |

| Replica throttle | THRUSTMASTER | U.S. Air Force A-10C attack aircraft HOTAS | |

| Screen connected to PC | Redmi | RMMNT27NF, 27-inch, 1920 X 1080 resolution ratio | Screen allows the experimenter to simultaneously view what is happening in the VR HMD |

| Screen recording software | OBS Project | OBS Studio Version 28.0 | A free and open source software for video recording and live streaming |

| Statistical power analysis software | Open-Source | G*power Version 3.1.9.6 | A free and user-friendly tool for estimating statistical power and sample size. |

| Statistical software | IBM | SPSS Version 24.0 | A powerful statistical software platform |

| Versatile statistics tool | GraphPad Software | GraphPad Prism Version 9.4.0 | A versatile statistics tool purpose-built for scientists-not statisticians |

| VR app store | HTC Corporation | VIVE Software 2.0.17.6 / 2.1.17.6 | An app store for virtual reality where customers can explore, create, connect, and experience the content they love and need. |

| VR head-mounted display (HMD) | HTC Corporation | VIVE Pro Eye | A VR headset with precision eye tracking |

| VR software | Steam | Steam VR Version 1.23 | A tool for experiencing VR content on the hardware |

Referenzen

- Oberhauser, M., Dreyer, D., Braunstingl, R., Koglbauer, I. What's real about virtual reality flight simulation. Aviation Psychology and Applied Human Factors. 8 (1), 22-34 (2018).

- Oberhauser, M., Dreyer, D. A virtual reality flight simulator for human factors engineering. Cognition, Technology & Work. 19 (2-3), 263-277 (2017).

- Rolfe, J. M., Staples, K. J. . Flight Simulation. , (1986).

- Robinson, A., Mania, K., Perey, P. Flight simulation: Research challenges and user assessments of fidelity. Proceedings of the 2004 ACM SIGGRAPH International Conference on Virtual Reality Continuum and its Applications in Industry. , 261-268 (2004).

- Moroney, W. F., Moreney, B. W. Flight Simulation. Handbook of Aviation Human Factors. , 261-268 (1999).

- McCarty, W. D., Sheasby, S., Amburn, P., Stytz, M. R., Switzer, C. A virtual cockpit for a distributed interactive simulation. IEEE Computer Graphics and Applications. 14 (1), 49-54 (1994).

- Dorr, K. U., Schiefel, J., Kubbat, I. Virtual cockpit simulation for pilot training. In . The Hague, The Netherlands. What is Essential for Virtual Reality Systems to Meet Military Human Performance Goals? RTO human factors and medicine panel (HEM) workshop. , (2001).

- Bauer, M., Klingauf, U. Virtual-reality as a future training medium for civilian flight procedure training. AIAA Modeling and Simulation Technologies Conference and Exhibit. , 18-21 (2008).

- Yavrucuk, I., Kubali, E., Tarimci, O. A low cost flight simulator using virtual reality tools. IEEE Aerospace and Electronic Systems Magazine. 26 (4), 10-14 (2011).

- Aslandere, T., Dreyer, D., Pankratz, F., Schubotz, R. A generic virtual reality flight simulator. Virtuelle und Erweiterte Realität, 11. Workshop der GI-Fachgruppe VR/AR. , 1-13 (2014).

- Joyce, R. D., Robinson, S. K. The rapidly reconfigurable research cockpit. AIAA Modeling and Simulation Technologies Conference. , 22-26 (2015).

- Schijven, M. P., Jakimowicz, J. J., Carter, F. J. How to select aspirant laparoscopic surgical trainees: Establishing concurrent validity comparing Xitact LS500 index performance scores with standardized psychomotor aptitude test battery scores. The Journal of Surgical Research. 121 (1), 112-119 (2004).

- Huang, P., Zhu, X., Liu, X., Xiao, W., Wu, S. . Psychology selecting device for air force pilot recruitment based on virtual reality technology, has industrial personal computer connected with memory, where industrial control computer is connected with image display device. , (2020).

- Wojciechowski, P., Wojtowicz, K. Simulator sickness and cybersickness as significant indicators in a primary selection of candidates for FPV drone piloting. 2022 IEEE 9th International Workshop on Metrology for AeroSpace (MetroAeroSpace). , (2022).

- Ziv, G. Gaze behavior and visual attention: A review of eye tracking studies in aviation. The International Journal of Aviation Psychology. 26 (3-4), 75-104 (2016).

- Lai, M. L., et al. A review of using eye-tracking technology in exploring learning from 2000 to 2012. Educational Research Review. 10, 90-115 (2013).

- Robinski, M., Stein, M. Tracking visual scanning techniques in training simulation for helicopter landing. Journal of Eye Movement Research. 6 (2), 1-17 (2013).

- Yang, J. H., Kennedy, Q., Sullivan, J., Fricker, R. D. Pilot performance: Assessing how scan patterns & navigational assessments vary by flight expertise. Aviation Space and Environmental Medecine. 84 (2), 116-124 (2013).

- Yu, C. S., Wang, E. M. Y., Li, W. C., Braithwaite, G., Greaves, M. Pilots' visual scan patterns and attention distribution during the pursuit of a dynamic target. Aerospace Medicine and Human Performance. 87 (1), 40-47 (2016).

- Haslbeck, A., Zhang, B. I spy with my little eye: Analysis of airline pilots' gaze patterns in a manual instrument flight scenario. Applied Ergonomics. 63, 62-71 (2017).

- Brams, S., et al. Does effective gaze behavior lead to enhanced performance in a complex error-detection cockpit task. PLoS One. 13 (11), e0207439 (2018).

- Peißl, S., Wickens, C. D., Baruah, R. Eye-tracking measures in aviation: A selective literature review. The International Journal of Aerospace Psychology. 28 (3-4), 98-112 (2018).

- Jin, H., et al. Study on how expert and novice pilots can distribute their visual attention to improve flight performance. IEEE Access. 9, 44757-44769 (2021).

- Lounis, C., Peysakhovich, V., Causse, M. Visual scanning strategies in the cockpit are modulated by pilots' expertise: A flight simulator study. PLoS One. 16 (2), e0247061 (2021).

- Bellenkes, A. H., Wickens, C. D., Kramer, A. F. Visual scanning and pilot expertise: The role of attentional flexibility and mental model development. Aviation Space and Environmental. 68 (7), 569-579 (1997).

- Kasarskis, P., Stehwien, J., Hickox, J., Aretz, A., Wickens, C. Comparison of expert and novice scan behaviors during VFR flight. Proceedings of the 11th International Symposium on Aviation Psychology. , (2001).

- Lorenz, B., et al. Performance, situation awareness, and visual scanning of pilots receiving onboard taxi navigation support during simulated airport surface operation. Human Factors and Aerospace Safety. 6 (2), 135-154 (2006).

- Horrey, W. J., Alexander, A. L., Wickens, C. D. Does workload modulate the effects of in-vehicle display location on concurrent driving and side task performance. Driving Simulator Conference North America Proceedings. , (2013).

- Wang, L., Ren, Y., Sun, H., Dong, C. A landing operation performance evaluation method and device based on flight data. In Engineering Psychology and Cognitive Ergonomics: Cognition and Design. , 297-305 (2017).

- Wang, L., Ren, Y., Wu, C. Effects of flare operation on landing safety: A study based on ANOVA of real flight data. Safety Science. 102, 14-25 (2018).

- Huang, R., Sun, H., Wu, C., Wang, C., Lu, B. Estimating eddy dissipation rate with QAR flight big data. Applied Sciences. 9 (23), 5192 (2019).

- Wang, L., Zhang, J., Dong, C., Sun, H., Ren, Y. A method of applying flight data to evaluate landing operation performance. Ergonomics. 62 (2), 171-180 (2019).

- Gerathewohl, S. J. Leitfaden der Militärischen Flugpsychologie. Verlag für Wehrwissenschaften. , (1987).

- Ugwitz, P., Kvarda, O., Juříková, Z., Šašinka, &. #. 2. 6. 8. ;., Tamm, S. Eye-tracking in interactive virtual environments: implementation and evaluation. Applied Sciences. 12 (3), 1027 (2022).

- Faul, F., Erdfelder, E., Lang, A. -. G., Buchner, A. G*Power 3: A flexible statistical power analysis program for the social, behavioral, and biomedical sciences. Behavior Research Methods. 39 (2), 175-191 (2007).

- Boslaugh, S. E. . Snellen Chart. , (2018).

- He, J., Becic, E., Lee, Y. -. C., McCarley, J. S. Mind wandering behind the wheel. Human Factors: The Journal of the Human Factors and Ergonomics Society. 53 (1), 13-21 (2011).

- Tanveer Alam, . GitHub - tanvcodes/qar_analytics: Scripts for working with publicly available Quick Access Recorder (QAR) data from a fleet of 35 BAE-146 aircraft. GitHub. , (2022).

- Shapiro, S. S., Wilk, M. B. An analysis of variance test for normality (complete samples). Biometrika. 52 (3-4), 591-611 (1965).

- Hintze, J. L., Nelson, R. D. Violin plots: A box plot-density trace synergism. The American Statistician. 52 (2), 181-184 (1998).

- Cohen, J. . Statistical Power Analysis for the Behavioral Sciences (2nd ed.). , (1988).

- Sawilowsky, S. S. New effect size rules of thumb. Journal of Modern Applied Statistical Methods. 8 (2), 26 (2009).

- Bateman, T. S., Crant, J. M. The proactive component of organizational behavior: A measure and correlates. Journal of Organizational Behavior. 14 (2), 103-118 (1993).

- Endsley, M. R. Measurement of situation awareness in dynamic systems. Human Factors. 37 (1), 65-84 (1995).

- Hunter, D. R. Measuring general aviation pilot judgment using a situational judgment technique. The International Journal of Aviation Psychology. 13 (4), 373-386 (2003).

- Kim, H. K., Park, J., Choi, Y., Choe, M. Virtual reality sickness questionnaire (VRSQ): Motion sickness measurement index in a virtual reality environment. Applied Ergonomics. 69, 66-73 (2018).

- Hart, S. G. . NASA Task Load Index (TLX). , (1986).

Nachdrucke und Genehmigungen

Genehmigung beantragen, um den Text oder die Abbildungen dieses JoVE-Artikels zu verwenden

Genehmigung beantragenThis article has been published

Video Coming Soon

Copyright © 2025 MyJoVE Corporation. Alle Rechte vorbehalten