Se requiere una suscripción a JoVE para ver este contenido. Inicie sesión o comience su prueba gratuita.

Method Article

Pruebas robotizadas de las posiciones de la cámara para determinar la configuración ideal para la visualización estéreo en 3D de la cirugía a corazón abierto

En este artículo

Resumen

La percepción de profundidad humana de los videos estéreo 3D depende de la separación de la cámara, el punto de convergencia, la distancia y la familiaridad del objeto. Este artículo presenta un método robotizado para la recopilación rápida y confiable de datos de prueba durante la cirugía a corazón abierto en vivo para determinar la configuración ideal de la cámara.

Resumen

El video estéreo 3D de procedimientos quirúrgicos puede ser muy valioso para la educación médica y mejorar la comunicación clínica. Pero el acceso al quirófano y al campo quirúrgico está restringido. Es un ambiente estéril, y el espacio físico está lleno de personal quirúrgico y equipo técnico. En este contexto, la captura no oscurecida y la reproducción realista de los procedimientos quirúrgicos son difíciles. Este artículo presenta un método para la recopilación rápida y confiable de datos de videos 3D estereoscópicos a diferentes distancias de referencia de la cámara y distancias de convergencia. Para recopilar datos de prueba con la mínima interferencia durante la cirugía, con alta precisión y repetibilidad, las cámaras se conectaron a cada mano de un robot de doble brazo. El robot estaba montado en el techo en la sala de operaciones. Fue programado para realizar una secuencia cronometrada de movimientos sincronizados de la cámara que atraviesan una gama de posiciones de prueba con una distancia de referencia entre 50-240 mm en pasos incrementales de 10 mm, y a dos distancias de convergencia de 1100 mm y 1400 mm. La cirugía se detuvo para permitir 40 muestras de video consecutivas de 5 s. Se registraron un total de 10 escenarios quirúrgicos.

Introducción

En cirugía, la visualización 3D se puede utilizar para la educación, el diagnóstico, la planificación preoperatoria y la evaluación postoperatoria1,2. La percepción realista de la profundidad puede mejorar la comprensión3,4,5,6 de las anatomías normales y anormales. Las grabaciones de video 2D simples de procedimientos quirúrgicos son un buen comienzo. Sin embargo, la falta de percepción de profundidad puede dificultar que los colegas no quirúrgicos comprendan completamente las relaciones antero-posteriores entre diferentes estructuras anatómicas y, por lo tanto, también introducir un riesgo de mala interpretación de la anatomía7,8,9,10.

La experiencia de visualización en 3D se ve afectada por cinco factores: (1) La configuración de la cámara puede ser paralela o toed-in como se muestra en la Figura 1, (2) Distancia de referencia (la separación entre las cámaras). (3) Distancia al objeto de interés y otras características de la escena, como el fondo. (4) Características de los dispositivos de visualización, como el tamaño de la pantalla y la posición de visualización1,11,12,13. (5) Preferencias individuales de los espectadores14,15.

El diseño de una configuración de cámara 3D comienza con la captura de videos de prueba grabados a varias distancias de referencia de la cámara y configuraciones que se utilizarán para la evaluación subjetiva o automática16,17,18,19,20. La distancia de la cámara debe ser constante al campo quirúrgico para capturar imágenes nítidas. Se prefiere el enfoque fijo porque el enfoque automático se ajustará para enfocar las manos, los instrumentos o las cabezas que puedan aparecer a la vista. Sin embargo, esto no es fácilmente alcanzable cuando la escena de interés es el campo quirúrgico. Los quirófanos son áreas de acceso restringido porque estas instalaciones deben mantenerse limpias y estériles. El equipo técnico, los cirujanos y las enfermeras de fregado a menudo se agrupan estrechamente alrededor del paciente para garantizar una buena visión general visual y un flujo de trabajo eficiente. Para comparar y evaluar el efecto de las posiciones de la cámara en la experiencia de visualización 3D, un rango de prueba completo de posiciones de cámara debe ser la grabación de la misma escena, ya que las características del objeto, como la forma, el tamaño y el color, pueden afectar la experiencia de visualización 3D21.

Por la misma razón, los rangos de prueba completos de las posiciones de la cámara deben repetirse en diferentes procedimientos quirúrgicos. Toda la secuencia de posiciones debe repetirse con alta precisión. En un entorno quirúrgico, los métodos existentes que requieren el ajuste manual de la distancia basal22 o diferentes pares de cámaras con distancias basales fijas23 no son factibles debido a limitaciones de espacio y tiempo. Para hacer frente a este desafío, se diseñó esta solución robotizada.

Los datos se recogieron con un robot industrial colaborativo de doble brazo montado en el techo del quirófano. Las cámaras se conectaron a las muñecas del robot y se movieron a lo largo de una trayectoria en forma de arco con una distancia de referencia creciente, como se muestra en la Figura 2.

Para demostrar el enfoque, se registraron 10 series de pruebas de 4 pacientes diferentes con 4 defectos cardíacos congénitos diferentes. Se eligieron escenas cuando era factible una pausa en la cirugía: con los corazones latiendo justo antes y después de la reparación quirúrgica. También se hicieron series cuando los corazones fueron arrestados. Las cirugías se detuvieron durante 3 minutos y 20 s para recolectar cuarenta secuencias de 5 con diferentes distancias de convergencia de la cámara y distancias de referencia para capturar la escena. Los videos fueron posteriormente postprocesados, mostrados en 3D para el equipo clínico, que calificó cuán realista era el video 3D a lo largo de una escala de 0 a 5.

El punto de convergencia para las cámaras estéreo es donde se encuentran los puntos centrales de ambas imágenes. El punto de convergencia puede, por principio, colocarse delante, dentro o detrás del objeto, véase la Figura 1A-C. Cuando el punto de convergencia está frente al objeto, el objeto se capturará y se mostrará a la izquierda de la línea media para la imagen de la cámara izquierda y a la derecha de la línea media para la imagen de la cámara derecha (Figura 1A). Lo contrario se aplica cuando el punto de convergencia está detrás del objeto (Figura 1B). Cuando el punto de convergencia está en el objeto, el objeto también aparecerá en la línea media de las imágenes de la cámara (Figura 1C), lo que presumiblemente debería producir la visualización más cómoda ya que no se requiere entrecerrar los ojos para fusionar las imágenes. Para lograr un video 3D estéreo cómodo, el punto de convergencia debe ubicarse en, o ligeramente detrás, del objeto de interés, de lo contrario se requiere que el espectador entrecierre voluntariamente los ojos hacia afuera (exotropía).

Los datos se recopilaron utilizando un robot industrial colaborativo de doble brazo para posicionar las cámaras (Figura 2A-B). El robot pesa 38 kg sin equipo. El robot es intrínsecamente seguro; cuando detecta un impacto inesperado, deja de moverse. El robot fue programado para posicionar las cámaras de 5 megapíxeles con lentes de montura C a lo largo de una trayectoria en forma de arco que se detiene a distancias de referencia predeterminadas (Figura 2C). Las cámaras se conectaron a las manos del robot utilizando placas adaptadoras, como se muestra en la Figura 3. Cada cámara grabó a 25 fotogramas por segundo. Las lentes se ajustaron en f-stop 1/8 con el enfoque fijo en el objeto de interés (centro geométrico aproximado del corazón). Cada fotograma de imagen tenía una marca de tiempo que se usaba para sincronizar las dos secuencias de vídeo.

Se calibraron los desplazamientos entre la muñeca del robot y la cámara. Esto se puede lograr alineando el punto de mira de las imágenes de la cámara, como se muestra en la Figura 4. En esta configuración, el desplazamiento traslacional total desde el punto de montaje en la muñeca del robot y el centro del sensor de imagen de la cámara fue de 55,3 mm en la dirección X y 21,2 mm en la dirección Z, que se muestra en la Figura 5. Los desplazamientos rotacionales se calibraron a una distancia de convergencia de 1100 mm y una distancia de referencia de 50 mm y se ajustaron manualmente con el joystick en el panel de control del robot. El robot en este estudio tenía una precisión especificada de 0,02 mm en el espacio cartesiano y una resolución rotacional de 0,01 grados24. En un radio de 1100 m, una diferencia de ángulo de 0,01 grados compensa el punto central 0,2 mm. Durante el movimiento completo del robot de separación de 50-240 mm, la cruz de cada cámara estaba a 2 mm del centro ideal de convergencia.

La distancia de referencia se incrementó paso a paso mediante la separación simétrica de las cámaras alrededor del centro del campo de visión en incrementos de 10 mm que oscilan entre 50 y 240 mm (Figura 2). Las cámaras se mantuvieron detenidas durante 5 s en cada posición y se movieron entre las posiciones a una velocidad de 50 mm/s. El punto de convergencia podría ajustarse en direcciones X y Z utilizando una interfaz gráfica de usuario (Figura 6). El robot siguió en consecuencia dentro de su rango de trabajo.

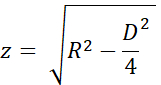

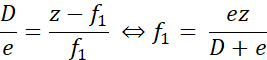

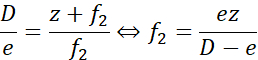

La precisión del punto de convergencia se estimó utilizando los triángulos uniformes y los nombres de las variables de las figuras 7A y B. La altura 'z' se calculó a partir de la distancia de convergencia 'R' con el teorema de Pitágoras como

Cuando el punto de convergencia real estaba más cerca que el punto deseado, como se muestra en la Figura 7A, la distancia de error 'f1' se calculó como

Del mismo modo, cuando el punto de convergencia era distal al punto deseado, la distancia de error 'f2' se calculó como

Aquí, 'e' fue la separación máxima entre los puntos de mira, como máximo 2 mm en la separación basal máxima durante la calibración (D = 240 mm). Para R = 1100 mm (z = 1093 mm), el error fue menor que ± 9,2 mm. Para R = 1400 mm (z = 1395 mm), el error fue ± 11,7 mm. Es decir, el error de la colocación del punto de convergencia estuvo dentro del 1% del deseado. Por lo tanto, las dos distancias de prueba de 1100 mm y 1400 mm estaban bien separadas.

Protocolo

Los experimentos fueron aprobados por el Comité de Ética local en Lund, Suecia. La participación fue voluntaria y los tutores legales de los pacientes dieron su consentimiento informado por escrito.

1. Instalación y configuración del robot

NOTA: Este experimento utilizó un robot industrial colaborativo de doble brazo y el panel de control estándar con una pantalla táctil. El robot se controla con el software de controlador RobotWare 6.10.01 y el entorno de desarrollo integrado del robot (IDE) RobotStudio 2019.525. El software desarrollado por los autores, incluida la aplicación del robot, la aplicación de grabación y los scripts de postprocesamiento, están disponibles en el repositorio de GitHub26.

PRECAUCIÓN: Use anteojos protectores y velocidad reducida durante la configuración y prueba del programa del robot.

- Monte el robot en el techo o en una mesa utilizando pernos dimensionados para 100 kg como se describe en la página 25 de la especificación del producto24, siguiendo las especificaciones del fabricante. Asegúrese de que los brazos puedan moverse libremente y que la línea de visión hacia el campo de visión no esté oscurecida.

PRECAUCIÓN: Utilice cuerdas elevadoras o de seguridad cuando monte el robot en una posición alta. - Inicie el robot girando el interruptor de arranque ubicado en la base del robot. Calibre el robot siguiendo el procedimiento descrito en el manual de operación en las páginas 47-5625.

- Inicie el IDE del robot en una computadora con Windows.

- Conéctese al sistema físico del robot (manual de funcionamiento página 14027).

- Cargue el código del programa del robot y las bibliotecas de aplicaciones para la interfaz de usuario del robot:

- El código de robot para un robot montado en el techo se encuentra en la carpeta Robot/InvertedCode y para un robot montado en mesa en Robot/TableMountedCode. Para cada uno de los archivos left/Data.mod, left/MainModule.mod, right/Data.mod y right/MainModule.mod:

- Cree un nuevo módulo de programa (consulte la página 31827 del manual de funcionamiento) con el mismo nombre que el archivo (Data o MainModule) y copie el contenido del archivo en el nuevo módulo.

- Presione Aplicar en el IDE del robot para guardar los archivos en el robot.

- Utilice Transferencia de archivos (manual de funcionamiento página 34627) para transferir los archivos de aplicación del robot TpSViewStereo2.dll, TpsViewStereo2.gtpu.dll y TpsViewStereo2.pdb ubicados en la carpeta FPApp al robot. Después de este paso, el IDE del robot no se utilizará más.

- Pulse el botón Reset (Reinicio ) situado en la parte posterior de la pantalla táctil del robot (FlexPendant) para volver a cargar la interfaz gráfica. La aplicación del robot Stereo2 ahora será visible en el menú de la pantalla táctil.

- Instale la aplicación de grabación (Liveview) y la aplicación de posprocesamiento en una computadora Ubuntu 20.04 ejecutando el script install_all_linux.sh, ubicado en la carpeta raíz en el repositorio de Github.

- Monte cada cámara en el robot. Los componentes necesarios para el montaje se muestran en la Figura 3A.

- Monte el objetivo en la cámara.

- Monte la cámara en la placa adaptadora de la cámara con tres tornillos M2.

- Monte la placa de montaje circular en la placa adaptadora de la cámara con cuatro tornillos M6 en el lado opuesto de la cámara.

- Repita los pasos 1.9.1-1.9.3 para la otra cámara. Los conjuntos resultantes se reflejan, como se muestra en la Figura 3B y la Figura 3C.

- Monte la placa adaptadora en la muñeca del robot con cuatro tornillos M2.5, como se muestra en la Figura 3D.

- Para un robot montado en el techo: conecte la cámara izquierda de la Figura 3C al brazo robótico izquierdo como se muestra en la Figura 2A.

- Para un robot montado en la mesa: conecte la cámara izquierda de la Figura 3C al brazo robótico derecho.

- Conecte los cables USB a las cámaras, como se muestra en la Figura 3E, y a la computadora Ubuntu.

2. Verifique la calibración de la cámara

- En la pantalla táctil del robot, pulse el botón Menú y seleccione Stereo2 para iniciar la aplicación del robot. Esto abrirá la pantalla principal, como se muestra en la Figura 6A.

- En la pantalla principal, presione Ir para comenzar durante 1100 mm en la aplicación del robot y espere a que el robot se mueva a la posición inicial.

- Retire las tapas protectoras de la lente de las cámaras y conecte los cables USB a la computadora Ubuntu.

- Coloque una rejilla de calibración impresa (CalibrationGrid.png en el repositorio) a 1100 mm de los sensores de la cámara. Para facilitar la correcta identificación de los cuadrados correspondientes, coloque una pequeña tuerca de tornillo o una marca en algún lugar del centro de la cuadrícula.

- Inicie la aplicación de grabación en la computadora Ubuntu (ejecute el script start.sh ubicado en la carpeta liveview dentro del repositorio de Github). Esto inicia la interfaz, como se muestra en la Figura 4.

- Ajuste la apertura y el enfoque en la lente con los anillos de apertura y enfoque.

- En la aplicación de grabación, marque Crosshair para visualizar el punto de mira.

- En la aplicación de grabación, asegúrese de que el punto de mira se alinea con la rejilla de calibración en la misma posición en ambas imágenes de cámara, como se muestra en la Figura 4. Lo más probable es que se requiera algún ajuste de la siguiente manera:

- Si las cruces no se superponen, presione el icono de engranaje ( figura 6A inferior izquierda) en la aplicación del robot en la pantalla táctil del robot para abrir la pantalla de configuración, como se muestra en la Figura 6B.

- Presione en 1. Vaya a Iniciar pos, como se muestra en la figura 6B.

- Trote el robot con el joystick para ajustar la posición de la cámara (manual de operación página 3123).

- Actualice la posición de la herramienta para cada brazo robótico. Presione 3. Actualizar herramienta izquierda y 4. Actualice la herramienta derecha para guardar la calibración del brazo izquierdo y derecho, respectivamente.

- Pulse el icono flecha atrás (arriba a la derecha, Figura 6B) para volver a la pantalla principal.

- Pulse Ejecutar experimento (Figura 6A) en la aplicación del robot y compruebe que el punto de mira se alinea. De lo contrario, repita los pasos 2.3-2.3.5.

- Agregue y pruebe cualquier cambio en las distancias y / o el tiempo en este punto. Esto requiere cambios en el código del programa del robot y habilidades avanzadas de programación del robot. Cambie las siguientes variables en el módulo Datos en la tarea izquierda (brazo): las distancias de separación deseadas en la variable de matriz entera Distancias, las distancias de convergencia en la matriz entera ConvergencePos y edite el tiempo en cada paso editando la variable Nwaittime (valor en segundos).

PRECAUCIÓN: Nunca ejecute un programa de robot no probado durante la cirugía en vivo. - Cuando se complete la calibración, presione Levantar para elevar los brazos del robot a la posición de espera.

- Opcionalmente, apague el robot.

NOTA: El procedimiento se puede pausar entre cualquiera de los pasos anteriores.

3. Preparación al inicio de la cirugía

- Desempolva el robot.

- Si el robot estaba apagado, inícielo encendiendo el interruptor de inicio ubicado en la base del robot.

- Inicie la aplicación del robot en la pantalla táctil y la aplicación de grabación descritas en los pasos 2.1 y 2.2.

- En la aplicación de grabación, cree y luego seleccione la carpeta donde guardar el video (presione Cambiar carpeta).

- En la aplicación del robot: presione el ícono de engranaje, coloque las cámaras en relación con el paciente. Cambie la dirección X y Z presionando +/- para Distancia de la mano desde el robot y Altura, respectivamente, para que la imagen capture el campo quirúrgico. Realice el posicionamiento en la dirección Y moviendo manualmente el robot o el paciente.

NOTA: Los preparativos se pueden pausar entre los pasos de preparación 3.1-3.4.

4. Experimenta

PRECAUCIÓN: Todo el personal debe ser informado sobre el experimento de antemano.

- Pausar la cirugía.

- Informe al personal de quirófano que se ha iniciado el experimento.

- Pulse Grabar en la aplicación de grabación.

- Pulse Ejecutar experimento en la aplicación del robot.

- Espere mientras el programa se está ejecutando; el robot muestra "Listo" en la aplicación del robot en la pantalla táctil cuando termina.

- Detenga la grabación en la aplicación de grabación presionando Salir.

- Informe al personal de quirófano que el experimento ha finalizado.

- Reanudar la cirugía.

NOTA: El experimento no se puede pausar durante los pasos 4.1-4.6.

5. Repite

- Repita los pasos 4.1-4.6 para capturar otra secuencia y los pasos 3.1-3.4 y los pasos 4.1-4.6 para capturar secuencias de diferentes cirugías. Captura alrededor de diez secuencias completas.

6. Postprocesamiento

NOTA: Los siguientes pasos se pueden llevar a cabo utilizando la mayoría del software de edición de video o los scripts proporcionados en la carpeta de posprocesamiento.

- En este caso, debayer el video tal como está guardado en el formato RAW:

- Ejecute el script postprocessing/debayer/run.sh para abrir la aplicación debayer que se muestra en la figura 8A.

- Pulse Examinar directorio de entrada y seleccione la carpeta con el vídeo RAW.

- Pulse Examinar directorio de salida y seleccione una carpeta para los archivos de vídeo descapotables y ajustados por color resultantes.

- ¡Presiona Debayer! y espere hasta que finalice el proceso: ambas barras de progreso están llenas, como se muestra en la Figura 8B.

- Combina los vídeos sincronizados a la derecha y a la izquierda con el formato estéreo 3D28:

- Ejecute el script postprocessing/merge_tb/run.sh para iniciar la aplicación de combinación; abre la interfaz gráfica de usuario que se muestra en la Figura 8C.

- Pulse Examinar directorio de entrada y seleccione la carpeta con los archivos de vídeo desmenuzados.

- Pulse Examinar directorio de salida y seleccione una carpeta para el archivo estéreo 3D combinado resultante.

- ¡Presiona Fusionar! y espere hasta que se muestre la pantalla de finalización de la Figura 8D .

- Utilice un software de edición de vídeo estándar, como Premiere Pro, para añadir etiquetas de texto a cada distancia de cámara del vídeo.

NOTA: En el video, hay una sacudida visible cada vez que el robot se mueve, y la distancia de la cámara aumenta. En este experimento, se utilizaron etiquetas A-T para las distancias de la cámara.

7. Evaluación

- Muestre el vídeo en formato 3D superior e inferior con un proyector 3D activo.

- La experiencia de visualización depende del ángulo de visión y la distancia a la pantalla; evaluar el video utilizando la audiencia prevista y la configuración.

Resultados

En video1 se muestra un video de evaluación aceptable con la imagen correcta colocada en la parte superior en 3D estereoscópico superior-inferior. Una secuencia exitosa debe ser nítida, enfocada y sin marcos de imagen no sincronizados. Las transmisiones de video no sincronizadas causarán desenfoque, como se muestra en el archivo Video 2. El punto de convergencia debe estar centrado horizontalmente, independientemente de la separación de la cámara, como se ve en

Discusión

Durante la cirugía en vivo, el tiempo total del experimento utilizado para la recopilación de datos de video en 3D se limitó para ser seguro para el paciente. Si el objeto está desenfocado o sobreexpuesto, los datos no se pueden utilizar. Los pasos críticos son durante la calibración y configuración de la herramienta de la cámara (paso 2). La apertura y el enfoque de la cámara no se pueden cambiar cuando la cirugía ha comenzado; se deben utilizar las mismas condiciones de iluminación y distancia durante la con...

Divulgaciones

Los autores no tienen nada que revelar.

Agradecimientos

La investigación se llevó a cabo con fondos de Vinnova (2017-03728, 2018-05302 y 2018-03651), Heart-Lung Foundation (20180390), Family Kamprad Foundation (20190194) y Anna-Lisa y Sven Eric Lundgren Foundation (2017 y 2018).

Materiales

| Name | Company | Catalog Number | Comments |

| 2 C-mount lenses (35 mm F2.1, 5 M pixel) | Tamron | M112FM35 | Rated for 5 Mpixel |

| 3D glasses (DLP-link active shutter) | Celexon | G1000 | Any compatible 3D glasses can be used |

| 3D Projector | Viewsonic | X10-4K | Displays 3D in 1080, can be exchanged for other 3D projectors |

| 6 M2 x 8 screws | To attach the cXimea cameras to the camera adaptor plates | ||

| 8 M2.5 x 8 screws | To attach the circular mounting plates to the robot wrist | ||

| 8 M5 x 40 screws | To mount the robot | ||

| 8 M6 x 10 screws with flat heads | For attaching the circular mounting plate and the camera adaptor plates | ||

| Calibration checker board plate (25 by 25 mm) | Any standard checkerboard can be used, including printed, as long as the grid is clearly visible in the cameras | ||

| Camera adaptor plates, x2 | Designed by the authors in robot_camera_adaptor_plates.dwg, milled in aluminium. | ||

| Circular mounting plates, x2 | Distributed with the permission of the designer Julius Klein and printed with ABS plastic on an FDM 3D printer. License Tecnalia Research & Innovation 2017. Attached as Mountingplate_ROBOT_SIDE_ NewDesign_4.stl | ||

| Fix focus usb cameras, x2 (5 Mpixel) | Ximea | MC050CG-SY-UB | With Sony IMX250LQR sensor |

| Flexpendant | ABB | 3HAC028357-001 | robot touch display |

| Liveview | recording application | ||

| RobotStudio | robot integrated development environment (IDE) | ||

| USB3 active cables (10.0 m), x2 | Thumbscrew lock connector, water proofed. | ||

| YuMi dual-arm robot | ABB | IRB14000 |

Referencias

- Held, R. T., Hui, T. T. A guide to stereoscopic 3D displays in medicine. Academic Radiology. 18 (8), 1035-1048 (2011).

- van Beurden, M. H. P. H., IJsselsteijn, W. A., Juola, J. F. Effectiveness of stereoscopic displays in medicine: A review. 3D Research. 3 (1), 1-13 (2012).

- Luursema, J. M., Verwey, W. B., Kommers, P. A. M., Geelkerken, R. H., Vos, H. J. Optimizing conditions for computer-assisted anatomical learning. Interacting with Computers. 18 (5), 1123-1138 (2006).

- Takano, M., et al. Usefulness and capability of three-dimensional, full high-definition movies for surgical education. Maxillofacial Plastic and Reconstructive Surgery. 39 (1), 10 (2017).

- Triepels, C. P. R., et al. Does three-dimensional anatomy improve student understanding. Clinical Anatomy. 33 (1), 25-33 (2020).

- Beermann, J., et al. Three-dimensional visualisation improves understanding of surgical liver anatomy. Medical Education. 44 (9), 936-940 (2010).

- Battulga, B., Konishi, T., Tamura, Y., Moriguchi, H. The Effectiveness of an interactive 3-dimensional computer graphics model for medical education. Interactive Journal of Medical Research. 1 (2), (2012).

- Yammine, K., Violato, C. A meta-analysis of the educational effectiveness of three-dimensional visualization technologies in teaching anatomy. Anatomical Sciences Education. 8 (6), 525-538 (2015).

- Fitzgerald, J. E. F., White, M. J., Tang, S. W., Maxwell-Armstrong, C. A., James, D. K. Are we teaching sufficient anatomy at medical school? The opinions of newly qualified doctors. Clinical Anatomy. 21 (7), 718-724 (2008).

- Bergman, E. M., Van Der Vleuten, C. P. M., Scherpbier, A. J. J. A. Why don't they know enough about anatomy? A narrative review. Medical Teacher. 33 (5), 403-409 (2011).

- Terzić, K., Hansard, M. Methods for reducing visual discomfort in stereoscopic 3D: A review. Signal Processing: Image Communication. 47, 402-416 (2016).

- Fan, Z., Weng, Y., Chen, G., Liao, H. 3D interactive surgical visualization system using mobile spatial information acquisition and autostereoscopic display. Journal of Biomedical Informatics. 71, 154-164 (2017).

- Fan, Z., Zhang, S., Weng, Y., Chen, G., Liao, H. 3D quantitative evaluation system for autostereoscopic display. Journal of Display Technology. 12 (10), 1185-1196 (2016).

- McIntire, J. P., et al. Binocular fusion ranges and stereoacuity predict positional and rotational spatial task performance on a stereoscopic 3D display. Journal of Display Technology. 11 (11), 959-966 (2015).

- Kalia, M., Navab, N., Fels, S. S., Salcudean, T. A method to introduce & evaluate motion parallax with stereo for medical AR/MR. IEEE Conference on Virtual Reality and 3D User Interfaces. , 1755-1759 (2019).

- Kytö, M., Hakala, J., Oittinen, P., Häkkinen, J. Effect of camera separation on the viewing experience of stereoscopic photographs. Journal of Electronic Imaging. 21 (1), 1-9 (2012).

- Moorthy, A. K., Su, C. C., Mittal, A., Bovik, A. C. Subjective evaluation of stereoscopic image quality. Signal Processing: Image Communication. 28 (8), 870-883 (2013).

- Yilmaz, G. N. A depth perception evaluation metric for immersive 3D video services. 3DTV Conference: The True Vision - Capture, Transmission and Display of 3D Video. , 1-4 (2017).

- Lebreton, P., Raake, A., Barkowsky, M., Le Callet, P. Evaluating depth perception of 3D stereoscopic videos. IEEE Journal on Selected Topics in Signal Processing. 6, 710-720 (2012).

- López, J. P., Rodrigo, J. A., Jiménez, D., Menéndez, J. M. Stereoscopic 3D video quality assessment based on depth maps and video motion. EURASIP Journal on Image and Video Processing. 2013 (1), 62 (2013).

- Banks, M. S., Read, J. C., Allison, R. S., Watt, S. J. Stereoscopy and the human visual system. SMPTE Motion Imaging Journal. 121 (4), 24-43 (2012).

- Kytö, M., Nuutinen, M., Oittinen, P. Method for measuring stereo camera depth accuracy based on stereoscopic vision. Three-Dimensional Imaging, Interaction, and Measurement. 7864, 168-176 (2011).

- Kang, Y. S., Ho, Y. S. Geometrical compensation algorithm of multiview image for arc multi-camera arrays. Advances in Multimedia Information Processing. 2008, 543-552 (2008).

- Product Specification IRB 14000. DocumentID: 3HAC052982-001 Revision J. ABB Robotics Available from: https://library.abb.com/en/results (2018)

- Operating Manual IRB 14000. Document ID: 3HAC052986-001 Revision F. ABB Robotics Available from: https://library.abb.com/en/results (2019)

- . Github repository Available from: https://github.com/majstenmark/stereo2 (2021)

- Operating manual RobotStudio. Document ID: 3HAC032104-001 Revision Y. ABB Robotics Available from: https://library.abb.com/en/results (2019)

- Won, C. S. Adaptive interpolation for 3D stereoscopic video in frame-compatible top-bottom packing. IEEE International Conference on Consumer Electronics. 2011, 179-180 (2011).

- Kim, S. K., Lee, C., Kim, K. T., Javidi, B., Okano, F., Son, J. Y. Multi-view image acquisition and display. Three-Dimensional Imaging, Visualization, and Display. , 227-249 (2009).

- Liu, F., Niu, Y., Jin, H. Keystone correction for stereoscopic cinematography. IEEE Computer Society Conference on Computer Vision and Pattern Recognition Workshops. 2012, 1-7 (2012).

- Kang, W., Lee, S. Horizontal parallax distortion correction method in toed-in camera with wide-angle lens. 3DTV Conference: The True Vision - Capture, Transmission and Display of 3D Video. 2009, 1-4 (2009).

Reimpresiones y Permisos

Solicitar permiso para reutilizar el texto o las figuras de este JoVE artículos

Solicitar permisoThis article has been published

Video Coming Soon

ACERCA DE JoVE

Copyright © 2025 MyJoVE Corporation. Todos los derechos reservados