É necessária uma assinatura da JoVE para visualizar este conteúdo. Faça login ou comece sua avaliação gratuita.

Method Article

Teste robotizado de posições da câmera para determinar configuração ideal para visualização estéreo 3D de cirurgia de coração aberto

Neste Artigo

Resumo

A percepção de profundidade humana dos vídeos estéreo 3D depende da separação da câmera, ponto de convergência, distância e familiaridade do objeto. Este artigo apresenta um método robotizado para coleta rápida e confiável de dados de teste durante a cirurgia de coração aberto ao vivo para determinar a configuração ideal da câmera.

Resumo

O vídeo estéreo 3D de procedimentos cirúrgicos pode ser altamente valioso para a educação médica e melhorar a comunicação clínica. Mas o acesso à sala de cirurgia e ao campo cirúrgico é restrito. É um ambiente estéril, e o espaço físico está lotado de equipe cirúrgica e equipamentos técnicos. Neste cenário, a captura não obscurecido e a reprodução realista dos procedimentos cirúrgicos são difíceis. Este artigo apresenta um método para coleta rápida e confiável de dados de vídeos 3D estereoscópicos a diferentes distâncias de linha de base da câmera e distâncias de convergência. Para coletar dados de teste com interferência mínima durante a cirurgia, com alta precisão e repetibilidade, as câmeras foram anexadas a cada mão de um robô de braço duplo. O robô estava montado no teto da sala de cirurgia. Foi programado para realizar uma sequência cronometrada de movimentos sincronizados da câmera passando por uma gama de posições de teste com distância de linha de base entre 50-240 mm em etapas incrementais de 10 mm, e a duas distâncias de convergência de 1100 mm e 1400 mm. A cirurgia foi pausada para permitir 40 amostras de vídeo 5 s consecutivas. Foram registrados 10 cenários cirúrgicos.

Introdução

Na cirurgia, a visualização 3D pode ser usada para educação, diagnósticos, planejamento pré-operatório e avaliação pós-operatória1,2. A percepção de profundidade realista pode melhorar a compreensão3,4,5,6 de anatomias normais e anormais. Gravações simples de vídeo 2D de procedimentos cirúrgicos são um bom começo. No entanto, a falta de percepção de profundidade pode dificultar que os colegas não cirúrgicos compreendam plenamente as relações antero-posteriores entre diferentes estruturas anatômicas e, portanto, também introduzem um risco de má interpretação da anatomia7,8,9,10.

A experiência de visualização 3D é afetada por cinco fatores: (1) A configuração da câmera pode ser paralela ou toed-in como mostrado na Figura 1, (2) Distância da linha de base (a separação entre as câmeras). (3) Distância até o objeto de interesse e outras características da cena, como o fundo. (4) Características de dispositivos de visualização, como tamanho da tela e posição de visualização1,11,12,13. (5) Preferências individuais dos telespectadores14,15.

A concepção de uma configuração de câmera 3D começa com a captura de vídeos de teste gravados em várias distâncias e configurações da linha de base da câmera para serem usados para avaliação subjetiva ou automática16,17,18,19,20. A distância da câmera deve ser constante ao campo cirúrgico para capturar imagens nítidas. O foco fixo é preferido porque o foco automático se ajustará para focar em mãos, instrumentos ou cabeças que possam vir à vista. No entanto, isso não é facilmente alcançável quando a cena de interesse é o campo cirúrgico. As salas de cirurgia são áreas de acesso restrito porque essas instalações devem ser mantidas limpas e estéreis. Equipamentos técnicos, cirurgiões e enfermeiros de limpeza são frequentemente agrupados ao redor do paciente para garantir uma boa visão visual e um fluxo de trabalho eficiente. Para comparar e avaliar o efeito das posições da câmera na experiência de visualização 3D, uma faixa completa de teste de posições da câmera deve estar registrando a mesma cena porque as características do objeto, como forma, tamanho e cor, podem afetar a experiência de visualização 3D21.

Pelo mesmo motivo, as faixas completas de teste de posições da câmera devem ser repetidas em diferentes procedimentos cirúrgicos. Toda a sequência de posições deve ser repetida com alta precisão. Em um ambiente cirúrgico, os métodos existentes que requerem ajuste manual da distância da linha de base22 ou diferentes pares de câmeras com distâncias fixas da linha de base23 não são viáveis devido a restrições de espaço e tempo. Para enfrentar esse desafio, esta solução robotizada foi projetada.

Os dados foram coletados com um robô industrial colaborativo de braço duplo montado no teto da sala de cirurgia. As câmeras foram anexadas aos pulsos do robô e moveram-se ao longo de uma trajetória em forma de arco com crescente distância de linha de base, como mostrado na Figura 2.

Para demonstrar a abordagem, foram registradas 10 séries de testes de 4 pacientes diferentes com 4 defeitos cardíacos congênitos diferentes. As cenas foram escolhidas quando uma pausa na cirurgia era viável: com os corações batendo pouco antes e depois do reparo cirúrgico. Séries também foram feitas quando os corações foram presos. As cirurgias foram pausadas por 3 minutos e 20 s para coletar quarenta 5-ssequences com diferentes distâncias de convergência de câmera e distâncias de linha de base para capturar a cena. Os vídeos foram posteriormente pós-processados, exibidos em 3D para a equipe clínica, que classificou o quão realista o vídeo 3D foi ao longo de uma escala de 0-5.

O ponto de convergência para câmeras estéreo toed-in é onde os pontos centrais de ambas as imagens se encontram. O ponto de convergência pode, por princípio, ser colocado na frente, dentro ou atrás do objeto, ver a Figura 1A-C. Quando o ponto de convergência estiver na frente do objeto, o objeto será capturado e exibido à esquerda da linha média para a imagem da câmera esquerda e à direita da linha média para a imagem da câmera direita (Figura 1A). O oposto se aplica quando o ponto de convergência está atrás do objeto (Figura 1B). Quando o ponto de convergência estiver no objeto, o objeto também aparecerá na linha média das imagens da câmera (Figura 1C), o que, presumivelmente, deve render a visualização mais confortável, já que nenhum squinting é necessário para mesclar as imagens. Para obter um vídeo estéreo 3D confortável, o ponto de convergência deve estar localizado sobre, ou ligeiramente atrás, do objeto de interesse, senão o espectador é obrigado a olhar voluntariamente para fora (exotropia).

Os dados foram coletados utilizando um robô industrial colaborativo de braço duplo para posicionar as câmeras (Figura 2A-B). O robô pesa 38 kg sem equipamento. O robô é intrinsecamente seguro; quando detecta um impacto inesperado, ele pára de se mover. O robô foi programado para posicionar as câmeras de 5 Megapixels com lentes de montagem C ao longo de uma trajetória em forma de arco parando em distâncias de linha de base predeterminadas (Figura 2C). As câmeras foram anexadas às mãos do robô usando placas adaptadoras, como mostrado na Figura 3. Cada câmera gravada a 25 quadros por segundo. As lentes foram definidas em f-stop 1/8 com foco fixo no objeto de interesse (centro geométrico aproximado do coração). Cada quadro de imagem tinha um cronô de tempo que era usado para sincronizar as duas transmissões de vídeo.

Os deslocamentos entre o pulso do robô e a câmera foram calibrados. Isso pode ser alcançado alinhando a mira das imagens da câmera, como mostrado na Figura 4. Nesta configuração, o deslocamento translacional total do ponto de montagem no pulso do robô e o centro do sensor de imagem da câmera foi de 55,3 mm na direção X e 21,2 mm na direção Z, exibido na Figura 5. Os deslocamentos rotacionais foram calibrados a uma distância de convergência de 1100 mm e uma distância de linha de base de 50 mm e ajustado manualmente com o joystick no painel de controle do robô. O robô neste estudo teve uma precisão especificada de 0,02 mm no espaço cartesiano e 0,01 graus de resolução rotacional24. Num raio de 1100 m, uma diferença de ângulo de 0,01 graus compensa o ponto central de 0,2 mm. Durante o movimento completo do robô de 50-240 mm de separação, a mira de cada câmera estava dentro de 2 mm do centro ideal de convergência.

A distância da linha de base foi aumentada passo a passo pela separação simétrica das câmeras ao redor do centro do campo de visão em incrementos de 10 mm que variam de 50-240 mm (Figura 2). As câmeras foram mantidas paradas por 5 s em cada posição e movidas entre as posições a uma velocidade de 50 mm/s. O ponto de convergência pode ser ajustado nas direções X e Z usando uma interface gráfica de usuário (Figura 6). O robô seguiu de acordo dentro de seu alcance de trabalho.

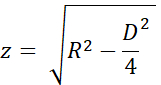

A precisão do ponto de convergência foi estimada utilizando-se os triângulos uniformes e os nomes variáveis nas Figuras 7A e B. A altura 'z' foi calculada a partir da distância de convergência 'R' com o teorema pitagórico como

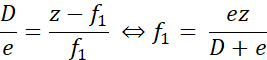

Quando o ponto de convergência real estava mais próximo do ponto desejado, como mostrado na Figura 7A, a distância de erro 'f1' foi calculada como

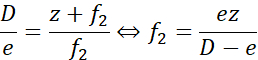

Da mesma forma, quando o ponto de convergência foi distal ao ponto desejado, a distância de erro 'f2' foi calculada como

Aqui, 'e' foi a separação máxima entre as miras, no máximo 2 mm na separação máxima da linha de base durante a calibração (D = 240 mm). Para R = 1100 mm (z = 1093 mm), o erro foi inferior a ± 9,2 mm. Para R = 1400 mm (z = 1395 mm), o erro foi ± 11,7 mm. Ou seja, o erro da colocação do ponto de convergência foi dentro de 1% do desejado. As duas distâncias de teste de 1100 mm e 1400 mm foram, portanto, bem separadas.

Protocolo

Os experimentos foram aprovados pelo Comitê de Ética local em Lund, Suécia. A participação foi voluntária, e os responsáveis legais dos pacientes forneceram consentimento por escrito informado.

1. Configuração e configuração do robô

NOTA: Este experimento usou um robô industrial colaborativo de dois braços e o painel de controle padrão com um display sensível ao toque. O robô é controlado com software de controlador RobotWare 6.10.01 e robot integrated development environment (IDE) RobotStudio 2019.525. Software desenvolvido pelos autores, incluindo o aplicativo robô, aplicativo de gravação e scripts pós-processamento, estão disponíveis no repositório GitHub26.

ATENÇÃO: Use óculos protetores e velocidade reduzida durante a configuração e teste do programa robô.

- Monte o robô no teto ou em uma mesa usando parafusos dimensionados por 100 kg conforme descrito na página 25 na especificação do produto24, seguindo as especificações do fabricante. Certifique-se de que os braços podem se mover livremente e a linha de visão para o campo de visão não é obscurecido.

ATENÇÃO: Levante ou as cordas de segurança ao montar o robô em uma posição elevada. - Inicie o robô girando o interruptor de partida localizado na base do robô. Calibrar o robô seguindo o procedimento descrito no manual de operação nas páginas 47-5625.

- Inicie o IDE robô em um computador Windows.

- Conecte-se ao sistema robô físico (página manual de funcionamento 14027).

- Carregue o código para o programa de robôs e bibliotecas de aplicativos para a interface do usuário para o robô:

- O código robô para um robô montado no teto está na pasta Robot/InvertedCode e para um robô montado em mesa em Robot/TableMountedCode. Para cada um dos arquivos esquerda/Data.mod, esquerda/MainModule.mod, right/Data.mod e right/MainModule.mod:

- Crie um novo módulo de programa (consulte a página manual de operação 31827) com o mesmo nome do arquivo (Data ou MainModule) e copie o conteúdo do arquivo para o novo módulo.

- Pressione o Aplicar no IDE robô para salvar os arquivos do robô.

- Use a Transferência de Arquivos (página manual de operação 34627) para transferir os arquivos do aplicativo robô TpSViewStereo2.dll, TpsViewStereo2.gtpu.dll e TpsViewStereo2.pdb localizados na pasta FPApp para o robô. Após esta etapa, o IDE robô não será mais utilizado.

- Pressione o botão Redefinir na parte de trás do display de toque do robô (FlexPendant) para recarregar a interface gráfica. O aplicativo robô Stereo2 agora será visível sob o menu de exibição de toque.

- Instale o aplicativo de gravação (Liveview) e o aplicativo de pós-processamento em um computador Ubuntu 20.04 executando o script install_all_linux.sh, localizado na pasta raiz no repositório do Github.

- Monte cada câmera para o robô. Os componentes necessários para a montagem são exibidos na Figura 3A.

- Monte a lente para a câmera.

- Monte a câmera na placa adaptadora da câmera com três parafusos M2.

- Monte a placa de montagem circular na placa adaptadora da câmera com quatro parafusos M6 no lado oposto da câmera.

- Repita as etapas 1.9.1-1.9.3 para a outra câmera. Os conjuntos resultantes são espelhados, como mostrado na Figura 3B e Figura 3C.

- Monte a placa adaptadora ao pulso do robô com quatro parafusos M2.5, como mostrado na Figura 3D.

- Para um robô montado no teto: conecte a câmera esquerda na Figura 3C ao braço do robô esquerdo, como mostrado na Figura 2A.

- Para um robô montado na mesa: conecte a câmera esquerda na Figura 3C ao braço do robô direito.

- Conecte os cabos USB às câmeras, como mostrado na Figura 3E, e ao computador Ubuntu.

2. Verifique a calibração da câmera

- No visor de toque do robô, pressione o botão Menu e selecione Stereo2 para iniciar a aplicação do robô. Isso abrirá a tela principal, como mostrado na Figura 6A.

- Na tela principal, pressione em Ir para iniciar por 1100 mm no aplicativo do robô e esperar que o robô se mova para a posição inicial.

- Remova as tampas das lentes protetoras das câmeras e conecte os cabos USB ao computador Ubuntu.

- Coloque uma grade de calibração impressa (CalibrationGrid.png no repositório) 1100 mm dos sensores da câmera. Para facilitar a identificação correta dos quadrados correspondentes, coloque uma pequena porca ou marque em algum lugar no centro da grade.

- Inicie o aplicativo de gravação no computador do Ubuntu (execute o script start.sh localizado na pasta liveview dentro do repositório do Github). Isso inicia a interface, como mostrado na Figura 4.

- Ajuste a abertura e foque na lente com a abertura e os anéis de foco.

- No aplicativo de gravação, verifique a Mira para visualizar a mira.

- No aplicativo de gravação, certifique-se de que a mira esteja alinhada com a grade de calibração na mesma posição em ambas as imagens da câmera, como mostrado na Figura 4. Provavelmente, algum ajuste será necessário da seguinte forma:

- Se as cruzes não se sobreporem, pressione o ícone Engrenagem (inferior esquerdo Figura 6A) no aplicativo robô no display de toque do robô para abrir a tela de configuração, como mostrado na Figura 6B.

- Pressione 1. Vá para Start Pos, como mostrado na Figura 6B.

- Corra o robô com o joystick para ajustar a posição da câmera (página manual de funcionamento 3123).

- Atualize a posição da ferramenta para cada braço robô. Pressione 3. Atualizar ferramenta esquerda e 4. Atualize a ferramenta direita para salvar a calibração para o braço esquerdo e direito, respectivamente.

- Pressione o ícone Back Arrow (superior direito, Figura 6B) para retornar à tela principal.

- Pressione o Experimento de Execução (Figura 6A) no aplicativo do robô e verifique se a mira se alinha. Caso contrário, repita as etapas 2.3-2.3.5.

- Adicione e teste quaisquer alterações nas distâncias e/ou tempo neste momento. Isso requer mudanças no código do programa robô e habilidades avançadas de programação de robôs. Alterar as seguintes variáveis no módulo Data na tarefa esquerda (braço): as distâncias de separação desejadas na variável de matriz inteiro Distâncias, as distâncias de convergência no array inteiro ConvergênciaPospos e editar o tempo em cada passo editando a variável Nwaittime (valor em segundos).

ATENÇÃO: Nunca execute um programa robô não testado durante a cirurgia ao vivo. - Quando a calibração estiver completa, pressione 'Levantar para elevar os braços do robô à posição de espera.

- Opcionalmente desligue o robô.

NOTA: O procedimento pode ser pausado entre qualquer uma das etapas acima.

3. Preparação no início da cirurgia

- Espasça o robô.

- Se o robô foi desligado, inicie-o ligando o interruptor Iniciar localizado na base do robô.

- Inicie o aplicativo robô no display de toque e aplicativo de gravação descrito nas etapas 2.1 e 2.2.

- No aplicativo de gravação, crie e selecione a pasta onde salvar o vídeo ( pressione a pasta de alteração).

- Na aplicação do robô: pressione o ícone da engrenagem, posicione as câmeras em relação ao paciente. Altere a direção X e Z pressionando +/- para Distância manual do Robô e Altura, respectivamente, para que a imagem capture o campo cirúrgico. Realize o posicionamento na direção Y movendo manualmente o robô ou o paciente.

NOTA: Os preparativos podem ser pausados entre as etapas de preparação 3.1-3.4.

4. Experimento

ATENÇÃO: Todo o pessoal deve ser informado sobre o experimento com antecedência.

- Pausar a cirurgia.

- Informe o pessoal da OR que o experimento foi iniciado.

- Pressione a Gravação no aplicativo de gravação.

- Testeça o experimento do Press Run na aplicação do robô.

- Espere enquanto o programa estiver em execução; o robô exibe "Feito" no aplicativo robô no display de toque quando terminado.

- Pare de gravar no aplicativo de gravação pressionando Quit.

- Informe o pessoal da OR que o experimento terminou.

- Retome a cirurgia.

NOTA: O experimento não pode ser pausado durante as etapas 4.1-4.6.

5. Repita

- Repita os passos 4.1-4.6 para capturar outra sequência e passos 3.1-3.4 e passos 4.1-4.6 para capturar sequências de diferentes cirurgias. Capture em torno de dez sequências completas.

6. Pós-processamento

NOTA: As seguintes etapas podem ser realizadas usando a maioria dos softwares de edição de vídeo ou os scripts fornecidos na pasta de pós-processamento.

- Neste caso, desbayer o vídeo como ele é salvo no formato RAW:

- Execute o script postprocessando/debayer/run.sh para abrir o aplicativo debayer mostrado na Figura 8A.

- Pressione procurar diretório de entrada e selecione a pasta com o vídeo RAW.

- Pressione o Diretório de Saída de Navegação e selecione uma pasta para os arquivos de vídeo resultantes desbayered e coloridos.

- Pressione Debayer! e esperar até que o processo seja concluído - ambas as barras de progresso estão cheias, como mostrado na Figura 8B.

- Mescle os vídeos sincronizados à direita e à esquerda ao formato estéreo 3D28:

- Executar o pósprocessamento/merge_tb/execução do script.sh para iniciar o aplicativo de fusão; ele abre a interface gráfica do usuário mostrada na Figura 8C.

- Pressione o Diretório de Entrada de Navegação e selecione a pasta com os arquivos de vídeo desbayerados.

- Pressione o Diretório de saída de navegação e selecione uma pasta para o arquivo estéreo 3D fundido resultante.

- Pressione Mesclagem! e esperar até que a tela de acabamento na Figura 8D seja mostrada.

- Use software de edição de vídeo off-the-shelf, como o Premiere Pro, para adicionar etiquetas de texto a cada distância da câmera no vídeo.

NOTA: No vídeo, há um aperto visível toda vez que o robô se moveu, e a distância da câmera aumentou. Neste experimento, os rótulos A-T foram usados para as distâncias da câmera.

7. Avaliação

- Exibir o vídeo em formato 3D inferior superior com um projetor 3D ativo.

- A experiência de visualização depende do ângulo de visão e da distância para a tela; avaliar o vídeo usando o público e a configuração pretendidos.

Resultados

Um vídeo de avaliação aceitável com a imagem certa colocada na parte superior do 3D estereoscópico é mostrado no Video1. Uma sequência bem sucedida deve ser afiada, focada e sem molduras de imagem não sincronizadas. Fluxos de vídeo não sincronizados causarão desfoque, como mostrado no arquivo Vídeo 2. O ponto de convergência deve ser centrado horizontalmente, independente da separação da câmera, como visto na Figura 9A,B. Qua...

Discussão

Durante a cirurgia ao vivo, o tempo total do experimento utilizado para coleta de dados de vídeo 3D limitou-se a ser seguro para o paciente. Se o objeto não estiver desconcentrado ou superexposto, os dados não poderão ser usados. As etapas críticas são durante a calibração e configuração da ferramenta da câmera (etapa 2). A abertura e o foco da câmera não podem ser alterados quando a cirurgia começou; as mesmas condições de iluminação e distância devem ser utilizadas durante a configuração e cirurgia...

Divulgações

Os autores não têm nada a revelar.

Agradecimentos

A pesquisa foi realizada com financiamento da Vinnova (2017-03728, 2018-05302 e 2018-03651), Fundação Coração-Pulmão (20180390), Fundação Família Kamprad (20190194) e Fundação Anna-Lisa e Sven Eric Lundgren (2017 e 2018).

Materiais

| Name | Company | Catalog Number | Comments |

| 2 C-mount lenses (35 mm F2.1, 5 M pixel) | Tamron | M112FM35 | Rated for 5 Mpixel |

| 3D glasses (DLP-link active shutter) | Celexon | G1000 | Any compatible 3D glasses can be used |

| 3D Projector | Viewsonic | X10-4K | Displays 3D in 1080, can be exchanged for other 3D projectors |

| 6 M2 x 8 screws | To attach the cXimea cameras to the camera adaptor plates | ||

| 8 M2.5 x 8 screws | To attach the circular mounting plates to the robot wrist | ||

| 8 M5 x 40 screws | To mount the robot | ||

| 8 M6 x 10 screws with flat heads | For attaching the circular mounting plate and the camera adaptor plates | ||

| Calibration checker board plate (25 by 25 mm) | Any standard checkerboard can be used, including printed, as long as the grid is clearly visible in the cameras | ||

| Camera adaptor plates, x2 | Designed by the authors in robot_camera_adaptor_plates.dwg, milled in aluminium. | ||

| Circular mounting plates, x2 | Distributed with the permission of the designer Julius Klein and printed with ABS plastic on an FDM 3D printer. License Tecnalia Research & Innovation 2017. Attached as Mountingplate_ROBOT_SIDE_ NewDesign_4.stl | ||

| Fix focus usb cameras, x2 (5 Mpixel) | Ximea | MC050CG-SY-UB | With Sony IMX250LQR sensor |

| Flexpendant | ABB | 3HAC028357-001 | robot touch display |

| Liveview | recording application | ||

| RobotStudio | robot integrated development environment (IDE) | ||

| USB3 active cables (10.0 m), x2 | Thumbscrew lock connector, water proofed. | ||

| YuMi dual-arm robot | ABB | IRB14000 |

Referências

- Held, R. T., Hui, T. T. A guide to stereoscopic 3D displays in medicine. Academic Radiology. 18 (8), 1035-1048 (2011).

- van Beurden, M. H. P. H., IJsselsteijn, W. A., Juola, J. F. Effectiveness of stereoscopic displays in medicine: A review. 3D Research. 3 (1), 1-13 (2012).

- Luursema, J. M., Verwey, W. B., Kommers, P. A. M., Geelkerken, R. H., Vos, H. J. Optimizing conditions for computer-assisted anatomical learning. Interacting with Computers. 18 (5), 1123-1138 (2006).

- Takano, M., et al. Usefulness and capability of three-dimensional, full high-definition movies for surgical education. Maxillofacial Plastic and Reconstructive Surgery. 39 (1), 10 (2017).

- Triepels, C. P. R., et al. Does three-dimensional anatomy improve student understanding. Clinical Anatomy. 33 (1), 25-33 (2020).

- Beermann, J., et al. Three-dimensional visualisation improves understanding of surgical liver anatomy. Medical Education. 44 (9), 936-940 (2010).

- Battulga, B., Konishi, T., Tamura, Y., Moriguchi, H. The Effectiveness of an interactive 3-dimensional computer graphics model for medical education. Interactive Journal of Medical Research. 1 (2), (2012).

- Yammine, K., Violato, C. A meta-analysis of the educational effectiveness of three-dimensional visualization technologies in teaching anatomy. Anatomical Sciences Education. 8 (6), 525-538 (2015).

- Fitzgerald, J. E. F., White, M. J., Tang, S. W., Maxwell-Armstrong, C. A., James, D. K. Are we teaching sufficient anatomy at medical school? The opinions of newly qualified doctors. Clinical Anatomy. 21 (7), 718-724 (2008).

- Bergman, E. M., Van Der Vleuten, C. P. M., Scherpbier, A. J. J. A. Why don't they know enough about anatomy? A narrative review. Medical Teacher. 33 (5), 403-409 (2011).

- Terzić, K., Hansard, M. Methods for reducing visual discomfort in stereoscopic 3D: A review. Signal Processing: Image Communication. 47, 402-416 (2016).

- Fan, Z., Weng, Y., Chen, G., Liao, H. 3D interactive surgical visualization system using mobile spatial information acquisition and autostereoscopic display. Journal of Biomedical Informatics. 71, 154-164 (2017).

- Fan, Z., Zhang, S., Weng, Y., Chen, G., Liao, H. 3D quantitative evaluation system for autostereoscopic display. Journal of Display Technology. 12 (10), 1185-1196 (2016).

- McIntire, J. P., et al. Binocular fusion ranges and stereoacuity predict positional and rotational spatial task performance on a stereoscopic 3D display. Journal of Display Technology. 11 (11), 959-966 (2015).

- Kalia, M., Navab, N., Fels, S. S., Salcudean, T. A method to introduce & evaluate motion parallax with stereo for medical AR/MR. IEEE Conference on Virtual Reality and 3D User Interfaces. , 1755-1759 (2019).

- Kytö, M., Hakala, J., Oittinen, P., Häkkinen, J. Effect of camera separation on the viewing experience of stereoscopic photographs. Journal of Electronic Imaging. 21 (1), 1-9 (2012).

- Moorthy, A. K., Su, C. C., Mittal, A., Bovik, A. C. Subjective evaluation of stereoscopic image quality. Signal Processing: Image Communication. 28 (8), 870-883 (2013).

- Yilmaz, G. N. A depth perception evaluation metric for immersive 3D video services. 3DTV Conference: The True Vision - Capture, Transmission and Display of 3D Video. , 1-4 (2017).

- Lebreton, P., Raake, A., Barkowsky, M., Le Callet, P. Evaluating depth perception of 3D stereoscopic videos. IEEE Journal on Selected Topics in Signal Processing. 6, 710-720 (2012).

- López, J. P., Rodrigo, J. A., Jiménez, D., Menéndez, J. M. Stereoscopic 3D video quality assessment based on depth maps and video motion. EURASIP Journal on Image and Video Processing. 2013 (1), 62 (2013).

- Banks, M. S., Read, J. C., Allison, R. S., Watt, S. J. Stereoscopy and the human visual system. SMPTE Motion Imaging Journal. 121 (4), 24-43 (2012).

- Kytö, M., Nuutinen, M., Oittinen, P. Method for measuring stereo camera depth accuracy based on stereoscopic vision. Three-Dimensional Imaging, Interaction, and Measurement. 7864, 168-176 (2011).

- Kang, Y. S., Ho, Y. S. Geometrical compensation algorithm of multiview image for arc multi-camera arrays. Advances in Multimedia Information Processing. 2008, 543-552 (2008).

- Product Specification IRB 14000. DocumentID: 3HAC052982-001 Revision J. ABB Robotics Available from: https://library.abb.com/en/results (2018)

- Operating Manual IRB 14000. Document ID: 3HAC052986-001 Revision F. ABB Robotics Available from: https://library.abb.com/en/results (2019)

- . Github repository Available from: https://github.com/majstenmark/stereo2 (2021)

- Operating manual RobotStudio. Document ID: 3HAC032104-001 Revision Y. ABB Robotics Available from: https://library.abb.com/en/results (2019)

- Won, C. S. Adaptive interpolation for 3D stereoscopic video in frame-compatible top-bottom packing. IEEE International Conference on Consumer Electronics. 2011, 179-180 (2011).

- Kim, S. K., Lee, C., Kim, K. T., Javidi, B., Okano, F., Son, J. Y. Multi-view image acquisition and display. Three-Dimensional Imaging, Visualization, and Display. , 227-249 (2009).

- Liu, F., Niu, Y., Jin, H. Keystone correction for stereoscopic cinematography. IEEE Computer Society Conference on Computer Vision and Pattern Recognition Workshops. 2012, 1-7 (2012).

- Kang, W., Lee, S. Horizontal parallax distortion correction method in toed-in camera with wide-angle lens. 3DTV Conference: The True Vision - Capture, Transmission and Display of 3D Video. 2009, 1-4 (2009).

Reimpressões e Permissões

Solicitar permissão para reutilizar o texto ou figuras deste artigo JoVE

Solicitar PermissãoThis article has been published

Video Coming Soon

Copyright © 2025 MyJoVE Corporation. Todos os direitos reservados