È necessario avere un abbonamento a JoVE per visualizzare questo. Accedi o inizia la tua prova gratuita.

Method Article

Test robotizzati delle posizioni della telecamera per determinare la configurazione ideale per la visualizzazione 3D stereo della chirurgia a cuore aperto

In questo articolo

Riepilogo

La percezione della profondità umana dei video stereo 3D dipende dalla separazione della telecamera, dal punto di convergenza, dalla distanza e dalla familiarità dell'oggetto. Questo documento presenta un metodo robotizzato per la raccolta rapida e affidabile dei dati di test durante la chirurgia a cuore aperto dal vivo per determinare la configurazione ideale della telecamera.

Abstract

Il video 3D stereo delle procedure chirurgiche può essere molto prezioso per l'educazione medica e migliorare la comunicazione clinica. Ma l'accesso alla sala operatoria e al campo chirurgico è limitato. È un ambiente sterile e lo spazio fisico è affollato di personale chirurgico e attrezzature tecniche. In questo contesto, la cattura non oscurata e la riproduzione realistica delle procedure chirurgiche sono difficili. Questo documento presenta un metodo per la raccolta rapida e affidabile di dati di video 3D stereoscopici a diverse distanze di base della telecamera e distanze di convergenza. Per raccogliere i dati dei test con interferenze minime durante l'intervento chirurgico, con alta precisione e ripetibilità, le telecamere sono state collegate a ciascuna mano di un robot a doppio braccio. Il robot era montato a soffitto in sala operatoria. È stato programmato per eseguire una sequenza temporizzata di movimenti sincronizzati della telecamera che attraversano una serie di posizioni di prova con distanza di base compresa tra 50-240 mm a passi incrementali di 10 mm e a due distanze di convergenza di 1100 mm e 1400 mm. L'intervento chirurgico è stato sospeso per consentire 40 campioni video consecutivi da 5 s. Sono stati registrati un totale di 10 scenari chirurgici.

Introduzione

In chirurgia, la visualizzazione 3D può essere utilizzata per l'istruzione, le diagnosi, la pianificazione pre-operatoria e la valutazione post-operatoria1,2. La percezione realistica della profondità può migliorare la comprensione3,4,5,6 di anatomie normali e anormali. Semplici registrazioni video 2D di procedure chirurgiche sono un buon inizio. Tuttavia, la mancanza di percezione della profondità può rendere difficile per i colleghi non chirurgici comprendere appieno le relazioni antero-posteriori tra diverse strutture anatomiche e quindi introdurre anche un rischio di interpretazione errata dell'anatomia7,8,9,10.

L'esperienza di visualizzazione 3D è influenzata da cinque fattori: (1) La configurazione della telecamera può essere parallela o integrata come mostrato nella Figura 1, (2) Distanza di base (la separazione tra le telecamere). (3) Distanza dall'oggetto di interesse e altre caratteristiche della scena come lo sfondo. (4) Caratteristiche dei dispositivi di visualizzazione come le dimensioni dello schermo e la posizione di visualizzazione1,11,12,13. (5) Preferenze individuali degli spettatori14,15.

La progettazione di una configurazione della fotocamera 3D inizia con l'acquisizione di video di prova registrati a varie distanze e configurazioni di base della telecamera da utilizzare per la valutazione soggettiva o automatica16,17,18,19,20. La distanza della fotocamera deve essere costante rispetto al campo chirurgico per acquisire immagini nitide. La messa a fuoco fissa è preferita perché l'autofocus si regola per mettere a fuoco mani, strumenti o teste che potrebbero entrare in vista. Tuttavia, questo non è facilmente realizzabile quando la scena di interesse è il campo chirurgico. Le sale operatorie sono aree ad accesso limitato perché queste strutture devono essere mantenute pulite e sterili. Attrezzature tecniche, chirurghi e infermieri di scrub sono spesso raggruppati strettamente attorno al paziente per garantire una buona panoramica visiva e un flusso di lavoro efficiente. Per confrontare e valutare l'effetto delle posizioni della telecamera sull'esperienza di visualizzazione 3D, una gamma di test completa delle posizioni della telecamera deve registrare la stessa scena perché le caratteristiche dell'oggetto come forma, dimensioni e colore possono influire sull'esperienza di visione 3D21.

Per lo stesso motivo, le gamme di test complete delle posizioni della telecamera devono essere ripetute su diverse procedure chirurgiche. L'intera sequenza di posizioni deve essere ripetuta con elevata precisione. In un ambiente chirurgico, i metodi esistenti che richiedono la regolazione manuale della distanza di base22 o diverse coppie di telecamere con distanze fisse di base23 non sono fattibili a causa di vincoli di spazio e tempo. Per affrontare questa sfida, è stata progettata questa soluzione robotizzata.

I dati sono stati raccolti con un robot industriale collaborativo a doppio braccio montato nel soffitto della sala operatoria. Le telecamere sono state attaccate ai polsi del robot e spostate lungo una traiettoria a forma di arco con una distanza di base crescente, come mostrato nella Figura 2.

Per dimostrare l'approccio, sono state registrate 10 serie di test da 4 diversi pazienti con 4 diversi difetti cardiaci congeniti. Le scene sono state scelte quando una pausa in chirurgia era fattibile: con i cuori che battono appena prima e dopo la riparazione chirurgica. Le serie sono state fatte anche quando i cuori sono stati arrestati. Gli interventi chirurgici sono stati sospesi per 3 minuti e 20 secondi per raccogliere quaranta 5-ssequence con diverse distanze di convergenza della fotocamera e distanze di base per catturare la scena. I video sono stati successivamente post-elaborati, visualizzati in 3D per il team clinico, che ha valutato quanto fosse realistico il video 3D su una scala da 0 a 5.

Il punto di convergenza per le telecamere stereo toed-in è dove si incontrano i punti centrali di entrambe le immagini. Il punto di convergenza può, in linea di principio, essere posizionato davanti, all'interno o dietro l'oggetto, vedi Figura 1A-C. Quando il punto di convergenza si trova di fronte all'oggetto, l'oggetto verrà catturato e visualizzato a sinistra della linea mediana per l'immagine della fotocamera sinistra e a destra della linea mediana per l'immagine della fotocamera destra (Figura 1A). Il contrario si applica quando il punto di convergenza è dietro l'oggetto (Figura 1B). Quando il punto di convergenza è sull'oggetto, l'oggetto apparirà anche nella linea mediana delle immagini della fotocamera (Figura 1C), che presumibilmente dovrebbe produrre la visione più comoda poiché non è necessario strizzare gli occhi per unire le immagini. Per ottenere un comodo video 3D stereo, il punto di convergenza deve essere posizionato sopra, o leggermente dietro, l'oggetto di interesse, altrimenti lo spettatore è tenuto a strizzare volontariamente gli occhi verso l'esterno (esotropia).

I dati sono stati raccolti utilizzando un robot industriale collaborativo a doppio braccio per posizionare le telecamere (Figura 2A-B). Il robot pesa 38 kg senza attrezzatura. Il robot è intrinsecamente sicuro; quando rileva un impatto imprevisto, smette di muoversi. Il robot è stato programmato per posizionare le telecamere da 5 Megapixel con obiettivi con innesto C lungo una traiettoria a forma di arco fermandosi a distanze di base predeterminate (Figura 2C). Le telecamere sono state attaccate alle mani del robot utilizzando piastre adattatori, come mostrato nella Figura 3. Ogni telecamera ha registrato a 25 fotogrammi al secondo. Le lenti sono state impostate a f-stop 1/8 con messa a fuoco fissa sull'oggetto di interesse (centro geometrico approssimativo del cuore). Ogni fotogramma dell'immagine aveva un timestamp che veniva utilizzato per sincronizzare i due flussi video.

Gli offset tra il polso del robot e la fotocamera sono stati calibrati. Ciò può essere ottenuto allineando il mirino delle immagini della fotocamera, come mostrato nella Figura 4. In questa configurazione, l'offset traslazionale totale dal punto di montaggio sul polso del robot e dal centro del sensore di immagine della telecamera era di 55,3 mm nella direzione X e 21,2 mm nella direzione Z, visualizzati nella Figura 5. Gli offset rotazionali sono stati calibrati a una distanza di convergenza di 1100 mm e una distanza di base di 50 mm e regolati manualmente con il joystick sul pannello di controllo del robot. Il robot in questo studio aveva una precisione specificata di 0,02 mm nello spazio cartesiano e una risoluzione rotazionale di 0,01 gradi24. Con un raggio di 1100 m, una differenza d'angolo di 0,01 gradi compensa il punto centrale di 0,2 mm. Durante il movimento completo del robot da 50-240 mm di separazione, il mirino di ogni telecamera era entro 2 mm dal centro ideale di convergenza.

La distanza di base è stata aumentata gradualmente dalla separazione simmetrica delle telecamere attorno al centro del campo visivo con incrementi di 10 mm compresi tra 50 e 240 mm (Figura 2). Le telecamere sono state tenute ferme per 5 s in ogni posizione e spostate tra le posizioni ad una velocità di 50 mm/s. Il punto di convergenza può essere regolato nelle direzioni X e Z utilizzando un'interfaccia utente grafica (Figura 6). Il robot ha seguito di conseguenza all'interno del suo raggio di lavoro.

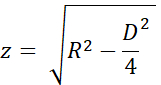

L'accuratezza del punto di convergenza è stata stimata utilizzando i triangoli uniformi e i nomi delle variabili nella Figura 7A e B. L'altezza 'z' è stata calcolata dalla distanza di convergenza 'R' con il teorema di Pitagora come

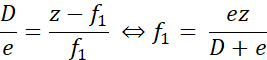

Quando il punto di convergenza reale era più vicino del punto desiderato, come mostrato nella Figura 7A, la distanza di errore 'f1' è stata calcolata come

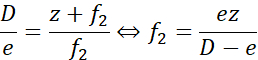

Allo stesso modo, quando il punto di convergenza era distale al punto desiderato, la distanza di errore 'f2' veniva calcolata come

Qui, 'e' era la massima separazione tra il mirino, al massimo 2 mm alla massima separazione della linea di base durante la calibrazione (D = 240 mm). Per R = 1100 mm (z = 1093 mm), l'errore era inferiore a ± 9,2 mm. Per R = 1400 mm (z = 1395 mm), l'errore è stato ± 11,7 mm. Cioè, l'errore del posizionamento del punto di convergenza era entro l'1% del desiderato. Le due distanze di prova di 1100 mm e 1400 mm erano quindi ben separate.

Protocollo

Gli esperimenti sono stati approvati dal Comitato Etico locale di Lund, in Svezia. La partecipazione è stata volontaria e i tutori legali dei pazienti hanno fornito un consenso scritto informato.

1. Configurazione e configurazione del robot

NOTA: questo esperimento ha utilizzato un robot industriale collaborativo a doppio braccio e il pannello di controllo standard con display touch. Il robot è controllato con il software di controllo RobotWare 6.10.01 e l'ambiente di sviluppo integrato robot (IDE) RobotStudio 2019.525. Il software sviluppato dagli autori, tra cui l'applicazione robot, l'applicazione di registrazione e gli script di post-elaborazione, sono disponibili nel repository GitHub26.

ATTENZIONE: utilizzare occhiali protettivi e velocità ridotta durante l'installazione e il collaudo del programma robot.

- Montare il robot a soffitto o su un tavolo utilizzando bulloni dimensionati per 100 kg come descritto a pagina 25 delle specifiche del prodotto24, seguendo le specifiche del produttore. Assicurarsi che le braccia possano muoversi liberamente e che la linea di vista verso il campo visivo non sia oscurata.

ATTENZIONE: utilizzare corde di sollevamento o di sicurezza quando si monta il robot in posizione elevata. - Avviare il robot ruotando l'interruttore di avvio situato alla base del robot. Calibrare il robot seguendo la procedura descritta nel manuale d'uso alle pagine 47-5625.

- Avviare l'IDE del robot su un computer Windows.

- Collegarsi al sistema robotizzato fisico (manuale operativo pagina 14027).

- Caricare il codice per il programma robot e le librerie di applicazioni per l'interfaccia utente sul robot:

- Il codice robot per un robot montato a soffitto si trova nella cartella Robot/InvertedCode e per un robot montato su tavolo in Robot/TableMountedCode. Per ciascuno dei file left/Data.mod, left/MainModule.mod, right/Data.mod e right/MainModule.mod:

- Creare un nuovo modulo di programma (vedere manuale operativo pagina 31827) con lo stesso nome del file (Data o MainModule) e copiare il contenuto del file nel nuovo modulo.

- Premere su Applica nell'IDE del robot per salvare i file sul robot.

- Utilizzare Trasferimento file (pagina del manuale operativo 34627) per trasferire i file dell'applicazione robot TpSViewStereo2.dll, TpsViewStereo2.gtpu.dll e TpsViewStereo2.pdb che si trovano nella cartella FPApp al robot. Dopo questo passaggio, l'IDE del robot non verrà ulteriormente utilizzato.

- Premere il pulsante Reset sul retro del display touch del robot (FlexPendant) per ricaricare l'interfaccia grafica. L'applicazione robot Stereo2 sarà ora visibile sotto il menu del display touch.

- Installare l'applicazione di registrazione (Liveview) e l'applicazione di post-elaborazione su un computer Ubuntu 20.04 eseguendo lo script install_all_linux.sh, che si trova nella cartella principale nel repository Github.

- Montare ogni telecamera sul robot. I componenti necessari per il montaggio sono visualizzati nella Figura 3A.

- Montare l'obiettivo sulla fotocamera.

- Montare la fotocamera sulla piastra dell'adattatore della fotocamera con tre viti M2.

- Montare la piastra di montaggio circolare sulla piastra dell'adattatore della telecamera con quattro viti M6 sul lato opposto della telecamera.

- Ripetere i passaggi 1.9.1-1.9.3 per l'altra fotocamera. Gli assiemi risultanti vengono specchiati, come illustrato nella Figura 3B e nella Figura 3C.

- Montare la piastra dell'adattatore al polso del robot con quattro viti M2.5, come mostrato nella Figura 3D.

- Per un robot montato a soffitto: collegare la telecamera sinistra nella Figura 3C al braccio sinistro del robot, come mostrato nella Figura 2A.

- Per un robot montato su tavolo: collegare la telecamera sinistra nella Figura 3C al braccio destro del robot.

- Collegare i cavi USB alle fotocamere, come mostrato nella Figura 3E, e al computer Ubuntu.

2. Verificare la calibrazione della fotocamera

- Sul display touch del robot, premere il pulsante Menu e selezionare Stereo2 per avviare l'applicazione robot. Si aprirà la schermata principale, come mostrato nella Figura 6A.

- Nella schermata principale, premere Vai per avviare per 1100 mm nell'applicazione robot e attendere che il robot si sposti nella posizione iniziale.

- Rimuovere i cappucci protettivi delle lenti dalle fotocamere e collegare i cavi USB al computer Ubuntu.

- Posizionare una griglia di calibrazione stampata (CalibrationGrid.png nel repository) a 1100 mm dai sensori della telecamera. Per facilitare la corretta identificazione dei quadrati corrispondenti, posizionare un piccolo dado a vite o un segno da qualche parte al centro della griglia.

- Avviare l'applicazione di registrazione sul computer Ubuntu (eseguire lo script start.sh che si trova nella cartella liveview all'interno del repository Github). Verrà avviata l'interfaccia, come illustrato nella Figura 4.

- Regola l'apertura e metti a fuoco l'obiettivo con le ghiere di apertura e messa a fuoco.

- Nell'applicazione di registrazione, selezionare Mirino per visualizzare il mirino.

- Nell'applicazione di registrazione, assicurarsi che il mirino sia allineato con la griglia di calibrazione nella stessa posizione in entrambe le immagini della telecamera, come mostrato nella Figura 4. Molto probabilmente, saranno necessari alcuni aggiustamenti come segue:

- Se le croci non si sovrappongono, premere l'icona a forma di ingranaggio (in basso a sinistra Figura 6A) nell'applicazione robot sul display touch del robot per aprire la schermata di impostazione, come mostrato nella Figura 6B.

- Premere su 1. Passare a Start Pos, come illustrato nella Figura 6B.

- Spingere il robot con il joystick per regolare la posizione della fotocamera (manuale operativo pagina 3123).

- Aggiornare la posizione dell'utensile per ciascun braccio robotico. Premere 3. Aggiorna lo strumento a sinistra e 4. Aggiorna strumento destro per salvare la calibrazione rispettivamente per il braccio sinistro e destro.

- Premere l'icona Freccia indietro (in alto a destra, Figura 6B) per tornare alla schermata principale.

- Premere su Esegui esperimento (Figura 6A) nell'applicazione robot e verificare che il mirino sia allineato. In caso contrario, ripetere i passaggi 2.3-2.3.5.

- Aggiungi e testa eventuali modifiche alle distanze e/o all'ora a questo punto. Ciò richiede modifiche nel codice del programma robot e competenze avanzate di programmazione del robot. Modificare le seguenti variabili nel modulo Dati nell'attività sinistra (braccio): le distanze di separazione desiderate nella variabile di matrice intera Distanze, le distanze di convergenza nell'array intero ConvergencePos e modificare l'ora ad ogni passaggio modificando la variabile Nwaittime (valore in secondi).

ATTENZIONE: non eseguire mai un programma robot non testato durante un intervento chirurgico dal vivo. - Al termine della calibrazione, premere su Alza per sollevare i bracci del robot in posizione di standby.

- Facoltativamente, spegnere il robot.

NOTA: la procedura può essere sospesa tra uno dei passaggi precedenti.

3. Preparazione all'inizio dell'intervento chirurgico

- Spolverare il robot.

- Se il robot è stato spento, avviarlo attivando l'interruttore Start situato alla base del robot.

- Avviare l'applicazione robot sul display touch e sull'applicazione di registrazione descritta nei passaggi 2.1 e 2.2.

- Nell'applicazione di registrazione, creare e quindi selezionare la cartella in cui salvare il video (premere Cambia cartella).

- Nell'applicazione robot: premere l'icona dell'ingranaggio, posizionare le telecamere in relazione al paziente. Modificare la direzione X e Z premendo +/- per Distanza della mano dal robot e Altezza, rispettivamente, in modo che l'immagine catturi il campo chirurgico. Eseguire il posizionamento nella direzione Y spostando manualmente il robot o il paziente.

NOTA: i preparativi possono essere sospesi tra le fasi di preparazione 3.1-3.4.

4. Esperimento

ATTENZIONE: Tutto il personale deve essere informato in anticipo sull'esperimento.

- Mettere in pausa l'intervento chirurgico.

- Informare il personale di sala operatoria che l'esperimento è stato avviato.

- Premere Registra nell'applicazione di registrazione.

- Premere Esegui esperimento nell'applicazione robot.

- Attendere mentre il programma è in esecuzione; il robot visualizza "Fatto" nell'applicazione robot sul display touch al termine.

- Interrompere la registrazione nell'applicazione di registrazione premendo Esci.

- Informare il personale di sala operatoria che l'esperimento è terminato.

- Riprendere l'intervento chirurgico.

NOTA: l'esperimento non può essere sospeso durante i passaggi 4.1-4.6.

5. Ripeti

- Ripetere i passaggi 4.1-4.6 per acquisire un'altra sequenza e i passaggi 3.1-3.4 e 4.1-4.6 per acquisire sequenze da diversi interventi chirurgici. Cattura circa dieci sequenze complete.

6. Post-elaborazione

NOTA: i seguenti passaggi possono essere eseguiti utilizzando la maggior parte dei software di editing video o gli script forniti nella cartella di post-elaborazione.

- In questo caso, debayer il video in quanto viene salvato nel formato RAW:

- Eseguire lo script postprocessing/debayer/run.sh per aprire l'applicazione debayer mostrata nella Figura 8A.

- Premere Sfoglia directory di input e selezionare la cartella con il video RAW.

- Premere Sfoglia directory di output e selezionare una cartella per i file video debayered e regolati a colori risultanti.

- Premi Debayer! e attendere il completamento del processo: entrambe le barre di avanzamento sono piene, come illustrato nella Figura 8B.

- Unisci i video sincronizzati a destra e a sinistra in formato stereo 3D28:

- Eseguire lo script postprocessing/merge_tb/run.sh per avviare l'applicazione di unione; apre l'interfaccia utente grafica mostrata nella Figura 8C.

- Premi Sfoglia directory di input e seleziona la cartella con i file video debayered.

- Premere Sfoglia directory di output e selezionare una cartella per il file stereo 3D unito risultante.

- Premi Unisci! e attendere fino a quando non viene visualizzata la schermata di fine nella Figura 8D .

- Utilizzate un software di editing video standard come Premiere Pro per aggiungere etichette di testo a ogni distanza della videocamera nel video.

NOTA: nel video, c'è una scossa visibile ogni volta che il robot si muove e la distanza della telecamera aumenta. In questo esperimento, le etichette A-T sono state utilizzate per le distanze della fotocamera.

7. Valutazione

- Visualizza il video in formato 3D superiore-inferiore con un proiettore 3D attivo.

- L'esperienza visiva dipende dall'angolo di visione e dalla distanza dallo schermo; valutare il video utilizzando il pubblico e la configurazione previsti.

Risultati

Un video di valutazione accettabile con l'immagine giusta posizionata in alto nel 3D stereoscopico superiore-inferiore viene mostrato in Video1. Una sequenza riuscita deve essere nitida, focalizzata e senza fotogrammi di immagine non sincronizzati. I flussi video non sincronizzati causeranno sfocature, come mostrato nel file Video 2. Il punto di convergenza deve essere centrato orizzontalmente, indipendentemente dalla separazione della telecamera, come mostrato nella

Discussione

Durante la chirurgia dal vivo, il tempo totale dell'esperimento utilizzato per la raccolta di dati video 3D è stato limitato per essere sicuro per il paziente. Se l'oggetto non è focalizzato o sovraesposto, i dati non possono essere utilizzati. I passaggi critici sono durante la calibrazione e la configurazione dello strumento della fotocamera (passaggio 2). L'apertura e la messa a fuoco della fotocamera non possono essere modificate quando l'intervento chirurgico è iniziato; le stesse condizioni di illuminazione e di...

Divulgazioni

Gli autori non hanno nulla da rivelare.

Riconoscimenti

La ricerca è stata condotta con finanziamenti da Vinnova (2017-03728, 2018-05302 e 2018-03651), Heart-Lung Foundation (20180390), Family Kamprad Foundation (20190194) e Anna-Lisa e Sven Eric Lundgren Foundation (2017 e 2018).

Materiali

| Name | Company | Catalog Number | Comments |

| 2 C-mount lenses (35 mm F2.1, 5 M pixel) | Tamron | M112FM35 | Rated for 5 Mpixel |

| 3D glasses (DLP-link active shutter) | Celexon | G1000 | Any compatible 3D glasses can be used |

| 3D Projector | Viewsonic | X10-4K | Displays 3D in 1080, can be exchanged for other 3D projectors |

| 6 M2 x 8 screws | To attach the cXimea cameras to the camera adaptor plates | ||

| 8 M2.5 x 8 screws | To attach the circular mounting plates to the robot wrist | ||

| 8 M5 x 40 screws | To mount the robot | ||

| 8 M6 x 10 screws with flat heads | For attaching the circular mounting plate and the camera adaptor plates | ||

| Calibration checker board plate (25 by 25 mm) | Any standard checkerboard can be used, including printed, as long as the grid is clearly visible in the cameras | ||

| Camera adaptor plates, x2 | Designed by the authors in robot_camera_adaptor_plates.dwg, milled in aluminium. | ||

| Circular mounting plates, x2 | Distributed with the permission of the designer Julius Klein and printed with ABS plastic on an FDM 3D printer. License Tecnalia Research & Innovation 2017. Attached as Mountingplate_ROBOT_SIDE_ NewDesign_4.stl | ||

| Fix focus usb cameras, x2 (5 Mpixel) | Ximea | MC050CG-SY-UB | With Sony IMX250LQR sensor |

| Flexpendant | ABB | 3HAC028357-001 | robot touch display |

| Liveview | recording application | ||

| RobotStudio | robot integrated development environment (IDE) | ||

| USB3 active cables (10.0 m), x2 | Thumbscrew lock connector, water proofed. | ||

| YuMi dual-arm robot | ABB | IRB14000 |

Riferimenti

- Held, R. T., Hui, T. T. A guide to stereoscopic 3D displays in medicine. Academic Radiology. 18 (8), 1035-1048 (2011).

- van Beurden, M. H. P. H., IJsselsteijn, W. A., Juola, J. F. Effectiveness of stereoscopic displays in medicine: A review. 3D Research. 3 (1), 1-13 (2012).

- Luursema, J. M., Verwey, W. B., Kommers, P. A. M., Geelkerken, R. H., Vos, H. J. Optimizing conditions for computer-assisted anatomical learning. Interacting with Computers. 18 (5), 1123-1138 (2006).

- Takano, M., et al. Usefulness and capability of three-dimensional, full high-definition movies for surgical education. Maxillofacial Plastic and Reconstructive Surgery. 39 (1), 10 (2017).

- Triepels, C. P. R., et al. Does three-dimensional anatomy improve student understanding. Clinical Anatomy. 33 (1), 25-33 (2020).

- Beermann, J., et al. Three-dimensional visualisation improves understanding of surgical liver anatomy. Medical Education. 44 (9), 936-940 (2010).

- Battulga, B., Konishi, T., Tamura, Y., Moriguchi, H. The Effectiveness of an interactive 3-dimensional computer graphics model for medical education. Interactive Journal of Medical Research. 1 (2), (2012).

- Yammine, K., Violato, C. A meta-analysis of the educational effectiveness of three-dimensional visualization technologies in teaching anatomy. Anatomical Sciences Education. 8 (6), 525-538 (2015).

- Fitzgerald, J. E. F., White, M. J., Tang, S. W., Maxwell-Armstrong, C. A., James, D. K. Are we teaching sufficient anatomy at medical school? The opinions of newly qualified doctors. Clinical Anatomy. 21 (7), 718-724 (2008).

- Bergman, E. M., Van Der Vleuten, C. P. M., Scherpbier, A. J. J. A. Why don't they know enough about anatomy? A narrative review. Medical Teacher. 33 (5), 403-409 (2011).

- Terzić, K., Hansard, M. Methods for reducing visual discomfort in stereoscopic 3D: A review. Signal Processing: Image Communication. 47, 402-416 (2016).

- Fan, Z., Weng, Y., Chen, G., Liao, H. 3D interactive surgical visualization system using mobile spatial information acquisition and autostereoscopic display. Journal of Biomedical Informatics. 71, 154-164 (2017).

- Fan, Z., Zhang, S., Weng, Y., Chen, G., Liao, H. 3D quantitative evaluation system for autostereoscopic display. Journal of Display Technology. 12 (10), 1185-1196 (2016).

- McIntire, J. P., et al. Binocular fusion ranges and stereoacuity predict positional and rotational spatial task performance on a stereoscopic 3D display. Journal of Display Technology. 11 (11), 959-966 (2015).

- Kalia, M., Navab, N., Fels, S. S., Salcudean, T. A method to introduce & evaluate motion parallax with stereo for medical AR/MR. IEEE Conference on Virtual Reality and 3D User Interfaces. , 1755-1759 (2019).

- Kytö, M., Hakala, J., Oittinen, P., Häkkinen, J. Effect of camera separation on the viewing experience of stereoscopic photographs. Journal of Electronic Imaging. 21 (1), 1-9 (2012).

- Moorthy, A. K., Su, C. C., Mittal, A., Bovik, A. C. Subjective evaluation of stereoscopic image quality. Signal Processing: Image Communication. 28 (8), 870-883 (2013).

- Yilmaz, G. N. A depth perception evaluation metric for immersive 3D video services. 3DTV Conference: The True Vision - Capture, Transmission and Display of 3D Video. , 1-4 (2017).

- Lebreton, P., Raake, A., Barkowsky, M., Le Callet, P. Evaluating depth perception of 3D stereoscopic videos. IEEE Journal on Selected Topics in Signal Processing. 6, 710-720 (2012).

- López, J. P., Rodrigo, J. A., Jiménez, D., Menéndez, J. M. Stereoscopic 3D video quality assessment based on depth maps and video motion. EURASIP Journal on Image and Video Processing. 2013 (1), 62 (2013).

- Banks, M. S., Read, J. C., Allison, R. S., Watt, S. J. Stereoscopy and the human visual system. SMPTE Motion Imaging Journal. 121 (4), 24-43 (2012).

- Kytö, M., Nuutinen, M., Oittinen, P. Method for measuring stereo camera depth accuracy based on stereoscopic vision. Three-Dimensional Imaging, Interaction, and Measurement. 7864, 168-176 (2011).

- Kang, Y. S., Ho, Y. S. Geometrical compensation algorithm of multiview image for arc multi-camera arrays. Advances in Multimedia Information Processing. 2008, 543-552 (2008).

- Product Specification IRB 14000. DocumentID: 3HAC052982-001 Revision J. ABB Robotics Available from: https://library.abb.com/en/results (2018)

- Operating Manual IRB 14000. Document ID: 3HAC052986-001 Revision F. ABB Robotics Available from: https://library.abb.com/en/results (2019)

- . Github repository Available from: https://github.com/majstenmark/stereo2 (2021)

- Operating manual RobotStudio. Document ID: 3HAC032104-001 Revision Y. ABB Robotics Available from: https://library.abb.com/en/results (2019)

- Won, C. S. Adaptive interpolation for 3D stereoscopic video in frame-compatible top-bottom packing. IEEE International Conference on Consumer Electronics. 2011, 179-180 (2011).

- Kim, S. K., Lee, C., Kim, K. T., Javidi, B., Okano, F., Son, J. Y. Multi-view image acquisition and display. Three-Dimensional Imaging, Visualization, and Display. , 227-249 (2009).

- Liu, F., Niu, Y., Jin, H. Keystone correction for stereoscopic cinematography. IEEE Computer Society Conference on Computer Vision and Pattern Recognition Workshops. 2012, 1-7 (2012).

- Kang, W., Lee, S. Horizontal parallax distortion correction method in toed-in camera with wide-angle lens. 3DTV Conference: The True Vision - Capture, Transmission and Display of 3D Video. 2009, 1-4 (2009).

Ristampe e Autorizzazioni

Richiedi autorizzazione per utilizzare il testo o le figure di questo articolo JoVE

Richiedi AutorizzazioneThis article has been published

Video Coming Soon