Для просмотра этого контента требуется подписка на Jove Войдите в систему или начните бесплатную пробную версию.

Method Article

Роботизированное тестирование положения камеры для определения идеальной конфигурации для стерео 3D-визуализации операции на открытом сердце

В этой статье

Резюме

Восприятие человеком глубины 3D-стерео видео зависит от разделения камеры, точки сходимости, расстояния до объекта и знакомства с ним. В этой статье представлен роботизированный метод быстрого и надежного сбора тестовых данных во время операции на открытом сердце в реальном времени для определения идеальной конфигурации камеры.

Аннотация

Стерео 3D-видео с хирургических процедур может быть очень ценным для медицинского образования и улучшения клинической коммуникации. Но доступ в операционную и хирургическое поле ограничен. Это стерильная среда, а физическое пространство переполнено хирургическим персоналом и техническим оборудованием. В этой обстановке незатененный захват и реалистичное воспроизведение хирургических процедур затруднены. В данной работе представлен метод быстрого и надежного сбора данных стереоскопических 3D-видео на различных базовых расстояниях камеры и расстояниях конвергенции. Для сбора тестовых данных с минимальным вмешательством во время операции, с высокой точностью и повторяемостью, камеры были прикреплены к каждой руке двухрукого робота. Робот был установлен на потолке в операционной. Он был запрограммирован на выполнение синхронизированной последовательности синхронизированных движений камеры, проходящих через диапазон испытательных позиций с базовым расстоянием между 50-240 мм при шаге 10 мм и на двух расстояниях сходимости 1100 мм и 1400 мм. Операция была приостановлена, чтобы позволить 40 последовательных 5-х сэмплов видео. Всего было зафиксировано 10 хирургических сценариев.

Введение

В хирургии 3D-визуализация может использоваться для обучения, диагностики, предоперационного планирования и послеоперационной оценки1,2. Реалистичное восприятие глубины может улучшить понимание3,4,5,6 нормальных и аномальных анатомий. Простые 2D-видеозаписи хирургических процедур являются хорошим началом. Тем не менее, отсутствие восприятия глубины может затруднить для нехирургических коллег полное понимание передне-задних отношений между различными анатомическими структурами и, следовательно, также создает риск неправильного толкования анатомии7,8,9,10.

На качество 3D-просмотра влияют пять факторов: (1) Конфигурация камеры может быть параллельной или наклонной, как показано на рисунке 1, (2) Базовое расстояние (расстояние между камерами). (3) Расстояние до интересующего объекта и другие характеристики сцены, такие как фон. (4) Характеристики устройств просмотра, такие как размер экрана и положение просмотра1,11,12,13. (5) Индивидуальные предпочтения зрителей14,15.

Проектирование настройки 3D-камеры начинается с захвата тестовых видео, записанных на различных базовых расстояниях и конфигурациях камеры, которые будут использоваться для субъективной или автоматической оценки16,17,18,19,20. Расстояние от камеры должно быть постоянным до хирургического поля, чтобы захватывать четкие изображения. Фиксированный фокус предпочтительнее, потому что автофокус будет настраиваться на фокусировку на руках, инструментах или головах, которые могут попасть в поле зрения. Однако это нелегко достичь, когда интересной сценой является хирургическая область. Операционные являются зонами с ограниченным доступом, потому что эти помещения должны содержаться в чистоте и стерильности. Техническое оборудование, хирурги и медсестры-скрабы часто группируются вокруг пациента, чтобы обеспечить хороший визуальный обзор и эффективный рабочий процесс. Чтобы сравнить и оценить влияние положений камеры на опыт 3D-просмотра, один полный тестовый диапазон положений камеры должен записывать одну и ту же сцену, поскольку характеристики объекта, такие как форма, размер и цвет, могут повлиять на опыт 3D-просмотра21.

По той же причине полные диапазоны тестов положения камеры должны быть повторены на разных хирургических процедурах. Вся последовательность позиций должна повторяться с высокой точностью. В хирургических условиях существующие методы, требующие либо ручной регулировки базового расстояния22 , либо различных пар камер с фиксированными базовыми расстояниями23 , невозможны из-за как пространственных, так и временных ограничений. Для решения этой проблемы было разработано это роботизированное решение.

Данные были собраны с помощью двухрукого коллаборативного промышленного робота, установленного в потолке в операционной. Камеры были прикреплены к запястьям робота и двигались по дугообразной траектории с увеличением базового расстояния, как показано на рисунке 2.

Чтобы продемонстрировать подход, было зарегистрировано 10 серий тестов у 4 разных пациентов с 4 различными врожденными пороками сердца. Сцены были выбраны, когда пауза в операции была возможна: с бьющимися сердцами непосредственно до и после хирургического ремонта. Сериалы также были сделаны, когда сердца были арестованы. Операции были приостановлены на 3 минуты и 20 с, чтобы собрать сорок 5-секундных последовательностей с различными расстояниями конвергенции камеры и базовыми расстояниями для захвата сцены. Позже видео были обработаны, показаны в 3D для клинической команды, которая оценила, насколько реалистичным было 3D-видео по шкале от 0 до 5.

Точка конвергенции для стереокамер с носком — это место, где встречаются центральные точки обоих изображений. Точка сходимости в принципе может быть размещена либо спереди, внутри или позади объекта, см. рисунок 1A-C. Когда точка сходимости находится перед объектом, объект будет захвачен и отображен слева от средней линии для изображения левой камеры и справа от средней линии для изображения правой камеры (рисунок 1A). Обратное применимо, когда точка сходимости находится позади объекта (рисунок 1B). Когда точка сходимости находится на объекте, объект также появится в средней линии изображений камеры (рисунок 1C), что, по-видимому, должно обеспечить наиболее комфортный просмотр, поскольку для слияния изображений не требуется прищуривание. Для достижения комфортного стерео 3D-видео точка конвергенции должна быть расположена на интересующем объекте или немного позади него, в противном случае зритель должен добровольно прищуриться наружу (экзотропия).

Данные были собраны с использованием двухрукого коллаборативного промышленного робота для позиционирования камер (рисунок 2A-B). Робот весит 38 кг без оборудования. Робот искробезопасен; когда он обнаруживает неожиданное воздействие, он перестает двигаться. Робот был запрограммирован на позиционирование 5-мегапиксельных камер с объективами c-mount вдоль дугообразной траектории, останавливаясь на заданных базовых расстояниях (рисунок 2C). Камеры были прикреплены к рукам робота с помощью пластин адаптера, как показано на рисунке 3. Каждая камера записывает со скоростью 25 кадров в секунду. Линзы устанавливались на диафрагме 1/8 с фокусом, зафиксированным на интересующем объекте (приближенный геометрический центр сердца). Каждый кадр изображения имел метку времени, которая использовалась для синхронизации двух видеопотоков.

Смещения между запястьем робота и камерой были откалиброваны. Это может быть достигнуто путем выравнивания перекрестия изображений камеры, как показано на рисунке 4. В этой установке общее трансляционное смещение от точки крепления на запястье робота и центра датчика изображения камеры составило 55,3 мм в направлении X и 21,2 мм в Z-направлении, показанное на рисунке 5. Вращательные смещения калибровались на расстоянии сходимости 1100 мм и базовом расстоянии 50 мм и регулировались вручную с помощью джойстика на панели управления робота. Робот в этом исследовании имел заданную точность 0,02 мм в декартовом пространстве и 0,01 градуса вращательного разрешения24. При радиусе 1100 м разность углов 0,01 градуса смещает центральную точку на 0,2 мм. Во время полного движения робота с расстояния 50-240 мм перекрестие для каждой камеры находилось в пределах 2 мм от идеального центра конвергенции.

Базовое расстояние увеличивалось поэтапно за счет симметричного разделения камер вокруг центра поля зрения с шагом 10 мм в пределах 50-240 мм (рисунок 2). Камеры держались в режиме ожидания в течение 5 с в каждом положении и перемещались между позициями со скоростью 50 мм/с. Точка сходимости может быть отрегулирована в направлениях X и Z с помощью графического интерфейса пользователя (рисунок 6). Робот следовал соответственно в пределах своего рабочего диапазона.

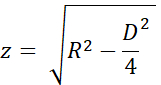

Точность точки сходимости оценивалась с использованием однородных треугольников и названий переменных на рисунках 7A и B. Высота 'z' была вычислена из расстояния сходимости 'R' с теоремой Пифагора как

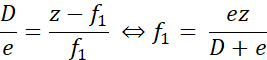

Когда реальная точка сходимости была ближе желаемой точки, как показано на рисунке 7A, расстояние ошибки 'f1' вычислялось как

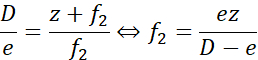

Аналогичным образом, когда точка сходимости была дистальна к желаемой точке, расстояние ошибки «f2» вычислялось как

Здесь 'e' представляло собой максимальное расстояние между перекрестиями, не более 2 мм при максимальном базовом расстоянии во время калибровки (D = 240 мм). Для R = 1100 мм (z = 1093 мм) погрешность составляла менее ± 9,2 мм. Для R = 1400 мм (z = 1395 мм) погрешность составила ± 11,7 мм. То есть погрешность размещения точки сходимости оказалась в пределах 1% от желаемой. Таким образом, два испытательных расстояния в 1100 мм и 1400 мм были хорошо разделены.

протокол

Эксперименты были одобрены местным Комитетом по этике в Лунде, Швеция. Участие было добровольным, и законные опекуны пациентов предоставили информированное письменное согласие.

1. Настройка и настройка робота

ПРИМЕЧАНИЕ: В этом эксперименте использовался двухрукий коллаборативный промышленный робот и стандартная панель управления с сенсорным дисплеем. Робот управляется с помощью программного обеспечения контроллера RobotWare 6.10.01 и интегрированной среды разработки робота (IDE) RobotStudio 2019.525. Программное обеспечение, разработанное авторами, включая приложение для роботов, приложение для записи и сценарии постобработки, доступно в репозитории GitHub26.

ВНИМАНИЕ: Используйте защитные очки и снижайте скорость во время настройки и тестирования программы робота.

- Установите робота на потолок или стол с помощью болтов весом 100 кг, как описано на странице 25 в спецификации продукта24, следуя спецификациям производителя. Убедитесь, что руки могут свободно перемещаться, а линия видимости в поле зрения не затемнена.

ВНИМАНИЕ: Используйте подъемные или предохранительные канаты при монтаже робота в высоком положении. - Запустите робота, повернув пусковой переключатель, расположенный в основании робота. Откалибруйте робота, следуя процедуре, описанной в руководстве по эксплуатации на страницах 47-5625.

- Запустите интегрированную среду разработки робота на компьютере с Windows.

- Подключитесь к физической роботизированной системе (руководство по эксплуатации, стр. 14027).

- Загрузите код для программы робота и библиотеки приложений для пользовательского интерфейса робота:

- Код робота для потолочного робота находится в папке Robot/InvertedCode , а для настольного робота — в Robot/TableMountedCode. Для каждого из файлов left/Data.mod, left/MainModule.mod, right/Data.mod и right/MainModule.mod:

- Создайте новый программный модуль (см. руководство по эксплуатации, стр. 31827) с тем же именем, что и файл (Data или MainModule), и скопируйте содержимое файла в новый модуль.

- Нажмите применить в IDE робота, чтобы сохранить файлы роботу.

- Используйте file Transfer (страница руководства по эксплуатации 34627) для передачи роботу файлов приложения TpSViewStereo2.dll, TpsViewStereo2.gtpu.dll и TpsViewStereo2.pdb расположенных в папке FPApp, роботу. После этого шага IDE робота больше не будет использоваться.

- Нажмите кнопку Reset на задней панели сенсорного дисплея робота (FlexPendant), чтобы перезагрузить графический интерфейс. Робот-приложение Stereo2 теперь будет видно под меню сенсорного дисплея.

- Установите приложение записи (Liveview) и приложение постобработки на компьютере Ubuntu 20.04, запустив скрипт install_all_linux.sh, расположенный в корневой папке в репозитории Github.

- Установите каждую камеру на робота. Компоненты, необходимые для монтажа, показаны на рисунке 3A.

- Установите объектив на камеру.

- Установите камеру на пластину адаптера камеры с помощью трех винтов M2.

- Установите круглую монтажную пластину на пластину адаптера камеры четырьмя винтами M6 на противоположной стороне камеры.

- Повторите шаги 1.9.1-1.9.3 для другой камеры. Полученные сборки зеркально отражаются, как показано на рисунках 3B и 3C.

- Установите пластину адаптера на запястье робота с помощью четырех винтов M2.5, как показано на рисунке 3D.

- Для потолочного робота: прикрепите левую камеру на рисунке 3C к левой руке робота, как показано на рисунке 2A.

- Для настольного робота: прикрепите левую камеру на рисунке 3C к правой руке робота.

- Подключите USB-кабели к камерам, как показано на рисунке 3E, и к компьютеру Ubuntu.

2. Проверьте калибровку камеры

- На сенсорном дисплее робота нажмите кнопку Меню и выберите Stereo2 , чтобы запустить приложение робота. Откроется главный экран, как показано на рисунке 6A.

- На главном экране нажмите go, чтобы запустить на 1100 мм в приложении робота и подождите, пока робот перейдет в исходное положение.

- Снимите защитные крышки объективов с камер и подключите USB-кабели к компьютеру Ubuntu.

- Поместите печатную калибровочную сетку (CalibrationGrid.png в репозиторий) на расстоянии 1100 мм от датчиков камеры. Чтобы облегчить правильную идентификацию соответствующих квадратов, поместите небольшую винтовую гайку или отметку где-нибудь в центре сетки.

- Запустите приложение записи на компьютере Ubuntu (запустите скрипт start.sh, расположенном в папке liveview внутри репозитория Github). Это запустит интерфейс, как показано на рисунке 4.

- Отрегулируйте диафрагму и фокусировку на объективе с помощью колец диафрагмы и фокусировки.

- В приложении записи проверьте Перекрестие , чтобы визуализировать перекрестие.

- В записывающем приложении убедитесь, что перекрестие совпадает с калибровочной сеткой в одном и том же положении на обоих изображениях камеры, как показано на рисунке 4. Скорее всего, потребуется некоторая корректировка следующим образом:

- Если крестики не перекрываются, нажмите значок Gear (внизу слева , рисунок 6A) в приложении робота на сенсорном дисплее робота, чтобы открыть экран настроек, как показано на рисунке 6B.

- Нажмите на 1. Перейдите в Start Pos, как показано на рисунке 6B.

- Прогоните робота джойстиком, чтобы отрегулировать положение камеры (руководство по эксплуатации стр. 3123).

- Обновите положение инструмента для каждой руки робота. Нажмите 3. Обновить левый инструмент и 4. Обновите правый инструмент , чтобы сохранить калибровку для левой и правой руки соответственно.

- Нажмите на значок стрелки назад (вверху справа, рисунок 6B), чтобы вернуться на главный экран.

- Нажмите run Experiment (рисунок 6A) в приложении робота и убедитесь, что перекрестие прицела выровнено. В противном случае повторите шаги 2.3-2.3.5.

- Добавьте и протестируйте любые изменения расстояний и/или времени на этом этапе. Это требует изменений в программном коде робота и продвинутых навыков программирования роботов. Измените следующие переменные в модуле Data в левой задаче (arm): требуемые расстояния разделения в целочисленном массиве переменной Distances, расстояния сходимости в целочисленном массиве ConvergencePos и редактируйте время на каждом шаге, редактируя переменную Nwaittime (значение в секундах).

ВНИМАНИЕ: Никогда не запускайте непроверенную роботизированную программу во время операции в реальном времени. - Когда калибровка будет завершена, нажмите кнопку «Поднять», чтобы поднять руки робота в резервное положение.

- При необходимости выключите робота.

ПРИМЕЧАНИЕ: Процедура может быть приостановлена между любым из описанных выше шагов.

3. Подготовка в начале операции

- Запылите робота.

- Если робот был выключен, запустите его, включив переключатель Start , расположенный в основании робота.

- Запустите приложение робота на сенсорном дисплее и приложение записи, описанное в шагах 2.1 и 2.2.

- В приложении записи создайте и выберите папку, в которую нужно сохранить видео (нажмите Изменить папку).

- В приложении робота: нажмите на значок шестеренки, расположите камеры по отношению к пациенту. Измените направление X и Z, нажав +/- для параметров Расстояние руки от робота и Высоту соответственно, чтобы изображение захватывало хирургическое поле. Выполняйте позиционирование в Y-направлении, вручную перемещая робота или пациента.

ПРИМЕЧАНИЕ: Подготовка может быть приостановлена между этапами подготовки 3.1-3.4.

4. Эксперимент

ВНИМАНИЕ: Весь персонал должен быть проинформирован об эксперименте заранее.

- Приостановите операцию.

- Сообщите персоналу операционной службы о том, что эксперимент начат.

- Нажмите Запись в приложении записи.

- Нажмите Выполнить эксперимент в приложении робота.

- Подождите, пока программа запущена; робот отображает «Готово» в приложении робота на сенсорном дисплее после завершения.

- Остановите запись в приложении записи, нажав клавишу Quit.

- Сообщите персоналу операционной службы, что эксперимент завершен.

- Возобновить операцию.

ПРИМЕЧАНИЕ: Эксперимент нельзя приостановить на шагах 4.1-4.6.

5. Повторите

- Повторите шаги 4.1-4.6, чтобы захватить другую последовательность, и шаги 3.1-3.4 и шаги 4.1-4.6, чтобы захватить последовательности из различных операций. Захватите около десяти полных последовательностей.

6. Постобработка

ПРИМЕЧАНИЕ: Следующие шаги могут быть выполнены с использованием большинства программного обеспечения для редактирования видео или предоставленных скриптов в папке постобработки.

- В этом случае дебайер видео так, как оно сохранено в формате RAW:

- Запустите скрипт postprocessing/debayer/run.sh чтобы открыть приложение debayer, показанное на рисунке 8A.

- Нажмите «Обзор входного каталога » и выберите папку с видео RAW.

- Нажмите «Обзор выходного каталога » и выберите папку для полученных видеофайлов с пониженным и настроенным по цвету.

- Нажмите Дебайер! и подождите, пока процесс не будет завершен - оба индикатора выполнения заполнены, как показано на рисунке 8B.

- Объедините правое и левое синхронизированные видео в 3D стерео формат28:

- Запустите скрипт postprocessing/merge_tb/run.sh запустите приложение слияния; он открывает графический пользовательский интерфейс, показанный на рисунке 8C.

- Нажмите Browse Input Directory (Обзор входного каталога ) и выберите папку с обезвреженными видеофайлами.

- Нажмите «Обзор выходного каталога » и выберите папку для полученного объединенного 3D-стереофайла.

- Нажмите Слияние! и подождите, пока не появится финишный экран на рисунке 8D .

- Используйте готовое программное обеспечение для редактирования видео, такое как Premiere Pro, чтобы добавлять текстовые метки к каждому расстоянию камеры в видео.

ПРИМЕЧАНИЕ: На видео есть видимая дрожь каждый раз, когда робот двигался, и расстояние до камеры увеличивалось. В этом эксперименте метки A-T использовались для расстояний камеры.

7. Оценка

- Отображение видео в 3D-формате сверху вниз с активным 3D-проектором.

- Просмотр зависит от угла обзора и расстояния до экрана; оцените видео, используя целевую аудиторию и настройку.

Результаты

Приемлемое оценочное видео с правильным изображением, размещенным вверху в стереоскопическом 3D сверху вниз, показано в Video1. Успешная последовательность должна быть четкой, сфокусированной и без несинхронизированных кадров изображения. Несинхронизированные видеопотоки выз?...

Обсуждение

Во время живой хирургии общее время эксперимента, используемого для сбора 3D-видеоданных, было ограничено, чтобы быть безопасным для пациента. Если объект не сфокусирован или переэкспонирован, данные не могут быть использованы. Критические шаги выполняются во время калибровки и настро?...

Раскрытие информации

Авторам нечего раскрывать.

Благодарности

Исследование проводилось при финансировании Vinnova (2017-03728, 2018-05302 и 2018-03651), Heart-Lung Foundation (20180390), Family Kamprad Foundation (20190194) и Anna-Lisa and Sven Eric Lundgren Foundation (2017 и 2018).

Материалы

| Name | Company | Catalog Number | Comments |

| 2 C-mount lenses (35 mm F2.1, 5 M pixel) | Tamron | M112FM35 | Rated for 5 Mpixel |

| 3D glasses (DLP-link active shutter) | Celexon | G1000 | Any compatible 3D glasses can be used |

| 3D Projector | Viewsonic | X10-4K | Displays 3D in 1080, can be exchanged for other 3D projectors |

| 6 M2 x 8 screws | To attach the cXimea cameras to the camera adaptor plates | ||

| 8 M2.5 x 8 screws | To attach the circular mounting plates to the robot wrist | ||

| 8 M5 x 40 screws | To mount the robot | ||

| 8 M6 x 10 screws with flat heads | For attaching the circular mounting plate and the camera adaptor plates | ||

| Calibration checker board plate (25 by 25 mm) | Any standard checkerboard can be used, including printed, as long as the grid is clearly visible in the cameras | ||

| Camera adaptor plates, x2 | Designed by the authors in robot_camera_adaptor_plates.dwg, milled in aluminium. | ||

| Circular mounting plates, x2 | Distributed with the permission of the designer Julius Klein and printed with ABS plastic on an FDM 3D printer. License Tecnalia Research & Innovation 2017. Attached as Mountingplate_ROBOT_SIDE_ NewDesign_4.stl | ||

| Fix focus usb cameras, x2 (5 Mpixel) | Ximea | MC050CG-SY-UB | With Sony IMX250LQR sensor |

| Flexpendant | ABB | 3HAC028357-001 | robot touch display |

| Liveview | recording application | ||

| RobotStudio | robot integrated development environment (IDE) | ||

| USB3 active cables (10.0 m), x2 | Thumbscrew lock connector, water proofed. | ||

| YuMi dual-arm robot | ABB | IRB14000 |

Ссылки

- Held, R. T., Hui, T. T. A guide to stereoscopic 3D displays in medicine. Academic Radiology. 18 (8), 1035-1048 (2011).

- van Beurden, M. H. P. H., IJsselsteijn, W. A., Juola, J. F. Effectiveness of stereoscopic displays in medicine: A review. 3D Research. 3 (1), 1-13 (2012).

- Luursema, J. M., Verwey, W. B., Kommers, P. A. M., Geelkerken, R. H., Vos, H. J. Optimizing conditions for computer-assisted anatomical learning. Interacting with Computers. 18 (5), 1123-1138 (2006).

- Takano, M., et al. Usefulness and capability of three-dimensional, full high-definition movies for surgical education. Maxillofacial Plastic and Reconstructive Surgery. 39 (1), 10 (2017).

- Triepels, C. P. R., et al. Does three-dimensional anatomy improve student understanding. Clinical Anatomy. 33 (1), 25-33 (2020).

- Beermann, J., et al. Three-dimensional visualisation improves understanding of surgical liver anatomy. Medical Education. 44 (9), 936-940 (2010).

- Battulga, B., Konishi, T., Tamura, Y., Moriguchi, H. The Effectiveness of an interactive 3-dimensional computer graphics model for medical education. Interactive Journal of Medical Research. 1 (2), (2012).

- Yammine, K., Violato, C. A meta-analysis of the educational effectiveness of three-dimensional visualization technologies in teaching anatomy. Anatomical Sciences Education. 8 (6), 525-538 (2015).

- Fitzgerald, J. E. F., White, M. J., Tang, S. W., Maxwell-Armstrong, C. A., James, D. K. Are we teaching sufficient anatomy at medical school? The opinions of newly qualified doctors. Clinical Anatomy. 21 (7), 718-724 (2008).

- Bergman, E. M., Van Der Vleuten, C. P. M., Scherpbier, A. J. J. A. Why don't they know enough about anatomy? A narrative review. Medical Teacher. 33 (5), 403-409 (2011).

- Terzić, K., Hansard, M. Methods for reducing visual discomfort in stereoscopic 3D: A review. Signal Processing: Image Communication. 47, 402-416 (2016).

- Fan, Z., Weng, Y., Chen, G., Liao, H. 3D interactive surgical visualization system using mobile spatial information acquisition and autostereoscopic display. Journal of Biomedical Informatics. 71, 154-164 (2017).

- Fan, Z., Zhang, S., Weng, Y., Chen, G., Liao, H. 3D quantitative evaluation system for autostereoscopic display. Journal of Display Technology. 12 (10), 1185-1196 (2016).

- McIntire, J. P., et al. Binocular fusion ranges and stereoacuity predict positional and rotational spatial task performance on a stereoscopic 3D display. Journal of Display Technology. 11 (11), 959-966 (2015).

- Kalia, M., Navab, N., Fels, S. S., Salcudean, T. A method to introduce & evaluate motion parallax with stereo for medical AR/MR. IEEE Conference on Virtual Reality and 3D User Interfaces. , 1755-1759 (2019).

- Kytö, M., Hakala, J., Oittinen, P., Häkkinen, J. Effect of camera separation on the viewing experience of stereoscopic photographs. Journal of Electronic Imaging. 21 (1), 1-9 (2012).

- Moorthy, A. K., Su, C. C., Mittal, A., Bovik, A. C. Subjective evaluation of stereoscopic image quality. Signal Processing: Image Communication. 28 (8), 870-883 (2013).

- Yilmaz, G. N. A depth perception evaluation metric for immersive 3D video services. 3DTV Conference: The True Vision - Capture, Transmission and Display of 3D Video. , 1-4 (2017).

- Lebreton, P., Raake, A., Barkowsky, M., Le Callet, P. Evaluating depth perception of 3D stereoscopic videos. IEEE Journal on Selected Topics in Signal Processing. 6, 710-720 (2012).

- López, J. P., Rodrigo, J. A., Jiménez, D., Menéndez, J. M. Stereoscopic 3D video quality assessment based on depth maps and video motion. EURASIP Journal on Image and Video Processing. 2013 (1), 62 (2013).

- Banks, M. S., Read, J. C., Allison, R. S., Watt, S. J. Stereoscopy and the human visual system. SMPTE Motion Imaging Journal. 121 (4), 24-43 (2012).

- Kytö, M., Nuutinen, M., Oittinen, P. Method for measuring stereo camera depth accuracy based on stereoscopic vision. Three-Dimensional Imaging, Interaction, and Measurement. 7864, 168-176 (2011).

- Kang, Y. S., Ho, Y. S. Geometrical compensation algorithm of multiview image for arc multi-camera arrays. Advances in Multimedia Information Processing. 2008, 543-552 (2008).

- Product Specification IRB 14000. DocumentID: 3HAC052982-001 Revision J. ABB Robotics Available from: https://library.abb.com/en/results (2018)

- Operating Manual IRB 14000. Document ID: 3HAC052986-001 Revision F. ABB Robotics Available from: https://library.abb.com/en/results (2019)

- . Github repository Available from: https://github.com/majstenmark/stereo2 (2021)

- Operating manual RobotStudio. Document ID: 3HAC032104-001 Revision Y. ABB Robotics Available from: https://library.abb.com/en/results (2019)

- Won, C. S. Adaptive interpolation for 3D stereoscopic video in frame-compatible top-bottom packing. IEEE International Conference on Consumer Electronics. 2011, 179-180 (2011).

- Kim, S. K., Lee, C., Kim, K. T., Javidi, B., Okano, F., Son, J. Y. Multi-view image acquisition and display. Three-Dimensional Imaging, Visualization, and Display. , 227-249 (2009).

- Liu, F., Niu, Y., Jin, H. Keystone correction for stereoscopic cinematography. IEEE Computer Society Conference on Computer Vision and Pattern Recognition Workshops. 2012, 1-7 (2012).

- Kang, W., Lee, S. Horizontal parallax distortion correction method in toed-in camera with wide-angle lens. 3DTV Conference: The True Vision - Capture, Transmission and Display of 3D Video. 2009, 1-4 (2009).

Перепечатки и разрешения

Запросить разрешение на использование текста или рисунков этого JoVE статьи

Запросить разрешениеThis article has been published

Video Coming Soon

Авторские права © 2025 MyJoVE Corporation. Все права защищены