このコンテンツを視聴するには、JoVE 購読が必要です。 サインイン又は無料トライアルを申し込む。

Method Article

多目的な自家製ビデオカメラとDeepLabCutを使用して、オペラコンディショニングチャンバー内のラットを追跡する

要約

このプロトコルは、小型で汎用性の高いビデオカメラを構築する方法と、そこから得られたビデオを使用してニューラルネットワークを訓練し、オペラ座内の動物の位置を追跡する方法を説明します。これは、オペラコンディショニングテストから得られたデータログの標準的な分析を補完する貴重なものです。

要約

オペラコンディショニングチャンバーは、神経科学の分野で幅広い行動検査を行うために使用されます。記録されたデータは、通常、チャンバー内に存在するレバーと鼻突きセンサーのトリガーに基づいています。これは、動物が特定の応答を実行するタイミングと方法の詳細なビューを提供しますが、センサーをトリガーしない動作を評価するために使用することはできません。したがって、動物が自分自身を配置し、チャンバー内を移動する方法を評価することはめったに不可能です。この情報を得るためには、研究者は一般的にビデオを記録して分析する必要があります。オペラコンディショニングチャンバーのメーカーは、通常、高品質のカメラ設定を顧客に供給することができます。しかし、これらは非常に高価であり、必ずしも他のメーカーまたは他の行動テストのセットアップからのチャンバーに合うわけではありません。現在のプロトコルは、ホビーエレクトロニクスコンポーネントを使用して安価で汎用性の高いビデオカメラを構築する方法を説明しています。さらに、画像解析ソフトウェアパッケージDeepLabCutを使用して、強力な光信号の状態とラットの位置を、オペランコンディショニングチャンバーから収集したビデオで追跡する方法について説明します。前者は、テストセッション全体をカバーするビデオに関心のある短いセグメントを選択する際に大きな助けとなり、後者は、オペラ室によって生成されたデータログから得ることができないパラメータの分析を可能にします。

概要

行動神経科学の分野では、研究者は一般的にげっ歯類の異なる認知および精神医学的特徴の広い範囲を評価するためにオペラコンディショニングチャンバーを使用しています。このようなシステムには複数の異なるメーカーがありますが、通常は特定の属性を共有し、ほぼ標準化された設計11、2、32,を持っています。チャンバーは一般的に正方形または長方形の形をしており、動物を内部に配置するために開くことができる1つの壁と、レバー、鼻突き開口部、報酬トレイ、応答ホイールおよび様々な種類のライト1、2、32,3などのコンポーネントを含む残りの壁の1つまたは2つを有する。チャンバーに存在するライトとセンサーは、テストプロトコルを制御し、動物の行動11、2、3、4、52,3,4を5追跡するために使用されます。典型的なオペラの調節システムは動物が部屋に存在する異なったオペランドおよび開口部と相互作用する方法の非常に詳細な分析を可能にする。一般に、センサーがトリガされる任意の機会は、システムによって記録することができ、このデータからユーザーは、テスト44、55の特定のステップの間に動物が何をしたかを記述する詳細なログファイルを取得することができます。これは動物の性能を広範囲に表現しますが、1つ以上のセンサー44,55を直接トリガする動作を記述するためにのみ使用できます。そのため、試験の異なる段階で動物がチャンバー内をどのように位置づけ、移動するのかについては、6、7、8、9、10などはよく説明されていない。6,7,8,9,10このような情報は動物の行動を完全に理解するために価値がある可能性がありますので、これは残念です。例えば、特定の動物が特定のテスト6で悪いパフォーマンスを発揮する理由を明らかにするために使用され、困難,なタスク6、7、8、9、107,8,9を扱うために動物が開発する戦略を記述したり、おそらく単純な行動11、12,12の真の複雑さを理解することができます。610このような明瞭な情報を得るために、研究者は一般的にビデオ,6、7、8、9、10、117,8,9,10の手動分析に目を向けます。611

オペラコンディショニングチャンバーからのビデオを録画する場合、カメラの選択は非常に重要です。チャンバーは一般的に孤立したキュービクルに位置し、プロトコルは頻繁に可視光が輝いているステップを利用して3、6、7、8、9。6,7,8,9そのため、赤外線(IR)照明とIRに敏感なカメラを組み合わせて使用する必要があります。また、隔離キュービクル内にカメラを配置するために利用可能なスペースは、多くの場合、非常に限られた、広い視野を有するレンズ(例えば、魚眼レンズ)9を用いた小型カメラを有することから強く利益を得られることを意味する。オペラコンディショニングシステムのメーカーは、多くの場合、顧客に高品質のカメラのセットアップを供給することができますが、これらのシステムは高価であり、必ずしも他のメーカーや他の行動テストのためのセットアップからのチャンバーに適合しません。しかし、スタンドアロンビデオカメラを使用する上で顕著な利点は、これらのセットアップは、多くの場合、オペランコンディショニングシステム13、14,14と直接インターフェースすることができるということです。これにより、完全なテスト セッションではなく特定のイベントのみを記録するように設定できるため、次の分析に大きく役立ちます。

現在のプロトコルは、ホビーエレクトロニクスコンポーネントを使用して安価で汎用性の高いビデオカメラを構築する方法を説明しています。カメラは魚眼レンズを使用し、IR照明に敏感で、IR発光ダイオード(IR LED)のセットが取り付けられています。さらに、それは平らで、細いプロフィールを持つために造られる。これらの側面は、市販のオペラコンディショニングチャンバーや他の行動テスト設定からのビデオを録画するのに理想的です。このプロトコルはさらに、カメラで取得したビデオを処理する方法と、ソフトウェアパッケージDeepLabCut15,16を使用して、目的のビデオシーケンスを抽出し、16動物の動きを追跡する方法について説明します。これは、コンディショニングシステムのオペラメーカーが提供する統合ソリューション上でスタンドアロンカメラを使用することの欠点を部分的に回避し、行動の手動スコアリングを補完します。

プロトコルを一般的な形式で記述し、プロセス全体を異なるオペラコンディショニングテストのビデオに適応させることができることを強調する努力がなされています。特定の主要概念を説明するために、5選択逐次反応時間試験(5CSRTT)1717を行うラットの動画が例として用いられる。

プロトコル

動物の取り扱いを含むすべての手順は、動物研究のためのマルメルンド倫理委員会によって承認されています。

1. ビデオカメラの構築

注: カメラの構築に必要なコンポーネントのリストは、 材料表に記載されています。 図 1、 図 2、図 3、 図 4、図 5も参照してください。

- カメラスタンドの開口部の周りに(魚眼レンズパッケージに付属する)磁気金属リングを取り付けます(図2A)。これにより、魚眼レンズをカメラの前に置きます。

- カメラモジュールをカメラスタンドに取り付けます(図2B)。これにより、カメラモジュールにいくらかの安定性が与え、電子回路に対してある程度の保護を提供します。

- カメラモジュールとマイクロコンピュータ(図1)のカメラポートを、プラスチッククリップの端をそっと引っ張って開きます(図2C)。

- カメラポートにリボンケーブルを置き、銀色のコネクタが回路基板に向かるようにします(図2C)。カメラポートのプラスチッククリップを押し込み、ケーブルを所定の位置にロックします。

- マイクロコンピュータをプラスチックケースに入れ、リストされているマイクロSDカード(図2D)を挿入します。

メモ:マイクロSDカードは、マイクロコンピュータのハードドライブとして機能し、完全なオペレーティングシステムが含まれています。リストされているマイクロSDカードには、インストールマネージャがプリインストールされています(新しいアウトオブボックスソフトウェア(NOOBS)。。別の方法として、マイクロコンピュータのオペレーティングシステム(RaspbianまたはRasberry Pi OS)の最新バージョンの画像を一般的なマイクロSDカードに書き込むことができます。これに関する支援については、公式のWebリソース18を参照してください。32 Gbのストレージスペースを備えたクラス10マイクロSDカードを使用することが好ましい。より大きなSDカードは、記載されているマイクロコンピュータと完全に互換性がない可能性があります。 - モニタ、キーボード、マウスをマイクロコンピュータに接続し、電源を接続します。

- インストールガイドの指示に従って、マイクロコンピュータのオペレーティングシステム(RaspbianまたはRasberry Pi OS)の完全インストールを実行します。マイクロコンピュータが起動したら、イーサネットケーブルまたはWi-Fiを介してインターネットに接続されていることを確認します。

- 以下の手順に従って、マイクロコンピュータのプレインストールされたソフトウェアパッケージを更新します。

- ターミナル ウィンドウを開きます (図 3A)。

- 「sudo apt-get 更新」(引用符を除く) と入力し、Enter キーを押します (図 3B)。プロセスが完了するまで待ちます。

- 「sudo apt フルアップグレード」(引用符を除く)と入力して Enter キーを押します。プロンプトが表示されたらボタンの応答を行い、プロセスが完了するまで待ちます。

- [スタート]メニューの [基本設定とラズベリーパイの構成] を選択します (図 3C)。開いたウィンドウで、[インターフェイス] タブに移動し、[カメラとI2Cを有効にする] をクリックします。これは、マイクロコンピュータがカメラとIR LEDモジュールで動作するために必要です。

- 補足ファイル 1の名前を "Pi_video_camera_Clemensson_2019.py" に変更します。USB メモリスティックにコピーし、その後、マイクロコンピュータの /home/pi フォルダにコピーします (図 3D)。このファイルは Python スクリプトで、ステップ 1.13 で接続されているボタン スイッチでビデオ録画を行うことができます。

- 以下の手順に従って、マイクロコンピュータの rc.local ファイルを編集します。これにより、コンピュータはステップ 1.10 でコピーされたスクリプトを起動し、ステップ 1.13 で接続された IR LED を起動すると起動します。

注意: この自動起動機能は、一覧に記載されているモデル以外のマイクロコンピュータボードでは動作しません。- ターミナルウィンドウを開き、「sudo nano /etc/rc.local」(引用符を除く)と入力して Enter キーを押します。テキスト ファイルが開きます (図 4A)。

- キーボードの矢印キーを使用して、カーソルを「fi」と「exit 0」の間のスペースに移動します(図4A)。

- 図 4Bに示すように、次のテキストを追加します。

sudo i2cset -y 1 0x70 0x00 0xa5 &

sudo i2cset -y 1 0x70 0x09 0x0f &

sudo i2cset -y 1 0x70 0x01 0x32 &

sudo i2cset -y 1 0x70 0x03 0x32 &

sudo i2cset -y 1 0x70 0x06 0x32 &

sudo i2cset -y 1 0x70 0x08 0x32 &

スドパイソン /ホーム/パイ/Pi_video_camera_Clemensson_2019.py & - Ctrl + xキーを押し、その後yとEnterを押して変更を保存します。

- 図5Aに示すように必要な成分を一緒にソルダ化し、以下に説明する。

- 2 つの色付き LED の場合は、抵抗と女性のジャンパ ケーブルを片方の脚に、もう 1 本の脚に女性のジャンパ ケーブルを取り付けます(図 5A)。ケーブルはできるだけ短くしてください。これは、マイクロコンピュータの汎用入出力(GPIO)ピンの地面に接続する必要がありますので、LEDの電極のどれが負のもの(通常は短いもの)であるのかをメモしてください。

- 2 つのボタン スイッチの場合は、各脚にメスのジャンパ ケーブルを取り付けます(図 5A)。ケーブルをスイッチの1つに長くし、もう一方のスイッチに短くします。

- IR LED モジュールを組み立てるには、公式 Web リソース19で入手可能な指示に従ってください。

- はんだ付きジョイントをシュリンクチューブで覆い、コンポーネントを短絡するリスクを抑えます。

- マイクロコンピュータの電源を切り、 図 5Bに示すようにスイッチと LED を GPIO ピンに接続します( 以下を参照)。

注意: 間違ったGPIOピンにコンポーネントを配線すると、カメラの電源が入っているときに、それらの、またはマイクロコンピュータが損傷する可能性があります。- マイナスの端がピン#14に接続し、正の端がピン#12に接続するように、1 つの LED を接続します。このLEDは、マイクロコンピュータが起動し、カメラを使用する準備が整ったときに輝きます。

- ボタンスイッチを長いケーブルで接続して、1本のケーブルをピン#9に接続し、もう一方のケーブルをピン#11接続します。このボタンは、ビデオ録画を開始および停止するために使用されます。

メモ:カメラを制御するスクリプトは、ビデオ録画を開始または停止した直後に数秒間このボタンが応答しないように書かれています。 - マイナスの端がピン#20に接続し、正の端がピン#13に接続するように、1 つの LED を接続します。この LED は、カメラがビデオを録画しているときに輝きます。

- ボタンスイッチを短いケーブルで接続して、1 本のケーブルをピン #37に接続し、もう 1 本のケーブルをピン #39に接続します。このスイッチは、カメラの電源を切るために使用されます。

- IR LED モジュールを、公式 Web リソース19に記載されているように接続します。

2. 目的のオペラコンディショニングプロトコルの設計

注: DeepLabCut を使用して、オペラ室から録画されたビデオのプロトコル進行を追跡するには、以下で説明するように、動作プロトコルを特定の方法で構成する必要があります。

- プロトコルの特定のステップ(個別の試験の開始、またはテストセッションなど)の指標として、チャンバーのハウスライト、または別の強い光信号を使用するようにプロトコルを設定する(図6A)。このシグナルは、このプロトコルの残りの部分では「プロトコルステップインジケータ」と呼ばれます。この信号が存在すると、記録されたビデオでプロトコルの進行を追跡することができます。

- プロトコルステップインジケータがアクティブになったときに関連して、関心のあるすべての応答を個々のタイムスタンプで記録するようにプロトコルを設定します。

3. 目的の行動テストを行う動物の動画を録画する

- カメラを室内の上に置き、内部の領域の上面図を記録します(図7)。

注:これは、チャンバー内で動物の一般的な位置と姿勢をキャプチャするために特に適しています。カメラのインジケータライトとIR LEDモジュールをカメラレンズの近くに置かないようにしてください。 - 電源ケーブルを介してカメラをコンセントに接続してカメラを起動します。

注:最初の使用前に、カメラモジュールに付属している小さなツールを使用して、カメラの焦点を設定することが有益です。 - ビデオ録画を開始および停止するには、ステップ 1.13.2 で接続されているボタンを使用します。

- 次の手順に従って、カメラの電源を切ります。

- ステップ 1.13.4 で接続されているボタンを押し続けて、ステップ 1.13.1 で接続されている LED がオフになるまで押し続けます。これにより、カメラのシャットダウンプロセスが開始されます。

- マイクロコンピュータの上部に表示されている緑色の LED (図 1)が点滅しなくなるまで待ちます。

- カメラの電源を取り外します。

注意: マイクロコンピュータの実行中に電源を抜き、マイクロSDカードのデータが破損する可能性があります。

- カメラをモニター、キーボード、マウス、USB ストレージデバイスに接続し、デスクトップからビデオファイルを取得します。

注: ファイルの名前は、ビデオ録画が開始された日時に従って指定されます。しかし、マイクロコンピュータは内部クロックを持っていないし、唯一のインターネットに接続したときに、その時間の設定を更新します。 - 録画したビデオを .h264 から に変換します。MP4は、後者がDeepLabCutとほとんどのメディアプレーヤーでうまく機能します。

注: これを実現するには、複数の方法があります。1 つは 補足ファイル 2 で説明されています。

4. ディープラボカットを使用したビデオの分析

注:DeepLabCutは、ユーザーがビデオフレームのセットに関心のある任意のオブジェクトを定義し、その後、フルレングスビデオ15、16,16でオブジェクトの位置を追跡するニューラルネットワークを訓練するためにこれらを使用することを可能にするソフトウェアパッケージです。このセクションでは、DeepLabCutを使用して、プロトコルステップインジケータのステータスとラットの頭部の位置を追跡する方法について、大まかな概要を説明します。DeepLabCutのインストールと使用は、他の公開プロトコル15、16,でよく説明されています。各ステップは、他の場所で説明されているように、特定のPythonコマンドまたはDeepLabCutのグラフィックユーザーインターフェースを介して行うことができます15,,16.

- 16で概説されている手順に従って、新しい DeepLabCut プロジェクトを作成および構成します。

- DeepLabCutのフレームグラブ機能を使用して、セクション3で記録された1つ以上のビデオから700\u2012900ビデオフレームを抽出します。

注:動物が毛皮の色素沈着やその他の視覚特性でかなり異なる場合は、700\u2012900抽出されたビデオフレームが異なる動物のビデオに分割されることをお勧めします。これを通して、1つの訓練されたネットワークを使用して、異なる個人を追跡することができます。- プロトコル ステップ インジケータのアクティブ (図 8A) と非アクティブ (図 8B) の両方の状態を表示するビデオ フレームを含める必要があります。

- テスト中にラットが表示する可能性のあるさまざまな位置、姿勢、頭の動きの範囲をカバーするビデオフレームを含める必要があります。これには、ラットがチャンバーの異なる領域に静止しているビデオフレームと、その頭が異なる方向を向いているビデオフレーム、ラットが積極的に動いているビデオフレーム、鼻突き開口部に入り、ペレットトラフに入るビデオフレームが含まれるはずです。

- 手順 4.2 で抽出した各ビデオ フレームで、Rat の頭部の位置を手動でマークするには、DeepLabCut のラベリング ツールボックスを使用します。マウスカーソルを使用して、ラットの耳の間の中央の位置に「頭部」ラベルを配置します(図8A,B)。また、室内のハウスライト(または他のプロトコルステップインジケータ)の位置を、活発に輝いている各ビデオフレームにマークを付けます(図8A)。ハウス ライトは、非アクティブなフレームにラベルを付けておいてください (図 8B)。

- DeepLabCutの「トレーニングデータセットの作成」および「トレーニングネットワーク」機能を使用して、ステップ4.3でラベル付けされたビデオフレームからトレーニングデータセットを作成し、ニューラルネットワークのトレーニングを開始します。選択したネットワークの種類に対して必ず [resnet_101] を選択してください。

- トレーニング損失が 0.01 を下回った場合は、ネットワークのトレーニングを停止します。これには、最大 500,000 のトレーニング イテレーションが必要になる場合があります。

注: 約 8 GB のメモリを搭載した GPU マシンと、約 900 個のビデオ フレーム (解像度: 1640 x 1232 ピクセル) のトレーニング セットを使用する場合、トレーニング プロセスには約 72 時間かかることが判明しました。 - DeepLabCutのビデオ分析機能を使用して、ステップ4.4で訓練されたニューラルネットワークを使用して、ステップ3で収集したビデオを分析します。これにより、分析されたビデオの各ビデオフレームで、ラットの頭部の追跡位置とプロトコルステップインジケータをリストした.csvファイルが提供されます。また、トラック位置が視覚的に表示されるマークアップビデオファイルが作成されます (ビデオ 1-8)。

- 追跡の精度を評価するには、以下の手順に従います。

- DeepLabCutの組み込みの評価機能を使用して、ネットワークの追跡精度の自動評価を取得します。これは、ステップ 4.3 でラベル付けされたビデオ フレームに基づいており、ネットワークによって追跡される位置が手動で配置されたラベルからどれくらい離れているかを示します。

- ステップ 4.6 で取得したマークアップ ビデオで、1 つ以上の短いビデオ シーケンス (それぞれ約 100\u2012200 ビデオ フレーム) を選択します。ビデオシーケンスを通り、フレームごとに、ラベルが正しくラットの頭、尾などの位置を示すフレーム数、およびラベルが誤った位置に配置されたフレームの数または表示されないフレームの数に注意してください。

- ボディパーツまたはオブジェクトのラベルが頻繁に失われたり、誤った位置に配置されたりする場合は、トラッキングが失敗する状況を特定します。手順 4.2 を繰り返して、これらの機会のラベル付きフレームを抽出して追加します。と4.3.次に、ネットワークを再トレーニングし、手順 4.4 ~ 4.7 を繰り返してビデオを再分析します。最終的には、>90%の精度のトラッキング精度を達成する必要があります。

5. オペラ室の関心点の座標を取得する

- ステップ 4.3 で説明したように DeepLabCut を使用して、単一のビデオ フレーム (図 8C)で、操作室の対象となるポイント (鼻突き開口部、レバーなど) を手動でマークします。これらは、研究固有の興味に応じて手動で選択されますが、プロトコルステップインジケータの位置は常に含める必要があります。

- プロジェクト フォルダーの "ラベル付きデータ" の下に DeepLabCut が自動的に格納する .csv ファイルから、目的のマークされたポイントの座標を取得します。

6. プロトコルステップインジケータがアクティブなビデオセグメントの識別

- ステップ 4.6 の DeepLabCut ビデオ分析から得た .csv ファイルを、選択したデータ管理ソフトウェアにロードします。

注: DeepLabCutおよびオペラコンディショニングシステムから得られるデータの量と複雑さにより、データ管理は自動分析スクリプトを使用して行うことをお勧めします。この作業を開始するには、他の場所で入手できるエントリ レベルのガイド20、21、,22を参照してください。 - プロトコルステップインジケータがセクション5で得られた位置から60ピクセル以内に、ビデオセグメントが追跡される点に注意してください。これらは、プロトコルステップインジケータがアクティブな期間になります(図6B)。

注: プロトコル ステップ インジケーターが輝いていないビデオ セグメントでは、マークされたビデオは DeepLabCut がどの位置にもそれを追跡していないことを示しているように見えるかもしれません。ただし、これはまれにしか行われず、通常は複数の散在する場所に追跡されます。 - プロトコルステップインジケータがアクティブな各期間の正確な開始点を抽出します (図6C:1)。

7. 関心のある動画セグメントの特定

- プロトコルステップインジケータがアクティブになるポイント(図6C:1)と、オペラ室によって記録された応答のタイムスタンプ(セクション2、 図6C:2)を考えてみましょう。

- この情報を使用して、試行間の間隔、応答、報酬の取得など、特定の興味深いイベントをカバーするビデオ セグメントを特定します (図 6C: 3、図 6D)。

注:このためには、ここに記載されているカメラは30 fpsでビデオを記録することを覚えておいてください。 - 関心のあるこれらのイベントをカバーする特定のビデオ フレームに注意してください。

- (オプション)完全なテスト セッションのビデオ ファイルを編集して、特定のセグメントのみを含めます。

注: これを実現するには、複数の方法があります。1 つは 補助ファイル 2 および 3で説明されています。これは、多数のビデオを保存する場合に非常に役立ち、結果の確認と表示をより便利にすることもできます。

8. 特定のビデオセグメントにおける動物の位置と動きを分析する

- ステップ 4.6 で DeepLabCut から取得したヘッド位置の完全なトラッキング データをサブセット化して、セクション 7 に記載されているビデオ セグメントのみを含めます。

- セクション 5 (図 8C) で選択した 1 つまたは複数の基準点に対して、動物の頭部の位置を計算します。これにより、さまざまな動画間でのトラッキングと位置の比較が可能になります。

- 動物の位置と動きの関連する詳細な分析を実行します。

注: 実行される特定の分析は、厳密にスタディ固有になります。分析できるパラメータの例を以下に示します。- 1 つのグラフ内の選択した期間に検出されたすべての座標をプロットして、パス トレースを視覚化します。

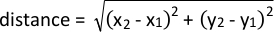

- 次の式を使用して、特定の対象点への近接性を分析します。

- 連続したフレームでのトラッキングされた座標間の距離を計算し、カメラの 1/fps で除算することで、移動中の速度の変化を分析します。

結果

ビデオカメラのパフォーマンス

代表結果は、床面積が28.5cm x 25.5cm、高さ28.5cmのラット用の手術用コンディショニングチャンバーに集めた。魚眼レンズを取り付けた状態で、カメラはチャンバーの上に置くと、床面積全体と周囲の壁の大部分を捉えます(図7A)。そのため、カメラがチャンバーの上部の中心外に配置されていても、良好な?...

ディスカッション

このプロトコルは、操作コンディショニングチャンバーやその他の動作テスト設定からビデオを記録するために使用できる安価で柔軟なビデオカメラを構築する方法を説明します。さらに、DeepLabCutを使用してこれらのビデオ内の強い光信号を追跡する方法と、完全なテストセッションをカバーするビデオファイルの関心のある短いビデオセグメントを特定するのにどのように使用できるかを...

開示事項

ラズベリーパイ財団の資料やリソースがこの原稿に使用され、引用されていますが、財団はこの原稿の機器やデータの準備や使用に積極的に関与しませんでした。同じことがパイサプライにも当てはまります。著者らは開示するものは何もない。

謝辞

この研究は、スウェーデン脳財団、スウェーデンパーキンソン財団、スウェーデン政府臨床研究資金(M.A.C.)、ウェンナー・グレン財団(M.A.C,E.K.H.C)、オーレン財団(M.A.C)、財団ブランシュフロール・ボンコムニ・ルドヴォヴィシ(S.F.)からの助成金によって支えられました。

資料

| Name | Company | Catalog Number | Comments |

| 32 Gb micro SD card with New Our Of Box Software (NOOBS) preinstalled | The Pi hut (https://thpihut.com) | 32GB | |

| 330-Ohm resistor | The Pi hut (https://thpihut.com) | 100287 | This article is for a package with mixed resistors, where 330-ohm resistors are included. |

| Camera module (Raspberry Pi NoIR camera v.2) | The Pi hut (https://thpihut.com) | 100004 | |

| Camera ribbon cable (Raspberry Pi Zero camera cable stub) | The Pi hut (https://thpihut.com) | MMP-1294 | This is only needed if a Raspberry Pi zero is used. If another Raspberry Pi board is used, a suitable camera ribbon cable accompanies the camera component |

| Colored LEDs | The Pi hut (https://thpihut.com) | ADA4203 | This article is for a package with mixed colors of LEDs. Any color can be used. |

| Female-Female jumper cables | The Pi hut (https://thpihut.com) | ADA266 | |

| IR LED module (Bright Pi) | Pi Supply (https://uk.pi-supply.com) | PIS-0027 | |

| microcomputer motherboard (Raspberry Pi Zero board with presoldered headers) | The Pi hut (https://thpihut.com) | 102373 | Other Raspberry Pi boards can also be used, although the method for automatically starting the Python script only works with Raspberry Pi zero. If using other models, the python script needs to be started manually. |

| Push button switch | The Pi hut (https://thpihut.com) | ADA367 | |

| Raspberry Pi power supply cable | The Pi hut (https://thpihut.com) | 102032 | |

| Raspberry Pi Zero case | The Pi hut (https://thpihut.com) | 102118 | |

| Raspberry Pi, Mod my pi, camera stand with magnetic fish eye lens and magnetic metal ring attachment | The Pi hut (https://thpihut.com) | MMP-0310-KIT |

参考文献

- Pritchett, K., Mulder, G. B. Operant conditioning. Contemporary Topics in Laboratory Animal Science. 43 (4), (2004).

- Clemensson, E. K. H., Novati, A., Clemensson, L. E., Riess, O., Nguyen, H. P. The BACHD rat model of Huntington disease shows slowed learning in a Go/No-Go-like test of visual discrimination. Behavioural Brain Research. 359, 116-126 (2019).

- Asinof, S. K., Paine, T. A. The 5-choice serial reaction time task: a task of attention and impulse control for rodents. Journal of Visualized Experiments. (90), e51574 (2014).

- Coulbourn instruments. Graphic State: Graphic State 4 user's manual. Coulbourn instruments. , 12-17 (2013).

- Med Associates Inc. Med-PC IV: Med-PC IV programmer's manual. Med Associates Inc. , 21-44 (2006).

- Clemensson, E. K. H., Clemensson, L. E., Riess, O., Nguyen, H. P. The BACHD rat model of Huntingon disease shows signs of fronto-striatal dysfunction in two operant conditioning tests of short-term memory. PloS One. 12 (1), (2017).

- Herremans, A. H. J., Hijzen, T. H., Welborn, P. F. E., Olivier, B., Slangen, J. L. Effect of infusion of cholinergic drugs into the prefrontal cortex area on delayed matching to position performance in the rat. Brain Research. 711 (1-2), 102-111 (1996).

- Chudasama, Y., Muir, J. L. A behavioral analysis of the delayed non-matching to position task: the effects of scopolamine, lesions of the fornix and of the prelimbic region on mediating behaviours by rats. Psychopharmacology. 134 (1), 73-82 (1997).

- Talpos, J. C., McTighe, S. M., Dias, R., Saksida, L. M., Bussey, T. J. Trial-unique, delayed nonmatching-to-location (TUNL): A novel, highly hippocampus-dependent automated touchscreen test of location memory and pattern separation. Neurobiology of Learning and Memory. 94 (3), 341 (2010).

- Rayburn-Reeves, R. M., Moore, M. K., Smith, T. E., Crafton, D. A., Marden, K. L. Spatial midsession reversal learning in rats: Effects of egocentric cue use and memory. Behavioural Processes. 152, 10-17 (2018).

- Gallo, A., Duchatelle, E., Elkhessaimi, A., Le Pape, G., Desportes, J. Topographic analysis of the rat's behavior in the Skinner box. Behavioural Processes. 33 (3), 318-328 (1995).

- Iversen, I. H. Response-initiated imaging of operant behavior using a digital camera. Journal of the Experimental Analysis of Behavior. 77 (3), 283-300 (2002).

- Med Associates Inc. Video monitor: Video monitor SOF-842 user's manual. Med Associates Inc. , 26-30 (2004).

- . Coulbourn Instruments Available from: https://www.coulbourn.com/product_p/h39-16.htm (2020)

- Mathis, A., et al. DeepLabCut: markerless pose estimation of user-defined body parts with deep learning. Nature Neuroscience. 21 (9), 1281-1289 (2018).

- Nath, T., Mathis, A., Chen, A. C., Patel, A., Bethge, M., Mathis, M. W. Using DeepLabCut for 3D markerless pose estimation across species and behaviors. Nature Protocols. 14 (7), 2152-2176 (2019).

- Bari, A., Dalley, J. W., Robbins, T. W. The application of the 5-chopice serial reaction time task for the assessment of visual attentional processes and impulse control in rats. Nature Protocols. 3 (5), 759-767 (2008).

- . Raspberry Pi foundation Available from: https://thepi.io/how-to-install-raspbian-on-the-raspberry-pi/ (2020)

- . Pi-supply Available from: https://learn.pi-supply.com/make/bright-pi-quickstart-faq/ (2018)

- . Python Available from: https://wiki.python.org/moin/BeginnersGuide/NonProgrammers (2020)

- . MathWorks Available from: https://mathworks.com/academia/highschool/ (2020)

- . Cran.R-Project.org Available from: https://cran.r-project.org/manuals.html (2020)

- Liu, Y., Tian, C., Huang, Y. . Critical assessment of correction methods for fisheye lens distortion. The international archives of the photogrammetry, remote sensing and spatial information sciences. , (2016).

- Pereira, T. D., et al. Fast animal pose estimation using deep neural networks. Nature Methods. 16 (1), 117-125 (2019).

- Graving, J. M., et al. DeepPoseKit, a software toolkit for fast and robust animal pose estimation using deep learning. Elife. 8 (47994), (2019).

- Geuther, B. Q., et al. Robust mouse tracking in complex environments using neural networks. Communications Biology. 2 (124), (2019).

転載および許可

このJoVE論文のテキスト又は図を再利用するための許可を申請します

許可を申請さらに記事を探す

This article has been published

Video Coming Soon

Copyright © 2023 MyJoVE Corporation. All rights reserved