JoVE 비디오를 활용하시려면 도서관을 통한 기관 구독이 필요합니다. 전체 비디오를 보시려면 로그인하거나 무료 트라이얼을 시작하세요.

Method Article

다재다능한 수제 비디오 카메라와 DeepLabCut을 사용하여 오페라 컨디셔닝 챔버에서 쥐 추적

요약

이 프로토콜은 작고 다재다능한 비디오 카메라를 구축하는 방법과 작동 컨디셔닝 챔버 내부의 동물의 위치를 추적하는 신경망을 훈련하기 위해 비디오에서 얻은 비디오를 사용하는 방법에 대해 설명합니다. 이는 작동 컨디셔닝 테스트에서 얻은 데이터 로그의 표준 분석을 보완하는 데 유용합니다.

초록

오페라 컨디셔닝 챔버는 신경 과학 분야에서 광범위한 행동 테스트를 수행하는 데 사용됩니다. 기록된 데이터는 일반적으로 챔버 내부에 존재하는 레버 및 코 찌르기 센서의 트리거링을 기반으로 합니다. 이것은 동물이 특정 응답을 수행하는 시기와 방법에 대한 자세한 보기를 제공하지만 센서를 트리거하지 않는 동작을 평가하는 데 사용할 수 없습니다. 따라서 동물이 어떻게 자신을 배치하고 챔버 내부로 이동하는지 평가하는 것은 거의 불가능합니다. 이 정보를 얻으려면 일반적으로 연구자들은 비디오를 녹화하고 분석해야 합니다. 작동 식 컨디셔닝 챔버 제조업체는 일반적으로 고객에게 고품질 의 카메라 설정을 공급할 수 있습니다. 그러나, 이들은 매우 비용이 많이 드는 수 있으며 반드시 다른 제조 업체 또는 다른 행동 테스트 설정에서 챔버를 적합 하지 않습니다. 현재 프로토콜은 취미 전자 부품으로 저렴하고 다양한 비디오 카메라를 구축하는 방법을 설명합니다. 또한 이미지 분석 소프트웨어 패키지 DeepLabCut을 사용하여 조작된 컨디셔닝 챔버에서 수집한 비디오에서 강력한 광 신호의 상태와 쥐의 위치를 추적하는 방법을 설명합니다. 전자는 전체 테스트 세션을 포함하는 비디오에 대한 짧은 관심 세그먼트를 선택할 때 큰 도움이되며, 후자는 작동 챔버에서 생성 한 데이터 로그에서 얻을 수없는 매개 변수를 분석 할 수 있습니다.

서문

행동 신경 과학 분야에서, 연구원은 일반적으로 설치류에 있는 다른 인지 및 정신 기능의 넓은 범위를 평가하기 위하여 조작된 컨디셔닝 챔버를 이용합니다. 이러한 시스템의 여러 다른 제조업체가 있지만 일반적으로 특정 특성을 공유하고 거의 표준화 된 디자인1,2,,3을가지고 있습니다. 챔버는 일반적으로 사각형 또는 사각형 모양이며, 내부에 동물을 배치하기 위해 열 수있는 하나의 벽, 레버, 코 찌르기 개구부, 보상 트레이, 응답 바퀴 및 다양한 종류의조명1,,2,,3과같은 구성 요소를 포함하는 나머지 벽 중 하나 또는 두 개가 있습니다. 챔버에 존재하는 조명과 센서는 테스트 프로토콜을 제어하고 동물의 동작을추적하는 데 사용됩니다1,2,,3,,4,,5. 일반적인 작동 조절 시스템은 동물이 챔버에 존재하는 다른 오페라다 및 개구부와 상호 작용하는 방법에 대한 매우 상세한 분석을 허용합니다. 일반적으로 센서가 트리거되는 경우는 시스템에 의해 기록될 수 있으며, 이 데이터에서 사용자는 테스트4,,5의특정 단계에서 동물이 한 일을 설명하는 자세한 로그 파일을 얻을 수 있습니다. 이것은 동물의 성능을 광범위하게 표현하지만 하나 이상의4센서4,5를직접 트리거하는 동작을 설명하는 데만 사용할 수 있습니다. 이와 같이, 동물의 위치와 시험의 상이한 단계에서,챔버 내부의 이동 방식과 관련된 측면은6,77,8,,9,,10을잘 설명하지 않는다. 이러한 정보는 동물의 행동을 완전히 이해하는 데 유용할 수 있기 때문에 이것은 불행한 일입니다. 예를 들어, 특정 동물이 주어진 시험6에서제대로 수행하는 이유를 명확히하는 데 사용할 수 있으며, 동물이 어려운 작업,6,7,8,,9,10을처리하기 위해 개발할 수 있는 전략을 설명하거나, 아마도 간단한,동작(11,,12)의진정한 복잡성을 인식할 수 있다., 이러한 명확한 정보를 얻기 위해, 연구원은 일반적으로 비디오,,6,7,8,89,910,,11의수동 분석으로 전환합니다.

편집 가능한 컨디셔닝 챔버에서 비디오를 녹화할 때 카메라의 선택이 중요합니다. 챔버는 일반적으로 격리 칸막이에 위치하며, 프로토콜은 가시광선이3,6,,7,,88,9를비추지 않는 단계를 자주 사용합니다., 따라서 완전한 어둠 속에서도 시야를 확보할 수 있으므로 IR에 민감한 카메라와 함께 적외선(IR) 조명을 사용해야 합니다. 또한, 격리 칸막이 안에 카메라를 배치할 수 있는 공간은 매우 제한적이기 때문에 넓은 시야(예: 어안 렌즈)를 가진 렌즈를 사용하는 소형 카메라를 갖는 것이 매우 유익하다는 것을 의미한다9. 작동 식 컨디셔닝 시스템 제조업체는 종종 고객에게 고품질 의 카메라 설정을 공급할 수 있지만 이러한 시스템은 비용이 많이 들 수 있으며 다른 제조업체의 챔버 또는 다른 행동 테스트를 위해 반드시 적합하지는 않습니다. 그러나 독립 실행형 비디오 카메라를 사용하는 데 비해 주목할 만한 이점은 이러한 설정이 종종 작동 컨디셔닝시스템(13,,14)과직접 인터페이스할 수 있다는 것입니다. 이를 통해 전체 테스트 세션이 아닌 특정 이벤트만 기록하도록 설정할 수 있으며, 이는 다음 분석에 크게 도움이 될 수 있습니다.

현재 프로토콜은 취미 전자 부품으로 저렴하고 다양한 비디오 카메라를 구축하는 방법을 설명합니다. 카메라는 어안 렌즈를 사용하고 IR 조명에 민감하며 IR 발광 다이오드 세트(IR LED)가 부착되어 있습니다. 또한, 그것은 평평하고 슬림 프로파일을 가지고 내장되어 있습니다. 이러한 측면은 함께 대부분의 시판 가능한 작동 조절 챔버뿐만 아니라 다른 행동 테스트 설정에서 비디오를 녹화하는 데 이상적입니다. 이 프로토콜은 카메라로 얻은 비디오를 처리하는 방법과 소프트웨어 패키지 DeepLabCut15,,16을 사용하여 관심 있는 비디오 시퀀스를 추출하고 동물의 움직임을 추적하는 데 도움을 줄 수 있는 방법을 추가로 설명합니다. 이는 컨디셔닝 시스템의 작동 제조업체가 제공하는 통합 솔루션에 독립형 카메라를 사용하는 단점을 부분적으로 우회하고 동작의 수동 점수를 보완합니다.

전체 프로세스가 다른 작동 컨디셔닝 테스트의 비디오에 적용 될 수 있음을 강조하기 위해 일반적인 형식으로 프로토콜을 작성하기 위한 노력이 이루어졌습니다. 특정 주요 개념을 설명하기 위해 5선택 직렬 반응 시간 테스트(5CSRTT)17을 수행하는 쥐의 비디오가 예로 사용됩니다.

프로토콜

동물 취급을 포함하는 모든 절차는 동물 연구를 위한 말뫼-룬드 윤리 위원회에 의해 승인되었습니다.

1. 비디오 카메라 구축

참고: 카메라 를 구축하는 데 필요한 구성 요소 목록이 재료 표에제공됩니다. 도 1, 도 2, 그림 3, 그림 4, 그림 5를참조하십시오.

- 카메라스탠드(그림 2A)의개구부 주변에 자기 금속 링(어안 렌즈 패키지와 함께)을 부착합니다. 이렇게 하면 어안 렌즈를 카메라 앞에 배치할 수 있습니다.

- 카메라 모듈을 카메라스탠드(그림 2B)에부착합니다. 이를 통해 카메라 모듈에 약간의 안정성을 제공하고 전자 회로를 보호합니다.

- 카메라 모듈 및 마이크로컴퓨터(그림1)에서카메라 포트를 열어 플라스틱 클립의 가장자리를 부드럽게 당기면(그림2C)을가열합니다.

- 실버 커넥터가 회로기판(그림2C)에직면할 수 있도록 리본 케이블을 카메라 포트에 배치합니다. 카메라 포트의 플라스틱 클립을 밀어 제자리에 케이블을 잠급합니다.

- 마이크로컴퓨터를 플라스틱 케이스에 놓고 나열된 마이크로 SD카드(도 2D)를삽입합니다.

참고: 마이크로 SD 카드는 마이크로컴퓨터의 하드 드라이브로 작동하며 전체 운영 체제가 포함되어 있습니다. 나열된 마이크로 SD 카드에는 설치 관리자가 미리 설치되어 있습니다(새 아웃 오브 박스 소프트웨어(NOOBS). 대안으로, 하나는 일반 마이크로 SD 카드에 마이크로 컴퓨터의 운영 체제 (Raspbian 또는 라즈베리 파이 OS)의 최신 버전의 이미지를 쓸 수 있습니다. 이 에 대한 도움을 받으려면 공식 웹리소스(18)를참조하십시오. 32Gb의 저장 공간을 가진 클래스 10 마이크로 SD 카드를 사용하는 것이 바람직하다. 더 큰 SD 카드는 나열된 마이크로컴퓨터와 완전히 호환되지 않을 수 있습니다. - 모니터, 키보드 및 마우스를 마이크로컴퓨터에 연결한 다음 전원 공급 장치를 연결합니다.

- 마이크로 컴퓨터의 운영 체제 (Raspbian 또는 라즈베리 파이 OS)의 전체 설치를 수행하기 위해 설치 가이드에 의해 메시지가 단계를 따르십시오. 마이크로컴퓨터가 부팅되면 이더넷 케이블 또는 Wi-Fi를 통해 인터넷에 연결되어 있는지 확인합니다.

- 마이크로컴퓨터의 사전 설치된 소프트웨어 패키지를 업데이트하려면 아래 설명된 단계를 따르십시오.

- 터미널 창열기(그림 3A).

- "sudo apt-get 업데이트"(견적 표시 제외)를 입력하고 Enter키(그림 3B)를누릅니다. 프로세스가 완료될 때까지 기다립니다.

- "sudo apt 전체 업그레이드"(견적 표시 제외)를 입력하고 enter을 누릅니다. 메시지가 표시되면 단추 응답을 하고 프로세스가 완료될 때까지 기다립니다.

- 시작 메뉴에서 환경 설정 및 라즈베리 파이 구성(그림 3C)을선택합니다. 열린 창에서 인터페이스 탭으로 이동하여 클릭하여 카메라 및 I2C를 활성화합니다. 이는 마이크로컴퓨터가 카메라 및 IR LED 모듈과 함께 작동하려면 필요합니다.

- 보충 파일 1의 이름을 "Pi_video_camera_Clemensson_2019.py"로 변경합니다. USB 메모리 스틱에 복사한 다음 마이크로컴퓨터/홈/파이 폴더(그림3D)에복사합니다. 이 파일은 1.13 단계에 연결된 버튼 스위치로 비디오 녹화를 만들 수 있는 Python 스크립트입니다.

- 마이크로컴퓨터의 rc.local 파일을 편집하려면 아래 설명된 단계를 따르십시오. 이렇게 하면 컴퓨터가 1.10 단계에서 복사된 스크립트를 시작하고 부팅할 때 1.13 단계에서 연결된 IR LED를 시작합니다.

주의: 이 자동 시작 기능은 나열된 모델 이외의 마이크로컴퓨터 보드에서 안정적으로 작동하지 않습니다.- 터미널 창을 열고 "sudo nano /etc/rc.local"(인용 부호 제외)을 입력하고 enter을 누릅니다. 이렇게 하면 텍스트파일(그림 4A)이열립니다.

- 키보드의 화살표 키를 사용하여 커서를 "fi"와 "exit 0" 사이의 공간으로 이동합니다(그림4A).

- 그림 4B에표시된 대로 다음 텍스트를 추가하여 새 줄에 각 텍스트 문자열을 작성합니다.

sudo i2cset -y 1 0x70 0x00 0xa5 및;

sudo i2cset -y 1 0x70 0x09 0x09 0x0f &

sudo i2cset -y 1 0x70 0x01 0x32 및;

sudo i2cset -y 1 0x70 0x03 0x32 &

sudo i2cset -y 1 0x70 0x06 0x32 및;

sudo i2cset -y 1 0x70 0x08 0x32 및;

스도 파이썬 /홈/파이/Pi_video_camera_Clemensson_2019.py & - Ctrl + x를 누르고 y 및 Enter를 눌러 변경 내용을 저장합니다.

- 그림 5A에표시된 대로 필요한 구성 요소를 함께 납땜하고 아래에 설명된 대로 솔더.

- 두 개의 색깔의 LED의 경우 저항기와 여성 점퍼 케이블을 한쪽 다리에 연결하고 다른 쪽 다리에 여성 점퍼케이블(그림 5A)을부착합니다. 케이블을 가능한 한 짧게 유지하십시오. 이 마이크로 컴퓨터의 범용 입력 / 출력 (GPIO) 핀에 지상에 연결해야하므로 LED의 전극 중 어느 음수 (일반적으로 짧은 하나)입니다 주의하십시오.

- 두 개의 버튼 스위치의 경우 각 다리에 여성 점퍼 케이블을 부착합니다(그림5A). 스위치 중 하나에 대 한 긴 케이블을 확인 하 고 다른 에 대 한 짧은.

- IR LED 모듈을 조립하려면 공식 웹 리소스19에서사용할 수 있는 지침을 따르십시오.

- 납땜 된 관절을 수축 튜브로 덮어 구성 요소를 단락할 위험을 제한하십시오.

- 마이크로 컴퓨터를 끄고 스위치와 LED를 그림 5B에표시된 대로 GPIO 핀에 연결하고 아래에 설명합니다.

주의: 구성 요소를 잘못된 GPIO 핀에 배선하면 카메라가 켜져 있을 때 부품 및/또는 마이크로컴퓨터가 손상될 수 있습니다.- 하나의 LED를 연결하여 음의 끝이 핀 #14 연결하고 양단 끝이 핀 #12 연결되도록 합니다. 이 LED는 마이크로 컴퓨터가 부팅되고 카메라를 사용할 준비가 되면 빛납니다.

- 버튼 스위치를 긴 케이블로 연결하여 하나의 케이블이 핀 #9 연결하고 다른 케이블은 핀 #11 고정합니다. 이 버튼은 비디오 녹화를 시작하고 중지하는 데 사용됩니다.

참고: 카메라를 제어하는 스크립트가 작성되어 비디오 녹화를 시작하거나 중지한 직후 몇 초 동안 이 버튼이 응답하지 않습니다. - 하나의 LED를 연결하여 음의 끝이 핀 #20 연결하고 양단 끝이 핀 #13 연결되도록 합니다. 이 LED는 카메라가 비디오를 녹화할 때 빛납니다.

- 버튼 스위치를 짧은 케이블과 연결하여 한 케이블이 핀 #37 연결하고 다른 케이블은 #39 고정합니다. 이 스위치는 카메라를 끄는 데 사용됩니다.

- 공식 웹리소스(19)에설명된 대로 IR LED 모듈을 연결한다.

2. 관심있는 작동 컨디셔닝 프로토콜 설계

참고: DeepLabCut을 사용하여 작동 챔버에서 기록된 비디오에서 프로토콜 진행을 추적하려면 아래 설명과 같이 동작 프로토콜을 특정 방식으로 구성해야 합니다.

- 프로토콜(예: 개별 시험의 시작 또는 시험 세션)의 특정 단계의 지표로서 챔버의 집빛 또는 다른 강한 광 신호를 사용하도록 프로토콜을 설정한다(그림6A). 이 신호를 이 프로토콜의 나머지 부분에서 "프로토콜 단계 표시기"라고 합니다. 이 신호의 존재는 녹화 된 비디오에서 추적 프로토콜 진행을 허용합니다.

- 프로토콜을 설정하여 프로토콜 단계 표시기가 활성화될 때와 관련하여 개별 타임스탬프로 관심 있는 모든 응답을 기록합니다.

3. 관심의 행동 테스트를 수행하는 동물의 비디오 녹화

- 카메라를 작동 챔버 위에 배치하여 내부 영역의 최고 뷰를 기록할 수 있도록합니다(그림 7).

참고: 이것은 챔버 내부의 동물의 일반적인 위치와 자세를 포착하는 데 특히 적합합니다. 카메라의 표시등과 IR LED 모듈을 카메라 렌즈 가까이에 두지 마십시오. - 전원 공급 장치를 통해 전기 콘센트에 연결하여 카메라를 시작합니다.

참고: 처음 사용하기 전에 카메라 모듈과 함께 작은 도구를 사용하여 카메라의 포커스를 설정하는 것이 좋습니다. - 1.13.2 단계에서 연결된 버튼을 사용하여 비디오 녹화를 시작하고 중지합니다.

- 다음 단계를 수행하여 카메라를 끕시다.

- LED가 1.13.1 단계에서 연결될 때까지 1.13.4 단계에서 연결된 버튼을 누르고 누를 수 있습니다. 이렇게 하면 카메라의 종료 프로세스가 시작됩니다.

- 마이크로컴퓨터 상단에 보이는 녹색 LED(그림1)가깜박임이 멈출 때까지 기다립니다.

- 카메라의 전원 공급 장치를 제거합니다.

주의: 마이크로컴퓨터가 계속 실행되는 동안 전원 공급 장치를 분리하면 마이크로 SD 카드의 데이터가 손상될 수 있습니다.

- 카메라를 모니터, 키보드, 마우스 및 USB 저장 장치에 연결하고 데스크톱에서 비디오 파일을 검색합니다.

참고: 파일의 이름은 비디오 녹화가 시작된 날짜 와 시간에 따라 지정됩니다. 그러나 마이크로컴퓨터는 내부 시계가 없으며 인터넷에 연결할 때만 시간 설정을 업데이트합니다. - 녹화된 비디오를 .h264에서 로 변환합니다. MP4, 후자는 DeepLabCut 및 대부분의 미디어 플레이어와 잘 작동으로.

참고: 이를 달성하는 방법에는 여러 가지가 있습니다. 하나는 보충 파일 2에설명되어 있습니다.

4. 딥랩컷으로 동영상 분석

참고: DeepLabCut은 사용자가 비디오 프레임 집합에 관심 있는 대상을 정의할 수 있는 소프트웨어 패키지이며, 이후에 이를 사용하여 전체 길이 동영상15,,16에서개체의 위치를 추적하는 신경망을 학습할 수 있습니다. 이 섹션에서는 DeepLabCut을 사용하여 프로토콜 단계 표시기의 상태와 쥐머리의 위치를 추적하는 방법에 대한 대략적인 개요를 제공합니다. DeepLabCut의 설치 및 사용은 다른 게시된프로토콜(15,,16)에잘 설명되어 있습니다. 각 단계는 다른 곳에서 설명한 대로 특정 파이썬 명령 또는 DeepLabCut의 그래픽 사용자 인터페이스를 통해 수행할 수 있습니다15,,16.

- 16에설명된 단계를 수행하여 새 DeepLabCut 프로젝트를 만들고 구성합니다.

- DeepLabCut의 프레임 잡기 기능을 사용하여 섹션 3에 기록된 동영상 중 하나 이상에서 700\u2012900 비디오 프레임을 추출합니다.

참고: 동물이 모피 색소 침착 이나 다른 시각적 특성에서 상당히 다른 경우, 그것은 700\u2012900 추출 된 비디오 프레임 다른 동물의 동영상에 걸쳐 분할 하는 것이 좋습니다. 이를 통해 숙련된 네트워크 하나를 사용하여 다른 개인을 추적할 수 있습니다.- 프로토콜 단계 표시기의 활성(도8A)및 비활성(도8B)상태를 모두 표시하는 비디오 프레임을 포함해야 합니다.

- 시험 중에 쥐가 보여줄 수 있는 다양한 위치, 자세 및 머리 움직임의 범위를 포괄하는 비디오 프레임을 포함해야 합니다. 여기에는 쥐가 챔버의 다른 영역에 가만히 서 있는 비디오 프레임과 머리가 다른 방향을 가리키는 비디오 프레임뿐만 아니라 쥐가 적극적으로 움직이는 비디오 프레임, 코 찌르기 개구부 입력 및 펠릿 트로프입력이 포함되어야 합니다.

- DeepLabCut의 라벨링 툴박스를 사용하여 4.2단계에서 추출된 각 비디오 프레임에서 쥐 머리의 위치를 수동으로 표시합니다. 마우스 커서를 사용하여 쥐의 귀 사이의 중앙 위치에 "헤드" 라벨을 놓습니다(그림8A, B). 또한, 각 비디오 프레임에서 챔버의 집광(또는 기타 프로토콜 단계 표시기)의 위치를 표시하여 적극적으로 빛나는곳(도 8A). 비활성 프레임에 레이블이 지정되지 않은 하우스 라이트를 둡니다(그림8B).

- DeepLabCut의 "교육 데이터 세트 만들기" 및 "기차 네트워크" 기능을 사용하여 4.3 단계에 레이블이 표시된 비디오 프레임에서 교육 데이터 집합을 만들고 신경망 교육을 시작합니다. 선택한 네트워크 유형에 대해 "resnet_101"를 선택해야 합니다.

- 훈련 손실이 0.01 이하로 고원했을 때 네트워크 교육을 중지하십시오. 최대 500,000개의 교육 반복이 필요할 수 있습니다.

참고: 약 8GB의 메모리와 약 900개의 비디오 프레임(해상도: 1640 x 1232 픽셀)의 학습 세트를 갖춘 GPU 기계를 사용하는 경우 교육 프로세스는 약 72시간이 걸리는 것으로 나타났습니다. - DeepLabCut의 비디오 분석 기능을 사용하여 4.4 단계에서 학습된 신경망을 사용하여 3단계에서 수집된 비디오를 분석합니다. 이렇게 하면 쥐 머리의 추적된 위치와 분석된 비디오의 각 비디오 프레임에 프로토콜 단계 표시기를 나열하는 .csv 파일이 표시됩니다. 또한 추적된 위치가 시각적으로 표시되는 표시형 비디오 파일을만듭니다(동영상1-8).

- 아래 설명된 단계를 따라 추적의 정확성을 평가합니다.

- DeepLabCut의 기본 제공 평가 기능을 사용하여 네트워크의 추적 정확도에 대한 자동화된 평가를 얻을 수 있습니다. 이는 4.3 단계에서 레이블이 지정된 비디오 프레임을 기반으로 하며 네트워크에서 추적한 위치가 수동으로 배치된 레이블에서 얼마나 멀리 떨어져 있는지 를 설명합니다.

- 4.6단계에서 얻은 표시된 동영상에서 하나 이상의 간단한 비디오 시퀀스(각 100\u2012200 비디오 프레임)를 선택합니다. 비디오 시퀀스를 살펴보고 프레임별로 프레임으로 이동하고 레이블이 쥐의 머리, 꼬리 등의 위치를 올바르게 나타내는 프레임 수와 라벨이 잘못된 위치에 배치되는지 또는 표시되지 않는 프레임 수를 기록합니다.

- 바디 파트 또는 개체의 레이블이 잘못 된 위치에 자주 분실되거나 잘못된 위치에 배치된 경우 추적이 실패한 상황을 식별합니다. 4.2 단계를 반복하여 이러한 경우의 레이블이 지정된 프레임을 추출하고 추가합니다. 및 4.3. 그런 다음 네트워크를 다시 학습하고 4.4-4.7 단계를 반복하여 비디오를 다시 분석합니다. 궁극적으로, >90% 정확도의 추적 정확도를 달성해야 합니다.

5. 작동 챔버에 관심있는 지점에 대한 좌표 획득

- 4.3 단계에서 설명된 대로 DeepLabCut을 사용하여 단일 비디오프레임(그림 8C)에서조작 챔버(예: 코 찌르기 개구부, 레버 등)에 대한 관심 지점을 수동으로 표시합니다. 프로토콜 단계 표시기의 위치는 항상 포함되어야 하지만 연구별 관심사에 따라 수동으로 선택됩니다.

- DeepLabCut이 프로젝트 폴더의 "레이블이 지정된 데이터"아래에 자동으로 저장하는 .csv 파일에서 표시된 관심 점의 좌표를 검색합니다.

6. 프로토콜 단계 표시등이 활성화된 비디오 세그먼트 식별

- DeepLabCut 비디오 분석에서 얻은 .csv 파일을 4.6 단계에서 선택한 데이터 관리 소프트웨어에 로드합니다.

참고: DeepLabCut 및 작동 컨디셔닝 시스템에서 얻은 데이터의 양과 복잡성으로 인해 자동 분석 스크립트를 통해 데이터 관리가 가장 좋습니다. 이 것으로,시작하려면20,21,,22에서사용할 수있는 엔트리 레벨 가이드를 참조하십시오. - 비디오 세그먼트프로토콜 단계 표시기가 섹션 5에서 얻은 위치의 60픽셀 내에서 추적되는 점에 유의하십시오. 프로토콜 단계 표시등이 활성화된기간(그림 6B)이됩니다.

참고: 프로토콜 단계 표시등이 빛나지 않는 비디오 세그먼트 에서 표시된 동영상은 DeepLabCut이 어떤 위치로도 추적되지 않음을 나타낼 수 있습니다. 그러나 이 경우는 거의 발생하지 않으며 일반적으로 여러 개의 흩어진 위치로 추적됩니다. - 프로토콜 단계 표시기가 활성화된 각 기간에 대해 정확한 시작점을 추출합니다(그림6C: 1).

7. 관심 있는 동영상 세그먼트 식별

- 프로토콜 단계 표시기가 활성화되는점(그림 6C: 1)과 작동 챔버에 의해 기록된 응답의 타임스탬프(섹션 2, 그림 6C: 2)를 고려하십시오.

- 이 정보를 사용하여 시험 간 간격, 응답, 보상 검색 등과 같은 특정 흥미로운 이벤트를 다루는 비디오 세그먼트를 결정합니다(그림6C: 3, 그림 6D).

참고: 이를 위해 여기에 설명된 카메라가 30fps로 비디오를 기록한다는 점에 유의하십시오. - 이러한 관심 이벤트를 다루는 특정 비디오 프레임을 기록합니다.

- (선택 사항) 관심 있는 특정 세그먼트만 포함하도록 전체 테스트 세션의 비디오 파일을 편집합니다.

참고: 이를 달성하는 방법에는 여러 가지가 있습니다. 하나는 보충 파일 2 및 3에설명되어 있습니다. 이렇게 하면 많은 수의 동영상을 저장할 때 도움이 되며 결과를 보다 편리하게 검토하고 프레젠테이션할 수도 있습니다.

8. 특정 비디오 세그먼트 동안 동물의 위치와 움직임을 분석

- DeepLabCut에서 얻은 헤드 위치의 전체 추적 데이터를 섹션 7에 명시된 비디오 세그먼트만 포함하도록 4.6 단계에서 하위 설정합니다.

- 5항(도8C)에서선택한 기준점 중 하나 이상과 관련하여 동물의 머리 위치를 계산합니다. 이를 통해 다양한 비디오에서 추적 및 위치를 비교할 수 있습니다.

- 동물의 위치와 움직임에 대한 관련 심층 분석을 수행합니다.

참고: 수행된 특정 분석은 연구별입니다. 분석할 수 있는 매개 변수의 몇 가지 예는 다음과 같습니다.- 선택한 기간 동안 검색된 모든 좌표를 하나의 그래프 내에서 플로팅하여 경로 추적을 시각화합니다.

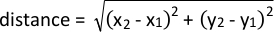

- 다음 수식을 사용하여 지정된 관심 지점에 대한 근접성을 분석합니다.

- 연속 프레임에서 추적된 좌표 사이의 거리를 계산하고 카메라의 1/fps로 분할하여 이동 중 속도 변화를 분석합니다.

결과

비디오 카메라 성능

대표적인 결과는 28.5cm x 25.5 cm, 높이 28.5 cm의 랫트에 대한 편집 컨디셔닝 챔버에 수집되었다. 어안 렌즈가 부착되어 있어 카메라는 챔버 위에 배치될 때 주변 벽의 전체 바닥 면적과 큰 부분을 포착합니다(그림7A). 따라서 카메라가 챔버 상단에 중앙에 배치되더라도 좋은 시야를 얻을 수 있습니다. 이것은 비교 가능한 작동...

토론

이 프로토콜은 조작 컨디셔닝 챔버 및 기타 행동 테스트 설정에서 비디오를 녹화하는 데 사용할 수 있는 저렴하고 유연한 비디오 카메라를 구축하는 방법을 설명합니다. 또한 DeepLabCut을 사용하여 이러한 비디오 내에서 강력한 라이트 신호를 추적하는 방법과 전체 테스트 세션을 포함하는 비디오 파일에 대한 관심있는 간단한 비디오 세그먼트를 식별하는 데 사용할 수있는 방법을 보여줍니다. 마?...

공개

라즈베리 파이 재단의 재료와 자원이 이 원고에 사용되고 인용되었지만, 재단은 이 원고에서 장비와 데이터의 준비 또는 사용에 적극적으로 관여하지 않았습니다. Pi-Supply도 마찬가지입니다. 저자는 공개 할 것이 없습니다.

감사의 말

이 작품은 스웨덴 뇌 재단, 스웨덴 파킨슨 재단, 임상 연구를위한 스웨덴 정부 기금 (M.A.C.) 뿐만 아니라 베너 - 그렌 재단 (M.A.C., E.K.H.C), 올렌 재단 (M.A.C) 및 기초 블랑케플로르 본콤파니 루도비시, 빌스 스 (Néet S.)의 보조금에 의해 지원되었다.

자료

| Name | Company | Catalog Number | Comments |

| 32 Gb micro SD card with New Our Of Box Software (NOOBS) preinstalled | The Pi hut (https://thpihut.com) | 32GB | |

| 330-Ohm resistor | The Pi hut (https://thpihut.com) | 100287 | This article is for a package with mixed resistors, where 330-ohm resistors are included. |

| Camera module (Raspberry Pi NoIR camera v.2) | The Pi hut (https://thpihut.com) | 100004 | |

| Camera ribbon cable (Raspberry Pi Zero camera cable stub) | The Pi hut (https://thpihut.com) | MMP-1294 | This is only needed if a Raspberry Pi zero is used. If another Raspberry Pi board is used, a suitable camera ribbon cable accompanies the camera component |

| Colored LEDs | The Pi hut (https://thpihut.com) | ADA4203 | This article is for a package with mixed colors of LEDs. Any color can be used. |

| Female-Female jumper cables | The Pi hut (https://thpihut.com) | ADA266 | |

| IR LED module (Bright Pi) | Pi Supply (https://uk.pi-supply.com) | PIS-0027 | |

| microcomputer motherboard (Raspberry Pi Zero board with presoldered headers) | The Pi hut (https://thpihut.com) | 102373 | Other Raspberry Pi boards can also be used, although the method for automatically starting the Python script only works with Raspberry Pi zero. If using other models, the python script needs to be started manually. |

| Push button switch | The Pi hut (https://thpihut.com) | ADA367 | |

| Raspberry Pi power supply cable | The Pi hut (https://thpihut.com) | 102032 | |

| Raspberry Pi Zero case | The Pi hut (https://thpihut.com) | 102118 | |

| Raspberry Pi, Mod my pi, camera stand with magnetic fish eye lens and magnetic metal ring attachment | The Pi hut (https://thpihut.com) | MMP-0310-KIT |

참고문헌

- Pritchett, K., Mulder, G. B. Operant conditioning. Contemporary Topics in Laboratory Animal Science. 43 (4), (2004).

- Clemensson, E. K. H., Novati, A., Clemensson, L. E., Riess, O., Nguyen, H. P. The BACHD rat model of Huntington disease shows slowed learning in a Go/No-Go-like test of visual discrimination. Behavioural Brain Research. 359, 116-126 (2019).

- Asinof, S. K., Paine, T. A. The 5-choice serial reaction time task: a task of attention and impulse control for rodents. Journal of Visualized Experiments. (90), e51574 (2014).

- Coulbourn instruments. Graphic State: Graphic State 4 user's manual. Coulbourn instruments. , 12-17 (2013).

- Med Associates Inc. Med-PC IV: Med-PC IV programmer's manual. Med Associates Inc. , 21-44 (2006).

- Clemensson, E. K. H., Clemensson, L. E., Riess, O., Nguyen, H. P. The BACHD rat model of Huntingon disease shows signs of fronto-striatal dysfunction in two operant conditioning tests of short-term memory. PloS One. 12 (1), (2017).

- Herremans, A. H. J., Hijzen, T. H., Welborn, P. F. E., Olivier, B., Slangen, J. L. Effect of infusion of cholinergic drugs into the prefrontal cortex area on delayed matching to position performance in the rat. Brain Research. 711 (1-2), 102-111 (1996).

- Chudasama, Y., Muir, J. L. A behavioral analysis of the delayed non-matching to position task: the effects of scopolamine, lesions of the fornix and of the prelimbic region on mediating behaviours by rats. Psychopharmacology. 134 (1), 73-82 (1997).

- Talpos, J. C., McTighe, S. M., Dias, R., Saksida, L. M., Bussey, T. J. Trial-unique, delayed nonmatching-to-location (TUNL): A novel, highly hippocampus-dependent automated touchscreen test of location memory and pattern separation. Neurobiology of Learning and Memory. 94 (3), 341 (2010).

- Rayburn-Reeves, R. M., Moore, M. K., Smith, T. E., Crafton, D. A., Marden, K. L. Spatial midsession reversal learning in rats: Effects of egocentric cue use and memory. Behavioural Processes. 152, 10-17 (2018).

- Gallo, A., Duchatelle, E., Elkhessaimi, A., Le Pape, G., Desportes, J. Topographic analysis of the rat's behavior in the Skinner box. Behavioural Processes. 33 (3), 318-328 (1995).

- Iversen, I. H. Response-initiated imaging of operant behavior using a digital camera. Journal of the Experimental Analysis of Behavior. 77 (3), 283-300 (2002).

- Med Associates Inc. Video monitor: Video monitor SOF-842 user's manual. Med Associates Inc. , 26-30 (2004).

- . Coulbourn Instruments Available from: https://www.coulbourn.com/product_p/h39-16.htm (2020)

- Mathis, A., et al. DeepLabCut: markerless pose estimation of user-defined body parts with deep learning. Nature Neuroscience. 21 (9), 1281-1289 (2018).

- Nath, T., Mathis, A., Chen, A. C., Patel, A., Bethge, M., Mathis, M. W. Using DeepLabCut for 3D markerless pose estimation across species and behaviors. Nature Protocols. 14 (7), 2152-2176 (2019).

- Bari, A., Dalley, J. W., Robbins, T. W. The application of the 5-chopice serial reaction time task for the assessment of visual attentional processes and impulse control in rats. Nature Protocols. 3 (5), 759-767 (2008).

- . Raspberry Pi foundation Available from: https://thepi.io/how-to-install-raspbian-on-the-raspberry-pi/ (2020)

- . Pi-supply Available from: https://learn.pi-supply.com/make/bright-pi-quickstart-faq/ (2018)

- . Python Available from: https://wiki.python.org/moin/BeginnersGuide/NonProgrammers (2020)

- . MathWorks Available from: https://mathworks.com/academia/highschool/ (2020)

- . Cran.R-Project.org Available from: https://cran.r-project.org/manuals.html (2020)

- Liu, Y., Tian, C., Huang, Y. . Critical assessment of correction methods for fisheye lens distortion. The international archives of the photogrammetry, remote sensing and spatial information sciences. , (2016).

- Pereira, T. D., et al. Fast animal pose estimation using deep neural networks. Nature Methods. 16 (1), 117-125 (2019).

- Graving, J. M., et al. DeepPoseKit, a software toolkit for fast and robust animal pose estimation using deep learning. Elife. 8 (47994), (2019).

- Geuther, B. Q., et al. Robust mouse tracking in complex environments using neural networks. Communications Biology. 2 (124), (2019).

재인쇄 및 허가

JoVE'article의 텍스트 или 그림을 다시 사용하시려면 허가 살펴보기

허가 살펴보기더 많은 기사 탐색

This article has been published

Video Coming Soon

Copyright © 2025 MyJoVE Corporation. 판권 소유