Zum Anzeigen dieser Inhalte ist ein JoVE-Abonnement erforderlich. Melden Sie sich an oder starten Sie Ihre kostenlose Testversion.

Method Article

Tracking Ratten in Operant Conditioning Chambers mit einer vielseitigen hausgemachten Videokamera und DeepLabCut

In diesem Artikel

Zusammenfassung

Dieses Protokoll beschreibt, wie man eine kleine und vielseitige Videokamera baut und wie man von ihm erhaltene Videos verwendet, um ein neuronales Netzwerk zu trainieren, um die Position eines Tieres in Opernkonditionierungskammern zu verfolgen. Dies ist eine wertvolle Ergänzung zu Standardanalysen von Datenprotokollen, die aus Operant-Konditionierungstests gewonnen wurden.

Zusammenfassung

Operant-Konditionierungskammern werden verwendet, um eine breite Palette von Verhaltenstests auf dem Gebiet der Neurowissenschaften durchzuführen. Die aufgezeichneten Daten basieren in der Regel auf der Auslösung von Hebel- und Nasen-Poke-Sensoren, die in den Kammern vorhanden sind. Dies bietet zwar eine detaillierte Ansicht, wann und wie Tiere bestimmte Antworten ausführen, kann jedoch nicht verwendet werden, um Verhaltensweisen zu bewerten, die keine Sensoren auslösen. Daher ist es selten möglich, zu beurteilen, wie sich Tiere positionieren und sich innerhalb der Kammer bewegen. Um diese Informationen zu erhalten, müssen Forscher in der Regel Videos aufzeichnen und analysieren. Hersteller von Operant-Konditionskammern können ihre Kunden in der Regel mit hochwertigen Kamera-Setups beliefern. Diese können jedoch sehr kostspielig sein und passen nicht unbedingt zu Kammern anderer Hersteller oder anderen Verhaltenstests. Das aktuelle Protokoll beschreibt, wie man eine kostengünstige und vielseitige Videokamera mit Hobby-Elektronikkomponenten baut. Weiter wird beschrieben, wie das Bildanalyse-Softwarepaket DeepLabCut verwendet wird, um den Status eines starken Lichtsignals sowie die Position einer Ratte in Videos zu verfolgen, die aus einer Operant-Konditionierungskammer gesammelt wurden. Ersteres ist eine große Hilfe bei der Auswahl kurzer Segmente von Interesse an Videos, die ganze Testsitzungen abdecken, und letztere ermöglicht die Analyse von Parametern, die nicht aus den von den Opernkammern erstellten Datenprotokollen gewonnen werden können.

Einleitung

Im Bereich der Verhaltensneurowissenschaften verwenden Forscher häufig Opernkonditionierungskammern, um eine breite Palette verschiedener kognitiver und psychiatrischer Merkmale bei Nagetieren zu bewerten. Zwar gibt es mehrere verschiedene Hersteller solcher Systeme, sie haben in der Regel bestimmte Attribute und haben ein fast standardisiertes Design1,2,3. Die Kammern sind in der Regel quadratisch oder rechteckig, mit einer Wand, die für die Platzierung von Tieren im Inneren geöffnet werden kann, und eine oder zwei der verbleibenden Wände mit Komponenten wie Hebel, Nasen-Poke-Öffnungen, Belohnungsschalen, Reaktionsräder und Lichter verschiedener Arten1,2,3. Die in den Kammern vorhandenen Leuchten und Sensoren werden verwendet, um sowohl das Testprotokoll zu steuern als auch das Verhalten der Tiere zu verfolgen1,2,3,4,5. Die typischen Operant-Konditionierungssysteme ermöglichen eine sehr detaillierte Analyse, wie die Tiere mit den verschiedenen Operanden und Öffnungen in den Kammern interagieren. Im Allgemeinen können alle Fälle, in denen Sensoren ausgelöst werden, vom System aufgezeichnet werden, und aus diesen Daten können Benutzer detaillierte Protokolldateien erhalten, die beschreiben, was das Tier während bestimmter Schritte des Tests4,5getan hat. Dies bietet zwar eine umfassende Darstellung der Leistung eines Tieres, kann aber nur zur Beschreibung von Verhaltensweisen verwendet werden, die direkt einen oder mehrere Sensoren auslösen4,5. Als solche, Aspekte im Zusammenhang damit, wie das Tier sich selbst positioniert und bewegt sich innerhalb der Kammer während der verschiedenen Phasen des Tests sind nicht gut beschrieben6,7,8,9,10. Dies ist bedauerlich, da solche Informationen wertvoll sein können, um das Verhalten des Tieres vollständig zu verstehen. Zum Beispiel kann es verwendet werden, um zu klären, warum bestimmte Tiere in einem bestimmten Test schlecht abschneiden6, um die Strategien zu beschreiben, die Tiere entwickeln könnten, um schwierige Aufgaben zu bewältigen6,7,8,9,,10, oder um die wahre Komplexität vermeintlich einfacher Verhaltensweisen zu schätzen11,12. Um solche artikulierten Informationen zu erhalten, wenden sich Forscher häufig der manuellen Analyse von Videos6,7,8,9,10,11zu.

Bei der Aufnahme von Videos aus Operat-Konditionierungskammern ist die Wahl der Kamera entscheidend. Die Kammern befinden sich häufig in Isolationskabinen, mit Protokollen, die häufig Schritte verwenden, in denen kein sichtbares Licht leuchtet3,6,7,8,9. Daher ist die Verwendung von Infrarotbeleuchtung (IR) in Kombination mit einer IR-empfindlichen Kamera notwendig, da sie auch bei völliger Dunkelheit Sichtbarkeit ermöglicht. Darüber hinaus ist der Platz für die Platzierung einer Kamera in der Isolationskabine oft sehr begrenzt, was bedeutet, dass man stark von kleinen Kameras profitiert, die Objektive mit einem weiten Sichtfeld (z.B. Fischaugenlinsen) verwenden9. Während Hersteller von Operant-Konditionierungssystemen ihren Kunden oft hochwertige Kamera-Setups liefern können, können diese Systeme teuer sein und nicht unbedingt Kammern anderer Hersteller oder Setups für andere Verhaltenstests passen. Ein bemerkenswerter Vorteil gegenüber der Verwendung von Stand-Alone-Videokameras ist jedoch, dass diese Setups oft direkt mit den Operant-Konditionierungssystemen13,14in Verbindung stehen können. Dadurch können sie so eingerichtet werden, dass sie nur bestimmte Ereignisse aufzeichnen, anstatt vollständige Testsitzungen aufzuzeichnen, was bei der folgenden Analyse sehr helfen kann.

Das aktuelle Protokoll beschreibt, wie man eine kostengünstige und vielseitige Videokamera mit Hobby-Elektronikkomponenten baut. Die Kamera verwendet ein Fisheye-Objektiv, ist empfindlich auf IR-Beleuchtung und hat eine Reihe von IR-Lichtemittierdioden (IR-LEDs) daran befestigt. Darüber hinaus ist es gebaut, um ein flaches und schlankes Profil zu haben. Zusammen bilden diese Aspekte ideal für die Aufnahme von Videos aus den meisten kommerziell erhältlichen Operant-Konditionierungskammern sowie anderen Verhaltenstest-Setups. Das Protokoll beschreibt weiter, wie man mit der Kamera erhaltene Videos verarbeitet und wie man das Softwarepaket DeepLabCut15,16 verwendet, um Videosequenzen von Interesse zu extrahieren sowie die Bewegungen eines Tieres darin zu verfolgen. Dies umgeht teilweise den Rückzieher einer Stand-Alone-Kamera über die integrierten Lösungen von Operant-Herstellern von Konditionierungssystemen und bietet eine Ergänzung zur manuellen Bewertung von Verhaltensweisen.

Es wurden Anstrengungen unternommen, das Protokoll in einem allgemeinen Format zu schreiben, um hervorzuheben, dass der gesamte Prozess an Videos aus verschiedenen Operant-Konditionierungstests angepasst werden kann. Zur Veranschaulichung bestimmter Schlüsselkonzepte werden als Beispiele Videos von Ratten verwendet, die den 5-Wahl-Serienreaktionszeittest (5CSRTT)17 durchführen.

Protokoll

Alle Verfahren, die den Umgang mit Tieren umfassen, wurden von der Ethikkommission Malmö-Lund für Tierforschung genehmigt.

1. Aufbau der Videokamera

HINWEIS: Eine Liste der Komponenten, die für den Aufbau der Kamera benötigt werden, finden Sie in der Tabelle der Materialien. Siehe auch Abbildung 1, Abbildung 2, Abbildung 3, Abbildung 4, Abbildung 5.

- Befestigen Sie den magnetischen Metallring (der das Fisheye-Objektivpaket begleitet) um die Öffnung des Kameraständers(Abbildung 2A). Dadurch kann das Fisheye-Objektiv vor der Kamera platziert werden.

- Befestigen Sie das Kameramodul am Kameraständer (Abbildung 2B). Dies wird dem Kameramodul eine gewisse Stabilität verleihen und einen gewissen Schutz für die elektronischen Schaltungen bieten.

- Öffnen Sie die Kameraanschlüsse am Kameramodul und am Mikrocomputer (Abbildung 1), indem Sie sanft an den Rändern ihrer Kunststoffclips ziehen (Abbildung 2C).

- Legen Sie das Flachbandkabel in die Kameraanschlüsse, so dass die silbernen Anschlüsse den Leiterplatten gegenüberstehen (Abbildung2C). Verriegeln Sie das Kabel an Ort und Stelle, indem Sie die Kunststoffclips der Kameraanschlüsse einschieben.

- Legen Sie den Mikrocomputer in das Kunststoffgehäuse und legen Sie die aufgelistete Micro-SD-Karte ein (Abbildung 2D).

HINWEIS: Die Micro-SD-Karte fungiert als Festplatte des Mikrocomputers und enthält ein vollständiges Betriebssystem. Die aufgelistete Micro-SD-Karte wird mit einem vorinstallierten Installationsmanager (New Out Of Box Software (NOOBS) geliefert. Alternativ kann man ein Abbild der neuesten Version des Betriebssystems des Mikrocomputers (Raspbian oder Rasberry Pi OS) auf eine generische Micro-SD-Karte schreiben. Hilfe hierzu finden Sie in den offiziellen Webressourcen18. Es ist vorzuziehen, eine Micro-SD-Karte der Klasse 10 mit 32 GB Speicherplatz zu verwenden. Größere SD-Karten sind möglicherweise nicht vollständig mit dem aufgeführten Mikrocomputer kompatibel. - Schließen Sie einen Monitor, eine Tastatur und eine Maus an den Mikrocomputer an, und schließen Sie dann das Netzteil an.

- Führen Sie die vom Installationshandbuch aufgeforderten Schritte aus, um eine vollständige Installation des Betriebssystems des Mikrocomputers (Raspbian oder Rasberry Pi OS) durchzuführen. Wenn der Mikrocomputer gebootet wurde, stellen Sie sicher, dass er entweder über ein Ethernet-Kabel oder WLAN mit dem Internet verbunden ist.

- Führen Sie die unten beschriebenen Schritte aus, um die vorinstallierten Softwarepakete des Mikrocomputers zu aktualisieren.

- Öffnen Sie ein Klemmenfenster (Abbildung 3A).

- Geben Sie "sudo apt-get update" (ohne Anführungszeichen) ein und drücken Sie die Eingabetaste (Abbildung 3B). Warten Sie, bis der Prozess abgeschlossen ist.

- Geben Sie "sudo apt full-upgrade" (ohne Anführungszeichen) ein und drücken Sie die Eingabetaste. Erstellen Sie Schaltflächenantworten, wenn Sie dazu aufgefordert werden, und warten Sie, bis der Prozess abgeschlossen ist.

- Wählen Sie im Startmenü Einstellungen und Raspberry Pi-Konfigurationen aus (Abbildung 3C). Wechseln Sie im geöffneten Fenster zur Registerkarte Schnittstellen, und klicken Sie auf Kamera und I2C aktivieren . Dies ist erforderlich, damit der Mikrocomputer mit der Kamera und IR-LED-Modulen arbeitet.

- Ergänzende Datei 1 in "Pi_video_camera_Clemensson_2019.py" umbenennen. Kopieren Sie es auf einen USB-Speicherstick und anschließend in den /home/pi-Ordner des Mikrocomputers (Abbildung 3D). Diese Datei ist ein Python-Skript, mit dem Videoaufzeichnungen mit den Tastenschaltern erstellt werden können, die in Schritt 1.13 angefügt sind.

- Führen Sie die unten beschriebenen Schritte aus, um die datei rc.local des Mikrocomputers zu bearbeiten. Dadurch startet der Computer das in Schritt 1.10 kopierte Skript und startet die IR-LEDs, die beim Starten in Schritt 1.13 angefügt werden.

VORSICHT: Diese Autostart-Funktion funktioniert nicht zuverlässig mit anderen Mikrocomputer-Boards als dem aufgeführten Modell.- Öffnen Sie ein Klemmenfenster, geben Sie "sudo nano /etc/rc.local" (ohne Anführungszeichen) ein und drücken Sie die Eingabetaste. Dadurch wird eine Textdatei geöffnet (Abbildung 4A).

- Verwenden Sie die Pfeiltasten der Tastatur, um den Cursor nach unten in den Abstand zwischen "fi" und "exit 0" zu bewegen (Abbildung 4A).

- Fügen Sie den folgenden Text hinzu, wie in Abbildung 4Bdargestellt, und schreiben Sie jede Textzeichenfolge in eine neue Zeile:

sudo i2cset -y 1 0x70 0x00 0xa5 &

sudo i2cset -y 1 0x70 0x09 0x0f &

sudo i2cset -y 1 0x70 0x01 0x32 &

sudo i2cset -y 1 0x70 0x03 0x32 &

sudo i2cset -y 1 0x70 0x06 0x32 &

sudo i2cset -y 1 0x70 0x08 0x32 &

sudo python /home/pi/Pi_video_camera_Clemensson_2019.py & - Speichern Sie die Änderungen, indem Sie Strg + x gefolgt von y und Enterdrücken.

- Löten Sie die notwendigen Komponenten wie in Abbildung 5Aangegeben und wie unten beschrieben.

- Befestigen Sie bei den beiden farbigen LEDs einen Widerstand und ein weibliches Jumperkabel an einem Bein und ein weibliches Jumperkabel an das andere (Abbildung 5A). Versuchen Sie, die Kabel so kurz wie möglich zu halten. Beachten Sie, welche der LED-Elektroden die negative ist (in der Regel die kurze), da diese an den GPIO-Pins (Allzweck-Eingangs-/-Ausgangs)-Pins des Mikrocomputers mit Masse verbunden werden muss.

- Befestigen Sie bei den beiden Tastenschaltern ein weibliches Jumperkabel an jedem Bein (Abbildung 5A). Machen Sie die Kabel lang für einen der Schalter und kurz für den anderen.

- Um das IR-LED-Modul zu montieren, folgen Sie den Anweisungen auf den offiziellen Web-Ressourcen19.

- Bedecken Sie die gelöteten Gelenke mit Schrumpfschläuchen, um das Risiko eines Kurzschlusses der Komponenten zu begrenzen.

- Schalten Sie den Mikrocomputer aus und schließen Sie die Schalter und LEDs an die GPIO-Pins an, wie in Abbildung 5Bangegeben und unten beschrieben.

VORSICHT: Die Verdrahtung der Komponenten mit den falschen GPIO-Pins kann sie und/oder den Mikrocomputer beschädigen, wenn die Kamera eingeschaltet ist.- Schließen Sie eine LED an, so dass ihr negatives Ende mit Pin-#14 und sein positives Ende mit Pin-#12 verbunden ist. Diese LED leuchtet, wenn der Mikrocomputer gebootet ist und die Kamera einsatzbereit ist.

- Schließen Sie den Tastenschalter mit langen Kabeln an, sodass ein Kabel mit pin #9 und das andere mit dem Pin-#11 verbunden ist. Diese Schaltfläche wird verwendet, um die Videoaufzeichnungen zu starten und zu stoppen.

HINWEIS: Das Skript, das die Kamera steuert, wurde so geschrieben, dass diese Schaltfläche kurz nach dem Starten oder Beenden einer Videoaufzeichnung für einige Sekunden nicht mehr reagiert. - Schließen Sie eine LED an, so dass ihr negatives Ende mit Pin-#20 und sein positives Ende mit Pin-#13 verbunden ist. Diese LED leuchtet, wenn die Kamera ein Video aufnimmt.

- Schließen Sie den Tastenschalter mit den kurzen Kabeln an, sodass ein Kabel mit pin #37 und das andere mit dem #39 verbunden ist. Dieser Schalter wird verwendet, um die Kamera auszuschalten.

- Schließen Sie das IR-LED-Modul wie in seinen offiziellen Web-Ressourcenbeschrieben 19an.

2. Gestaltung des von Interesse kommenden Betriebskonditionierungsprotokolls

HINWEIS: Um DeepLabCut zum Nachverfolgen des Protokollverlaufs in Videos zu verwenden, die aus Operantkammern aufgenommen wurden, müssen die Verhaltensprotokolle auf spezifische Weise strukturiert werden, wie unten erläutert.

- Legen Sie das Protokoll fest, um das Hauslicht der Kammer oder ein anderes starkes Lichtsignal als Indikator für einen bestimmten Schritt im Protokoll (z. B. den Beginn einzelner Versuche oder die Testsitzung) zu verwenden (Abbildung 6A). Dieses Signal wird im Rest dieses Protokolls als "Protokollschrittindikator" bezeichnet. Das Vorhandensein dieses Signals ermöglicht die Verfolgung des Protokollverlaufs in den aufgezeichneten Videos.

- Legen Sie das Protokoll fest, um alle von Interesse sindden Antworten mit einzelnen Zeitstempeln in Bezug auf die Aktivität des Protokollschrittindikators aufzuzeichnen.

3. Aufnehmen von Videos von Tieren, die den Verhaltenstest von Interesse durchführen

- Platzieren Sie die Kamera auf den Opernkammern, sodass sie eine Ansicht des Bereichs im Inneren aufzeichnet (Abbildung 7).

HINWEIS: Dies eignet sich besonders zum Erfassen der allgemeinen Position und Körperhaltung eines Tieres in der Kammer. Vermeiden Sie es, die Kontrollleuchten der Kamera und das IR-LED-Modul in der Nähe des Kameraobjektivs zu platzieren. - Starten Sie die Kamera, indem Sie sie über das Netzkabel an eine Steckdose anschließen.

HINWEIS: Vor der ersten Verwendung ist es vorteilhaft, den Fokus der Kamera mit dem kleinen Werkzeug einzustellen, das das Kameramodul begleitet. - Verwenden Sie die in Schritt 1.13.2 angeschlossene Taste, um Videoaufzeichnungen zu starten und zu beenden.

- Schalten Sie die Kamera aus, indem Sie diese Schritte ausführen.

- Halten Sie die in Schritt 1.13.4 angeschlossene Taste so lange gedrückt, bis die in Schritt 1.13.1 angeschlossene LED ausgeschaltet ist. Dadurch wird der Abschaltvorgang der Kamera eingeleitet.

- Warten Sie, bis die grüne LED, die oben auf dem Mikrocomputer sichtbar ist (Abbildung 1), nicht mehr blinkt.

- Entfernen Sie das Netzteil der Kamera.

VORSICHT: Das Trennen des Netzteils, während der Mikrocomputer noch läuft, kann zu einer Beschädigung der Daten auf der Micro-SD-Karte führen.

- Schließen Sie die Kamera an einen Monitor, eine Tastatur, eine Maus und ein USB-Speichergerät an und rufen Sie die Videodateien von ihrem Desktop ab.

HINWEIS: Die Dateien werden nach dem Datum und der Uhrzeit benannt, zu der die Videoaufzeichnung gestartet wurde. Der Mikrocomputer verfügt jedoch nicht über eine interne Uhr und aktualisiert seine Zeiteinstellung nur, wenn er mit dem Internet verbunden ist. - Konvertieren Sie die aufgenommenen Videos von .h264 in . MP4, da letzteres gut mit DeepLabCut und den meisten Media-Playern funktioniert.

HINWEIS: Es gibt mehrere Möglichkeiten, dies zu erreichen. Eine wird in Der Ergänzungsdatei 2beschrieben.

4. Analysieren von Videos mit DeepLabCut

HINWEIS: DeepLabCut ist ein Softwarepaket, mit dem Benutzer jedes Objekt von Interesse in einer Reihe von Videoframes definieren und anschließend ein neuronales Netzwerk trainieren können, um die Positionen der Objekte in Videos in voller Länge zu verfolgen15,16. Dieser Abschnitt gibt einen groben Überblick darüber, wie DeepLabCut verwendet wird, um den Status des Protokollschrittindikators und die Position des Kopfes einer Ratte zu verfolgen. Die Installation und Verwendung von DeepLabCut ist in anderen veröffentlichten Protokollen15,16gut beschrieben. Jeder Schritt kann über bestimmte Python-Befehle oder die grafische Benutzeroberfläche von DeepLabCut ausgeführt werden, wie an anderer Stelle beschrieben15,16.

- Erstellen und konfigurieren Sie ein neues DeepLabCut-Projekt, indem Sie die in16beschriebenen Schritte ausführen.

- Verwenden Sie die Frame-Grabbing-Funktion von DeepLabCut, um 700-u2012900-Videoframes aus einem oder mehreren der in Abschnitt 3 aufgenommenen Videos zu extrahieren.

HINWEIS: Wenn sich die Tiere in der Fellpigmentierung oder anderen visuellen Eigenschaften erheblich unterscheiden, ist es ratsam, dass die 700-u2012900 extrahierten Videoframes auf Videos von verschiedenen Tieren aufgeteilt werden. Dadurch kann ein geschultes Netzwerk verwendet werden, um verschiedene Personen zu verfolgen.- Stellen Sie sicher, dass Sie Videoframes einschließen, die sowohl den aktiven (Abbildung 8A) als auch den inaktiven (Abbildung 8B) Zustand der Protokollschrittanzeige anzeigen.

- Stellen Sie sicher, dass Sie Videoframes enthalten, die den Bereich der verschiedenen Positionen, Haltungen und Kopfbewegungen abdecken, die die Ratte während des Tests zeigen kann. Dazu gehören Videorahmen, in denen die Ratte in verschiedenen Bereichen der Kammer still steht, wobei ihr Kopf in verschiedene Richtungen zeigt, sowie Videorahmen, in denen sich die Ratte aktiv bewegt, in Nasensacköffnungen eintritt und in den Pellettrog eintritt.

- Verwenden Sie die Labeling Toolbox von DeepLabCut, um die Position des Kopfes der Ratte in jedem in Schritt 4.2 extrahierten Videorahmen manuell zu markieren. Verwenden Sie den Mauszeiger, um ein "Kopf"-Etikett an einer zentralen Position zwischen den Ohren der Ratte zu platzieren (Abbildung 8A,B). Markieren Sie außerdem die Position des Hauslichts der Kammer (oder einer anderen Protokollschrittanzeige) in jedem Videorahmen, in dem es aktiv leuchtet (Abbildung 8A). Lassen Sie das Hauslicht unbeschriftet in Rahmen, wo es inaktiv ist (Abbildung 8B).

- Verwenden Sie die Funktionen "Trainingsdatensatz erstellen" und "Zugnetzwerk" von DeepLabCut, um einen Trainingsdatensatz aus den in Schritt 4.3 beschrifteten Videoframes zu erstellen und mit dem Training eines neuronalen Netzwerks zu beginnen. Stellen Sie sicher, dass Sie "resnet_101" für den ausgewählten Netzwerktyp auswählen.

- Beenden Sie das Training des Netzwerks, wenn der Trainingsverlust unter 0,01 gesunken ist. Dies kann bis zu 500.000 Trainingsiterationen erfordern.

HINWEIS: Bei Verwendung eines GPU-Computers mit ca. 8 GB Arbeitsspeicher und einem Trainingssatz von ca. 900 Videoframes (Auflösung: 1640 x 1232 Pixel) hat sich herausgestellt, dass der Trainingsprozess ca. 72 h beträgt. - Verwenden Sie die Videoanalysefunktion von DeepLabCut, um die in Schritt 3 gesammelten Videos mithilfe des in Schritt 4.4 trainierten neuronalen Netzwerks zu analysieren. Dies wird eine .csv-Datei mit den verfolgten Positionen des Kopfes der Ratte und der Protokollschrittanzeige in jedem Videoframe der analysierten Videos bereitstellen. Darüber hinaus werden markierte Videodateien erstellt, in denen die verfolgten Positionen visuell angezeigt werden (Videos 1-8).

- Bewerten Sie die Genauigkeit der Nachverfolgung, indem Sie die unten beschriebenen Schritte befolgen.

- Verwenden Sie die integrierte Auswertungsfunktion von DeepLabCut, um eine automatisierte Auswertung der Tracking-Genauigkeit des Netzwerks zu erhalten. Dies basiert auf den Videoframes, die in Schritt 4.3 beschriftet wurden, und beschreibt, wie weit die vom Netzwerk verfolgte Position im Durchschnitt von der manuell platzierten Beschriftung entfernt ist.

- Wählen Sie in den in Schritt 4.6 erhaltenen markierten Videos eine oder mehrere kurze Videosequenzen (jeweils ca. 100-u2012200-Videoframes) aus. Gehen Sie durch die Videosequenzen, Frame für Frame, und beachten Sie, in wie vielen Rahmen die Beschriftungen korrekt die Positionen des Kopfes, des Schwanzes usw. der Ratte angeben und in wie vielen Frames die Beschriftungen in fehlerhaften Positionen platziert oder nicht angezeigt werden.

- Wenn die Beschriftung eines Körperteils oder Objekts häufig verloren geht oder sich in einer fehlerhaften Position befindet, identifizieren Sie die Situationen, in denen die Nachverfolgung fehlschlägt. Extrahieren und fügen Sie beschriftete Rahmen dieser Gelegenheiten hinzu, indem Sie die Schritte 4.2 wiederholen. und 4.3. Trainieren Sie dann das Netzwerk neu und analysieren Sie die Videos erneut, indem Sie die Schritte 4.4-4.7 wiederholen. Letztendlich sollte eine Tracking-Genauigkeit von >90% Genauigkeit erreicht werden.

5. Abrufen von Koordinaten für Sehenswürdigkeiten in den Opernkammern

- Verwenden Sie DeepLabCut, wie in Schritt 4.3 beschrieben, um Punkte, die in den Operantkammern (z. B. Nasensacköffnungen, Hebel usw.) angezeigt werden, manuell in einem einzigen Videorahmen zu markieren (Abbildung 8C). Diese werden manuell je nach studienspezifischen Interessen ausgewählt, wobei die Position des Protokollschrittindikators immer einbezogen werden sollte.

- Rufen Sie die Koordinaten der markierten Sehenswürdigkeiten aus der CSV-Datei ab, die DeepLabCut automatisch unter "beschriftete Daten" im Projektordner speichert.

6. Identifizieren von Videosegmenten, in denen die Protokollschrittanzeige aktiv ist

- Laden Sie die .csv-Dateien aus der DeepLabCut-Videoanalyse in Schritt 4.6 in eine Datenverwaltungssoftware Ihrer Wahl.

HINWEIS: Aufgrund der Menge und Komplexität der Daten, die von DeepLabCut und Operant-Konditionierungssystemen erhalten werden, erfolgt die Datenverwaltung am besten durch automatisierte Analyseskripts. Um damit zu beginnen, lesen Sie bitte einsende-Guides, die an anderer Stelle verfügbar sind20,21,22. - Beachten Sie, in welchen Videosegmenten die Protokollschrittanzeige innerhalb von 60 Pixeln der in Abschnitt 5 erhaltenen Position nachverfolgt wird. Dies sind Zeiträume, in denen das Protokollschrittkennzeichen aktiv ist (Abbildung 6B).

HINWEIS: Während Videosegmenten, in denen die Protokollschrittanzeige nicht leuchtet, scheint das markierte Video darauf hinzuweisen, dass DeepLabCut es nicht an einer Position verfolgt. Dies ist jedoch selten der Fall, und es wird stattdessen in der Regel an mehreren verstreuten Standorten nachverfolgt. - Extrahieren Sie den genauen Startpunkt für jeden Zeitraum, in dem der Protokollschrittindikator aktiv ist (Abbildung 6C: 1).

7. Identifizieren von Videosegmenten von Interesse

- Berücksichtigen Sie die Punkte, an denen der Indikator für protokollierte Schritte aktiv wird (Abbildung 6C:1) und die Zeitstempel der von den Opernkammern aufgezeichneten Antworten (Abschnitt 2, Abbildung 6C:2).

- Anhand dieser Informationen können Sie ermitteln, welche Videosegmente bestimmte interessante Ereignisse abdecken, wie z. B. Testintervalle, Antworten, Belohnungsabrufe usw.(Abbildung 6C:3, Abbildung 6D).

HINWEIS: Beachten Sie hierfür, dass die hier beschriebene Kamera Videos mit 30 fps aufzeichnet. - Beachten Sie die spezifischen Videoframes, die diese Ereignisse von Interesse abdecken.

- (Optional) Bearbeiten Sie Videodateien vollständiger Testsitzungen, um nur die einzelnen Segmente von Interesse einzuschließen.

HINWEIS: Es gibt mehrere Möglichkeiten, dies zu erreichen. Eine ist in der Zusatzdatei 2 und 3beschrieben. Dies hilft sehr, wenn eine große Anzahl von Videos gespeichert wird und kann auch das Überprüfen und Präsentieren von Ergebnissen bequemer machen.

8. Analyse der Position und Bewegungen eines Tieres während bestimmter Videosegmente

- Subset die vollständigen Tracking-Daten der Kopfposition aus DeepLabCut in Schritt 4.6 erhalten, um nur Videosegmente in Abschnitt 7 angegeben enthalten.

- Berechnen Sie die Position des Tieres in Bezug auf einen oder mehrere der in Abschnitt 5 (Abbildung 8C) ausgewählten Bezugspunkte. Dies ermöglicht Vergleiche von Tracking und Position über verschiedene Videos hinweg.

- Führen Sie eine relevante eingehende Analyse der Position und Der Bewegungen des Tieres durch.

HINWEIS: Die spezifische Analyse wird stark studienspezifisch sein. Einige Beispiele für Parameter, die analysiert werden können, sind unten aufgeführt.- Visualisieren Sie Pfadablaufverfolgungen, indem Sie alle Koordinaten, die während eines ausgewählten Zeitraums erkannt wurden, innerhalb eines Diagramms darstellen.

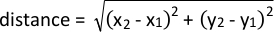

- Analysieren Sie die Nähe zu einem bestimmten Sehenswürdigkeiten mithilfe der folgenden Formel:

- Analysieren Sie Geschwindigkeitsänderungen während einer Bewegung, indem Sie den Abstand zwischen verfolgten Koordinaten in aufeinander folgenden Frames berechnen und durch 1/fps der Kamera dividieren.

Ergebnisse

Videokameraleistung

Die repräsentativen Ergebnisse wurden in Opernkonditionierungskammern für Ratten mit Einer Bodenfläche von 28,5 cm x 25,5 cm und einer Höhe von 28,5 cm gesammelt. Mit dem Fisheye-Objektiv befestigt, erfasst die Kamera die gesamte Bodenfläche und große Teile der umgebenden Wände, wenn sie über der Kammer platziert (Abbildung 7A). Als solche kann eine gute Sicht erhalten werden, auch wenn die Kamera außerhalb der Mitte a...

Diskussion

Dieses Protokoll beschreibt, wie eine kostengünstige und flexible Videokamera erstellt wird, mit der Videos aus Operant-Konditionierungskammern und anderen Verhaltenstest-Setups aufgenommen werden können. Es zeigt weiter, wie DeepLabCut verwendet wird, um ein starkes Lichtsignal in diesen Videos zu verfolgen, und wie dies verwendet werden kann, um bei der Identifizierung kurzer Videosegmente von Interesse an Videodateien zu helfen, die vollständige Testsitzungen abdecken. Schließlich wird beschrieben, wie die Verfolg...

Offenlegungen

Während Materialien und Ressourcen der Raspberry Pi Stiftung in diesem Manuskript verwendet und zitiert wurden, war die Stiftung nicht aktiv an der Vorbereitung oder Verwendung von Geräten und Daten in diesem Manuskript beteiligt. Dasselbe gilt für Pi-Supply. Die Autoren haben nichts zu verraten.

Danksagungen

Diese Arbeit wurde durch Stipendien der Schwedischen Brain Foundation, der Schwedischen Parkinson-Stiftung und der Schwedischen Regierungsfonds für klinische Forschung (M.A.C.) sowie der Wenner-Gren-Stiftungen (M.A.C, E.K.H.C),ehlén Foundation (M.A.C) und der Stiftung Blanceflor Boncompagni Ludovisi, geb.

Materialien

| Name | Company | Catalog Number | Comments |

| 32 Gb micro SD card with New Our Of Box Software (NOOBS) preinstalled | The Pi hut (https://thpihut.com) | 32GB | |

| 330-Ohm resistor | The Pi hut (https://thpihut.com) | 100287 | This article is for a package with mixed resistors, where 330-ohm resistors are included. |

| Camera module (Raspberry Pi NoIR camera v.2) | The Pi hut (https://thpihut.com) | 100004 | |

| Camera ribbon cable (Raspberry Pi Zero camera cable stub) | The Pi hut (https://thpihut.com) | MMP-1294 | This is only needed if a Raspberry Pi zero is used. If another Raspberry Pi board is used, a suitable camera ribbon cable accompanies the camera component |

| Colored LEDs | The Pi hut (https://thpihut.com) | ADA4203 | This article is for a package with mixed colors of LEDs. Any color can be used. |

| Female-Female jumper cables | The Pi hut (https://thpihut.com) | ADA266 | |

| IR LED module (Bright Pi) | Pi Supply (https://uk.pi-supply.com) | PIS-0027 | |

| microcomputer motherboard (Raspberry Pi Zero board with presoldered headers) | The Pi hut (https://thpihut.com) | 102373 | Other Raspberry Pi boards can also be used, although the method for automatically starting the Python script only works with Raspberry Pi zero. If using other models, the python script needs to be started manually. |

| Push button switch | The Pi hut (https://thpihut.com) | ADA367 | |

| Raspberry Pi power supply cable | The Pi hut (https://thpihut.com) | 102032 | |

| Raspberry Pi Zero case | The Pi hut (https://thpihut.com) | 102118 | |

| Raspberry Pi, Mod my pi, camera stand with magnetic fish eye lens and magnetic metal ring attachment | The Pi hut (https://thpihut.com) | MMP-0310-KIT |

Referenzen

- Pritchett, K., Mulder, G. B. Operant conditioning. Contemporary Topics in Laboratory Animal Science. 43 (4), (2004).

- Clemensson, E. K. H., Novati, A., Clemensson, L. E., Riess, O., Nguyen, H. P. The BACHD rat model of Huntington disease shows slowed learning in a Go/No-Go-like test of visual discrimination. Behavioural Brain Research. 359, 116-126 (2019).

- Asinof, S. K., Paine, T. A. The 5-choice serial reaction time task: a task of attention and impulse control for rodents. Journal of Visualized Experiments. (90), e51574 (2014).

- Coulbourn instruments. Graphic State: Graphic State 4 user's manual. Coulbourn instruments. , 12-17 (2013).

- Med Associates Inc. Med-PC IV: Med-PC IV programmer's manual. Med Associates Inc. , 21-44 (2006).

- Clemensson, E. K. H., Clemensson, L. E., Riess, O., Nguyen, H. P. The BACHD rat model of Huntingon disease shows signs of fronto-striatal dysfunction in two operant conditioning tests of short-term memory. PloS One. 12 (1), (2017).

- Herremans, A. H. J., Hijzen, T. H., Welborn, P. F. E., Olivier, B., Slangen, J. L. Effect of infusion of cholinergic drugs into the prefrontal cortex area on delayed matching to position performance in the rat. Brain Research. 711 (1-2), 102-111 (1996).

- Chudasama, Y., Muir, J. L. A behavioral analysis of the delayed non-matching to position task: the effects of scopolamine, lesions of the fornix and of the prelimbic region on mediating behaviours by rats. Psychopharmacology. 134 (1), 73-82 (1997).

- Talpos, J. C., McTighe, S. M., Dias, R., Saksida, L. M., Bussey, T. J. Trial-unique, delayed nonmatching-to-location (TUNL): A novel, highly hippocampus-dependent automated touchscreen test of location memory and pattern separation. Neurobiology of Learning and Memory. 94 (3), 341 (2010).

- Rayburn-Reeves, R. M., Moore, M. K., Smith, T. E., Crafton, D. A., Marden, K. L. Spatial midsession reversal learning in rats: Effects of egocentric cue use and memory. Behavioural Processes. 152, 10-17 (2018).

- Gallo, A., Duchatelle, E., Elkhessaimi, A., Le Pape, G., Desportes, J. Topographic analysis of the rat's behavior in the Skinner box. Behavioural Processes. 33 (3), 318-328 (1995).

- Iversen, I. H. Response-initiated imaging of operant behavior using a digital camera. Journal of the Experimental Analysis of Behavior. 77 (3), 283-300 (2002).

- Med Associates Inc. Video monitor: Video monitor SOF-842 user's manual. Med Associates Inc. , 26-30 (2004).

- . Coulbourn Instruments Available from: https://www.coulbourn.com/product_p/h39-16.htm (2020)

- Mathis, A., et al. DeepLabCut: markerless pose estimation of user-defined body parts with deep learning. Nature Neuroscience. 21 (9), 1281-1289 (2018).

- Nath, T., Mathis, A., Chen, A. C., Patel, A., Bethge, M., Mathis, M. W. Using DeepLabCut for 3D markerless pose estimation across species and behaviors. Nature Protocols. 14 (7), 2152-2176 (2019).

- Bari, A., Dalley, J. W., Robbins, T. W. The application of the 5-chopice serial reaction time task for the assessment of visual attentional processes and impulse control in rats. Nature Protocols. 3 (5), 759-767 (2008).

- . Raspberry Pi foundation Available from: https://thepi.io/how-to-install-raspbian-on-the-raspberry-pi/ (2020)

- . Pi-supply Available from: https://learn.pi-supply.com/make/bright-pi-quickstart-faq/ (2018)

- . Python Available from: https://wiki.python.org/moin/BeginnersGuide/NonProgrammers (2020)

- . MathWorks Available from: https://mathworks.com/academia/highschool/ (2020)

- . Cran.R-Project.org Available from: https://cran.r-project.org/manuals.html (2020)

- Liu, Y., Tian, C., Huang, Y. . Critical assessment of correction methods for fisheye lens distortion. The international archives of the photogrammetry, remote sensing and spatial information sciences. , (2016).

- Pereira, T. D., et al. Fast animal pose estimation using deep neural networks. Nature Methods. 16 (1), 117-125 (2019).

- Graving, J. M., et al. DeepPoseKit, a software toolkit for fast and robust animal pose estimation using deep learning. Elife. 8 (47994), (2019).

- Geuther, B. Q., et al. Robust mouse tracking in complex environments using neural networks. Communications Biology. 2 (124), (2019).

Nachdrucke und Genehmigungen

Genehmigung beantragen, um den Text oder die Abbildungen dieses JoVE-Artikels zu verwenden

Genehmigung beantragenThis article has been published

Video Coming Soon

Copyright © 2025 MyJoVE Corporation. Alle Rechte vorbehalten