È necessario avere un abbonamento a JoVE per visualizzare questo. Accedi o inizia la tua prova gratuita.

Method Article

Monitoraggio dei ratti nelle camere di condizionamento operanti utilizzando una videocamera fatta in casa versatile e DeepLabCut

In questo articolo

Riepilogo

Questo protocollo descrive come costruire una videocamera piccola e versatile e come utilizzare video ottenuti da essa per addestrare una rete neurale a tracciare la posizione di un animale all'interno di camere di condizionamento operanti. Si tratta di un valido complemento alle analisi standard dei log dei dati ottenuti da test di condizionamento operanti.

Abstract

Le camere di condizionamento operanti sono utilizzate per eseguire una vasta gamma di test comportamentali nel campo delle neuroscienze. I dati registrati si basano in genere sull'innesco di sensori a leva e naso-poke presenti all'interno delle camere. Anche se questo fornisce una visione dettagliata di quando e come gli animali eseguono determinate risposte, non può essere utilizzato per valutare i comportamenti che non attivano alcun sensore. Come tale, valutare come gli animali si posizionano e si muovono all'interno della camera è raramente possibile. Per ottenere queste informazioni, i ricercatori in genere devono registrare e analizzare i video. I produttori di camere di condizionamento operanti possono in genere fornire ai propri clienti configurazioni di telecamere di alta qualità. Tuttavia, questi possono essere molto costosi e non si adattano necessariamente camere di altri produttori o altre configurazioni di test comportamentali. Il protocollo attuale descrive come costruire una videocamera economica e versatile utilizzando componenti elettronici per hobby. Descrive inoltre come utilizzare il pacchetto software di analisi delle immagini DeepLabCut per tenere traccia dello stato di un segnale luminoso forte, nonché la posizione di un ratto, nei video raccolti da una camera di condizionamento operante. Il primo è un grande aiuto nella scelta di brevi segmenti di interesse per i video che coprono intere sessioni di test, e il secondo consente l'analisi di parametri che non possono essere ottenuti dai registri di dati prodotti dalle camere operanti.

Introduzione

Nel campo delle neuroscienze comportamentali, i ricercatori usano comunemente camere di condizionamento operanti per valutare una vasta gamma di diverse caratteristiche cognitive e psichiatriche nei roditori. Mentre ci sono diversi produttori di tali sistemi, in genere condividono alcuni attributi e hanno un design quasi standardizzato1,2,3.3 Le camere sono generalmente a forma quadrata o rettangolare, con una parete che può essere aperta per posizionare gli animali all'interno, e una o due delle pareti rimanenti contenenti componenti come leve, aperture naso-poke, vassoi di ricompensa, ruote di risposta e luci di vario tipo1,2,3. Le luci e i sensori presenti nelle camere sono utilizzati sia per controllare il protocollo di prova che per tracciare i comportamenti degli animali1,2,3,4,5. I tipici sistemi di condizionamento operanti consentono un'analisi molto dettagliata di come gli animali interagiscono con i diversi operandi e le aperture presenti nelle camere. In generale, tutte le occasioni in cui i sensori vengono attivati possono essere registrati dal sistema, e da questi dati gli utenti possono ottenere file di log dettagliati che descrivono ciò che l'animale ha fatto durante passaggi specifici del test4,5. Mentre questo fornisce una rappresentazione estesa delle prestazioni di un animale, può essere utilizzato solo per descrivere i comportamenti che attivano direttamente uno o più sensori4,5. Di conseguenza, gli aspetti relativi al modo in cui l'animale si posiziona e si muove all'interno della camera durante le diverse fasi del test non sono ben descritti6,7,8,9,9.10 Questo è un peccato, in quanto tali informazioni possono essere preziose per comprendere appieno il comportamento dell'animale. Ad esempio, può essere utilizzato per chiarire perché alcuni animali si comportano male su un determinato test6, per descrivere le strategie che gli animali potrebbero sviluppare per gestire compiti difficili6,7,8,9,10, o per apprezzare la vera complessità di comportamenti presumibilmente semplici11,12. Per ottenere tali informazioni articolate, i ricercatori si rivolgono comunemente all'analisi manuale dei video6,7,8,9,10,11.

Quando si registrano video da camere di condizionamento operanti, la scelta della fotocamera è fondamentale. Le camere sono comunemente situate in cubi isolati, con protocolli che spesso fanno uso di gradini in cui nessuna luce visibile splende3,6,7,8,9. Pertanto, l'uso dell'illuminazione a infrarossi (IR) in combinazione con una fotocamera sensibile agli infrarossi è necessario, in quanto consente la visibilità anche in completa oscurità. Inoltre, lo spazio disponibile per posizionare una fotocamera all'interno del cubicolo di isolamento è spesso molto limitato, il che significa che si beneficia noto fortemente di avere piccole telecamere che utilizzano lenti con un ampio campo visivo (ad esempio, lenti fish-eye)9. Mentre i produttori di sistemi di condizionamento operanti possono spesso fornire configurazioni di telecamere di alta qualità ai loro clienti, questi sistemi possono essere costosi e non si adattano necessariamente camere di altri produttori o configurazioni per altri test comportamentali. Tuttavia, un notevole vantaggio rispetto all'utilizzo di videocamere autonome è che queste configurazioni possono spesso interfacciarsi direttamente con i sistemi di condizionamento operanti13,14. In questo modo, possono essere impostati solo per registrare eventi specifici anziché sessioni di test complete, che possono essere notevolmente aiutate nell'analisi che segue.

Il protocollo attuale descrive come costruire una videocamera economica e versatile utilizzando componenti elettronici per hobby. La fotocamera utilizza un obiettivo fisheye, è sensibile all'illuminazione IR e ha una serie di diodi a emissione di luce IR (LED IR) collegati ad esso. Inoltre, è costruito per avere un profilo piatto e sottile. Insieme, questi aspetti lo rendono ideale per la registrazione di video dalla maggior parte delle camere di condizionamento operanti disponibili in commercio e da altre configurazioni di test comportamentali. Il protocollo descrive inoltre come elaborare i video ottenuti con la fotocamera e come utilizzare il pacchetto software DeepLabCut15,16 per aiutare a estrarre sequenze video di interesse e a monitorare i movimenti di un animale in esso contenuti. Questo elude parzialmente il draw-back dell'utilizzo di una fotocamera stand-alone rispetto alle soluzioni integrate fornite dai produttori operanti di sistemi di condizionamento, e offre un complemento al punteggio manuale dei comportamenti.

Sono stati compiuti sforzi per scrivere il protocollo in un formato generale per evidenziare che il processo complessivo può essere adattato ai video di diversi test di condizionamento operanti. Per illustrare alcuni concetti chiave, i video dei ratti che eseguono il test del tempo di reazione seriale a 5 scelte (5CSRTT)17 vengono utilizzati come esempi.

Protocollo

Tutte le procedure che includono la movimentazione degli animali sono state approvate dal comitato etico Malmà-Lund per la ricerca sugli animali.

1. Costruire la videocamera

NOTA: nella Tabella dei materialiè disponibile un elenco dei componenti necessari per la costruzione della videocamera. Fare riferimento anche alla figura 1, Figura 2, Figura 3, Figura 4, Figura 5.

- Fissare l'anello magnetico di metallo (che accompagna il pacchetto lente fisheye) intorno all'apertura del supporto della fotocamera (Figura 2A). Questo permetterà all'obiettivo fisheye di essere posizionato davanti alla fotocamera.

- Collegare il modulo della fotocamera al supporto della fotocamera (Figura 2B). Questo darà un po 'di stabilità al modulo della telecamera e offrirà una certa protezione ai circuiti elettronici.

- Aprire le porte della fotocamera sul modulo della fotocamera e sul microcomputer (Figura 1) tirando delicatamente sui bordi delle clip di plastica (Figura 2C).

- Posizionare il cavo a nastro nelle porte della fotocamera, in modo che i connettori in argento siano di fronte alle schede comandi(Figura2C). Bloccare il cavo in posizione spingendo le clip di plastica delle porte della fotocamera.

- Posizionare il microcomputer nella custodia di plastica e inserire la scheda micro SD elencata(Figura 2D).

NOTA: la scheda micro SD funziona come disco rigido del microcomputer e contiene un sistema operativo completo. La scheda micro SD elencata viene fornita con un gestore di installazione preinstallato su di esso (Nuovo Software Out Of Box (NOOBS). In alternativa, si può scrivere un'immagine dell'ultima versione del sistema operativo del microcomputer (Raspbian o Rasberry Pi OS) su una scheda micro SD generica. Per assistenza in questo caso, fare riferimento alle risorse web ufficiali18. È preferibile utilizzare una scheda SD di classe 10 micro con 32 Gb di spazio di archiviazione. Le schede SD più grandi potrebbero non essere completamente compatibili con il microcomputer elencato. - Collegare un monitor, una tastiera e un mouse al microcomputer, quindi collegare l'alimentatore.

- Seguire i passaggi indicati dalla guida all'installazione per eseguire un'installazione completa del sistema operativo del microcomputer (Raspbian o Rasberry Pi OS). Quando il microcomputer è stato avviato, assicurarsi che sia connesso a Internet tramite un cavo ethernet o Wi-Fi.

- Attenersi alla procedura descritta di seguito per aggiornare i pacchetti software preinstallati del microcomputer.

- Aprire una finestra del terminale(Figura 3A).

- Digitare "sudo apt-get update" (escluse le virgolette) e premere invio (Figura 3B). Attendere il completamento del processo.

- Digitare "sudo apt full-upgrade" (escluse le virgolette) e premere Invio. Apportare le risposte ai pulsanti quando richiesto e attendere il completamento del processo.

- Nel menu Start, selezionare le configurazioni Preferenze e Raspberry Pi (Figura 3C). Nella finestra aperta, andare alla scheda Interfacce e fare clic su Abilita fotocamera e I2C. Ciò è necessario per far funzionare il microcomputer con la fotocamera e i moduli LED IR.

- Rinominare il file supplementare 1 in "Pi_video_camera_Clemensson_2019.py". Copiarlo su una chiavetta USB e successivamente nella cartella /home/pi del microcomputer (Figura 3D). Questo file è uno script Python, che consente di registrare video con gli interruttori dei pulsanti collegati nel passaggio 1.13.

- Attenersi alla procedura descritta di seguito per modificare il file rc.local del microcomputer. In questo modo il computer avvia lo script copiato nel passaggio 1.10 e avvia i LED IR collegati nel passaggio 1.13 all'avvio.

AVVISO: questa funzione di avvio automatico non funziona in modo affidabile con schede di microcomputer diverse dal modello elencato.- Aprire una finestra del terminale, digitare "sudo nano /etc/rc.local" (escluse le virgolette) e premere Invio. Verrà aperto un file di testo (Figura 4A).

- Utilizzare i tasti di direzione della tastiera per spostare il cursore verso il basso nello spazio compreso tra "fi" e "exit 0" (Figura 4A).

- Aggiungere il testo seguente come illustrato nella Figura 4B, scrivendo ogni stringa di testo su una nuova riga:

sudo i2cset -y 1 0x70 0x00 0xa5 &

sudo i2cset -y 1 0x70 0x09 0x0f &

sudo i2cset -y 1 0x70 0x01 0x32 &

sudo i2cset -y 1 0x70 0x03 0x32 &

sudo i2cset -y 1 0x70 0x06 0x32 &

sudo i2cset -y 1 0x70 0x08 0x32 &

sudo python /home/pi/Pi_video_camera_Clemensson_2019.py & - Salvare le modifiche premendo Ctrl e x seguite da y e INVIO.

- Solder insieme i componenti necessari come indicato nella figura 5Ae come descritto di seguito.

- Per i due LED colorati, collegare un resistore e un cavo ponticello femminile a una gamba e un cavo ponticello femminile all'altro (Figura 5A). Cercate di mantenere i cavi il più corti possibile. Prendere nota di quale degli elettrodi del LED è quello negativo (tipicamente quello corto), in quanto questo deve essere collegato a terra sui pin di ingresso/uscita (GPIO) generici del microcomputer.

- Per i due interruttori dei pulsanti, collegare un cavo ponticello femminile a ogni gamba (Figura 5A). Rendere i cavi lunghi per uno degli interruttori e abbreviazione dell'altro.

- Per assemblare il modulo LED IR, seguire le istruzioni disponibili sulle sue risorse web ufficiali19.

- Coprire i giunti saldati con tubi di compattazione per limitare il rischio di cortocircuito dei componenti.

- Spegnere il microcomputer e collegare gli interruttori e i LED ai relativi pin GPIO come indicato nella figura 5Be descritti di seguito.

AVVISO: collegare i componenti ai pin GPIO errati potrebbe danneggiarli e/o il microcomputer quando la fotocamera è accesa.- Collegare un LED in modo che la sua estremità negativa si colleghi a pin #14 e la sua estremità positiva si collega al #12 pin. Questo LED brillerà quando il microcomputer è stato avviato e la fotocamera è pronta per essere utilizzata.

- Collegare l'interruttore a pulsante con cavi lunghi in modo che un cavo si colleghi per bloccare #9 e l'altro per bloccare #11. Questo pulsante viene utilizzato per avviare e arrestare le registrazioni video.

NOTA: lo script che controlla la fotocamera è stato scritto in modo che questo pulsante non risponda per alcuni secondi subito dopo l'avvio o l'interruzione di una registrazione video. - Collegare un LED in modo che la sua estremità negativa si colleghi al pin #20 e la sua estremità positiva si colleghi al #13 pin. Questo LED brillerà quando la fotocamera sta registrando un video.

- Collegare l'interruttore a pulsante con i cavi corti in modo che un cavo si colleghi per bloccare #37 e l'altro per bloccare #39. Questo interruttore viene utilizzato per spegnere la fotocamera.

- Collegare il modulo LED IR come descritto nelle sue risorse web ufficiali19.

2. Progettazione del protocollo di condizionamento operante di interesse

NOTA: per utilizzare DeepLabCut per tenere traccia della progressione del protocollo nei video registrati dalle camere operanti, i protocolli comportamentali devono essere strutturati in modi specifici, come spiegato di seguito.

- Impostare il protocollo per utilizzare la luce domestica della camera, o un altro segnale luminoso forte, come indicatore di un passaggio specifico del protocollo (come l'inizio di singole prove o la sessione di test) (Figura 6A). Questo segnale sarà indicato come l'"indicatore del passaggio del protocollo" nel resto di questo protocollo. La presenza di questo segnale consentirà di tracciare la progressione del protocollo nei video registrati.

- Impostare il protocollo per registrare tutte le risposte di interesse con i singoli timestamp in relazione al momento in cui l'indicatore del passaggio del protocollo diventa attivo.

3. Registrazione di video di animali che eseguono la prova comportamentale di interesse

- Posizionare la fotocamera sopra le camere operanti, in modo che registri una vista superiore dell'area all'interno (Figura 7).

NOTA: Questo è particolarmente adatto per catturare la posizione generale e la postura di un animale all'interno della camera. Evitare di posizionare le luci dell'indicatore della fotocamera e il modulo LED IR vicino all'obiettivo della fotocamera. - Avviare la fotocamera collegandola a una presa elettrica tramite il cavo di alimentazione.

NOTA: Prima del primo utilizzo, è utile impostare la messa a fuoco della fotocamera, utilizzando il piccolo strumento che accompagna il modulo della fotocamera. - Utilizzare il pulsante collegato nel passaggio 1.13.2 per avviare e arrestare le registrazioni video.

- Spegnere la fotocamera seguendo questi passaggi.

- Premere e tenere premuto il pulsante collegato al punto 1.13.4 fino a quando il LED collegato nel passaggio 1.13.1 si spegne. Questo avvia il processo di spegnimento della fotocamera.

- Attendere che il LED verde visibile sopra il microcomputer (Figura 1) abbia smesso di lampeggiare.

- Rimuovere l'alimentatore della fotocamera.

AVVISO: Lo scollegamento dell'alimentatore mentre il microcomputer è ancora in funzione può causare il danneggiamento dei dati sulla scheda micro SD.

- Collegare la fotocamera a un monitor, tastiera, mouse e dispositivo di archiviazione USB e recuperare i file video dal suo desktop.

NOTA: i file vengono denominati in base alla data e all'ora in cui è stata avviata la registrazione video. Tuttavia, il microcomputer non ha un orologio interno e aggiorna solo l'impostazione dell'ora quando è connesso a Internet. - Convertire i video registrati da .h264 a . MP4, in quanto quest'ultimo funziona bene con DeepLabCut e la maggior parte dei lettori multimediali.

NOTA: Ci sono diversi modi per raggiungere questo obiettivo. Uno è descritto nel file supplementare 2.

4. Analisi dei video con DeepLabCut

NOTA: DeepLabCut è un pacchetto software che consente agli utenti di definire qualsiasi oggetto di interesse in un set di fotogrammi video, e successivamente utilizzarli per addestrare una rete neurale nel tracciare le posizioni degli oggetti in video full-length15,16. Questa sezione fornisce un contorno approssimativo su come utilizzare DeepLabCut per tenere traccia dello stato dell'indicatore del passo del protocollo e la posizione della testa di un ratto. L'installazione e l'uso di DeepLabCut è ben descritto in altri protocolli pubblicati15,16. Ogni passaggio può essere eseguito tramite comandi Python specifici o l'interfaccia utente grafica di DeepLabCut, come descritto altrove15,16.

- Creare e configurare un nuovo progetto DeepLabCut seguendo la procedura descritta in16.

- Utilizzate la funzione di cattura dei fotogrammi di DeepLabCut per estrarre 700 fotogrammi da uno o più video registrati nella sezione 3.

NOTA: Se gli animali differiscono notevolmente nella pigmentazione delle pellicce o in altre caratteristiche visive, è consigliabile che i fotogrammi video estratti 700-u2012900 siano suddivisi tra video di animali diversi. Attraverso questo, una rete addestrata può essere utilizzata per tenere traccia di individui diversi.- Assicurarsi di includere i fotogrammi video che visualizzano sia lo stato attivo (Figura 8A) che inattivo (Figura 8B) dell'indicatore del passaggio del protocollo.

- Assicurati di includere fotogrammi video che coprono la gamma di diverse posizioni, posture e movimenti della testa che il ratto può mostrare durante il test. Questo dovrebbe includere fotogrammi video in cui il ratto è fermo in diverse aree della camera, con la testa rivolta in direzioni diverse, così come i fotogrammi video in cui il ratto è attivamente in movimento, entrando nelle aperture del poke del naso e entrando nella depressione del pellet.

- Utilizzare la casella degli strumenti di etichettatura di DeepLabCut per contrassegnare manualmente la posizione della testa del ratto in ogni fotogramma video estratto nel passaggio 4.2. Utilizzare il cursore del mouse per posizionare un'etichetta "testa" in una posizione centrale tra le orecchie del ratto (Figura 8A,B). Inoltre, contrassegnare la posizione della luce domestica della camera (o altro indicatore di passo protocollo) in ogni fotogramma video in cui brilla attivamente (Figura 8A). Lasciare la luce domestica senza etichetta nei fotogrammi in cui è inattiva (Figura 8B).

- Usare le funzioni "crea set di dati di training" e "rete di addestramento" di DeepLabCut per creare un set di dati di training dai frame video etichettati nel passaggio 4.3 e avviare il training di una rete neurale. Assicurarsi di selezionare "resnet_101" per il tipo di rete scelto.

- Interrompere la formazione della rete quando la perdita di formazione si è stabilizzato al di sotto di 0,01. Questa operazione può richiedere fino a 500.000 iterazioni di training.

NOTA: quando si utilizza un computer GPU con circa 8 GB di memoria e un set di formazione di circa 900 fotogrammi video (risoluzione: 1640 x 1232 pixel), il processo di training è stato trovato per prendere circa 72 h. - Utilizzare la funzione di analisi video di DeepLabCut per analizzare i video raccolti nel passaggio 3, usando la rete neurale addestrata nel passaggio 4.4. Questo fornirà un file .csv che elenca le posizioni monitorate della testa del ratto e l'indicatore del passo del protocollo in ogni fotogramma video dei video analizzati. Inoltre, creerà file video contrassegnati in cui le posizioni tracciate vengono visualizzate visivamente (Video 1-8).

- Valutare l'accuratezza del rilevamento attenendosi alla procedura descritta di seguito.

- Utilizzare la funzione di valutazione integrata di DeepLabCut per ottenere una valutazione automatica dell'accuratezza del rilevamento della rete. Questo si basa sui fotogrammi video che sono stati etichettati nel passaggio 4.3 e descrive quanto in media la posizione tracciata dalla rete è dall'etichetta posizionata manualmente.

- Selezionate una o più brevi sequenze video (di circa 100 fotogrammi video u2012200 ciascuna) nei video contrassegnati ottenuti nel passaggio 4.6. Passare attraverso le sequenze video, fotogramma per fotogramma, e notare in quanti fotogrammi le etichette indicano correttamente le posizioni della testa del ratto, coda, ecc, e in quanti fotogrammi le etichette sono collocate in posizioni errate o non mostrate.

- Se l'etichetta di una parte del corpo o di un oggetto viene spesso persa o posizionata in una posizione errata, identificare le situazioni in cui il rilevamento non riesce. Estrarre e aggiungere cornici etichettate di queste occasioni ripetendo i passaggi 4.2. e 4.3. Quindi riaddestrare la rete e rianalizzare i video ripetendo i passaggi 4.4-4.7. In definitiva, la precisione di tracciamento di >90% precisione dovrebbe essere raggiunto.

5. Ottenere le coordinate per i punti di interesse nelle camere operanti

- Utilizzare DeepLabCut come descritto nel passaggio 4.3 per contrassegnare manualmente i punti di interesse nelle camere operanti (ad esempio le aperture del naso, le leve, ecc.) in un singolo fotogramma video (Figura 8C). Questi sono scelti manualmente a seconda degli interessi specifici dello studio, anche se la posizione dell'indicatore passo protocollo dovrebbe sempre essere inclusa.

- Recuperare le coordinate dei punti di interesse contrassegnati dal file CSV che DeepLabCut archivia automaticamente in "dati etichettati" nella cartella del progetto.

6. Identificazione dei segmenti video in cui l'indicatore del passo del protocollo è attivo

- Caricare i file .csv ottenuti dall'analisi video DeepLabCut nel passaggio 4.6 in un software di gestione dei dati preferito.

NOTA: a causa della quantità e della complessità dei dati ottenuti da DeepLabCut e dai sistemi di condizionamento operanti, la gestione dei dati è ideale attraverso script di analisi automatizzati. Per iniziare, si prega di fare riferimento alle guide di livello base disponibili altrove20,21,22. - Notare in quali segmenti video l'indicatore della fase del protocollo viene tracciato entro 60 pixel dalla posizione ottenuta nella sezione 5. Questi saranno i punti in cui l'indicatore del passaggio del protocollo è attivo (Figura 6B).

NOTA: durante i segmenti video in cui l'indicatore della fase del protocollo non brilla, il video contrassegnato potrebbe indicare che DeepLabCut non lo sta tracciando in nessuna posizione. Tuttavia, questo è raramente il caso, e viene invece in genere tracciato in più posizioni sparse. - Estrarre il punto di partenza esatto per ogni periodo in cui l'indicatore della fase del protocollo è attivo(Figura 6C: 1).

7. Identificazione dei segmenti video di interesse

- Considerare i punti in cui l'indicatore del passo del protocollo diventa attivo(Figura 6C: 1) e i timestamp delle risposte registrate dalle camere operanti (sezione 2, Figura 6C: 2).

- Utilizzare queste informazioni per determinare quali segmenti video coprono eventi interessanti specifici, ad esempio intervalli tra tentativi, risposte, recuperi di premi e così via (Figura 6C: 3, Figura 6D).

NOTA: Per questo, tenere a mente che la fotocamera descritta qui registra i video a 30 fps. - Nota i fotogrammi video specifici che coprono questi eventi di interesse.

- (Facoltativo) Modifica i file video delle sessioni di test complete per includere solo i segmenti specifici di interesse.

NOTA: Ci sono diversi modi per raggiungere questo obiettivo. Uno è descritto nei file supplementari 2 e 3. Questo aiuta notevolmente quando si memorizza un gran numero di video e può anche rendere la revisione e la presentazione dei risultati più conveniente.

8. Analisi della posizione e dei movimenti di un animale durante specifici segmenti video

- Sottoinsieme dei dati di tracciamento completi della posizione della testa ottenuti da DeepLabCut nel passaggio 4.6 per includere solo i segmenti video indicati nella sezione 7.

- Calcolare la posizione della testa dell'animale in relazione a uno o più punti di riferimento selezionati nella sezione 5(Figura 8C). Ciò consente di confrontare il monitoraggio e la posizione tra diversi video.

- Eseguire un'analisi approfondita della posizione e dei movimenti dell'animale.

NOTA: l'analisi specifica eseguita sarà fortemente specifica dello studio. Di seguito sono riportati alcuni esempi di parametri che possono essere analizzati.- Visualizza le tracce del percorso tracciando tutte le coordinate rilevate durante un periodo selezionato all'interno di un grafico.

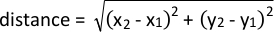

- Analizzare la prossimità a un determinato punto di interesse utilizzando la formula seguente:

- Analizzare i cambiamenti di velocità durante un movimento calcolando la distanza tra le coordinate tracciate in fotogrammi consecutivi e dividere per 1/fps della fotocamera.

Risultati

Prestazioni della videocamera

I risultati rappresentativi sono stati raccolti in camere di condizionamento operanti per ratti con superfici del pavimento di 28,5 cm x 25,5 cm e altezze di 28,5 cm. Con l'obiettivo fisheye attaccato, la fotocamera cattura l'intera superficie del pavimento e grandi parti delle pareti circostanti, quando posizionate sopra la camera (Figura 7A). Come tale, una buona vista può essere ottenuta, anche se la fotocamera è...

Discussione

Questo protocollo descrive come costruire una videocamera economica e flessibile che può essere utilizzata per registrare video da camere di condizionamento operanti e altre configurazioni di test comportamentali. Dimostra inoltre come utilizzare DeepLabCut per monitorare un forte segnale luminoso all'interno di questi video e come questo può essere utilizzato per aiutare a identificare brevi segmenti video di interesse nei file video che coprono sessioni di test complete. Infine, descrive come utilizzare il tracciamen...

Divulgazioni

Mentre i materiali e le risorse della fondazione The Raspberry Pi sono stati utilizzati e citati in questo manoscritto, la fondazione non è stata attivamente coinvolta nella preparazione o nell'uso di attrezzature e dati in questo manoscritto. Lo stesso vale per Pi-Supply. Gli autori non hanno nulla da rivelare.

Riconoscimenti

Questo lavoro è stato sostenuto dalle sovvenzioni della Swedish Brain Foundation, della Swedish Parkinson Foundation e dei Fondi governativi svedesi per la ricerca clinica (M.A.C.), nonché dalle fondazioni Wenner-Gren (M.A.C, E.K.H.C), dalla fondazione .hlén (M.A.C) e dalla fondazione Blanceflor Bon Lucompagnidovisi, née né Bildt (S.F).

Materiali

| Name | Company | Catalog Number | Comments |

| 32 Gb micro SD card with New Our Of Box Software (NOOBS) preinstalled | The Pi hut (https://thpihut.com) | 32GB | |

| 330-Ohm resistor | The Pi hut (https://thpihut.com) | 100287 | This article is for a package with mixed resistors, where 330-ohm resistors are included. |

| Camera module (Raspberry Pi NoIR camera v.2) | The Pi hut (https://thpihut.com) | 100004 | |

| Camera ribbon cable (Raspberry Pi Zero camera cable stub) | The Pi hut (https://thpihut.com) | MMP-1294 | This is only needed if a Raspberry Pi zero is used. If another Raspberry Pi board is used, a suitable camera ribbon cable accompanies the camera component |

| Colored LEDs | The Pi hut (https://thpihut.com) | ADA4203 | This article is for a package with mixed colors of LEDs. Any color can be used. |

| Female-Female jumper cables | The Pi hut (https://thpihut.com) | ADA266 | |

| IR LED module (Bright Pi) | Pi Supply (https://uk.pi-supply.com) | PIS-0027 | |

| microcomputer motherboard (Raspberry Pi Zero board with presoldered headers) | The Pi hut (https://thpihut.com) | 102373 | Other Raspberry Pi boards can also be used, although the method for automatically starting the Python script only works with Raspberry Pi zero. If using other models, the python script needs to be started manually. |

| Push button switch | The Pi hut (https://thpihut.com) | ADA367 | |

| Raspberry Pi power supply cable | The Pi hut (https://thpihut.com) | 102032 | |

| Raspberry Pi Zero case | The Pi hut (https://thpihut.com) | 102118 | |

| Raspberry Pi, Mod my pi, camera stand with magnetic fish eye lens and magnetic metal ring attachment | The Pi hut (https://thpihut.com) | MMP-0310-KIT |

Riferimenti

- Pritchett, K., Mulder, G. B. Operant conditioning. Contemporary Topics in Laboratory Animal Science. 43 (4), (2004).

- Clemensson, E. K. H., Novati, A., Clemensson, L. E., Riess, O., Nguyen, H. P. The BACHD rat model of Huntington disease shows slowed learning in a Go/No-Go-like test of visual discrimination. Behavioural Brain Research. 359, 116-126 (2019).

- Asinof, S. K., Paine, T. A. The 5-choice serial reaction time task: a task of attention and impulse control for rodents. Journal of Visualized Experiments. (90), e51574 (2014).

- Coulbourn instruments. Graphic State: Graphic State 4 user's manual. Coulbourn instruments. , 12-17 (2013).

- Med Associates Inc. Med-PC IV: Med-PC IV programmer's manual. Med Associates Inc. , 21-44 (2006).

- Clemensson, E. K. H., Clemensson, L. E., Riess, O., Nguyen, H. P. The BACHD rat model of Huntingon disease shows signs of fronto-striatal dysfunction in two operant conditioning tests of short-term memory. PloS One. 12 (1), (2017).

- Herremans, A. H. J., Hijzen, T. H., Welborn, P. F. E., Olivier, B., Slangen, J. L. Effect of infusion of cholinergic drugs into the prefrontal cortex area on delayed matching to position performance in the rat. Brain Research. 711 (1-2), 102-111 (1996).

- Chudasama, Y., Muir, J. L. A behavioral analysis of the delayed non-matching to position task: the effects of scopolamine, lesions of the fornix and of the prelimbic region on mediating behaviours by rats. Psychopharmacology. 134 (1), 73-82 (1997).

- Talpos, J. C., McTighe, S. M., Dias, R., Saksida, L. M., Bussey, T. J. Trial-unique, delayed nonmatching-to-location (TUNL): A novel, highly hippocampus-dependent automated touchscreen test of location memory and pattern separation. Neurobiology of Learning and Memory. 94 (3), 341 (2010).

- Rayburn-Reeves, R. M., Moore, M. K., Smith, T. E., Crafton, D. A., Marden, K. L. Spatial midsession reversal learning in rats: Effects of egocentric cue use and memory. Behavioural Processes. 152, 10-17 (2018).

- Gallo, A., Duchatelle, E., Elkhessaimi, A., Le Pape, G., Desportes, J. Topographic analysis of the rat's behavior in the Skinner box. Behavioural Processes. 33 (3), 318-328 (1995).

- Iversen, I. H. Response-initiated imaging of operant behavior using a digital camera. Journal of the Experimental Analysis of Behavior. 77 (3), 283-300 (2002).

- Med Associates Inc. Video monitor: Video monitor SOF-842 user's manual. Med Associates Inc. , 26-30 (2004).

- . Coulbourn Instruments Available from: https://www.coulbourn.com/product_p/h39-16.htm (2020)

- Mathis, A., et al. DeepLabCut: markerless pose estimation of user-defined body parts with deep learning. Nature Neuroscience. 21 (9), 1281-1289 (2018).

- Nath, T., Mathis, A., Chen, A. C., Patel, A., Bethge, M., Mathis, M. W. Using DeepLabCut for 3D markerless pose estimation across species and behaviors. Nature Protocols. 14 (7), 2152-2176 (2019).

- Bari, A., Dalley, J. W., Robbins, T. W. The application of the 5-chopice serial reaction time task for the assessment of visual attentional processes and impulse control in rats. Nature Protocols. 3 (5), 759-767 (2008).

- . Raspberry Pi foundation Available from: https://thepi.io/how-to-install-raspbian-on-the-raspberry-pi/ (2020)

- . Pi-supply Available from: https://learn.pi-supply.com/make/bright-pi-quickstart-faq/ (2018)

- . Python Available from: https://wiki.python.org/moin/BeginnersGuide/NonProgrammers (2020)

- . MathWorks Available from: https://mathworks.com/academia/highschool/ (2020)

- . Cran.R-Project.org Available from: https://cran.r-project.org/manuals.html (2020)

- Liu, Y., Tian, C., Huang, Y. . Critical assessment of correction methods for fisheye lens distortion. The international archives of the photogrammetry, remote sensing and spatial information sciences. , (2016).

- Pereira, T. D., et al. Fast animal pose estimation using deep neural networks. Nature Methods. 16 (1), 117-125 (2019).

- Graving, J. M., et al. DeepPoseKit, a software toolkit for fast and robust animal pose estimation using deep learning. Elife. 8 (47994), (2019).

- Geuther, B. Q., et al. Robust mouse tracking in complex environments using neural networks. Communications Biology. 2 (124), (2019).

Ristampe e Autorizzazioni

Richiedi autorizzazione per utilizzare il testo o le figure di questo articolo JoVE

Richiedi AutorizzazioneThis article has been published

Video Coming Soon