JoVE 비디오를 활용하시려면 도서관을 통한 기관 구독이 필요합니다. 전체 비디오를 보시려면 로그인하거나 무료 트라이얼을 시작하세요.

Method Article

복잡한 환경에서 두드러진 물체 감지를 위한 End-to-End Deep Neural Network

요약

본 프로토콜은 새로운 종단 간 두드러진 물체 감지 알고리즘을 설명합니다. 심층 신경망을 활용하여 복잡한 환경 컨텍스트 내에서 두드러진 물체 감지의 정밀도를 향상시킵니다.

초록

현저한 물체 감지는 컴퓨터 비전 영역 내에서 급성장하는 관심 영역으로 부상했습니다. 그러나 일반적인 알고리즘은 복잡하고 다면적인 환경에서 두드러진 물체를 감지하는 작업을 수행할 때 정밀도가 감소합니다. 이러한 긴급한 문제에 비추어 이 기사에서는 복잡한 환경 내에서 두드러진 물체를 감지하는 것을 목표로 하는 종단 간 심층 신경망을 제시합니다. 이 연구는 복잡한 환경 내에서 두드러진 물체를 감지하는 것을 목표로 하는 종단 간 심층 신경망을 소개합니다. 제안된 네트워크는 두 개의 상호 관련된 구성 요소, 즉 픽셀 수준의 다중 스케일 전체 컨볼루션 네트워크와 심층 인코더-디코더 네트워크로 구성되며, 컨텍스트 의미 체계를 통합하여 다중 스케일 기능 맵에서 시각적 대비를 생성하는 동시에 깊고 얕은 이미지 기능을 사용하여 개체 경계 식별의 정확도를 향상시킵니다. 완전히 연결된 CRF(Conditional Random Field) 모델의 통합은 두드러진 맵의 공간 일관성과 등고선 묘사를 더욱 향상시킵니다. 제안된 알고리즘은 SOD 및 ECSSD 데이터베이스에서 10개의 최신 알고리즘에 대해 광범위하게 평가됩니다. 평가 결과는 제안된 알고리즘이 정밀도와 정확성 측면에서 다른 접근 방식을 능가하여 복잡한 환경에서 두드러진 물체 감지에 대한 효율성을 확립했음을 보여줍니다.

서문

눈에 띄는 물체 감지는 사람의 시각적 주의를 모방하여 배경 정보를 억제하면서 주요 이미지 영역을 신속하게 식별합니다. 이 기법은 이미지 자르기(image cropping)1, 의미론적 분할(semantic segmentation)2, 이미지 편집(image editing)3과 같은 작업에서 전처리 도구로 널리 사용된다. 배경 교체 및 전경 추출과 같은 작업을 간소화하여 편집 효율성과 정밀도를 향상시킵니다. 또한 타겟 국소화를 강화하여 의미론적 분할을 지원합니다. 계산 효율성을 높이고 메모리를 보존하기 위한 두드러진 물체 감지의 잠재력은 중요한 연구 및 응용 프로그램 전망을 강조합니다.

수년에 걸쳐 두드러진 객체 감지는 초기 기존 알고리즘에서 딥 러닝 알고리즘의 통합으로 발전했습니다. 이러한 발전의 목적은 두드러진 물체 감지와 인간의 시각적 메커니즘 사이의 격차를 좁히는 것이었습니다. 이로 인해 두드러진 물체 감지 연구를 위한 심층 컨볼루션 네트워크 모델이 채택되었습니다. Borji et al.4 은 이미지의 기본 특징에 의존하는 대부분의 고전적인 기존 알고리즘을 요약하고 일반화했습니다. 감지 정확도가 약간 향상되었음에도 불구하고 수동 경험 및 인지는 복잡한 환경에서 두드러진 물체 감지에 대한 문제를 계속 제기합니다.

CNN(Convolutional Neural Networks)의 사용은 두드러진 물체 감지 영역에서 널리 사용됩니다. 이러한 맥락에서 심층 컨볼루션 신경망은 자율 학습을 통한 가중치 업데이트에 활용됩니다. 컨볼루션 신경망은 캐스케이드 컨볼루션 및 풀링 레이어를 사용하여 이미지에서 컨텍스트 의미를 추출하는 데 사용되어 다양한 환경에서 두드러진 물체 감지를 위한 더 높은 식별 및 특성화 능력을 가진 더 높은 수준의 복잡한 이미지 기능을 학습할 수 있습니다.

2016년, 완전 컨볼루션 신경망(fully convolutional neural networks)5 은 현저한 물체 감지를 위한 인기 있는 접근 방식으로 상당한 주목을 받았으며, 연구자들은 이를 기반으로 픽셀 수준의 현저한 물체 감지를 시작했습니다. 많은 모델은 일반적으로 이미지 표현을 향상시키고 에지 감지 효과를 강화하기 위해 기존 네트워크(예: VGG166, ResNet7)를 기반으로 구축됩니다.

Liu et al.8 은 이미 훈련된 신경망을 프레임워크로 사용하여 이미지를 전역적으로 계산한 다음 계층적 네트워크를 사용하여 객체 경계를 구체화했습니다. 두 네트워크의 조합은 최종 심층 현저성 네트워크를 형성합니다. 이는 이전에 획득한 두드러진 지도를 반복적인 방식으로 사전 지식으로 네트워크에 공급함으로써 수행되었습니다. Zhang et al.9 은 각각 얕은 층에서 깊은 층으로, 깊은 층에서 얕은 층으로 양방향 정보 전달이 가능한 심층 네트워크를 사용하여 이미지 의미 및 공간 정보를 효과적으로 융합했습니다. 상호 학습 딥 모델을 사용한 두드러진 물체 감지는 Wu et al.10에 의해 제안되었습니다. 이 모델은 컨볼루션 신경망 내에서 전경 및 에지 정보를 활용하여 감지 프로세스를 용이하게 합니다. Li et al.11 은 신경망의 '구멍 알고리즘'을 사용하여 두드러진 물체 감지의 맥락에서 심층 신경망에서 다양한 계층의 수용 필드를 고정하는 문제를 해결했습니다. 그러나 슈퍼 픽셀 분할은 객체 에지 획득에 사용되어 계산 노력과 계산 시간을 크게 증가시킵니다. Ren et al.12 는 두드러진 물체를 감지하기 위해 멀티스케일 인코더-디코더 네트워크를 고안하고 컨볼루션 신경망을 활용하여 깊고 얕은 특징을 효과적으로 결합했습니다. 이 접근 방식을 통해 물체 감지의 경계 모호 문제가 해결되지만, 정보의 다중 스케일 융합은 불가피하게 계산 요구 사항을 증가시킵니다.

문헌 검토13 에서는 전통적인 방법에서 딥러닝 방법에 이르기까지 현저성 검출을 요약하고, 현저성 표적 검출의 기원에서 딥러닝 시대까지의 진화를 매우 명확하게 볼 수 있다고 제안합니다. 우수한 성능을 갖는 다양한 RGB-D-기반 현저한 물체 검출 모델이 문헌14에서 제안되었다. 위의 문헌은 현저성 객체 감지를 위한 다양한 유형의 알고리즘을 검토 및 분류하고 애플리케이션 시나리오, 사용된 데이터베이스 및 평가 메트릭을 설명합니다. 이 기사에서는 제안된 데이터베이스 및 평가 메트릭과 관련하여 제안된 알고리즘에 대한 정성적 및 정량적 분석도 제공합니다.

위의 모든 알고리즘은 공용 데이터베이스에서 놀라운 결과를 얻었으며 복잡한 환경에서 두드러진 물체 감지를 위한 기반을 제공합니다. 국내외적으로 이 분야에서 수많은 연구 성과가 있었지만 여전히 해결해야 할 과제가 있습니다. (1) 기존의 비딥러닝 알고리즘은 주관적인 경험과 인식에 쉽게 영향을 받을 수 있는 색상, 질감 및 빈도와 같은 수동으로 레이블링된 기능에 의존하기 때문에 정확도가 낮은 경향이 있습니다. 결과적으로 두드러진 물체 감지 기능의 정밀도가 떨어집니다. 기존의 비딥러닝 알고리즘을 사용하여 복잡한 환경에서 두드러진 물체를 감지하는 것은 복잡한 시나리오를 처리하기 어렵기 때문에 어렵습니다. (2) 현저한 물체 검출을 위한 종래의 방법은 색상, 질감 및 빈도와 같은 수동으로 라벨링된 특징에 의존하기 때문에 정확도가 제한적입니다. 또한 영역 수준 감지는 계산 비용이 많이 들 수 있고, 공간 일관성을 무시하는 경우가 많으며, 객체 경계를 제대로 감지하지 못하는 경향이 있습니다. 이러한 문제는 두드러진 물체 감지의 정밀도를 향상시키기 위해 해결해야 합니다. (3) 복잡한 환경에서 현저한 물체를 감지하는 것은 대부분의 알고리즘에 도전 과제입니다. 대부분의 두드러진 물체 감지 알고리즘은 다양한 배경(유사한 배경 및 전경색, 복잡한 배경 텍스처 등)이 있는 점점 더 복잡해지는 두드러진 물체 감지 환경, 일관되지 않은 감지 물체 크기와 같은 많은 불확실성, 전경 및 배경 가장자리의 불분명한 정의로 인해 심각한 문제에 직면해 있습니다.

현재 알고리즘의 대부분은 유사한 배경색과 전경색, 복잡한 배경 질감 및 흐릿한 가장자리를 가진 복잡한 환경에서 두드러진 물체를 감지하는 데 낮은 정확도를 보입니다. 현재의 딥러닝 기반 현저한 객체 알고리즘은 기존 탐지 방법보다 더 높은 정확도를 보여주지만, 이들이 활용하는 기본 이미지 특징은 여전히 의미론적 특징을 효과적으로 특성화하는 데 부족하여 성능 개선의 여지가 있습니다.

요약하면, 이 연구는 복잡한 환경에서 현저한 물체 감지의 정확도를 높이고 대상 가장자리를 개선하며 의미론적 특징을 더 잘 특성화하는 것을 목표로 하는 현저한 물체 감지 알고리즘을 위한 종단 간 심층 신경망을 제안합니다. 이 논문의 기여는 다음과 같습니다: (1) 첫 번째 네트워크는 VGG16을 기본 네트워크로 사용하고 '구멍 알고리즘'을 사용하여 5개의 풀링 레이어를 수정합니다.11 픽셀 수준의 다중 스케일 완전 컨볼루션 신경망은 다양한 공간 스케일에서 이미지 특징을 학습하여 심층 신경망의 다양한 계층에 걸쳐 정적 수용 필드의 문제를 해결하고 현장의 중요한 초점 영역에서 감지 정확도를 향상시킵니다. (2) 두드러진 물체 감지의 정확도를 개선하기 위한 최근의 노력은 VGG16과 같은 심층 신경망을 활용하여 인코더 네트워크에서 깊이 특징과 디코더 네트워크에서 얕은 특징을 모두 추출하는 데 중점을 두었습니다. 이 접근 방식은 개체 경계의 감지 정확도를 효과적으로 향상시키고 특히 다양한 배경, 일관되지 않은 개체 크기 및 전경과 배경 사이의 불분명한 경계가 있는 복잡한 환경에서 의미 체계 정보를 개선합니다. (3) 두드러진 물체 검출의 정밀도를 향상시키려는 최근의 노력은 인코더 네트워크에서 깊은 특징을 추출하고 디코더 네트워크에서 얕은 특징을 추출하기 위해 VGG16을 포함한 더 깊은 네트워크의 사용을 강조했습니다. 이 접근 방식은 특히 다양한 배경, 개체 크기 및 전경과 배경 사이의 불분명한 경계가 있는 복잡한 환경에서 개체 경계의 향상된 감지와 더 큰 의미 체계 정보를 보여주었습니다. 또한 완전히 연결된 CRF(Conditional Random Field) 모델의 통합이 구현되어 현저한 맵의 공간 일관성과 등고선 정밀도를 강화했습니다. 이 접근 방식의 효과는 복잡한 배경을 가진 SOD 및 ECSSD 데이터 세트에서 평가되었으며 통계적으로 유의한 것으로 나타났습니다.

관련 작품

Fu et al.15 는 현저한 물체 감지를 위해 RGB와 딥 러닝을 사용하는 공동 접근 방식을 제안했습니다. Lai et al.16 은 주석 시간을 절약하기 위해 주로 낙서 레이블을 사용하여 주석에서 현저성을 학습하는 두드러진 물체 감지를 위한 약한 지도 모델을 도입했습니다. 이러한 알고리즘은 현저성 물체 감지를 위한 두 가지 보완 네트워크의 융합을 제시했지만 복잡한 시나리오에서 현저성 검출에 대한 심층적인 조사가 부족했습니다. Wang et al.17 은 상향식(bottom-up) 및 하향식(top-down)의 신경망 특징의 두 가지 모드 반복 융합을 설계하여 수렴할 때까지 이전 반복의 결과를 점진적으로 최적화했습니다. Zhang et al.18 은 각각 얕은 층에서 깊은 층으로, 깊은 층에서 얕은 층으로 양방향 정보 전달을 통해 심층 네트워크를 사용하여 이미지 의미론적 정보와 공간 정보를 효과적으로 융합했습니다. 상호 학습 심층 모델을 사용한 두드러진 물체의 감지는 Wu et al.19에 의해 제안되었습니다. 이 모델은 컨볼루션 신경망 내에서 전경 및 에지 정보를 활용하여 감지 프로세스를 용이하게 합니다. 이러한 심층 신경망 기반 현저한 물체 감지 모델은 공개적으로 사용 가능한 데이터 세트에서 놀라운 성능을 달성하여 복잡한 자연 장면에서 현저한 물체 감지를 가능하게 합니다. 그럼에도 불구하고 훨씬 더 우수한 모델을 설계하는 것은 이 연구 분야에서 중요한 목표로 남아 있으며 이 연구의 주요 동기가 됩니다.

전체 프레임워크

그림 1에 표시된 바와 같이 제안된 모델의 회로도 표현은 주로 VGG16 아키텍처에서 파생된 것으로, 픽셀 수준 다중 스케일 완전 컨볼루션 신경망(DCL)과 심층 인코더-디코더 네트워크(DEDN)를 모두 통합합니다. 이 모델은 VGG16의 모든 최종 풀링 및 완전 연결 레이어를 제거하면서 W × H의 입력 이미지 크기를 수용합니다. 운영 메커니즘에는 DCL을 통한 입력 이미지의 초기 처리가 포함되며, DEDN 네트워크에서 얕은 특징을 쉽게 추출할 수 있습니다. 이러한 특성의 융합은 이후에 완전히 연결된 CRF(Conditional Random Field) 모델을 거쳐 생성된 현저성 맵의 공간 일관성 및 등고선 정확도를 증가시킵니다.

모델의 효능을 확인하기 위해 복잡한 배경을 가진 SOD20 및 ECSSD21 데이터 세트에 대한 테스트 및 검증을 거쳤습니다. 입력 이미지가 DCL을 통과한 후 다양한 수용 필드를 가진 다양한 스케일 기능 맵을 얻고 컨텍스트 의미 체계를 결합하여 차원 간 일관성을 가진 W × H 현저한 맵을 생성합니다. DCL은 원래 VGG16 네트워크의 최종 풀링 계층을 대체하기 위해 7 x 7 커널이 있는 한 쌍의 컨볼루셔널 계층을 사용하여 기능 맵의 공간 정보 보존을 향상시킵니다. 이것은 문맥적 의미론과 결합되어 차원 간 일관성을 가진 W × H 돌출 맵을 생성합니다. 마찬가지로 DEDN(Deep Encoder-Decoder Network)은 디코더에 3 x 3 커널이 있는 컨볼루션 계층과 마지막 디코딩 모듈 뒤에 단일 컨볼루션 계층을 사용합니다. 이미지의 깊고 얕은 특징을 활용하여 W × H의 공간 차원을 가진 돌출 지도를 생성하여 불분명한 물체 경계의 문제를 해결할 수 있습니다. 이 연구는 DCL 및 DEDN 모델을 통합 네트워크로 통합하는 두드러진 물체 감지를 위한 선구적인 기술을 설명합니다. 이 두 심층 네트워크의 가중치는 훈련 과정을 통해 학습되며, 결과 현저성 맵은 병합된 다음 완전히 연결된 CRF(Conditional Random Field)를 사용하여 미세 조정됩니다. 이 구체화의 주요 목표는 공간 일관성과 등고선 위치 파악을 개선하는 것입니다.

픽셀 수준 다중 스케일 완전 컨볼루션 신경망

VGG16 아키텍처는 원래 5개의 풀링 레이어로 구성되었으며, 각 레이어는 2의 스트라이드를 가지고 있습니다. 각 풀링 계층은 영상 크기를 압축하여 채널 개수를 늘리고 더 많은 컨텍스트 정보를 얻습니다. DCL 모델은 문헌13에서 영감을 받았으며 VGG16의 프레임워크를 개선한 것입니다. 이 글에서는 그림 2와 같이 심층 컨볼루션 신경망인 VGG16의 아키텍처 내에서 픽셀 레벨 DCL 모델(11)이 사용된다. 처음 4개의 최대 풀링 계층은 3개의 커널과 상호 연결됩니다. 첫 번째 커널은 3 × 3 × 128입니다. 두 번째 커널은 1 × 1 × 128입니다. 세 번째 커널은 1 × 1 × 1입니다. 3개의 커널에 연결된 초기 4개의 풀링 계층 이후에 각 크기가 원본 이미지의 1/8에 해당하는 균일한 크기의 특징 맵을 얻기 위해 이 4개의 가장 큰 풀링 계층에 연결된 첫 번째 커널의 스텝 크기는 각각 4, 2, 1, 1로 설정됩니다.

상이한 커널들에서 원래의 수용장을 보존하기 위해, 문헌11 에서 제안된 "구멍 알고리즘"은 0을 추가함으로써 커널의 크기를 확장하기 위해 사용되며, 따라서 커널의 무결성을 유지한다. 이 4개의 특징 맵은 서로 다른 단계 크기를 가진 첫 번째 커널에 연결됩니다. 결과적으로, 최종 단계에서 생성된 특징 맵은 동일한 차원을 갖습니다. 4개의 특징 맵은 서로 다른 척도에서 얻은 다중 척도 특징의 집합으로 구성되며, 각 특징은 다양한 크기의 수용 영역을 나타냅니다. 4개의 중간 레이어에서 얻은 결과 기능 맵은 VGG16에서 파생된 궁극적인 기능 맵과 연결되어 5채널 출력을 생성합니다. 후속 출력은 이후 시그모이드 활성화 함수를 사용하여 1 × 1 × 1 커널을 거쳐 궁극적으로 돌출 맵(원본 이미지의 1/8 해상도)을 생성합니다. 이미지는 쌍선형 보간을 사용하여 업샘플링 및 확대되어 현저성 맵이라고 하는 결과 이미지가 초기 이미지와 동일한 해상도를 유지하도록 합니다.

심층 인코더-디코더 네트워크

마찬가지로 VGG16 네트워크는 백본 네트워크로 사용됩니다. VGG16은 얕은 기능 맵 채널 수는 적지만 해상도는 높고 깊은 기능 채널 수는 많지만 해상도가 낮은 것이 특징입니다. 계층을 풀링하고 다운샘플링하면 심층 신경망의 계산 속도가 빨라지지만 특징 맵 해상도가 감소합니다. 이 문제를 해결하기 위해 문헌14의 분석에 따라 인코더 네트워크를 사용하여 원래 VGG16의 마지막 풀링 레이어의 전체 연결을 수정합니다. 이 수정에는 7개 × 7개의 커널이 있는 두 개의 컨볼루셔널 레이어로 대체하는 것이 포함됩니다(컨볼루셔널 커널이 클수록 수용 필드가 증가함). 두 컨벌루션 커널 모두 정규화(BN) 연산과 ReLU(수정된 선형 단위)를 갖추고 있습니다. 이렇게 조정하면 이미지 공간 정보를 더 잘 보존하는 인코더 출력 기능 맵이 생성됩니다.

인코더는 돌출 개체의 전역 지역화를 위해 높은 수준의 이미지 의미 체계를 개선하지만 돌출 개체의 경계 모호 문제는 효과적으로 개선되지 않습니다. 이 문제를 해결하기 위해 에지 감지 작업(edge detection work)12에서 영감을 받은 심층적인 특징과 얕은 특징이 융합되어 그림 3과 같이 인코더-디코더 네트워크 모델(DEDN)을 제안합니다. 인코더 아키텍처는 초기 4개와 상호 연결된 3개의 커널로 구성되며, 디코더는 최대 풀링 계층에서 검색된 최대값을 사용하여 기능 맵 해상도를 체계적으로 향상시킵니다.

두드러진 물체 감지를 위한 이 혁신적인 방법론에서는 디코더 단계에서 3 × 3 커널이 있는 컨볼루션 계층이 배치 정규화 계층 및 적응된 선형 단위와 함께 활용됩니다. 디코더 아키텍처 내에서 최종 디코딩 모듈이 끝날 때, 단독 채널 컨볼루션 계층은 공간 차원 W × H의 두드러진 맵을 조달하기 위해 사용됩니다. 두드러진 맵은 인코더-디코더 모델의 협업 융합을 통해 생성되어 결과를 산출하고 둘의 보완적 융합, 즉 심층 정보와 얕은 정보의 보완적 융합을 산출합니다. 이는 두드러진 물체의 정확한 위치 파악을 달성하고 수용 영역을 증가시킬 뿐만 아니라 이미지 세부 정보를 효과적으로 보존하고 두드러진 물체의 경계를 강화합니다.

통합 메커니즘

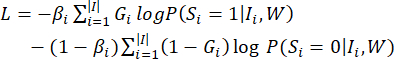

인코더 아키텍처는 VGG16 모델의 초기 4개의 최대 풀링 계층과 연결된 3개의 커널로 구성됩니다. 대조적으로, 디코더는 대응하는 풀링 레이어로부터 얻어진 최대값을 이용함으로써 업샘플링 레이어로부터 획득된 특징 맵의 해상도를 점진적으로 증가시키도록 의도적으로 공식화된다. 그런 다음 3 x 3 커널, 배치 정규화 계층 및 수정된 선형 단위를 사용하는 컨볼루셔널 레이어를 디코더에서 활용한 다음 단일 채널 컨볼루셔널 레이어를 사용하여 W × H 차원의 두드러진 맵을 생성합니다. 두 심층 네트워크의 가중치는 교대 훈련 주기를 통해 학습됩니다. 첫 번째 네트워크의 파라미터는 고정된 상태로 유지된 반면, 두 번째 네트워크의 파라미터는 총 50주기 동안 훈련을 거쳤습니다. 이 과정에서 융합에 사용되는 현저성 맵(S1 및 S2)의 가중치는 무작위 기울기를 통해 업데이트됩니다. 손실 함수(11 )는,

(1)

(1)

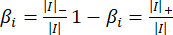

주어진 표현식에서 기호 G는 수동으로 레이블이 지정된 값을 나타내고 W는 네트워크 매개변수의 전체 집합을 나타냅니다. 가중치 β i는 계산 과정에서 두드러진 픽셀과 두드러지지 않은 픽셀의 비율을 조절하는 균형 인자 역할을 합니다.

영상 I 는 세 가지 파라미터로 특징지어진다.나|, |나|- 및 |나|+는 각각 총 픽셀 수, 두드러지지 않는 픽셀의 수, 두드러진 픽셀의 수를 나타냅니다.

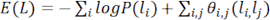

상기 두 네트워크로부터 얻어진 현저성 맵들은 인접 픽셀들의 일관성을 고려하지 않기 때문에, 공간 일관성을 향상시키기 위해 완전히 연결된 픽셀-레벨 현저성 미세 모델 CRF(15 )가 사용된다. 에너지 방정식11 은 이진 픽셀 라벨링 문제를 푸는 다음과 같습니다.

(2)

(2)

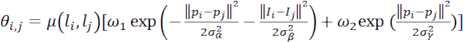

여기서 L은 모든 픽셀에 할당된 이진 레이블(두드러진 값 또는 두드러지지 않은 값)을 나타냅니다. 변수 P(li)는 주어진 픽셀 xi에 특정 레이블 li가 할당될 가능성을 나타내며, 이는 픽셀 xi가 현저성일 가능성을 나타냅니다. 처음에는 P(1) = Si및 P(0) = 1 - Si이며, 여기서 Si는 융합 현저성 맵 S 내의 픽셀 x i에서의 현저성 값을 나타냅니다. θi,j(li,l j)는 다음과 같이 정의되는 쌍별 전위입니다.

(3)

(3)

그 중 li≠ lj이면 μ(li,l j) = 1이고, 그렇지 않으면 μ(li,l j) = 0입니다. θi,j의 계산에는 두 개의 커널이 사용되며, 여기서 초기 커널은 픽셀 위치 P와 픽셀 강도 I에 모두 종속됩니다. 그 결과 유사한 색상을 가진 픽셀의 근접성이 유사한 현저성 값을 나타냅니다. α 와 σ β σ 두 매개 변수는 색상 유사성과 공간 근접성이 결과에 영향을 미치는 정도를 조절합니다. 두 번째 커널의 목적은 고립된 작은 영역을 제거하는 것입니다. 에너지의 최소화는 고차원 필터링을 통해 달성되며, 이는 CRF(Conditional Random Field) 분포의 평균 필드를 가속화합니다. 계산 시, Scrf로 표시된 현저한 지도는 감지된 돌출 물체와 관련하여 향상된 공간 일관성 및 윤곽을 나타냅니다.

실험적 구성

이 기사에서는 VGG16 신경망을 기반으로 하는 두드러진 표적 감지를 위한 심층 네트워크를 Python을 사용하여 구성합니다. 제안된 모델은 SOD20 및 ECSSD21 데이터 세트를 사용하여 다른 방법과 비교됩니다. SOD 이미지 데이터베이스는 복잡하고 어수선한 배경, 전경과 배경 간의 색상 유사성, 작은 개체 크기로 유명합니다. 이 데이터 세트의 각 이미지에는 정량적 및 정성적 성능 평가를 위해 수동으로 레이블이 지정된 true 값이 할당됩니다. 반면에 ECSSD 데이터 세트는 주로 인터넷에서 가져온 이미지로 구성되며, 이미지 배경과 두드러진 물체 사이의 대비가 낮은 보다 복잡하고 사실적인 자연 장면을 특징으로 합니다.

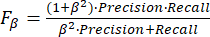

이 논문에서 모델을 비교하는 데 사용되는 평가 지수에는 일반적으로 사용되는 정밀도-재현율 곡선, Fβ및 EMAE가 포함됩니다. 예측된 현저성 맵을 정량적으로 평가하기 위해, 정밀 리콜(P-R) 곡선(22 )은 현저성 맵을 이진화하기 위해 임계값을 0 내지 255로 변경함으로써 채용된다. Fβ는 이진화된 돌출 맵과 실제 값 맵에서 파생된 정밀도 및 재현율 방정식으로 계산된 포괄적인 평가 메트릭입니다.

(4)

(4)

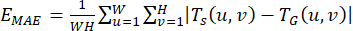

여기서 β는 정확도와 재현율을 조정하기 위한 가중치 매개변수로, β2 = 0.3으로 설정합니다. EMAE의 계산은 다음 수학 표현식에 의해 정의된 대로 결과 현저성 맵과 실측 맵 사이의 평균 절대 오차를 계산하는 것과 같습니다.

(5)

(5)

Ts(u,v)는 두드러진 맵 (u,v) 픽셀의 추출된 값을 나타내고, TG(u,v)는 실제 맵 (u,v) 픽셀의 대응값을 나타냅니다.

프로토콜

1. 실험 설정 및 절차

- 사전 훈련된 VGG16 모델을 불러옵니다.

참고: 첫 번째 단계는 Keras 라이브러리6에서 사전 훈련된 VGG16 모델을 로드하는 것입니다.- PyTorch와 같은 인기 있는 딥러닝 라이브러리를 사용하여 Python에서 사전 훈련된 VGG16 모델을 로드하려면( 자료 목차 참조) 다음 일반 단계를 따르십시오.

- 수입품 토치. torchvision.models 를 모델로 가져옵니다.

- 사전 훈련된 VGG16 모델을 불러옵니다. vgg16_model = models.vgg16(pretrained=True)입니다.

- VGG16 모델의 요약이 "print(vgg16_model)"인지 확인합니다.

- PyTorch와 같은 인기 있는 딥러닝 라이브러리를 사용하여 Python에서 사전 훈련된 VGG16 모델을 로드하려면( 자료 목차 참조) 다음 일반 단계를 따르십시오.

- DCL 및 DEDN 모델을 정의합니다.

- DCL 알고리즘의 의사 코드의 경우 입력: 이미지 데이터 세트 SOD 및 출력: 학습된 DCL 모델을 제공합니다.

- VGG16 백본 네트워크로 DCL 모델을 초기화합니다.

- 이미지 데이터셋 D를 전처리합니다(예: 크기 조정, 정규화).

- 데이터 세트를 학습 세트와 검증 세트로 분할합니다.

- DCL 모델을 학습하기 위한 손실 함수(예: 이진 교차 엔트로피)를 정의합니다.

- 학습률(0.0001), 설정된 훈련 epoch 수(50), 배치 크기(8), 옵티마이저(Adam)와 같은 훈련을 위한 하이퍼파라미터 설정.

- DCL 모델 훈련: 정의된 Epoch 수의 각 Epoch에 대해 훈련 세트의 각 배치에 대해 수행합니다. 다음을 입력합니다.

- 전달 패스: 배치 이미지를 DCL 모델에 공급합니다. 예측된 현저성 맵과 실측 맵을 사용하여 손실을 계산합니다.

- 역방향 패스: 경사하강법 끝을 사용하여 모델 매개변수를 업데이트합니다. 검증 세트 끝에서 검증 손실과 다른 평가 메트릭을 계산합니다.

- 학습된 DCL 모델을 저장합니다.

- 훈련된 DCL 모델을 반환합니다.

- DEDN 알고리즘에 대한 의사 코드의 경우 이미지 데이터 세트(X), 실측 자료 현저성 맵(Y), 학습 반복 횟수(N)를 입력합니다.

- 인코더 네트워크의 경우 인코더가 VGG16 스켈레톤을 기반으로 하여 수정 사항이 적용되었는지 확인합니다(아래 설명 참조).

참고: encoder_input = 입력(모양=input_shape)

encoder_conv1 = Conv2D(64, (3, 3), 활성화='relu', 패딩='동일')(encoder_input)

encoder_pool1 = MaxPooling2D((2, 2))(encoder_conv1)

encoder_conv2 = Conv2D(128, (3, 3), 활성화='relu', 패딩='동일')(encoder_pool1)

encoder_pool2 = MaxPooling2D((2, 2))(encoder_conv2)

encoder_conv3 = Conv2D (256, (3, 3), 활성화 = 'relu', 패딩 = '동일') (encoder_pool2)

encoder_pool3 = MaxPooling2D((2, 2))(encoder_conv3) - 디코더 네트워크의 경우 디코더가 VGG16 스켈레톤을 기반으로 수정되었는지 확인합니다(아래 설명 참조).

참고 : decoder_conv1 = Conv2D (256, (3, 3), 활성화 = 'relu', 패딩 = '동일') (encoder_pool3)

decoder_upsample1 = UpSampling2D((2, 2))(decoder_conv1)

decoder_conv2 = Conv2D (128, (3, 3), 활성화 = 'relu', 패딩 = '동일') (decoder_upsample1)

decoder_upsample2 = UpSampling2D((2, 2))(decoder_conv2)

decoder_conv3 = Conv2D(64, (3, 3), 활성화='relu', 패딩='동일')(decoder_upsample2)

decoder_upsample3 = UpSampling2D((2, 2))(decoder_conv3)

decoder_output = Conv2D(1, (1, 1), 활성화='시그모이드', 패딩='동일')(decoder_upsample3)

- 인코더 네트워크의 경우 인코더가 VGG16 스켈레톤을 기반으로 하여 수정 사항이 적용되었는지 확인합니다(아래 설명 참조).

- DEDN 모델을 정의합니다. 모델 = 모델(입력 = encoder_input, 출력 = decoder_output).

- 모델을 컴파일합니다. model.compile (optimizer = adam, loss = binary_crossentropy).

- 학습 루프를 선택합니다.

참고: 범위(N)에서 반복하는 경우: # 이미지 배치와 지상 실측 자료 맵을 무작위로 선택합니다. batch_X, batch_Y = randomly_select_batch(X, Y, batch_size)입니다.- 일괄 처리에서 모델을 학습시킵니다. 손실 = model.train_on_batch(batch_X, batch_Y)입니다. 모니터링을 위해 손실을 인쇄합니다.

- 학습된 모델을 저장합니다. model.save ('dedn_model.h5')입니다.

- DCL 알고리즘의 의사 코드의 경우 입력: 이미지 데이터 세트 SOD 및 출력: 학습된 DCL 모델을 제공합니다.

- 결합하다.

- DCL 신경망과 DEDN 신경망의 출력을 결합하고 완전 연결 조건부 랜덤 필드(CRF) 모델을 사용하여 현저성 맵을 구체화합니다.

2. 이미지 처리

- run code( 실행 코드)를 클릭하여 GUI 인터페이스를 불러옵니다(그림 4).

- 이미지 열기를 클릭하여 경로를 선택하고 감지할 이미지를 선택합니다.

- 디스플레이 이미지를 클릭하면 감지를 위해 선택한 이미지가 표시됩니다.

- 감지 시작을 클릭하여 선택한 이미지를 감지합니다.

알림: 감지 결과는 감지된 이미지, 즉 돌출된 물체의 결과와 함께 나타납니다(그림 5). - 저장 경로 선택을 클릭하여 두드러진 물체 감지의 이미지 결과를 저장합니다.

결과

이 연구에서는 픽셀 수준의 다중 스케일 완전 컨볼루션 네트워크와 심층 인코더-디코더 네트워크라는 두 가지 상호 보완적인 네트워크로 구성된 종단 간 심층 신경망을 소개합니다. 첫 번째 네트워크는 컨텍스트 의미론을 통합하여 다중 축척 기능 맵에서 시각적 대비를 도출하여 다양한 계층에 걸친 심층 신경망의 고정 수용 필드 문제를 해결합니다. 두 번째 신경망은 깊은 영상과 얕은 영상 특?...

토론

이 기사에서는 복잡한 환경에서 두드러진 물체를 감지하도록 특별히 설계된 종단 간 심층 신경망을 소개합니다. 이 신경망은 두 개의 상호 연결된 구성요소, 즉 픽셀 수준의 다중 스케일 완전 컨벌루션 신경망(DCL)과 심층 인코더-디코더 신경망(DEDN)으로 구성됩니다. 이러한 구성 요소는 시너지 효과를 발휘하여 상황별 의미 체계를 통합하여 다중 축척 기능 맵 내에서 시각적 대비를 생성합니다. 또...

공개

저자는 공개할 것이 없습니다.

감사의 말

이 작업은 2024년 허난성 고등 교육 기관 핵심 과학 연구 프로젝트 자금 지원 프로그램 설립(프로젝트 번호: 24A520053)의 지원을 받습니다. 이 연구는 허난성의 전문 창조 및 통합 특성 시범 코스 건설의 지원도 받고 있습니다.

자료

| Name | Company | Catalog Number | Comments |

| Matlab | MathWorks | Matlab R2016a | MATLAB's programming interface provides development tools for improving code quality maintainability and maximizing performance. It provides tools for building applications using custom graphical interfaces. It provides tools for combining MATLAB-based algorithms with external applications and languages |

| Processor | Intel | 11th Gen Intel(R) Core (TM) i5-1135G7 @ 2.40GHz | 64-bit Win11 processor |

| Pycharm | JetBrains | PyCharm 3.0 | PyCharm is a Python IDE (Integrated Development Environment) a list of required python: modulesmatplotlib skimage torch os time pydensecrf opencv glob PIL torchvision numpy tkinter |

| PyTorch | PyTorch 1.4 | PyTorch is an open source Python machine learning library , based on Torch , used for natural language processing and other applications.PyTorch can be viewed both as the addition of GPU support numpy , but also can be viewed as a powerful deep neural network with automatic derivatives . |

참고문헌

- Wang, W. G., Shen, J. B., Ling, H. B. A deep network solution for attention and aesthetics aware photo cropping. IEEE Transactions on Pattern Analysis and Machine Intelligence. 41 (7), 1531-1544 (2018).

- Wang, W. G., Sun, G. L., Gool, L. V. Looking beyond single images for weakly supervised semantic segmentation learning. IEEE Transactions on Pattern Analysis and Machine. , (2022).

- Mei, H. L., et al. Exploring dense context for salient object detection. IEEE Transactions on Circuits and Systems for Video Technology. 32 (3), 1378-1389 (2021).

- Borji, A., Itti, L. State-of-the-art in visual attention modeling. IEEE Transactions on Pattern Analysis and Machine Intelligence. 35 (1), 185-207 (2012).

- Long, J., Shelhamer, E., Darrell, T. Fully convolutional networks for semantic segmentation. , 3431-3440 (2015).

- Simonyan, K., Zisserman, A. Very deep convolutional networks for large-scale image recognition. arXiv preprint. , 1409-1556 (2014).

- He, K., Zhang, X., Ren, S., Sun, J. Deep residual learning for image recognition. , 770-778 (2016).

- Liu, N., Han, J. Dhsnet: Deep hierarchical saliency network for salient object detection. , 678-686 (2016).

- Zhang, L., Dai, J., Lu, H., He, Y., Wang, G. A bi-directional message passing model for salient object detection. , 1741-1750 (2018).

- Wu, R., et al. A mutual learning method for salient object detection with intertwined multi-supervision. , 8150-8159 (2019).

- Li, G., Yu, Y. Deep contrast learning for salient object detection. , 478-487 (2019).

- Ren, Q., Hu, R. Multi-scale deep encoder-decoder network for salient object detection. Neurocomputing. 316, 95-104 (2018).

- Wang, W. G., et al. Salient object detection in the deep learning era: An in-depth survey. IEEE Transactions on Pattern Analysis and Machine Intelligence. 44 (6), 3239-3259 (2021).

- Zhou, T., et al. RGB-D salient object detection: A survey. Computational Visual Media. 7, 37-69 (2021).

- Fu, K., et al. Siamese network for RGB-D salient object detection and beyond. IEEE Transactions on Pattern Analysis and Machine Intelligence. 44 (9), 5541-5559 (2021).

- Lai, Q., et al. Weakly supervised visual saliency prediction. IEEE Transactions on Image Processing. 31, 3111-3124 (2022).

- Zhang, L., Dai, J., Lu, H., He, Y., Wang, G. A bi-directional message passing model for salient object detection. , 1741-1750 (2018).

- Wu, R. A mutual learning method for salient object detection with intertwined multi-supervision. , 8150-8159 (2019).

- Wang, W., Shen, J., Dong, X., Borji, A., Yang, R. Inferring salient objects from human fixations. IEEE Transactions on Pattern Analysis and Machine Intelligence. 42 (8), 1913-1927 (2019).

- Movahedi, V., Elder, J. H. Design and perceptual validation of performance measures for salient object segmentation. , 49-56 (2010).

- Shi, J., Yan, Q., Xu, L., Jia, J. Hierarchical image saliency detection on extended CSSD. IEEE Transactions on Pattern Analysis and Machine Intelligence. 38 (4), 717-729 (2015).

- Achanta, R., Hemami, S., Estrada, F., Susstrunk, S. Frequency-tuned salient region detection. , 1597-1604 (2009).

- Yang, C., Zhang, L., Lu, H., Ruan, X., Yang, M. H. Saliency detection via graph-based manifold ranking. , 3166-3173 (2013).

- Wei, Y., et al. Geodesic saliency using background priors. Computer Vision-ECCV 2012. , 29-42 (2012).

- Margolin, R., Tal, A., Zelnik-Manor, L. What makes a patch distinct. , 1139-1146 (2013).

- Perazzi, F., Krähenbühl, P., Pritch, Y., Hornung, A. Saliency filters: Contrast based filtering for salient region detection. , 733-740 (2012).

- Hou, X., Harel, J., Koch, C. Image signature: Highlighting sparse salient regions. IEEE Transactions on Pattern Analysis and Machine Intelligence. 34 (1), 194-201 (2011).

- Jiang, H., et al. Salient object detection: A discriminative regional feature integration approach. , 2083-2090 (2013).

- Li, G., Yu, Y. Visual saliency based on multiscale deep features. , 5455-5463 (2015).

- Lee, G., Tai, Y. W., Kim, J. Deep saliency with encoded low level distance map and high-level features. , 660-668 (2016).

- Liu, N., Han, J. Dhsnet: Deep hierarchical saliency network for salient object detection. , 678-686 (2016).

재인쇄 및 허가

JoVE'article의 텍스트 или 그림을 다시 사용하시려면 허가 살펴보기

허가 살펴보기더 많은 기사 탐색

This article has been published

Video Coming Soon

Copyright © 2025 MyJoVE Corporation. 판권 소유