需要订阅 JoVE 才能查看此. 登录或开始免费试用。

Method Article

在复杂的航空任务中进行眼动追踪,以深入了解信息处理

摘要

眼动追踪是一种探测信息处理的非侵入性方法。本文介绍了如何使用眼动追踪来研究低时飞行员在飞行模拟紧急任务期间(即 <350 飞行小时)的注视行为。

摘要

眼动追踪已被广泛用作一种代理,以深入了解构成技能表现基础的认知、知觉和感觉运动过程。以前的研究表明,传统和高级凝视指标可靠地展示了飞行员专业知识、认知负荷、疲劳甚至态势感知 (SA) 方面的巨大差异。

本研究描述了使用可穿戴眼动仪和凝视映射算法的方法,该算法在高保真飞行静止模拟器中捕捉自然的头部和眼球运动(即凝视)。本文概述的方法描述了基于感兴趣区域 (AOI) 的眼动分析,它提供了与参与者观看位置相关的更多上下文,以及停留持续时间,这表明他们处理固定信息的效率。该协议说明了可穿戴眼动仪和计算机视觉算法的效用,以评估眼动行为的变化以应对意外的飞行中紧急情况。

代表性结果表明,当引入紧急事件时,凝视受到了显着影响。具体来说,注意力分配、注视分散和注视序列复杂性显着降低,并在紧急情况下高度集中在看前窗外和空速计上(所有 p 值均< 0.05)。讨论了在高保真无动飞行模拟环境中使用可穿戴式眼动仪来理解注视行为的时空特征及其与航空领域信息处理的关系的效用和局限性。

引言

人类主要通过首先移动眼睛和头部来将视线(即凝视)聚焦于感兴趣的特定物体或位置,从而与周围的世界互动。在复杂的环境中尤其如此,例如飞行员面临多种竞争性刺激的飞机驾驶舱。注视运动能够收集高分辨率的视觉信息,使人类能够以安全灵活的方式与环境互动1,这在航空中至关重要。研究表明,眼球运动和注视行为可以深入了解各种任务中潜在的感知、认知和运动过程 1,2,3。此外,我们看的地方直接影响上肢运动的计划和执行3。因此,航空任务期间的注视行为分析提供了一种客观且非侵入性的方法,可以揭示眼球运动模式与信息处理和性能的各个方面之间的关系。

几项研究表明,在各种实验室范式以及复杂的实际任务(即作飞机)中,凝视和任务表现之间存在关联。例如,与任务相关的区域往往更频繁地被固定,总持续时间更长,这表明注视位置、频率和停留时间是神经认知和航空任务中注意力分配的代理 4,5,6。与不太成功的表演者或新手相比,高度成功的表演者和专家表现出对任务关键领域的明显固定偏见 4,7,8。注视的时空方面是通过各种感兴趣区域 (AOI) 的停留时间模式的变化或注视分布的测量(即静止凝视熵:SGE)来捕获的。在基于实验室的范式的背景下,平均注视持续时间、扫描路径长度和凝视序列复杂性(即凝视转换熵:GTE)往往会增加,因为解决问题和阐述更具挑战性的任务目标/解决方案所需的扫描和处理增加 4,7。

相反,航空研究表明,扫描路径长度和注视序列复杂性会随着任务复杂性和认知负荷的增加而降低。这种差异凸显了这样一个事实,即理解任务组件和所采用范式的需求对于准确解释眼动指标至关重要。总而言之,迄今为止的研究支持眼动测量为任务特定信息处理提供了有意义、客观的见解,这些信息处理是任务难度、认知负荷和任务表现差异的基础。随着眼动追踪技术(即便携性、校准和成本)的进步,研究“野外”的凝视行为是一个新兴的研究领域,在推进医学 9,10,11 和航空 12,13,14 领域的职业培训方面具有切实的应用。

目前的工作旨在通过在低时飞行员的紧急飞行模拟任务中专门使用可穿戴眼动仪来进一步研究使用基于凝视的指标来深入了解信息处理的效用。本研究扩展了之前使用头部稳定眼动仪(即 EyeLink II)来检查视线行为指标与飞行难度(即天气条件的变化)的差异5。本手稿中介绍的工作还扩展了其他工作,这些工作描述了在虚拟现实系统中使用眼动追踪的方法和分析方法15。我们的研究使用了更高保真度的静止模拟器,并报告了对眼球运动数据(即熵)的额外分析。这种类型的分析在以前的论文中已经报道过;然而,当前文献中的一个局限性是报告分析步骤缺乏标准化。例如,报告感兴趣区域的定义方式至关重要,因为它直接影响生成的熵值16。

总而言之,目前的工作检查了传统的和动态的凝视行为指标,同时通过引入飞行中的紧急场景(即意外的发动机总故障)来纵任务难度。预计飞行中紧急场景的引入将提供对更具挑战性的任务条件下信息处理基础的注视行为变化的洞察。这里报道的这项研究是一项更大规模的研究的一部分,该研究考察了眼动追踪在飞行模拟器中的效用,为基于能力的飞行员培训提供信息。此处介绍的结果以前未发表过。

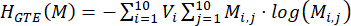

研究方案

以下协议可应用于涉及可穿戴眼动仪和飞行模拟器的研究。目前的研究涉及在飞行模拟器中与复杂的航空相关任务一起记录的眼动追踪数据(参见 材料表)。该模拟器被配置为代表 Cessna 172,并与必要的仪表板(蒸汽表配置)、航空电子设备/GPS 系统、音频/灯光面板、断路器面板和飞行控制单元 (FCU) 一起使用(见 图 1)。本研究中使用的飞行模拟器设备可用于培训目的,并被当地飞行学校用于训练在低风险环境中应对各种紧急情况(例如发动机故障)所需的技能。这项研究的参与者都获得了许可;因此,他们之前在培训过程中体验过发动机故障模拟器场景。这项研究得到了滑铁卢大学研究伦理办公室 (43564;日期:2021 年 11 月 17 日)。所有参与者 (N = 24;14 名男性,10 名女性;平均年龄 = 22 岁;飞行小时范围:51-280 小时)都提供了书面知情同意书。

图 1:飞行模拟器环境。飞行模拟器环境的图示。参与者对驾驶舱的视角复制了飞行员驾驶 Cessna 172 的视角,该飞机预设为顺风到基地再到最终进近,飞往加利福尼亚州安大略省布雷斯劳的滑铁卢国际机场。橙色框代表眼动分析中使用的 10 个主要感兴趣区域。这些包括 (1) 空速、(2) 姿态、(3) 高度计、(4) 转弯协调器、(5) 航向、(6) 垂直速度和 (7) 电源指示器,以及 (8) 前窗、(9) 左窗和 (10) 右窗。该图是从 Ayala 等人 5 修改而来的。请单击此处查看此图的较大版本。

1. 参与者筛选和知情同意

- 根据纳入/排除标准 2,5 通过自我报告问卷筛选参与者:至少拥有私人飞行员执照 (PPL),视力正常或矫正至正常,并且之前没有诊断出患有神经精神/神经疾病或学习障碍。

- 通过由实验者和监督飞行教官/模拟器技术人员处理的详细简报,告知参与者研究目标和程序。查看机构的道德审查委员会批准的同意文件中概述的风险。回答有关潜在风险的任何问题。在开始任何研究程序之前获得书面知情同意书。

2. 硬件/软件要求和启动

- 飞行模拟器(通常由模拟器技术人员完成)

- 打开模拟器和投影仪屏幕。如果其中一台投影仪没有与其他投影仪同时打开,请重新启动模拟器。

- 在 Instruction 屏幕上,按 Presets 选项卡并验证所需的 Position 和/或 Weather 预设是否可用。如果需要,请创建新的预设类型;请咨询技术人员寻求帮助。

- Collection 笔记本电脑

- 打开笔记本电脑并使用凭据登录。

- 出现提示时,请选择预先存在的配置文件,或者在测试新参与者时创建一个配置文件。或者,选择 Guest 选项以覆盖其上次校准。

- 要创建新配置文件,请滚动到配置文件列表的末尾,然后单击 Add。

- 将 配置文件 ID 设置为 参与者 ID。此配置文件 ID 将用于标记文件夹,该文件夹在录制完成后保存眼动追踪数据。

- 眼镜校准

注意:眼镜必须与笔记本电脑保持连接才能进行录制。在数据收集开始时,只需完成一次盒式校准。- 打开眼动仪盒并取出眼镜。

- 将 USB 转 micro-USB 电缆从笔记本电脑连接到眼镜。如果笔记本电脑上出现提示,请更新固件。

- 找到眼动仪盒内的黑色校准框。

- 在采集笔记本电脑的 眼动追踪中心内,选择 工具 |设备校准。

- 将眼镜放入盒子中,然后按弹出窗口上的 Start 开始 校准。

- 校准完成后,从包装盒中取出眼镜。

- 物镜转盘适配

- 选择物镜转盘。

- 指示参与者坐在驾驶舱内并戴上眼镜。

- 在 Eye tracking Hub 中,导航到 File |设置 |鼻子巫师。

- 检查屏幕左侧的 adjust fit of your glasses 框。如果拟合为 “极好”,请继续执行下一步。否则,请单击该框。

- 告诉参与者遵循屏幕上显示的贴合建议说明:设置物镜转换器,调整眼镜使其坐得舒适,然后直视前方的笔记本电脑。

- 如果需要,请更换物镜转盘。捏住物镜转盘的中间,将其从眼镜中滑出,然后再滑入另一个。继续测试不同的物镜转盘,直到确定最适合参与者的物镜转盘。

- 空中交通管制 (ATC) 呼叫

注意:如果研究需要 ATC 呼叫,请让参与者自带耳机或使用实验室耳机。只有在参与者戴上耳机后才能完成眼球校准,因为耳机可以移动头上的眼镜,从而影响校准精度。- 检查耳机是否连接到仪表板左下方的插孔。

- 指示参与者戴上耳机。要求他们在录制完成之前不要触摸或取下它。

注意: 每次移动头戴式设备(以及眼镜)时,都需要重新校准。 - 进行无线电检查。

- 眼球校准

注意:每当参与者移动头上的眼镜时,他们必须重复眼球校准。要求参与者在试用结束之前不要触摸眼镜。- 在 Eye tracking Hub 中,导航到屏幕左侧的 参数框 。

- 检查 校准模式 并相应地选择 fixed gaze 或 fixed head 。

- 检查校准点是否为 5 x 5 网格,总共 25 个点。

- 检查 验证模式 并确保它与 校准模式匹配。

- 检查眼动追踪输出,并验证是否使用复选框选中了研究需要记录的所有内容。

- 点击 File |设置 |高级 并检查 采样率 是否为 250 Hz。

- 选中屏幕上的 Calibrate your eye tracking (校准您的眼动追踪 ) 框。校准说明将根据模式而有所不同。要遵循当前研究,请使用 固定凝视 校准模式:指示参与者移动他们的头部,使框与黑色方块重叠并对齐。然后,让参与者将目光集中在黑色方块中的十字准星上,然后按空格键。

- 按 Validate your setup (验证您的设置 ) 框。说明与步骤 2.6.3 中的说明相同。检查 验证图 MAE (平均绝对误差) 是否 为 <1°。如果没有,请重复步骤 2.6.3 和 2.6.4。

- 按 Save Calibration 可在每次完成校准和验证时将校准保存到配置文件中。

- 在 Eye tracking Hub 中,导航到屏幕左侧的 参数框 。

- iPad 使用情况

注意: iPad 位于仪表板的左侧(参见 图 1)。它通常用于飞行后的问卷调查。- 打开 iPad 并确保它已连接到 Internet。

- 在 Safari 中打开一个窗口,然后输入研究问卷的链接。

3. 数据收集

注意:对每个试用重复这些步骤。建议将笔记本电脑放在驾驶舱外的长凳上。

- 在飞行模拟器计算机的 指令 屏幕中,按 预设,然后选择要模拟的所需 位置 预设。按 Apply 按钮并观察模拟器周围的屏幕,以验证更改是否发生。

- 重复步骤 3.1 以应用 Weather 预设。

- 向参与者提供有关试用或飞行路径的任何具体说明。这包括告诉他们在开始之前更改仪表板上的任何设置。

- 在说明屏幕中,按橙色的 STOPPED 按钮开始数据收集。颜色将变为绿色,文本将显示 FLYING。请务必向参与者提供口头提示,以便他们知道他们可以开始驾驶飞机。推荐的提示是 “3, 2, 1, you have controls” ,因为按下橙色 的停止 按钮。

- 在采集笔记本电脑中,点击 Start Recording (开始记录 ),以便眼动仪数据与飞行模拟器数据同步。

- 当参与者完成他们的循环并降落后,等待飞机停止移动。

注意:等待很重要,因为在后处理期间;当 GroundSpeed 稳定在 0 时,数据将被截断。这为所有试验的终点提供了一致性。 - 在说明屏幕中,按下绿色的 FLYING 按钮。颜色将恢复为橙色,文本将显示 STOPPED。在此步骤中,当数据收集即将结束时,提供口头提示。推荐的提示点是 “3, 2, 1, stop”。

- 指导参与者在 iPad 上完成试用后问卷。刷新下一次试用的页面。

注:目前的研究使用态势感知评级技术 (SART) 自我评定问卷作为唯一的试验后问卷17。

4. 数据处理和分析

- 飞行模拟器数据

注意:从飞行模拟器复制的 .csv 文件包含 1,000 多个可在模拟器中控制的参数。 表 1 中列出并描述了感兴趣的主要性能指标。- 对于每个参与者,使用方程 (1) 计算成功率,方法是在任务条件中取百分比。失败的试验由模拟器内编程的预定标准识别,由于平面方向和垂直速度,该标准在着陆时自动终止试验。进行试验后验证,以确保该标准与实际飞机限制一致(即,在着陆时垂直速度> 700 英尺/分钟 [fpm] 时,塞斯纳 172 起落架损坏/坠毁很明显)。

成功率 = (1)

(1)

注意:较低的成功率值表示较差的结果,因为它们与成功着陆尝试的减少有关。 - 对于每次试验,根据时间戳计算 完成时间 ,时间戳表示飞机停在跑道上(即 GroundSpeed = 0 节)。

注意:较短的完成时间可能并不总是等同于更好的性能。必须谨慎了解任务条件(即额外的风、紧急情况等)预计会如何影响完成时间。 - 对于每个试验,根据飞机最初降落在跑道上的飞机垂直速度 (fpm) 确定 着陆硬度 。确保在与 AircraftOnGround 状态从 0 (空中)到 1 (地面)的第一次更改关联的同一时间戳获取此值。

注意: -700 fpm 到 0 fpm 范围内的值被认为是 安全的,接近 0 的值表示着陆较软(即更好)。 负值 表示 向下的垂直速度; 正值 表示 向上的垂直速度。 - 对于每次试验,根据着陆坐标与跑道上的参考点(500 英尺标记的中心)之间的差异计算 着陆误差 (°)。 使用参考点,使用 Eq (2) 计算着陆误差。

差值 = √((δ 纬度)2 + (δ 经度)2) (2)

注意:低于 1° 的值显示为正常值 5,15。较大的值表示与距离着陆区较远的飞机着陆点相关的着陆误差较大。 - 计算每个任务条件的每个绩效结果变量的所有参与者的均值。报告这些值。

- 对于每个参与者,使用方程 (1) 计算成功率,方法是在任务条件中取百分比。失败的试验由模拟器内编程的预定标准识别,由于平面方向和垂直速度,该标准在着陆时自动终止试验。进行试验后验证,以确保该标准与实际飞机限制一致(即,在着陆时垂直速度> 700 英尺/分钟 [fpm] 时,塞斯纳 172 起落架损坏/坠毁很明显)。

- 态势感知数据

- 对于每个试验,根据 SA17 的 10 个维度的自我报告的 SART 分数计算 SA 分数。

- 使用 SART 问卷17 确定参与者对整体任务难度的主观回答,以及他们对在任务执行过程中可用和花费多少注意力资源的印象。

- 使用 7 点李克特量表,要求参与者对他们在探究问题上的感知体验进行评分,包括情况的复杂性、注意力的划分、空闲的心理能力以及信息的数量和质量。

- 将这些量表组合成更大的维度,即注意力需求 (Demand)、注意力供应 (Supply) 和情境理解 (Understanding)。

- 使用这些评级来计算基于方程 (3) 的 SA 度量:

SA = 理解 - (需求-供应) (3)

注意:量表上的较高分数相结合,可提供理解的衡量标准,表明参与者对手头的任务有很好的理解。同样,供应域中的高分表明参与者有大量的注意力资源可以投入到给定的任务中。相比之下,高需求分数表明任务需要大量的注意力资源才能完成。重要的是要澄清,这些分数在跨条件(即简单与困难条件)进行比较时得到最佳解释,而不是用作独立衡量标准。

- 数据收集完成后,计算每个任务条件(即基本、紧急)所有参与者的均值。报告这些值。

- 对于每个试验,根据 SA17 的 10 个维度的自我报告的 SART 分数计算 SA 分数。

- 眼动追踪数据

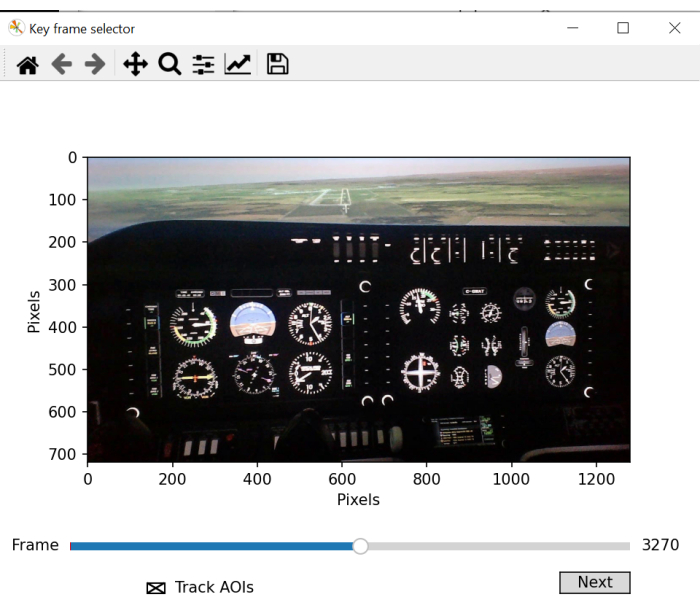

- 使用眼动追踪批处理脚本手动定义用于凝视映射的 AOI。该脚本将打开一个用于关键帧选择的新窗口,该窗口应清楚地显示将要分析的所有关键 AOI。滚动视频并选择清晰显示所有 AOI 的帧。

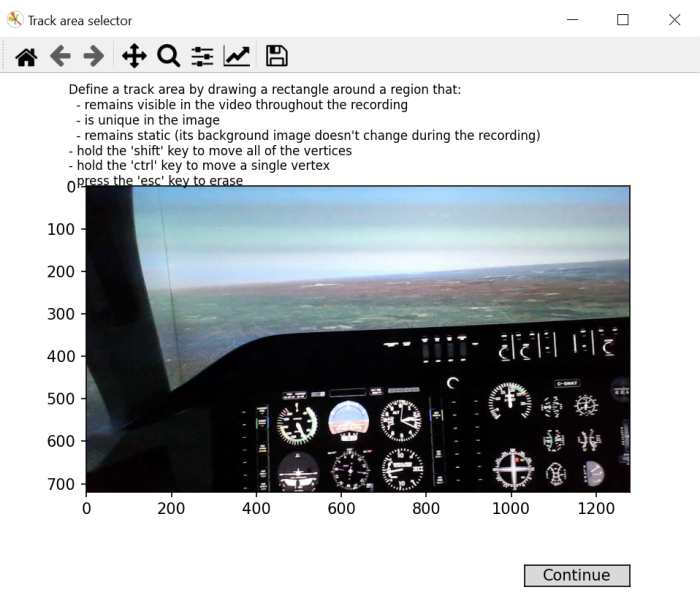

- 按照屏幕上的说明,在帧的某个区域上绘制一个矩形,该矩形将在整个视频中可见,唯一且保持稳定。

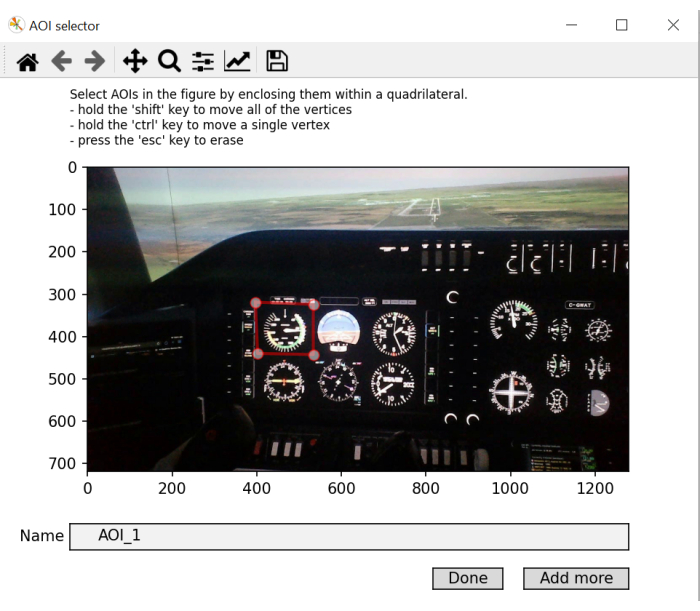

注意:此步骤的目的是生成一个“屏幕内”坐标帧,该坐标帧可用于整个视频录制,因为头部运动会导致环境中对象的位置在视频录制过程中发生变化。 - 为图片中的每个 AOI 绘制一个矩形,一次绘制一个矩形。相应地命名它们。点击 添加更多 添加新的 AOI,然后按 完成 在最后一个上。如果在给定的注视点期间,视线坐标位于“屏幕内”坐标系中定义的对象空间内,则使用相应的 AOI 标签标记该注视点。

注意:此步骤的目的是生成一个对象坐标库,然后在将凝视坐标与屏幕内坐标进行比较时,将其用作参考。

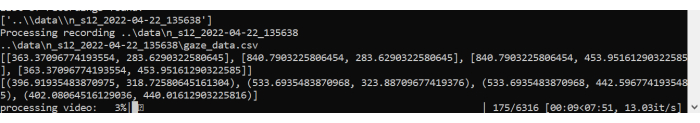

通常有 10 个 AOI,但这取决于飞行模拟器的配置方式。仪表板可能有所不同。与之前的工作 5,18 一致,当前研究使用以下 AOI:空速、姿态、高度计、转弯协调器、航向、垂直速度、功率、前窗、左窗和右窗(见图 1)。 - 让脚本开始处理 AOI 并生成注视点数据。它生成一个图,显示视频上的扫视和注视。

- 将创建两个新文件:fixations.csv 和 aoi_parameters.yaml。批处理器将完成每个试验和每个参与者的眼动数据的后处理。

注意:感兴趣的主要眼动追踪测量指标列于 表 2 中,并针对每次试验的每个 AOI 计算。 - 对于每个试验,根据 fixation.csv 文件中生成的数据计算每个 AOI 的传统凝视指标 4,5。

注意:在这里,我们关注 停留时间 (%),它是通过将特定 AOI 的注视总和除以所有注视的总和,然后将商乘以 100 得到在特定 AOI 中花费的时间百分比来计算的。从计算出的停留时间中没有固有的否定/正解释。它们表明了注意力主要分配到哪里。较长的平均固定时间表明加工需求增加。 - 对于每个试验,使用方程 (4) 计算闪烁率:

闪烁速率 = 总闪烁次数/完成时间 (4)

注意:以前的研究表明,眨眼率与认知负荷 2,6,13,19,20 呈负相关。 - 对于每个试验,使用方程 (5)21 计算 SGE:

(5)

(5)

其中 v 是查看第 i 个 AOI 的概率, V 是 AOI 的数量。

注:较高的 SGE 值与较大的注视分散相关,而较低的值表示注视点的分配更加集中22。 - 对于每个试验,使用 eq (6)23 计算 GTE:

(6)

(6)

其中 V 是查看第 i 个 AOI 的概率,M 是给定之前查看第 i 个 AOI 的概率。

注意:较高的 GTE 值与更不可预测、更复杂的视觉扫描路径相关,而较低的 GTE 值表示更可预测的常规视觉扫描路径。 - 计算每个眼动追踪输出变量(以及指示时的 AOI)和每个任务条件的所有参与者的 平均值 。报告这些值。

| 术语 | 定义 |

| 成功率 (%) | 成功登陆试验的百分比 |

| 完成时间 (s) | 从着陆场景开始到飞机在跑道上完全停止的持续时间 |

| 着陆硬度 (fpm) | 达阵时的体面率 |

| 着陆误差 (°) | 飞机中心与 500 英尺跑道标记中心在着陆点的差值 |

表 1:模拟器性能结果变量。 飞机性能相关变量及其定义。

图 2:着陆场景飞行路径。 (A) 在所有试验中完成的着陆电路和 (B) 带有 500 英尺标记的跑道的示意图,这些标记被用作着陆区的参考点(即,中间的橙色圆圈)。 请单击此处查看此图的较大版本。

图 3:感兴趣区域映射。 批处理脚本的图示,演示了用于框架选择的窗口。选择最佳帧涉及选择包含要映射的大部分或所有感兴趣区域的视频帧。 请单击此处查看此图的较大版本。

图 4:生成感兴趣区域映射“屏幕内”坐标。 批处理脚本的图示,演示了用于 “屏幕内” 坐标选择的窗口。此步骤涉及选择一个方形/矩形区域,该区域在整个录制过程中保持可见,对图像是唯一的,并且保持静态。 请单击此处查看此图的较大版本。

图 5:确定要映射的感兴趣区域。 批处理脚本窗口的图示,允许选择和标记感兴趣的区域。缩写: AOIs = 感兴趣区域。 请单击此处查看此图的较大版本。

图 6:批处理脚本处理。批处理脚本的插图,用于处理视频和眼动,映射整个试验过程中所做的注视。 请单击此处查看此图的较大版本。

| 术语 | 定义 |

| 停留时间 (%) | 一个 AOI 上累积的所有固定期总和相对于所有 AOI 上累积的固定期总和的百分比 |

| 平均注视时间 (ms) | 一个 AOI 从进入到退出的平均固定时间 |

| 闪烁速率 (blinks/s) | 每秒闪烁次数 |

| SGE(位) | 固定分散 |

| GTE(位) | 扫描序列复杂性 |

| 回合次数 | 认知隧道事件数 (>10 s) |

| 总回合时间 (s) | 认知隧道事件的总时间 |

表 2:眼动追踪结果变量。 凝视行为相关变量及其定义。

结果

任务需求对飞行性能的影响

根据在基本和紧急情况下的成功着陆试验对数据进行了分析。所有措施均采用配对样本 t 检验(主体内因素:任务条件(基本、紧急))。所有 t 检验均以设置为 0.05 的 alpha 水平进行。四名参与者在紧急情景试验期间崩溃,未被纳入主要分析,因为稀疏的数据无法得出有意义的结论。除 success rate 外,所有变量都专...

讨论

这里描述的眼动追踪方法可以通过可穿戴眼动仪在飞行模拟器环境中评估信息处理。评估凝视行为的空间和时间特征有助于深入了解人类信息处理,这已经使用高度受控的实验室范式进行了广泛研究 4,7,28。利用最新的技术进步,可以将眼动追踪研究推广到具有更高保真度的更逼真的范式,从而模拟更?...

披露声明

不存在相互竞争的经济利益。

致谢

这项工作部分得到了加拿大自然科学与工程研究委员会 (NSERC) 的加拿大研究生奖学金 (CGS) 和新前沿研究基金的勘探补助金 (00753) 的支持。本材料中表达的任何意见、发现、结论或建议均来自作者,并不一定反映赞助商的意见。

材料

| Name | Company | Catalog Number | Comments |

| flight simulator | ALSIM | AL-250 | fixed fully immersive flight simulation training device |

| laptop | Hp | Lenovo | eye tracking data collection laptop; requirements: Windows 10 and python 3.0 |

| portable eye-tracker | AdHawk | MindLink eye tracking glasses (250 Hz, <2° gaze error, front-facing camera); eye tracking batch script is made available with AdHawk device purchase |

参考文献

- de Brouwer, A. J., Flanagan, J. R., Spering, M. Functional use of eye movements for an acting system. Trends Cogn Sci. 25 (3), 252-263 (2021).

- Ayala, N., Kearns, S., Cao, S., Irving, E., Niechwiej-Szwedo, E. Investigating the role of flight phase and task difficulty on low-time pilot performance, gaze dynamics and subjective situation awareness during simulated flight. J Eye Mov Res. 17 (1), (2024).

- Land, M. F., Hayhoe, M. In what ways do eye movements contribute to everyday activities. Vision Res. 41 (25-26), 3559-3565 (2001).

- Ayala, N., Zafar, A., Niechwiej-Szwedo, E. Gaze behavior: a window into distinct cognitive processes revealed by the Tower of London test. Vision Res. 199, 108072 (2022).

- Ayala, N. The effects of task difficulty on gaze behavior during landing with visual flight rules in low-time pilots. J Eye Mov Res. 16, 10 (2023).

- Glaholt, M. G. . Eye tracking in the cockpit: a review of the relationships between eye movements and the aviators cognitive state. , (2014).

- Hodgson, T. L., Bajwa, A., Owen, A. M., Kennard, C. The strategic control of gaze direction in the Tower-of-London task. J Cognitive Neurosci. 12 (5), 894-907 (2000).

- van De Merwe, K., Van Dijk, H., Zon, R. Eye movements as an indicator of situation awareness in a flight simulator experiment. Int J Aviat Psychol. 22 (1), 78-95 (2012).

- Kok, E. M., Jarodzka, H. Before your very eyes: The value and limitations of eye tracking in medical education. Med Educ. 51 (1), 114-122 (2017).

- Di Stasi, L. L., et al. Gaze entropy reflects surgical task load. Surg Endosc. 30, 5034-5043 (2016).

- Laubrock, J., Krutz, A., Nübel, J., Spethmann, S. Gaze patterns reflect and predict expertise in dynamic echocardiographic imaging. J Med Imag. 10 (S1), S11906-S11906 (2023).

- Brams, S., et al. Does effective gaze behavior lead to enhanced performance in a complex error-detection cockpit task. PloS One. 13 (11), e0207439 (2018).

- Peißl, S., Wickens, C. D., Baruah, R. Eye-tracking measures in aviation: A selective literature review. Int J Aero Psych. 28 (3-4), 98-112 (2018).

- Ziv, G. Gaze behavior and visual attention: A review of eye tracking studies in aviation. Int J Aviat Psychol. 26 (3-4), 75-104 (2016).

- Ke, L., et al. Evaluating flight performance and eye movement patterns using virtual reality flight simulator. J. Vis. Exp. (195), e65170 (2023).

- Krejtz, K., et al. Gaze transition entropy. ACM Transactions on Applied Perception. 13 (1), 1-20 (2015).

- Taylor, R. M., Selcon, S. J. Cognitive quality and situational awareness with advanced aircraft attitude displays. Proceedings of the Human Factors Society Annual Meeting. 34 (1), 26-30 (1990).

- Ayala, N., et al. Does fiducial marker visibility impact task performance and information processing in novice and low-time pilots. Computers & Graphics. 199, 103889 (2024).

- Recarte, M. &. #. 1. 9. 3. ;., Pérez, E., Conchillo, &. #. 1. 9. 3. ;., Nunes, L. M. Mental workload and visual impairment: Differences between pupil, blink, and subjective rating. Spanish J Psych. 11 (2), 374-385 (2008).

- Zheng, B., et al. Workload assessment of surgeons: correlation between NASA TLX and blinks. Surg Endosc. 26, 2746-2750 (2012).

- Shannon, C. E. A mathematical theory of communication. The Bell System Technical Journal. 27 (3), 379-423 (1948).

- Shiferaw, B., Downey, L., Crewther, D. A review of gaze entropy as a measure of visual scanning efficiency. Neurosci Biobehav R. 96, 353-366 (2019).

- Ciuperca, G., Girardin, V. Estimation of the entropy rate of a countable Markov chain. Commun Stat-Theory and Methods. 36 (14), 2543-2557 (2007).

- Federal aviation administration. . Airplane flying handbook. , (2021).

- Brown, D. L., Vitense, H. S., Wetzel, P. A., Anderson, G. M. Instrument scan strategies of F-117A Pilots. Aviat, Space, Envir Med. 73 (10), 1007-1013 (2002).

- Lu, T., Lou, Z., Shao, F., Li, Y., You, X. Attention and entropy in simulated flight with varying cognitive loads. Aerosp Medicine Hum Perf. 91 (6), 489-495 (2020).

- Dehais, F., Peysakhovich, V., Scannella, S., Fongue, J., Gateau, T. "Automation surprise" in aviation: Real-time solutions. , 2525-2534 (2015).

- Kowler, E. Eye movements: The past 25 years. J Vis Res. 51 (13), 1457-1483 (2011).

- Zafar, A., et al. Investigation of camera-free eye-tracking glasses compared to a video-based system. Sensors. 23 (18), 7753 (2023).

- Leube, A., Rifai, K. Sampling rate influences saccade detection in mobile eye tracking of a reading task. J Eye Mov Res. 10 (3), (2017).

- Diaz-Piedra, C., et al. The effects of flight complexity on gaze entropy: An experimental study with fighter pilots. Appl Ergon. 77, 92-99 (2019).

- Shiferaw, B. A., et al. Stationary gaze entropy predicts lane departure events in sleep-deprived drivers. Sci Rep. 8 (1), 1-10 (2018).

- Parker, A. J., Kirkby, J. A., Slattery, T. J. Undersweep fixations during reading in adults and children. J Exp Child Psychol. 192, 104788 (2020).

- Ayala, N., Kearns, S., Irving, E., Cao, S., Niechwiej-Szwedo, E. The effects of a dual task on gaze behavior examined during a simulated flight in low-time pilots. Front Psychol. 15, 1439401 (2024).

- Ayala, N., Heath, M. Executive dysfunction after a sport-related concussion is independent of task-based symptom burden. J Neurotraum. 37 (23), 2558-2568 (2020).

- Huddy, V. C., et al. Gaze strategies during planning in first-episode psychosis. J Abnorm Psychol. 116 (3), 589 (2007).

- Irving, E. L., Steinbach, M. J., Lillakas, L., Babu, R. J., Hutchings, N. Horizontal saccade dynamics across the human life span. Invest Opth Vis Sci. 47 (6), 2478-2484 (2006).

- Yep, R., et al. Interleaved pro/anti-saccade behavior across the lifespan. Front Aging Neurosci. 14, 842549 (2022).

- Manoel, E. D. J., Connolly, K. J. Variability and the development of skilled actions. Int J Psychophys. 19 (2), 129-147 (1995).

转载和许可

请求许可使用此 JoVE 文章的文本或图形

请求许可探索更多文章

This article has been published

Video Coming Soon

版权所属 © 2025 MyJoVE 公司版权所有,本公司不涉及任何医疗业务和医疗服务。