JoVE 비디오를 활용하시려면 도서관을 통한 기관 구독이 필요합니다. 전체 비디오를 보시려면 로그인하거나 무료 트라이얼을 시작하세요.

Method Article

정보 처리에 대한 통찰력을 위한 복잡한 항공 작업 중 시선 추적

요약

시선추적은 정보 처리를 프로브하는 비침습적 방법입니다. 이 문서에서는 시선 추적을 사용하여 저시간 조종사(예: <350 비행 시간)의 비행 시뮬레이션 비상 작업 중 시선 행동을 연구하는 방법을 설명합니다.

초록

시선 추적은 기술 수행의 기초가 되는 인지적, 지각적, 감각적 운동 과정에 대한 통찰력을 얻기 위한 프록시로 광범위하게 사용되었습니다. 이전 연구에서는 기존 시선 메트릭과 고급 시선 메트릭이 조종사 전문 지식, 인지 부하, 피로 및 심지어 상황 인식(SA)에서 강력한 차이를 안정적으로 보여주는 것으로 나타났습니다.

본 연구는 고충실도 비행 모션 시뮬레이터에서 자연스러운 머리와 눈의 움직임(즉, 시선)을 캡처하는 웨어러블 시선추적기 및 시선 매핑 알고리즘을 사용하는 방법론을 설명합니다. 이 논문에서 설명한 방법은 참가자가 보는 위치와 관련된 더 많은 컨텍스트를 제공하는 AOI(Area of Interest) 기반 시선 분석과 고정된 정보를 얼마나 효율적으로 처리하고 있는지를 나타내는 체류 시간 기간을 설명합니다. 이 프로토콜은 웨어러블 시선 추적기 및 컴퓨터 비전 알고리즘의 유용성을 보여 주며 예상치 못한 기내 비상 사태에 대응하여 시선 행동의 변화를 평가합니다.

대표적인 결과는 비상 사태가 도입되었을 때 시선이 상당한 영향을 받았다는 것을 보여주었습니다. 구체적으로, 주의 할당, 시선 분산, 시선 순서 복잡성이 크게 감소하고 비상 시나리오 동안 앞 창문 밖과 대기 속도 게이지를 보는 데 고도로 집중되었습니다(모든 p 값은 0.05<). 시선 동작의 시공간 특성과 항공 분야의 정보 처리와의 관계를 이해하기 위해 충실도가 높은 움직임이 없는 비행 시뮬레이션 환경에서 웨어러블 시선 추적기를 사용하는 것의 유용성과 한계에 대해 논의합니다.

서문

인간은 주로 눈과 머리를 먼저 움직여 특정 물체나 관심 위치에 시선(즉, 시선)을 집중함으로써 주변 세계와 상호 작용합니다. 이는 조종사가 여러 경쟁 자극에 직면하는 항공기 조종석과 같은 복잡한 환경에서 특히 그렇습니다. 시선 이동은 인간이 안전하고 유연한 방식으로 환경과 상호 작용할 수 있도록 하는 고해상도 시각 정보를 수집할 수 있게 하며1, 이는 항공에서 가장 중요합니다. 연구에 따르면 안구 움직임과 시선 행동은 다양한 작업에 걸쳐 근본적인 지각, 인지 및 운동 과정에 대한 통찰력을 제공합니다 1,2,3. 더욱이, 우리가 보는 곳은 상지 움직임의 계획과 실행에 직접적인 영향을 미친다3. 따라서 항공 작업 중 시선 행동 분석은 객관적이고 비침습적인 방법을 제공하며, 이는 안구 운동 패턴이 정보 처리 및 수행의 다양한 측면과 어떻게 관련되어 있는지 밝힐 수 있습니다.

여러 연구에서 다양한 실험실 패러다임뿐만 아니라 복잡한 실제 작업(예: 항공기 작동)에 걸쳐 시선과 작업 수행 간의 연관성을 보여주었습니다. 예를 들어, 과제 관련 영역은 더 자주 그리고 더 긴 총 기간 동안 고정되는 경향이 있는데, 이는 고정 위치, 빈도 및 체류 시간이 신경인지 및 항공 과제에서 주의력 할당을 위한 프록시임을 시사합니다 4,5,6. 매우 성공적인 성과자와 전문가는 덜 성공적인 성과자 또는 초보자에 비해 업무가 중요한 영역에 대해 상당한 고정 편향을 보인다 4,7,8. 시선의 시공간적 측면은 다양한 관심 영역(AOI)에 걸친 체류 시간 패턴의 변화 또는 고정 분포 측정(예: 정지 시선 엔트로피: SGE)을 통해 포착됩니다. 실험실 기반 패러다임의 맥락에서 평균 고정 시간, 스캔 경로 길이 및 시선 시퀀스 복잡성(즉, 시선 전환 엔트로피: GTE)은 문제를 해결하고 더 어려운 작업 목표/솔루션을 정교화하는 데 필요한 스캔 및 처리가 증가하기 때문에 증가하는 경향이 있습니다 4,7.

반대로, 항공 연구는 스캔 경로 길이와 시선 시퀀스 복잡성이 작업 복잡성과 인지 부하에 따라 감소한다는 것을 보여주었습니다. 이러한 불일치는 작업 구성 요소와 사용되는 패러다임의 요구 사항을 이해하는 것이 시선 메트릭의 정확한 해석에 중요하다는 사실을 강조합니다. 현재까지의 연구는 시선 측정이 작업 난이도, 인지적 부하 및 작업 수행의 차이의 기초가 되는 작업별 정보 처리에 대한 의미 있고 객관적인 통찰력을 제공한다는 것을 뒷받침합니다. 시선 추적 기술(즉, 휴대성, 보정 및 비용)의 발전으로 '야생'에서 시선 행동을 조사하는 것은 의학 9,10,11 및 항공 12,13,14 분야에서 직업 훈련을 발전시키는 데 가시적인 응용 프로그램을 가진 새로운 연구 분야입니다.

현재 연구는 저시간 조종사의 비상 비행 시뮬레이션 작업 중에 웨어러블 시선 추적기를 특별히 사용하여 정보 처리에 대한 통찰력을 얻기 위해 시선 기반 메트릭을 사용하는 유용성을 추가로 조사하는 것을 목표로 합니다. 이 연구는 머리 안정화 시선 추적기(예: EyeLink II)를 사용하여 비행 난이도(즉, 기상 조건의 변화)의 함수로 시선 행동 지표의 차이를 조사한 이전 연구를 확장합니다5. 이 원고에 제시된 연구는 가상 현실 시스템에서 시선 추적을 사용하기 위한 방법론적, 분석적 접근 방식을 설명한 다른 연구에도 확장됩니다15. 본 연구는 충실도가 높은 무동작 시뮬레이터를 사용했으며 안구 운동 데이터(즉, 엔트로피)에 대한 추가 분석을 보고합니다. 이러한 유형의 분석은 이전 논문에서 보고되었습니다. 그러나 현재 문헌의 한계는 분석 단계 보고에 대한 표준화가 부족하다는 것입니다. 예를 들어, 관심 영역이 어떻게 정의되는지를 보고하는 것은 결과 엔트로피 값16에 직접적인 영향을 미치기 때문에 매우 중요합니다.

요약하자면, 현재 연구는 기내 비상 시나리오(즉, 예기치 않은 전체 엔진 고장)의 도입을 통해 작업 난이도를 조작하는 동안 전통적이고 역동적인 시선 행동 지표를 조사했습니다. 기내 비상 시나리오의 도입은 더 어려운 작업 조건에서 정보 처리의 기초가 되는 시선 행동 변화에 대한 통찰력을 제공할 것으로 예상되었습니다. 여기에 보고된 연구는 역량 기반 조종사 훈련을 알리기 위해 비행 시뮬레이터에서 시선 추적의 유용성을 조사하는 더 큰 연구의 일부입니다. 여기에 제시된 결과는 이전에 발표된 적이 없습니다.

프로토콜

다음 프로토콜은 웨어러블 시선 추적기 및 비행 시뮬레이터와 관련된 연구에 적용할 수 있습니다. 현재 연구는 비행 시뮬레이터에서 복잡한 항공 관련 작업과 함께 기록된 시선 추적 데이터와 관련이 있습니다( 재료 표 참조). 시뮬레이터는 Cessna 172를 대표하도록 구성되었으며 필요한 계기판(증기 게이지 구성), 항공 전자 공학/GPS 시스템, 오디오/조명 패널, 차단기 패널 및 비행 제어 장치(FCU)와 함께 사용되었습니다( 그림 1 참조). 이 연구에 사용된 비행 시뮬레이터 장치는 교육 목적으로 인증될 수 있으며 지역 비행 학교에서 저위험 환경에서 엔진 고장과 같은 다양한 비상 시나리오에 대응하는 데 필요한 기술을 훈련하는 데 사용됩니다. 이 연구의 참가자는 모두 면허를 취득했습니다. 따라서 그들은 이전에 교육 과정에서 엔진 고장 시뮬레이터 시나리오를 경험했습니다. 이 연구는 워털루 대학의 연구 윤리 사무국(Office of Research Ethics, 43564; 날짜: 2021년 11월 17일). 모든 참가자(N = 24명, 남성 14명, 여성 10명, 평균 연령 = 22세, 비행 시간 범위: 51-280시간)는 서면 동의서를 제공했습니다.

그림 1: 비행 시뮬레이터 환경. 비행 시뮬레이터 환경을 보여 줍니다. 조종석에 대한 참가자의 관점은 캘리포니아 온타리오주 브레슬라우에 있는 워털루 국제공항에 대한 하향풍에서 기지에서 최종 접근 방식으로 사전 설정된 Cessna 172를 조종하는 조종사의 관점을 복제했습니다. 주황색 상자는 시선 분석에 사용되는 10가지 주요 관심 영역을 나타냅니다. 여기에는 (1) 속도, (2) 자세, (3) 고도계, (4) 회전 코디네이터, (5) 방향, (6) 수직 속도 및 (7) 전원 표시기와 (8) 전면, (9) 왼쪽 및 (10) 오른쪽 창이 포함됩니다. 이 수치는 Ayala et al.5에서 수정되었습니다. 이 그림의 더 큰 버전을 보려면 여기를 클릭하십시오.

1. 참가자 심사 및 사전 동의

- 포함/제외 기준 2,5: 최소한 개인 조종사 면허(PPL) 소지, 정상 또는 정상으로 교정된 시력, 신경 정신과적/신경 장애 또는 학습 장애에 대한 이전 진단이 없음에 따라 자가 보고 설문지를 통해 참가자를 선별합니다.

- 실험자와 감독 비행 강사/시뮬레이터 기술자가 처리하는 자세한 브리핑을 통해 참가자에게 연구 목적과 절차에 대해 알립니다. 기관의 윤리 검토 위원회에서 승인한 동의 문서에 설명된 위험을 검토합니다. 잠재적 위험에 대한 모든 질문에 답합니다. 연구 절차를 시작하기 전에 서면 동의서를 받으십시오.

2. 하드웨어/소프트웨어 요구 사항 및 시작

- 비행 시뮬레이터(일반적으로 시뮬레이터 기술자가 완료)

- 시뮬레이터와 프로젝터 스크린을 켭니다. 프로젝터 중 하나가 다른 프로젝터와 동시에 켜지지 않으면 시뮬레이터를 다시 시작하십시오.

- Instruction Screen(지시 화면)에서 Presets(사전 설정) 탭을 누르고 필요한 위치 및/또는 날씨 사전 설정을 사용할 수 있는지 확인합니다. 필요한 경우 새 유형의 사전 설정을 만듭니다. 도움이 필요하면 기술자에게 문의하십시오.

- 제품분류 laptop

- 노트북을 켜고 자격 증명으로 로그인합니다.

- 메시지가 표시되면 기존 프로필을 선택하거나 새 참가자를 테스트하는 경우 프로필을 만듭니다. 또는 게스트 옵션을 선택하여 마지막 보정을 덮어씁니다.

- 새 프로필을 만들려면 프로필 목록의 끝으로 스크롤하고 추가를 클릭합니다.

- 프로필 ID를 참가자 ID로 설정합니다. 이 프로필 ID는 기록이 완료된 후 시선 추적 데이터가 들어 있는 폴더에 태그를 지정하는 데 사용됩니다.

- 안경 교정

참고: 녹화하려면 안경이 노트북에 연결되어 있어야 합니다. 상자를 사용한 보정은 데이터 수집을 시작할 때 한 번만 완료하면 됩니다.- 아이트래커 케이스를 열고 안경을 꺼냅니다.

- 노트북에서 유리잔으로 USB-micro-USB 케이블을 연결합니다. 랩톱에 메시지가 표시되면 펌웨어를 업데이트합니다.

- 아이 트래커 케이스 내부에서 검은색 보정 상자를 찾습니다.

- 컬렉션 노트북의 시선 추적 허브에서 Tools(도구) | 장치 보정.

- 안경을 상자 안에 넣고 팝업 창에서 시작을 눌러 보정을 시작합니다.

- 보정이 완료되면 상자에서 안경을 꺼냅니다.

- 노즈피스 핏

- 노즈피스를 선택합니다.

- 참가자에게 조종석에 앉아 안경을 쓰도록 지시합니다.

- 시선 추적 허브에서 파일 | 설정 | 코 마법사.

- 화면 왼쪽에 있는 안경 상자의 핏 을 확인합니다. 적합도가 우수이면 다음 단계로 진행합니다. 그렇지 않으면 상자를 클릭합니다.

- 참가자에게 화면에 표시된 핏 권장 지침을 따르라고 말합니다: 노즈피스를 설정하고, 편안하게 앉을 수 있도록 안경을 조정하고, 노트북을 똑바로 바라보세요.

- 필요한 경우 노즈피스를 교체합니다. 노즈피스의 가운데를 끼우고 안경에서 밀어낸 다음 다른 노즈피스를 밀어 넣습니다. 참가자에게 가장 적합한 것이 식별될 때까지 다른 노즈피스를 계속 테스트합니다.

- 항공 교통 관제(ATC) 호출

참고: 연구에서 ATC 통화가 필요한 경우, 참가자가 자신의 헤드셋을 가져오거나 실험실 헤드셋을 사용하도록 합니다. 헤드셋이 머리의 안경을 움직일 수 있으므로 참가자가 헤드셋을 착용한 후에만 안구 보정을 완료해야 하며, 이는 보정 정확도에 영향을 미칩니다.- 헤드셋이 계기판의 왼쪽 아래쪽에 있는 잭에 연결되어 있는지 확인합니다.

- 참가자에게 헤드셋을 착용하도록 지시합니다. 녹음이 끝날 때까지 만지거나 벗지 말라고 요청하십시오.

알림: 헤드셋(따라서 안경)을 이동할 때마다 재보정이 필요합니다. - 라디오 확인을 합니다.

- 안구 보정

참고: 참가자가 머리에 쓴 안경을 바꿀 때마다 안구 보정을 반복해야 합니다. 참가자에게 시험이 끝날 때까지 안경을 만지지 않도록 요청하십시오.- 시선 추적 허브에서 화면 왼쪽의 매개 변수 상자로 이동합니다.

- 보정 모드를 확인하고 그에 따라 고정 응시 또는 고정 헤드를 선택합니다.

- 보정 포인트가 총 25개 포인트에 대해 5 x 5 그리드인지 확인합니다.

- 검증 모드를 확인하고 보정 모드와 일치하는지 확인하십시오.

- 시선 추적 출력을 검사하고 연구를 위해 기록해야 하는 모든 것이 체크 상자를 사용하여 선택되었는지 확인합니다.

- 딸깍 하는 소리F ile | 설정 | 고급을 선택하고 샘플링 속도가 250Hz인지 확인합니다.

- 마우스를 사용하여 화면에서 시선 추적 보정 상자를 선택합니다. 보정 지침은 모드에 따라 다릅니다. 현재 연구를 따르려면 고정 시선 보정 모드를 사용하십시오: 참가자에게 상자가 검은색 사각형과 겹치고 정렬되도록 머리를 움직이도록 지시합니다. 그런 다음 참가자에게 검은색 사각형의 십자선에 시선을 집중하고 스페이스 바를 누르도록 요청합니다.

- 설정 확인 상자를 누릅니다. 지침은 2.6.3단계와 동일합니다. 검증 지수 MAE(Mean Absolute Error)가 <1°인지 확인합니다. 그렇지 않은 경우 2.6.3 및 2.6.4단계를 반복합니다.

- Save Calibration(보정 저장)을 눌러 보정 및 검증이 완료될 때마다 프로필에 보정을 저장합니다.

- 시선 추적 허브에서 화면 왼쪽의 매개 변수 상자로 이동합니다.

- iPad 사용 현황

알림: iPad는 계기판의 왼쪽에 있습니다( 그림 1 참조). 일반적으로 비행 후 설문지에 사용됩니다.- iPad를 켜고 인터넷에 연결되어 있는지 확인합니다.

- Safari에서 창을 열고 연구 설문지 링크를 입력합니다.

3. 데이터 수집

참고: 각 평가판에 대해 이 단계를 반복합니다. 노트북은 조종석 밖의 벤치에 놓는 것이 좋습니다.

- 비행 시뮬레이터 컴퓨터의 지침 화면에서 Presets를 누른 다음 시뮬레이션할 원하는 Position 사전 설정을 선택합니다. 적용 단추를 누르고 시뮬레이터를 둘러싼 화면을 보고 변경 사항이 발생하는지 확인합니다.

- 3.1단계를 반복하여 날씨 사전 설정을 적용합니다.

- 참가자에게 시험 또는 비행 경로에 대한 구체적인 지침을 제공합니다. 여기에는 시작하기 전에 계기판의 설정을 변경하라는 지시가 포함됩니다.

- 안내 화면에서 주황색 STOPPED 버튼을 눌러 데이터 수집을 시작합니다. 색상이 녹색으로 변경되고 텍스트가 FLYING으로 표시됩니다. 참가자가 항공기 비행을 시작할 수 있다는 것을 알 수 있도록 참가자에게 구두 신호를 보내야 합니다. 권장 신호는 주황색 정지 버튼을 눌렀을 때 "3, 2, 1, 컨트롤이 있습니다"입니다.

- 수집 노트북에서 녹화 시작을 눌러 시선 추적기 데이터가 비행 시뮬레이터 데이터와 동기화되도록 합니다.

- 참가자가 회로를 완료하고 착륙하면 항공기가 움직임을 멈출 때까지 기다립니다.

참고: 후처리 중에는 기다리는 것이 중요합니다. 지면 속도가 0으로 설정되면 데이터가 잘립니다. 이렇게 하면 모든 시도의 종점에 일관성을 유지할 수 있습니다. - 안내 화면에서 녹색 FLYING 버튼을 누릅니다. 색상이 주황색으로 돌아가고 텍스트가 STOPPED로 표시됩니다. 이 단계에서 데이터 수집이 끝나려고 할 때 구두 신호를 제공합니다. 권장 신호는 "3, 2, 1, 정지"입니다.

- 참가자에게 iPad에서 재판 후 설문지를 작성하도록 지시합니다. 다음 평가판을 위해 페이지를 새로 고칩니다.

참고: 본 연구에서는 SART(Situation Awareness Rating Technique)의 자기평가 설문지를 유일한 재판 후 설문지로 사용했다17.

4. 데이터 처리 및 분석

- 비행 시뮬레이터 데이터

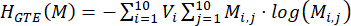

참고: 비행 시뮬레이터에서 복사된 .csv 파일에는 시뮬레이터에서 제어할 수 있는 1,000개 이상의 매개변수가 포함되어 있습니다. 관심 있는 주요 성능 측정은 표 1에 나열되고 설명되어 있습니다.- 각 참가자에 대해 작업 조건 전반의 백분율을 취하여 Eq (1)를 사용하여 성공률을 계산합니다. 실패한 시도는 시뮬레이터 내에 프로그래밍된 미리 결정된 기준에 의해 식별되며, 비행기 방향 및 수직 속도로 인해 착륙 시 시도가 자동으로 종료됩니다. 이 기준이 실제 항공기 제한과 일치하는지 확인하기 위해 재판 후 검증을 수행합니다(즉, Cessna 172 랜딩 기어 손상/충돌은 착륙 시 700피트/분[fpm]> 수직 속도에서 분명함).

성공률 = (1)

(1)

참고: 성공률 값이 낮을수록 성공적인 착륙 시도의 감소와 관련이 있으므로 결과가 더 나쁘다는 것을 나타냅니다. - 각 시도에 대해 비행기가 활주로에서 멈췄음을 나타내는 타임스탬프를 기반으로 완료 시간을 계산합니다(즉, GroundSpeed = 0노트).

참고: 완료 시간이 짧다고 해서 항상 성능이 향상되는 것은 아닙니다. 작업 조건(예: 추가 바람, 비상 시나리오 등)이 완료 시간에 어떤 영향을 미칠 것으로 예상되는지 이해하려면 주의를 기울여야 합니다. - 각 시도에 대해 항공기가 활주로에 처음 착륙할 때의 항공기 수직 속도(fpm)를 기준으로 착륙 경도 를 결정합니다. 이 값이 AircraftOnGround 상태의 첫 번째 변경과 연결된 동일한 타임스탬프에서 0 (공중)에서 1 (지상)로 변경되는지 확인합니다.

참고: -700 fpm 에서 0 fpm 사이의 값은 안전한 것으로 간주되며, 0에 가까운 값은 더 부드러운 착륙(즉, 더 좋음)을 나타냅니다. 음수 값은 하향 수직 속도를 나타냅니다. 양수 값은 수직 상향 속도를 나타냅니다. - 각 시도에 대해 터치다운 좌표와 활주로의 기준점(500피트 마커의 중심) 간의 차이를 기반으로 착륙 오류(°) 를 계산합니다. 기준점을 사용하여 Eq (2)를 사용하여 착륙 오류를 계산합니다.

차이 = √((Δ 위도)2 + (Δ 경도)2) (2)

참고: 1° 미만의 값은 정상 5,15로 표시됩니다. 값이 크면 착륙 구역에서 더 멀리 떨어진 항공기 착륙 지점과 관련된 더 큰 착륙 오류를 나타냅니다. - 각 작업 조건에 대한 각 성과 결과 변수에 대한 모든 참가자의 평균을 계산합니다. 이러한 값을 보고합니다.

- 각 참가자에 대해 작업 조건 전반의 백분율을 취하여 Eq (1)를 사용하여 성공률을 계산합니다. 실패한 시도는 시뮬레이터 내에 프로그래밍된 미리 결정된 기준에 의해 식별되며, 비행기 방향 및 수직 속도로 인해 착륙 시 시도가 자동으로 종료됩니다. 이 기준이 실제 항공기 제한과 일치하는지 확인하기 위해 재판 후 검증을 수행합니다(즉, Cessna 172 랜딩 기어 손상/충돌은 착륙 시 700피트/분[fpm]> 수직 속도에서 분명함).

- 상황 인식 데이터

- 각 임상시험에 대해 SA17의 10개 차원에서 자가 보고된 SART 점수를 기반으로 SA 점수를 계산합니다.

- SART 설문지17 을 사용하여 전반적인 과제 난이도에 대한 참가자의 주관적인 응답과 과제 수행 중에 얼마나 많은 주의 자원을 사용할 수 있고 소비했는지에 대한 인상을 확인하십시오.

- 7점 리커트 척도를 사용하여 참가자들에게 상황의 복잡성, 주의력 분산, 여분의 정신 능력, 정보의 양과 질을 포함하여 탐구 질문에 대해 인식된 경험을 평가하도록 요청합니다.

- 이러한 척도를 주의 요구(Demand), 주의 공급(Supply) 및 상황 이해(Understanding)의 더 큰 차원으로 결합합니다.

- 다음 등급을 사용하여 Eq (3)를 기반으로 SA 측정값을 계산합니다.

SA = 이해 - (수요-공급) (3)

참고: 이해도의 척도를 제공하기 위해 결합된 척도에서 더 높은 점수는 참가자가 당면한 과제에 대해 잘 이해하고 있음을 나타냅니다. 마찬가지로, 공급 영역에서 높은 점수는 참가자가 주어진 작업에 할애할 수 있는 상당한 양의 주의 자원이 있음을 시사합니다. 반대로, 높은 수요 점수는 작업을 완료하는 데 상당한 양의 주의 리소스가 필요하다는 것을 나타냅니다. 이러한 점수는 독립적인 척도로 사용되는 대신 여러 조건(즉, 쉬운 조건과 어려운 조건)에 걸쳐 비교할 때 가장 잘 해석된다는 점을 명확히 하는 것이 중요합니다.

- 데이터 수집이 완료되면 각 작업 조건(예: 기본, 비상 사태)에 대한 모든 참가자의 평균을 계산합니다. 이러한 값을 보고합니다.

- 각 임상시험에 대해 SA17의 10개 차원에서 자가 보고된 SART 점수를 기반으로 SA 점수를 계산합니다.

- 시선 추적 데이터

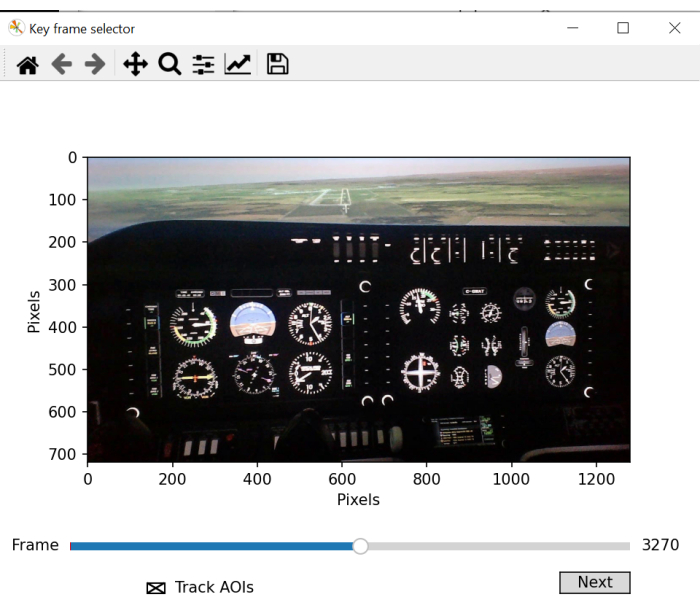

- 시선 추적 배치 스크립트를 사용하여 시선 매핑에 사용할 AOI를 수동으로 정의합니다. 스크립트는 분석할 모든 주요 AOI를 명확하게 표시해야 하는 키 프레임 선택을 위한 새 창을 엽니다. 비디오를 스크롤하여 모든 AOI를 명확하게 보여주는 프레임을 선택합니다.

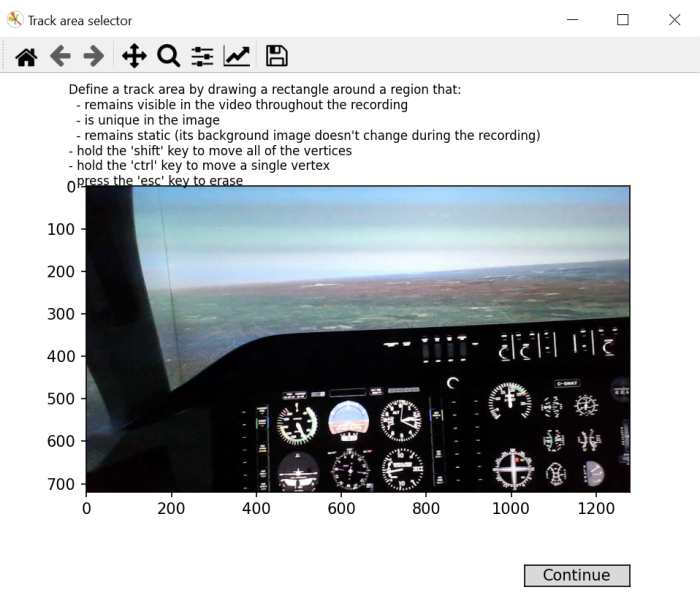

- 화면의 지시에 따라 전체 비디오에서 볼 수 있고 고유하며 안정적으로 유지되는 프레임 영역에 사각형을 그립니다.

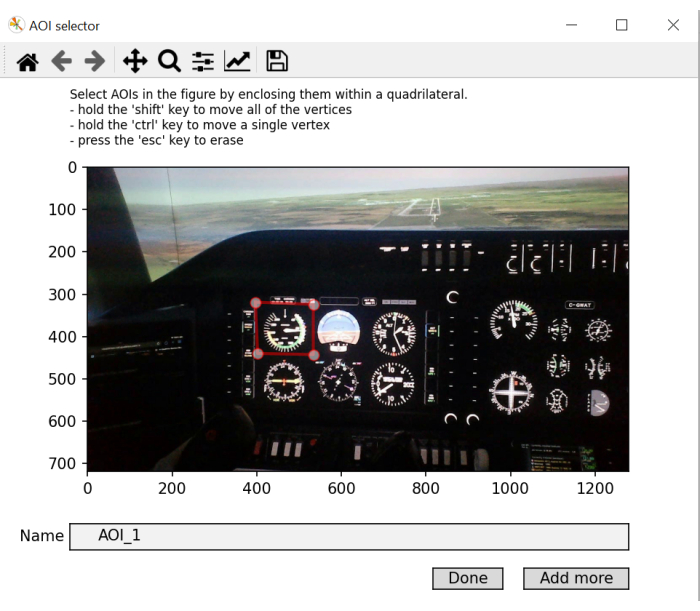

참고: 이 단계의 목적은 머리의 움직임으로 인해 비디오 녹화가 진행되는 동안 환경에서 물체의 위치가 변경되기 때문에 비디오 녹화 전반에 걸쳐 사용할 수 있는 "화면내" 좌표 프레임을 생성하는 것입니다. - 그림의 각 AOI에 대해 한 번에 하나씩 사각형을 그립니다. 그에 따라 이름을 지정하십시오. 추가를 클릭하여 새 AOI를 추가하고 마지막 AOI에서 완료 를 누릅니다. 주어진 고정 중 시선 좌표가 "in-screen" 좌표 프레임에 정의된 개체 공간 내에 있는 경우 해당 고정에 해당 AOI 레이블로 레이블을 지정합니다.

참고: 이 단계의 목적은 응시 좌표를 화면 내 좌표와 비교할 때 참조로 사용되는 개체 좌표 라이브러리를 생성하는 것입니다.

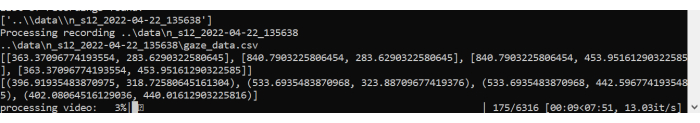

일반적으로 10개의 AOI가 있지만 이는 비행 시뮬레이터가 어떻게 구성되었는지에 따라 다릅니다. 계기판은 다를 수 있습니다. 이전 작업 5,18에 따라 현재 연구는 Airspeed, Attitude, Altimeter, Turn Coordinator, Heading, Vertical Speed, Power, Front Window, Left Window 및 Right Window와 같은 AOI를 사용합니다(그림 1 참조). - 스크립트가 AOI 처리를 시작하고 고정 데이터를 생성하도록 합니다. 비디오에 대한 단속과 고정을 보여주는 플롯을 생성합니다.

- fixations.csv 및 aoi_parameters.yaml이라는 두 개의 새 파일이 생성됩니다. 배치 프로세서는 각 시도 및 각 참가자에 대한 응시 데이터의 사후 처리를 완료합니다.

참고: 관심 있는 주요 시선 추적 측정값은 표 2 에 나열되어 있으며 각 시도의 각 AOI에 대해 계산됩니다. - 각 시도에 대해 fixation.csv 파일에서 생성된 데이터를 기반으로 각 AOI에 대한 기존 시선 메트릭 4,5를 계산합니다.

참고: 여기서는 특정 AOI에 대한 고정 합계를 모든 고정 합계로 나누고 몫에 100을 곱하여 특정 AOI에서 보낸 시간 백분율을 구하여 계산하는 체류 시간(%)에 중점을 둡니다. 계산된 체류 시간에서 내재된 부정적/긍정적 해석은 없습니다. 그들은 주의가 주로 할당되는 위치를 나타냅니다. 평균 고정 기간이 길다는 것은 가공 수요가 증가했음을 나타냅니다. - 각 시도에 대해 Eq(4)를 사용하여 깜박임 속도를 계산합니다.

깜박임 속도 = 총 깜박임/완료 시간(4)

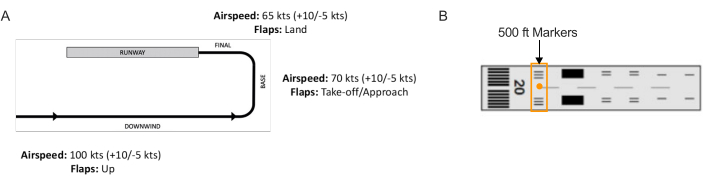

참고: 이전 연구에서는 깜박임 속도가 인지 부하 2,6,13,19,20과 반비례하는 것으로 나타났습니다. - 각 시도에 대해 식 (5)21을 사용하여 SGE를 계산합니다.

(5)

(5)

여기서, v 는 i번째 AOI를 볼 확률이고, V 는 AOI의 개수이다.

참고: SGE 값이 높을수록 고정 분산이 더 커지는 반면, 값이 낮을수록 고정22가 더 집중적으로 할당되었음을 나타냅니다. - 각 시행에 대해 식 (6)23을 사용하여 GTE를 계산합니다.

(6)

(6)

여기서, V는 i번째 AOI를 시청할 확률이고, M은 i번째 AOI를 이전에 시청한 경우 j번째 AOI를 시청할 확률이다.

참고: GTE 값이 높을수록 예측할 수 없고 복잡한 시각적 스캔 경로와 관련이 있는 반면, GTE 값이 낮을수록 예측 가능하고 일상적인 시각적 스캔 경로를 나타냅니다. - 각 시선 추적 출력 변수(표시된 경우 AOI) 및 각 작업 조건에 대한 모든 참가자의 평균 을 계산합니다. 이러한 값을 보고합니다.

| 학기 | 정의 |

| 성공(%) | 성공적인 착륙 시도의 비율 |

| 완료 시간 (초) | 착륙 시나리오가 시작된 시점부터 비행기가 활주로에서 완전히 정지할 때까지의 시간 |

| 착륙 경도 (fpm) | 터치다운 시점에서 적절한 비율 |

| 착륙 오류(°) | 착륙 지점에서 비행기의 중심과 500피트 활주로 마커의 중심의 차이 |

표 1: 시뮬레이터 성능 결과 변수. 항공기 성능 종속 변수 및 해당 정의.

그림 2: 착륙 시나리오의 비행 경로. (A) 모든 시험에서 완료된 착륙 회로와 (B) 착륙 구역의 기준점으로 사용된 500피트 마커가 있는 활주로(즉, 중앙 주황색 원)의 개략도. 이 그림의 더 큰 버전을 보려면 여기를 클릭하십시오.

그림 3: 관심 영역 매핑. 프레임 선택을 위한 창을 보여 주는 배치 스크립트의 그림입니다. 최적의 프레임을 선택하려면 매핑할 관심 영역의 대부분 또는 전부를 포함하는 비디오 프레임을 선택하는 작업이 포함됩니다. 이 그림의 더 큰 버전을 보려면 여기를 클릭하십시오.

그림 4: "in-screen" 좌표를 매핑하는 관심 영역 생성. "화면내" 좌표 선택을 위한 창을 보여 주는 배치 스크립트의 그림입니다. 이 단계에는 기록 전체에서 계속 볼 수 있고, 이미지에 고유하며, 정적으로 유지되는 정사각형/직사각형 영역을 선택하는 작업이 포함됩니다. 이 그림의 더 큰 버전을 보려면 여기를 클릭하십시오.

그림 5: 매핑할 관심 영역 식별. 관심 영역을 선택하고 레이블을 지정할 수 있는 배치 스크립트 창의 그림입니다. 약어 : AOIs = 관심 영역. 이 그림의 더 큰 버전을 보려면 여기를 클릭하십시오.

그림 6: 배치 스크립트 처리. 배치 스크립트의 그림, 비디오 및 시선을 처리하고, 재판 전반에 걸쳐 이루어진 고정을 매핑합니다. 이 그림의 더 큰 버전을 보려면 여기를 클릭하십시오.

| 학기 | 정의 |

| 체류 시간(%) | 모든 AOI에 대해 누적된 고정 기간의 합에 대한 모든 AOI에 대해 누적된 모든 고정 기간의 합에 대한 백분율 |

| 평균 고정 시간(ms) | 진입부터 퇴장까지 하나의 AOI에 대한 고정의 평균 지속 시간 |

| 깜박임 속도(깜박임/초) | 초당 깜박임 횟수 |

| SGE(비트) | 정착 분산 |

| GTE(비트) | 스캔 시퀀스 복잡성 |

| 시합 횟수 | 인지 터널링 이벤트 수(>10초) |

| 총 시합 시간(초) | 인지 터널링 이벤트의 총 시간 |

표 2: 시선 추적 결과 변수. 행동 종속 변수와 그 정의를 응시합니다.

결과

작업 요구가 비행 성능에 미치는 영향

데이터는 기본 및 비상 상황에 대한 성공적인 착륙 시험을 기반으로 분석되었습니다. 모든 측정은 쌍을 이룬 표본의 t-검정(피험자 내 요인: 작업 상태(기본, 비상))을 적용했습니다. 모든 t-검정은 알파 수준을 0.05로 설정하여 수행되었습니다. 응급 시나리오 임상시험 중 4명의 참가자가 추락했으며, 희소 ?...

토론

여기에 설명된 시선 추적 방법을 사용하면 웨어러블 시선 추적기를 통해 비행 시뮬레이터 환경에서 정보 처리를 평가할 수 있습니다. 시선 행동의 공간적, 시간적 특성을 평가하면 고도로 통제된 실험실 패러다임 4,7,28을 사용하여 광범위하게 연구된 인간 정보 처리에 대한 통찰력을 얻을 수 있습니다...

공개

경쟁하는 재정적 이해관계가 존재하지 않습니다.

감사의 말

이 작업은 캐나다 자연과학 및 공학 연구 위원회(NSERC)의 캐나다 대학원 장학금(CGS)과 연구 기금의 New Frontiers in Research Fund의 탐사 보조금(00753)의 지원을 받습니다. 이 자료에 표현된 모든 의견, 연구 결과, 결론 또는 권장 사항은 저자의 것이며 반드시 의뢰자의 의견을 반영하는 것은 아닙니다.

자료

| Name | Company | Catalog Number | Comments |

| flight simulator | ALSIM | AL-250 | fixed fully immersive flight simulation training device |

| laptop | Hp | Lenovo | eye tracking data collection laptop; requirements: Windows 10 and python 3.0 |

| portable eye-tracker | AdHawk | MindLink eye tracking glasses (250 Hz, <2° gaze error, front-facing camera); eye tracking batch script is made available with AdHawk device purchase |

참고문헌

- de Brouwer, A. J., Flanagan, J. R., Spering, M. Functional use of eye movements for an acting system. Trends Cogn Sci. 25 (3), 252-263 (2021).

- Ayala, N., Kearns, S., Cao, S., Irving, E., Niechwiej-Szwedo, E. Investigating the role of flight phase and task difficulty on low-time pilot performance, gaze dynamics and subjective situation awareness during simulated flight. J Eye Mov Res. 17 (1), (2024).

- Land, M. F., Hayhoe, M. In what ways do eye movements contribute to everyday activities. Vision Res. 41 (25-26), 3559-3565 (2001).

- Ayala, N., Zafar, A., Niechwiej-Szwedo, E. Gaze behavior: a window into distinct cognitive processes revealed by the Tower of London test. Vision Res. 199, 108072 (2022).

- Ayala, N. The effects of task difficulty on gaze behavior during landing with visual flight rules in low-time pilots. J Eye Mov Res. 16, 10 (2023).

- Glaholt, M. G. . Eye tracking in the cockpit: a review of the relationships between eye movements and the aviators cognitive state. , (2014).

- Hodgson, T. L., Bajwa, A., Owen, A. M., Kennard, C. The strategic control of gaze direction in the Tower-of-London task. J Cognitive Neurosci. 12 (5), 894-907 (2000).

- van De Merwe, K., Van Dijk, H., Zon, R. Eye movements as an indicator of situation awareness in a flight simulator experiment. Int J Aviat Psychol. 22 (1), 78-95 (2012).

- Kok, E. M., Jarodzka, H. Before your very eyes: The value and limitations of eye tracking in medical education. Med Educ. 51 (1), 114-122 (2017).

- Di Stasi, L. L., et al. Gaze entropy reflects surgical task load. Surg Endosc. 30, 5034-5043 (2016).

- Laubrock, J., Krutz, A., Nübel, J., Spethmann, S. Gaze patterns reflect and predict expertise in dynamic echocardiographic imaging. J Med Imag. 10 (S1), S11906-S11906 (2023).

- Brams, S., et al. Does effective gaze behavior lead to enhanced performance in a complex error-detection cockpit task. PloS One. 13 (11), e0207439 (2018).

- Peißl, S., Wickens, C. D., Baruah, R. Eye-tracking measures in aviation: A selective literature review. Int J Aero Psych. 28 (3-4), 98-112 (2018).

- Ziv, G. Gaze behavior and visual attention: A review of eye tracking studies in aviation. Int J Aviat Psychol. 26 (3-4), 75-104 (2016).

- Ke, L., et al. Evaluating flight performance and eye movement patterns using virtual reality flight simulator. J. Vis. Exp. (195), e65170 (2023).

- Krejtz, K., et al. Gaze transition entropy. ACM Transactions on Applied Perception. 13 (1), 1-20 (2015).

- Taylor, R. M., Selcon, S. J. Cognitive quality and situational awareness with advanced aircraft attitude displays. Proceedings of the Human Factors Society Annual Meeting. 34 (1), 26-30 (1990).

- Ayala, N., et al. Does fiducial marker visibility impact task performance and information processing in novice and low-time pilots. Computers & Graphics. 199, 103889 (2024).

- Recarte, M. &. #. 1. 9. 3. ;., Pérez, E., Conchillo, &. #. 1. 9. 3. ;., Nunes, L. M. Mental workload and visual impairment: Differences between pupil, blink, and subjective rating. Spanish J Psych. 11 (2), 374-385 (2008).

- Zheng, B., et al. Workload assessment of surgeons: correlation between NASA TLX and blinks. Surg Endosc. 26, 2746-2750 (2012).

- Shannon, C. E. A mathematical theory of communication. The Bell System Technical Journal. 27 (3), 379-423 (1948).

- Shiferaw, B., Downey, L., Crewther, D. A review of gaze entropy as a measure of visual scanning efficiency. Neurosci Biobehav R. 96, 353-366 (2019).

- Ciuperca, G., Girardin, V. Estimation of the entropy rate of a countable Markov chain. Commun Stat-Theory and Methods. 36 (14), 2543-2557 (2007).

- Federal aviation administration. . Airplane flying handbook. , (2021).

- Brown, D. L., Vitense, H. S., Wetzel, P. A., Anderson, G. M. Instrument scan strategies of F-117A Pilots. Aviat, Space, Envir Med. 73 (10), 1007-1013 (2002).

- Lu, T., Lou, Z., Shao, F., Li, Y., You, X. Attention and entropy in simulated flight with varying cognitive loads. Aerosp Medicine Hum Perf. 91 (6), 489-495 (2020).

- Dehais, F., Peysakhovich, V., Scannella, S., Fongue, J., Gateau, T. "Automation surprise" in aviation: Real-time solutions. , 2525-2534 (2015).

- Kowler, E. Eye movements: The past 25 years. J Vis Res. 51 (13), 1457-1483 (2011).

- Zafar, A., et al. Investigation of camera-free eye-tracking glasses compared to a video-based system. Sensors. 23 (18), 7753 (2023).

- Leube, A., Rifai, K. Sampling rate influences saccade detection in mobile eye tracking of a reading task. J Eye Mov Res. 10 (3), (2017).

- Diaz-Piedra, C., et al. The effects of flight complexity on gaze entropy: An experimental study with fighter pilots. Appl Ergon. 77, 92-99 (2019).

- Shiferaw, B. A., et al. Stationary gaze entropy predicts lane departure events in sleep-deprived drivers. Sci Rep. 8 (1), 1-10 (2018).

- Parker, A. J., Kirkby, J. A., Slattery, T. J. Undersweep fixations during reading in adults and children. J Exp Child Psychol. 192, 104788 (2020).

- Ayala, N., Kearns, S., Irving, E., Cao, S., Niechwiej-Szwedo, E. The effects of a dual task on gaze behavior examined during a simulated flight in low-time pilots. Front Psychol. 15, 1439401 (2024).

- Ayala, N., Heath, M. Executive dysfunction after a sport-related concussion is independent of task-based symptom burden. J Neurotraum. 37 (23), 2558-2568 (2020).

- Huddy, V. C., et al. Gaze strategies during planning in first-episode psychosis. J Abnorm Psychol. 116 (3), 589 (2007).

- Irving, E. L., Steinbach, M. J., Lillakas, L., Babu, R. J., Hutchings, N. Horizontal saccade dynamics across the human life span. Invest Opth Vis Sci. 47 (6), 2478-2484 (2006).

- Yep, R., et al. Interleaved pro/anti-saccade behavior across the lifespan. Front Aging Neurosci. 14, 842549 (2022).

- Manoel, E. D. J., Connolly, K. J. Variability and the development of skilled actions. Int J Psychophys. 19 (2), 129-147 (1995).

재인쇄 및 허가

JoVE'article의 텍스트 или 그림을 다시 사용하시려면 허가 살펴보기

허가 살펴보기더 많은 기사 탐색

This article has been published

Video Coming Soon

Copyright © 2025 MyJoVE Corporation. 판권 소유