Se requiere una suscripción a JoVE para ver este contenido. Inicie sesión o comience su prueba gratuita.

Method Article

Seguimiento ocular durante una tarea compleja de aviación para obtener información sobre el procesamiento de la información

En este artículo

Resumen

El seguimiento ocular es un método no invasivo para sondear el procesamiento de la información. Este artículo describe cómo se puede utilizar el seguimiento ocular para estudiar el comportamiento de la mirada durante una tarea de emergencia de simulación de vuelo en pilotos de tiempo bajo (es decir, <350 horas de vuelo).

Resumen

El seguimiento ocular se ha utilizado ampliamente como un indicador para obtener información sobre los procesos cognitivos, perceptivos y sensoriomotores que subyacen al rendimiento de las habilidades. Trabajos anteriores han demostrado que las métricas de mirada tradicionales y avanzadas demuestran de manera confiable diferencias sólidas en la experiencia del piloto, la carga cognitiva, la fatiga e incluso la conciencia de la situación (SA).

Este estudio describe la metodología para utilizar un rastreador ocular portátil y un algoritmo de mapeo de mirada que captura los movimientos naturalistas de la cabeza y los ojos (es decir, la mirada) en un simulador de vuelo inmóvil de alta fidelidad. El método descrito en este documento describe los análisis de mirada basados en el área de interés (AOI), que proporciona más contexto relacionado con dónde miran los participantes y la duración del tiempo de permanencia, que indica la eficiencia con la que están procesando la información fijada. El protocolo ilustra la utilidad de un rastreador ocular portátil y un algoritmo de visión por computadora para evaluar los cambios en el comportamiento de la mirada en respuesta a una emergencia inesperada durante el vuelo.

Los resultados representativos demostraron que la mirada se vio significativamente afectada cuando se introdujo el evento de emergencia. Específicamente, la asignación de atención, la dispersión de la mirada y la complejidad de la secuencia de la mirada disminuyeron significativamente y se concentraron mucho en mirar por la ventana frontal y en el medidor de velocidad del aire durante el escenario de emergencia (todos los valores de p < 0,05). Se discute la utilidad y las limitaciones de emplear un rastreador ocular portátil en un entorno de simulación de vuelo inmóvil de alta fidelidad para comprender las características espacio-temporales del comportamiento de la mirada y su relación con el procesamiento de la información en el dominio de la aviación.

Introducción

Los seres humanos interactúan predominantemente con el mundo que los rodea moviendo primero los ojos y la cabeza para enfocar su línea de visión (es decir, la mirada) hacia un objeto o lugar de interés específico. Esto es particularmente cierto en entornos complejos, como las cabinas de los aviones, donde los pilotos se enfrentan a múltiples estímulos que compiten entre sí. Los movimientos de la mirada permiten la recopilación de información visual de alta resolución que permite a los seres humanos interactuar con su entorno de manera segura y flexible1, lo cual es de suma importancia en la aviación. Los estudios han demostrado que los movimientos oculares y el comportamiento de la mirada proporcionan información sobre los procesos perceptuales, cognitivos y motores subyacentes en diversas tareas 1,2,3. Además, el lugar donde miramos tiene una influencia directa en la planificación y ejecución de los movimientos de las extremidades superiores3. Por lo tanto, el análisis del comportamiento de la mirada durante las tareas de aviación proporciona un método objetivo y no invasivo, que podría revelar cómo los patrones de movimiento ocular se relacionan con varios aspectos del procesamiento y el rendimiento de la información.

Varios estudios han demostrado una asociación entre la mirada y el rendimiento de las tareas en varios paradigmas de laboratorio, así como en tareas complejas del mundo real (es decir, operar una aeronave). Por ejemplo, las áreas relevantes para la tarea tienden a fijarse con más frecuencia y durante períodos totales más largos, lo que sugiere que la ubicación de la fijación, la frecuencia y el tiempo de permanencia son indicadores de la asignación de atención en tareas neurocognitivas y de aviación 4,5,6. Los expertos y los que tienen un desempeño altamente exitoso muestran sesgos de fijación significativos hacia las áreas críticas para la tarea en comparación con los que tienen un desempeño menos exitoso o los novatos 4,7,8. Los aspectos espacio-temporales de la mirada se capturan a través de cambios en los patrones de tiempo de permanencia en varias áreas de interés (AOI) o medidas de distribución de la fijación (es decir, entropía de la mirada estacionaria: SGE). En el contexto de los paradigmas basados en el laboratorio, la duración media de la fijación, la longitud de la trayectoria de exploración y la complejidad de la secuencia de la mirada (es decir, la entropía de transición de la mirada: GTE) tienden a aumentar debido al aumento del escaneo y el procesamiento necesarios para resolver problemas y elaborar objetivos/soluciones de tareas más desafiantes 4,7.

Por el contrario, los estudios de aviación han demostrado que la longitud de la ruta de exploración y la complejidad de la secuencia de mirada disminuyen con la complejidad de la tarea y la carga cognitiva. Esta discrepancia pone de manifiesto el hecho de que la comprensión de los componentes de la tarea y las demandas del paradigma que se emplea es fundamental para la interpretación precisa de las métricas de la mirada. En conjunto, la investigación hasta la fecha respalda que las medidas de la mirada proporcionan una visión significativa y objetiva del procesamiento de información específica de la tarea que subyace a las diferencias en la dificultad de la tarea, la carga cognitiva y el rendimiento de la tarea. Con los avances en la tecnología de seguimiento ocular (es decir, la portabilidad, la calibración y el costo), el examen del comportamiento de la mirada en "la naturaleza" es un área emergente de investigación con aplicaciones tangibles hacia el avance de la capacitación ocupacional en los campos de la medicina 9,10,11 y la aviación 12,13,14.

El trabajo actual tiene como objetivo examinar más a fondo la utilidad del uso de métricas basadas en la mirada para obtener información sobre el procesamiento de la información mediante el empleo específico de un rastreador ocular portátil durante una tarea de simulación de vuelo de emergencia en pilotos de bajo tiempo. Este estudio amplía el trabajo previo que utilizó un rastreador ocular estabilizado por la cabeza (es decir, EyeLink II) para examinar las diferencias en las métricas de comportamiento de la mirada en función de la dificultad de vuelo (es decir, los cambios en las condiciones climáticas)5. El trabajo presentado en este manuscrito también se extiende sobre otros trabajos que describieron los enfoques metodológicos y analíticos para el uso del seguimiento ocular en un sistema de realidad virtual15. Nuestro estudio utilizó un simulador inmóvil de mayor fidelidad e informa de un análisis adicional de los datos de movimiento ocular (es decir, entropía). Este tipo de análisis ha sido reportado en trabajos previos; Sin embargo, una limitación en la literatura actual es la falta de estandarización en el reporte de los pasos analíticos. Por ejemplo, informar sobre cómo se definen las áreas de interés es de vital importancia porque influye directamente en los valores de entropía resultantes16.

En resumen, el trabajo actual examinó las métricas tradicionales y dinámicas del comportamiento de la mirada, mientras que la dificultad de la tarea se manipuló mediante la introducción de un escenario de emergencia en vuelo (es decir, una falla total inesperada del motor). Se esperaba que la introducción de un escenario de emergencia en vuelo proporcionara información sobre los cambios en el comportamiento de la mirada que subyacen al procesamiento de la información durante condiciones de tarea más desafiantes. El estudio reportado aquí es parte de un estudio más amplio que examina la utilidad del seguimiento ocular en un simulador de vuelo para informar el entrenamiento de pilotos basado en competencias. Los resultados aquí presentados no han sido publicados previamente.

Protocolo

El siguiente protocolo se puede aplicar a estudios que involucran un rastreador ocular portátil y un simulador de vuelo. El estudio actual involucra datos de seguimiento ocular registrados junto con tareas complejas relacionadas con la aviación en un simulador de vuelo (ver Tabla de Materiales). El simulador se configuró para ser representativo de un Cessna 172 y se utilizó con el panel de instrumentos necesario (configuración de medidor de vapor), un sistema de aviónica/GPS, un panel de audio/luces, un panel de interruptores y una unidad de control de vuelo (FCU) (ver Figura 1). El dispositivo de simulador de vuelo utilizado en este estudio es certificable con fines de entrenamiento y utilizado por la escuela de vuelo local para entrenar las habilidades necesarias para responder a diversos escenarios de emergencia, como fallas de motor, en un entorno de bajo riesgo. Todos los participantes en este estudio tenían licencia; Por lo tanto, experimentaron el escenario del simulador de falla del motor anteriormente en el curso de su capacitación. Este estudio fue aprobado por la Oficina de Ética de la Investigación de la Universidad de Waterloo (43564; Fecha: 17 de noviembre de 2021). Todos los participantes (N = 24; 14 hombres, 10 mujeres; edad media = 22 años; rango de horas de vuelo: 51-280 h) dieron su consentimiento informado por escrito.

Figura 1: Entorno del simulador de vuelo. Una ilustración del entorno del simulador de vuelo. El punto de vista del participante sobre la cabina de mando reprodujo el de un piloto que vuela un Cessna 172, preestablecido para una aproximación a favor del viento hasta la base hasta la final al Aeropuerto Internacional de Waterloo, Breslau, Ontario, CA. Los recuadros naranjas representan las diez principales áreas de interés utilizadas en los análisis de la mirada. Estos incluyen los (1) velocidad del aire, (2) actitud, (3) altímetro, (4) coordinador de giro, (5) rumbo, (6) velocidad vertical y (7) indicadores de encendido, así como las (8) ventanas delanteras, (9) izquierdas y (10) derechas. Esta figura fue modificada a partir de Ayala et al.5. Haga clic aquí para ver una versión más grande de esta figura.

1. Selección de participantes y consentimiento informado

- Evaluar al participante a través de un cuestionario de autoinforme basado en los criterios de inclusión/exclusión 2,5: posesión de al menos una Licencia de Piloto Privado (PPL), visión normal o corregida a normal, y sin diagnóstico previo de un trastorno neuropsiquiátrico/neurológico o discapacidad de aprendizaje.

- Informar al participante sobre los objetivos y procedimientos del estudio a través de una sesión informativa detallada manejada por el experimentador y el instructor de vuelo supervisor / técnico del simulador. Revise los riesgos descritos en el documento de consentimiento aprobado por la junta de revisión de ética de la institución. Responda cualquier pregunta sobre los riesgos potenciales. Obtener el consentimiento informado por escrito antes de comenzar cualquier procedimiento del estudio.

2. Requisitos de hardware/software y puesta en marcha

- Simulador de vuelo (normalmente completado por el técnico del simulador)

- Encienda las pantallas del simulador y del proyector. Si uno de los proyectores no se enciende al mismo tiempo que los demás, reinicie el simulador.

- En la pantalla de instrucciones, presione la pestaña Preajustes y verifique que los ajustes preestablecidos de posición y/o clima requeridos estén disponibles. Si es necesario, cree un nuevo tipo de ajuste preestablecido; Consulte al técnico para obtener ayuda.

- Portátil de colección

- Encienda la computadora portátil e inicie sesión con las credenciales.

- Cuando se le solicite, seleccione un perfil preexistente o cree uno si está probando un nuevo participante. Como alternativa, seleccione la opción Invitado para sobrescribir su última calibración.

- Para crear un nuevo perfil, desplácese hasta el final de la lista de perfiles y haga clic en Agregar.

- Establezca el ID de perfil en el ID de participante. Este ID de perfil se utilizará para etiquetar la carpeta, que contiene datos de seguimiento ocular una vez completada una grabación.

- Calibración de gafas

NOTA: Las gafas deben permanecer conectadas a la computadora portátil para grabar. La calibración con la caja solo debe completarse una vez al inicio de la recopilación de datos.- Abra el estuche del rastreador ocular y saque las gafas.

- Conecte el cable USB a micro-USB de la computadora portátil a las gafas. Si se le solicita en la computadora portátil, actualice el firmware.

- Ubique la caja de calibración negra dentro de la caja del rastreador ocular.

- En el portátil de la colección, en el Centro de seguimiento ocular, elija Herramientas | Calibración de dispositivos.

- Coloque las gafas dentro de la caja y presione Inicio en la ventana emergente para comenzar la calibración.

- Retire los vasos de la caja una vez que se complete la calibración.

- Ajuste de la boquilla

- Seleccione el revólver.

- Indique al participante que se siente en la cabina y se ponga las gafas.

- En el Centro de seguimiento ocular, vaya a Archivo | Ajustes | Mago de la nariz.

- Comprueba el ajuste de tu caja de gafas en el lado izquierdo de la pantalla. Si el ajuste es excelente, continúe con el siguiente paso. De lo contrario, haga clic en la casilla.

- Dígale al participante que siga las instrucciones de recomendación de ajuste que se muestran en la pantalla: coloque la pieza nasal, ajuste las gafas para sentarse cómodamente y mire directamente al frente a la computadora portátil.

- Si es necesario, cambie la pieza nasal. Pellizque la pieza nasal por la mitad, deslícela hacia afuera de las gafas y luego deslice otra hacia adentro. Continúa probando los diferentes revólver hasta identificar el que mejor se ajusta al participante.

- Llamadas de control de tráfico aéreo (ATC)

NOTA: Si el estudio requiere llamadas ATC, pídale al participante que traiga su propio auricular o que use el auricular de laboratorio. Complete la calibración del globo ocular solo después de que el participante se ponga el auricular, ya que el auricular puede mover las gafas en la cabeza, lo que afecta la precisión de la calibración.- Compruebe que el auricular esté conectado al conector en la parte inferior izquierda del panel de instrumentos.

- Indique al participante que se ponga los auriculares. Pídeles que no lo toquen ni que se lo quiten hasta que termine la grabación.

NOTA: Es necesario volver a calibrar cada vez que se mueve el auricular (y, por lo tanto, las gafas). - Haz una revisión de radio.

- Calibración del globo ocular

NOTA: Cada vez que el participante se cambia las gafas en la cabeza, debe repetir la calibración del globo ocular. Pida al participante que no toque las gafas hasta que terminen sus pruebas.- En el Centro de seguimiento ocular, navegue hasta el cuadro de parámetros a la izquierda de la pantalla.

- Compruebe el modo de calibración y elija la mirada fija o la cabeza fija según corresponda.

- Compruebe que los puntos de calibración sean una cuadrícula de 5 x 5, para un total de 25 puntos.

- Verifique el modo de validación y asegúrese de que coincida con el modo de calibración.

- Examine los resultados del seguimiento ocular y verifique que todo lo que debe registrarse para el estudio esté marcado con las casillas de verificación.

- Haga clic en File | Ajustes | Avanzado y compruebe que la frecuencia de muestreo es de 250 Hz.

- Marque la casilla Calibrar su seguimiento ocular en la pantalla con el mouse. Las instrucciones de calibración variarán según el modo. Para seguir el estudio actual, utilice el modo de calibración de mirada fija : indique a los participantes que muevan la cabeza para que el cuadro se superponga con el cuadrado negro y se alineen. Luego, pida al participante que centre su mirada en la cruz en el cuadrado negro y presione la barra espaciadora.

- Presione el cuadro Validar su configuración . Las instrucciones serán las mismas que en el paso 2.6.3. Compruebe que la cifra de validación MAE (Error Absoluto Medio) es <1°. Si no es así, repita los pasos 2.6.3 y 2.6.4.

- Presione Guardar calibración para guardar la calibración en el perfil cada vez que se completen la calibración y la validación.

- En el Centro de seguimiento ocular, navegue hasta el cuadro de parámetros a la izquierda de la pantalla.

- Uso del iPad

NOTA: El iPad se encuentra a la izquierda del panel de instrumentos (consulte la Figura 1). Se utiliza para cuestionarios, generalmente después del vuelo.- Encienda el iPad y asegúrese de que esté conectado a Internet.

- Abra una ventana en Safari e introduzca el enlace del cuestionario del estudio.

3. Recopilación de datos

NOTA: Repita estos pasos para cada prueba. Se recomienda que la computadora portátil se coloque en el banco fuera de la cabina.

- En la computadora del simulador de vuelo, en la pantalla de instrucciones , presione Ajustes preestablecidos y, a continuación, elija el ajuste preestablecido de posición deseado para simular. Presione el botón Aplicar y observe las pantallas que rodean el simulador para verificar que se produce el cambio.

- Repita el paso 3.1 para aplicar el ajuste preestablecido Clima .

- Dé al participante instrucciones específicas sobre la prueba o su trayectoria de vuelo. Esto incluye decirles que cambien cualquier configuración en el panel de instrumentos antes de comenzar.

- En la pantalla de instrucciones, presione el botón naranja STOP para iniciar la recopilación de datos. El color cambiará a verde y el texto dirá FLYING. Asegúrese de dar una señal verbal al participante para que sepa que puede comenzar a volar la aeronave. La señal recomendada es "3, 2, 1, tienes controles" mientras se presiona el botón naranja de parada .

- En la computadora portátil de colección, presione Iniciar grabación para que los datos del seguimiento ocular se sincronicen con los datos del simulador de vuelo.

- Cuando el participante haya completado su circuito y aterrizado, espere a que la aeronave deje de moverse.

NOTA: Es importante esperar porque durante el postprocesamiento; Los datos se truncan cuando la velocidad de avance se establece en 0. Esto proporciona coherencia para el punto de conexión de todas las pruebas. - En la pantalla de instrucciones, presione el botón verde FLYING . El color volverá a ser naranja y el texto dirá STOPPED. Dé una señal verbal durante este paso cuando la recopilación de datos esté a punto de terminar. La señal recomendada es "3, 2, 1, stop".

- Indique al participante que complete los cuestionarios posteriores al ensayo en el iPad. Actualice la página para la próxima prueba.

NOTA: El presente estudio utilizó el cuestionario de autoevaluación Situation Awareness Rating Technique (SART) como único cuestionario posterior al ensayo17.

4. Procesamiento y análisis de datos

- Datos del simulador de vuelo

NOTA: El archivo .csv copiado del simulador de vuelo contiene más de 1.000 parámetros que se pueden controlar en el simulador. En la Tabla 1 se enumeran y describen las principales medidas de rendimiento de interés.- Para cada participante, calcule la tasa de éxito utilizando la Ec (1) tomando el porcentaje en las condiciones de la tarea. Las pruebas fallidas se identifican mediante criterios predeterminados programados dentro del simulador que finaliza la prueba automáticamente al aterrizar debido a la orientación del avión y la velocidad vertical. Llevar a cabo una verificación posterior al juicio para asegurarse de que este criterio se alineó con las limitaciones reales de la aeronave (es decir, el daño/choque del tren de aterrizaje del Cessna 172 es evidente a velocidades verticales > 700 pies/min [fpm] al aterrizar).

Tasa de éxito = (1)

(1)

NOTA: Los valores más bajos de la tasa de éxito indican peores resultados, ya que se asocian con una reducción en los intentos de aterrizaje exitosos. - Para cada prueba, calcule el tiempo de finalización en función de la marca de tiempo, que indica que el avión se detuvo en la pista (es decir, velocidad de avance = 0 nudos).

NOTA: Un tiempo de finalización más corto no siempre equivale a un mejor rendimiento. Se debe tener cuidado para comprender cómo se espera que las condiciones de la tarea (es decir, vientos adicionales, escenarios de emergencia, etc.) afecten el tiempo de finalización. - Para cada prueba, determine la dureza del aterrizaje en función de la velocidad vertical de la aeronave (fpm) en el momento en que la aeronave aterriza inicialmente en la pista. Asegúrese de que este valor se tome en la misma marca de tiempo asociada con el primer cambio en el estado de AircraftOnGround de 0 (en el aire) a 1 (en tierra).

NOTA: Los valores dentro del rango de -700 fpm a 0 fpm se consideran seguros, y los valores más cercanos a 0 representan aterrizajes más suaves (es decir, mejores). Los valores negativos representan la velocidad vertical descendente; Los valores positivos representan la velocidad vertical ascendente. - Para cada intento, calcule el error de aterrizaje (°) en función de la diferencia entre las coordenadas de aterrizaje y el punto de referencia en la pista (centro de los marcadores de 500 pies). Usando el punto de referencia, calcule el error de aterrizaje usando la Ec (2).

Diferencia = √((δ latitud)2 + (δ longitud)2) (2)

NOTA: Los valores inferiores a 1° se muestran como normales 5,15. Los valores grandes indican un error de aterrizaje mayor asociado con los puntos de aterrizaje de las aeronaves que están más lejos de la zona de aterrizaje. - Calcule las medias de todos los participantes para cada variable de resultado de rendimiento para cada condición de la tarea. Notifique estos valores.

- Para cada participante, calcule la tasa de éxito utilizando la Ec (1) tomando el porcentaje en las condiciones de la tarea. Las pruebas fallidas se identifican mediante criterios predeterminados programados dentro del simulador que finaliza la prueba automáticamente al aterrizar debido a la orientación del avión y la velocidad vertical. Llevar a cabo una verificación posterior al juicio para asegurarse de que este criterio se alineó con las limitaciones reales de la aeronave (es decir, el daño/choque del tren de aterrizaje del Cessna 172 es evidente a velocidades verticales > 700 pies/min [fpm] al aterrizar).

- Datos de conocimiento de la situación

- Para cada ensayo, calcule la puntuación de SA en función de las puntuaciones de SART autoinformadas en las 10 dimensiones de SA17.

- Utilice el cuestionario SART17 para determinar las respuestas subjetivas de los participantes con respecto a la dificultad general de la tarea, así como su impresión de cuántos recursos atencionales tenían disponibles y gastados durante la realización de la tarea.

- Usando una escala Likert de 7 puntos, pida a los participantes que califiquen su experiencia percibida en preguntas de sondeo, incluyendo la complejidad de la situación, la división de la atención, la capacidad mental adicional y la cantidad y calidad de la información.

- Combine estas escalas en dimensiones más grandes de demandas atencionales (Demanda), oferta atencional (Oferta) y comprensión de la situación (Comprensión).

- Utilice estas clasificaciones para calcular una medida de SA basada en la Ec (3):

SA = Entendimiento - (Oferta-Demanda) (3)

NOTA: Las puntuaciones más altas en las escalas combinadas para proporcionar una medida de comprensión sugieren que el participante tiene una buena comprensión de la tarea en cuestión. Del mismo modo, las puntuaciones altas en el dominio de la oferta sugieren que el participante tiene una cantidad significativa de recursos atencionales para dedicar a una tarea determinada. Por el contrario, una puntuación de alta demanda sugiere que la tarea requiere una cantidad significativa de recursos atencionales para completarse. Es importante aclarar que estas puntuaciones se interpretan mejor cuando se comparan entre condiciones (es decir, condiciones fáciles frente a condiciones difíciles) en lugar de utilizarse como medidas independientes.

- Una vez completada la recopilación de datos, calcule las medias de todos los participantes para cada condición de la tarea (es decir, básica, de emergencia). Notifique estos valores.

- Para cada ensayo, calcule la puntuación de SA en función de las puntuaciones de SART autoinformadas en las 10 dimensiones de SA17.

- Datos de seguimiento ocular

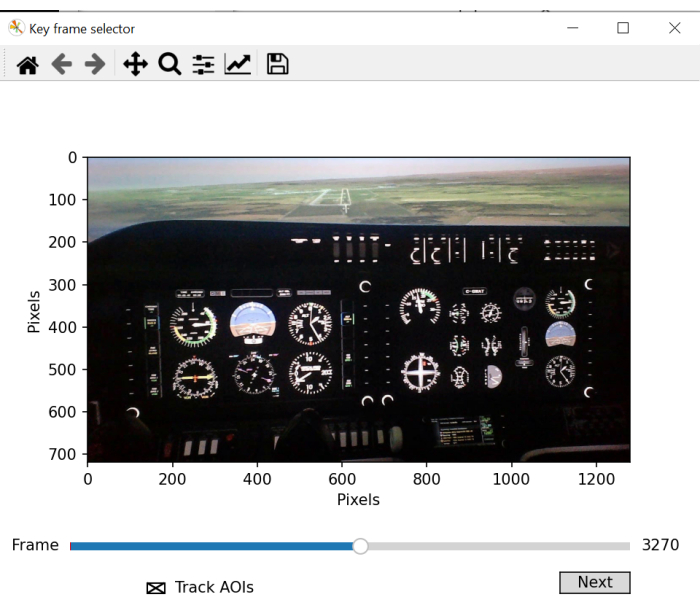

- Utilice un script por lotes de seguimiento ocular para definir manualmente los AOI para su uso en el mapeo de mirada. El script abrirá una nueva ventana para la selección de fotogramas clave que debería mostrar claramente todos los AOI clave que se analizarán. Desplácese por el video y elija un marco que muestre todos los AOI claramente.

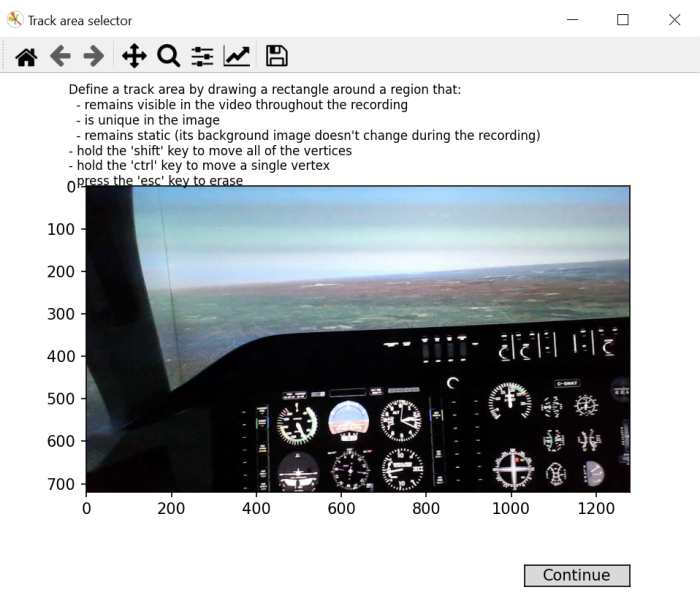

- Siguiendo las instrucciones en pantalla, dibuja un rectángulo sobre una región del marco que será visible durante todo el video, único y permanecerá estable.

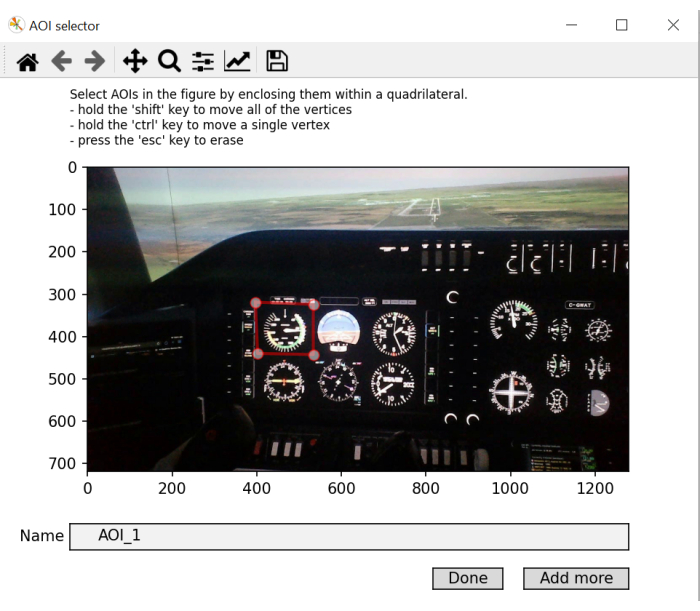

NOTA: El propósito de este paso es generar un marco de coordenadas "en pantalla" que se pueda usar en toda la grabación de video, ya que los movimientos de la cabeza hacen que la ubicación de los objetos en el entorno cambie en el transcurso de la grabación de video. - Dibuja un rectángulo para cada AOI de la imagen, uno a la vez. Nómbralos en consecuencia. Haga clic en Agregar más para agregar un nuevo AOI y presione Listo en el último. Si las coordenadas de la mirada durante una fijación determinada aterrizan dentro del espacio del objeto tal como se define en el marco de coordenadas "en pantalla", etiquete esa fijación con la etiqueta AOI respectiva.

NOTA: El propósito de este paso es generar una biblioteca de coordenadas de objetos que luego se utilizan como referencias al comparar las coordenadas de mirada con las coordenadas en pantalla.

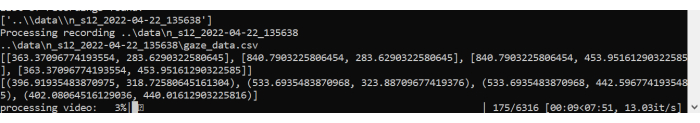

Por lo general, hay 10 AOI, pero esto depende de cómo esté configurado el simulador de vuelo. El panel de instrumentos puede ser diferente. De acuerdo con el trabajo previo 5,18, el estudio actual utiliza los siguientes AOI: Velocidad del aire, Actitud, Altímetro, Coordinador de giro, Rubo, Velocidad vertical, Potencia, Ventana frontal, Ventana izquierda y Ventana derecha (ver Figura 1). - Deje que el script comience a procesar los AOI y genere datos de fijación. Genera un gráfico que muestra las sacadas y fijaciones sobre el video.

- Se crearán dos nuevos archivos: fixations.csv y aoi_parameters.yaml. El procesador por lotes completará el posprocesamiento de los datos de mirada para cada ensayo y cada participante.

NOTA: Las principales medidas de interés del seguimiento ocular se enumeran en la Tabla 2 y se calculan para cada AOI de cada ensayo. - Para cada prueba, calcule las métricas de mirada tradicionales 4,5 para cada AOI en función de los datos generados en el archivo fixation.csv.

NOTA: Aquí, nos centramos en el tiempo de permanencia (%), que se calcula dividiendo la suma de las fijaciones de un AOI determinado por la suma de todas las fijaciones y multiplicando el cociente por 100 para obtener el porcentaje de tiempo dedicado a un AOI específico. No hay una interpretación negativa/positiva inherente de los tiempos de permanencia calculados. Dan una indicación de dónde se está asignando predominantemente la atención. Las duraciones medias de fijación más largas son indicativas de un aumento de las demandas de procesamiento. - Para cada prueba, calcule la tasa de parpadeo usando la Ec (4):

Tasa de parpadeo = Tiempo total de parpadeo/finalización (4)

NOTA: Trabajos anteriores han demostrado que la tasa de parpadeo está inversamente relacionada con la carga cognitiva 2,6,13,19,20. - Para cada ensayo, calcule el SGE utilizando la ecuación (5)21:

(5)

(5)

Donde v es la probabilidad de ver eli-ésimo AOI y V es el número de AOI.

NOTA: Los valores más altos de SGE se asocian con una mayor dispersión de la fijación, mientras que los valores más bajos son indicativos de una asignación más focalizada de las fijaciones22. - Para cada prueba, calcule el GTE usando la ecuación (6)23:

(6)

(6)

Donde V es la probabilidad de ver eli-ésimo AOI, y M es la probabilidad de ver elj-ésimo AOI dada la visualización previa deli-ésimo AOI.

NOTA: Los valores de GTE más altos se asocian con rutas de exploración visual más impredecibles y complejas, mientras que los valores de GTE más bajos son indicativos de rutas de exploración visual más predecibles y rutinarias. - Calcule las medias de todos los participantes para cada variable de salida de seguimiento ocular (y AOI cuando se indique) y cada condición de la tarea. Notifique estos valores.

| Término | Definición |

| Éxito (%) | Porcentaje de pruebas de aterrizaje exitosas |

| Tiempo (s) de finalización | Duración del tiempo desde el inicio del escenario de aterrizaje hasta que el avión se detiene por completo en la pista |

| Dureza de aterrizaje (fpm) | La tasa de decente en el punto de aterrizaje |

| Error de aterrizaje (°) | La diferencia entre el centro del avión y el centro del marcador de pista de 500 pies en el punto de aterrizaje |

Tabla 1: Variables de resultado del rendimiento del simulador. Variables dependientes del rendimiento de la aeronave y sus definiciones.

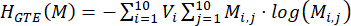

Figura 2: Trayectoria de vuelo del escenario de aterrizaje. Esquema de (A) el circuito de aterrizaje completado en todas las pruebas y (B) la pista con los marcadores de 500 pies que se utilizaron como punto de referencia para la zona de aterrizaje (es decir, círculo naranja central). Haga clic aquí para ver una versión más grande de esta figura.

Figura 3: Mapeo del área de interés. Ilustración del script por lotes que muestra una ventana para la selección de fotogramas. La selección de un fotograma óptimo implica la elección de un fotograma de vídeo que incluya la mayoría o todas las áreas de interés que se van a cartografiar. Haga clic aquí para ver una versión más grande de esta figura.

Figura 4: Generación de coordenadas "en pantalla" de mapeo de área de interés. Una ilustración del script por lotes que muestra una ventana para la selección de coordenadas "en pantalla". Este paso implica la selección de una región cuadrada/rectangular que permanezca visible durante toda la grabación, que sea exclusiva de la imagen y que permanezca estática. Haga clic aquí para ver una versión más grande de esta figura.

Figura 5: Identificación del área de interés a mapear. Una ilustración de la ventana de script por lotes que permite la selección y el etiquetado de áreas de interés. Abreviatura: AOIs = áreas de interés. Haga clic aquí para ver una versión más grande de esta figura.

Figura 6: Procesamiento de scripts por lotes. Una ilustración del script por lotes procesando el video y mapeando las fijaciones realizadas a lo largo del juicio. Haga clic aquí para ver una versión más grande de esta figura.

| Término | Definición |

| Tiempo de permanencia (%) | Porcentaje de la suma de todas las duraciones de fijación acumuladas en un AOI en relación con la suma de las duraciones de fijación acumuladas en todos los AOI |

| Duración media de la fijación (ms) | Duración media de una fijación en un AOI desde la entrada hasta la salida |

| Velocidad de parpadeo (parpadeos/s) | Número de parpadeos por segundo |

| SGE (bits) | Dispersión de la fijación |

| GTE (bits) | Complejidad de la secuencia de escaneo |

| Número de combates | Número de eventos de tunelización cognitiva (>10 s) |

| Tiempo total del combate (s) | Tiempo total de los eventos de tunelización cognitiva |

Tabla 2: Variables de resultado del seguimiento ocular. Variables dependientes del comportamiento de la mirada y sus definiciones.

Resultados

El impacto de las demandas de las tareas en el rendimiento del vuelo

Los datos se analizaron sobre la base de pruebas de aterrizaje exitosas en condiciones básicas y de emergencia. Todas las medidas se sometieron a una prueba t de muestras pareadas (factor dentro del sujeto: condición de la tarea (básica, emergencia)). Todas las pruebas t se realizaron con un nivel alfa establecido en 0,05. Cuatro participantes se estrellaron durante la prueba de ...

Discusión

El método de seguimiento ocular descrito aquí permite evaluar el procesamiento de la información en un entorno de simulador de vuelo a través de un rastreador ocular portátil. La evaluación de las características espaciales y temporales del comportamiento de la mirada proporciona información sobre el procesamiento de la información humana, que se ha estudiado ampliamente utilizando paradigmas de laboratorio altamente controlados 4,7,28

Divulgaciones

No existen intereses financieros contrapuestos.

Agradecimientos

Este trabajo está financiado en parte por la Beca Canadiense de Posgrado (CGS) del Consejo de Investigación en Ciencias Naturales e Ingeniería (NSERC) de Canadá, y la Beca de Exploración (00753) del Fondo de Investigación de Nuevas Fronteras. Todas las opiniones, hallazgos, conclusiones o recomendaciones expresadas en este material son del autor o autores y no reflejan necesariamente las de los patrocinadores.

Materiales

| Name | Company | Catalog Number | Comments |

| flight simulator | ALSIM | AL-250 | fixed fully immersive flight simulation training device |

| laptop | Hp | Lenovo | eye tracking data collection laptop; requirements: Windows 10 and python 3.0 |

| portable eye-tracker | AdHawk | MindLink eye tracking glasses (250 Hz, <2° gaze error, front-facing camera); eye tracking batch script is made available with AdHawk device purchase |

Referencias

- de Brouwer, A. J., Flanagan, J. R., Spering, M. Functional use of eye movements for an acting system. Trends Cogn Sci. 25 (3), 252-263 (2021).

- Ayala, N., Kearns, S., Cao, S., Irving, E., Niechwiej-Szwedo, E. Investigating the role of flight phase and task difficulty on low-time pilot performance, gaze dynamics and subjective situation awareness during simulated flight. J Eye Mov Res. 17 (1), (2024).

- Land, M. F., Hayhoe, M. In what ways do eye movements contribute to everyday activities. Vision Res. 41 (25-26), 3559-3565 (2001).

- Ayala, N., Zafar, A., Niechwiej-Szwedo, E. Gaze behavior: a window into distinct cognitive processes revealed by the Tower of London test. Vision Res. 199, 108072 (2022).

- Ayala, N. The effects of task difficulty on gaze behavior during landing with visual flight rules in low-time pilots. J Eye Mov Res. 16, 10 (2023).

- Glaholt, M. G. . Eye tracking in the cockpit: a review of the relationships between eye movements and the aviators cognitive state. , (2014).

- Hodgson, T. L., Bajwa, A., Owen, A. M., Kennard, C. The strategic control of gaze direction in the Tower-of-London task. J Cognitive Neurosci. 12 (5), 894-907 (2000).

- van De Merwe, K., Van Dijk, H., Zon, R. Eye movements as an indicator of situation awareness in a flight simulator experiment. Int J Aviat Psychol. 22 (1), 78-95 (2012).

- Kok, E. M., Jarodzka, H. Before your very eyes: The value and limitations of eye tracking in medical education. Med Educ. 51 (1), 114-122 (2017).

- Di Stasi, L. L., et al. Gaze entropy reflects surgical task load. Surg Endosc. 30, 5034-5043 (2016).

- Laubrock, J., Krutz, A., Nübel, J., Spethmann, S. Gaze patterns reflect and predict expertise in dynamic echocardiographic imaging. J Med Imag. 10 (S1), S11906-S11906 (2023).

- Brams, S., et al. Does effective gaze behavior lead to enhanced performance in a complex error-detection cockpit task. PloS One. 13 (11), e0207439 (2018).

- Peißl, S., Wickens, C. D., Baruah, R. Eye-tracking measures in aviation: A selective literature review. Int J Aero Psych. 28 (3-4), 98-112 (2018).

- Ziv, G. Gaze behavior and visual attention: A review of eye tracking studies in aviation. Int J Aviat Psychol. 26 (3-4), 75-104 (2016).

- Ke, L., et al. Evaluating flight performance and eye movement patterns using virtual reality flight simulator. J. Vis. Exp. (195), e65170 (2023).

- Krejtz, K., et al. Gaze transition entropy. ACM Transactions on Applied Perception. 13 (1), 1-20 (2015).

- Taylor, R. M., Selcon, S. J. Cognitive quality and situational awareness with advanced aircraft attitude displays. Proceedings of the Human Factors Society Annual Meeting. 34 (1), 26-30 (1990).

- Ayala, N., et al. Does fiducial marker visibility impact task performance and information processing in novice and low-time pilots. Computers & Graphics. 199, 103889 (2024).

- Recarte, M. &. #. 1. 9. 3. ;., Pérez, E., Conchillo, &. #. 1. 9. 3. ;., Nunes, L. M. Mental workload and visual impairment: Differences between pupil, blink, and subjective rating. Spanish J Psych. 11 (2), 374-385 (2008).

- Zheng, B., et al. Workload assessment of surgeons: correlation between NASA TLX and blinks. Surg Endosc. 26, 2746-2750 (2012).

- Shannon, C. E. A mathematical theory of communication. The Bell System Technical Journal. 27 (3), 379-423 (1948).

- Shiferaw, B., Downey, L., Crewther, D. A review of gaze entropy as a measure of visual scanning efficiency. Neurosci Biobehav R. 96, 353-366 (2019).

- Ciuperca, G., Girardin, V. Estimation of the entropy rate of a countable Markov chain. Commun Stat-Theory and Methods. 36 (14), 2543-2557 (2007).

- Federal aviation administration. . Airplane flying handbook. , (2021).

- Brown, D. L., Vitense, H. S., Wetzel, P. A., Anderson, G. M. Instrument scan strategies of F-117A Pilots. Aviat, Space, Envir Med. 73 (10), 1007-1013 (2002).

- Lu, T., Lou, Z., Shao, F., Li, Y., You, X. Attention and entropy in simulated flight with varying cognitive loads. Aerosp Medicine Hum Perf. 91 (6), 489-495 (2020).

- Dehais, F., Peysakhovich, V., Scannella, S., Fongue, J., Gateau, T. "Automation surprise" in aviation: Real-time solutions. , 2525-2534 (2015).

- Kowler, E. Eye movements: The past 25 years. J Vis Res. 51 (13), 1457-1483 (2011).

- Zafar, A., et al. Investigation of camera-free eye-tracking glasses compared to a video-based system. Sensors. 23 (18), 7753 (2023).

- Leube, A., Rifai, K. Sampling rate influences saccade detection in mobile eye tracking of a reading task. J Eye Mov Res. 10 (3), (2017).

- Diaz-Piedra, C., et al. The effects of flight complexity on gaze entropy: An experimental study with fighter pilots. Appl Ergon. 77, 92-99 (2019).

- Shiferaw, B. A., et al. Stationary gaze entropy predicts lane departure events in sleep-deprived drivers. Sci Rep. 8 (1), 1-10 (2018).

- Parker, A. J., Kirkby, J. A., Slattery, T. J. Undersweep fixations during reading in adults and children. J Exp Child Psychol. 192, 104788 (2020).

- Ayala, N., Kearns, S., Irving, E., Cao, S., Niechwiej-Szwedo, E. The effects of a dual task on gaze behavior examined during a simulated flight in low-time pilots. Front Psychol. 15, 1439401 (2024).

- Ayala, N., Heath, M. Executive dysfunction after a sport-related concussion is independent of task-based symptom burden. J Neurotraum. 37 (23), 2558-2568 (2020).

- Huddy, V. C., et al. Gaze strategies during planning in first-episode psychosis. J Abnorm Psychol. 116 (3), 589 (2007).

- Irving, E. L., Steinbach, M. J., Lillakas, L., Babu, R. J., Hutchings, N. Horizontal saccade dynamics across the human life span. Invest Opth Vis Sci. 47 (6), 2478-2484 (2006).

- Yep, R., et al. Interleaved pro/anti-saccade behavior across the lifespan. Front Aging Neurosci. 14, 842549 (2022).

- Manoel, E. D. J., Connolly, K. J. Variability and the development of skilled actions. Int J Psychophys. 19 (2), 129-147 (1995).

Reimpresiones y Permisos

Solicitar permiso para reutilizar el texto o las figuras de este JoVE artículos

Solicitar permisoExplorar más artículos

This article has been published

Video Coming Soon

ACERCA DE JoVE

Copyright © 2025 MyJoVE Corporation. Todos los derechos reservados