Zum Anzeigen dieser Inhalte ist ein JoVE-Abonnement erforderlich. Melden Sie sich an oder starten Sie Ihre kostenlose Testversion.

Method Article

Eye-Tracking während einer komplexen Luftfahrtaufgabe für Einblicke in die Informationsverarbeitung

In diesem Artikel

Zusammenfassung

Eye-Tracking ist eine nicht-invasive Methode, um die Informationsverarbeitung zu untersuchen. In diesem Artikel wird beschrieben, wie Eye-Tracking verwendet werden kann, um das Blickverhalten während einer Flugsimulations-Notfallaufgabe bei Piloten mit geringer Arbeitszeit (z. B. <350 Flugstunden) zu untersuchen.

Zusammenfassung

Eye-Tracking wird in großem Umfang als Proxy eingesetzt, um Einblicke in die kognitiven, wahrnehmungsbezogenen und sensomotorischen Prozesse zu gewinnen, die der Leistung von Fähigkeiten zugrunde liegen. Frühere Arbeiten haben gezeigt, dass traditionelle und fortschrittliche Blickmetriken zuverlässig robuste Unterschiede in der Expertise des Piloten, der kognitiven Belastung, der Müdigkeit und sogar dem Situationsbewusstsein (SA) aufweisen.

Diese Studie beschreibt die Methodik für die Verwendung eines tragbaren Eyetracker- und Gaze-Mapping-Algorithmus, der naturalistische Kopf- und Augenbewegungen (d. h. Anvisieren) in einem bewegungslosen High-Fidelity-Flugsimulator erfasst. Die in diesem Artikel beschriebene Methode beschreibt die Area-of-Interest (AOI)-basierte Blickanalyse, die mehr Kontext in Bezug darauf liefert, wohin die Teilnehmer schauen, und die Verweildauer, die anzeigt, wie effizient sie die fixierten Informationen verarbeiten. Das Protokoll veranschaulicht die Nützlichkeit eines tragbaren Eyetrackers und eines Computer-Vision-Algorithmus, um Änderungen des Blickverhaltens als Reaktion auf einen unerwarteten Notfall während des Fluges zu bewerten.

Repräsentative Ergebnisse zeigten, dass der Blick signifikant beeinflusst wurde, als das Notfallereignis eingeführt wurde. Insbesondere nahmen die Aufmerksamkeitszuweisung, die Blickstreuung und die Komplexität der Blicksequenz signifikant ab und konzentrierten sich während des Notfallszenarios stark auf den Blick aus dem Frontfenster und auf den Geschwindigkeitsmesser (alle p-Werte < 0,05). Der Nutzen und die Grenzen des Einsatzes eines tragbaren Eyetrackers in einer bewegungslosen Flugsimulationsumgebung mit hoher Wiedergabetreue zum Verständnis der raumzeitlichen Eigenschaften des Blickverhaltens und seiner Beziehung zur Informationsverarbeitung in der Luftfahrt werden diskutiert.

Einleitung

Der Mensch interagiert hauptsächlich mit der Welt um ihn herum, indem er zuerst seine Augen und seinen Kopf bewegt, um seine Sichtlinie (d. h. seinen Blick) auf ein bestimmtes Objekt oder einen bestimmten Ort von Interesse zu richten. Dies gilt insbesondere für komplexe Umgebungen wie Flugzeugcockpits, in denen Piloten mit mehreren konkurrierenden Reizen konfrontiert sind. Blickbewegungen ermöglichen das Sammeln von hochauflösenden visuellen Informationen, die es dem Menschen ermöglichen, auf sichere und flexible Weise mit seiner Umgebung zu interagieren1, was in der Luftfahrt von größter Bedeutung ist. Studien haben gezeigt, dass Augenbewegungen und Blickverhalten Einblicke in die zugrunde liegenden Wahrnehmungs-, kognitiven und motorischen Prozesse bei verschiedenen Aufgaben geben 1,2,3. Darüber hinaus hat der Blickwinkel einen direkten Einfluss auf die Planung und Ausführung von Bewegungen der oberen Gliedmaßen3. Daher stellt die Analyse des Blickverhaltens bei Flugaufgaben eine objektive und nicht-invasive Methode dar, die aufzeigen könnte, wie Augenbewegungsmuster mit verschiedenen Aspekten der Informationsverarbeitung und -leistung zusammenhängen.

Mehrere Studien haben einen Zusammenhang zwischen Blick- und Aufgabenleistung über verschiedene Laborparadigmen hinweg sowie bei komplexen Aufgaben in der realen Welt (z. B. beim Bedienen eines Flugzeugs) gezeigt. Zum Beispiel neigen aufgabenrelevante Areale dazu, häufiger und für eine längere Gesamtdauer fixiert zu werden, was darauf hindeutet, dass Fixationsort, -häufigkeit und -verweildauer Proxies für die Zuweisung von Aufmerksamkeit bei neurokognitiven und fliegerischen Aufgaben sind 4,5,6. Sehr erfolgreiche Performer und Experten zeigen im Vergleich zu weniger erfolgreichen Performern oder Anfängern eine signifikante Fixierungsverzerrung auf aufgabenkritische Bereiche 4,7,8. Raum-zeitliche Aspekte des Blicks werden durch Änderungen der Verweilzeitmuster über verschiedene Interessenbereiche (AOIs) oder Messungen der Fixationsverteilung (d.h. Stationary Gaze Entropy: SGE) erfasst. Im Kontext laborbasierter Paradigmen nehmen die durchschnittliche Fixationsdauer, die Länge des Scanpfads und die Komplexität der Blicksequenz (d. h. die Blickübergangsentropie: GTE) tendenziell zu, da mehr Scannen und Verarbeiten erforderlich sind, um Probleme zu lösen und anspruchsvollere Aufgabenziele/-lösungen zu erarbeiten 4,7.

Umgekehrt haben Luftfahrtstudien gezeigt, dass die Länge des Scanpfads und die Komplexität der Blicksequenz mit der Komplexität der Aufgabe und der kognitiven Belastung abnehmen. Diese Diskrepanz unterstreicht die Tatsache, dass das Verständnis der Aufgabenkomponenten und der Anforderungen des verwendeten Paradigmas für die genaue Interpretation von Blickmetriken entscheidend ist. Insgesamt unterstützt die bisherige Forschung, dass Blickmessungen einen aussagekräftigen, objektiven Einblick in die aufgabenspezifische Informationsverarbeitung bieten, die den Unterschieden in der Aufgabenschwierigkeit, der kognitiven Belastung und der Aufgabenleistung zugrunde liegt. Mit den Fortschritten in der Eye-Tracking-Technologie (d. h. Portabilität, Kalibrierung und Kosten) ist die Untersuchung des Blickverhaltens in freier Wildbahn ein aufstrebendes Forschungsgebiet mit konkreten Anwendungen zur Förderung der Berufsausbildung in den Bereichen Medizin 9,10,11 und Luftfahrt 12,13,14.

Die aktuelle Arbeit zielt darauf ab, den Nutzen der Verwendung von blickbasierten Metriken weiter zu untersuchen, um Einblicke in die Informationsverarbeitung zu gewinnen, indem ein tragbarer Eyetracker während einer Notfallflugsimulationsaufgabe bei Piloten mit geringer Zeit eingesetzt wird. Diese Studie baut auf früheren Arbeiten auf, bei denen ein kopfstabilisierter Eyetracker (d. h. EyeLink II) verwendet wurde, um Unterschiede in den Metriken des Blickverhaltens in Abhängigkeit von der Flugschwierigkeit (d. h. Änderungen der Wetterbedingungen) zu untersuchen5. Die in diesem Manuskript vorgestellte Arbeit erweitert auch andere Arbeiten, die die methodischen und analytischen Ansätze für den Einsatz von Eye-Tracking in einem Virtual-Reality-System beschriebenhaben 15. Unsere Studie verwendete einen bewegungslosen Simulator mit höherer Genauigkeit und berichtet über eine zusätzliche Analyse von Augenbewegungsdaten (d. h. Entropie). Über diese Art der Analyse wurde bereits in früheren Arbeiten berichtet. Eine Einschränkung in der aktuellen Literatur ist jedoch die fehlende Standardisierung bei der Berichterstattung über die analytischen Schritte. Zum Beispiel ist die Berichterstattung, wie Interessenbereiche definiert werden, von entscheidender Bedeutung, da sie die resultierenden Entropiewerte16 direkt beeinflusst.

Zusammenfassend lässt sich sagen, dass in der aktuellen Arbeit traditionelle und dynamische Blickverhaltensmetriken untersucht wurden, während die Schwierigkeit der Aufgabe durch die Einführung eines Notfallszenarios während des Fluges (d.h. unerwarteter Totalausfall des Triebwerks) manipuliert wurde. Es wurde erwartet, dass die Einführung eines Notfallszenarios während des Fluges Einblicke in die Veränderungen des Blickverhaltens geben würde, die der Informationsverarbeitung unter schwierigeren Aufgabenbedingungen zugrunde liegen. Die Studie, über die hier berichtet wird, ist Teil einer größeren Studie, die den Nutzen von Eye-Tracking in einem Flugsimulator untersucht, um die kompetenzbasierte Pilotenausbildung zu informieren. Die hier vorgestellten Ergebnisse wurden bisher nicht veröffentlicht.

Protokoll

Das folgende Protokoll kann auf Studien angewendet werden, an denen ein tragbarer Eyetracker und ein Flugsimulator beteiligt sind. In der aktuellen Studie werden Eye-Tracking-Daten neben komplexen luftfahrtbezogenen Aufgaben in einem Flugsimulator aufgezeichnet (siehe Materialtabelle). Der Simulator war so konfiguriert, dass er repräsentativ für eine Cessna 172 war, und wurde mit der erforderlichen Instrumententafel (Dampfanzeigekonfiguration), einem Avionik-/GPS-System, einer Audio-/Lichttafel, einer Unterbrechertafel und einer Flight Control Unit (FCU) verwendet (siehe Abbildung 1). Das in dieser Studie verwendete Flugsimulatorgerät ist zu Schulungszwecken zertifizierbar und wird von der örtlichen Flugschule verwendet, um die Fähigkeiten zu trainieren, die erforderlich sind, um auf verschiedene Notfallszenarien, wie z. B. einen Triebwerksausfall, in einer risikoarmen Umgebung zu reagieren. Die Teilnehmer dieser Studie waren alle lizenziert; Daher haben sie das Szenario des Motorausfallsimulators bereits im Rahmen ihrer Ausbildung erlebt. Diese Studie wurde vom Office of Research Ethics der University of Waterloo genehmigt (43564; Datum: 17. November 2021). Alle Teilnehmer (N = 24; 14 Männer, 10 Frauen; Durchschnittsalter = 22 Jahre; Flugstundenbereich: 51-280 h) gaben eine schriftliche Einverständniserklärung ab.

Abbildung 1: Flugsimulator-Umgebung. Eine Illustration der Flugsimulatorumgebung. Die Sicht des Teilnehmers auf das Cockpit entsprach der eines Piloten, der eine Cessna 172 flog, die für einen Anflug von Lee zur Basis bis zum Endanflug auf den Waterloo International Airport, Breslau, Ontario, Kalifornien, voreingestellt war. Die orangefarbenen Kästchen stellen die zehn Hauptinteressengebiete dar, die in den Blickanalysen verwendet werden. Dazu gehören die (1) Fluggeschwindigkeit, (2) die Fluglage, (3) der Höhenmesser, (4) der Kurvenkoordinator, (5) der Kurs, (6) die vertikale Geschwindigkeit und (7) die Betriebsanzeigen sowie die (8) vorderen, (9) linken und (10) rechten Fenster. Diese Abbildung wurde von Ayala et al.5 modifiziert. Bitte klicken Sie hier, um eine größere Version dieser Abbildung anzuzeigen.

1. Teilnehmer-Screening und Einwilligungserklärung

- Screenen Sie den Teilnehmer über einen Selbstberichtsfragebogen basierend auf den Einschluss-/Ausschlusskriterien 2,5: Besitz von mindestens einer Privatpilotenlizenz (PPL), normales oder auf normales Sehvermögen korrigiertes Sehvermögen und keine vorherige Diagnose einer neuropsychiatrischen/neurologischen Störung oder Lernbehinderung.

- Informieren Sie den Teilnehmer über die Ziele und den Ablauf der Studie durch eine ausführliche Einweisung durch den Experimentator und den betreuenden Fluglehrer/Simulatortechniker. Überprüfen Sie die Risiken, die in dem vom Ethikprüfungsausschuss der Institution genehmigten Einwilligungsdokument beschrieben sind. Beantworten Sie alle Fragen zu den potenziellen Risiken. Holen Sie eine schriftliche Einverständniserklärung ein, bevor Sie mit Studienverfahren beginnen.

2. Hardware-/Softwareanforderungen und Inbetriebnahme

- Flugsimulator (in der Regel vom Simulatortechniker ausgefüllt)

- Schalten Sie die Simulator- und Projektorbildschirme ein. Wenn sich einer der Projektoren nicht gleichzeitig mit den anderen einschaltet, starten Sie den Simulator neu.

- Drücken Sie auf dem Anweisungsbildschirm auf die Registerkarte "Voreinstellungen " und vergewissern Sie sich, dass die erforderlichen Positions - und/oder Wettervoreinstellungen verfügbar sind. Erstellen Sie bei Bedarf einen neuen Vorgabentyp. Wenden Sie sich an den Techniker, um Hilfe zu erhalten.

- Kollektion Laptop

- Drehen Sie den Laptop um und melden Sie sich mit den Anmeldeinformationen an.

- Wenn Sie dazu aufgefordert werden, wählen Sie entweder ein bereits vorhandenes Profil aus oder erstellen Sie eines, wenn Sie einen neuen Teilnehmer testen. Alternativ können Sie die Option Gast auswählen, um die letzte Kalibrierung zu überschreiben.

- Um ein neues Profil zu erstellen, scrollen Sie bis zum Ende der Profilliste und klicken Sie auf Hinzufügen.

- Legen Sie die Profil-ID auf die Teilnehmer-ID fest. Diese Profil-ID wird verwendet, um den Ordner zu markieren, der nach Abschluss einer Aufzeichnung Eye-Tracking-Daten enthält.

- Kalibrierung von Brillen

HINWEIS: Die Brille muss mit dem Laptop verbunden bleiben, um aufnehmen zu können. Die Kalibrierung mit der Box muss nur einmal zu Beginn der Datenerfassung durchgeführt werden.- Öffnen Sie das Eyetracker-Gehäuse und nehmen Sie die Brille heraus.

- Verbinden Sie das USB-zu-Micro-USB-Kabel vom Laptop mit der Brille. Wenn Sie auf dem Laptop dazu aufgefordert werden, aktualisieren Sie die Firmware.

- Suchen Sie das schwarze Kalibrierungsfeld im Gehäuse des Eyetrackers.

- Wählen Sie auf dem Sammlungs-Laptop im Eye-Tracking-Hub Extras | Kalibrierung von Geräten.

- Legen Sie die Brille in die Box und drücken Sie im Popup-Fenster auf Start , um mit der Kalibrierung zu beginnen.

- Nehmen Sie die Brille aus der Verpackung, sobald die Kalibrierung abgeschlossen ist.

- Passform des Nasenstücks

- Wählen Sie den Objektivrevolver aus.

- Weisen Sie den Teilnehmer an, sich ins Cockpit zu setzen und die Brille aufzusetzen.

- Navigieren Sie im Eyetracking-Hub zu Datei | Einstellungen | Nasen-Zauberer.

- Aktivieren Sie das Kontrollkästchen für die Passform Ihrer Brille auf der linken Seite des Bildschirms. Wenn die Passform Ausgezeichnet ist, fahren Sie mit dem nächsten Schritt fort. Klicken Sie andernfalls auf das Kästchen.

- Sagen Sie dem Teilnehmer, dass er die auf dem Bildschirm angezeigten Passformempfehlungen befolgen soll: Stellen Sie den Objektivrevolver ein, stellen Sie die Brille so ein, dass sie bequem sitzt, und schauen Sie geradeaus auf den Laptop.

- Tauschen Sie bei Bedarf den Objektivrevolver aus. Drücken Sie den Objektivrevolver in der Mitte zusammen, schieben Sie ihn aus der Brille heraus und schieben Sie dann einen anderen hinein. Testen Sie die verschiedenen Nasenstücke weiter, bis derjenige identifiziert ist, der am besten zu den Teilnehmern passt.

- Anrufe der Flugsicherung (ATC)

HINWEIS: Wenn die Studie ATC-Anrufe erfordert, bitten Sie den Teilnehmer, sein eigenes Headset mitzubringen oder das Labor-Headset zu verwenden. Schließen Sie die Augapfelkalibrierung erst ab, nachdem der Teilnehmer das Headset aufgesetzt hat, da das Headset die Brille auf dem Kopf bewegen kann, was sich auf die Kalibrierungsgenauigkeit auswirkt.- Vergewissern Sie sich, dass der Steuersatz an die Buchse an der linken Unterseite der Instrumententafel angeschlossen ist.

- Weisen Sie den Teilnehmer an, das Headset aufzusetzen. Bitten Sie sie, sie nicht zu berühren oder abzunehmen, bis die Aufnahme beendet ist.

HINWEIS: Jedes Mal, wenn das Headset (und damit die Brille) bewegt wird, ist eine Neukalibrierung erforderlich. - Führen Sie einen Funkcheck durch.

- Kalibrierung des Augapfels

HINWEIS: Jedes Mal, wenn der Teilnehmer die Brille auf den Kopf schiebt, muss er die Augapfelkalibrierung wiederholen. Bitten Sie den Teilnehmer, die Brille nicht zu berühren, bis seine Tests beendet sind.- Navigieren Sie im Eyetracking-Hub zum Parameterfeld am linken Bildschirmrand.

- Überprüfen Sie den Kalibrierungsmodus und wählen Sie entsprechend fester Blick oder fester Kopf .

- Überprüfen Sie, ob es sich bei den Kalibrierungspunkten um ein 5 x 5-Raster handelt, was insgesamt 25 Punkte ergibt.

- Überprüfen Sie den Validierungsmodus und stellen Sie sicher, dass er mit dem Kalibrierungsmodus übereinstimmt.

- Untersuchen Sie die Eye-Tracking-Ausgaben und stellen Sie sicher, dass alles, was für die Studie aufgezeichnet werden muss, mit den Kontrollkästchen aktiviert ist.

- Klicken Sie auf File | Einstellungen | Erweitert und überprüfen Sie, ob die Abtastrate 250 Hz beträgt.

- Aktivieren Sie das Kontrollkästchen Kalibrieren Sie Ihre Augenverfolgung auf dem Bildschirm mit der Maus. Die Kalibrierungsanweisungen variieren je nach Modus. Um der aktuellen Studie zu folgen, verwenden Sie den Kalibrierungsmodus mit festem Blick : Weisen Sie die Teilnehmer an, ihren Kopf so zu bewegen, dass das Feld das schwarze Quadrat überlappt und sie sich ausrichten. Bitten Sie dann den Teilnehmer, seinen Blick auf das Fadenkreuz im schwarzen Quadrat zu richten und die Leertaste zu drücken.

- Klicken Sie auf das Kontrollkästchen Setup validieren . Die Anweisungen sind die gleichen wie in Schritt 2.6.3. Prüfen Sie, ob die Validierungszahl MAE (Mean Absolute Error) <1° beträgt. Wenn nicht, wiederholen Sie die Schritte 2.6.3 und 2.6.4.

- Klicken Sie auf Kalibrierung speichern , um die Kalibrierung jedes Mal im Profil zu speichern, wenn die Kalibrierung und Validierung abgeschlossen sind.

- Navigieren Sie im Eyetracking-Hub zum Parameterfeld am linken Bildschirmrand.

- iPad-Nutzung

HINWEIS: Das iPad befindet sich links neben der Instrumententafel (siehe Abbildung 1). Es wird für Fragebögen verwendet, typischerweise nach dem Flug.- Schalten Sie das iPad ein und stellen Sie sicher, dass es mit dem Internet verbunden ist.

- Öffnen Sie ein Fenster in Safari und geben Sie den Link für den Studienfragebogen ein.

3. Datenerhebung

HINWEIS: Wiederholen Sie diese Schritte für jede Testversion. Es wird empfohlen, den Laptop auf der Bank außerhalb des Cockpits zu platzieren.

- Drücken Sie auf dem Flugsimulator-Computer auf dem Anweisungsbildschirm auf Voreinstellungen, und wählen Sie dann die gewünschte Positionsvoreinstellung aus, die simuliert werden soll. Klicken Sie auf die Schaltfläche Übernehmen, und beobachten Sie die Bildschirme rund um den Simulator, um zu überprüfen, ob die Änderung erfolgt.

- Wiederholen Sie Schritt 3.1, um die Wettervoreinstellung anzuwenden.

- Geben Sie dem Teilnehmer spezifische Anweisungen zum Test oder zu seiner Flugroute. Dazu gehört, dass sie alle Einstellungen auf der Instrumententafel ändern sollen, bevor sie beginnen.

- Drücken Sie auf dem Anweisungsbildschirm die orangefarbene Taste STOPP, um die Datenerfassung zu starten. Die Farbe ändert sich in Grün und der Text lautet FLIEGEN. Achten Sie darauf, dem Teilnehmer ein verbales Signal zu geben, damit er weiß, dass er mit dem Fliegen des Flugzeugs beginnen kann. Der empfohlene Hinweis ist "3, 2, 1, you have control", wenn die orangefarbene Stopp-Taste gedrückt wird.

- Drücken Sie auf dem Erfassungslaptop auf Aufzeichnung starten , damit die Eyetracker-Daten mit den Flugsimulatordaten synchronisiert werden.

- Wenn der Teilnehmer seinen Rundkurs beendet hat und gelandet ist, warten Sie, bis sich das Flugzeug nicht mehr bewegt.

HINWEIS: Es ist wichtig zu warten, da während der Nachbearbeitung; Die Daten werden abgeschnitten, wenn sich die Fahrgeschwindigkeit bei 0 einpendelt. Dies sorgt für Konsistenz für den Endpunkt aller Studien. - Drücken Sie auf dem Anweisungsbildschirm die grüne FLYING-Taste. Die Farbe wird wieder orange und der Text lautet STOPPED. Geben Sie in diesem Schritt einen verbalen Hinweis, wenn die Datenerfassung kurz vor dem Ende steht. Das empfohlene Stichwort ist "3, 2, 1, Stopp".

- Weisen Sie den Teilnehmer an, den/die Fragebogen nach der Testphase auf dem iPad auszufüllen. Aktualisieren Sie die Seite für die nächste Testversion.

HINWEIS: In der aktuellen Studie wurde der Selbsteinschätzungsfragebogen der Situation Awareness Rating Technique (SART) als einziger Fragebogen nach der Studie verwendet17.

4. Datenverarbeitung und -analyse

- Flugsimulator-Daten

HINWEIS: Die .csv Datei, die aus dem Flugsimulator kopiert wird, enthält mehr als 1.000 Parameter, die im Simulator gesteuert werden können. Die wichtigsten Leistungskennzahlen von Interesse sind in Tabelle 1 aufgeführt und beschrieben.- Berechnen Sie für jeden Teilnehmer die Erfolgsquote mit Gl (1), indem Sie den Prozentsatz über die Aufgabenbedingungen hinweg nehmen. Fehlgeschlagene Versuche werden durch vorgegebene Kriterien identifiziert, die im Simulator programmiert sind und den Versuch aufgrund der Ausrichtung der Ebene und der vertikalen Geschwindigkeit automatisch beim Aufsetzen beenden. Führen Sie eine nachträgliche Überprüfung durch, um sicherzustellen, dass dieses Kriterium mit den tatsächlichen Einschränkungen des Flugzeugs übereinstimmt (d. h. Beschädigung/Absturz des Fahrwerks der Cessna 172 ist bei vertikalen Geschwindigkeiten > 700 Fuß/min [fpm] beim Aufsetzen offensichtlich).

Erfolgsquote = (1)

(1)

HINWEIS: Niedrigere Erfolgsquotenwerte deuten auf schlechtere Ergebnisse hin, da sie mit einer Verringerung erfolgreicher Landeversuche verbunden sind. - Berechnen Sie für jeden Versuch die Fertigstellungszeit basierend auf dem Zeitstempel, der angibt, dass das Flugzeug auf der Landebahn gestoppt wurde (d. h. Grundgeschwindigkeit = 0 Knoten).

HINWEIS: Eine kürzere Fertigstellungszeit ist nicht immer gleichbedeutend mit einer besseren Leistung. Es ist Vorsicht geboten, um zu verstehen, wie sich die Aufgabenbedingungen (d. h. zusätzliche Winde, Notfallszenarien usw.) voraussichtlich auf die Fertigstellungszeit auswirken werden. - Bestimmen Sie für jeden Versuch die Landehärte basierend auf der vertikalen Geschwindigkeit (fpm) des Flugzeugs zum Zeitpunkt der ersten Landung des Flugzeugs auf der Start- und Landebahn. Stellen Sie sicher, dass dieser Wert mit demselben Zeitstempel verwendet wird, der mit der ersten Änderung des AircraftOnGround-Status von 0 (in der Luft) in 1 (am Boden) verknüpft ist.

HINWEIS: Werte im Bereich von -700 fpm bis 0 fpm gelten als sicher, wobei Werte näher an 0 für weichere (d. h. bessere) Landungen stehen. Negative Werte stellen die vertikale Abwärtsgeschwindigkeit dar. Positive Werte stellen die vertikale Geschwindigkeit nach oben dar. - Berechnen Sie für jeden Versuch den Landefehler (°) basierend auf der Differenz zwischen den Aufsetzkoordinaten und dem Referenzpunkt auf der Landebahn (Mitte der 500-Fuß-Markierungen). Berechnen Sie anhand des Referenzpunkts den Landefehler mit Gl (2).

Differenz = √((Δ Breitengrad)2 + (Δ Längengrad)2) (2)

HINWEIS: Werte unter 1° werden als normal 5,15 angezeigt. Große Werte weisen auf einen größeren Landefehler hin, der mit Flugzeugaufsetzpunkten verbunden ist, die weiter von der Landezone entfernt sind. - Berechnen Sie die Mittelwerte aller Teilnehmer für jede Leistungsergebnisvariable für jede Aufgabenbedingung. Melden Sie diese Werte.

- Berechnen Sie für jeden Teilnehmer die Erfolgsquote mit Gl (1), indem Sie den Prozentsatz über die Aufgabenbedingungen hinweg nehmen. Fehlgeschlagene Versuche werden durch vorgegebene Kriterien identifiziert, die im Simulator programmiert sind und den Versuch aufgrund der Ausrichtung der Ebene und der vertikalen Geschwindigkeit automatisch beim Aufsetzen beenden. Führen Sie eine nachträgliche Überprüfung durch, um sicherzustellen, dass dieses Kriterium mit den tatsächlichen Einschränkungen des Flugzeugs übereinstimmt (d. h. Beschädigung/Absturz des Fahrwerks der Cessna 172 ist bei vertikalen Geschwindigkeiten > 700 Fuß/min [fpm] beim Aufsetzen offensichtlich).

- Daten zum Situationsbewusstsein

- Berechnen Sie für jeden Versuch den SA-Score basierend auf den selbstberichteten SART-Scores in den 10 Dimensionen von SA17.

- Verwenden Sie den SART-Fragebogen17 , um die subjektiven Antworten der Teilnehmer in Bezug auf die allgemeine Aufgabenschwierigkeit sowie ihren Eindruck davon zu ermitteln, wie viel Aufmerksamkeitsressourcen sie während der Aufgabenausführung zur Verfügung hatten und aufwendeten.

- Bitten Sie die Teilnehmer anhand einer 7-stufigen Likert-Skala, ihre wahrgenommenen Erfahrungen mit bohrenden Fragen zu bewerten, einschließlich der Komplexität der Situation, der Aufteilung der Aufmerksamkeit, der freien geistigen Kapazität sowie der Quantität und Qualität der Informationen.

- Kombinieren Sie diese Skalen zu größeren Dimensionen des Aufmerksamkeitsbedarfs (Nachfrage), des Aufmerksamkeitsangebots (Angebot) und des Situationsverständnisses (Verständnis).

- Verwenden Sie diese Bewertungen, um ein Maß für SA basierend auf Gl (3) zu berechnen:

SA = Verstehen - (Angebot-Nachfrage) (3)

HINWEIS: Höhere Punktzahlen auf Skalen, die kombiniert werden, um ein Maß für das Verständnis zu liefern, deuten darauf hin, dass der Teilnehmer ein gutes Verständnis für die anstehende Aufgabe hat. In ähnlicher Weise deuten hohe Punktzahlen im Versorgungsbereich darauf hin, dass der Teilnehmer über eine beträchtliche Menge an Aufmerksamkeitsressourcen verfügt, die er einer bestimmten Aufgabe widmen kann. Im Gegensatz dazu deutet ein hoher Anforderungswert darauf hin, dass die Aufgabe eine erhebliche Menge an Aufmerksamkeitsressourcen erfordert, um sie zu erledigen. Es ist wichtig klarzustellen, dass diese Werte am besten interpretiert werden, wenn sie über Bedingungen hinweg verglichen werden (d. h. leichte vs. schwierige Bedingungen) und nicht als eigenständige Messgrößen verwendet werden.

- Sobald die Datenerfassung abgeschlossen ist, berechnen Sie die Mittelwerte für alle Teilnehmer für jede Aufgabenbedingung (z. B. einfach, Notfall). Melden Sie diese Werte.

- Berechnen Sie für jeden Versuch den SA-Score basierend auf den selbstberichteten SART-Scores in den 10 Dimensionen von SA17.

- Eye-Tracking-Daten

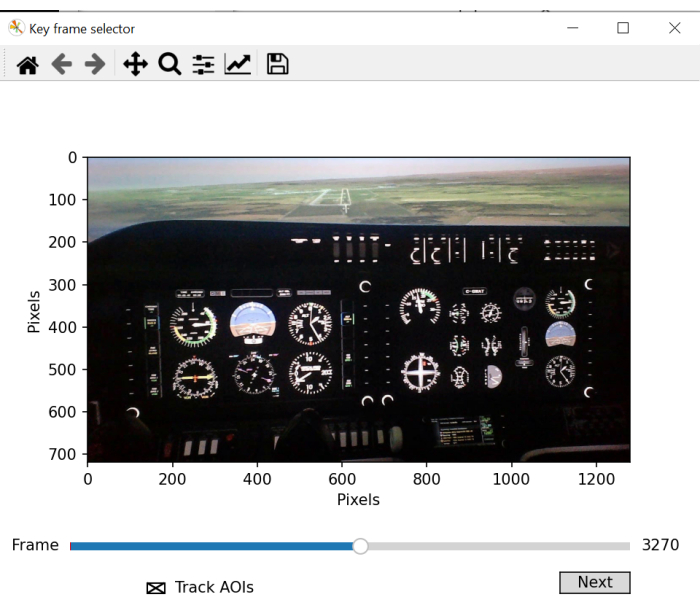

- Verwenden Sie ein Eye-Tracking-Batch-Skript zum manuellen Definieren von AOIs für die Verwendung im Gaze Mapping. Das Skript öffnet ein neues Fenster für die Auswahl von Schlüsselbildern, in dem alle wichtigen AOIs, die analysiert werden sollen, deutlich angezeigt werden sollten. Scrollen Sie durch das Video und wählen Sie einen Frame aus, der alle AOIs deutlich zeigt.

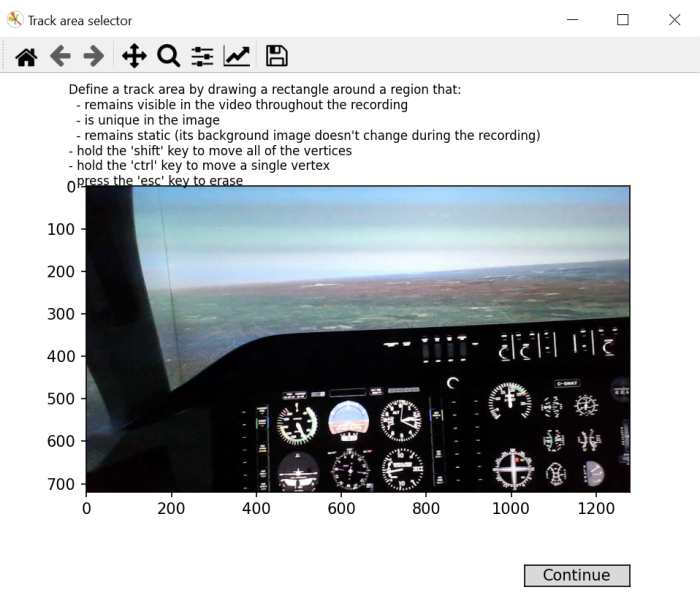

- Befolgen Sie die Anweisungen auf dem Bildschirm und zeichnen Sie ein Rechteck über einen Bereich des Bildes, der im gesamten Video sichtbar und einzigartig ist und stabil bleibt.

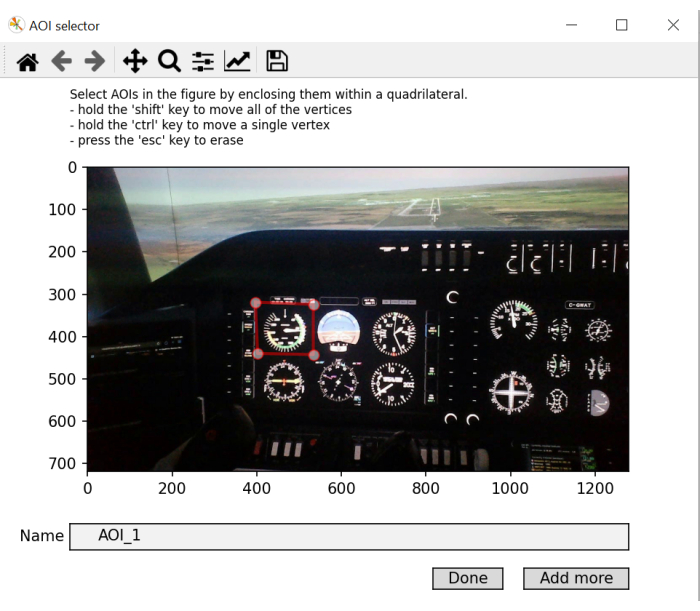

HINWEIS: Der Zweck dieses Schritts besteht darin, einen Koordinatenrahmen auf dem Bildschirm zu generieren, der in der gesamten Videoaufzeichnung verwendet werden kann, da Kopfbewegungen dazu führen, dass sich die Position von Objekten in der Umgebung im Laufe der Videoaufzeichnung ändert. - Zeichnen Sie ein Rechteck für jeden AOI im Bild, nacheinander. Benenne sie entsprechend. Klicken Sie auf Weitere hinzufügen, um ein neues AOI hinzuzufügen, und drücken Sie beim letzten AOI auf Fertig . Wenn die Blickkoordinaten während einer bestimmten Fixierung innerhalb des Objektraums landen, wie er im "In-Screen"-Koordinatensystem definiert ist, beschriften Sie diese Fixierung mit der entsprechenden AOI-Beschriftung.

HINWEIS: Der Zweck dieses Schritts besteht darin, eine Bibliothek von Objektkoordinaten zu generieren, die dann als Referenz verwendet werden, wenn Anvisiertkoordinaten mit Koordinaten auf dem Bildschirm verglichen werden.

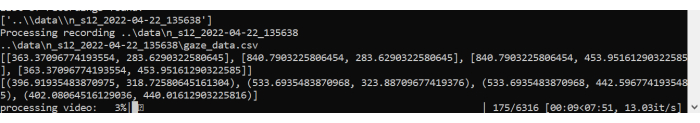

In der Regel gibt es 10 AOIs, aber das hängt davon ab, wie der Flugsimulator konfiguriert ist. Die Instrumententafel kann anders sein. In Übereinstimmung mit früheren Arbeiten 5,18 verwendet die aktuelle Studie die folgenden AOIs: Fluggeschwindigkeit, Fluglage, Höhenmesser, Kurvenkoordinator, Kurs, vertikale Geschwindigkeit, Leistung, Frontscheibe, linkes Fenster und rechtes Fenster (siehe Abbildung 1). - Lassen Sie das Skript mit der Verarbeitung der AOIs beginnen und Fixationsdaten generieren. Es wird ein Diagramm generiert, das die Sakkaden und Fixationen über dem Video zeigt.

- Es werden zwei neue Dateien erstellt: fixations.csv und aoi_parameters.yaml. Der Batch-Prozessor schließt die Nachbearbeitung der Blickdaten für jeden Versuch und jeden Teilnehmer ab.

HINWEIS: Die wichtigsten interessierenden Eye-Tracking-Maßnahmen sind in Tabelle 2 aufgeführt und werden für jeden AOI für jeden Versuch berechnet. - Berechnen Sie für jeden Versuch die traditionellen Blickmetriken 4,5 für jeden AOI basierend auf den in der fixation.csv Datei generierten Daten.

HINWEIS: Hier konzentrieren wir uns auf die Verweildauer (%), die berechnet wird, indem die Summe der Fixationen für einen bestimmten AOI durch die Summe aller Fixationen dividiert und der Quotient mit 100 multipliziert wird, um den Prozentsatz der Zeit zu erhalten, die in einem bestimmten AOI verbracht wurde. Es gibt keine inhärente negative/positive Interpretation aus den berechneten Verweilzeiten. Sie geben einen Hinweis darauf, wo die Aufmerksamkeit überwiegend verteilt wird. Längere durchschnittliche Fixierungsdauern sind ein Hinweis auf einen erhöhten Verarbeitungsbedarf. - Berechnen Sie für jeden Versuch die Blinzelrate mit Gl (4):

Blinkrate = Gesamtblinken/Abschlusszeit (4)

HINWEIS: Frühere Arbeiten haben gezeigt, dass die Blinzelfrequenz umgekehrt proportional zur kognitiven Belastungist 2,6,13,19,20. - Berechnen Sie für jeden Versuch die SGE unter Verwendung von Gl (5)21:

(5)

(5)

Dabei ist v die Wahrscheinlichkeit, dass dasi-te AOI angezeigt wird, und V die Anzahl der AOIs.

ANMERKUNG: Höhere SGE-Werte sind mit einer größeren Fixierungsdispersion verbunden, während niedrigere Werte auf eine stärker fokussierte Allokation der Fixierungenhinweisen 22. - Berechnen Sie für jeden Versuch die GTE mit Gl (6)23:

(6)

(6)

Dabei ist V die Wahrscheinlichkeit, dasi-te AOI zu sehen, und M ist die Wahrscheinlichkeit, das jte AOI zu sehen, wenn das vorherige Betrachten desi-ten AOI berücksichtigt wird.

HINWEIS: Höhere GTE-Werte sind mit unvorhersehbareren, komplexeren visuellen Scanpfaden verbunden, während niedrigere GTE-Werte auf vorhersehbarere, routinemäßigere visuelle Scanpfade hinweisen. - Berechnen Sie die Mittelwerte aller Teilnehmer für jede Eye-Tracking-Ausgabevariable (und AOI, falls angegeben) und jede Aufgabenbedingung. Melden Sie diese Werte.

| Ausdruck | Definition |

| Erfolg (%) | Prozentsatz der erfolgreichen Landungsversuche |

| Fertigstellungszeit(en) | Zeitdauer vom Beginn des Landeszenarios bis zum vollständigen Stillstand des Flugzeugs auf der Landebahn |

| Landehärte (fpm) | Die Rate des Abstands beim Aufsetzen |

| Fehler bei der Landung (°) | Die Differenz zwischen der Mitte des Flugzeugs und der Mitte der 500-Fuß-Landebahnmarkierung am Aufsetzpunkt |

Tabelle 1: Variablen für das Ergebnis der Simulatorleistung. Leistungsabhängige Variablen des Luftfahrzeugs und ihre Definitionen.

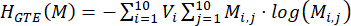

Abbildung 2: Flugbahn des Landeszenarios. Schematische Darstellung von (A) dem Landekreis, der in allen Versuchen absolviert wurde, und (B) der Landebahn mit den 500-Fuß-Markierungen, die als Referenzpunkt für die Landezone verwendet wurden (d. h. orangefarbener Kreis in der Mitte). Bitte klicken Sie hier, um eine größere Version dieser Abbildung anzuzeigen.

Abbildung 3: Kartierung des Interessenbereichs. Eine Abbildung des Batch-Skripts, das ein Fenster für die Frame-Auswahl zeigt. Die Auswahl eines optimalen Frames umfasst die Auswahl eines Videoframes, der die meisten oder alle zu kartierenden Bereiche von Interesse umfasst. Bitte klicken Sie hier, um eine größere Version dieser Abbildung anzuzeigen.

Abbildung 4: Generieren von Area of Interest-Mapping von "In-Screen"-Koordinaten. Eine Illustration des Batch-Skripts, das ein Fenster für die Auswahl von Koordinaten auf dem Bildschirm zeigt. In diesem Schritt wird ein quadratischer/rechteckiger Bereich ausgewählt, der während der gesamten Aufnahme sichtbar bleibt, für das Bild einzigartig ist und statisch bleibt. Bitte klicken Sie hier, um eine größere Version dieser Abbildung anzuzeigen.

Abbildung 5: Identifizieren des zu kartierenden Bereichs von Interesse. Eine Abbildung des Batch-Skriptfensters, in dem Sie interessante Bereiche auswählen und beschriften können. Abkürzung: AOIs = Areas of Interest. Bitte klicken Sie hier, um eine größere Version dieser Abbildung anzuzeigen.

Abbildung 6: Batch-Skriptverarbeitung. Eine Illustration des Batch-Skripts, das das Video und die Blickzuordnung der während des Versuchs vorgenommenen Fixierungen verarbeitet. Bitte klicken Sie hier, um eine größere Version dieser Abbildung anzuzeigen.

| Ausdruck | Definition |

| Verweildauer (%) | Prozentsatz der Summe aller über ein AOI kumulierten Fixationsdauern im Verhältnis zur Summe der über alle AOI kumulierten Fixationsdauern |

| Durchschnittliche Fixationsdauer (ms) | Durchschnittliche Dauer einer Fixation über einen AOI vom Eintritt bis zum Ausgang |

| Blinkfrequenz (Blinken/s) | Anzahl der Blinzeln pro Sekunde |

| SGE (Bits) | Dispersion der Fixierung |

| GTE (Bits) | Komplexität der Scansequenz |

| Anzahl der Kämpfe | Anzahl der kognitiven Tunnelereignisse (>10 s) |

| Gesamtzeit des Kampfes (s) | Gesamtzeit von kognitiven Tunnelereignissen |

Tabelle 2: Variablen für das Eye-Tracking-Ergebnis. Anvisieren von verhaltensabhängigen Variablen und deren Definitionen.

Ergebnisse

Der Einfluss von Aufgabenanforderungen auf die Flugleistung

Die Daten wurden auf der Grundlage erfolgreicher Landeversuche unter einfachen und Notfallbedingungen analysiert. Alle Messungen wurden einem t-Test für paarweise Stichproben unterzogen (Within-Subject-Faktor: Aufgabenbedingung (grundlegend, Notfall)). Alle t-Tests wurden mit einem Alpha-Wert von 0,05 durchgeführt. Vier Teilnehmer stürzten während des Versuchs des Notfallszenarios ab und...

Diskussion

Das hier beschriebene Eye-Tracking-Verfahren ermöglicht die Beurteilung der Informationsverarbeitung in einer Flugsimulator-Umgebung über einen tragbaren Eyetracker. Die Bewertung der räumlichen und zeitlichen Eigenschaften des Blickverhaltens bietet Einblicke in die menschliche Informationsverarbeitung, die mit hochgradig kontrollierten Laborparadigmen ausgiebig untersucht wurde 4,7,28. Die ...

Offenlegungen

Es bestehen keine konkurrierenden finanziellen Interessen.

Danksagungen

Diese Arbeit wird teilweise durch das Canadian Graduate Scholarship (CGS) des Natural Sciences and Engineering Research Council (NSERC) von Kanada und den Exploration Grant (00753) des New Frontiers in Research Fund unterstützt. Alle Meinungen, Erkenntnisse, Schlussfolgerungen oder Empfehlungen, die in diesem Material geäußert werden, stammen von dem/den Autor(en) und spiegeln nicht unbedingt die der Sponsoren wider.

Materialien

| Name | Company | Catalog Number | Comments |

| flight simulator | ALSIM | AL-250 | fixed fully immersive flight simulation training device |

| laptop | Hp | Lenovo | eye tracking data collection laptop; requirements: Windows 10 and python 3.0 |

| portable eye-tracker | AdHawk | MindLink eye tracking glasses (250 Hz, <2° gaze error, front-facing camera); eye tracking batch script is made available with AdHawk device purchase |

Referenzen

- de Brouwer, A. J., Flanagan, J. R., Spering, M. Functional use of eye movements for an acting system. Trends Cogn Sci. 25 (3), 252-263 (2021).

- Ayala, N., Kearns, S., Cao, S., Irving, E., Niechwiej-Szwedo, E. Investigating the role of flight phase and task difficulty on low-time pilot performance, gaze dynamics and subjective situation awareness during simulated flight. J Eye Mov Res. 17 (1), (2024).

- Land, M. F., Hayhoe, M. In what ways do eye movements contribute to everyday activities. Vision Res. 41 (25-26), 3559-3565 (2001).

- Ayala, N., Zafar, A., Niechwiej-Szwedo, E. Gaze behavior: a window into distinct cognitive processes revealed by the Tower of London test. Vision Res. 199, 108072 (2022).

- Ayala, N. The effects of task difficulty on gaze behavior during landing with visual flight rules in low-time pilots. J Eye Mov Res. 16, 10 (2023).

- Glaholt, M. G. . Eye tracking in the cockpit: a review of the relationships between eye movements and the aviators cognitive state. , (2014).

- Hodgson, T. L., Bajwa, A., Owen, A. M., Kennard, C. The strategic control of gaze direction in the Tower-of-London task. J Cognitive Neurosci. 12 (5), 894-907 (2000).

- van De Merwe, K., Van Dijk, H., Zon, R. Eye movements as an indicator of situation awareness in a flight simulator experiment. Int J Aviat Psychol. 22 (1), 78-95 (2012).

- Kok, E. M., Jarodzka, H. Before your very eyes: The value and limitations of eye tracking in medical education. Med Educ. 51 (1), 114-122 (2017).

- Di Stasi, L. L., et al. Gaze entropy reflects surgical task load. Surg Endosc. 30, 5034-5043 (2016).

- Laubrock, J., Krutz, A., Nübel, J., Spethmann, S. Gaze patterns reflect and predict expertise in dynamic echocardiographic imaging. J Med Imag. 10 (S1), S11906-S11906 (2023).

- Brams, S., et al. Does effective gaze behavior lead to enhanced performance in a complex error-detection cockpit task. PloS One. 13 (11), e0207439 (2018).

- Peißl, S., Wickens, C. D., Baruah, R. Eye-tracking measures in aviation: A selective literature review. Int J Aero Psych. 28 (3-4), 98-112 (2018).

- Ziv, G. Gaze behavior and visual attention: A review of eye tracking studies in aviation. Int J Aviat Psychol. 26 (3-4), 75-104 (2016).

- Ke, L., et al. Evaluating flight performance and eye movement patterns using virtual reality flight simulator. J. Vis. Exp. (195), e65170 (2023).

- Krejtz, K., et al. Gaze transition entropy. ACM Transactions on Applied Perception. 13 (1), 1-20 (2015).

- Taylor, R. M., Selcon, S. J. Cognitive quality and situational awareness with advanced aircraft attitude displays. Proceedings of the Human Factors Society Annual Meeting. 34 (1), 26-30 (1990).

- Ayala, N., et al. Does fiducial marker visibility impact task performance and information processing in novice and low-time pilots. Computers & Graphics. 199, 103889 (2024).

- Recarte, M. &. #. 1. 9. 3. ;., Pérez, E., Conchillo, &. #. 1. 9. 3. ;., Nunes, L. M. Mental workload and visual impairment: Differences between pupil, blink, and subjective rating. Spanish J Psych. 11 (2), 374-385 (2008).

- Zheng, B., et al. Workload assessment of surgeons: correlation between NASA TLX and blinks. Surg Endosc. 26, 2746-2750 (2012).

- Shannon, C. E. A mathematical theory of communication. The Bell System Technical Journal. 27 (3), 379-423 (1948).

- Shiferaw, B., Downey, L., Crewther, D. A review of gaze entropy as a measure of visual scanning efficiency. Neurosci Biobehav R. 96, 353-366 (2019).

- Ciuperca, G., Girardin, V. Estimation of the entropy rate of a countable Markov chain. Commun Stat-Theory and Methods. 36 (14), 2543-2557 (2007).

- Federal aviation administration. . Airplane flying handbook. , (2021).

- Brown, D. L., Vitense, H. S., Wetzel, P. A., Anderson, G. M. Instrument scan strategies of F-117A Pilots. Aviat, Space, Envir Med. 73 (10), 1007-1013 (2002).

- Lu, T., Lou, Z., Shao, F., Li, Y., You, X. Attention and entropy in simulated flight with varying cognitive loads. Aerosp Medicine Hum Perf. 91 (6), 489-495 (2020).

- Dehais, F., Peysakhovich, V., Scannella, S., Fongue, J., Gateau, T. "Automation surprise" in aviation: Real-time solutions. , 2525-2534 (2015).

- Kowler, E. Eye movements: The past 25 years. J Vis Res. 51 (13), 1457-1483 (2011).

- Zafar, A., et al. Investigation of camera-free eye-tracking glasses compared to a video-based system. Sensors. 23 (18), 7753 (2023).

- Leube, A., Rifai, K. Sampling rate influences saccade detection in mobile eye tracking of a reading task. J Eye Mov Res. 10 (3), (2017).

- Diaz-Piedra, C., et al. The effects of flight complexity on gaze entropy: An experimental study with fighter pilots. Appl Ergon. 77, 92-99 (2019).

- Shiferaw, B. A., et al. Stationary gaze entropy predicts lane departure events in sleep-deprived drivers. Sci Rep. 8 (1), 1-10 (2018).

- Parker, A. J., Kirkby, J. A., Slattery, T. J. Undersweep fixations during reading in adults and children. J Exp Child Psychol. 192, 104788 (2020).

- Ayala, N., Kearns, S., Irving, E., Cao, S., Niechwiej-Szwedo, E. The effects of a dual task on gaze behavior examined during a simulated flight in low-time pilots. Front Psychol. 15, 1439401 (2024).

- Ayala, N., Heath, M. Executive dysfunction after a sport-related concussion is independent of task-based symptom burden. J Neurotraum. 37 (23), 2558-2568 (2020).

- Huddy, V. C., et al. Gaze strategies during planning in first-episode psychosis. J Abnorm Psychol. 116 (3), 589 (2007).

- Irving, E. L., Steinbach, M. J., Lillakas, L., Babu, R. J., Hutchings, N. Horizontal saccade dynamics across the human life span. Invest Opth Vis Sci. 47 (6), 2478-2484 (2006).

- Yep, R., et al. Interleaved pro/anti-saccade behavior across the lifespan. Front Aging Neurosci. 14, 842549 (2022).

- Manoel, E. D. J., Connolly, K. J. Variability and the development of skilled actions. Int J Psychophys. 19 (2), 129-147 (1995).

Nachdrucke und Genehmigungen

Genehmigung beantragen, um den Text oder die Abbildungen dieses JoVE-Artikels zu verwenden

Genehmigung beantragenWeitere Artikel entdecken

This article has been published

Video Coming Soon

Copyright © 2025 MyJoVE Corporation. Alle Rechte vorbehalten