Method Article

Generación de avatares de combatientes a partir de imágenes de escenas de entrenamiento de armas para simulaciones de exposición a explosiones

En este artículo

Resumen

Se desarrolló un marco computacional para reconstruir automáticamente escenas virtuales compuestas por avatares 3D de soldados utilizando datos de imagen y/o video. Las escenas virtuales ayudan a estimar la exposición a la sobrepresión de la explosión durante el entrenamiento con armas. La herramienta facilita una representación realista de la postura humana en simulaciones de exposición a explosiones en varios escenarios.

Resumen

El personal militar que participa en el entrenamiento con armas es sometido a repetidas explosiones de bajo nivel. El método predominante para estimar las cargas de voladura involucra medidores de voladura portátiles. Sin embargo, mediante el uso de datos de sensores portátiles, las cargas de explosión en la cabeza u otros órganos no se pueden estimar con precisión sin el conocimiento de la postura corporal del miembro del servicio. Se desarrolló una plataforma computacional experimental complementaria aumentada por imagen y video para llevar a cabo un entrenamiento con armas más seguras. Este estudio describe el protocolo para la generación automatizada de escenas de entrenamiento de armas a partir de datos de video para simulaciones de exposición a explosiones. La escena de la explosión extraída de los datos de video en el instante del disparo del arma involucra a los avatares del cuerpo del miembro del servicio, armas, tierra y otras estructuras. El protocolo computacional se utiliza para reconstruir las posiciones y posturas de los miembros del servicio utilizando estos datos. Los datos de imagen o video extraídos de las siluetas corporales de los miembros del servicio se utilizan para generar un esqueleto anatómico y los datos antropométricos clave. Estos datos se utilizan para generar los avatares de la superficie corporal en 3D segmentados en partes individuales del cuerpo y transformados geométricamente para que coincidan con las posturas de los miembros del servicio extraídas. La escena final de entrenamiento de armas virtuales se utiliza para simulaciones computacionales en 3D de la carga de ondas expansivas de armas en los miembros del servicio. El generador de escenas de entrenamiento de armas se ha utilizado para construir avatares anatómicos en 3D de cuerpos individuales de miembros del servicio a partir de imágenes o videos en varias orientaciones y posturas. Se presentan los resultados de la generación de una escena de entrenamiento a partir de datos de imágenes de sistemas de armas de asalto y sistemas de armas de mortero montados en el hombro. La herramienta Sobrepresión de explosión (BOP) utiliza la escena de entrenamiento de armas virtuales para simulaciones en 3D de la carga de ondas de explosión en los cuerpos de avatar de los miembros del servicio. Este artículo presenta simulaciones computacionales en 3D de la propagación de las ondas expansivas a partir de disparos de armas y las correspondientes cargas explosivas en miembros del servicio en entrenamiento.

Introducción

Durante el entrenamiento militar, los miembros del servicio y los instructores están expuestos con frecuencia a explosiones de bajo nivel con armas pesadas y ligeras. Estudios recientes han demostrado que la exposición a blastos podría conducir a una disminución del rendimiento neurocognitivo 1,2 y alteraciones en los biomarcadores sanguíneos 3,4,5,6. La exposición repetida a explosiones de bajo nivel dificulta el mantenimiento de un rendimiento óptimo y la minimización del riesgo de lesiones 7,8. El enfoque convencional que utiliza sensores de presión portátiles tiene inconvenientes, especialmente cuando se trata de determinar con precisión las presiones de explosión en la cabeza9. Los efectos adversos conocidos de la exposición repetida a explosiones de bajo nivel en el rendimiento humano (por ejemplo, durante el entrenamiento y en funciones operativas) exacerban este problema. Los mandatos del Congreso (Secciones 734 y 717) han estipulado el requisito de monitorear la exposición a explosiones en el entrenamiento y el combate y su inclusión en el historial médico del miembro del servicio10.

Los sensores portátiles se pueden usar para monitorear la sobrepresión de la explosión durante estas operaciones de entrenamiento de combate. Sin embargo, estos sensores están influenciados por variables como la postura corporal, la orientación y la distancia a la fuente de la explosión debido a la naturaleza compleja de las interacciones de las ondas de explosión con el cuerpo humano9. Los siguientes factores afectan a la distribución de la presión y a las mediciones de los sensores9:

Distancia desde la fuente de la explosión: La intensidad de la presión varía con la distancia a medida que la onda expansiva se dispersa y atenúa. Los sensores más cercanos a la voladura registran presiones más altas, lo que afecta la precisión y la consistencia de los datos.

Postura corporal: Diferentes posturas exponen varias superficies corporales a la explosión, alterando la distribución de la presión. Por ejemplo, estar de pie frente a agacharse da como resultado diferentes lecturas de presión 9,11.

Orientación: El ángulo del cuerpo en relación con la fuente de la explosión afecta la forma en que la onda de presión interactúa con el cuerpo, lo que lleva a discrepancias en las lecturas9. Las simulaciones numéricas basadas en la física proporcionan evaluaciones más precisas al tener en cuenta sistemáticamente estas variables, ofreciendo un análisis controlado y completo en comparación con los sensores portátiles, que están inherentemente influenciados por estos factores.

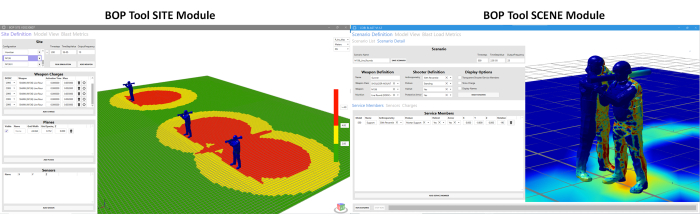

En respuesta a estos desafíos, ha habido un esfuerzo concertado para desarrollar herramientas más sofisticadas. En esta dirección, se desarrolla la herramienta de sobrepresión por explosión (BOP). Esta herramienta está desarrollada para estimar la exposición a la sobrepresión bajo diferentes posturas de miembros del servicio y posiciones alrededor de los sistemas de armas. Hay dos módulos diferentes en la herramienta BOP11. Ellos son: (a) el módulo SCENE de la herramienta BOP y (b) el módulo SITE de la herramienta BOP. Estos módulos se utilizan para estimar la sobrepresión de la explosión durante el disparo del arma12. El módulo BOP SCENE está desarrollado para estimar las sobrepresiones de voladura experimentadas por miembros individuales del servicio o instructores que participan en un escenario de capacitación, mientras que el módulo BOP SITE reconstruye una vista panorámica del curso de capacitación, representando las zonas de sobrepresión de voladura generadas por múltiples estaciones de disparo. La Figura 1 muestra una instantánea de ambos módulos. Actualmente, los módulos de herramientas BOP comprenden características de sobrepresión de explosión de armas (término de fuente de explosión equivalente) para cuatro sistemas de armas de nivel 1 definidos por el Departamento de Defensa, incluido el rifle de francotirador de aplicación especial (SASR) M107 calibre .50, el arma de asalto montada en el hombro M136, el mortero de fuego indirecto M120 y las cargas de ruptura. El término núcleo de explosión de arma se refiere a un término equivalente de fuente de explosión desarrollado para replicar el mismo campo de explosión que rodea un sistema de armas que el del arma real. Una descripción más detallada del marco computacional utilizado para el desarrollo de la herramienta BOP está disponible para referencia adicional11. Las simulaciones de sobrepresión se ejecutan utilizando el motor de resolución CoBi-Blast. Se trata de una herramienta multifísica multiescala para simular sobrepresiones de voladura. Las capacidades de modelado de voladuras del motor se validan con los datos experimentales de la literatura12. Esta herramienta BOP se está integrando actualmente en el kit de herramientas de los gestores de campos de tiro (RMTK) para su uso en diferentes campos de entrenamiento con armas. RMTK es un conjunto de herramientas de escritorio multiservicio diseñadas para satisfacer las necesidades de los gerentes de campo de tiro en todo el Ejército, el Cuerpo de Marines, la Fuerza Aérea y la Armada mediante la automatización de las operaciones de campo, la seguridad y los procesos de modernización.

Figura 1: Interfaz gráfica de usuario (GUI) para el módulo SCENE de la herramienta BOP y el módulo SITE de la herramienta BOP. El módulo BOP SCENE está diseñado para estimar las sobrepresiones de voladura en modelos de cuerpos de instructores y miembros del servicio, mientras que el módulo BOP SITE está diseñado para proporcionar una estimación de los contornos de sobrepresión en un plano que representa el campo de entrenamiento. El usuario tiene la opción de elegir la altura a la que se sitúa el avión en relación con el suelo. Haga clic aquí para ver una versión más grande de esta figura.

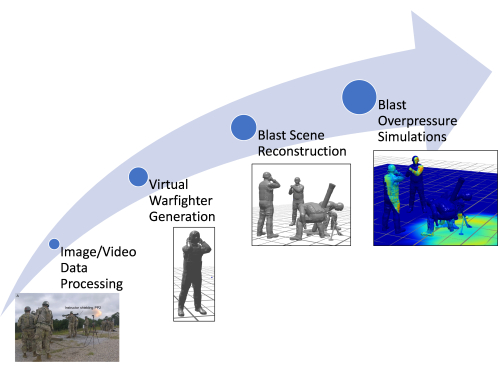

Una limitación del módulo SCENE de la herramienta BOP existente es el uso de datos estimados manualmente para crear modelos virtuales del cuerpo de los miembros del servicio, incluida su antropometría, postura y posición. La generación manual de los miembros del servicio virtual en la postura adecuada requiere mucha mano de obra y tiempo 11,12. La herramienta BOP heredada (enfoque heredado) utiliza una base de datos de posturas preconfiguradas para construir la escena de entrenamiento del arma en función de los datos de la imagen (si están disponibles). Además, dado que las posturas se aproximan manualmente a través de la evaluación visual, es posible que no se capturen las posturas correctas para un entorno postural complejo. Como resultado, este enfoque introduce imprecisiones en la exposición estimada a la sobrepresión para los miembros individuales del servicio (ya que un cambio en la postura puede modificar la exposición a la sobrepresión en regiones más vulnerables). El documento presenta las mejoras que se realizaron en el marco computacional existente para permitir la generación rápida y automática de modelos de miembros del servicio utilizando las herramientas de estimación de pose de última generación existentes. En este artículo se analiza la mejora de la herramienta BOP, haciendo especial hincapié en el desarrollo de una nueva y rápida línea de cálculo para reconstruir escenas de voladuras utilizando datos de vídeo e imagen. La herramienta mejorada también puede reconstruir modelos corporales detallados de los miembros del servicio e instructores en el momento del disparo del arma, utilizando datos de video para crear avatares personalizados en comparación con el enfoque heredado. Estos avatares reflejan con precisión la postura de los miembros del servicio. Este trabajo agiliza el proceso de generación de escenas de explosión y facilita una inclusión más rápida de escenas de explosión para sistemas de armas adicionales, lo que reduce significativamente el tiempo y el esfuerzo necesarios para la creación de escenas de entrenamiento de armas. La Figura 2 muestra un esquema del marco computacional mejorado discutido en este documento.

Figura 2: Esquema que muestra el diagrama de flujo general del proceso en el marco computacional. Los diferentes pasos incluyen el procesamiento de datos de imagen/video, la generación de combatientes virtuales, la reconstrucción de la escena de la explosión y las simulaciones de sobrepresión de la explosión. Haga clic aquí para ver una versión más grande de esta figura.

El artículo presenta el enfoque automatizado que se está implementando en la herramienta BOP, que representa una mejora significativa en las herramientas computacionales disponibles para estimar la exposición a la sobrepresión durante el entrenamiento y las operaciones. Esta herramienta se distingue por su rápida generación de avatares personalizados y escenarios de entrenamiento, lo que permite simulaciones inmersivas de sobrepresión de voladura. Esto marca una desviación significativa de la dependencia tradicional de los modelos de cuerpo humano promediados por la población, ofreciendo un enfoque más preciso e individualizado.

Herramientas computacionales utilizadas en el proceso de automatización

La automatización de la generación de modelos de miembros del servicio virtual es un proceso de varios pasos que aprovecha las herramientas informáticas avanzadas para transformar datos de imagen o video sin procesar en representaciones 3D detalladas. Todo el proceso está automatizado, pero se puede adaptar para permitir la entrada manual de mediciones conocidas si es necesario.

Herramientas de estimación de poses en 3D: En el núcleo de la canalización de automatización se encuentran las herramientas de estimación de poses en 3D. Estas herramientas analizan los datos de la imagen para identificar la posición y la orientación de cada articulación en el cuerpo del miembro del servicio, creando efectivamente un esqueleto digital. Actualmente, la canalización es compatible con Mediapipe y MMPose, que ofrecen API de Python. Sin embargo, el sistema está diseñado teniendo en cuenta la flexibilidad, lo que permite la incorporación de otras herramientas, como cámaras de profundidad, siempre que puedan emitir los datos 3D necesarios de las articulaciones y los huesos.

Generador de modelos antropométricos (AMG): Una vez estimada la pose 3D, entra en juego el AMG. Esta herramienta utiliza datos de pose para crear un modelo de superficie de piel en 3D que coincida con las dimensiones corporales únicas del miembro del servicio. La herramienta AMG permite la introducción automática o manual de mediciones antropométricas, que luego se vinculan a los componentes principales de la herramienta para transformar la malla corporal 3D en consecuencia.

Modelado esquelético de OpenSim: El siguiente paso involucra la plataforma OpenSim13 de código abierto, donde se ajusta un modelo esquelético para alinearlo con los datos de pose 3D. Las herramientas de estimación de la postura no imponen longitudes óseas consistentes en el esqueleto, lo que puede conducir a una asimetría poco realista en el cuerpo. El uso de un esqueleto OpenSim anatómicamente correcto produce una estructura ósea más realista. Los marcadores se colocan en el esqueleto de OpenSim para corresponderse con los centros de las articulaciones identificados por la herramienta de estimación de posición. A continuación, este modelo esquelético se monta en la malla de piel 3D utilizando técnicas de animación estándar.

Cinemática inversa y secuencias de comandos de Python: Para finalizar la pose del miembro del servicio virtual, se emplea un algoritmo de cinemática inversa. Este algoritmo ajusta el modelo de esqueleto de OpenSim para que coincida mejor con la pose 3D estimada. Todo el proceso de posado está totalmente automatizado e implementado en Python 3. A través de la integración de estas herramientas, el proceso de generación de modelos de miembros del servicio virtual se ha acelerado significativamente, reduciendo el tiempo requerido de días a segundos o minutos. Este avance representa un salto adelante en la simulación y análisis de escenarios de entrenamiento de armas, proporcionando reconstrucciones rápidas de escenarios específicos documentados mediante imágenes o video.

Protocolo

Las imágenes y videos utilizados en este estudio no fueron obtenidos directamente por los autores de sujetos humanos. Una imagen se obtuvo de recursos gratuitos en Wikimedia Commons, que está disponible bajo una licencia de dominio público. La otra imagen fue proporcionada por colaboradores del Instituto de Investigación del Ejército Walter Reed (WRAIR). Los datos obtenidos de WRAIR no fueron identificados y se compartieron de acuerdo con sus lineamientos institucionales. Para las imágenes proporcionadas por WRAIR, el protocolo siguió las pautas del comité de ética de investigación en humanos de WRAIR, incluida la obtención de todas las aprobaciones y consentimientos necesarios.

1. Acceso al módulo SCENE de la herramienta BOP

- Abra el módulo SCENE de la herramienta BOP desde la interfaz de la herramienta BOP haciendo clic en el botón Módulo SCENE de la herramienta BOP .

- Haga clic en Definición de escenario y, a continuación, haga clic en la pestaña Detalle del escenario .

2. Lectura y procesamiento de los datos de la imagen

- Haga clic en el botón POSETOOL IMPORT en el módulo SCENE de la herramienta BOP. Se abre una ventana emergente en la que se pide al usuario que seleccione la imagen o el vídeo correspondiente.

- Navegue a la carpeta y seleccione la imagen/video relevante usando las operaciones del mouse.

- Haga clic en Abrir en la ventana emergente una vez que se selecciona una imagen.

NOTA: Esta operación lee el archivo de imagen o video, genera una imagen si se selecciona un video, ejecuta el algoritmo de estimación de pose en segundo plano, genera los modelos de miembros del servicio virtual involucrados en la escena de entrenamiento de armas y los carga en el módulo SCENE de la herramienta BOP en sus posiciones respectivas.

3. Configuración del arma y el tirador

- Elija un nombre para el escenario mediante el cuadro de texto debajo de Nombre del escenario. Esta es una elección del usuario. Para el escenario descrito aquí, los desarrolladores han elegido el nombre de escenario BlastDemo1.

- Elija un nombre personalizado en el campo Nombre en la definición de arma. Esta es, de nuevo, una elección del usuario. Para el escenario discutido aquí, los desarrolladores han elegido el nombre de arma 120Mortar.

- Seleccione la clase de arma adecuada, por ejemplo, MORTERO PESADO, de la lista de opciones en el menú desplegable.

- Selecciona el arma (M120 en este caso) de la lista de opciones en el menú desplegable. Al seleccionar el sistema de armas, el núcleo de explosión correspondiente se cargará automáticamente en la GUI en la subpestaña Cargas.

NOTA: El menú desplegable tendrá los diferentes sistemas de armas posibles específicos para la clase de arma elegida anteriormente. - Selecciona el cartucho de munición (proyectil de entrenamiento de alcance completo) para el sistema de armas elegido usando las opciones desplegables.

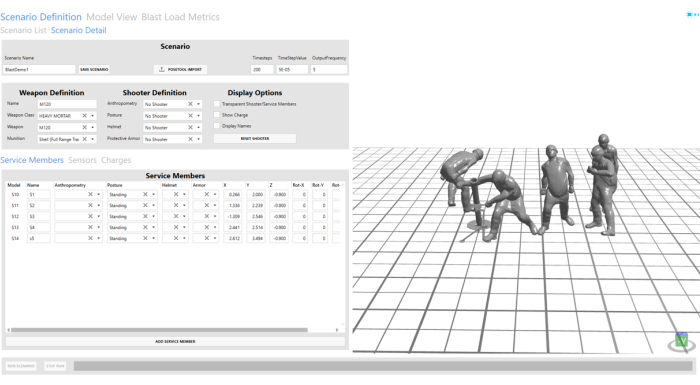

- Seleccione Ningún tirador en los campos Antropometría, Postura, Casco y Armadura protectora en la Definición de tirador en las opciones desplegables. Consulte la Figura 3 para ver el tirador y los miembros del servicio configurados.

NOTA: Dado que el tirador se incluirá en la escena importada a través del paso 4, no se seleccionó ningún tirador en la definición del tirador.

Figura 3: Escena de voladura importada de los datos de la imagen. La escena de la voladura es visible en la ventana de visualización en el lado derecho de la herramienta GUI. Haga clic aquí para ver una versión más grande de esta figura.

4. Configuración de los miembros del servicio

- Haga clic en la pestaña Miembros del Servicio . Esta pestaña controla la posición y orientación de los miembros del servicio importados de los datos de la imagen; use las opciones X, Y, Z y rotación para hacer esto. Para el avatar correspondiente al artillero asistente, los autores han ajustado la posición Y de 2.456 a 2 para una posición de artillero asistente más razonable.

- Elija nombres personalizados para todos los modelos de miembros del servicio virtual importados a la GUI mediante el campo Nombre en la pestaña Miembros del servicio. Aquí se eligen S1, S2, S3, S4 y S5 para todos los modelos de miembros del servicio importados automáticamente.

NOTA: Para el escenario discutido aquí, se denominaron S1 y S2. Los demás campos se rellenan automáticamente. Los usuarios pueden modificarlos para refinar la posición/posturas estimadas automáticamente. - Utilice el botón Eliminar para eliminar S2, S4 y S5. En el escenario que se muestra aquí, solo el tirador y el artillero asistente están presentes en el momento del disparo.

NOTA: Esto se realizó para demostrar las opciones de usuario personalizadas para eliminar o agregar modelos de miembros del servicio según sea necesario a una escena existente.

5. Configuración de los sensores virtuales

- Vaya a la pestaña Sensores . Agregue un nuevo sensor virtual haciendo clic en Agregar sensor.

- Elija un nombre personalizado en el campo Nombre. Los desarrolladores han elegido V1 para la demostración en este documento.

- Seleccione el tipo como Virtual haciendo clic en el menú desplegable debajo del campo Tipo de sensor.

- Elija la ubicación del sensor (-0,5, 2, 0,545) editando los cuadros de texto debajo de los campos X, Y y Z. Para el escenario discutido aquí, los desarrolladores han creado cuatro sensores diferentes en cuatro ubicaciones diferentes con fines de demostración. Los desarrolladores han elegido V2, V3 y V4 como nombres de sensores para los sensores adicionales.

- Repita los pasos de 5.1 a 5.4 para crear sensores adicionales en (-0.5, 1, 0.545), (-0.5, 0.5, 0.545) y (-0.5, 0, 0.545). Deje el valor de Rotación en cero.

NOTA: El usuario también puede elegir sensores planos durante los cuales la rotación se puede utilizar para ajustar la orientación del sensor con respecto a la carga de explosión.

6. Guardar y ejecutar el programa

- Guarde la escena de entrenamiento de armas haciendo clic en el botón Guardar escenario en la GUI en la parte superior.

- Ejecute la simulación de sobrepresión de explosión para la escena de entrenamiento del arma M120 haciendo clic en el botón Ejecutar escenario en la parte inferior. El progreso de la simulación se muestra mediante la barra de progreso en la parte inferior.

7. Visualización de los resultados

- Vaya a la pestaña Vista del modelo para examinar la simulación de exposición a la sobrepresión de la voladura.

- Haga clic en el botón Actual para cargar la simulación completada en la ventana de visualización.

- Una vez cargada la simulación, visualícela usando el botón Reproducir en la parte inferior de la pantalla.

- El usuario puede elegir entre las diferentes opciones de la barra de navegación para reproducir y pausar la simulación a diferentes velocidades. La captura de pantalla de los controles de reproducción a continuación muestra más opciones. El usuario puede controlar la ventana interactiva con el ratón. Haga clic con el botón derecho y arrastre para rotar el modo, el botón izquierdo para trasladar el modelo y el botón central para desplazarse hacia adentro o hacia afuera.

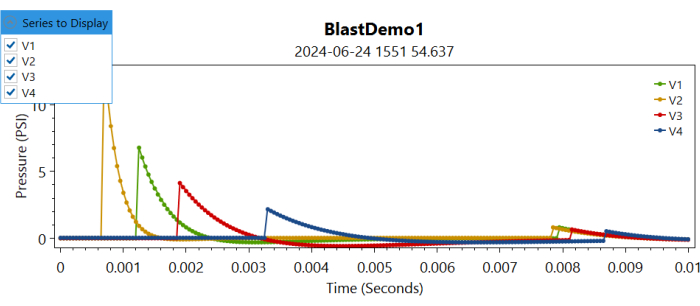

- Después de revisar la simulación, navegue hasta la pestaña Métricas de carga explosiva haciendo clic en ella.

- Haga clic en el botón Actual para cargar los gráficos de sobrepresión en las ubicaciones de los sensores virtuales.

NOTA: Esto cargará la información de sobrepresión en las diferentes ubicaciones de los sensores en diferentes gráficos. - Navegue hasta la serie desplegable para mostrar y seleccione marcando la casilla del sensor correspondiente para trazar la sobrepresión registrada en ese sensor virtual (consulte la Figura 4).

Figura 4: Controles de trazado para sobrepresiones en diferentes sensores virtuales a lo largo del tiempo. Los usuarios pueden elegir la serie que se mostrará marcando o desmarcando los diferentes sensores. Haga clic aquí para ver una versión más grande de esta figura.

Resultados

Reconstrucción automatizada de miembros del servicio virtual y escenas de voladuras

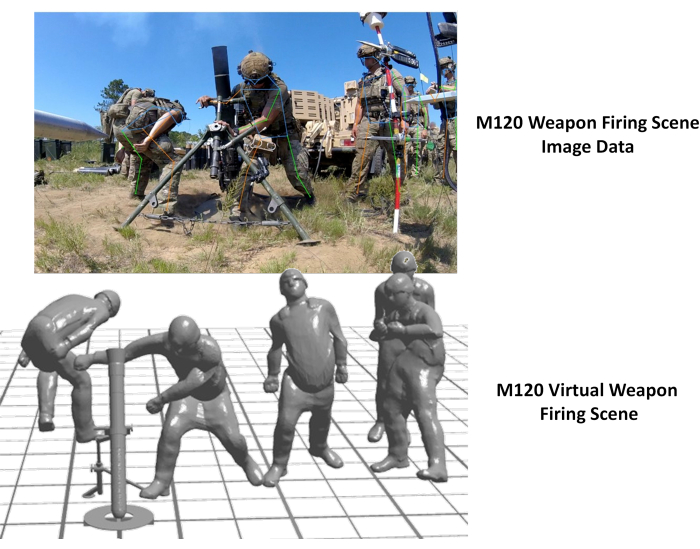

El modelo virtual automatizado del cuerpo de los miembros del servicio y la generación de modelos de escenas de entrenamiento de armas se lograron a través de las capacidades de automatización de la herramienta BOP. En la figura 5 se muestra la escena de entrenamiento virtual generada a partir de los datos de la imagen. Como se puede observar aquí, la escena resultante era una buena representación de los datos de la imagen. La imagen utilizada para la demostración en la Figura 5 se obtuvo de Wikimedia Commons.

Figura 5: Escena de entrenamiento con armas virtuales a partir de los datos de la imagen. La imagen del lado izquierdo muestra los datos de la imagen correspondientes al disparo de un arma AT4, y el lado derecho muestra la escena de entrenamiento de armas virtual generada automáticamente. Esta cifra ha sido obtenida de Wikimedia Commons. Haga clic aquí para ver una versión más grande de esta figura.

Además, se aplicó el enfoque para reconstruir la escena de disparo del arma M120. La imagen fue recopilada por WRAIR como parte de un esfuerzo de recopilación de datos de presión para el arma de mortero M120. La Figura 6 a continuación ilustra la escena de disparo de arma virtual reconstruida junto con la imagen original. Se observó una discrepancia en la posición del artillero asistente en la reconstrucción virtual. Esto se puede corregir ajustando la posición del artillero asistente utilizando las opciones de usuario de la GUI de BOP. Además, la postura pélvica del instructor parecía inexacta, probablemente debido a la obstrucción de las estacas en las imágenes. La integración de este enfoque con otras modalidades de imágenes de profundidad sería beneficiosa para abordar estas discrepancias.

Figura 6: Escena de entrenamiento con armas virtuales a partir de los datos de la imagen. La imagen del lado izquierdo muestra los datos de la imagen correspondientes al disparo de un arma M120 y el lado derecho muestra la escena de entrenamiento de arma virtual generada automáticamente. Haga clic aquí para ver una versión más grande de esta figura.

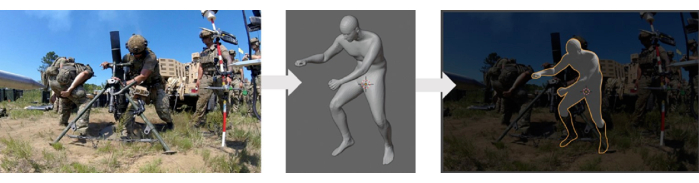

Validación del enfoque de generación automatizada de escenas

El generador de modelos de cuerpo humano empleado en este estudio se sometió a validación utilizando la base de datos de escaneo de cuerpo humanoANSUR II 14, que incluyó mediciones antropométricas a partir de datos de imágenes médicas. Un método de reconstrucción automatizado, que utilizó este generador de modelos del cuerpo humano, se sometió a una validación cualitativa con los datos disponibles. Este proceso de validación consistió en comparar los modelos reconstruidos con los datos experimentales (imágenes) mediante la superposición de ellos. La Figura 7 presenta una comparación entre los modelos de avatar 3D y los datos experimentales. Sin embargo, es necesaria una validación más exhaustiva de este método, lo que requeriría datos experimentales adicionales de la escena, incluidas las posiciones, posturas y orientaciones precisas de los diferentes miembros del servicio que participan en una escena de entrenamiento.

Figura 7: Comparación cualitativa del modelo de cuerpo humano virtual generado con la imagen. El panel izquierdo muestra la imagen original, el panel central muestra el modelo de cuerpo virtual generado y el panel derecho muestra el modelo virtual superpuesto a la imagen original. Haga clic aquí para ver una versión más grande de esta figura.

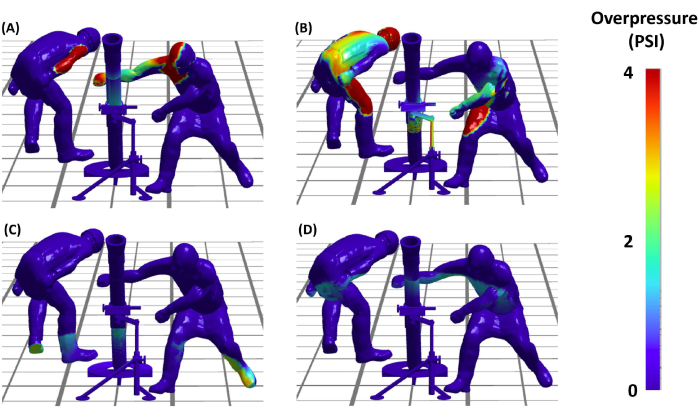

Simulaciones representativas de sobrepresión de voladura

Después de configurar la escena de la voladura, los autores pudieron pasar a la fase crítica de las simulaciones de sobrepresión de voladura (BOP). Esto nos permitirá comprender la distribución de las cargas de explosión en diferentes miembros del servicio involucrados en una escena de disparo de arma. En la Figura 8 se presentan los resultados de estas simulaciones de BOP durante el evento de disparo de armas AT4. Las simulaciones proporcionan una visualización detallada de las cargas de sobrepresión sobre el miembro del servicio virtual en la escena en diferentes instantes a lo largo del tiempo. En conclusión, los resultados demuestran no solo la factibilidad, sino también la efectividad del protocolo en la creación de reconstrucciones precisas y analíticamente útiles de escenarios de entrenamiento de armas, allanando así el camino para estudios más avanzados en seguridad y eficiencia de entrenamiento militar.

Figura 8: Exposición a la sobrepresión de la explosión en el tirador. (A, B, C y D) Los cuatro paneles muestran la sobrepresión de explosión predicha por el modelo en los miembros del servicio virtual involucrados en el disparo de mortero M120 en diferentes instantes de tiempo. Los paneles (C) y (D) muestran la propagación de la sobrepresión debido a la reflexión del suelo. Haga clic aquí para ver una versión más grande de esta figura.

Discusión

El marco computacional presentado en este artículo acelera significativamente la generación de escenas de entrenamiento con armas explosivas en comparación con los métodos manuales utilizados anteriormente que utilizan la evaluación visual. Este enfoque demuestra la capacidad del marco para capturar y reconstruir rápidamente diversas posturas militares.

Ventajas del enfoque actual

La creación de modelos virtuales del cuerpo humano en posturas y posiciones específicas es una tarea desafiante, con herramientas limitadas disponibles para este propósito. El método convencional empleado en el enfoque heredado, específicamente para la herramienta BOP, utilizó CoBi-DYN 14,15,16,17. Este método consistía en crear manualmente modelos virtuales del cuerpo humano con ropa, cascos, armaduras protectoras y botas. Los modelos se generaron a través de una aproximación visual aproximada, careciendo de un enfoque sistemático. En la herramienta BOP heredada, se utilizó CoBi-DYN para crear una base de datos de modelos del cuerpo humano a la que se podía acceder durante el paso de configuración del escenario. Los usuarios seleccionarían manualmente una configuración postural aproximada y los posicionarían aproximadamente para que un sistema de armas en particular ejecutara el escenario BOP. Aunque la reconstrucción de la escena de la voladura a partir de la base de datos de miembros del servicio existente (a la que se accede desde el menú desplegable de la herramienta BOP) fue relativamente rápida, la creación inicial de la base de datos del modelo de miembro del servicio virtual llevó mucho tiempo, ya que tardó entre 16 y 24 horas por escena debido a la naturaleza manual y aproximada del proceso. Por el contrario, el nuevo enfoque aprovecha las herramientas de estimación de poses bien establecidas para la creación más automatizada y rápida de modelos de cuerpos humanos virtuales. Estas herramientas utilizan automáticamente datos de video e imagen para reconstruir rápidamente escenas de explosiones con avatares virtuales de miembros del servicio. Esto reduce significativamente el tiempo necesario para crear la base de datos del cuerpo humano. El enfoque novedoso implica un solo clic de botón para generar o reconstruir la escena virtual completa a partir de datos de imágenes sin la necesidad de software adicional. Todo el proceso ahora toma aproximadamente 5-6 s por escena (después de leer los datos de la imagen, como se demostrará en el video), lo que demuestra una mejora sustancial en la eficiencia con respecto al método heredado. Este método no pretende reemplazar el enfoque original, sino más bien complementarlo acelerando la generación de modelos virtuales de miembros del servicio (que se pueden agregar a la base de datos de modelos de cuerpo de miembros del servicio en el futuro). Simplifica la adición de nuevas configuraciones con diversas complejidades y facilita la integración de nuevos sistemas de armas en el futuro, mejorando así la extensibilidad de la herramienta BOP. En comparación con el enfoque heredado, es evidente que el método presentado ofrece una solución más optimizada y automatizada, que reduce el esfuerzo y el tiempo manuales, al tiempo que mejora la precisión y la naturaleza sistemática de la creación de modelos de cuerpo humano virtual. Esto pone de manifiesto la fuerza y la innovación del método descrito en el campo.

Validación de la generación automatizada de escenas

Se llevó a cabo una validación cualitativa del enfoque mediante la superposición de los escenarios reconstruidos en los datos de la imagen. Sin embargo, la validación cuantitativa no fue factible debido a la falta de datos disponibles sobre el posicionamiento y la postura de estas imágenes. Los autores reconocen la importancia de una validación más exhaustiva y planean abordar esto en trabajos futuros. Para lograr esto, los autores prevén un esfuerzo integral de recopilación de datos para obtener información precisa sobre el posicionamiento y la postura. Esto nos permitirá realizar una validación cuantitativa detallada, mejorando en última instancia la solidez y precisión del enfoque.

Validación de las simulaciones de exposición a explosiones

Los núcleos de explosión del arma se desarrollaron y validaron utilizando datos de sonda de lápiz recopilados durante el disparo del arma. En una próxima publicación se incluirán más detalles sobre el núcleo de la explosión del arma y las exposiciones relevantes. Algunas informaciones al respecto también están disponibles en las publicaciones anteriores 11,12. Este esfuerzo continuo contribuirá a mejorar la precisión y la eficacia de las simulaciones de sobrepresión de voladura, reforzando la validez de la herramienta.

El enfoque presentado aquí también se puede utilizar para generar avatares virtuales de los miembros del servicio, que posteriormente se pueden incorporar a la base de datos para su selección utilizando la herramienta BOP. Aunque el proceso actual no guarda automáticamente los modelos en la base de datos, los autores planean incluir esta característica en futuras versiones de la herramienta BOP. Además, los autores poseen herramientas internas que permiten la modificación manual de la postura una vez que se han generado la postura automatizada y el modelo 3D a partir de los datos de la imagen. En la actualidad, esta capacidad existe de forma independiente y no está integrada en la herramienta BOP, ya que se requiere un mayor desarrollo de la interfaz de usuario. Sin embargo, este es un trabajo en progreso, y los autores tienen la intención de incorporarlo en futuras versiones de la herramienta BOP.

Los datos de la carga de explosión también podrían exportarse en forma de un archivo de texto ASCII, y se podrían aplicar otros pasos de posprocesamiento para investigar con más detalle los patrones de dosis de explosión para diferentes sistemas de armas. Actualmente, se está trabajando en el desarrollo de herramientas avanzadas de posprocesamiento para métricas de salida como el impulso, la intensidad y otras que podrían ayudar a los usuarios a comprender e investigar la carga de explosiones repetidas más compleja durante estos escenarios. Además, las herramientas están desarrolladas para la eficiencia computacional y permiten velocidades de simulación rápidas. Por lo tanto, estas herramientas nos permiten ejecutar estudios de optimización inversa para determinar la postura y posición óptimas durante un escenario de disparo de arma. Estas mejoras mejoran la aplicabilidad de la herramienta para optimizar los protocolos de entrenamiento en diferentes campos de entrenamiento de armas. Las estimaciones de la dosis blástica también podrían utilizarse para desarrollar modelos computacionales a macroescala más refinados y de alta resolución para diferentes regiones anatómicas vulnerables, como el cerebro, los pulmones y otros modelos de lesiones a microescala18,19,20 y modelos de lesiones a microescala20,21. En este caso, el casco y la armadura incorporados en los modelos son únicamente para representación visual y no afectan a la dosis de explosión en estas simulaciones. Esto se debe a que los modelos se consideran estructuras rígidas, lo que significa que su inclusión no modifica ni influye en los resultados de las simulaciones de sobrepresión de voladura.

Este artículo aprovecha una herramienta de estimación de pose de código abierto existente para estimar la pose humana en escenarios de entrenamiento con armas. Tenga en cuenta que el marco desarrollado y discutido aquí plantea un enfoque independiente de la herramienta, es decir, los autores pueden reemplazar una herramienta existente con una nueva herramienta a medida que se realizan más avances. En general, las pruebas demostraron que, si bien las herramientas de software modernas son extremadamente poderosas, la detección de poses basada en imágenes es una tarea desafiante. Sin embargo, hay varias recomendaciones que se pueden usar para mejorar el rendimiento de la detección de poses. Estas herramientas funcionan mejor cuando la persona de interés está a la vista de la cámara. Si bien esto no siempre es posible durante los ejercicios de entrenamiento con armas, tener en cuenta esto al colocar la cámara puede mejorar los resultados de detección de poses. Además, los miembros del servicio que realizan ejercicios de entrenamiento con frecuencia usan uniformes camuflados que se mezclan con su entorno. Esto hace que sea más difícil que sean detectados tanto por el ojo humano como por los algoritmos de aprendizaje automático (ML). Existen métodos para mejorar la capacidad de los algoritmos de ML para detectar a los humanos con camuflaje23, pero no son triviales de implementar. Siempre que sea posible, la recopilación de imágenes de entrenamiento con armas en un lugar con un fondo de alto contraste puede mejorar la detección de poses.

Además, el enfoque convencional para estimar cantidades 3D a partir de imágenes es utilizar técnicas de fotogrametría con múltiples ángulos de cámara. La grabación de imágenes/vídeos desde múltiples ángulos también puede utilizarse para mejorar la estimación de la pose. Fusionar las estimaciones de pose de varias cámaras es relativamente sencillo24. Otra técnica de fotogrametría que podría mejorar los resultados es utilizar un tablero de ajedrez u otro objeto de dimensiones conocidas como punto de referencia común para cada cámara. Un desafío con el uso de varias cámaras es sincronizarlas en el tiempo. Se podrían desarrollar modelos de aprendizaje automático entrenados a medida para detectar características como un casco en lugar de una cara o para detectar personas que usan ropa y equipo específico militar (por ejemplo, botas, chalecos, chalecos antibalas). Las herramientas de estimación de posición existentes se pueden aumentar mediante modelos de ML entrenados a medida. Aunque esto lleva mucho tiempo y es tedioso, puede mejorar significativamente el rendimiento del modelo de estimación de pose.

En resumen, este documento describe de manera efectiva los diversos componentes del marco mejorado de sobrepresión de voladura. Aquí, los autores también reconocen el potencial para mejorar su aplicabilidad y eficacia a través de una integración más fluida y una automatización completa de la tubería. Elementos como la generación de una malla de carrocería 3D a escala con la herramienta AMG están en proceso de automatización para reducir la intervención manual del usuario. Actualmente, se está trabajando en la integración de estas capacidades en el módulo SCENE de la herramienta BOP. A medida que esta tecnología se desarrolle, se pondrá a disposición de todas las partes interesadas y laboratorios del Departamento de Defensa. Además, el trabajo en curso incluye la caracterización y validación de núcleos de armas para sistemas de armas adicionales. Este esfuerzo continuo por refinar y validar las metodologías garantiza que las herramientas desarrolladas por los autores permanezcan a la vanguardia de los avances tecnológicos, contribuyendo significativamente a la seguridad y eficacia de los ejercicios de entrenamiento militar. Las publicaciones futuras proporcionarán más detalles sobre estos desarrollos, contribuyendo al campo más amplio de la capacitación militar y la seguridad.

Divulgaciones

Los autores no tienen nada que revelar.

Agradecimientos

La investigación está financiada por la oficina de Coordinación de Investigación de Lesiones por Explosiones del Departamento de Defensa bajo la convocatoria del proyecto MTEC MTEC-22-02-MPAI-082. Los autores también reconocen la contribución de Hamid Gharahi por los granos de explosión de armas y Zhijian J Chen por desarrollar las capacidades de modelado para las simulaciones de sobrepresión de explosiones de disparo de armas. Los puntos de vista, opiniones y/o hallazgos expresados en esta presentación son los de los autores y no reflejan la política o posición oficial del Departamento del Ejército o del Departamento de Defensa.

Materiales

| Name | Company | Catalog Number | Comments |

| Anthropometric Model Generator (AMG) | CFD Research | N/A | For generting 3D human body models with different anthropometric characteristics. The tool is DoD Open Source. |

| BOP Tool | CFD Research | N/A | For setting up blast scenes and overpressure simulations. The tool is DoD open source. |

| BOP Tool SCENE Module | CFD Research | N/A | For setting up blast scenes and overpressure simulations. The tool is DoD open source. |

| Mediapipe | Version 0.9 | Open-source pose estimation library. | |

| MMPose | OpenMMLab | Version 1.2 | Open-source pose estimation library. |

| OpenSim | Stanford University | Version 4.4 | Open-source musculoskeletal modeling and simulation platform. |

| Python 3 | Anaconda Inc | Version 3.8 | The open source Individual Edition containing Python 3.8 and preinstalled packages to perform video processing and connecting the pose estimation tools. |

Referencias

- LaValle, C. R., et al. Neurocognitive performance deficits related to immediate and acute blast overpressure exposure. Front Neurol. 10, (2019).

- Kamimori, G. H., et al. Longitudinal investigation of neurotrauma serum biomarkers, behavioral characterization, and brain imaging in soldiers following repeated low-level blast exposure (New Zealand Breacher Study). Military Med. 183 (suppl_1), 28-33 (2018).

- Wang, Z., et al. Acute and chronic molecular signatures and associated symptoms of blast exposure in military breachers. J Neurotrauma. 37 (10), 1221-1232 (2020).

- Gill, J., et al. Moderate blast exposure results in increased IL-6 and TNFα in peripheral blood. Brain Behavior Immunity. 65, 90-94 (2017).

- Carr, W., et al. Ubiquitin carboxy-terminal hydrolase-L1 as a serum neurotrauma biomarker for exposure to occupational low-Level blast. Front Neurol. 6, (2015).

- Boutté, A. M., et al. Brain-related proteins as serum biomarkers of acute, subconcussive blast overpressure exposure: A cohort study of military personnel. PLoS One. 14 (8), e0221036 (2019).

- Skotak, M., et al. Occupational blast wave exposure during multiday 0.50 caliber rifle course. Front Neurol. 10, (2019).

- Kamimori, G. H., Reilly, L. A., LaValle, C. R., Silva, U. B. O. D. Occupational overpressure exposure of breachers and military personnel. Shock Waves. 27 (6), 837-847 (2017).

- Misistia, A., et al. Sensor orientation and other factors which increase the blast overpressure reporting errors. PLoS One. 15 (10), e0240262 (2020).

- National Defense Authorization Act for Fiscal Year 2020. Wikipedia Available from: https://en.wikipedia.org/w/index.php?title=National_Defense_Authorization_Act_for_Fiscal_Year_2020&oldid=1183832580 (2023)

- Przekwas, A., et al. Fast-running tools for personalized monitoring of blast exposure in military training and operations. Military Med. 186 (Supplement_1), 529-536 (2021).

- Spencer, R. W., et al. Fiscal year 2018 National Defense Authorization Act, Section 734, Weapon systems line of inquiry: Overview and blast overpressure tool-A module for human body blast wave exposure for safer weapons training. Military Med. 188 (Supplement_6), 536-544 (2023).

- Delp, S. L., et al. OpenSim: open-source software to create and analyze dynamic simulations of movement. IEEE Trans Biomed Eng. 54 (11), 1940-1950 (2007).

- Zhou, X., Sun, K., Roos, P. E., Li, P., Corner, B. Anthropometry model generation based on ANSUR II database. Int J Digital Human. 1 (4), 321 (2016).

- Zhou, X., Przekwas, A. A fast and robust whole-body control algorithm for running. Int J Human Factors Modell Simulat. 2 (1-2), 127-148 (2011).

- Zhou, X., Whitley, P., Przekwas, A. A musculoskeletal fatigue model for prediction of aviator neck manoeuvring loadings. Int J Human Factors Modell Simulat. 4 (3-4), 191-219 (2014).

- Roos, P. E., Vasavada, A., Zheng, L., Zhou, X. Neck musculoskeletal model generation through anthropometric scaling. PLoS One. 15 (1), e0219954 (2020).

- Garimella, H. T., Kraft, R. H. Modeling the mechanics of axonal fiber tracts using the embedded finite element method. Int J Numer Method Biomed Eng. 33 (5), (2017).

- Garimella, H. T., Kraft, R. H., Przekwas, A. J. Do blast induced skull flexures result in axonal deformation. PLoS One. 13 (3), e0190881 (2018).

- Przekwas, A., et al. Biomechanics of blast TBI with time-resolved consecutive primary, secondary, and tertiary loads. Military Med. 184 (Suppl 1), 195-205 (2019).

- Gharahi, H., Garimella, H. T., Chen, Z. J., Gupta, R. K., Przekwas, A. Mathematical model of mechanobiology of acute and repeated synaptic injury and systemic biomarker kinetics. Front Cell Neurosci. 17, 1007062 (2023).

- Przekwas, A., Somayaji, M. R., Gupta, R. K. Synaptic mechanisms of blast-induced brain injury. Front Neurol. 7, 2 (2016).

- Liu, Y., Wang, C., Zhou, Y. Camouflaged people detection based on a semi-supervised search identification network. Def Technol. 21, 176-183 (2023).

- Real time 3D body pose estimation using MediaPipe. Available from: https://temugeb.github.io/python/computer_vision/2021/09/14/bodypose3d.html (2021)

Reimpresiones y Permisos

Solicitar permiso para reutilizar el texto o las figuras de este JoVE artículos

Solicitar permisoExplorar más artículos

This article has been published

Video Coming Soon

ACERCA DE JoVE

Copyright © 2025 MyJoVE Corporation. Todos los derechos reservados