Method Article

Geração de avatares de combatentes a partir de imagens de cenas de treinamento de armas para simulações de exposição a explosões

Neste Artigo

Resumo

Uma estrutura computacional foi desenvolvida para reconstruir automaticamente cenas virtuais compostas por avatares 3D de soldados usando dados de imagem e/ou vídeo. As cenas virtuais ajudam a estimar a exposição à sobrepressão da explosão durante o treinamento com armas. A ferramenta facilita uma representação realista da postura humana em simulações de exposição a explosões em vários cenários.

Resumo

Os militares envolvidos no treinamento com armas são submetidos a repetidas explosões de baixo nível. O método predominante de estimativa de cargas de detonação envolve medidores de detonação vestíveis. No entanto, usando dados de sensores vestíveis, as cargas de explosão na cabeça ou em outros órgãos não podem ser estimadas com precisão sem o conhecimento da postura corporal do militar. Uma plataforma experimental-computacional complementar aumentada por imagem/vídeo para conduzir um treinamento de armas mais seguro foi desenvolvida. Este estudo descreve o protocolo para a geração automatizada de cenas de treinamento de armas a partir de dados de vídeo para simulações de exposição a explosões. A cena da explosão extraída dos dados de vídeo no instante do disparo da arma envolve os avatares do corpo do militar, armas, solo e outras estruturas. O protocolo computacional é usado para reconstruir as posições e posturas dos militares usando esses dados. Dados de imagem ou vídeo extraídos das silhuetas corporais dos militares são usados para gerar um esqueleto anatômico e os principais dados antropométricos. Esses dados são usados para gerar os avatares 3D da superfície corporal segmentados em partes individuais do corpo e geometricamente transformados para corresponder às posturas extraídas dos membros do serviço. A cena final de treinamento de armas virtuais é usada para simulações computacionais 3D de carregamento de ondas de explosão de armas em membros do serviço. O gerador de cenas de treinamento com armas tem sido usado para construir avatares anatômicos 3D de corpos individuais de membros do serviço a partir de imagens ou vídeos em várias orientações e posturas. Os resultados da geração de uma cena de treinamento a partir de dados de imagem do sistema de armas de assalto montado no ombro e do sistema de armas de morteiro são apresentados. A ferramenta Blast Overpressure (BOP) usa a cena de treinamento de armas virtuais para simulações 3D de carregamento de ondas de choque nos corpos de avatar dos membros do serviço. Este artigo apresenta simulações computacionais 3D da propagação de ondas de choque a partir de disparos de armas e cargas de explosão correspondentes em membros do serviço em treinamento.

Introdução

Durante o treinamento militar, os militares e instrutores são frequentemente expostos a explosões de baixo nível com armas pesadas e leves. Estudos recentes mostraram que a exposição à explosão pode levar à diminuição do desempenho neurocognitivo 1,2 e alterações nos biomarcadores sanguíneos 3,4,5,6. A exposição repetida a explosões de baixo nível resulta em desafios para manter o desempenho ideal e minimizar o risco de lesões 7,8. A abordagem convencional que usa sensores de pressão vestíveis tem desvantagens, principalmente quando se trata de determinar com precisão as pressões de explosão na cabeça9. Os efeitos adversos conhecidos da exposição repetida a explosões de baixo nível no desempenho humano (por exemplo, durante o treinamento e em funções operacionais) exacerbam esse problema. Os mandatos do Congresso (Seções 734 e 717) estipularam a exigência de monitoramento da exposição a explosões em treinamento e combate e sua inclusão no prontuário médico do militar10.

Sensores vestíveis podem ser usados para monitorar a sobrepressão da explosão durante essas operações de treinamento de combate. No entanto, esses sensores são influenciados por variáveis como postura corporal, orientação e distância da fonte de explosão devido à natureza complexa das interações das ondas de choque com o corpo humano9. Os seguintes fatores afetam a distribuição de pressão e as medições do sensor9:

Distância da fonte de explosão: A intensidade da pressão varia com a distância à medida que a onda de choque se dispersa e atenua. Os sensores mais próximos da explosão registram pressões mais altas, afetando a precisão e a consistência dos dados.

Postura corporal: Diferentes posturas expõem várias superfícies do corpo à explosão, alterando a distribuição da pressão. Por exemplo, ficar em pé versus agachado resulta em diferentes leituras de pressão 9,11.

Orientação: O ângulo do corpo em relação à fonte da explosão afeta a forma como a onda de pressão interage com o corpo, levando a discrepâncias nas leituras9. As simulações numéricas baseadas em física fornecem avaliações mais precisas, contabilizando sistematicamente essas variáveis, oferecendo uma análise controlada e abrangente em comparação com os sensores vestíveis, que são inerentemente influenciados por esses fatores.

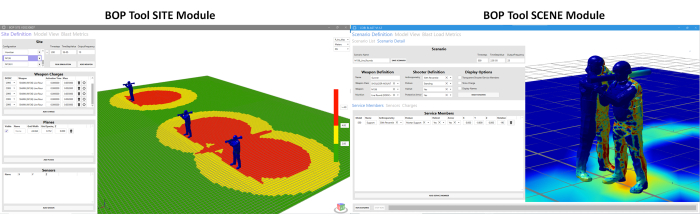

Em resposta a esses desafios, tem havido um esforço conjunto para desenvolver ferramentas mais sofisticadas. Nesse sentido, é desenvolvida a ferramenta Blast Overpressure (BOP). Esta ferramenta foi desenvolvida para estimar a exposição à sobrepressão sob diferentes posturas e posições dos membros do serviço ao redor dos sistemas de armas. Existem dois módulos diferentes na ferramenta BOP11. Eles são (a) o módulo SCENE da ferramenta BOP e (b) o módulo SITE da ferramenta BOP. Esses módulos são usados para estimar a sobrepressão da explosão durante o disparo da arma12. O módulo BOP SCENE é desenvolvido para estimar as sobrepressões de explosão experimentadas por membros individuais do serviço ou instrutores que participam de um cenário de treinamento, enquanto o módulo BOP SITE reconstrói uma visão panorâmica do curso de treinamento, descrevendo as zonas de sobrepressão de explosão geradas por várias estações de disparo. A Figura 1 mostra um instantâneo de ambos os módulos. Atualmente, os módulos da ferramenta BOP compreendem características de sobrepressão de explosão de arma (termo de fonte de explosão equivalente) para quatro sistemas de armas de nível 1 definidos pelo DoD, incluindo o rifle de precisão de aplicação especial M107 .50 cal (SASR), arma de assalto montada no ombro M136, morteiro de fogo indireto M120 e cargas de violação. O termo kernel de explosão de arma refere-se a um termo de fonte de explosão equivalente desenvolvido para replicar o mesmo campo de explosão em torno de um sistema de armas que o da arma real. Uma descrição mais detalhada da estrutura computacional usada para o desenvolvimento da ferramenta BOP está disponível para referência adicional11. As simulações de sobrepressão são executadas usando o mecanismo do solucionador CoBi-Blast. Esta é uma ferramenta multifísica multiescala para simular sobrepressões de detonação. Os recursos de modelagem de explosão do motor são validados em relação a dados experimentais da literatura12. Esta ferramenta BOP está atualmente sendo integrada ao Range Managers Toolkit (RMTK) para uso em diferentes campos de treinamento de armas. O RMTK é um conjunto multisserviço de ferramentas de desktop projetado para atender às necessidades dos gerentes de alcance em todo o Exército, Corpo de Fuzileiros Navais, Força Aérea e Marinha, automatizando as operações de alcance, segurança e processos de modernização.

Figura 1: Interface gráfica do usuário (GUI) para o módulo SCENE da ferramenta BOP e o módulo SITE da ferramenta BOP. O módulo BOP SCENE foi projetado para estimar as sobrepressões de explosão em modelos de corpo de militares e instrutores, enquanto o módulo BOP SITE destina-se a fornecer uma estimativa dos contornos de sobrepressão em um plano que representa o campo de treinamento. O usuário tem a opção de escolher a altura em que o avião está situado em relação ao solo. Clique aqui para ver uma versão maior desta figura.

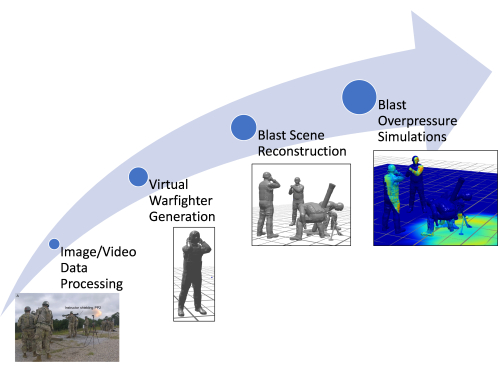

Uma limitação do módulo SCENE da ferramenta BOP existente é o uso de dados estimados manualmente para a construção de modelos corporais de membros do serviço virtual, incluindo sua antropometria, postura e posição. A geração manual dos militares virtuais na postura adequada é trabalhosa e demorada11,12. A ferramenta BOP legada (abordagem legada) usa um banco de dados de posturas pré-configuradas para construir a cena de treinamento de armas com base nos dados de imagem (se disponíveis). Além disso, como as posturas são aproximadas manualmente por meio de avaliação visual, as posturas corretas podem não ser capturadas para um ambiente postural complexo. Como resultado, essa abordagem introduz imprecisões na exposição estimada à sobrepressão para membros individuais do serviço (já que uma mudança na postura pode modificar a exposição à sobrepressão em regiões mais vulneráveis). O artigo apresenta melhorias que foram feitas na estrutura computacional existente para permitir a geração rápida e automática de modelos de membros do serviço usando ferramentas de estimativa de pose de última geração existentes. Este artigo discute o aprimoramento da ferramenta BOP, enfatizando particularmente o desenvolvimento de um pipeline computacional novo e rápido para reconstruir cenas de explosão usando dados de vídeo e imagem. A ferramenta aprimorada também pode reconstruir modelos corporais detalhados de militares e instrutores no momento do disparo da arma, utilizando dados de vídeo para criar avatares personalizados em comparação com a abordagem legada. Esses avatares refletem com precisão a postura dos militares. Este trabalho agiliza o processo de geração de cenas de explosão e facilita uma inclusão mais rápida de cenas de explosão para sistemas de armas adicionais, reduzindo significativamente o tempo e o esforço necessários para a criação de cenas de treinamento de armas. A Figura 2 mostra um esquema da estrutura computacional aprimorada discutida neste artigo.

Figura 2: Esquema mostrando o fluxograma geral do processo na estrutura computacional. As diferentes etapas incluem processamento de dados de imagem/vídeo, geração de combatentes virtuais, reconstrução da cena da explosão e simulações de sobrepressão da explosão. Clique aqui para ver uma versão maior desta figura.

O artigo apresenta a abordagem automatizada que está sendo implementada na ferramenta BOP, o que representa uma melhoria significativa nas ferramentas computacionais disponíveis para estimar a exposição à sobrepressão durante o treinamento e as operações. Esta ferramenta se distingue por sua rápida geração de avatares personalizados e cenários de treinamento, permitindo simulações imersivas de sobrepressão de explosão. Isso marca um afastamento significativo da dependência tradicional de modelos de corpo humano com média populacional, oferecendo uma abordagem mais precisa e individualizada.

Ferramentas computacionais utilizadas no processo de automação

A automação da geração de modelos de membros de serviço virtual é um processo de várias etapas que aproveita ferramentas computacionais avançadas para transformar dados brutos de imagem ou vídeo em representações 3D detalhadas. Todo o processo é automatizado, mas pode ser adaptado para permitir a entrada manual de medições conhecidas, se necessário.

Ferramentas de estimativa de pose 3D: No centro do pipeline de automação estão as ferramentas de estimativa de pose 3D. Essas ferramentas analisam os dados da imagem para identificar a posição e a orientação de cada articulação no corpo do militar, criando efetivamente um esqueleto digital. Atualmente, o pipeline dá suporte a Mediapipe e MMPose, que oferecem APIs Python. No entanto, o sistema foi projetado com flexibilidade em mente, permitindo a incorporação de outras ferramentas, como câmeras de profundidade, desde que possam produzir os dados 3D necessários sobre articulações e ossos.

Gerador de modelo antropométrico (AMG): Uma vez que a pose 3D é estimada, o AMG entra em ação. Essa ferramenta utiliza dados de pose para criar um modelo de superfície de pele 3D que corresponda às dimensões corporais exclusivas do membro do serviço. A ferramenta AMG permite a entrada automatizada ou manual de medições antropométricas, que são então vinculadas aos principais componentes dentro da ferramenta para transformar a malha do corpo 3D de acordo.

Modelagem esquelética do OpenSim: A próxima etapa envolve a plataforma OpenSim13 de código aberto, onde um modelo esquelético é ajustado para se alinhar com os dados de pose 3D. As ferramentas de estimativa de pose não impõem comprimentos ósseos consistentes no esqueleto, o que pode levar a uma assimetria irreal no corpo. O uso de um esqueleto OpenSim anatomicamente correto produz uma estrutura óssea mais realista. Os marcadores são colocados no esqueleto do OpenSim para corresponder aos centros de articulação identificados pela ferramenta de estimativa de pose. Este modelo esquelético é então manipulado para a malha de pele 3D usando técnicas de animação padrão.

Cinemática inversa e scripts Python: Para finalizar a pose do membro do serviço virtual, um algoritmo de cinemática inversa é empregado. Esse algoritmo ajusta o modelo de esqueleto do OpenSim para melhor corresponder à pose 3D estimada. Todo o pipeline de poses é totalmente automatizado e implementado no Python 3. Por meio da integração dessas ferramentas, o processo de geração de modelos de membros do serviço virtual foi significativamente acelerado, reduzindo o tempo necessário de dias para segundos ou minutos. Esse avanço representa um salto na simulação e análise de cenários de treinamento de armas, fornecendo reconstruções rápidas de cenários específicos documentados usando imagens ou vídeo.

Protocolo

As imagens e vídeos utilizados neste estudo não foram obtidos diretamente pelos autores de seres humanos. Uma imagem foi obtida de recursos gratuitos no Wikimedia Commons, que está disponível sob uma licença de domínio público. A outra imagem foi fornecida por colaboradores do Instituto de Pesquisa do Exército Walter Reed (WRAIR). Os dados obtidos do WRAIR não foram identificados e foram compartilhados de acordo com suas diretrizes institucionais. Para as imagens fornecidas pelo WRAIR, o protocolo seguiu as diretrizes do comitê de ética em pesquisa com seres humanos do WRAIR, incluindo a obtenção de todas as aprovações e consentimentos necessários.

1. Acessando o módulo BOP Tool SCENE

- Abra o módulo BOP Tool SCENE na interface da ferramenta BOP clicando no botão BOP Tool SCENE Module .

- Clique em Definição de Cenário e, em seguida, clique na guia Detalhes do Cenário .

2. Leitura e processamento dos dados da imagem

- Clique no botão POSETOOL IMPORT no módulo BOP tool SCENE. Uma janela pop-up é aberta, solicitando que o usuário selecione a imagem ou vídeo relevante.

- Navegue até a pasta e selecione a imagem/vídeo relevante usando as operações do mouse.

- Clique em Abrir na janela pop-up quando uma imagem for selecionada.

NOTA: Esta operação lê a imagem ou o arquivo de vídeo, gera uma imagem se um vídeo for selecionado, executa o algoritmo de estimativa de pose em segundo plano, gera os modelos de membros do serviço virtual envolvidos na cena de treinamento de armas e os carrega no módulo BOP Tool SCENE em suas respectivas posições.

3. Configurando a arma e o atirador

- Escolha um nome para o cenário usando a caixa de texto em Nome do Cenário. Esta é uma escolha do usuário. Para o cenário discutido aqui, os desenvolvedores escolheram o nome do cenário BlastDemo1.

- Escolha um nome personalizado no campo Nome na Definição de arma. Esta é, novamente, uma escolha do usuário. Para o cenário discutido aqui, os desenvolvedores escolheram o nome da arma 120Mortar.

- Selecione a classe de arma apropriada, por exemplo, MORTEIRO PESADO, na lista de opções no menu suspenso.

- Selecione a arma (M120 neste caso) na lista de opções no menu suspenso. Ao selecionar o sistema de armas, o kernel de explosão correspondente será carregado automaticamente na GUI na subguia Cargas.

NOTA: O menu suspenso terá os diferentes sistemas de armas possíveis específicos para a classe de arma escolhida acima. - Selecione o Projétil de Munição (Rodada de Treinamento de Alcance Total) para o sistema de armas escolhido usando as opções suspensas.

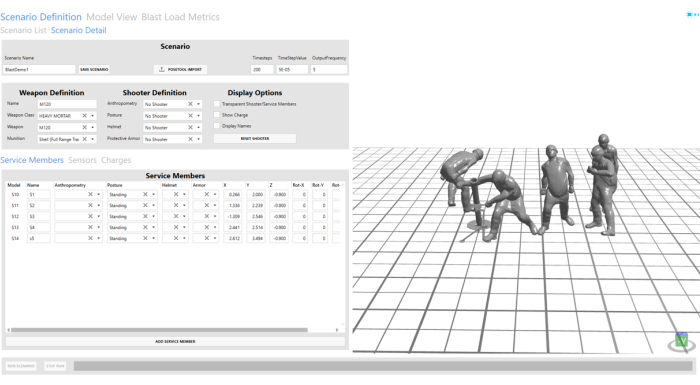

- Selecione Sem Atirador nos campos Antropometria, Postura, Capacete e Armadura de proteção na Definição de Atirador nas opções suspensas. Consulte a Figura 3 para atirador configurado e membros do serviço.

NOTA: Como o atirador será incluído na cena importada até a etapa 4, nenhum atirador foi selecionado na Definição do atirador.

Figura 3: Cena de explosão importada dos dados da imagem. A cena da explosão é visível na janela de visualização no lado direito da ferramenta GUI. Clique aqui para ver uma versão maior desta figura.

4. Configurando os membros do serviço

- Clique na guia Membros do serviço . Esta guia controla a posição e a orientação dos membros do serviço importados dos dados da imagem; use as opções X, Y, Z e rotação para fazer isso. Para o avatar correspondente ao artilheiro assistente, os autores ajustaram a posição Y de 2.456 para 2 para uma posição de artilheiro assistente mais razoável.

- Escolha nomes personalizados para todos os modelos de membros do serviço virtual importados para a GUI usando o campo Nome na guia Membros do serviço. S1, S2, S3, S4 e S5 são escolhidos aqui para todos os modelos de membros do serviço importados automaticamente.

NOTA: Para o cenário discutido aqui, eles foram nomeados S1 e S2. Os outros campos são preenchidos automaticamente. Os usuários podem modificá-los para refinar a posição/posturas estimadas automaticamente. - Use o botão Excluir para remover S2, S4 e S5. No cenário demonstrado aqui, apenas o atirador e o artilheiro assistente estão presentes no momento do disparo.

NOTA: Isso foi executado para demonstrar as opções de usuário personalizadas para excluir ou adicionar modelos de membros do serviço conforme necessário a uma cena existente.

5. Configurando os sensores virtuais

- Navegue até a guia Sensores . Adicione um novo sensor virtual clicando em Adicionar sensor.

- Escolha um nome personalizado no campo Nome. Os desenvolvedores escolheram o V1 para demonstração neste artigo.

- Selecione o tipo como Virtual clicando no menu suspenso no campo Tipo de sensor.

- Escolha a localização do sensor a ser (-0,5, 2, 0,545) editando as caixas de texto nos campos X, Y e Z. Para o cenário discutido aqui, os desenvolvedores criaram quatro sensores diferentes em quatro locais diferentes para fins de demonstração. Os desenvolvedores escolheram V2, V3 e V4 como os nomes dos sensores adicionais.

- Repita as etapas de 5.1 a 5.4 para criar sensores adicionais em (-0.5, 1, 0.545), (-0.5, 0.5, 0.545) e (-0.5, 0, 0.545). Deixe o valor de Rotação como zero.

NOTA: O usuário também pode escolher sensores planares durante os quais a rotação pode ser usada para ajustar a orientação do sensor em relação à carga de explosão.

6. Salvando e executando o programa

- Salve a cena de treinamento de armas clicando no botão Salvar cenário na GUI na parte superior.

- Execute a simulação de sobrepressão de explosão para a cena de treinamento de armas M120 clicando no botão Executar cenário na parte inferior. O progresso da simulação é mostrado usando a barra de progresso na parte inferior.

7. Visualizando os resultados

- Navegue até a guia Vista do modelo para examinar a simulação de exposição à sobrepressão de explosão.

- Clique no botão Atual para carregar a simulação concluída na janela de visualização.

- Depois que a simulação for carregada, visualize a simulação usando o botão Reproduzir na parte inferior da tela.

- O usuário pode escolher entre as diferentes opções na barra de navegação para reproduzir e pausar a simulação em diferentes velocidades. A captura de tela dos controles de reprodução abaixo mostra mais opções. O usuário pode controlar a janela interativa usando o mouse. Clique com o botão direito do mouse e arraste para girar o modo, o botão esquerdo para transladar o modelo e o botão do meio para rolar para dentro/para fora.

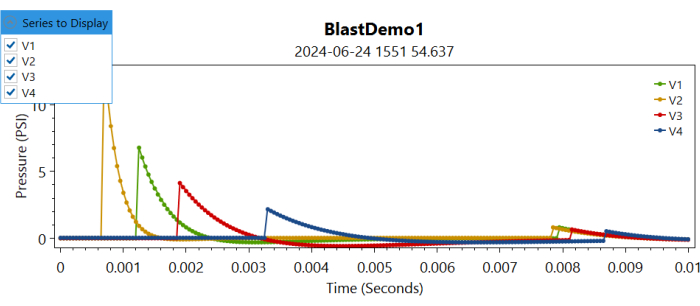

- Depois de revisar a simulação, navegue até a guia Métricas de carga de detonação clicando nela.

- Clique no botão Atual para carregar as plotagens de sobrepressão nos locais do sensor virtual.

NOTA: Isso carregará as informações de sobrepressão nos diferentes locais do sensor em diferentes gráficos. - Navegue até a série suspensa a ser exibida e selecione marcando a caixa do sensor correspondente para plotar a sobrepressão registrada nesse sensor virtual (consulte a Figura 4).

Figura 4: Controles de plotagem para sobrepressões em diferentes sensores virtuais ao longo do tempo. Os usuários podem escolher a série a ser exibida marcando ou desmarcando os diferentes sensores. Clique aqui para ver uma versão maior desta figura.

Resultados

Reconstrução automatizada de membros do serviço virtual e cenas de explosão

O modelo de corpo de membro de serviço virtual automatizado e a geração de modelo de cena de treinamento de armas foram alcançados por meio dos recursos de automação da ferramenta BOP. A Figura 5 mostra a cena de treinamento virtual gerada a partir dos dados da imagem. Como pode ser observado aqui, a cena resultante foi uma boa representação dos dados da imagem. A imagem usada para demonstração na Figura 5 foi obtida do Wikimedia Commons.

Figura 5: Cena de treinamento de arma virtual a partir dos dados da imagem. A imagem do lado esquerdo mostra os dados da imagem correspondentes ao disparo de uma arma AT4, e o lado direito mostra a cena virtual de treinamento de armas gerada automaticamente. Este número foi obtido do Wikimedia Commons. Clique aqui para ver uma versão maior desta figura.

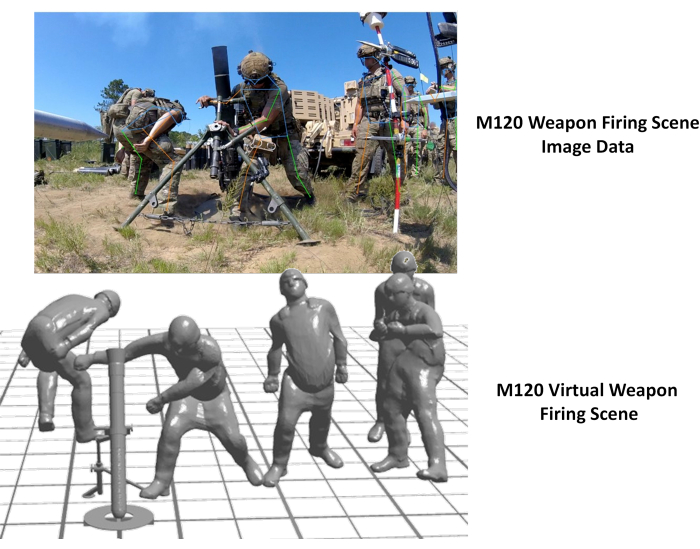

Além disso, a abordagem foi aplicada para reconstruir a cena de disparo da arma M120. A imagem foi coletada pela WRAIR como parte de um esforço de coleta de dados de pressão para a arma de morteiro M120. A Figura 6 abaixo ilustra a cena de disparo de arma virtual reconstruída ao lado da imagem original. Foi observada uma discrepância na posição do artilheiro assistente na reconstrução virtual. Isso pode ser corrigido ajustando a posição do artilheiro assistente usando as opções do usuário da GUI do BOP. Além disso, a postura pélvica do instrutor parecia imprecisa, provavelmente devido à obstrução das estacas nas imagens. A integração dessa abordagem com outras modalidades de imagem de profundidade seria benéfica para lidar com essas discrepâncias.

Figura 6: Cena de treinamento de arma virtual a partir dos dados da imagem. A imagem do lado esquerdo mostra os dados da imagem correspondentes ao disparo de uma arma M120 e o lado direito mostra a cena virtual de treinamento de armas gerada automaticamente. Clique aqui para ver uma versão maior desta figura.

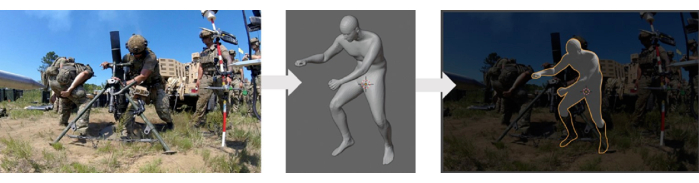

Validação da abordagem de geração de cena automatizada

O gerador de modelos de corpo humano empregado neste estudo foi validado usando o banco de dados de varredura do corpo humano ANSUR II14, que incluiu medidas antropométricas de dados de imagens médicas. Um método de reconstrução automatizado, que utilizou este gerador de modelo de corpo humano, passou por validação qualitativa com os dados disponíveis. Esse processo de validação envolveu a comparação dos modelos reconstruídos com dados experimentais (imagens) por meio da sobreposição deles. A Figura 7 apresenta uma comparação entre os modelos de avatar 3D e os dados experimentais. No entanto, é necessária uma validação mais completa desse método, o que exigiria dados experimentais adicionais da cena, incluindo posições, posturas e orientações precisas dos diferentes membros do serviço envolvidos em uma cena de treinamento.

Figura 7: Comparação qualitativa do modelo de corpo humano virtual gerado com a imagem. O painel esquerdo mostra a imagem original, o painel do meio mostra o modelo de corpo virtual gerado e o painel direito mostra o modelo virtual sobreposto na imagem original. Clique aqui para ver uma versão maior desta figura.

Simulações representativas de sobrepressão de explosão

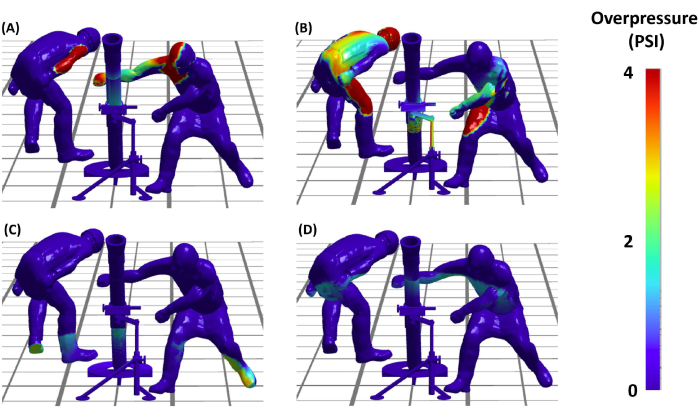

Depois de configurar a cena da explosão, os autores foram capazes de prosseguir para a fase crítica da execução de simulações de sobrepressão de explosão (BOP). Isso nos permitirá entender a distribuição das cargas de explosão em diferentes membros do serviço envolvidos em uma cena de disparo de armas. A Figura 8 apresenta os resultados dessas simulações BOP durante o evento de disparo da arma AT4. As simulações fornecem uma visualização detalhada das cargas de sobrepressão no militar virtual na cena em diferentes instantes ao longo do tempo. Em conclusão, os resultados demonstram não apenas a viabilidade, mas também a eficácia do protocolo na criação de reconstruções precisas e analiticamente úteis de cenários de treinamento de armas, abrindo caminho para estudos mais avançados em segurança e eficiência do treinamento militar.

Figura 8: Exposição à sobrepressão da explosão no atirador. (A, B, C e D) Os quatro painéis mostram o modelo previu a sobrepressão da explosão nos membros do serviço virtual envolvidos no disparo de morteiros M120 em diferentes instantes de tempo. Os painéis (C) e (D) mostram a propagação da sobrepressão devido à reflexão do solo. Clique aqui para ver uma versão maior desta figura.

Discussão

A estrutura computacional apresentada neste artigo acelera significativamente a geração de cenas de treinamento de armas de explosão em comparação com métodos manuais usados anteriormente usando avaliação visual. Essa abordagem demonstra a capacidade da estrutura de capturar e reconstruir rapidamente diversas posturas militares.

Vantagens da abordagem atual

A criação de modelos virtuais do corpo humano em posturas e posições específicas é uma tarefa desafiadora, com ferramentas limitadas disponíveis para esse fim. O método convencional empregado na abordagem legada, especificamente para a ferramenta BOP, utilizou CoBi-DYN 14,15,16,17. Esse método envolvia a criação manual de modelos virtuais de corpos humanos com roupas, capacetes, armaduras de proteção e botas. Os modelos foram gerados por meio de aproximação visual, carecendo de uma abordagem sistemática. Na ferramenta BOP legada, o CoBi-DYN foi usado para criar um banco de dados de modelos de corpo humano que estava acessível durante a etapa de configuração do cenário. Os usuários selecionariam manualmente uma configuração postural aproximada e a posicionariam aproximadamente para um sistema de armas específico para executar o cenário BOP. Embora a reconstrução da cena da explosão a partir do banco de dados de membros do serviço existente (acessada a partir do menu suspenso na ferramenta BOP) tenha sido relativamente rápida, a criação inicial do banco de dados do modelo de membro do serviço virtual foi demorada, levando cerca de 16 a 24 horas por cena devido à natureza manual e aproximada do processo. Em contraste, a nova abordagem aproveita ferramentas de estimativa de pose bem estabelecidas para uma criação mais automatizada e rápida de modelos virtuais de corpo humano. Essas ferramentas utilizam automaticamente dados de vídeo e imagem para reconstruir rapidamente cenas de explosão com avatares de membros do serviço virtual. Isso reduz significativamente o tempo necessário para criar o banco de dados do corpo humano. A nova abordagem envolve um único clique de botão para gerar ou reconstruir a cena virtual completa a partir de dados de imagem sem a necessidade de software adicional. Todo o processo agora leva aproximadamente 5-6 s por cena (após a leitura dos dados da imagem, como será demonstrado no vídeo), demonstrando uma melhoria substancial na eficiência em relação ao método legado. Esse método não se destina a substituir a abordagem original, mas sim complementá-la, acelerando a geração de modelos de membros do serviço virtual (que podem ser adicionados ao banco de dados do modelo de corpo do membro do serviço no futuro). Ele simplifica a adição de novas configurações com complexidades variadas e facilita a integração de novos sistemas de armas no futuro, aumentando assim a extensibilidade da ferramenta BOP. Comparado com a abordagem legada, é evidente que o método apresentado oferece uma solução mais simplificada e automatizada, reduzindo o esforço e o tempo manual, melhorando a precisão e a natureza sistemática da criação de modelos virtuais de corpo humano. Isso destaca a força e a inovação do método descrito no campo.

Validação da geração automatizada de cenas

Uma validação qualitativa da abordagem foi realizada sobrepondo os cenários reconstruídos nos dados da imagem. No entanto, a validação quantitativa não foi viável devido à falta de dados disponíveis sobre posicionamento e postura para essas imagens. Os autores reconhecem a importância de uma validação mais completa e planejam abordar isso em trabalhos futuros. Para conseguir isso, os autores preveem um esforço abrangente de coleta de dados para obter informações precisas de posicionamento e postura. Isso nos permitirá realizar uma validação quantitativa detalhada, aumentando a robustez e a precisão da abordagem.

Validação das simulações de exposição à explosão

Os núcleos de explosão de armas foram desenvolvidos e validados usando dados de sonda de lápis coletados durante o disparo da arma. Mais detalhes sobre o kernel de explosão de armas e exposições relevantes serão incluídos em uma próxima publicação. Algumas informações a esse respeito também estão disponíveis nas publicações anteriores11,12. Esse esforço contínuo contribuirá para melhorar a precisão e a eficácia das simulações de sobrepressão de explosão, reforçando a validade da ferramenta.

A abordagem apresentada aqui também pode ser utilizada para gerar avatares virtuais de membros do serviço, que podem ser posteriormente incorporados ao banco de dados para seleção usando a ferramenta BOP. Embora o processo atual não salve automaticamente os modelos no banco de dados, os autores planejam incluir esse recurso em versões futuras da ferramenta BOP. Além disso, os autores possuem ferramentas internas que permitem a modificação manual da postura, uma vez que a postura automatizada e o modelo 3D tenham sido gerados a partir dos dados da imagem. Atualmente, esse recurso existe de forma independente e não está integrado à ferramenta BOP, pois é necessário um desenvolvimento adicional na interface do usuário. No entanto, este é um trabalho em andamento e os autores pretendem incorporá-lo em versões futuras da ferramenta BOP.

Os dados de carga de explosão também podem ser exportados na forma de um arquivo de texto ASCII, e outras etapas de pós-processamento podem ser aplicadas para investigar os padrões de dose de explosão para diferentes sistemas de armas com mais detalhes. Atualmente, o trabalho está em andamento para desenvolver ferramentas avançadas de pós-processamento para métricas de saída, como impulso, intensidade e outras, que podem ajudar os usuários a entender e investigar cargas de explosão repetidas mais complexas durante esses cenários. Além disso, as ferramentas são desenvolvidas para eficiência computacional e permitem velocidades de simulação rápidas. Portanto, essas ferramentas nos permitem executar estudos de otimização inversa para determinar a postura e a posição ideais durante um cenário de disparo de arma. Tais melhorias aumentam a aplicabilidade da ferramenta para otimizar os protocolos de treinamento em diferentes faixas de treinamento de armas. As estimativas de dose de blasto também podem ser usadas para desenvolver modelos computacionais de macroescala de alta resolução mais refinados para diferentes regiões anatômicas vulneráveis, como cérebro, pulmões e outros 18,19,20 e modelos de lesão em microescala 20,21. Aqui, o capacete e a armadura incorporados aos modelos são apenas para representação visual e não afetam a dose de explosão nessas simulações. Isso se deve ao fato de os modelos serem considerados estruturas rígidas, o que significa que sua inclusão não modifica ou influencia os resultados das simulações de sobrepressão de explosão.

Este artigo aproveita uma ferramenta de estimativa de pose de código aberto existente para estimar a pose humana em cenários de treinamento de armas. Observe que a estrutura desenvolvida e discutida aqui é independente de ferramentas, ou seja, os autores podem substituir uma ferramenta existente por uma nova ferramenta à medida que mais avanços estão sendo feitos. No geral, o teste demonstrou que, embora as ferramentas de software modernas sejam extremamente poderosas, a detecção de pose baseada em imagem é uma tarefa desafiadora. No entanto, há várias recomendações que podem ser usadas para melhorar o desempenho da detecção de pose. Essas ferramentas funcionam melhor quando a pessoa de interesse está à vista da câmera. Embora isso nem sempre seja possível durante os exercícios de treinamento com armas, considerar isso ao colocar a câmera pode melhorar os resultados da detecção de poses. Além disso, os militares que realizam exercícios de treinamento frequentemente usam uniformes camuflados que se misturam ao ambiente. Isso torna mais difícil para eles serem detectados pelo olho humano e pelos algoritmos de aprendizado de máquina (ML). Existem métodos para aprimorar a capacidade dos algoritmos de ML de detectar humanos usando camuflagem23, mas não são triviais de implementar. Sempre que possível, coletar imagens de treinamento com armas em um local com fundo de alto contraste pode melhorar a detecção de poses.

Além disso, a abordagem convencional para estimar quantidades 3D a partir de imagens é usar técnicas de fotogrametria com vários ângulos de câmera. A gravação de imagens/vídeos de vários ângulos também pode ser usada para melhorar a estimativa de pose. A fusão de estimativas de pose de várias câmeras é relativamente simples24. Outra técnica de fotogrametria que pode melhorar os resultados é usar um tabuleiro de xadrez ou outro objeto de dimensões conhecidas como ponto de referência comum para cada câmera. Um desafio com o uso de várias câmeras é sincronizá-las com o tempo. Modelos de aprendizado de máquina personalizados podem ser desenvolvidos para detectar características como um capacete em vez de um rosto ou para detectar pessoas usando roupas e equipamentos específicos para militares (por exemplo, botas, coletes, coletes à prova de balas). As ferramentas de estimativa de pose existentes podem ser aumentadas usando modelos de ML treinados personalizados. Embora isso seja demorado e tedioso, pode melhorar significativamente o desempenho do modelo de estimativa de pose.

Em resumo, este artigo descreve efetivamente os vários componentes da estrutura aprimorada de sobrepressão de explosão. Aqui, os autores também reconhecem o potencial para melhorar sua aplicabilidade e eficácia por meio de uma integração mais perfeita e automação total do pipeline. Elementos como a geração de uma malha de corpo 3D dimensionada com a ferramenta AMG estão em processo de automação para reduzir a entrada manual do usuário. Atualmente, há um trabalho em andamento para integrar esses recursos ao módulo SCENE da ferramenta BOP. À medida que essa tecnologia se desenvolve, ela se tornará acessível a todas as partes interessadas e laboratórios do DoD. Além disso, o trabalho em andamento inclui a caracterização e validação de núcleos de armas para sistemas de armas adicionais. Esse esforço contínuo para refinar e validar as metodologias garante que as ferramentas desenvolvidas pelos autores permaneçam na vanguarda do avanço tecnológico, contribuindo significativamente para a segurança e eficácia dos exercícios de treinamento militar. Publicações futuras fornecerão mais detalhes sobre esses desenvolvimentos, contribuindo para o campo mais amplo do treinamento e segurança militar.

Divulgações

Os autores não têm nada a divulgar.

Agradecimentos

A pesquisa é financiada pelo escritório de Coordenação de Pesquisa de Lesões por Explosão do DoD sob a Chamada do Projeto MTEC MTEC-22-02-MPAI-082. Os autores também reconhecem a contribuição de Hamid Gharahi para núcleos de explosão de armas e Zhijian J Chen para o desenvolvimento de recursos de modelagem para simulações de sobrepressão de explosão de disparo de armas. As visões, opiniões e/ou descobertas expressas nesta apresentação são de responsabilidade dos autores e não refletem a política ou posição oficial do Departamento do Exército ou do Departamento de Defesa.

Materiais

| Name | Company | Catalog Number | Comments |

| Anthropometric Model Generator (AMG) | CFD Research | N/A | For generting 3D human body models with different anthropometric characteristics. The tool is DoD Open Source. |

| BOP Tool | CFD Research | N/A | For setting up blast scenes and overpressure simulations. The tool is DoD open source. |

| BOP Tool SCENE Module | CFD Research | N/A | For setting up blast scenes and overpressure simulations. The tool is DoD open source. |

| Mediapipe | Version 0.9 | Open-source pose estimation library. | |

| MMPose | OpenMMLab | Version 1.2 | Open-source pose estimation library. |

| OpenSim | Stanford University | Version 4.4 | Open-source musculoskeletal modeling and simulation platform. |

| Python 3 | Anaconda Inc | Version 3.8 | The open source Individual Edition containing Python 3.8 and preinstalled packages to perform video processing and connecting the pose estimation tools. |

Referências

- LaValle, C. R., et al. Neurocognitive performance deficits related to immediate and acute blast overpressure exposure. Front Neurol. 10, (2019).

- Kamimori, G. H., et al. Longitudinal investigation of neurotrauma serum biomarkers, behavioral characterization, and brain imaging in soldiers following repeated low-level blast exposure (New Zealand Breacher Study). Military Med. 183 (suppl_1), 28-33 (2018).

- Wang, Z., et al. Acute and chronic molecular signatures and associated symptoms of blast exposure in military breachers. J Neurotrauma. 37 (10), 1221-1232 (2020).

- Gill, J., et al. Moderate blast exposure results in increased IL-6 and TNFα in peripheral blood. Brain Behavior Immunity. 65, 90-94 (2017).

- Carr, W., et al. Ubiquitin carboxy-terminal hydrolase-L1 as a serum neurotrauma biomarker for exposure to occupational low-Level blast. Front Neurol. 6, (2015).

- Boutté, A. M., et al. Brain-related proteins as serum biomarkers of acute, subconcussive blast overpressure exposure: A cohort study of military personnel. PLoS One. 14 (8), e0221036(2019).

- Skotak, M., et al. Occupational blast wave exposure during multiday 0.50 caliber rifle course. Front Neurol. 10, (2019).

- Kamimori, G. H., Reilly, L. A., LaValle, C. R., Silva, U. B. O. D. Occupational overpressure exposure of breachers and military personnel. Shock Waves. 27 (6), 837-847 (2017).

- Misistia, A., et al. Sensor orientation and other factors which increase the blast overpressure reporting errors. PLoS One. 15 (10), e0240262(2020).

- National Defense Authorization Act for Fiscal Year 2020. Wikipedia. , https://en.wikipedia.org/w/index.php?title=National_Defense_Authorization_Act_for_Fiscal_Year_2020&oldid=1183832580 (2023).

- Przekwas, A., et al. Fast-running tools for personalized monitoring of blast exposure in military training and operations. Military Med. 186 (Supplement_1), 529-536 (2021).

- Spencer, R. W., et al. Fiscal year 2018 National Defense Authorization Act, Section 734, Weapon systems line of inquiry: Overview and blast overpressure tool-A module for human body blast wave exposure for safer weapons training. Military Med. 188 (Supplement_6), 536-544 (2023).

- Delp, S. L., et al. OpenSim: open-source software to create and analyze dynamic simulations of movement. IEEE Trans Biomed Eng. 54 (11), 1940-1950 (2007).

- Zhou, X., Sun, K., Roos, P. E., Li, P., Corner, B. Anthropometry model generation based on ANSUR II database. Int J Digital Human. 1 (4), 321(2016).

- Zhou, X., Przekwas, A. A fast and robust whole-body control algorithm for running. Int J Human Factors Modell Simulat. 2 (1-2), 127-148 (2011).

- Zhou, X., Whitley, P., Przekwas, A. A musculoskeletal fatigue model for prediction of aviator neck manoeuvring loadings. Int J Human Factors Modell Simulat. 4 (3-4), 191-219 (2014).

- Roos, P. E., Vasavada, A., Zheng, L., Zhou, X. Neck musculoskeletal model generation through anthropometric scaling. PLoS One. 15 (1), e0219954(2020).

- Garimella, H. T., Kraft, R. H. Modeling the mechanics of axonal fiber tracts using the embedded finite element method. Int J Numer Method Biomed Eng. 33 (5), (2017).

- Garimella, H. T., Kraft, R. H., Przekwas, A. J. Do blast induced skull flexures result in axonal deformation. PLoS One. 13 (3), e0190881(2018).

- Przekwas, A., et al. Biomechanics of blast TBI with time-resolved consecutive primary, secondary, and tertiary loads. Military Med. 184 (Suppl 1), 195-205 (2019).

- Gharahi, H., Garimella, H. T., Chen, Z. J., Gupta, R. K., Przekwas, A. Mathematical model of mechanobiology of acute and repeated synaptic injury and systemic biomarker kinetics. Front Cell Neurosci. 17, 1007062(2023).

- Przekwas, A., Somayaji, M. R., Gupta, R. K. Synaptic mechanisms of blast-induced brain injury. Front Neurol. 7, 2(2016).

- Liu, Y., Wang, C., Zhou, Y. Camouflaged people detection based on a semi-supervised search identification network. Def Technol. 21, 176-183 (2023).

- Batpurev, T. Real time 3D body pose estimation using MediaPipe. , Available from: https://temugeb.github.io/python/computer_vision/2021/09/14/bodypose3d.html (2021).

Reimpressões e Permissões

Solicitar permissão para reutilizar o texto ou figuras deste artigo JoVE

Solicitar PermissãoExplore Mais Artigos

This article has been published

Video Coming Soon

Copyright © 2025 MyJoVE Corporation. Todos os direitos reservados