Method Article

폭발 노출 시뮬레이션을 위한 무기 훈련 장면 이미지에서 전투원 아바타 생성

요약

이미지 및/또는 비디오 데이터를 사용하여 군인의 3D 아바타로 구성된 가상 장면을 자동으로 재구성하기 위해 계산 프레임워크가 개발되었습니다. 가상 장면은 무기 훈련 중 폭발 과압 노출을 추정하는 데 도움이 됩니다. 이 도구는 다양한 시나리오의 폭발 노출 시뮬레이션에서 인간의 자세를 사실적으로 표현할 수 있도록 합니다.

초록

무기 훈련에 참여한 군인들은 반복적인 저수준 폭발을 겪는다. 폭발 하중을 추정하는 일반적인 방법에는 웨어러블 폭발 게이지가 포함됩니다. 그러나 웨어러블 센서 데이터를 사용하면 군인의 신체 자세에 대한 지식 없이는 머리나 다른 장기에 가해지는 폭발 하중을 정확하게 추정할 수 없습니다. 보다 안전한 무기 훈련을 수행하기 위한 이미지/비디오 증강 보완 실험-계산 플랫폼이 개발되었습니다. 이 연구는 폭발 노출 시뮬레이션을 위해 비디오 데이터에서 무기 훈련 장면을 자동으로 생성하기 위한 프로토콜을 설명합니다. 무기 발사 순간 영상 데이터에서 추출한 폭발 장면에는 장병들의 신체 아바타, 무기, 지상 및 기타 구조물이 포함된다. 계산 프로토콜은 이 데이터를 사용하여 군인의 위치와 자세를 재구성하는 데 사용됩니다. 군인의 신체 실루엣에서 추출한 이미지 또는 비디오 데이터는 해부학적 골격과 주요 인체 측정 데이터를 생성하는 데 사용됩니다. 이 데이터는 개별 신체 부위로 분할되고 추출된 군인 자세와 일치하도록 기하학적으로 변형된 3D 신체 표면 아바타를 생성하는 데 사용됩니다. 최종 가상 무기 훈련 장면은 장병의 무기 폭발 파도 하중에 대한 3D 계산 시뮬레이션에 사용됩니다. 무기 훈련 장면 생성기는 다양한 방향과 자세의 이미지 또는 비디오에서 개별 군인 신체의 3D 해부학적 아바타를 구성하는 데 사용되었습니다. 어깨 장착형 돌격 무기 체계와 박격포 무기 체계 이미지 데이터로부터 훈련 장면을 생성한 결과를 제시합니다. BOP(Blast Overpressure) 도구는 가상 무기 훈련 장면을 사용하여 군인 아바타 신체에 가해지는 폭발파 하중의 3D 시뮬레이션을 수행합니다. 이 논문은 무기 발사로 인한 폭발파 전파와 훈련 중인 군인의 폭발 부하에 대한 3D 컴퓨터 시뮬레이션을 제시합니다.

서문

군사 훈련 중에 군인과 교관은 중화기와 경화기로 낮은 수준의 폭발에 자주 노출됩니다. 최근 연구에 따르면 폭발 노출은 신경인지 성능 저하 1,2 및 혈액 바이오마커 3,4,5,6의 변화로 이어질 수 있습니다. 낮은 수준의 폭발 노출이 반복되면 최적의 성능을 유지하고 부상 위험을 최소화하는 데 어려움이 있습니다 7,8. 웨어러블 압력 센서를 사용하는 기존의 접근법은 특히 머리에 가해지는 폭발 압력을 정확하게 결정하는 데 있어 단점이 있다9. 낮은 수준의 폭발 노출이 인간의 성과에 미치는 알려진 부작용(예: 훈련 중 및 운영 역할)은 이 문제를 악화시킵니다. 의회의 명령(섹션 734 및 717)은 훈련 및 전투 중 폭발 노출에 대한 모니터링 및 군인의 의료 기록에 이를 포함시키기 위한 요구 사항을 규정했습니다10.

웨어러블 센서는 이러한 전투 훈련 작업 중 폭발 과압을 모니터링하는 데 사용할 수 있습니다. 그러나 이러한 센서는 인체와 폭발파 상호 작용의 복잡한 특성으로 인해 신체 자세, 방향 및 폭발원으로부터의 거리와 같은 변수의 영향을 받는다9. 다음 요인은 압력 분포 및 센서 측정에 영향을 미칩니다9:

폭발원으로부터의 거리: 압력 강도는 폭발파가 분산되고 감쇠됨에 따라 거리에 따라 달라집니다. 폭발에 가까운 센서는 더 높은 압력을 기록하여 데이터 정확성과 일관성에 영향을 미칩니다.

신체 자세: 다양한 자세는 다양한 신체 표면을 폭발에 노출시켜 압력 분포를 변경합니다. 예를 들어, 서 있는 것과 웅크리는 것은 다른 압력 판독값을 초래합니다 9,11.

방향: 폭발원에 대한 물체의 각도는 압력파가 물체와 상호 작용하는 방식에 영향을 미치므로 판독값에 불일치가 발생합니다9. 물리 기반 수치 시뮬레이션은 이러한 변수를 체계적으로 설명함으로써 보다 정확한 평가를 제공하며, 본질적으로 이러한 요인의 영향을 받는 웨어러블 센서에 비해 통제되고 포괄적인 분석을 제공합니다.

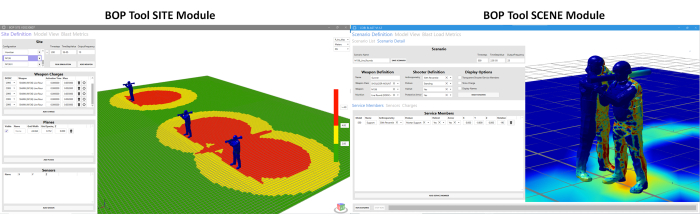

이러한 도전에 대응하기 위해 보다 정교한 도구를 개발하기 위한 공동의 노력이 있었습니다. 이 방향으로 BOP(Blast Overpressure) 도구가 개발됩니다. 이 도구는 무기 시스템 주변의 다양한 군인 자세와 위치에서 과압 노출을 추정하기 위해 개발되었습니다. BOP 도구11 아래에는 두 가지 다른 모듈이 있습니다. (a) BOP 도구 SCENE 모듈과 (b) BOP 도구 SITE 모듈입니다. 이 모듈은 무기 발사 중 폭발 과압을 추정하는 데 사용됩니다12. BOP SCENE 모듈은 훈련 시나리오에 참여하는 개별 군인 또는 교관이 경험한 폭발 과압을 추정하기 위해 개발되었으며, BOP SITE 모듈은 여러 발사 스테이션에서 생성된 폭발 과압 영역을 묘사하여 훈련 과정의 조감도를 재구성합니다. 그림 1 은 두 모듈의 스냅샷을 보여줍니다. 현재 BOP 도구 모듈은 M107 .50 cal SASR(Special Application Sniper Rifle), M136 어깨 장착 돌격 무기, M120 간접 사격 박격포 및 돌파 폭약을 포함한 4개의 국방부 정의 Tier-1 무기 시스템에 대한 무기 폭발 과압 특성(동등한 폭발 소스 용어)으로 구성됩니다. 무기 폭발 커널이라는 용어는 실제 무기와 동일한 폭발 필드를 둘러싼 무기 시스템을 복제하기 위해 개발 된 동등한 폭발 소스 용어를 나타냅니다. BOP 툴의 개발에 사용된 계산 프레임워크에 대한 보다 상세한 설명은 추가 참조문헌11에서 확인할 수 있다. 과압 시뮬레이션은 CoBi-Blast 솔버 엔진을 사용하여 실행됩니다. 이것은 폭발 과압을 시뮬레이션하기 위한 멀티스케일 다중 물리 도구입니다. 엔진의 폭발 모델링 능력은 문헌12의 실험 데이터에 대해 검증되었습니다. 이 BOP 도구는 현재 다양한 무기 훈련 범위에서 사용할 수 있도록 RMTK(Range Managers Toolkit)에 통합되고 있습니다. RMTK는 사격장 운영, 안전 및 현대화 프로세스를 자동화하여 육군, 해병대, 공군 및 해군 전반에 걸쳐 사격장 관리자의 요구 사항을 충족하도록 설계된 다중 서비스 데스크톱 도구 제품군입니다.

그림 1: BOP 도구 SCENE 모듈 및 BOP 도구 SITE 모듈의 그래픽 사용자 인터페이스(GUI). BOP SCENE 모듈은 군인 및 교관 신체 모델의 폭발 과압을 추정하도록 설계되었으며, BOP SITE 모듈은 훈련 필드를 나타내는 비행기의 과압 윤곽을 추정하기 위한 것입니다. 사용자는 지면을 기준으로 비행기가 위치하는 높이를 선택할 수 있습니다. 이 그림의 더 큰 버전을 보려면 여기를 클릭하십시오.

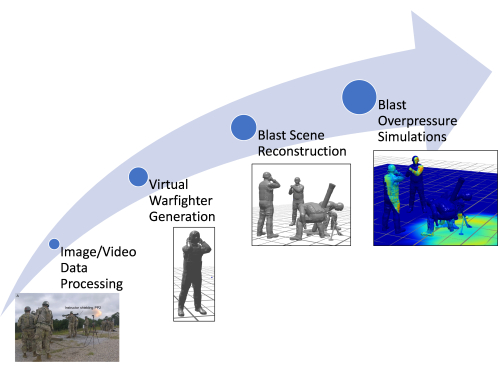

기존 BOP 도구 SCENE 모듈의 한 가지 제한 사항은 인체 측정, 자세 및 위치를 포함하여 가상 서비스 회원 신체 모델을 구축하기 위해 수동으로 추정된 데이터를 사용한다는 것입니다. 적절한 자세를 취하는 가상 서비스 구성원을 수동으로 생성하는 것은 노동 집약적이고 시간이 많이 걸립니다11,12. 레거시 BOP 도구(레거시 접근 방식)는 사전 구성된 자세 데이터베이스를 사용하여 이미지 데이터(사용 가능한 경우)를 기반으로 무기 훈련 장면을 구축합니다. 또한 자세는 시각적 평가를 통해 수동으로 근사화되기 때문에 복잡한 자세 환경에서 올바른 자세가 포착되지 않을 수 있습니다. 결과적으로, 이 접근 방식은 개별 군인에 대한 추정 과압 노출에 부정확성을 초래합니다(자세의 변화는 더 취약한 지역의 과압 노출을 수정할 수 있기 때문에). 이 백서는 기존의 최첨단 포즈 추정 도구를 사용하여 서비스 구성원 모델을 빠르고 자동으로 생성할 수 있도록 기존 계산 프레임워크에 대한 개선 사항을 제시합니다. 이 백서에서는 BOP 도구의 향상된 기능에 대해 설명하며, 특히 비디오 및 이미지 데이터를 사용하여 폭발 장면을 재구성하기 위한 새롭고 신속한 컴퓨팅 파이프라인의 개발을 강조합니다. 개선된 도구는 또한 무기 발사 순간에 군인과 교관의 상세한 신체 모델을 재구성할 수 있으며, 비디오 데이터를 활용하여 기존 접근 방식에 비해 개인화된 아바타를 생성할 수 있습니다. 이 아바타는 장병의 자세를 정확하게 반영합니다. 이 작업은 폭발 장면 생성 프로세스를 간소화하고 추가 무기 시스템에 대한 폭발 장면을 보다 빠르게 포함할 수 있도록 하여 무기 훈련 장면 생성에 필요한 시간과 노력을 크게 줄입니다. 그림 2는 이 문서에서 논의된 향상된 계산 프레임워크의 개략도를 보여줍니다.

그림 2: 계산 프레임워크의 전체 프로세스 흐름도를 보여주는 개략도. 다양한 단계에는 이미지/비디오 데이터 처리, 가상 전투원 생성, 폭발 장면 재구성 및 폭발 과압 시뮬레이션이 포함됩니다. 이 그림의 더 큰 버전을 보려면 여기를 클릭하십시오.

이 백서에서는 BOP 도구에 구현되는 자동화된 접근 방식을 제시하며, 이는 교육 및 작업 중 과압 노출을 추정하는 데 사용할 수 있는 계산 도구의 상당한 개선을 나타냅니다. 이 도구는 개인화된 아바타와 훈련 시나리오의 빠른 생성을 통해 차별화되어 몰입형 폭발 과압 시뮬레이션을 가능하게 합니다. 이는 인구 평균 인체 모델에 대한 기존의 의존에서 크게 벗어나 보다 정확하고 개별화된 접근 방식을 제공합니다.

자동화 프로세스에 사용되는 계산 도구

가상 서비스 구성원 모델 생성의 자동화는 고급 계산 도구를 활용하여 원시 이미지 또는 비디오 데이터를 상세한 3D 표현으로 변환하는 다단계 프로세스입니다. 전체 프로세스는 자동화되어 있지만 필요한 경우 알려진 측정값을 수동으로 입력할 수 있도록 조정할 수 있습니다.

3D 포즈 추정 도구: 자동화 파이프라인의 핵심은 3D 포즈 추정 도구입니다. 이러한 도구는 이미지 데이터를 분석하여 군인의 신체에 있는 각 관절의 위치와 방향을 식별하여 디지털 골격을 효과적으로 생성합니다. 파이프라인은 현재 Python API를 제공하는 Mediapipe 및 MMPose를 지원합니다. 그러나 이 시스템은 유연성을 염두에 두고 설계되어 필요한 3D 관절 및 뼈 데이터를 출력할 수 있는 경우 깊이 카메라와 같은 다른 도구를 통합할 수 있습니다.

인체 측정 모델 생성기(AMG): 3D 포즈가 추정되면 AMG가 작동합니다. 이 도구는 포즈 데이터를 활용하여 서비스 구성원의 고유한 신체 치수와 일치하는 3D 스킨 표면 모델을 만듭니다. AMG 도구를 사용하면 인체 측정 값을 자동 또는 수동으로 입력 할 수 있으며, 이는 도구 내의 주요 구성 요소에 연결되어 그에 따라 3D 바디 메쉬를 모핑합니다.

OpenSim 골격 모델링: 다음 단계는 오픈 소스 OpenSim 플랫폼13과 관련이 있으며, 여기서 골격 모델은 3D 포즈 데이터와 정렬되도록 조정됩니다. 포즈 추정 도구는 스켈레톤에 일관된 뼈대 길이를 적용하지 않으며, 이로 인해 신체의 비대칭이 비현실적으로 발생할 수 있습니다. 해부학적으로 올바른 OpenSim 골격을 사용하면 보다 사실적인 뼈 구조를 생성할 수 있습니다. 마커는 포즈 추정 도구로 식별된 관절 중심에 해당하도록 OpenSim 골격에 배치됩니다. 그런 다음 이 스켈레톤 모델은 표준 애니메이션 기술을 사용하여 3D 스킨 메시에 리깅됩니다.

역운동학 및 Python 스크립팅: 가상 서비스 구성원의 포즈를 마무리하기 위해 역운동학 알고리즘이 사용됩니다. 이 알고리즘은 추정된 3D 포즈와 가장 잘 일치하도록 OpenSim 골격 모델을 조정합니다. 전체 포즈 파이프라인은 완전히 자동화되어 Python 3에서 구현됩니다. 이러한 도구의 통합을 통해 가상 서비스 회원 모델을 생성하는 프로세스가 크게 빨라져 필요한 시간이 며칠에서 몇 초 또는 몇 분으로 단축되었습니다. 이러한 발전은 무기 훈련 시나리오의 시뮬레이션 및 분석에서 도약을 의미하며, 이미지 또는 비디오를 사용하여 문서화된 특정 시나리오를 신속하게 재구성할 수 있습니다.

프로토콜

이 연구에 사용된 이미지와 비디오는 저자가 인간 피험자로부터 직접 얻은 것이 아닙니다. 한 이미지는 공개 도메인 라이선스에 따라 사용할 수 있는 Wikimedia Commons의 무료 리소스에서 가져왔습니다. 다른 이미지는 Walter Reed Army Institute of Research(WRAIR)의 공동 작업자가 제공했습니다. WRAIR에서 얻은 데이터는 확인되지 않았으며 기관 지침에 따라 공유되었습니다. WRAIR가 제공한 이미지의 경우, 프로토콜은 필요한 모든 승인 및 동의를 얻는 것을 포함하여 WRAIR의 인간 연구 윤리 위원회의 지침을 따랐습니다.

1. BOP Tool SCENE 모듈 액세스

- BOP Tool SCENE Module 버튼을 클릭하여 BOP Tool Interface에서 BOP Tool SCENE 모듈을 엽니다.

- Scenario Definition(시나리오 정의)을 클릭한 다음 Scenario Detail(시나리오 세부 정보) 탭을 클릭합니다.

2. 이미지 데이터 읽기 및 처리

- BOP 도구 SCENE 모듈에서 POSETOOL IMPORT 버튼을 클릭합니다. 사용자에게 관련 이미지 또는 비디오를 선택하라는 팝업 창이 열립니다.

- 폴더로 이동하여 마우스 조작을 사용하여 관련 이미지/비디오를 선택합니다.

- 이미지를 선택하면 창 팝업에서 열기 를 클릭합니다.

참고: 이 작업은 이미지 또는 비디오 파일을 읽고, 비디오가 선택된 경우 이미지를 생성하고, 백그라운드에서 포즈 추정 알고리즘을 실행하고, 무기 훈련 장면과 관련된 가상 서비스 멤버 모델을 생성하고, 이를 BOP Tool SCENE 모듈의 해당 위치에 로드합니다.

3. 무기 및 슈터 구성

- Scenario Name(시나리오 이름) 아래의 텍스트 상자를 사용하여 시나리오의 이름을 선택합니다. 이것은 사용자의 선택입니다. 여기에 설명된 시나리오의 경우 개발자는 시나리오 이름 BlastDemo1을 선택했습니다.

- Weapon Definition(무기 정의) 아래의 Name(이름) 필드에서 사용자 지정 이름을 선택합니다. 이것은 다시 사용자 선택입니다. 여기에서 논의된 시나리오의 경우 개발자는 무기 이름 120Mortar를 선택했습니다.

- 드롭다운 메뉴의 옵션 목록에서 적절한 무기 클래스(예: HEAVY MORTAR)를 선택합니다.

- 드롭다운의 선택 목록에서 무기(이 경우 M120)를 선택합니다. 무기 시스템을 선택하면 해당 블래스트 커널이 Charges 하위 탭의 GUI에 자동으로 로드됩니다.

참고: 드롭다운에는 위에서 선택한 무기 클래스에 따라 가능한 다양한 무기 시스템이 있습니다. - 드롭다운 옵션을 사용하여 선택한 무기 시스템의 탄약탄(Full Range Training Round) 을 선택합니다.

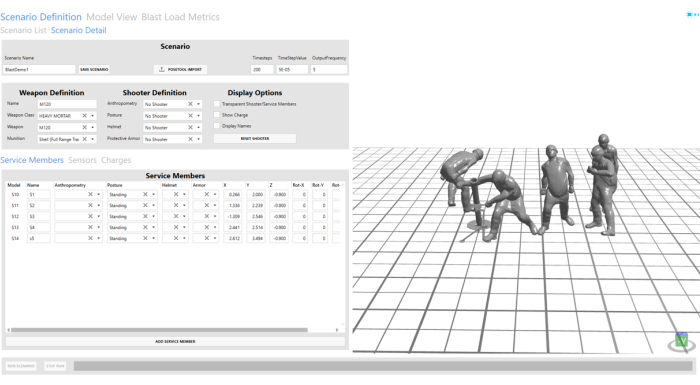

- 드롭다운 옵션의 Shooter Definition(슈터 정의) 아래에 있는 Anthropometry(인체 측정), Posture(자세), Helmet(헬멧) 및 Protective armor(보호 갑옷) 필드에서 No Shooter(슈터 없음 )를 선택합니다. 구성된 사수 및 서비스 구성원에 대해서는 그림 3 을 참조하십시오.

참고: 슈터는 4단계를 통해 가져온 씬에 포함되므로 슈터 정의에서 슈터가 선택되지 않았습니다.

그림 3: 이미지 데이터에서 가져온 폭발 장면. 폭발 장면은 GUI 도구의 오른쪽에 있는 시각화 창에서 볼 수 있습니다. 이 그림의 더 큰 버전을 보려면 여기를 클릭하십시오.

4. 서비스 멤버 구성

- Service Members 탭을 클릭합니다. 이 탭은 이미지 데이터에서 가져온 서비스 구성원의 위치와 방향을 제어합니다. X, Y, Z 및 회전 옵션을 사용하여 이 작업을 수행합니다. 보조 사수에 해당하는 아바타의 경우 저자는 보다 합리적인 보조 사수 위치를 위해 Y 위치를 2.456에서 2로 조정했습니다.

- Service Members 탭의 Name 필드를 사용하여 GUI로 가져온 모든 가상 서비스 멤버 모델에 대한 사용자 정의 이름을 선택합니다. 여기에서 S1, S2, S3, S4 및 S5가 자동으로 가져온 모든 서비스 멤버 모델에 대해 선택됩니다.

참고: 여기에 설명된 시나리오의 경우 S1 및 S2로 명명되었습니다. 다른 필드는 자동으로 채워집니다. 사용자는 이를 수정하여 자동으로 추정된 위치/자세를 구체화할 수 있습니다. - 삭제 버튼을 사용하여 S2, S4 및 S5를 제거합니다. 여기에 표시된 시나리오에서는 발사 시 사수와 보조 사수만 있습니다.

참고: 이 작업은 필요에 따라 서비스 멤버 모델을 삭제하거나 기존 장면에 추가할 수 있는 사용자 지정 사용자 옵션을 보여주기 위해 수행되었습니다.

5. 가상 센서 구성

- 센서 탭으로 이동합니다. Add Sensor(센서 추가)를 클릭하여 새 가상 센서를 추가합니다.

- Name(이름) 필드에서 사용자 지정 이름을 선택합니다. 개발자는 이 문서에서 데모를 위해 V1을 선택했습니다.

- Sensor Type(센서 유형) 필드 아래의 Drop-down(드롭다운)을 클릭하여 유형을 Virtual(가상)로 선택합니다.

- 센서의 위치를 (-0.5, 2, 0.545)로 선택합니다. X, Y 및 Z 필드 아래의 텍스트 상자를 편집합니다. 여기에 설명된 시나리오의 경우 개발자는 데모를 위해 4개의 서로 다른 위치에 4개의 서로 다른 센서를 만들었습니다. 개발자는 추가 센서의 센서 이름으로 V2, V3 및 V4를 선택했습니다.

- 5.1에서 5.4까지의 단계를 반복하여 (-0.5, 1, 0.545), (-0.5, 0.5, 0.545) 및 (-0.5, 0, 0.545)에 추가 센서를 만듭니다. [Rotation] 값을 0으로 둡니다.

알림: 사용자는 폭발 충전에 대한 센서의 방향을 조정하기 위해 회전을 사용할 수 있는 평면 센서를 선택할 수도 있습니다.

6. 프로그램 저장 및 실행

- 상단의 GUI에서 Save Scenario 버튼을 클릭하여 무기 훈련 장면을 저장합니다.

- 하단의 Run Scenario 버튼을 클릭하여 M120 무기 훈련 장면에 대한 폭발 과압 시뮬레이션을 실행합니다. 시뮬레이션 진행률은 하단의 진행률 표시줄을 사용하여 표시됩니다.

7. 결과 시각화

- 모델 뷰(Model View) 탭으로 이동하여 폭발 과압 노출 시뮬레이션을 검사합니다.

- 현재 버튼을 클릭하여 완료된 시뮬레이션을 시각화 창에 로드합니다.

- 시뮬레이션이 로드되면 화면 하단의 Play 버튼을 사용하여 시뮬레이션을 시각화합니다.

- 사용자는 탐색 모음의 다양한 옵션 중에서 선택하여 다양한 속도로 시뮬레이션을 재생하고 일시 중지할 수 있습니다. 아래 재생 컨트롤의 스크린샷은 더 많은 옵션을 보여줍니다. 사용자는 마우스를 사용하여 대화형 창을 제어할 수 있습니다. 마우스 오른쪽 버튼을 클릭하고 드래그하여 모드를 회전하고, 왼쪽 버튼을 클릭하여 모델을 변환하고, 중간 버튼을 클릭하여 안팎으로 스크롤합니다.

- 시뮬레이션을 검토한 후 Blast Load Metrics 탭을 클릭하여 이동합니다.

- Current 버튼을 클릭하여 가상 센서 위치에서 과압 플롯을 불러옵니다.

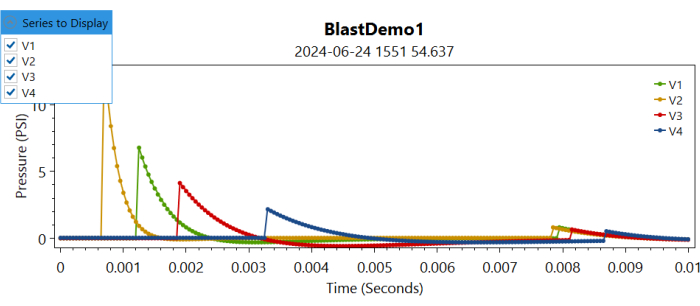

알림: 이렇게 하면 다른 플롯의 다른 센서 위치에서 과압 정보가 로드됩니다. - Display to Display(표시할 시리즈) 드롭다운 메뉴로 이동하고 Corresponding Sensor(해당 센서)의 Box(상자)를 선택하여 선택하여 해당 가상 센서에서 기록된 과압을 표시합니다( 그림 4 참조).

그림 4: 시간 경과에 따른 다양한 가상 센서의 과압에 대한 플롯 제어. 사용자는 다른 센서를 선택하거나 선택 취소하여 표시할 시리즈를 선택할 수 있습니다. 이 그림의 더 큰 버전을 보려면 여기를 클릭하십시오.

결과

가상 서비스 대원 및 폭발 현장의 자동 재구성

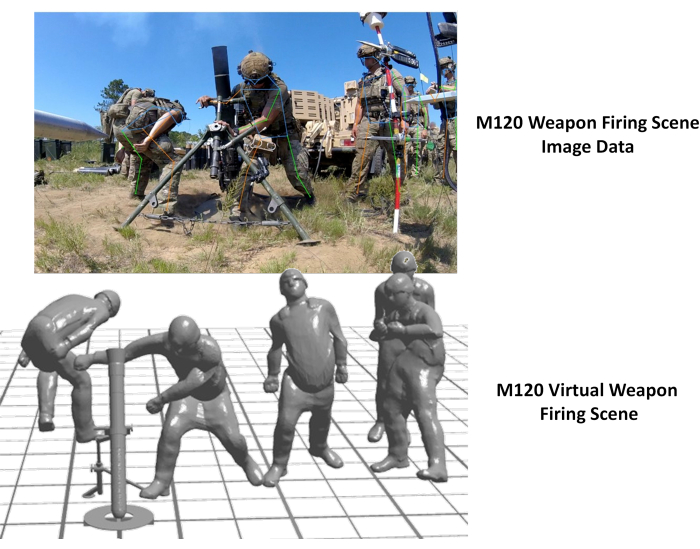

자동화된 가상 서비스 구성원 신체 모델 및 무기 훈련 장면 모델 생성은 BOP 도구 자동화 기능을 통해 달성되었습니다. 그림 5 는 이미지 데이터에서 생성된 가상 훈련 장면을 보여줍니다. 여기에서 볼 수 있듯이 결과 장면은 이미지 데이터를 잘 표현했습니다. 그림 5의 시연에 사용된 이미지는 Wikimedia Commons에서 가져온 것입니다.

그림 5: 이미지 데이터의 가상 무기 훈련 장면. 왼쪽 사진은 AT4 무기 발사에 해당하는 이미지 데이터, 오른쪽 사진은 가상 자동 생성 무기 훈련 장면을 보여줍니다. 이 수치는 Wikimedia Commons에서 가져온 것입니다. 이 그림의 더 큰 버전을 보려면 여기를 클릭하십시오.

또한 이 접근 방식을 적용하여 M120 무기 발사 장면을 재구성했습니다. 이 이미지는 M120 박격포 무기에 대한 압력 데이터 수집 노력의 일환으로 WRAIR에 의해 수집되었습니다. 아래 그림 6 은 원본 이미지와 함께 재구성된 가상 무기 발사 장면을 보여줍니다. 가상 재건에서 보조 사수의 위치에서 불일치가 관찰되었습니다. 이것은 BOP GUI 사용자 옵션을 사용하여 보조 사수의 위치를 조정하여 수정할 수 있습니다. 더욱이, 강사의 골반 자세는 정확하지 않은 것처럼 보였는데, 이는 이미지의 말뚝으로 인한 방해 때문인 것으로 보인다. 이 접근 방식을 다른 깊이 이미징 양식과 통합하면 이러한 불일치를 해결하는 데 도움이 될 것입니다.

그림 6: 이미지 데이터의 가상 무기 훈련 장면. 왼쪽 사진은 M120 무기 발사에 해당하는 이미지 데이터이고 오른쪽 사진은 가상 자동 생성 무기 훈련 장면을 보여줍니다. 이 그림의 더 큰 버전을 보려면 여기를 클릭하십시오.

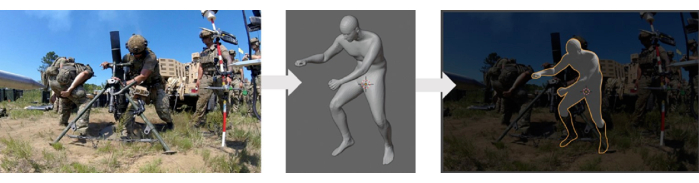

자동화된 장면 생성 접근 방식의 검증

이 연구에 사용된 인체 모델 생성기는 의료 영상 데이터의 인체 측정 측정을 포함하는 ANSUR II 인체 스캔 데이터베이스14를 사용하여 검증을 거쳤습니다. 이 인체 모델 생성기를 활용한 자동 재구성 방법은 손에 쥔 데이터로 정성적 검증을 거쳤습니다. 이 검증 프로세스에는 재구성된 모델을 실험 데이터(이미지)와 오버레이하여 비교하는 작업이 포함되었습니다. 그림 7 은 3D 아바타 모델과 실험 데이터를 비교한 것입니다. 그러나 이 방법에 대한 보다 철저한 검증이 필요하며, 이를 위해서는 훈련 장면에 참여한 다양한 군인의 정확한 위치, 자세 및 방향을 포함하여 현장의 추가 실험 데이터가 필요합니다.

그림 7: 이미지로 생성된 가상 인체 모델의 정성적 비교. 왼쪽 패널에는 원본 이미지, 중간 패널에는 생성된 가상 바디 모델, 오른쪽 패널에는 원본 이미지에 겹쳐진 가상 모델이 표시됩니다. 이 그림의 더 큰 버전을 보려면 여기를 클릭하십시오.

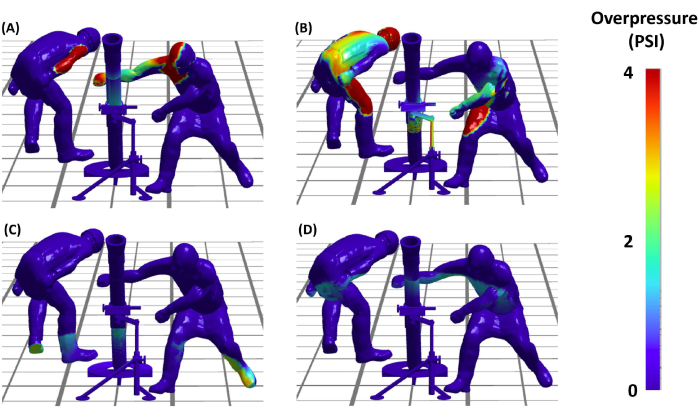

대표적인 폭발 과압 시뮬레이션

폭발 장면을 설정한 후 저자는 폭발 과압(BOP) 시뮬레이션을 실행하는 임계 단계로 진행할 수 있었습니다. 이를 통해 무기 발사 현장에 관련된 다양한 군인에 대한 폭발 하중 분포를 이해할 수 있습니다. 그림 8 은 AT4 무기 발사 이벤트 중 이러한 BOP 시뮬레이션의 결과를 나타냅니다. 시뮬레이션은 시간이 지남에 따라 서로 다른 순간에 장면의 가상 군인에 대한 과압 부하에 대한 자세한 시각화를 제공합니다. 결론적으로, 이 결과는 실현 가능성뿐만 아니라 무기 훈련 시나리오의 정확하고 분석적으로 유용한 재구성을 생성하는 프로토콜의 효과를 보여주며, 이를 통해 군사 훈련 안전 및 효율성에 대한 보다 발전된 연구를 위한 길을 열었습니다.

그림 8: 슈터에 대한 폭발 과압 노출. (A, B, C, D) 4개의 패널은 서로 다른 순간에 M120 박격포 발사에 참여한 가상 군인에 대한 예측 폭발 과압 모델을 보여줍니다. 패널 (C) 및 (D)는 지면 반사로 인한 과압 전파를 보여줍니다. 이 그림의 더 큰 버전을 보려면 여기를 클릭하십시오.

토론

이 논문에 제시된 계산 프레임워크는 시각적 평가를 사용하여 이전에 사용된 수동 방법에 비해 폭발 무기 훈련 장면의 생성을 크게 가속화합니다. 이 접근법은 다양한 군사 태세를 신속하게 포착하고 재구성할 수 있는 프레임워크의 능력을 보여준다.

현재 접근 방식의 장점

특정 자세와 위치에서 가상 인체 모델을 만드는 것은 어려운 작업이며 이러한 목적으로 사용할 수 있는 도구가 제한되어 있습니다. 레거시 접근 방식, 특히 BOP 도구에 사용된 기존 방법은 CoBi-DYN 14,15,16,17을 사용했습니다. 이 방법에는 의복, 헬멧, 보호 갑옷 및 부츠가 있는 가상 인체 모델을 수동으로 만드는 작업이 포함되었습니다. 모델은 체계적인 접근 방식이 부족한 대략적인 시각적 근사치를 통해 생성되었습니다. 레거시 BOP 도구에서 CoBi-DYN은 시나리오 구성 단계에서 액세스할 수 있는 인체 모델 데이터베이스를 만드는 데 사용되었습니다. 사용자는 수동으로 대략적인 자세 구성을 선택하고 BOP 시나리오를 실행하기 위해 특정 무기 시스템에 대략적으로 배치합니다. 기존 서비스 구성원 데이터베이스(BOP 도구의 드롭다운에서 액세스)에서 폭발 장면을 재구성하는 것은 비교적 빨랐지만, 가상 서비스 구성원 모델 데이터베이스의 초기 생성은 수동 및 대략적인 프로세스 특성으로 인해 장면당 약 16-24시간이 소요되어 시간이 많이 걸렸습니다. 반면, 새로운 접근 방식은 잘 정립된 포즈 추정 도구를 활용하여 가상 인체 모델을 보다 자동화되고 빠르게 생성합니다. 이러한 도구는 비디오 및 이미지 데이터를 자동으로 활용하여 가상 군인 아바타로 폭발 장면을 신속하게 재구성합니다. 이를 통해 인체 데이터베이스를 만드는 데 필요한 시간을 크게 줄일 수 있습니다. 이 새로운 접근 방식에는 추가 소프트웨어 없이 이미징 데이터에서 전체 가상 장면을 생성하거나 재구성하기 위해 한 번의 버튼 클릭이 포함됩니다. 이제 전체 프로세스는 장면당 약 5-6초가 소요되며(비디오에서 시연될 것처럼 이미지 데이터를 읽은 후) 기존 방법에 비해 효율성이 크게 향상되었음을 보여줍니다. 이 방법은 원래 접근 방식을 대체하기 위한 것이 아니라 가상 서비스 구성원 모델(향후 서비스 구성원 본문 모델 데이터베이스에 추가할 수 있음)의 생성 속도를 높여 보완하기 위한 것입니다. 다양한 복잡성을 가진 새로운 구성의 추가를 단순화하고 향후 새로운 무기 시스템의 통합을 용이하게 하여 BOP 도구의 확장성을 향상시킵니다. 기존 접근 방식과 비교했을 때, 제시된 방법은 보다 간소화되고 자동화된 솔루션을 제공하여 수동 작업과 시간을 줄이는 동시에 가상 인체 모델 생성의 정확성과 체계적인 특성을 개선한다는 것이 분명합니다. 이것은 현장에서 설명된 방법의 강점과 혁신을 강조합니다.

자동화된 장면 생성의 검증

접근 방식에 대한 정성적 검증은 이미지 데이터에 재구성된 시나리오를 오버레이하여 수행되었습니다. 그러나 이러한 이미지의 위치 및 자세에 대한 사용 가능한 데이터가 부족하여 정량적 검증이 불가능했습니다. 저자들은 보다 철저한 검증의 중요성을 인식하고 향후 작업에서 이 문제를 해결할 계획입니다. 이를 달성하기 위해 저자들은 정확한 위치 및 자세 정보를 얻기 위한 포괄적인 데이터 수집 노력을 구상하고 있습니다. 이를 통해 상세한 정량적 검증을 수행할 수 있으며, 궁극적으로 접근 방식의 견고성과 정확성을 향상시킬 수 있습니다.

폭발 노출 시뮬레이션의 검증

무기 폭발 커널은 무기 발사 중에 수집된 연필 프로브 데이터를 사용하여 개발 및 검증되었습니다. 무기 폭발 커널 및 관련 노출에 대한 자세한 내용은 향후 간행물에 포함될 예정입니다. 이와 관련된 일부 정보는 과거 간행물11,12에서도 확인할 수 있습니다. 이러한 지속적인 노력은 폭발 과압 시뮬레이션의 정밀도와 효율성을 개선하고 도구의 유효성을 강화하는 데 기여할 것입니다.

여기에 제시된 접근 방식은 군인의 가상 아바타를 생성하는 데에도 사용할 수 있으며, 나중에 BOP 도구를 사용하여 선택을 위해 데이터베이스에 통합할 수 있습니다. 현재 프로세스에서는 모델을 데이터베이스에 자동으로 저장하지 않지만 작성자는 BOP 도구의 향후 버전에 이 기능을 포함할 계획입니다. 또한 저자는 이미지 데이터에서 자동화된 자세와 3D 모델이 생성되면 자세를 수동으로 수정할 수 있는 사내 도구를 보유하고 있습니다. 현재 이 기능은 독립적으로 존재하며 사용자 인터페이스에 대한 추가 개발이 필요하므로 BOP 도구에 통합되지 않습니다. 그럼에도 불구하고 이것은 진행 중인 작업이며 저자는 이를 BOP 도구의 향후 버전에 통합할 계획입니다.

폭발 하중 데이터는 ASCII 텍스트 파일 형식으로도 내보낼 수 있으며, 추가 후처리 단계를 적용하여 다양한 무기 시스템의 폭발 선량 패턴을 보다 자세히 조사할 수 있습니다. 현재 임펄스, 강도 등과 같은 출력 메트릭에 대한 고급 후처리 도구를 개발하기 위한 작업이 진행 중이며, 이를 통해 사용자는 이러한 시나리오에서 더 복잡한 반복 폭발 하중을 이해하고 조사할 수 있습니다. 또한 이 도구는 계산 효율성을 위해 개발되었으며 빠른 시뮬레이션 속도를 가능하게 합니다. 따라서 이러한 도구를 사용하면 역 최적화 연구를 실행하여 무기 발사 시나리오에서 최적의 자세와 위치를 결정할 수 있습니다. 이러한 개선은 다양한 무기 훈련 범위에서 훈련 프로토콜을 최적화하기 위한 도구의 적용 가능성을 향상시킵니다. 폭발량 추정은 또한 뇌, 폐 등과 같은 다양한 취약한 해부학적 영역(18,19,20) 및 미시적 손상 모델(20,21)에 대한 보다 정교한 고해상도 거시적 계산 모델을 개발하는 데 사용될 수 있습니다. 여기서 모델에 통합된 헬멧과 갑옷은 시각적 표현만을 위한 것이며 이러한 시뮬레이션에서 폭발량에 영향을 미치지 않습니다. 이는 모델이 강체 구조로 간주되기 때문이며, 이는 모델이 포함되어도 폭발 과압 시뮬레이션의 결과를 수정하거나 영향을 미치지 않는다는 것을 의미합니다.

이 논문은 무기 훈련 시나리오에서 인간의 포즈를 추정하기 위해 기존 오픈 소스 포즈 추정 도구를 활용합니다. 여기에서 개발되고 논의된 프레임워크는 포즈 도구에 구애받지 않습니다, 즉, 저자는 더 많은 발전이 이루어짐에 따라 기존 도구를 새 도구로 교체할 수 있습니다. 전반적으로 테스트 결과 최신 소프트웨어 도구는 매우 강력하지만 이미지 기반 포즈 감지는 어려운 작업이라는 것이 입증되었습니다. 그러나 포즈 감지 성능을 향상시키는 데 사용할 수 있는 몇 가지 권장 사항이 있습니다. 이러한 도구는 관심 있는 사람이 카메라의 명확한 시야에 있을 때 가장 잘 작동합니다. 무기 훈련 중에 항상 가능한 것은 아니지만 카메라를 배치할 때 이를 고려하면 포즈 감지 결과를 향상시킬 수 있습니다. 더욱이 훈련을 실시하는 장병들은 주변 환경과 조화를 이루는 위장된 피로를 착용하는 경우가 많습니다. 이로 인해 사람의 눈과 기계 학습(ML) 알고리즘 모두에서 감지하기가 더 어려워집니다. 위장23을 착용한 인간을 감지하는 ML 알고리즘의 능력을 향상시키는 방법이 존재하지만 구현하기가 쉽지 않습니다. 가능한 경우 대비가 높은 배경의 위치에서 무기 훈련 이미지를 수집하면 포즈 감지를 향상시킬 수 있습니다.

또한 이미지에서 3D 수량을 추정하는 기존의 접근 방식은 여러 카메라 각도에서 사진 측량 기술을 사용하는 것입니다. 여러 각도에서 이미지/비디오를 녹화하는 것도 포즈 추정을 개선하는 데 사용할 수 있습니다. 여러 카메라에서 포즈 추정치를 융합하는 것은 비교적 간단합니다24. 결과를 개선할 수 있는 또 다른 사진 측량 기술은 바둑판 또는 알려진 치수의 기타 물체를 각 카메라의 공통 기준점으로 사용하는 것입니다. 여러 대의 카메라를 사용할 때의 어려움은 카메라를 시간 동기화하는 것입니다. 맞춤형 학습된 머신 러닝 모델을 개발하여 얼굴 대신 헬멧과 같은 특성을 감지하거나 군대 전용 의류 및 장비(예: 부츠, 조끼, 방탄복)를 착용한 사람을 감지할 수 있습니다. 기존 포즈 추정 도구는 맞춤형 학습된 ML 모델을 사용하여 보강할 수 있습니다. 이것은 시간이 많이 걸리고 지루하지만 포즈 추정 모델의 성능을 크게 향상시킬 수 있습니다.

요약하면, 이 백서는 향상된 폭발 과압 프레임워크의 다양한 구성 요소를 효과적으로 설명합니다. 여기에서 저자들은 파이프라인의 보다 원활한 통합과 완전 자동화를 통해 적용 가능성과 효율성을 향상시킬 수 있는 잠재력도 인식합니다. AMG 툴을 사용한 스케일링된 3D 바디 메시 생성과 같은 요소는 수동 사용자 입력을 줄이기 위해 자동화되고 있습니다. 현재 이러한 기능을 BOP 도구 SCENE 모듈에 통합하기 위한 작업이 진행 중입니다. 이 기술이 개발됨에 따라 모든 국방부 이해 관계자와 연구소에서 액세스할 수 있게 될 것입니다. 또한 진행 중인 작업에는 추가 무기 시스템에 대한 무기 커널의 특성화 및 검증이 포함됩니다. 방법론을 개선하고 검증하기 위한 이러한 지속적인 노력은 저자가 개발하는 도구가 기술 발전의 최전선에 서서 군사 훈련 훈련의 안전성과 효율성에 크게 기여할 수 있도록 합니다. 향후 간행물에서는 이러한 발전에 대한 자세한 내용을 제공하여 군사 훈련 및 안전 분야를 더욱 넓히는 데 기여할 것입니다.

공개

저자는 밝힐 것이 없습니다.

감사의 말

이 연구는 MTEC 프로젝트 호출 MTEC-22-02-MPAI-082 산하 DoD 폭발 부상 연구 조정 사무소에서 자금을 지원합니다. 저자들은 또한 무기 폭발 커널에 대한 Hamid Gharahi와 무기 발사 폭발 과압 시뮬레이션을 위한 모델링 기능을 개발한 Zhijian J Chen의 기여를 인정합니다. 이 프레젠테이션에 표현된 견해, 의견 및/또는 결과는 저자의 것이며 육군부 또는 국방부의 공식 정책이나 입장을 반영하지 않습니다.

자료

| Name | Company | Catalog Number | Comments |

| Anthropometric Model Generator (AMG) | CFD Research | N/A | For generting 3D human body models with different anthropometric characteristics. The tool is DoD Open Source. |

| BOP Tool | CFD Research | N/A | For setting up blast scenes and overpressure simulations. The tool is DoD open source. |

| BOP Tool SCENE Module | CFD Research | N/A | For setting up blast scenes and overpressure simulations. The tool is DoD open source. |

| Mediapipe | Version 0.9 | Open-source pose estimation library. | |

| MMPose | OpenMMLab | Version 1.2 | Open-source pose estimation library. |

| OpenSim | Stanford University | Version 4.4 | Open-source musculoskeletal modeling and simulation platform. |

| Python 3 | Anaconda Inc | Version 3.8 | The open source Individual Edition containing Python 3.8 and preinstalled packages to perform video processing and connecting the pose estimation tools. |

참고문헌

- LaValle, C. R., et al. Neurocognitive performance deficits related to immediate and acute blast overpressure exposure. Front Neurol. 10, (2019).

- Kamimori, G. H., et al. Longitudinal investigation of neurotrauma serum biomarkers, behavioral characterization, and brain imaging in soldiers following repeated low-level blast exposure (New Zealand Breacher Study). Military Med. 183 (suppl_1), 28-33 (2018).

- Wang, Z., et al. Acute and chronic molecular signatures and associated symptoms of blast exposure in military breachers. J Neurotrauma. 37 (10), 1221-1232 (2020).

- Gill, J., et al. Moderate blast exposure results in increased IL-6 and TNFα in peripheral blood. Brain Behavior Immunity. 65, 90-94 (2017).

- Carr, W., et al. Ubiquitin carboxy-terminal hydrolase-L1 as a serum neurotrauma biomarker for exposure to occupational low-Level blast. Front Neurol. 6, (2015).

- Boutté, A. M., et al. Brain-related proteins as serum biomarkers of acute, subconcussive blast overpressure exposure: A cohort study of military personnel. PLoS One. 14 (8), e0221036(2019).

- Skotak, M., et al. Occupational blast wave exposure during multiday 0.50 caliber rifle course. Front Neurol. 10, (2019).

- Kamimori, G. H., Reilly, L. A., LaValle, C. R., Silva, U. B. O. D. Occupational overpressure exposure of breachers and military personnel. Shock Waves. 27 (6), 837-847 (2017).

- Misistia, A., et al. Sensor orientation and other factors which increase the blast overpressure reporting errors. PLoS One. 15 (10), e0240262(2020).

- National Defense Authorization Act for Fiscal Year 2020. Wikipedia. , https://en.wikipedia.org/w/index.php?title=National_Defense_Authorization_Act_for_Fiscal_Year_2020&oldid=1183832580 (2023).

- Przekwas, A., et al. Fast-running tools for personalized monitoring of blast exposure in military training and operations. Military Med. 186 (Supplement_1), 529-536 (2021).

- Spencer, R. W., et al. Fiscal year 2018 National Defense Authorization Act, Section 734, Weapon systems line of inquiry: Overview and blast overpressure tool-A module for human body blast wave exposure for safer weapons training. Military Med. 188 (Supplement_6), 536-544 (2023).

- Delp, S. L., et al. OpenSim: open-source software to create and analyze dynamic simulations of movement. IEEE Trans Biomed Eng. 54 (11), 1940-1950 (2007).

- Zhou, X., Sun, K., Roos, P. E., Li, P., Corner, B. Anthropometry model generation based on ANSUR II database. Int J Digital Human. 1 (4), 321(2016).

- Zhou, X., Przekwas, A. A fast and robust whole-body control algorithm for running. Int J Human Factors Modell Simulat. 2 (1-2), 127-148 (2011).

- Zhou, X., Whitley, P., Przekwas, A. A musculoskeletal fatigue model for prediction of aviator neck manoeuvring loadings. Int J Human Factors Modell Simulat. 4 (3-4), 191-219 (2014).

- Roos, P. E., Vasavada, A., Zheng, L., Zhou, X. Neck musculoskeletal model generation through anthropometric scaling. PLoS One. 15 (1), e0219954(2020).

- Garimella, H. T., Kraft, R. H. Modeling the mechanics of axonal fiber tracts using the embedded finite element method. Int J Numer Method Biomed Eng. 33 (5), (2017).

- Garimella, H. T., Kraft, R. H., Przekwas, A. J. Do blast induced skull flexures result in axonal deformation. PLoS One. 13 (3), e0190881(2018).

- Przekwas, A., et al. Biomechanics of blast TBI with time-resolved consecutive primary, secondary, and tertiary loads. Military Med. 184 (Suppl 1), 195-205 (2019).

- Gharahi, H., Garimella, H. T., Chen, Z. J., Gupta, R. K., Przekwas, A. Mathematical model of mechanobiology of acute and repeated synaptic injury and systemic biomarker kinetics. Front Cell Neurosci. 17, 1007062(2023).

- Przekwas, A., Somayaji, M. R., Gupta, R. K. Synaptic mechanisms of blast-induced brain injury. Front Neurol. 7, 2(2016).

- Liu, Y., Wang, C., Zhou, Y. Camouflaged people detection based on a semi-supervised search identification network. Def Technol. 21, 176-183 (2023).

- Batpurev, T. Real time 3D body pose estimation using MediaPipe. , Available from: https://temugeb.github.io/python/computer_vision/2021/09/14/bodypose3d.html (2021).

재인쇄 및 허가

JoVE'article의 텍스트 или 그림을 다시 사용하시려면 허가 살펴보기

허가 살펴보기더 많은 기사 탐색

This article has been published

Video Coming Soon

Copyright © 2025 MyJoVE Corporation. 판권 소유