Method Article

Generierung von Avataren von Soldaten aus Bildern von Waffentrainingsszenen für Explosionssimulationen

In diesem Artikel

Zusammenfassung

Es wurde ein rechnerisches Framework entwickelt, um virtuelle Szenen mit 3D-Avataren von Soldaten anhand von Bild- und/oder Videodaten automatisch zu rekonstruieren. Die virtuellen Szenen helfen bei der Abschätzung der Explosionsüberdruckbelastung während des Waffentrainings. Das Tool ermöglicht eine realistische Darstellung der menschlichen Körperhaltung in Explosionssimulationen in verschiedenen Szenarien.

Zusammenfassung

Militärangehörige, die an der Waffenausbildung beteiligt sind, sind wiederholten Explosionen aus geringer Höhe ausgesetzt. Die vorherrschende Methode zur Abschätzung von Strahllasten sind tragbare Strahlmessgeräte. Anhand von tragbaren Sensordaten können die Explosionsbelastungen des Kopfes oder anderer Organe jedoch nicht genau abgeschätzt werden, wenn die Körperhaltung des Soldaten nicht bekannt ist. Es wurde eine bild-/videogestützte, komplementäre experimentell-rechnerische Plattform für die Durchführung eines sichereren Waffentrainings entwickelt. Diese Studie beschreibt das Protokoll zur automatisierten Generierung von Waffentrainingsszenen aus Videodaten für Explosionsexpositionssimulationen. Die Explosionsszene, die aus den Videodaten im Moment des Waffenschusses extrahiert wurde, umfasst die Körperavatare der Soldaten, die Waffen, den Boden und andere Strukturen. Das Berechnungsprotokoll wird verwendet, um die Positionen und Körperhaltungen der Soldaten anhand dieser Daten zu rekonstruieren. Bild- oder Videodaten, die aus den Körpersilhouetten der Soldaten extrahiert werden, werden verwendet, um ein anatomisches Skelett und die wichtigsten anthropometrischen Daten zu erstellen. Diese Daten werden verwendet, um die 3D-Körperoberflächen-Avatare zu generieren, die in einzelne Körperteile segmentiert und geometrisch transformiert werden, um den extrahierten Haltungen der Soldaten zu entsprechen. Die abschließende virtuelle Waffentrainingsszene wird für 3D-Computersimulationen der Belastung von Militärangehörigen durch Druckwellen verwendet. Der Waffentrainingsszenen-Generator wurde verwendet, um anatomische 3D-Avatare einzelner Soldatenkörper aus Bildern oder Videos in verschiedenen Ausrichtungen und Haltungen zu konstruieren. Es werden Ergebnisse der Generierung einer Trainingsszene aus Bilddaten des schultermontierten Sturmwaffensystems und des Mörserwaffensystems vorgestellt. Das Explosionsüberdruck-Tool (BOP) verwendet die virtuelle Waffentrainingsszene für 3D-Simulationen der Druckwellenbelastung auf die Avatarkörper der Soldaten. In diesem Beitrag werden 3D-Computersimulationen der Druckwellenausbreitung durch Waffenabschuss und der entsprechenden Explosionsbelastungen auf Militärangehörige in der Ausbildung vorgestellt.

Einleitung

Während der militärischen Ausbildung sind Militärangehörige und Ausbilder häufig Explosionen aus geringer Höhe mit schweren und leichten Waffen ausgesetzt. Neuere Studien haben gezeigt, dass die Exposition gegenüber Blasten zu einer verminderten neurokognitiven Leistungsfähigkeit führen kann 1,2 und zu Veränderungen der Blutbiomarker 3,4,5,6. Wiederholte Exposition gegenüber schwachen Strahlen führt zu Herausforderungen bei der Aufrechterhaltung einer optimalen Leistung und der Minimierung des Verletzungsrisikos 7,8. Der herkömmliche Ansatz mit tragbaren Drucksensoren hat Nachteile, insbesondere wenn es darum geht, den Strahldruck am Kopf genau zu bestimmen9. Die bekannten nachteiligen Auswirkungen einer wiederholten Exposition gegenüber schwachen Explosionen auf die menschliche Leistungsfähigkeit (z. B. während der Ausbildung und in operativen Rollen) verschärfen dieses Problem. Mandate des Kongresses (Abschnitte 734 und 717) haben die Anforderung zur Überwachung der Explosionsexposition in Ausbildung und Kampf und deren Aufnahme in die Krankenakte des Soldaten festgelegt10.

Tragbare Sensoren können verwendet werden, um den Explosionsüberdruck während dieser Gefechtsübungsoperationen zu überwachen. Diese Sensoren werden jedoch aufgrund der komplexen Natur der Druckwellenwechselwirkungen mit dem menschlichen Körper von Variablen wie Körperhaltung, Ausrichtung und Entfernung von der Druckquelle beeinflusst9. Folgende Faktoren beeinflussen die Druckverteilung und die Sensormessungen9:

Entfernung von der Druckquelle: Die Druckintensität variiert mit der Entfernung, da sich die Druckwelle ausbreitet und abschwächt. Sensoren, die näher an der Explosion liegen, zeichnen höhere Drücke auf, was sich auf die Genauigkeit und Konsistenz der Daten auswirkt.

Körperhaltung: Unterschiedliche Körperhaltungen setzen verschiedene Körperoberflächen der Explosion aus, wodurch sich die Druckverteilung verändert. Zum Beispiel führt das Stehen im Vergleich zum Hocken zu unterschiedlichen Druckwerten 9,11.

Ausrichtung: Der Winkel des Körpers relativ zur Explosionsquelle beeinflusst, wie die Druckwelle mit dem Körper interagiert, was zu Diskrepanzen bei den Messwertenführt 9. Physikbasierte numerische Simulationen ermöglichen genauere Bewertungen, indem sie diese Variablen systematisch berücksichtigen und eine kontrollierte und umfassende Analyse im Vergleich zu tragbaren Sensoren bieten, die von Natur aus von diesen Faktoren beeinflusst werden.

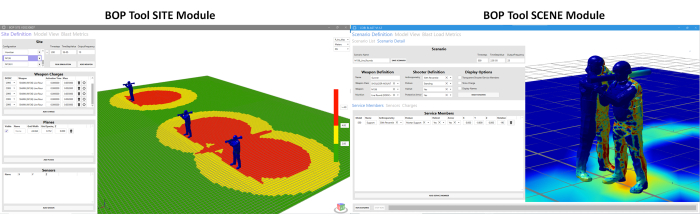

Als Reaktion auf diese Herausforderungen wurden konzertierte Anstrengungen unternommen, um ausgefeiltere Instrumente zu entwickeln. In diese Richtung wird das Tool Blast Overpressure (BOP) entwickelt. Dieses Tool wurde entwickelt, um die Überdruckbelastung unter unterschiedlichen Haltungen und Positionen von Militärangehörigen um die Waffensysteme herum abzuschätzen. Unter dem BOP-Tool11 gibt es zwei verschiedene Module. Es handelt sich um (a) das BOP-Tool SCENE und (b) das BOP Tool SITE Modul. Diese Module werden verwendet, um den Explosionsüberdruck während des Waffenabfeuernsabzuschätzen 12. Das BOP SCENE-Modul wurde entwickelt, um den Explosionsüberdruck abzuschätzen, dem einzelne Militärangehörige oder Ausbilder, die an einem Trainingsszenario teilnehmen, ausgesetzt sind, während das BOP SITE-Modul eine Vogelperspektive des Trainingskurses rekonstruiert und die von mehreren Feuerstationen erzeugten Explosionsüberdruckzonen darstellt. Abbildung 1 zeigt einen Snapshot der beiden Module. Derzeit umfassen die BOP-Tool-Module Waffenüberdruckeigenschaften (äquivalenter Begriff der Explosionsquelle) für vier vom Verteidigungsministerium definierte Tier-1-Waffensysteme, darunter das M107 .50 cal Special Application Sniper Rifle (SASR), die M136 Shoulder-Mounted Assault Weapon, der M120 Indirect Fire Mortar und Durchbruchsladungen. Der Begriff Waffenexplosionskern bezieht sich auf einen äquivalenten Begriff der Explosionsquelle, der entwickelt wurde, um das gleiche Explosionsfeld zu replizieren, das ein Waffensystem umgibt wie das der eigentlichen Waffe. Eine detailliertere Beschreibung des Berechnungsrahmens, der für die Entwicklung des BOP-Tools verwendet wurde, ist für weitere Referenz11 verfügbar. Die Überdrucksimulationen werden mit der CoBi-Blast-Solver-Engine ausgeführt. Hierbei handelt es sich um ein Multiskalen-Multiphysik-Tool zur Simulation von Explosionsüberdrücken. Die Explosionsmodellierungsfähigkeiten des Motors werden anhand experimenteller Daten aus der Literaturvalidiert 12. Dieses BOP-Tool wird derzeit in das Range Managers Toolkit (RMTK) integriert und kann auf verschiedenen Waffenübungsplätzen eingesetzt werden. RMTK ist eine Multi-Service-Suite von Desktop-Tools, die entwickelt wurde, um die Anforderungen von Range-Managern in der gesamten Armee, dem Marine Corps, der Luftwaffe und der Navy zu erfüllen, indem sie den Range-Betrieb, die Sicherheit und die Modernisierungsprozesse automatisieren.

Abbildung 1: Grafische Benutzeroberfläche (GUI) für das BOP-Tool SCENE Module und das BOP Tool SITE Module. Das BOP SCENE-Modul dient zur Schätzung des Explosionsüberdrucks an Körpermodellen von Soldaten und Ausbildern, während das BOP SITE-Modul eine Schätzung der Überdruckkonturen auf einer Ebene ermöglichen soll, die das Trainingsfeld darstellt. Der Benutzer hat die Möglichkeit, die Höhe zu wählen, in der sich die Ebene relativ zum Boden befindet. Bitte klicken Sie hier, um eine größere Version dieser Abbildung anzuzeigen.

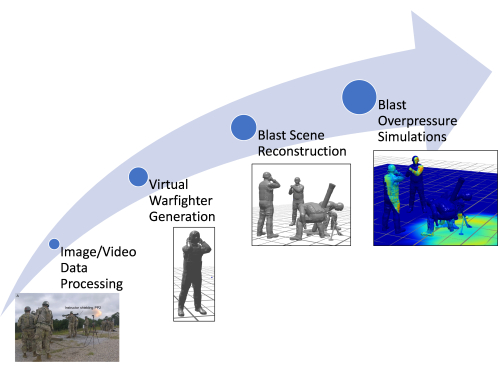

Eine Einschränkung des vorhandenen BOP-Tools SCENE-Modul besteht in der Verwendung manuell geschätzter Daten für die Erstellung virtueller Modelle von Servicemitgliedern, einschließlich ihrer Anthropometrie, Haltung und Position. Die manuelle Generierung der virtuellen Servicemitglieder in der entsprechenden Haltung ist arbeits- und zeitintensiv11,12. Das Legacy-BOP-Tool (Legacy-Ansatz) verwendet eine Datenbank mit vorkonfigurierten Haltungen, um die Waffentrainingsszene auf der Grundlage der Bilddaten (falls verfügbar) zu erstellen. Da die Körperhaltungen manuell durch visuelle Beurteilung angenähert werden, können korrekte Körperhaltungen für eine komplexe Haltungseinstellung möglicherweise nicht erfasst werden. Infolgedessen führt dieser Ansatz zu Ungenauigkeiten in der geschätzten Überdruckexposition für einzelne Militärangehörige (da eine Änderung der Körperhaltung die Überdruckbelastung in anfälligeren Regionen verändern kann). Das Papier stellt Verbesserungen vor, die am bestehenden Berechnungsrahmen vorgenommen wurden, um eine schnelle und automatische Generierung von Modellen für Servicemitglieder unter Verwendung vorhandener State-of-the-Art-Tools zur Posenschätzung zu ermöglichen. In diesem Beitrag wird die Verbesserung des BOP-Tools diskutiert, wobei insbesondere die Entwicklung einer neuartigen und schnellen Rechenpipeline zur Rekonstruktion von Explosionsszenen anhand von Video- und Bilddaten im Vordergrund steht. Das verbesserte Tool kann auch detaillierte Körpermodelle von Militärangehörigen und Ausbildern zum Zeitpunkt des Waffenabschusses rekonstruieren und dabei Videodaten verwenden, um personalisierte Avatare im Vergleich zum alten Ansatz zu erstellen. Diese Avatare spiegeln die Haltung der Militärangehörigen genau wider. Diese Arbeit rationalisiert den Prozess der Generierung von Explosionsszenen und ermöglicht eine schnellere Einbeziehung von Explosionsszenen für zusätzliche Waffensysteme, wodurch der Zeit- und Arbeitsaufwand für die Erstellung von Waffentrainingsszenen erheblich reduziert wird. Abbildung 2 zeigt ein Schema des erweiterten Berechnungsrahmens, der in diesem Artikel diskutiert wird.

Abbildung 2: Schematische Darstellung des gesamten Prozessflussdiagramms im Computational Framework. Zu den verschiedenen Schritten gehören die Verarbeitung von Bild-/Videodaten, die Generierung virtueller Soldaten, die Rekonstruktion von Explosionsszenen und Simulationen von Explosionsüberdruck. Bitte klicken Sie hier, um eine größere Version dieser Abbildung anzuzeigen.

Das Papier stellt den automatisierten Ansatz vor, der in das BOP-Tool implementiert wird, was eine signifikante Verbesserung der verfügbaren Berechnungswerkzeuge zur Abschätzung der Überdruckbelastung während des Trainings und des Betriebs darstellt. Dieses Tool zeichnet sich durch die schnelle Generierung personalisierter Avatare und Trainingsszenarien aus, die immersive Explosionsüberdrucksimulationen ermöglichen. Dies stellt eine deutliche Abkehr von der traditionellen Abhängigkeit von bevölkerungsgemittelten menschlichen Körpermodellen dar und bietet einen präziseren und individuelleren Ansatz.

Rechenwerkzeuge, die im Automatisierungsprozess verwendet werden

Die Automatisierung der Generierung von Modellen für virtuelle Servicemitglieder ist ein mehrstufiger Prozess, der fortschrittliche Berechnungstools nutzt, um rohe Bild- oder Videodaten in detaillierte 3D-Darstellungen umzuwandeln. Der gesamte Prozess ist automatisiert, kann aber bei Bedarf so angepasst werden, dass die manuelle Eingabe bekannter Messungen möglich ist.

Tools zur Schätzung von 3D-Posen: Das Herzstück der Automatisierungspipeline sind die 3D-Tools zur Posenschätzung. Diese Tools analysieren die Bilddaten, um die Position und Ausrichtung jedes Gelenks im Körper des Soldaten zu identifizieren und so effektiv ein digitales Skelett zu erstellen. Die Pipeline unterstützt derzeit Mediapipe und MMPose, die Python-APIs anbieten. Das System ist jedoch auf Flexibilität ausgelegt und ermöglicht die Integration anderer Werkzeuge, wie z. B. Tiefenkameras, sofern diese die erforderlichen 3D-Gelenk- und Knochendaten ausgeben können.

Anthropometrischer Modellgenerator (AMG): Sobald die 3D-Pose geschätzt ist, kommt der AMG ins Spiel. Dieses Werkzeug verwendet Posendaten, um ein 3D-Hautoberflächenmodell zu erstellen, das den einzigartigen Körperabmessungen des Service-Mitglieds entspricht. Das AMG-Tool ermöglicht die automatische oder manuelle Eingabe von anthropometrischen Messungen, die dann mit den Hauptkomponenten innerhalb des Tools verknüpft werden, um das 3D-Körpernetz entsprechend zu morphen.

OpenSim-Skelettmodellierung: Der nächste Schritt betrifft die Open-Source-OpenSim-Plattform13, bei der ein Skelettmodell angepasst wird, um es an den 3D-Posendaten auszurichten. Tools zur Posenschätzung erzwingen keine konsistenten Knochenlängen im Skelett, was zu einer unrealistischen Asymmetrie im Körper führen kann. Durch die Verwendung eines anatomisch korrekten OpenSim-Skeletts entsteht eine realistischere Knochenstruktur. Markierungen werden auf dem OpenSim-Skelett platziert, die den Gelenkzentren entsprechen, die vom Posenschätzungstool identifiziert wurden. Dieses Skelettmodell wird dann mit Hilfe von Standardanimationstechniken an das 3D-Hautnetz geriggt.

Inverse Kinematik und Python-Scripting: Um die Pose des virtuellen Servicemitglieds zu finalisieren, wird ein inverser Kinematikalgorithmus verwendet. Dieser Algorithmus passt das OpenSim-Skelettmodell so an, dass es der geschätzten 3D-Pose am besten entspricht. Die gesamte Posing-Pipeline ist vollständig automatisiert und in Python 3 implementiert. Durch die Integration dieser Tools wurde der Prozess der Generierung virtueller Servicemitgliedermodelle erheblich beschleunigt, wodurch der Zeitaufwand von Tagen auf Sekunden oder Minuten reduziert wurde. Dieser Fortschritt stellt einen Sprung nach vorne in der Simulation und Analyse von Waffentrainingsszenarien dar und ermöglicht eine schnelle Rekonstruktion spezifischer Szenarien, die mit Bildern oder Videos dokumentiert sind.

Protokoll

Die in dieser Studie verwendeten Bilder und Videos wurden von den Autoren nicht direkt von menschlichen Probanden gewonnen. Ein Bild stammt aus freien Quellen auf Wikimedia Commons, die unter einer Public-Domain-Lizenz verfügbar sind. Das andere Bild wurde von Mitarbeitern des Walter Reed Army Institute of Research (WRAIR) zur Verfügung gestellt. Die von WRAIR erhaltenen Daten waren nicht identifiziert und wurden in Übereinstimmung mit den institutionellen Richtlinien weitergegeben. Für die von WRAIR bereitgestellten Bilder folgte das Protokoll den Richtlinien der Ethikkommission von WRAIR für die Humanforschung, einschließlich der Einholung aller erforderlichen Genehmigungen und Zustimmungen.

1. Zugriff auf das BOP Tool SCENE-Modul

- Öffnen Sie das BOP Tool SCENE Module über die BOP Tool Interface, indem Sie auf die Schaltfläche BOP Tool SCENE Module klicken.

- Klicken Sie auf Szenariodefinition und dann auf die Registerkarte Szenariodetail .

2. Auslesen und Verarbeiten der Bilddaten

- Klicken Sie auf die Schaltfläche POSETOOL IMPORT im Modul SCENE des BOP-Tools. Es öffnet sich ein Pop-up-Fenster, in dem der Benutzer aufgefordert wird, das entsprechende Bild oder Video auszuwählen.

- Navigieren Sie zu dem Ordner und wählen Sie das entsprechende Bild/Video mit der Maus aus.

- Klicken Sie im Fenster-Popup auf Öffnen , sobald ein Bild ausgewählt ist.

HINWEIS: Dieser Vorgang liest die Bild- oder Videodatei, generiert ein Bild, wenn ein Video ausgewählt ist, führt den Posenschätzungsalgorithmus im Hintergrund aus, generiert die Modelle der virtuellen Soldaten, die an der Waffentrainingsszene beteiligt sind, und lädt sie an ihren jeweiligen Positionen in das BOP Tool SCENE-Modul.

3. Konfiguration der Waffe und des Shooters

- Wählen Sie einen Namen für das Szenario aus, indem Sie das Textfeld unter Szenarioname verwenden. Dies ist eine Entscheidung des Benutzers. Für das hier besprochene Szenario haben die Entwickler den Szenarionamen BlastDemo1 gewählt.

- Wählen Sie einen benutzerdefinierten Namen im Feld Name unter der Waffendefinition. Auch dies ist eine Entscheidung des Benutzers. Für das hier besprochene Szenario haben die Entwickler den Waffennamen 120Mortar gewählt.

- Wählen Sie die entsprechende Waffenklasse, z.B. SCHWERER MÖRSER, aus der Liste der Optionen im Dropdown-Menü aus.

- Wähle die Waffe (in diesem Fall M120) aus der Liste der Auswahlmöglichkeiten in der Dropdown-Liste aus. Bei der Auswahl des Waffensystems wird der entsprechende Explosionskern automatisch in die GUI unter dem Unterreiter "Ladungen" geladen.

HINWEIS: Das Dropdown-Menü enthält die verschiedenen möglichen Waffensysteme, die für die oben ausgewählte Waffenklasse spezifisch sind. - Wählen Sie die Munitionsgranate (Full Range Training Round) für das gewählte Waffensystem mithilfe der Dropdown-Optionen aus.

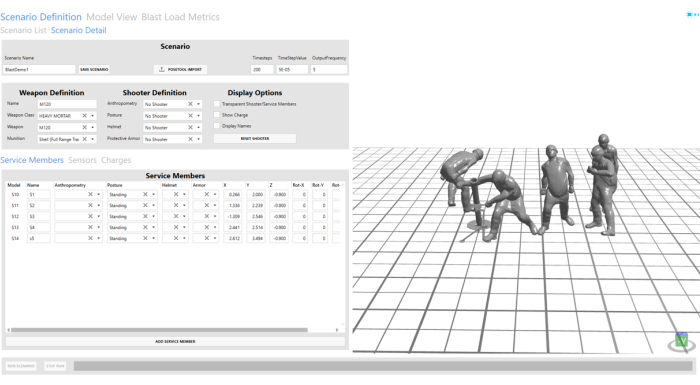

- Wählen Sie in den Dropdown-Optionen in den Feldern Anthropometrie, Haltung, Helm und Schutzrüstung unter der Schützendefinition die Option Kein Schütze aus. In Abbildung 3 finden Sie konfigurierte Shooter- und Service-Member.

HINWEIS: Da der Shooter in die Szene aufgenommen wird, die durch Schritt 4 importiert wurde, wurde kein Shooter unter der Shooter-Definition ausgewählt.

Abbildung 3: Importierte Explosionsszene aus den Bilddaten. Die Explosionsszene ist im Visualisierungsfenster auf der rechten Seite des GUI-Tools sichtbar. Bitte klicken Sie hier, um eine größere Version dieser Abbildung anzuzeigen.

4. Konfigurieren der Servicemitglieder

- Klicken Sie auf die Registerkarte "Servicemitglieder ". Diese Registerkarte steuert die Position und Ausrichtung der Service-Mitglieder, die aus den Bilddaten importiert werden. Verwenden Sie dazu die Optionen X, Y, Z und ROTATION. Für den Avatar, der dem Hilfsschützen entspricht, haben die Autoren die Y-Position von 2,456 auf 2 angepasst, um eine vernünftigere Position des Hilfsschützen zu erhalten.

- Wählen Sie benutzerdefinierte Namen für alle Modelle virtueller Servicemitglieder aus, die in die GUI importiert wurden, indem Sie das Feld Name auf der Registerkarte Servicemitglieder verwenden. S1, S2, S3, S4 und S5 werden hier für alle automatisch importierten Modelle von Servicemitgliedern ausgewählt.

HINWEIS: Für das hier beschriebene Szenario wurden sie als S1 und S2 bezeichnet. Die anderen Felder werden automatisch ausgefüllt. Benutzer können sie ändern, um die automatisch geschätzte Position/Haltung zu verfeinern. - Verwenden Sie die Schaltfläche Löschen , um S2, S4 und S5 zu entfernen. In dem hier gezeigten Szenario sind zum Zeitpunkt des Schusses nur der Schütze und der Hilfsschütze anwesend.

HINWEIS: Dies wurde durchgeführt, um die benutzerdefinierten Benutzeroptionen zum Löschen oder Hinzufügen von Service-Member-Modellen nach Bedarf zu einer vorhandenen Szene zu veranschaulichen.

5. Konfigurieren der virtuellen Sensoren

- Navigieren Sie zur Registerkarte Sensoren . Fügen Sie einen neuen virtuellen Sensor hinzu, indem Sie auf Sensor hinzufügen klicken.

- Wählen Sie im Feld Name einen benutzerdefinierten Namen aus. Die Entwickler haben V1 für die Demonstration in diesem Artikel ausgewählt.

- Wählen Sie den Typ als Virtuell aus, indem Sie auf das Dropdown-Menü unter dem Feld Sensortyp klicken.

- Wählen Sie die Position des Sensors (-0,5, 2, 0,545) aus, indem Sie die Textfelder unter den Feldern X, Y und Z bearbeiten. Für das hier besprochene Szenario haben die Entwickler zu Demonstrationszwecken vier verschiedene Sensoren an vier verschiedenen Standorten erstellt. Als Sensornamen für die zusätzlichen Sensoren haben die Entwickler V2, V3 und V4 gewählt.

- Wiederholen Sie die Schritte von 5.1 bis 5.4, um zusätzliche Sensoren bei (-0,5, 1, 0,545), (-0,5, 0,5, 0,545) und (-0,5, 0, 0,545) zu erstellen. Belassen Sie den Rotationswert auf Null.

HINWEIS: Der Benutzer kann auch planare Sensoren wählen, bei denen die Drehung verwendet werden kann, um die Ausrichtung des Sensors in Bezug auf die Explosionscharge anzupassen.

6. Speichern und Ausführen des Programms

- Speichere die Waffentrainingsszene, indem du oben in der GUI auf die Schaltfläche "Szenario speichern" klickst.

- Führen Sie die Explosionsüberdrucksimulation für die M120-Waffentrainingsszene aus, indem Sie unten auf die Schaltfläche "Szenario ausführen " klicken. Der Fortschritt der Simulation wird über den Fortschrittsbalken am unteren Rand angezeigt.

7. Visualisierung der Ergebnisse

- Navigieren Sie zur Registerkarte Modellansicht, um die Simulation der Explosionsüberdruckexposition zu untersuchen.

- Klicken Sie auf die Schaltfläche Aktuell , um die abgeschlossene Simulation in das Visualisierungsfenster zu laden.

- Nachdem die Simulation geladen ist, visualisieren Sie die Simulation mit der Schaltfläche Abspielen am unteren Bildschirmrand.

- Der Benutzer kann zwischen den verschiedenen Optionen in der Navigationsleiste wählen, um die Simulation in unterschiedlichen Geschwindigkeiten abzuspielen und zu pausieren. Der Screenshot der Wiedergabesteuerung unten zeigt weitere Optionen. Der Benutzer kann das interaktive Fenster mit der Maus steuern. Klicken und ziehen Sie mit der rechten Maustaste, um den Modus zu drehen, mit der linken Taste zum Verschieben des Modells und mit der mittleren Taste zum Ein- und Ausscrollen.

- Nachdem Sie die Simulation überprüft haben, navigieren Sie zur Registerkarte "Blast-Load-Metriken ", indem Sie darauf klicken.

- Klicken Sie auf die Schaltfläche Aktuell , um die Überdruckdiagramme an den virtuellen Sensorstandorten zu laden.

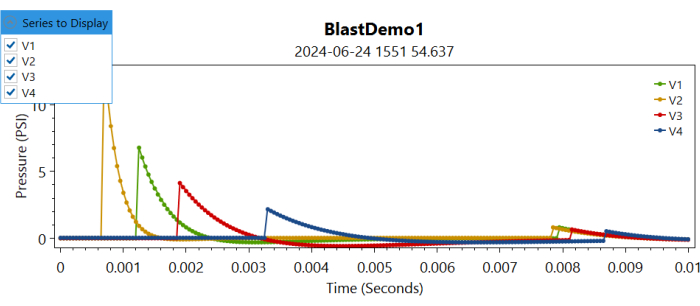

HINWEIS: Dadurch werden die Überdruckinformationen an den verschiedenen Sensorstandorten in verschiedenen Diagrammen geladen. - Navigieren Sie zur Dropdown-Liste Anzuzeigende Reihe, und aktivieren Sie das Kontrollkästchen für den entsprechenden Sensor , um den an diesem virtuellen Sensor aufgezeichneten Überdruck darzustellen (siehe Abbildung 4).

Abbildung 4: Diagramm der Kontrollen für Überdrücke an verschiedenen virtuellen Sensoren im Zeitverlauf. Der Benutzer kann die anzuzeigende Serie auswählen, indem er die verschiedenen Sensoren aktiviert oder deaktiviert. Bitte klicken Sie hier, um eine größere Version dieser Abbildung anzuzeigen.

Ergebnisse

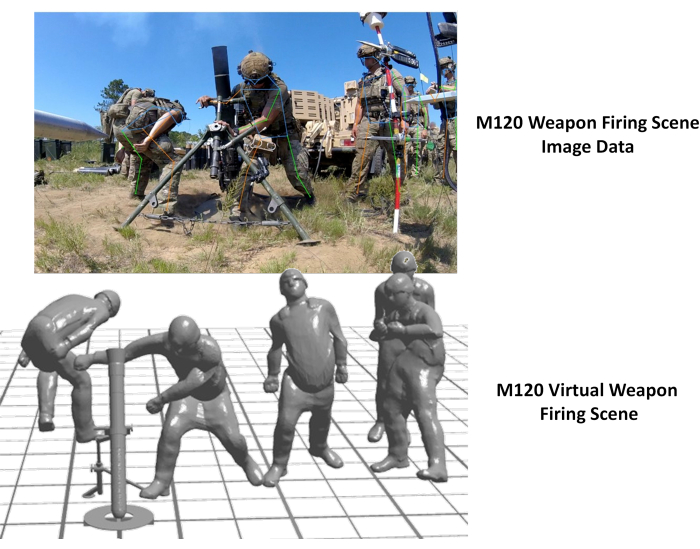

Automatisierte Rekonstruktion von virtuellen Soldaten und Explosionsszenen

Die automatisierte Generierung von Modellen für virtuelle Militärangehörige und Waffentrainingsszenen wurde durch die Automatisierungsfunktionen des BOP-Tools erreicht. Abbildung 5 zeigt die aus den Bilddaten generierte virtuelle Trainingsszene. Wie hier zu sehen ist, war die resultierende Szene eine gute Darstellung der Bilddaten. Das Bild, das zur Demonstration in Abbildung 5 verwendet wird, stammt von Wikimedia Commons.

Abbildung 5: Virtuelle Waffentrainingsszene aus den Bilddaten. Das linke Bild zeigt die Bilddaten, die dem Abschuss einer AT4-Waffe entsprechen, und die rechte Seite zeigt die virtuelle, automatisch generierte Waffentrainingsszene. Diese Zahl stammt von Wikimedia Commons. Bitte klicken Sie hier, um eine größere Version dieser Abbildung anzuzeigen.

Zusätzlich wurde der Ansatz angewendet, um die Schussszene der M120-Waffe zu rekonstruieren. Das Bild wurde von WRAIR im Rahmen einer Druckdatenerfassung für die Mörserwaffe M120 gesammelt. Abbildung 6 unten zeigt die rekonstruierte Szene mit dem Abschuss einer virtuellen Waffe neben dem Originalbild. Eine Diskrepanz wurde in der Position des Hilfsschützen in der virtuellen Rekonstruktion festgestellt. Dies kann korrigiert werden, indem die Position des Hilfsschützen mit den Benutzeroptionen der BOP-GUI angepasst wird. Darüber hinaus schien die Beckenhaltung des Instruktors ungenau zu sein, wahrscheinlich aufgrund einer Obstruktion durch die Pfähle auf den Bildern. Die Integration dieses Ansatzes mit anderen Tiefenbildgebungsmodalitäten wäre von Vorteil, um diese Diskrepanzen zu beheben.

Abbildung 6: Virtuelle Waffentrainingsszene aus den Bilddaten. Das linke Bild zeigt die Bilddaten, die dem Abschuss einer M120-Waffe entsprechen, und die rechte Seite zeigt die virtuelle, automatisch generierte Waffentrainingsszene. Bitte klicken Sie hier, um eine größere Version dieser Abbildung anzuzeigen.

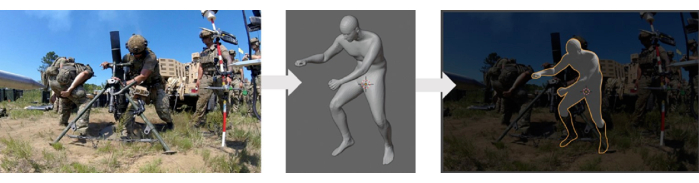

Validierung des Ansatzes der automatisierten Szenengenerierung

Der in dieser Studie verwendete Modellgenerator für den menschlichen Körper wurde mit der ANSUR II-Datenbank14 für menschliche Körperscans validiert, die anthropometrische Messungen aus medizinischen Bildgebungsdaten enthielt. Eine automatisierte Rekonstruktionsmethode, die diesen Modellgenerator des menschlichen Körpers verwendete, wurde mit den vorliegenden Daten einer qualitativen Validierung unterzogen. Bei diesem Validierungsprozess wurden die rekonstruierten Modelle mit experimentellen Daten (Bildern) verglichen, indem diese überlagert wurden. Abbildung 7 zeigt einen Vergleich zwischen den 3D-Avatarmodellen und den experimentellen Daten. Eine gründlichere Validierung dieser Methode ist jedoch erforderlich, was zusätzliche experimentelle Daten aus der Szene erfordern würde, einschließlich präziser Positionen, Haltungen und Orientierungen der verschiedenen Soldaten, die an einer Übungsszene beteiligt sind.

Abbildung 7: Qualitativer Vergleich des generierten virtuellen menschlichen Körpermodells mit dem Bild. Der linke Bereich zeigt das Originalbild, der mittlere Bereich das generierte virtuelle Körpermodell und der rechte Bereich das virtuelle Modell, das sich mit dem Originalbild überlappt. Bitte klicken Sie hier, um eine größere Version dieser Abbildung anzuzeigen.

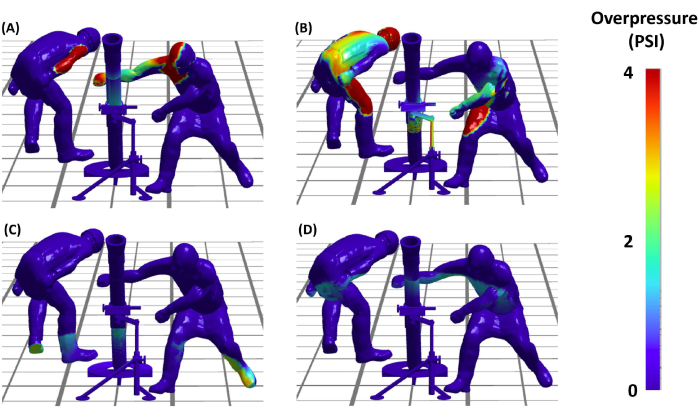

Repräsentative Strahlüberdrucksimulationen

Nach dem Einrichten der Explosionsszene konnten die Autoren mit der kritischen Phase der Durchführung von Explosionsüberdrucksimulationen (BOP) fortfahren. Dies wird es uns ermöglichen, die Verteilung der Explosionslasten auf verschiedene Militärangehörige zu verstehen, die an einer Waffenschussszene beteiligt sind. Abbildung 8 zeigt die Ergebnisse dieser BOP-Simulationen während des AT4-Waffenfeuerereignisses. Die Simulationen bieten eine detaillierte Visualisierung der Überdruckbelastungen des virtuellen Soldaten in der Szene zu verschiedenen Zeitpunkten im Zeitverlauf. Zusammenfassend lässt sich sagen, dass die Ergebnisse nicht nur die Machbarkeit, sondern auch die Wirksamkeit des Protokolls bei der Erstellung genauer und analytisch nützlicher Rekonstruktionen von Waffentrainingsszenarien belegen und damit den Weg für weiterführende Studien zur Sicherheit und Effizienz der militärischen Ausbildung ebnen.

Abbildung 8: Explosionsüberdruckbelastung des Schützen. (A, B, C und D) Die vier Felder zeigen den vom Modell vorhergesagten Explosionsüberdruck auf die virtuellen Soldaten, die zu verschiedenen Zeitpunkten am M120-Mörserabschuss beteiligt waren. Die Paneele (C) und (D) zeigen die Überdruckausbreitung aufgrund der Bodenreflexion. Bitte klicken Sie hier, um eine größere Version dieser Abbildung anzuzeigen.

Diskussion

Das in diesem Beitrag vorgestellte rechnerische Framework beschleunigt die Generierung von Explosionswaffen-Trainingsszenen im Vergleich zu bisher verwendeten manuellen Methoden mittels visueller Begutachtung erheblich. Dieser Ansatz demonstriert die Fähigkeit des Frameworks, verschiedene militärische Haltungen schnell zu erfassen und zu rekonstruieren.

Vorteile des aktuellen Ansatzes

Die Erstellung virtueller menschlicher Körpermodelle in bestimmten Haltungen und Positionen ist eine herausfordernde Aufgabe, für die nur begrenzte Werkzeuge zur Verfügung stehen. Die konventionelle Methode, die im Legacy-Ansatz speziell für das BOP-Tool verwendet wurde, verwendete CoBi-DYN 14,15,16,17. Bei dieser Methode wurden virtuelle menschliche Körpermodelle mit Kleidung, Helmen, Schutzpanzern und Stiefeln manuell erstellt. Die Modelle wurden durch approximative visuelle Annäherung generiert, ohne einen systematischen Ansatz. Im alten BOP-Tool wurde CoBi-DYN verwendet, um eine Datenbank mit menschlichen Körpermodellen zu erstellen, auf die während des Schritts "Szenariokonfiguration" zugegriffen werden konnte. Die Benutzer wählten manuell eine ungefähre Haltungskonfiguration aus und positionierten sie ungefähr für ein bestimmtes Waffensystem, um das BOP-Szenario auszuführen. Obwohl die Rekonstruktion der Explosionsszene aus der vorhandenen Datenbank der Soldaten (auf die über die Dropdown-Liste im BOP-Tool zugegriffen werden kann) relativ schnell war, war die anfängliche Erstellung der Modelldatenbank für virtuelle Soldaten zeitaufwändig und dauerte aufgrund des manuellen und ungefähren Charakters des Prozesses etwa 16-24 Stunden pro Szene. Im Gegensatz dazu nutzt der neue Ansatz etablierte Tools zur Posenschätzung für eine automatisierte und schnellere Erstellung virtueller menschlicher Körpermodelle. Diese Tools verwenden automatisch Video- und Bilddaten, um Explosionsszenen mit virtuellen Avataren von Militärangehörigen schnell zu rekonstruieren. Dadurch wird der Zeitaufwand für die Erstellung der Datenbank des menschlichen Körpers erheblich reduziert. Der neuartige Ansatz besteht darin, mit einem einzigen Knopfdruck die gesamte virtuelle Szene aus Bilddaten zu generieren oder zu rekonstruieren, ohne dass zusätzliche Software erforderlich ist. Der gesamte Prozess dauert nun ca. 5-6 s pro Szene (nach dem Lesen der Bilddaten, wie im Video gezeigt), was eine erhebliche Effizienzsteigerung gegenüber der alten Methode zeigt. Diese Methode soll den ursprünglichen Ansatz nicht ersetzen, sondern ihn vielmehr ergänzen, indem sie die Generierung virtueller Modelle für Dienstmitglieder beschleunigt (die in Zukunft der Modelldatenbank der Dienstgliederschaft hinzugefügt werden können). Es vereinfacht das Hinzufügen neuer Konfigurationen mit unterschiedlicher Komplexität und erleichtert die Integration neuer Waffensysteme in der Zukunft, wodurch die Erweiterbarkeit des BOP-Tools verbessert wird. Im Vergleich zum herkömmlichen Ansatz ist es offensichtlich, dass die vorgestellte Methode eine schlankere und automatisiertere Lösung bietet, die den manuellen Aufwand und die Zeit reduziert und gleichzeitig die Genauigkeit und den systematischen Charakter der Erstellung virtueller menschlicher Körpermodelle verbessert. Dies unterstreicht die Stärke und Innovation der beschriebenen Methode in der Praxis.

Validierung der automatisierten Szenengenerierung

Eine qualitative Validierung des Ansatzes erfolgte durch Überlagerung der rekonstruierten Szenarien mit den Bilddaten. Eine quantitative Validierung war jedoch aufgrund des Mangels an verfügbaren Daten zu Positionierung und Haltung für diese Bilder nicht möglich. Die Autoren erkennen die Bedeutung einer gründlicheren Validierung an und planen, dies in zukünftigen Arbeiten zu berücksichtigen. Um dies zu erreichen, stellen sich die Autoren eine umfassende Datenerhebung vor, um genaue Informationen über Positionierung und Haltung zu erhalten. Dies wird es uns ermöglichen, eine detaillierte quantitative Validierung durchzuführen und letztendlich die Robustheit und Genauigkeit des Ansatzes zu verbessern.

Validierung der Explosionssimulationen

Die Waffensprengkerne wurden unter Verwendung von Bleistiftsondendaten entwickelt und validiert, die während des Waffenabschusses gesammelt wurden. Weitere Details zum Weapon Blast-Kernel und den relevanten Exposures werden in einer kommenden Veröffentlichung veröffentlicht. Einige Informationen hierzu finden sich auch in den früheren Publikationen11,12. Diese kontinuierlichen Bemühungen werden dazu beitragen, die Präzision und Effektivität der Strahlüberdrucksimulationen zu verbessern und die Gültigkeit des Tools zu stärken.

Der hier vorgestellte Ansatz kann auch verwendet werden, um virtuelle Avatare von Militärangehörigen zu generieren, die anschließend zur Auswahl mit dem BOP-Tool in die Datenbank aufgenommen werden können. Obwohl der aktuelle Prozess die Modelle nicht automatisch in der Datenbank speichert, planen die Autoren, dieses Feature in zukünftige Versionen des BOP-Tools aufzunehmen. Darüber hinaus verfügen die Autoren über hauseigene Werkzeuge, die es ermöglichen, die Haltung manuell zu ändern, sobald die automatisierte Haltung und das 3D-Modell aus den Bilddaten generiert wurden. Derzeit existiert diese Funktion eigenständig und ist nicht in das BOP-Tool integriert, da eine Weiterentwicklung auf der Benutzeroberfläche erforderlich ist. Nichtsdestotrotz ist dies noch in Arbeit, und die Autoren beabsichtigen, es in zukünftige Versionen des BOP-Tools zu integrieren.

Die Explosionslastdaten könnten auch in Form einer ASCII-Textdatei exportiert werden, und es könnten weitere Nachbearbeitungsschritte angewendet werden, um die Explosionsdosismuster für verschiedene Waffensysteme genauer zu untersuchen. Derzeit wird an der Entwicklung fortschrittlicher Nachbearbeitungswerkzeuge für Ausgangsmetriken wie Impuls, Intensität und andere gearbeitet, die den Benutzern helfen könnten, komplexere wiederholte Explosionsbelastungen in diesen Szenarien zu verstehen und zu untersuchen. Darüber hinaus sind die Werkzeuge auf Recheneffizienz ausgelegt und ermöglichen schnelle Simulationsgeschwindigkeiten. Daher ermöglichen uns diese Werkzeuge, inverse Optimierungsstudien durchzuführen, um die optimale Haltung und Position während eines Waffenabschussszenarios zu bestimmen. Solche Verbesserungen verbessern die Anwendbarkeit des Tools zur Optimierung der Trainingsprotokolle in verschiedenen Waffenübungsbereichen. Die Schätzungen der Blastdosis könnten auch verwendet werden, um verfeinerte, hochauflösende makroskalige Rechenmodelle für verschiedene gefährdete anatomische Regionen wie das Gehirn, die Lunge und andere zu entwickeln 18,19,20 und mikroskalige Verletzungsmodelle20,21. Hier dienen der Helm und die Panzerung, die in die Modelle integriert sind, ausschließlich der visuellen Darstellung und haben keinen Einfluss auf die Explosionsdosis in diesen Simulationen. Dies liegt daran, dass die Modelle als starre Strukturen betrachtet werden, was bedeutet, dass ihre Einbeziehung die Ergebnisse der Explosionsüberdrucksimulationen nicht verändert oder beeinflusst.

In diesem Artikel wird ein bestehendes Open-Source-Tool zur Schätzung der Pose zur Schätzung der menschlichen Pose in Waffentrainingsszenarien genutzt. Bitte beachten Sie, dass das hier entwickelte und diskutierte Framework unabhängig von Posing-Tools ist, d.h. die Autoren können ein vorhandenes Tool durch ein neues Tool ersetzen, wenn weitere Fortschritte gemacht werden. Insgesamt zeigten die Tests, dass moderne Softwaretools zwar extrem leistungsfähig sind, die bildbasierte Posenerkennung jedoch eine herausfordernde Aufgabe darstellt. Es gibt jedoch mehrere Empfehlungen, die verwendet werden können, um die Leistung der Posenerkennung zu verbessern. Diese Werkzeuge funktionieren am besten, wenn sich die betreffende Person in freier Sicht auf die Kamera befindet. Während dies bei Waffentrainingsübungen nicht immer möglich ist, kann die Berücksichtigung bei der Platzierung der Kamera die Ergebnisse bei der Posenerkennung verbessern. Darüber hinaus tragen Militärangehörige, die Übungen durchführen, häufig getarnte Uniformen, die sich in ihre Umgebung einfügen. Dies macht es schwieriger, sie sowohl vom menschlichen Auge als auch von Algorithmen des maschinellen Lernens (ML) zu erkennen. Es gibt Methoden, um die Fähigkeit von ML-Algorithmen zu verbessern, Menschen mit Tarnung23 zu erkennen, aber diese sind nicht trivial zu implementieren. Wenn möglich, kann das Sammeln von Bildern von Waffentrainings an einem Ort mit kontrastreichem Hintergrund die Posenerkennung verbessern.

Darüber hinaus besteht der herkömmliche Ansatz zur Schätzung von 3D-Größen aus Bildern darin, Photogrammetrietechniken mit mehreren Kamerawinkeln zu verwenden. Das Aufnehmen von Bildern/Videos aus mehreren Blickwinkeln kann ebenfalls verwendet werden, um die Posenschätzung zu verbessern. Die Fusion von Posenschätzungen von mehreren Kameras ist relativ einfach24. Eine weitere Photogrammetrietechnik, die die Ergebnisse verbessern könnte, besteht darin, ein Schachbrett oder ein anderes Objekt mit bekannten Abmessungen als gemeinsamen Referenzpunkt für jede Kamera zu verwenden. Eine Herausforderung bei der Verwendung mehrerer Kameras besteht darin, sie zeitlich zu synchronisieren. Individuell trainierte Modelle des maschinellen Lernens könnten entwickelt werden, um Merkmale wie einen Helm anstelle eines Gesichts zu erkennen oder um Personen zu erkennen, die militärspezifische Kleidung und Ausrüstung (z. B. Stiefel, Westen, Schutzwesten) tragen. Bestehende Tools zur Posenschätzung können mit benutzerdefinierten trainierten ML-Modellen erweitert werden. Dies ist zwar zeitaufwändig und mühsam, kann aber die Leistung des Posenschätzungsmodells erheblich verbessern.

Zusammenfassend lässt sich sagen, dass dieses Papier die verschiedenen Komponenten des erweiterten Blasüberdruck-Gerüsts effektiv umreißt. Hier erkennen die Autoren auch das Potenzial zur Verbesserung der Anwendbarkeit und Wirksamkeit durch eine nahtlosere Integration und vollständige Automatisierung der Pipeline. Elemente wie die Generierung eines skalierten 3D-Karosserienetzes mit dem AMG-Tool werden derzeit automatisiert, um manuelle Benutzereingaben zu reduzieren. Derzeit wird daran gearbeitet, diese Funktionen in das Modul SCENE des BOP-Tools zu integrieren. Im Zuge der Weiterentwicklung dieser Technologie wird sie allen Interessengruppen und Laboren des Verteidigungsministeriums zugänglich gemacht. Darüber hinaus umfasst die laufende Arbeit die Charakterisierung und Validierung von Waffenkernen für weitere Waffensysteme. Diese kontinuierlichen Bemühungen um die Verfeinerung und Validierung der Methoden stellen sicher, dass die von den Autoren entwickelten Werkzeuge an der Spitze des technologischen Fortschritts bleiben und erheblich zur Sicherheit und Wirksamkeit militärischer Trainingsübungen beitragen. Zukünftige Veröffentlichungen werden weitere Einzelheiten zu diesen Entwicklungen enthalten und einen Beitrag zum breiteren Feld der militärischen Ausbildung und Sicherheit leisten.

Offenlegungen

Die Autoren haben nichts offenzulegen.

Danksagungen

Die Forschung wird vom DoD Blast Injury Research Coordinating Office unter dem MTEC Project Call MTEC-22-02-MPAI-082 finanziert. Die Autoren würdigen auch den Beitrag von Hamid Gharahi für die Kerne von Waffenexplosionen und Zhijian J Chen für die Entwicklung der Modellierungsfähigkeiten für Überdrucksimulationen von Waffenexplosionen. Die Ansichten, Meinungen und/oder Ergebnisse, die in dieser Präsentation geäußert werden, sind die der Autoren und spiegeln nicht die offizielle Politik oder Position des Department of the Army oder des Department of Defense wider.

Materialien

| Name | Company | Catalog Number | Comments |

| Anthropometric Model Generator (AMG) | CFD Research | N/A | For generting 3D human body models with different anthropometric characteristics. The tool is DoD Open Source. |

| BOP Tool | CFD Research | N/A | For setting up blast scenes and overpressure simulations. The tool is DoD open source. |

| BOP Tool SCENE Module | CFD Research | N/A | For setting up blast scenes and overpressure simulations. The tool is DoD open source. |

| Mediapipe | Version 0.9 | Open-source pose estimation library. | |

| MMPose | OpenMMLab | Version 1.2 | Open-source pose estimation library. |

| OpenSim | Stanford University | Version 4.4 | Open-source musculoskeletal modeling and simulation platform. |

| Python 3 | Anaconda Inc | Version 3.8 | The open source Individual Edition containing Python 3.8 and preinstalled packages to perform video processing and connecting the pose estimation tools. |

Referenzen

- LaValle, C. R., et al. Neurocognitive performance deficits related to immediate and acute blast overpressure exposure. Front Neurol. 10, (2019).

- Kamimori, G. H., et al. Longitudinal investigation of neurotrauma serum biomarkers, behavioral characterization, and brain imaging in soldiers following repeated low-level blast exposure (New Zealand Breacher Study). Military Med. 183 (suppl_1), 28-33 (2018).

- Wang, Z., et al. Acute and chronic molecular signatures and associated symptoms of blast exposure in military breachers. J Neurotrauma. 37 (10), 1221-1232 (2020).

- Gill, J., et al. Moderate blast exposure results in increased IL-6 and TNFα in peripheral blood. Brain Behavior Immunity. 65, 90-94 (2017).

- Carr, W., et al. Ubiquitin carboxy-terminal hydrolase-L1 as a serum neurotrauma biomarker for exposure to occupational low-Level blast. Front Neurol. 6, (2015).

- Boutté, A. M., et al. Brain-related proteins as serum biomarkers of acute, subconcussive blast overpressure exposure: A cohort study of military personnel. PLoS One. 14 (8), e0221036(2019).

- Skotak, M., et al. Occupational blast wave exposure during multiday 0.50 caliber rifle course. Front Neurol. 10, (2019).

- Kamimori, G. H., Reilly, L. A., LaValle, C. R., Silva, U. B. O. D. Occupational overpressure exposure of breachers and military personnel. Shock Waves. 27 (6), 837-847 (2017).

- Misistia, A., et al. Sensor orientation and other factors which increase the blast overpressure reporting errors. PLoS One. 15 (10), e0240262(2020).

- National Defense Authorization Act for Fiscal Year 2020. Wikipedia. , https://en.wikipedia.org/w/index.php?title=National_Defense_Authorization_Act_for_Fiscal_Year_2020&oldid=1183832580 (2023).

- Przekwas, A., et al. Fast-running tools for personalized monitoring of blast exposure in military training and operations. Military Med. 186 (Supplement_1), 529-536 (2021).

- Spencer, R. W., et al. Fiscal year 2018 National Defense Authorization Act, Section 734, Weapon systems line of inquiry: Overview and blast overpressure tool-A module for human body blast wave exposure for safer weapons training. Military Med. 188 (Supplement_6), 536-544 (2023).

- Delp, S. L., et al. OpenSim: open-source software to create and analyze dynamic simulations of movement. IEEE Trans Biomed Eng. 54 (11), 1940-1950 (2007).

- Zhou, X., Sun, K., Roos, P. E., Li, P., Corner, B. Anthropometry model generation based on ANSUR II database. Int J Digital Human. 1 (4), 321(2016).

- Zhou, X., Przekwas, A. A fast and robust whole-body control algorithm for running. Int J Human Factors Modell Simulat. 2 (1-2), 127-148 (2011).

- Zhou, X., Whitley, P., Przekwas, A. A musculoskeletal fatigue model for prediction of aviator neck manoeuvring loadings. Int J Human Factors Modell Simulat. 4 (3-4), 191-219 (2014).

- Roos, P. E., Vasavada, A., Zheng, L., Zhou, X. Neck musculoskeletal model generation through anthropometric scaling. PLoS One. 15 (1), e0219954(2020).

- Garimella, H. T., Kraft, R. H. Modeling the mechanics of axonal fiber tracts using the embedded finite element method. Int J Numer Method Biomed Eng. 33 (5), (2017).

- Garimella, H. T., Kraft, R. H., Przekwas, A. J. Do blast induced skull flexures result in axonal deformation. PLoS One. 13 (3), e0190881(2018).

- Przekwas, A., et al. Biomechanics of blast TBI with time-resolved consecutive primary, secondary, and tertiary loads. Military Med. 184 (Suppl 1), 195-205 (2019).

- Gharahi, H., Garimella, H. T., Chen, Z. J., Gupta, R. K., Przekwas, A. Mathematical model of mechanobiology of acute and repeated synaptic injury and systemic biomarker kinetics. Front Cell Neurosci. 17, 1007062(2023).

- Przekwas, A., Somayaji, M. R., Gupta, R. K. Synaptic mechanisms of blast-induced brain injury. Front Neurol. 7, 2(2016).

- Liu, Y., Wang, C., Zhou, Y. Camouflaged people detection based on a semi-supervised search identification network. Def Technol. 21, 176-183 (2023).

- Batpurev, T. Real time 3D body pose estimation using MediaPipe. , Available from: https://temugeb.github.io/python/computer_vision/2021/09/14/bodypose3d.html (2021).

Nachdrucke und Genehmigungen

Genehmigung beantragen, um den Text oder die Abbildungen dieses JoVE-Artikels zu verwenden

Genehmigung beantragenWeitere Artikel entdecken

This article has been published

Video Coming Soon

Copyright © 2025 MyJoVE Corporation. Alle Rechte vorbehalten