Method Article

Generazione di avatar di combattenti da immagini di scene di addestramento con armi per simulazioni di esposizione all'esplosione

In questo articolo

Riepilogo

È stato sviluppato un framework computazionale per ricostruire automaticamente scene virtuali comprendenti avatar 3D di soldati utilizzando dati di immagini e/o video. Le scene virtuali aiutano a stimare l'esposizione alla sovrapressione da esplosione durante l'addestramento con le armi. Lo strumento facilita una rappresentazione realistica della postura umana nelle simulazioni di esposizione alle esplosioni in vari scenari.

Abstract

Il personale militare coinvolto nell'addestramento alle armi è sottoposto a ripetute esplosioni a basso livello. Il metodo prevalente per stimare i carichi di esplosione coinvolge i misuratori di esplosione indossabili. Tuttavia, utilizzando i dati dei sensori indossabili, i carichi di esplosione alla testa o ad altri organi non possono essere stimati con precisione senza la conoscenza della postura del corpo del membro del servizio. È stata sviluppata una piattaforma sperimentale-computazionale complementare aumentata con immagini/video per condurre un addestramento con armi più sicure. Questo studio descrive il protocollo per la generazione automatizzata di scene di addestramento con armi da dati video per simulazioni di esposizione all'esplosione. La scena dell'esplosione estratta dai dati video nell'istante dello sparo dell'arma coinvolge gli avatar del corpo del membro del servizio, le armi, il terreno e altre strutture. Il protocollo computazionale viene utilizzato per ricostruire le posizioni e le posture dei membri del servizio utilizzando questi dati. I dati di immagini o video estratti dalle sagome del corpo dei membri del servizio vengono utilizzati per generare uno scheletro anatomico e i dati antropometrici chiave. Questi dati vengono utilizzati per generare gli avatar 3D della superficie corporea segmentati in singole parti del corpo e trasformati geometricamente per corrispondere alle posture dei membri del servizio estratti. La scena finale di addestramento virtuale con le armi viene utilizzata per simulazioni computazionali 3D del carico dell'onda d'urto dell'arma sui membri del servizio. Il generatore di scene di addestramento con le armi è stato utilizzato per costruire avatar anatomici 3D dei corpi dei singoli membri del servizio da immagini o video in vari orientamenti e posture. Vengono presentati i risultati della generazione di una scena di addestramento dai dati delle immagini del sistema d'arma d'assalto montato a spalla e del sistema d'arma da mortaio. Lo strumento Blast Overpressure (BOP) utilizza la scena di addestramento virtuale dell'arma per simulazioni 3D del carico dell'onda d'urto sui corpi avatar dei membri del servizio. Questo articolo presenta simulazioni computazionali 3D della propagazione dell'onda d'urto dallo sparo delle armi e dei corrispondenti carichi di esplosione sui membri del servizio in addestramento.

Introduzione

Durante l'addestramento militare, i membri del servizio e gli istruttori sono spesso esposti a esplosioni di basso livello con armi pesanti e leggere. Studi recenti hanno dimostrato che l'esposizione alle esplosioni potrebbe portare a una diminuzione delle prestazioni neurocognitive 1,2 e ad alterazioni dei biomarcatori ematici 3,4,5,6. L'esposizione ripetuta a basse esplosioni comporta difficoltà nel mantenere prestazioni ottimali e ridurre al minimo il rischio di lesioni 7,8. L'approccio convenzionale che utilizza sensori di pressione indossabili presenta degli svantaggi, in particolare quando si tratta di determinare con precisione le pressioni di granigliatura sulla testa9. Gli effetti negativi noti dell'esposizione ripetuta a basse esplosioni sulle prestazioni umane (ad esempio, durante l'addestramento e nei ruoli operativi) aggravano questo problema. I mandati del Congresso (Sezioni 734 e 717) hanno stabilito l'obbligo di monitorare l'esposizione alle esplosioni durante l'addestramento e il combattimento e la sua inclusionenella cartella clinica del membro del servizio.

I sensori indossabili possono essere utilizzati per monitorare la sovrapressione dell'esplosione durante queste operazioni di addestramento al combattimento. Tuttavia, questi sensori sono influenzati da variabili come la postura del corpo, l'orientamento e la distanza dalla sorgente di esplosione a causa della natura complessa delle interazioni delle onde d'urto con il corpo umano9. I seguenti fattori influenzano la distribuzione della pressione e le misurazioni del sensore9:

Distanza dalla sorgente di esplosione: l'intensità della pressione varia con la distanza man mano che l'onda d'urto si disperde e si attenua. I sensori più vicini alla granigliatura registrano pressioni più elevate, compromettendo l'accuratezza e la coerenza dei dati.

Postura del corpo: diverse posture espongono varie superfici del corpo all'esplosione, alterando la distribuzione della pressione. Ad esempio, stare in piedi rispetto a accovacciarsi comporta letture di pressione diverse 9,11.

Orientamento: l'angolo del corpo rispetto alla sorgente di esplosione influisce sul modo in cui l'onda di pressione interagisce con il corpo, portando a discrepanze nelle letture9. Le simulazioni numeriche basate sulla fisica forniscono valutazioni più accurate tenendo sistematicamente conto di queste variabili, offrendo un'analisi controllata e completa rispetto ai sensori indossabili, che sono intrinsecamente influenzati da questi fattori.

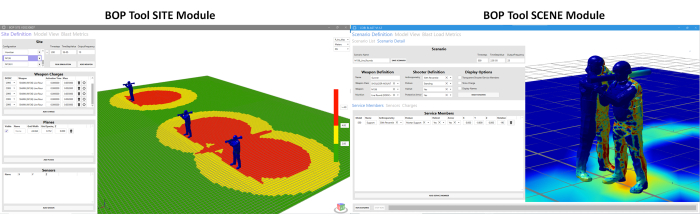

In risposta a queste sfide, c'è stato uno sforzo concertato per sviluppare strumenti più sofisticati. In questa direzione, viene sviluppato l'utensile di sovrapressione di granigliatura (BOP). Questo strumento è stato sviluppato per stimare l'esposizione alla sovrapressione in presenza di diverse posture e posizioni dei membri del servizio intorno ai sistemi d'arma. Ci sono due diversi moduli sotto lo strumento BOP11. Si tratta di (a) il modulo BOP tool SCENE e (b) il modulo BOP tool SITE. Questi moduli vengono utilizzati per stimare la sovrapressione dell'esplosione durante il fuoco dell'arma12. Il modulo BOP SCENE è sviluppato per stimare le sovrapressioni di esplosione sperimentate dai singoli membri del servizio o dagli istruttori che partecipano a uno scenario di addestramento, mentre il modulo BOP SITE ricostruisce una vista a volo d'uccello del corso di addestramento, raffigurando le zone di sovrapressione di esplosione generate da più stazioni di sparo. La Figura 1 mostra un'istantanea di entrambi i moduli. Attualmente, i moduli BOP Tool comprendono le caratteristiche di sovrapressione dell'esplosione dell'arma (termine equivalente della sorgente di esplosione) per quattro sistemi d'arma Tier-1 definiti dal DoD, tra cui il fucile da cecchino per applicazioni speciali (SASR) calibro .50 M107, l'arma d'assalto a spalla M136, il mortaio a fuoco indiretto M120 e le cariche da sfondamento. Il termine nucleo di esplosione dell'arma si riferisce a un termine equivalente della sorgente di esplosione sviluppato per replicare lo stesso campo di esplosione che circonda un sistema d'arma come quello dell'arma reale. Una descrizione più dettagliata del framework computazionale utilizzato per lo sviluppo dello strumento BOP è disponibile per ulteriori riferimenti11. Le simulazioni di sovrapressione vengono eseguite utilizzando il motore del solutore CoBi-Blast. Si tratta di uno strumento multiscala e multifisico per la simulazione delle sovrapressioni di esplosione. Le capacità di modellazione dell'esplosione del motore sono convalidate rispetto ai dati sperimentali della letteratura12. Questo strumento BOP è attualmente in fase di integrazione nel Range Managers Toolkit (RMTK) per l'uso su diversi poligoni di addestramento con le armi. RMTK è una suite multiservizio di strumenti desktop progettata per soddisfare le esigenze dei gestori di poligono in tutto l'esercito, il corpo dei marines, l'aeronautica e la marina automatizzando le operazioni di poligono, la sicurezza e i processi di modernizzazione.

Figura 1: Interfaccia utente grafica (GUI) per il modulo BOP tool SCENE e il modulo BOP tool SITE. Il modulo BOP SCENE è progettato per stimare le sovrapressioni di esplosione sui modelli del corpo dei membri del servizio e dell'istruttore, mentre il modulo BOP SITE ha lo scopo di fornire una stima dei contorni di sovrapressione su un piano che rappresenta il campo di addestramento. L'utente ha la possibilità di scegliere l'altezza alla quale si trova l'aereo rispetto al suolo. Clicca qui per visualizzare una versione più grande di questa figura.

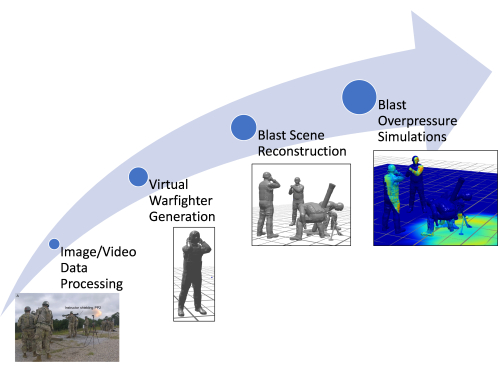

Una limitazione dell'attuale modulo SCENE dello strumento BOP è l'uso di dati stimati manualmente per la creazione di modelli corporei virtuali dei membri del servizio, tra cui l'antropometria, la postura e la posizione. La generazione manuale dei membri del servizio virtuale nella postura appropriata è laboriosa e richiede molto tempo11,12. Lo strumento BOP legacy (approccio legacy) utilizza un database di posture preconfigurate per costruire la scena di addestramento con le armi in base ai dati dell'immagine (se disponibili). Inoltre, poiché le posture vengono approssimate manualmente attraverso la valutazione visiva, le posture corrette potrebbero non essere catturate per un contesto posturale complesso. Di conseguenza, questo approccio introduce imprecisioni nella stima dell'esposizione alla sovrapressione per i singoli membri del servizio (poiché un cambiamento di postura può modificare l'esposizione alla sovrapressione nelle regioni più vulnerabili). Il documento presenta i miglioramenti apportati al framework computazionale esistente per consentire la generazione rapida e automatica di modelli di membri del servizio utilizzando gli strumenti di stima della posa all'avanguardia esistenti. Questo articolo discute il miglioramento dello strumento BOP, sottolineando in particolare lo sviluppo di una nuova e rapida pipeline computazionale per la ricostruzione di scene di esplosione utilizzando dati video e immagini. Lo strumento migliorato può anche ricostruire modelli corporei dettagliati dei membri del servizio e degli istruttori al momento dello sparo con l'arma, utilizzando i dati video per creare avatar personalizzati rispetto all'approccio legacy. Questi avatar riflettono accuratamente la postura dei membri del servizio. Questo lavoro semplifica il processo di generazione delle scene di esplosione e facilita un'inclusione più rapida delle scene di esplosione per sistemi d'arma aggiuntivi, riducendo significativamente il tempo e lo sforzo necessari per la creazione di scene di addestramento alle armi. La Figura 2 mostra uno schema del framework computazionale avanzato discusso in questo articolo.

Figura 2: Schema che mostra il diagramma di flusso complessivo del processo nel framework computazionale. Le diverse fasi includono l'elaborazione dei dati di immagini/video, la generazione di combattenti virtuali, la ricostruzione della scena dell'esplosione e le simulazioni di sovrapressione dell'esplosione. Clicca qui per visualizzare una versione più grande di questa figura.

Il documento presenta l'approccio automatizzato implementato nello strumento BOP, che rappresenta un miglioramento significativo degli strumenti computazionali disponibili per stimare l'esposizione alla sovrapressione durante l'addestramento e le operazioni. Questo strumento si distingue per la sua rapida generazione di avatar personalizzati e scenari di addestramento, che consentono simulazioni immersive di sovrapressione dell'esplosione. Ciò segna un allontanamento significativo dalla tradizionale dipendenza da modelli di corpo umano mediati dalla popolazione, offrendo un approccio più preciso e individualizzato.

Strumenti computazionali utilizzati nel processo di automazione

L'automazione della generazione di modelli di membri del servizio virtuale è un processo in più fasi che sfrutta strumenti computazionali avanzati per trasformare i dati grezzi di immagini o video in rappresentazioni 3D dettagliate. L'intero processo è automatizzato, ma può essere adattato per consentire l'inserimento manuale di misure note, se necessario.

Strumenti di stima della posa 3D: Al centro della pipeline di automazione ci sono gli strumenti di stima della posa 3D. Questi strumenti analizzano i dati dell'immagine per identificare la posizione e l'orientamento di ciascuna articolazione nel corpo del membro del servizio, creando efficacemente uno scheletro digitale. La pipeline supporta attualmente Mediapipe e MMPose, che offrono API Python. Tuttavia, il sistema è stato progettato pensando alla flessibilità, consentendo l'incorporazione di altri strumenti, come le telecamere di profondità, a condizione che siano in grado di produrre i dati 3D necessari per le articolazioni e le ossa.

Generatore di modelli antropometrici (AMG): Una volta stimata la posa 3D, entra in gioco l'AMG. Questo strumento utilizza i dati di posa per creare un modello 3D della superficie della pelle che corrisponda alle dimensioni uniche del corpo del membro del servizio. Lo strumento AMG consente l'inserimento automatico o manuale di misurazioni antropometriche, che vengono poi collegate ai componenti principali all'interno dello strumento per trasformare di conseguenza la mesh 3D del corpo.

Modellazione scheletrica OpenSim: Il passo successivo riguarda la piattaforma open-source OpenSim13, in cui un modello scheletrico viene regolato per allinearsi con i dati di posa 3D. Gli strumenti di stima della posa non impongono lunghezze costanti delle ossa nello scheletro, il che può portare a un'asimmetria irrealistica nel corpo. L'uso di uno scheletro OpenSim anatomicamente corretto produce una struttura ossea più realistica. I marker vengono posizionati sullo scheletro di OpenSim in modo che corrispondano ai centri articolari identificati dallo strumento di stima della posa. Questo modello scheletrico viene quindi montato sulla mesh 3D della pelle utilizzando tecniche di animazione standard.

Cinematica inversa e scripting Python: Per finalizzare la posa del membro del servizio virtuale, viene utilizzato un algoritmo di cinematica inversa. Questo algoritmo regola il modello di scheletro di OpenSim in modo che corrisponda al meglio alla posa 3D stimata. L'intera pipeline di posa è completamente automatizzata e implementata in Python 3. Grazie all'integrazione di questi strumenti, il processo di generazione di modelli virtuali per i membri del servizio è stato notevolmente accelerato, riducendo il tempo necessario da giorni a secondi o minuti. Questo progresso rappresenta un passo avanti nella simulazione e nell'analisi di scenari di addestramento alle armi, fornendo rapide ricostruzioni di scenari specifici documentati tramite immagini o video.

Protocollo

Le immagini e i video utilizzati in questo studio non sono stati ottenuti direttamente dagli autori da soggetti umani. Un'immagine è stata tratta da risorse gratuite su Wikimedia Commons, che è disponibile con una licenza di pubblico dominio. L'altra immagine è stata fornita dai collaboratori del Walter Reed Army Institute of Research (WRAIR). I dati ottenuti da WRAIR non sono stati identificati e sono stati condivisi in conformità con le loro linee guida istituzionali. Per le immagini fornite da WRAIR, il protocollo ha seguito le linee guida del comitato etico per la ricerca umana di WRAIR, incluso l'ottenimento di tutte le approvazioni e i consensi necessari.

1. Accesso al modulo BOP Tool SCENE

- Aprire il BOP Tool SCENE Module dall'interfaccia dello strumento BOP facendo clic sul pulsante BOP Tool SCENE Module .

- Fare clic su Definizione scenario , quindi fare clic sulla scheda Dettagli scenario .

2. Lettura ed elaborazione dei dati dell'immagine

- Fare clic sul pulsante POSETOOL IMPORT nel modulo SCENE dello strumento BOP. Si apre una finestra pop-up che chiede all'utente di selezionare l'immagine o il video pertinente.

- Passare alla cartella e selezionare l'immagine/video pertinente utilizzando le operazioni del mouse.

- Fare clic su Apri nel pop-up della finestra una volta selezionata un'immagine.

NOTA: Questa operazione legge l'immagine o il file video, genera un'immagine se è selezionato un video, esegue l'algoritmo di stima della posa in background, genera i modelli dei membri del servizio virtuale coinvolti nella scena di addestramento con le armi e li carica nel modulo BOP Tool SCENE nelle rispettive posizioni.

3. Configurazione dell'arma e del tiratore

- Scegliere un nome per lo scenario utilizzando la casella di testo in Nome scenario. Si tratta di una scelta dell'utente. Per lo scenario descritto qui, gli sviluppatori hanno scelto il nome dello scenario BlastDemo1.

- Scegli un nome personalizzato nel campo Nome sotto la definizione dell'arma. Si tratta, ancora una volta, di una scelta dell'utente. Per lo scenario qui discusso, gli sviluppatori hanno scelto il nome dell'arma 120Mortar.

- Seleziona la classe di arma appropriata, ad esempio MORTAIO PESANTE, dall'elenco delle opzioni nel menu a discesa.

- Seleziona l'arma (M120 in questo caso) dall'elenco delle scelte nel menu a discesa. Dopo aver selezionato il sistema d'arma, il kernel dell'esplosione corrispondente verrà caricato automaticamente nell'interfaccia grafica nella sottoscheda Cariche.

NOTA: Il menu a tendina conterrà i diversi possibili sistemi d'arma specifici per la classe di armi scelta sopra. - Seleziona il proiettile per munizioni (round di addestramento a raggio completo) per il sistema d'arma scelto utilizzando le opzioni a discesa.

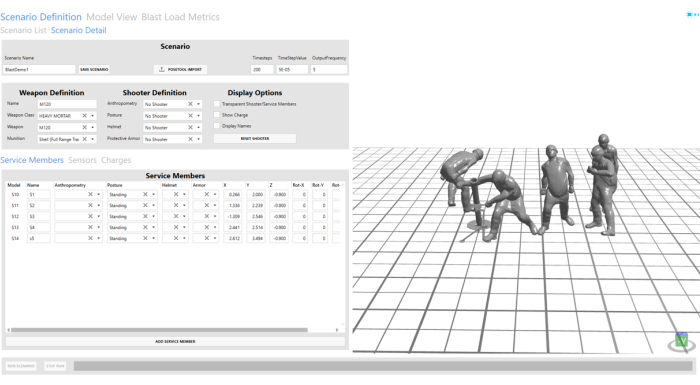

- Seleziona Nessun tiratore nei campi Antropometria, Postura, Elmetto e Armatura protettiva sotto Definizione tiratore dalle opzioni a discesa. Vedere la Figura 3 per il tiratore configurato e i membri del servizio.

NOTA: Poiché lo sparatutto sarà incluso nella scena importata tramite il passaggio 4, non è stato selezionato alcun sparatutto nella definizione dello sparatutto.

Figura 3: Scena dell'esplosione importata dai dati dell'immagine. La scena dell'esplosione è visibile nella finestra di visualizzazione sul lato destro dello strumento GUI. Clicca qui per visualizzare una versione più grande di questa figura.

4. Configurazione dei membri del servizio

- Fare clic sulla scheda Membri del servizio . Questa scheda controlla la posizione e l'orientamento dei membri del servizio importati dai dati dell'immagine; A tale scopo, utilizzare le opzioni X, Y, Z e di rotazione. Per l'avatar corrispondente all'assistente artigliere, gli autori hanno regolato la posizione Y da 2,456 a 2 per una posizione più ragionevole dell'assistente artigliere.

- Scegliere nomi personalizzati per tutti i modelli di membri del servizio virtuali importati nella GUI utilizzando il campo Nome nella scheda Membri del servizio. S1, S2, S3, S4 e S5 vengono scelti qui per tutti i modelli di membri del servizio importati automaticamente.

NOTA: per lo scenario descritto qui, sono stati denominati S1 e S2. Gli altri campi vengono compilati automaticamente. Gli utenti possono modificarli per perfezionare la posizione/posture stimate automaticamente. - Utilizzare il pulsante Elimina per rimuovere S2, S4 e S5. Nello scenario qui dimostrato, solo il tiratore e l'assistente mitragliere sono presenti al momento dello sparo.

NOTA: questa operazione è stata eseguita per dimostrare le opzioni utente personalizzate per eliminare o aggiungere modelli di membri del servizio in base alle esigenze a una scena esistente.

5. Configurazione dei sensori virtuali

- Vai alla scheda Sensori . Aggiungi un nuovo sensore virtuale facendo clic su Aggiungi sensore.

- Scegli un nome personalizzato nel campo Nome. Gli sviluppatori hanno scelto V1 per la dimostrazione in questo documento.

- Selezionare il tipo come Virtuale facendo clic sul menu a discesa sotto il campo Tipo di sensore.

- Scegliere la posizione del sensore (-0,5, 2, 0,545) modificando le caselle di testo nei campi X, Y e Z. Per lo scenario qui discusso, gli sviluppatori hanno creato quattro diversi sensori in quattro diverse posizioni a scopo dimostrativo. Gli sviluppatori hanno scelto V2, V3 e V4 come nomi dei sensori aggiuntivi.

- Ripetere i passaggi da 5.1 a 5.4 per creare sensori aggiuntivi a (-0.5, 1, 0.545), (-0.5, 0.5, 0.545) e (-0.5, 0, 0.545). Lasciate il valore Rotazione (Rotation) su zero.

NOTA: L'utente può anche scegliere sensori planari durante i quali la rotazione può essere utilizzata per regolare l'orientamento del sensore rispetto alla carica di sabbiatura.

6. Salvataggio ed esecuzione del programma

- Salva la scena di addestramento con le armi facendo clic sul pulsante Salva scenario nella GUI in alto.

- Esegui la simulazione della sovrapressione dell'esplosione per la scena di addestramento dell'arma M120 facendo clic sul pulsante Esegui scenario in basso. L'avanzamento della simulazione viene visualizzato utilizzando la barra di avanzamento in basso.

7. Visualizzazione dei risultati

- Passare alla scheda Vista modello per esaminare la simulazione dell'esposizione alla sovrapressione dell'esplosione.

- Fare clic sul pulsante Corrente per caricare la simulazione completata nella finestra di visualizzazione.

- Una volta caricata la simulazione, visualizzala utilizzando il pulsante Riproduci nella parte inferiore dello schermo.

- L'utente può scegliere tra le diverse opzioni nella barra di navigazione per riprodurre e mettere in pausa la simulazione a velocità diverse. Lo screenshot dei controlli di riproduzione qui sotto mostra più opzioni. L'utente può controllare la finestra interattiva utilizzando il mouse. Fare clic con il pulsante destro del mouse e trascinare per ruotare la modalità, il pulsante sinistro per traslare il modello e il pulsante centrale per scorrere avanti/indietro.

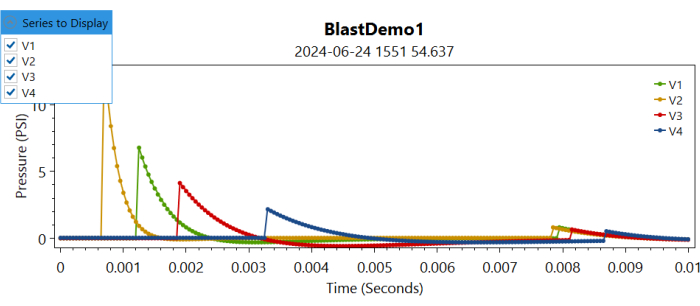

- Dopo aver esaminato la simulazione, accedere alla scheda Metriche del carico di esplosione facendo clic su di essa.

- Fare clic sul pulsante Corrente per caricare i grafici di sovrapressione nelle posizioni dei sensori virtuali.

NOTA: Questo caricherà le informazioni sulla sovrapressione nelle diverse posizioni dei sensori in diversi grafici. - Passare al menu a discesa Serie da visualizzare e selezionare selezionando la casella per il sensore corrispondente per tracciare la sovrapressione registrata su quel sensore virtuale (vedere la Figura 4).

Figura 4: Tracciare i controlli per le sovrapressioni in diversi sensori virtuali nel tempo. Gli utenti possono scegliere la serie da visualizzare selezionando o deselezionando i diversi sensori. Clicca qui per visualizzare una versione più grande di questa figura.

Risultati

Ricostruzione automatizzata dei membri del servizio virtuale e delle scene di esplosione

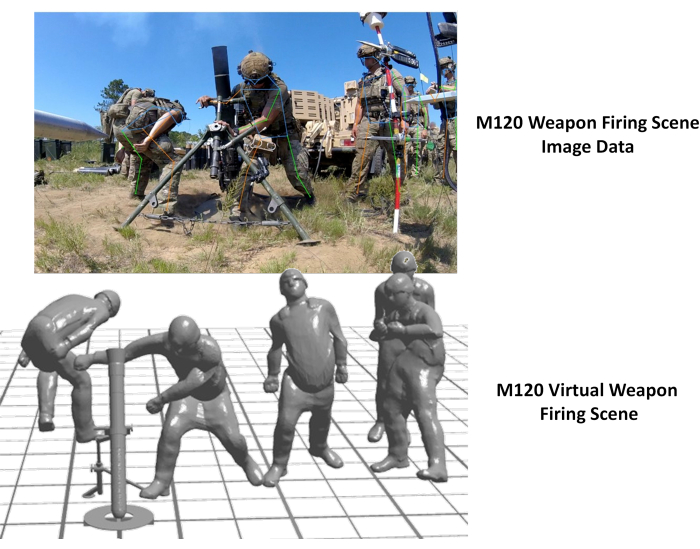

La generazione automatizzata di modelli corporei virtuali per membri del servizio e di scene di addestramento con armi è stata ottenuta attraverso le funzionalità di automazione dello strumento BOP. La Figura 5 mostra la scena di addestramento virtuale generata dai dati dell'immagine. Come si può osservare qui, la scena risultante era una buona rappresentazione dei dati dell'immagine. L'immagine utilizzata per la dimostrazione nella Figura 5 è stata ottenuta da Wikimedia Commons.

Figura 5: Scena virtuale di addestramento con le armi dai dati dell'immagine. L'immagine sul lato sinistro mostra i dati dell'immagine corrispondenti allo sparo di un'arma AT4 e il lato destro mostra la scena virtuale di addestramento con l'arma generata automaticamente. Questa cifra è stata ottenuta da Wikimedia Commons. Clicca qui per visualizzare una versione più grande di questa figura.

Inoltre, l'approccio è stato applicato per ricostruire la scena di sparo dell'arma M120. L'immagine è stata raccolta da WRAIR come parte di uno sforzo di raccolta dei dati sulla pressione per l'arma da mortaio M120. La Figura 6 qui sotto illustra la scena di sparo virtuale ricostruita con l'arma accanto all'immagine originale. È stata osservata una discrepanza nella posizione dell'assistente artigliere nella ricostruzione virtuale. Questo può essere corretto regolando la posizione dell'assistente mitragliere utilizzando le opzioni utente della GUI BOP. Inoltre, la postura pelvica dell'istruttore appariva imprecisa, probabilmente a causa dell'ostruzione dei paletti nelle immagini. L'integrazione di questo approccio con altre modalità di imaging di profondità sarebbe utile per affrontare queste discrepanze.

Figura 6: Scena virtuale di addestramento con le armi dai dati dell'immagine. L'immagine sul lato sinistro mostra i dati dell'immagine corrispondenti allo sparo di un'arma M120 e il lato destro mostra la scena virtuale di addestramento dell'arma generata automaticamente. Clicca qui per visualizzare una versione più grande di questa figura.

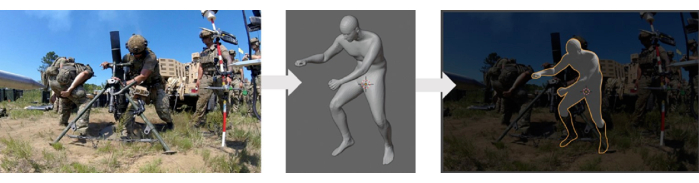

Convalida dell'approccio di generazione automatizzata delle scene

Il generatore di modelli di corpo umano utilizzato in questo studio è stato sottoposto a convalida utilizzando il database di scansione del corpo umano ANSUR II14, che includeva misurazioni antropometriche da dati di imaging medico. Un metodo di ricostruzione automatizzato, che utilizzava questo generatore di modelli di corpo umano, è stato sottoposto a convalida qualitativa con i dati a disposizione. Questo processo di convalida ha comportato il confronto dei modelli ricostruiti con i dati sperimentali (immagini) sovrapponendoli. La Figura 7 presenta un confronto tra i modelli di avatar 3D e i dati sperimentali. Tuttavia, è necessaria una convalida più approfondita di questo metodo, che richiederebbe ulteriori dati sperimentali dalla scena, comprese le posizioni, le posture e gli orientamenti precisi dei diversi membri del servizio coinvolti in una scena di addestramento.

Figura 7: Confronto qualitativo del modello virtuale del corpo umano generato con l'immagine. Il pannello di sinistra mostra l'immagine originale, il pannello centrale mostra il modello del corpo virtuale generato e il pannello di destra mostra il modello virtuale sovrapposto all'immagine originale. Clicca qui per visualizzare una versione più grande di questa figura.

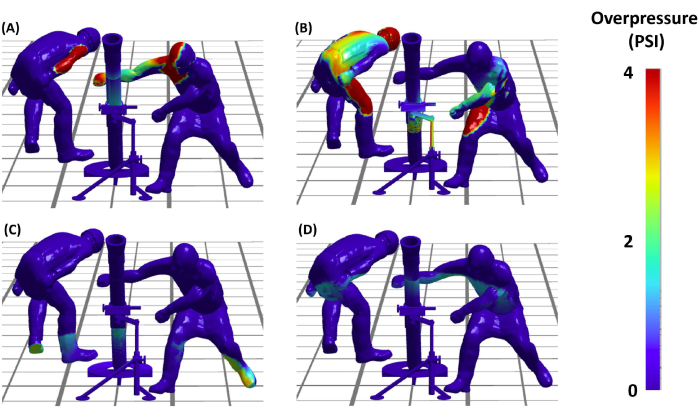

Simulazioni rappresentative della sovrapressione di esplosione

Dopo aver impostato la scena dell'esplosione, gli autori sono stati in grado di procedere alla fase critica dell'esecuzione delle simulazioni di sovrapressione dell'esplosione (BOP). Questo ci permetterà di capire la distribuzione dei carichi di esplosione sui diversi membri del servizio coinvolti in una scena di sparo con un'arma. La Figura 8 presenta i risultati di queste simulazioni BOP durante l'evento di sparo dell'arma AT4. Le simulazioni forniscono una visualizzazione dettagliata dei carichi di sovrapressione sul membro del servizio virtuale nella scena in diversi istanti nel tempo. In conclusione, i risultati dimostrano non solo la fattibilità, ma anche l'efficacia del protocollo nel creare ricostruzioni accurate e analiticamente utili di scenari di addestramento alle armi, aprendo così la strada a studi più avanzati sulla sicurezza e l'efficienza dell'addestramento militare.

Figura 8: Esposizione alla sovrapressione dell'esplosione sul tiratore. (A, B, C e D) I quattro pannelli mostrano la sovrapressione dell'esplosione prevista dal modello sui membri del servizio virtuale coinvolti nel lancio del mortaio M120 in diversi istanti di tempo. I pannelli (C) e (D) mostrano la propagazione della sovrapressione dovuta alla riflessione del terreno. Clicca qui per visualizzare una versione più grande di questa figura.

Discussione

Il framework computazionale presentato in questo articolo accelera significativamente la generazione di scene di addestramento con armi esplosive rispetto ai metodi manuali precedentemente utilizzati utilizzando la valutazione visiva. Questo approccio dimostra la capacità del quadro di catturare e ricostruire rapidamente diverse posizioni militari.

Vantaggi dell'approccio attuale

La creazione di modelli virtuali del corpo umano in posture e posizioni specifiche è un compito impegnativo, con strumenti limitati disponibili per questo scopo. Il metodo convenzionale impiegato nell'approccio legacy, in particolare per lo strumento BOP, utilizzava CoBi-DYN 14,15,16,17. Questo metodo prevedeva la creazione manuale di modelli virtuali del corpo umano con vestiti, caschi, armature protettive e stivali. I modelli sono stati generati attraverso un'approssimazione visiva approssimativa, priva di un approccio sistematico. Nello strumento BOP legacy, CoBi-DYN è stato utilizzato per creare un database di modelli del corpo umano accessibile durante la fase di configurazione dello scenario. Gli utenti selezionavano manualmente una configurazione posturale approssimativa e la posizionavano approssimativamente per un particolare sistema d'arma per eseguire lo scenario BOP. Sebbene la ricostruzione della scena dell'esplosione dal database dei membri del servizio esistente (accessibile dal menu a discesa nello strumento BOP) sia stata relativamente veloce, la creazione iniziale del database virtuale del modello dei membri del servizio ha richiesto molto tempo, richiedendo circa 16-24 ore per scena a causa della natura manuale e approssimativa del processo. Al contrario, il nuovo approccio sfrutta strumenti consolidati di stima della posa per una creazione più automatizzata e rapida di modelli virtuali del corpo umano. Questi strumenti utilizzano automaticamente i dati video e le immagini per ricostruire rapidamente le scene di esplosione con avatar virtuali dei membri del servizio. Ciò riduce significativamente il tempo necessario per creare il database del corpo umano. Il nuovo approccio prevede un singolo clic del pulsante per generare o ricostruire l'intera scena virtuale dai dati di imaging senza la necessità di software aggiuntivo. L'intero processo richiede ora circa 5-6 secondi per scena (dopo aver letto i dati dell'immagine, come verrà dimostrato nel video), dimostrando un sostanziale miglioramento dell'efficienza rispetto al metodo precedente. Questo metodo non è destinato a sostituire l'approccio originale, ma piuttosto a completarlo accelerando la generazione di modelli virtuali dei membri del servizio (che possono essere aggiunti al database dei modelli del corpo dei membri del servizio in futuro). Semplifica l'aggiunta di nuove configurazioni con complessità variabili e facilita l'integrazione di nuovi sistemi d'arma in futuro, migliorando così l'estensibilità dello strumento BOP. Rispetto all'approccio legacy, è evidente che il metodo presentato offre una soluzione più snella e automatizzata, riducendo lo sforzo manuale e il tempo, migliorando al contempo l'accuratezza e la natura sistematica della creazione di modelli di corpo umano virtuale. Ciò evidenzia la forza e l'innovazione del metodo descritto nel campo.

Convalida della generazione automatizzata di scene

Una convalida qualitativa dell'approccio è stata condotta sovrapponendo gli scenari ricostruiti ai dati dell'immagine. Tuttavia, la convalida quantitativa non è stata fattibile a causa della mancanza di dati disponibili sul posizionamento e la postura di queste immagini. Gli autori riconoscono l'importanza di una convalida più approfondita e prevedono di affrontare questo problema nel lavoro futuro. Per raggiungere questo obiettivo, gli autori prevedono uno sforzo completo di raccolta dati per ottenere informazioni precise sul posizionamento e sulla postura. Questo ci consentirà di eseguire una convalida quantitativa dettagliata, migliorando in ultima analisi la robustezza e l'accuratezza dell'approccio.

Validazione delle simulazioni di esposizione alle esplosioni

I noccioli dell'esplosione dell'arma sono stati sviluppati e convalidati utilizzando i dati della sonda a matita raccolti durante il lancio dell'arma. Ulteriori dettagli sul nucleo dell'esplosione dell'arma e sulle relative esposizioni saranno inclusi in una prossima pubblicazione. Alcune informazioni al riguardo sono disponibili anche nelle precedenti pubblicazioni11,12. Questo sforzo continuo contribuirà a migliorare la precisione e l'efficacia delle simulazioni di sovrapressione di brillamento, rafforzando la validità dell'utensile.

L'approccio qui presentato può essere utilizzato anche per generare avatar virtuali dei membri del servizio, che possono essere successivamente incorporati nel database per la selezione utilizzando lo strumento BOP. Sebbene il processo corrente non salvi automaticamente i modelli nel database, gli autori prevedono di includere questa funzione nelle versioni future dello strumento BOP. Inoltre, gli autori dispongono di strumenti interni che consentono la modifica manuale della postura una volta che la postura automatizzata e il modello 3D sono stati generati dai dati dell'immagine. Attualmente, questa capacità esiste in modo indipendente e non è integrata nello strumento BOP, poiché è necessario un ulteriore sviluppo dell'interfaccia utente. Tuttavia, questo è un lavoro in corso e gli autori intendono incorporarlo nelle versioni future dello strumento BOP.

I dati del carico di esplosione potrebbero anche essere esportati sotto forma di file di testo ASCII e ulteriori fasi di post-elaborazione potrebbero essere applicate per studiare in modo più dettagliato i modelli di dose di esplosione per diversi sistemi d'arma. Attualmente, è in corso il lavoro per sviluppare strumenti avanzati di post-elaborazione per metriche di output come impulso, intensità e altri che potrebbero aiutare gli utenti a comprendere e studiare carichi di esplosione ripetuti più complessi durante questi scenari. Inoltre, gli strumenti sono sviluppati per l'efficienza computazionale e consentono velocità di simulazione elevate. Pertanto, questi strumenti ci consentono di eseguire studi di ottimizzazione inversa per determinare la postura e la posizione ottimali durante uno scenario di sparo con un'arma. Tali miglioramenti migliorano l'applicabilità dello strumento per l'ottimizzazione dei protocolli di addestramento in diversi campi di addestramento con le armi. Le stime della dose blastica potrebbero anche essere utilizzate per sviluppare modelli computazionali su macroscala ad alta risoluzione più raffinati per diverse regioni anatomiche vulnerabili come il cervello, i polmoni e altri 18,19,20 e modelli di lesioni su microscala20,21. Qui, l'elmetto e l'armatura incorporati nei modelli sono esclusivamente per la rappresentazione visiva e non influiscono sulla dose di esplosione in queste simulazioni. Ciò è dovuto al fatto che i modelli sono considerati strutture rigide, il che significa che la loro inclusione non modifica né influenza i risultati delle simulazioni di sovrapressione dell'esplosione.

Questo documento sfrutta uno strumento di stima della posa open source esistente per stimare la posa umana in scenari di addestramento con le armi. Si prega di notare che il framework sviluppato e discusso qui è indipendente dallo strumento, ovvero gli autori possono sostituire uno strumento esistente con uno nuovo strumento man mano che vengono fatti ulteriori progressi. Nel complesso, i test hanno dimostrato che, sebbene i moderni strumenti software siano estremamente potenti, il rilevamento delle pose basato su immagini è un compito impegnativo. Tuttavia, esistono diverse raccomandazioni che possono essere utilizzate per migliorare le prestazioni di rilevamento delle pose. Questi strumenti funzionano meglio quando la persona di interesse è in piena visuale della telecamera. Sebbene ciò non sia sempre possibile durante gli esercizi di addestramento con le armi, considerare questo aspetto quando si posiziona la fotocamera può migliorare i risultati del rilevamento della posa. Inoltre, i membri del servizio che eseguono esercizi di addestramento indossano spesso tute mimetiche che si fondono con l'ambiente circostante. Ciò rende più difficile il loro rilevamento sia da parte dell'occhio umano che degli algoritmi di apprendimento automatico (ML). Esistono metodi per migliorare la capacità degli algoritmi ML di rilevare gli esseri umani che indossano il camouflage23, ma questi non sono banali da implementare. Ove possibile, la raccolta di immagini di addestramento con armi in un luogo con uno sfondo ad alto contrasto può migliorare il rilevamento delle pose.

Inoltre, l'approccio convenzionale per stimare le quantità 3D dalle immagini consiste nell'utilizzare tecniche di fotogrammetria con più angolazioni della telecamera. La registrazione di immagini/video da più angolazioni può essere utilizzata anche per migliorare la stima della posa. Fondere le stime delle pose da più telecamere è relativamente semplice24. Un'altra tecnica di fotogrammetria che potrebbe migliorare i risultati è quella di utilizzare una scacchiera o un altro oggetto di dimensioni note come punto di riferimento comune per ogni fotocamera. Una sfida con l'utilizzo di più telecamere è la sincronizzazione temporale. È possibile sviluppare modelli di apprendimento automatico addestrati su misura per rilevare caratteristiche come un casco invece di un viso o per rilevare persone che indossano indumenti e attrezzature specifici per l'esercito (ad esempio, stivali, giubbotti, giubbotti antiproiettile). Gli strumenti di stima della posa esistenti possono essere aumentati utilizzando modelli ML addestrati su misura. Sebbene ciò richieda molto tempo e sia noioso, può migliorare significativamente le prestazioni del modello di stima della posa.

In sintesi, questo articolo delinea efficacemente i vari componenti del quadro di sovrapressione dell'esplosione potenziata. Qui, gli autori riconoscono anche il potenziale per migliorarne l'applicabilità e l'efficacia attraverso un'integrazione più fluida e la completa automazione della pipeline. Elementi come la generazione di una mesh 3D della carrozzeria in scala con lo strumento AMG sono in fase di automazione per ridurre l'input manuale dell'utente. Attualmente, è in corso un lavoro per integrare queste funzionalità nel modulo SCENE dello strumento BOP. Man mano che questa tecnologia si sviluppa, sarà resa accessibile a tutte le parti interessate e ai laboratori del DoD. Inoltre, il lavoro in corso include la caratterizzazione e la convalida dei nuclei delle armi per ulteriori sistemi d'arma. Questo continuo sforzo per perfezionare e convalidare le metodologie garantisce che gli strumenti sviluppati dagli autori rimangano all'avanguardia del progresso tecnologico, contribuendo in modo significativo alla sicurezza e all'efficacia delle esercitazioni di addestramento militare. Le future pubblicazioni forniranno maggiori dettagli su questi sviluppi, contribuendo al più ampio campo dell'addestramento e della sicurezza militare.

Divulgazioni

Gli autori non hanno nulla da rivelare.

Riconoscimenti

La ricerca è finanziata dall'ufficio di coordinamento della ricerca sulle lesioni da esplosione del DoD nell'ambito del bando MTEC MTEC-22-02-MPAI-082. Gli autori riconoscono anche il contributo di Hamid Gharahi per i nuclei di esplosione delle armi e di Zhijian J Chen per lo sviluppo delle capacità di modellazione per le simulazioni di sovrapressione delle esplosioni di sparo di armi. I punti di vista, le opinioni e/o i risultati espressi in questa presentazione sono quelli degli autori e non riflettono la politica o la posizione ufficiale del Dipartimento dell'Esercito o del Dipartimento della Difesa.

Materiali

| Name | Company | Catalog Number | Comments |

| Anthropometric Model Generator (AMG) | CFD Research | N/A | For generting 3D human body models with different anthropometric characteristics. The tool is DoD Open Source. |

| BOP Tool | CFD Research | N/A | For setting up blast scenes and overpressure simulations. The tool is DoD open source. |

| BOP Tool SCENE Module | CFD Research | N/A | For setting up blast scenes and overpressure simulations. The tool is DoD open source. |

| Mediapipe | Version 0.9 | Open-source pose estimation library. | |

| MMPose | OpenMMLab | Version 1.2 | Open-source pose estimation library. |

| OpenSim | Stanford University | Version 4.4 | Open-source musculoskeletal modeling and simulation platform. |

| Python 3 | Anaconda Inc | Version 3.8 | The open source Individual Edition containing Python 3.8 and preinstalled packages to perform video processing and connecting the pose estimation tools. |

Riferimenti

- LaValle, C. R., et al. Neurocognitive performance deficits related to immediate and acute blast overpressure exposure. Front Neurol. 10, (2019).

- Kamimori, G. H., et al. Longitudinal investigation of neurotrauma serum biomarkers, behavioral characterization, and brain imaging in soldiers following repeated low-level blast exposure (New Zealand Breacher Study). Military Med. 183 (suppl_1), 28-33 (2018).

- Wang, Z., et al. Acute and chronic molecular signatures and associated symptoms of blast exposure in military breachers. J Neurotrauma. 37 (10), 1221-1232 (2020).

- Gill, J., et al. Moderate blast exposure results in increased IL-6 and TNFα in peripheral blood. Brain Behavior Immunity. 65, 90-94 (2017).

- Carr, W., et al. Ubiquitin carboxy-terminal hydrolase-L1 as a serum neurotrauma biomarker for exposure to occupational low-Level blast. Front Neurol. 6, (2015).

- Boutté, A. M., et al. Brain-related proteins as serum biomarkers of acute, subconcussive blast overpressure exposure: A cohort study of military personnel. PLoS One. 14 (8), e0221036(2019).

- Skotak, M., et al. Occupational blast wave exposure during multiday 0.50 caliber rifle course. Front Neurol. 10, (2019).

- Kamimori, G. H., Reilly, L. A., LaValle, C. R., Silva, U. B. O. D. Occupational overpressure exposure of breachers and military personnel. Shock Waves. 27 (6), 837-847 (2017).

- Misistia, A., et al. Sensor orientation and other factors which increase the blast overpressure reporting errors. PLoS One. 15 (10), e0240262(2020).

- National Defense Authorization Act for Fiscal Year 2020. Wikipedia. , https://en.wikipedia.org/w/index.php?title=National_Defense_Authorization_Act_for_Fiscal_Year_2020&oldid=1183832580 (2023).

- Przekwas, A., et al. Fast-running tools for personalized monitoring of blast exposure in military training and operations. Military Med. 186 (Supplement_1), 529-536 (2021).

- Spencer, R. W., et al. Fiscal year 2018 National Defense Authorization Act, Section 734, Weapon systems line of inquiry: Overview and blast overpressure tool-A module for human body blast wave exposure for safer weapons training. Military Med. 188 (Supplement_6), 536-544 (2023).

- Delp, S. L., et al. OpenSim: open-source software to create and analyze dynamic simulations of movement. IEEE Trans Biomed Eng. 54 (11), 1940-1950 (2007).

- Zhou, X., Sun, K., Roos, P. E., Li, P., Corner, B. Anthropometry model generation based on ANSUR II database. Int J Digital Human. 1 (4), 321(2016).

- Zhou, X., Przekwas, A. A fast and robust whole-body control algorithm for running. Int J Human Factors Modell Simulat. 2 (1-2), 127-148 (2011).

- Zhou, X., Whitley, P., Przekwas, A. A musculoskeletal fatigue model for prediction of aviator neck manoeuvring loadings. Int J Human Factors Modell Simulat. 4 (3-4), 191-219 (2014).

- Roos, P. E., Vasavada, A., Zheng, L., Zhou, X. Neck musculoskeletal model generation through anthropometric scaling. PLoS One. 15 (1), e0219954(2020).

- Garimella, H. T., Kraft, R. H. Modeling the mechanics of axonal fiber tracts using the embedded finite element method. Int J Numer Method Biomed Eng. 33 (5), (2017).

- Garimella, H. T., Kraft, R. H., Przekwas, A. J. Do blast induced skull flexures result in axonal deformation. PLoS One. 13 (3), e0190881(2018).

- Przekwas, A., et al. Biomechanics of blast TBI with time-resolved consecutive primary, secondary, and tertiary loads. Military Med. 184 (Suppl 1), 195-205 (2019).

- Gharahi, H., Garimella, H. T., Chen, Z. J., Gupta, R. K., Przekwas, A. Mathematical model of mechanobiology of acute and repeated synaptic injury and systemic biomarker kinetics. Front Cell Neurosci. 17, 1007062(2023).

- Przekwas, A., Somayaji, M. R., Gupta, R. K. Synaptic mechanisms of blast-induced brain injury. Front Neurol. 7, 2(2016).

- Liu, Y., Wang, C., Zhou, Y. Camouflaged people detection based on a semi-supervised search identification network. Def Technol. 21, 176-183 (2023).

- Batpurev, T. Real time 3D body pose estimation using MediaPipe. , Available from: https://temugeb.github.io/python/computer_vision/2021/09/14/bodypose3d.html (2021).

Ristampe e Autorizzazioni

Richiedi autorizzazione per utilizzare il testo o le figure di questo articolo JoVE

Richiedi AutorizzazioneEsplora altri articoli

This article has been published

Video Coming Soon