A subscription to JoVE is required to view this content. Sign in or start your free trial.

Method Article

نظام قائم على الذكاء الاصطناعي للكشف عن مستويات الانتباه لدى الطلاب

In This Article

Summary

تقترح هذه الورقة نظاما قائما على الذكاء الاصطناعي للكشف تلقائيا عما إذا كان الطلاب ينتبهون إلى الفصل أو مشتتون. تم تصميم هذا النظام لمساعدة المعلمين في الحفاظ على انتباه الطلاب ، وتحسين دروسهم ، وإدخال تعديلات ديناميكية حتى يكونوا أكثر جاذبية.

Abstract

يمكن تحسين مستوى انتباه الطلاب في الفصل الدراسي من خلال استخدام تقنيات الذكاء الاصطناعي (الذكاء الاصطناعي). من خلال تحديد مستوى الانتباه تلقائيا ، يمكن للمدرسين استخدام استراتيجيات لاستعادة تركيز الطلاب. يمكن تحقيق ذلك من خلال مصادر مختلفة للمعلومات.

أحد المصادر هو تحليل المشاعر المنعكسة على وجوه الطلاب. الذكاء الاصطناعي اكتشاف المشاعر ، مثل المحايدة والاشمئزاز والمفاجأة والحزن والخوف والسعادة والغضب. بالإضافة إلى ذلك ، يمكن أن يشير اتجاه نظرة الطلاب أيضا إلى مستوى انتباههم. مصدر آخر هو مراقبة وضع جسم الطلاب. باستخدام الكاميرات وتقنيات التعلم العميق ، يمكن تحليل الموقف لتحديد مستوى الانتباه. على سبيل المثال ، قد يكون لدى الطلاب الذين يترهلون أو يستريحون رؤوسهم على مكاتبهم مستوى أقل من الاهتمام. يمكن أن توفر الساعات الذكية الموزعة على الطلاب بيانات بيومترية وغيرها ، بما في ذلك معدل ضربات القلب والقياسات بالقصور الذاتي ، والتي يمكن استخدامها أيضا كمؤشرات للانتباه. من خلال الجمع بين مصادر المعلومات هذه ، يمكن تدريب نظام الذكاء الاصطناعي لتحديد مستوى الانتباه في الفصل الدراسي. ومع ذلك ، فإن دمج الأنواع المختلفة من البيانات يشكل تحديا يتطلب إنشاء مجموعة بيانات مصنفة. يتم الرجوع إلى مدخلات الخبراء والدراسات الحالية لوضع العلامات بدقة. في هذه الورقة ، نقترح دمج هذه القياسات وإنشاء مجموعة بيانات ومصنف انتباه محتمل. لتقديم ملاحظات للمعلم ، نستكشف طرقا مختلفة ، مثل الساعات الذكية أو أجهزة الكمبيوتر المباشرة. بمجرد أن يصبح المعلم على دراية بقضايا الانتباه ، يمكنه تعديل نهج التدريس الخاص به لإعادة إشراك الطلاب وتحفيزهم. باختصار ، يمكن لتقنيات الذكاء الاصطناعي تحديد مستوى انتباه الطلاب تلقائيا من خلال تحليل عواطفهم واتجاه نظراتهم ووضعية الجسم والبيانات البيومترية. يمكن أن تساعد هذه المعلومات المعلمين في تحسين عملية التعليم والتعلم.

Introduction

في البيئات التعليمية الحديثة ، يعد التقييم الدقيق لانتباه الطلاب والحفاظ عليه أمرا بالغ الأهمية للتعليم والتعلم الفعالين. ومع ذلك ، فإن الطرق التقليدية لقياس المشاركة ، مثل الإبلاغ الذاتي أو ملاحظات المعلم الذاتية ، تستغرق وقتا طويلا وعرضة للتحيز. لمواجهة هذا التحدي ، ظهرت تقنيات الذكاء الاصطناعي (الذكاء الاصطناعي) كحلول واعدة للكشف الآلي عن الانتباه. أحد الجوانب المهمة لفهم مستويات مشاركة الطلاب هو التعرف على المشاعر1. يمكن للأنظمة الذكاء الاصطناعي تحليل تعبيرات الوجه لتحديد المشاعر ، مثل المحايد والاشمئزاز والمفاجأة والحزن والخوف والسعادة والغضب2.

اتجاه النظرة ووضعية الجسم هي أيضا مؤشرات حاسمة لانتباه الطلاب3. من خلال استخدام الكاميرات وخوارزميات التعلم الآلي المتقدمة ، يمكن للأنظمة الذكاء الاصطناعي تتبع المكان الذي يبحث فيه الطلاب بدقة وتحليل وضع أجسامهم لاكتشاف علامات عدم الاهتمام أو التعب4. علاوة على ذلك ، فإن دمج البيانات البيومترية يعزز دقة وموثوقية اكتشاف الانتباه5. من خلال جمع القياسات ، مثل معدل ضربات القلب ومستويات تشبع الأكسجين في الدم ، من خلال الساعات الذكية التي يرتديها الطلاب ، يمكن الحصول على مؤشرات موضوعية للانتباه ، تكمل مصادر المعلومات الأخرى.

تقترح هذه الورقة نظاما يقيم مستوى انتباه الفرد باستخدام الكاميرات الملونة وأجهزة الاستشعار المختلفة الأخرى. فهو يجمع بين التعرف على المشاعر وتحليل اتجاه النظرة وتقييم وضعية الجسم والبيانات البيومترية لتزويد المعلمين بمجموعة شاملة من الأدوات لتحسين عملية التدريس والتعلم وتحسين مشاركة الطلاب. من خلال استخدام هذه الأدوات ، يمكن للمعلمين اكتساب فهم شامل لعملية التدريس والتعلم وتعزيز مشاركة الطلاب ، وبالتالي تحسين التجربة التعليمية الشاملة. من خلال تطبيق تقنيات الذكاء الاصطناعي ، من الممكن تقييم هذه البيانات تلقائيا.

الهدف الرئيسي من هذا العمل هو وصف النظام الذي يسمح لنا بالتقاط جميع المعلومات ، وبمجرد التقاطها ، لتدريب نموذج الذكاء الاصطناعي يسمح لنا بجذب انتباه الفصل بأكمله في الوقت الفعلي. على الرغم من أن أعمالا أخرى قد اقترحت بالفعل جذب الانتباه باستخدام المعلومات المرئية أو العاطفية6 ، يقترح هذا العمل الاستخدام المشترك لهذه التقنيات ، مما يوفر نهجا شاملا للسماح باستخدام تقنيات الذكاء الاصطناعي أكثر تعقيدا وفعالية. علاوة على ذلك ، تقتصر مجموعات البيانات المتاحة حتى الآن إما على مجموعة من مقاطع الفيديو أو واحدة من البيانات البيومترية. لا تتضمن الأدبيات أي مجموعات بيانات توفر بيانات كاملة مع صور لوجه الطالب أو جسمه ، وبيانات بيومترية ، وبيانات عن موقف المعلم ، وما إلى ذلك. مع النظام المقدم هنا ، من الممكن التقاط هذا النوع من مجموعات البيانات.

يربط النظام مستوى من الاهتمام مع كل طالب في كل نقطة زمنية. هذه القيمة هي قيمة احتمالية للانتباه بين 0٪ و 100٪ ، والتي يمكن تفسيرها على أنها مستوى منخفض من الانتباه (0٪ -40٪) ، ومستوى متوسط من الانتباه (40٪ -75٪) ، ومستوى عال من الانتباه (75٪ -100٪). في جميع أنحاء النص ، يشار إلى احتمال الانتباه هذا على أنه مستوى الانتباه ، أو انتباه الطلاب ، أو ما إذا كان الطلاب مشتتين أم لا ، ولكن هذه كلها مرتبطة بنفس قيمة الخرج لنظامنا.

على مر السنين ، نما مجال الكشف التلقائي عن المشاركة بشكل كبير بسبب قدرته على إحداث ثورة في التعليم. اقترح الباحثون مناهج مختلفة لهذا المجال من الدراسة.

قدم Ma et al.7 طريقة جديدة تعتمد على آلة تورينج العصبية للتعرف التلقائي على المشاركة. لقد استخلصوا ميزات معينة ، مثل نظرة العين ، ووحدات عمل الوجه ، ووضعية الرأس ، ووضعية الجسم ، لإنشاء تمثيل شامل للتعرف على المشاركة.

استخدم EyeTab8 ، وهو نظام مبتكر آخر ، نماذج لتقدير المكان الذي ينظر إليه شخص ما بكلتا عينيه. تم تصميمه خصيصا للعمل بسلاسة على جهاز لوحي قياسي دون أي تعديلات. يسخر هذا النظام خوارزميات معروفة لمعالجة الصور وتحليل رؤية الكمبيوتر. يتضمن خط أنابيب تقدير النظرة الخاص بهم كاشف العين القائم على ميزة Haar ، بالإضافة إلى نهج تركيب القطع الناقص القائم على RANSAC.

يقترح Sanghvi et al.9 نهجا يعتمد على التقنيات القائمة على الرؤية لاستخراج الميزات الوضعية التعبيرية تلقائيا من مقاطع الفيديو المسجلة من منظر جانبي ، والتقاط سلوك الأطفال. يتم إجراء تقييم أولي ، يتضمن تدريب نماذج التعرف المتعددة باستخدام التعبيرات الوضعية العاطفية السياقية. تظهر النتائج التي تم الحصول عليها أن أنماط السلوك الوضعي يمكن أن تتنبأ بشكل فعال بمشاركة الأطفال مع الروبوت.

في أعمال أخرى ، مثل Gupta et al.10 ، يتم استخدام طريقة قائمة على التعلم العميق للكشف عن المشاركة في الوقت الفعلي للمتعلمين عبر الإنترنت من خلال تحليل تعبيرات وجوههم وتصنيف عواطفهم. يستخدم هذا النهج التعرف على مشاعر الوجه لحساب مؤشر المشاركة (EI) الذي يتنبأ بحالتين من الارتباط: المشاركة وعدم الارتباط. يتم تقييم نماذج التعلم العميق المختلفة ، بما في ذلك Inception-V3 و VGG19 و ResNet-50 ، ومقارنتها لتحديد نموذج التصنيف التنبئي الأكثر فعالية لاكتشاف المشاركة في الوقت الفعلي.

في Altuwairqi et al.11 ، يقدم الباحثون نهجا تلقائيا جديدا متعدد الوسائط لتقييم مستويات مشاركة الطلاب في الوقت الفعلي. لضمان قياسات دقيقة ويمكن الاعتماد عليها ، قام الفريق بدمج وتحليل ثلاث طرق متميزة تلتقط سلوكيات الطلاب: تعبيرات الوجه للعواطف ، وضغطات لوحة المفاتيح ، وحركات الماوس.

يقترح Guillén et al.12 تطوير نظام مراقبة يستخدم تخطيط القلب الكهربائي (ECG) كإشارة فسيولوجية أولية لتحليل والتنبؤ بوجود أو عدم وجود الانتباه المعرفي لدى الأفراد أثناء أداء المهمة.

يستخدم Alban et al.13 شبكة عصبية (NN) لاكتشاف العواطف من خلال تحليل قيم معدل ضربات القلب (HR) والنشاط الكهربائي (EDA) لمختلف المشاركين في كل من مجالات الوقت والتردد. وجدوا أن الزيادة في جذر متوسط مربع الاختلافات المتتالية (RMSDD) وفترات الانحراف المعياري الطبيعي إلى الطبيعي (SDNN) ، إلى جانب انخفاض في متوسط الموارد البشرية ، تشير إلى زيادة النشاط في الجهاز العصبي الودي ، والذي يرتبط بالخوف.

يقترح Kajiwara et al.14 نظاما مبتكرا يستخدم أجهزة استشعار يمكن ارتداؤها وشبكات عصبية عميقة للتنبؤ بمستوى العاطفة والمشاركة لدى العمال. يتبع النظام عملية من ثلاث خطوات. في البداية ، تلتقط المستشعرات القابلة للارتداء وتجمع البيانات حول السلوكيات وموجات النبض. بعد ذلك ، يتم حساب ميزات السلاسل الزمنية بناء على البيانات السلوكية والفسيولوجية المكتسبة. أخيرا ، يتم استخدام الشبكات العصبية العميقة لإدخال ميزات السلاسل الزمنية وإجراء تنبؤات حول مشاعر الفرد ومستويات المشاركة.

في أبحاث أخرى ، مثل Costante et al.15 ، تم اقتراح نهج يعتمد على خوارزمية تعلم متري نقل جديدة ، والتي تستخدم المعرفة المسبقة بمجموعة محددة مسبقا من الإيماءات لتعزيز التعرف على الإيماءات المعرفة من قبل المستخدم. يتم تحقيق هذا التحسن مع الحد الأدنى من الاعتماد على عينات التدريب الإضافية. وبالمثل ، يتم تقديم إطار التعرف على النشاط البشري القائم على أجهزة الاستشعار16 لمعالجة هدف الاعتراف غير الشخصي بالأنشطة البشرية المعقدة. يتم استخدام بيانات الإشارة التي تم جمعها من أجهزة الاستشعار التي يتم ارتداؤها على المعصم في إطار التعرف على النشاط البشري الذي تم تطويره ، باستخدام أربعة نماذج DL قائمة على RNN (ذكريات طويلة المدى قصيرة المدى ، وذكريات ثنائية الاتجاه طويلة المدى قصيرة المدى ، ووحدات متكررة ذات بوابات ، ووحدات متكررة ذات بوابات ثنائية الاتجاه) للتحقيق في الأنشطة التي يقوم بها مستخدم الجهاز القابل للارتداء.

Protocol

يتبع البروتوكول التالي إرشادات لجنة أخلاقيات البحوث البشرية بجامعة أليكانتي برقم البروتوكول المعتمد UA-2022-11-12. تم الحصول على موافقة مستنيرة من جميع المشاركين لهذه التجربة ولاستخدام البيانات هنا.

1. الأجهزة والبرامج وإعداد الفصل

- قم بتعيين جهاز توجيه بإمكانيات WiFi (تم إجراء التجارب باستخدام DLink DSR 1000AC) في الموقع المطلوب بحيث يغطي نطاقه الغرفة بأكملها. هنا ، تمت تغطية 25 م2 فصول دراسية مع 30 طالبا.

- قم بتعيين ساعة ذكية واحدة (هنا Samsung Galaxy Smartwatch 5) وكاميرا واحدة (هنا كاميرات Logitech C920) لكل موقع طالب. قم بتعيين جهاز مضمن واحد لكل طالبين. ثبت كاميرتين على حاملين ثلاثي القوائم وقم بتوصيلهما بجهاز مضمن آخر (يشار إليه فيما يلي باسم كاميرات السمت).

- قم بتوصيل الكاميرات بالأجهزة المضمنة المقابلة باستخدام رابط USB وقم بتشغيلها. قم بتشغيل الساعات الذكية أيضا. قم بتوصيل كل جهاز مضمن وساعة ذكية بشبكة WiFi الخاصة بالموجه الذي تم إعداده في الخطوة 1.1.

- ضع الكاميرات في زاوية مكتب كل طالب ووجهها للأمام وإمالتها قليلا لأعلى بحيث يكون وجه الطالب مرئيا بوضوح في الصور.

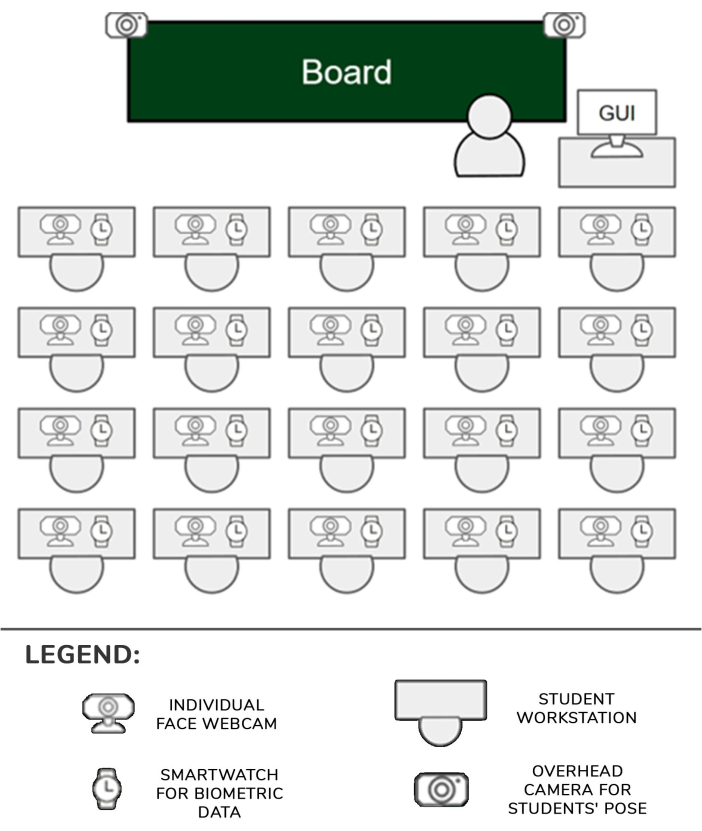

- ضع الحاملين ثلاثي القوائم مع وضع الكاميرات أمام المكاتب الأقرب إلى الممرات في الصف الأول من مقاعد الفصل الدراسي. حرك رافع الحامل ثلاثي القوائم إلى أعلى موضع حتى تتمكن الكاميرات من رؤية معظم الطلاب بوضوح. سيتمكن كل جهاز مضمن من إدارة طالب أو طالبين ، إلى جانب الكاميرات والساعات الخاصة بكل منهما. الإعداد موضح في الشكل 1.

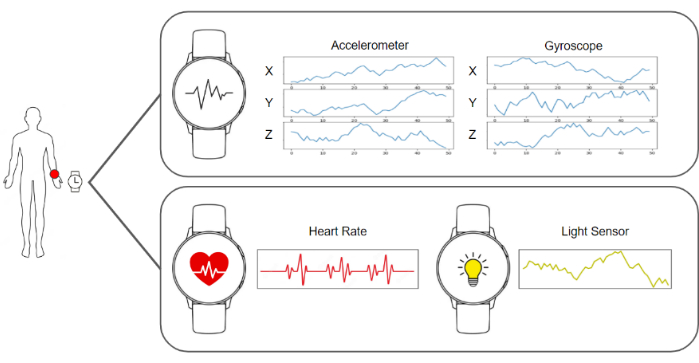

- قم بتشغيل برنامج الالتقاط في الساعات الذكية وفي الأجهزة المدمجة بحيث تكون جاهزة لإرسال الصور ومقياس التسارع والجيروسكوب ومعدل ضربات القلب وبيانات الإضاءة. قم بتشغيل برنامج الخادم الذي يجمع البيانات ويخزنها. يمكن رؤية شكل يوضح كل هذه العناصر في الشكل 2.

- تأكد من أن كاميرات السمت تهيمن على المشهد بحيث يكون لها رؤية واضحة لأجساد الطلاب. ضع كاميرا فردية إضافية أمام كل طالب.

- دع الطلاب يجلسون في أماكنهم ، ويطلعهم على أهداف التجربة ، ويوجههم إلى ارتداء الساعات الذكية في يدهم المهيمنة وعدم التفاعل مع أي من عناصر الإعداد.

- ابدأ في التقاط البيانات وجمعها في الخادم واستأنف دروس الفصل كالمعتاد.

الشكل 1: خط أنابيب الأجهزة والبيانات. يتم جمع بيانات الكاميرات والساعات الذكية وتغذيتها إلى خوارزميات التعلم الآلي لتتم معالجتها. يرجى النقر هنا لعرض نسخة أكبر من هذا الرقم.

الشكل 2: موضع المستشعرات والمعلم والطلاب. رسم تخطيطي يوضح مواقع الكاميرات والساعات الذكية وواجهة المستخدم الرسومية في الفصل مع المعلم والطلاب. يرجى النقر هنا لعرض نسخة أكبر من هذا الرقم.

2. التقاط ومعالجة البيانات خط أنابيب

ملاحظة: يتم تنفيذ كافة هذه الخطوات تلقائيا عن طريق معالجة البرامج المنشورة في الخادم. تمت كتابة التطبيق المستخدم للتجارب في هذا العمل في Python 3.8.

- جمع البيانات المطلوبة من خلال جمع جميع الصور والبيانات البيومترية من الساعة الذكية لكل طالب وبناء إطار بيانات يتضمن بيانات من 1 ثانية. يتكون إطار البيانات هذا من صورة واحدة من الكاميرا الفردية ، وصورة واحدة من كل كاميرا سمتي (اثنان في هذه الحالة) ، وخمسون سجلا لقيم الجيروسكوب الثلاثة ، وخمسون سجلا لقيم مقياس التسارع الثلاثة ، وقيمة واحدة لمعدل ضربات القلب ، وقيمة واحدة لحالة الضوء.

- لحساب اتجاه الرأس ، تتمثل الخطوة الأولى في استخدام كاميرا الويب الموجهة إلى وجه الطالب واسترداد صورة. بعد ذلك ، تتم معالجة هذه الصورة بواسطة خوارزمية تقدير معلم BlazeFace17 . إخراج هذه الخوارزمية هو قائمة من النقاط الرئيسية 2D المقابلة لمناطق محددة من الوجه.

- باستخدام الموضع المقدر للعينين والأنف والفم والذقن الذي توفره الخوارزمية ، قم بحل مشكلة نقطة n للمنظور باستخدام الطريقة cv::SolvePnPMethod لمكتبة OpenCV ، وهو إعداد وجه أساسي. يتم الحصول على مصفوفة الدوران التي تحدد اتجاه الرأس نتيجة لهذا الإجراء.

- احسب وضع الجسم عن طريق إعادة توجيه الصورة السمتي من إطار البيانات الذي يصور فيه الطالب إلى خوارزمية تقدير معلم BlazePose18 واسترجاع قائمة بإحداثيات 2D لمفاصل الجسم الموضحة في الصورة. تصف قائمة المعالم هذه وضع الطالب.

ملاحظة: يعد وضع الجسم مهما لأنه يمكن أن يمثل بدقة مشاركة الطالب في الأنشطة المختلفة أثناء الفصل. على سبيل المثال ، إذا كان الطالب يجلس بشكل طبيعي ويديه على المكتب ، فقد يعني ذلك أنه يدون الملاحظات. في المقابل ، إذا كانوا يحركون أذرعهم باستمرار ، فقد يعني ذلك أنهم يتحدثون إلى شخص ما. - الحصول على صورة وجه الطالب وإجراء المعالجة المسبقة للمحاذاة. استرجع النقاط الرئيسية للعيون من القائمة المحسوبة في الخطوة 2.3 وقم بعرضها على مستوى الصورة بحيث يتم الحصول على موضع العينين.

- تتبع متجه افتراضي ينضم إلى موضع كلتا العينين. احسب الزاوية بين هذا المتجه والخط الأفقي وقم ببناء مصفوفة متجانسة لتطبيق الزاوية العكسية على الصورة والنقاط الرئيسية بحيث يتم محاذاة العينين أفقيا.

- قم بقص الوجه باستخدام النقاط الرئيسية للكشف عن حدوده وتغذية التصحيح بالشبكة العصبية التلافيفية للكشف عن المشاعر19. استرجع الإخراج من الشبكة ، وهو متجه به 7 مواضع ، كل موضع يعطي احتمال أن يظهر الوجه أحد المشاعر الأساسية السبعة: محايد ، سعيد ، مشمئز ، غاضب ، خائف ، متفاجئ ، وحزين.

- قم بقياس مستوى الانتباه من خلال الحصول على بيانات مقياس التسارع والجيروسكوب ومعدل ضربات القلب من إطار البيانات (الشكل 3).

- قم بتغذية النموذج القائم على التعلم العميق الذي تم تصميمه وتدريبه خصيصا من البداية الموصوفة في النتائج التمثيلية مع دفق بيانات مقياس التسارع والجيروسكوب. استرجع الناتج من النموذج ، وهو متجه به 4 مواضع ، كل موضع يعطي احتمال أن تمثل البيانات أحد الإجراءات المحتملة التالية: الكتابة اليدوية أو الكتابة على لوحة المفاتيح أو استخدام الهاتف المحمول أو الراحة ، كما هو موضح في الشكل 4.

- قم بتغذية مصنف الانتباه النهائي بخط جميع النتائج من الأنظمة السابقة عن طريق دمج اتجاه الرأس ، وإخراج التعرف على المشاعر ، ووضعية الجسم ، وبيانات الجيروسكوب ، ومقياس التسارع ، ومعدل ضربات القلب. استرجع النتائج من هذا المصنف النهائي ، وهو درجة من 0 إلى 100. صنف هذه القيمة المستمرة إلى واحدة من ثلاث فئات منفصلة ممكنة من الانتباه: مستوى منخفض من الانتباه (0-40٪) ، ومستوى متوسط من الانتباه (40٪ -75٪) ، ومستوى عال من الانتباه (75٪ - 100٪). يظهر الجدول 1 هيكل مجموعة البيانات التي تم إنشاؤها.

- اعرض نتائج مستويات الانتباه للمعلم باستخدام واجهة المستخدم الرسومية (GUI) من كمبيوتر المعلم ، والتي يمكن الوصول إليها من متصفح الويب العادي.

الشكل 3: البيانات التي تم التقاطها بواسطة الساعة الذكية. توفر الساعة الذكية جيروسكوب ومقياس تسارع ومعدل ضربات القلب وحالة الضوء كتدفقات من البيانات. يرجى النقر هنا لعرض نسخة أكبر من هذا الرقم.

الشكل 4: أمثلة على الفئات التي يأخذها نموذج التعرف على النشاط في الاعتبار. يتم التعرف على أربعة إجراءات مختلفة بواسطة نموذج التعرف على النشاط: الكتابة اليدوية والكتابة على لوحة المفاتيح واستخدام الهاتف الذكي ووضع الراحة. يرجى النقر هنا لعرض نسخة أكبر من هذا الرقم.

النتائج

الفئة المستهدفة من هذه الدراسة هي طلاب البكالوريوس والماجستير ، وبالتالي فإن الفئة العمرية الرئيسية تتراوح بين 18 و 25 عاما. تم اختيار هذه الفئة من السكان لأنهم يستطيعون التعامل مع الأجهزة الإلكترونية مع عدد أقل من عوامل التشتيت مقارنة بالطلاب الأصغر سنا. في المجموع ، ضمت المجموعة 25 شخصا. ي?...

Discussion

يقدم هذا العمل نظاما يقيس مستوى انتباه الطالب في الفصل الدراسي باستخدام الكاميرات والساعات الذكية وخوارزميات الذكاء الاصطناعي. يتم تقديم هذه المعلومات لاحقا إلى المعلم حتى يكون لديهم فكرة عن الحالة العامة للفصل.

تتمثل إحدى الخطوات الرئيسية الحاسمة للبروتوكول في مزامنة م?...

Disclosures

يعلن المؤلفون أنه ليس لديهم مصالح مالية متنافسة معروفة أو علاقات شخصية يمكن أن يبدو أنها تؤثر على العمل المذكور في هذه الورقة.

Acknowledgements

تم تطوير هذا العمل بتمويل من Programa Prometeo ، معرف المشروع CIPROM / 2021/017. البروفيسورة روزابيل رويج هي رئيسة اليونسكو "التربية والبحوث والشمول الرقمي".

Materials

| Name | Company | Catalog Number | Comments |

| 4 GPUs Nvidia A40 Ampere | NVIDIA | TCSA40M-PB | GPU for centralized model processing server |

| FusionServer 2288H V5 | X-Fusion | 02311XBK | Platform that includes power supply and motherboard for centralized model processing server |

| Memory Card Evo Plus 128 GB | Samsung | MB-MC128KA/EU | Memory card for the operation of the raspberry pi 4b 2gb. One for each raspberry. |

| NEMIX RAM - 512 GB Kit DDR4-3200 PC4-25600 8Rx4 EC | NEMIX | M393AAG40M32-CAE | RAM for centralized model processing server |

| Processor Intel Xeon Gold 6330 | Intel | CD8068904572101 | Processor for centralized model processing server |

| Raspberry PI 4B 2GB | Raspberry | 1822095 | Local server that receives requests from the clocks and sends them to the general server. One every two students. |

| Samsung Galaxy Watch 5 (40mm) | Samsung | SM-R900NZAAPHE | Clock that monitors each student's activity. For each student. |

| Samsung MZQL23T8HCLS-00B7C PM9A3 3.84Tb Nvme U.2 PCI-Express-4 x4 2.5inch Ssd | Samsung | MZQL23T8HCLS-00B7C | Internal storage for centralized model processing server |

| WebCam HD Pro C920 Webcam FullHD | Logitech | 960-001055 | Webcam HD. One for each student plus two for student poses. |

References

- Hasnine, M. N., et al. Students' emotion extraction and visualization for engagement detection in online learning. Procedia Comp Sci. 192, 3423-3431 (2021).

- Khare, S. K., Blanes-Vidal, V., Nadimi, E. S., Acharya, U. R. Emotion recognition and artificial intelligence: A systematic review (2014-2023) and research recommendations. Info Fusion. 102, 102019 (2024).

- Bosch, N. Detecting student engagement: Human versus machine. UMAP '16: Proc the 2016 Conf User Model Adapt Personal. , 317-320 (2016).

- Araya, R., Sossa-Rivera, J. Automatic detection of gaze and body orientation in elementary school classrooms. Front Robot AI. 8, 729832 (2021).

- Lu, Y., Zhang, J., Li, B., Chen, P., Zhuang, Z. Harnessing commodity wearable devices for capturing learner engagement. IEEE Access. 7, 15749-15757 (2019).

- Vanneste, P., et al. Computer vision and human behaviour, emotion and cognition detection: A use case on student engagement. Mathematics. 9 (3), 287 (2021).

- Ma, X., Xu, M., Dong, Y., Sun, Z. Automatic student engagement in online learning environment based on neural Turing machine. Int J Info Edu Tech. 11 (3), 107-111 (2021).

- Wood, E., Bulling, A. EyeTab: model-based gaze estimation on unmodified tablet computers. ETRA '14: Proc Symp Eye Tracking Res Appl. , 207-210 (2014).

- Sanghvi, J., et al. Automatic analysis of affective postures and body motion to detect engagement with a game companion. HRI '11: Proc 6th Int Conf Human-robot Interact. , 205-211 (2011).

- Gupta, S., Kumar, P., Tekchandani, R. K. Facial emotion recognition based real-time learner engagement detection system in online learning context using deep learning models. Multimed Tools Appl. 82 (8), 11365-11394 (2023).

- Altuwairqi, K., Jarraya, S. K., Allinjawi, A., Hammami, M. Student behavior analysis to measure engagement levels in online learning environments. Signal Image Video Process. 15 (7), 1387-1395 (2021).

- Belle, A., Hargraves, R. H., Najarian, K. An automated optimal engagement and attention detection system using electrocardiogram. Comput Math Methods Med. 2012, 528781 (2012).

- Alban, A. Q., et al. Heart rate as a predictor of challenging behaviours among children with autism from wearable sensors in social robot interactions. Robotics. 12 (2), 55 (2023).

- Kajiwara, Y., Shimauchi, T., Kimura, H. Predicting emotion and engagement of workers in order picking based on behavior and pulse waves acquired by wearable devices. Sensors. 19 (1), 165 (2019).

- Costante, G., Porzi, L., Lanz, O., Valigi, P., Ricci, E. Personalizing a smartwatch-based gesture interface with transfer learning. , 2530-2534 (2014).

- Mekruksavanich, S., Jitpattanakul, A. Deep convolutional neural network with RNNs for complex activity recognition using wrist-worn wearable sensor data. Electronics. 10 (14), 1685 (2021).

- Bazarevsky, V., Kartynnik, Y., Vakunov, A., Raveendran, K., Grundmann, M. BlazeFace: Sub-millisecond Neural Face Detection on Mobile GPUs. arXiv. , (2019).

- Bazarevsky, V., et al. BlazePose: On-device Real-time Body Pose tracking. arXiv. , (2020).

- Mejia-Escobar, C., Cazorla, M., Martinez-Martin, E. Towards a better performance in facial expression recognition: a data-centric approach. Comput Intelligence Neurosci. , (2023).

- El-Garem, A., Adel, R. Applying systematic literature review and Delphi methods to explore digital transformation key success factors. Int J Eco Mgmt Engi. 16 (7), 383-389 (2022).

- Indumathi, V., Kist, A. A. Using electroencephalography to determine student attention in the classroom. , 1-3 (2023).

- Ma, X., Xie, Y., Wang, H. Research on the construction and application of teacher-student interaction evaluation system for smart classroom in the post COVID-19. Studies Edu Eval. 78, 101286 (2023).

- Andersen, D. Constructing Delphi statements for technology foresight. Futures Foresight Sci. 5 (2), e144 (2022).

- Khodyakov, D., et al. Disciplinary trends in the use of the Delphi method: A bibliometric analysis. PLoS One. 18 (8), e0289009 (2023).

- Martins, A. I., et al. Consensus on the Terms and Procedures for Planning and Reporting a Usability Evaluation of Health-Related Digital Solutions: Delphi Study and a Resulting Checklist. J Medical Internet Res. 25, e44326 (2023).

- Dalmaso, M., Castelli, L., Galfano, G. Social modulators of gaze-mediated orienting of attention: A review. Psychon Bull Rev. 27 (5), 833-855 (2020).

- Klein, R. M. Thinking about attention: Successive approximations to a productive taxonomy. Cognition. 225, 105137 (2022).

- Schindler, S., Bublatzky, F. Attention and emotion: An integrative review of emotional face processing as a function of attention. Cortex. 130, 362-386 (2020).

- Zaletelj, J., Košir, A. Predicting students' attention in the classroom from Kinect facial and body features. J Image Video Proc. 80, (2017).

- Strauch, C., Wang, C. A., Einhäuser, W., Van der Stigchel, S., Naber, M. Pupillometry as an integrated readout of distinct attentional networks. Trends Neurosci. 45 (8), 635-647 (2022).

Reprints and Permissions

Request permission to reuse the text or figures of this JoVE article

Request PermissionExplore More Articles

This article has been published

Video Coming Soon

Copyright © 2025 MyJoVE Corporation. All rights reserved