需要订阅 JoVE 才能查看此. 登录或开始免费试用。

Method Article

基于人工智能的系统,用于检测学生的注意力水平

摘要

本文提出了一种基于人工智能的系统,可以自动检测学生是否在专心致志地上课或分心。该系统旨在帮助教师保持学生的注意力,优化他们的课程,并动态地引入修改,以使他们更具吸引力。

摘要

通过使用人工智能 (AI) 技术,可以提高课堂上学生的注意力水平。通过自动识别注意力水平,教师可以采用策略来重新吸引学生的注意力。这可以通过各种信息来源来实现。

一个来源是分析学生脸上反映的情绪。人工智能可以检测情绪,如中性、厌恶、惊讶、悲伤、恐惧、快乐和愤怒。此外,学生注视的方向也可以潜在地表明他们的注意力水平。另一个来源是观察学生的身体姿势。通过使用摄像头和深度学习技术,可以分析姿势以确定注意力水平。例如,懒洋洋地躺着或把头靠在桌子上的学生可能注意力较低。分发给学生的智能手表可以提供生物识别和其他数据,包括心率和惯性测量,这些数据也可以用作注意力指标。通过结合这些信息源,可以训练人工智能系统来识别课堂上的注意力水平。然而,集成不同类型的数据带来了一个挑战,需要创建带标签的数据集。参考专家意见和现有研究,以确保准确标记。在本文中,我们提出了将此类测量结果集成并创建数据集和潜在注意力分类器的建议。为了向老师提供反馈,我们探索了各种方法,例如智能手表或直接计算机。一旦教师意识到注意力问题,他们就可以调整他们的教学方法,以重新吸引和激励学生。总的来说,人工智能技术可以通过分析学生的情绪、注视方向、身体姿势和生物特征数据来自动识别他们的注意力水平。这些信息可以帮助教师优化教学过程。

引言

在现代教育环境中,准确评估和保持学生的注意力对于有效的教学和学习至关重要。然而,衡量敬业度的传统方法,如自我报告或主观的教师观察,既耗时又容易产生偏见。为了应对这一挑战,人工智能 (AI) 技术已成为自动注意力检测的有前途的解决方案。了解学生参与水平的一个重要方面是情绪识别1。人工智能系统可以分析面部表情来识别情绪,如中性、厌恶、惊讶、悲伤、恐惧、快乐和愤怒2.

注视方向和身体姿势也是学生注意力的重要指标3.通过利用摄像头和先进的机器学习算法,人工智能系统可以准确跟踪学生的视线,并分析他们的身体姿势,以检测出不感兴趣或疲劳的迹象4.此外,结合生物识别数据可以提高注意力检测的准确性和可靠性5.通过学生佩戴的智能手表收集心率和血氧饱和度水平等测量值,可以获得客观的注意力指标,从而补充其他信息来源。

本文提出了一种系统,该系统使用彩色相机和其他不同的传感器评估个人的注意力水平。它结合了情绪识别、视线方向分析、身体姿势评估和生物识别数据,为教育工作者提供了一套全面的工具,用于优化教学过程和提高学生参与度。通过使用这些工具,教育工作者可以全面了解教学过程并提高学生的参与度,从而优化整体教育体验。通过应用人工智能技术,甚至可以自动评估这些数据。

这项工作的主要目标是描述一个系统,该系统使我们能够捕获所有信息,并在捕获后训练一个人工智能模型,使我们能够实时获得整个班级的注意力。尽管其他工作已经提出使用视觉或情感信息来吸引注意力6,但这项工作建议结合使用这些技术,这提供了一种整体方法,允许使用更复杂和有效的人工智能技术。此外,迄今为止可用的数据集仅限于一组视频或生物识别数据之一。文献中没有提供完整数据的数据集,包括学生面部或身体的图像、生物特征数据、教师位置数据等。使用此处介绍的系统,可以捕获这种类型的数据集。

该系统在每个时间点将注意力水平与每个学生相关联。该值是 0% 到 100% 之间的注意力概率值,可以解释为低水平注意力 (0%-40%)、中等注意力水平 (40%-75%) 和高水平注意力 (75%-100%)。在整篇文章中,这种注意力的概率被称为注意力水平、学生的注意力,或者学生是否分心,但这些都与我们系统的相同输出值有关。

多年来,由于其有可能彻底改变教育,自动参与检测领域取得了显着增长。研究人员为这一研究领域提出了各种方法。

马等[7 ]介绍了一种基于神经图灵机的自动参与识别新方法。他们提取了某些特征,如眼睛凝视、面部动作单位、头部姿势和身体姿势,以创建参与识别的综合表示。

EyeTab8 是另一个创新系统,它使用模型来估计某人用双眼看向哪里。它是专门为在标准平板电脑上顺利运行而设计的,无需任何修改。该系统利用众所周知的算法来处理图像和分析计算机视觉。他们的视线估计管道包括一个类似Haar的基于特征的眼睛检测器,以及一个基于RANSAC的角膜缘椭圆拟合方法。

Sanghvi 等人 9 提出了一种方法,该方法依赖于基于视觉的技术,从侧视图录制的视频中自动提取富有表现力的姿势特征,捕捉儿童的行为。进行了初步评估,涉及使用情境化情感姿势表达的多个识别模型的训练。获得的结果表明,姿势行为模式可以有效地预测儿童与机器人的互动。

在其他工作中,例如Gupta等人[10],采用基于深度学习的方法,通过分析在线学习者的面部表情并对他们的情绪进行分类来检测在线学习者的实时参与度。该方法利用面部情绪识别来计算参与指数 (EI),该指数预测两种参与状态:参与和脱离。对包括 Inception-V3、VGG19 和 ResNet-50 在内的各种深度学习模型进行评估和比较,以确定最有效的实时参与度检测预测分类模型。

在Altuwairqi等人[11]中,研究人员提出了一种新颖的自动多模式方法,用于实时评估学生的参与度。为了确保准确可靠的测量结果,该团队整合并分析了三种不同的模式来捕捉学生的行为:情绪的面部表情、键盘击键和鼠标移动。

Guillén 等人 [12 ] 提出开发一种监测系统,该系统使用心电图 (ECG) 作为主要生理信号来分析和预测个体在执行任务时是否存在认知注意力。

Alban 等人 [13 ] 利用神经网络 (NN) 通过分析不同参与者在时域和频域中的心率 (HR) 和皮肤电活动 (EDA) 值来检测情绪。他们发现,连续差值均方根 (RMSDD) 和标准差正常与正常 (SDNN) 间间的增加,加上平均心率的降低,表明交感神经系统的活动增加,这与恐惧有关。

Kajiwara 等人 [14 ] 提出了一种创新系统,该系统采用可穿戴传感器和深度神经网络来预测工人的情绪和参与度水平。该系统遵循三个步骤。最初,可穿戴传感器捕获并收集有关行为和脉搏波的数据。随后,根据获取的行为和生理数据计算时间序列特征。最后,深度神经网络用于输入时间序列特征,并对个人的情绪和参与水平进行预测。

在其他研究中,如Costante等人[15],提出了一种基于新型迁移度量学习算法的方法,该算法利用预定义手势集的先验知识来增强对用户定义手势的识别。这种改进是通过对额外训练样本的最小依赖来实现的。同样,提出了一种基于传感器的人类活动识别框架16 ,以解决对复杂人类活动的非个人识别的目标。从腕戴式传感器收集的信号数据被用于开发的人类活动识别框架,采用四种基于 RNN 的 DL 模型(长短期记忆、双向长短期记忆、门控循环单元和双向门控循环单元)来研究可穿戴设备用户执行的活动。

研究方案

以下协议遵循阿利坎特大学人类研究伦理委员会的指导方针,批准的协议编号为 UA-2022-11-12。已获得本实验和在此处使用数据的所有参与者的知情同意。

1. 硬件、软件和类设置

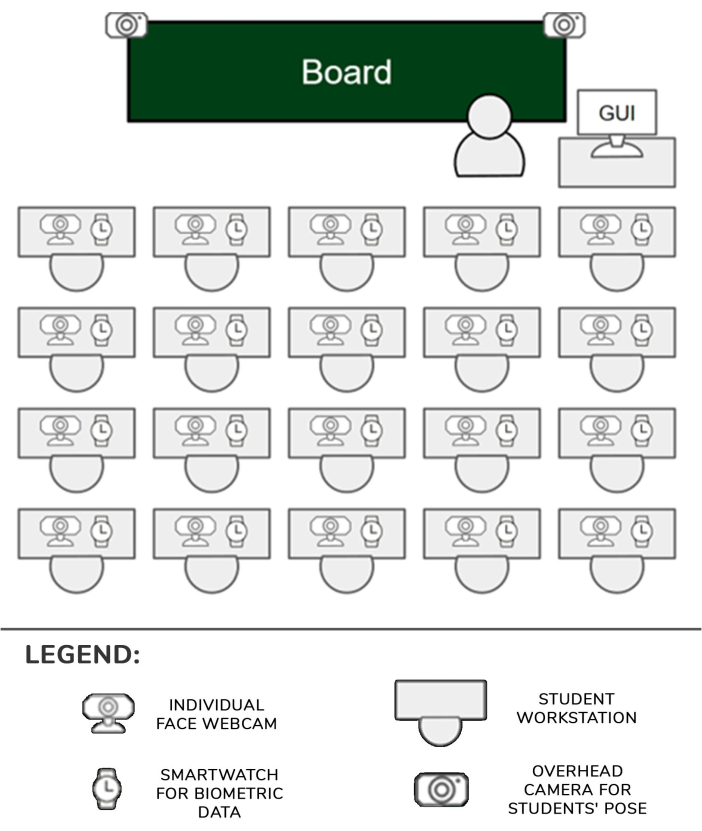

- 在所需位置设置具有WiFi功能的路由器(实验是使用DLink DSR 1000AC进行的),以便其范围覆盖整个房间。在这里,覆盖了 25 m2 的教室,可容纳 30 名学生。

- 为每个学生位置设置一个智能手表(这里是三星 Galaxy Smartwatch 5)和一个摄像头(这里是罗技 C920 摄像头)。为每两名学生设置一个嵌入式设备。将两个摄像头固定在两个三脚架上,并将它们连接到另一个嵌入式设备(以下简称天顶摄像头)。

- 通过 USB 链接将相机连接到相应的嵌入式设备并打开它们。 同时打开智能手表。将每个嵌入式设备和智能手表连接到步骤 1.1 中设置的路由器的 WiFi 网络。

- 将摄像头放在每个学生课桌的一角,将它们指向前方并略微向上倾斜,以便在图像中清楚地看到学生的脸部。

- 将带有摄像头的两个三脚架放在教室第一排座位最靠近过道的课桌前。将三脚架立管移动到最高位置,以便摄像头可以清楚地看到大部分学生。每个嵌入式设备将能够管理一到两个学生,以及他们各自的摄像头和手表。设置如图 1 所示。

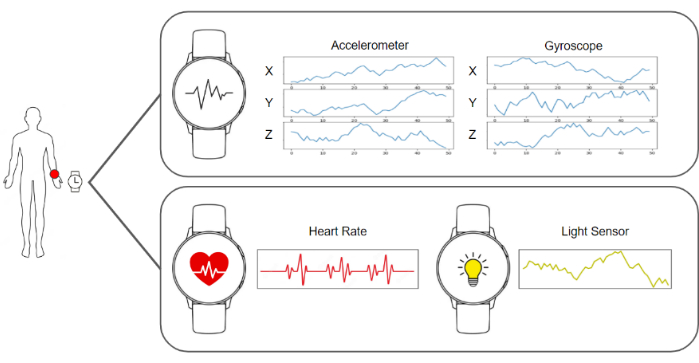

- 在智能手表和嵌入式设备中运行捕获软件,以便它们准备好发送图像和加速度计、陀螺仪、心率和照明数据。运行收集和存储数据的服务器软件。所有这些元素的图表如图 2 所示。

- 确保天顶摄像机占据现场,以便他们能够清楚地看到学生的身体。在每个学生面前放置一个额外的独立摄像头。

- 让学生坐在自己的位置上,告诉他们实验的目标,并指导他们把智能手表戴在他们的惯用手上,不要与设置的任何元素互动。

- 开始在服务器中捕获和收集数据,并像往常一样恢复课堂课程。

图 1:硬件和数据管道。 摄像头和智能手表数据被收集并馈送到机器学习算法进行处理。 请点击这里查看此图的较大版本.

图 2:传感器、教师和学生的位置。 该图显示了摄像头、智能手表和 GUI 在教室中与教师和学生的位置。 请点击这里查看此图的较大版本.

2. 捕获和数据处理管道

注意:所有这些步骤都是通过处理服务器中部署的软件自动执行的。这项工作中用于实验的实现是用 Python 3.8 编写的。

- 通过从智能手表收集每个学生的所有图像和生物识别数据来收集所需数据,并构建一个包含 1 秒数据的数据帧。该数据框由来自单个摄像头的一张图像、来自每个天顶摄像头的一张图像(本例中为两个)、三个陀螺仪值的 50 个寄存器、三个加速度计值的 50 个寄存器、一个心率值和一个光照条件值组成。

- 要计算头部方向,第一步是使用指向学生面部的网络摄像头并检索图像。然后,该图像由 BlazeFace17 地标估计算法进行处理。这种算法的输出是对应于面部特定区域的 2D 关键点列表。

- 利用算法提供的眼睛、鼻子、嘴巴和下巴的估计位置,使用 OpenCV 库的 cv::SolvePnPMethod 方法求解透视 n 点问题,这是一种规范的人脸设置。定义头部方向的旋转矩阵是此过程的结果。

- 通过将描绘学生的数据帧中的天顶图像转发到 BlazePose18 地标估计算法来计算身体姿势,并检索图像中描绘的身体关节的 2D 坐标列表。此地标列表描述了学生的姿势。

注意:身体姿势很重要,因为它可以准确地代表学生在课堂上参与不同活动的程度。例如,如果学生自然而然地坐着,双手放在桌子上,这可能意味着他们正在做笔记。相反,如果他们不断移动手臂,这可能意味着他们正在与某人交谈。 - 获取学生面部图像并执行对齐预处理。从步骤 2.3 中计算的列表中检索眼睛的关键点,并将它们投影到图像平面上,从而获得眼睛的位置。

- 追踪连接双眼位置的虚拟向量。计算该矢量与水平线之间的角度,并构建单调矩阵,将反向角度应用于图像和关键点,使眼睛水平对齐。

- 使用关键点裁剪面部以检测其极限,并将补丁提供给情绪检测卷积神经网络19。从网络中检索输出,这是一个有 7 个位置的向量,每个位置给出了面部显示七种基本情绪之一的概率:中性、快乐、厌恶、愤怒、害怕、惊讶和悲伤。

- 通过从数据帧获取加速度计、陀螺仪和心率数据来测量注意力水平(图 3)。

- 将代表性结果中描述的基于深度学习的模型与加速度计和陀螺仪数据流一起输入,该模型是从头开始构建和训练的。从模型中检索输出,该向量是一个具有 4 个位置的向量,每个位置给出的数据概率表示以下可能的操作之一:手写、在键盘上打字、使用移动电话或休息,如图 4 所示。

- 通过合并头部方向、情绪识别输出、身体姿势以及陀螺仪、加速度计和心率数据,将先前系统的所有结果线性化,为最终的注意力分类器提供线性化。从此最终分类器中检索结果,该分类器的分数从 0 到 100。将此连续值分类为三个可能的离散注意力类别之一:低水平注意力 (0-40%)、中等注意力水平 (40%-75%) 和高水平注意力 (75% - 100%)。生成的数据集结构如 表1所示。

- 使用教师计算机的图形用户界面 (GUI) 向教师显示注意力水平的结果,该界面可从常规 Web 浏览器访问。

图 3:智能手表捕获的数据。 智能手表以数据流的形式提供陀螺仪、加速度计、心率和光线状况。 请点击这里查看此图的较大版本.

图 4:活动识别模型考虑的类别示例。 活动识别模型可识别四种不同的动作:手写、在键盘上打字、使用智能手机和休息姿势。 请点击这里查看此图的较大版本.

结果

本研究的目标群体是本科生和硕士生,因此主要年龄组年龄在 18 至 25 岁之间。之所以选择这个群体,是因为与年轻学生相比,他们可以以更少的干扰处理电子设备。该小组总共包括25人。这个年龄组可以提供最可靠的结果来检验提案。

向教师展示的注意力水平结果有 2 个部分。结果的 A 部分显示了有关每个学生当前注意力水平的个人信息。然后,B 部分旨在获得整个班级的?...

讨论

这项工作提出了一个系统,该系统使用摄像头、智能手表和人工智能算法来测量教室中学生的注意力水平。这些信息随后被呈现给老师,以便他们了解班级的总体状态。

该协议的主要关键步骤之一是将智能手表信息与彩色相机图像同步,因为它们具有不同的频率。通过将覆盆子部署为服务器,这些服务器从智能手表和相机接收带有各自时间戳的信息,并对这些信息进行粗略?...

披露声明

作者声明,他们没有已知的相互竞争的经济利益或个人关系,这些利益或个人关系可能会影响本文所报告的工作。

致谢

这项工作是在 Programa Prometeo 的资助下开发的,项目 ID CIPROM/2021/017。罗莎贝尔·罗伊格(Rosabel Roig)教授是联合国教科文组织“教育、研究和数字包容”的主席。

材料

| Name | Company | Catalog Number | Comments |

| 4 GPUs Nvidia A40 Ampere | NVIDIA | TCSA40M-PB | GPU for centralized model processing server |

| FusionServer 2288H V5 | X-Fusion | 02311XBK | Platform that includes power supply and motherboard for centralized model processing server |

| Memory Card Evo Plus 128 GB | Samsung | MB-MC128KA/EU | Memory card for the operation of the raspberry pi 4b 2gb. One for each raspberry. |

| NEMIX RAM - 512 GB Kit DDR4-3200 PC4-25600 8Rx4 EC | NEMIX | M393AAG40M32-CAE | RAM for centralized model processing server |

| Processor Intel Xeon Gold 6330 | Intel | CD8068904572101 | Processor for centralized model processing server |

| Raspberry PI 4B 2GB | Raspberry | 1822095 | Local server that receives requests from the clocks and sends them to the general server. One every two students. |

| Samsung Galaxy Watch 5 (40mm) | Samsung | SM-R900NZAAPHE | Clock that monitors each student's activity. For each student. |

| Samsung MZQL23T8HCLS-00B7C PM9A3 3.84Tb Nvme U.2 PCI-Express-4 x4 2.5inch Ssd | Samsung | MZQL23T8HCLS-00B7C | Internal storage for centralized model processing server |

| WebCam HD Pro C920 Webcam FullHD | Logitech | 960-001055 | Webcam HD. One for each student plus two for student poses. |

参考文献

- Hasnine, M. N., et al. Students' emotion extraction and visualization for engagement detection in online learning. Procedia Comp Sci. 192, 3423-3431 (2021).

- Khare, S. K., Blanes-Vidal, V., Nadimi, E. S., Acharya, U. R. Emotion recognition and artificial intelligence: A systematic review (2014-2023) and research recommendations. Info Fusion. 102, 102019 (2024).

- Bosch, N. Detecting student engagement: Human versus machine. UMAP '16: Proc the 2016 Conf User Model Adapt Personal. , 317-320 (2016).

- Araya, R., Sossa-Rivera, J. Automatic detection of gaze and body orientation in elementary school classrooms. Front Robot AI. 8, 729832 (2021).

- Lu, Y., Zhang, J., Li, B., Chen, P., Zhuang, Z. Harnessing commodity wearable devices for capturing learner engagement. IEEE Access. 7, 15749-15757 (2019).

- Vanneste, P., et al. Computer vision and human behaviour, emotion and cognition detection: A use case on student engagement. Mathematics. 9 (3), 287 (2021).

- Ma, X., Xu, M., Dong, Y., Sun, Z. Automatic student engagement in online learning environment based on neural Turing machine. Int J Info Edu Tech. 11 (3), 107-111 (2021).

- Wood, E., Bulling, A. EyeTab: model-based gaze estimation on unmodified tablet computers. ETRA '14: Proc Symp Eye Tracking Res Appl. , 207-210 (2014).

- Sanghvi, J., et al. Automatic analysis of affective postures and body motion to detect engagement with a game companion. HRI '11: Proc 6th Int Conf Human-robot Interact. , 205-211 (2011).

- Gupta, S., Kumar, P., Tekchandani, R. K. Facial emotion recognition based real-time learner engagement detection system in online learning context using deep learning models. Multimed Tools Appl. 82 (8), 11365-11394 (2023).

- Altuwairqi, K., Jarraya, S. K., Allinjawi, A., Hammami, M. Student behavior analysis to measure engagement levels in online learning environments. Signal Image Video Process. 15 (7), 1387-1395 (2021).

- Belle, A., Hargraves, R. H., Najarian, K. An automated optimal engagement and attention detection system using electrocardiogram. Comput Math Methods Med. 2012, 528781 (2012).

- Alban, A. Q., et al. Heart rate as a predictor of challenging behaviours among children with autism from wearable sensors in social robot interactions. Robotics. 12 (2), 55 (2023).

- Kajiwara, Y., Shimauchi, T., Kimura, H. Predicting emotion and engagement of workers in order picking based on behavior and pulse waves acquired by wearable devices. Sensors. 19 (1), 165 (2019).

- Costante, G., Porzi, L., Lanz, O., Valigi, P., Ricci, E. Personalizing a smartwatch-based gesture interface with transfer learning. , 2530-2534 (2014).

- Mekruksavanich, S., Jitpattanakul, A. Deep convolutional neural network with RNNs for complex activity recognition using wrist-worn wearable sensor data. Electronics. 10 (14), 1685 (2021).

- Bazarevsky, V., Kartynnik, Y., Vakunov, A., Raveendran, K., Grundmann, M. BlazeFace: Sub-millisecond Neural Face Detection on Mobile GPUs. arXiv. , (2019).

- Bazarevsky, V., et al. BlazePose: On-device Real-time Body Pose tracking. arXiv. , (2020).

- Mejia-Escobar, C., Cazorla, M., Martinez-Martin, E. Towards a better performance in facial expression recognition: a data-centric approach. Comput Intelligence Neurosci. , (2023).

- El-Garem, A., Adel, R. Applying systematic literature review and Delphi methods to explore digital transformation key success factors. Int J Eco Mgmt Engi. 16 (7), 383-389 (2022).

- Indumathi, V., Kist, A. A. Using electroencephalography to determine student attention in the classroom. , 1-3 (2023).

- Ma, X., Xie, Y., Wang, H. Research on the construction and application of teacher-student interaction evaluation system for smart classroom in the post COVID-19. Studies Edu Eval. 78, 101286 (2023).

- Andersen, D. Constructing Delphi statements for technology foresight. Futures Foresight Sci. 5 (2), e144 (2022).

- Khodyakov, D., et al. Disciplinary trends in the use of the Delphi method: A bibliometric analysis. PLoS One. 18 (8), e0289009 (2023).

- Martins, A. I., et al. Consensus on the Terms and Procedures for Planning and Reporting a Usability Evaluation of Health-Related Digital Solutions: Delphi Study and a Resulting Checklist. J Medical Internet Res. 25, e44326 (2023).

- Dalmaso, M., Castelli, L., Galfano, G. Social modulators of gaze-mediated orienting of attention: A review. Psychon Bull Rev. 27 (5), 833-855 (2020).

- Klein, R. M. Thinking about attention: Successive approximations to a productive taxonomy. Cognition. 225, 105137 (2022).

- Schindler, S., Bublatzky, F. Attention and emotion: An integrative review of emotional face processing as a function of attention. Cortex. 130, 362-386 (2020).

- Zaletelj, J., Košir, A. Predicting students' attention in the classroom from Kinect facial and body features. J Image Video Proc. 80, (2017).

- Strauch, C., Wang, C. A., Einhäuser, W., Van der Stigchel, S., Naber, M. Pupillometry as an integrated readout of distinct attentional networks. Trends Neurosci. 45 (8), 635-647 (2022).

转载和许可

请求许可使用此 JoVE 文章的文本或图形

请求许可探索更多文章

This article has been published

Video Coming Soon

版权所属 © 2025 MyJoVE 公司版权所有,本公司不涉及任何医疗业务和医疗服务。