Для просмотра этого контента требуется подписка на Jove Войдите в систему или начните бесплатную пробную версию.

Method Article

Система определения уровня внимания у учащихся на основе искусственного интеллекта

В этой статье

Резюме

В этой статье предлагается система на основе искусственного интеллекта для автоматического определения того, обращают ли студенты внимание на класс или отвлекаются. Эта система предназначена для того, чтобы помочь учителям удерживать внимание учеников, оптимизировать их уроки и динамически вносить изменения, чтобы они были более увлекательными.

Аннотация

Уровень внимания учащихся в классе может быть повышен с помощью методов искусственного интеллекта (ИИ). Автоматически определяя уровень внимания, учителя могут использовать стратегии для восстановления концентрации внимания учащихся. Этого можно достичь с помощью различных источников информации.

Одним из источников является анализ эмоций, отражающихся на лицах студентов. ИИ может обнаруживать эмоции, такие как нейтральность, отвращение, удивление, грусть, страх, счастье и гнев. Кроме того, направление взгляда учащихся также потенциально может указывать на уровень их внимания. Другой источник – наблюдение за положением тела учеников. С помощью камер и методов глубокого обучения можно анализировать осанку, чтобы определить уровень внимания. Например, учащиеся, которые сутулятся или кладут голову на парты, могут иметь более низкий уровень внимания. Умные часы, раздаваемые студентам, могут предоставлять биометрические и другие данные, включая частоту сердечных сокращений и инерционные измерения, которые также могут использоваться в качестве индикаторов внимания. Комбинируя эти источники информации, систему ИИ можно обучить определять уровень внимания в классе. Однако интеграция различных типов данных представляет собой проблему, требующую создания помеченного набора данных. Для точной маркировки мы обращаемся к экспертам и существующим исследованиям. В данной статье мы предлагаем интегрировать такие измерения и создать набор данных и классификатор потенциального внимания. Чтобы обеспечить обратную связь с учителем, мы изучаем различные методы, такие как умные часы или компьютеры с прямым управлением. Как только учитель осознает проблемы с вниманием, он может скорректировать свой подход к обучению, чтобы снова вовлечь и мотивировать учеников. Таким образом, методы искусственного интеллекта могут автоматически определять уровень внимания учащихся, анализируя их эмоции, направление взгляда, положение тела и биометрические данные. Эта информация может помочь учителям в оптимизации процесса преподавания и обучения.

Введение

В современных образовательных учреждениях точная оценка и удержание внимания учащихся имеет решающее значение для эффективного преподавания и обучения. Тем не менее, традиционные методы измерения вовлеченности, такие как самоотчетность или субъективные наблюдения учителя, отнимают много времени и подвержены предубеждениям. Для решения этой проблемы методы искусственного интеллекта (ИИ) стали многообещающими решениями для автоматизированного обнаружения внимания. Одним из важных аспектов понимания уровня вовлеченности учащихся является распознавание эмоций1. Системы искусственного интеллекта могут анализировать выражения лица для выявления таких эмоций, как нейтральность, отвращение, удивление, печаль, страх, счастье и гнев.

Направление взгляда и положение тела также являются важными показателями внимания учащихся3. Используя камеры и передовые алгоритмы машинного обучения, системы искусственного интеллекта могут точно отслеживать, куда смотрят учащиеся, и анализировать их положение тела, чтобы обнаружить признаки отсутствия интереса или усталости4. Кроме того, включение биометрических данных повышает точность и надежность обнаружения внимания5. Собирая измерения, такие как частота сердечных сокращений и уровень насыщения крови кислородом, с помощью умных часов, которые носят учащиеся, можно получить объективные показатели внимания, дополняющие другие источники информации.

В этой статье предлагается система, которая оценивает уровень внимания человека с помощью цветных камер и других различных сенсоров. Он сочетает в себе распознавание эмоций, анализ направления взгляда, оценку осанки тела и биометрические данные, чтобы предоставить преподавателям полный набор инструментов для оптимизации процесса преподавания и обучения и повышения вовлеченности учащихся. Используя эти инструменты, преподаватели могут получить всестороннее представление о процессе преподавания и обучения и повысить вовлеченность учащихся, тем самым оптимизируя общий образовательный опыт. Применяя методы искусственного интеллекта, можно даже автоматически оценивать эти данные.

Основная цель данной работы — описать систему, которая позволяет нам захватывать всю информацию и, будучи захваченной, обучать модель искусственного интеллекта, которая позволяет нам привлекать внимание всего класса в режиме реального времени. Хотя в других работах уже предлагалось привлекать внимание с помощью визуальной или эмоциональнойинформации6, в этой работе предлагается комбинированное использование этих методов, что обеспечивает целостный подход, позволяющий использовать более сложные и эффективные методы ИИ. Более того, доступные до сих пор наборы данных ограничены либо набором видео, либо набором биометрических данных. В литературе отсутствуют датасеты, предоставляющие полные данные с изображениями лица учащегося или его тела, биометрические данные, данные о должности учителя и т.д. С помощью представленной здесь системы можно захватывать этот тип набора данных.

Система связывает уровень внимания с каждым учеником в каждый момент времени. Это значение представляет собой вероятностное значение внимания в диапазоне от 0% до 100%, которое можно интерпретировать как низкий уровень внимания (0%-40%), средний уровень внимания (40%-75%) и высокий уровень внимания (75%-100%). На протяжении всего текста эта вероятность внимания называется уровнем внимания, вниманием учащихся или тем, отвлечены ли студенты или нет, но все они связаны с одним и тем же выходным значением нашей системы.

С годами область автоматического обнаружения вовлечения значительно выросла благодаря своему потенциалу революционизировать образование. Исследователи предложили различные подходы к этой области исследований.

Ma et al.7 представили новый метод, основанный на нейронной машине Тьюринга для автоматического распознавания вовлеченности. Они извлекли определенные особенности, такие как взгляд, мимические единицы действий, поза головы и поза тела, чтобы создать всеобъемлющее представление о распознавании вовлеченности.

EyeTab8, еще одна инновационная система, использовала модели для оценки того, куда человек смотрит обоими глазами. Он был специально сделан для бесперебойной работы на стандартном планшете без каких-либо модификаций. Эта система использует известные алгоритмы обработки изображений и анализа компьютерного зрения. Их конвейер оценки взгляда включает в себя детектор глаз на основе функций Haar, а также подход к подгонке лимба на основе RANSAC.

Sanghvi et al.9 предлагают подход, который опирается на методы, основанные на зрении, для автоматического извлечения выразительных постуральных черт из видео, записанных с бокового обзора, фиксируя поведение детей. Проводится первичная оценка, включающая обучение множественных моделей распознавания с использованием контекстуализированных аффективных постуральных выражений. Полученные результаты демонстрируют, что паттерны постурального поведения могут эффективно предсказывать взаимодействие детей с роботом.

В других работах, таких как Гупта и др.10, метод, основанный на глубоком обучении, используется для определения вовлеченности онлайн-учащихся в режиме реального времени путем анализа их мимики и классификации их эмоций. Этот подход использует распознавание эмоций лица для расчета индекса вовлеченности (EI), который предсказывает два состояния вовлеченности: вовлеченность и невовлеченность. Различные модели глубокого обучения, включая Inception-V3, VGG19 и ResNet-50, оцениваются и сравниваются, чтобы определить наиболее эффективную модель предиктивной классификации для обнаружения взаимодействия в режиме реального времени.

В работе Altuwairqi et al.11 исследователи представили новый автоматический мультимодальный подход к оценке уровня вовлеченности учащихся в режиме реального времени. Чтобы обеспечить точные и надежные измерения, команда интегрировала и проанализировала три различных модальности, которые фиксируют поведение учащихся: выражения лица для выражения эмоций, нажатия клавиш на клавиатуре и движения мыши.

Guillén et al.12 предлагают разработку системы мониторинга, которая использует электрокардиографию (ЭКГ) в качестве первичного физиологического сигнала для анализа и прогнозирования наличия или отсутствия когнитивного внимания у людей во время выполнения задачи.

Албан и др.13 используют нейронную сеть (НС) для обнаружения эмоций путем анализа значений частоты сердечных сокращений (ЧСС) и электрокожной активности (ЭДА) различных участников как во временной, так и в частотной областях. Они обнаружили, что увеличение среднеквадратичного значения последовательных различий (RMSDD) и интервалов стандартного отклонения от нормы к норме (SDNN) в сочетании со снижением среднего ЧСС указывает на повышенную активность в симпатической нервной системе, которая связана со страхом.

Кадживара и др.14 предлагают инновационную систему, которая использует носимые датчики и глубокие нейронные сети для прогнозирования уровня эмоций и вовлеченности работников. Система состоит из трех этапов. Первоначально носимые датчики захватывают и собирают данные о поведении и пульсовых волнах. Впоследствии на основе полученных поведенческих и физиологических данных рассчитываются особенности временных рядов. Наконец, глубокие нейронные сети используются для ввода характеристик временных рядов и прогнозирования эмоций человека и уровня вовлеченности.

В других исследованиях, таких как Costante et al.15, предлагается подход, основанный на новом алгоритме обучения на основе трансферной метрики, который использует предварительные знания о предопределенном наборе жестов для улучшения распознавания жестов, определенных пользователем. Это улучшение достигается при минимальной зависимости от дополнительных обучающих выборок. Аналогичным образом, для решения задачи безличного распознавания сложных видов человеческой деятельности представлена основанная на датчиках структура16 для решения задачи обезличенного распознавания сложных видов человеческой деятельности. Данные сигнала, собранные с датчиков, носимых на запястье, используются в разработанной среде распознавания человеческой активности с использованием четырех моделей DL на основе RNN (долгосрочная-краткосрочная память, двунаправленная долгосрочная-краткосрочная память, стробированные рекуррентные единицы и двунаправленные стробные рекуррентные единицы) для исследования действий, выполняемых пользователем носимого устройства.

протокол

Следующий протокол соответствует рекомендациям комитета по этике исследований человека Университета Аликанте с утвержденным протоколом No UA-2022-11-12. Информированное согласие всех участников было получено для проведения данного эксперимента и использования приведенных здесь данных.

1. Аппаратное и программное обеспечение и настройка классов

- Установите роутер с возможностями WiFi (эксперименты проводились с использованием DLink DSR 1000AC) в нужном месте так, чтобы его радиус действия охватывал всю комнату. Здесь были охвачены классные комнаты площадью 25м2 с 30 учениками.

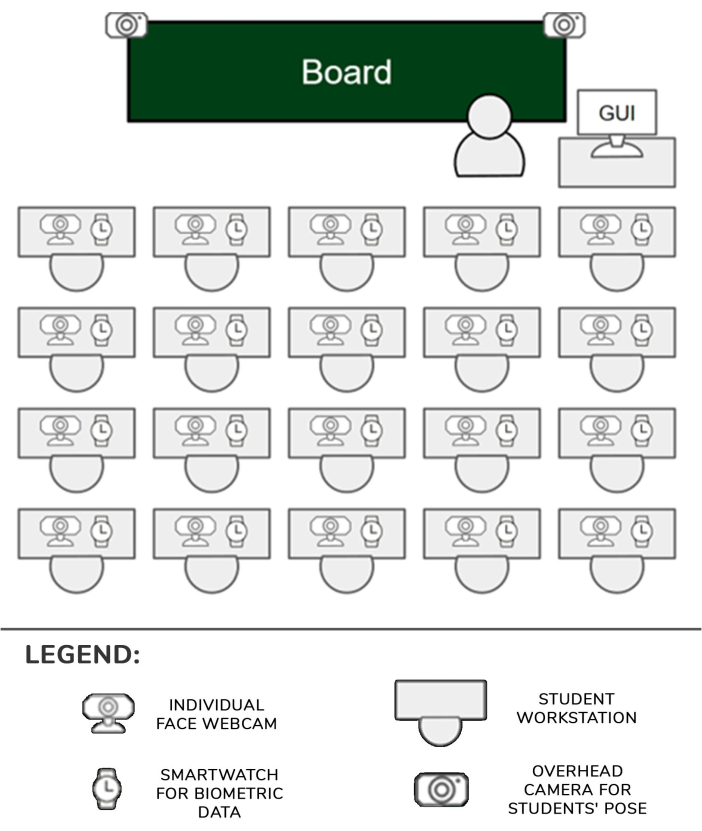

- Установите по одному смарт-часу (здесь Samsung Galaxy Smartwatch 5) и по одной камере (здесь камеры Logitech C920) для каждой локации ученика. Установите одно встроенное устройство для каждых двух учеников. Закрепите две камеры на двух штативах и подключите их к другому встроенному устройству (далее — зенитные камеры).

- Подключите камеры к соответствующим встроенным устройствам с помощью USB-соединения и включите их. Включите также смарт-часы. Подключите все встроенные устройства и смарт-часы к сети Wi-Fi роутера, настроенной на шаге 1.1.

- Поместите камеры в угол парты каждого ученика и направьте их вперед и слегка наклоните вверх так, чтобы лицо ученика было хорошо видно на изображениях.

- Поставьте два штатива с камерами перед партами, которые находятся ближе всего к проходам в первом ряду сидений в классе. Переместите подставку штатива в самое высокое положение, чтобы камеры могли четко видеть большинство учеников. Каждое встроенное устройство сможет управлять одним или двумя учениками, а также их соответствующими камерами и часами. Установка изображена на рисунке 1.

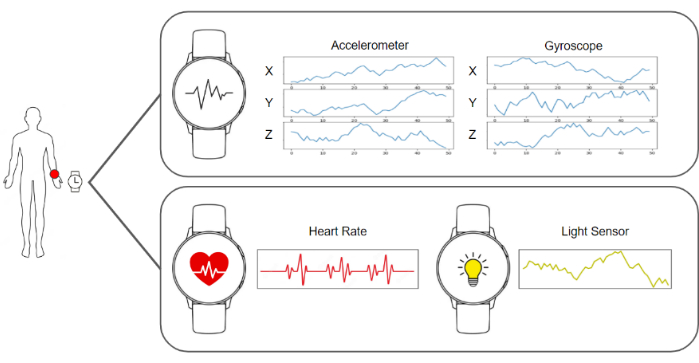

- Запустите программное обеспечение для захвата в умных часах и встроенных устройствах, чтобы они были готовы к отправке изображений и данных акселерометра, гироскопа, пульса и освещения. Запустите серверное программное обеспечение, которое собирает данные и хранит их. Схему всех этих элементов можно увидеть на рисунке 2.

- Убедитесь, что зенитные камеры доминируют над сценой, чтобы они могли хорошо видеть тела студентов. Поставьте перед каждым учеником дополнительную индивидуальную камеру.

- Пусть ученики сядут на свои места, расскажут им о целях эксперимента и проинструктируют их носить умные часы на доминирующей руке и не взаимодействовать ни с одним из элементов установки.

- Начните сбор и сбор данных на сервере и возобновите занятия в обычном режиме.

Рисунок 1: Аппаратное обеспечение и конвейер данных. Данные камер и умных часов собираются и подаются в алгоритмы машинного обучения для обработки. Пожалуйста, нажмите здесь, чтобы просмотреть увеличенную версию этой цифры.

Рисунок 2: Положение датчиков, учителя и учеников. Схема, показывающая расположение камер, смарт-часов и графического интерфейса пользователя в классе с учителем и учениками. Пожалуйста, нажмите здесь, чтобы просмотреть увеличенную версию этой цифры.

2. Конвейер захвата и обработки данных

ПРИМЕЧАНИЕ: Все эти шаги выполняются автоматически программным обеспечением, развернутым на сервере. Реализация, использованная для экспериментов в этой работе, была написана на Python 3.8.

- Соберите необходимые данные, собрав все изображения и биометрические данные с умных часов для каждого ученика, и постройте фрейм данных, включающий данные за 1 секунду. Этот кадр данных состоит из одного изображения с отдельной камеры, по одному изображению с каждой зенитной камеры (в данном случае двух), пятидесяти регистров трех значений гироскопа, пятидесяти регистров трех значений акселерометра, одного значения частоты сердечных сокращений и одного значения освещенности.

- Чтобы вычислить направление головы, первым делом необходимо использовать веб-камеру, направленную на лицо учащегося, и получить изображение. Затем это изображение обрабатывается алгоритмом оценки ориентиров BlazeFace17 . Результатом работы такого алгоритма является список 2D-ключевых точек, соответствующих конкретным областям лица.

- Используя предполагаемое положение глаз, носа, рта и подбородка, предоставленное алгоритмом, решите перспективную задачу n-точки с помощью метода cv::SolvePnPMethod библиотеки OpenCV, канонической настройки лица. В результате этой процедуры получается матрица вращения, определяющая направление головы.

- Вычислите позу тела путем пересылки зенитного изображения из кадра данных, в котором изображен учащийся, в алгоритм оценки ориентиров BlazePose18 и получите список 2D-координат суставов тела, изображенных на изображении. Этот список достопримечательностей описывает позу ученика.

ПРИМЕЧАНИЕ: Поза тела важна, так как она может точно отражать вовлеченность студента в различные виды деятельности во время занятия. Например, если ученик сидит естественно, положив руки на парту, это может означать, что он делает заметки. Напротив, если они постоянно двигают руками, это может означать, что они с кем-то разговаривают. - Получите изображение лица учащегося и выполните предварительную обработку выравнивания. Извлеките ключевые точки глаз из списка, вычисленного на шаге 2.3, и спроецируйте их на плоскость изображения, чтобы получить положение глаз.

- Обведите виртуальный вектор, соединяющий положение обоих глаз. Вычислите угол между этим вектором и горизонтальной линией и постройте матрицу гомографии, чтобы применить обратный угол к изображению и ключевым точкам так, чтобы глаза были выровнены горизонтально.

- Обрежьте лицо, используя ключевые точки для определения его пределов, и подайте патч в сверточную нейронную сеть19 для обнаружения эмоций. Получите выходные данные из сети, которые представляют собой вектор с 7 позициями, каждая из которых дает вероятность того, что лицо будет выражать одну из семи основных эмоций: нейтральность, счастье, отвращение, злость, испуг, удивление и грусть.

- Измерьте уровень внимания, получив данные акселерометра, гироскопа и частоты сердечных сокращений из кадра данных (рис. 3).

- Загрузите модель на основе глубокого обучения, которая была специально создана и обучена с нуля, описанную в репрезентативных результатах, с помощью потока данных акселерометра и гироскопа. Получите выходные данные модели, которые представляют собой вектор с 4 позициями, каждая из которых дает вероятность того, что данные представляют одно из следующих возможных действий: рукописный ввод, набор текста на клавиатуре, использование мобильного телефона или отдых, как показано на рисунке 4.

- Загрузите окончательный классификатор внимания с линеаризацией всех результатов из предыдущих систем путем объединения направления головы, вывода распознавания эмоций, позы тела, а также гироскопа, акселерометра и данных о частоте сердечных сокращений. Получите результаты из этого итогового классификатора, который имеет оценку от 0 до 100. Классифицируйте эту непрерывную величину по одной из трех возможных дискретных категорий внимания: низкий уровень внимания (0-40%), средний уровень внимания (40%-75%) и высокий уровень внимания (75% - 100%). Структура сгенерированного набора данных представлена в таблице 1.

- Показывайте результаты уровней внимания учителю с помощью графического пользовательского интерфейса (GUI) с компьютера учителя, доступного из обычного веб-браузера.

Рисунок 3: Данные, собранные умными часами. Умные часы предоставляют гироскоп, акселерометр, частоту сердечных сокращений и состояние света в виде потоков данных. Пожалуйста, нажмите здесь, чтобы просмотреть увеличенную версию этой цифры.

Рисунок 4: Примеры категорий, рассматриваемых моделью распознавания активности. Модель распознавания действий распознает четыре различных действия: рукописный ввод, ввод текста на клавиатуре, использование смартфона и положение в положении покоя. Пожалуйста, нажмите здесь, чтобы просмотреть увеличенную версию этой цифры.

Результаты

Целевой группой данного исследования являются студенты бакалавриата и магистратуры, поэтому основная возрастная группа – от 18 до 25 лет. Эта группа была выбрана потому, что они могут обращаться с электронными устройствами с меньшим количеством отвлекающих факторов, чем младшие школьн?...

Обсуждение

В данной работе представлена система, которая измеряет уровень внимания ученика в классе с помощью камер, умных часов и алгоритмов искусственного интеллекта. Эта информация впоследствии представляется учителю, чтобы он имел представление об общем состоянии класса.

Одн?...

Раскрытие информации

Авторы заявляют, что у них нет известных конкурирующих финансовых интересов или личных отношений, которые могли бы повлиять на работу, описанную в этой статье.

Благодарности

Работа выполнена при финансовой поддержке Programa Prometeo, идентификатор проекта CIPROM/2021/017. Профессор Розабель Роиг является председателем Программы ЮНЕСКО «Образование, исследования и цифровая инклюзия».

Материалы

| Name | Company | Catalog Number | Comments |

| 4 GPUs Nvidia A40 Ampere | NVIDIA | TCSA40M-PB | GPU for centralized model processing server |

| FusionServer 2288H V5 | X-Fusion | 02311XBK | Platform that includes power supply and motherboard for centralized model processing server |

| Memory Card Evo Plus 128 GB | Samsung | MB-MC128KA/EU | Memory card for the operation of the raspberry pi 4b 2gb. One for each raspberry. |

| NEMIX RAM - 512 GB Kit DDR4-3200 PC4-25600 8Rx4 EC | NEMIX | M393AAG40M32-CAE | RAM for centralized model processing server |

| Processor Intel Xeon Gold 6330 | Intel | CD8068904572101 | Processor for centralized model processing server |

| Raspberry PI 4B 2GB | Raspberry | 1822095 | Local server that receives requests from the clocks and sends them to the general server. One every two students. |

| Samsung Galaxy Watch 5 (40mm) | Samsung | SM-R900NZAAPHE | Clock that monitors each student's activity. For each student. |

| Samsung MZQL23T8HCLS-00B7C PM9A3 3.84Tb Nvme U.2 PCI-Express-4 x4 2.5inch Ssd | Samsung | MZQL23T8HCLS-00B7C | Internal storage for centralized model processing server |

| WebCam HD Pro C920 Webcam FullHD | Logitech | 960-001055 | Webcam HD. One for each student plus two for student poses. |

Ссылки

- Hasnine, M. N., et al. Students' emotion extraction and visualization for engagement detection in online learning. Procedia Comp Sci. 192, 3423-3431 (2021).

- Khare, S. K., Blanes-Vidal, V., Nadimi, E. S., Acharya, U. R. Emotion recognition and artificial intelligence: A systematic review (2014-2023) and research recommendations. Info Fusion. 102, 102019 (2024).

- Bosch, N. Detecting student engagement: Human versus machine. UMAP '16: Proc the 2016 Conf User Model Adapt Personal. , 317-320 (2016).

- Araya, R., Sossa-Rivera, J. Automatic detection of gaze and body orientation in elementary school classrooms. Front Robot AI. 8, 729832 (2021).

- Lu, Y., Zhang, J., Li, B., Chen, P., Zhuang, Z. Harnessing commodity wearable devices for capturing learner engagement. IEEE Access. 7, 15749-15757 (2019).

- Vanneste, P., et al. Computer vision and human behaviour, emotion and cognition detection: A use case on student engagement. Mathematics. 9 (3), 287 (2021).

- Ma, X., Xu, M., Dong, Y., Sun, Z. Automatic student engagement in online learning environment based on neural Turing machine. Int J Info Edu Tech. 11 (3), 107-111 (2021).

- Wood, E., Bulling, A. EyeTab: model-based gaze estimation on unmodified tablet computers. ETRA '14: Proc Symp Eye Tracking Res Appl. , 207-210 (2014).

- Sanghvi, J., et al. Automatic analysis of affective postures and body motion to detect engagement with a game companion. HRI '11: Proc 6th Int Conf Human-robot Interact. , 205-211 (2011).

- Gupta, S., Kumar, P., Tekchandani, R. K. Facial emotion recognition based real-time learner engagement detection system in online learning context using deep learning models. Multimed Tools Appl. 82 (8), 11365-11394 (2023).

- Altuwairqi, K., Jarraya, S. K., Allinjawi, A., Hammami, M. Student behavior analysis to measure engagement levels in online learning environments. Signal Image Video Process. 15 (7), 1387-1395 (2021).

- Belle, A., Hargraves, R. H., Najarian, K. An automated optimal engagement and attention detection system using electrocardiogram. Comput Math Methods Med. 2012, 528781 (2012).

- Alban, A. Q., et al. Heart rate as a predictor of challenging behaviours among children with autism from wearable sensors in social robot interactions. Robotics. 12 (2), 55 (2023).

- Kajiwara, Y., Shimauchi, T., Kimura, H. Predicting emotion and engagement of workers in order picking based on behavior and pulse waves acquired by wearable devices. Sensors. 19 (1), 165 (2019).

- Costante, G., Porzi, L., Lanz, O., Valigi, P., Ricci, E. Personalizing a smartwatch-based gesture interface with transfer learning. , 2530-2534 (2014).

- Mekruksavanich, S., Jitpattanakul, A. Deep convolutional neural network with RNNs for complex activity recognition using wrist-worn wearable sensor data. Electronics. 10 (14), 1685 (2021).

- Bazarevsky, V., Kartynnik, Y., Vakunov, A., Raveendran, K., Grundmann, M. BlazeFace: Sub-millisecond Neural Face Detection on Mobile GPUs. arXiv. , (2019).

- Bazarevsky, V., et al. BlazePose: On-device Real-time Body Pose tracking. arXiv. , (2020).

- Mejia-Escobar, C., Cazorla, M., Martinez-Martin, E. Towards a better performance in facial expression recognition: a data-centric approach. Comput Intelligence Neurosci. , (2023).

- El-Garem, A., Adel, R. Applying systematic literature review and Delphi methods to explore digital transformation key success factors. Int J Eco Mgmt Engi. 16 (7), 383-389 (2022).

- Indumathi, V., Kist, A. A. Using electroencephalography to determine student attention in the classroom. , 1-3 (2023).

- Ma, X., Xie, Y., Wang, H. Research on the construction and application of teacher-student interaction evaluation system for smart classroom in the post COVID-19. Studies Edu Eval. 78, 101286 (2023).

- Andersen, D. Constructing Delphi statements for technology foresight. Futures Foresight Sci. 5 (2), e144 (2022).

- Khodyakov, D., et al. Disciplinary trends in the use of the Delphi method: A bibliometric analysis. PLoS One. 18 (8), e0289009 (2023).

- Martins, A. I., et al. Consensus on the Terms and Procedures for Planning and Reporting a Usability Evaluation of Health-Related Digital Solutions: Delphi Study and a Resulting Checklist. J Medical Internet Res. 25, e44326 (2023).

- Dalmaso, M., Castelli, L., Galfano, G. Social modulators of gaze-mediated orienting of attention: A review. Psychon Bull Rev. 27 (5), 833-855 (2020).

- Klein, R. M. Thinking about attention: Successive approximations to a productive taxonomy. Cognition. 225, 105137 (2022).

- Schindler, S., Bublatzky, F. Attention and emotion: An integrative review of emotional face processing as a function of attention. Cortex. 130, 362-386 (2020).

- Zaletelj, J., Košir, A. Predicting students' attention in the classroom from Kinect facial and body features. J Image Video Proc. 80, (2017).

- Strauch, C., Wang, C. A., Einhäuser, W., Van der Stigchel, S., Naber, M. Pupillometry as an integrated readout of distinct attentional networks. Trends Neurosci. 45 (8), 635-647 (2022).

Перепечатки и разрешения

Запросить разрешение на использование текста или рисунков этого JoVE статьи

Запросить разрешениеСмотреть дополнительные статьи

This article has been published

Video Coming Soon

Авторские права © 2025 MyJoVE Corporation. Все права защищены