Se requiere una suscripción a JoVE para ver este contenido. Inicie sesión o comience su prueba gratuita.

Method Article

Sistema basado en inteligencia artificial para detectar los niveles de atención en estudiantes

En este artículo

Resumen

Este artículo propone un sistema basado en inteligencia artificial para detectar automáticamente si los estudiantes están prestando atención a la clase o están distraídos. Este sistema está diseñado para ayudar a los profesores a mantener la atención de los estudiantes, optimizar sus lecciones e introducir modificaciones dinámicamente para que sean más atractivas.

Resumen

El nivel de atención de los estudiantes en un aula se puede mejorar mediante el uso de técnicas de Inteligencia Artificial (IA). Al identificar automáticamente el nivel de atención, los maestros pueden emplear estrategias para recuperar la concentración de los estudiantes. Esto se puede lograr a través de diversas fuentes de información.

Una de las fuentes es analizar las emociones reflejadas en los rostros de los estudiantes. La IA puede detectar emociones, como la neutralidad, el disgusto, la sorpresa, la tristeza, el miedo, la felicidad y la ira. Además, la dirección de la mirada de los estudiantes también puede indicar su nivel de atención. Otra fuente es observar la postura corporal de los estudiantes. Mediante el uso de cámaras y técnicas de aprendizaje profundo, se puede analizar la postura para determinar el nivel de atención. Por ejemplo, los estudiantes que están encorvados o descansando la cabeza en sus escritorios pueden tener un nivel más bajo de atención. Los relojes inteligentes distribuidos a los estudiantes pueden proporcionar datos biométricos y de otro tipo, incluidas mediciones de frecuencia cardíaca e inercial, que también se pueden usar como indicadores de atención. Al combinar estas fuentes de información, se puede entrenar un sistema de IA para identificar el nivel de atención en el aula. Sin embargo, la integración de los diferentes tipos de datos plantea un desafío que requiere la creación de un conjunto de datos etiquetado. Se consultan los aportes de los expertos y los estudios existentes para un etiquetado preciso. En este trabajo, proponemos la integración de dichas mediciones y la creación de un conjunto de datos y un clasificador de atención potencial. Para proporcionar retroalimentación al profesor, exploramos varios métodos, como los relojes inteligentes o los ordenadores directos. Una vez que el profesor se da cuenta de las dificultades de atención, puede ajustar su enfoque de enseñanza para volver a involucrar y motivar a los estudiantes. En resumen, las técnicas de IA pueden identificar automáticamente el nivel de atención de los estudiantes mediante el análisis de sus emociones, la dirección de la mirada, la postura corporal y los datos biométricos. Esta información puede ayudar a los profesores a optimizar el proceso de enseñanza-aprendizaje.

Introducción

En los entornos educativos modernos, evaluar y mantener con precisión la atención de los estudiantes es crucial para una enseñanza y un aprendizaje eficaces. Sin embargo, los métodos tradicionales para medir el compromiso, como el autoinforme o las observaciones subjetivas de los docentes, requieren mucho tiempo y son propensos a sesgos. Para hacer frente a este reto, las técnicas de Inteligencia Artificial (IA) han surgido como soluciones prometedoras para la detección automatizada de la atención. Un aspecto importante para comprender los niveles de participación de los estudiantes es el reconocimiento de emociones1. Los sistemas de IA pueden analizar las expresiones faciales para identificar emociones, como neutral, disgusto, sorpresa, tristeza, miedo, felicidad e ira2.

La dirección de la mirada y la postura corporal también son indicadores cruciales de la atención de los estudiantes3. Mediante el uso de cámaras y algoritmos avanzados de aprendizaje automático, los sistemas de IA pueden rastrear con precisión dónde miran los estudiantes y analizar su postura corporal para detectar signos de desinterés o fatiga. Además, la incorporación de datos biométricos mejora la precisión y fiabilidad de la detección de la atención5. Al recopilar mediciones, como la frecuencia cardíaca y los niveles de saturación de oxígeno en sangre, a través de relojes inteligentes que usan los estudiantes, se pueden obtener indicadores objetivos de atención, complementando otras fuentes de información.

Este artículo propone un sistema que evalúa el nivel de atención de un individuo utilizando cámaras a color y otros sensores diferentes. Combina el reconocimiento de emociones, el análisis de la dirección de la mirada, la evaluación de la postura corporal y los datos biométricos para proporcionar a los educadores un conjunto completo de herramientas para optimizar el proceso de enseñanza-aprendizaje y mejorar la participación de los estudiantes. Al emplear estas herramientas, los educadores pueden obtener una comprensión integral del proceso de enseñanza-aprendizaje y mejorar la participación de los estudiantes, optimizando así la experiencia educativa general. Mediante la aplicación de técnicas de IA, incluso es posible evaluar automáticamente estos datos.

El objetivo principal de este trabajo es describir el sistema que nos permite capturar toda la información y, una vez capturada, entrenar un modelo de IA que nos permita obtener la atención de toda la clase en tiempo real. Aunque otros trabajos ya han propuesto capturar la atención utilizando información visual o emocional6, este trabajo propone el uso combinado de estas técnicas, lo que proporciona un enfoque holístico para permitir el uso de técnicas de IA más complejas y efectivas. Además, los conjuntos de datos disponibles hasta ahora se limitan a un conjunto de vídeos o a uno de datos biométricos. La literatura no incluye conjuntos de datos que aporten datos completos con imágenes de la cara del alumno o de su cuerpo, datos biométricos, datos sobre la posición del profesor, etcétera. Con el sistema que se presenta aquí, es posible capturar este tipo de conjunto de datos.

El sistema asocia un nivel de atención a cada alumno en cada momento. Este valor es un valor de probabilidad de atención entre 0% y 100%, que puede interpretarse como un nivel de atención bajo (0%-40%), un nivel de atención medio (40%-75%) y un nivel de atención alto (75%-100%). A lo largo del texto, esta probabilidad de atención se refiere al nivel de atención, la atención del alumno, o si los alumnos están distraídos o no, pero todos estos están relacionados con el mismo valor de salida de nuestro sistema.

A lo largo de los años, el campo de la detección automática de interacciones ha crecido significativamente debido a su potencial para revolucionar la educación. Los investigadores han propuesto varios enfoques para esta área de estudio.

Ma et al.7 introdujeron un método novedoso basado en una máquina de Turing neuronal para el reconocimiento automático del compromiso. Extrajeron ciertas características, como la mirada, las unidades de acción facial, la postura de la cabeza y la postura del cuerpo, para crear una representación completa del reconocimiento de la participación.

EyeTab8, otro sistema innovador, utilizó modelos para estimar hacia dónde está mirando alguien con ambos ojos. Fue especialmente hecho para funcionar sin problemas en una tableta estándar sin modificaciones. Este sistema aprovecha algoritmos bien conocidos para el procesamiento de imágenes y el análisis de la visión artificial. Su canal de estimación de la mirada incluye un detector ocular basado en características similar a Haar, así como un enfoque de ajuste de elipse del limbo basado en RANSAC.

Sanghvi et al.9 proponen un enfoque que se basa en técnicas basadas en la visión para extraer automáticamente los rasgos posturales expresivos de los vídeos grabados desde una vista lateral, capturando el comportamiento de los niños. Se lleva a cabo una evaluación inicial, que implica el entrenamiento de múltiples modelos de reconocimiento utilizando expresiones posturales afectivas contextualizadas. Los resultados obtenidos demuestran que los patrones de comportamiento postural pueden predecir eficazmente el compromiso de los niños con el robot.

En otros trabajos, como el de Gupta et al.10, se emplea un método basado en el aprendizaje profundo para detectar la participación en tiempo real de los estudiantes en línea mediante el análisis de sus expresiones faciales y la clasificación de sus emociones. El enfoque utiliza el reconocimiento facial de emociones para calcular un índice de compromiso (IE) que predice dos estados de compromiso: comprometido y desvinculado. Se evalúan y comparan varios modelos de aprendizaje profundo, incluidos Inception-V3, VGG19 y ResNet-50, para identificar el modelo de clasificación predictiva más eficaz para la detección de interacciones en tiempo real.

En Altuwairqi et al.11, los investigadores presentan un novedoso enfoque multimodal automático para evaluar los niveles de participación de los estudiantes en tiempo real. Para garantizar mediciones precisas y confiables, el equipo integró y analizó tres modalidades distintas que capturan los comportamientos de los estudiantes: expresiones faciales para las emociones, pulsaciones de teclas del teclado y movimientos del mouse.

Guillén et al.12 proponen el desarrollo de un sistema de monitorización que utiliza la electrocardiografía (ECG) como señal fisiológica primaria para analizar y predecir la presencia o ausencia de atención cognitiva en los individuos mientras realizan una tarea.

Alban et al.13 utilizan una red neuronal (NN) para detectar emociones mediante el análisis de los valores de frecuencia cardíaca (FC) y actividad electrodérmica (EDA) de varios participantes tanto en el dominio del tiempo como en el de la frecuencia. Descubrieron que un aumento en la raíz cuadrada media de las diferencias sucesivas (RMSDD) y la desviación estándar de los intervalos de normal a normal (SDNN), junto con una disminución en la FC promedio, indican una mayor actividad en el sistema nervioso simpático, que se asocia con el miedo.

Kajiwara et al.14 proponen un sistema innovador que emplea sensores portátiles y redes neuronales profundas para predecir el nivel de emoción y compromiso de los trabajadores. El sistema sigue un proceso de tres pasos. Inicialmente, los sensores portátiles capturan y recopilan datos sobre comportamientos y ondas de pulso. Posteriormente, se calculan las características de las series temporales en función de los datos conductuales y fisiológicos adquiridos. Por último, las redes neuronales profundas se utilizan para introducir las características de las series temporales y hacer predicciones sobre las emociones y los niveles de compromiso del individuo.

En otras investigaciones, como la de Costante et al.15, se propone un enfoque basado en un novedoso algoritmo de aprendizaje métrico de transferencia, que utiliza el conocimiento previo de un conjunto predefinido de gestos para mejorar el reconocimiento de gestos definidos por el usuario. Esta mejora se logra con una dependencia mínima de muestras de entrenamiento adicionales. De manera similar, se presenta un marco de reconocimiento de actividad humana basado en sensores16 para abordar el objetivo del reconocimiento impersonal de actividades humanas complejas. Los datos de señales recopilados de los sensores portátiles se utilizan en el marco de reconocimiento de actividad humana desarrollado, empleando cuatro modelos DL basados en RNN (Memorias a Largo y Corto Plazo, Memorias Bidireccionales a Largo y Corto Plazo, Unidades Recurrentes Cerradas y Unidades Recurrentes Cerradas Bidireccionales) para investigar las actividades realizadas por el usuario del dispositivo portátil.

Protocolo

El siguiente protocolo sigue las directrices del comité de ética de investigación en humanos de la Universidad de Alicante con el número de protocolo aprobado UA-2022-11-12. Se ha obtenido el consentimiento informado de todos los participantes para este experimento y para el uso de los datos aquí.

1. Configuración de hardware, software y clases

- Coloque un enrutador con capacidades WiFi (los experimentos se llevaron a cabo utilizando un DLink DSR 1000AC) en la ubicación deseada para que su alcance cubra toda la habitación. Aquí se cubrieron aulas de 25m2 con 30 alumnos.

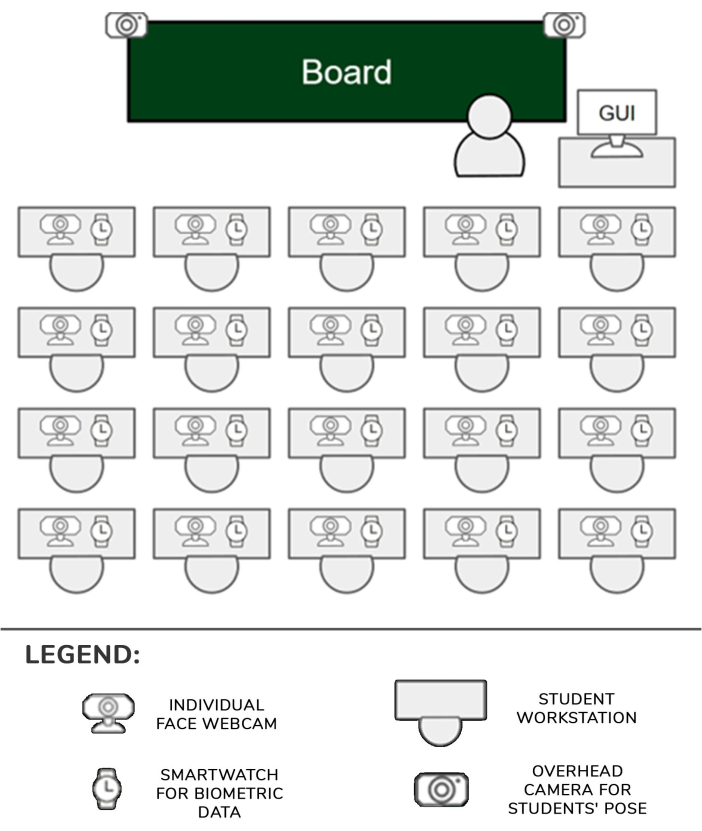

- Establezca un reloj inteligente (aquí Samsung Galaxy Smartwatch 5) y una cámara (aquí cámaras Logitech C920) para cada ubicación de estudiante. Establezca un dispositivo integrado por cada dos estudiantes. Fije dos cámaras en dos trípodes y conéctelas a otro dispositivo integrado (en lo sucesivo, cámaras cenitales).

- Conecte las cámaras a los dispositivos integrados correspondientes con un enlace USB y enciéndalos. Encienda también los relojes inteligentes. Conecte todos los dispositivos integrados y relojes inteligentes a la red WiFi del enrutador configurado en el paso 1.1.

- Coloque las cámaras en la esquina del escritorio de cada estudiante y apúntelas hacia adelante y ligeramente inclinadas hacia arriba para que la cara del estudiante sea claramente visible en las imágenes.

- Coloque los dos trípodes con las cámaras frente a los pupitres que están más cerca de los pasillos en la primera fila de asientos del aula. Mueva el elevador del trípode a la posición más alta para que las cámaras puedan ver claramente a la mayoría de los estudiantes. Cada dispositivo integrado podrá gestionar uno o dos estudiantes, junto con sus respectivas cámaras y relojes. La configuración se muestra en la Figura 1.

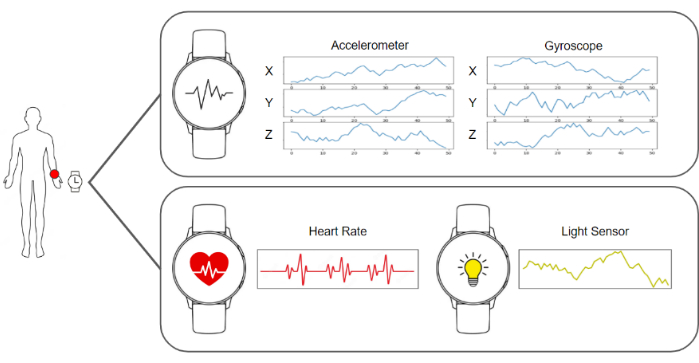

- Ejecute el software de captura en los relojes inteligentes y en los dispositivos integrados para que estén listos para enviar las imágenes y los datos del acelerómetro, el giroscopio, la frecuencia cardíaca y la iluminación. Ejecute el software del servidor que recopila los datos y los almacena. Un diagrama de todos estos elementos se puede ver en la Figura 2.

- Asegúrese de que las cámaras cenitales dominen la escena para que tengan una visión clara de los cuerpos de los estudiantes. Coloque una cámara individual adicional frente a cada estudiante.

- Deje que los estudiantes se sienten en sus lugares, infórmeles de los objetivos del experimento e indíqueles que usen los relojes inteligentes en su mano dominante y que no interactúen con ninguno de los elementos de la configuración.

- Inicie la captura y recopilación de los datos en el servidor y reanude las lecciones de clase como de costumbre.

Figura 1: Hardware y canalización de datos. Los datos de las cámaras y los relojes inteligentes se recopilan y se introducen en los algoritmos de aprendizaje automático para su procesamiento. Haga clic aquí para ver una versión más grande de esta figura.

Figura 2: Posición de los sensores, del profesor y de los alumnos. Diagrama que muestra las posiciones de las cámaras, relojes inteligentes y GUI en el aula con el profesor y los estudiantes. Haga clic aquí para ver una versión más grande de esta figura.

2. Canalización de captura y procesamiento de datos

NOTA: Todos estos pasos se realizan automáticamente mediante el software de procesamiento implementado en un servidor. La implementación utilizada para los experimentos en este trabajo fue escrita en Python 3.8.

- Recopile los datos requeridos recopilando todas las imágenes y datos biométricos del reloj inteligente para cada estudiante y construya un marco de datos que incluya datos de 1 s. Este marco de datos se compone de una imagen de la cámara individual, una imagen de cada cámara cenital (dos en este caso), cincuenta registros de los tres valores del giroscopio, cincuenta registros de los tres valores del acelerómetro, un valor de frecuencia cardíaca y un valor de condición de luz.

- Para calcular la dirección de la cabeza, el primer paso es usar la cámara web que apunta a la cara del estudiante y recuperar una imagen. Luego, esa imagen es procesada por el algoritmo de estimación de puntos de referencia BlazeFace17 . La salida de dicho algoritmo es una lista de puntos clave 2D correspondientes a áreas específicas de la cara.

- Utilizando la posición estimada de los ojos, la nariz, la boca y la barbilla proporcionada por el algoritmo, resuelva el problema de n puntos de perspectiva utilizando el método cv::SolvePnPMethod de la biblioteca OpenCV, una configuración de cara canónica. Como resultado de este procedimiento se obtiene la matriz de rotación que define la dirección de la cabeza.

- Calcule la pose del cuerpo reenviando la imagen cenital del marco de datos en el que se representa al estudiante al algoritmo de estimación de puntos de referencia BlazePose18 y recupere una lista de coordenadas 2D de las articulaciones del cuerpo representado en la imagen. Esta lista de puntos de referencia describe la pose del estudiante.

NOTA: La postura del cuerpo es importante, ya que puede representar con precisión la participación de un estudiante en diferentes actividades durante la clase. Por ejemplo, si el estudiante está sentado naturalmente con las manos en el escritorio, podría significar que está tomando notas. Por el contrario, si están moviendo continuamente los brazos, podría significar que están hablando con alguien. - Obtener la imagen de la cara del alumno y realizar el preprocesamiento de la alineación. Recupere los puntos clave de los ojos de la lista calculada en el paso 2.3 y proyéctelos en el plano de la imagen para obtener la posición de los ojos.

- Traza un vector virtual que une la posición de ambos ojos. Calcule el ángulo entre ese vector y la línea horizontal y construya una matriz de homografía para aplicar el ángulo inverso a la imagen y los puntos clave para que los ojos estén alineados horizontalmente.

- Recorte la cara utilizando los puntos clave para detectar sus límites y alimente el parche a la red neuronal convolucional de detección de emociones19. Recupere la salida de la red, que es un vector con 7 posiciones, cada posición da la probabilidad de que la cara muestre una de las siete emociones básicas: neutral, feliz, disgustado, enojado, asustado, sorprendido y triste.

- Mida el nivel de atención obteniendo los datos del acelerómetro, el giroscopio y la frecuencia cardíaca del marco de datos (Figura 3).

- Alimente el modelo basado en el aprendizaje profundo que se creó y entrenó a medida desde cero descrito en los resultados representativos con el flujo de datos del acelerómetro y el giroscopio. Recupere la salida del modelo, que es un vector con 4 posiciones, cada posición da la probabilidad de que los datos representen una de las siguientes acciones posibles: escribir a mano, escribir en un teclado, usar un teléfono móvil o descansar, como se muestra en la Figura 4.

- Alimente el clasificador de atención final con una linealización de todos los resultados de los sistemas anteriores mediante la fusión de la dirección de la cabeza, la salida de reconocimiento de emociones, la postura del cuerpo y los datos del giroscopio, el acelerómetro y la frecuencia cardíaca. Recupere los resultados de este clasificador final, que es una puntuación de 0 a 100. Clasifique este valor continuo en una de las tres categorías discretas posibles de atención: nivel de atención bajo (0-40%), nivel medio de atención (40%-75%) y nivel alto de atención (75% - 100%). La estructura del conjunto de datos generado se muestra en la Tabla 1.

- Mostrar los resultados de los niveles de atención al profesor utilizando la interfaz gráfica de usuario (GUI) desde el ordenador del profesor, accesible desde un navegador web normal.

Figura 3: Datos capturados por el reloj inteligente. El reloj inteligente proporciona un giroscopio, un acelerómetro, la frecuencia cardíaca y las condiciones de luz como flujos de datos. Haga clic aquí para ver una versión más grande de esta figura.

Figura 4: Ejemplos de las categorías consideradas por el modelo de reconocimiento de actividades. El modelo de reconocimiento de actividad reconoce cuatro acciones diferentes: escribir a mano, escribir en un teclado, usar un teléfono inteligente y posición de reposo. Haga clic aquí para ver una versión más grande de esta figura.

Resultados

El grupo objetivo de este estudio son los estudiantes de grado y máster, por lo que el principal grupo de edad se encuentra entre los 18 y los 25 años. Esta población fue seleccionada porque pueden manejar dispositivos electrónicos con menos distracciones que los estudiantes más jóvenes. En total, el grupo incluía a 25 personas. Este grupo de edad puede proporcionar los resultados más fiables para probar la propuesta.

Los resultados del nivel de atención mostrado al profesor tienen 2 ...

Discusión

Este trabajo presenta un sistema que mide el nivel de atención de un estudiante en un aula utilizando cámaras, relojes inteligentes y algoritmos de inteligencia artificial. Esta información se presenta posteriormente al profesor para que tenga una idea del estado general de la clase.

Uno de los principales pasos críticos del protocolo es la sincronización de la información del reloj inteligente con la imagen de la cámara a color, ya que estas tienen diferentes frecuencias. Esto se soluc...

Divulgaciones

Los autores declaran que no tienen intereses financieros o relaciones personales contradictorias que puedan haber influido en el trabajo reportado en este artículo.

Agradecimientos

Este trabajo se desarrolló con financiamiento del Programa Prometeo, ID de proyecto CIPROM/2021/017. La Prof. Rosabel Roig es la presidenta del proyecto "Educación, Investigación e Inclusión Digital" de la UNESCO.

Materiales

| Name | Company | Catalog Number | Comments |

| 4 GPUs Nvidia A40 Ampere | NVIDIA | TCSA40M-PB | GPU for centralized model processing server |

| FusionServer 2288H V5 | X-Fusion | 02311XBK | Platform that includes power supply and motherboard for centralized model processing server |

| Memory Card Evo Plus 128 GB | Samsung | MB-MC128KA/EU | Memory card for the operation of the raspberry pi 4b 2gb. One for each raspberry. |

| NEMIX RAM - 512 GB Kit DDR4-3200 PC4-25600 8Rx4 EC | NEMIX | M393AAG40M32-CAE | RAM for centralized model processing server |

| Processor Intel Xeon Gold 6330 | Intel | CD8068904572101 | Processor for centralized model processing server |

| Raspberry PI 4B 2GB | Raspberry | 1822095 | Local server that receives requests from the clocks and sends them to the general server. One every two students. |

| Samsung Galaxy Watch 5 (40mm) | Samsung | SM-R900NZAAPHE | Clock that monitors each student's activity. For each student. |

| Samsung MZQL23T8HCLS-00B7C PM9A3 3.84Tb Nvme U.2 PCI-Express-4 x4 2.5inch Ssd | Samsung | MZQL23T8HCLS-00B7C | Internal storage for centralized model processing server |

| WebCam HD Pro C920 Webcam FullHD | Logitech | 960-001055 | Webcam HD. One for each student plus two for student poses. |

Referencias

- Hasnine, M. N., et al. Students' emotion extraction and visualization for engagement detection in online learning. Procedia Comp Sci. 192, 3423-3431 (2021).

- Khare, S. K., Blanes-Vidal, V., Nadimi, E. S., Acharya, U. R. Emotion recognition and artificial intelligence: A systematic review (2014-2023) and research recommendations. Info Fusion. 102, 102019 (2024).

- Bosch, N. Detecting student engagement: Human versus machine. UMAP '16: Proc the 2016 Conf User Model Adapt Personal. , 317-320 (2016).

- Araya, R., Sossa-Rivera, J. Automatic detection of gaze and body orientation in elementary school classrooms. Front Robot AI. 8, 729832 (2021).

- Lu, Y., Zhang, J., Li, B., Chen, P., Zhuang, Z. Harnessing commodity wearable devices for capturing learner engagement. IEEE Access. 7, 15749-15757 (2019).

- Vanneste, P., et al. Computer vision and human behaviour, emotion and cognition detection: A use case on student engagement. Mathematics. 9 (3), 287 (2021).

- Ma, X., Xu, M., Dong, Y., Sun, Z. Automatic student engagement in online learning environment based on neural Turing machine. Int J Info Edu Tech. 11 (3), 107-111 (2021).

- Wood, E., Bulling, A. EyeTab: model-based gaze estimation on unmodified tablet computers. ETRA '14: Proc Symp Eye Tracking Res Appl. , 207-210 (2014).

- Sanghvi, J., et al. Automatic analysis of affective postures and body motion to detect engagement with a game companion. HRI '11: Proc 6th Int Conf Human-robot Interact. , 205-211 (2011).

- Gupta, S., Kumar, P., Tekchandani, R. K. Facial emotion recognition based real-time learner engagement detection system in online learning context using deep learning models. Multimed Tools Appl. 82 (8), 11365-11394 (2023).

- Altuwairqi, K., Jarraya, S. K., Allinjawi, A., Hammami, M. Student behavior analysis to measure engagement levels in online learning environments. Signal Image Video Process. 15 (7), 1387-1395 (2021).

- Belle, A., Hargraves, R. H., Najarian, K. An automated optimal engagement and attention detection system using electrocardiogram. Comput Math Methods Med. 2012, 528781 (2012).

- Alban, A. Q., et al. Heart rate as a predictor of challenging behaviours among children with autism from wearable sensors in social robot interactions. Robotics. 12 (2), 55 (2023).

- Kajiwara, Y., Shimauchi, T., Kimura, H. Predicting emotion and engagement of workers in order picking based on behavior and pulse waves acquired by wearable devices. Sensors. 19 (1), 165 (2019).

- Costante, G., Porzi, L., Lanz, O., Valigi, P., Ricci, E. Personalizing a smartwatch-based gesture interface with transfer learning. , 2530-2534 (2014).

- Mekruksavanich, S., Jitpattanakul, A. Deep convolutional neural network with RNNs for complex activity recognition using wrist-worn wearable sensor data. Electronics. 10 (14), 1685 (2021).

- Bazarevsky, V., Kartynnik, Y., Vakunov, A., Raveendran, K., Grundmann, M. BlazeFace: Sub-millisecond Neural Face Detection on Mobile GPUs. arXiv. , (2019).

- Bazarevsky, V., et al. BlazePose: On-device Real-time Body Pose tracking. arXiv. , (2020).

- Mejia-Escobar, C., Cazorla, M., Martinez-Martin, E. Towards a better performance in facial expression recognition: a data-centric approach. Comput Intelligence Neurosci. , (2023).

- El-Garem, A., Adel, R. Applying systematic literature review and Delphi methods to explore digital transformation key success factors. Int J Eco Mgmt Engi. 16 (7), 383-389 (2022).

- Indumathi, V., Kist, A. A. Using electroencephalography to determine student attention in the classroom. , 1-3 (2023).

- Ma, X., Xie, Y., Wang, H. Research on the construction and application of teacher-student interaction evaluation system for smart classroom in the post COVID-19. Studies Edu Eval. 78, 101286 (2023).

- Andersen, D. Constructing Delphi statements for technology foresight. Futures Foresight Sci. 5 (2), e144 (2022).

- Khodyakov, D., et al. Disciplinary trends in the use of the Delphi method: A bibliometric analysis. PLoS One. 18 (8), e0289009 (2023).

- Martins, A. I., et al. Consensus on the Terms and Procedures for Planning and Reporting a Usability Evaluation of Health-Related Digital Solutions: Delphi Study and a Resulting Checklist. J Medical Internet Res. 25, e44326 (2023).

- Dalmaso, M., Castelli, L., Galfano, G. Social modulators of gaze-mediated orienting of attention: A review. Psychon Bull Rev. 27 (5), 833-855 (2020).

- Klein, R. M. Thinking about attention: Successive approximations to a productive taxonomy. Cognition. 225, 105137 (2022).

- Schindler, S., Bublatzky, F. Attention and emotion: An integrative review of emotional face processing as a function of attention. Cortex. 130, 362-386 (2020).

- Zaletelj, J., Košir, A. Predicting students' attention in the classroom from Kinect facial and body features. J Image Video Proc. 80, (2017).

- Strauch, C., Wang, C. A., Einhäuser, W., Van der Stigchel, S., Naber, M. Pupillometry as an integrated readout of distinct attentional networks. Trends Neurosci. 45 (8), 635-647 (2022).

Reimpresiones y Permisos

Solicitar permiso para reutilizar el texto o las figuras de este JoVE artículos

Solicitar permisoThis article has been published

Video Coming Soon

ACERCA DE JoVE

Copyright © 2025 MyJoVE Corporation. Todos los derechos reservados