È necessario avere un abbonamento a JoVE per visualizzare questo. Accedi o inizia la tua prova gratuita.

Method Article

Sistema basato sull'intelligenza artificiale per rilevare i livelli di attenzione negli studenti

In questo articolo

Riepilogo

Questo articolo propone un sistema basato sull'intelligenza artificiale per rilevare automaticamente se gli studenti stanno prestando attenzione alla classe o sono distratti. Questo sistema è progettato per aiutare gli insegnanti a mantenere l'attenzione degli studenti, ottimizzare le loro lezioni e introdurre dinamicamente modifiche in modo che siano più coinvolgenti.

Abstract

Il livello di attenzione degli studenti in classe può essere migliorato attraverso l'uso di tecniche di Intelligenza Artificiale (AI). Identificando automaticamente il livello di attenzione, gli insegnanti possono utilizzare strategie per ritrovare la concentrazione degli studenti. Ciò può essere ottenuto attraverso varie fonti di informazione.

Una fonte è analizzare le emozioni riflesse sui volti degli studenti. L'intelligenza artificiale è in grado di rilevare emozioni come quelle neutre, il disgusto, la sorpresa, la tristezza, la paura, la felicità e la rabbia. Inoltre, la direzione dello sguardo degli studenti può anche potenzialmente indicare il loro livello di attenzione. Un'altra fonte è osservare la postura del corpo degli studenti. Utilizzando telecamere e tecniche di deep learning, la postura può essere analizzata per determinare il livello di attenzione. Ad esempio, gli studenti che sono ciondolanti o appoggiano la testa sui banchi possono avere un livello di attenzione inferiore. Gli smartwatch distribuiti agli studenti possono fornire dati biometrici e di altro tipo, tra cui misurazioni della frequenza cardiaca e inerziali, che possono essere utilizzati anche come indicatori di attenzione. Combinando queste fonti di informazioni, è possibile addestrare un sistema di intelligenza artificiale a identificare il livello di attenzione in classe. Tuttavia, l'integrazione dei diversi tipi di dati rappresenta una sfida che richiede la creazione di un set di dati etichettato. Per un'etichettatura accurata vengono consultati i contributi degli esperti e gli studi esistenti. In questo articolo, proponiamo l'integrazione di tali misurazioni e la creazione di un set di dati e di un potenziale classificatore di attenzione. Per fornire un feedback all'insegnante, esploriamo vari metodi, come smartwatch o computer diretti. Una volta che l'insegnante diventa consapevole dei problemi di attenzione, può adattare il proprio approccio didattico per coinvolgere e motivare nuovamente gli studenti. In sintesi, le tecniche di intelligenza artificiale possono identificare automaticamente il livello di attenzione degli studenti analizzando le loro emozioni, la direzione dello sguardo, la postura del corpo e i dati biometrici. Queste informazioni possono aiutare gli insegnanti a ottimizzare il processo di insegnamento-apprendimento.

Introduzione

Nei moderni contesti educativi, valutare accuratamente e mantenere l'attenzione degli studenti è fondamentale per un insegnamento e un apprendimento efficaci. Tuttavia, i metodi tradizionali di misurazione del coinvolgimento, come l'autovalutazione o le osservazioni soggettive dell'insegnante, richiedono molto tempo e sono soggetti a distorsioni. Per affrontare questa sfida, le tecniche di intelligenza artificiale (AI) sono emerse come soluzioni promettenti per il rilevamento automatizzato dell'attenzione. Un aspetto significativo della comprensione dei livelli di coinvolgimento degli studenti è il riconoscimento delle emozioni1. I sistemi di intelligenza artificiale possono analizzare le espressioni facciali per identificare le emozioni, come il neutro, il disgusto, la sorpresa, la tristezza, la paura, la felicità e la rabbia2.

Anche la direzione dello sguardo e la postura del corpo sono indicatori cruciali dell'attenzione degli studenti3. Utilizzando telecamere e algoritmi avanzati di apprendimento automatico, i sistemi di intelligenza artificiale possono tracciare con precisione dove stanno guardando gli studenti e analizzare la postura del loro corpo per rilevare segni di disinteresse o affaticamento4. Inoltre, l'incorporazione di dati biometrici migliora l'accuratezza e l'affidabilità del rilevamento dell'attenzione5. Raccogliendo misurazioni, come la frequenza cardiaca e i livelli di saturazione di ossigeno nel sangue, attraverso gli smartwatch indossati dagli studenti, è possibile ottenere indicatori oggettivi di attenzione, a complemento di altre fonti di informazione.

Questo articolo propone un sistema che valuta il livello di attenzione di un individuo utilizzando telecamere a colori e altri sensori diversi. Combina il riconoscimento delle emozioni, l'analisi della direzione dello sguardo, la valutazione della postura del corpo e i dati biometrici per fornire agli educatori un set completo di strumenti per ottimizzare il processo di insegnamento-apprendimento e migliorare il coinvolgimento degli studenti. Utilizzando questi strumenti, gli educatori possono acquisire una comprensione completa del processo di insegnamento-apprendimento e migliorare il coinvolgimento degli studenti, ottimizzando così l'esperienza educativa complessiva. Applicando tecniche di intelligenza artificiale, è persino possibile valutare automaticamente questi dati.

L'obiettivo principale di questo lavoro è quello di descrivere il sistema che ci permette di catturare tutte le informazioni e, una volta catturate, di addestrare un modello di AI che ci permetta di ottenere l'attenzione di tutta la classe in tempo reale. Sebbene altri lavori abbiano già proposto di catturare l'attenzione utilizzando informazioni visive o emotive6, questo lavoro propone l'uso combinato di queste tecniche, che fornisce un approccio olistico per consentire l'uso di tecniche di intelligenza artificiale più complesse ed efficaci. Inoltre, i set di dati finora disponibili sono limitati a un insieme di video o a dati biometrici. La letteratura non include set di dati che forniscano dati completi con immagini del volto o del corpo dello studente, dati biometrici, dati sulla posizione dell'insegnante, ecc. Con il sistema qui presentato, è possibile acquisire questo tipo di set di dati.

Il sistema associa un livello di attenzione a ogni studente in ogni momento. Questo valore è un valore di probabilità di attenzione compreso tra 0% e 100%, che può essere interpretato come un livello di attenzione basso (0%-40%), un livello di attenzione medio (40%-75%) e un livello di attenzione alto (75%-100%). In tutto il testo, questa probabilità di attenzione è indicata come il livello di attenzione, l'attenzione degli studenti o se gli studenti sono distratti o meno, ma questi sono tutti correlati allo stesso valore di output del nostro sistema.

Nel corso degli anni, il campo del rilevamento automatico del coinvolgimento è cresciuto in modo significativo grazie al suo potenziale di rivoluzionare l'istruzione. I ricercatori hanno proposto vari approcci per quest'area di studio.

Ma et al.7 hanno introdotto un nuovo metodo basato su una macchina di Turing neurale per il riconoscimento automatico dell'impegno. Hanno estratto alcune caratteristiche, come lo sguardo, le unità di azione facciale, la posa della testa e la posa del corpo, per creare una rappresentazione completa del riconoscimento del coinvolgimento.

EyeTab8, un altro sistema innovativo, utilizzava modelli per stimare dove qualcuno sta guardando con entrambi gli occhi. È stato realizzato appositamente per funzionare senza problemi su un tablet standard senza modifiche. Questo sistema sfrutta algoritmi ben noti per l'elaborazione delle immagini e l'analisi della visione artificiale. La loro pipeline di stima dello sguardo include un rilevatore oculare basato su caratteristiche simili a quelle di Haar, nonché un approccio di adattamento dell'ellisse del limbus basato su RANSAC.

Sanghvi et al.9 propongono un approccio che si basa su tecniche basate sulla visione per estrarre automaticamente le caratteristiche posturali espressive dai video registrati da una vista laterale, catturando il comportamento dei bambini. Viene condotta una valutazione iniziale, che prevede l'addestramento di più modelli di riconoscimento utilizzando espressioni posturali affettive contestualizzate. I risultati ottenuti dimostrano che i modelli di comportamento posturale possono prevedere efficacemente l'impegno dei bambini con il robot.

In altri lavori, come Gupta et al.10, viene impiegato un metodo basato sul deep learning per rilevare il coinvolgimento in tempo reale degli studenti online analizzando le loro espressioni facciali e classificando le loro emozioni. L'approccio utilizza il riconoscimento delle emozioni facciali per calcolare un indice di coinvolgimento (EI) che prevede due stati di coinvolgimento: coinvolto e disimpegnato. Vari modelli di deep learning, tra cui Inception-V3, VGG19 e ResNet-50, vengono valutati e confrontati per identificare il modello di classificazione predittiva più efficace per il rilevamento del coinvolgimento in tempo reale.

In Altuwairqi et al.11, i ricercatori presentano un nuovo approccio multimodale automatico per valutare i livelli di coinvolgimento degli studenti in tempo reale. Per garantire misurazioni accurate e affidabili, il team ha integrato e analizzato tre modalità distinte che catturano i comportamenti degli studenti: espressioni facciali per le emozioni, sequenze di tasti della tastiera e movimenti del mouse.

Guillén et al.12 propongono lo sviluppo di un sistema di monitoraggio che utilizza l'elettrocardiografia (ECG) come segnale fisiologico primario per analizzare e prevedere la presenza o l'assenza di attenzione cognitiva negli individui durante l'esecuzione di un compito.

Alban et al.13 utilizzano una rete neurale (NN) per rilevare le emozioni analizzando i valori della frequenza cardiaca (HR) e dell'attività elettrodermica (EDA) di vari partecipanti sia nel dominio del tempo che in quello della frequenza. Hanno scoperto che un aumento del quadrato medio delle differenze successive (RMSDD) e degli intervalli di deviazione standard da normale a normale (SDNN), insieme a una diminuzione della FC media, indicano un'elevata attività nel sistema nervoso simpatico, che è associata alla paura.

Kajiwara et al.14 propongono un sistema innovativo che impiega sensori indossabili e reti neurali profonde per prevedere il livello di emozione e coinvolgimento nei lavoratori. Il sistema segue un processo in tre fasi. Inizialmente, i sensori indossabili acquisiscono e raccolgono dati sui comportamenti e sulle onde del polso. Successivamente, le caratteristiche delle serie temporali vengono calcolate in base ai dati comportamentali e fisiologici acquisiti. Infine, le reti neurali profonde vengono utilizzate per inserire le caratteristiche delle serie temporali e fare previsioni sulle emozioni e sui livelli di coinvolgimento dell'individuo.

In altre ricerche, come Costante et al.15, viene proposto un approccio basato su un nuovo algoritmo di apprendimento metrico di trasferimento, che utilizza la conoscenza preliminare di un insieme predefinito di gesti per migliorare il riconoscimento dei gesti definiti dall'utente. Questo miglioramento si ottiene con un ricorso minimo a campioni di formazione aggiuntivi. Allo stesso modo, viene presentato un quadro di riconoscimento dell'attività umana basato su sensori16 per affrontare l'obiettivo del riconoscimento impersonale di attività umane complesse. I dati del segnale raccolti dai sensori indossati al polso vengono utilizzati nel framework di riconoscimento dell'attività umana sviluppato, impiegando quattro modelli DL basati su RNN (Long-Short Term Memories, Bidirectional Long-Short Term Memories, Gated Recurrent Units e Bidirectional Gated Recurrent Units) per indagare le attività svolte dall'utente del dispositivo indossabile.

Protocollo

Il seguente protocollo segue le linee guida del comitato etico per la ricerca umana dell'Università di Alicante con il numero di protocollo approvato UA-2022-11-12. Il consenso informato è stato ottenuto da tutti i partecipanti per questo esperimento e per l'utilizzo dei dati qui.

1. Hardware, software e configurazione della classe

- Imposta un router con funzionalità WiFi (gli esperimenti sono stati effettuati utilizzando un DLink DSR 1000AC) nella posizione desiderata in modo che la sua portata copra l'intera stanza. Qui sono state coperte aule di 25 m2 con 30 studenti.

- Imposta uno smartwatch (qui Samsung Galaxy Smartwatch 5) e una fotocamera (qui fotocamere Logitech C920) per ogni sede dello studente. Imposta un dispositivo incorporato ogni due studenti. Fissare due fotocamere su due treppiedi e collegarle a un altro dispositivo incorporato (di seguito denominate fotocamere zenitali).

- Collega le fotocamere ai dispositivi integrati corrispondenti con un collegamento USB e accendile. Accendi anche gli smartwatch. Collega tutti i dispositivi integrati e gli smartwatch alla rete WiFi del router configurato al punto 1.1.

- Posiziona le telecamere nell'angolo della scrivania di ogni studente e puntale in avanti e leggermente inclinate verso l'alto in modo che il volto dello studente sia chiaramente visibile nelle immagini.

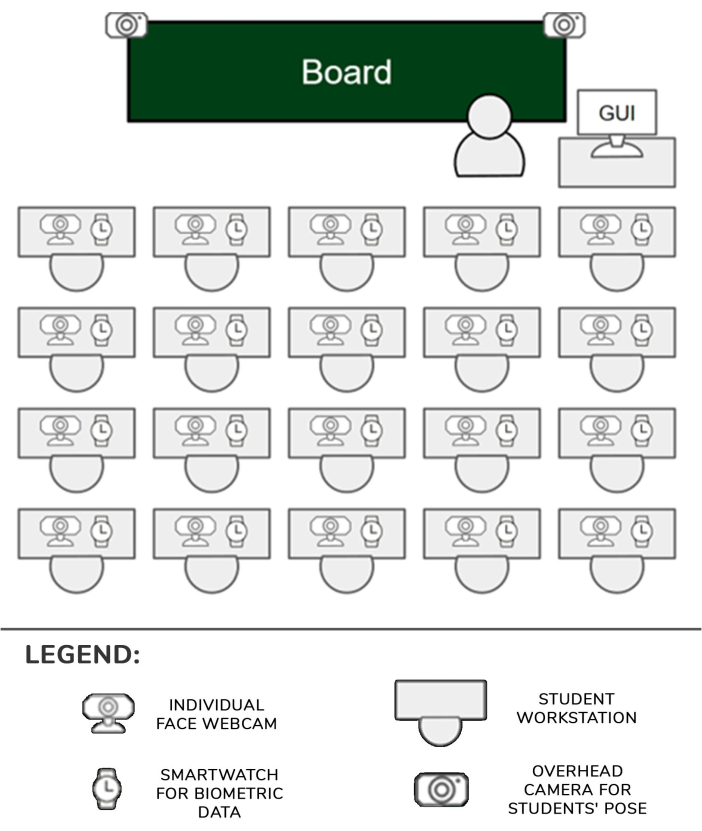

- Posiziona i due treppiedi con le telecamere davanti ai banchi che si trovano più vicini ai corridoi nella prima fila di sedili dell'aula. Sposta il montante del treppiede nella posizione più alta in modo che le telecamere possano vedere chiaramente la maggior parte degli studenti. Ogni dispositivo integrato sarà in grado di gestire uno o due studenti, insieme alle rispettive fotocamere e orologi. La configurazione è illustrata nella Figura 1.

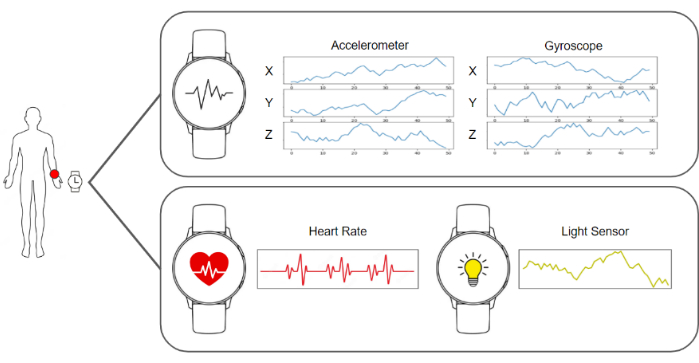

- Esegui il software di acquisizione negli smartwatch e nei dispositivi integrati in modo che siano pronti a inviare le immagini e i dati dell'accelerometro, del giroscopio, della frequenza cardiaca e dell'illuminazione. Eseguire il software del server che raccoglie i dati e li memorizza. Un diagramma di tutti questi elementi può essere visto nella Figura 2.

- Assicurati che le telecamere zenitali dominino la scena in modo da avere una visione chiara dei corpi degli studenti. Posiziona un'ulteriore telecamera individuale davanti a ogni studente.

- Lascia che gli studenti si siedano al loro posto, informali degli obiettivi dell'esperimento e istruiscili a indossare gli smartwatch sulla mano dominante e a non interagire con nessuno degli elementi della configurazione.

- Avvia l'acquisizione e la raccolta dei dati nel server e riprendi le lezioni in classe come di consueto.

Figura 1: Hardware e pipeline di dati. I dati delle fotocamere e degli smartwatch vengono raccolti e inviati agli algoritmi di apprendimento automatico per essere elaborati. Clicca qui per visualizzare una versione più grande di questa figura.

Figura 2: Posizione dei sensori, dell'insegnante e degli studenti. Diagramma che mostra le posizioni delle telecamere, degli smartwatch e dell'interfaccia grafica in classe con l'insegnante e gli studenti. Clicca qui per visualizzare una versione più grande di questa figura.

2. Pipeline di acquisizione ed elaborazione dei dati

NOTA: tutti questi passaggi vengono eseguiti automaticamente elaborando il software distribuito in un server. L'implementazione utilizzata per gli esperimenti in questo lavoro è stata scritta in Python 3.8.

- Raccogli i dati richiesti raccogliendo tutte le immagini e i dati biometrici dallo smartwatch per ogni studente e crea un frame di dati che includa dati da 1 s. Questo frame di dati è composto da un'immagine della singola fotocamera, un'immagine di ciascuna fotocamera zenitale (due in questo caso), cinquanta registri dei tre valori del giroscopio, cinquanta registri dei tre valori dell'accelerometro, un valore della frequenza cardiaca e un valore della condizione di luce.

- Per calcolare la direzione della testa, il primo passo è utilizzare la webcam puntata sul viso dello studente e recuperare un'immagine. Quindi, l'immagine viene elaborata dall'algoritmo di stima dei punti di riferimento BlazeFace17 . L'output di un tale algoritmo è un elenco di punti chiave 2D corrispondenti ad aree specifiche del viso.

- Utilizzando la posizione stimata di occhi, naso, bocca e mento fornita dall'algoritmo, risolvi il problema prospettico di n punti utilizzando il metodo cv::SolvePnPMethod della libreria OpenCV, un'impostazione canonica del volto. La matrice di rotazione che definisce la direzione della testa si ottiene come risultato di questa procedura.

- Calcola la posa del corpo inoltrando l'immagine zenitale dal frame di dati in cui lo studente è raffigurato all'algoritmo di stima dei punti di riferimento BlazePose18 e recupera un elenco di coordinate 2D delle articolazioni del corpo raffigurato nell'immagine. Questo elenco di punti di riferimento descrive la posa dello studente.

NOTA: La posa del corpo è importante in quanto può rappresentare accuratamente l'impegno di uno studente con diverse attività durante la lezione. Ad esempio, se lo studente è seduto naturalmente con le mani sulla scrivania, potrebbe significare che sta prendendo appunti. Al contrario, se muovono continuamente le braccia, potrebbe significare che stanno parlando con qualcuno. - Ottenere l'immagine del volto dello studente ed eseguire la pre-elaborazione dell'allineamento. Recupera i punti chiave degli occhi dall'elenco calcolato nel passaggio 2.3 e proiettali sul piano dell'immagine in modo da ottenere la posizione degli occhi.

- Traccia un vettore virtuale che unisce la posizione di entrambi gli occhi. Calcola l'angolo tra quel vettore e la linea orizzontale e costruisci una matrice di omografia per applicare l'angolo inverso all'immagine e ai punti chiave in modo che gli occhi siano allineati orizzontalmente.

- Ritaglia il viso utilizzando i punti chiave per rilevarne i limiti e alimenta il cerotto alla rete neurale convoluzionale di rilevamento delle emozioni19. Recupera l'output dalla rete, che è un vettore con 7 posizioni, ognuna delle quali fornisce la probabilità che il volto mostri una delle sette emozioni di base: neutro, felice, disgustato, arrabbiato, spaventato, sorpreso e triste.

- Misurare il livello di attenzione ottenendo i dati dell'accelerometro, del giroscopio e della frequenza cardiaca dal frame di dati (Figura 3).

- Alimenta il modello basato sul deep learning, costruito su misura e addestrato da zero descritto nei risultati rappresentativi, con il flusso di dati dell'accelerometro e del giroscopio. Recupera l'output dal modello, che è un vettore con 4 posizioni, ognuna delle quali fornisce la probabilità che i dati rappresentino una delle seguenti azioni possibili: scrittura a mano, digitazione su una tastiera, utilizzo di un telefono cellulare o riposo, come mostrato nella Figura 4.

- Alimenta il classificatore di attenzione finale con una linearizzazione di tutti i risultati dei sistemi precedenti unendo la direzione della testa, l'output del riconoscimento delle emozioni, la posa del corpo e il giroscopio, l'accelerometro e i dati della frequenza cardiaca. Recupera i risultati da questo classificatore finale, ovvero un punteggio compreso tra 0 e 100. Classificare questo valore continuo in una delle tre possibili categorie distinte di attenzione: livello di attenzione basso (0-40%), livello di attenzione medio (40%-75%) e livello di attenzione alto (75% - 100%). La struttura del set di dati generato è illustrata nella Tabella 1.

- Mostra i risultati dei livelli di attenzione all'insegnante utilizzando l'interfaccia utente grafica (GUI) dal computer dell'insegnante, accessibile da un normale browser web.

Figura 3: Dati acquisiti dallo smartwatch. Lo smartwatch fornisce un giroscopio, un accelerometro, la frequenza cardiaca e la condizione di luce come flussi di dati. Clicca qui per visualizzare una versione più grande di questa figura.

Figura 4: Esempi delle categorie considerate dal modello di riconoscimento delle attività. Il modello di riconoscimento delle attività riconosce quattro diverse azioni: scrittura a mano, digitazione su una tastiera, utilizzo di uno smartphone e posizione di riposo. Clicca qui per visualizzare una versione più grande di questa figura.

Risultati

Il gruppo target di questo studio è costituito da studenti universitari e master, quindi la fascia di età principale è compresa tra i 18 e i 25 anni. Questa popolazione è stata selezionata perché è in grado di gestire dispositivi elettronici con meno distrazioni rispetto agli studenti più giovani. In totale, il gruppo comprendeva 25 persone. Questa fascia d'età può fornire i risultati più affidabili per testare la proposta.

I risultati del livello di attenzione mostrato all'insegnant...

Discussione

Questo lavoro presenta un sistema che misura il livello di attenzione di uno studente in una classe utilizzando telecamere, smartwatch e algoritmi di intelligenza artificiale. Queste informazioni vengono successivamente presentate all'insegnante per fargli avere un'idea dello stato generale della classe.

Uno dei principali passaggi critici del protocollo è la sincronizzazione delle informazioni dello smartwatch con l'immagine della telecamera a colori, poiché queste hanno frequenze diverse. ...

Divulgazioni

Gli autori dichiarano di non avere interessi finanziari concorrenti noti o relazioni personali che possano aver influenzato il lavoro riportato in questo articolo.

Riconoscimenti

Questo lavoro è stato sviluppato con il finanziamento di Programa Prometeo, ID progetto CIPROM/2021/017. La Prof.ssa Rosabel Roig è titolare della cattedra UNESCO "Educazione, Ricerca e Inclusione Digitale".

Materiali

| Name | Company | Catalog Number | Comments |

| 4 GPUs Nvidia A40 Ampere | NVIDIA | TCSA40M-PB | GPU for centralized model processing server |

| FusionServer 2288H V5 | X-Fusion | 02311XBK | Platform that includes power supply and motherboard for centralized model processing server |

| Memory Card Evo Plus 128 GB | Samsung | MB-MC128KA/EU | Memory card for the operation of the raspberry pi 4b 2gb. One for each raspberry. |

| NEMIX RAM - 512 GB Kit DDR4-3200 PC4-25600 8Rx4 EC | NEMIX | M393AAG40M32-CAE | RAM for centralized model processing server |

| Processor Intel Xeon Gold 6330 | Intel | CD8068904572101 | Processor for centralized model processing server |

| Raspberry PI 4B 2GB | Raspberry | 1822095 | Local server that receives requests from the clocks and sends them to the general server. One every two students. |

| Samsung Galaxy Watch 5 (40mm) | Samsung | SM-R900NZAAPHE | Clock that monitors each student's activity. For each student. |

| Samsung MZQL23T8HCLS-00B7C PM9A3 3.84Tb Nvme U.2 PCI-Express-4 x4 2.5inch Ssd | Samsung | MZQL23T8HCLS-00B7C | Internal storage for centralized model processing server |

| WebCam HD Pro C920 Webcam FullHD | Logitech | 960-001055 | Webcam HD. One for each student plus two for student poses. |

Riferimenti

- Hasnine, M. N., et al. Students' emotion extraction and visualization for engagement detection in online learning. Procedia Comp Sci. 192, 3423-3431 (2021).

- Khare, S. K., Blanes-Vidal, V., Nadimi, E. S., Acharya, U. R. Emotion recognition and artificial intelligence: A systematic review (2014-2023) and research recommendations. Info Fusion. 102, 102019 (2024).

- Bosch, N. Detecting student engagement: Human versus machine. UMAP '16: Proc the 2016 Conf User Model Adapt Personal. , 317-320 (2016).

- Araya, R., Sossa-Rivera, J. Automatic detection of gaze and body orientation in elementary school classrooms. Front Robot AI. 8, 729832 (2021).

- Lu, Y., Zhang, J., Li, B., Chen, P., Zhuang, Z. Harnessing commodity wearable devices for capturing learner engagement. IEEE Access. 7, 15749-15757 (2019).

- Vanneste, P., et al. Computer vision and human behaviour, emotion and cognition detection: A use case on student engagement. Mathematics. 9 (3), 287 (2021).

- Ma, X., Xu, M., Dong, Y., Sun, Z. Automatic student engagement in online learning environment based on neural Turing machine. Int J Info Edu Tech. 11 (3), 107-111 (2021).

- Wood, E., Bulling, A. EyeTab: model-based gaze estimation on unmodified tablet computers. ETRA '14: Proc Symp Eye Tracking Res Appl. , 207-210 (2014).

- Sanghvi, J., et al. Automatic analysis of affective postures and body motion to detect engagement with a game companion. HRI '11: Proc 6th Int Conf Human-robot Interact. , 205-211 (2011).

- Gupta, S., Kumar, P., Tekchandani, R. K. Facial emotion recognition based real-time learner engagement detection system in online learning context using deep learning models. Multimed Tools Appl. 82 (8), 11365-11394 (2023).

- Altuwairqi, K., Jarraya, S. K., Allinjawi, A., Hammami, M. Student behavior analysis to measure engagement levels in online learning environments. Signal Image Video Process. 15 (7), 1387-1395 (2021).

- Belle, A., Hargraves, R. H., Najarian, K. An automated optimal engagement and attention detection system using electrocardiogram. Comput Math Methods Med. 2012, 528781 (2012).

- Alban, A. Q., et al. Heart rate as a predictor of challenging behaviours among children with autism from wearable sensors in social robot interactions. Robotics. 12 (2), 55 (2023).

- Kajiwara, Y., Shimauchi, T., Kimura, H. Predicting emotion and engagement of workers in order picking based on behavior and pulse waves acquired by wearable devices. Sensors. 19 (1), 165 (2019).

- Costante, G., Porzi, L., Lanz, O., Valigi, P., Ricci, E. Personalizing a smartwatch-based gesture interface with transfer learning. , 2530-2534 (2014).

- Mekruksavanich, S., Jitpattanakul, A. Deep convolutional neural network with RNNs for complex activity recognition using wrist-worn wearable sensor data. Electronics. 10 (14), 1685 (2021).

- Bazarevsky, V., Kartynnik, Y., Vakunov, A., Raveendran, K., Grundmann, M. BlazeFace: Sub-millisecond Neural Face Detection on Mobile GPUs. arXiv. , (2019).

- Bazarevsky, V., et al. BlazePose: On-device Real-time Body Pose tracking. arXiv. , (2020).

- Mejia-Escobar, C., Cazorla, M., Martinez-Martin, E. Towards a better performance in facial expression recognition: a data-centric approach. Comput Intelligence Neurosci. , (2023).

- El-Garem, A., Adel, R. Applying systematic literature review and Delphi methods to explore digital transformation key success factors. Int J Eco Mgmt Engi. 16 (7), 383-389 (2022).

- Indumathi, V., Kist, A. A. Using electroencephalography to determine student attention in the classroom. , 1-3 (2023).

- Ma, X., Xie, Y., Wang, H. Research on the construction and application of teacher-student interaction evaluation system for smart classroom in the post COVID-19. Studies Edu Eval. 78, 101286 (2023).

- Andersen, D. Constructing Delphi statements for technology foresight. Futures Foresight Sci. 5 (2), e144 (2022).

- Khodyakov, D., et al. Disciplinary trends in the use of the Delphi method: A bibliometric analysis. PLoS One. 18 (8), e0289009 (2023).

- Martins, A. I., et al. Consensus on the Terms and Procedures for Planning and Reporting a Usability Evaluation of Health-Related Digital Solutions: Delphi Study and a Resulting Checklist. J Medical Internet Res. 25, e44326 (2023).

- Dalmaso, M., Castelli, L., Galfano, G. Social modulators of gaze-mediated orienting of attention: A review. Psychon Bull Rev. 27 (5), 833-855 (2020).

- Klein, R. M. Thinking about attention: Successive approximations to a productive taxonomy. Cognition. 225, 105137 (2022).

- Schindler, S., Bublatzky, F. Attention and emotion: An integrative review of emotional face processing as a function of attention. Cortex. 130, 362-386 (2020).

- Zaletelj, J., Košir, A. Predicting students' attention in the classroom from Kinect facial and body features. J Image Video Proc. 80, (2017).

- Strauch, C., Wang, C. A., Einhäuser, W., Van der Stigchel, S., Naber, M. Pupillometry as an integrated readout of distinct attentional networks. Trends Neurosci. 45 (8), 635-647 (2022).

Ristampe e Autorizzazioni

Richiedi autorizzazione per utilizzare il testo o le figure di questo articolo JoVE

Richiedi AutorizzazioneThis article has been published

Video Coming Soon