JoVE 비디오를 활용하시려면 도서관을 통한 기관 구독이 필요합니다. 전체 비디오를 보시려면 로그인하거나 무료 트라이얼을 시작하세요.

Method Article

학생의 주의력 수준을 감지하기 위한 인공 지능 기반 시스템

요약

이 논문은 학생들이 수업에 집중하고 있는지 또는 주의가 산만한지 자동으로 감지하는 인공 지능 기반 시스템을 제안합니다. 이 시스템은 교사가 학생들의 주의를 유지하고, 수업을 최적화하고, 학생들의 참여를 돕기 위해 동적으로 수정 사항을 도입할 수 있도록 설계되었습니다.

초록

교실에서 학생들의 주의력 수준은 인공 지능(AI) 기술을 사용하여 향상시킬 수 있습니다. 주의 수준을 자동으로 식별함으로써 교사는 학생들의 집중력을 되찾기 위한 전략을 사용할 수 있습니다. 이는 다양한 정보 소스를 통해 달성할 수 있습니다.

한 가지 원천은 학생들의 얼굴에 반영된 감정을 분석하는 것입니다. AI는 중립, 혐오, 놀람, 슬픔, 두려움, 행복, 분노와 같은 감정을 감지할 수 있습니다. 또한 학생들의 시선 방향은 잠재적으로 학생들의 관심 수준을 나타낼 수도 있습니다. 또 다른 출처는 학생들의 신체 자세를 관찰하는 것입니다. 카메라와 딥 러닝 기술을 사용하여 자세를 분석하여 주의 수준을 결정할 수 있습니다. 예를 들어, 구부정한 자세를 취하거나 책상에 머리를 기대고 있는 학생은 주의력이 떨어질 수 있습니다. 학생들에게 배포되는 스마트워치는 심박수 및 관성 측정을 포함한 생체 인식 및 기타 데이터를 제공할 수 있으며, 이는 주의의 지표로도 사용할 수 있습니다. 이러한 정보 소스를 결합함으로써 AI 시스템은 교실에서 주의 수준을 식별하도록 훈련할 수 있습니다. 그러나 다양한 유형의 데이터를 통합하려면 레이블이 지정된 데이터 세트를 만들어야 하는 문제가 발생합니다. 정확한 라벨링을 위해 전문가의 의견과 기존 연구를 참조합니다. 이 논문에서는 이러한 측정의 통합과 데이터 세트 및 잠재적인 주의 분류기의 생성을 제안합니다. 교사에게 피드백을 제공하기 위해 스마트 워치 또는 다이렉트 컴퓨터와 같은 다양한 방법을 탐색합니다. 교사가 주의력 문제를 인식하게 되면 학생들을 다시 참여시키고 동기를 부여하기 위해 교수 방식을 조정할 수 있습니다. 요약하면, AI 기술은 학생들의 감정, 시선 방향, 신체 자세 및 생체 인식 데이터를 분석하여 학생들의 주의 수준을 자동으로 식별할 수 있습니다. 이 정보는 교사가 교수-학습 과정을 최적화하는 데 도움이 될 수 있습니다.

서문

현대 교육 환경에서 학생들의 주의를 정확하게 평가하고 유지하는 것은 효과적인 교수 및 학습에 매우 중요합니다. 그러나 자기 보고 또는 주관적인 교사 관찰과 같은 참여도를 측정하는 전통적인 방법은 시간이 많이 걸리고 편향이 발생하기 쉽습니다. 이 문제를 해결하기 위해 인공 지능(AI) 기술이 자동화된 주의 감지를 위한 유망한 솔루션으로 부상했습니다. 학생들의 참여 수준을 이해하는 데 있어 한 가지 중요한 측면은 감정 인식이다1. AI 시스템은 얼굴 표정을 분석하여 중립, 혐오, 놀람, 슬픔, 두려움, 행복, 분노와 같은 감정을 식별할 수 있습니다2.

시선 방향과 몸의 자세도 학생들의 주의력을 나타내는 중요한 지표이다3. AI 시스템은 카메라와 고급 머신 러닝 알고리즘을 활용하여 학생들이 보는 곳을 정확하게 추적하고 신체 자세를 분석하여 무관심이나 피로의 징후를 감지할 수 있습니다4. 또한, 생체 인식 데이터를 통합하면 주의 감지의 정확성과 신뢰성이 향상된다5. 학생들이 착용하는 스마트워치를 통해 심박수 및 혈중 산소 포화도와 같은 측정값을 수집함으로써 주의력에 대한 객관적인 지표를 얻을 수 있고 다른 정보 소스를 보완할 수 있습니다.

이 논문은 컬러 카메라 및 기타 다양한 센서를 사용하여 개인의 주의 수준을 평가하는 시스템을 제안합니다. 감정 인식, 시선 방향 분석, 신체 자세 평가 및 생체 인식 데이터를 결합하여 교육자에게 교수-학습 프로세스를 최적화하고 학생 참여를 개선하기 위한 포괄적인 도구 세트를 제공합니다. 이러한 도구를 사용함으로써 교육자는 교수-학습 과정에 대한 포괄적인 이해를 얻고 학생 참여를 향상시켜 전반적인 교육 경험을 최적화할 수 있습니다. AI 기술을 적용하면 이 데이터를 자동으로 평가할 수도 있습니다.

이 작업의 주요 목표는 모든 정보를 캡처할 수 있는 시스템을 설명하고, 캡처한 후에는 실시간으로 전체 학급의 관심을 끌 수 있는 AI 모델을 훈련시키는 것입니다. 다른 연구에서는 이미 시각 또는 감성적 정보를 사용하여 관심을 끌 것을 제안했지만6 이 연구는 보다 복잡하고 효과적인 AI 기술을 사용할 수 있도록 총체적인 접근 방식을 제공하는 이러한 기술의 결합 사용을 제안합니다. 또한 지금까지 사용 가능한 데이터 세트는 비디오 세트 또는 생체 인식 데이터 중 하나로 제한됩니다. 문헌에는 학생의 얼굴이나 신체 이미지, 생체 인식 데이터, 교사의 위치에 대한 데이터 등이 포함된 완전한 데이터를 제공하는 데이터 세트가 포함되어 있지 않습니다. 여기에 제시된 시스템을 사용하면 이러한 유형의 데이터 세트를 캡처할 수 있습니다.

시스템은 각 시점에서 각 학생에 대한 관심 수준을 연결합니다. 이 값은 0%에서 100% 사이의 관심 확률 값으로, 낮은 주의 수준(0%-40%), 중간 수준의 주의(40%-75%) 및 높은 주의 수준(75%-100%)으로 해석될 수 있습니다. 텍스트 전체에서 이 주의 확률은 주의 수준, 학생 주의 또는 학생이 산만한지 여부라고 하지만 모두 시스템의 동일한 출력 값과 관련이 있습니다.

수년에 걸쳐 자동 참여 감지 분야는 교육에 혁명을 일으킬 수 있는 잠재력으로 인해 크게 성장했습니다. 연구자들은 이 연구 분야에 대한 다양한 접근 방식을 제안했습니다.

Ma et al.7 은 자동 교전 인식을 위한 뉴럴 튜링 머신(Neural Turing Machine)을 기반으로 하는 새로운 방법을 소개했습니다. 그들은 시선 응시, 얼굴 동작 단위, 머리 자세 및 신체 자세와 같은 특정 기능을 추출하여 참여 인식을 포괄적으로 표현했습니다.

또 다른 혁신적인 시스템인 아이탭 8(EyeTab8)은 모델을 사용하여 사람이 두 눈으로 어디를 보고 있는지 추정했습니다. 수정 없이 표준 태블릿에서 원활하게 작동하도록 특별히 제작되었습니다. 이 시스템은 이미지 처리 및 컴퓨터 비전 분석을 위해 잘 알려진 알고리즘을 활용합니다. 그들의 시선 추정 파이프라인에는 Haar와 같은 특징 기반 눈 감지기와 RANSAC 기반 limbus ellipse fitting 접근 방식이 포함됩니다.

상비(Sanghvi) 등9 은 시각 기반 기법을 사용하여 측면 시점으로 녹화된 비디오에서 표현적인 자세 특징을 자동으로 추출하여 어린이의 행동을 포착하는 접근 방식을 제안합니다. 상황에 맞는 정서적 자세 표현을 사용하여 여러 인식 모델의 훈련을 포함하는 초기 평가가 수행됩니다. 얻어진 결과는 자세 행동 패턴이 로봇과 어린이의 참여를 효과적으로 예측할 수 있음을 보여줍니다.

Gupta et al.10과 같은 다른 연구에서는 딥 러닝 기반 방법을 사용하여 얼굴 표정을 분석하고 감정을 분류하여 온라인 학습자의 실시간 참여를 감지합니다. 이 접근 방식은 얼굴 감정 인식을 활용하여 참여 및 이탈의 두 가지 참여 상태를 예측하는 참여 지수(EI)를 계산합니다. Inception-V3, VGG19 및 ResNet-50을 포함한 다양한 딥 러닝 모델을 평가하고 비교하여 실시간 참여 감지를 위한 가장 효과적인 예측 분류 모델을 식별합니다.

Altuwairqi et al.11에서 연구원들은 학생 참여 수준을 실시간으로 평가하기 위한 새로운 자동 다중 모드 접근 방식을 제시합니다. 정확하고 신뢰할 수 있는 측정을 보장하기 위해 연구팀은 학생들의 행동을 포착하는 세 가지 뚜렷한 양식, 즉 감정에 대한 얼굴 표정, 키보드 키 입력, 마우스 움직임을 통합하고 분석했습니다.

Guillén et al.12 은 작업을 수행하는 동안 개인의 인지적 주의의 유무를 분석하고 예측하기 위해 심전도(ECG)를 주요 생리학적 신호로 사용하는 모니터링 시스템의 개발을 제안합니다.

Alban et al.13 은 신경망(NN)을 활용하여 시간 및 주파수 영역에서 다양한 참가자의 심박수(HR) 및 전기 활동(EDA) 값을 분석하여 감정을 감지합니다. 그들은 RMSDD(Root-Mean-Square of Consecutive Differences) 및 SDNN(Standard Devation Normal-to-Normal) 간격의 증가와 평균 HR의 감소가 두려움과 관련된 교감신경계의 활동이 증가했음을 나타낸다는 것을 발견했습니다.

Kajiwara 등[14 ]은 웨어러블 센서와 심층 신경망을 사용하여 근로자의 감정 및 참여 수준을 예측하는 혁신적인 시스템을 제안합니다. 시스템은 3단계 프로세스를 따릅니다. 처음에는 웨어러블 센서가 동작과 맥파에 대한 데이터를 캡처하고 수집합니다. 그 후, 시계열 특징은 획득된 행동 및 생리학적 데이터를 기반으로 계산됩니다. 마지막으로, 심층 신경망은 시계열 기능을 입력하고 개인의 감정과 참여 수준을 예측하는 데 사용됩니다.

Costante et al.15과 같은 다른 연구에서는 사용자 정의 제스처의 인식을 향상시키기 위해 사전 정의된 제스처 세트에 대한 사전 지식을 활용하는 새로운 전송 메트릭 학습 알고리즘을 기반으로 하는 접근 방식이 제안됩니다. 이러한 개선은 추가 학습 샘플에 대한 의존도를 최소화하면서 달성됩니다. 이와 유사하게, 센서 기반 인간 활동 인식 프레임워크(sensor-based human activity recognition framework)(16)는 복잡한 인간 활동에 대한 비인격적 인식의 목표를 다루기 위해 제시된다. 손목에 착용하는 센서에서 수집된 신호 데이터는 웨어러블 장치 사용자가 수행한 활동을 조사하기 위해 4개의 RNN 기반 DL 모델(Long-Short Term Memories, Bidirectional Long-Short Term Memories, Gated Recurrent Units 및 Bidirectional Gated Recurrent Units)을 사용하여 개발된 인간 활동 인식 프레임워크에 활용됩니다.

프로토콜

다음 프로토콜은 승인된 프로토콜 번호 UA-2022-11-12로 알리칸테 대학교의 인간 연구 윤리 위원회의 지침을 따릅니다. 이 실험 및 여기의 데이터 사용에 대해 모든 참가자로부터 정보에 입각한 동의를 얻었습니다.

1. 하드웨어, 소프트웨어 및 클래스 설정

- WiFi 기능이 있는 라우터(실험은 DLink DSR 1000AC를 사용하여 수행됨)를 원하는 위치에 설정하여 범위가 전체 방을 포함하도록 합니다. 여기에서는 30명의 학생이 있는 25m2 교실을 대상으로 했습니다.

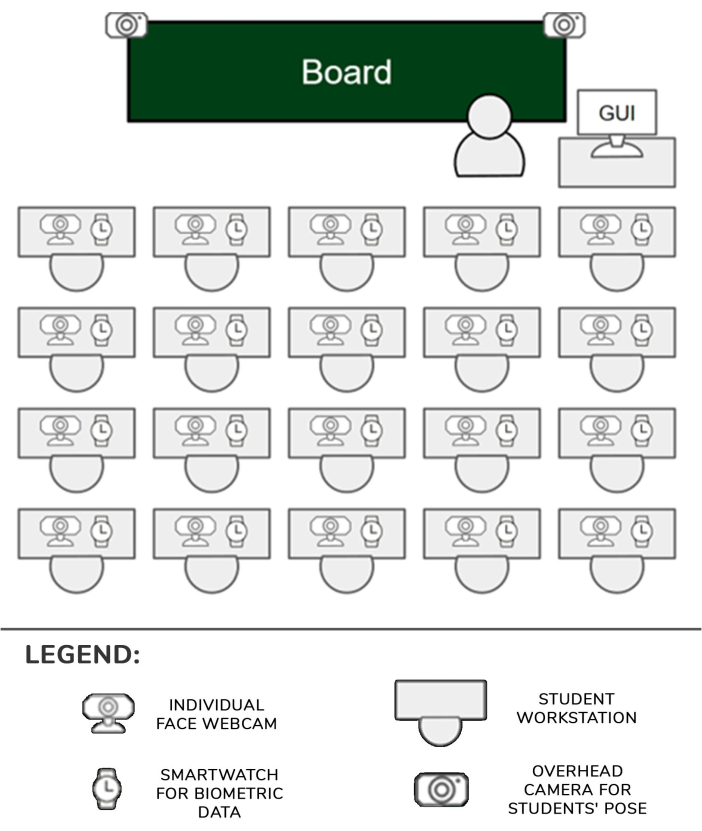

- 각 학생 위치에 대해 하나의 스마트워치(여기에서 Samsung Galaxy Smartwatch 5)와 하나의 카메라(여기에서 Logitech C920 카메라)를 설정합니다. 학생 2명당 1개의 내장 장치를 설정합니다. 두 개의 삼각대에 두 대의 카메라를 고정하고 다른 내장 장치(이하 천정 카메라라고 함)에 연결합니다.

- USB 링크를 사용하여 카메라를 해당 내장 장치에 연결하고 전원을 켭니다. 스마트워치도 켭니다. 모든 임베디드 장치와 스마트워치를 1.1단계에서 설정한 라우터의 WiFi 네트워크에 연결합니다.

- 카메라를 각 학생의 책상 구석에 놓고 이미지에서 학생의 얼굴이 명확하게 보이도록 앞쪽으로 향하게 하고 약간 위쪽으로 기울입니다.

- 카메라가 있는 두 개의 삼각대를 교실 첫 번째 줄 좌석의 통로에서 가장 가까운 책상 앞에 놓습니다. 카메라가 대부분의 학생을 명확하게 볼 수 있도록 삼각대 라이저를 가장 높은 위치로 이동합니다. 각 임베디드 장치는 한 명 또는 두 명의 학생과 해당 카메라 및 시계를 관리할 수 있습니다. 설정은 그림 1에 나와 있습니다.

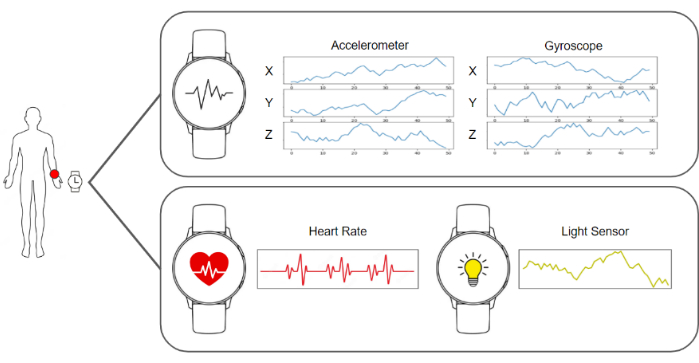

- 스마트워치와 임베디드 장치에서 캡처 소프트웨어를 실행하여 이미지와 가속도계, 자이로스코프, 심박수 및 조명 데이터를 보낼 준비가 되도록 합니다. 데이터를 수집하고 저장하는 서버 소프트웨어를 실행합니다. 이러한 모든 요소의 다이어그램은 그림 2에서 볼 수 있습니다.

- 천정 카메라가 장면을 지배하여 학생들의 신체를 명확하게 볼 수 있도록 합니다. 각 학생 앞에 개별 카메라를 추가로 배치합니다.

- 학생들을 제자리에 앉히게 하고, 실험의 목표를 알리고, 주로 사용하는 손에 스마트워치를 착용하고 설정의 어떤 요소와도 상호 작용하지 않도록 지시합니다.

- 서버에서 데이터 캡처 및 수집을 시작하고 평소와 같이 수업 수업을 재개합니다.

그림 1: 하드웨어 및 데이터 파이프라인. 카메라와 스마트워치 데이터가 수집되어 기계 학습 알고리즘에 공급되어 처리됩니다. 이 그림의 더 큰 버전을 보려면 여기를 클릭하십시오.

그림 2: 센서, 교사 및 학생의 위치. 교사와 학생이 있는 교실에서 카메라, 스마트워치 및 GUI의 위치를 보여주는 다이어그램. 이 그림의 더 큰 버전을 보려면 여기를 클릭하십시오.

2. 캡처 및 데이터 처리 파이프라인

참고: 이러한 모든 단계는 서버에 배포된 소프트웨어를 처리하여 자동으로 수행됩니다. 이 작업의 실험에 사용된 구현은 Python 3.8로 작성되었습니다.

- 각 학생에 대한 스마트워치의 모든 이미지와 생체 인식 데이터를 수집하여 필요한 데이터를 수집하고 1초의 데이터를 포함하는 데이터 프레임을 구축합니다. 이 데이터 프레임은 개별 카메라의 이미지 1개, 각 천정 카메라의 이미지 1개(이 경우 2개), 3개의 자이로스코프 값에 대한 50개의 레지스터, 3개의 가속도계 값에 대한 50개의 레지스터, 1개의 심박수 값 및 1개의 조명 상태 값으로 구성됩니다.

- 머리 방향을 계산하기 위한 첫 번째 단계는 학생의 얼굴을 가리키는 웹캠을 사용하여 이미지를 검색하는 것입니다. 그런 다음 해당 이미지는 BlazeFace17 랜드마크 추정 알고리즘에 의해 처리됩니다. 이러한 알고리즘의 출력은 얼굴의 특정 영역에 해당하는 2D 키 포인트 목록입니다.

- 알고리즘에서 제공하는 눈, 코, 입 및 턱의 추정 위치를 사용하여 표준 얼굴 설정인 OpenCV 라이브러리의 cv::SolvePnPMethod 메서드를 사용하여 원근 n점 문제를 풉니다. 머리 방향을 정의하는 회전 행렬은 이 절차의 결과로 얻어집니다.

- 학생이 묘사된 데이터 프레임의 천정 이미지를 BlazePose18 랜드마크 추정 알고리즘으로 전달하여 신체 포즈를 계산하고 이미지에 묘사된 신체 관절의 2D 좌표 목록을 검색합니다. 이 랜드마크 목록은 학생의 포즈를 설명합니다.

알림: 신체 포즈는 수업 중 다양한 활동에 대한 학생의 참여를 정확하게 나타낼 수 있으므로 중요합니다. 예를 들어, 학생이 책상에 손을 얹고 자연스럽게 앉아 있다면 메모를 하고 있다는 의미일 수 있습니다. 반대로, 그들이 계속해서 팔을 움직이고 있다면, 그것은 그들이 누군가에게 말하고 있다는 것을 의미할 수 있습니다. - 학습자의 얼굴 이미지를 얻고 정렬 전처리를 수행한다. 2.3단계에서 계산된 목록에서 눈의 키 포인트를 검색하고 이미지 평면에 투영하여 눈의 위치를 얻습니다.

- 양쪽 눈의 위치를 결합하는 가상 벡터를 추적합니다. 해당 벡터와 수평선 사이의 각도를 계산하고 호모그래피 행렬을 구축하여 이미지와 키 포인트에 역각도를 적용하여 눈이 수평으로 정렬되도록 합니다.

- 한계를 감지하기 위해 키 포인트를 사용하여 얼굴을 자르고 패치를 감정 감지 컨볼루션 신경망(19)에 공급합니다. 신경망에서 7개의 위치가 있는 벡터인 출력값을 가져오며, 각 위치는 얼굴이 7가지 기본 감정(중립, 행복, 혐오, 화남, 무서움, 놀라움, 슬픔) 중 하나를 나타낼 확률을 제공합니다.

- 데이터 프레임에서 가속도계, 자이로스코프 및 심박수 데이터를 얻어 주의 수준을 측정합니다(그림 3).

- 대표적인 결과에 설명된 처음부터 맞춤형으로 구축되고 훈련된 딥 러닝 기반 모델에 가속도계 및 자이로스코프 데이터 스트림을 제공합니다. 그림 4와 같이 4개의 위치가 있는 벡터인 모델에서 출력을 검색하며, 각 위치는 데이터가 필기, 키보드 입력, 휴대폰 사용 또는 휴식과 같은 가능한 작업 중 하나를 나타낼 확률을 제공합니다.

- 머리 방향, 감정 인식 출력, 신체 자세, 자이로스코프, 가속도계 및 심박수 데이터를 병합하여 이전 시스템의 모든 결과를 선형화하여 최종 주의 분류기에 제공합니다. 이 최종 분류자에서 0에서 100까지의 점수인 결과를 검색합니다. 이 연속적인 값을 낮은 주의 수준(0-40%), 중간 주의 수준(40%-75%) 및 높은 주의 수준(75% - 100%)의 세 가지 가능한 개별 주의 범주 중 하나로 분류합니다. 생성된 데이터셋의 구조는 표 1에 나와 있습니다.

- 일반 웹 브라우저에서 액세스할 수 있는 교사의 컴퓨터에서 그래픽 사용자 인터페이스(GUI)를 사용하여 교사에게 주의 수준의 결과를 표시합니다.

그림 3: 스마트워치로 캡처한 데이터. 스마트워치는 자이로스코프, 가속도계, 심박수 및 조명 상태를 데이터 스트림으로 제공합니다. 이 그림의 더 큰 버전을 보려면 여기를 클릭하십시오.

그림 4: 활동 인식 모델에서 고려하는 범주의 예. 활동 인식 모델은 네 가지 다른 동작, 즉 필기, 키보드로 입력, 스마트폰 사용, 휴식 자세를 인식합니다. 이 그림의 더 큰 버전을 보려면 여기를 클릭하십시오.

결과

이 연구의 대상 그룹은 학부생과 석사생이므로 주요 연령 그룹은 18세에서 25세 사이입니다. 이 모집단은 어린 학생들보다 산만함이 적은 전자 장치를 다룰 수 있기 때문에 선택되었습니다. 이 그룹에는 총 25명이 포함되었습니다. 이 연령대는 제안서를 테스트하기 위해 가장 신뢰할 수 있는 결과를 제공할 수 있습니다.

교사에게 보여지는 주의 수준의 결과는 2부분으로 나뉩니...

토론

이 연구는 카메라, 스마트워치, 인공지능 알고리즘을 이용해 교실에서 학생의 주의력을 측정하는 시스템을 제시한다. 이 정보는 교사가 학급의 일반적인 상태에 대해 알 수 있도록 교사에게 제공됩니다.

프로토콜의 주요 중요한 단계 중 하나는 주파수가 다르기 때문에 스마트 워치 정보를 컬러 카메라 이미지와 동기화하는 것입니다. 이 문제는 라즈베리를 서버로 배포하여 ?...

공개

저자들은 이 논문에 보고된 연구에 영향을 미칠 수 있는 경쟁적인 재정적 이해관계나 개인적 관계를 알지 못한다고 선언합니다.

감사의 말

이 작업은 Programa Prometeo(프로젝트 ID CIPROM/2021/017)의 자금 지원으로 개발되었습니다. Rosabel Roig 교수는 유네스코 "교육, 연구 및 디지털 포용"의 의장입니다.

자료

| Name | Company | Catalog Number | Comments |

| 4 GPUs Nvidia A40 Ampere | NVIDIA | TCSA40M-PB | GPU for centralized model processing server |

| FusionServer 2288H V5 | X-Fusion | 02311XBK | Platform that includes power supply and motherboard for centralized model processing server |

| Memory Card Evo Plus 128 GB | Samsung | MB-MC128KA/EU | Memory card for the operation of the raspberry pi 4b 2gb. One for each raspberry. |

| NEMIX RAM - 512 GB Kit DDR4-3200 PC4-25600 8Rx4 EC | NEMIX | M393AAG40M32-CAE | RAM for centralized model processing server |

| Processor Intel Xeon Gold 6330 | Intel | CD8068904572101 | Processor for centralized model processing server |

| Raspberry PI 4B 2GB | Raspberry | 1822095 | Local server that receives requests from the clocks and sends them to the general server. One every two students. |

| Samsung Galaxy Watch 5 (40mm) | Samsung | SM-R900NZAAPHE | Clock that monitors each student's activity. For each student. |

| Samsung MZQL23T8HCLS-00B7C PM9A3 3.84Tb Nvme U.2 PCI-Express-4 x4 2.5inch Ssd | Samsung | MZQL23T8HCLS-00B7C | Internal storage for centralized model processing server |

| WebCam HD Pro C920 Webcam FullHD | Logitech | 960-001055 | Webcam HD. One for each student plus two for student poses. |

참고문헌

- Hasnine, M. N., et al. Students' emotion extraction and visualization for engagement detection in online learning. Procedia Comp Sci. 192, 3423-3431 (2021).

- Khare, S. K., Blanes-Vidal, V., Nadimi, E. S., Acharya, U. R. Emotion recognition and artificial intelligence: A systematic review (2014-2023) and research recommendations. Info Fusion. 102, 102019 (2024).

- Bosch, N. Detecting student engagement: Human versus machine. UMAP '16: Proc the 2016 Conf User Model Adapt Personal. , 317-320 (2016).

- Araya, R., Sossa-Rivera, J. Automatic detection of gaze and body orientation in elementary school classrooms. Front Robot AI. 8, 729832 (2021).

- Lu, Y., Zhang, J., Li, B., Chen, P., Zhuang, Z. Harnessing commodity wearable devices for capturing learner engagement. IEEE Access. 7, 15749-15757 (2019).

- Vanneste, P., et al. Computer vision and human behaviour, emotion and cognition detection: A use case on student engagement. Mathematics. 9 (3), 287 (2021).

- Ma, X., Xu, M., Dong, Y., Sun, Z. Automatic student engagement in online learning environment based on neural Turing machine. Int J Info Edu Tech. 11 (3), 107-111 (2021).

- Wood, E., Bulling, A. EyeTab: model-based gaze estimation on unmodified tablet computers. ETRA '14: Proc Symp Eye Tracking Res Appl. , 207-210 (2014).

- Sanghvi, J., et al. Automatic analysis of affective postures and body motion to detect engagement with a game companion. HRI '11: Proc 6th Int Conf Human-robot Interact. , 205-211 (2011).

- Gupta, S., Kumar, P., Tekchandani, R. K. Facial emotion recognition based real-time learner engagement detection system in online learning context using deep learning models. Multimed Tools Appl. 82 (8), 11365-11394 (2023).

- Altuwairqi, K., Jarraya, S. K., Allinjawi, A., Hammami, M. Student behavior analysis to measure engagement levels in online learning environments. Signal Image Video Process. 15 (7), 1387-1395 (2021).

- Belle, A., Hargraves, R. H., Najarian, K. An automated optimal engagement and attention detection system using electrocardiogram. Comput Math Methods Med. 2012, 528781 (2012).

- Alban, A. Q., et al. Heart rate as a predictor of challenging behaviours among children with autism from wearable sensors in social robot interactions. Robotics. 12 (2), 55 (2023).

- Kajiwara, Y., Shimauchi, T., Kimura, H. Predicting emotion and engagement of workers in order picking based on behavior and pulse waves acquired by wearable devices. Sensors. 19 (1), 165 (2019).

- Costante, G., Porzi, L., Lanz, O., Valigi, P., Ricci, E. Personalizing a smartwatch-based gesture interface with transfer learning. , 2530-2534 (2014).

- Mekruksavanich, S., Jitpattanakul, A. Deep convolutional neural network with RNNs for complex activity recognition using wrist-worn wearable sensor data. Electronics. 10 (14), 1685 (2021).

- Bazarevsky, V., Kartynnik, Y., Vakunov, A., Raveendran, K., Grundmann, M. BlazeFace: Sub-millisecond Neural Face Detection on Mobile GPUs. arXiv. , (2019).

- Bazarevsky, V., et al. BlazePose: On-device Real-time Body Pose tracking. arXiv. , (2020).

- Mejia-Escobar, C., Cazorla, M., Martinez-Martin, E. Towards a better performance in facial expression recognition: a data-centric approach. Comput Intelligence Neurosci. , (2023).

- El-Garem, A., Adel, R. Applying systematic literature review and Delphi methods to explore digital transformation key success factors. Int J Eco Mgmt Engi. 16 (7), 383-389 (2022).

- Indumathi, V., Kist, A. A. Using electroencephalography to determine student attention in the classroom. , 1-3 (2023).

- Ma, X., Xie, Y., Wang, H. Research on the construction and application of teacher-student interaction evaluation system for smart classroom in the post COVID-19. Studies Edu Eval. 78, 101286 (2023).

- Andersen, D. Constructing Delphi statements for technology foresight. Futures Foresight Sci. 5 (2), e144 (2022).

- Khodyakov, D., et al. Disciplinary trends in the use of the Delphi method: A bibliometric analysis. PLoS One. 18 (8), e0289009 (2023).

- Martins, A. I., et al. Consensus on the Terms and Procedures for Planning and Reporting a Usability Evaluation of Health-Related Digital Solutions: Delphi Study and a Resulting Checklist. J Medical Internet Res. 25, e44326 (2023).

- Dalmaso, M., Castelli, L., Galfano, G. Social modulators of gaze-mediated orienting of attention: A review. Psychon Bull Rev. 27 (5), 833-855 (2020).

- Klein, R. M. Thinking about attention: Successive approximations to a productive taxonomy. Cognition. 225, 105137 (2022).

- Schindler, S., Bublatzky, F. Attention and emotion: An integrative review of emotional face processing as a function of attention. Cortex. 130, 362-386 (2020).

- Zaletelj, J., Košir, A. Predicting students' attention in the classroom from Kinect facial and body features. J Image Video Proc. 80, (2017).

- Strauch, C., Wang, C. A., Einhäuser, W., Van der Stigchel, S., Naber, M. Pupillometry as an integrated readout of distinct attentional networks. Trends Neurosci. 45 (8), 635-647 (2022).

재인쇄 및 허가

JoVE'article의 텍스트 или 그림을 다시 사용하시려면 허가 살펴보기

허가 살펴보기더 많은 기사 탐색

This article has been published

Video Coming Soon

Copyright © 2025 MyJoVE Corporation. 판권 소유