Bu içeriği görüntülemek için JoVE aboneliği gereklidir. Oturum açın veya ücretsiz deneme sürümünü başlatın.

Method Article

Öğrencilerdeki Dikkat Düzeylerini Tespit Etmek İçin Yapay Zeka Tabanlı Sistem

Bu Makalede

Özet

Bu makale, öğrencilerin derse dikkat edip etmediklerini veya dikkatlerinin dağılıp dağılmadığını otomatik olarak tespit etmek için yapay zeka tabanlı bir sistem önermektedir. Bu sistem, öğretmenlerin öğrencilerin dikkatini sürdürmelerine, derslerini optimize etmelerine ve daha ilgi çekici olmaları için dinamik olarak değişiklikler yapmalarına yardımcı olmak için tasarlanmıştır.

Özet

Bir sınıftaki öğrencilerin dikkat düzeyi, Yapay Zeka (AI) tekniklerinin kullanılmasıyla geliştirilebilir. Dikkat düzeyini otomatik olarak belirleyerek, öğretmenler öğrencilerin odağını yeniden kazanmak için stratejiler uygulayabilir. Bu, çeşitli bilgi kaynakları aracılığıyla başarılabilir.

Bir kaynak, öğrencilerin yüzlerine yansıyan duyguları analiz etmektir. Yapay zeka, nötr, iğrenme, şaşkınlık, üzüntü, korku, mutluluk ve öfke gibi duyguları algılayabilir. Ek olarak, öğrencilerin bakışlarının yönü de potansiyel olarak dikkat düzeylerini gösterebilir. Diğer bir kaynak ise öğrencilerin vücut duruşlarını gözlemlemektir. Kameralar ve derin öğrenme teknikleri kullanılarak, dikkat düzeyini belirlemek için duruş analiz edilebilir. Örneğin, kambur duran veya başlarını masalarına yaslayan öğrenciler daha düşük bir dikkat seviyesine sahip olabilir. Öğrencilere dağıtılan akıllı saatler, kalp atış hızı ve atalet ölçümleri de dahil olmak üzere biyometrik ve diğer verileri sağlayabilir ve bu veriler aynı zamanda dikkat göstergesi olarak da kullanılabilir. Bu bilgi kaynaklarını birleştirerek, sınıftaki dikkat düzeyini belirlemek için bir yapay zeka sistemi eğitilebilir. Ancak, farklı veri türlerini tümleştirmek, etiketli bir veri kümesi oluşturmayı gerektiren bir zorluk oluşturur. Doğru etiketleme için uzman görüşlerine ve mevcut çalışmalara başvurulur. Bu yazıda, bu tür ölçümlerin entegrasyonunu ve bir veri setinin ve potansiyel bir dikkat sınıflandırıcısının oluşturulmasını öneriyoruz. Öğretmene geri bildirim sağlamak için akıllı saatler veya doğrudan bilgisayarlar gibi çeşitli yöntemleri keşfediyoruz. Öğretmen dikkat sorunlarının farkına vardığında, öğrencileri yeniden meşgul etmek ve motive etmek için öğretim yaklaşımlarını ayarlayabilir. Özetle yapay zeka teknikleri, öğrencilerin duygularını, bakış yönlerini, vücut duruşlarını ve biyometrik verilerini analiz ederek dikkat düzeylerini otomatik olarak belirleyebilir. Bu bilgiler, öğretmenlere öğretme-öğrenme sürecini optimize etmede yardımcı olabilir.

Giriş

Modern eğitim ortamlarında, öğrencilerin dikkatini doğru bir şekilde değerlendirmek ve sürdürmek, etkili öğretme ve öğrenme için çok önemlidir. Bununla birlikte, kendi kendine raporlama veya öznel öğretmen gözlemleri gibi geleneksel katılımı ölçme yöntemleri zaman alıcıdır ve önyargılara eğilimlidir. Bu zorluğun üstesinden gelmek için, Yapay Zeka (AI) teknikleri, otomatik dikkat algılama için umut verici çözümler olarak ortaya çıkmıştır. Öğrencilerin katılım düzeylerini anlamanın önemli bir yönü duygu tanımadır1. Yapay zeka sistemleri, nötr, iğrenme, şaşkınlık, üzüntü, korku, mutluluk ve öfke gibi duyguları tanımlamak için yüz ifadelerini analiz edebilir2.

Bakış yönü ve vücut duruşu da öğrencilerin dikkatinin önemli göstergeleridir3. Yapay zeka sistemleri, kameraları ve gelişmiş makine öğrenimi algoritmalarını kullanarak, öğrencilerin nereye baktıklarını doğru bir şekilde izleyebilir ve ilgisizlik veya yorgunluk belirtilerini tespit etmek için vücut duruşlarını analiz edebilir4. Ayrıca, biyometrik verilerin dahil edilmesi, dikkat algılamanın doğruluğunu ve güvenilirliğini artırır5. Öğrenciler tarafından takılan akıllı saatler aracılığıyla kalp atış hızı ve kan oksijen doygunluğu seviyeleri gibi ölçümler toplanarak, diğer bilgi kaynaklarını tamamlayan objektif dikkat göstergeleri elde edilebilir.

Bu makale, renkli kameralar ve diğer farklı sensörleri kullanarak bireyin dikkat düzeyini değerlendiren bir sistem önermektedir. Eğitimcilere öğretme-öğrenme sürecini optimize etmek ve öğrenci katılımını artırmak için kapsamlı bir araç seti sağlamak için duygu tanıma, bakış yönü analizi, vücut duruşu değerlendirmesi ve biyometrik verileri birleştirir. Eğitimciler bu araçları kullanarak öğretme-öğrenme süreci hakkında kapsamlı bir anlayış kazanabilir ve öğrenci katılımını artırabilir, böylece genel eğitim deneyimini optimize edebilir. Yapay zeka tekniklerini uygulayarak, bu verileri otomatik olarak değerlendirmek bile mümkündür.

Bu çalışmanın temel amacı, tüm bilgileri yakalamamıza izin veren sistemi tanımlamak ve bir kez yakalandıktan sonra, tüm sınıfın dikkatini gerçek zamanlı olarak elde etmemizi sağlayan bir yapay zeka modelini eğitmektir. Diğer çalışmalar zaten görsel veyaduygusal bilgiler kullanarak dikkat çekmeyi önermiş olsa da6, bu çalışma, daha karmaşık ve etkili AI tekniklerinin kullanımına izin vermek için bütünsel bir yaklaşım sağlayan bu tekniklerin birlikte kullanılmasını önermektedir. Ayrıca, şimdiye kadar mevcut olan veri kümeleri ya bir dizi video ya da biyometrik verilerden biriyle sınırlıdır. Literatür, öğrencinin yüzünün veya vücudunun görüntüleri, biyometrik veriler, öğretmenin pozisyonuna ilişkin veriler vb. ile eksiksiz veri sağlayan veri kümeleri içermez. Burada sunulan sistem ile bu tür bir veri kümesini yakalamak mümkündür.

Sistem, her zaman noktasında her öğrenciyle bir dikkat düzeyini ilişkilendirir. Bu değer %0 ile %100 arasında bir dikkat olasılık değeri olup, dikkat düzeyi düşük (%0-%40), orta dikkat düzeyi (%40-%75) ve yüksek dikkat düzeyi (%75-%100) olarak yorumlanabilir. Metin boyunca bu dikkat olasılığı, dikkat düzeyi, öğrencinin dikkati ya da öğrencilerin dikkatinin dağılıp dağılmadığı olarak anılır ancak bunların hepsi sistemimizin aynı çıktı değeri ile ilgilidir.

Yıllar geçtikçe, otomatik katılım algılama alanı, eğitimde devrim yaratma potansiyeli nedeniyle önemli ölçüde büyüdü. Araştırmacılar bu çalışma alanı için çeşitli yaklaşımlar önermişlerdir.

Ma ve ark.7 , otomatik etkileşim tanıma için bir Nöral Turing Makinesine dayalı yeni bir yöntem tanıttı. Etkileşim tanımanın kapsamlı bir temsilini oluşturmak için göz bakışı, yüz hareket birimleri, baş duruşu ve vücut duruşu gibi belirli özellikleri çıkardılar.

Bir başka yenilikçi sistem olan EyeTab8, bir kişinin her iki gözüyle nereye baktığını tahmin etmek için modeller kullandı. Hiçbir değişiklik yapılmadan standart bir tablette sorunsuz çalışacak şekilde özel olarak yapılmıştır. Bu sistem, görüntüleri işlemek ve bilgisayar görüşünü analiz etmek için iyi bilinen algoritmalardan yararlanır. Bakış tahmin boru hattı, Haar benzeri özellik tabanlı bir göz dedektörünün yanı sıra RANSAC tabanlı bir limbus elips uydurma yaklaşımını içerir.

Sanghvi ve ark.9 , çocukların davranışlarını yakalayan, yanal bir görünümden kaydedilen videolardan etkileyici postüral özellikleri otomatik olarak çıkarmak için görme temelli tekniklere dayanan bir yaklaşım önermektedir. Bağlamsallaştırılmış duyuşsal postüral ifadeler kullanılarak çoklu tanıma modellerinin eğitimini içeren bir ilk değerlendirme yapılır. Elde edilen sonuçlar, postüral davranış kalıplarının çocukların robotla olan etkileşimini etkili bir şekilde tahmin edebileceğini göstermektedir.

Gupta ve ark.10 gibi diğer çalışmalarda, yüz ifadelerini analiz ederek ve duygularını sınıflandırarak çevrimiçi öğrenenlerin gerçek zamanlı katılımını tespit etmek için derin öğrenme tabanlı bir yöntem kullanılmaktadır. Yaklaşım, iki etkileşim durumunu tahmin eden bir etkileşim indeksi (EI) hesaplamak için yüz duygu tanımayı kullanır: nişanlı ve nişansız. Inception-V3, VGG19 ve ResNet-50 dahil olmak üzere çeşitli derin öğrenme modelleri, gerçek zamanlı etkileşim tespiti için en etkili tahmine dayalı sınıflandırma modelini belirlemek üzere değerlendirilir ve karşılaştırılır.

Altuwairqi ve ark.11'de araştırmacılar, öğrenci katılım düzeylerini gerçek zamanlı olarak değerlendirmek için yeni bir otomatik multimodal yaklaşım sunmaktadır. Doğru ve güvenilir ölçümler sağlamak için ekip, öğrencilerin davranışlarını yakalayan üç farklı yöntemi entegre etti ve analiz etti: duygular için yüz ifadeleri, klavye tuş vuruşları ve fare hareketleri.

Guillén ve ark.12 , bir görevi yerine getirirken bireylerde bilişsel dikkatin varlığını veya yokluğunu analiz etmek ve tahmin etmek için birincil fizyolojik sinyal olarak elektrokardiyografiyi (EKG) kullanan bir izleme sisteminin geliştirilmesini önermektedir.

Alban ve ark.13 , hem zaman hem de frekans alanlarında çeşitli katılımcıların kalp atış hızı (HR) ve elektrodermal aktivite (EDA) değerlerini analiz ederek duyguları tespit etmek için bir sinir ağı (NN) kullanır. Ardışık farklılıkların (RMSDD) kök-ortalama-karesindeki bir artışın ve standart sapma normal-normal (SDNN) aralıklarının, ortalama HR'deki bir azalma ile birleştiğinde, sempatik sinir sisteminde korku ile ilişkili artan aktiviteyi gösterdiğini bulmuşlardır.

Kajiwara ve ark.14 , çalışanların duygu ve katılım düzeyini tahmin etmek için giyilebilir sensörler ve derin sinir ağları kullanan yenilikçi bir sistem önermektedir. Sistem üç aşamalı bir süreç izler. Başlangıçta, giyilebilir sensörler davranışlar ve nabız dalgaları hakkında veri toplar ve toplar. Daha sonra, zaman serisi özellikleri, elde edilen davranışsal ve fizyolojik verilere dayalı olarak hesaplanır. Son olarak, derin sinir ağları, zaman serisi özelliklerini girmek ve bireyin duyguları ve katılım seviyeleri hakkında tahminlerde bulunmak için kullanılır.

Costante ve ark.15 gibi diğer araştırmalarda, kullanıcı tanımlı hareketlerin tanınmasını geliştirmek için önceden tanımlanmış bir dizi hareketin önceki bilgilerini kullanan yeni bir transfer metriği öğrenme algoritmasına dayalı bir yaklaşım önerilmiştir. Bu iyileştirme, ek eğitim örneklerine en az güvenilerek elde edilir. Benzer şekilde, karmaşık insan faaliyetlerinin kişisel olmayan tanınması hedefini ele almak için sensör tabanlı bir insan etkinliği tanıma çerçevesi16 sunulmuştur. Bileğe takılan sensörlerden toplanan sinyal verileri, giyilebilir cihazın kullanıcısı tarafından gerçekleştirilen aktiviteleri araştırmak için dört RNN tabanlı DL modeli (Uzun-Kısa Süreli Anılar, Çift Yönlü Uzun-Kısa Süreli Anılar, Geçitli Tekrarlayan Birimler ve Çift Yönlü Kapılı Tekrarlayan Birimler) kullanılarak geliştirilen insan aktivitesi tanıma çerçevesinde kullanılır.

Protokol

Aşağıdaki protokol, onaylanmış protokol numarası UA-2022-11-12 ile Alicante Üniversitesi'nin insan araştırmaları etik komitesinin yönergelerini takip eder. Bu deney ve buradaki verilerin kullanımı için tüm katılımcılardan bilgilendirilmiş onam alınmıştır.

1. Donanım, yazılım ve sınıf kurulumu

- WiFi özelliklerine sahip bir yönlendirici (deneyler bir DLink DSR 1000AC kullanılarak gerçekleştirilmiştir) istenen yere, menzili tüm odayı kapsayacak şekilde ayarlayın. Burada 30 öğrencinin bulunduğu 25m2 derslik kapsanmıştır.

- Her öğrenci konumu için bir akıllı saat (burada Samsung Galaxy Smartwatch 5) ve bir kamera (burada Logitech C920 kameralar) ayarlayın. Her iki öğrenci için bir yerleşik cihaz ayarlayın. İki kamerayı iki tripoda sabitleyin ve bunları başka bir gömülü cihaza bağlayın (bundan böyle zenithal kameralar olarak anılacaktır).

- Kameraları bir USB bağlantısıyla ilgili gömülü cihazlara bağlayın ve AÇIN. Akıllı saatleri de AÇIN. Her gömülü cihazı ve akıllı saati, adım 1.1'de ayarlanan yönlendiricinin WiFi ağına bağlayın.

- Kameraları her öğrencinin masasının köşesine yerleştirin ve görüntülerde öğrencinin yüzünün net bir şekilde görülebilmesi için öne doğru ve hafifçe yukarı doğru eğik tutun.

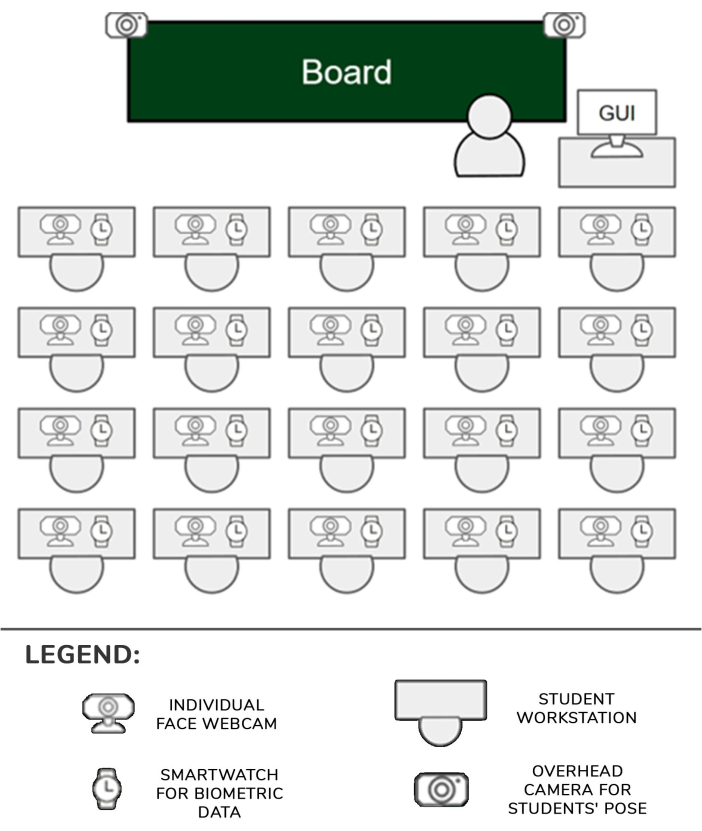

- Kameralarla birlikte iki tripodu, sınıfın ilk koltuk sırasındaki koridorlara en yakın sıraların önüne yerleştirin. Kameraların öğrencilerin çoğunu net bir şekilde görebilmesi için tripod yükselticiyi en yüksek konuma getirin. Her gömülü cihaz, ilgili kameraları ve saatleriyle birlikte bir veya iki öğrenciyi yönetebilecek. Kurulum Şekil 1'de gösterilmiştir.

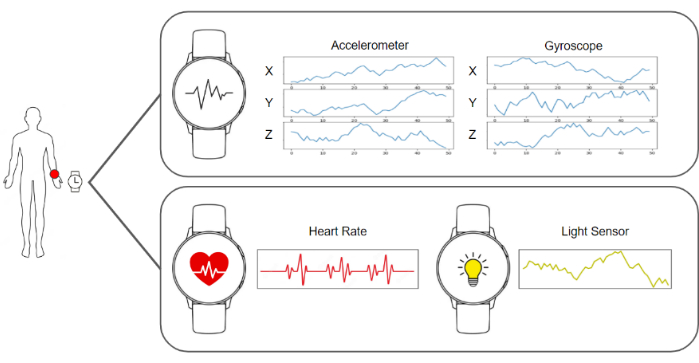

- Yakalama yazılımını akıllı saatlerde ve gömülü cihazlarda, görüntüleri ve ivmeölçer, jiroskop, kalp atış hızı ve aydınlatma verilerini göndermeye hazır olacak şekilde çalıştırın. Verileri toplayan ve depolayan sunucu yazılımını çalıştırın. Tüm bu elemanların bir diyagramı Şekil 2'de görülebilir.

- Zenithal kameraların, öğrencilerin vücutlarını net bir şekilde görebilmeleri için sahneye hakim olduğundan emin olun. Her öğrencinin önüne ek bir bireysel kamera yerleştirin.

- Öğrencilerin yerlerine oturmalarına izin verin, onlara deneyin hedefleri hakkında bilgi verin ve akıllı saatleri baskın ellerine takmalarını ve kurulumun herhangi bir unsuruyla etkileşime girmemelerini söyleyin.

- Sunucudaki verilerin yakalanmasını ve toplanmasını başlatın ve sınıf derslerine her zamanki gibi devam edin.

Şekil 1: Donanım ve veri işlem hattı. Kameralar ve akıllı saatlerin verileri toplanır ve işlenmek üzere makine öğrenimi algoritmalarına beslenir. Bu rakamın daha büyük bir sürümünü görüntülemek için lütfen buraya tıklayın.

Şekil 2: Sensörlerin, öğretmenin ve öğrencilerin konumu. Sınıftaki kameraların, akıllı saatlerin ve GUI'nin konumlarını öğretmen ve öğrencilerle birlikte gösteren diyagram. Bu rakamın daha büyük bir sürümünü görüntülemek için lütfen buraya tıklayın.

2. Yakalama ve veri işleme boru hattı

NOT: Tüm bu adımlar, bir sunucuya dağıtılan yazılım işlenerek otomatik olarak gerçekleştirilir. Bu çalışmada deneyler için kullanılan uygulama Python 3.8'de yazılmıştır.

- Her öğrenci için akıllı saatten tüm görüntüleri ve biyometrik verileri toplayarak gerekli verileri toplayın ve 1 saniyeden itibaren verileri içeren bir veri çerçevesi oluşturun. Bu veri çerçevesi, tek tek kameradan bir görüntüden, her zenithal kameradan bir görüntüden (bu durumda iki), üç jiroskop değerinin elli kaydından, üç ivmeölçer değerinin elli kaydından, bir kalp atış hızı değerinden ve bir ışık durumu değerinden oluşur.

- Kafa yönünü hesaplamak için ilk adım, öğrencinin yüzüne doğrultulmuş web kamerasını kullanmak ve bir görüntü almaktır. Ardından, bu görüntü BlazeFace17 yer işareti tahmin algoritması tarafından işlenir. Böyle bir algoritmanın çıktısı, yüzün belirli alanlarına karşılık gelen 2B anahtar noktaların bir listesidir.

- Algoritma tarafından sağlanan gözlerin, burnun, ağzın ve çenenin tahmini konumunu kullanarak, kurallı bir yüz ayarı olan OpenCV kütüphanesinin cv::SolvePnPMethod yöntemini kullanarak perspektif n-noktası problemini çözün. Kafa yönünü tanımlayan rotasyon matrisi bu işlem sonucunda elde edilir.

- Öğrencinin tasvir edildiği veri çerçevesinden zenithal görüntüsünü BlazePose18 dönüm noktası tahmin algoritmasına ileterek vücut pozunu hesaplayın ve görüntüde tasvir edilen vücudun eklemlerinin 2B koordinatlarının bir listesini alın. Bu yer işaretleri listesi, öğrencinin duruşunu tanımlar.

NOT: Vücut duruşu, bir öğrencinin ders sırasında farklı etkinliklere katılımını doğru bir şekilde temsil edebileceği için önemlidir. Örneğin, öğrenci elleri masanın üzerinde doğal bir şekilde oturuyorsa, not aldığı anlamına gelebilir. Buna karşılık, sürekli olarak kollarını hareket ettiriyorlarsa, bu biriyle konuştukları anlamına gelebilir. - Öğrencinin yüzünün görüntüsünü elde edin ve hizalama ön işlemesini gerçekleştirin. Adım 2.3'te hesaplanan listeden gözlerin kilit noktalarını alın ve gözlerin pozisyonunun elde edilmesi için bunları görüntü düzlemine yansıtın.

- Her iki gözün konumunu birleştiren sanal bir vektör izleyin. Bu vektör ile yatay çizgi arasındaki açıyı hesaplayın ve gözlerin yatay olarak hizalanması için görüntüye ve kilit noktalara ters açıyı uygulamak için bir homografi matrisi oluşturun.

- Sınırlarını tespit etmek için kilit noktaları kullanarak yüzü kırpın ve yamayı duygu algılama evrişimli sinir ağınabesleyin 19. 7 konumlu bir vektör olan ağdan çıktıyı alın, her konum yüzün yedi temel duygudan birini gösterme olasılığını verir: nötr, mutlu, iğrenmiş, kızgın, korkmuş, şaşırmış ve üzgün.

- Veri çerçevesinden ivmeölçer, jiroskop ve kalp atış hızı verilerini alarak dikkat seviyesini ölçün (Şekil 3).

- İvmeölçer ve jiroskop veri akışıyla temsili sonuçlarda açıklanan özel olarak oluşturulmuş ve sıfırdan eğitilmiş derin öğrenme tabanlı modeli besleyin. 4 konumlu bir vektör olan modelden çıktıyı alın, her konum verilerin aşağıdaki olası eylemlerden birini temsil etme olasılığını verir: el yazısı, klavyede yazma, cep telefonu kullanma veya Şekil 4'te gösterildiği gibi dinlenme.

- Kafa yönünü, duygu tanıma çıkışını, vücut duruşunu ve jiroskop, ivmeölçer ve kalp atış hızı verilerini birleştirerek önceki sistemlerden elde edilen tüm sonuçların doğrusallaştırılmasıyla son dikkat sınıflandırıcısını besleyin. 0 ile 100 arasında bir puan olan bu son sınıflandırıcıdan sonuçları alın. Bu sürekli değeri, olası üç ayrı dikkat kategorisinden birine sınıflandırın: düşük dikkat düzeyi (%0-40), orta düzeyde dikkat (%40-%75) ve yüksek dikkat düzeyi (%75 - %100). Oluşturulan veri setinin yapısı Tablo 1'de gösterilmektedir.

- Dikkat düzeylerinin sonuçlarını, öğretmenin bilgisayarından normal bir web tarayıcısından erişilebilen grafik kullanıcı arayüzünü (GUI) kullanarak öğretmene gösterin.

Şekil 3: Akıllı saat tarafından yakalanan veriler. Akıllı saat, veri akışları olarak bir jiroskop, ivmeölçer, kalp atış hızı ve ışık durumu sağlar. Bu rakamın daha büyük bir sürümünü görüntülemek için lütfen buraya tıklayın.

Şekil 4: Etkinlik tanıma modeli tarafından dikkate alınan kategorilere örnekler. Etkinlik tanıma modeli tarafından dört farklı eylem tanınır: el yazısı, klavyede yazma, akıllı telefon kullanma ve dinlenme pozisyonu. Bu rakamın daha büyük bir sürümünü görüntülemek için lütfen buraya tıklayın.

Sonuçlar

Bu çalışmanın hedef kitlesi lisans ve yüksek lisans öğrencileridir ve bu nedenle ana yaş grubu 18 ile 25 yaşları arasındadır. Bu popülasyon, genç öğrencilere göre daha az dikkat dağıtıcı elektronik cihazları kullanabildikleri için seçildi. Toplamda, grup 25 kişiden oluşuyordu. Bu yaş grubu, teklifi test etmek için en güvenilir sonuçları sağlayabilir.

Öğretmene gösterilen dikkat düzeyi sonuçları 2 bölümden oluşmaktadır. Sonucun A Bölümü, her öğrenc...

Tartışmalar

Bu çalışma, kameralar, akıllı saatler ve yapay zeka algoritmaları kullanarak bir sınıftaki bir öğrencinin dikkat düzeyini ölçen bir sistem sunmaktadır. Bu bilgiler daha sonra sınıfın genel durumu hakkında fikir sahibi olmaları için öğretmene sunulur.

Protokolün ana kritik adımlarından biri, farklı frekanslara sahip oldukları için akıllı saat bilgilerinin renkli kamera görüntüsü ile senkronize edilmesidir. Bu, ahududuların akıllı saatten ve kameralardan ilgi...

Açıklamalar

Yazarlar, bu yazıda rapor edilen çalışmayı etkilemiş gibi görünebilecek bilinen hiçbir rekabet eden mali çıkarları veya kişisel ilişkileri olmadığını beyan ederler.

Teşekkürler

Bu çalışma, Programa Prometeo, proje kimliği CIPROM/2021/017 tarafından finanse edilen fiyatlarla geliştirilmiştir. Prof. Dr. Rosabel Roig, UNESCO'nun "Eğitim, Araştırma ve Dijital Kapsayıcılık" başkanıdır.

Malzemeler

| Name | Company | Catalog Number | Comments |

| 4 GPUs Nvidia A40 Ampere | NVIDIA | TCSA40M-PB | GPU for centralized model processing server |

| FusionServer 2288H V5 | X-Fusion | 02311XBK | Platform that includes power supply and motherboard for centralized model processing server |

| Memory Card Evo Plus 128 GB | Samsung | MB-MC128KA/EU | Memory card for the operation of the raspberry pi 4b 2gb. One for each raspberry. |

| NEMIX RAM - 512 GB Kit DDR4-3200 PC4-25600 8Rx4 EC | NEMIX | M393AAG40M32-CAE | RAM for centralized model processing server |

| Processor Intel Xeon Gold 6330 | Intel | CD8068904572101 | Processor for centralized model processing server |

| Raspberry PI 4B 2GB | Raspberry | 1822095 | Local server that receives requests from the clocks and sends them to the general server. One every two students. |

| Samsung Galaxy Watch 5 (40mm) | Samsung | SM-R900NZAAPHE | Clock that monitors each student's activity. For each student. |

| Samsung MZQL23T8HCLS-00B7C PM9A3 3.84Tb Nvme U.2 PCI-Express-4 x4 2.5inch Ssd | Samsung | MZQL23T8HCLS-00B7C | Internal storage for centralized model processing server |

| WebCam HD Pro C920 Webcam FullHD | Logitech | 960-001055 | Webcam HD. One for each student plus two for student poses. |

Referanslar

- Hasnine, M. N., et al. Students' emotion extraction and visualization for engagement detection in online learning. Procedia Comp Sci. 192, 3423-3431 (2021).

- Khare, S. K., Blanes-Vidal, V., Nadimi, E. S., Acharya, U. R. Emotion recognition and artificial intelligence: A systematic review (2014-2023) and research recommendations. Info Fusion. 102, 102019 (2024).

- Bosch, N. Detecting student engagement: Human versus machine. UMAP '16: Proc the 2016 Conf User Model Adapt Personal. , 317-320 (2016).

- Araya, R., Sossa-Rivera, J. Automatic detection of gaze and body orientation in elementary school classrooms. Front Robot AI. 8, 729832 (2021).

- Lu, Y., Zhang, J., Li, B., Chen, P., Zhuang, Z. Harnessing commodity wearable devices for capturing learner engagement. IEEE Access. 7, 15749-15757 (2019).

- Vanneste, P., et al. Computer vision and human behaviour, emotion and cognition detection: A use case on student engagement. Mathematics. 9 (3), 287 (2021).

- Ma, X., Xu, M., Dong, Y., Sun, Z. Automatic student engagement in online learning environment based on neural Turing machine. Int J Info Edu Tech. 11 (3), 107-111 (2021).

- Wood, E., Bulling, A. EyeTab: model-based gaze estimation on unmodified tablet computers. ETRA '14: Proc Symp Eye Tracking Res Appl. , 207-210 (2014).

- Sanghvi, J., et al. Automatic analysis of affective postures and body motion to detect engagement with a game companion. HRI '11: Proc 6th Int Conf Human-robot Interact. , 205-211 (2011).

- Gupta, S., Kumar, P., Tekchandani, R. K. Facial emotion recognition based real-time learner engagement detection system in online learning context using deep learning models. Multimed Tools Appl. 82 (8), 11365-11394 (2023).

- Altuwairqi, K., Jarraya, S. K., Allinjawi, A., Hammami, M. Student behavior analysis to measure engagement levels in online learning environments. Signal Image Video Process. 15 (7), 1387-1395 (2021).

- Belle, A., Hargraves, R. H., Najarian, K. An automated optimal engagement and attention detection system using electrocardiogram. Comput Math Methods Med. 2012, 528781 (2012).

- Alban, A. Q., et al. Heart rate as a predictor of challenging behaviours among children with autism from wearable sensors in social robot interactions. Robotics. 12 (2), 55 (2023).

- Kajiwara, Y., Shimauchi, T., Kimura, H. Predicting emotion and engagement of workers in order picking based on behavior and pulse waves acquired by wearable devices. Sensors. 19 (1), 165 (2019).

- Costante, G., Porzi, L., Lanz, O., Valigi, P., Ricci, E. Personalizing a smartwatch-based gesture interface with transfer learning. , 2530-2534 (2014).

- Mekruksavanich, S., Jitpattanakul, A. Deep convolutional neural network with RNNs for complex activity recognition using wrist-worn wearable sensor data. Electronics. 10 (14), 1685 (2021).

- Bazarevsky, V., Kartynnik, Y., Vakunov, A., Raveendran, K., Grundmann, M. BlazeFace: Sub-millisecond Neural Face Detection on Mobile GPUs. arXiv. , (2019).

- Bazarevsky, V., et al. BlazePose: On-device Real-time Body Pose tracking. arXiv. , (2020).

- Mejia-Escobar, C., Cazorla, M., Martinez-Martin, E. Towards a better performance in facial expression recognition: a data-centric approach. Comput Intelligence Neurosci. , (2023).

- El-Garem, A., Adel, R. Applying systematic literature review and Delphi methods to explore digital transformation key success factors. Int J Eco Mgmt Engi. 16 (7), 383-389 (2022).

- Indumathi, V., Kist, A. A. Using electroencephalography to determine student attention in the classroom. , 1-3 (2023).

- Ma, X., Xie, Y., Wang, H. Research on the construction and application of teacher-student interaction evaluation system for smart classroom in the post COVID-19. Studies Edu Eval. 78, 101286 (2023).

- Andersen, D. Constructing Delphi statements for technology foresight. Futures Foresight Sci. 5 (2), e144 (2022).

- Khodyakov, D., et al. Disciplinary trends in the use of the Delphi method: A bibliometric analysis. PLoS One. 18 (8), e0289009 (2023).

- Martins, A. I., et al. Consensus on the Terms and Procedures for Planning and Reporting a Usability Evaluation of Health-Related Digital Solutions: Delphi Study and a Resulting Checklist. J Medical Internet Res. 25, e44326 (2023).

- Dalmaso, M., Castelli, L., Galfano, G. Social modulators of gaze-mediated orienting of attention: A review. Psychon Bull Rev. 27 (5), 833-855 (2020).

- Klein, R. M. Thinking about attention: Successive approximations to a productive taxonomy. Cognition. 225, 105137 (2022).

- Schindler, S., Bublatzky, F. Attention and emotion: An integrative review of emotional face processing as a function of attention. Cortex. 130, 362-386 (2020).

- Zaletelj, J., Košir, A. Predicting students' attention in the classroom from Kinect facial and body features. J Image Video Proc. 80, (2017).

- Strauch, C., Wang, C. A., Einhäuser, W., Van der Stigchel, S., Naber, M. Pupillometry as an integrated readout of distinct attentional networks. Trends Neurosci. 45 (8), 635-647 (2022).

Yeniden Basımlar ve İzinler

Bu JoVE makalesinin metnini veya resimlerini yeniden kullanma izni talebi

Izin talebiThis article has been published

Video Coming Soon

JoVE Hakkında

Telif Hakkı © 2020 MyJove Corporation. Tüm hakları saklıdır