Un abonnement à JoVE est nécessaire pour voir ce contenu. Connectez-vous ou commencez votre essai gratuit.

Method Article

Système basé sur l’intelligence artificielle pour détecter les niveaux d’attention chez les élèves

Dans cet article

Résumé

Cet article propose un système basé sur l’intelligence artificielle pour détecter automatiquement si les élèves sont attentifs à la classe ou s’ils sont distraits. Ce système est conçu pour aider les enseignants à maintenir l’attention des élèves, à optimiser leurs leçons et à introduire dynamiquement des modifications afin qu’ils soient plus engageants.

Résumé

Le niveau d’attention des élèves dans une salle de classe peut être amélioré grâce à l’utilisation de techniques d’intelligence artificielle (IA). En identifiant automatiquement le niveau d’attention, les enseignants peuvent employer des stratégies pour retrouver la concentration des élèves. Cela peut se faire par le biais de diverses sources d’information.

L’une d’entre elles consiste à analyser les émotions reflétées sur le visage des élèves. L’IA peut détecter des émotions telles que le neutre, le dégoût, la surprise, la tristesse, la peur, le bonheur et la colère. De plus, la direction du regard des élèves peut également indiquer leur niveau d’attention. Une autre source consiste à observer la posture corporelle des élèves. En utilisant des caméras et des techniques d’apprentissage profond, la posture peut être analysée pour déterminer le niveau d’attention. Par exemple, les élèves qui sont avachis ou qui reposent la tête sur leur bureau peuvent avoir un niveau d’attention inférieur. Les montres intelligentes distribuées aux élèves peuvent fournir des données biométriques et autres, y compris des mesures de fréquence cardiaque et d’inertie, qui peuvent également être utilisées comme indicateurs d’attention. En combinant ces sources d’information, un système d’IA peut être entraîné à identifier le niveau d’attention dans la classe. Cependant, l’intégration des différents types de données pose un défi qui nécessite la création d’un jeu de données étiqueté. Les commentaires d’experts et les études existantes sont consultés pour un étiquetage précis. Dans cet article, nous proposons l’intégration de ces mesures et la création d’un ensemble de données et d’un classificateur d’attention potentiel. Pour fournir un retour d’information à l’enseignant, nous explorons différentes méthodes, telles que les montres intelligentes ou les ordinateurs directs. Une fois que l’enseignant prend conscience des problèmes d’attention, il peut ajuster son approche pédagogique pour réengager et motiver les élèves. En résumé, les techniques d’IA peuvent identifier automatiquement le niveau d’attention des élèves en analysant leurs émotions, la direction de leur regard, leur posture corporelle et leurs données biométriques. Ces informations peuvent aider les enseignants à optimiser le processus d’enseignement-apprentissage.

Introduction

Dans les contextes éducatifs modernes, il est essentiel d’évaluer et de maintenir avec précision l’attention des élèves pour un enseignement et un apprentissage efficaces. Cependant, les méthodes traditionnelles d’évaluation de l’engagement, telles que l’auto-évaluation ou les observations subjectives de l’enseignant, prennent du temps et sont sujettes à des biais. Pour relever ce défi, les techniques d’intelligence artificielle (IA) sont apparues comme des solutions prometteuses pour la détection automatisée de l’attention. Un aspect important de la compréhension des niveaux d’engagement des élèves est la reconnaissance des émotions1. Les systèmes d’IA peuvent analyser les expressions faciales pour identifier les émotions, telles que la neutralité, le dégoût, la surprise, la tristesse, la peur, le bonheur et la colère2.

La direction du regard et la posture du corps sont également des indicateurs cruciaux de l’attention des élèves3. En utilisant des caméras et des algorithmes d’apprentissage automatique avancés, les systèmes d’IA peuvent suivre avec précision l’endroit où les élèves regardent et analyser leur posture corporelle pour détecter des signes de désintérêt ou de fatigue4. De plus, l’intégration de données biométriques améliore la précision et la fiabilité de la détection de l’attention5. En recueillant des mesures, telles que la fréquence cardiaque et les niveaux de saturation en oxygène dans le sang, à l’aide de montres intelligentes portées par les élèves, il est possible d’obtenir des indicateurs objectifs d’attention, complétant ainsi d’autres sources d’information.

Cet article propose un système qui évalue le niveau d’attention d’un individu à l’aide de caméras couleur et d’autres capteurs différents. Il combine la reconnaissance des émotions, l’analyse de la direction du regard, l’évaluation de la posture corporelle et les données biométriques pour fournir aux éducateurs un ensemble complet d’outils permettant d’optimiser le processus d’enseignement-apprentissage et d’améliorer l’engagement des élèves. En utilisant ces outils, les éducateurs peuvent acquérir une compréhension globale du processus d’enseignement-apprentissage et améliorer l’engagement des élèves, optimisant ainsi l’expérience éducative globale. En appliquant des techniques d’IA, il est même possible d’évaluer automatiquement ces données.

L’objectif principal de ce travail est de décrire le système qui nous permet de capturer toutes les informations et, une fois capturées, d’entraîner un modèle d’IA qui nous permet d’obtenir l’attention de toute la classe en temps réel. Bien que d’autres travaux aient déjà proposé de capter l’attention à l’aide d’informations visuelles ou émotionnelles6, ce travail propose l’utilisation combinée de ces techniques, ce qui fournit une approche holistique pour permettre l’utilisation de techniques d’IA plus complexes et efficaces. De plus, les ensembles de données disponibles jusqu’à présent se limitent soit à un ensemble de vidéos, soit à un ensemble de données biométriques. La littérature ne comprend pas d’ensembles de données fournissant des données complètes avec des images du visage ou du corps de l’élève, des données biométriques, des données sur la position de l’enseignant, etc. Avec le système présenté ici, il est possible de capturer ce type de jeu de données.

Le système associe un niveau d’attention à chaque élève à chaque moment donné. Cette valeur est une valeur de probabilité d’attention comprise entre 0 % et 100 %, qui peut être interprétée comme un niveau d’attention faible (0 %-40 %), un niveau d’attention moyen (40 %-75 %) et un niveau d’attention élevé (75 %-100 %). Tout au long du texte, cette probabilité d’attention est appelée le niveau d’attention, l’attention des élèves, ou le fait que les élèves soient distraits ou non, mais ils sont tous liés à la même valeur de sortie de notre système.

Au fil des ans, le domaine de la détection automatique de l’engagement s’est considérablement développé en raison de son potentiel à révolutionner l’éducation. Les chercheurs ont proposé différentes approches pour ce domaine d’étude.

Ma et al.7 ont introduit une nouvelle méthode basée sur une machine de Turing neuronale pour la reconnaissance automatique de l’engagement. Ils ont extrait certaines caractéristiques, telles que le regard oculaire, les unités d’action faciale, la pose de la tête et la pose du corps, pour créer une représentation complète de la reconnaissance de l’engagement.

EyeTab8, un autre système innovant, a utilisé des modèles pour estimer où une personne regarde avec ses deux yeux. Il a été spécialement conçu pour fonctionner sans problème sur une tablette standard sans aucune modification. Ce système exploite des algorithmes bien connus pour le traitement des images et l’analyse de la vision par ordinateur. Leur pipeline d’estimation du regard comprend un détecteur oculaire basé sur des caractéristiques de type Haar, ainsi qu’une approche d’ajustement de l’ellipse de limbe basée sur RANSAC.

Sanghvi et al.9 proposent une approche qui s’appuie sur des techniques basées sur la vision pour extraire automatiquement des caractéristiques posturales expressives à partir de vidéos enregistrées à partir d’une vue latérale, capturant le comportement des enfants. Une évaluation initiale est réalisée, impliquant l’entraînement de plusieurs modèles de reconnaissance à l’aide d’expressions posturales affectives contextualisées. Les résultats obtenus démontrent que les modèles de comportement postural peuvent prédire efficacement l’engagement des enfants avec le robot.

Dans d’autres travaux, tels que Gupta et al.10, une méthode basée sur l’apprentissage profond est utilisée pour détecter l’engagement en temps réel des apprenants en ligne en analysant leurs expressions faciales et en classifiant leurs émotions. L’approche utilise la reconnaissance des émotions faciales pour calculer un indice d’engagement (IE) qui prédit deux états d’engagement : engagé et désengagé. Divers modèles de deep learning, notamment Inception-V3, VGG19 et ResNet-50, sont évalués et comparés afin d’identifier le modèle de classification prédictive le plus efficace pour la détection de l’engagement en temps réel.

Dans Altuwairqi et al.11, les chercheurs présentent une nouvelle approche multimodale automatique pour évaluer les niveaux d’engagement des étudiants en temps réel. Pour garantir des mesures précises et fiables, l’équipe a intégré et analysé trois modalités distinctes qui capturent les comportements des élèves : les expressions faciales pour les émotions, les frappes au clavier et les mouvements de la souris.

Guillén et al.12 proposent le développement d’un système de surveillance qui utilise l’électrocardiographie (ECG) comme signal physiologique primaire pour analyser et prédire la présence ou l’absence d’attention cognitive chez les individus lors de l’exécution d’une tâche.

Alban et al.13 utilisent un réseau neuronal (NN) pour détecter les émotions en analysant les valeurs de fréquence cardiaque (FC) et d’activité électrodermale (EDA) de divers participants dans les domaines temporel et fréquentiel. Ils constatent qu’une augmentation de la racine carrée moyenne des différences successives (RMSDD) et de l’écart-type des intervalles normal-à-normal (SDNN), associée à une diminution de la FC moyenne, indique une activité accrue dans le système nerveux sympathique, qui est associée à la peur.

Kajiwara et coll.14 proposent un système novateur qui utilise des capteurs portables et des réseaux neuronaux profonds pour prévoir le niveau d’émotion et d’engagement chez les travailleurs. Le système suit un processus en trois étapes. Initialement, les capteurs portables capturent et collectent des données sur les comportements et les ondes de pouls. Par la suite, les caractéristiques des séries chronologiques sont calculées sur la base des données comportementales et physiologiques acquises. Enfin, les réseaux neuronaux profonds sont utilisés pour saisir les caractéristiques de la série chronologique et faire des prédictions sur les émotions et les niveaux d’engagement de l’individu.

Dans d’autres recherches, telles que Costante et al.15, une approche basée sur un nouvel algorithme d’apprentissage métrique de transfert est proposée, qui utilise la connaissance préalable d’un ensemble prédéfini de gestes pour améliorer la reconnaissance des gestes définis par l’utilisateur. Cette amélioration est obtenue avec une dépendance minimale à l’égard d’échantillons d’apprentissage supplémentaires. De même, un cadre de reconnaissance de l’activité humaine basé sur des capteurs16 est présenté pour répondre à l’objectif de la reconnaissance impersonnelle d’activités humaines complexes. Les données de signal collectées à partir de capteurs portés au poignet sont utilisées dans le cadre de reconnaissance de l’activité humaine développé, en utilisant quatre modèles DL basés sur RNN (Long-Short Term Memories, Bidirectional Long-Short Term Memories, Gated Recurrent Units et Bidirectional Gated Recurrent Units) pour étudier les activités effectuées par l’utilisateur du dispositif portable.

Protocole

Le protocole suivant suit les directives du comité d’éthique de la recherche humaine de l’Université d’Alicante avec le numéro de protocole approuvé UA-2022-11-12. Le consentement éclairé de tous les participants a été obtenu pour cette expérience et pour l’utilisation des données ici.

1. Configuration du matériel, des logiciels et de la classe

- Placez un routeur avec des capacités WiFi (les expériences ont été réalisées à l’aide d’un DLink DSR 1000AC) à l’endroit souhaité afin que sa portée couvre toute la pièce. Ici, 25 m2 salles de classe avec 30 élèves ont été couvertes.

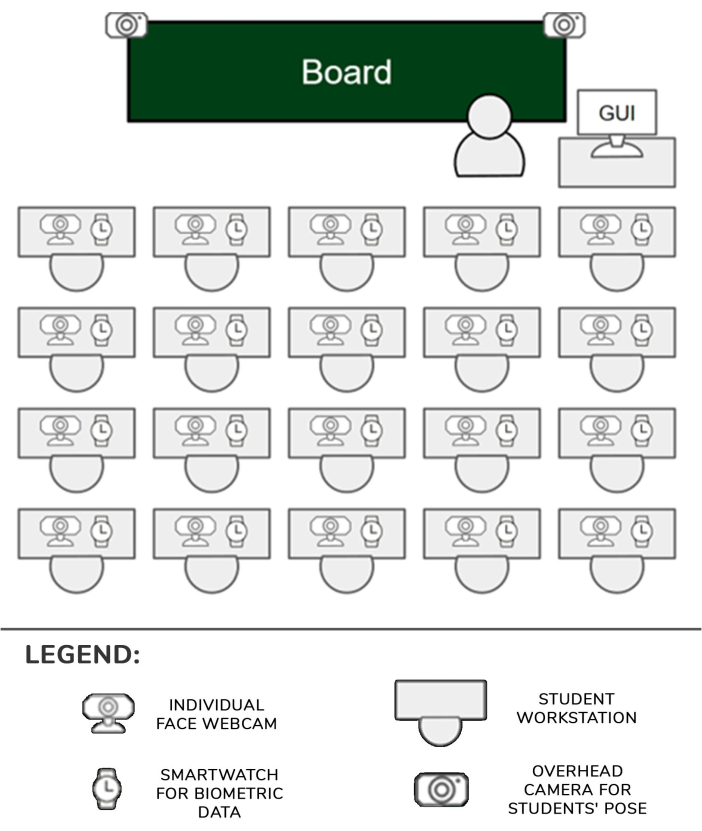

- Définissez une smartwatch (ici Samsung Galaxy Smartwatch 5) et un appareil photo (ici les appareils photo Logitech C920) pour chaque emplacement d’étudiant. Définissez un appareil intégré pour deux élèves. Fixez deux caméras sur deux trépieds et connectez-les à un autre appareil embarqué (ci-après dénommés caméras zénithales).

- Connectez les appareils photo aux appareils intégrés correspondants avec une liaison USB et allumez-les. Allumez également les smartwatches. Connectez chaque appareil intégré et smartwatch au réseau WiFi du routeur configuré à l’étape 1.1.

- Placez les caméras dans le coin du bureau de chaque élève et pointez-les vers l’avant et légèrement inclinées vers le haut afin que le visage de l’élève soit clairement visible sur les images.

- Placez les deux trépieds avec les caméras devant les bureaux les plus proches des allées dans la première rangée de sièges de la salle de classe. Déplacez le trépied vers la position la plus haute afin que les caméras puissent voir clairement la plupart des élèves. Chaque appareil embarqué sera capable de gérer un ou deux élèves, ainsi que leurs appareils photo et montres respectifs. La configuration est illustrée à la figure 1.

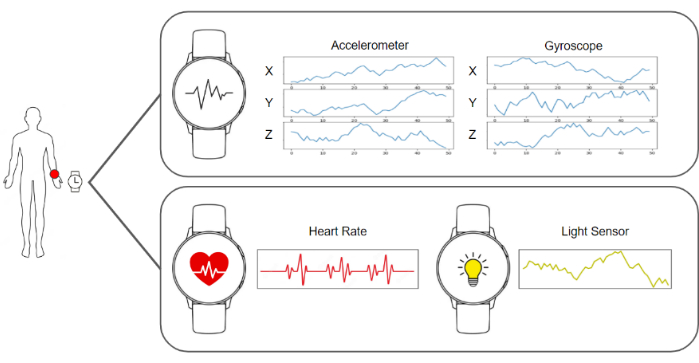

- Exécutez le logiciel de capture dans les montres intelligentes et dans les appareils intégrés afin qu’ils soient prêts à envoyer les images et les données de l’accéléromètre, du gyroscope, de la fréquence cardiaque et de l’éclairage. Exécutez le logiciel serveur qui collecte les données et les stocke. Un schéma de tous ces éléments est illustré à la figure 2.

- Assurez-vous que les caméras zénithales dominent la scène afin qu’elles aient une vue claire du corps des élèves. Placez une caméra individuelle supplémentaire devant chaque élève.

- Laissez les élèves s’asseoir à leur place, informez-les des objectifs de l’expérience et demandez-leur de porter les montres intelligentes sur leur main dominante et de ne pas interagir avec l’un des éléments de la configuration.

- Démarrez la capture et la collecte des données sur le serveur et reprenez les leçons de classe comme d’habitude.

Figure 1 : Pipeline de matériel et de données. Les données des appareils photo et des montres connectées sont collectées et transmises aux algorithmes d’apprentissage automatique pour être traitées. Veuillez cliquer ici pour voir une version agrandie de cette figure.

Figure 2 : Position des capteurs, de l’enseignant et des élèves. Schéma montrant les positions des caméras, des montres intelligentes et de l’interface graphique dans la salle de classe avec l’enseignant et les élèves. Veuillez cliquer ici pour voir une version agrandie de cette figure.

2. Pipeline de capture et de traitement des données

REMARQUE : Toutes ces étapes sont effectuées automatiquement par un logiciel de traitement déployé sur un serveur. L’implémentation utilisée pour les expériences dans ce travail a été écrite en Python 3.8.

- Collectez les données requises en rassemblant toutes les images et les données biométriques de la smartwatch pour chaque élève et créez un cadre de données qui comprend des données de 1 s. Cette trame de données est composée d’une image de la caméra individuelle, d’une image de chaque caméra zénithale (deux dans ce cas), de cinquante registres des trois valeurs du gyroscope, de cinquante registres des trois valeurs de l’accéléromètre, d’une valeur de fréquence cardiaque et d’une valeur de condition de lumière.

- Pour calculer la direction de la tête, la première étape consiste à utiliser la webcam qui est pointée vers le visage de l’élève et à récupérer une image. Ensuite, cette image est traitée par l’algorithme d’estimation du point de repère BlazeFace17 . Le résultat d’un tel algorithme est une liste de points clés 2D correspondant à des zones spécifiques du visage.

- En utilisant la position estimée des yeux, du nez, de la bouche et du menton fournie par l’algorithme, résolvez le problème de perspective n-point à l’aide de la méthode cv ::SolvePnPMethod de la bibliothèque OpenCV, un paramètre de visage canonique. La matrice de rotation qui définit la direction de la tête est obtenue à la suite de cette procédure.

- Calculez la pose du corps en transmettant l’image zénithale du cadre de données dans lequel l’étudiant est représenté à l’algorithme d’estimation du point de repère BlazePose18 et récupérez une liste de coordonnées 2D des articulations du corps représenté dans l’image. Cette liste de points de repère décrit la pose de l’élève.

REMARQUE : La posture du corps est importante car elle peut représenter avec précision l’engagement d’un élève dans différentes activités pendant le cours. Par exemple, si l’élève est assis naturellement avec ses mains sur le bureau, cela pourrait signifier qu’il prend des notes. En revanche, s’ils bougent continuellement leurs bras, cela pourrait signifier qu’ils parlent à quelqu’un. - Obtenez l’image du visage de l’élève et effectuez le prétraitement de l’alignement. Récupérez les points clés des yeux dans la liste calculée à l’étape 2.3 et projetez-les sur le plan de l’image afin d’obtenir la position des yeux.

- Tracez un vecteur virtuel qui rejoint la position des deux yeux. Calculez l’angle entre ce vecteur et la droite horizontale et construisez une matrice d’homographie pour appliquer l’angle inverse à l’image et aux points clés afin que les yeux soient alignés horizontalement.

- Recadrez le visage à l’aide des points clés pour détecter ses limites et alimentez le patch au réseau neuronal convolutif de détection d’émotion19. Récupérez la sortie du réseau, qui est un vecteur à 7 positions, chaque position donnant la probabilité que le visage montre l’une des sept émotions de base : neutre, heureux, dégoûté, en colère, effrayé, surpris et triste.

- Mesurez le niveau d’attention en obtenant les données de l’accéléromètre, du gyroscope et de la fréquence cardiaque à partir du cadre de données (Figure 3).

- Alimentez le modèle basé sur le deep learning qui a été construit sur mesure et entraîné à partir de zéro, décrit dans les résultats représentatifs, avec le flux de données de l’accéléromètre et du gyroscope. Récupérez le résultat du modèle, qui est un vecteur à 4 positions, chaque position donnant la probabilité que les données représentent l’une des actions possibles suivantes : écrire à la main, taper sur un clavier, utiliser un téléphone portable ou se reposer, comme le montre la figure 4.

- Alimentez le classificateur d’attention final avec une linéarisation de tous les résultats des systèmes précédents en fusionnant la direction de la tête, la sortie de reconnaissance des émotions, la posture du corps et les données du gyroscope, de l’accéléromètre et de la fréquence cardiaque. Récupérez les résultats de ce classificateur final, qui est un score de 0 à 100. Classez cette valeur continue dans l’une des trois catégories d’attention discrètes possibles : niveau d’attention faible (0-40%), niveau d’attention moyen (40%-75%) et niveau d’attention élevé (75% - 100%). La structure de l’ensemble de données généré est illustrée au tableau 1.

- Montrez les résultats des niveaux d’attention à l’enseignant à l’aide de l’interface utilisateur graphique (GUI) de l’ordinateur de l’enseignant, accessible à partir d’un navigateur Web ordinaire.

Figure 3 : Données capturées par la smartwatch. La smartwatch fournit un gyroscope, un accéléromètre, une fréquence cardiaque et une condition lumineuse comme flux de données. Veuillez cliquer ici pour voir une version agrandie de cette figure.

Figure 4 : Exemples de catégories prises en compte par le modèle de reconnaissance d’activité. Quatre actions différentes sont reconnues par le modèle de reconnaissance d’activité : l’écriture manuscrite, la frappe sur un clavier, l’utilisation d’un smartphone et la position de repos. Veuillez cliquer ici pour voir une version agrandie de cette figure.

Résultats

Le groupe cible de cette étude est constitué des étudiants de premier cycle et de master, et le groupe d’âge principal se situe donc entre 18 et 25 ans. Cette population a été choisie parce qu’elle peut manipuler des appareils électroniques avec moins de distractions que les élèves plus jeunes. Au total, le groupe comprenait 25 personnes. Ce groupe d’âge peut fournir les résultats les plus fiables pour tester la proposition.

Les résultats du niveau d’attention montré à l?...

Discussion

Ce travail présente un système qui mesure le niveau d’attention d’un élève dans une salle de classe à l’aide de caméras, de montres intelligentes et d’algorithmes d’intelligence artificielle. Ces informations sont ensuite présentées à l’enseignant pour qu’il ait une idée de l’état général de la classe.

L’une des principales étapes critiques du protocole est la synchronisation des informations de la smartwatch avec l’image couleur de la caméra, car celles-ci o...

Déclarations de divulgation

Les auteurs déclarent qu’ils n’ont pas d’intérêts financiers concurrents connus ou de relations personnelles qui auraient pu sembler influencer les travaux rapportés dans cet article.

Remerciements

Ce travail a été développé avec le financement du Programa Prometeo, projet ID CIPROM/2021/017. Le professeur Rosabel Roig est titulaire de la chaire de l’UNESCO « Éducation, recherche et inclusion numérique ».

matériels

| Name | Company | Catalog Number | Comments |

| 4 GPUs Nvidia A40 Ampere | NVIDIA | TCSA40M-PB | GPU for centralized model processing server |

| FusionServer 2288H V5 | X-Fusion | 02311XBK | Platform that includes power supply and motherboard for centralized model processing server |

| Memory Card Evo Plus 128 GB | Samsung | MB-MC128KA/EU | Memory card for the operation of the raspberry pi 4b 2gb. One for each raspberry. |

| NEMIX RAM - 512 GB Kit DDR4-3200 PC4-25600 8Rx4 EC | NEMIX | M393AAG40M32-CAE | RAM for centralized model processing server |

| Processor Intel Xeon Gold 6330 | Intel | CD8068904572101 | Processor for centralized model processing server |

| Raspberry PI 4B 2GB | Raspberry | 1822095 | Local server that receives requests from the clocks and sends them to the general server. One every two students. |

| Samsung Galaxy Watch 5 (40mm) | Samsung | SM-R900NZAAPHE | Clock that monitors each student's activity. For each student. |

| Samsung MZQL23T8HCLS-00B7C PM9A3 3.84Tb Nvme U.2 PCI-Express-4 x4 2.5inch Ssd | Samsung | MZQL23T8HCLS-00B7C | Internal storage for centralized model processing server |

| WebCam HD Pro C920 Webcam FullHD | Logitech | 960-001055 | Webcam HD. One for each student plus two for student poses. |

Références

- Hasnine, M. N., et al. Students' emotion extraction and visualization for engagement detection in online learning. Procedia Comp Sci. 192, 3423-3431 (2021).

- Khare, S. K., Blanes-Vidal, V., Nadimi, E. S., Acharya, U. R. Emotion recognition and artificial intelligence: A systematic review (2014-2023) and research recommendations. Info Fusion. 102, 102019 (2024).

- Bosch, N. Detecting student engagement: Human versus machine. UMAP '16: Proc the 2016 Conf User Model Adapt Personal. , 317-320 (2016).

- Araya, R., Sossa-Rivera, J. Automatic detection of gaze and body orientation in elementary school classrooms. Front Robot AI. 8, 729832 (2021).

- Lu, Y., Zhang, J., Li, B., Chen, P., Zhuang, Z. Harnessing commodity wearable devices for capturing learner engagement. IEEE Access. 7, 15749-15757 (2019).

- Vanneste, P., et al. Computer vision and human behaviour, emotion and cognition detection: A use case on student engagement. Mathematics. 9 (3), 287 (2021).

- Ma, X., Xu, M., Dong, Y., Sun, Z. Automatic student engagement in online learning environment based on neural Turing machine. Int J Info Edu Tech. 11 (3), 107-111 (2021).

- Wood, E., Bulling, A. EyeTab: model-based gaze estimation on unmodified tablet computers. ETRA '14: Proc Symp Eye Tracking Res Appl. , 207-210 (2014).

- Sanghvi, J., et al. Automatic analysis of affective postures and body motion to detect engagement with a game companion. HRI '11: Proc 6th Int Conf Human-robot Interact. , 205-211 (2011).

- Gupta, S., Kumar, P., Tekchandani, R. K. Facial emotion recognition based real-time learner engagement detection system in online learning context using deep learning models. Multimed Tools Appl. 82 (8), 11365-11394 (2023).

- Altuwairqi, K., Jarraya, S. K., Allinjawi, A., Hammami, M. Student behavior analysis to measure engagement levels in online learning environments. Signal Image Video Process. 15 (7), 1387-1395 (2021).

- Belle, A., Hargraves, R. H., Najarian, K. An automated optimal engagement and attention detection system using electrocardiogram. Comput Math Methods Med. 2012, 528781 (2012).

- Alban, A. Q., et al. Heart rate as a predictor of challenging behaviours among children with autism from wearable sensors in social robot interactions. Robotics. 12 (2), 55 (2023).

- Kajiwara, Y., Shimauchi, T., Kimura, H. Predicting emotion and engagement of workers in order picking based on behavior and pulse waves acquired by wearable devices. Sensors. 19 (1), 165 (2019).

- Costante, G., Porzi, L., Lanz, O., Valigi, P., Ricci, E. Personalizing a smartwatch-based gesture interface with transfer learning. , 2530-2534 (2014).

- Mekruksavanich, S., Jitpattanakul, A. Deep convolutional neural network with RNNs for complex activity recognition using wrist-worn wearable sensor data. Electronics. 10 (14), 1685 (2021).

- Bazarevsky, V., Kartynnik, Y., Vakunov, A., Raveendran, K., Grundmann, M. BlazeFace: Sub-millisecond Neural Face Detection on Mobile GPUs. arXiv. , (2019).

- Bazarevsky, V., et al. BlazePose: On-device Real-time Body Pose tracking. arXiv. , (2020).

- Mejia-Escobar, C., Cazorla, M., Martinez-Martin, E. Towards a better performance in facial expression recognition: a data-centric approach. Comput Intelligence Neurosci. , (2023).

- El-Garem, A., Adel, R. Applying systematic literature review and Delphi methods to explore digital transformation key success factors. Int J Eco Mgmt Engi. 16 (7), 383-389 (2022).

- Indumathi, V., Kist, A. A. Using electroencephalography to determine student attention in the classroom. , 1-3 (2023).

- Ma, X., Xie, Y., Wang, H. Research on the construction and application of teacher-student interaction evaluation system for smart classroom in the post COVID-19. Studies Edu Eval. 78, 101286 (2023).

- Andersen, D. Constructing Delphi statements for technology foresight. Futures Foresight Sci. 5 (2), e144 (2022).

- Khodyakov, D., et al. Disciplinary trends in the use of the Delphi method: A bibliometric analysis. PLoS One. 18 (8), e0289009 (2023).

- Martins, A. I., et al. Consensus on the Terms and Procedures for Planning and Reporting a Usability Evaluation of Health-Related Digital Solutions: Delphi Study and a Resulting Checklist. J Medical Internet Res. 25, e44326 (2023).

- Dalmaso, M., Castelli, L., Galfano, G. Social modulators of gaze-mediated orienting of attention: A review. Psychon Bull Rev. 27 (5), 833-855 (2020).

- Klein, R. M. Thinking about attention: Successive approximations to a productive taxonomy. Cognition. 225, 105137 (2022).

- Schindler, S., Bublatzky, F. Attention and emotion: An integrative review of emotional face processing as a function of attention. Cortex. 130, 362-386 (2020).

- Zaletelj, J., Košir, A. Predicting students' attention in the classroom from Kinect facial and body features. J Image Video Proc. 80, (2017).

- Strauch, C., Wang, C. A., Einhäuser, W., Van der Stigchel, S., Naber, M. Pupillometry as an integrated readout of distinct attentional networks. Trends Neurosci. 45 (8), 635-647 (2022).

Réimpressions et Autorisations

Demande d’autorisation pour utiliser le texte ou les figures de cet article JoVE

Demande d’autorisationThis article has been published

Video Coming Soon