このコンテンツを視聴するには、JoVE 購読が必要です。 サインイン又は無料トライアルを申し込む。

Method Article

人工知能を用いた学生の注意力検出システム

要約

この論文では、学生がクラスに注意を払っているか、気を散らしているかを自動的に検出する人工知能ベースのシステムを提案しています。このシステムは、教師が生徒の注意を引き付け、授業を最適化し、生徒がより魅力的になるように動的に変更を導入できるように設計されています。

要約

教室での生徒の注意力は、人工知能(AI)技術を使用することで向上させることができます。注意力のレベルを自動的に特定することで、教師は生徒の集中力を取り戻すための戦略を採用できます。これは、さまざまな情報源を通じて実現できます。

その一つが、生徒の顔に映る感情を分析することです。AIは、中立、嫌悪感、驚き、悲しみ、恐怖、幸福、怒りなどの感情を検出できます。さらに、生徒の視線の方向も、生徒の注意力のレベルを示している可能性があります。もう一つの情報源は、生徒の体の姿勢を観察することです。カメラやディープラーニングの手法を用いることで、姿勢を解析し、注意力の度合いを判断することができます。たとえば、前かがみになったり、机に頭を乗せたりしている学生は、注意力が低い可能性があります。学生に配布されるスマートウォッチは、心拍数や慣性測定などの生体認証やその他のデータを提供でき、注意の指標としても使用できます。これらの情報源を組み合わせることで、AIシステムを訓練して、教室での注意のレベルを特定できます。ただし、さまざまな種類のデータを統合するには、ラベル付きデータセットを作成する必要があるという課題があります。正確なラベリングのために、専門家の意見と既存の研究が参照されます。この論文では、そのような測定値の統合と、データセットと潜在的な注意分類器の作成を提案します。教師にフィードバックを提供するために、スマートウォッチやダイレクトコンピューターなど、さまざまな方法を検討します。教師が注意力の問題に気付いたら、生徒を再び関与させ、やる気を起こさせるために、教育アプローチを調整することができます。要約すると、AI技術は、学生の感情、視線方向、体の姿勢、および生体認証データを分析することにより、学生の注意レベルを自動的に識別できます。この情報は、教師が教育と学習のプロセスを最適化するのに役立ちます。

概要

現代の教育現場では、効果的な教育と学習のためには、生徒の注意を正確に評価し、維持することが重要です。しかし、自己報告や教師の主観的な観察など、エンゲージメントを測定する従来の方法は時間がかかり、バイアスがかかりやすい。この課題に対処するために、人工知能(AI)技術が自動アテンション検出の有望なソリューションとして浮上しています。学生のエンゲージメントレベルを理解する上で重要な側面の1つは、感情認識1です。AIシステムは、顔の表情を分析して、中立、嫌悪、驚き、悲しみ、恐怖、幸福、怒りなどの感情を特定できます2。

視線の向きと体の姿勢も、生徒の注意力の重要な指標です3。カメラと高度な機械学習アルゴリズムを活用することで、AIシステムは生徒がどこを見ているかを正確に追跡し、生徒の体の姿勢を分析して、興味のなさや疲労の兆候を検出することができます4。さらに、生体認証データを組み込むことで、注意検出の精度と信頼性が向上します5。生徒が着用するスマートウォッチを通じて、心拍数や血中酸素飽和度などの測定値を収集することにより、注意の客観的な指標を取得し、他の情報源を補完することができます。

本稿では、カラーカメラなどのセンサーを用いて個人の注意力を評価するシステムを提案します。感情認識、視線方向分析、身体姿勢評価、生体認証データを組み合わせて、教育学習プロセスを最適化し、学生のエンゲージメントを向上させるための包括的なツールセットを教育者に提供します。これらのツールを使用することで、教育者は教育と学習のプロセスを包括的に理解し、学生の関与を高めることで、全体的な教育体験を最適化することができます。AIの技術を応用することで、このデータを自動的に評価することも可能です。

この作業の主な目標は、すべての情報をキャプチャできるシステムについて説明し、キャプチャすると、クラス全体の注意をリアルタイムで取得できるAIモデルをトレーニングすることです。他の研究では、視覚的または感情的な情報を使用して注意を引くことをすでに提案していますが6、この研究では、これらの技術を組み合わせて使用することを提案しており、これにより、より複雑で効果的なAI技術の使用を可能にする全体的なアプローチが提供されます。また、これまで利用可能なデータセットは、動画のセットまたは生体認証データの1つに限定されていました。文献には、生徒の顔や体の画像、生体認証データ、教師の位置に関するデータなど、完全なデータを提供するデータセットは含まれていません。ここで紹介するシステムでは、このタイプのデータセットをキャプチャすることができます。

システムは、各時点で各学生に注意のレベルを関連付けます。この値は、0% から 100% の間の注意の確率値であり、注意のレベルが低い (0%-40%)、注意のレベルが中程度 (40%-75%)、注意のレベルが高い (75%-100%) と解釈できます。テキスト全体を通して、この注意力の確率は、注意力のレベル、生徒の注意力、または生徒が気を散らしているかどうかと呼ばれますが、これらはすべてシステムの同じ出力値に関連しています。

長年にわたり、自動エンゲージメント検出の分野は、教育に革命をもたらす可能性を秘めているため、大幅に成長してきました。研究者は、この研究分野に対してさまざまなアプローチを提案しています。

Ma et al.7 は、ニューラルチューリングマシンに基づく自動エンゲージメント認識のための新しい方法を導入しました。彼らは、視線入力、顔のアクション ユニット、頭のポーズ、体のポーズなどの特定の特徴を抽出して、エンゲージメント認識の包括的な表現を作成しました。

EyeTab8 も革新的なシステムであり、モデルを使用して、誰かが両目でどこを見ているかを推定しました。これは、標準のタブレットで問題なくスムーズに動作するように特別に作られました。このシステムは、画像の処理とコンピュータービジョンの分析によく知られているアルゴリズムを利用しています。彼らの視線推定パイプラインには、Haarのような特徴ベースのアイ検出器と、RANSACベースのリンバス楕円フィッティングアプローチが含まれています。

Sanghviら9 は、視覚ベースの技術に依存して、横方向から記録されたビデオから表現力豊かな姿勢の特徴を自動的に抽出し、子供たちの行動を捉えるアプローチを提案しています。初期評価が行われ、文脈に応じた感情的な姿勢表現を使用した複数の認識モデルのトレーニングが含まれます。得られた結果は、姿勢行動のパターンが、ロボットに対する子どもの関与を効果的に予測できることを示しています。

Guptaら10などの他の研究では、ディープラーニングベースの方法が採用されており、オンライン学習者の顔の表情を分析し、感情を分類することにより、オンライン学習者のリアルタイムのエンゲージメントを検出しています。このアプローチでは、顔の感情認識を利用して、エンゲージメントとエンゲージメント解除の 2 つのエンゲージメント状態を予測するエンゲージメント インデックス (EI) を計算します。Inception-V3、VGG19、ResNet-50 など、さまざまなディープラーニング モデルが評価され、比較され、リアルタイムのエンゲージメント検出に最も効果的な予測分類モデルが特定されます。

Altuwairqi et al.11 では、研究者は、学生のエンゲージメント レベルをリアルタイムで評価するための新しい自動マルチモーダル アプローチを提示しています。正確で信頼性の高い測定を確保するために、チームは、感情の表情、キーボードのキーストローク、マウスの動きという、生徒の行動を捉える3つの異なるモダリティを統合して分析しました。

Guillénら12 は、タスクを実行している間の個人の認知的注意の有無を分析および予測するための主要な生理学的信号として心電図(ECG)を使用するモニタリングシステムの開発を提案しています。

Alban et al.13 は、ニューラルネットワーク(NN)を利用して、時間領域と周波数領域の両方でさまざまな参加者の心拍数(HR)と皮膚電気活動(EDA)の値を分析することにより、感情を検出します。その結果、逐次差の二乗平均平方根(RMSDD)と標準偏差の正常から正常(SDNN)の間隔の増加は、平均HRの減少と相まって、交感神経系の活動が活発化していることを示しており、これは恐怖と関連していることが分かった。

梶原ら14 は、ウェアラブルセンサーとディープニューラルネットワークを用いて、労働者の感情とエンゲージメントのレベルを予測する革新的なシステムを提案しています。システムは3段階のプロセスに従います。当初、ウェアラブルセンサーは、行動と脈波に関するデータを取得して収集します。その後、取得した行動データや生理学的データに基づいて時系列特徴量が計算されます。最後に、ディープニューラルネットワークを使用して時系列の特徴を入力し、個人の感情とエンゲージメントレベルについて予測を行います。

Costante et al.15などの他の研究では、新しい転送メトリック学習アルゴリズムに基づくアプローチが提案されており、これは、事前定義されたジェスチャーのセットに関する事前知識を利用して、ユーザー定義のジェスチャーの認識を強化します。この改善は、追加のトレーニングサンプルへの依存を最小限に抑えることで達成されます。同様に、センサベースの人間活動認識フレームワーク16 は、複雑な人間活動の非人格的認識の目標に対処するために提示される。腕時計型センサーから収集した信号データは、4つのRNNベースのDLモデル(Long-Short Term Memories、Bidirectional Long-Short Term Memories、Gated Recurrent Units、Bidirectional Gated Recurrent Units)を用いて、ウェアラブルデバイスのユーザーが行った活動を調査し、ヒト活動認識フレームワークに活用されます。

プロトコル

次のプロトコルは、アリカンテ大学の人間研究倫理委員会のガイドラインに従っており、承認されたプロトコル番号は UA-2022-11-12 です。この実験およびここにあるデータの使用について、すべての参加者からインフォームド コンセントが得られています。

1. ハードウェア、ソフトウェア、クラスのセットアップ

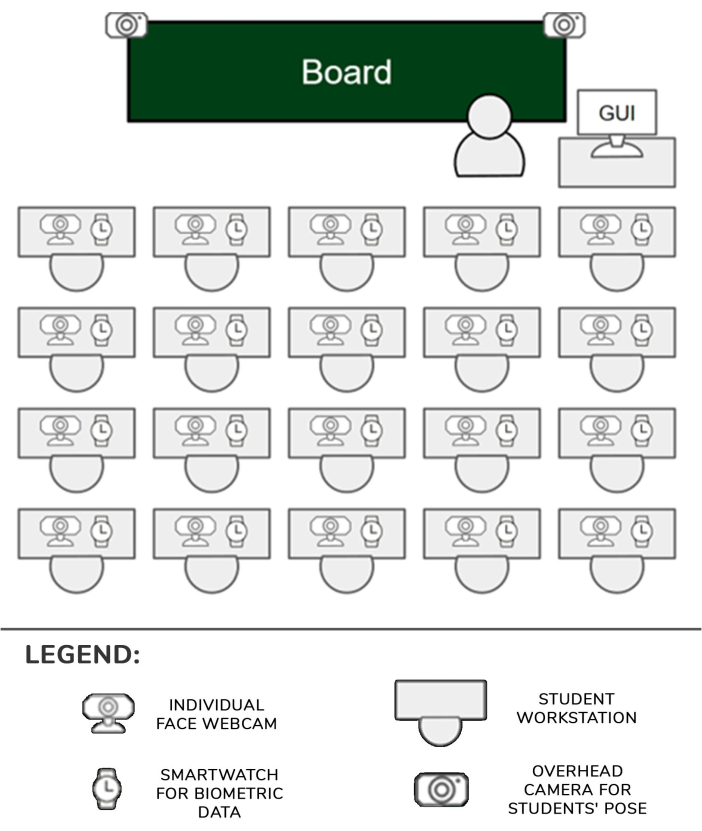

- WiFi機能を備えたルーター(実験はDLink DSR 1000ACを使用して実施)を目的の場所に設定して、その範囲が部屋全体をカバーするようにします。ここでは、25人の生徒と30人の生徒がいる25mの 教室がカバーされました。

- 生徒の場所に1台のスマートウォッチ(ここではSamsung Galaxy Smartwatch 5)と1台のカメラ(ここではLogitech C920カメラ)を設定します。生徒2人につき1台の組み込みデバイスを設定します。2台のカメラを2台の三脚に固定し、別の組み込みデバイス(以下、天頂カメラ)に接続します。

- カメラをUSBリンクで対応する組み込みデバイスに接続し、電源を入れます。すべての組み込みデバイスとスマートウォッチを、手順1.1で設定したルーターのWiFiネットワークに接続します。

- カメラを各生徒の机の隅に置き、生徒の顔が画像にはっきりと見えるように、カメラを前方に向け、少し上に傾けます。

- カメラ付きの2つの三脚を、教室の最前列の通路に最も近い机の前に置きます。三脚ライザーを最も高い位置に移動して、カメラがほとんどの生徒をはっきりと見ることができるようにします。各組み込みデバイスは、1人または2人の学生と、それぞれのカメラと時計を管理できます。セットアップを 図 1 に示します。

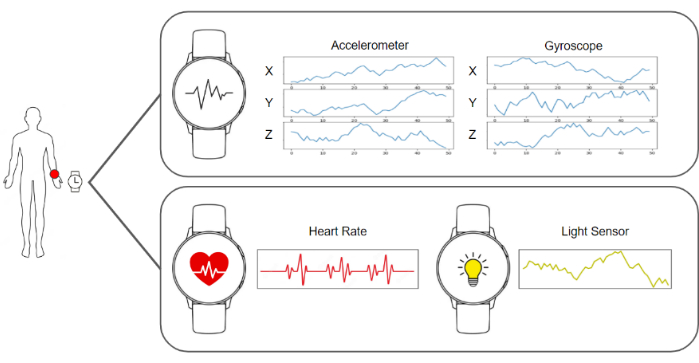

- スマートウォッチと組み込みデバイスでキャプチャソフトウェアを実行して、画像と加速度計、ジャイロスコープ、心拍数、および照明データを送信する準備が整います。データを収集して保存するサーバーソフトウェアを実行します。これらすべての要素の図を 図 2 に示します。

- 天頂カメラがシーンを支配し、生徒の体がはっきりと見えるようにします。各生徒の前に追加の個別のカメラを置きます。

- 生徒を自分の場所に座らせ、実験の目標を伝え、利き手にスマートウォッチを装着し、セットアップのどの要素にも触れないように指示します。

- サーバー内のデータのキャプチャと収集を開始し、通常どおりクラスのレッスンを再開します。

図 1: ハードウェアとデータ パイプライン。 カメラとスマートウォッチのデータは収集され、機械学習アルゴリズムに供給されて処理されます。 この図の拡大版を表示するには、ここをクリックしてください。

図2:センサー、教師、生徒の位置。 教師と生徒がいる教室のカメラ、スマートウォッチ、GUIの位置を示す図。 この図の拡大版を表示するには、ここをクリックしてください。

2. キャプチャとデータ処理パイプライン

注: これらの手順はすべて、サーバーに展開されたソフトウェアを処理することによって自動的に実行されます。この作業の実験に使用された実装は、Python 3.8 で書かれました。

- 各生徒のスマートウォッチからすべての画像と生体認証データを収集して必要なデータを収集し、1秒からのデータを含むデータフレームを構築します。このデータ フレームは、個々のカメラからの 1 つの画像、各天頂カメラからの 1 つの画像 (この場合は 2 つ)、3 つのジャイロ スコープ値の 50 個のレジスタ、3 つの加速度計値の 50 個のレジスタ、1 つの心拍数値、および 1 つの光条件値で構成されます。

- 頭の向きを計算するには、最初のステップは、生徒の顔を指しているWebカメラを使用して画像を取得することです。次に、その画像は BlazeFace17 ランドマーク推定アルゴリズムによって処理されます。このようなアルゴリズムの出力は、顔の特定の領域に対応する 2D キーポイントのリストです。

- アルゴリズムによって提供される目、鼻、口、あごの推定位置を使用して、OpenCV ライブラリのメソッド cv::SolvePnPMethod (標準的な顔の設定) を使用して、遠近法の n 点問題を解きます。ヘッドの方向を定義する回転マトリックスは、この手順の結果として得られます。

- 学生が描かれているデータ フレームから天頂画像を BlazePose18 ランドマーク推定アルゴリズムに転送して、体の姿勢を計算し、画像に描かれている体の関節の 2D 座標のリストを取得します。このランドマークのリストは、生徒のポーズを説明しています。

注:ボディポーズは、クラス中のさまざまな活動に対する生徒の関与を正確に表すことができるため、重要です。たとえば、生徒が自然に机に手を置いて座っている場合、それは彼らがメモを取っていることを意味する可能性があります。一方、常に腕を動かしている場合は、誰かに話しかけている可能性があります。 - 生徒の顔の画像を取得し、アライメント前処理を行います。手順2.3で計算したリストから目のキーポイントを取得し、それらを画像平面に投影して、目の位置が得られるようにします。

- 両目の位置を結合する仮想ベクトルをトレースします。そのベクトルと水平線との間の角度を計算し、ホモグラフィ行列を作成して、画像とキーポイントに逆角度を適用して、目が水平に整列するようにします。

- キーポイントを使用して顔を切り抜き、その限界を検出し、パッチを感情検出畳み込みニューラルネットワーク19に供給する。ネットワークから出力を取得します。これは 7 つの位置を持つベクトルであり、各位置は、顔が 7 つの基本的な感情 (中立、嬉しい、嫌悪感、怒り、怖い、驚き、悲しい) のいずれかを示す確率を示します。

- データフレームから加速度計、ジャイロスコープ、および心拍数のデータを取得して、注意レベルを測定します(図3)。

- 代表的な結果に記載されているカスタムビルドでゼロからトレーニングされたディープラーニングベースのモデルに、加速度計とジャイロスコープのデータのストリームをフィードします。モデル ( 図 4 に示すように、手書き、キーボードでの入力、携帯電話の使用、休憩) のいずれかを表すデータの確率を示す 4 つの位置を持つベクトルであるモデルから出力を取得します。

- 頭の方向、感情認識出力、体の姿勢、ジャイロスコープ、加速度計、心拍数のデータをマージして、前のシステムからのすべての結果を線形化して、最終的な注意分類器にフィードします。この最終分類子 (0 から 100 までのスコア) から結果を取得します。この連続値を、注意の 3 つの個別のカテゴリ (低レベルの注意 (0 から 40%)、中程度の注意 (40% から 75%)、および高レベルの注意 (75% から 100%) のいずれかに分類します。生成されたデータセットの構造を 表 1 に示します。

- 通常のWebブラウザからアクセスできる教師のコンピューターからのグラフィカルユーザーインターフェイス(GUI)を使用して、注意レベルの結果を教師に表示します。

図3:スマートウォッチによってキャプチャされたデータ。 スマートウォッチは、ジャイロスコープ、加速度計、心拍数、および光の状態をデータの流れとして提供します。 この図の拡大版を表示するには、ここをクリックしてください。

図4:アクティビティ認識モデルで考慮されるカテゴリの例。 アクティビティ認識モデルでは、手書き、キーボードでの入力、スマートフォンの使用、休息位置の 4 つの異なるアクションが認識されます。 この図の拡大版を表示するには、ここをクリックしてください。

結果

本研究の対象グループは学部生と修士課程の学生であり、18歳から25歳が主な年齢層です。この集団は、若い学生よりも気を散らすものが少なく電子機器を扱えるため、選ばれました。グループには合計25人が含まれていました。この年齢層は、プロポーザルをテストするための最も信頼性の高い結果を提供できます。

教師に示された注意力の結果は2つの部分から成りま?...

ディスカッション

この作品は、カメラ、スマートウォッチ、人工知能アルゴリズムを使用して、教室での生徒の注意力レベルを測定するシステムを示しています。この情報は、その後、教師に提示され、クラスの一般的な状態を把握することができます。

このプロトコルの主な重要なステップの1つは、スマートウォッチの情報をカラーカメラ画像と同期させることです。これは、これら?...

開示事項

著者らは、この論文で報告された研究に影響を与えたと思われる可能性のある既知の競合する金銭的利益や個人的な関係がないことを宣言します。

謝辞

この研究は、 Programa Prometeo(プロジェクトID CIPROM/2021/017)からの資金提供を受けて開発されました。ロザベル・ロイグ教授は、ユネスコの「教育、研究、デジタルインクルージョン」の議長です。

資料

| Name | Company | Catalog Number | Comments |

| 4 GPUs Nvidia A40 Ampere | NVIDIA | TCSA40M-PB | GPU for centralized model processing server |

| FusionServer 2288H V5 | X-Fusion | 02311XBK | Platform that includes power supply and motherboard for centralized model processing server |

| Memory Card Evo Plus 128 GB | Samsung | MB-MC128KA/EU | Memory card for the operation of the raspberry pi 4b 2gb. One for each raspberry. |

| NEMIX RAM - 512 GB Kit DDR4-3200 PC4-25600 8Rx4 EC | NEMIX | M393AAG40M32-CAE | RAM for centralized model processing server |

| Processor Intel Xeon Gold 6330 | Intel | CD8068904572101 | Processor for centralized model processing server |

| Raspberry PI 4B 2GB | Raspberry | 1822095 | Local server that receives requests from the clocks and sends them to the general server. One every two students. |

| Samsung Galaxy Watch 5 (40mm) | Samsung | SM-R900NZAAPHE | Clock that monitors each student's activity. For each student. |

| Samsung MZQL23T8HCLS-00B7C PM9A3 3.84Tb Nvme U.2 PCI-Express-4 x4 2.5inch Ssd | Samsung | MZQL23T8HCLS-00B7C | Internal storage for centralized model processing server |

| WebCam HD Pro C920 Webcam FullHD | Logitech | 960-001055 | Webcam HD. One for each student plus two for student poses. |

参考文献

- Hasnine, M. N., et al. Students' emotion extraction and visualization for engagement detection in online learning. Procedia Comp Sci. 192, 3423-3431 (2021).

- Khare, S. K., Blanes-Vidal, V., Nadimi, E. S., Acharya, U. R. Emotion recognition and artificial intelligence: A systematic review (2014-2023) and research recommendations. Info Fusion. 102, 102019 (2024).

- Bosch, N. Detecting student engagement: Human versus machine. UMAP '16: Proc the 2016 Conf User Model Adapt Personal. , 317-320 (2016).

- Araya, R., Sossa-Rivera, J. Automatic detection of gaze and body orientation in elementary school classrooms. Front Robot AI. 8, 729832 (2021).

- Lu, Y., Zhang, J., Li, B., Chen, P., Zhuang, Z. Harnessing commodity wearable devices for capturing learner engagement. IEEE Access. 7, 15749-15757 (2019).

- Vanneste, P., et al. Computer vision and human behaviour, emotion and cognition detection: A use case on student engagement. Mathematics. 9 (3), 287 (2021).

- Ma, X., Xu, M., Dong, Y., Sun, Z. Automatic student engagement in online learning environment based on neural Turing machine. Int J Info Edu Tech. 11 (3), 107-111 (2021).

- Wood, E., Bulling, A. EyeTab: model-based gaze estimation on unmodified tablet computers. ETRA '14: Proc Symp Eye Tracking Res Appl. , 207-210 (2014).

- Sanghvi, J., et al. Automatic analysis of affective postures and body motion to detect engagement with a game companion. HRI '11: Proc 6th Int Conf Human-robot Interact. , 205-211 (2011).

- Gupta, S., Kumar, P., Tekchandani, R. K. Facial emotion recognition based real-time learner engagement detection system in online learning context using deep learning models. Multimed Tools Appl. 82 (8), 11365-11394 (2023).

- Altuwairqi, K., Jarraya, S. K., Allinjawi, A., Hammami, M. Student behavior analysis to measure engagement levels in online learning environments. Signal Image Video Process. 15 (7), 1387-1395 (2021).

- Belle, A., Hargraves, R. H., Najarian, K. An automated optimal engagement and attention detection system using electrocardiogram. Comput Math Methods Med. 2012, 528781 (2012).

- Alban, A. Q., et al. Heart rate as a predictor of challenging behaviours among children with autism from wearable sensors in social robot interactions. Robotics. 12 (2), 55 (2023).

- Kajiwara, Y., Shimauchi, T., Kimura, H. Predicting emotion and engagement of workers in order picking based on behavior and pulse waves acquired by wearable devices. Sensors. 19 (1), 165 (2019).

- Costante, G., Porzi, L., Lanz, O., Valigi, P., Ricci, E. Personalizing a smartwatch-based gesture interface with transfer learning. , 2530-2534 (2014).

- Mekruksavanich, S., Jitpattanakul, A. Deep convolutional neural network with RNNs for complex activity recognition using wrist-worn wearable sensor data. Electronics. 10 (14), 1685 (2021).

- Bazarevsky, V., Kartynnik, Y., Vakunov, A., Raveendran, K., Grundmann, M. BlazeFace: Sub-millisecond Neural Face Detection on Mobile GPUs. arXiv. , (2019).

- Bazarevsky, V., et al. BlazePose: On-device Real-time Body Pose tracking. arXiv. , (2020).

- Mejia-Escobar, C., Cazorla, M., Martinez-Martin, E. Towards a better performance in facial expression recognition: a data-centric approach. Comput Intelligence Neurosci. , (2023).

- El-Garem, A., Adel, R. Applying systematic literature review and Delphi methods to explore digital transformation key success factors. Int J Eco Mgmt Engi. 16 (7), 383-389 (2022).

- Indumathi, V., Kist, A. A. Using electroencephalography to determine student attention in the classroom. , 1-3 (2023).

- Ma, X., Xie, Y., Wang, H. Research on the construction and application of teacher-student interaction evaluation system for smart classroom in the post COVID-19. Studies Edu Eval. 78, 101286 (2023).

- Andersen, D. Constructing Delphi statements for technology foresight. Futures Foresight Sci. 5 (2), e144 (2022).

- Khodyakov, D., et al. Disciplinary trends in the use of the Delphi method: A bibliometric analysis. PLoS One. 18 (8), e0289009 (2023).

- Martins, A. I., et al. Consensus on the Terms and Procedures for Planning and Reporting a Usability Evaluation of Health-Related Digital Solutions: Delphi Study and a Resulting Checklist. J Medical Internet Res. 25, e44326 (2023).

- Dalmaso, M., Castelli, L., Galfano, G. Social modulators of gaze-mediated orienting of attention: A review. Psychon Bull Rev. 27 (5), 833-855 (2020).

- Klein, R. M. Thinking about attention: Successive approximations to a productive taxonomy. Cognition. 225, 105137 (2022).

- Schindler, S., Bublatzky, F. Attention and emotion: An integrative review of emotional face processing as a function of attention. Cortex. 130, 362-386 (2020).

- Zaletelj, J., Košir, A. Predicting students' attention in the classroom from Kinect facial and body features. J Image Video Proc. 80, (2017).

- Strauch, C., Wang, C. A., Einhäuser, W., Van der Stigchel, S., Naber, M. Pupillometry as an integrated readout of distinct attentional networks. Trends Neurosci. 45 (8), 635-647 (2022).

転載および許可

このJoVE論文のテキスト又は図を再利用するための許可を申請します

許可を申請さらに記事を探す

This article has been published

Video Coming Soon

Copyright © 2023 MyJoVE Corporation. All rights reserved