Se requiere una suscripción a JoVE para ver este contenido. Inicie sesión o comience su prueba gratuita.

Method Article

Identificación automática superior de parásitos tripanosomas mediante el uso de un modelo híbrido de aprendizaje profundo

En este artículo

Resumen

Los parásitos sanguíneos médicos de todo el mundo se examinaron automáticamente mediante sencillos pasos en una plataforma de IA de bajo código. El diagnóstico prospectivo de los frotis sanguíneos se mejoró mediante el uso de un método de detección y clasificación de objetos en un modelo híbrido de aprendizaje profundo. La colaboración de la monitorización activa y los modelos bien entrenados ayuda a identificar los puntos críticos de transmisión de tripanosomas.

Resumen

La tripanosomiasis es un importante problema de salud pública en varias regiones del mundo, incluidos el sur y el sudeste asiático. La identificación de las zonas críticas bajo vigilancia activa es un procedimiento fundamental para controlar la transmisión de enfermedades. El examen microscópico es un método de diagnóstico comúnmente utilizado. Sin embargo, depende principalmente de personal cualificado y experimentado. Para abordar este problema, se introdujo un programa de inteligencia artificial (IA) que hace uso de una técnica híbrida de aprendizaje profundo de redes troncales neuronales de identificación y clasificación de objetos en la plataforma interna de IA de bajo código (CiRA CORE). El programa puede identificar y clasificar las especies de protozoos tripanosomas, a saber, Trypanosoma cruzi, T. brucei y T. evansi, a partir de imágenes microscópicas de inmersión en aceite. El programa de IA utiliza el reconocimiento de patrones para observar y analizar múltiples protozoos dentro de una sola muestra de sangre y destaca el núcleo y el cinetoplasto de cada parásito como rasgos característicos específicos utilizando un mapa de atención.

Para evaluar el rendimiento del programa de IA, se crean dos módulos únicos que proporcionan una variedad de medidas estadísticas, como la exactitud, la recuperación, la especificidad, la precisión, la puntuación F1, la tasa de clasificación errónea, las curvas de características operativas del receptor (ROC) y las curvas de precisión frente a recuperación (PR). Los resultados de la evaluación muestran que el algoritmo de IA es eficaz para identificar y categorizar parásitos. Al ofrecer una herramienta de detección rápida, automatizada y precisa, esta tecnología tiene el potencial de transformar la vigilancia y el control de enfermedades. También podría ayudar a los funcionarios locales a tomar decisiones más informadas sobre las estrategias de bloqueo de la transmisión de enfermedades.

Introducción

La tripanosomiasis es un desafío importante para los problemas de salud mundial debido a una variedad de especies zoonóticas que causan enfermedades humanas con un amplio rango de distribución geográfica fuera de los continentes africano y americano, como el sur y sudeste de Asia 1,2,3. La tripanosomiasis africana humana (HAT) o enfermedad del sueño, es causada por Trypanosoma brucei gambiense y T. b. rhodesiense, que producen las formas crónica y aguda, respectivamente, que representan la mayor propagación en África. El parásito causante pertenece al grupo Salivaria debido a la transmisión por saliva infectada de la mosca tse-tsé4. Considerando que la conocida tripanosomiasis americana (enfermedad de Chagas) causada por T. cruzi ha sido un problema de salud pública para los países no endémicos; incluyendo Canadá, Estados Unidos, Europa, Australia y Japón, debido a la frecuente migración de individuos de áreas endémicas5. La infección por tripanosomas pertenece al grupo Stercoraria porque se transmite por las heces infectadas de los insectos reduviidos. Las tripanosomiasis y tripanosomiasis (enfermedad de Surra) causadas por la infección por T. evansi son endémicas en África, América del Sur, Asia Occidental y Oriental, y países del sur y sudeste asiático 3,6. A pesar de que se ha descrito tripanosomiasis humana causada por el tripanosoma 3,4,7,8,9,10,11,12, la vía de transmisión de la infección parasitaria es objeto de debate: ya sea la sangre mecánica o infectada a través de insectos hematófagos como moscas tse-tsé y tabánidos o tábanos 6,7, 8,9,10,12,13,14. No se ha encontrado ningún informe de caso en Tailandia, sin embargo, se ha publicado una alta prevalencia de la infección por T. evansi en perros15, caballos de carreras y búfalos de agua en la región oriental16, lo que sugiere que se habría producido una transmisión adquirida entre animales domésticos. Se reportaron varias infecciones humanas atípicas causadas por tripanosomas animales (T. vivax, T. b. brucei, T. congolense, T. lewisi y T. evansi), que no son las formas clásicas de tripanosomas humanos17. Es posible que se subestime la concienciación sobre las infecciones humanas atípicas, lo que pone de relieve la necesidad de mejorar las pruebas diagnósticas y las investigaciones sobre el terreno para detectar y confirmar estos casos atípicos, y permitir el control y el tratamiento adecuados de las enfermedades patógenas animales que afectan a la ganadería mundial, la seguridad alimentaria18 y la atención sanitaria humana. Esto condujo al desarrollo de una estrategia potencial integrada con un método común existente (examen microscópico) para analizar rápidamente muestras de sangre en áreas remotas durante la vigilancia activa, lo que permite identificar las zonas críticas para restringir y controlar la enfermedad.

Tener una incidencia esporádica de la enfermedad de Surra en una amplia gama de animales domésticos como dromedarios, bovinos, equinos y perros que evocan un T. evansi euryxeno puede ser zoonótico para los humanos 1,4,13,14. La infección humana parece imposible porque un factor tripanolítico en el suero humano, expresado a partir de un gen similar al sra, es capaz de prevenir T. brucei y T. congolensehumanos 12,19. Además, como demuestra el primer informe de caso de la India, la enfermedad no tiene asociación con pacientes inmunodeprimidos con VIH4. Como se ha descrito anteriormente, la posible infección humana puede estar relacionada con una deficiencia de lipoproteínas de alta densidad con función anormal del factor lítico tripanosoma, que es un trastorno genético autosómico recesivo poco frecuente, concretamente la enfermedad de Tánger4. En 2016, se descubrió que un paciente vietnamita poseía dos alelos APOL1 de tipo salvaje y una concentración sérica de APOL1 dentro del rango normal. Sin embargo, la teoría de la deficiencia de APOL-1 ya no se considera válida12. Por lo tanto, un posible mecanismo de infección por tripanosomas es el contacto directo de una herida con sangre animal infectada durante la cría ocupacional de animales 4,12. El examen microscópico revela que la morfología de T. evansi es una forma monomórfica del tripomastigote que incluye un tripanosoma predominante largo, delgado, flagelado y en división que es similar a su especie pariente de T. brucei 1,12,13. El núcleo está en posición central con un pequeño cinetoplasto visible en posición posterior. Un estudio anterior indicó que el parásito puede existir en dos formas comparables, conocidas como las formas clásica y truncada. Sin embargo, sigue siendo necesario confirmar sus respectivos efectos patógenos sobre los huéspedes20. El curso de los síntomas varía y va desde fiebre intermitente asociada con escalofríos y sudoración. La suramina, afortunadamente, es una terapia exitosa de primera línea para la tripanosomiasis africana humana en etapa temprana sin invasión del sistema nervioso central (SNC), curando a pacientes en India y Vietnam 4,12,21.

A excepción del examen clínico de los signos, existen varios métodos de diagnóstico para los parásitos de T. evansi, incluida la observación microscópica parasitológica 4,9,12, la serológica 4,8,9,10,12 y las pruebas biológicas moleculares 4,12. Las películas de sangre delgada teñidas con Giemsa se utilizan a menudo para visualizar el parásito presente bajo examen microscópico, que se utiliza de forma rutinaria y común22. Sin embargo, el procedimiento parece ser factible; Sin embargo, requiere mucho tiempo y mano de obra, tiene variabilidad en la evaluación entre evaluadores, es sensible solo a una fase aguda y requiere un aprendiz personal23. Tanto las pruebas de biología molecular como las serológicas también requerían personal altamente calificado para realizar múltiples procesos de preparación de muestras, incluida la extracción y purificación de las muestras antes de analizarlas con aparatos costosos, que son difíciles de estandarizar, riesgo de contaminación con materiales extraparasitarios y discrepancias en los resultados24. Sobre la base de los fundamentos descritos anteriormente, se necesita una tecnología de detección rápida y temprana para apoyar el estudio de vigilancia sobre el terreno y garantizar que el resultado de la encuesta se comunique de manera oportuna para identificar la zona de puntos críticos para un mayor control de la transmisión de la enfermedad 1,8. Los dispositivos basados en computadora (CAD) han sido propuestos como una tecnología innovadora para los campos médicos, incluyendo tareas histopatológicas y citopatológicas25. El CAD mencionado anteriormente se realizó a alta velocidad y se calculó mediante reconocimiento de patrones, es decir, inteligencia artificial (IA). El método de IA se lleva a cabo utilizando algoritmos de redes neuronales convolucionales que se pueden utilizar para tratar con una gran cantidad de muestras de conjuntos de datos, especialmente, un enfoque de aprendizaje supervisado que entrena un modelo bien entrenado sobre el consumo de datos.

En general, la IA es la capacidad de las computadoras para resolver tareas que requieren inteligencia experta, como el etiquetado de datos. El aprendizaje automático (ML), un subcampo de la IA, se representa como un sistema informático con dos procesos diferentes compuestos por la extracción de características y el reconocimiento de patrones. El aprendizaje profundo (DL), o algoritmos avanzados de aprendizaje automático, se refiere al desarrollo de programas y dispositivos computarizados que comparan el rendimiento similar al humano con niveles de precisión mayores e iguales a los logrados por los profesionales humanos26. En la actualidad, el papel de la DL en los campos médico y veterinario se está expandiendo y revolucionando de manera prometedora la prevención de enfermedades transmisibles con el objetivo de la prevención reciente y orientándola al personal de salud individual22,27. La aplicación potencial de DL es ilimitada con etiquetas de calidad y una gran cantidad de conjuntos de datos aumentados, lo que libera a los especialistas para administrar la tarea del proyecto. En concreto, un avance en la imagen digital junto con el análisis asistido por ordenador, mejoraron el diagnóstico y cribado automático en cinco categorías de patología reportadas; incluidos los métodos estáticos, dinámicos, robóticos, de imágenes de portaobjetos completos e híbridos28. Es necesario considerar que la integración de los enfoques de algoritmos de aprendizaje a distancia y los datos de imágenes digitales podría alentar al personal local a utilizar la tecnología en sus prácticas diarias.

Anteriormente, se había demostrado el aumento en la precisión de la predicción del uso de un modelo híbrido27. Para identificar el parásito tripanosoma en imágenes microscópicas, esta investigación presenta dos modelos híbridos, incorporando los algoritmos YOLOv4-tiny (detección de objetos) y Densenet201 (clasificación de objetos). Entre varios modelos de detección, YOLOv4-tiny con una red troncal CSPDarknet53 mostró un alto rendimiento como resultado de predicción en términos de localización y clasificación29. Dado que el detector en tiempo real ha modificado el equilibrio óptimo entre la resolución de la red de entrada, la cantidad de la capa convolucional, el parámetro total y el número de salidas de capa, ha mejorado la priorización de las velocidades de operación rápidas y la optimización de los cálculos paralelos en comparación con las versiones anteriores. La red convolucional densa (DenseNet) es otro modelo popular que logra resultados de vanguardia en conjuntos de datos competitivos. DenseNet201 produjo un error de validación similar comparable al de ResNet101; sin embargo, DenseNet201 tiene menos de 20 millones de parámetros, que es menor que los más de 40 millones de parámetros de ResNet10130. Por lo tanto, el modelo DenseNet podría mejorar la precisión de la predicción con un número creciente de parámetros sin signos de sobreajuste. En este caso, un programa de inteligencia artificial (IA) utiliza un algoritmo híbrido de aprendizaje profundo con redes troncales neuronales de detección y clasificación profundas en la plataforma interna CiRA CORE. El programa desarrollado puede identificar y clasificar las especies de protozoos tripanosomas, a saber, Trypanosoma cruzi, T. brucei y T. evansi, a partir de imágenes microscópicas de inmersión en aceite. Esta tecnología tiene el potencial de revolucionar la vigilancia y el control de enfermedades al proporcionar un método de detección rápido, automatizado y preciso. Podría ayudar al personal local a tomar decisiones más informadas sobre las estrategias de bloqueo de la transmisión de las enfermedades parasitarias de los protozoos.

Protocolo

Las pruebas de sangre archivadas y el diseño del proyecto fueron aprobados por el Comité Institucional de Bioseguridad, el Comité Institucional de Cuidado y Uso de Animales de la Facultad de Ciencias Veterinarias de la Universidad de Chulalongkorn (IBC Nº 2031033 e IACUC Nº 1931027), y el Comité de Ética de Investigación Humana del Instituto de Tecnología Rey Mongkut de Ladkrabang (EC-KMITL_66_014).

1. Preparación de imágenes en bruto

- La preparación del conjunto de datos de imagen

- Obtener al menos 13 portaobjetos positivos con infecciones por parásitos de la sangre, incluidos T. brucei, T. cruzi y T. evansi, confirmados por expertos parasitólogos. Separe las 13 diapositivas para la capacitación (10 diapositivas) y las pruebas (tres diapositivas).

- Adquirir imágenes de las finas películas de sangre teñidas de Giemsa descritas anteriormente bajo un campo de inmersión en aceite de un microscopio óptico con una cámara digital. Obtener imágenes que contengan múltiples objetos de los tripomastigotes de las tres especies de parásitos bajo examen microscópico; Busca una forma esbelta, colas largas, una membrana ondulante y un cinetoplasto en el extremo anterior.

NOTA: La creación de frotis gruesos y finos mejoraría la detección de la tripanosomiasis en fase aguda31. La extracción de sangre mediante pinchazo en el dedo está recomendada por la OMS32. Sin embargo, las películas delgadas son más efectivas para identificar a Trypanosoma cruzi y otras especies, ya que estos organismos tienden a distorsionarse en películas gruesas33. A la luz de esto, utilizamos imágenes de películas de sangre delgadas para mantener la morfología apropiada de los parásitos para este estudio. - Almacene todas las imágenes en una carpeta específica del parásito con las siguientes especificaciones: 1.600 x 1.200 píxeles, profundidad de 24 bits y formato de archivo JPG. Divida las imágenes en los conjuntos de entrenamiento y prueba en una proporción de ~6:1.

NOTA: Ver https://gitlab.com/parasite3/superior-auto-identification-of-medically-important-trypanosome-parasites-by-using-a-hybrid-deep-learning-model/-/blob/main/JOVEimage.zip; Se dividieron 650 imágenes en modelo de entrenamiento (560 imágenes) y prueba (90 imágenes). - Defina la región de interés como una etiqueta rectangular para dos clases: tripanosomas y no tripanosomas. Utilice el módulo de recorte automático para recortar todas las imágenes detectadas mediante el modelo de detección de objetos bien entrenado. El módulo de auto-recorte es el módulo desarrollado en el programa interno CiRA CORE (ver Tabla de Materiales). Recopile un solo objeto por imagen para entrenar la clasificación de objetos.

NOTA: Para este artículo, se dividieron 1.017 imágenes para entrenamiento (892 imágenes) y pruebas (126 imágenes). El entrenamiento modelo se realizó con cuatro clases marcadas, incluyendo leucocitos, T. brucei, T. cruzi y T. evansi.

2. Proceso de formación con la plataforma interna CiRA CORE

- Iniciar un nuevo proyecto

- Abra la aplicación CiRA CORE desde el escritorio de la computadora (ver Tabla de materiales) y cree un nuevo proyecto haciendo doble clic en el icono del programa.

- Elija el icono de operación en la barra de herramientas vertical izquierda para seleccionar las herramientas necesarias.

- Entrenamiento del modelo de detección de objetos

- Seleccione la función de modelo training-DL para el etiquetado de datos y el entrenamiento mediante el método de arrastrar y colocar . Ir a la barra de herramientas General | CiRA IA | Arrastre DeepTrain | Suelta DeepTrain en la pantalla (lado derecho).

NOTA: Para obtener opciones adicionales, haga clic con el botón derecho en la herramienta seleccionada y realice las funciones adecuadas: Copiar, Cortar o Eliminar. - Importe las imágenes utilizando la configuración de la herramienta DeepTrain. Haga clic en el botón Cargar imágenes y navegue hasta el directorio de imágenes. Etiquete los objetos manteniendo pulsado el botón izquierdo y asignando un nombre al objeto seleccionado. Ajuste el grosor de la línea rectangular y el tamaño de la fuente haciendo clic en el botón Configuración de pantalla y Guarde GT como un archivo .gt en el mismo directorio.

NOTA: Guarde según sea necesario para evitar condiciones no deseadas, como cortes de energía, cierres automáticos de programas y colgados dentro del proceso de etiquetado. - Antes de entrenar el modelo, amplíe los datos para recopilar suficiente información mediante las cuatro técnicas de aumento: Rotación, Contraste, Ruido y Desenfoque. Haga clic en el botón Configuración de generación para acceder a esta función.

- Inicie el entrenamiento del modelo haciendo clic en el botón Entrenamiento de la herramienta DeepTrain . La parte de entrenamiento tiene dos subfunciones: Generar archivos de entrenamiento y Entrenar. En la función Generar archivos de entrenamiento , seleccione los modelos deseados, el tamaño del lote y las subdivisiones. Haga clic en el botón Generar para generar datos y guardarlos en el directorio. En la función Entrenar , elija las siguientes opciones: i) usar otra ubicación de entrenamiento generada para las condiciones y la copia de seguridad, ii) usar pesos prediseñados para el entrenamiento continuo o iii) anular los parámetros para el diseño de entrenamiento actual. Esto diseñará la configuración del modelo y las condiciones de entrenamiento.

NOTA: El tiempo del proceso de generación depende del tamaño del archivo de imagen, el uso de aumentos y el espacio de memoria disponible. - Una vez que se completen todas las configuraciones necesarias, comience el entrenamiento del modelo haciendo clic en el botón Entrenar . Permita que el programa se ejecute continuamente, evaluando la pérdida de entrenamiento y ajustando el peso del conjunto de datos durante el proceso de entrenamiento. Si el modelo logra una pérdida óptima, guarde el archivo de peso entrenado en el directorio especificado haciendo clic en el botón Exportar .

- Seleccione la función de modelo training-DL para el etiquetado de datos y el entrenamiento mediante el método de arrastrar y colocar . Ir a la barra de herramientas General | CiRA IA | Arrastre DeepTrain | Suelta DeepTrain en la pantalla (lado derecho).

3. Evaluación del modelo de detección de objetos

- Seleccione la función de evaluación del modelo de detección de objetos para la evaluación del modelo mediante el método de arrastrar y soltar. Ir a la barra de herramientas del plugin | Evaluar | Arrastre EvalDetect | Suelte EvalDetect en la pantalla (lado derecho).

- Haga clic en Configuración y espere tres funciones: Detección, Evaluación y Trazado. Inicie la evaluación del modelo importando el archivo de peso entrenado desde el directorio (paso 2.2.5) haciendo clic en Cargar configuración.

- En la función Detección , seleccione el valor de supresión no máxima (NMS) para mejorar la precisión mediante la eliminación de las detecciones de falsos positivos (FP) redundantes. NMS elimina las detecciones duplicadas generadas por el modelo para mejorar la confiabilidad.

- Continúe con los siguientes pasos en la función Evaluación :

- Importe imágenes de prueba desde el directorio de archivos de imagen haciendo clic en Examinar. Importe el archivo GT desde el directorio donde se guardó en el paso 2.2.2 haciendo clic en Cargar GT.

- Elija el valor Intersección sobre unión (IoU) para evaluar la precisión en el dataset de prueba de imagen específico.

- Haga clic en el botón Evaluación para evaluar el modelo de detección en el directorio especificado. Una vez completada la evaluación, los resultados se guardarán automáticamente como un archivo CSV en el mismo directorio, ordenados por nombre de clase. Este archivo CSV proporcionará parámetros esenciales como Verdadero Positivo (TP), Falso Positivo (FP), Falso Negativo (FN), Recuperación y Precisión para cada clase.

- Para trazar la curva Precisión-Recuperación (PR), siga estos pasos en la función Plot : Importe los archivos CSV del directorio de la sección anterior (paso 3.4) haciendo clic en Examinar. Elija clases de la lista y haga clic en el botón Trazar para mostrar la imagen editable de la curva PR.

- Finalmente, para guardar una imagen con los valores AUC de la curva PR en el formato de imagen requerido en el directorio especificado, haga clic en el botón Guardar de la imagen.

4. Recorte de imágenes para un solo objeto por imagen

- Antes de recortar las imágenes, siga estos pasos:

- Importe las imágenes desde el directorio de archivos de imagen accediendo a la configuración de la herramienta Diapositiva de imagen.

- Importe el archivo de peso entrenado (guardado en el paso 2.2.8) accediendo a la configuración de la herramienta Detección profunda. Haga clic en el botón Configuración | botón +, seleccione el backend (CUDA o CPU), proporcione un nombre, haga clic en Aceptar, elija el directorio de archivos de peso y haga clic en Elegir. Dentro de la herramienta Detección profunda, seleccione los parámetros de detección (supresión de umbral y no máxima (nms)); parámetros de dibujo; parámetros de seguimiento; y parámetros de región de interés (ROI).

- Seleccione el directorio donde se guardarán las imágenes recortadas accediendo a la configuración de la herramienta Recorte profundo . Haga clic en Examinar | elija el directorio para guardar las imágenes recortadas | haga clic en Elegir | seleccione el formato de imagen (jpg o png) | habilite la opción Guardado automático.

- Recorte imágenes para obtener un solo objeto por imagen para la clasificación y segmentación de imágenes. Para llevar a cabo este proceso, utilice cuatro herramientas y establezca conexiones entre ellas: vaya a la barra de herramientas General | Generalidades | Botón Ejecutar. A continuación, vaya a la barra de herramientas General | CiRA IA | DeepDetect; A continuación, vaya a la barra de herramientas General | CiRA IA | Cultivo profundo. Finalmente, vaya a la barra de herramientas Imagen | Adquisición | Diapositiva de imagen.

- Una vez que todos los ajustes necesarios estén en su lugar, inicie el proceso de recorte de imágenes haciendo clic en la herramienta Ejecutar botón .

- Obtenga un nuevo conjunto de datos de entrenamiento de imágenes que consta de imágenes de un solo objeto con un tamaño de 608 x 608.

5. Clasificación de imágenes como entrenamiento de modelos

- Utilice la función de arrastrar y soltar para seleccionar la función de entrenamiento del modelo de clasificación de imágenes para el entrenamiento de datos. Ir a la barra de herramientas Imagen | DeepClassif | Arrastre ClassifTrain | Suelte ClassifTrain en la pantalla.

- Importe imágenes para el entrenamiento de modelos utilizando la configuración de la herramienta ClassifTrain . Haga clic en el botón Abrir carpeta y navegue hasta el directorio de imágenes deseado. Antes del entrenamiento, amplíe los datos haciendo clic en el botón Aumento para obtener más información utilizando técnicas como Rotación, Contraste, Volteo (horizontal y/o vertical), Ruido y Desenfoque.

- Para comenzar el entrenamiento del modelo, haga clic en el botón GenTrain de la herramienta ClassifTrain . En la función GenTrain , seleccione los modelos, el tamaño del lote y las subdivisiones. Asigne un directorio para guardar el archivo generado. Haga clic en el botón Generar para continuar con los datos para el entrenamiento. En la función Entrenar , marque las opciones adecuadas: Continuar entrenando con el peso predeterminado o el peso personalizado.

NOTA: El proceso de generación puede tardar tiempo en función de factores como el tamaño del archivo de imagen, el uso de aumentos, el equilibrio de clases y el espacio de memoria disponible. - Una vez completados todos los preparativos, inicie el entrenamiento del modelo haciendo clic en el botón Inicio . Permitir que el programa se ejecute continuamente, evaluando la pérdida de entrenamiento y ajustando el peso del conjunto de datos durante el proceso de entrenamiento. Si el modelo alcanza el nivel deseado de pérdida, guarde el archivo de peso entrenado en el directorio especificado haciendo clic en el botón Exportar .

6. Evaluación del modelo de clasificación

- Seleccione la función de evaluación del modelo de clasificación de imágenes para la evaluación del modelo mediante el método de arrastrar y soltar . Ir a la barra de herramientas del plugin | Evaluar | Arrastre EvaluateClassif | Suelte EvaluateClassif en la pantalla (el lado derecho).

- Haga clic en Configuración para acceder a funciones adicionales dentro de la herramienta EvaluarClasesi , a saber, Evaluar y TrazarROC.

- Para iniciar la evaluación del modelo, haga clic en el botón Evaluar de la herramienta EvaluarClasesi. Siga estos pasos en la función Evaluar .

- Importe las imágenes de prueba desde el directorio de archivos de imagen haciendo clic en la imagen de la carpeta Cargar. Importe el archivo de peso entrenado desde el directorio (guardado en el paso 5.4) haciendo clic en Cargar configuración. Haga clic en el botón Inicio para evaluar el modelo de clasificación.

- Una vez completada la evaluación, guarde el archivo evaluado como CSV en el directorio especificado haciendo clic en el botón Exportar a CSV . Para la evaluación de los datos en cada umbral, guarde el archivo CSV con los nombres de clase en el directorio especificado haciendo clic en Iniciar todo el umbral. El archivo CSV guardado incluye parámetros como Recall (True Positive Rate), False Positive Rate y Precision para cada clase.

- Para trazar la curva de características operativas del receptor (ROC), haga clic en el botón PlotROC dentro de la herramienta EvaluarClasesi . Siga estos pasos en la función PlotROC .

- Importe archivos CSV desde el directorio obtenido anteriormente haciendo clic en Examinar. Inspeccione la lista de clases importadas y seleccione cada etiqueta de clase para trazar la curva ROC.

- Haga clic en el botón Trazar para visualizar la curva ROC como una imagen. Realice las ediciones deseadas para ajustar las propiedades de la imagen, incluido el tamaño de la fuente, los colores de la fuente, el redondeo del decimal, los estilos de línea y los colores de línea.

- Finalmente, guarde una imagen de la curva ROC con los valores de AUC en el formato de imagen requerido en el directorio especificado haciendo clic en el botón Guardar .

7. Probar el proceso con la aplicación CiRA CORE

- Detección de objetos como prueba de modelo

- Para realizar pruebas de modelos, utilice cuatro herramientas y establezca conexiones entre ellas. Ir a la barra de herramientas General | Generalidades | Botón Ejecutar. A continuación, barra de herramientas General | Generalidades | Depurar. Después de eso, haga clic en Barra de herramientas General | CiRA IA | DeepDetect, y finalmente Barra de herramientas de imagen | Adquisición | Diapositiva de imagen.

- Antes de probar las imágenes, siga estos pasos:

- Importe las imágenes de prueba desde el directorio de archivos de imagen haciendo clic en la opción Configuración en la herramienta Diapositiva de imagen .

- Importe el archivo de peso entrenado guardado del paso 2.2.8 haciendo clic en la opción Configuración en la herramienta DeepDetect . Haga clic en el botón Config , luego en el botón +, seleccione el backend (CUDA o CPU), proporcione un nombre, haga clic en Aceptar, elija el directorio de archivos de peso y haga clic en Elegir. En la herramienta DeepDetect , seleccione los parámetros de detección (Umbral y nms), los parámetros de dibujo, los parámetros de seguimiento y los parámetros de ROI.

- Para ver los resultados de la imagen de prueba, haga clic en la función de imagen en la herramienta Depurar .

- Por último, compruebe los resultados previstos para cada imagen haciendo clic en el botón Ejecutar de la herramienta Botón Ejecutar .

- Clasificación de imágenes como prueba de modelo

- Para realizar pruebas de modelos, utilice cuatro herramientas y establezca conexiones entre ellas. Ir a la barra de herramientas General | Generalidades | Correr botón; luego, barra de herramientas General | Depurar. Después de eso, navegue hasta la barra de herramientas de imagen | Adquisición | ImageSlide, y finalmente, Barra de herramientas de imagen | DeepClassif | DeepClassif.

- Antes de probar las imágenes, siga estos pasos:

- Importe las imágenes de prueba desde el directorio de archivos de imagen haciendo clic en la opción Configuración en la herramienta Diapositiva de imagen .

- Importe el archivo de peso entrenado guardado de la sección 5.5 haciendo clic en la opción Configuración de la herramienta DeepClassif . Haga clic en el botón Configuración | Botón + | seleccione el backend (CUDA o CPU) | Proporcione un nombre | haga clic en Aceptar | Elija el directorio Archivo de peso | haga clic en Elegir. En la herramienta DeepClassif , seleccione los parámetros de clasificación (Umbral y número de predicciones de clase superior), los parámetros del mapa de guía (umbral, alfa, beta y mapa de color) y varios parámetros del mapa de color.

- Para ver los resultados de la imagen de prueba, haga clic en la función de imagen en la herramienta Depurar .

- Por último, compruebe los resultados previstos para cada imagen haciendo clic en el botón Ejecutar de la herramienta Botón Ejecutar .

8. Híbrido (detección y clasificación) como prueba de modelo

- Para realizar esta prueba de modelo, utilice cuatro herramientas y establezca conexiones entre ellas. Ir a la barra de herramientas General | Generalidades | BotónEjecutar. A continuación, barra de herramientas General | Generalidades | Depurar. Después de eso, la barra de herramientas de la imagen | Adquisición | ImageSlide, y finalmente, Barra de herramientas de imagen | DeepComposite | ProfundoD->C.

- Antes de probar las imágenes, siga estos pasos: Importe imágenes de prueba desde el directorio de archivos de imagen haciendo clic en la opción Configuración en la herramienta Diapositiva de imagen . Importe los dos archivos de peso entrenados guardados de la sección 2.1.5 y la sección 4.4 haciendo clic en la opción Configuración de la herramienta DeepD->C :

- Para la función Detectar, haga clic en el botón Config |+, seleccione el backend (CUDA o CPU) | Proporcione un nombre | haga clic en Aceptar | elija el directorio del archivo de peso | haga clic en Elegir. En la función Detectar, seleccione los parámetros de detección (Umbral y nms), los parámetros de dibujo, los parámetros de seguimiento y los parámetros de ROI.

- Para la función Classif, haga clic en el botón Config |+, seleccione el backend (CUDA o CPU) | Proporcione un nombre | haga clic en Aceptar | elija el directorio del archivo de peso | haga clic en Elegir. En la función Classif, seleccione los parámetros de clasificación (Umbral y número de predicciones de primera clase) y los parámetros del mapa de guía (umbral, alfa, beta y mapa de colores).

- Para ver los resultados de la imagen de prueba, haga clic en la función de imagen en la herramienta Depurar . Por último, compruebe los resultados previstos para cada imagen haciendo clic en el botón Ejecutar de la herramienta Botón Ejecutar .

9. Validación cruzada quíntuple

NOTA: Para validar el rendimiento del modelo propuesto de manera más efectiva, se utiliza la validación cruzada de K-fold.

- Divida el conjunto de datos en cinco secciones, correspondientes a los cinco pliegues de validación cruzada. Durante cada iteración del entrenamiento y las pruebas del modelo, use una sección como conjunto de validación para las pruebas y las cuatro secciones restantes para el entrenamiento. Repita este proceso cinco veces, y cada pliegue se utilizará como conjunto de validación una vez.

- Para los pliegues del 1 al 5:

- Repita la sección 5 para entrenar el modelo utilizando los datos de entrenamiento de los cuatro pliegues.

- Repita la sección 7.2 para probar el modelo utilizando el pliegue restante como equipo de prueba.

10. Evaluación del modelo

- Matriz de confusión

- Según los resultados de la prueba, las cuatro condiciones se darán de la siguiente manera:

- Verdadero positivo (TP): cuando la imagen de entrada es verdadera y la predicción también es verdadera.

- Falso positivo (FP): cuando la imagen de entrada es falsa, pero la predicción es verdadera.

- Falso negativo (FN): cuando la imagen de entrada es verdadera, pero la predicción es falsa.

- Verdadero negativo (TN): cuando la imagen de entrada es falsa y la predicción también es falsa.

- Usando estas cuatro condiciones, evalúe los rendimientos con la matriz de confusión.

- Según los resultados de la prueba, las cuatro condiciones se darán de la siguiente manera:

- Evaluaciones de desempeño

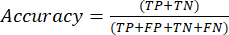

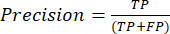

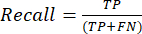

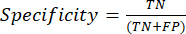

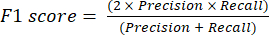

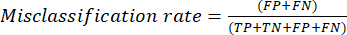

- Las métricas de rendimiento de clasificación más utilizadas son la exactitud, la precisión, la recuperación, la especificidad y los valores de puntuación F1. Calcule todas las métricas de evaluación en las ecuaciones (1-6) utilizadas para evaluar el rendimiento del modelo a partir de los valores de la matriz de confusión.

(1)

(1) (2)

(2) (3)

(3) (4)

(4) (5)

(5) (6)

(6)

- Las métricas de rendimiento de clasificación más utilizadas son la exactitud, la precisión, la recuperación, la especificidad y los valores de puntuación F1. Calcule todas las métricas de evaluación en las ecuaciones (1-6) utilizadas para evaluar el rendimiento del modelo a partir de los valores de la matriz de confusión.

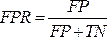

- Curva ROC

NOTA: La curva ROC es una medida de rendimiento para problemas de clasificación con diferentes configuraciones de umbral. El área bajo la curva ROC (AUC) representa el grado o medida de separabilidad, mientras que la ROC es una curva de probabilidad.- La curva ROC es un gráfico bidimensional con los valores de la tasa de verdaderos positivos (TPR) y la tasa de falsos positivos (FPR) trazados en los ejes Y y X, respectivamente. Construya las curvas ROC utilizando los valores de TPR y TFR obtenidos de la matriz de confusión. El valor de TPR es el mismo que la sensibilidad; calcular el valor de FPR utilizando la ecuación (7).

(7)

(7) - Después de obtener los valores de TPR y FPR, trace la curva ROC con la herramienta web de código abierto Jupyter Notebook en un entorno de Python. El AUC es una forma eficaz de evaluar el rendimiento del modelo propuesto en el análisis de la curva ROC.

- La curva ROC es un gráfico bidimensional con los valores de la tasa de verdaderos positivos (TPR) y la tasa de falsos positivos (FPR) trazados en los ejes Y y X, respectivamente. Construya las curvas ROC utilizando los valores de TPR y TFR obtenidos de la matriz de confusión. El valor de TPR es el mismo que la sensibilidad; calcular el valor de FPR utilizando la ecuación (7).

- Curva de PR

- Utilice la curva PR para evaluar modelos midiendo el área bajo la curva PR. Construya la curva PR representando gráficamente la precisión y la recuperación de los modelos utilizando las funciones de umbral de confianza del modelo. Dado que la curva PR también es un gráfico bidimensional, represente Recall en el eje x y Precision en el eje y.

- Represente la curva PR, como la curva ROC, con la herramienta web Jupyter Notebook de código abierto en un entorno de Python. El área bajo la puntuación de la curva de precisión-recuperación (AUC) también es útil en la clasificación de etiquetas múltiples.

Resultados

En este estudio, se propusieron algoritmos híbridos de aprendizaje profundo para ayudar a predecir automáticamente la positividad de una muestra de sangre con una infección por el parásito tripanosoma. Las muestras de sangre archivadas teñidas con Giemsa se clasificaron para localizar y clasificar a los parasitados frente a los no parásitos mediante el uso del algoritmo de detección de objetos basado en una red neuronal troncal de la red oscura. Dentro de cualquier resultado de predicción de caja rectangular obte...

Discusión

La observación microscópica de la infección por protozoos de Trypanosoma es temprana y se usa comúnmente, especialmente durante la vigilancia en áreas remotas donde hay una falta de técnicos calificados y procesos que requieren mucha mano de obra y mucho tiempo, lo que constituye un obstáculo para informar a la organización de salud a tiempo. Aunque las técnicas de biología molecular como la inmunología y la reacción en cadena de la polimerasa (PCR) han sido aprobadas como métodos de alta sensibilidad para r...

Divulgaciones

Todos los autores no tienen información financiera ni conflictos de intereses.

Agradecimientos

Este trabajo (Beca de investigación para New Scholar, Grant No. RGNS 65-212) contó con el apoyo financiero de la Oficina del Secretario Permanente del Ministerio de Educación Superior, Ciencia, Investigación e Innovación (OPS MHESI), Investigación Científica e Innovación de Tailandia (TSRI) y el Instituto de Tecnología Rey Mongkut de Ladkrabang. Agradecemos al Consejo Nacional de Investigación de Tailandia (NRCT, por sus siglas en inglés) [NRCT5-RSA63001-10] por financiar el proyecto de investigación. M.K. fue financiado por el Fondo de Investigación e Innovación Científica de Tailandia de la Universidad de Chulalongkorn. También agradecemos al Colegio de Innovación de Fabricación Avanzada, Instituto de Tecnología King Mongkut, Ladkrabang, que ha proporcionado la plataforma de aprendizaje profundo y el software para respaldar el proyecto de investigación.

Materiales

| Name | Company | Catalog Number | Comments |

| Darknet19, Darknet53 and Densenet201 | Gao Huang, Z. L., Laurens van der Maaten. Densely Connected Convolutional Networks. arXiv:1608.06993 [cs.CV]. (2016) | https://github.com/liuzhuang13/DenseNet | Deep convolutional neural network model that can function to classification Generic name: YOLO model/ detection model? |

| Olympus CX31 Model CX31RRBSFA | Olympus, Tokyo, Japan | SN 4G42178 | A light microscope |

| Olympus DP21-SAL U-TV0.5XC-3 | Olympus, Tokyo, Japan | SN 3D03838 | A digital camera Generic name: Classification models/ densely CNNs |

| Window 10 | Microsoft | Window 10 | Operation system in computers |

| YOLO v4-tiny | Naing, K. M. et al. Automatic recognition of parasitic products in stool examination using object detection approach. PeerJ Comput Sci. 8 e1065, (2022). | https://git.cira-lab.com/users/sign_in | Deep convolutional neural network model that can function to both localization and also classification |

| https://git.cira-lab.com/users/sign_in |

Referencias

- Kasozi, K. I., et al. Epidemiology of trypanosomiasis in wildlife-implications for humans at the wildlife interface in Africa. Frontiers in Veterinary Science. 8, 621699 (2021).

- Ola-Fadunsin, S. D., Gimba, F. I., Abdullah, D. A., Abdullah, F. J. F., Sani, R. A. Molecular prevalence and epidemiology of Trypanosoma evansi among cattle in peninsular Malaysia. Acta Parasitologica. 65 (1), 165-173 (2020).

- Aregawi, W. G., Agga, G. E., Abdi, R. D., Buscher, P. Systematic review and meta-analysis on the global distribution, host range, and prevalence of Trypanosoma evansi. Parasites & Vectors. 12 (1), 67 (2019).

- Joshi, P. P., et al. Human trypanosomiasis caused by Trypanosoma evansi in India: the first case report. The Am Journal of Tropical Medicine and Hygiene. 73 (3), 491-495 (2005).

- Lidani, K. C. F., et al. Chagas disease: from discovery to a worldwide health problem. Frontiers in Public Health. 7, 166 (2019).

- Sazmand, A., Desquesnes, M., Otranto, D. Trypanosoma evansi. Trends in Parasitology. 38 (6), 489-490 (2022).

- Powar, R. M., et al. A rare case of human trypanosomiasis caused by Trypanosoma evansi.Indian. Journal of Medical Microbiology. 24 (1), 72-74 (2006).

- Shegokar, V. R., et al. Short report: Human trypanosomiasis caused by Trypanosoma evansi in a village in India: preliminary serologic survey of the local population. American Journal of Tropical Medicine and Hygiene. 75 (5), 869-870 (2006).

- Haridy, F. M., El-Metwally, M. T., Khalil, H. H., Morsy, T. A. Trypanosoma evansi in dromedary camel: with a case report of zoonosis in greater Cairo, Egypt. Journal of the Egyptian Society of Parasitology. 41 (1), 65-76 (2011).

- Dey, S. K. CATT/T.evansi antibody levels in patients suffering from pyrexia of unknown origin in a tertiary care hospital in Kolkata. Research Journal of Pharmaceutical, Biological and Chemical Sciences. 5, 334-338 (2014).

- Dakshinkar, N. P., et al. Aberrant trypanosomias in human. Royal Veterinary Journal of India. 3 (1), 6-7 (2007).

- Vn Vinh Chau, N., et al. A clinical and epidemiological investigation of the first reported human infection with the zoonotic parasite Trypanosoma evansi in Southeast Asia. Clinical Infectious Diseases. 62 (8), 1002-1008 (2016).

- Misra, K. K., Roy, S., Choudhary, A. Biology of Trypanosoma (Trypanozoon) evansi in experimental heterologous mammalian hosts. Journal of Parasitic Diseases. 40 (3), 1047-1061 (2016).

- Nakayima, J., et al. Molecular epidemiological studies on animal trypanosomiases in Ghana. Parasites & Vectors. 5, 217 (2012).

- Riana, E., et al. The occurrence of Trypanosoma in bats from Western Thailand. The 20th Chulalongkorn University Veterinary Conference CUVC 2021: Research in practice. 51, (2021).

- Camoin, M., et al. The Indirect ELISA Trypanosoma evansi in equids: optimisation and application to a serological survey including racing horses, in Thailand. BioMed Research International. 2019, 2964639 (2019).

- Truc, P., et al. Atypical human infections by animal trypanosomes. PLoS Neglected Tropical Diseases. 7 (9), 2256 (2013).

- Desquesnes, M., et al. Diagnosis of animal trypanosomoses: proper use of current tools and future prospects. Parasites & Vectors. 15 (1), 235 (2022).

- Da Silva, A. S., et al. Trypanocidal activity of human plasma on Trypanosoma evansi in mice. Revista Brasileira de Parasitologia Veterinaria. 21 (1), 55-59 (2012).

- Desquesnes, M., et al. Trypanosoma evansi and surra: a review and perspectives on transmission, epidemiology and control, impact, and zoonotic aspects. BioMed Research International. 2013, 321237 (2013).

- World Health Organization. A new form of human trypanosomiasis in India. Description of the first human case in the world caused by Trypanosoma evansi. Weekly Epidemiological Record. 80 (7), 62-63 (2005).

- Naing, K. M., et al. Automatic recognition of parasitic products in stool examination using object detection approach. PeerJ Computer Science. 8, 1065 (2022).

- Wongsrichanalai, C., Barcus, M. J., Muth, S., Sutamihardja, A., Wernsdorfer, W. H. A review of malaria diagnostic tools: microscopy and rapid diagnostic test (RDT). American Journal of Tropical Medicine and Hygiene. 77, 119-127 (2007).

- Rostami, A., Karanis, P., Fallahi, S. Advances in serological, imaging techniques and molecular diagnosis of Toxoplasma gondii infection. Infection. 46 (3), 303-315 (2018).

- Ahmad, Z., Rahim, S., Zubair, M., Abdul-Ghafar, J. Artificial intelligence (AI) in medicine, current applications and future role with special emphasis on its potential and promise in pathology: present and future impact, obstacles including costs and acceptance among pathologists, practical and philosophical considerations. A comprehensive review. Diagnostic Pathology. 16 (1), 24 (2021).

- Sarker, I. H. Deep learning: a comprehensive overview on techniques, taxonomy, applications and research directions. SN Computer Science. 2 (6), 420 (2021).

- Kittichai, V., et al. Classification for avian malaria parasite Plasmodium gallinaceum blood stages by using deep convolutional neural networks. Scientific Reports. 11 (1), 16919 (2021).

- Baskota, S. U., Wiley, C., Pantanowitz, L. The next generation robotic microscopy for intraoperative teleneuropathology consultation. Journal of Pathology Informatics. 11, 13 (2020).

- Bochkovskiy, A., Wang, C. -. Y., Liao, H. -. Y. M. YOLOv4: optimal speed and accuracy of object detection. arXiv. , 10934 (2004).

- Huang, G., Liu, Z., vander Maaten, L., Weinberger, K. Q. Densely connected convolutional networks. arXiv. , 06993 (2018).

- . CDC-DPDx. Diagnostic procedures - Blood specimens Available from: https://www.cdc.gov/dpdx/diagosticprocedures/blood/specimenproc.html#print (2020)

- Control and surveillance of African trypanosomiasis: report of a WHO expert committee. WHO Technical Report Series 881 Available from: https://iris.who.int/bitstream/handle/10665/42087/WHO_TRS_881.pdf?sequence=1 (1998)

- Leber, A. L. Detection of blood parasites. Clinical Microbiology Procedures Handbook. , (2022).

- Huang, L. -. P., Hong, M. -. H., Luo, C. -. H., Mahajan, S., Chen, L. -. J. A vector mosquitoes classification system based on edge computing and deep learning. Proceedings-2018 Conmference on Technologies and Applications of Artifical Intelligence. , 24-27 (2018).

- Cihan, P., Gökçe, E., Kalipsiz, O. A review of machine learning applications in veterinary field. Kafkas Universitesi Veteriner Fakultesi Dergisi. 23 (4), 673-680 (2017).

- Berrar, D. Cross-validation. Encyclopedia of Bioinformatics and Computational Biology. 1, 542-545 (2019).

- Gaithuma, A. K., et al. A single test approach for accurate and sensitive detection and taxonomic characterization of Trypanosomes by comprehensive analysis of internal transcribed spacer 1 amplicons. PLoS Neglected Tropical Diseases. 13 (2), 0006842 (2019).

- Vijayalakshmi, A., Rajesh Kanna, B. Deep learning approach to detect malaria from microscopic images. Multimedia Tools and Applications. 79 (21-22), 15297-15317 (2019).

- Morais, M. C. C., et al. Automatic detection of the parasite Trypanosoma cruzi in blood smears using a machine learning approach applied to mobile phone images. PeerJ. 10, 13470 (2022).

- Uc-Cetina, V., Brito-Loeza, C., Ruiz-Pina, H. Chagas parasite detection in blood images using AdaBoost. Computational and Mathematical Methods in Medicine. 2015, 139681 (2015).

- Zhang, C., et al. Deep learning for microscopic examination of protozoan parasites. Computational and Structural Biotechnology Journal. 20, 1036-1043 (2022).

- Sarataphan, N., et al. Diagnosis of a Trypanosoma lewisi-like (Herpetosoma) infection in a sick infant from Thailand. Journal of Medical Microbiology. 56, 1118-1121 (2007).

- Desquesnes, M., et al. A review on the diagnosis of animal trypanosomoses. Parasites & Vectors. 15 (1), 64 (2022).

- Fuhad, K. M. F., et al. Deep learning based automatic malaria parasite detection from blood smear and its smartphone based application. Diagnostics (Basel). 10 (5), 329 (2020).

- Christian Matek, S. S., Spiekermann, K., Marr, C. Human-level recognition of blast cells in acute myeloid leukaemia with convolutional neural networks. Nature Machine Intelligence. 1, 538-544 (2019).

- Hamdan, S., Ayyash, M., Almajali, S. Edge-computing architectures for internet of things applications: a survey. Sensors (Basel). 20 (22), 6441 (2020).

- Visser, T., et al. A comparative evaluation of mobile medical APPS (MMAS) for reading and interpreting malaria rapid diagnostic tests. Malaria Journal. 20 (1), 39 (2021).

- Giorgi, E., Macharia, P. M., Woodmansey, J., Snow, R. W., Rowlingson, B. Maplaria: a user friendly web-application for spatio-temporal malaria prevalence mapping. Malaria Journal. 20 (1), 471 (2021).

- Rajaraman, S., Jaeger, S., Antani, S. K. Performance evaluation of deep neural ensembles toward malaria parasite detection in thin-blood smear images. PeerJ. 7, 6977 (2019).

Reimpresiones y Permisos

Solicitar permiso para reutilizar el texto o las figuras de este JoVE artículos

Solicitar permisoExplorar más artículos

This article has been published

Video Coming Soon

ACERCA DE JoVE

Copyright © 2025 MyJoVE Corporation. Todos los derechos reservados